|

|

|

|

|

|

|

Zoek je algemene informatie over oudere GPUs? Kijk dan even in de first posts van de voorgaande topics en lees hun bijbehorende FAQs.

01 02 03 04 05 06 07 08 09 10 11 12 13 14 15 16 17 18 19 20 R520 / R580 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 R600 / RV630 / RV610 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 RV670 / R680 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 RV770 / RV700 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 Evergreen 105 106 107 108 109 110 111 112 113 114 115 116 117 Northern Islands 118 119 120 121 122 Southern Islands 123 124 125 Sea Islands 125 126127 128 Volcanic Islands 128 129 Caribbean Islands 129 130 131 132 133 Arctic Islands 134 135 136 137 |

|

Op 9 september 2015 werd bekend dat de GPU tak een los bedrijfsonderdeel binnen AMD wordt. Sinds de overname van ATi meer dan 9 jaar geleden door AMD was het meer een fusie bedrijf, waarbij de APU's van AMD het perfecte voorbeeld zijn van de fusie. Nu is de GPU tak een losse divisie onder de naam Radeon Technologies Group en staat het onder leiding van Raja Koduri. Zo moet de GPU tak zich beter kunnen focussen op nieuwe GPU's en weer een groter marktaandeel krijgen.  |

|

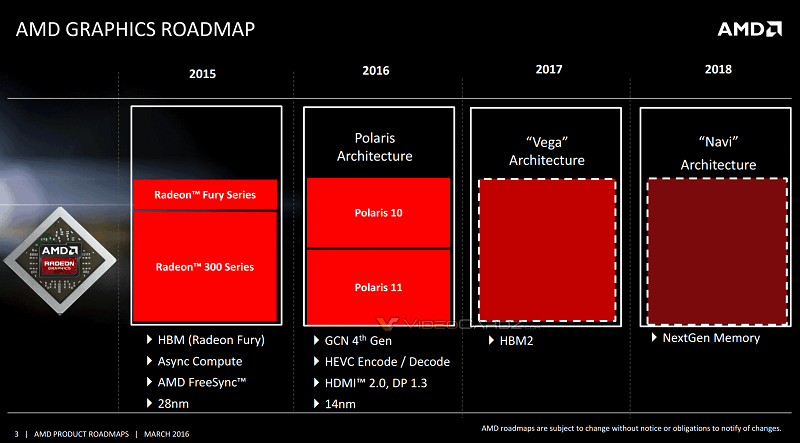

GCNDe Graphics Core Next Generation 1 of kortweg GCN microarchitectuur zag voor het eerst het levenslicht met Southern Islands in de HD 7000 serie. Het is de opvolger van de TeraScale microarchitectuur welke gebruikt werd sinds de HD 2000 series. De TeraScale microarchitectuur is een zogenaamde VLIW SIMD architectuur. De GCN microarchitectuur is een zogenaamde RISC SIMD architectuur.Meer informatie over de GCN microarchitectuur kun je vinden in de HD 7970 review op AnandTech. GCN2Met de launch van de HD 7790 (Bonaire) had de GCN microarchitectuur de eerste veranderingen ondergaan. Bij AMD noemen ze de het GCN2, maar op internet staat het vooral bekend als GCN 1.1. De veranderingen zijn o.a. een nieuwe revisie van Powertune en ondersteuning voor TrueAudio en FreeSync.Meer informatie over de GCN microarchitectuur kun je vinden in de HD 7790 review op AnandTech. GCN3Met de launch van de R9 285 (Tonga) zag de derde revisie van de GCN microarchitectuur het levenslicht. AMD noemt het GCN3, maar op internet zul je vooral GCN 1.2 tegenkomen. De veranderingen bestaan o.a. uit verbeterde tesselation performance, losless delta color compressie (voor geheugenbandbreedte reductie) en een nieuwe UVD.Meer informatie over de GCN 1.2 microarchitectuur kun je vinden in de R9 285 review op AnandTech GCN4Met de launch van de RX 480 (Ellesmere) zag de vierde revisie van de Graphics Core Next architectuur genaamd GCN4 het levenslicht. De veranderingen zijn o.a. TrueAudio Next, betere Delta Color Compression, H.265 GPU versnelling voor afspelen video's, HEVC/H.264 video encoding voor videorecording en streaming met OBS of Raptr, HDMI 2.0b en Display Port 1.3/1.4 ondersteuning. |

|

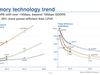

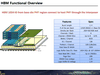

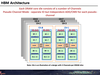

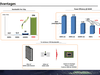

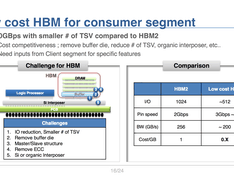

Na HBM is het in de nieuwe generatie de beurt aan de opvolger met de weinig verrassende naam HBM2. Het idee bij HBM2 is nog hetzelfde als HBM. Geheugen wordt naast de GPU geplaatst op een interposer. Via de interposer wordt het HBM verbonden met de GPU.  Door HBM wordt de totale oppervlakte van de GPU en het videogeheugen dat nodig is op een videokaart vele malen kleiner in vergelijking met GDDR5 en GDDR5X. Dit maakt kleine high-end videokaarten mogelijk, zie bijvoorbeeld de Fury X en Nano. Ander voordeel van HBM2 is dat het veel minder verbruikt als hoog geklokt GDDR5 geheugen en zelfs GDDR5X verbruikt meer.  Het verschil tussen HBM en HBM2 is dat HBM2 meer geheugen en meer bandbreedte mogelijk maakt zoals je op bovenstaande afbeelding kunt zien. Zat je met HBM vast aan 4096bit geheugenbus welke 512GB/s bandbreedte gaf en maximaal 4GB geheugen had verdeeld over vier stacks. Met HBM2 kun je die zelfde 512GB/s al bereiken met twee stacks van 256GB/s en dus maar een 2048 bit geheugenbus ook zit je nu niet aan maximaal 4GB vast, maar is 8GB in deze configuratie ook prima mogelijk. HBM2 is dus ideaal voor een kleine high-end videokaart, maar misschien nog wel perfecter voor een high-end APU van AMD voor in bijvoorbeeld een console of kleine en zuinige game PC. |

|

Een aantal weken nadat bekend werd dat grafische tak binnen AMD een eigen divisie kreeg, kwam al snel één van de eerste veranderingen in de zin een opvolger voor Catalyst Control Center. Catalyst Control Center, geschreven in .NET, wordt opgevolgd door Radeon Software Crimson Edition, geschreven in Qt. Naast de volledig veranderde en meer moderne interface is Radeon Software Crimson Edition ook vele malen lichter als Catalyst Control Center, het start dus veel sneller. Bij het lanceren van de nieuwe drivers beloofde AMD ook meer drivers en minimaal 6 WHQL versies uit te brengen per jaar. Vooralsnog maken ze ook hun belofte van meer drivers waar en ook liggen ze op schema voor 6 WHQL drivers binnen een jaar.  Voor alle slides en veranderingen zie het volgende artikel op TechPowerUp. |

|

GPUOpen is AMD's antwoord op nVidia's GameWorks, er is alleen één heel groot verschil. Waarbij GameWorks een gesloten systeem is wat er vaak voor zorgt dat games verschrikkelijk slecht presteren op bijna alle hardware, met soms uitzondering van enkele Maxwell kaarten, die dan gewoon slecht presteren, in plaats van extreem slecht.  Voor meer informatie en nog wat over zie AnandTech en Wikipedia: GPUOpen |

|

FreeSync is AMD's tegenhanger van nVidia's Gsync. Met FreeSync is het mogelijk om een dynamische refreshrate te krijgen, in plaats van een vaste zoals gebruikelijk. Het voordeel hiervan is dat je geen screen tearing meer krijgt. Bij screen tearing worden 2 of meerdere frames van de videokaart op één refresh weergeven. Bij een snel bewegend beeld ziet dit er nogal vreemd uit, doordat het ene stukje beeld dan al verder is al een ander stukje.  Voorbeeld van screen tearing Screen tearing ontstaat doordat op het moment dat de monitor een nieuwe frame uit de framebuffer van de videokaart er halverwege dit proces een nieuwe frame in de framebuffer wordt geplaatst. Op zo'n moment zie je dus twee halve frames op je scherm van verschillende tijdstippen. Zoals het plaatje hierboven laat zien is dit niet ideaal. De oplossing hiertegen was altijd het gebruik van Vsync. Met Vsync produceert de videokaart niet meer frames dan het beeldscherm kan weergeven. Maar Vsync brengt ook weer andere problemen met zich mee. Vsync zorgt namelijk voor input lag. Ook zal de framerate halveren op het moment dat de videokaart niet het benodigd aantal frames kan weergeven. Dit zorgt dan weer voor een niet soepele game ervaring. Met FreeSync pak je alle problemen aan welke je kan krijgen met een niet FreeSync setup. In tegenstelling tot hoe het eerst was bepaald nu niet de monitor wanneer er een nieuw beeld wordt weergeven, maar bepaald nu de videokaart dat. Op het moment dat de videokaart dus klaar is met een frame geeft die dit door aan de monitor welke dan de nieuwe frame uit de framebuffer kan halen. Zo pak je screentearing aan en heb je tegelijkertijd ook geen last input lag of een veel lagere framerate. FreeSync heeft een bereik van 9 t/m 240Hz, al zijn er (op dit moment) geen schermen te vinden die zo'n groot bereik hebben. FreeSync zit verwerkt in de DisplayPort 1.2a specificatie en is een open standaard welke voor iedereen te gebruiken is. Naast DisplayPort is AMD op dit moment ook bezig om FreeSync in een nieuwe HDMI standaard te verwerken.  Reviews over FreeSync zijn te vinden op bijvoorbeeld AnandTech en TechReport en TFT Central. Meer informatie over FreeSync en geschikte monitoren op AMD.com |

|

Low Framerate Compensation, kortweg LFC, is een nieuwe functie bij het gebruik van FreeSync. Zonder deze functie krijg je bij FreeSync last van tearing en judder als de framerate onder het minimale zakt wat het FreeSync scherm kan weergeven. Bij het gebruik van LFC met Vsync heb je hier geen last van doordat dan meermaals dezelfde frame wordt weergegeven ter compensatie. Wel moet de maximale refreshrate van de monitor minimaal 2,5 maal zo hoog zijn als de minimale.   |

|

AMD TressFX Hair is een haar physics systeem. Bedoeld om haar zo natuurlijk mogelijk te laten ogen. Op dit moment zitten we op versie 2.0 in de nieuwe Deus Ex game zal versie 3.0 worden gebruikt. TressFX is in tegenstelling tot nVidia's Hairworks open source en kan dus door iedereen gebruikt worden.  |

|

Virtual Super Resolution of kortweg VSR maakt het mogelijk om een hogere resolutie in te stellen dan dat het scherm werkelijk ondersteund. Vanzelfsprekend zal dit er bij normaal desktop gebruik minder mooi uitzien, maar bij games waarbij anti aliasing niet ondersteund wordt of problemen geeft kan VSR een handige bijkomstigheid zijn.  |

|

Frame Rate Target Control of kortweg FRTC zorgt er voor dat je de frame rate kan afkappen tot een bepaalde maximale waarde, welke in principe los staat van de verversingssnelheid van je beeldscherm. Het werkt niet alleen bij 3D games, maar ook bij introschermen of menu's e.d. In menu's wil een fps van enkele duizenden frames per seconde wel eens voorkomen, dit heeft natuurlijk geen enkel nut, kan alleen maar zorgen voor coil whine. Met FRTC heb je daar dus geen last meer van en het verlaagt ook nog eens het verbruik van de videokaart, doordat deze minder hoeft te berekenen. Het maximale aantal frames per seconde dat ingesteld kan worden is op dit moment 200 en het minimale aantal is 30.  |

|

High Dynamic Range, kortweg HDR, brengt simpelweg een groter kleurbereik. Vanzelfsprekend moet je wel een HDR scherm hebben anders kan het niet weergegeven worden. Op dit moment zijn er een handje vol TV's welke het ondersteunen, maar in de toekomst wordt dit ongetwijfeld de standaard, ook voor monitoren. Zover is het nu in ieder geval nog niet, maar de nieuwste kaarten van AMD zijn hier alvast op voorbereid.   |

|

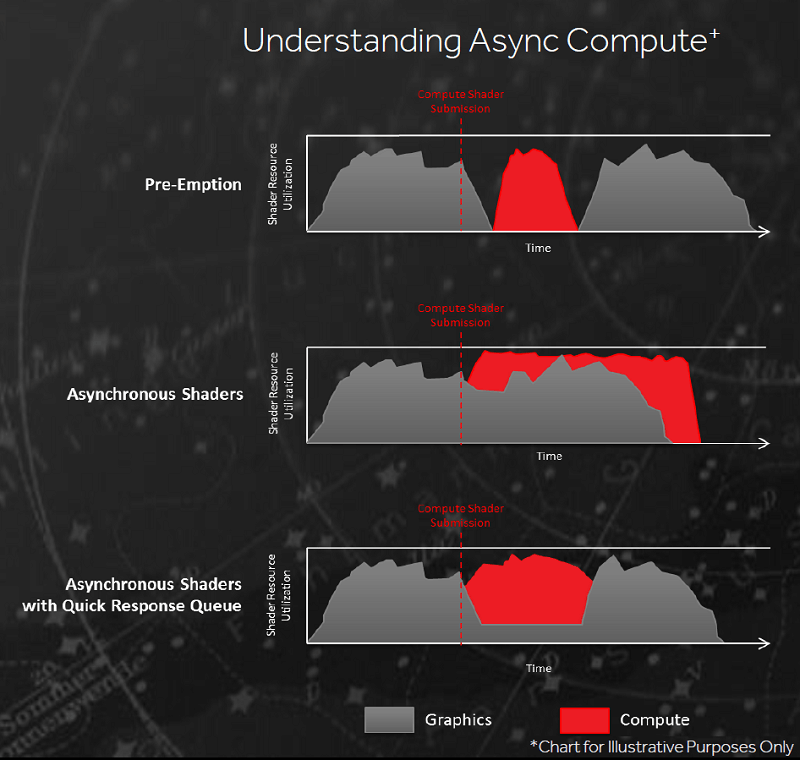

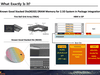

Async Compute is één van de mooie onderdelen van DirectX 12. Async Compute maakt het mogelijk om meerdere verschillende opdrachten parallel door de GPU pipeline te laten lopen. Dit kan voor een grote prestatiewinst zorgen, dus meer fps of de instellingen kunnen hoger. Alle GCN kaarten van AMD ondersteunen Async Compute. nVidia's Maxwell en ook Pascal ondersteunen geen Async Compute waardoor AMD bij gebruik van Async Compute een erg grote sprong kan maken ten opzichte van nVidia.   Whitepaper van AMD wat betreft Async Compute, artikel hierover op Anandtech. nVidia beweert overigens wel dat ze Async Compute ondersteunen. Zo hebben ze altijd vol gehouden dat Maxwell Async Compute heeft maar dat dit uitgeschakeld is in de driver. Vanzelfsprekend is dit niet waar, als het wel waar zou zijn hadden ze het ook al lang veranderd nu meerdere games en zelfs 3DMark er gebruik van kan maken. Bij Pascal hebben ze wel iets wat ze Async Compute noemen. Dit is echter geen Async Compute, er is namelijk niks asynchroon aan hun Async Compute.  Wat nVidia doet is het pauzeren van de een berekening data opslaan, andere data inladen die berekening uitvoeren, data van de eerste berekening weer inladen en verder gaan met die berekening. Gaat dus allemaal serieel terwijl Async Compute parallel werkt. Overigens heeft wat nVidia doet ook een naam, dat heet namelijk pre-emption iets wat AMD ook ondersteund. Alleen doordat nVidia geen Async Compute ondersteund noemen ze hun pre-emption ook maar Async Compute, terwijl dat heel wat anders is. In de bovenstaande afbeelding kun je echter ook zien dat pre-emption ook nadelen heeft, door het wisselen kun je ook juist performance verlies in plaats van winst krijgen.  Hierboven zie je ook nog schematische tekening van AMD waar je pre-emption, Async Compute los en gecombineerd aan het werk ziet. |

|

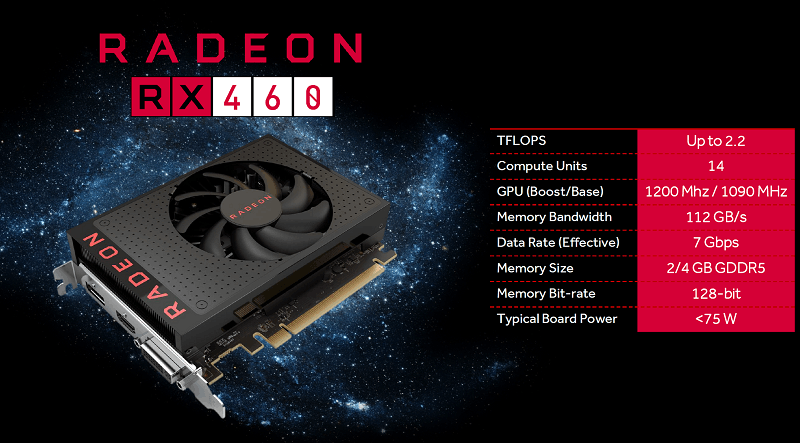

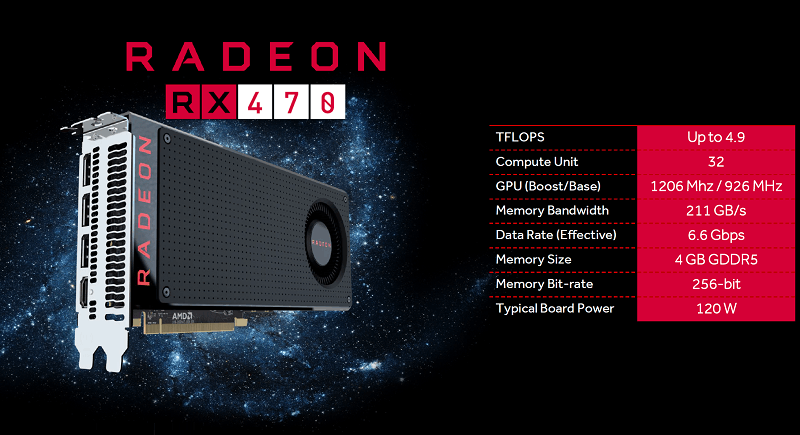

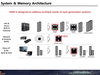

Met de 400 serie is AMD ook overgestapt op een een naamsverandering, zodat het simpeler en duidelijker moet worden dan het was. Hieronder kun je een afbeelding zien wat de naam ongeveer moet betekenen.  Alles met de naam RX moet geschikt zijn voor minimaal games als DOTA 2 en LoL op full HD met minimaal 60 frames per seconde en dit geld voor de traagste RX kaart. Het eerste cijfer achter het voorvoegsel (RX) blijft de generatie, in dit geval vierde generatie. Tweede cijfer blijft prestaties 9 snelste en 5 het laagste aldus de slide. Laatste cijfer is dan voor de revisie, kan een 0 of 5 zijn. Zo had je ook al de R9 285 gebaseerd op Tonga wat je kan beschouwen als een nieuw revisie van Tahiti in de R9 280. Tonga had o.a. een nieuwe GCN versie en een kleinere geheugenbus en geheugencompressie. AMD Radeon RX 460De AMD Radeon RX 460 is gebaseerd op de Baffin (Polaris 11) GPU. Deze GPU heeft 1024 stream processors verdeelt over 16 CU's, waarbij twee CU's in de RX 460 zijn uitgeschakeld waardoor je een totaal krijgt van 896 stream processors. De volledige GPU zal eerst alleen als notebook GPU verschijnen en misschien later ooit nog als RX 465 beschikbaar komen.  Hierboven zie je een render van hoe een RX 460 eruit kan gaan zien. Er komt geen reference versie van deze kaart dus fabrikanten kunnen hun eigen PCB lay-out en koeler maken. Uiterlijk van deze render zal dus niet met de praktijk overeen te komen. Doordat het hier gaat om een Baffin Pro GPU en dus niet de volledig ingeschakelde Baffin XT GPU, zit de prestatie iets onder die van een GTX 950 in DirectX 11 en OpenGL games en iets boven de GTX 950 in DirectX 12 en Vulkan games. Dit is een kaart welke moderne zware games op gemiddelde instellingen zal kunnen spelen op full HD. Maar de markt waar deze kaart vooral op gericht is zal naast de notebook de meer lichtere games zijn zoals Counter Strike, DOTA 2, Heroes of the Storm, Overwatch, Rocket League, Team Fortress 2 of de gewoon iets oudere games. Standaard verbruik van deze kaart ligt onder de 75W, overgeklokte exemplaren gaan over de 75W heen en hebben dan ook een extra PEG connector nodig. Met een stille koeler zal dit ook een prima HTPC kaart zijn welke op de toekomst is voorbereid door HDR, H.265/HEVC, HDMI 2.0b en DisplayPort 1.3 en 1.4. AMD Radeon RX 470De AMD Radeon RX 470 is gebaseerd op Ellesmere Pro (Polaris 10). Deze GPU heeft 2304 stream processors verdeelt over 36 CU's, waarbij 4 CU's in de RX 470 zijn uitgeschakeld waardoor je een totaal krijgt van 2048 stream processors. De volledige GPU vind je terug in de RX 480. De basiskloksnelheid van de GPU is 926MHz en de boostfrequentie is 1206MHz. Het GDDR5 geheugen heeft een frequentie van 1650MHz wat effectief neerkomt op 6,6Gbps. Op bovenstaande foto zie je de RX 470, dit is echter een foto met reference versie. De RX 470 verschijnt echter alleen maar als custom versie, dus elke fabrikant zal komen met zijn eigen ontwerp van deze kaart. In DirectX 11 en OpenGL games zal de kaart zo'n 10% langzamer als een GTX 970 zijn, met Direct X 12 en Vulkan games moet de kaart zo'n 10% sneller kunnen zijn. Het verwachte verbruik van de kaart zal rond de 120W zitten. De vanaf prijs zal 179 dollar worden (net onder de 200 euro inclusief btw). AMD Radeon RX 480De AMD Radeon RX 480 is de eerste kaart van deze nieuwe serie. Deze videokaart is gebaseerd op de volledige Ellesmere (Polaris 10) GPU en telt 2304 stream processors verdeeld over de 36 CU's. De basiskloksnelheid bedraagt 1120MHz en de maximale frequentie is 1266MHz en hier zal de kaart, gemiddeld tijdens een zware game zal de reference kaart rond de 1200MHz zitten.  De geheugenbus bedraagt net als de RX 470 256 bit, het geheugen van de reference versie draait op 2GHz (8Gbps). Het geheugen mag echter ook op 1,75GHz (7Gbps) draaien om kosten te drukken. 7Gbps geheugenchips zijn namelijk goedkoper. De keuze is dus aan de fabrikant. RX 480 gericht op een lage prijs zullen waarschijnlijk vaker 7Gbps geheugenchips bevatten, terwijl duurdere modellen vaker 8Gbps geheugenchips zullen hebben. Geheugen hoeveelheid kan zowel 4GB als 8GB GDDR5 zijn, waarbij de 4GB kaarten een MSRP (Manufacturer's Suggested Retail Price) hebben vanaf 199 dollar (~215 euro incl btw) en de 8GB kaarten een MSRP van 229 dollar (~260 euro incl. btw) hebben meegekregen. Zoals je kunt zien op de laatste afbeelding van hierboven heeft ook de RX 480 standaard een enkele PEG connector. Verbruik van de kaart zit zo rond de 160W, waarmee AMD de kaart beter een 8 pins PEG connector had kunnen geven. Custom versies zullen waarschijnlijk meestal dan ook een 8 pins, twee 6 pins of een 6 en 8 pins PEG connector hebben. Prestaties van deze kaart zitten zo'n 10% onder die van een GTX 980 in DirectX 11 en OpenGL, maar moeten zo'n 10% hoger liggen in DirectX 12 en Vulkan games. Hoe meer DirectX 12 games er in de toekomst dus komen hoe sneller de kaart gemiddeld dus wordt ten opzichte van de GTX 980.   Bron: http://www.hardwarecanuck...erformance-review-24.html |

|

|

|

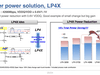

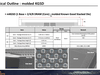

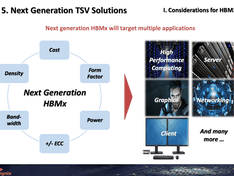

Q1 2017 wordt AMD's high-end Vega10 chip verwacht. Dit zou een chip moeten zijn met 64CU's oftewel 4096 stream processors, dit is een verdubbeling van de RX 470. Verwacht wordt dat de kloksnelheid van de GPU echter iets hoger ligt dan deze kaart, waardoor dubbele prestaties mogelijk moeten zijn. Schaling is echter nooit perfect waardoor, alleen een dubbel aantal stream processors niet genoeg is voor dubbele prestaties, de hogere kloksnelheid moet dat echter wel mogelijk maken. Dat deze GPU hetzelfde aantal stream processors heeft als Fiji zegt overigens niks over de prestaties van Vega10. Vega10 is meer vergelijkbaar met Polaris en daarvan weten we al dat die een betere IPC heeft (meer prestaties op dezelfde kloksnelheid per stream processor). Daarmee kun je dus een prestatie verwachten van waarschijnlijk iets boven de GTX 1070, maar onder de GTX 1080. Het is echter allemaal afhankelijk van de kloksnelheid en die is waarschijnlijk nog niet eens precies bepaald door AMD op dit moment. Vega10 zou voor de rest 2 stacks HBM2 geheugen moeten hebben, een halvering van Fiji, maar doordat met HBM2 de bandbreedte verdubbeld per stack zal de bandbreedte identiek blijven aan Fiji met 512GB/s. Ook dit is geen probleem, Vega10 kan net als Polaris een stuk efficiënter omgaan met geheugenbandbreedte door compressie technieken. De RX 480 heeft dan ook 256GB/s aan geheugenbandbreedte, een verdubbeling hiervan voor Vega10 moet dus voldoende zijn. Qua geheugengrootte kan AMD gaan voor zowel 8GB als 16GB, beide zijn realistische mogelijkheden en misschien kiezen ze ook wel voor beide door twee videokaarten uit te brengen gebaseerd op deze GPU. Doordat HBM2 een stuk zuiniger is als GDDR5 geheugen zal het verbruik van de videokaart niet verdubbelen. Het geheugen op de RX 480 neemt waarschijnlijk maar liefst iets van 50W, waarmee de rest van deze videokaart dus iets van 110W verbruikt. Een verdubbeling van 160W (RX 480) zou 320W zijn, maar doordat Vega10 geen GDDR5 gebruikt, neem je twee maal 110W wat uitkomt op 220W en daarbij komt waarschijnlijk iets van 30W voor het HBM2 geheugen. Hierdoor kom je dus uit op 250W in plaats van 320W, een besparing van 70W door alleen maar een ander type geheugen te gebruiken. Nu is Vega10 echter geen verdubbeling van de RX 480, maar eerder van de RX 470 met waarschijnlijk wel een hogere kloksnelheid en waarschijnlijk een iets beter productieproces. Een verdubbeling van de RX 470 betekend dus een lager verbruik dan 250W, eerder iets van 200W met HBM2. De verwachte hogere kloksnelheid zal het verbruik echter weer opdrijven, maar een beter productieproces zorgt er weer voor dat het verbruik lager ligt. Al met al zou ik dus uitgaan van een verbruik van zo'n 225W. |

|

AMD-only partnersAMD / nVidia partnersUtilities

Officieel AMD-gerelateerd

Topic-gerelateerd

|

|

Deze topicstart is opgedragen aan CJ, oprichter en schrijver van de ATi/AMD Radeon topicreeks van deel 1 tot en met deel 116, welke veel te vroeg van ons is heengegaan.  Rust zacht, CJ |

[ Voor 4% gewijzigd door Verwijderd op 09-12-2016 15:10 ]

:strip_icc():strip_exif()/u/45765/3dfx2.jpg?f=community)

:strip_icc():strip_exif()/u/192627/av70.jpg?f=community)

/u/343341/crop6095457d39560_cropped.png?f=community)

:strip_exif()/u/330838/crop57571595947e8.gif?f=community)

:strip_exif()/u/327460/cowboy.gif?f=community)

:strip_icc():strip_exif()/u/92491/crop64a1593f33a7b_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/14597/crop68eebbb5832b5_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/544669/someone%2520is%2520wrong%2520on%2520the%2520internet60.jpg?f=community)

:strip_exif()/u/652157/crop5eb85d27e7c33_cropped.gif?f=community)

:strip_exif()/u/492254/crop67e544ad1c3eb_cropped.webp?f=community)

:strip_exif()/u/17028/ico_sphere.gif?f=community)

:strip_icc():strip_exif()/u/486359/crop5679254888b42_cropped.jpeg?f=community)

:strip_exif()/u/211274/bestabstractwallpapers5.gif?f=community)

:strip_icc():strip_exif()/u/112011/crop64ec918860c01_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/352653/watchmen_50x50.jpg?f=community)

:strip_exif()/u/6897/IGKIPU.gif?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

/u/34200/crop6554f56fe2075_cropped.png?f=community)

:strip_icc():strip_exif()/u/291146/crop5d31533862205_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/157053/crop574c68cea92df_cropped.jpeg?f=community)

/u/316174/crop5b26bc86bda66_cropped.png?f=community)

/u/400/defember100.png?f=community)

:strip_icc():strip_exif()/u/287731/crop6270fa65746ea_cropped.jpg?f=community)