| |

Welkom in CJ's Radeon Nieuwsdiscussietopic, het topic met de laatste nieuwtjes op het gebied van 3D-videokaarten van de ATI Graphics Division van AMD. Lees, om het hier gezellig te houden, wel even onderstaande regels door voordat je in het topic post. Technische vragen of problemen? Bezoek de AMD Game forums! | |

| |

Ja, ook dit topic heeft regels! In dit topic dienen alleen nieuwsfeiten en geruchten gepost en besproken te worden over AMD Radeons. Heb je problemen met je videokaart? Gebruik dan eerst de search-functie van het forum. Bestaat er nog geen onderwerp over... Open dan een nieuw topic, vul het Catalyst Crew Feedback Form in of vraag het op het AMD Game forum! Post je probleem dus niet hier! Dit is namelijk niet het "Grote Radeon Problemen Topic"! Ook voor advies over de aankoop van een nieuwe videokaart kun je hier niet terecht. Lees daarvoor [BBG aanschaf] Videokaarten Natuurlijk is het normaal dat er vergeleken wordt met de concurrenten, maar doe dat dan zonder geflame en probeer ontopic te blijven om te voorkomen dat dit topic gesloten wordt. De nieuws- en discussiewaarde is het belangrijkste in dit topic. Wat is absoluut NOT DONE in dit topic?

| |

Oude informatie Zoek je algemene informatie over oudere GPUs? Kijk dan even in de first posts van de voorgaande topics en/of lees hun bijbehorende FAQs.

[rml]01[/rml] [rml]02[/rml] [rml]03[/rml] [rml]04[/rml] [rml]05[/rml] [rml]06[/rml] [rml]07[/rml] [rml]08[/rml] [rml]09[/rml] [rml]10[/rml] [rml]11[/rml] 12 [rml]13[/rml] [rml]14[/rml] [rml]15[/rml] [rml]16[/rml] [rml]17[/rml] [rml]18[/rml] [rml]19[/rml] [rml]20[/rml] [rml]21[/rml] [rml]22[/rml] [rml]23[/rml] [rml]24[/rml] [rml]25[/rml] [rml]26[/rml] [rml]27[/rml] [rml]28[/rml] [rml]29[/rml] [rml]30[/rml] [rml]31[/rml] [rml]32[/rml] [rml]33[/rml] [rml]34[/rml] [rml]35[/rml] [rml]36[/rml] [rml]37[/rml] [rml]38[/rml] [rml]39[/rml] [rml]40[/rml] 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 6667 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 | |

Op 23 September 2009 lanceerde AMD de HD5800 Serie uit de Evergreen DX11 generatie. Deze serie gebruikt de Cypress GPU (voorheen bekend als RV870). Dit is een "single die GPU" dus geen MCM oplossing zoals sommigen misschien verwacht hadden. De Cypress GPU is gebruikt in een aantal varianten: - HD5970 - HD5870 - HD5870 Eyefinity(6) Edition - HD5850 - HD5830  Met de uitrol van deze generatie liep AMD ruim voor op de concurrentie en waren ze ongeveer zes maanden lang de enige leverancier van Dx11 gpu's. De populariteit van deze kaarten nam ongekende vormen aan en de vraag was dan ook enorm. Helaas voor de consument betekende dat al snel stijgende prijzen en slechte verkrijgbaarheid. AMD kon de productie van deze kaarten namelijk niet eenvoudig opschoeven. De reden hiervoor lag in het nieuwe 40nm productieproces. De gpu's werden namelijk geproduceerd door TSMC en dat bedrijf had moeite om de kwaliteit van het productieproces op deze node hoog te houden, wat teleurstellende yields ten gevolg had. Het zou maanden duren voordat dit opgelost werd. Ondertussen werden er nog een drietal kleinere gpu's op dit productieproces uitgebracht om de lagere segmenten te bedienen. Juniper werd ingezet op de HD5770 en HD5750, Redwood op de mainstram HD5670, HD5570 en HD5550 en Cedar was de low-end variant die op de HD5450 werd ingezet. Met het uitbrengen van de op Cypress gebaseerde grafische kaarten werden naast hogere prestaties ook een aantal nieuwe features geïntroduceerd. De meest opvallende was EyeFinity. Mt deze techniek kun je drie schermen aan je videokaart koppelen om je zo helemaal te laten omgeven door de gamewereld. Met een speciale Eyefinity Six Edition grafische kaart, loopt dat aantal zelfs op tot zes monitoren.  | |

Bijna exact één jaar na de launch van de eerste Evergreen gpu's, verschenen op 22 oktober 2010 twee nieuwe videokaarten op de markt uit de nieuwe Northern Islands generatie. De HD6850 en HD6870 kaarten zijn voorzien van een Barts gpu. De kaarten werden warm ontvangen, maar zorgden ook voor enige verwarring. In tegenstelling tot wat de naamgeving doet vermoeden, vervangen deze kaarten namelijk niet de populaire HD5850 en HD5870 in het performance segment, maar nemen ze de hun markpositie in vlak boven het niveau waar de op Juniper gebaseerde HD5770 stond. De HD5000 generatie was op dat prijspunt namelijk zeer matig vertegenwoordigd. De HD5830 was niet instaat goed te concurreren met NVidia's GTX460. Maar waarom dan die vreemde type aanduiding? Onderstaande plaatje moet dat verduidelijken.  Zoals je ziet zal Juniper vorlopig in de line-up blijven staan. Aangezien AMD hier niet de concurrentie wil nadoen en de chip rebranden naar bijvoorbeeld HD6600, moest Barts wel een naam krijgen die de verkopen van de HD5770 niet zou schaden. Met een Barts als HD6770 kun je je voorstellen dat Juniper onverkocht op de schappen zou blijven liggen. Ook technisch gezien is Barts een x8xx product. De die size is vergelijkbaar met die van een HD4800 en de geheugencontroller is 256-bits breed.  Wat is Barts? Eenvoudig gezegd is Barts een geoptimaliseerde Cypress gpu. AMD heeft hoog ingezet op efficiency van het design. Dat betekent meer performace per Watt, die size en.... per Euro. De nieuwe gpu kent twee verschijningsvormen: de Barts Pro (HD6850) en Barts XT (HD6870): HD 6850 specs

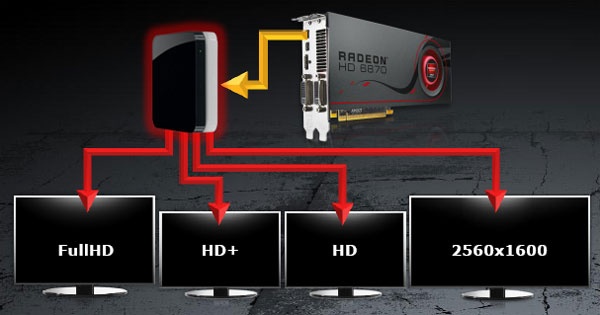

Wat is er nieuw? DisplayPort 1.2 AMD maakt al gebruik van DisplayPort aansluitingen op de HD5000 serie, ondanks dat er nog nauwelijks beeldschermen met dergelijke aansluitingen te koop waren. Nu die schermen langzamerhand beter verkrijgbaar worden, stapt AMD al over op de volgende generatie van die techniek; en weer zijn de beeldschermen met deze techniek niet verkrijgbaar. Daar heeft AMD echter een zeer goede reden voor. DisplayPort 1.2 levert tweemaal zo veel bandbreedte (21,6Gbps) als de vorige generatie en daarmee ook twee maal de bandbreedte die een dual-link DVI aansluiting aankan. Dat betekent in de praktijk dat je met één aansluiting voldoende bandbreedte hebt om twee beeldschermen met 2560*1600 resolutie aan te sluiten of vier beeldschermen met 1920*1080 resolutie. En dat levert weer heel wat mogelijkheden op voor Eyefinity. Eyefinity Bij het verschijnen van Eyefinity waren veel sites lovend over de mate van immersion die de nieuwe techniek bracht. 'Een stap in de richting van het holodeck' was een veelgehoorde opmerking. Er was echter ook kritiek op met name de verplichting om beeldschermen met DisplayPort aansluitingen te moeten hebben. Had je dat niet, dan moest je met converters werken. Om maar meteen met de deur in huis te vallen: die verplichting ligt er nog steeds. De techniek is echter wel een stuk veelzijdiger geworden. Omdat DisplyPort data verstuurt in packages, zijn er twee nieuwe opties om schermen mee aan te sturen: de daisy chain en de hub. Beide aansluitmogelijkheden zijn weergegeven in onderstaande afbeelding.  In de onderste rij beeldschermen zie je een voorbeeld van de daisy chain. De eerste monitor wordt middels DP1.2 aangesloten op de videokaart. De tweede monitor wordt middels DP1.2 aangesloten op een uitgang op de eerste monitor en de derde monitor weer op een DP1.2 uitgang op monitor nummer twee. De mogelijkheid om een hub te gebruiken is echter veel interessanter. Op korte termijn zullen er zogenaamde Multi-Stream Transport (MST) hubs te koop zijn die actief de ontvangen packets verdelen over de aan te sluiten monitoren, zoals je in bovenstaande plaatje op de bovenste rij kunt zien. Het grote voordeel is dat deze monitoren niet met een DP aansluitingen hoeven te zijn uitgerust. Je DVI monitor hoeft de deur dus niet uit. Zoals gezegd biedt DP1.2 voldoende bandbreedte voor vier 1080p beeldschermen, dus kunnen er vier schermen op één hub worden aangesloten.  Bovenstaande situatie is mogelijk met slechts één enkele standaard videokaart. Er zal dus geen speciale Eyefinity Six Edition kaart vanuit AMD verschijnen, al staat het de board partners vrij om eigen varianten op de markt te zetten. Met één enkele MST hub kun je zes DVI beeldschermen aansluiten op je Barts videokaart. Tenslotte is er nog de mogelijkheid om simultaan verschillende resoluties te gebruiken, wat ongetwijfeld het meest bruikbaar zal zijn in professionele omgevingen.  hdmi 1.4a De laatste incarnatie van de hdmi aansluiting is bekend geworden om de ondersteuning van stereoscopisch 3d op televisies, Blu-ray spelers en receivers en is nu ook aanwezig op de nieuwste Radeon videokaarten. In feite maakt deze technologie het mogelijk om voor elk oog een separate frame te tonen met een net iets andere kijkhoek. Uiteraard zijn voor het bekijken van driedimensionale content nog wel brillen en 120Hz monitoren nodig.  AMD heeft zijn 3d initiatief het merk HD3D meegegeven. Met dit open source initiatief gaat het de strijd aan met Nvidia's 3D Vision. Het grote voordeel van AMD's variant is dat er geen specifieke 'HD3D compliant' hardware voor vereist is. De techniek werkt op eender welke 3d monitor met een hdmi 1.4a aansluiting. Op het moment van schrijven zijn er nog maar weinig computerbeeldschermen met dergelijke aansluitingen, maar er komen steeds meer monitoren en televisies op de markt waar deze wel op aanwezig is. Daarnaast kan de techniek overweg met zowel actieve shutter glasses, passieve gepolariseerde brillen alsook toekomstige oplossingen zonder brilletje. De reden hiervoor is dat het een softwarematige oplossing is. Wil je een 3d film bekijken, dan doe je dat middels een player als CyberLink’s PowerDVD 10 Ultra of Arcsoft’s TotalMedia Theatre 3. Wil je een 3d game spelen, dan maak je gebruik van de iZ3D of DDD Tridef driver. Bezoek AMD's HD3D pagina voor meer informatie.  | |

| Hoe de performance is van de Radeons uit de HD6800 serie kan je vrij goed zien in de meeste reviews. Hieronder een performance rating overview: HD6800 Series Launch Reviews

Bron: Xbitlabs | |

AMD zou AMD niet zijn als ze bij de introductie van een nieuwe videokaart ook niet iets verbeterd hadden aan de beeldkwaliteit, oftewel Image Quality (IQ). Op het gebied van zowel anti-aliasing als texture filtering zijn er wat zaken veranderd. Staploze, hoekonafhankelijke Anisotropische Filtering (AF) Met de Evergreen architectuur introduceerde AMD ware hoekonafhankelijke AF. Toch waren kritische reviewers en eindgebruikers niet altijd even lovend over AMD's AF oplossing. Wat was er mis? Door een "bug" [quote Dave Baumann] was er in synthetische tests en een beperkt aantal games (met name Trackmania) een stappenverschil in de diepte te zien.  Dat is in Northern Islands echter aangepast en AMD heeft dit met terugwerkende kracht via het Catalyst Control Panel ook toegepast op de HD4000 en HD5000 serie. Tevens zijn er kwaliteitsverbetering op de LOD waardes, wat zou moeten betekenen dat er geen of minder "texture crawl" zou moeten zijn.  Na een standaardinstalltie staat de slider halverwege op "Quality". Dit zijn instellingen gelijk aan voorgaande Catalyst drivers (HD4000, HD5000) en volgens AMD van dezelfde of hogere kwaliteit dan Nvidia's instellingen. Zet je de slider echter op High Quality dan worden ALLE optimalisaties uitgezet; een optie die samen met hoekonafhankelijke AF, niet mogelijk is bij Nvidia. Hieronder een lijst met effecten van de slider:

Anti-Aliasing Op het gebied van Anti-Aliasing is er één grote verandering: AMD biedt een oplossing die een paar generaties terug nog afgebrand werd. Zoals de meesten van jullie hopelijk weten was het ATI's idee met R600 om alle Anti-Aliasing via de shaders van de videokaart te laten lopen. Dit bleek achteraf niet het beste idee ter wereld, toen in sommige gevallen de oude generatie (X1950XTX) sneller bleek te zijn dan de nieuwe generatie (HD2900XT). Echter, de tijden zijn veranderd en AMD's aanpak ook. In plaats van pure omzetting van Anti-Aliasing naar shadertaal biedt AMD nu een optie die Full-Screen Anti-Aliasing toestaat via de DirectCompute 5.0-taal (DirectCompute 5.0 is de DirectX 11 tegenhanger van OpenCL en NVIDIA's CUDA). Dit betekend dus dat MLAA een post-processing AA techniek is die onafhankelijk van de game draait, dus ook op games die geen AA ondersteunen, zoals games gebaseerd op de Unreal3 engine in DirectX 9 modes (BioShock, Batman: Arkham Asylum, etcetera). Morphological AA (MLAA) biedt gebruikers de mogelijkheid om met minimaal prestatieverlies AA toe te passen op alle contrasterende objecten op het scherm. Dit is vergelijkbaar met NVIDIAs Coverage-Filtering Anti-Aliasing (CFAA) maar met één groot verschil. het prestatieverlies is met MLAA zó klein dat dit binnen de foutmarges van de benchmarkstatistieken valt; vergelijkbaar met het hedendaags gebruik van 16xAF op High Quality. Om het prestatieverlies te illustreren gebruiken we een game waar AA de meeste impact heeft op de framerates: StarCraft II.  Zoals je in bovenstaande benchmark kunt zien, is het prestatieverlies bij het gebruik van MLAA minimaal (minder dan 2.5%) ten opzichte van het gebruik van geen AA. 4xMulti Sampling AA zorgt al snel voor meer dan 50% prestatieverlies en 4x Super Sampling AA voor 60%. Nu is dit worst-case scenario voor MSAA en SSAA, maar het laat duidelijk zien dat AA vanaf nu "gratis" is op DirectX 11 Radeon kaarten. Let wel: DirectX 11 Radeon kaarten, want de code draait voorlopig alleen op DirectCompute 5 en niet Op DirectCompute 4 (HD4000). Overigens, MLAA werd eerder toegepast in Metro 2033 (als AAA) en wordt ook op de PS3 toegepast aangezien daar normale MSAA NVIDIA's "RSX" prestatie kost in tegenstelling tot ATI's Xenos. MLAA kan aangezet worden door het vinkje voor Morphological AA aan te zetten in het CCC:  Kwaliteit 0xAA 8xMLAA:  Zoals je ziet lijkt dit verdacht veel op SSAA, maar dan zonder de eerder genoemde prestatieverliezen. Maar nu zul je denken: 'SSAA past soms AA toe op dingen die het niet zouden moeten hebben?' Dat klopt en daar heeft MLAA ook een klein beetje last van. Echter, door de manier van verwerken is het veel minder storend met MLAA dan met SSAA. Hier een voorbeeld van text blurring: 1920x1200 8xMSAA: 1920x1200 8xMLAA: Het is lang niet zo erg als de blurring bij de ouderwetse SSAA technieken en we kunnen ook niet zeggen dat het erg opvalt bij normaal gebruik. Vergelijking MLAA & MSAA (afbeelding is 4x ingezoomd). Company of Heroes: Online @ 1920x1200 8xMLAA 16xHQAF  Company of Heroes: Online @ 1920x1200 8xMSAA 16xHQAF  Wat eigenlijk direct opvalt bij de overgang van licht naar donker in de afbeeldingen is het minder aanwezig zijn van het "trapsgewijze" effect van Anti-Aliasing bij gebruik van MLAA. Als laatste kunnen we melden dat de Wide- en Narrow-Tent AA modi uit CCC zullen gaan verdwijnen. Ze zijn nog wel te vinden in de huidige drivers (10.10a), maar ze zijn met de komst van MLAA misschien wel overbodig geworden. | |

| AMD zal ook met een volledige Mobility Radeon DX11 lineup komen. De mobile Evergreen GPUs vallen onder de Manhattan noemer en bestaat uit 4 GPUs die op hun beurt weer verdeeld zijn in 12 SKUs. Elke GPU heeft de naam van een locatie op het eiland Manhattan. Alleen Lexington is nooit uitgebracht... dit is de mobiele Cypress variant. De reden waarom deze (nog) niet is uitgebracht? Misschien een te hoog stroomverbruik. Of misschien wacht AMD totdat NV een Fermi-based mobile GPU uitbrengt. Manhattan Mobility Radeon

Vancouver Mobility Radeon:

De performance per watt is een stuk beter dan z'n voorganger van de M9x GPU en gemiddeld gezien ligt de performance op ongeveer 1,35x a 1,45x de vorige generatie uit de M9x series. Net zoals z'n dekstop broertjes is de Manhattan lineup gemaakt op het 40nm proces en ondersteunt het naast DX11 en EyeFinity ook technieken die speciaal bedoeld zijn voor mobile GPUs zoals PowerXpress, SG Switching, XGP support. Alle GPUs zijn pin-to-pin compatible met de vorige generatie dus niets staat een snelle uitrol in de weg. Hieronder de positionering van de Mobility Radeon HD5000 Series door AMD: HD5800 Series - Gaming Enthusiast Segment HD5700 & HD5600 Series - Performance Segment HD5470 & HD5450 - Mainstream Segment HD5430 - Thin & Light Segment De Mobility Radeon HD5870 (Broadway) is niet gebaseerd op Cypress, maar op Juniper. De GPU heeft 1.04 Miljard transistors en 800 Streamprocessors en kan gekoppeld worden aan GDDR5, GDDR3 en DDR3 geheugen. De Mobility Radeon 5700 en 5600 Series (Madison) zijn gebaseerd op Redwood en bevatten 400 streamprocessors in een GPU van 626 miljoen transistors. Ook deze GPU is geschikt voor GDDR5, GDDR3 en DDR3 geheugen. De 5400 Serie (Park) is gebaseerd op Cedar en bevat 80 streamprocessors in een GPU van 242M transistors. Deze budget GPU kan gekoppeld worden aan GDDR5, GDDR3, DDR3 en DDR2. Ook de GPUs van Fusion krijgen namen. Waar voor mobile ski resorts in de buurt van Vancouver genomen zijn, krijgt Fusion de namen van ski resorts rond Colorado:

| |

Op korte termijn (eind 2010) staan gepland:

| |

Gerucht: de high-end varianten van de komende lichting Mobility Radeon gpu's worden geleverd met 2GB GDDR. Waarschijnlijkheidsfactor: 73.2% Gerucht: de naam 'Mobility Radeon' gaat verdwijnen. Waarschijnlijkheidsfactor: 100% Gerucht: Antilles (HD6990) launch tijdens de CES 2011. Waarschijnlijkheidsfactor: 70% Gerucht: De HD7000 serie welke op 28nm gebakken en uit vier verschillende GPU's bestaat, zou eind volgend jaar al weer in de winkels liggen. Waarschijnlijkheidsfactor: 50%, nieuwe geruchten wijzen op problemen bij TSMC. | |

| AMD Exclusive Fabrikanten voor NederlandNon Exclusive Fabrikanten (zowel AMD als nVidia)ATi Tweak Tools

|

Deze topicstart is opgedragen aan CJ, oprichter en schrijver van de ATi/AMD Radeon topicreeks, van deel 1 tot en met deel 116. Rust zacht, Tweaker.  Condoleance topic voor CJ. | |

[ Voor 201% gewijzigd door Verwijderd op 16-12-2010 14:08 ]

:strip_icc():strip_exif()/u/939/crop5729ac029c082_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/326608/crop5d26079bc4d20_cropped.jpeg?f=community)

:strip_exif()/u/327460/cowboy.gif?f=community)

:strip_icc():strip_exif()/u/80624/crop56269c878c330.jpeg?f=community)

:strip_icc():strip_exif()/u/69419/0089865db7d71e77582b59be11e15f7c448c248e_medium.jpg?f=community)

/u/34200/crop6554f56fe2075_cropped.png?f=community)

:strip_exif()/u/52345/amd_quadcore_barcelona_re.gif?f=community)

:strip_icc():strip_exif()/u/270023/iso.jpg?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

:strip_icc():strip_exif()/u/193806/22.jpg?f=community)

/u/258116/crop5d27969c3ab9d_cropped.png?f=community)

:strip_icc():strip_exif()/u/345031/Salival60.jpg?f=community)

/u/351975/28008.png?f=community)

:strip_icc():strip_exif()/u/123789/crop5a4b15203fcba_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/220197/pino2.jpg?f=community)

/u/257243/crop67d5ead43213c_cropped.png?f=community)

/u/139379/format-c.png?f=community)

:strip_icc():strip_exif()/u/172752/crop5b8bcb4d224e0_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/7205/duke3.jpg?f=community)

/u/875/60px-Vexilloid_of_the_Roman_Empire.svg.png?f=community)

:strip_exif()/u/318790/vertomme-1130623773.gif?f=community)

:strip_icc():strip_exif()/u/99201/21.jpg?f=community)

/u/180271/av.png?f=community)