|

|

|

|

|

|

|

Zoek je algemene informatie over oudere GPUs? Kijk dan even in de first posts van de voorgaande topics en lees hun bijbehorende FAQs.

01 02 03 04 05 06 07 08 09 10 11 12 13 14 15 16 17 18 19 20 R520 / R580 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 R600 / RV630 / RV610 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 RV670 / R680 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 RV770 / RV700 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 Evergreen 105 106 107 108 109 110 111 112 113 114 115 116 117 Northern Islands 118 119 120 121 122 Southern Islands 123 124 125 Volcanic Islands 126 127 128 |

|

GCN 1.0 key points

Voor meer informatie over de GCN architectuur zie: AMD's Graphics Core Next Preview op AnandTech GCN 1.1 key pointsGCN 1.1 bestaat niet echt bij AMD, maar als er over GCN 1.1 wordt gesproken, dan wordt Bonaire (HD7790, R7 260(X)), Hawaii (R9 290(X)) en Vesuvius (R9 295X2) bedoeld. Naast deze GPU's beschikt de Kaveri APU's (7000 serie) ook over deze architectuur.GCN 1.1 bevat de volgende verbeteringen:

|

|

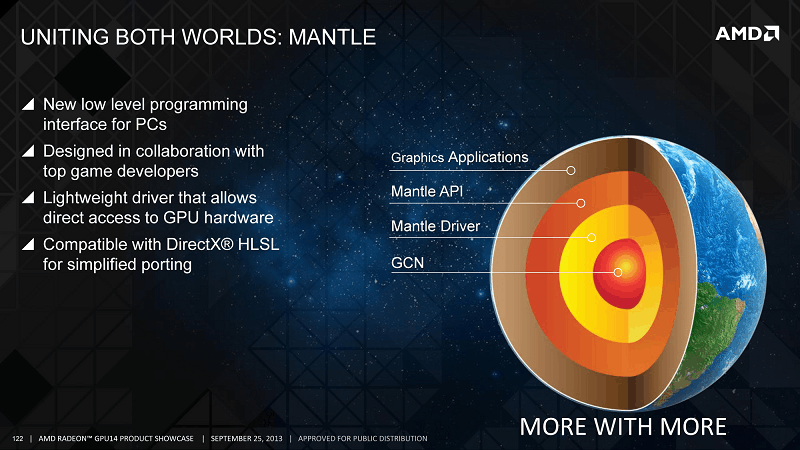

Mantle APIMantle is een low-level rendering API bedoeld voor 3D computergames en is bedacht en ontwikkeld door AMD in samenwerking met DICE in 2013. Mantle is een alternatief voor Direct3D en OpenGL. Het grote voordeel van Mantle is dat het de draw calls naar de CPU verminderd, waardoor bij met name een CPU bottleneck erg grote winst kunt krijgen in performance. Naast dat de load op de CPU minder wordt kan de Mantle API ook beter omgaan met meerdere CPU core's. Games met Mantle ondersteuning |

|

|

|

|

|

AMD-only partnersAMD / nVidia partnersUtilities

Officieel AMD-gerelateerd

Topic-gerelateerd

|

|

Deze topicstart is opgedragen aan CJ, oprichter en schrijver van de ATi/AMD Radeon topicreeks van deel 1 tot en met deel 116, welke veel te vroeg van ons is heen gegaan.  Rust zacht, CJ |

Kom maar met de sappige rumors over de nieuwe AMD kaartjes, heb al voorzorgsmaatregelen getroffen..

N47h4N|The secret to creativity is knowing how to hide your sources| Dyslexic atheists don't believe in doG! | ˙ʞuɐlq ʇɟǝl ʎllɐuoᴉʇuǝʇuᴉ sɐʍ ǝɔɐds sᴉɥ┴ ®

Jup ziet er mooi strak uit, met daarin mss wel de juiste specs, maar die fanboyz slides van zowel de rode als de groene zijn zo vermakelijk, dus dat is ook wel smullen, er tussendoor lees je daar toch wel wat waarheden doorheen, niks aan te merken op je TP, Douwe!

N47h4N|The secret to creativity is knowing how to hide your sources| Dyslexic atheists don't believe in doG! | ˙ʞuɐlq ʇɟǝl ʎllɐuoᴉʇuǝʇuᴉ sɐʍ ǝɔɐds sᴉɥ┴ ®

Hoe zit het eigenlijk met de volledig geactiveerde Hawaii chip? Gaan we deze niet misschien terug zien in de 300 serie? Of is het gerucht van een volledig geactiveerde Hawaii chip ontkracht?

Verwijderd

Ha!

Evolve max settings 1080P gebruikt mijn volle 4GB vram. Wie zei dat 4GB genoeg was voor de toekomst ?

Hopelijk komt de 390X in 8GB variant, anders koop ik hem niet

Evolve max settings 1080P gebruikt mijn volle 4GB vram. Wie zei dat 4GB genoeg was voor de toekomst ?

Hopelijk komt de 390X in 8GB variant, anders koop ik hem niet

Niemand zei dat het genoeg was voor de toekomst. Het wordt gezegd over de 'nabije' toekomst.

Zou de 300 serie eindelijk een kaart hebben met 1024 shaders of meer, met een TDP van minder dan 75Watt?

Zou de 300 serie eindelijk een kaart hebben met 1024 shaders of meer, met een TDP van minder dan 75Watt?

Graphene; a material that can do everything, except leave the lab. - Asianometry

Dat je ram tot 4 gb gebruikt is zegt niet dat er zoveel in gebruik moet zijn om het soepel te laten lopen. Dat geheugen is volgepompt, omdat er domweg de ruimte voor is en niet omdat het echt nodig is.Verwijderd schreef op donderdag 12 februari 2015 @ 13:44:

Ha!

Evolve max settings 1080P gebruikt mijn volle 4GB vram. Wie zei dat 4GB genoeg was voor de toekomst ?

Hopelijk komt de 390X in 8GB variant, anders koop ik hem niet

Het is zeker de afgelopen maand al meermaals aangetoond dat het vrijwel onmogelijk is om echt 4gb te laten overlopen op resoluties onder de 4K. Er is eerder een gpu bottleneck, dan een ram bottleneck. Pas als gpu's snel genoeg zijn om 4K bij te kunnen benen zie ik het nut van 8GB kaarten in. En ik vrees dat geen enkele 28nm GPU daar ooit toe in staat zal zijn bij moderne games.

Verwijderd

GPU's zijn nu al snel genoeg voor 4K.sjekneck schreef op donderdag 12 februari 2015 @ 15:12:

[...]

Dat je ram tot 4 gb gebruikt is zegt niet dat er zoveel in gebruik moet zijn om het soepel te laten lopen. Dat geheugen is volgepompt, omdat er domweg de ruimte voor is en niet omdat het echt nodig is.

Het is zeker de afgelopen maand al meermaals aangetoond dat het vrijwel onmogelijk is om echt 4gb te laten overlopen op resoluties onder de 4K. Er is eerder een gpu bottleneck, dan een ram bottleneck. Pas als gpu's snel genoeg zijn om 4K bij te kunnen benen zie ik het nut van 8GB kaarten in. En ik vrees dat geen enkele 28nm GPU daar ooit toe in staat zal zijn bij moderne games.

Máar als het puur gaat om gamen ben je beter af met een 1440P 120/144hz beeldscherm imo (tot 2016 dan komt 4K 120hz), voor de rest van de dingen heb ik me 4K TV

En dat is t.o.v. een R9 290X (overclocked to 1030 MHz GPU, 4 GB GDDR5 at 1375 MHz (5500 MT/s))

V.z.i.w. zijn er nog geen goede Crossfire reviews van de R9 290X 8GB. Kitguru heeft het getest met 2x8 PCI-e 3.0 lanes.

[ Voor 25% gewijzigd door madmaxnl op 12-02-2015 19:08 ]

Nope.Verwijderd schreef op donderdag 12 februari 2015 @ 15:50:

[...]

GPU's zijn nu al snel genoeg voor 4K.

Server: Xeon X3430 21TB RAID 5 | Game: 5900X, 6900XT, dual FS2735 | Mobile: Lenovo X1 Carbon, Thinkpad T440s, Moto G7 Plus

Verwijderd

WccFTech is weer lekker bezig met geruchten

http://wccftech.com/amd-f...90x-cooler-master-liquid/

http://wccftech.com/fiji-xt-limited-4gb-memory/

http://wccftech.com/amd-f...90x-cooler-master-liquid/

http://wccftech.com/fiji-xt-limited-4gb-memory/

Duurt wel lang voordat er weer wat nieuws komt. Zeker in het mainstream segment. Het is zelfs zo erg dat een 270X duurder is dan meer dan een jaar geleden.

Die is duurder omdat de Euro minder waard is geworden ten opzichte van de Dollar. Als ik me niet vergis.

Graphene; a material that can do everything, except leave the lab. - Asianometry

Nou dat telt ook mee natuurlijk, maar in principe is die kaart nooit in prijs omlaag gegaan.

Zulke artikelen is natuurlijk volop speculeren maar ze schrijven release data eind februari/begin maart. Aangezien het zo super stil is rondom de kaarten vraag ik me af of dit gaat gebeuren, het is immers al eind feb.

http://wccftech.com/gtx-9...mds-r9-380x-febuary-2015/

Denken jullie dat de 390X voor mei nog gelanceerd zal zijn of niet? Zit namelijk te twijfelen om mijn CF R9 290 Tri-X OC te verkopen en dan 1x zo'n bakbeest ervoor terug te kopen.

Waarom voor mei? Dat leg ik nog wel eens uit

Hier is het weer apr-jun -> http://forums.overclockers.co.uk/showthread.php?p=27661220

-> http://forums.overclockers.co.uk/showthread.php?p=27661220

4-6 weken -> http://www.tweaktown.com/...four-six-weeks/index.html

-> http://www.tweaktown.com/...four-six-weeks/index.html

Edit: Vergat linkje

http://wccftech.com/gtx-9...mds-r9-380x-febuary-2015/

Denken jullie dat de 390X voor mei nog gelanceerd zal zijn of niet? Zit namelijk te twijfelen om mijn CF R9 290 Tri-X OC te verkopen en dan 1x zo'n bakbeest ervoor terug te kopen.

Waarom voor mei? Dat leg ik nog wel eens uit

Hier is het weer apr-jun

4-6 weken

Edit: Vergat linkje

[ Voor 24% gewijzigd door BastiaanNL op 23-02-2015 12:05 ]

Het duurt me echt the lang. Geld brand in m'n hand. Van de week bijna even 290 gekocht maar ik kon me nog net inhouden. Luxe probleem maar toch...

Verwijderd

Ik heb nu 1 pricewatch: Sapphire R9 290 4GB GDDR5 OC TRI-X en ik ga niet voor 1 maar voor 2 390(X)? RIP spaargeldBastiaanNL schreef op maandag 23 februari 2015 @ 11:58:

Zulke artikelen is natuurlijk volop speculeren maar ze schrijven release data eind februari/begin maart. Aangezien het zo super stil is rondom de kaarten vraag ik me af of dit gaat gebeuren, het is immers al eind feb.

http://wccftech.com/gtx-9...mds-r9-380x-febuary-2015/

Denken jullie dat de 390X voor mei nog gelanceerd zal zijn of niet? Zit namelijk te twijfelen om mijn CF R9 290 Tri-X OC te verkopen en dan 1x zo'n bakbeest ervoor terug te kopen.

Waarom voor mei? Dat leg ik nog wel eens uit

Hier is het weer apr-jun-> http://forums.overclockers.co.uk/showthread.php?p=27661220

4-6 weken-> http://www.tweaktown.com/...four-six-weeks/index.html

Edit: Vergat linkje

Het is wel waard om een 1440P 144hz vol te benutten.

Ik game ook op 1440P, dan wel op 110 hz (QNIX). Maar toch leuk met battefield 4. Far Cry 4 kennen de beestjes in crossfire alles op ultra niet hoger dan 70fps ;(Verwijderd schreef op maandag 23 februari 2015 @ 19:37:

[...]

Ik heb nu 1 [URL="http://tweakers.net/pricewatch/362247/sapphire-r9-290-4gb-gddr5-oc-tri-x.html"]

Het is wel waard om een 1440P 144hz vol te benutten.

Verwijderd

Ik ben toch bang dat ergens in 2016 de eerste 4K 120hz monitoren uitkomen (Displayport 1.3)BastiaanNL schreef op maandag 23 februari 2015 @ 20:04:

[...]

Ik game ook op 1440P, dan wel op 110 hz (QNIX). Maar toch leuk met battefield 4. Far Cry 4 kennen de beestjes in crossfire alles op ultra niet hoger dan 70fps ;(Haha

Daarvoor zal je weer nieuwe videokaarten moeten hebben (De 300-serie heeft hoogstwaarschijnlijk geen 1.3 versie)

Wel leuk om eens San Andreas en dergelijke te herspelen in 4K 120hz

http://www.thinkcomputers...coming-radeon-300-series/

Other rumors have suggested that Fiji will get the full 4096 stream processors, that is about 45 percent more than Hawaii. AMD is expected to launch Fiji and the Radeon R300 in the second quarter of this year, most likely in connection with Computex which takes place June 1-6.

Ik weet niet hoe het met die website gesteld is qua geruchten, maar 1-6 juni duurt mij veel te lang

Other rumors have suggested that Fiji will get the full 4096 stream processors, that is about 45 percent more than Hawaii. AMD is expected to launch Fiji and the Radeon R300 in the second quarter of this year, most likely in connection with Computex which takes place June 1-6.

Ik weet niet hoe het met die website gesteld is qua geruchten, maar 1-6 juni duurt mij veel te lang

Ik hoop dat er ook laptop GPUs mee komen in combinatie met Carrizo.

We horen al sinds vorig jaar allerlei geruchten over allerlei claims over allerlei quarters. Als je met hagel schiet, zal je wel iets raken, zeker ?

Verwijderd

In tijd voor Batman: Arkham Knight maar later dan Witcher 3BastiaanNL schreef op dinsdag 24 februari 2015 @ 15:50:

http://www.thinkcomputers...coming-radeon-300-series/

Other rumors have suggested that Fiji will get the full 4096 stream processors, that is about 45 percent more than Hawaii. AMD is expected to launch Fiji and the Radeon R300 in the second quarter of this year, most likely in connection with Computex which takes place June 1-6.

Ik weet niet hoe het met die website gesteld is qua geruchten, maar 1-6 juni duurt mij veel te lang

Na release nog paar weken wachten op aftermarket-koelers. Hopelijk kunnen ze iets mooi maken met die waterkoeling

Ik wacht ook al lang op Broadwell K/Skylake K want ik wil geen 4790K nemen

[ Voor 4% gewijzigd door Verwijderd op 24-02-2015 18:42 ]

http://community.amd.com/...-and-the-future-of-mantle

Vooral deze regel is interessant:

Vooral deze regel is interessant:

The Mantle SDK also remains available to partners who register in this co-development and evaluation program. However, if you are a developer interested in Mantle "1.0" functionality, we suggest that you focus your attention on DirectX® 12 or GLnext.

Inderdaad, wat ik vond op Fudzilla: http://www.fudzilla.com/n...e-of-mantle-is-directx-12LongBowNL schreef op dinsdag 03 maart 2015 @ 08:46:

http://community.amd.com/...-and-the-future-of-mantle

Vooral deze regel is interessant:

[...]

Ik vind het persoonlijk een hele goede move, om niet allerlei eigen standaarden actief te houden en zelf te focussen op gedeelde (doch niet echt open) standaarden. Dit artikel laat verder zien dat Fuad ook pro-rood kan zijnMantle has apparently served its purpose as a bridge between DirectX 11 and DirectX 12 and AMD is starting to tell new developers to focus their attention on DirectX and GLnext.

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

Leuk artikel van Anandtech over GLNext:

http://www.anandtech.com/...ditional-details-released

http://forums.anandtech.c...p?p=37218419#post37218419

http://forums.anandtech.c...p?p=37218504&postcount=56

Slimme actie van AMD, door dit te doen hebben ze een voordeel in games met GLNext omdat ze veel meer kennis van de API hebben (omdat ze hem zelf hebben gemaakt voor een groot deel). Ik hoop ook dat dit betekent dat AMD drivers in Linux beter worden voor het spelen van games, videoplayback is in orde .

.

Oud artikel wat ik nog niet had gezien:

http://hothardware.com/Ne...rue-/#HmuGfem8M7zdPUSS.99

http://www.anandtech.com/...ditional-details-released

Wat mensen hebben de functies van Mantle en GLNext met elkaar vergeleken.The actual Vulkan API itself has yet to be finalized, however at this point in time Khronos expects it to behave very similar to Mantle and DX12, so developers capable of working on the others shouldn’t have much trouble with Vulkan. In fact Khronos has confirmed that AMD has contributed Mantle towards the development of Vulkan, and though we need to be clear that Vulkan is not Mantle, Mantle was used to bootstrap the process and speed its development, making Vulkan a derivation of sorts of Mantle (think Unix family tree). What has changed from Mantle is that Khronos has gone through a period of refinement, keeping what worked in Vulcan and throwing out portions of Mantle that didn’t work well – particularly HLSL and anything that would prevent the API from being cross-vendor – replacing it with the other necessary/better functionality.

http://forums.anandtech.c...p?p=37218419#post37218419

http://forums.anandtech.c...p?p=37218504&postcount=56

Slimme actie van AMD, door dit te doen hebben ze een voordeel in games met GLNext omdat ze veel meer kennis van de API hebben (omdat ze hem zelf hebben gemaakt voor een groot deel). Ik hoop ook dat dit betekent dat AMD drivers in Linux beter worden voor het spelen van games, videoplayback is in orde

Oud artikel wat ik nog niet had gezien:

http://hothardware.com/Ne...rue-/#HmuGfem8M7zdPUSS.99

[ Voor 17% gewijzigd door Sp3ci3s8472 op 03-03-2015 14:34 . Reden: blah blah blah :p ]

Verwijderd

Jammer, ik had toch graag gezien dat Mantle de concurrentie was aangegaan met DirectX. Maar goed, Mantle heeft inderdaad voor een close-to-metal evolutie gezorgd en vormt de basis van GLnext, dat was en is goed nieuws voor spelers.LongBowNL schreef op dinsdag 03 maart 2015 @ 08:46:

http://community.amd.com/...-and-the-future-of-mantle

Vooral deze regel is interessant:

[...]

Donderdag is er trouwens een talk op GDC over GLnext. Daarbij zullen naast mensen van de Khronos Group ook mensen van Epic, Unity en EA spreken. Daar zal vermoedelijk aangekondigt worden dat Unreal, Unity en Frostbite GLnext gaan ondersteunen. e.e.a. Is "Presented by Valve", dat zal dan wel betekenen dat GLnext een (grote?) rol gaat spelen in SteamOS. Het zou ook best kunnen dat GLnext voor de rendering van SteamVR zorgt in de Source 2 engine, maar dat is wel echt speculeren. Ik ben benieuwd.

Een vulkaan is (onder andere) toch een resultaat van activiteit in de mantel van de aarde. Alleen al qua naamgeving lijkt er een relatie te bestaan tussen de twee API's.

https://www.khronos.org/a...15_vulkan_v1_Overview.pdf

[EDIT2 voor hierboven]

En Source 2 is aangekondigd en gaat later dit jaar ook draaien op Vulkan.

https://steamdb.info/blog/source2-announcement/

LiquidVR SDK van AMD

http://www.engadget.com/2015/03/03/amd-liquid-vr/

Je speculatie heeft misschien wat onderbouwing als je kijkt naar de presentatie van Vulkan, kijk maar op pagina 8. Daar staat een plaatje van Dota 2 (Source Engine) draaiend in een Vulkan debugger.Verwijderd schreef op dinsdag 03 maart 2015 @ 15:32:

[...]

Het zou ook best kunnen dat GLnext voor de rendering van SteamVR zorgt in de Source 2 engine, maar dat is wel echt speculeren. Ik ben benieuwd.

https://www.khronos.org/a...15_vulkan_v1_Overview.pdf

[EDIT2 voor hierboven]

En Source 2 is aangekondigd en gaat later dit jaar ook draaien op Vulkan.

https://steamdb.info/blog/source2-announcement/

[EDIT]Also as part of supporting PC gaming, Valve announced that it will be releasing a Vulkan-compatible version of the Source 2 engine. Vulkan is a cross-platform, cross-vendor 3D graphics API that allows game developers to get the most out of the latest graphics hardware, and ensures hardware developers that there is a consistent, low overhead method of taking advantage of products. Vulkan, previously called Next Generation OpenGL, is administered by the Khronos Group, along with other standards such as OpenCL, OpenGL, and WebGL.

LiquidVR SDK van AMD

http://www.engadget.com/2015/03/03/amd-liquid-vr/

[ Voor 104% gewijzigd door LongBowNL op 04-03-2015 09:15 . Reden: Zo veel nieuws :O ]

AMD Officially Confirms New Radeon Flagship – R9 390X Ultra-Enthusiast Graphics Card In All Likelihood

http://wccftech.com/amd-reveals-radeon-r9-390x-gdc-wip/

Dit draadje ook wel interessant:

http://www.tomshardware.c...megathread-links-faq.html

http://wccftech.com/amd-reveals-radeon-r9-390x-gdc-wip/

Dit draadje ook wel interessant:

http://www.tomshardware.c...megathread-links-faq.html

https://twitter.com/amd_roy/status/573304652982190082

AMD's Next Radeon Flagship Spotted Powering Oculus Rift http://fw.to/0uIXbMl

AMD tegen ontwikkelaars: focus op nieuwe API's in plaats van Mantle

Wel leuk dat er schijnbaar mensen zijn die hier nog een negatieve draai aan weten te geven...[ Voor 20% gewijzigd door madmaxnl op 05-03-2015 13:48 ]

Ik vind het persoonlijk juist knap dat mensen hier nog een positieve draai aan weten te geven..madmaxnl schreef op donderdag 05 maart 2015 @ 13:48:AMD tegen ontwikkelaars: focus op nieuwe API's in plaats van Mantle

Wel leuk dat er schijnbaar mensen zijn die hier nog een negatieve draai aan weten te geven...

Mantle is in de markt gezet als de ''next big thing'' in het api landschap. Nu wordt het vrijwel volkomen aan de kant geschoven voor DX12 en Vulkan.

Ja, ik snap dat Mantle de hele low-level hype heeft aangewakkerd, en dat zijn zeker pluspunten voor AMD. Maar achteraf gezien, wat heeft AMD, een bedrijf dat al jaren moeite heeft om boven water te blijven, hier nu aan? De Mantle API was juist een reden om specifiek voor AMD GPU's te kiezen. Door Mantle aan de kant te schuiven zijn ze hun grootste selling point kwijt geraakt. Nvidia daarentegen heeft zaken als Physx, Shield, GameWorks en Geforce Experience. Je bent vrij om te beslissen hoe nuttig deze vendor specifieke zaken voor jou persoonlijk zijn, maar feit blijft dat Nvidia hierdoor wel extra producten verkoopt.

En ja, ik ben me ervan bewust dat AMD zaken als TressFX en True Audio heeft. Maar in hoeveel games worden deze tot op heden toegepast?

[ Voor 5% gewijzigd door ColinZ op 05-03-2015 15:27 ]

Nee inderdaad, vast blijven houden aan je eigen standaard, ongeacht wat, is veel beter. Vooral voor ons consumenten. Het wordt helemaal goed voor ons consumenten als AMD geld geeft aan developers om Mantle te gebruiken.

Voor de consument is het goed ja, maar het is de vraag of het voor amd de moeite waard is geweest.

Misschien wel, als dankzij dx12 hun cpu's weer interessant worden.

Misschien wel, als dankzij dx12 hun cpu's weer interessant worden.

Mechwarrior Online: Flapdrol

Vulkan (glNext) heeft schijnbaar een hoop overeenkomsten met Mantle. Daar heeft AMD dus profijt bij.

Dit:

Plus dit:haarbal schreef op donderdag 05 maart 2015 @ 16:00:

Misschien wel, als dankzij dx12 hun cpu's weer interessant worden.

Is wat AMD er aan heeft. Mantle is de basis van Vulkan, wat de turnaround time van Mantle -> Vulkan voor de developers die Mantle al gebruikten vrij kort maakt. Verder worden hun CPU's nu weer een stuk boeiender voor games; met name dan ook de APU's. Dus AMD heeft er genoeg uit gehaald, daarnaast is de naam Mantle nu ook bekend en gaan ze die naar eigen zeggen gewoon blijven gebruiken.LongBowNL schreef op donderdag 05 maart 2015 @ 16:42:

Vulkan (glNext) heeft schijnbaar een hoop overeenkomsten met Mantle. Daar heeft AMD dus profijt bij.

Ik ben dan ook van plan een laptop te kopen met een Carrizo APU (+eventueel een dedicated GPU). Ten minste, als de performance een beetje OK is. Scheelt hopelijk in de kosten t.o.v. Intel.

Ben ik het niet mee eens. Ik verwacht dat in de toekomst, als low-level API's meer ingeburgerd raken, en CPU's hun huidige trend qua snelheids bump per generatie voortzetten, game devs de CPU gewoon andere/zwaardere dingen laten doen (advanced physics bijvoorbeeld). Ik kan me niet voorstellen dat game devs de CPU's op 50% laten lopen alleen omdat de API's CPU overhead verminderen. Ze willen (hopelijk) de vrijgekomen CPU kracht gaan gebruiken.Werelds schreef op donderdag 05 maart 2015 @ 17:17:

Dit:

[...]

Plus dit:

[...]

Is wat AMD er aan heeft. Mantle is de basis van Vulkan, wat de turnaround time van Mantle -> Vulkan voor de developers die Mantle al gebruikten vrij kort maakt. Verder worden hun CPU's nu weer een stuk boeiender voor games; met name dan ook de APU's. Dus AMD heeft er genoeg uit gehaald, daarnaast is de naam Mantle nu ook bekend en gaan ze die naar eigen zeggen gewoon blijven gebruiken.

Daarom ben ik nog steeds van mening dat Mantle op de lange duur weinig voor AMD zal doen. Ze zullen het gat met Intel nooit meer gaan dichten. Blijkbaar hopen veel mensen op Jim Keller, maar de man is ook geen profeet, en gaat naar mijn mening weinig veranderen bij AMD.

Het lijkt erop dat AMD meer focus legt op de server markt. De uitwisselbaarheid van x86 en ARM processors is ideaal in die omgeving. Het zou me niet verbazen als AMD uit de consumenten markt gaat verdwijnen op CPU gebied. Gelukkig kan Intel tot nu toe nog niet heel goed meekomen op GPU gebied, maar met zo'n enorm R&D budget kan zoiets altijd veranderen.

[ Voor 0% gewijzigd door LongBowNL op 05-03-2015 19:27 . Reden: Woord vergeten ]

Ze zullen eerder meer drawcalls naar de GPU gaan sturen. We hebben nu al meer dan genoeg ruimte op CPU's voor dingen als physics. Het is niet zo zeer dat die overhead te veel cycles op vreet, maar meer dat de engine moet wachten tot D3D eindelijk eens klaar is voor de volgende instructie. Kijk nog maar eens naar de verschillende D3D12/Mantle (p)reviews of naar je eigen CPU in de gemiddelde game: onder D3D11 zie je vaak maar 2 cores echt onder druk staan, terwijl de andere cores maar amper half belast worden. Dat is de single-threaded aard met hoge overhead van D3D<12 (vergis je niet; D3D11 is beter voor meerdere cores, maar onderhuids zit nog steeds een single-threaded beest).ColinZ schreef op donderdag 05 maart 2015 @ 19:09:

Ben ik het niet mee eens. Ik verwacht dat in de toekomst, als low-level API's meer ingeburgerd raken, en CPU's hun huidige trend qua snelheids bump per generatie voortzetten, game devs de CPU gewoon andere/zwaardere dingen laten doen (advanced physics bijvoorbeeld). Ik kan me niet voorstellen dat game devs de CPU's op 50% laten lopen alleen omdat de API's CPU overhead verminderen. Ze willen (hopelijk) de vrijgekomen CPU kracht gaan gebruiken.

Wel zal het betekenen dat je op low-end CPU's (APU's

Overigens is juist physics iets waar we waarschijnlijk niets zullen zien veranderen. De dingen die heel zichtbaar zijn en relatief complexe berekeningen zijn (zo'n beetje alles in RF: Guerrilla) draaien al op de CPU met meer dan voldoende ruimte over. De andere dingen die Nvidia en AMD op de GPU draaien zul je niet naar de CPU zien komen omdat dat soort dingen bestaan uit honderden extreem simpele berekeningen. Daar kunnen we 10 keer de IPC op 16 cores voor krijgen in een CPU, een GPU zal er nog steeds veel beter mee uit de voeten kunnen.

Geluid en AI zouden allebei wel kunnen, maar daar heb ik een beetje een hard hoofd in. De meeste developers zijn daar gewoon te lui voor, omdat het de gemiddelde gamer simpelweg niet boeit. Die hebben liever een mooi plaatje. Er zijn maar een paar developers die ik er toe in staat zie om daar iets mee te doen. Valve qua AI, DICE qua geluid, maar voor de rest? De rest zijn allemaal extreem op graphics gericht.

Mja dat is een kwestie van afwachten. Ze hebben nu weer min of meer de teams die achter K7 en K8 zaten. Ik denk dat we allemaal wel een Athlon XP of 64 gehad hebbenDaarom ben ik nog steeds van mening dat Mantle op de lange duur weinig voor AMD zal doen. Ze zullen het gat met Intel nooit meer gaan dichten. Blijkbaar hopen veel mensen op Jim Keller, maar de man is ook geen profeet, en gaat naar mijn mening weinig veranderen bij AMD.

Het gerucht gaat in elk geval dat ze naar SMT (Intel's stijl) gaan in plaats van CMT (die geclusterde "modules" in hun CPU's). Dat is op zich al een hele grote koerswijziging.

Voor sommige spellen zal het ook niet enorm veel doen voor de fps vrees ik, in arma 3 is de simulatie van het gevecht de bottleneck. En bij een flink gevecht is dat gewoon zwaarder dan de dx thread, al zou het nog wel kunnen schelen qua input lag.

Mechwarrior Online: Flapdrol

De k7 was een goed product omdat het mee kon komen op prijs/kwaliteit. Echt beter was hij niet behalve games op lagere snelheden. Intel had wel een hogere snelheid en won bij de meeste andere benchmarks. Daarom was AMD bij veel gamers populair in die tijd. Hij was echter minder futureproof dan de pentium tegenhanger die die veel meer instructiesets aan boord had als is dit maar een detail. De k7 generatie maakte AMD groot bij het publiek. Athlon XP 2800+ op 3200+ clocks FTW!Werelds schreef op donderdag 05 maart 2015 @ 20:32:

[...]

Mja dat is een kwestie van afwachten. Ze hebben nu weer min of meer de teams die achter K7 en K8 zaten. Ik denk dat we allemaal wel een Athlon XP of 64 gehad hebben

Het gerucht gaat in elk geval dat ze naar SMT (Intel's stijl) gaan in plaats van CMT (die geclusterde "modules" in hun CPU's). Dat is op zich al een hele grote koerswijziging.

De k8 verraste Intel, omdat AMD opeens de 64bit instructieset had bepaald en Intel deze moest volgen ipv bepalen met de overgang van 32 naar 64 bit. Intel had daar nog geen zin in en had andere plannen en ingezet op hogere kloksnelheden tot 4 ghz en hoger op chips die daar ongeschikt voor waren. AMD heeft 2 jaar lang eigenlijk een leidende positie gehad en die het binnen no-time weer heeft verspeeld door zelf design foutjes te maken en te weinig te innoveren.

Toen intel echter weer orde op zaken had heeft het er alles aan gedaan om AMD pijn te doen en sinds de i3,i5,i7 introductie stelt AMD weinig meer voor op de CPU markt. AMD kan redelijk meekomen op prijs kwaliteit op de mid range desktop markt, maar high end en mobiel zijn ze totaal verslagen. Intel heeft een beter productieproces, veel meer R&D en bijna de hele markt in handen. Je kunt hopen, maar ARM fabrikanten zijn een grotere bedreiging geworden dan dat AMD ooit nog kan zijn voor Intel.

Verwijderd

Je bedoelt, afgezien van de illegale prijsafspraken van Intel die het een belachelijk hoog marktaandeel (en dus inkomsten) met een inferieur product bezorgde. AMD is daar later dankzij een rechtzaak wel financieel voor gecompenseerd, maar zonder die afspraken had AMD meer en Intel minder inkomsten gehad en had AMD veel meer geld in R&D kunnen steken en Intel veel minder. Intel had er dan veel langer over gedaan om terug te komen, wat AMD de kans had gegeven om uit te kunnen groeien tot een geduchte concurrent van Intel. Tegen de tijd dat die compensatie uit die rechtzaak binnen kwam was het daar al te laat voor, met de huidige situatie tot gevolg.sjekneck schreef op donderdag 05 maart 2015 @ 21:01:

[...]

De k8 verraste Intel, omdat AMD opeens de 64bit instructieset had bepaald en Intel deze moest volgen ipv bepalen met de overgang van 32 naar 64 bit. Intel had daar nog geen zin in en had andere plannen en ingezet op hogere kloksnelheden tot 4 ghz en hoger op chips die daar ongeschikt voor waren. AMD heeft 2 jaar lang eigenlijk een leidende positie gehad en die het binnen no-time weer heeft verspeeld door zelf design foutjes te maken en te weinig te innoveren.

[...]

Intel profiteert tot de dag van vandaag van die praktijken. Ondertussen hebben wij te maken met CPU generaties waarbij je al blij mag zijn met een 20% performance increase in twee jaar tijd, en mag je daar vervolgens de hoofprijs voor betalen.

[ Voor 8% gewijzigd door Verwijderd op 05-03-2015 23:44 ]

We gaan hier wellicht iets te veel off-topic, maar ik kan het niet latensjekneck schreef op donderdag 05 maart 2015 @ 21:01:

De k7 was een goed product omdat het mee kon komen op prijs/kwaliteit. Echt beter was hij niet behalve games op lagere snelheden. Intel had wel een hogere snelheid en won bij de meeste andere benchmarks. Daarom was AMD bij veel gamers populair in die tijd. Hij was echter minder futureproof dan de pentium tegenhanger die die veel meer instructiesets aan boord had als is dit maar een detail. De k7 generatie maakte AMD groot bij het publiek. Athlon XP 2800+ op 3200+ clocks FTW!

Ik denk dat jij de laatste Northwoods in je gedachten hebt. Willamette even daar gelaten (dat was geen P4 Intel, foei

Dat is ook wat ik altijd in het achterhoofd houd, of het nu om CPU's of GPU's gaat. Ze hebben allemaal onwijs slechte periodes gehad. Intel is ook uit een dal gekropen dat even diep was als het dal waar AMD (CPU) nu in zit, als het niet dieper was. Het enige goede dat ik zelf over Intel's ongein uit die tijd te melden heb is dat ze volgens mij onverwoestbaar zijn, aangezien mijn eigen EE 955 (Presler, Jan '06, van Intel gekregen toen) pas sinds afgelopen maand niet meer in gebruik is...omdat het bordje waar ik hem op had zitten ineens rook en stank produceerde. De CPU zelf is volgens mij nog steeds in orde. Aan de andere kant, mijn schoonzus heeft ook nog steeds mijn oude XP 2000+ in gebruik, met een gigantische koperen waaier er op

En datzelfde gaat voor de GPU's op. Kijk waar AMD/ATI in 2004-2006 zat, hoe ze daar in 2007-2008 op reageerden en in 2009 gewoon terug waren. Of naar Nvidia, waar we 5 jaar geleden nog dat misbaksel hadden en nu van Maxwell mogen genieten

Het is allemaal koffiedik kijken natuurlijk, wij weten niet wat er bij AMD speelt, maar doemdenken is ook onrealistisch. Daar draait AMD al te lang voor mee, ze hebben al genoeg dalen gehad en ze hebben toch elke keer weer terug kunnen slaan. Vanaf 0 beginnen kost nu eenmaal wat tijd.

Offtopic; Prescott was niet zo slecht, alleen het procede waarop het werd gebakken was te groot. Prescott op 65nm was zeer aantrekkelijk (Cedar Mill). En een AthlonXP 2000+ kon mijn Pentium 4 2,26GHz bijhouden in spellen.

Ontopic; AMD moet gauw de specs van de 300 serie vrijgeven, ik heb steeds minder hoop dat die serie een opvolger voor mijn HD7750 zal bevatten (minder dan 75Watt, meer dan 512 unified shaders).

Ontopic; AMD moet gauw de specs van de 300 serie vrijgeven, ik heb steeds minder hoop dat die serie een opvolger voor mijn HD7750 zal bevatten (minder dan 75Watt, meer dan 512 unified shaders).

Graphene; a material that can do everything, except leave the lab. - Asianometry

Verwijderd

Alleen de 390 en de 390X zijn nieuwe kaarten, rest is rebrand. Misschien is een 2de hands R9 280X/290 iets voor jou?NitroX infinity schreef op vrijdag 06 maart 2015 @ 01:00:

Offtopic; Prescott was niet zo slecht, alleen het procede waarop het werd gebakken was te groot. Prescott op 65nm was zeer aantrekkelijk (Cedar Mill). En een AthlonXP 2000+ kon mijn Pentium 4 2,26GHz bijhouden in spellen.

Ontopic; AMD moet gauw de specs van de 300 serie vrijgeven, ik heb steeds minder hoop dat die serie een opvolger voor mijn HD7750 zal bevatten (minder dan 75Watt, meer dan 512 unified shaders).

Anders is een pricewatch: EVGA GeForce GTX 960 Superclocked ook een nice zuinig,compact kaartje en hij heeft H.265 decoding dat is erg vet voor de toekomst!

[ Voor 16% gewijzigd door Verwijderd op 06-03-2015 01:10 ]

Verwijderd

Belangen. DirectX12 is natuurlijk alleen beschikbaar op de nog te releasen Windows 10.

Als Mantle DirectX12 overbodig zou maken zou er een grote groep zijn die niet zou overstappen op langere temijn naar Windows 10. En microsoft zit er niet voor jou of mij, maar voor het maken van keiharde knaken jaar in jaar uit. DirectX is een belangrijk middel voor MS. Zorg dat grote developers op je nieuwste API ontwikkelen gaan en iedereen moet op ten duur voor de nieuwe features op zijn kaart mee.

Mantle is een geniaal concept, met het juiste doel ontwikkeld. Het vrijmaken van resources voor betere performance. In tegenstelling tot microsoft en directx zijn zij sinds DX10 en hoger gewoon lui geweest.

Nope, beide suggesties verbruiken meer dan 75Watt, dat is niet de bedoeling. Maar goed, ik heb al zo'n beetje geaccepteerd dat ik op minimaal 14nm moet wachten voor een nieuwe kaart die aan m'n wensen voldoet.Verwijderd schreef op vrijdag 06 maart 2015 @ 01:04:

[...]

Alleen de 390 en de 390X zijn nieuwe kaarten, rest is rebrand. Misschien is een 2de hands R9 280X/290 iets voor jou?

Anders is een pricewatch: EVGA GeForce GTX 960 Superclocked ook een nice zuinig,compact kaartje en hij heeft H.265 decoding dat is erg vet voor de toekomst!

Graphene; a material that can do everything, except leave the lab. - Asianometry

Ik had gelezen dat de R9 360 (of moet dat dan R7 zijn zoals de 260?) ook een nieuwe chip is. Misschien dat deze zuinig genoeg is.

Ik heb eigenlijk nog nooit een CPU gezien die kapot ging. CPU's waar extreme voltages op los gelaten zijn daargelaten.Werelds schreef op vrijdag 06 maart 2015 @ 00:32:

[...]

Het enige goede dat ik zelf over Intel's ongein uit die tijd te melden heb is dat ze volgens mij onverwoestbaar zijn, aangezien mijn eigen EE 955 (Presler, Jan '06, van Intel gekregen toen) pas sinds afgelopen maand niet meer in gebruik is...omdat het bordje waar ik hem op had zitten ineens rook en stank produceerde. De CPU zelf is volgens mij nog steeds in orde. Aan de andere kant, mijn schoonzus heeft ook nog steeds mijn oude XP 2000+ in gebruik, met een gigantische koperen waaier er op

Verwijderd

Zelfs ik als muzikant wil liever power dan stilte. De build in de video haalt 14Db @ idle en 24Db @ full load. Dat is praktisch onhoorbaar en jou wenslijst zou eens meer geluid kunnen opleveren dan dat.NitroX infinity schreef op vrijdag 06 maart 2015 @ 23:50:

[...]

Heb je in m'n inventaris of 'passief' wenslijstje gekeken? Dat wenslijstje is slechts een opzetje om bij te houden wat er momenteel is. En nee, ik wil compleet passief.

Maar we gaat offtopic hier

Maarja we gaan hier inderdaad compleet offtopic.

Om toch iets ontopic te zeggen:

Hoop dat de 390X stiller is dan mijn R9 290 straaljager

Ach, als ze serieus met een waterkoeler komen, moet dat toch wel? En dat ding is vooral leuk voor de benchmarks, kijk eens in DAA en CAA hoeveel mensen nog steeds geen R9 290 willen "want die worden wel 100 graden en maken een takke herrie", puur omdat die mensen op day one reviews met reference coolers afgaan. Natuurlijk kun je die nog kopen, maar geen enkel mens koopt nu nog een reference kaart, tenzij ze hem voor weinig uit de V&A halen en er een andere koeler opvrotten.

En bakkers als Sapphire, MSI, GB, HIS, whatever, die zetten er wel weer een van hun koelers op, waardoor je geen waterkoeling meer hebt. Slim truukje.

En bakkers als Sapphire, MSI, GB, HIS, whatever, die zetten er wel weer een van hun koelers op, waardoor je geen waterkoeling meer hebt. Slim truukje.

People as things, that’s where it starts.

Verwijderd

Waarom is iedereen tegen waterkoeling? Als daarmee 390X op 50-60 graden komt en onhoorbaar is (ik snap nog steeds niet waarom er een grote fan op komt) is het een win=win.VasZaitsev schreef op zaterdag 07 maart 2015 @ 00:06:

Ach, als ze serieus met een waterkoeler komen, moet dat toch wel? En dat ding is vooral leuk voor de benchmarks, kijk eens in DAA en CAA hoeveel mensen nog steeds geen R9 290 willen "want die worden wel 100 graden en maken een takke herrie", puur omdat die mensen op day one reviews met reference coolers afgaan. Natuurlijk kun je die nog kopen, maar geen enkel mens koopt nu nog een reference kaart, tenzij ze hem voor weinig uit de V&A halen en er een andere koeler opvrotten.

En bakkers als Sapphire, MSI, GB, HIS, whatever, die zetten er wel weer een van hun koelers op, waardoor je geen waterkoeling meer hebt. Slim truukje.

Van mij mag hij kleiner, een 1x slot zou helemaal geweldig zijn

Zoals de pricewatch: Asus Republic Of Gamers ARES III 8GB die btw behoorlijk goed geprijsd is nu.

Die grote fan is bij waterkoeling aan te raden om je VRM's en VRAM koel te houden, natuurlijk kan een fullcover ook, maar je moet ergens je pomp kwijt, en het is een stuk duurder dan alleen een GPU-block.

Vroeger werden zelfs high-end kaarten nog passief uitgevoerd, met desnoods een paar lullige stukjes alu of koper, zou leuk als die tijd terugkomt

Vroeger werden zelfs high-end kaarten nog passief uitgevoerd, met desnoods een paar lullige stukjes alu of koper, zou leuk als die tijd terugkomt

People as things, that’s where it starts.

Deels mee eens.

Hij zegt dat hij de term fanboy niet leuk vindt, maar een n00b vindt de term n00b ook niet leuk

Misschien zijn de nummers die hij heeft wel fout?Or the numbers they list conflict with mine...

Uhm, benchmarks die ik lees tonen toch duidelijk dat een i5 en i7 stukken beter presteren dan wat AMD in de schappen heeft (FX-8000 & FX-9000).When it comes to gaming and streaming, the performance differences between AMD, Intel, and Nvidia are negligible in my opinion.

Onzin, i3 en FX-6300 zijn ongeveer gelijk geprijsd en presteren ook ongeveer gelijk. In de meeste gevallen presteerd de i3 beter. De i5 is duurder dan een FX-8000 serie processor, maar presteerd ook een stuk beter en een Pentium houdt een 860K bij.The main reason I still choose AMD over Intel is price vs performance...

Hij zegt dat hij de term fanboy niet leuk vindt, maar een n00b vindt de term n00b ook niet leuk

Graphene; a material that can do everything, except leave the lab. - Asianometry

Verwijderd

Inderdaad mooi artikel.LongBowNL schreef op zaterdag 07 maart 2015 @ 21:22:

http://www.hardblogtech.com/p/why-amd.html

Hier kan ik het wel mee eens zijn, lekker nuchter.

Wat je bij GPU's zit is dat Nvidia/AMD elkaar altijd omwisselen.

700 serie vs 200 serie = AMD wint door prijs/performance van R9 290

900 serie vs 200 serie = Nvidia wint door HDMI 2.0/G-sync/Lage vebruik/Goedkope 970 (al is het 3.5GB)

900 serie vs 300 serie = AMD wint door HBM, 4096 cores en aio waterkoeling en Freesync

Pascal serie vs 300 serie = Nvidia wint weer door 20nm

enz enz enz

Bij CPU's is het anders, ik heb nog nooit een AMD cpu gehad en dat gaat het ook niet worden omdat ik naast gamen ook andere dingen doe. Mijn volgende cpu wordt eentje met 6 of 8 cores

Meestal zit AMD eerder dan Nvidia op een nieuwe process node.Verwijderd schreef op zaterdag 07 maart 2015 @ 22:33:

[...]

Inderdaad mooi artikel.

Wat je bij GPU's zit is dat Nvidia/AMD elkaar altijd omwisselen.

700 serie vs 200 serie = AMD wint door prijs/performance van R9 290

900 serie vs 200 serie = Nvidia wint door HDMI 2.0/G-sync/Lage vebruik/Goedkope 970 (al is het 3.5GB)

900 serie vs 300 serie = AMD wint door HBM, 4096 cores en aio waterkoeling en Freesync

Pascal serie vs 300 serie = Nvidia wint weer door 20nm

enz enz enz

Bij CPU's is het anders, ik heb nog nooit een AMD cpu gehad en dat gaat het ook niet worden omdat ik naast gamen ook andere dingen doe. Mijn volgende cpu wordt eentje met 6 of 8 cores

http://techsoda.com/no-20nm-graphics-amd-nvidia/

Nvidia gaat voor 16nm bij TSMC terwijl AMD voor Globalfoundries,Samsung 14 nm gaat. TSMC heeft vertraging opgelopen met 16nm, terwijl Samsung al cpu's op 14nm produceert.

Als mensen overtuigd moeten worden om bij AMD te blijven of naar AMD te gaan met wazige fanboy blogs, dan bevestigt dat alleen dat AMD niet goed (genoeg) bezig is.

Op het CPU gebied is dat zeer duidelijk, op het GPU gebied is dat discutabel: de R9-series kaarten zijn niet slecht maar verbruiken wel veel stroom in vergelijking. De reference coolers waren een duidelijke foute keuze. Maar aan de andere kant heeft AMD ons ook Mantle (en onrechtstreeks DX12 en Vulkan) bezorgd. Hun drivers in 2014 waren problematisch, het hielp niet dat mensen ook nog eens last hadden van de problemen veroorzaakt door ULPS en Elpida geheugen. Maar hun 2015 drivers (de Omega) lijkt dan weer heel wat beter gemiddeld.

AMD moet hard knokken om boven water te blijven maar het is duidelijk dat ze dat ook doen. Dat vind ik veel respectabeler dan een merk dat elke week met nieuwe vendor-lockin technieken afkomt.

Op het CPU gebied is dat zeer duidelijk, op het GPU gebied is dat discutabel: de R9-series kaarten zijn niet slecht maar verbruiken wel veel stroom in vergelijking. De reference coolers waren een duidelijke foute keuze. Maar aan de andere kant heeft AMD ons ook Mantle (en onrechtstreeks DX12 en Vulkan) bezorgd. Hun drivers in 2014 waren problematisch, het hielp niet dat mensen ook nog eens last hadden van de problemen veroorzaakt door ULPS en Elpida geheugen. Maar hun 2015 drivers (de Omega) lijkt dan weer heel wat beter gemiddeld.

AMD moet hard knokken om boven water te blijven maar het is duidelijk dat ze dat ook doen. Dat vind ik veel respectabeler dan een merk dat elke week met nieuwe vendor-lockin technieken afkomt.

Op CPU gebied overdrijft die blogger misschien wel een beetje. Het ging mij vooral om het GPU gedeelte.

Vergeet alleen niet dat CPU-streaming software veel CPU power vreet, en dan is een FX-8320 opeens een stuk interessanter dan een i5, idem dito met een FX-6300 vs een i3.NitroX infinity schreef op zaterdag 07 maart 2015 @ 22:33:

Deels mee eens.

[...]

Misschien zijn de nummers die hij heeft wel fout?

[...]

Uhm, benchmarks die ik lees tonen toch duidelijk dat een i5 en i7 stukken beter presteren dan wat AMD in de schappen heeft (FX-8000 & FX-9000).

[...]

Onzin, i3 en FX-6300 zijn ongeveer gelijk geprijsd en presteren ook ongeveer gelijk. In de meeste gevallen presteerd de i3 beter. De i5 is duurder dan een FX-8000 serie processor, maar presteerd ook een stuk beter en een Pentium houdt een 860K bij.

Hij zegt dat hij de term fanboy niet leuk vindt, maar een n00b vindt de term n00b ook niet leuk

Verschil bij normaal gaming is wat groter, al ligt het ook heel erg aan de game/benchmarks die je toepast. In jouw blog zag ik bijv. een hele stapel single/dualcore benchmarks, tja, dat is kut voor AMD, maar pak je programma's en games die heel mooi schalen, dan is AMD vaak weer in het voordeel. En vergeet niet dat er de nodige synthetische benchmarks zijn die bijna direct voor Intel geschreven zijn, zoals SuperPi.

Qua GPU's ben ik van mening dat nVidia in zowel de 700 serie als wat wij nu zien in de 900 serie achterloopt. Niet veel sneller, wel zuiniger, maar veel duurder in ieder budget. De enige reden waarom je Nvidia neemt is als verbruik belangrijk, je CUDA nodig hebt, je geilt op PhysX of gewoon een fanboy bent. Anders heeft AMD naar mijn mening de betere deal, en dat wordt alleen maar erger in de 300 series.

Ook vind ik AMD een veel fijner bedrijf qua gebrek aan omkoping en vendor-lock-in dan haar concurrenten, maar dat is al helemaal offtopic

People as things, that’s where it starts.

R9 290 is overduidelijk een betere deal dan de 970 nu, maar ja, grotere chip, complexere pcb, etc, ik zou niet zeggen dat nvidia achterloopt, ze hebben gewoon geen reden om een prijzenoorlog te gaan voeren.

Mechwarrior Online: Flapdrol

Ho stop! GTX 970 behoor je zowel qua prestatieniveau als prijs te vergelijken met een R9 290X, niet een non-x.

Graphene; a material that can do everything, except leave the lab. - Asianometry

Wellicht maar Nvidia heeft op het prijs niveau van de 280x en 290 (non-x) gewoon niets te bieden. Zowel de GTX770 en de GTX960 zijn te duur voor wat ze bieden. Voor de GTX770 is het nog te begrijpen omdat deze waarschijnlijk EOL is.NitroX infinity schreef op zondag 08 maart 2015 @ 15:23:

Ho stop! GTX 970 behoor je zowel qua prestatieniveau als prijs te vergelijken met een R9 290X, niet een non-x.

De GTX970 is niet zo gigantisch veel sneller dan een 290 dat het 70 euro extra goed praat.

Snap ook vaak de driver problemen niet, die heb ik nooit

[ Voor 15% gewijzigd door Sp3ci3s8472 op 08-03-2015 17:39 ]

Verwijderd

De 970 heeft HDMI 2.0/G-sync is kleiner, zuiniger en koeler.Sp3ci3s8472 schreef op zondag 08 maart 2015 @ 17:37:

[...]

Wellicht maar Nvidia heeft op het prijs niveau van de 280x en 290 (non-x) gewoon niets te bieden. Zowel de GTX770 en de GTX960 zijn te duur voor wat ze bieden. Voor de GTX770 is het nog te begrijpen omdat deze waarschijnlijk EOL is.

De GTX970 is niet zo gigantisch veel sneller dan een 290 dat het 70 euro extra goed praat.

Snap ook vaak de driver problemen niet, die heb ik nooit. Het ligt vaak aan andere dingen (zoals het niet goed verwijderen van de oude driver, met name als je van de oude driver naar Omega overschakelt).

Ik had waarschijnlijk de pricewatch: EVGA GeForce GTX 970 4GB FTW ACX 2.0 of de pricewatch: Gigabyte GV-N970G1 GAMING-4GD gehaald als ik langer had gewacht

[ Voor 19% gewijzigd door Verwijderd op 08-03-2015 18:16 ]

Maar G-sync is overpriced vendor lock-in rommel welke zodra FreeSync op de markt is eigenlijk al achterhaald is, en ik zie Nvidia er voor aan om niet direct FreeSync te ondersteunen, dan ben je blij.

HDMI 2.0 is nou niet echt geweldig, DP is imo de betere standaard, en zit momenteel op ongeveer ieder 4k scherm.

Koeler is totaal onbelangrijk, het zegt alleen wat over de koeler.

Zuiniger is leuk als je echt een argument zoekt waarom de GTX970 beter is. Hij is zoveel duurder, daar kun je heel lang het extra verbruik van betalen.

Kleiner is ook iets wat grotendeels aan de aftermarket merken ligt. Als je grondig gaat knutselen aan een R9 290 krijg je die ook behoorlijk compact, en kijken naar hoe goed de Gelid Icy koelt, hoef je nieteens een zo gek groot koelblok te gebruiken.

Wat Sp3c zegt klopt ook gewoon, en ik trek het graag verder Tenzij je de meest hoge singlegpu prestatie nodig hebt, of CUDA, heeft Nvidia in ieder budget niks te zeggen. Prijs/prestatie van ze vond ik in de 700 serie al matig, in de 900 slaat hij nergens meer op. Kijk bijvoorbeeld naar de GTX960: wat moet je nou met zo'n kaart?

AMD heeft naar mijn mening de boel gewoon erg goed voor elkaar sinds eigenlijk de HD5000 serie, Keer op keer gewoon erg goed spul voor een goede prijs, en sinds de HD7950 en HD7970 ook veel meer futureproof dan nVidia in dezelfde prijsklasse. En het lijkt erop dat de 300 serie alleen maar verder uitloopt.

HDMI 2.0 is nou niet echt geweldig, DP is imo de betere standaard, en zit momenteel op ongeveer ieder 4k scherm.

Koeler is totaal onbelangrijk, het zegt alleen wat over de koeler.

Zuiniger is leuk als je echt een argument zoekt waarom de GTX970 beter is. Hij is zoveel duurder, daar kun je heel lang het extra verbruik van betalen.

Kleiner is ook iets wat grotendeels aan de aftermarket merken ligt. Als je grondig gaat knutselen aan een R9 290 krijg je die ook behoorlijk compact, en kijken naar hoe goed de Gelid Icy koelt, hoef je nieteens een zo gek groot koelblok te gebruiken.

Wat Sp3c zegt klopt ook gewoon, en ik trek het graag verder Tenzij je de meest hoge singlegpu prestatie nodig hebt, of CUDA, heeft Nvidia in ieder budget niks te zeggen. Prijs/prestatie van ze vond ik in de 700 serie al matig, in de 900 slaat hij nergens meer op. Kijk bijvoorbeeld naar de GTX960: wat moet je nou met zo'n kaart?

AMD heeft naar mijn mening de boel gewoon erg goed voor elkaar sinds eigenlijk de HD5000 serie, Keer op keer gewoon erg goed spul voor een goede prijs, en sinds de HD7950 en HD7970 ook veel meer futureproof dan nVidia in dezelfde prijsklasse. En het lijkt erop dat de 300 serie alleen maar verder uitloopt.

People as things, that’s where it starts.

Zolang er geen directe vergelijking is tussen G-sync en FreeSync (waardeloze naam imo), of zelfs geen fatsoenlijke FreeSync review, is G-sync veruit superieur. We weten immers niet eens hoe FreeSync zich in de praktijk verhoud tov G-sync.VasZaitsev schreef op zondag 08 maart 2015 @ 18:44:

Maar G-sync is overpriced vendor lock-in rommel welke zodra FreeSync op de markt is eigenlijk al achterhaald is, en ik zie Nvidia er voor aan om niet direct FreeSync te ondersteunen, dan ben je blij.

In het geval van de stock koeler zegt het wel wat over het totaal plaatje van het product. Het overgrote gedeelte van de klanten zal voor een aftermarket koeler gaan, maar de stock oplossing is het referentie product, en zal dus vaak als eerste gereviewd worden. Eerste impressies zijn erg belangrijk. De de 290 en 290X worden nog steeds gezien als luidruchtig en heethoofden. Terwijl aftermarket coolers dat probleem al lang verholpen hebben.VasZaitsev schreef op zondag 08 maart 2015 @ 18:44:

Koeler is totaal onbelangrijk, het zegt alleen wat over de koeler.

Het zegt ook iets over technische superioriteit. Dat de GTX970 deze prestaties neer weet te zetten en ook nog zuiniger is, is voor een bepaalde doelgroep gewoon heel belangrijk.VasZaitsev schreef op zondag 08 maart 2015 @ 18:44:

Zuiniger is leuk als je echt een argument zoekt waarom de GTX970 beter is. Hij is zoveel duurder, daar kun je heel lang het extra verbruik van betalen.

Puur kijkend naar het verschil in verkopen tussen Nvidia's 900 serie en AMD's 200 serie, en het daarop volgende verschil in marketshare, denk ik dat de rest van de markt het oneens is met je. Het is Nvidia die steeds verder uitloopt.VasZaitsev schreef op zondag 08 maart 2015 @ 18:44:

AMD heeft naar mijn mening de boel gewoon erg goed voor elkaar sinds eigenlijk de HD5000 serie, Keer op keer gewoon erg goed spul voor een goede prijs, en sinds de HD7950 en HD7970 ook veel meer futureproof dan nVidia in dezelfde prijsklasse. En het lijkt erop dat de 300 serie alleen maar verder uitloopt.

[ Voor 63% gewijzigd door ColinZ op 08-03-2015 19:30 ]

Natuurlijk, FreeSync is een waardeloze naam en G-sync is veel beterColinZ schreef op zondag 08 maart 2015 @ 19:19:

[...]

Zolang er geen directe vergelijking is tussen G-sync en FreeSync (waardeloze naam imo), of zelfs geen fatsoenlijke FreeSync review, is G-sync veruit superieur. We weten immers niet eens hoe FreeSync zich in de praktijk verhoud tov G-sync.

[...]

In het geval van de stock koeler zegt het wel wat over het totaal plaatje van het product. Het overgrote gedeelte van de klanten zal voor een aftermarket koeler gaan, maar de stock oplossing is het referentie product, en zal dus vaak als eerste gereviewd worden. Eerste impressies zijn erg belangrijk. De de 290 en 290X worden nog steeds gezien als luidruchtig en heethoofden. Terwijl aftermarket coolers dat probleem al lang verholpen hebben.

[...]

Het zegt ook iets over technische superioriteit. Dat de GTX970 deze prestaties neer weet te zetten en ook nog zuiniger is, is voor een bepaalde doelgroep gewoon heel belangrijk.

[...]

Puur kijkend naar het verschil in verkopen tussen Nvidia's 900 serie en AMD's 200 serie, en het daarop volgende verschil in marketshare, denk ik dat de rest van de markt het oneens is met je. Het is Nvidia die steeds verder uitloopt.

"In het geval van de stock koeler zegt het wel wat over het totaal plaatje van het product."

Want hoe warm een kaart word door zijn stock koeler bepaald hoe goed of slecht een product is...

"Het zegt ook iets over technische superioriteit. Dat de GTX970 deze prestaties neer weet te zetten en ook nog zuiniger is, is voor een bepaalde doelgroep gewoon heel belangrijk."

Hahahaha, jazeker, technische superioriteit... Man, man, man... 3,5GB VRAM anyone?

"Puur kijkend naar het verschil in verkopen tussen Nvidia's 900 serie en AMD's 200 serie, en het daarop volgende verschil in marketshare, denk ik dat de rest van de markt het oneens is met je. Het is Nvidia die steeds verder uitloopt."

De rest van de markt is een markt waar nVidia zo ongeveer standaard word gekozen in elke OEM PC, zelfde met Intel, raar dat nVidia en Intel mensen meer zegt dan een AMD als het in 8/10 producten zit verwerkt. Dit terwijl AMD net zo capabele producten maakt tegen vaak een lagere prijs, dit riekt naar onzuivere koffie...

Buiten dat, wil je soms dat AMD op de fles gaat? Met je tenenkrommende argumenten lijkt dat in ieder geval wel zo te zijn, als er geen concurrentie is is er geen push en is er geen innovatie enz. enz.

9800X3D - RX 6900XT - Volvo S40 T5 '10 - Kever '74

Zeker dat stuk over de markt zegt inderdaad weinig, kijk eens op 9gag, wat een pracht doorsnee is van de westerse wereld qua jongeren, en het is daar Nvidia voor en na.

Ook lijken er meer nvidia fanboys te zijn dan AMD, maar dat kan ook komen omdat ik een AMD fan ben en daarom dingen wat vertekend zie.

Sowieso klopt het argument "de markt weet het beter" van geen kant.. Kijk eens hoeveel Samsung verdient aan hun TV's en telefoons, maar zijn het de beste? echt niet.

Ook lijken er meer nvidia fanboys te zijn dan AMD, maar dat kan ook komen omdat ik een AMD fan ben en daarom dingen wat vertekend zie.

Sowieso klopt het argument "de markt weet het beter" van geen kant.. Kijk eens hoeveel Samsung verdient aan hun TV's en telefoons, maar zijn het de beste? echt niet.

People as things, that’s where it starts.

Onzuivere koffie is een ''argument'' wat vaker wordt gebruikt in dit soort discussies. AMD werd genaaid door Intel jaren terug en daarom is Intel heer en meester in de CPU wereld. AMD's Bulldozer arch of hun incapabele management heeft er natuurlijk helemaal niets mee te maken. Dat wil niet zeggen dat er geen kern van waarheid in zit, en ik ben het zeker met je eens dat Nvidia niet bekend staat om hun fair play. Maar niet alle ellende bij AMD is het gevolg van Intel of Nvidia.kuusj98 schreef op zondag 08 maart 2015 @ 19:42:

De rest van de markt is een markt waar nVidia zo ongeveer standaard word gekozen in elke OEM PC, zelfde met Intel, raar dat nVidia en Intel mensen meer zegt dan een AMD als het in 8/10 producten zit verwerkt. Dit terwijl AMD net zo capabele producten maakt tegen vaak een lagere prijs, dit riekt naar onzuivere koffie...

Maar kijkend naar de financiële resultaten van beide bedrijven, is Nvidia's manier van bedrijfsvoering vele male effectiever. Is dat eerlijk? Nee, zeker niet. Maar blijkbaar is dat hoe de wereld in elkaar steekt.

Tuurlijk wil ik niet dat AMD op de fles gaat. Dat zou desastreus voor de consument. Ik wel enkel aangeven dat AMD niet alleen maar het slachtoffer is in dit verhaal.kuusj98 schreef op zondag 08 maart 2015 @ 19:42:

Buiten dat, wil je soms dat AMD op de fles gaat? Met je tenenkrommende argumenten lijkt dat in ieder geval wel zo te zijn, als er geen concurrentie is is er geen push en is er geen innovatie enz. enz.

Welkom in de wondere wereld van de marketing.VasZaitsev schreef op zondag 08 maart 2015 @ 19:48:

Sowieso klopt het argument "de markt weet het beter" van geen kant.. Kijk eens hoeveel Samsung verdient aan hun TV's en telefoons, maar zijn het de beste? echt niet.

[ Voor 9% gewijzigd door ColinZ op 08-03-2015 20:10 ]

Verwijderd

We weten dat je AMD fan-boy bent, ik kijk gewoon naar elke generatie. Ben zwaar geirriteerd dat mijn R9 290 maar HDMI 1.4 heeft en er bestaat ook nog geen converter. Ik haal maar 30hz @ 3840x2160 op mijn tv erdoor.VasZaitsev schreef op zondag 08 maart 2015 @ 18:44:

Maar G-sync is overpriced vendor lock-in rommel welke zodra FreeSync op de markt is eigenlijk al achterhaald is, en ik zie Nvidia er voor aan om niet direct FreeSync te ondersteunen, dan ben je blij.

HDMI 2.0 is nou niet echt geweldig, DP is imo de betere standaard, en zit momenteel op ongeveer ieder 4k scherm.

Koeler is totaal onbelangrijk, het zegt alleen wat over de koeler.

Zuiniger is leuk als je echt een argument zoekt waarom de GTX970 beter is. Hij is zoveel duurder, daar kun je heel lang het extra verbruik van betalen.

Kleiner is ook iets wat grotendeels aan de aftermarket merken ligt. Als je grondig gaat knutselen aan een R9 290 krijg je die ook behoorlijk compact, en kijken naar hoe goed de Gelid Icy koelt, hoef je nieteens een zo gek groot koelblok te gebruiken.

Wat Sp3c zegt klopt ook gewoon, en ik trek het graag verder Tenzij je de meest hoge singlegpu prestatie nodig hebt, of CUDA, heeft Nvidia in ieder budget niks te zeggen. Prijs/prestatie van ze vond ik in de 700 serie al matig, in de 900 slaat hij nergens meer op. Kijk bijvoorbeeld naar de GTX960: wat moet je nou met zo'n kaart?

AMD heeft naar mijn mening de boel gewoon erg goed voor elkaar sinds eigenlijk de HD5000 serie, Keer op keer gewoon erg goed spul voor een goede prijs, en sinds de HD7950 en HD7970 ook veel meer futureproof dan nVidia in dezelfde prijsklasse. En het lijkt erop dat de 300 serie alleen maar verder uitloopt.

Nu ik me eerste echte baan heb, kan ik als het waard is, elke generatie een nieuwe kaart kopen. Denk dat de overstap van R9 290 naar 390X het wel waard zal zijn

Als Nvidia dan weer in 2016 met Pascal komt en die heeft leuke features (Displayport 1.4a anyone?) verkoop ik me 390X en zet er 200-300€ erbij en koop ik de GTX 1080 enz.

[ Voor 4% gewijzigd door Verwijderd op 08-03-2015 21:23 ]

Verwijderd

Een luide GPU kan je prima zelf oplossen door iets meer caseflow door je kast te jagen. Er zijn mensen die een kast met een enkele PSU-fan plus casefan gebruiken, verder niks. Een beetje airflow maak je met teminste 3x 120mm outtake en 3x 120mm intake fans.

Wat betreft AMD; eigenlijk al vanaf de 486 waren ze net zo goed al dan niet beter dan Intel. Het zat 'm vaak in het prijsverschil. Echter omdat de naam Intel pentium en consort beter in de oor lag bij mensen werd AMD vaak opzij gelegd. AMD heeft zeker goede CPU's uitgezet, vanaf de K6(-2) al. Het was niet AMD maar chipsetmakers die voor merendeelse problemen zorgde in combinatie met Windows 98 bijv (Via, Ali anyone?). Vanaf de K7 is het echt concurrentie geworden, de K8 was als ik me niet vergis de A64 die gehakt van Intel maakte.

De chipsets zoals Nforce van Nvidia in die tijd waren ontzettend goed, brachten bliss performance en knalde met bijv een Opteron of A64. Nadat AMD zelf hun eigen chipsets begon te bakken was het feestje voor Nvidia een beetje een beetje over. AMD heeft tot op heden prima en zeer competitieve chipsets uitgebracht die ook op high end moederborden (Zoals Asus Crosshair IV) werden gezet.

Aangezien AM3 EOL geraakt is en het nu alleen nog FM2 biedt blijf ik wachten totdat ik een betere keuze kan maken. Draai op 4GHz met een R7 270 in crossfire. SNEL zat. En 23 uur van de dag eet m'n PC uit z'n neus, zovaak game ik nu. Ik gebruik m'n pc eerder voor multimedia en dergelijk, en dat gaat prima af op een X6 op 4GHz. Geen reden nog om op de trein van upgraden te stappen.

Geen reden nog om op de trein van upgraden te stappen.

Overigens zijn in vele benchmarks, een set R270's vaak sneller dan een enkele 290x. Alleen het stroomverbruik wijkt iets af (50W meer in totaal) dan met een single kaart.

Wat betreft AMD; eigenlijk al vanaf de 486 waren ze net zo goed al dan niet beter dan Intel. Het zat 'm vaak in het prijsverschil. Echter omdat de naam Intel pentium en consort beter in de oor lag bij mensen werd AMD vaak opzij gelegd. AMD heeft zeker goede CPU's uitgezet, vanaf de K6(-2) al. Het was niet AMD maar chipsetmakers die voor merendeelse problemen zorgde in combinatie met Windows 98 bijv (Via, Ali anyone?). Vanaf de K7 is het echt concurrentie geworden, de K8 was als ik me niet vergis de A64 die gehakt van Intel maakte.

De chipsets zoals Nforce van Nvidia in die tijd waren ontzettend goed, brachten bliss performance en knalde met bijv een Opteron of A64. Nadat AMD zelf hun eigen chipsets begon te bakken was het feestje voor Nvidia een beetje een beetje over. AMD heeft tot op heden prima en zeer competitieve chipsets uitgebracht die ook op high end moederborden (Zoals Asus Crosshair IV) werden gezet.

Aangezien AM3 EOL geraakt is en het nu alleen nog FM2 biedt blijf ik wachten totdat ik een betere keuze kan maken. Draai op 4GHz met een R7 270 in crossfire. SNEL zat. En 23 uur van de dag eet m'n PC uit z'n neus, zovaak game ik nu. Ik gebruik m'n pc eerder voor multimedia en dergelijk, en dat gaat prima af op een X6 op 4GHz.

Overigens zijn in vele benchmarks, een set R270's vaak sneller dan een enkele 290x. Alleen het stroomverbruik wijkt iets af (50W meer in totaal) dan met een single kaart.

[ Voor 5% gewijzigd door Verwijderd op 08-03-2015 23:09 ]

En display port is niet mogelijk?Verwijderd schreef op zondag 08 maart 2015 @ 21:17:

We weten dat je AMD fan-boy bent, ik kijk gewoon naar elke generatie. Ben zwaar geirriteerd dat mijn R9 290 maar HDMI 1.4 heeft en er bestaat ook nog geen converter. Ik haal maar 30hz @ 3840x2160 op mijn tv erdoor.

Her zou mee niet verbazen als zijn TV geen Display Port heeft. (Ik heb persoonlijk nog nooit een Display Port op een monitor in het wild gezien. :-O)

Ik heb een pesthekel aan DisplayPort, dat mogen ze van mij echt deze minuut afschaffen. Wat een ellende, ik heb per-see een DP kabel nodig voor mijn derde scherm, als men niet zo moeilijk had gedaan en gewoon HDMI had aangehouden was ik geen 40 euro voor een convertor kwijt.LongBowNL schreef op zondag 08 maart 2015 @ 22:06:

Her zou mee niet verbazen als zijn TV geen Display Port heeft. (Ik heb persoonlijk nog nooit een Display Port op een monitor in het wild gezien. :-O)

Dat sluit dus aan op jou punt, ik zie nog vaker monitoren met VGA dan met DP...

9800X3D - RX 6900XT - Volvo S40 T5 '10 - Kever '74

Kwam ook omdat DP niet veel meerwaarde had ten opzichte van DVI of HDMI, maar nu men graag 60hz, of meer, 4k, of meer, wilt kijken, is HDMI/DVI opeens iets te karig. Ik denk dat DP wel populairder gaat worden, iig hoop ik het, want die stekkertjes zijn veel kleiner dan die achterlijk grote HDMI stekkers.

Maar een 4k TV zonder DP is imo wel armoede, maar dat zie/zag je wel bij die nieuwe, goedkope dingen.

Overigens vraag ik mij af of de HDMI 2.0 standaard überhaubt wel bestond toen de eerste R9 290 gebakken werd, het antwoord: ja, nog geen 2 maanden. Zo heel raar vind ik het dan niet dat het niet op de R9 290 zit, want die kaart is ontworpen voordat HDMI 2.0 uitgegeven werd.

Overigens is technisch gezien DP veel interessanter, DP 1.2, uit 2009, heeft 3x de bandbreedte van HDMI 2.0. Het zou interessanter zijn als HDMI zou verdwijnen in dat opzicht

Maar een 4k TV zonder DP is imo wel armoede, maar dat zie/zag je wel bij die nieuwe, goedkope dingen.

Overigens vraag ik mij af of de HDMI 2.0 standaard überhaubt wel bestond toen de eerste R9 290 gebakken werd, het antwoord: ja, nog geen 2 maanden. Zo heel raar vind ik het dan niet dat het niet op de R9 290 zit, want die kaart is ontworpen voordat HDMI 2.0 uitgegeven werd.

Overigens is technisch gezien DP veel interessanter, DP 1.2, uit 2009, heeft 3x de bandbreedte van HDMI 2.0. Het zou interessanter zijn als HDMI zou verdwijnen in dat opzicht

People as things, that’s where it starts.

Uhm, VGA/DVI/HDMI zijn voor elke aansluiting een kloksignaal nodig, ofzoiets ongeveer. Bij displayport hoeft dat niet. Dus dat jij een dp-kabel nodig hebt voor dat derde scherm is niet de schuld van displayport maar van HDMI dat nog gewoon op oude technologie gebaseerd is (digitaal+audio+drm).kuusj98 schreef op zondag 08 maart 2015 @ 22:17:

[...]

Ik heb een pesthekel aan DisplayPort, dat mogen ze van mij echt deze minuut afschaffen. Wat een ellende, ik heb per-see een DP kabel nodig voor mijn derde scherm, als men niet zo moeilijk had gedaan en gewoon HDMI had aangehouden was ik geen 40 euro voor een convertor kwijt.

Dat sluit dus aan op jou punt, ik zie nog vaker monitoren met VGA dan met DP...

Graphene; a material that can do everything, except leave the lab. - Asianometry

Wat dacht je van 3 clocksignalen inbouwen?NitroX infinity schreef op zondag 08 maart 2015 @ 23:15:

[...]

Uhm, VGA/DVI/HDMI zijn voor elke aansluiting een kloksignaal nodig, ofzoiets ongeveer. Bij displayport hoeft dat niet. Dus dat jij een dp-kabel nodig hebt voor dat derde scherm is niet de schuld van displayport maar van HDMI dat nog gewoon op oude technologie gebaseerd is (digitaal+audio+drm).

Wow, zal wel space-age technologie zijn...

Men weet wel 6,2 miljard transistors op 550 vierkante millimeter te proppen maar 3 HDMI signalen is toch nog een beetje te moeilijk. Nee sorry maar dat maak je me niet wijs, het zal eerder een soort van forceren zijn naar de DP toe, omdat men anders al helemaal geen marktaandeel kan behalen.

Ik zie wel in dat DP voordelen heeft t.o.v. HDMI maar die hebben bijna allemaal te maken met 4K @60Hz, iets wat misschien 0,000001% van alle consumenten in bezit heeft. Het lijkt me dat het aantal mensen met 3 screens toch al relatief hoger zal uitvallen.

9800X3D - RX 6900XT - Volvo S40 T5 '10 - Kever '74

Blijkbaar kost het wel wat extra om die extra clocksignalen te maken. Want Nvidia (sli hack even niet meegerekentkuusj98 schreef op zondag 08 maart 2015 @ 23:26:

[...]

Wat dacht je van 3 clocksignalen inbouwen?

Wow, zal wel space-age technologie zijn...

Men weet wel 6,2 miljard transistors op 550 vierkante millimeter te proppen maar 3 HDMI signalen is toch nog een beetje te moeilijk. Nee sorry maar dat maak je me niet wijs, het zal eerder een soort van forceren zijn naar de DP toe, omdat men anders al helemaal geen marktaandeel kan behalen.

Ik zie wel in dat DP voordelen heeft t.o.v. HDMI maar die hebben bijna allemaal te maken met 4K @60Hz, iets wat misschien 0,000001% van alle consumenten in bezit heeft. Het lijkt me dat het aantal mensen met 3 screens toch al relatief hoger zal uitvallen.

HDMI is gewoon een klote standaard die achter de feiten aanloopt (lage bandbreedte, geen adaptive sync enzovoort), ik heb mijn versterker via HDMI aangesloten en heb in het begin vaak problemen gehad met content protection shit die via HDMI loopt. Handshake gaat niet goed enzovoort.

Met displayport heb ik persoonlijk nog nooit problemen gehad, ik hoop dat het langzamerhand HDMI de markt uitdrukt of in ieder dat het op elk apparaat komt.

Natuurlijk, maar er zijn ook een boel hypokrieten die toen de GTX480 uitkwam, allemaal die kaart kochten ondanks dat hij in zijn eentje meer dan 300 watt trok (meer dan de 290(x)). Toen hoorde je niemand over de zuinigheid. Nu Nvidia eindelijk eens een keer een zuinige kaart heeft worden ze de hemel in geprezenColinZ schreef op zondag 08 maart 2015 @ 19:19:

[...]

Het zegt ook iets over technische superioriteit. Dat de GTX970 deze prestaties neer weet te zetten en ook nog zuiniger is, is voor een bepaalde doelgroep gewoon heel belangrijk.

Slim marketen, ik heb zelf het idee dat een bepaalt soort groep Nvidia videokaarten koopt. Tweakers even daarbuiten gelaten, die groep weet vaak weinig van computers af en koopt het "snelste" of hetgene wat iedereen roept. Vaak zijn dit de mensen die ook graag over hun setup opscheppen, dit kan om verschilllende redenen "e-peen" of ze willen op een of andere manier validatie krijgen van hun aankoop.VasZaitsev schreef op zondag 08 maart 2015 @ 19:48:

Zeker dat stuk over de markt zegt inderdaad weinig, kijk eens op 9gag, wat een pracht doorsnee is van de westerse wereld qua jongeren, en het is daar Nvidia voor en na.

Nvidia heeft daar slim op ingespeelt met hun "The way its meant to be played" catch phrase, mensen kunnen zich daarmee indentificeren. Op een of andere manier denken ze dat ze op die manier bij de elite horen.

Dit zie je in elke sector terug, Apple, Bose, Ferari, BMW, Beats, AlienWare enzovoort.

offtopic:

Ik had psychologie moeten studeren...

Ik had psychologie moeten studeren...

Niks tegen mensen die na zichzelf goed te informeren een Nvidia kaart kopen

[ Voor 24% gewijzigd door Sp3ci3s8472 op 09-03-2015 00:29 ]

Verwijderd

0,000001% ?kuusj98 schreef op zondag 08 maart 2015 @ 23:26:

[...]

Wat dacht je van 3 clocksignalen inbouwen?

Wow, zal wel space-age technologie zijn...

Men weet wel 6,2 miljard transistors op 550 vierkante millimeter te proppen maar 3 HDMI signalen is toch nog een beetje te moeilijk. Nee sorry maar dat maak je me niet wijs, het zal eerder een soort van forceren zijn naar de DP toe, omdat men anders al helemaal geen marktaandeel kan behalen.

Ik zie wel in dat DP voordelen heeft t.o.v. HDMI maar die hebben bijna allemaal te maken met 4K @60Hz, iets wat misschien 0,000001% van alle consumenten in bezit heeft. Het lijkt me dat het aantal mensen met 3 screens toch al relatief hoger zal uitvallen.

Wat moet je dan anders kopen?

Ik zie nu veel mensen een 1440p 60hz monitor kopen *facepalm* zoals de pricewatch: Dell U2515H Zwart

Terwijl je voor 100€ meer een IPS UHD hebt van dezelfde merk;

pricewatch: Dell P2415Q Zwart

Zijn ze te lui om 1 minuut verder te zoeken of wat?

Mensen zeggen altijd dat de videokaart de belangrijkste is in een pc, wel guess what;

MONITOR > ALLES

Al die mensen die de power van hun 290X/970 verspillen aan 1080P 60hz (ik ook maar ik wacht al maanden op Freesync

[ Voor 10% gewijzigd door Verwijderd op 09-03-2015 00:34 ]

Tja daar kan AMD niets aan doen, HDMI 2.0 kwam pas in dezelfde maand als Hawaï uit. Dat is te laat om nog toe te voegen, want ze moeten dat ook allemaal testen, certificeren en zo voortVerwijderd schreef op zondag 08 maart 2015 @ 21:17:

We weten dat je AMD fan-boy bent, ik kijk gewoon naar elke generatie. Ben zwaar geirriteerd dat mijn R9 290 maar HDMI 1.4 heeft en er bestaat ook nog geen converter. Ik haal maar 30hz @ 3840x2160 op mijn tv erdoor.

Ze zeggen het hierboven al, maar je hebt geen idee hoe veel ruimte de hardware voor een TMDS (die klok) in neemt. En dan moet je je ook bedenken dat DVI-DL en HDMI 1.3+ allebei een grotere TMDS nodig hebben (om met 3D om te kunnen gaan). Heb je wel eens een die shot bekeken? Zo'n beetje 50% van een GPU heeft niks met rekenwerk te maken. Er gaat makkelijk 15-20% verloren aan alleen al de memory controllers, de display controllers kosten ook al snel 10% aan oppervlak en TMDS is daar een relatief groot deel van. Het zijn lompe dingen die simpelweg duur zijn.kuusj98 schreef op zondag 08 maart 2015 @ 23:26:

[...]

Wat dacht je van 3 clocksignalen inbouwen?

Wow, zal wel space-age technologie zijn...

Men weet wel 6,2 miljard transistors op 550 vierkante millimeter te proppen maar 3 HDMI signalen is toch nog een beetje te moeilijk. Nee sorry maar dat maak je me niet wijs, het zal eerder een soort van forceren zijn naar de DP toe, omdat men anders al helemaal geen marktaandeel kan behalen.

Ik zie wel in dat DP voordelen heeft t.o.v. HDMI maar die hebben bijna allemaal te maken met 4K @60Hz, iets wat misschien 0,000001% van alle consumenten in bezit heeft. Het lijkt me dat het aantal mensen met 3 screens toch al relatief hoger zal uitvallen.

En nee, DisplayPort heeft nog veel meer voordelen dan alleen 4K60. Via DP kun je tal van andere signalen sturen (vandaar ook dat Thunderbolt via een mini-DP aansluiting loopt), niet alleen beeld. Juist door het feit dat er geen TMDS vereist is, zat DP in 2009 al op de bandbreedte waar HDMI 2.0 nu net pas aan komt. En het mooiste van alles? Jij kunt gewoon een passieve converter kopen om een DP signaal om te zetten in HDMI, omdat je gewoon een HDMI signaal over een DP verbinding kunt sturen. En behalve het feit dat DP goedkoper is om te implementeren, is het ook goedkoper om te verkopen. De royalties zijn veel lager en er is geen jaarlijks "abonnement" van $10000 zoals bij HDMI. Het is dan ook de HDMI groep waar een hoop rotzooi omtrent DRM vandaan komt.

Nee, wat mij betreft mag juist HDMI een stille dood sterven. VESA heeft met DP op alle vlakken een superieure standaard ontwikkeld.

Groot nieuws: AMD gaat grafische technologie licenties verschaffen aan Mediatek http://www.fudzilla.com/n...k-to-license-amd-graphics

Een bijzondere reintroductie van AMD in de mobiele grafische wereld. Een goede stap voorwaarts voor Mediatek, wiens GPUs vaak afhankelijk zijn van oudere ontwerpen van PowerVR of ARM. Dit is een goede manier om te concurreren met Qualcomm en Samsung! Ik ben enthousiast.

In het CPU gedeelte zit Mediatek al vaak op de eerste rij, ze hielden zelfs een maand het record voor consumer-koopbare chipset in AnTuTu score met hun MT6595 (dat stokje is ondertussen nipt over genomen door Snapdragon 810).

Een bijzondere reintroductie van AMD in de mobiele grafische wereld. Een goede stap voorwaarts voor Mediatek, wiens GPUs vaak afhankelijk zijn van oudere ontwerpen van PowerVR of ARM. Dit is een goede manier om te concurreren met Qualcomm en Samsung! Ik ben enthousiast.

In het CPU gedeelte zit Mediatek al vaak op de eerste rij, ze hielden zelfs een maand het record voor consumer-koopbare chipset in AnTuTu score met hun MT6595 (dat stokje is ondertussen nipt over genomen door Snapdragon 810).

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

Ik ben deze nog niet tegengekomen hierzo: http://www.kitguru.net/co...eries-lineup-at-computex/

Geruchten gaan dat het toch geen rebrands worden, maar toch nieuwe chips. Te verwachten tijdens Computex (Juni 2015).

[EDIT]

En FreeSync drivers op 19 maart

http://forums.overclocker...?p=27729788&postcount=249

[EDIT2]

Current Intel GPUs can't run graphics and compute simultaneously in DX12.

https://twitter.com/scottwasson/status/573640283427987456

Geruchten gaan dat het toch geen rebrands worden, maar toch nieuwe chips. Te verwachten tijdens Computex (Juni 2015).

[EDIT]

En FreeSync drivers op 19 maart

http://forums.overclocker...?p=27729788&postcount=249

[EDIT2]

Current Intel GPUs can't run graphics and compute simultaneously in DX12.

https://twitter.com/scottwasson/status/573640283427987456

[ Voor 69% gewijzigd door LongBowNL op 09-03-2015 14:36 . Reden: Freesync toegevoegd ]

Verwijderd

LongBowNL schreef op maandag 09 maart 2015 @ 12:34:

Ik ben deze nog niet tegengekomen hierzo: http://www.kitguru.net/co...eries-lineup-at-computex/

Geruchten gaan dat het toch geen rebrands worden, maar toch nieuwe chips. Te verwachten tijdens Computex (Juni 2015).

[EDIT]

En FreeSync drivers op 19 maart

http://forums.overclocker...?p=27729788&postcount=249

[EDIT2]

Current Intel GPUs can't run graphics and compute simultaneously in DX12.

https://twitter.com/scottwasson/status/573640283427987456

U w0t Amd, go home your drunk.We’re pleased to announce that a compatible AMD Catalyst™ graphics driver to enable AMD FreeSync™ technology for single-GPU configurations will be publicly available on AMD.com starting March 19, 2015.

Komt iets later...Support for AMD CrossFire™ configurations will be available the following month in April, 2015.

Dit topic heeft wel zijn laagste niveau ooit bereikt lijkt het...

DisplayPort is een geschiktere oplossing voor PC-doeleinden dan HDMI, dat mag wel duidelijk zijn doordat FreeSync én G-Sync beide via DisplayPort moeten gaan. HDMI is bedoeld als een link voor in de woonkamer, omdat het gebruiksvriendelijk werkt. 4K60 op HDMI 2.0 is leuk om te roepen maar de toestellen die daarmee uitgerust zijn, vallen juist vaak terug op 4:2:0 subsampling op die setting. Dan kan je net zo goed 1080@60Hz draaien met 4:4:4, dan gaat er tenminste geen resolutie in helderheid en kleurinformatie verloren.

DisplayPort is een geschiktere oplossing voor PC-doeleinden dan HDMI, dat mag wel duidelijk zijn doordat FreeSync én G-Sync beide via DisplayPort moeten gaan. HDMI is bedoeld als een link voor in de woonkamer, omdat het gebruiksvriendelijk werkt. 4K60 op HDMI 2.0 is leuk om te roepen maar de toestellen die daarmee uitgerust zijn, vallen juist vaak terug op 4:2:0 subsampling op die setting. Dan kan je net zo goed 1080@60Hz draaien met 4:4:4, dan gaat er tenminste geen resolutie in helderheid en kleurinformatie verloren.

Verwijderd

http://www.guru3d.com/new...nt-performance-boost.html

"Geen woord Mantle". Zo fucking jammer. Biased Nvidia fanboys...

Het is ook belangen... MS staat op het punt Windows 10 te lanceren. Het zou geen nut hebben al zou Mantle in Windows 7 bijvoorbeeld de gehele rol van DX12 overnemen.

"Geen woord Mantle". Zo fucking jammer. Biased Nvidia fanboys...

Het is ook belangen... MS staat op het punt Windows 10 te lanceren. Het zou geen nut hebben al zou Mantle in Windows 7 bijvoorbeeld de gehele rol van DX12 overnemen.

Verwijderd

Heb van mensen gehoord met een 970/980 dat ze wel 4:4:4 kunnen halen via HDMI 2.0.Phuncz schreef op maandag 09 maart 2015 @ 18:04: