Zoals ik al aangaf, als het dan toch beschikbaar komt, dan is het nog onlogisch.Verwijderd schreef op dinsdag 25 februari 2020 @ 15:06:

Ben benieuwd hoe deze kaart raytracing ondersteund.

[...]

https://twitter.com/HansDeVriesNL/status/1231838005792530435

Verwijderd

Snap ik, stap zou wel ineens heel groot worden terwijl ik nog redelijk game op mijn kaart met maar effectief 3,5gb gramVerwijderd schreef op dinsdag 25 februari 2020 @ 17:56:

[...]

Zoals ik al aangaf, als het dan toch beschikbaar komt, dan is het nog onlogisch.Ergens rond de helft van de genoemde geheugenbandbreedte is een logisch aantal voor een gaming exemplaar met zulke specs.

Maargoed wie weet vergt de raytracing implementatie van AMD wel veel geheugen ?

Met die specs? reken maar € 1500,- dan kan het waarschijnlijk niet heel erg tegenvallenDaniëlWW2 schreef op maandag 24 februari 2020 @ 19:27:

[...]

Dit zou het moeten zijn. Een 40CU Navi 10 is al sneller dan een RX Vega 64. Een 80CU Navi met ruim viermaal de geheugenbandbreedte zou 2x van een Navi 10 moeten kunnen doen, ook met lagere clock speeds. Geheugenbrandbreedte schaalt niet lineair maar exponentieel, maar 2TB/s+ zou dat moeten oplossen. De prijs, tja reken maar op €1000. Dan kan het waarschijnlijk eerder meevallen dan tegenvallen.

Maar goed, als die dan fatsoenlijk de opkomende LG 38GN950 kan aansturen...... dan ben ik daarna weer een tijdje arm

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Inderdaad voorspelbaar dat ze bij RTG door zouden krijgen dat mindshare helpt, net als de 64 core Threadripper die niemand nodig heeft.

Maar als het Assassin's Creed Odyssey runt op een strakke 4k60 wordt het een gevalletje:

Maar als het Assassin's Creed Odyssey runt op een strakke 4k60 wordt het een gevalletje:

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Geef daar dan ook even een linkje naar.Verwijderd schreef op woensdag 26 februari 2020 @ 10:42:

Bericht is inmiddels ontkracht door SK hynix

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

WDDM 2.7 zag ik voorbij komen. Opvallende feature is daarbij Hardware-accelerated GPU scheduling. Met de krachtige Graphics Command Processor van GCN (en icm ACEs?) klinkt dit als iets heel tofs, ben erg benieuwd wat het in de praktijk kan betekenen.

Hardware-accelerated GPU scheduling: It allows the video card to directly manage its video memory[49], which in turn significantly improves the performance of the minimum and average FPS, and thereby reducing latency. It works regardless of the API used for games and applications such as DirectX/Vulkan/OpenGL.

Wikipedia: Windows Display Driver Model

Hardware-accelerated GPU scheduling: It allows the video card to directly manage its video memory[49], which in turn significantly improves the performance of the minimum and average FPS, and thereby reducing latency. It works regardless of the API used for games and applications such as DirectX/Vulkan/OpenGL.

Wikipedia: Windows Display Driver Model

En in Q4/2019 heeft AMD maar liefst 22,6% meer geleverd dan in Q3 waar Nvidia 1,9% verloor. Meer mensen hebben nu een AMD GPU dan een Nvidia. Uiteraard tellen APU's hier ook mee, maar toch.

https://www.jonpeddie.com/store/market-watch-quarterly1

En een deep dive in Navi. Alles van dat het is geproduceerd op N7P (performance node), bedrading, waar de winsten zijn behaald etc.

https://fuse.wikichip.org...nd-the-rdna-architecture/

edit:

https://www.jonpeddie.com/store/market-watch-quarterly1

En een deep dive in Navi. Alles van dat het is geproduceerd op N7P (performance node), bedrading, waar de winsten zijn behaald etc.

https://fuse.wikichip.org...nd-the-rdna-architecture/

edit:

[ Voor 11% gewijzigd door DaniëlWW2 op 29-02-2020 17:29 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Vanavond 22:00 tot Vrijdag 03:00 onze tijd is het financial analyst day voor AMD. Het idee waart rond dat ze dan meer bekend maken over RDNA 2.

Ik hoop morgenochtend nieuws te zien.

Ik hoop morgenochtend nieuws te zien.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

@Blaat Haha Ja…Ik had het een paar weken geleden al in mijn agenda gezet, en zat gisteren al te kijken wanneer het begon, maar zat er dus een dagje naast  , ik ben benieuwd…..

, ik ben benieuwd…..

Ik ben allang voorbereid op nog meer teleurstelling en wachten.Blaat schreef op donderdag 5 maart 2020 @ 09:19:

Vanavond 22:00 tot Vrijdag 03:00 onze tijd is het financial analyst day voor AMD. Het idee waart rond dat ze dan meer bekend maken over RDNA 2.

Ik hoop morgenochtend nieuws te zien.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Korter dan een jaar na Navi 1 verwacht ik niet, dus voor je het weet is het september - december.

Je kunt iets prijsgeven over de architectuur zonder dat dat betekent dat er binnenkort een videokaart te koop is gebaseerd op die architectuur.Olaf van der Spek schreef op donderdag 5 maart 2020 @ 19:22:

Korter dan een jaar na Navi 1 verwacht ik niet, dus voor je het weet is het september - december.

Das mooi, dan kunnen we lagere prijzen van Nvidia verwachten i.c.m. een nieuwe architectuur en procede. Belooft een mooi jaar te wordenDaniëlWW2 schreef op donderdag 27 februari 2020 @ 20:08:

En in Q4/2019 heeft AMD maar liefst 22,6% meer geleverd dan in Q3 waar Nvidia 1,9% verloor. Meer mensen hebben nu een AMD GPU dan een Nvidia.

Dat is dus precies het probleem waardoor AMD tijden geen gpus verkocht. Mensen kopen dan lekker Nvidia want die moet in de prijs omlaag. Zelfs in de tijd van de HD5870 en Nvidia met Fermi bleven ze Nvidia kopen.

Ik hoop dat AMD net zoals ze dat met de andere Navi kaarten hebben gedaan dat ze ze gewoon voor een goede prijs verkopen en er goed winst op kunnen maken, dus gewoon dicht tegen de prijs van de Nvidia kaarten aan.

Ik heb momenteel een GTX1080. De voorlaatste Nvidia kaart was een TNT2 Ultra. Alles daartussen was Radeon/AMD. Ik bouw elke 36 maanden een nieuw systeem dus reken maar uit hoeveel Radeon kaarten dat dan zijn. Ik ben na de R9 serie overgestapt eigenlijk puur omdat ik het beu was dat er de laatste generaties altijd wel kleine dingetjes aan de hand waren.Sp3ci3s8472 schreef op donderdag 5 maart 2020 @ 23:34:

Dat is dus precies het probleem waardoor AMD tijden geen gpus verkocht. Mensen kopen dan lekker Nvidia want die moet in de prijs omlaag. Zelfs in de tijd van de HD5870 en Nvidia met Fermi bleven ze Nvidia kopen.

Ik hoop dat AMD net zoals ze dat met de andere Navi kaarten hebben gedaan dat ze ze gewoon voor een goede prijs verkopen en er goed winst op kunnen maken, dus gewoon dicht tegen de prijs van de Nvidia kaarten aan.

Vind ik dat Nvidia te duur is in verhouding? Hun hogere segment zeker wel. AMD heeft een betere prijs/performance. Maar goed, voor mij is er meer dan dat om een type of merk te kopen. Voor mij speelt geld ook minder een rol. Sowieso ben ik niet merktrouw. Ik besef dat er concurrentie moet zijn om de markt scherp te houden, maar welke bedrijven dat dan zijn kan mij weinig boeien. Een bedrijf heeft ook niet het beste met mij voor, enkel met hun winstoogmerk. Ik koop wat voor mij het beste is, niet omdat ik bedrijf <insert kleur> lief vind.

Dus ja, voor mij en eigenlijk iedereen die geen specifieke fanboy is, is het belangrijk dat AMD een goed product neerzet. Zodat er concurrentie is, de prijs meer in verhouding staat, en bovenal, dat er dus keuze is voor jou als consument om te kiezen wat het beste is.

Juist voor fanboys is het belangrijk, anders wordt hun favoriete merk duurder en duurder..JeroenNietDoen schreef op vrijdag 6 maart 2020 @ 07:04:

Dus ja, voor mij en eigenlijk iedereen die geen specifieke fanboy is, is het belangrijk dat AMD een goed product neerzet.

Het grote nieuws staat nu op de homepage in plaats van in dit topic: nieuws: AMD brengt eind dit jaar RDNA 2-videokaarten voor 4k-gaming uit

Het is wel te verwachten dat met RDNA2 AMD nu eerst voor de grote snelle kaarten gaat, omdat ze daarin nu nog niet mee kunnen komen met nVidia. Ikzelf vind, zoals bekend, vooral interessant hoeveel performance je uit 75W kunt persen, maar met de beloofde 50% betere performance per watt gaat AMD nu dus eerst voor de high-end.

Ikzelf laat mijn oog toch vallen op de verguisde 5500 XT om mijn RX460 te vervangen met het vakantiegeld van 2020, alternatief wordt wachten tot ver in 2021 voor mid-end Navi 2X.

Het is wel te verwachten dat met RDNA2 AMD nu eerst voor de grote snelle kaarten gaat, omdat ze daarin nu nog niet mee kunnen komen met nVidia. Ikzelf vind, zoals bekend, vooral interessant hoeveel performance je uit 75W kunt persen, maar met de beloofde 50% betere performance per watt gaat AMD nu dus eerst voor de high-end.

Ikzelf laat mijn oog toch vallen op de verguisde 5500 XT om mijn RX460 te vervangen met het vakantiegeld van 2020, alternatief wordt wachten tot ver in 2021 voor mid-end Navi 2X.

Maar helaas wachten tot het einde van het jaar. Het zat eraan te komen, maar toch. Het helpt ook niet dat Sony en Microsoft waarschijnlijk grotere aanspraak op 7nm capaciteit zullen maken waardoor er minder overblijft voor Radeon. Beiden zullen om miljoenen chips vragen en van de XBOX Series X weten we al dat het circa 400mm2 is. Krijg je ook iets dat de RTX2080S makkelijk de baas zou moeten zijn. Ook waarschijnlijk nog eens ruim minder dan 200W voor zoiets. Immers hebben consoles in de regel geen uitgebreide koelcapaciteit nog PSU. Twee barrières voor hoog verbruik. Een dergelijk presterende chip in een console lijkt me dan ook acceptabel.

Maar de echte winst gaat denk ik in de high end zitten. AMD die op een financial analyst day komt vertellen dat ze 50% perf/watt brengt, nou dat gaat gebeuren. Het hele punt voor AMD van dit soort dagen zijn deze aankondigingen, en die ook altijd leveren. Ga er maar vanuit dat AMD voor 225W een GPU kan leveren die de RTX2080Ti gaat matchen, zo niet verslaan. Dat zal waarschijnlijk dan niet eens de grootste chip zijn.

/i/2003439096.jpeg?f=imagegallery)

/i/2003439100.jpeg?f=imagegallery)

Maar de echte winst gaat denk ik in de high end zitten. AMD die op een financial analyst day komt vertellen dat ze 50% perf/watt brengt, nou dat gaat gebeuren. Het hele punt voor AMD van dit soort dagen zijn deze aankondigingen, en die ook altijd leveren. Ga er maar vanuit dat AMD voor 225W een GPU kan leveren die de RTX2080Ti gaat matchen, zo niet verslaan. Dat zal waarschijnlijk dan niet eens de grootste chip zijn.

/i/2003439096.jpeg?f=imagegallery)

/i/2003439100.jpeg?f=imagegallery)

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Dat mag ik hopen jaDaniëlWW2 schreef op vrijdag 6 maart 2020 @ 11:04:

Maar de echte winst gaat denk ik in de high end zitten. AMD die op een financial analyst day komt vertellen dat je 50% perf/watt brengt, nou dat gaat gebeuren. Het hele punt voor AMD van dit soort dagen zijn deze aankondigingen, en die ook altijd leveren. Ga er maar vanuit dat AMD voor 225W een GPU kan leveren die de RTX2080Ti gaat matchen, zo niet verslaan.

Uh ja, die schatting van mij was aan de hand van een 1200mv draaiende RX5700XT. Dat is dus bewust worse case scenario waar geen rekening gehouden is met bijvoorbeeld:Sissors schreef op vrijdag 6 maart 2020 @ 11:37:

[...]

Dat mag ik hopen ja. Gezien RTX2080TI een TDP van 250W heeft, is het nou niet een extreem indrukwekkende prestatie wanneer AMD 2-2.5 jaar later op een veel moderner proces een vergelijkbare rekenkracht voor 225W kan neerzetten. En natuurlijk dan kunnen we het nog hebben over board TDP vs puur GPU TDP, maar overall mag ik wel hopen dat AMD dat kan qua perf/watt.

-Betere clockspeed/voltage optimalisatie omdat het gewenste prestatieniveau makkelijker te behalen is.

-Potentieel grotere efficiëntiewinst met grotere, complexere en hoger geclockte chips die potentieel meer baat hebben aan betere logic.

-Het gebruik van HBM2(E) of 16Gbps GDDR6 met een 256 bit bus i.p.v een 384 bit bus.

-Veel betere schaling met juist wel een 384 bit bus en 16gbps GDDR6 waardoor je minder CU's nodig hebt voor een gewenst prestatieniveau.

-Überhaupt veel efficiënter met geheugenbandbreedte dan RDNA1 waardoor je met minder weg kan komen voor je gewenste prestatieniveau. Niet naar VRAM gaan, maar bij cache blijven is namelijk altijd efficiënter.

Het is niet zo simpel als RDNA1/Navi 10 even 50% groter maken, iets betere node en hallo RTX2080Ti. Dat was waarschijnlijk mogelijk met een 250W ish RDNA 1 met HBM2 en iets lagere clockspeeds dan een RX5700XT, maar daar is niet voor gekozen. Dit probeer ik nu al bijna een jaar duidelijk te maken. Er zullen serieuze stappen in architectuur gezet moeten worden voordat je dit bereikt. Daarom is de 12nm vs. 7nm discussie ook volstrekt zinloos. Volgende generatie is beiden op 7nm en dat wisten we allang. Het was en is nog steeds de vraag welke van de twee kampen de beste architectuur kan neerzetten op een 7nm node. Hebben we het nog niet gehad over de drie opties, TSMC N7 (DUV), N7+ (EUV) en Samsung (EUV) die allemaal nog mogelijk zijn. Nee, schrijf N7 ook nog niet af. EUV machines hebben een reticle limit die rond de 500mm2 zit.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Dit sluit alleen maar aan bij de verwachtingen, o.a. Buildzoid, die al aangaven waar en hoeveel de performance ongeveer ging zijn als je kijkt naar de restricties die komen kijken vanwege fysieke ruimte op de PCB in verband met de grote van de die en het geheugen.

15-20% sneller dan de 2080ti. Ik verwacht, i.t.t. @DaniëlWW2 , dat dit hun zwaarste chip zal zijn. Eigenlijk zeggen ze dit zelf al met het stukje over “4K gaming”, highend. Ze lopen tegen limieten aan.

15-20% sneller dan de 2080ti. Ik verwacht, i.t.t. @DaniëlWW2 , dat dit hun zwaarste chip zal zijn. Eigenlijk zeggen ze dit zelf al met het stukje over “4K gaming”, highend. Ze lopen tegen limieten aan.

Maar nieuws dan.

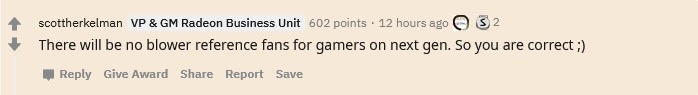

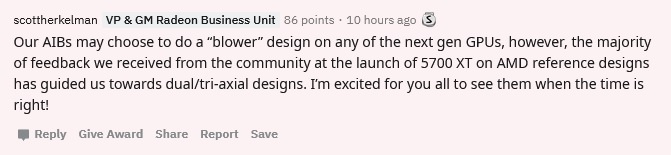

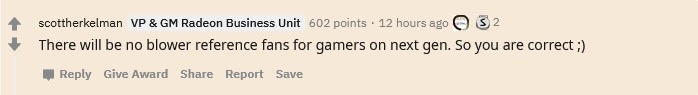

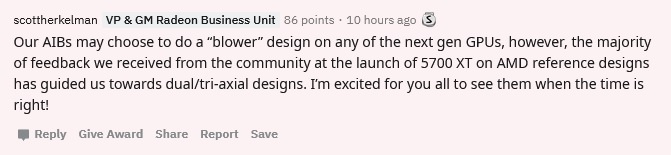

Geen blowers meer.

https://www.reddit.com/r/...ce=share&utm_medium=web2x

https://www.reddit.com/r/...ce=share&utm_medium=web2x

Geen blowers meer.

https://www.reddit.com/r/...ce=share&utm_medium=web2x

https://www.reddit.com/r/...ce=share&utm_medium=web2x

[ Voor 18% gewijzigd door DaniëlWW2 op 06-03-2020 12:35 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Goed dat ze daar, net als bij Nvidia, lekker van afgestapt zijn. Nodigt ook uit om je kaart van de fabrikant zelf te kopen i.p.v. AIB. Tenzij je echt een tuned/advanced apparaat wilt zoals een Asus Strix of MSI Gaming Trio.

Niet ontevreden over mijn RX 5700 kaart, maar ik had geen rekening gehouden met 50% betere perf/watt voor RDNA2. Van top to bottom. RDNA1 (Navi 10) refresh komt er dus waarschijnlijk niet. Kan ik mij waarschijnlijk niet inhouden om alsnog een nieuwe kaart te kopen.

[ Voor 16% gewijzigd door Maulwurfje op 06-03-2020 15:16 ]

En volgende stukje nieuws. AMD is bezig om de verwarring rond 7nm nodes op te lossen.

Ze laten expliciet de 7nm+ vallen omdat het verwarring kan veroorzaken met TSMC N7+, de EUV node. Dat is nodig omdat N7P ook bestaat. Dat is een DUV performance node.

https://www.anandtech.com...roducts-euv-not-specified

AMD zegt niet welke ze gebruiken, maar op deze manier vermoed ik N7P. Dat is logischer dan N7+ wat waarschijnlijk een meer low power node is. Ik denk dat we ons allemaal de laatste keer nog kunnen herinneren toen AMD een high end GPU liet produceren op een low power node. Low power was die niet, bizar veel lekstroom wel.

Ze laten expliciet de 7nm+ vallen omdat het verwarring kan veroorzaken met TSMC N7+, de EUV node. Dat is nodig omdat N7P ook bestaat. Dat is een DUV performance node.

https://www.anandtech.com...roducts-euv-not-specified

AMD zegt niet welke ze gebruiken, maar op deze manier vermoed ik N7P. Dat is logischer dan N7+ wat waarschijnlijk een meer low power node is. Ik denk dat we ons allemaal de laatste keer nog kunnen herinneren toen AMD een high end GPU liet produceren op een low power node. Low power was die niet, bizar veel lekstroom wel.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verder zal Big Navi het ook moeten opnemen tegen Nvidia's aanstaande 3000-serie, dus de vergelijking met RTX 2080 Ti kan zomaar in één klap achterhaald zijn.Sissors schreef op vrijdag 6 maart 2020 @ 11:37:

[...]

Dat mag ik hopen ja. Gezien RTX2080TI een TDP van 250W heeft, is het nou niet een extreem indrukwekkende prestatie wanneer AMD 2-2.5 jaar later op een veel moderner proces een vergelijkbare rekenkracht voor 225W kan neerzetten. En natuurlijk dan kunnen we het nog hebben over board TDP vs puur GPU TDP, maar overall mag ik wel hopen dat AMD dat kan qua perf/watt.

Ja, en de prijs van die 3000 serie zal dan weer 1op1 in verhouding staan met de performance die Big Navi gaat leveren, dus hoe dan ook een interessant jaar....XWB schreef op vrijdag 6 maart 2020 @ 20:36:

Verder zal Big Navi het ook moeten opnemen tegen Nvidia's aanstaande 3000-serie, dus de vergelijking met RTX 2080 Ti kan zomaar in één klap achterhaald zijn.

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Mijn phanteks evolv shift kast is het hier niet geheel mee eens

B650e | R5 7600 | RX6950XT | Formd T1 | AW3423DW

Die gast van Moore's Law is Dead schat (heel ruw) dat de nieuwe XBox iets van 33% meer ray tracing performance heeft dan de 2080Ti. Hij gebruikt daarvoor als inschatting de Crytek demo met RT en het feit dat de XBox 25 TFlops heeft voor RT alleen.

Ben erg benieuwd wat de PS5 gaat doen, ik hoop dat Sony qua RT hardware in de buurt blijft zodat we geen wildgroei aan implementaties krijgen.

Ben erg benieuwd wat de PS5 gaat doen, ik hoop dat Sony qua RT hardware in de buurt blijft zodat we geen wildgroei aan implementaties krijgen.

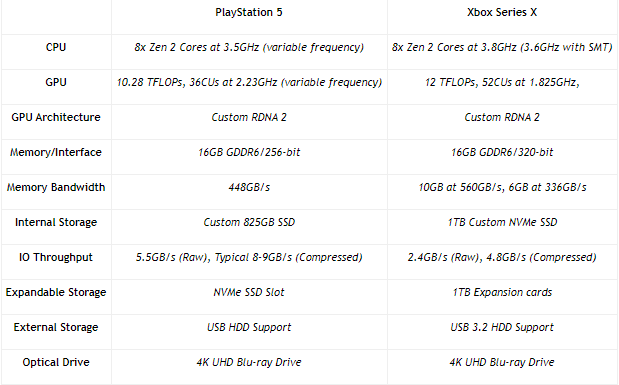

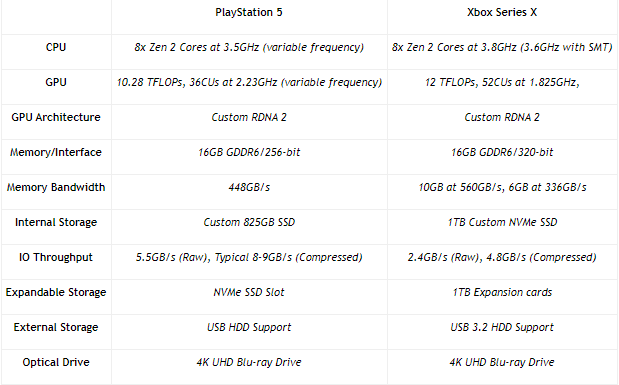

Dus nu hebben we een RDNA 2 met 52CU's die op 1,825GHz draait. Dat met een 320 bit bus en onderdeel van een APU waar de CPU ongeveer neer zal komen op een 3700X, allen voor 360mm2. Daarnaast een tweede RDNA 2 met 36CU's en een gezonde 2,3GHz. Dat is een mid range chip, kleiner dan Navi 10, maar waarschijnlijk wel sneller. Waarschijnlijk zit je voor een dergelijke GPU rond de 200mm2.

Is er nog iemand die eraan twijfelt dat AMD een gigantische stap gaat zetten met RDNA 2 of?

Die 50% perf/watt hebben ze al toegezegd, maar ik denk dat de meest hier meer zitten te kijken naar de performance en minder de watt. Dit zijn console chips en als ik het goed had begrepen is er een foto opgedoken die aangeeft dat de voeding van de Xbox series X beperkt zou zijn tot 305W. Dat is voor de hele console. Nou, tik iets van 70W eraf voor de Zen 2 8c/16t met 3,6GHz all core, nog wat voor de SSD en andere componenten en je zou zomaar rond of onder de 200W kunnen zitten voor de GPU. Dat is dan met een grotere bus en een prestatieniveau dat waarschijnlijk aardig richting de RTX2080Ti gaat. Formaat van puur de GPU zou ook wel eens sub 300mm2 kunnen zijn. Wederom niet erg spannend qua formaat. Dus kom maar op met die 80CU's.

Is er nog iemand die eraan twijfelt dat AMD een gigantische stap gaat zetten met RDNA 2 of?

Die 50% perf/watt hebben ze al toegezegd, maar ik denk dat de meest hier meer zitten te kijken naar de performance en minder de watt. Dit zijn console chips en als ik het goed had begrepen is er een foto opgedoken die aangeeft dat de voeding van de Xbox series X beperkt zou zijn tot 305W. Dat is voor de hele console. Nou, tik iets van 70W eraf voor de Zen 2 8c/16t met 3,6GHz all core, nog wat voor de SSD en andere componenten en je zou zomaar rond of onder de 200W kunnen zitten voor de GPU. Dat is dan met een grotere bus en een prestatieniveau dat waarschijnlijk aardig richting de RTX2080Ti gaat. Formaat van puur de GPU zou ook wel eens sub 300mm2 kunnen zijn. Wederom niet erg spannend qua formaat. Dus kom maar op met die 80CU's.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

PS 5 specs zijn nu ook bekent. PS5 lijkt wat zwakker te zijn dan de Xbox.

Hier een vergelijking:

Dit is meer ter info van de nieuwe graphics chip die AMD erin gestopt heeft, was zich waarschijnlijk ook als desktop kaart zal verwezelijken. Maar ik zie dat DanielWW2 deze al genoemd heeft.

Hier een vergelijking:

Dit is meer ter info van de nieuwe graphics chip die AMD erin gestopt heeft, was zich waarschijnlijk ook als desktop kaart zal verwezelijken. Maar ik zie dat DanielWW2 deze al genoemd heeft.

[ Voor 31% gewijzigd door bluebear op 18-03-2020 23:35 ]

* NitroX infinity zit op een 75W kaart te wachten.DaniëlWW2 schreef op woensdag 18 maart 2020 @ 18:52:

..maar ik denk dat de meest hier meer zitten te kijken naar de performance en minder de watt...

Ik hoop nou toch stiekem wel op beter dan 5500XT prestaties in 75W.

Graphene; a material that can do everything, except leave the lab. - Asianometry

Twijfel niet, maar dat hangt er volgens mij vooral vanaf vanuit welk perspectief je dit bekijkt.DaniëlWW2 schreef op woensdag 18 maart 2020 @ 18:52:

Is er nog iemand die eraan twijfelt dat AMD een gigantische stap gaat zetten met RDNA 2 of?

Als AMD naar 2080TI performance gaat met Big Navi dan geef ik je volledig gelijk als je zegtDaniëlWW2 schreef op woensdag 18 maart 2020 @ 18:52:

en een prestatieniveau dat waarschijnlijk aardig richting de RTX2080Ti gaat.

Het is helemaal prima dat AMD's komende generatie GPU op een prestatieniveau van 2080TI lopen. Het betekent dat er waarschijnlijk een betaalbaar alternatief is voor de 2080TI. Wel pas in Q4. Voor kopers die trouw aan team red hangen is dit natuurlijk heel goed nieuws.DaniëlWW2 schreef op woensdag 18 maart 2020 @ 18:52:

Is er nog iemand die eraan twijfelt dat AMD een gigantische stap gaat t.o.v. de huidige generatie gaat zetten met RDNA 2 of?

Echter, voor mensen die niet aan een kleurtje hangen en gewoon de beste performance willen is er wel al snel een redenatie van "die 2080TI, leuk dat je daarmee vergelijkt, maar die kaart is wel al een paar jaar op de markt". Nvidia zit ook niet stil en die blijven natuurlijk niet op hun 2080TI performance zitten met Ampere. En het is aannemelijk dat nu AMD aangesloten blijft Nvidia een scherpere pricing zal toepassen. We gaan echt geen 3080TI van €1500,- zien.

Hetgeen wat ik me afvraag echter: De Xbox gaat dus de trager geklokte, maar grotere versie hebben. Dus dan doe ik de aanname dat die al de grootste stap van minder verbruik door lagere kloksnelheid heeft gemaakt (immers is verbruik een dingetje bij die consoles). Als ze met een 80 CU kaart niet meer het verbruik veel lager kunnen krijgen per CU als tov de Xbox, dan zit je alsnog op 300W+.DaniëlWW2 schreef op woensdag 18 maart 2020 @ 18:52:

Dus nu hebben we een RDNA 2 met 52CU's die op 1,825GHz draait. Dat met een 320 bit bus en onderdeel van een APU waar de CPU ongeveer neer zal komen op een 3700X, allen voor 360mm2. Daarnaast een tweede RDNA 2 met 36CU's en een gezonde 2,3GHz. Dat is een mid range chip, kleiner dan Navi 10, maar waarschijnlijk wel sneller. Waarschijnlijk zit je voor een dergelijke GPU rond de 200mm2.

Is er nog iemand die eraan twijfelt dat AMD een gigantische stap gaat zetten met RDNA 2 of?

Die 50% perf/watt hebben ze al toegezegd, maar ik denk dat de meest hier meer zitten te kijken naar de performance en minder de watt. Dit zijn console chips en als ik het goed had begrepen is er een foto opgedoken die aangeeft dat de voeding van de Xbox series X beperkt zou zijn tot 305W. Dat is voor de hele console. Nou, tik iets van 70W eraf voor de Zen 2 8c/16t met 3,6GHz all core, nog wat voor de SSD en andere componenten en je zou zomaar rond of onder de 200W kunnen zitten voor de GPU. Dat is dan met een grotere bus en een prestatieniveau dat waarschijnlijk aardig richting de RTX2080Ti gaat. Formaat van puur de GPU zou ook wel eens sub 300mm2 kunnen zijn. Wederom niet erg spannend qua formaat. Dus kom maar op met die 80CU's.

Een RTX 2070 Super presteert ook ongeveer als een GTX 1080 Ti en een RX 5700 XT als een Radeon VII. Toch verkopen de RTX 2070 Super en RX 5700 XT prima. De markt voor het aller snelste is niet zo groot, de marge daarentegen wel natuurlijk.JeroenNietDoen schreef op donderdag 19 maart 2020 @ 08:21:

[...]

Echter, voor mensen die niet aan een kleurtje hangen en gewoon de beste performance willen is er wel al snel een redenatie van "die 2080TI, leuk dat je daarmee vergelijkt, maar die kaart is wel al een paar jaar op de markt".

Hoe weet je het verbruik van de GPU en het videogeheugen van de toekomstige Xbox?Sissors schreef op donderdag 19 maart 2020 @ 08:28:

[...]

Hetgeen wat ik me afvraag echter: De Xbox gaat dus de trager geklokte, maar grotere versie hebben. Dus dan doe ik de aanname dat die al de grootste stap van minder verbruik door lagere kloksnelheid heeft gemaakt (immers is verbruik een dingetje bij die consoles). Als ze met een 80 CU kaart niet meer het verbruik veel lager kunnen krijgen per CU als tov de Xbox, dan zit je alsnog op 300W+.

AMD heeft aangeven dat RDNA2 met de tweede generatie 7nm zorgt voor een performance/watt verbetering van 50% ten opzichte van RDNA op de eerste generatie 7nm. Daarmee kan AMD 30% meer prestaties halen als een RTX 2080 Ti met hetzelfde verbruik. Als je de RX5700 XT als basis pakt.

De vraag is echter of AMD hier ook voor kiest. Een meer logische keuze voor AMD is om zoveel mogelijk prestaties te halen uit zo weinig mogelijk silicon. En dat doe je door de klokfrequentie zo ver als mogelijk op te voeren. Dit gaat echter weer te koste van de performance per watt.

Ik zou er niet van uit gaan dat je zo'n kaart dit jaar gaat zien. De focus zal toch eerst liggen op de producten met meer marge. Misschien krijgen we over twee jaar wel SoC's met zulke prestaties. De techniek is er, zie de nieuwe Xbox en PS5. Maar ook eerder al natuurlijk met Kaby Lake G, met een losse AMD chip en HBM.NitroX infinity schreef op woensdag 18 maart 2020 @ 23:45:

[...]

* NitroX infinity zit op een 75W kaart te wachten.

Ik hoop nou toch stiekem wel op beter dan 5500XT prestaties in 75W.

Je begint met de aanname dat men er voor kiest de voeding voor 100% te belasten. Hierdoor is de berekening erachter al niks meer waard. Naast dat daar alleen maar aannames in staan. En je houdt geen rekening met SmartShift, waardoor de videochip alleen ook het volledige power budget voor zichzelf mag opeisen.DaniëlWW2 schreef op woensdag 18 maart 2020 @ 18:52:

Is er nog iemand die eraan twijfelt dat AMD een gigantische stap gaat zetten met RDNA 2 of?

Die 50% perf/watt hebben ze al toegezegd, maar ik denk dat de meest hier meer zitten te kijken naar de performance en minder de watt. Dit zijn console chips en als ik het goed had begrepen is er een foto opgedoken die aangeeft dat de voeding van de Xbox series X beperkt zou zijn tot 305W. Dat is voor de hele console. Nou, tik iets van 70W eraf voor de Zen 2 8c/16t met 3,6GHz all core, nog wat voor de SSD en andere componenten en je zou zomaar rond of onder de 200W kunnen zitten voor de GPU. Dat is dan met een grotere bus en een prestatieniveau dat waarschijnlijk aardig richting de RTX2080Ti gaat. Formaat van puur de GPU zou ook wel eens sub 300mm2 kunnen zijn. Wederom niet erg spannend qua formaat. Dus kom maar op met die 80CU's.

[ Voor 36% gewijzigd door Verwijderd op 19-03-2020 09:53 ]

We hebben alleen geen idee hoeveel de GPU werkelijk verbruikt. Het is custom een APU met een 8c/16t Zen 2 CPU, custom IF, een primaire 320bit GDDR6 bus met 10GB, een extra 192bit GDDR6 bus met 6GB en waarschijnlijk nog wat dingetjes waar Microsoft en AMD je niks over gaan vertellen. Het is een nauwelijks te vergelijken product, buiten dat we enige extrapolaties kunnen maken over prestaties en verbruik. Dat zit dan allemaal binnen de 300W, waarschijnlijk ruim binnen de 300W. Niet alleen vanwege de PSU, maar ook omdat het te koelen moet zijn. Zeker een dingetje voor 7nm chips. Ik ben zeer bewust aan de veilige kant gaan zitten met mijn inschattingen.Sissors schreef op donderdag 19 maart 2020 @ 08:28:

[...]

Hetgeen wat ik me afvraag echter: De Xbox gaat dus de trager geklokte, maar grotere versie hebben. Dus dan doe ik de aanname dat die al de grootste stap van minder verbruik door lagere kloksnelheid heeft gemaakt (immers is verbruik een dingetje bij die consoles). Als ze met een 80 CU kaart niet meer het verbruik veel lager kunnen krijgen per CU als tov de Xbox, dan zit je alsnog op 300W+.

Oh en wat is er precies mis met een 80CU RDNA2 die 300W verbruikt? Ik bedoel, als zoiets de Titan RTX met 50% verslaat, wie hoor je dan precies klagen? De mensen die nu klagen dat menig RTX2080Ti richting of over de 300W gaat? Zelfs als de onvermijdelijke RTX3080Ti iets sneller is, tja dan zal AMD waarschijnlijk flink onder die prijs gaan zitten. Zit genoeg marge op echt high end om dat te kunnen. Zelfs met 16GB aan HBM2E kan AMD het waarschijnlijk doen. Willen ze natuurlijk niet, maar het kan als het moet. Voor de doelgroep van zulke videokaarten is verbruik ook een non issue.

Kijk, deze is nou interessant. Jon Peddie heeft natuurlijk heel wat inzichtelijke zaken te vertellen over de GPU markt. Zeer zeker de moeite waard.

Maar er is nog meer. Op Github was gestolen data van Navi 10, Navi 21 en Arden (XBOX APU) source code gelekt. AMD is not amused, maar de vraag voor ons is natuurlijk wat daar uit te halen is. De bestanden zouden allang offline zijn gehaald en ik zou ze niet zomaar downloaden want je weet maar nooit wat er extra tussen kan zitten. Vraag me alleen wel af wat er precies in zal zitten qua hardware features. RDNA2 is behalve 50% perf/watt natuurlijk ook ray tracing.

https://www.amd.com/en/corporate/data-update

https://www.tomshardware....stolen-100-million-ransom

En als laatste natuurlijk wat PR praat over hoe Microsoft en AMD zo goed hebben samengewerkt voor DX12 Ultimate en DXR 1.1.

https://community.amd.com...2-and-directx-12-ultimate

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

RDNA2 doet het goed. Ben benieuwd wat een grotere desktop kaart kan

De demo die Epic ons gisteren heeft laten zien, heeft mij helemaal opgewonden met vragen achtergelaten. Ik heb vandaag diep de rabbithole ingegaan en probeer een beeld te krijgen van wat we nu allemaal zien. Want miljarden polygonen efficiënt omzetten tot REYES beeld (Render everything your eyes sees); wat ongeveer uit neer komt op polygon per pixel.

Digital Foundry heeft een diepere analyse gemaakt:

En het komt er nog steeds eigenlijk op neer dat ik de klok wel heb horen luiden maar nog niet weet waar de klepel hangt.

Microsoft en AMD hebben voor de nextgen een paar technieken ontwikkelt. Primative mesh shading. variable rate shading, sampler feedback van wat ik begrijp lijkt het allemaal in deze UE5 demo toegepast te zijn.

Hoe is het mogelijk dat Epic instaat is om gigantische hoeveelheden (miljarden) polygonen zo efficiënt om te zetten naar een frame met alsnog gigantisch veel (miljoenen) polygonen. Is primative mesh shading niet de achterliggende techniek om geometrie op een andere manier te berekenen? En ook om uiteindelijk heel efficiënt via culling alleen de polygonen te shaden die je ziet. En na primative mesh shading komt variable refresh shading om de hoek kijken om de hele frame zo efficient mogelijk te shaden?

Worden voor rasterisation alle drawcalls door de GPU of de CPU gedaan? Ondanks dat de consoles een flinke upgrade hebben gekregen in CPU-kracht lijkt mij een frame met miljoenen drawcalls ineens weer heel zwaar.

Epic gebruikt daarnaast ook 8K textures. Microsoft heeft voor DX12U (wat dus niet op de PS5 loopt) Sampler Feedback ontwikkelt. Hierbij wordt veel efficiënter omgegaan met midmap van textures; waardoor de GPU sneller weet welke midmap van de texture te gebruiken.

Zoals je ziet veel vragen aan de hand van deze demo. Als iemand mij kan vertellen hoe alle genoemde technieken hand in hand gaan please do. En ook al begrijp ik er nog weinig van, het ziet er wel prachtig uit

Digital Foundry heeft een diepere analyse gemaakt:

En het komt er nog steeds eigenlijk op neer dat ik de klok wel heb horen luiden maar nog niet weet waar de klepel hangt.

Microsoft en AMD hebben voor de nextgen een paar technieken ontwikkelt. Primative mesh shading. variable rate shading, sampler feedback van wat ik begrijp lijkt het allemaal in deze UE5 demo toegepast te zijn.

Hoe is het mogelijk dat Epic instaat is om gigantische hoeveelheden (miljarden) polygonen zo efficiënt om te zetten naar een frame met alsnog gigantisch veel (miljoenen) polygonen. Is primative mesh shading niet de achterliggende techniek om geometrie op een andere manier te berekenen? En ook om uiteindelijk heel efficiënt via culling alleen de polygonen te shaden die je ziet. En na primative mesh shading komt variable refresh shading om de hoek kijken om de hele frame zo efficient mogelijk te shaden?

Worden voor rasterisation alle drawcalls door de GPU of de CPU gedaan? Ondanks dat de consoles een flinke upgrade hebben gekregen in CPU-kracht lijkt mij een frame met miljoenen drawcalls ineens weer heel zwaar.

Epic gebruikt daarnaast ook 8K textures. Microsoft heeft voor DX12U (wat dus niet op de PS5 loopt) Sampler Feedback ontwikkelt. Hierbij wordt veel efficiënter omgegaan met midmap van textures; waardoor de GPU sneller weet welke midmap van de texture te gebruiken.

Zoals je ziet veel vragen aan de hand van deze demo. Als iemand mij kan vertellen hoe alle genoemde technieken hand in hand gaan please do. En ook al begrijp ik er nog weinig van, het ziet er wel prachtig uit

Drawcalls worden door de cpu klaargezet. Vroeger was dit met de oudere API's singlethreaded, DX11 gaf een hele kleine verbetering dacht ik. Pas met DirectX 12 en Vulkan kan dit volledig multithreaded worden gedaan.

Dit is ook de grote reden dat AMD ooit met Mantle is begonnen (wat uiteindelijk de grondlegger van Vulkan is), ze werden namelijk gelimiteerd door het aantal draw calls dat kon worden gemaakt in sommige spellen in DX11. Waar AMD de drawcalls singlethreaded heel efficient kon klaarzetten deed Nvidia dat in hun driver al multithreaded (hoewel minder efficient, maar meer cores loste dit op).

Miljoenen draw calls kan dus tegenwoordig met de low level API's.

Mesh Shading is iets wat Nvidia al met Turing heeft, zie ook:

Hoe de techniek precies werkt weet ik niet, daarvoor moet ik me inlezen. Het lijkt in ieder geval een aantal dingen die eerst op de cpu werden gedaan nu op de gpu te doen.

Dit is ook de grote reden dat AMD ooit met Mantle is begonnen (wat uiteindelijk de grondlegger van Vulkan is), ze werden namelijk gelimiteerd door het aantal draw calls dat kon worden gemaakt in sommige spellen in DX11. Waar AMD de drawcalls singlethreaded heel efficient kon klaarzetten deed Nvidia dat in hun driver al multithreaded (hoewel minder efficient, maar meer cores loste dit op).

Miljoenen draw calls kan dus tegenwoordig met de low level API's.

Mesh Shading is iets wat Nvidia al met Turing heeft, zie ook:

Hoe de techniek precies werkt weet ik niet, daarvoor moet ik me inlezen. Het lijkt in ieder geval een aantal dingen die eerst op de cpu werden gedaan nu op de gpu te doen.

Verwijderd

volgens EPIC:Maulwurfje schreef op donderdag 14 mei 2020 @ 22:13:

De demo die Epic ons gisteren heeft laten zien, heeft mij helemaal opgewonden met vragen achtergelaten. Ik heb vandaag diep de rabbithole ingegaan en probeer een beeld te krijgen van wat we nu allemaal zien. Want miljarden polygonen efficiënt omzetten tot REYES beeld (Render everything your eyes sees); wat ongeveer uit neer komt op polygon per pixel.

Zoals je ziet veel vragen aan de hand van deze demo. Als iemand mij kan vertellen hoe alle genoemde technieken hand in hand gaan please do. En ook al begrijp ik er nog weinig van, het ziet er wel prachtig uit

Dus ik denk dankzij de hogere I/O er meer hoog kwaliteit data kan worden gepresenteerd die gewoonweg minder bewerking/processing nodig heeft ? waardoor Rasterization de bottleneck wordt welke dus word opgelost door shaders in te zetten als software rasterization ipv van hardware rasterizers. Primitive en mesh shader haken in op dat versimpelen en repurpose van shader naar software rasterizers.The vast majority of triangles are software rasterised using hyper-optimised compute shaders specifically designed for the advantages we can exploit," explains Brian Karis. "As a result, we've been able to leave hardware rasterizer in the dust at this specific task. Software rasterization is a core component of Nanite that allows it to achieve what it does. We can't beat hardware rasterizer in all cases though so we'll use hardware when we've determined it's the faster path. On PlayStation 5 we use primitive shaders for that path which is considerably faster than using the old pipeline we had before with vertex shaders."

Die tech demo  en dat allemaal op AMD hardware.

en dat allemaal op AMD hardware.

Al wat ik aanraak werk niet meer zoals het hoort. Damic houd niet van zijn verjaardag

AMD gaat zich volgens de geruchten als eerste nu richten op het invullen van de high-end van de videokaarten markt: nieuws: Namen van AMD Navi-gpu's op basis van RDNA2 verschijnen online

Ikzelf heb het wachten op een (desktop) Navi die draait op minder dan 75 Watt opgegeven, het duurt mij te lang. Ik heb met mijn vakantiegeld, ondanks de slechte ontvangst ervan hier op Tweakers en elders op het internet, een 5500 XT 8 GB gekocht.

Het is voor het eerst in mijn leven dat ik een videokaart heb met een aparte voedingskabel. Aanvankelijk wou mijn systeem niet booten na het inbouwen. Opzoekend wat de piepjes van de BIOS-speaker betekenen, bleek de VGA niet gevonden. Ik was de voedingskabel vergeten! Ik heb nog nooit een voedingskabel aangesloten bij het inbouwen van een videokaart, dus daar had ik niet aan gedacht .

.

Ik had mijn ogen op een Sapphire Pulse vanwege de goede reviews en de dubbele BIOS, waarmee je kunt switchen naar lager vermogen, maar na onderzoek naar het duurzaamheidsbeleid van de verschillende AIB partners gekozen voor een Gigabyte kaart, want die hebben het beste beleid en rapporteren het meest uit- gebreid daarover: https://www.gigabyte.com/CSR.

Ik haal nu op 1080p veel meer fps op de hoogste settings dan echt nodig is in de meeste spellen, dus van de zomer maar eens de energie vinden om me te verdiepen in undervolting.

Ikzelf heb het wachten op een (desktop) Navi die draait op minder dan 75 Watt opgegeven, het duurt mij te lang. Ik heb met mijn vakantiegeld, ondanks de slechte ontvangst ervan hier op Tweakers en elders op het internet, een 5500 XT 8 GB gekocht.

Het is voor het eerst in mijn leven dat ik een videokaart heb met een aparte voedingskabel. Aanvankelijk wou mijn systeem niet booten na het inbouwen. Opzoekend wat de piepjes van de BIOS-speaker betekenen, bleek de VGA niet gevonden. Ik was de voedingskabel vergeten! Ik heb nog nooit een voedingskabel aangesloten bij het inbouwen van een videokaart, dus daar had ik niet aan gedacht

Ik had mijn ogen op een Sapphire Pulse vanwege de goede reviews en de dubbele BIOS, waarmee je kunt switchen naar lager vermogen, maar na onderzoek naar het duurzaamheidsbeleid van de verschillende AIB partners gekozen voor een Gigabyte kaart, want die hebben het beste beleid en rapporteren het meest uit- gebreid daarover: https://www.gigabyte.com/CSR.

Ik haal nu op 1080p veel meer fps op de hoogste settings dan echt nodig is in de meeste spellen, dus van de zomer maar eens de energie vinden om me te verdiepen in undervolting.

[ Voor 5% gewijzigd door FairPCsPlease op 25-05-2020 11:19 ]

Net als Sp3ci3s8472 en Maulwurfje vond ik de demo van de nieuwe Unreal Engine erg indrukwekkend. Op een 4K scherm zie je voor mijn gevoel ook echt hoe gedetailleerd en bijna foto-realistisch deze gecreëerde wereld eruit ziet. Het lijkt echt een revolutie te gaan worden in de wereld van computer graphics. Zelfs als PC- gamer begin ik stiekem al te verlangen naar zo'n nieuwe PlayStation 5. Ben benieuwd hoe lang het duurt voordat je op je PC de eerste op UE -V gebaseerde spellen kunt spelen die er even mooi uitzien als op een PS5 en welk bedrag je daar dan voor kwijt bent. Misschien ben je de eerste jaren wel beter af met een PS5 van $600 dan met de dure PC die de PS5 grafisch kan bijbenen?

In die tweede video van Digital Foundry wordt ook nog het interessante punt gemaakt dat de nieuw geïntroduceerde technieken als Lumen en Nanite ook een goed alternatief vormen voor de raytracing technologie, maar dan zonder de negatieve performance impact (geen terugval in FPS) van die laatste.

In die tweede video van Digital Foundry wordt ook nog het interessante punt gemaakt dat de nieuw geïntroduceerde technieken als Lumen en Nanite ook een goed alternatief vormen voor de raytracing technologie, maar dan zonder de negatieve performance impact (geen terugval in FPS) van die laatste.

Daar geef ik je gelijk in, maar dan wel in oudere demo's. Wat nu anders is is dat de pipeline om content in een game te krijgen veel makkelijker is en ze zich veel minder zorgen hoeven te maken over polycounts en het hele LOD process. Het maken van normal maps, parallax oclusion maps en het optimaliseren van een mesh hoeft hiermee niet meer.XWB schreef op zondag 24 mei 2020 @ 20:40:

Echter, in de praktijk komen games nooit in de buurt van dit soort demo's.

Hier door hebben modelers weer meer tijd over voor het maken van andere content.

Zodra de nieuwe consoles een tijd uit zijn zal je zien dat de kwaliteit van de games een stuk toeneemd. Dat zag je ook met de oudere geraties van consoles.

De sprong gaat deze keer groter worden dan we in heel erg lange tijd hebben gezien.Sp3ci3s8472 schreef op maandag 25 mei 2020 @ 00:47:

Zodra de nieuwe consoles een tijd uit zijn zal je zien dat de kwaliteit van de games een stuk toeneemd. Dat zag je ook met de oudere geraties van consoles.

Ik heb hem hier niet genoemd zien worden, maar Mark Cerny's presentatie over de PS5 is heerlijk om naar te kijken/luisteren. Hij is wat mij betreft echt één van de grootheden in de industrie en zijn presentaties zijn geweldig. En wat hij, z'n teams en AMD met de PS5 doen is fascinerend.

YouTube: The Road to PS5

Er zit een hoop verborgen goud in deze presentatie. Ik ben er sowieso al vrij zeker van dat Sony het gevecht al gewonnen heeft*. Belangrijker voor dit topic is echter de manier waarop ze met AMD samen werken en wat er precies in die GPU zit.

Als je een beetje tussen de regels door...luistert, dan valt op dat AMD en Sony bijzonder nauw samen lijken te werken. Er zijn een paar open deuren (primitive shaders komen terug

Als ik het een beetje goed inschat, dan is RDNA2 geen puur AMD product, Sony heeft daar volgens mij meer invloed op gehad dan velen wellicht denken. Ze lijken heel erg op de balans gefocust te hebben, vandaar het lagere aantal CU's. Waar ik verder op hoop is dat enkele van de andere dingen ook beschikbaar komen voor PC's in één of andere vorm. Data rechtstreeks van een speciale (hoppa, marketing kans jongens: plak er maar een "gaming" stikker op) m.2 SSD over PCI-e 4 naar je GPU laden? Yes please. Een degelijke audio chip? Jammie. Stop het maar in de chipsets AMD, m'n 1700X kan het vast wel verdragen als ik hem vervang

* de concurrent mag dan wel anderhalve teraflop meer hebben, dat zegt niet veel. Het is lastiger om ze allemaal aan te spreken; en door de lagere kloksnelheid is de doorvoer elders (geo, rasterizer) ook lager. Het geheugen is ook niet evenredig op dezelfde snelheid aanspreekbaar. De I/O setup op de PS5 is ook een groot voordeel en de audio setup is voor PSVR2 bijzonder waardevol.

Daar ben ik wel benieuwd naar, aangezien de nieuwe Xbox basically dezelfde hardware krijgt.Werelds schreef op zaterdag 30 mei 2020 @ 16:28:

[...]

Er zit een hoop verborgen goud in deze presentatie. Ik ben er sowieso al vrij zeker van dat Sony het gevecht al gewonnen heeft*.

Zie m'n voetnootXWB schreef op zaterdag 30 mei 2020 @ 16:32:

[...]

Daar ben ik wel benieuwd naar, aangezien de nieuwe Xbox basically dezelfde hardware krijgt.

Daarnaast zijn Sony's first-party studio's uitzonderlijk capabel. MS heeft niets nieuws aangekondigd, dus dat lijkt bij Gears, Halo en Forza te blijven. Fans van die games zullen bij Xbox blijven, maar tenzij ze nog iets in petto hebben, hebben ze niets om gamers van de andere kant over te halen.

Hetzelfde geldt voor de hardware: Sony heeft laten zien hoe ze een hele hoop dingen streamlinen en wat er aan unieke mogelijkheden beschikbaar is. MS heeft (nog) niets laten zien dat echt uniek is. Is het ding snel? Zeker. Zal alles er een stuk beter uit gaan zien? Vast wel. Maar Sony lijkt vooralsnog wederom de beste hand te hebben.

En die MS exclusives zijn nou ook niet zo exclusief, daar de meeste games ook voor de PC beschikbaar zijn.

Goed filmpje. Hij legt het allemaal helder uit op een manier dat ook een leek het begrijpt.Werelds schreef op zaterdag 30 mei 2020 @ 16:28:

[...]

De sprong gaat deze keer groter worden dan we in heel erg lange tijd hebben gezien.

Ik heb hem hier niet genoemd zien worden, maar Mark Cerny's presentatie over de PS5 is heerlijk om naar te kijken/luisteren. Hij is wat mij betreft echt één van de grootheden in de industrie en zijn presentaties zijn geweldig. En wat hij, z'n teams en AMD met de PS5 doen is fascinerend.

YouTube: The Road to PS5

Er zit een hoop verborgen goud in deze presentatie. Ik ben er sowieso al vrij zeker van dat Sony het gevecht al gewonnen heeft*. Belangrijker voor dit topic is echter de manier waarop ze met AMD samen werken en wat er precies in die GPU zit.

Als je een beetje tussen de regels door...luistert, dan valt op dat AMD en Sony bijzonder nauw samen lijken te werken. Er zijn een paar open deuren (primitive shaders komen terug), maar er zijn ook wat subtielere dingen: het hele I/O verhaal, de cache scrubbers, de audio. De techniek in de PS5 is op alle vlakken beter dan welke PC dan ook, behalve dan qua rauwe CPU core count. Dat doet er echter minder toe doordat alles zo nauw samen hangt. De PS4 was een solide product waar AMD liet zien dat ze de console bouwers konden geven wat ze wilden. Sony lijkt dat opgepikt te hebben en zich vol overgave in de samenwerking gestort te hebben. Ondanks het feit dat het weer een "PC" GPU architectuur met een "PC" CPU is, heeft de PS5 meer gemeen met de PS3 dan met de PS4.

Als ik het een beetje goed inschat, dan is RDNA2 geen puur AMD product, Sony heeft daar volgens mij meer invloed op gehad dan velen wellicht denken. Ze lijken heel erg op de balans gefocust te hebben, vandaar het lagere aantal CU's. Waar ik verder op hoop is dat enkele van de andere dingen ook beschikbaar komen voor PC's in één of andere vorm. Data rechtstreeks van een speciale (hoppa, marketing kans jongens: plak er maar een "gaming" stikker op) m.2 SSD over PCI-e 4 naar je GPU laden? Yes please. Een degelijke audio chip? Jammie. Stop het maar in de chipsets AMD, m'n 1700X kan het vast wel verdragen als ik hem vervang

* de concurrent mag dan wel anderhalve teraflop meer hebben, dat zegt niet veel. Het is lastiger om ze allemaal aan te spreken; en door de lagere kloksnelheid is de doorvoer elders (geo, rasterizer) ook lager. Het geheugen is ook niet evenredig op dezelfde snelheid aanspreekbaar. De I/O setup op de PS5 is ook een groot voordeel en de audio setup is voor PSVR2 bijzonder waardevol.

Op papier ziet de nieuwe PS5 console er echt uit als een hele grote stap vooruit. Vooral ook het audio verhaal spreekt me aan. Hopelijk gaan we daar ook wat van terugzien op de PC.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Dat zou heel goed kunnen, bij GCN is dat destijds immers ook zo gegaan.Werelds schreef op zaterdag 30 mei 2020 @ 16:28:

[...]

Als ik het een beetje goed inschat, dan is RDNA2 geen puur AMD product, Sony heeft daar volgens mij meer invloed op gehad dan velen wellicht denken.

Yep, zijn talks zijn altijd prettig om naar te luisteren. Hij praat heel rustig, duidelijk en het is een technische man, dus er zit maar zelden marketing onzin inHelp!!!! schreef op zaterdag 30 mei 2020 @ 19:26:

[...]

Goed filmpje. Hij legt het allemaal helder uit op een manier dat ook een leek het begrijpt.

Op papier ziet de nieuwe PS5 console er echt uit als een hele grote stap vooruit. Vooral ook het audio verhaal spreekt me aan. Hopelijk gaan we daar ook wat van terugzien op de PC.

De I/O zie ik echt wel een markt voor. Audio wil ik heel graag wijd verspreid zien, maar helaas is dat juist het aspect waar ik vrees dat de meeste mensen geen interesse zullen tonen. Audio in de meeste games is waardeloos en CMSS-3D met 5.1+ input is nog steeds de beste oplossing in de meeste gevallen.

Nee, dat was anders. De PS4 is in principe gewoon GCN 1.1 (Bonaire), maar dan met wat console-specifieke toevoegingen. Een DMA bus (want enkele geheugen pool), de L2 cache kan tegelijkertijd graphics en async compute data bevatten (minder invalidation en dus minder performance impact) en een bredere frontend. Niets van dat alles heeft zich terug vertaald naar desktop GPU'sTrygve schreef op zaterdag 30 mei 2020 @ 20:38:

Dat zou heel goed kunnen, bij GCN is dat destijds immers ook zo gegaan.

Enkel als men er (DX11 MT) expliciet gebruik van maakt. En dat doet vrijwel niemand.Sp3ci3s8472 schreef op donderdag 14 mei 2020 @ 22:57:

DX11 gaf een hele kleine verbetering dacht ik

Mesh Shading komt neer op AMD's primitive shaders + tessellation, met rechtstreekse output naar de rasterizer. Het is die laatste stap waar de winst wordt geboekt, want wat het voor de rest doet kan nu ook al met compute shaders (zal morgen even zoeken, er is ergens een demo die precies dit doet). Ga je echter meer pixels pushen (MSAA en/of gewoon echt hogere resoluties), dan worden de compute shaders traag omdat die alles telkens in het geheugen moeten stoppen. Het belangrijkste is dat er slim en snel culling gedaan wordt.Mesh Shading is iets wat Nvidia al met Turing heeft, zie ook:

[YouTube: Asteroids Mesh Shaders Demo]

Hoe de techniek precies werkt weet ik niet, daarvoor moet ik me inlezen. Het lijkt in ieder geval een aantal dingen die eerst op de cpu werden gedaan nu op de gpu te doen.

Het is een beetje een stap terug naar vroeger (pakweg 20 jaar geleden), toen veel pipelines rechtstreeks naar de rasterizer liepen. Met alle andere soorten shaders die we door de unified shaders stouwen werkt dat niet, maar voor de toepassingen van mesh/primitive shaders juist wel. Je stopt er een klein beetje in en er kan een hele hoop uit komen. Daar hoef je verder niets mee te doen, dus het kan rechtstreeks naar de rasterizer.

Krijg een beetje John Carmack vibe van hemHelp!!!! schreef op zaterdag 30 mei 2020 @ 19:26:

[...]

Goed filmpje. Hij legt het allemaal helder uit op een manier dat ook een leek het begrijpt.

Op papier ziet de nieuwe PS5 console er echt uit als een hele grote stap vooruit. Vooral ook het audio verhaal spreekt me aan. Hopelijk gaan we daar ook wat van terugzien op de PC.

Die heeft ook leuke talks, met name als ze gaan over game engines en VR.

Ja echt een verademing eens een keer niet dat snelle gehypte flashy gedoe. Lekker rustig en duidelijk.Werelds schreef op zaterdag 30 mei 2020 @ 23:16:

[...]

Yep, zijn talks zijn altijd prettig om naar te luisteren. Hij praat heel rustig, duidelijk en het is een technische man, dus er zit maar zelden marketing onzin in

Die I/O dat gaat sowieso wel komen lijkt me. Op de PC zal het allemaal misschien wat langer duren vanwege legacy, vooralsnog beperkte installed base en ontbreken speciale I/O logic.De I/O zie ik echt wel een markt voor. Audio wil ik heel graag wijd verspreid zien, maar helaas is dat juist het aspect waar ik vrees dat de meeste mensen geen interesse zullen tonen. Audio in de meeste games is waardeloos en CMSS-3D met 5.1+ input is nog steeds de beste oplossing in de meeste gevallen.

De speciale I/O chip vd PS5 hoeveel die space zou dat kosten en zou dat wellicht niet ook verwerkt (kunnen) gaan worden door AMD in de ZEN desktop I/O chiplet

Zou toch geniaal zijn: Console level I/O integratie icm PCI-e4 op de desktop. Beginnend bij Zen3 please

Qua audio is het misschien wel goed dat ze dit via de console gaan doen. Als men daar eenmaal gewend is en begrijpt hoe belangrijk goede audio is zal er op de PC misschien toch ook meer aandacht voor komen.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Nouja, dat hangt er imho ongeveer 100% vanaf of deze rumour waarheid word:Werelds schreef op zaterdag 30 mei 2020 @ 17:13:

[...]

Zie m'n voetnoot

Daarnaast zijn Sony's first-party studio's uitzonderlijk capabel. MS heeft niets nieuws aangekondigd, dus dat lijkt bij Gears, Halo en Forza te blijven. Fans van die games zullen bij Xbox blijven, maar tenzij ze nog iets in petto hebben, hebben ze niets om gamers van de andere kant over te halen.

Hetzelfde geldt voor de hardware: Sony heeft laten zien hoe ze een hele hoop dingen streamlinen en wat er aan unieke mogelijkheden beschikbaar is. MS heeft (nog) niets laten zien dat echt uniek is. Is het ding snel? Zeker. Zal alles er een stuk beter uit gaan zien? Vast wel. Maar Sony lijkt vooralsnog wederom de beste hand te hebben.

https://www.ccn.com/xbox-...c-gaming-to-your-console/

Als (en dat is een hele grote ALS) ik op wat voor een manier dan ook mijn PC-library op de XSX kan spelen, dan denk ik dat de XSX bijvoorbaat al gewonnen heeft.

Dat zou namelijk betekenen dat je voor €500,- - €700,- een dijk van een PC die ook nog goed gestyled is en met top hardware onder je TV kan hebben staan.... Als je met die "Windows Mode" ook nog andere windows applicaties kan draaien, dan kan Sony helemaal inpakken (imho).....

Als ik Elite:Dangerous/Star Citizen/The Witcher 3 etc met mijn bestaande PC accounts kan spelen op de XSX dan staat er bij mij iig op launch date een XSX in de huiskamer (met een nieuwe LG 55CX6LA om het maximale eruit te halen), de Xbox Elite series 2 controller heb ik al (voor de PC), dus dat is mooi meegenomen.

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Klopt inderdaad, Cerny is wel nog een stukje rustiger (en georganiseerderSp3ci3s8472 schreef op zondag 31 mei 2020 @ 01:21:

Krijg een beetje John Carmack vibe van hem.

Die heeft ook leuke talks, met name als ze gaan over game engines en VR.

We zullen het zien. Het hangt denk ik helemaal af van of er patenten achter zitten, en zoja, bij wie die liggen. Het zou me niets verbazen als er gewoon een cross-licensing deal ligt tussen AMD en Sony. Of AMD dat dan in de chiplet zou bakken weet ik niet. Ik zie (zoals ik al zei) flinke marketing mogelijkheden via andere wegen.Help!!!! schreef op zondag 31 mei 2020 @ 08:32:

Die I/O dat gaat sowieso wel komen lijkt me. Op de PC zal het allemaal misschien wat langer duren vanwege legacy, vooralsnog beperkte installed base en ontbreken speciale I/O logic.

De speciale I/O chip vd PS5 hoeveel die space zou dat kosten en zou dat wellicht niet ook verwerkt (kunnen) gaan worden door AMD in de ZEN desktop I/O chipletMaar misschien liggen de rechten ook wel (deels?) bij Sony.

Zou toch geniaal zijn: Console level I/O integratie icm PCI-e4 op de desktop. Beginnend bij Zen3

Qua audio is het misschien wel goed dat ze dit via de console gaan doen. Als men daar eenmaal gewend is en begrijpt hoe belangrijk goede audio is zal er op de PC misschien toch ook meer aandacht voor komen.

Audio moet AMD gewoon als chip bakken en aan moederborden fabrikanten aanbieden, samen met wat vereisten voor de output (degelijke amps). Ga de strijd maar aan met Realtek, Dolby en dergelijke.

Die had ik nog niet gezien, maar als dat klopt dan is dat Microsoft's troef. Ik denk echter niet dat dat dan een negatieve invloed op Sony heeft, maar juist op de verkoopcijfers van PC hardware.zion schreef op zondag 31 mei 2020 @ 10:20:

Nouja, dat hangt er imho ongeveer 100% vanaf of deze rumour waarheid word:

https://www.ccn.com/xbox-...c-gaming-to-your-console/

Als (en dat is een hele grote ALS) ik op wat voor een manier dan ook mijn PC-library op de XSX kan spelen, dan denk ik dat de XSX bijvoorbaat al gewonnen heeft.

Dat zou namelijk betekenen dat je voor €500,- - €700,- een dijk van een PC die ook nog goed gestyled is en met top hardware onder je TV kan hebben staan.... Als je met die "Windows Mode" ook nog andere windows applicaties kan draaien, dan kan Sony helemaal inpakken (imho).....

Als ik Elite:Dangerous/Star Citizen/The Witcher 3 etc met mijn bestaande PC accounts kan spelen op de XSX dan staat er bij mij iig op launch date een XSX in de huiskamer (met een nieuwe LG 55CX6LA om het maximale eruit te halen), de Xbox Elite series 2 controller heb ik al (voor de PC), dus dat is mooi meegenomen.

Dat is dan ook het enige dat de XSX voor haar lijkt te pleiten. Het zou een prachtig platform zijn voor veel PC gamers en het vernietigd Nvidia haar mainstream markt voor een aantal jaar, maar het is dan niet echt een console meer. Het is een voordelige PC vervanger waar je geen toegang hebt tot de games die Playstation heeft. Daar zitten alleen pareltjes tussen die ik graag zelf zou willen spelen. Ik zie Microsoft alleen wel hun eigen Windows Store pushen en dat is het. Steam zie ik niet zo snel beschikbaar komen. Een heel andere kwestie is comptabiliteit van veel games met specifiek een XSX.zion schreef op zondag 31 mei 2020 @ 10:20:

[...]

Nouja, dat hangt er imho ongeveer 100% vanaf of deze rumour waarheid word:

https://www.ccn.com/xbox-...c-gaming-to-your-console/

Als (en dat is een hele grote ALS) ik op wat voor een manier dan ook mijn PC-library op de XSX kan spelen, dan denk ik dat de XSX bijvoorbaat al gewonnen heeft.

Dat zou namelijk betekenen dat je voor €500,- - €700,- een dijk van een PC die ook nog goed gestyled is en met top hardware onder je TV kan hebben staan.... Als je met die "Windows Mode" ook nog andere windows applicaties kan draaien, dan kan Sony helemaal inpakken (imho).....

Als ik Elite:Dangerous/Star Citizen/The Witcher 3 etc met mijn bestaande PC accounts kan spelen op de XSX dan staat er bij mij iig op launch date een XSX in de huiskamer (met een nieuwe LG 55CX6LA om het maximale eruit te halen), de Xbox Elite series 2 controller heb ik al (voor de PC), dus dat is mooi meegenomen.

De GPU zou om een "RDNA 1,5" gaan. Vooral erg groot en efficiënter dan RDNA 1. Maar de geruchten dat Sony heel erg diep in de ontwikkeling van RDNA zit, zijn al oud. Ook is wel duidelijk dat Sony meer gedaan lijkt te hebben met hun GPU dan Microsoft.

Moet ik ook maar eens gaan kijken. De laatste tijd ben ik echt met veel te veel bezig en deze staat ook al weken op de alarmerend lange lijst.Werelds schreef op zaterdag 30 mei 2020 @ 16:28:

[...]

De sprong gaat deze keer groter worden dan we in heel erg lange tijd hebben gezien.

Ik heb hem hier niet genoemd zien worden, maar Mark Cerny's presentatie over de PS5 is heerlijk om naar te kijken/luisteren. Hij is wat mij betreft echt één van de grootheden in de industrie en zijn presentaties zijn geweldig. En wat hij, z'n teams en AMD met de PS5 doen is fascinerend.

YouTube: The Road to PS5

Er zit een hoop verborgen goud in deze presentatie. Ik ben er sowieso al vrij zeker van dat Sony het gevecht al gewonnen heeft*. Belangrijker voor dit topic is echter de manier waarop ze met AMD samen werken en wat er precies in die GPU zit.

Als je een beetje tussen de regels door...luistert, dan valt op dat AMD en Sony bijzonder nauw samen lijken te werken. Er zijn een paar open deuren (primitive shaders komen terug), maar er zijn ook wat subtielere dingen: het hele I/O verhaal, de cache scrubbers, de audio. De techniek in de PS5 is op alle vlakken beter dan welke PC dan ook, behalve dan qua rauwe CPU core count. Dat doet er echter minder toe doordat alles zo nauw samen hangt. De PS4 was een solide product waar AMD liet zien dat ze de console bouwers konden geven wat ze wilden. Sony lijkt dat opgepikt te hebben en zich vol overgave in de samenwerking gestort te hebben. Ondanks het feit dat het weer een "PC" GPU architectuur met een "PC" CPU is, heeft de PS5 meer gemeen met de PS3 dan met de PS4.

Als ik het een beetje goed inschat, dan is RDNA2 geen puur AMD product, Sony heeft daar volgens mij meer invloed op gehad dan velen wellicht denken. Ze lijken heel erg op de balans gefocust te hebben, vandaar het lagere aantal CU's. Waar ik verder op hoop is dat enkele van de andere dingen ook beschikbaar komen voor PC's in één of andere vorm. Data rechtstreeks van een speciale (hoppa, marketing kans jongens: plak er maar een "gaming" stikker op) m.2 SSD over PCI-e 4 naar je GPU laden? Yes please. Een degelijke audio chip? Jammie. Stop het maar in de chipsets AMD, m'n 1700X kan het vast wel verdragen als ik hem vervang

* de concurrent mag dan wel anderhalve teraflop meer hebben, dat zegt niet veel. Het is lastiger om ze allemaal aan te spreken; en door de lagere kloksnelheid is de doorvoer elders (geo, rasterizer) ook lager. Het geheugen is ook niet evenredig op dezelfde snelheid aanspreekbaar. De I/O setup op de PS5 is ook een groot voordeel en de audio setup is voor PSVR2 bijzonder waardevol.

Maar aangezien de RDNA + Sony geruchten al uit 2018 stammen en de financiële positie van AMD de jaren ervoor en het leiderschap van Lisa Su die ook betrokken was bij de Cell CPU in de PS3, vermoed ik eigenlijk dat RDNA2 wel eens een samenwerkingsproject kan zijn geweest en RDNA 1 meer een "prototype" om zaken te testen en drivers te ontwikkelen. Dat laatste, echt AMD, gewoon een 120mm tank projectiel door je voet.

Ergens denk ik namelijk dat AdoredTV gewoon de correcte informatie heeft gekregen over Navi 10, 12 en 14. Nu is Navi 12 een geval MIA, terwijl dat juist de 40CU versie zou zijn. Ik vermoed dat Navi 10 oorspronkelijk de 56CU versie was en AMD inderdaad tegen clock speed problemen is aangelopen en die heeft geannuleerd. Dat kon ook omdat Turing zo'n miserabele standaard heeft neergezet. De mainstream Navi 12 overclocken en nu Navi 10 noemen, was voldoende.

Ik vraag me alleen toch af hoe snel die SSD van de PS5, volledig aangesproken zal worden. Ze zullen meer moeten doen dan zeer hoge resolutie textures inladen. Audio zou al een deel kunnen verklaren. Een SSD op de GPU zie ik ook wel gebeuren. Misschien niet voor RDNA2, maar RDNA3 misschien al wel. Ik denkt toch dat AMD haar gehele platform complementair zal maken voor PC gaming en niet meer de som van de onderdelen samenstellen die toevallig goed werken. Een Zen 2/3 etc met een serieuze 4.0 NVME en een RDNA2/3 die de extra bandbreedte van 4.0 kan benutten, speciale audiochip en de B en X chipsets optimaliseren voor gaming I/O vereisten. Dat zou wel eens de motivering achter B550 kunnen zijn en waarom ze die splitsing door wenste te voeren. Het was ze ook gelukt als de marketing afdeling niet de boel had gesaboteerd. Kwam er gisteren ook nog "Warhol" op de radar, wat een tweede generatie Zen 3 op 7nm zou zijn. Het zou goed kunnen dat AM4 dus blijft voor 2021. Tja, zonder de marketing types die werkelijk alles moeten verprutsen daar, had je AM4+ kunnen introduceren met de 500 series als het ultieme gaming platform...

Ik ben me eigenlijk al maanden aan het voorbereiden op de realisatie dat het goed zou kunnen dat je RDNA3 niet goed gaat halen met maar een RX5700XT. Beetje dramatisch, ik weet het, maar ik ben ook niet onder de indruk van Navi 10 en ik denk dat zwakker dan een console in je PC, simpelweg geen goede basis is voor langdurig gebruik. Overclockte mainstream chip en meer is het niet. Het was dat ik mijn blower Vega had gesloopt met een te heet geworden HBM2 chip. De spreekwoordelijke druppel was die 50% perf/watt die RDNA2 gaat brengen. Dan weet je het eigenlijk al. Over de hele stack verwachte ik enige DXR ondersteuning, serieuze verbeteringen in clockspeed en waarschijnlijk snellere GDDR6 alsmede een verbetering in efficiënt gebruik van de beschikbare GB/s. Daar lijkt RDNA1 namelijk nog een beetje op GCN. Beter, maar de RX5700XT loopt al beetje tegen een muur aan met "maar" 448GB/s.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik raad je aan de video eens te bekijken en dan je eigen opmerking te lezenDaniëlWW2 schreef op zondag 31 mei 2020 @ 14:38:

Ik vraag me alleen toch af hoe snel die SSD van de PS5, volledig aangesproken zal worden. Ze zullen meer moeten doen dan zeer hoge resolutie textures inladen. Audio zou al een deel kunnen verklaren. Een SSD op de GPU zie ik ook wel gebeuren

Het gaat ook niet enkel om de SSD. Vergeet niet dat ook primitive/mesh shaders een ding worden, waarbij je minder aan LOD hoeft te sleutelen en de output rechtstreeks naar de rasterizer gaat. Textures zijn het slechtste voorbeeld, het gaat om poly's. Ik denk niet dat het lang duurt eer devs die 5,5 GB/s (of 8-9 met compressie) vrij aardig vol kunnen stouwen

Ik weet het, ik ga het zo proberen, maar ik ben echt met te veel dingen bezig de laatste tijd.Werelds schreef op zondag 31 mei 2020 @ 14:44:

[...]

Ik raad je aan de video eens te bekijken en dan je eigen opmerking te lezen

Het gaat ook niet enkel om de SSD. Vergeet niet dat ook primitive/mesh shaders een ding worden, waarbij je minder aan LOD hoeft te sleutelen en de output rechtstreeks naar de rasterizer gaat. Textures zijn het slechtste voorbeeld, het gaat om poly's. Ik denk niet dat het lang duurt eer devs die 5,5 GB/s (of 8-9 met compressie) vrij aardig vol kunnen stouwen

Behalve de politieke discussies hier want mod, zelf bijhouden voor de kennisbasis, eigen interesses die behoorlijk breed lopen, dan ook nog eens GPU's en CPU's`, verkapte mantelzorg voor mijn moeder, de kansloze missie om ooit een baan op mijn niveau te gaan vinden want ik moest zo nodig geschiedenis studeren en oh, probeer ook een voorstel voor een proefschrift te schrijven wat stroef gaat en zeer complex begint te worden. Give me a pass please.

[ Voor 4% gewijzigd door DaniëlWW2 op 31-05-2020 15:16 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Het zijn ook niet alleen textures maar zoals Werelds al zegt minder aan LODs hoeven sleutelen is erg interessant. Als je miljoenen vertices hebt dan kost dat ook veel schijfruimte.DaniëlWW2 schreef op zondag 31 mei 2020 @ 14:51:

[...]

Ik weet het, ik ga het zo proberen, maar ik ben echt met te veel dingen bezig de laatste tijd.

Behalve de politieke discussies hier want mod, zelf bijhouden voor de kennisbasis, eigen interesses die behoorlijk breed lopen, dan ook nog eens GPU's en CPU's`, verkapte mantelzorg voor mijn moeder, de kansloze missie om ooit een baan op mijn niveau te gaan vinden want ik moest zo nodig geschiedenis studeren en oh, probeer ook een voorstel voor een proefschrift te schrijven wat stroef gaat en zeer complex begint te worden. Give me a pass please.

Ik heb eindelijk maar eens wat tijd gemaakt en gekeken. Wauw AMD en Sony.Sp3ci3s8472 schreef op zondag 31 mei 2020 @ 17:00:

[...]

Het zijn ook niet alleen textures maar zoals Werelds al zegt minder aan LODs hoeven sleutelen is erg interessant. Als je miljoenen vertices hebt dan kost dat ook veel schijfruimte.

Alleen de I/O al met meerdere gespecialiseerde processoren om die SSD te voeden, cache gebruik te optimaliseren etc. De CPU cores zijn los voor gaming en system OS, cache gaat veel minder een bottleneck opwerpen en dat scheelt natuurlijk weer heel wat geheugenbandbreedte op de GPU. Aan de CPU kant zal RAM minder snel nodig zijn vanwege de extreem snelle SSD.

:strip_exif()/f/image/DfFHpt2hP45LTkmTxBKYpKbr.jpg?f=fotoalbum_large)

Ik wil dit.

No way dat AMD dit allemaal voor Sony heeft ontwikkeld en het allemaal Sony exclusief gaat blijven over de tijdspanne van een console generatie. Het zal niet allemaal meteen op PC gaming komen, maar het gaat komen. Dit is een potentiële knock out blow in PC gaming als die coprosessoren gezamenlijk echt iets van tien Zen 2 cores schelen en zulke SSD's ondersteunen die zeer hoge resolutie textures, audio, ray tracing, laadtijden, gamewerelden die we nu voor onmogelijk achten, opeens is het er.

Bouw het AM5 socket hierom met zo'n I/O chip die PCI-E 5.0 SSD's combineert met coprocessoren op een I/O die. Of ga RDNA2/3 GPU's uitrusten met zo'n I/O chip en een 4.0 SSD waarmee je het meeste van de PS5 waarschijnlijk al reproduceert.

Ook goed om te horen hoe AMD nu ray tracing gaat doen, want dit zou hetzelfde moeten zijn als in de PS5.

Er zit dedicated hardware in elke CU die de intersection engine heet. Deze berekent de kruisingspunten van rays met primitives. De informatie komt uit cache en terwijl de rest van de ALU's de geometrie berekeningen doet, checkt deze IE de light bounces. Uiteraard zeer geheugenintensief waardoor al se suggestie viel om het te combineren met logic i.p.v geometrie.

Qua ray tracing zou iets van een miljoen rays afdoende zijn voor spectaculaire audio. Iets meer zou global illumination doen. Enkele honderden miljoenen is nodig voor schaduwen of zeker reflections. Kennelijk is er al een interne demo die dat kan met weinig impact. Dit lijkt dus geen zwakke RT te zijn aangezien de PS5 GPU, 36CU's heeft met elk een IE. De befaamde Big Navi zou dus wat moeten kunnen.

Ze lijken dus een dedicated unit ervoor te hebben i.p.v een relatief zwakke RT unit en heel wat denoising met tensorcores, wat vervolgens ten koste gaat van geometrie, namelijk FP16. Verder lijkt Turing niet in staat te zijn om alle geometrie te blijven berekenen op volle snelheid als RT word gebruikt. Dat zou voor RDNA2 hopelijk minder zijn omdat een RDNA CU, veel meer typen berekeningen kan uitvoeren en je waarschijnlijk handig gebruik kan maken van de wave que om eerst geometrie waves te berekenen en dan physics en RT voor de frame.

AMD Smartshift zit dus ook in de PS5 om die 2,23GHz te halen op de GPU.

3D Audio dan onder Tempest. Tja, is dit niet een nieuwe implementatie van de TrueAudio technologie wat al op Haiwaii zat? Dat was nog een ASIC waar vrijwel niks mee is gedaan. TrueAudio next was CU based en nu gaan we weer terug naar TrueAudio? Daar wordt een beetje op gehint omdat het zou draaien op een ASIC die gebaseerd is op een AMD CU.

Alles bij elkaar lijkt Sony perfect te begrijpen wat developers en gamers willen, wat ze nodig hebben en hebben ze met AMD al die stappen afgewerkt. Indrukwekkend gaat die PS5 zeker worden.

En nu weer terug naar (onnodig) complexe theorievorming over het militair-industrieelcomplex.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Was het bijna vergeten @Sp3ci3s8472 maar dit is de demo waar ik het over had: http://www.humus.name/index.php?page=3D&ID=93

Dus de laatste dagen duikt "Sienna Cichlid" opeens op.

[Twitter: https://twitter.com/KOMACHI_ENSAKA/status/1267537045318033409]

Het is alleen de vraag of dit echt is of nep of toch niet...

https://i.imgur.com/Q9p4dqy.jpg

edit: Nee, zou een user made samenvatting van gelekte onderdelen uit code zijn.

Als ik het goed interpreteer dan is dit een "shader engine", hoewel dat waarschijnlijk ook gaat veranderen. AMD zou floating points en integer op deze manier gaan splitsen in aparte pijplijnen. Zo blijft er weinig niks meer over van RDNA1, laat staan GCN.

[Twitter: https://twitter.com/KOMACHI_ENSAKA/status/1267537045318033409]

Het is alleen de vraag of dit echt is of nep of toch niet...

https://i.imgur.com/Q9p4dqy.jpg

edit: Nee, zou een user made samenvatting van gelekte onderdelen uit code zijn.

Als ik het goed interpreteer dan is dit een "shader engine", hoewel dat waarschijnlijk ook gaat veranderen. AMD zou floating points en integer op deze manier gaan splitsen in aparte pijplijnen. Zo blijft er weinig niks meer over van RDNA1, laat staan GCN.

[ Voor 9% gewijzigd door DaniëlWW2 op 02-06-2020 20:53 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Tech demo's van Humus, dat is even een trip down memory lane zeg! Tof om te zien dat hij nog steeds demo's maakt!Werelds schreef op maandag 1 juni 2020 @ 09:14:

Was het bijna vergeten @Sp3ci3s8472 maar dit is de demo waar ik het over had: http://www.humus.name/index.php?page=3D&ID=93

Ik vind de slide er erg nep uitzien, maar ik kan het fout hebben.DaniëlWW2 schreef op dinsdag 2 juni 2020 @ 13:56:

Dus de laatste dagen duikt "Sienna Cichlid" opeens op.

[Twitter]

Het is alleen de vraag of dit echt is of nep of toch niet...

[Afbeelding]

Als ik het goed interpreteer dan is dit een "shader engine", hoewel dat waarschijnlijk ook gaat veranderen. AMD zou floating points en integer op deze manier gaan splitsen in aparte pijplijnen. Zo blijft er weinig niks meer over van RDNA1, laat staan GCN.

Het is misschien niet zozeer nep, maar ook niet van AMD nee. Zie edit.Sp3ci3s8472 schreef op dinsdag 2 juni 2020 @ 19:55:

[...]

Ik vind de slide er erg nep uitzien, maar ik kan het fout hebben.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

http://www.radgametools.com/oodle.htmDaniëlWW2 schreef op zondag 31 mei 2020 @ 19:09:

[...]

Het zal niet allemaal meteen op PC gaming komen, maar het gaat komen.

Niet realistisch om te verwachten dat iedereen deze software gaat kopen voor z'n pc. Overigens zullen die gasten wel flink hebben gecashed in deze deal.

Verder gaat DMA op een open systeem niet werken. Er is nu al genoeg drama over DMA (zie ook Thunderbolt, Firewire, ...).

[ Voor 14% gewijzigd door Paprika op 02-06-2020 23:46 ]

Heb een beetje hier en daar gelezen en weten jullie nog dat ik bij de Vega FE op de PCB een connector kon solderen voor een bepaald slot.

Volgens mij was dit pcb een test vehicle voor de PS5/XBOX, zodoende dat de ssd direct kon aangesproken worden door de gpu en dus een veel grotere band breedte naar de ssd kan gelegd worden zonder eerst langs de cpu te passeren.

Klinkt dit aannemelijk of eerder #mooshit

@DaniëlWW2 euhm tja

Volgens mij was dit pcb een test vehicle voor de PS5/XBOX, zodoende dat de ssd direct kon aangesproken worden door de gpu en dus een veel grotere band breedte naar de ssd kan gelegd worden zonder eerst langs de cpu te passeren.

Klinkt dit aannemelijk of eerder #mooshit

@DaniëlWW2 euhm tja

[ Voor 3% gewijzigd door Damic op 03-06-2020 21:11 ]

Al wat ik aanraak werk niet meer zoals het hoort. Damic houd niet van zijn verjaardag

Eindelijk echt nieuws.

-Big Navi komt als eerste RDNA2 en komt voor de consoles.

-Het is een halo product voor enthusiasts.

-RDNA2 is een volledige stack van mainstream tot halo.

https://www.pcgamer.com/amd-big-navi-first-rdna-product/

AMD gaat:

-Nooit meer competitief worden in CPU land.

-Ryzen gaat nooit een succes worden.

-Gaat nooit inlopen op Nvidia.

Een DMA zou op de GPU zitten. AMD heeft toch echt al eens een GPU (Vega) uitgebracht met een NVME erop en aan zoiets zou ik hier ook denken. Het ging denk ik zeker niet voor niks over de verbinding tussen de GPU en de PS5 NVME en het ontlasten van RAM en de CPU voor andere taken.

-Big Navi komt als eerste RDNA2 en komt voor de consoles.

-Het is een halo product voor enthusiasts.

-RDNA2 is een volledige stack van mainstream tot halo.

https://www.pcgamer.com/amd-big-navi-first-rdna-product/

Kraken is game developer niveau. Ze gebruiken het kennelijk voor games op consoles die werken met beperkte ruimte en de nadelen van een HDD. Ik zie niet in waarom je dit als individu zou moeten kopen? Ze gaan dit niet gebruiken als dat zou moeten.Paprika schreef op dinsdag 2 juni 2020 @ 23:42:

[...]

http://www.radgametools.com/oodle.htm

Niet realistisch om te verwachten dat iedereen deze software gaat kopen voor z'n pc. Overigens zullen die gasten wel flink hebben gecashed in deze deal.

Dit ga ik scharen onder de noemer van:Verder gaat DMA op een open systeem niet werken. Er is nu al genoeg drama over DMA (zie ook Thunderbolt, Firewire, ...).

AMD gaat:

-Nooit meer competitief worden in CPU land.

-Ryzen gaat nooit een succes worden.

-Gaat nooit inlopen op Nvidia.

Een DMA zou op de GPU zitten. AMD heeft toch echt al eens een GPU (Vega) uitgebracht met een NVME erop en aan zoiets zou ik hier ook denken. Het ging denk ik zeker niet voor niks over de verbinding tussen de GPU en de PS5 NVME en het ontlasten van RAM en de CPU voor andere taken.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Bedoel je dat Sony RDNA 1,5 heeft ipv van RDNA2 ? of dat XSX juist RDNA 1.5 heeft ?DaniëlWW2 schreef op zondag 31 mei 2020 @ 14:38:

De GPU zou om een "RDNA 1,5" gaan. Vooral erg groot en efficiënter dan RDNA 1. Maar de geruchten dat Sony heel erg diep in de ontwikkeling van RDNA zit, zijn al oud. Ook is wel duidelijk dat Sony meer gedaan lijkt te hebben met hun GPU dan Microsoft.

Moet ik ook maar eens gaan kijken. De laatste tijd ben ik echt met veel te veel bezig en deze staat ook al weken op de alarmerend lange lijst.

Maar aangezien de RDNA + Sony geruchten al uit 2018 stammen en de financiële positie van AMD de jaren ervoor en het leiderschap van Lisa Su die ook betrokken was bij de Cell CPU in de PS3, vermoed ik eigenlijk dat RDNA2 wel eens een samenwerkingsproject kan zijn geweest en RDNA 1 meer een "prototype" om zaken te testen en drivers te ontwikkelen. Dat laatste, echt AMD, gewoon een 120mm tank projectiel door je voet.