Een format (niet quick format) is al voldoende. Iemand heeft ooit eens bedacht dat er eind jaren 90 er een theoretische mogelijkheid was om met een electron tunnelling microscoop de vorige waarde van een bitje te kunnen achterhalen, na een format dus. Met moderne schijven is dat nog maar de vraag of dat kan. Bovendien heb je er een behoorlijk laboratorium voor nodig. Apparatuur kost miljoenen en om op deze manier een HD te analyseren ben je denk ik wel een paar jaar bezig. Anyhow dat is de achtergrond van al die secure erase tooltjes die meermaals hetzelfde bitje overschrijven. Mijn inziens volkomen nonsens.Videopac schreef op zondag 3 november 2019 @ 10:21:

Nu ik mijn back-up gebeuren zo goed als op orde heb kan mijn DS211 met hdd's en al de deur uit. Alleen: hoe verwijder ik op een goede manier alle data van de schijven? Ik heb geen desktop waar ik de schijven in kan hangen om het van daar uit te regelen.

Ik ben even zoekende.

Momenteel heb ik:

- - Synology DS212 met DSM 6.2.2-24922

- - 2x Samsung Ecogreen HD154UI pricewatch: Samsung EcoGreen F2 EG HD154UI, 1,5TB

- - SHR Raid type dus 1,4TB beschikbaar (fouttolerantie voor 1 schijf maar dat hoef ik hier niet uit te leggen denk ik zo.

Ik heb Gigabit en mijn wireless (laptop) zit ruim boven de 500Mbit (speedtest gaat niet sneller dan 250Mbit)

Mijn vragen:

- Hoe haal ik betere snelheden?

- Mijn Samsungs zouden zo rond de 80MB/s moeten kunnen lezen en schrijven.

- Is het de harde schijf die de limiet is? Heeft het zin 2x SSD 2TB te plaatsen? (kost flink meer)

- Of is het ook mogelijk een WD red erin te zetten?

- Of is de DS212 met 1.6Ghz te zwak?

- SMB3 geactiveerd op zowel Synology als Windows 10 PC

- Maximum SMB3 en minimum 2 ingesteld op Synology

- Transportcoderingsmodus uitschakelen (ging opeens nog maar 22MB/S)

[ Voor 16% gewijzigd door ApC_IcE op 03-11-2019 15:06 ]

Je Synology met gigabit aansluiten is leuk (en vind ik persoonlijk ook een must), maar de wifiverbinding met je laptop is de bottleneck.

Een wifisnelheid van 500 Mbps is erg snel. Weet je zeker dat je dat haalt?

Dan nog: 500 Mbps is ongeveer 50 MBps.

Ik denk dat er niks aan de hand is, maar dat je wifi niet zo snel is als je denkt.

Ik heb nu een 718+ in gebruik als data-opslag station/calendar-station/mail-station waarop met 5 mensen wordt gewerkt.

Stel dat ik nog een 718+ aanschaf en die bijvoorbeeld inzet als dedicated backup server. Kan ik dan bij een defect (hardware van de server zelf, dus niet de HDD's) aan de eerste 718+ de schijven van de twee verwisselen, zodat er direct (weinig tot geen downtime is van belang) weer gewerkt kan worden op de server die de schijven van de defecte DS heeft ontvangen? Ik ken de migratiemogelijkheden en het terugzetten van backups, dat heb ik ook allemaal geregeld (via een off-site backup op een 218+ en een on-site backup op een 216Play, met daarbij een cloudstation share-sync).

Ik hoop echter dat bij wisseling van de volledige server de downtime nog lager kan zijn.

Dank. Na het verwijderen van alle gedeelde mappen is hij nu bezig met de eerste schijf. De verwachting is dat het circa 5,5 uur duurt...Vorkie schreef op zondag 3 november 2019 @ 10:43:

[...]

https://www.synology.com/...p/DSM/StorageManager/disk

[...]

Weet alleen niet of die optie er op zit

* Uitsluitend beschikbaar op specifieke modellen.

Asustor AS6704T (32GB, 4x16TB MG08), OpenWrt (3x GL.iNet Flint 2 MT6000), Lyrion Media Server, Odroid H2/N2+/C4/C2, DS918+ (4x8TB WD RED)

Op eventuele licenties na, geen enkel probleem. Zelfs als het model anders* is kan je DSM met behoud van ALLE instellingen opnieuw installeren.JdM schreef op zondag 3 november 2019 @ 15:42:

Voor de kenners hier heb ik een vraag over de mogelijkheden met betrekking tot het uitwisselen van een Diskstation bij een defect.

* moet wel een beetje in dezelfde categorie vallen qua specs en voor CPU gerelateerde limitaties (BTRFS).

Dat geld niet voor SSD's, behalve dat je onnodig slijtage veroorzaakt met een full format heb je nog een ander probleem. Om de cellen gelijkmatig te laten slijten beslist de SSD zelf naar waar hij iets gaat schrijven. Als je dus software een format of erase laat doen dan gaat die op een SSD van 240GB bij 1 pass 240GB wegschrijven.HEY_DUDE schreef op zondag 3 november 2019 @ 12:05:

[...]

Een format (niet quick format) is al voldoende. Iemand heeft ooit eens bedacht dat er eind jaren 90 er een theoretische mogelijkheid was om met een electron tunnelling microscoop de vorige waarde van een bitje te kunnen achterhalen, na een format dus. Met moderne schijven is dat nog maar de vraag of dat kan. Bovendien heb je er een behoorlijk laboratorium voor nodig. Apparatuur kost miljoenen en om op deze manier een HD te analyseren ben je denk ik wel een paar jaar bezig. Anyhow dat is de achtergrond van al die secure erase tooltjes die meermaals hetzelfde bitje overschrijven. Mijn inziens volkomen nonsens.

Bij een HD is dat geen issue, die ga je volledig overschrijven maar bij een SSD heb je geen flauw idee, kan goed zijn dat het ding beslist cel X 5 keer te gebruiken omdat die de laatste tijd geen actie heeft gehad. Maar dat wilt ook zeggen dat er cellen zijn die hij niet gebruikt.

Dat kan je gaan oplossen door niet enkel random data weg te schrijven maar ze ook te markeren in een bestandsysteem zodat de SSD verplicht is om al zijn cellen vol te schrijven, een gewone format zal dit niet doen, immers dan is je disk "full" na je format.

Maar dan zit je ook nog met static wear leveling wat inhoud dat je SSD data naar andere cellen zet on the fly. Dat word gedaan om cellen te kunnen gebruiken die anders niet belast worden omdat ze altijd dezelfde data bevatten (zoals die Windows install toen je hem kocht).

Dat is ook de reden dat SSD's sneller slijten als ze (bijna) vol staan, dan heeft hij onvoldoende lege cellen om data naar te verplaatsen en is hij verplicht continu dezelfde cellen te gebruiken. Dat ze traag worden is omdat cellen leeg moeten zijn voor ze geschreven kunnen worden.

De software heeft dus niet enkel geen flauw idee welke cel hij aan het schrijven is, de data word dan ook nog eens continu verplaatst. En dan heb je nog controllers die door hebben dat ze een reeks nullen moeten schrijven en beslissen om in de cel gewoon te zetten, deze cel en de volgende 50 staan vol met 0 in plaats van ze effectief te schrijven, minder writes is minder slijtage.

En dan is er nog een probleem, reserve cellen waar je softwarematig niet bij geraakt, met name Enterprise gerichte SSD's hebben veel reserve zitten, soms 25% en het is dan maar de vraag of de controller die reserve enkel aanspreekt als er effectief een cel defect is of dat hij ze ook af en toe gebruikt.

Zelfs meerdere passes op een SSD is dus geen garantie, meer zelfs, klassiek formateren of wipen is gewoon ronduit onbetrouwbaar als je echt alle data weg moet hebben. (naast dat het slecht is voor je SSD)

Om deze redenen hebben SSD's een optie Secure Erase, te vinden in de BIOS/UEFI of in SSD tools van de fabrikant. Dan word via de firmware/controller de opdracht gegeven dat de disk leeg moet (bestaat ook bij klassieke HD's).

Dan is het de vraag wat er dan gebeurd, een klassieke HD die deze command ondersteund zal zichzelf volschrijven met 0 of 1 maar een SSD niet vanwege de slijtage. Wat er gebeurd hangt af hoe de fabrikant het ingesteld heeft.

optie 1 (worstcase): SSD gooit zijn file systeem weg en doet eigenlijk een quick format. (secure-erase)

optie 2 (beter): SSD is self encrypted en het wist zijn keys waardoor de data niet meer te ontsleutelen is. (crypto-erase)

optie 3 (preferred): SSD stuurt een hoog voltage naar zijn cellen om ze te wissen. Een cel van een SSD kan je niet overschrijven, een cel word altijd gereset voor er nieuwe data op komt maar in dit geval word er geen data naar toe geschreven. Gezien de SSD dit zelf doet ben je zeker dat je alle (reserve) cellen meehebt. (Block-erase)

Optie 2 is het snelst gevolgd door 1 gevolgd door 3 maar gezien 3 parallel gebeurd is het nog altijd veel sneller dan een write pass op een klassieke HD.

In de laatste standaarden zijn dit ook 3 aparte commando's in plaats van het enkel commando secure erase zodat je ook weet wat het ding effectief doet. Het kan ook zijn dat een SSD zowel command secure-erase als block-erase slikt maar dat het toch altijd een block-erase doet. Maar vaak staat er gewoon een secure erase in het tooltje zonder enige uitleg welke command gegeven word of welke actie de SSD effectief gaat doen.

Na te gaan bij de fabrikant dus.

Enkel nieuwe data naar elke sector op de disk wegschrijven zorgt er voor dat alles echt weg is.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Dank voor je antwoord.ikweethetbeter schreef op zondag 3 november 2019 @ 15:32:

@ApC_IcE

Je Synology met gigabit aansluiten is leuk (en vind ik persoonlijk ook een must), maar de wifiverbinding met je laptop is de bottleneck.

Een wifisnelheid van 500 Mbps is erg snel. Weet je zeker dat je dat haalt?

Dan nog: 500 Mbps is ongeveer 50 MBps.

Ik denk dat er niks aan de hand is, maar dat je wifi niet zo snel is als je denkt.

Wifi klopt wel. Ik heb zelf de AC chip vervangen. Met laptop naar andere pc (dus over draadloos) haal ik zo rond de 60-65 MB/s Dus dat klopt aardig. Natuurlijk zakt ie af en toe in en ligt het aan waar ik sta in huis.

Ik heb op deze laptop geen utp aansluiting en zal dat eens testen.

Vanaf de vaste pc heb ik geen toegang tot de NAS en wil ik ook niet (game pc). Maar zal dat straks even troubleshooten.

Dat is ook niet helemaal waar, enkel de index verwijderen is een quick format en dat is het inderdaad enkel de index terug opbouwen en het is alsof er nooit iets gebeurd is. (voor NTFS is hetzelfs gewoon de backup opzoeken en deze terug zetten)Ben(V) schreef op zondag 3 november 2019 @ 22:59:

Blijkbaar weet @HEY_DUDE niet dat formatteren niets anders doet dan wat indexen op de disk aanpassen en dat het met de juiste software het heel simpel is om de oude data weer terug te halen.

Enkel nieuwe data naar elke sector op de disk wegschrijven zorgt er voor dat alles echt weg is.

Een quick format kan je niet doen op een nieuwe disk of als je

Een gewone format zal de disk volledig bekijken op errors en de disk onderverdelen in clusters. Dat laatste zal data beschadigen maar vaak kan je nog heel veel terug halen.

Maar het kan ook zijn dat een format effectief iedere sector gaat beschrijven. XP niet, Vista/7 indien je de paramater /P:X meegeeft waarbij X staat voor het aantal passes. 8/10 doet minstens 1 pass ook al is parameter /P niet gebruikt.

Hoe het bij Linux zit, geen idee. Voor de Synology (Linux), die stuurt een secure erase command naar de disk maar hoe het algemeen zit onder Linux durf ik niet zeggen.

En op Ntfs zal bij een normale backup gewoon de al bestaande structuur hergebruikt worden (net als bij quick format) het enige verschil is dat de normale format de ketenstructuur doorloopt en checked of die nog intact is.

Dus in beide gevallen wordt er helemaal niets aan de data gedaan en is die prima met de juiste software te recoveren.

Op windows kun je sdelete van sysinternals gebruiken om de data echt te wissen.

https://docs.microsoft.co...ternals/downloads/sdelete

Op een Synology kun je secure erase vanuit de storage manager gebruiken.

Uiteraard moet wel eerst het volume verwijderd worden.

Onder water wordt daarvoor het dd commando gevrukt die random data naar alle clusters schrijft.

zoiets dus;

dd if=/dev/urandom of=/dev/sdX bs=1M *replace X with the target drive letter.

[ Voor 13% gewijzigd door Ben(V) op 04-11-2019 14:10 ]

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Een format op NTFS pre Windows 8 of zonder optie /P onder vista/7 zal indien er NTFS aanwezig is en indien de clustersize onveranderd is inderdaad de data 100% onbeschadigd achter laten.

Wat betreft Sdelete, als je dan toch op een command prompt zit zie ik de noodzaak niet (meer) om Sdelete te gaan gebruiken tenzij je een file of folder wilt aanpakken.

sdelete -p 7 c:

format c: /fs:NTFS /p:7

Voordeel van de format is dat hij meteen klaar voor gebruik is. Voor windows 8/10 zal deze commando in 8 passes resulteren gezien de standaard pass.

Dus format c: /fs:NTFS is eigenlijk voldoende vanaf Win8 voor een roterende disk.

Goed punt. Voor een quick format geldt dat inderdaad. Een full format schrijft meestal de schijf wel vol met nullen. Hangt misschien wel af van je besturingssysteem.Ben(V) schreef op zondag 3 november 2019 @ 22:59:

Blijkbaar weet @HEY_DUDE niet dat formatteren niets anders doet dan wat indexen op de disk aanpassen en dat het met de juiste software het heel simpel is om de oude data weer terug te halen.

Enkel nieuwe data naar elke sector op de disk wegschrijven zorgt er voor dat alles echt weg is.

De meeste tutorials gaan over het overzetten van disks of via hyperbackup/migration

https://techthoughts.info/synology-diskstation-migration/

Synology heeft een migration assistant (beta package). Deze lijkt echter ook de volume structuur in z'n geheel mee te nemen. Ik wil echt alleen de data over zetten.

https://www.synology.com/...ogy_NAS_DSM_6_0_and_later

2.1 HDD Migration

2.2 Migration via Migration Assistant

2.3 Migration via Hyper Backup

Volgens mij kan ik via rsync een backup maken naar de target synology met alleen de data.

[ Voor 17% gewijzigd door Viper® op 04-11-2019 15:49 ]

dat kan. Pas RMA voor mijn rackstation gedaan en er kwam een zelfde typenummer maar ander refurbished exemplaar voor terug. Eerst de nieuwe server geconfigureerd met een tijdelijke disk. Daarna server uit en tijdelijke disk eruit. Disks uit de defecte server er in en zonder problemen weer online. Wanneer je weet wat je moet doen (ik moest eerst even googlen) ben je denk ik binnen 15 minuten weer online.JdM schreef op zondag 3 november 2019 @ 15:42:

Ik hoop echter dat bij wisseling van de volledige server de downtime nog lager kan zijn.

Even een voorbeeld.. Heb een 213+ staan en als ik kijk in het 'RAR unpacking performance' topic ([Synology] RAR unpacking performance) doet mijn type/soc ongeveer 1,14 minuut over 700 MB testbestand. Echter staat hij op een 3,5 GB bestand nu al zo'n 15 minuten+ te stampen. Dat zou dan toch sneller moeten kunnen ;P als ik zo naar CPU/RAM kijk, die worden niet 100% gebruikt volgens broncontrole tijdens het unrarren.

[ Voor 43% gewijzigd door Dirrukje op 04-11-2019 19:46 ]

hmmm je had toch gelijk.ikweethetbeter schreef op zondag 3 november 2019 @ 15:32:

@ApC_IcE

Je Synology met gigabit aansluiten is leuk (en vind ik persoonlijk ook een must), maar de wifiverbinding met je laptop is de bottleneck.

Een wifisnelheid van 500 Mbps is erg snel. Weet je zeker dat je dat haalt?

Dan nog: 500 Mbps is ongeveer 50 MBps.

Ik denk dat er niks aan de hand is, maar dat je wifi niet zo snel is als je denkt.

Met de vaste pc is het 65MB/s

Lezen is vrij lastig he?sprankel schreef op maandag 4 november 2019 @ 15:17:

Dat zou mij nu echt verwonderen dat je op Linux geen quick format kan doen, Linux laat meestal net veel meer opties toe dan Windows.

Een format op NTFS pre Windows 8 of zonder optie /P onder vista/7 zal indien er NTFS aanwezig is en indien de clustersize onveranderd is inderdaad de data 100% onbeschadigd achter laten.

Wat betreft Sdelete, als je dan toch op een command prompt zit zie ik de noodzaak niet (meer) om Sdelete te gaan gebruiken tenzij je een file of folder wilt aanpakken.

sdelete -p 7 c:

format c: /fs:NTFS /p:7

Voordeel van de format is dat hij meteen klaar voor gebruik is. Voor windows 8/10 zal deze commando in 8 passes resulteren gezien de standaard pass.

Dus format c: /fs:NTFS is eigenlijk voldoende vanaf Win8 voor een roterende disk.

"sdelete" schrijft random data (of nullen indien gewenst) naar de disk sectoren.

Een format herstelt enkel de index structuur van de disk en doet niets met de data sectoren.

Met de juiste software is alle data gewoon terug te halen.

En op Linux bestaat echt geen quick format, dat is ook niet nodig doordat het ex4t filesysteem gewoon heel anders in elkaar zit en dus veel sneller formateert dan ntfs.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

dat is onjuist. Een format herschrijft normaal elke sector. Alleen quick format overschrijft alleen de index. Het is wel zo dat een format die alleen nullen schrijft best wat leesbare data achterlaat. Vandaar een multipass erase.Ben(V) schreef op maandag 4 november 2019 @ 21:28:

Een format herstelt enkel de index structuur van de disk en doet niets met de data sectoren.

Waar is Jos de Nooyer toch gebleven?

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Het is gelukt met disk2, maar bij disk1 is SmartSecure Erase niet beschikbaar, wellicht omdat DSM erop staat? Kan ik DSM ook op een USB stick zetten o.i.d of weet iemand hoe ik ook op disk1 smartSecure erase kan uitvoeren?kraades schreef op zondag 3 november 2019 @ 11:10:

Die optie is aanwezig. Ik heb dat eerder gedaan met een DS211.

[ Voor 3% gewijzigd door Videopac op 05-11-2019 13:46 ]

Asustor AS6704T (32GB, 4x16TB MG08), OpenWrt (3x GL.iNet Flint 2 MT6000), Lyrion Media Server, Odroid H2/N2+/C4/C2, DS918+ (4x8TB WD RED)

Ik ben blij dat je zelf inziet dat lezen nogal lastig gaat.Ben(V) schreef op maandag 4 november 2019 @ 21:28:

[...]

Lezen is vrij lastig he?

"sdelete" schrijft random data (of nullen indien gewenst) naar de disk sectoren.

Een format herstelt enkel de index structuur van de disk en doet niets met de data sectoren.

Met de juiste software is alle data gewoon terug te halen.

En op Linux bestaat echt geen quick format, dat is ook niet nodig doordat het ex4t filesysteem gewoon heel anders in elkaar zit en dus veel sneller formateert dan ntfs.

Speciaal voor jou ben ik het gaan opvragen bij Microsoft.

Aangepast in 8/10 en met KB941961 tot Vista aangepast (wist niet dat ze dat gepatcht hadden naar eerdere Windows versies, leer ik ook weer bij)

"The behavior of the format command changed in Windows Vista and later Windows versions. By default in Windows Vista and later versions, the format command writes zeros to the whole disk when a full format is performed. In Windows XP and earlier versions of Windows, the format command does not write zeros to the whole disk when a full format is performed."

KB941961

En indien je meer dan zeroes wilt of meerdere passes:

/p:count This format command option writes zeros to every sector of the drive: once. If you specify a count, a different random number will be written to the entire drive that many times after the zero writing is complete. You can not use the /p option with the /q option

Klopt. Ik heb het toen zo gedaan:Videopac schreef op dinsdag 5 november 2019 @ 10:38:

[...]

Het is gelukt met disk2, maar bij disk1 is SmartSecure Erase niet beschikbaar, wellicht omdat DSM erop staat? Kan ik DSM ook op een USB stick zetten o.i.d of weet iemand hoe ik ook op disk1 smartSecure erase kan uitvoeren?

kraades in "[Synology] Vraag en antwoord - deel 2"

Blijkbaar is mijn kennis verouderd, bedankt voor de update.sprankel schreef op dinsdag 5 november 2019 @ 11:37:

[...]

Ik ben blij dat je zelf inziet dat lezen nogal lastig gaat.

Speciaal voor jou ben ik het gaan opvragen bij Microsoft.

Aangepast in 8/10 en met KB941961 tot Vista aangepast (wist niet dat ze dat gepatcht hadden naar eerdere Windows versies, leer ik ook weer bij)

"The behavior of the format command changed in Windows Vista and later Windows versions. By default in Windows Vista and later versions, the format command writes zeros to the whole disk when a full format is performed. In Windows XP and earlier versions of Windows, the format command does not write zeros to the whole disk when a full format is performed."

KB941961

En indien je meer dan zeroes wilt of meerdere passes:

/p:count This format command option writes zeros to every sector of the drive: once. If you specify a count, a different random number will be written to the entire drive that many times after the zero writing is complete. You can not use the /p option with the /q option

Overigens gaat het hier uiteraard over Linux en niet over Windows en onder Linux doet een format nog veel minder dan een quick format onder windows.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Ik ben met disk 2 begonnen, maar als ik daarna met Synology Assistant (online) gebruik stuurt die me meteen door naar het IP adres van de NAS. Dus ik denk dat ik die eerste disk, die ik niet kan Smart erasen even los ga koppelen, dan DSM op disk 2 installeren en dan disk 1 weer aansluiten en smart erasen. Tenzij iemand een betere oplossing heeft, uiteraard.kraades schreef op donderdag 2 juli 2015 @ 08:02:

[...]

De disks werden bij mij niet gelocked dus ik heb het commando niet nodig gehad.

Wat ik heb gedaan:Secure erase van een (1) WD 2 TB disk duurde hier ongeveer 6-7 uur.

- Secure erase van disk 1

- Disk 2 kon ik hierna niet meer secure erasen (logisch)

- DSM opnieuw geinstalleerd met Synology Assistant

- Secure erase van disk 2

- Hierna opnieuw een disk group en volume gemaakt

Asustor AS6704T (32GB, 4x16TB MG08), OpenWrt (3x GL.iNet Flint 2 MT6000), Lyrion Media Server, Odroid H2/N2+/C4/C2, DS918+ (4x8TB WD RED)

Geen reactie gehad, en wellicht ook logisch.. Want na wat verder onderzoek werd me duidelijk dat het niet om RAM gaat maar om CPU en dat de disk wel eens de bottleneck zou kunnen zijn. Eerst maar eens even gekeken naar de lees/schrijf snelheden die gehaald worden. Beide zitten op dit moment tijdens het unrarren op 5 MB/s. Het gaat om een WD RED 3 TB..Dirrukje schreef op maandag 4 november 2019 @ 19:35:

Vraagje: Zou NZBGet bij het unrarren niet alle available RAM moeten gebruiken tbv het uitpakken? Zie bij het uitpakken de RAM eigenlijk op 20-30% hangen. Als ik in broncontrole kijk zie ik wel dat het overgrote merendeel 'in cache zit'.. en dus niet echt vrij zou zijn. Hoe zit dat precies?

Even een voorbeeld.. Heb een 213+ staan en als ik kijk in het 'RAR unpacking performance' topic ([Synology] RAR unpacking performance) doet mijn type/soc ongeveer 1,14 minuut over 700 MB testbestand. Echter staat hij op een 3,5 GB bestand nu al zo'n 15 minuten+ te stampen. Dat zou dan toch sneller moeten kunnen ;P als ik zo naar CPU/RAM kijk, die worden niet 100% gebruikt volgens broncontrole tijdens het unrarren.

Snap dat het 1 schijf is en dat het uitvoeren van de 2 acties op dezelfde schijf al een bottleneck is.. En dat ook de cache bijzonder laag te noemen is met 64MB. Maar is dan 5MB/s schrijf/lees het maximaal haalbare en moet ik dat accepteren, of zou het hoger moeten kunnen en speelt er iets anders mee?

[ Voor 11% gewijzigd door Dirrukje op 06-11-2019 18:38 ]

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Als de applicatie slechts 1 core aanspreekt van een duo core klopt 50%Dirrukje schreef op donderdag 7 november 2019 @ 08:20:

CPU hangt op +/- 50% tijdens unrar, dat zou dan toch hoger moeten zijn?

De unpar software is niet multithreaded, dus gebruikt hij maar een core van die cpu zoals al door @stormfly opgemerkt was.

Een disk in een Synology Nas haalt snelheden van boven de 100 MB/s dus het is echt niet de disk bottleneck.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Dirrukje schreef op maandag 4 november 2019 @ 19:35:

Even een voorbeeld.. Heb een 213+ staan en als ik kijk in het 'RAR unpacking performance' topic ([Synology] RAR unpacking performance) doet mijn type/soc ongeveer 1,14 minuut over 700 MB testbestand. Echter staat hij op een 3,5 GB bestand nu al zo'n 15 minuten+ te stampen. Dat zou dan toch sneller moeten kunnen ;P als ik zo naar CPU/RAM kijk, die worden niet 100% gebruikt volgens broncontrole tijdens het unrarren.

Voor zover ik weet was die 1:14 minuten voor (nog) oudere versies van unrar.Dirrukje schreef op woensdag 6 november 2019 @ 18:15:

Het gaat om een WD RED 3 TB..

Snap dat het 1 schijf is en dat het uitvoeren van de 2 acties op dezelfde schijf al een bottleneck is.. En dat ook de cache bijzonder laag te noemen is met 64MB. Maar is dan 5MB/s schrijf/lees het maximaal haalbare en moet ik dat accepteren, of zou het hoger moeten kunnen en speelt er iets anders mee?

Ik heb zelf een jaar later met de DS213+ een uitpaksnelheid van 41 seconden gehaald. (ook op 3TB WD Red schijven)

Dit komt neer op gemiddeld bijna 17MB/s. Inderdaad single core, dus max 50% (totale) CPU belasting.

In de praktijk ging uitpakken in SABnzbd+ met 35 MB/s.

Inmiddels zijn we wss al weer 5 jaar verder.

Het kan goed zijn dat de mate van compressie van jouw 3,5GB bestand natuurlijk een stuk hoger/sterker is dan dat testbestand van de RAR benchmark. Waardoor uitpakken, helemaal op oudere CPU's, een stuk meer tijd kost.

Delidded 4770K 4.7GHz @ H220 || Gigabyte Z87X-UD4H || 16GB @ 2400MHz || Gigabyte GTX 760 || 2x128GB Samsung 830 @ RAID-0 & WD 3 TB || Iiyama XB2483HSU-B1 || Synology DS916+ 3x6TB + 120GB SSD Cache || Synology DS213+ 6TB backup

Het gaat me dan om de bestandsstructuur die nodig is, dat is me totaal niet duidelijk.

[ Voor 20% gewijzigd door Sp33dFr34k op 07-11-2019 14:37 ]

i7 9700k + Be-Quiet Dark Rock 4 Pro | Gigabyte Z390 Aorus Ultra | Gigabyte RTX5070Ti | Samsung 970 Pro 512GB + 860 EVO 1TB + 860 QVO 4TB | 2x8GB DDR4 3000Mhz | Seasonic Platinum 660W | Fractal Design R6 | Samsung Oddyssey G7 Neo | Edifier M60

NZBGet heeft een functie om aan te geven wat hij moet doen, bij waarde 0 spreekt ie alles en zo veel mogelijk aan.. Echter kan in sommige oudere gevallen dat niet werken. Dus in mijn geval nu op 2 gezet ivm de dual cores en geen multi threading, maar geen effect nog. Bleef op 50% hangen. .stormfly schreef op donderdag 7 november 2019 @ 09:19:

[...]

Als de applicatie slechts 1 core aanspreekt van een duo core klopt 50%

Ben(V) schreef op donderdag 7 november 2019 @ 11:55:

Het is echt de cpu dat is een antieke dual core power PC cpu die in die DS213+ zit.

De unpar software is niet multithreaded, dus gebruikt hij maar een core van die cpu zoals al door @stormfly opgemerkt was.

Een disk in een Synology Nas haalt snelheden van boven de 100 MB/s dus het is echt niet de disk bottleneck.

Ik heb mijn conclusies dus gebaseerd op de test-bestanden en het feit dat dat doen ook al oude meuk was en de waarden die toen gehaald werden. Ik ging er ergens vanuit dat die waarde ook nu wel gehaald zouden moeten kunnen worden. Feit dat er een nieuwere NZBGet-versie op draait zou geen invloed moeten hebben.SmiGueL schreef op donderdag 7 november 2019 @ 12:13:

[...]

[...]

Voor zover ik weet was die 1:14 minuten voor (nog) oudere versies van unrar.

Ik heb zelf een jaar later met de DS213+ een uitpaksnelheid van 41 seconden gehaald. (ook op 3TB WD Red schijven)

Dit komt neer op gemiddeld bijna 17MB/s. Inderdaad single core, dus max 50% (totale) CPU belasting.

In de praktijk ging uitpakken in SABnzbd+ met 35 MB/s.

Inmiddels zijn we wss al weer 5 jaar verder.Dus of dit nog steeds zo is durf ik niet te zeggen.

Het kan goed zijn dat de mate van compressie van jouw 3,5GB bestand natuurlijk een stuk hoger/sterker is dan dat testbestand van de RAR benchmark. Waardoor uitpakken, helemaal op oudere CPU's, een stuk meer tijd kost.

Ik zal nog eens kijken of ik het betreffende test-bestand uit het eerder genoemde topic boven water kan toveren, of met een kleiner bestand testen om te zien wat dan de waarden zijn. Maar in de basis, tot nu toe, met de verschillende bestanden die ik heb getest maakt dat weinig uit. Pak elke keer 2-3-4 GB grote bestanden die grotendeels even lang staan te stampen.

edit

Eerste test met 500 MB groot bestand, 10x50MB. Unrar time 2 minuut. Dat komt inderdaad veel dichter in de buurt bij de resultaten uit het eerder genoemde topic. Misschien dat het hem dan toch zit in de andere bestanden en de manier van compressie anders of het moeilijker maakt.

[ Voor 5% gewijzigd door Dirrukje op 07-11-2019 18:47 ]

Want als je over nzbget praat denk ik eerder dat het over unpar gaat en dat is echt wat anders.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Ik bedoel het uitpakken van gedownloade bestanden. Het proces in broncontrol heet unrar en als ik de betreffende bestanden op mijn PC zou downloaden zou ik ze met winrar unrarren. Dus volgens mij is het unrar..Ben(V) schreef op donderdag 7 november 2019 @ 19:03:

Heb je het wel over unrar?

Want als je over nzbget praat denk ik eerder dat het over unpar gaat en dat is echt wat anders.

[ Voor 94% gewijzigd door Ben(V) op 08-11-2019 10:31 ]

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Daar heb je het even mis. Par is programma om pariteits-bestanden (.par) te maken naast de rar-bestanden. Dit om te controleren dat alle rar-bestanden correct gedownload zijn en eventueel ontbrekende of corrupte bestanden te herstellen. Dit heeft niets met uitpakken of compressie te maken.Ben(V) schreef op vrijdag 8 november 2019 @ 10:18:

par en rar zijn twee verschillednde compressie methoden.

Alleen newsgroup bestanden worden verpakt in het par formaat en omdat je het over nzbget hebt denk ik dat het om newsgroup bestanden gaat.

Par is specifiek ontwikkelt voor newsgroup bestanden en dat formaat focust zich op de hoogst mogelijke compressie terwijl het rar formaat een zo goed mogelijk evenwicht zoekt tussen compressie en effectiviteit ( dus snelheid).

rar is ook veel verder door ontwikkelt in vergelijking met par.

Beiden formaten worden ondersteund door de unrar applicatie, maar er zit een behoorlijk verschil in hoe snel het een par of een rar bestand kan uitpakken.

Wel is het zo dat als je par bestanden hebt het uitpakken veel langer duurt doordat er ook unparred moet worden.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Ik vind alleen maar op opzichzelfstaande oplossingen.

Verbinding met een client is geen probleem, alleen kan ik de NAS zelf niet benaderen. Ik heb de optie Allow clients to access server's LAN binnen het OpenVPN profiel ingeschakeld en nog gespeeld met statische routes op mijn router 192.168.200.0 gateway 192.168.178.3 maar ik kan deze niet benaderen. Qua firewall rules heb ik beide subnets op allow all gezet.

Heeft iemand een idee waar het op stuk loopt?

Lokaal netwerk 192.168.178.0 /24

VPN netwerk 192.168.200.0 /24

[ Voor 6% gewijzigd door Hari-Bo op 08-11-2019 11:43 ]

Bos Digitale Autoservice Onafhankelijke automotive dienstverlening; diagnose, codering, retrofit, sleutelservice, ECU en tuning. Projecten

ter info:Revaes schreef op woensdag 30 oktober 2019 @ 22:18:

Ik heb een probleem, mijn DS215+ met daarin 2 4TB schijven in raid 1 (mirror) SHR. Afgelopen week is de nas vastgelopen (knipperende oranje led). Vervolgens beide schijven los geprobeerd, maar kon NAS niet meer via DSM (of netwerk) benaderen. Had het vermoeden dat disk1 kapot was, deze heeft vorige week 1x een IO error gegeven, dit is tevens de oudste schijf.

NAS wel te benaderen via nieuw IP en daarin had ik de optie DSM opnieuw te installeren, dit niet gedaan omdat de data dan verloren zou gaan.

Vandaag een nieuwe identieke 4TB schijf erin gezet en daarop DSM opnieuw geinstalleerd, vervolgens de oude disk 2 erbij gestopt. Nas start daarna op met waarschuwingstoon en melding dat de schijf beschadigd is. Er wordt een optie gegeven om deze te herstellen (niet repareren), dit lijkt een tijdje te duren maar heeft verder geen merkbaar effect gehad. Optie om repareren te kiezen via actie is greyed out.https://1drv.ms/u/s!AtD8Xla4WtZYn-MPtIfotY8-zywCMA?e=zaeUXv

Ik heb disk2 aan een Ubuntu pc gehangen en kan met enige moeite de bestanden allemaal lezen, deze schijf lijkt verder ook OK, SMART laat geen gekke dingen zien.

Graag zou ik via DSM alles herstellen en weer in een raid 1 config doorgaan, maar ik heb geen idee hoe dit moet, vooralsnog kan ik bij Synology geen goede handleiding vinden.

Iemand enig idee wat handig is nu?

ps, er is een offsite backup van de belangrijkste bestanden (niet alles)

Probleem opgelost mbv Synology support. Via Config menu de locatie van alle bestaande mappen kunnen veranderen naar volume1/storage pool1, daarana (defecte) storage pool 2 verwijderd en storage pool 1 uitgebreid met de vrijgekomen schijf.

Ik heb hier in het begin ook veel mee zitten kloten.. Wat het probleem bij mij was; als ik via VPN verbindt dat moet ik niet de 192.168.x.x IP-adressen hebben, maar (uit mijn hoofd) 10.2.0.1 voor mijn NAS. Bij OpenVPN is dit wsl 10.8.0.1. Zie eerste instelling bij de VPN server instellingen. Afhankelijk van de services werkt "nasnaam.local" ookHari-Bo schreef op vrijdag 8 november 2019 @ 11:43:

Om verbinding naar mijn NAS te maken wil ik gebruik maken van OpenVPN server op mijn 918+ ipv PiVPN ivm troughput.

Verbinding met een client is geen probleem, alleen kan ik de NAS zelf niet benaderen. Ik heb de optie Allow clients to access server's LAN binnen het OpenVPN profiel ingeschakeld en nog gespeeld met statische routes op mijn router 192.168.200.0 gateway 192.168.178.3 maar ik kan deze niet benaderen. Qua firewall rules heb ik beide subnets op allow all gezet.

Heeft iemand een idee waar het op stuk loopt?

Lokaal netwerk 192.168.178.0 /24

VPN netwerk 192.168.200.0 /24

De grootste Nederlandstalige database met informatie over computers met zoekfunctie!!

Ik heb een map met videobestanden op mijn NAS. Hier komen soms bestanden bij, of ik haal wat weg.

Ik speel veel bestanden af met mijn Sony UBP-X800M2 4K blu-ray speler, middels DLNA.

Ik kan via die speler naar de map bladeren op mijn NAS, maar... ik mis dan vaak bestanden. Die bestanden voeg ik gewoon toe via mijn Windows HTPC.

Dan moet ik handmatig de Media Indexing weer starten op de NAS, en dat is vervelend en duurt lang.

Kan dit op de 1 of andere manier automatisch?

Online vind ik wel wat scripts, maar die zijn oud en werken niet.

ik ben van plan een NAS (vermoedelijk ga ik voor de Synology 918+ ) voor file sharing + backup maar ook voor het opnemen van camera beelden aan te schaffen.

De nas dient gebruikt te worden voor opslag van bestanden/foto's/video en file sharing. Verder zou de nas ook de camerabewaking op zich moeten nemen.

voor de bestanden/video's/... dient er een backup aanwezig te zijn. voor de camerabeelden is dit niet nodig..

Daarom had ik gedacht om de nas te voorzien van 2 X WD RED 6TB HDD + 1X 2TB WD PURPLE HDD

Ik vroeg mij af als het mogelijk was om de Synology zo te configureren dat de 2 RED hdd's (gebruikt voor file sharing en opslag van foto's en dergelijk waarvoor dus een backup nodig is) in een SHR configuratie staan.

En de 3e (geen backup) te gebruiken voor de camerabeelden

Is het mogelijk om die combinatie te doen en de NAS zo te configureren?

Bedankt!

Normaal gesproken zou dit ook automatisch moeten gaan. Een wijziging via SMB, AFP of middels file station triggert een synoindex update.Nyarlathotep schreef op vrijdag 8 november 2019 @ 20:38:

Kan dit op de 1 of andere manier automatisch?

Middels synoindex kan je vrij eenvoudig een job schedulen die bijv. een while/for doet door alle gewijzigde bestanden sinds een bepaalde tijd.Online vind ik wel wat scripts, maar die zijn oud en werken niet.

Ja, geen probleem echter zal SHR je netto net zoveel ruimte geven en is alles redundant. Daarnaast ben je flexibeler in het uitbreiden.thomke schreef op vrijdag 8 november 2019 @ 20:44:

Is het mogelijk om die combinatie te doen en de NAS zo te configureren?

[ Voor 23% gewijzigd door DukeBox op 08-11-2019 20:47 ]

Mijn DS413 heeft 4 geinstalleerde HDs in basic configuratie.

(dus geen RAID en elke HD->1 enkele storage pool->1 enkel volume)

Ik heb 1 HD als backup drive die ik om de paar weken handmatig voorzie van een backup vanuit de andere drives.

Is het mogelijk deze backup drive/volume uit te schakelen? Ik heb deze namelijk alleen nodig op het moment van backupen en daarna zou deze volledig uitgeschakeld mogen zijn. Scheelt energie en tevens dat de drive niet in gebruik is en daarmee minder belast wordt.

Is dit mogelijk?

Intel i9-9900K | MSI MPG Z390 Gaming Pro Carbon | MSI RTX 2080Ti Gaming X Trio | Ballistix Sport LT (32GB) | MSI Optix MAG274QRF-QD 1440p | Samsung 970 EVO Plus (2TB) | NZXT Kraken X52 | Valve Index | Fractal Design R6 | Synology DS420j

Stop hem in een 3,5" Enclosure en maak maandelijks een handmatige kopie;)

Je setup klinkt echter niet ideaal en van een echte backup kunnen we dus niet spreken. Wat als 1 van die andere HDD's in je NAS er mee op houdt, of als de boel in brand vliegt?

[ Voor 33% gewijzigd door Greatsword op 09-11-2019 19:24 ]

Dat klopt. Maar een simpele optie om deze uit te schakelen zonder je NAS open te hoeven doen is uiteraard beter.Greatsword schreef op zaterdag 9 november 2019 @ 19:21:

Je kan hem toch gewoon er uit halen als hij niet in RAID staat, dan verbruikt hij sowieso niets.

Ja klopt, maar ook hier heb ik reeds een HD in de NAS die ik op afstand aan/uit kan zetten en als backup gebruiken. Externe HDs kan uiteraard ook, maar mijn vraag was juist gericht op het gebruiken van een HD in je NAS.Stop hem in een 3,5" Enclosure en maak maandelijks een handmatige kopie;)

Ik heb erg goed nagedacht over mijn backup strategie.Je setup klinkt echter niet ideaal en van een echte backup kunnen we dus niet spreken. Wat als 1 van die andere HDD's in je NAS er mee op houdt, of als de boel in brand vliegt?

Om de y maanden maak ik een backup op een externe HD die ik in een kluis op een andere locatie bewaar.

Om de x maanden maak ik een backup op een andere externe HD die ik elders in huis bewaar.

Om de x weken maak ik een interne backup van mijn NAS drives naar 1 interne drive in de NAS.

Inderdaad, als de NAS in de fik vliegt heb ik niets aan deze backup. Maar daar is deze ook niet voor bedoelt. Ik gebruik deze als 1 van mijn HDs in mijn NAS crashed. Dan kan ik vanuit de NAS na het plaatsen van een nieuwe drive de bestanden simpel terugzetten.

Daar is dus deze backup strategie voor.

Mijn vraag slaat dus slechts op het wel dan niet mogelijk zijn de backupdrive uit te schakelen zonder aan mijn NAS te zitten. Het lijkt erop dat het alles aan of uit is. En bij losse volumes in basic configuratie lijkt het erop dat je niet vanuit de software een volume kan aan of uitzetten.

Of wellicht wel. Dat was mijn vraag.

Intel i9-9900K | MSI MPG Z390 Gaming Pro Carbon | MSI RTX 2080Ti Gaming X Trio | Ballistix Sport LT (32GB) | MSI Optix MAG274QRF-QD 1440p | Samsung 970 EVO Plus (2TB) | NZXT Kraken X52 | Valve Index | Fractal Design R6 | Synology DS420j

Al jaren draai ik een hyperbackup task die geselecteerde folders naar de backup drive binnen de NAS aanmaakt.

Als ik met file explorer de backup drive bekijk staan daar de folders en de bestanden zoals ik ze verwacht. Ik kan vanaf daar manueel bestanden kopieren en gebruiken.

Ik heb nu een nieuwe hyperbackup task gemaakt die hetzelfde zou moeten doen. Echter naar een nieuwe pas geinstalleerde drive.

Als ik nu naar de destination ga met file explorer dan is dit een soort van database met aparte folders en niet gerelateerde bestandsnamen. Een soort van versiebeheer archief. De folders en bestanden staan er in maar kan ik alleen bekijken via de backup explorer tool van Synology. Ik kan dus niet een bestand kopiëren uit de backupdrive.

Wat is nu het verschil tussen mijn oude backuptask (die 1:1 de folders en bestanden kopieert naar de destination) en deze die een .hbk bestand maakt die ik alleen kan openen met de backup explorer?

Kan het zijn dat er updates op hyperbackup zijn geweest en dat mijn oude task nog op een oude manier de backups wegschrijft?

Ik wil de oude methode. Dus dat de backup de folderstructuur en bestanden bevat die ik met file explorer kan bekijken en los kan gebruiken.

EDIT

Ik heb het zelf gevonden.

Je dient "Local folder & USB (single-version)" te kiezen.

Er komt dan een blauw vierkantje in het icoontje te staan van de taak.

[ Voor 6% gewijzigd door Xymox op 10-11-2019 13:08 ]

Intel i9-9900K | MSI MPG Z390 Gaming Pro Carbon | MSI RTX 2080Ti Gaming X Trio | Ballistix Sport LT (32GB) | MSI Optix MAG274QRF-QD 1440p | Samsung 970 EVO Plus (2TB) | NZXT Kraken X52 | Valve Index | Fractal Design R6 | Synology DS420j

Een backup naar een disk in hetzelfde systeem is geen backup en niet erg zinvol.Xymox schreef op zaterdag 9 november 2019 @ 21:59:

[...]

Dat klopt. Maar een simpele optie om deze uit te schakelen zonder je NAS open te hoeven doen is uiteraard beter.

[...]

Ja klopt, maar ook hier heb ik reeds een HD in de NAS die ik op afstand aan/uit kan zetten en als backup gebruiken. Externe HDs kan uiteraard ook, maar mijn vraag was juist gericht op het gebruiken van een HD in je NAS.

[...]

Ik heb erg goed nagedacht over mijn backup strategie.

Om de y maanden maak ik een backup op een externe HD die ik in een kluis op een andere locatie bewaar.

Om de x maanden maak ik een backup op een andere externe HD die ik elders in huis bewaar.

Om de x weken maak ik een interne backup van mijn NAS drives naar 1 interne drive in de NAS.

Inderdaad, als de NAS in de fik vliegt heb ik niets aan deze backup. Maar daar is deze ook niet voor bedoelt. Ik gebruik deze als 1 van mijn HDs in mijn NAS crashed. Dan kan ik vanuit de NAS na het plaatsen van een nieuwe drive de bestanden simpel terugzetten.

Daar is dus deze backup strategie voor.

Mijn vraag slaat dus slechts op het wel dan niet mogelijk zijn de backupdrive uit te schakelen zonder aan mijn NAS te zitten. Het lijkt erop dat het alles aan of uit is. En bij losse volumes in basic configuratie lijkt het erop dat je niet vanuit de software een volume kan aan of uitzetten.

Of wellicht wel. Dat was mijn vraag.

Een raidset zou dan slimmer zijn, dan ben je altijd beschermd tegen disk uitval van een enkele disk.

Maar uiteraard moet je het zelf weten.

De disk eruit halen is niet zo verstandig, dan kun je beter een USB disk aansluiten en daar de backup naar doen en die USB disk elders bewaren.

Een disk of volume uitschakelen kan natuurlijk niet, maar je kunt wel een hibernation voor disken aanzetten in het control panel.

De disken spinnen dan down als ze een bepaalde tijd niet gebruikt worden en verbruiken dan veel minder stroom.

En om op je ander vraag terug te komen waar je zelf al het antwoordt op gevonden had, in de hyperbackup applicatie zit een browser waarmee je door de inhoud van een normale hyperbackup set kunt browsen.

[ Voor 4% gewijzigd door Ben(V) op 10-11-2019 13:22 ]

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Je schrijft precies het omgekeerde van wat waar is. Raid is geen backup omdat je niet naar een vorige versie kan terug vallen. Een backup maar een 2e disk is een betere oplossing.Ben(V) schreef op zondag 10 november 2019 @ 13:20:

Een backup naar een disk in hetzelfde systeem is geen backup en niet erg zinvol.

Een raidset zou dan slimmer zijn..

USB is dan idd de betere oplossing , liefst nog roulerend tussen 2 stuks welke buitenshuis bewaard worden.

Niet alle data is even belangrijk. Zelf heb ik mijn documenten en foto’s op een synology in raid staan en een off-site kopie bij een cloud provider. Kans dat ik die data ga verliezen is vrijwel nihil. Media en ruwe go pro filmpjes staan alleen op mijn synology. Deze heeft al meermaals een HD crash meegemaakt en heb de raid array weer succesvol kunnen rebuild en. Als er brand of inbraak is, dan is het jammer. Als mijn raid array crasht tijdens een rebuild dan is het jammer. Vele TB aan opslag extern organiseren gaat ook geld kosten, of kan onpraktisch worden in het geval van het wisselen van losse externe HDD’s.

Weeg de risico’s af tegen de kosten en haalbaarheid.

@DukeBoxDukeBox schreef op zondag 10 november 2019 @ 13:55:

[...]

Je schrijft precies het omgekeerde van wat waar is. Raid is geen backup omdat je niet naar een vorige versie kan terug vallen. Een backup maar een 2e disk is een betere oplossing.

USB is dan idd de betere oplossing , liefst nog roulerend tussen 2 stuks welke buitenshuis bewaard worden.

Je leest het verkeerd.

Ik zei dat als je een backup naar een disk in hetzelfde systeem maakt je net zo goed (of eigenlijk beter) een raidset kunt maken.

Een backup moet zoals we allemaal weten naar een ander systeem en het liefst in een andere ruimte en incremental, anders is het niet erg zinvol en dus geen backup.

Verder gaat het niet om een definitie, maar om duidelijk te maken wat de risico's zijn.

Maximale risico's uitsluiten is een incremental backup maken naar een device op een andere locatie.

Vergeet niet dat data corruptie via software vele malen vaker voorkomt dan disk failure.

Corrupte data backuppen zonder dat er een incremental backup is komt vaak voor.

Denk maar aan wat er gebeurd als je originele disk bitrot gaat vertonen, die data wordt dan vrolijk corrupt naar de backup geschreven.

Of als je en synolocker virus opvangt, dan gebeurt hetzelfde.

[ Voor 30% gewijzigd door Ben(V) op 10-11-2019 14:40 ]

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Helaas niet want je bevestigd het. In géén gevallen is een raidset beter dan een backup.Ben(V) schreef op zondag 10 november 2019 @ 14:31:

Je leest het verkeerd.

Redundancy is voor beschikbaarheid bedoeld, niet als backup !

Jij beweerd dingen die ik echt niet zeg.

Ik zei als hij er voor kiest een copy te maken naar een disk in hetzelfde systeem en dat backup noemt, hij net zo goed (en zelf beter) een raidset nemen.

Ik heb nergens gezegd dat een raidset een backup is, dat maak jij ervan.

Lezen is moeilijk he?

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Zoals ik eerder zei heb ik elders een kopie liggen in een kluis. Tevens een extra kopie, die vaker ververst wordt in huis, andere ruimte.

De "binnen de NAS" backup is de eerste laag. Dus als ik op mijn NAS een bestand nodig heb, maar de HD is gecrashed, dat ik meteen, stante-pede, met verkenner naar de "backup" HD kan gaan en daar het bestand kan oppakken die ik nu nodig heb. Het vervangenvan HD's, rebuilden van RAIDS is dan voor latere zorg.

Ik wil gewoon een 1:1 kopie hebben van vaak gebruikte bestanden zowel op de HD's op de NAS die ik in normaal gebruik kan benaderen en im geval van crash en tevens in dezelfde NAS een aparte drive die deze bestanden heeft. Dus in plaats van naar locatie A op de nAS, ga ik naar locatie B op de NAS, wat een kopie is van het bestand van de datum waarop ik zelf gekozen heb de backup te maken.

Zo vreemd is dit niet. En ja, deze "backup" is niet waterdicht. Dat is de HD die ik in de kluis heb liggen en waar ik eerst moeite voor moet doen om deze te gebruiken.

Een extra HD is gewoon een simpele oplossing voor het ene probleem. Niet voor alles.

Intel i9-9900K | MSI MPG Z390 Gaming Pro Carbon | MSI RTX 2080Ti Gaming X Trio | Ballistix Sport LT (32GB) | MSI Optix MAG274QRF-QD 1440p | Samsung 970 EVO Plus (2TB) | NZXT Kraken X52 | Valve Index | Fractal Design R6 | Synology DS420j

Mijn vraag is:

ik heb op share niveau diverse rechten toegekend zo mag gebruiker B: geen bestanden verwijderen uit Folder B:

echter heeft deze gebruiker ook op zijn device synology drive in gebruik. Logischerwijs mag hij op zijn eigen systeem wel bestanden verwijderen en wanneer hij dit doet verwijderd Synology drive ook het bestand op de share. Is dat op een bepaalde manier tegen te gaan? Ik krijg het tot op heden niet gevonden.

De eindgebruiker is pertinent tegen het werken op shares en wil daarom gebruik blijven maken van de synchronisatie opzet

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Gevolg is dat na de automatische DSM update van afgelopen nacht mijn containers dus ook niet terug kwamen en er van alles uit lag hier.

Dit is eerder gebeurd en ik zie zo snel geen optie om packages om automatisch te starten na reboot.

Mis ik iets?

Vmu

Ik ken geen manier om in te stellen welke packages bij een systeem(her)start opstarten; voor zover ik weet worden gewoon de packages welke voor reboot liepen weer gestart?

Nee, dat maak ik er ook niet van.. (zie je eigen laatste opmerkingBen(V) schreef op zondag 10 november 2019 @ 15:36:

Ik heb nergens gezegd dat een raidset een backup is, dat maak jij ervan.

Jij stelt letterlijk dat je beter raid kan nemen dan een backup (=copy).. ik stel dat dat pertinent niet waar is.Ik zei als hij er voor kiest een copy te maken naar een disk in hetzelfde systeem en dat backup noemt, hij net zo goed (en zelf beter) een raidset nemen.

ik start mijn dockers op na een herstart (en sluit ze af met een script bij een herstart) met het volgende script:gwystyl schreef op dinsdag 12 november 2019 @ 14:33:

@Vmu bij mijn 218+ is docker wel gewoon herstart, dus ik vrees dat het een exemplarisch probleem bij jouw 218+ is.

Ik ken geen manier om in te stellen welke packages bij een systeem(her)start opstarten; voor zover ik weet worden gewoon de packages welke voor reboot liepen weer gestart?

starten

1

| docker run --name xxxx -variable1 xxxxx --variable2 xxx etc |

stoppen

1

| docker stop -t 5 containername |

[ Voor 5% gewijzigd door MAdD op 12-11-2019 15:54 . Reden: start stop commando ]

Assumption is the mother of all fuck-ups / You're MAdD. Well thank God for that, 'cause if I wasn't this would probably never work

[ Voor 2% gewijzigd door technorabilia op 12-11-2019 20:55 . Reden: Verkeerd gelezen ]

i7 9700k + Be-Quiet Dark Rock 4 Pro | Gigabyte Z390 Aorus Ultra | Gigabyte RTX5070Ti | Samsung 970 Pro 512GB + 860 EVO 1TB + 860 QVO 4TB | 2x8GB DDR4 3000Mhz | Seasonic Platinum 660W | Fractal Design R6 | Samsung Oddyssey G7 Neo | Edifier M60

Ja inderdaad.Sp33dFr34k schreef op dinsdag 12 november 2019 @ 20:39:

Als ik het bericht zo lees bedoelt hij dat het Docker package niet opstart waardoor er logischerwijs ook geen Docker containers gestart kunnen worden.

Klinkt dus alsof ik zoals @gwystyl zegt een eigen uniek probleem heb. Jammer, ik ga verder zoeken.

Bedankt allemaal.

Vmu

Sinds enige tijd vind ik mijn DS216j traag aanvoelen in de webgui en soms merk ik dat ook in de vertraging in acties in domoticz. Op andere momenten heb ik daar geen last van en schakelt alles prima. De webgui gebruik ik ook niet zo vaak dus vaak geen probleem.

Nu het vreemde, wanneer ik package manager open, blijft bij alle geïnstalleerde apps 'Status Ophalen' staan. Vroeger kwam hier gestart, gestopt etc. te staan. Dat betekend dat ik de apps niet meer kan starten of stoppen. Ik wil namelijk Photo station opnieuw starten en de instellingen controleren, omdat ik daar ook al geen verbinding mee kan maken. 'Albumgegevens kunnen niet worden opgehaald' krijg ik te zien in de Android app. Ik zie ook bij het uploaden van nieuwe foto's het media converteringsicoontje niet meer verschijnen bovenin de statusbalk van de webgui.

Ik heb al de andere repos uit de package manager verwijderd, logs bekeken, maar het geeft mij nog geen aanwijzing waar te zoeken. NAS is volledig up to date en is gerestart na de update.

Mijn smarthome blog artikelen over: Thuisaccu | Dynamische energieprijzen | Watermeter

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Ja maar daar merkt ik dan veder helemaal niets van in de rest van het gebruik van verbindingen en applicaties. Het verklaart ook niet waarom DS photo niet werkt en ik kan wel gewoon packages installeren.Ben(V) schreef op woensdag 13 november 2019 @ 13:26:

Klinkt alsof je een netwerk probleem hebt en je Nas de servers van Synology niet kan bereiken.

Mijn smarthome blog artikelen over: Thuisaccu | Dynamische energieprijzen | Watermeter

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Dat ligt er net aan hoe je het ziet.Ben(V) schreef op zondag 10 november 2019 @ 13:20:

[...]

Een backup naar een disk in hetzelfde systeem is geen backup en niet erg zinvol.

Een raidset zou dan slimmer zijn, dan ben je altijd beschermd tegen disk uitval van een enkele disk.

Maar uiteraard moet je het zelf weten.

Als je elk uur een backup maakt van een folder naar een zipfile, dan bouw je iets van history op. Verwijder je per ongeluk iets op de schijf, kun je die backup terug zetten. Staat die backup op de tweede disk, heb je daarmee een iets lager beschermingsniveau als van RAID, namelijk, je kan een uur aan data kwijt zijn.

Gebruik je RAID, dan wordt alles wat je verwijderd ook direct van beide schijven gewist. Met andere woorden, je hebt totaal geen historie. Wat je wel hebt, is het risico dat je RAID-structuren breken waardoor je een soort split-brain krijgt. Zeker bij 2-disk mirror gebeurt dat nogal eens. En vind als dan nog maar eens uit welke van de disks de meest recente is. Zeker als ze naderhand nog een keer gestart zijn om te kijken 'of er nog iets terug te halen valt'.

Overigens krijg ik jeuk van mensen die beweren dat een kopie, zelfs op een zelfde disk geen backup is. Het is maar net wat je nodig hebt qua bescherming en functionaliteit. Niet iedereen heeft de mogelijkheden om een oplossing als een NetApp Metrocluster over twee sites te combineren met SnapMirror-replicatie naar een derde site.

Er zijn zat mensen voor wie een PC gewoon als een auto is; start ie niet, dan is hij stuk. Dat gebeurt gelukkig niet zo veel, dus als je dan alles kwijt bent, dan is dat maar zo. Maar zolang hij het doet willen ze zich wel beschermen tegen hun eigen stommiteiten door hun documenten naar 2 plaatsen op dezelfde disk te kopiëren. Is dat een backup? Voor hun wel. Het doet wat het moet doen en het kost (bijna) niks. Is het een backup die ik zou verkiezen? Absoluut niet.

Maar ik vertrouw mijn data ook niet toe aan een cloud-backup-provider, noch aan een NAS bij vrienden of familie. Wel staan er time-machine backups op de time-capsule in de meterkast. Is dat dan wel een backup? Ben ik dan goed beschermd? Als mijn huis af fikt dan ben ik met een beetje geluk niet thuis en heb ik mijn laptop mee. Met een beetje pech kan ik het toch niet navertellen. En in de situatie dat ik net zonder laptop het huis kan ontvluchten heb ik wel andere dingen aan mijn hoofd. Dan ga ik mij echt niet druk maken over een enorme stapel eentjes en nulletjes. Dus ja, voor mij is het een backup, het doet wat het moet doen voor de prijs die ik ervoor over heb. Dat het geen offsite-archive is, kan mij werkelijk waar gestolen worden.

Waar het om gaat is dat je weet wat je doet en wat de consequenties zijn.

Ik probeer is erop te wijzen dat bij een backup naar een disk in dezelfde Nas je nog steeds niet beschermt bent tegen een aantal potentiele gevaren en dat geld ook voor een raidset.

En nogmaals voor iedereen die denkt iets te lezen on wat ik schrijf, ik heb nergens beweerd noch bedoelt dat Raid een vervanger voor backup is.

En als laatste opmerking wil ik wel beweren dat een mirror set waarin beiden delen defect gaan uiterst zelden voorkomt en bij 99,9% van de gevallen het gevolg is van mensen die de verkeerde handelingen plegen als ze constateren dat hun raidset corrupt geraakt is.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

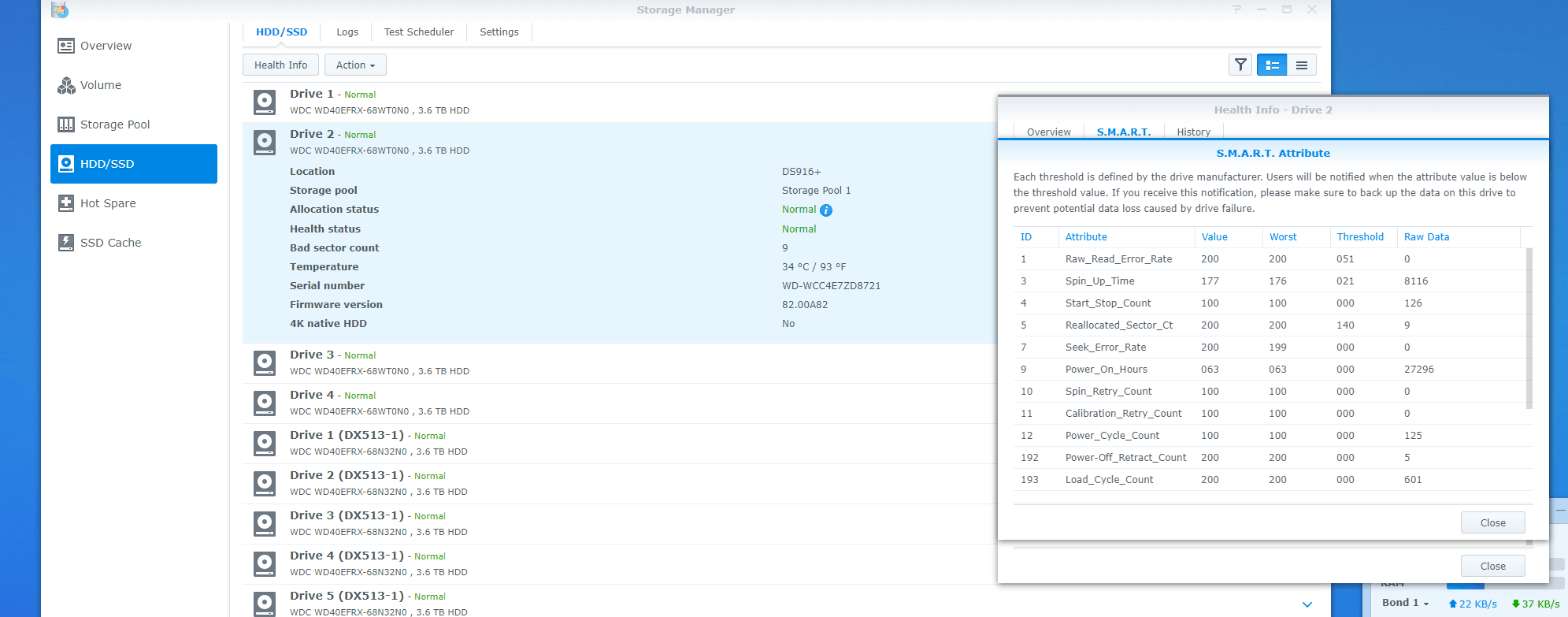

Wanneer moet ik deze disk gaan vervangen? Enig idee/advies? Ik draai SHR 1.

[ Voor 27% gewijzigd door wvkreg op 15-11-2019 10:40 ]

Je bent beschermt door SHR voor volledige uitval van de disk, dus pas als dat gebeurd zou ik de disk vervangen.

Het risico dat je dan loopt is dat er tussen de tijd dat de disk uitvalt en de tijd die je nodig hebt om een nieuwe disk te kopen en de raidset te rebuilden, je geen raid protectie meer hebt, maar dat is bij een onverwachte diskuitval ook al zo.

Pas als je meerdere disken met reallocations hebt zou ik persoonlijk een disk preventief gaan vervangen.

Zou wel regelmatig een scrubbing van je disken laten uitvoeren, maar als het goed is zet DSM tegenwoordig dat standaard in de taak planner voor je.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Settings al aangepast?xtravital schreef op vrijdag 15 november 2019 @ 17:58:

Vraagje ik heb een nieuwe DS918+ met 4x 8TB WD RED hdd's alleen als je hem aanzet is het net of hij op stijgt, zijn er meer mensen die dit ervaren met deze nas. Ik heb ook een DS412+ en die hoor je amper, de nieuwe wil ik met dit volume niet eens in de waankamer hebben.

Control Panel -> Hardware & Power -> Fan sectie.

Mode "Quiet" / "Cool" of "Full Speed" setting

Het is niet zozeer de fans het komt meer door de HDD's, met twee van de vier is hij stil maar test ik met de twee anderen dan is het geluidsvolume enorm ineens.jvanhambelgium schreef op vrijdag 15 november 2019 @ 18:15:

[...]

Settings al aangepast?

Control Panel -> Hardware & Power -> Fan sectie.

Mode "Quiet" / "Cool" of "Full Speed" setting

Net alsof die twee schijven zwaar uit het lood draaien.

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

[quote]xtravital schreef op vrijdag 15 november 2019 @ 17:58:Ben(V) schreef op vrijdag 15 november 2019 @ 22:08:

Tja dan is het niet je Nas maar de disken, zijn het soms Seagate disken?

Vraagje ik heb een nieuwe DS918+ met 4x 8TB WD RED hdd's...

[/quote]

Zo erg als jij het hebt ken ik het niet, maar ik weet wel dat mijn 412+ eerst met 3 WD RED schijven volledig stil was, maar toen ik er een 4e bij in stopte kon ik die schijf ook duidelijk horen ratelen. Is blijkbaar toch afhankelijk van welke batch je een schijf hebt.

Ga ik ff naar de doe het zelf zaak, kom ik terug, kan ik niet meer inloggen met mijn admin account?

You are not authorised to use this service.

Iemand enig idee waar dit door komt? Is dit een bekend probleem?

Ik heb voordien wel issues gehad omdat ik plex opnieuw vanaf 0 wil installeren, maar dat zou toch geen invloed op de admin user rechten mogen hebben...

Verder is mijn nas wel vol met geen ruimte op de storage pool, maar om de 1 of andere reden krijg ik daar geen ruimte voor vrij, ook al verwijderde ik data.

Kan allemaal met elkaar gerelateerd zijn maar lijkt me voor dit issue wel heel erg sterk...

De oplossing: YouTube: Synology DiskStation Vibration Noise - EASY $5 FIX!xtravital schreef op vrijdag 15 november 2019 @ 17:58:

Vraagje ik heb een nieuwe DS918+ met 4x 8TB WD RED hdd's alleen als je hem aanzet is het net of hij op stijgt, zijn er meer mensen die dit ervaren met deze nas. Ik heb ook een DS412+ en die hoor je amper, de nieuwe wil ik met dit volume niet eens in de waankamer hebben.

[ Voor 140% gewijzigd door ocdaan op 17-11-2019 11:50 ]

Dit heb ik ook gedaan, baat zeker wel voor de "zoem" die je hoort van de schijven, maar de "ratels" blijven natuurlijk wel. Is dus even de vraag waar hij last van heeft...

i7 9700k + Be-Quiet Dark Rock 4 Pro | Gigabyte Z390 Aorus Ultra | Gigabyte RTX5070Ti | Samsung 970 Pro 512GB + 860 EVO 1TB + 860 QVO 4TB | 2x8GB DDR4 3000Mhz | Seasonic Platinum 660W | Fractal Design R6 | Samsung Oddyssey G7 Neo | Edifier M60

Heb ik ook wel eens gehad, met een DS3617xs. Refreshen pagina / cache leegmaken / andere browser wil wel eens helpen.masauri schreef op zondag 17 november 2019 @ 10:13:

Net mijn syno rs3617xs geupdate naar de laatste dsm firmware 6.2.2-24922-4.

Ga ik ff naar de doe het zelf zaak, kom ik terug, kan ik niet meer inloggen met mijn admin account?

You are not authorised to use this service.

Iemand enig idee waar dit door komt? Is dit een bekend probleem?

Ik heb dat soms, ook pincode bij 2 factor authentificatie wordt dan geweigerd terwijl die wel klopt.

Drone Insight - De plek waar jouw drone avontuur een vlucht krijgt!

Die van mij klinkt toch helaas wat anders

[Video: https://post-man.nl/syno.mp4]

Dit geluid dus, ratelen van een hdd maakt me niet zoveel uit, maar dit is helaas geen ratelen meer.

Helaas werkt het allemaal niet , maar toch frapant dat het u ook overkomt met een gelijkaardig model!SpeedingWilly schreef op zondag 17 november 2019 @ 11:53:

[...]

Heb ik ook wel eens gehad, met een DS3617xs. Refreshen pagina / cache leegmaken / andere browser wil wel eens helpen.

Ik heb dat soms, ook pincode bij 2 factor authentificatie wordt dan geweigerd terwijl die wel klopt.

Inloggen met dezelfde gegevens op men ds surveilance app gaat zonder problemen.

Edit: Intussen zijn bepaalde shares al niet meer te benaderen met de login gegevens via windows.

Ik heb gelijk een ticket aangemaakt bij synology. Wordt vervolgd.

[ Voor 13% gewijzigd door masauri op 17-11-2019 12:25 ]

Dat is behoorlijk static sound. Heb je de NAS al eens (deels) uit elkaar gehaald en schoongemaakt?xtravital schreef op zondag 17 november 2019 @ 11:59:

[...]

Die van mij klinkt toch helaas wat andershet geluid wordt veroorzaakt door twee van de WD schijven iig.

[Video]

Dit geluid dus, ratelen van een hdd maakt me niet zoveel uit, maar dit is helaas geen ratelen meer.

Mag je kiezen maar toch even opletten.brambello schreef op zondag 17 november 2019 @ 15:44:

Ik wil mijn Synology NAS een vast IP geven. Voorheen zaten er twee netwerkkabels in, dit maakt het alleen maar lastig in mijn ogen, daarom heb ik net 1 van de 2 netwerkkabels eruit getrokken. Er blijft dus maar 1 IP over nu voor de NAS. Moet ik deze vanuit de NAS een vast IP geven of vanuit de router?

1) Vanuit de router is dat gewoon een "DHCP reservatie". Normaal zal de router die IP "koppelen" met het MAC-adres van de NAS en dat IP dus nooit uitdelen aan een ander device

2) Gewoon op de NAS kan ook, MAAR dan moet je de DHCP wel configgen zodat ie DAT IP nooit gaat uitdelen ! Dus dat valt liefst "buiten de range / pool" van de DHCP ....

Yep, denk het wel. Het IP dat je NAS op deze moment had is nu "gelinked" met het MAC-adresje van je NAS.brambello schreef op zondag 17 november 2019 @ 18:47:

In mijn router heb ik bij de IP van mijn NAS het vakje 'Vast IP adres bij DHCP binding' aangevinkt. Heb ik vanaf nu een vast IP adres?

Als je NAS terug opnieuw gaat starten zal je merken dat die hetzelfde IP krijgt.

Ik heb de DS1019+ en zoals iemand al in de yt comment aangeeft heeft deze al de zoem vanaf day 1.

De DS412+ heeft er na 7 jaar geen last van. Voor mijn gevoel zit die ook robuuster in elkaar. Beetje jammer van zo'n nieuw product.

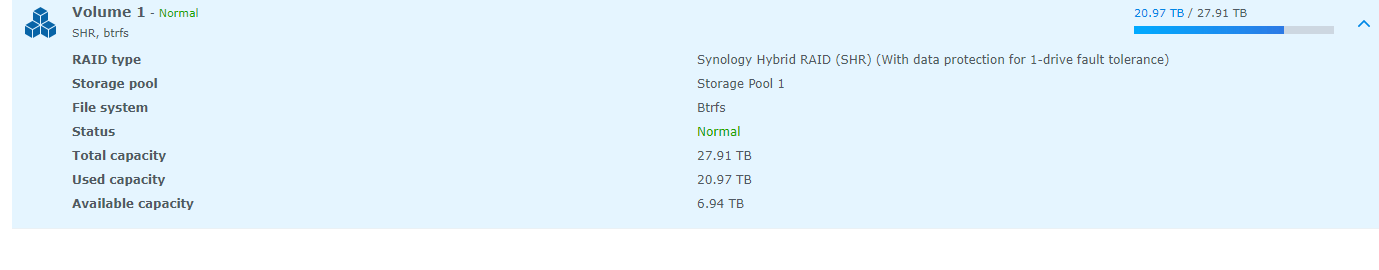

- een 3TB schijf verwijderen

- grotere schijf toevoegen

- nieuwe schijf aan SHR toevoegen

... en de NAS repareert dan zelf de opslagpool / ik moet handmatig de pool herstellen?

En daarna de andere 3TB schijf door een grotere vervangen en dan weer pool herstellen?

RPL MLA les op EHST | Aorus Z690 Pro | i9 13900K@5.8 | RTX 5090 | Varjo Aero | 64GB DDR5@5600 | HC Alpha Bravo Virpil Stick Collective | Buttkicker Gamer 2

All truth passes through three stages: First it is ridiculed, second it is violently opposed and third it is accepted as being self-evident.

Begint erger te worden en snel. Wanneer kom ik in actie?Ben(V) schreef op vrijdag 15 november 2019 @ 11:32:

Gewoon in de gaten blijven houden en verder niets doen.

Je bent beschermt door SHR voor volledige uitval van de disk, dus pas als dat gebeurd zou ik de disk vervangen.

Het risico dat je dan loopt is dat er tussen de tijd dat de disk uitvalt en de tijd die je nodig hebt om een nieuwe disk te kopen en de raidset te rebuilden, je geen raid protectie meer hebt, maar dat is bij een onverwachte diskuitval ook al zo.

Pas als je meerdere disken met reallocations hebt zou ik persoonlijk een disk preventief gaan vervangen.

Zou wel regelmatig een scrubbing van je disken laten uitvoeren, maar als het goed is zet DSM tegenwoordig dat standaard in de taak planner voor je.

Heb de NAS niet uit elkaar gehaald nee, maar dat is meer omdat zowel de NAS als de Schijven hagelnieuw zijn.wvkreg schreef op zondag 17 november 2019 @ 16:02:

[...]

Dat is behoorlijk static sound. Heb je de NAS al eens (deels) uit elkaar gehaald en schoongemaakt?

Maar probleem is opgelost twee van de hdd's vervangen en nu is hij lekker stil

Dit topic is onderdeel van de drie topics over Synology:In dit Vraag en Antwoord topic mogen alle vragen over Synology-producten tenzij:

- ... het een vraag betreft over een addon package voor Synology; daar is een apart topic voor.

- ... het een aankondiging of discussie-item betreft wat in het Nieuws en discussie topic hoort.

- ... jouw vraag al beantwoord is in de Veelgestelde vragen (FAQ).

/u/197564/crop6072aa9bcdaaf.png?f=community)

:strip_icc():strip_exif()/u/43218/crop5cd29cf426461_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/16677/crop5db01361a1e1e_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/565926/lynx1.jpg?f=community)

:strip_icc():strip_exif()/u/22063/DodgeViper3.jpg?f=community)

:strip_exif()/u/24321/motor1.gif?f=community)

:strip_icc():strip_exif()/u/103521/volvo-logo.jpg?f=community)

:strip_icc():strip_exif()/u/184432/crop5666ef06248fb_cropped.jpeg?f=community)

:strip_exif()/u/154471/crop5e09176a82484.gif?f=community)

/u/286685/crop58fcf863c48a5.png?f=community)

:strip_exif()/u/194304/Untitled-1.gif?f=community)

/u/88899/blues.png?f=community)

:strip_exif()/u/30814/newgot.gif?f=community)

:strip_icc():strip_exif()/u/97062/crop5601be1a24867_cropped.jpeg?f=community)

:strip_exif()/u/47543/jpcplanet.gif?f=community)

:strip_exif()/u/347463/crop63dd20785b307.gif?f=community)

/u/168181/crop596361aa05dfe.png?f=community)

:strip_icc():strip_exif()/u/28051/gwystyl_av.jpg?f=community)

:strip_exif()/u/178284/crop5da5934de9043_cropped.gif?f=community)

:strip_icc():strip_exif()/u/45777/CLoud-150x100.jpg?f=community)

:strip_exif()/u/36231/skipsmile.gif?f=community)

:strip_exif()/u/216514/sgisurf.gif?f=community)

:strip_icc():strip_exif()/u/10541/Elmo.jpg?f=community)

:strip_icc():strip_exif()/u/54978/crop60b9366a413c7_cropped.jpg?f=community)

:strip_exif()/u/2393/Tie-Fighter-Pilot3.gif?f=community)