Mijn LEGALE dvd collectie; (altijd onder constructie) http://www.invelos.com/dvdcollection.aspx/The%20Chosen%20One - - - - - - - - - Quietum Grandis: https://nl.hardware.info/usersystemen/28203/quietum-grandis---ryzen-2700x-game-pc

Het is vooral jammer dat er niet getest is met een 8600K. De 8400 is een stuk goedkoper en eigenlijk alleen interessant op een Z bord van o.a. Asrock (waarmee je kunt overclocken via de base frequency).Verwijderd schreef op donderdag 17 mei 2018 @ 15:40:

[afbeelding]

Het is jammer dat hij niet eveneens RAM testte met 3200 MT/s en 4,2 GHz , gezien het kleine verschil is het de vraag of dat de 2600 eveneens de 8400 zou verslaan met net iets trager RAM. Een 2600X was ook leuk geweest gezien de hogere boost. Qua prijs is het geen onlogische keuze, afhankelijk van of dat je wel of niet die stock-koeler bij de 8400 wil gebruiken.

Voor wie het niet zou weten, bij Intel is het verschil verwaarloosbaar klein als je beter RAM gebruikt, daarom testte hij voor Intel slechts met 1 RAM-klokfrequentie.

Scaling bij Intel is overigens behoorlijk aanwezig sinds Skylake. Even cherry picken (lage resolutie, specifieke game). Dit is de 8700K:

Totaal verschil is overigens inderdaad beperkt tot minder dan 4% bij lage resolutie (wat overigens goed te vergelijken is met een gpu over 3-4 jaar). Dus ja verder wel met je eens dat het niet heel schokkend is dat bij Intel niet met sneller geheugen is getest.

[ Voor 8% gewijzigd door sdk1985 op 20-05-2018 14:06 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Verwijderd

11 FPS tussen 2400 en 3200 bij zo'n lage resolutie, het is weinig in vergelijking met de verschillen die je bij Ryzen ziet, daar heb je 10-20 FPS verschil tussen 2400 en 3200 bij 1080p. Zie bijvoorbeeld ook deze korte vergelijking van RedGamingTech (ongeveer halverwege de video).

Ik vind benchmarks met 1280*720 in het algemeen niet nuttig in deze tijd. Je kan het als parameter voor een indicator van CPU-performance gebruiken - met caveats (je moet niet appels met peren vergelijken, de hogere multithreadperformance is net zo'n belangrijke indicator voor hoe goed de CPU X jaar later presteert als dat de betere performance bij lage resoluties is) - maar er zijn weinig mensen die in deze tijd met een lagere resolutie dan 1920*1080 spelen.

Het is geen punt van discussie of dat je bij Intel scaling ziet, de scaling is bij Intel veel kleiner dan bij Ryzen. Dat is logisch gezien het verschil in architectuur, Ryzen is min of meer 2 CPU's op 1 PCB waarbij Intel 1 CPU op 1 PCB heeft.

Overigens moet je bij Ryzen wel de kanttekening plaatsen dat het de totale kosten van het platform verhoogt. Lager dan 3000/3200 MT/s wil je echt niet doen bij Ryzen maar met de huidige afzetterij van Samsung, Hynix en Micron geeft dat helaas wel €50-100 extra kosten.

[ Voor 23% gewijzigd door Verwijderd op 20-05-2018 14:31 ]

[ Voor 3% gewijzigd door Fleximex op 20-05-2018 16:19 ]

Of kan zoiets ook gewoon nooit kunnen draaien.

[ Voor 8% gewijzigd door The Chosen One op 20-05-2018 17:41 ]

Mijn LEGALE dvd collectie; (altijd onder constructie) http://www.invelos.com/dvdcollection.aspx/The%20Chosen%20One - - - - - - - - - Quietum Grandis: https://nl.hardware.info/usersystemen/28203/quietum-grandis---ryzen-2700x-game-pc

Verschil tussen de twee resoluties is ongeveer 56% in die test. Dat is een prestatie toename die zeker ik nog wel verwacht te gaan zien op mijn huidige cpu platform. Mijn 2500K begon immers op een GTX 260 en eindigde op een GTX 1070. In ruwe rekenkracht zit daar factor 10 verschil tussen. Aan de gpu kant zie ik tot heden weinig reden zo pessimistisch te zijn dat die 56% niet gehaald wordt. Wat mij betreft is dus een dergelijke 720p test vooral informatief voor wie verwacht circa 5 jaar met zijn cpu platform door te willen komen (waar ik mijzelf ook onder reken).Verwijderd schreef op zondag 20 mei 2018 @ 14:25:

@sdk1985

Ik vind benchmarks met 1280*720 in het algemeen niet nuttig in deze tijd. Je kan het als parameter voor een indicator van CPU-performance gebruiken - met caveats (je moet niet appels met peren vergelijken, de hogere multithreadperformance is net zo'n belangrijke indicator voor hoe goed de CPU X jaar later presteert als dat de betere performance bij lage resoluties is) - maar er zijn weinig mensen die in deze tijd met een lagere resolutie dan 1920*1080 spelen.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Verwijderd

Ik val nu in herhaling, het is slechts een beperkte indicator aangezien daar tegenover staat dat software eveneens meer threads gaat gebruiken. Een 6c/12t Intel (dus de 8700k) vs. een 6c/12t Ryzen (dus de 2600(X)), dat kan je prima vergelijken met elkaar, daarvoor is een '720p'-test interessant. Een 6c/6t Intel vs. een 8c/16t Ryzen, daarvoor is het niet interessant aangezien je niet kan beoordelen - met zekerheid - hoe de toename van het aantal gebruikte threads opweegt tegenover de lagere singlethread-performance. Dat zijn de caveats die je moet maken wanneer je als reviewers een 720p vergelijking doet als indicator van CPU-performance, veel van die reviewers verzuimen om dat te doen om diverse redenen. Ik schat in dat spellen over een paar jaar standaard 16 threads gaan gebruiken (consoles) en dat die dan zijn afgestemd op de performance van 1 enkele core/thread bij de CPU's die in die consoles zit met de afstelling die daarvoor is gekozen. Aangezien bij consoles het vermogen laag moet zijn (hitte, klein volume, lawaai fan, prijs voeding...) ligt het voor de hand dat ze bij het programmeren uitgaan van 16 threads en 2,5-3,5 GHz. per thread. We weten zo goed als zeker dat de PS5 en de X2 (alleen gaat MS natuurlijk weer trollen met die naamsdk1985 schreef op zondag 20 mei 2018 @ 17:54:

[...]

Verschil tussen de twee resoluties is ongeveer 56% in die test. Dat is een prestatie toename die zeker ik nog wel verwacht te gaan zien op mijn huidige cpu platform. Mijn 2500K begon immers op een GTX 260 en eindigde op een GTX 1070. In ruwe rekenkracht zit daar factor 10 verschil tussen. Aan de gpu kant zie ik tot heden weinig reden zo pessimistisch te zijn dat die 56% niet gehaald wordt. Wat mij betreft is dus een dergelijke 720p test vooral informatief voor wie verwacht circa 5 jaar met zijn cpu platform door te willen komen (waar ik mijzelf ook onder reken).

[ Voor 17% gewijzigd door Verwijderd op 20-05-2018 20:32 ]

Ik denk tegen de tijd dat je die 0-20% (het verschil tussen AMD/Intel) op 720p gaat merken dat de meeste spellen over zijn op Vulkan of DX12 en dat je daar dus geen bottleneck meer hebt gezien Ryzen meer threads heeft. Jij doet iets van 5 jaar met je cpu, dus dat lijkt me een prima tijdlijn voor spellen om over te schakelen op de nieuwere render engines. Zelfs indies zijn dan over gezien alle grote engines het standaard ingebakken hebben.sdk1985 schreef op zondag 20 mei 2018 @ 17:54:

[...]

Verschil tussen de twee resoluties is ongeveer 56% in die test. Dat is een prestatie toename die zeker ik nog wel verwacht te gaan zien op mijn huidige cpu platform. Mijn 2500K begon immers op een GTX 260 en eindigde op een GTX 1070. In ruwe rekenkracht zit daar factor 10 verschil tussen. Aan de gpu kant zie ik tot heden weinig reden zo pessimistisch te zijn dat die 56% niet gehaald wordt. Wat mij betreft is dus een dergelijke 720p test vooral informatief voor wie verwacht circa 5 jaar met zijn cpu platform door te willen komen (waar ik mijzelf ook onder reken).

Als je alleen wilt gamen/office, dan kan je best af met Intel. Wil je daarnaast andere dingen met je pc doen die veel cores gebruiken (VM, compilen, encoden etc...) of gamen met streamen ben je beter af met Ryzen.

De 720p game test is altijd al een heel slechte test geweest. Het geeft namelijk alleen weer wat de geteste games nu doen in die paar seconden die de test vaak wordt gedraaid op die resolutie.sdk1985 schreef op zondag 20 mei 2018 @ 17:54:

[...]

Verschil tussen de twee resoluties is ongeveer 56% in die test. Dat is een prestatie toename die zeker ik nog wel verwacht te gaan zien op mijn huidige cpu platform. Mijn 2500K begon immers op een GTX 260 en eindigde op een GTX 1070. In ruwe rekenkracht zit daar factor 10 verschil tussen. Aan de gpu kant zie ik tot heden weinig reden zo pessimistisch te zijn dat die 56% niet gehaald wordt. Wat mij betreft is dus een dergelijke 720p test vooral informatief voor wie verwacht circa 5 jaar met zijn cpu platform door te willen komen (waar ik mijzelf ook onder reken).

Veel mensen staren zich al jaren blind op zulke tests, maar het geeft dus echt alleen een beeld van bovenstaande. Een zeer kort moment in de genoemde games op de genoemde lage instellingen. Zo'n test is dus ook alleen interessant voor mensen die die games spelen op zulke lage instellingen en dat zijn er vast niet veel.

Daarnaast moet je ook altijd afwachten of het gekozen moment ook een beetje representatief is voor de rest van de game, meestal ook niet namelijk. Meestal wordt er gekozen voor een moment wat het meest gemakkelijke te herhalen is, dat is logisch, maar maakt de test wel vrij nutteloos.

Hoe dan ook, als je denkt dat een 720p test realistisch is voor de komende 5 jaar dan zou ik upgraden naar een i3 8350K met snel geheugen en beide overklokken. Maar alle andere mensen kunnen beter een Ryzen 5 2600(X) nemen met ~3000MT/s geheugen voor een vergelijkbaar bedrag.

Een goede CPU test zou de games testen op de zwaarste momenten, met gebruikelijke instellingen en kijken naar frametimes. Alleen dat geeft een goede indicatie voor de games die getest worden. Niet voor toekomstige games overigens. Dat is iets waar je gewoon logisch over moet nadenken.

En omdat we bij zowel Intel als AMD nog wel iets van drie jaar met een vergelijkbare CPU architectuur en dus performance per thread zitten. Is het logisch om aan te nemen dat games alleen maar meer CPU kracht kunnen gebruiken als ze meer threads of core's gebruiken. Iets wat de laatste jaren, sinds Sandy Bridge trouwens al van toepassing is.

Sinds die tijd hebben we namelijk geen serieuze stap meer in performance per thread gehad. En sinds die tijd wordt multithread performance ook steeds belangrijker. Al zag je in het begin dat het in de Sandy Bridge tijd nog niet belangrijk was. Immers was de performance per thread elke generatie daarvoor toen nog wel een stap vooruit.

[ Voor 21% gewijzigd door Verwijderd op 21-05-2018 10:29 ]

Niet nodig. Met uitzondering van de G.Skill Sniper X zijn alle 3200MT/s+ setjes B-die. Die extreem hoge setjes zijn cherry picks die je toch nooit kan draaien op die snelheid met een gemiddelde chip. Dat geld ook voor Intel chips. Met een 2700X zou ik blij zijn als je 3600MT/s haalt of 3466MT/s met strakke timings. In principe kan je hiervoor ook een 3200MT/s C14 setje voor kopen. Die zijn niet goedkoper dan 3400MT/s C16 of 3600MT/s C17. Zijn namelijk dezelfde kwaliteit chips met lossere timings en hogere clockspeeds. Het enige dat je krijgt bij een hoger geclocked setje is het XMP profiel. Dat werkt de helft van de tijd toch niet, dus who cares?The Chosen One schreef op zondag 20 mei 2018 @ 17:20:

In principe kun je dus een 4500 setje kopen (heel slecht voorbeeld ofc) en dan 100% stabiel op 3000/3200 kunnen draaien puur door de speed/timings e.d. op safe/strak te zetten?

Of kan zoiets ook gewoon nooit kunnen draaien.

Verder alweer de 720P test?

Dit komt nu al jaar terug, en elke keer is de enige logische conclusie dat het onzin is. Om maar even een voorbeeld te pakken. Neem AC Origins. Die game kan je net spelen op een quadcore in de relatief lege omgevingen. Ga je Alexandrië binnen, dan krijg je een diavoorstelling op een quadcore. Dat is je 720P test in actie. De quadcore CPU loopt gewoon 100% op alle cores en vormt een enorme bottleneck. 720P testen gaat dat nooit detecteren, zeker als je niet benchmarked op locaties waar de CPU load zwaar is. Om dat eens te demonstreren wederom een van de zeer weinige reviews die werkelijk wat zinvols heeft getest...

"Gewoon" je Titan Xp en 1080P, maar in CPU intensieve gebieden liepen de Ryzen 1600(X) al weg van de 7600K. Dat is hier de trend die al jaren bezig is, en dat is waarom je geen quadcore meer moet kopen. Dat was vorig jaar zo, en dat is dit jaar nog veel meer zo.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik heb zelf reeds een 8700KVerwijderd schreef op maandag 21 mei 2018 @ 09:22:

[...]

Hoe dan ook, als je denkt dat een 720p test realistisch is voor de komende 5 jaar dan zou ik upgraden naar een i3 8350K met snel geheugen en beide overklokken. Maar alle andere mensen kunnen beter een Ryzen 5 2600(X) nemen met ~3000MT/s geheugen voor een vergelijkbaar bedrag.

Een goede CPU test zou de games testen op de zwaarste momenten, met gebruikelijke instellingen en kijken naar frametimes. Alleen dat geeft een goede indicatie voor de games die getest worden. Niet voor toekomstige games overigens. Dat is iets waar je gewoon logisch over moet nadenken.

En omdat we bij zowel Intel als AMD nog wel iets van drie jaar met een vergelijkbare CPU architectuur en dus performance per thread zitten. Is het logisch om aan te nemen dat games alleen maar meer CPU kracht kunnen gebruiken als ze meer threads of core's gebruiken. Iets wat de laatste jaren, sinds Sandy Bridge trouwens al van toepassing is.

Sinds die tijd hebben we namelijk geen serieuze stap meer in performance per thread gehad. En sinds die tijd wordt multithread performance ook steeds belangrijker. Al zag je in het begin dat het in de Sandy Bridge tijd nog niet belangrijk was. Immers was de performance per thread elke generatie daarvoor toen nog wel een stap vooruit.

Wat betreft Sandy Bridge, die heb ik ook nog staan. Daarbij merk je toch dat skylake in een aantal games een flink betere IPC heeft. Ik heb hier vaker het voorbeeld van Rainbow Six Siege gegeven waarbij mij G4560 betere minimum fps haalt dan mijn 2500K op 4.4+ Ghz. Dit is eigenlijk alleen te verklaren door de +- verdubbeling van de AVX prestaties. Immers de ipc per clock weegt niet op tegen de flink lagere clock (1.4 Gz minder) en het ontbreken van 2 fysieke cores. Het AVX vermoeden wordt bevestigd wordt op mijn 8700K omdat rainbow six siege daar altijd met de avx offset draait. Het sentiment dat er sinds Sandy Bridge niets is verandert klopt dus niet.

Verder was er een direct aantal games waarbij Sandy Bridge stock direct na launch niet voldoende was en je tegen een cpu bottleneck aan liep. De voor mij bekendste daarvan was F1 2010 en dan met name de Monaco track. Opmerkelijk genoeg draaide die game toen al op 80%+ core loads en was daarmee toen al opmerkelijk multithreaded. Als ik mij niet vergis zat ik toen nog op de voor die tijd niet bijzondere GTX 260.

Maar goed hoe je het ook went of keert de gouden regel bij pc hardware is dat je nooit hardware moet kopen op de gok dat het in de toekomst ineens de betere keuze wordt. Die denkfout werkt namelijk alleen maar in je eigen nadeel. Je levert op 'dit' moment prestatie in terwijl je in de toekomst maar moet afwachten wat er gebeurd. Hoe langer het duurt voor die toekomst waarheid wordt, als het al gebeurd, des te groter de kans dat je voor een prikkie kunt upgraden naar een superieur alternatief op beide vlakken.

Andere gouden regel is dat games altijd een main thread hebben die voldoende lucht moet hebben om de boel aan te sturen. De multithreaded toekomst zit er zeker aan te komen de vraag is even of de huidige generatie daar al sterk genoeg voor is. Aangezien bijvoorbeeld een 2600X, welke dicht bij zijn maximum OC zit, nu al 10 a 20% achter loopt op bijvoorbeeld een stock 8600K heb ik daar serieus mijn twijfels over wat die cpu betreft.

Combineer beiden regels en de 8600K blijft de veiligste optie. Die cpu is immers nu de onbetwiste winnaar op fps en frame times. Verder heeft hij, niet toevallig, ook de beste single threaded performance. Waar overigens ook nog veel rek in zit. Mijn 8700K met HT uit draaide stabiel op x52.

Los daarvan vind ik de 2600X een hele leuke cpu voor een leuke prijs. De nieuwe generatie loopt wellis waar feitelijk nog steeds achter, maar ze kunnen zeker mee komen. Maar ik zou mezelf daarmee niet rijk gaan rekenen. Je ziet dat de eerste Ryzen nu eigenlijk hun relevantie al volledig hebben verloren. Die konden op gaming immers helemaal niet mee komen en ik zie dat eigenlijk de komende 4 jaar niet veranderen. Ik moet de eerste game waarbij een 1800X significant sneller is dan een 8600K nog tegen komen. Voor Adobe software hoef je de 2600X ook niet te nemen, lightroom en photoshop en premiere ga je geen winsten zien, zeker niet met OC. Wat resteert is de prijs, je kiest voor een 2600X omdat een 8600K te duur voor je is. (Of omdat je heel graag een AMD cpu wil).

Of ik een 2600X in plaats van een 8400 zou aanraden vind ik lastig omdat ik een Asrock bord heb gehad waarbij base frequency overclocking perfect werkte. Maar ik heb geen 8400 getest dus of je die naar 5 Ghz kunt krijgen weet ik niet. Je kunt het proberen en anders terug sturen...

Een quadcore zou ik zelf overigens ook niet snel aanraden, dat is niet nodig binnen het huidige aanbod.

[ Voor 23% gewijzigd door sdk1985 op 21-05-2018 12:18 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Verwijderd

Crysis 3 is een nog mooier voorbeeld waarbij de 1600 gehakt maakt van de 7600k maar ACO laat vooral goed zien hoe erg je FPS-getallen met een korrel zout moet nemen aangezien het zo sterk afhangt van het stuk in het spel waarin die zijn gemeten. Is er veel extra werk die door andere threads kan worden uitgevoerd (NPC's bijvoorbeeld) dan wint de trage 6c/12t het ruimschoots van de snelle 4c/4t, is het een stuk waarbij vooral plaatjes worden getekend en wordt DX11 gebruikt dan wint de snelle 4c/4t het. Dan toch beter die trage 6c/12t aangezien de zwakste momenten in het spel het meest bepalen hoe lekker het speelt. Liever die 10% achterstand in delen en nergens een grote dip dan die 10% voorsprong in delen en regelmatig een grote dip. Van Assassin's Creed Origins is bekend dat zelfs de 7700k het niet redt in delen van het spel (rond de 30 FPS).

Als je voor Intel kiest, kies dan de 8700k of wacht op die 8c waarvan ik verwacht dat die €400-450 gaat kosten. Go big or go home.

[ Voor 9% gewijzigd door Verwijderd op 21-05-2018 12:00 ]

Ik denk niet dat hier iemand is die een quadcore gaat aanraden. The mask was niet serieus in zijn advies om voor een 8350K te gaan. Maar we gaan offtopic want het is stiekem niet het advies topic hier, doe ik zelf ook foutVerwijderd schreef op maandag 21 mei 2018 @ 11:55:

Volgens mij is dat AC Unity.

Crysis 3 is een nog mooier voorbeeld waarbij de 1600 gehakt maakt van de 7600k maar ACO laat vooral goed zien hoe erg je FPS-getallen met een korrel zout moet nemen aangezien het zo sterk afhangt van het stuk in het spel waarin die zijn gemeten. Is er veel extra werk die door andere threads kan worden uitgevoerd (NPC's bijvoorbeeld) dan wint de trage 6c/12t het ruimschoots van de snelle 4c/4t, is het een stuk waarbij vooral plaatjes worden getekend en wordt DX11 gebruikt dan wint de snelle 4c/4t het. Dan toch beter die trage 6c/12t aangezien de zwakste momenten in het spel het meest bepalen hoe lekker het speelt. Liever die 10% achterstand in delen en nergens een grote dip dan die 10% voorsprong in delen en regelmatig een grote dip. Van Assassin's Creed Origins is bekend dat zelfs de 7700k het niet redt in delen van het spel (rond de 30 FPS).

Als je voor Intel kiest, kies dan de 8700k of wacht op die 8c waarvan ik verwacht dat die €400-450 gaat kosten. Go big or go home.

[ Voor 3% gewijzigd door sdk1985 op 21-05-2018 12:20 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Nee ofcourse niet maar gewoon puur theoretisch gezien bedoel ik. Kun je een bijv. 4500/5000 (adata?) setje op 3200 100% stabiel laten draaien. Onzin om daadwerkelijk te doen natuurlijk. Maar is zoiets mogelijk met ram?DaniëlWW2 schreef op maandag 21 mei 2018 @ 11:44:

[...]

Niet nodig. Met uitzondering van de G.Skill Sniper X zijn alle 3200MT/s+ setjes B-die. Die extreem hoge setjes zijn cherry picks die je toch nooit kan draaien op die snelheid met een gemiddelde chip. Dat geld ook voor Intel chips. Met een 2700X zou ik blij zijn als je 3600MT/s haalt of 3466MT/s met strakke timings. In principe kan je hiervoor ook een 3200MT/s C14 setje voor kopen. Die zijn niet goedkoper dan 3400MT/s C16 of 3600MT/s C17. Zijn namelijk dezelfde kwaliteit chips met lossere timings en hogere clockspeeds. Het enige dat je krijgt bij een hoger geclocked setje is het XMP profiel. Dat werkt de helft van de tijd toch niet, dus who cares?

Heb zelf al een 3600 setje, alleen nog op 1 ding uit Amerika wachten dan bestel ik de rest bij Azerty/sicomputers.

@Verwijderd Nee dat bedoel ik niet, of een 5000 setje omlaag zetten naar 3*** theoretisch mogelijk is. Dat dat niet slim is om te doen is ff een 2e, en 3e, en 4e. ;p

-

Quadcore is alleen nog aan te raden als je een 7700k/set voor 150-200 totaal kunt kopen of zo met budget limiet. Dus niet nieuw/los.

[ Voor 11% gewijzigd door The Chosen One op 21-05-2018 13:59 ]

Mijn LEGALE dvd collectie; (altijd onder constructie) http://www.invelos.com/dvdcollection.aspx/The%20Chosen%20One - - - - - - - - - Quietum Grandis: https://nl.hardware.info/usersystemen/28203/quietum-grandis---ryzen-2700x-game-pc

Natuurlijk kan dat. Gewoon je XMP profiel selecteren en handmatig 3200 invoeren en booten. Je timings zijn dan zo slecht dat het meteen zal werken.The Chosen One schreef op maandag 21 mei 2018 @ 12:20:

Nee ofcourse niet maar gewoon puur theoretisch gezien bedoel ik. Kun je een bijv. 4500/5000 (adata?) setje op 3200 100% stabiel laten draaien. Onzin om daadwerkelijk te doen natuurlijk. Maar is zoiets mogelijk met ram?

Heb zelf al een 3600 setje, alleen nog op 1 ding uit Amerika wachten dan bestel ik de rest bij Azerty/sicomputers.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Nu niet meer maar ik herinner mij van vorig jaar dat veel mensen nog beweerden dat de 7700k de betere keuze was dan een 6c/12t Ryzen. Ik doel nu niet specifiek op iemand of een paar mensen, je zag het internationaal. Pas nadat CL uitkwam gingen mensen aanvaarden dat de quadcore outdated is, de becnhmarks die lieten zien dat zelfs de 7600k en 7700k worstelen bij sommige spellen (op bepaalde momenten in het spel) hielpen hierbij.sdk1985 schreef op maandag 21 mei 2018 @ 12:19:

[...]

Ik denk niet dat hier iemand is die een quadcore gaat aanraden.

Er is voorlopig geen AMD-nieuws dus dat lijkt me voor nu niet zo'n probleem.Maar we gaan offtopic want het is stiekem niet het advies topic hier, doe ik zelf ook fout.

Nee! 36** MT/s lijkt het maximum te zijn voor Ryzen2, uiteraard afhankelijk van allerlei loterijen. Rond de 3800 MT/s lukt normaal gesproken niet (8 uur lang een RAM-test draaien of iets dergelijks). 36** of 34** met hele strakke timings is het beste wat je kunt doen qua RAM bij Ryzen2 en dit haal je als je goede latjes hebt en je geen pech hebt met de memorycontroller.The Chosen One schreef op maandag 21 mei 2018 @ 12:20:

[...]

Nee ofcourse niet maar gewoon puur theoretisch gezien bedoel ik. Kun je een bijv. 4500/5000 (adata?) setje op 3200 100% stabiel laten draaien.

Natuurlijk kan dat. Handmatig de klokfrequentie verlagen en de timings strakker zetten. In het algemeen is het zinloos (met de huidige DDR4) om snellere RAM dan 3600 MT/s te kopen, qua performance heb je meer aan 3600 MT/s met hele strakke timings dan 4000 MT/s of 'sneller' met losse timings. Buildzoid (hij is een competitieve overklokker) had hier het een en ander over uitgelegd, je kan dat gemakkelijk vinden, 3600 MT/s met strakke timings is het beste qua performance wat op de markt is, bij snellere RAM gaat het teveel ten koste van die timings.@CHBF Nee dat bedoel ik niet, of een 5000 setje omlaag zetten naar 3*** theoretisch mogelijk is.

[ Voor 77% gewijzigd door Verwijderd op 21-05-2018 14:06 ]

G4560 ondersteunt AVX niet. Geen enkele Celeron of Pentium doet dat. AVX en AVX2 vind je alleen in processors onder de "Core" noemers.sdk1985 schreef op maandag 21 mei 2018 @ 11:53:

Dit is eigenlijk alleen te verklaren door de +- verdubbeling van de AVX prestaties.

Dus nee, dat is het niet

Daarnaast overschat jij het gebruik en nut van AVX enorm voor games. Bij mijn weten is er geen enkele game engine die AVX gebruikt voor core rendering taken (zie hieronder). Zowel PhysX als Havok maken wel gebruik van AVX (indien aanwezig) voor enkele dingen. Cloth bijvoorbeeld. Maar ook dat is nauwelijks het geval in R6:S.

Sterker nog, AVX zou voor engines zelfs averechts werken, omdat de AVX pipeline "exclusief" is. Zodra die pipeline z'n werk moet doen vreet dat zo veel stroom dat de CPU ook echt even 100% daar op focust; vandaar ook dat AVX offsets nodig zijn, omdat je anders met langdurige 100% belasting op de betrokken pipelines het ding vrij rap naar z'n limieten trekt. De paar gevallen waar AVX wél vrij veel gebruikt wordt, doen dat met expliciete codepaths en dat is meestal voor physics. pCARS deed dat - of ze het nog steeds doen weet ik niet. Kijk voor de gein eens naar Epyc vs Skylake-EP; laatstgenoemde is op papier sneller met AVX en met kortdurig gebruik is dat ook zo, maar in de praktijk zie je dat AMD dat gevecht met gemak wint omdat ze niet zo hard hoeven te throttlen. Hetzelfde is in mindere mate waar voor Ryzen/Kaby.

Dat jouw 8700K op de AVX offset draait in R6:S zegt ook helemaal niets over of die game bewust AVX gebruikt, laat staan veelvuldig. Alle gangbare compilers (GCC, ICC, MSVC) hebben ingebakken optimalisaties die automatisch vector instructies (SSE, AVX) gebruiken indien aanwezig, echter gaat het dan over kleine optimalisaties - en die optimalisaties kun je ook uitschakelen. Zodra er echter een AVX instructie wordt gebruikt dan schakelt de offset in. Het hoeft er echt slechts één in een batch te zijn.

Dus zitten er AVX instructies in R6:S? Vast wel.

Is dat de reden dat jouw G4560 hogere minima haalt dan je 2500K? Absoluut niet, aangezien eerstgenoemde überhaupt geen AVX ondersteunt - eerder het omgekeerde, jouw 2500K throttled wellicht als een malle

En haalt R6:S bakken performance uit AVX? Absoluut niet, omdat AVX een hoop beperkingen op de CPU legt.

Net gechecked en er zit volgens cpu-z inderdaad helemaal geen AVX in de G4560. Dus dan kan de verklaring voor de betere performance van skylake in die game inderdaad absoluut niet in AVX worden gezocht. Sterker nog, de lijst van extensions tussen de 2500K en de G4560 is identiek. Resteert nog wel de verklaring waarom die game dan zoveel beter op skylake draait.Werelds schreef op maandag 21 mei 2018 @ 14:13:

[...]

G4560 ondersteunt AVX niet. Geen enkele Celeron of Pentium doet dat. AVX en AVX2 vind je alleen in processors onder de "Core" noemers.

Dus nee, dat is het niet

Daarnaast overschat jij het gebruik en nut van AVX enorm voor games. Bij mijn weten is er geen enkele game engine die AVX gebruikt voor core rendering taken (zie hieronder). Zowel PhysX als Havok maken wel gebruik van AVX (indien aanwezig) voor enkele dingen. Cloth bijvoorbeeld. Maar ook dat is nauwelijks het geval in R6:S.

Sterker nog, AVX zou voor engines zelfs averechts werken, omdat de AVX pipeline "exclusief" is. Zodra die pipeline z'n werk moet doen vreet dat zo veel stroom dat de CPU ook echt even 100% daar op focust; vandaar ook dat AVX offsets nodig zijn, omdat je anders met langdurige 100% belasting op de betrokken pipelines het ding vrij rap naar z'n limieten trekt. De paar gevallen waar AVX wél vrij veel gebruikt wordt, doen dat met expliciete codepaths en dat is meestal voor physics. pCARS deed dat - of ze het nog steeds doen weet ik niet. Kijk voor de gein eens naar Epyc vs Skylake-EP; laatstgenoemde is op papier sneller met AVX en met kortdurig gebruik is dat ook zo, maar in de praktijk zie je dat AMD dat gevecht met gemak wint omdat ze niet zo hard hoeven te throttlen. Hetzelfde is in mindere mate waar voor Ryzen/Kaby.

Dat jouw 8700K op de AVX offset draait in R6:S zegt ook helemaal niets over of die game bewust AVX gebruikt, laat staan veelvuldig. Alle gangbare compilers (GCC, ICC, MSVC) hebben ingebakken optimalisaties die automatisch vector instructies (SSE, AVX) gebruiken indien aanwezig, echter gaat het dan over kleine optimalisaties - en die optimalisaties kun je ook uitschakelen. Zodra er echter een AVX instructie wordt gebruikt dan schakelt de offset in. Het hoeft er echt slechts één in een batch te zijn.

Dus zitten er AVX instructies in R6:S? Vast wel.

Is dat de reden dat jouw G4560 hogere minima haalt dan je 2500K? Absoluut niet, aangezien eerstgenoemde überhaupt geen AVX ondersteunt - eerder het omgekeerde, jouw 2500K throttled wellicht als een malle

En haalt R6:S bakken performance uit AVX? Absoluut niet, omdat AVX een hoop beperkingen op de CPU legt.

De 2500K zelf kan ik niets aan ontdekken. Die wordt niet warmer dan 66 graden met prime95 (idle 40) en als je een synthetic draait dan scoort hij goed. Sterker nog hij zit zelfs in het 100e percentiel op http://www.userbenchmark.com/UserRun/5512397 .

Verder heeft een maatje van me de stock 3570K en ook hij liep in die game tegen 100% cpu belasting op. Toevallig deze week zijn cpu even op x40 gezet en ook toen had hij slechtere minimum fps dan mijn G4560. Videokaarten waren op dat moment redelijk gelijkwaardig (GTX 660 Ti op de G4560 en een GTX 670 op de 3570K).

Dat bij elkaar doet mij toch vermoeden dat er iets zit in skylake waardoor die game beter draait.

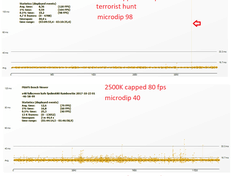

Bovenstaande heeft betrekking op de ingebouwde benchmark die wellicht niet heel representatief is. Maar heb vorig jaar ook gameplay opgenomen met FRAPS. Nog even ter illustraite hoe slecht die game op sandy (en dus ook ivy) draait:

Op de 8700K geen last (de streep daar de killcam):

Zou wellicht wel leuk zijn om iemand met een 1600X/2600X ook even FRAPS te laten draaien in terrorist hunt. Zien we meteen hoeveel beter dan Sandy/Ivy het dan is.

[ Voor 6% gewijzigd door sdk1985 op 21-05-2018 14:55 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Niet geheel identiek hoor: https://ark.intel.com/compare/97143,52210sdk1985 schreef op maandag 21 mei 2018 @ 14:45:

[...]

Net gechecked en er zit volgens cpu-z inderdaad helemaal geen AVX in de G4560. Dus dan kan de verklaring voor de betere performance van skylake in die game inderdaad absoluut niet in AVX worden gezocht. Sterker nog, de lijst van extensions tussen de 2500K en de G4560 is identiek. Resteert nog wel de verklaring waarom die game dan zoveel beter op skylake draait.

2500K heeft AVX wél

R6:S is een raar spel - ze hebben niet voor niets meerdere performance patches gedaan omdat hun spel zo raar overal op reageerdeDat bij elkaar doet mij toch vermoeden dat er iets zit in skylake waardoor die game beter draait.

Nog even ter illustraite hoe slecht die game op sandy (en dus ook ivy) draait:

[afbeelding]

Een 8400 doet het ook beter dan een 8700K. Het spel is ook 100% CPU-limited totdat je op 2160p zit te spelen. Met andere woorden: throttling en de manier waarop een driver gebruik maakt van de CPU is waardoor je die verschillen ziet.

In jouw geval zijn je benchmarks niet te vergelijken:

- De één heeft een FPS cap, de ander niet (FPS cap beperkt ook de CPU limit, waardoor je minima hoger uit kunnen vallen)

- De één op themepark, de ander op kafe (online sessies? even gegoogled en dat zijn blijkbaar namen van de maps

- De één loopt 4m46,1 - de ander slechts 2m44,4

Edit: ah, een edit

Die capped grafiek was dus ook van je 2500K. Het hoe en wat is lastig te vergelijken tenzij beide op dezelfde driver versie etc. waren - en de maps/omstandigheden blijven ook belangrijk.

[ Voor 6% gewijzigd door Werelds op 21-05-2018 15:04 ]

Haha maar even herschrijven dit...Werelds schreef op maandag 21 mei 2018 @ 15:00:

[...]

Niet geheel identiek hoor: https://ark.intel.com/compare/97143,52210

2500K heeft AVX wél

[...]

R6:S is een raar spel - ze hebben niet voor niets meerdere performance patches gedaan omdat hun spel zo raar overal op reageerde

Een 8400 doet het ook beter dan een 8700K. Het spel is ook 100% CPU-limited totdat je op 2160p zit te spelen. Met andere woorden: throttling en de manier waarop een driver gebruik maakt van de CPU is waardoor je die verschillen ziet.

In jouw geval zijn je benchmarks niet te vergelijken:

- De één heeft een FPS cap, de ander niet (FPS cap beperkt ook de CPU limit, waardoor je minima hoger uit kunnen vallen)

- De één op themepark, de ander op kafe (online sessies? even gegoogled en dat zijn blijkbaar namen van de maps)

- De één loopt 4m46,1 - de ander slechts 2m44,4

Dat het niet duidelijk is, is duidelijk. In de basis liep ik tegen een probleem aan op mijn oude systeem en dat was dat mijn rainbow six siege zoveel haperde dat ik niemand dood kreeg. Daar komt de eerste figuur in beeld. Immers het bleek dat een hogere framerate een dermate hoge overhead had dat het afgaan van een granaat of het intikken van een raampje ervoor kon zorgen dat je een halve seconde geen updates kreeg.

Dus even los van de map zie je op de 2500K dat het cappen van je fps altijd tot een flinke versmalling van de bandbreedte van je frame leidt. Verder inderdaad volkomen illustratief, andere games, andere tegenstanders, andere maps. Maar je moet maar even van mij aannemen dat het geen placebo effect is. Op elke map is het verschil even significant.

Dan de tweede figuur. Ik was nog altijd niet tevreden met de dips (40ms) dus toen heb ik de 8700K aangeschaft. Ik heb toen drie dagen later dezelfde GTX 1070 in de 8700K gegooid en ben ook daarmee gaan frapsen. Deze keer heb ik mijzelf beperkt tot terrorist hunt. Die modus is net wat zwaarder en kun je lekker snel doen (40seconde voor je dood bent). Dat leverde een verschil van dag en nacht op. Verder zie je dat zelfs met de 8700K het cappen nog altijd enige nut heeft.

Dat alles is puur voor mijn eigen spelplezier en niet om een review van te bouwen of iets dergelijks. Qua 'wetenschappelijk onderzoek' heb ik overigens wel met elke processor en framecap de ingebouwde benchmark gedaan. Persoonlijk vind ik die echter minder inzichtelijk de figuren die ik heb gedeeld. Daar zie je namelijk alleen de minimum, gemiddelde en maximum framerate.

Hoe dan ook is het bij deze game ook een kwestie van een niet te snelle videokaart hebben. Ik test zojuist de 2500K opnieuw met de ingebouwde benchmark. Die 2500K heeft nu een tragere 660 Ti en daar haal ik nu uncapped een minimum fps van 63.1. Daarmee is de prestatie vergelijkbaar met de G4560. Met de GTX 1070 knal je veel dieper omlaag. Getuige mijn eigen 8700K. Ik doe net de test even opnieuw en vandaag haalt die 15.4 min, 157 avg, 304 max.

Dus even heel kort door de bocht getallen uit de ingebouwde benchmark:

G4400 met GTX 660 Ti = 30 minimum

G4560 met GTX 660 Ti = 60 minimum

2500K OC met 660 Ti = 63 minimum

2500K OC met 1070 = <10 minimum

8700K met 1070 = 15 minimum (147 gemiddeld, 304 max)

8700K met 1070 / 120cap = 98 minimum (119,9 gemiddeld, 155 max)

Waarbij het dus het meest opmerkelijke is dat je met die 2500K rond de 4.4 Ghz nodig hebt om het niveau van de G4560 te evenaren. Onder de 4 Ghz hoef je het echt niet te proberen.

[ Voor 89% gewijzigd door sdk1985 op 21-05-2018 15:59 . Reden: opnieuw geschreven ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Wat voor geheugen gebruik je? Had laatst gelezen dat de 2500k zeker op 4.8Ghz een behoorlijke bandbreedte limiet heeft.sdk1985 schreef op maandag 21 mei 2018 @ 11:53:

[...]

Ik heb zelf reeds een 8700K.

Wat betreft Sandy Bridge, die heb ik ook nog staan. Daarbij merk je toch dat skylake in een aantal games een flink betere IPC heeft. Ik heb hier vaker het voorbeeld van Rainbow Six Siege gegeven waarbij mij G4560 betere minimum fps haalt dan mijn 2500K op 4.4+ Ghz. Dit is eigenlijk alleen te verklaren door de +- verdubbeling van de AVX prestaties. Immers de ipc per clock weegt niet op tegen de flink lagere clock (1.4 Gz minder) en het ontbreken van 2 fysieke cores. Het AVX vermoeden wordt bevestigd wordt op mijn 8700K omdat rainbow six siege daar altijd met de avx offset draait. Het sentiment dat er sinds Sandy Bridge niets is verandert klopt dus niet.

Grote kans dat dat meer meespeelt dan dat cpus daadwerkelijk zoveel sneller is geworden.

Edit:

Ik zie dat je 1600 hebt. Als je naar 2133 c9 zou gaan is daar best nog wat te halen.

[ Voor 4% gewijzigd door Sp3ci3s8472 op 21-05-2018 16:48 ]

Zit 1 stapje boven stock inderdaad. G4560 zit op DDR4 2400 Mhz, ook 1 stapje erboven. Memory bandwidth niet aan gedacht, goede suggestie. Mocht ik mij vervelen dan kan ik de 2400 Mhz DDR4 weleens terug clocken en dan de 660 Ti weer bij de G4560 stoppen en kijken wat er gebeurd. Sneller ddr3 heb ik immers niet zomaar, maar het DDR4 vertragen is vrij eenvoudig.Sp3ci3s8472 schreef op maandag 21 mei 2018 @ 16:44:

[...]

Wat voor geheugen gebruik je? Had laatst gelezen dat de 2500k zeker op 4.8Ghz een behoorlijke bandbreedte limiet heeft.

Grote kans dat dat meer meespeelt dan dat cpus daadwerkelijk zoveel sneller is geworden.

Edit:

Ik zie dat je 1600 hebt. Als je naar 2133 c9 zou gaan is daar best nog wat te halen.

[ Voor 5% gewijzigd door sdk1985 op 21-05-2018 22:48 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Nieuwe spectre bug gevonden. Benieuwd wat de impact van mitigerende maatregel bij AMD is.

De intel oplossing waarbij ze de patch standaard uit laten staan in BIOS ivm de grote performancehit vind ik overigens niet ok. Hopelijk gaat AMD dit pad niet volgen.

AMD heeft aangegeven microcode en patches uit te rollen, maar geeft niet aan wat voor impact op performance dat gaat hebben.

Intel heeft ook al microcode beschikbaar gesteld aan oem's om zich tegen het risico te weren, met een iets grotere performance impact van 2 tot 8 procent. Vanwege deze impact heeft Intel echter besloten om de optie standaard uit te laten staan, waardoor gebruikers van kritieke systemen zelf in de bios de patch moeten aanzetten.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

AMD doet exact hetzelfde als Intel, fix zal ook daar standaard niet aan staan. Te vinden op https://www.amd.com/en/corporate/security-updatesHelp!!!! schreef op dinsdag 22 mei 2018 @ 10:24:

https://nl.hardware.info/...tel-amd-en-arm-processors

Nieuwe spectre bug gevonden. Benieuwd wat de impact van mitigerende maatregel bij AMD is.

De intel oplossing waarbij ze de patch standaard uit laten staan in BIOS ivm de grote performancehit vind ik overigens niet ok. Hopelijk gaat AMD dit pad niet volgen.

[...]

Edit: Denk trouwens dat jij een eerste versie van dat artikel quote, HWI heeft er wat anders staan nu.

Fabrikanten: de reacties van Arm, Intel en AMD

Arm heeft al laten weten de veelgebruikte Cortex-A57, -A72, -A73 en -A75 cpu-kernen getroffen zijn door v4. Er is per direct firmware beschikbaar die het probleem migreert met een performance impact van 1 tot 2% bij de meeste workloads. In juli moeten er nieuwe versies van de A72, A73 en A75 kernen uitkomen die resistent zijn tegen variant 2, en Cortex-A75 wordt ook resistent gemaakt tegen v3, ook bekend als Meltdown.

Intel heeft ook al microcode beschikbaar gesteld aan oem's om zich tegen het risico te weren, met een iets grotere performance impact van 2 tot 8 procent. Vanwege deze impact heeft Intel echter besloten om de optie standaard uit te laten staan, waardoor gebruikers van kritieke systemen zelf in de bios de patch moeten aanzetten.

AMD heeft aangegeven microcode en patches uit te rollen, maar geeft niet aan wat voor impact op performance dat gaat hebben. Net als Intel zal het de patches standaard uitgeschakeld laten, omdat het risico op misbruik erg klein is.

[ Voor 48% gewijzigd door Dennism op 22-05-2018 11:46 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Voor zover ik het begrepen heb door snel even de whitepaper te lezen die gelinkt is in dat artikel geven ze dit aan in de volgende zin in de Blog.DaniëlWW2 schreef op dinsdag 22 mei 2018 @ 12:00:

Nergens in die security blog van AMD, geeft AMD aan dat ze patches die ze aanbrengen via microcode, standaard uit zetten...

Die default setting zou betekenen fix niet geactiveerd, non-default setting fix wel geactiveerd. Zie ook de onderstaande uitleg van Red Hat waarin te zien is dat Memory Disambiguation on = Spectre V4 fix off.Based on the difficulty to exploit the vulnerability, AMD and our ecosystem partners currently recommend using the default setting that maintains support for memory disambiguation.

Mitigation

Red Hat recommends customers apply the microcode/firmware update provided by your hardware or CPU vendor and also install these updated kernels as soon as possible. Software updates can be applied independently from the hardware microcode, but will not take effect until the CPU firmware has been updated.

Customers are advised to take a risk-based approach in mitigating this issue. Systems that require high degrees of security and trust should be addressed first, and should be isolated from untrusted systems until such time as treatments can be applied to those systems to reduce the risk of exploitation.

x86 processors from Intel and AMD offer Model Specific Registers(MSRs) which can be used to enable/disable the Speculative Store Bypass function. Using these MSRs, the new kernel updates offer the following kernel command line parameters:

spec_store_bypass_disable=[auto/on/off/prctl]

default: auto

auto: when booting with this option, the kernel detects if the processor supports the Speculative Store Bypass(SSB) function, and selects appropriate mitigation.

on: It turns the Speculative Store Bypass mitigation ON. The processor will not speculatively execute load(read) instructions, before all store(write) addresses are resolved.

off: It turns the Speculative Store Bypass mitigation OFF. The processor will use the memory disambiguator function to speculatively execute load(read) instructions before earlier store(write) instructions.

prctl: It enables the Speculative Store Bypass mitigation on a per-thread basis using the prctl(2) interface.

nospec_store_bypass_disable:

Disable all mitigations for the Speculative Store Bypass vulnerability.

[ Voor 57% gewijzigd door Dennism op 22-05-2018 12:48 ]

Verwijderd

https://www.phoronix.com/...y-LLVM-Ryzen-Improvements

One of Sony's compiler experts has taken to working on some tuning for the AMD Ryzen "znver1" microarchitecture support within the LLVM compiler stack. This begs the question why Sony is working on Ryzen improvements if not for a future product.

Sony's Simon Pilgrim has been recently investing time in the "znver1" AMD first-generation Zen CPU support within LLVM. Simon has been a programmer for Sony for the past decade. His LinkedIn reveals that indeed at Sony he's working on compiler tooling for the PlayStation devices:

...

But let's not forget that the PlayStation 4 is powered by a semi-custom AMD Jaguar CPU with GCN Radeon graphics. On top of that, Sony indeed uses LLVM/Clang as the compiler for the PlayStation 4. In fact, they contributed the PS4 support to upstream LLVM and have dealt with the upstream LLVM compiler community over the years.

...

Het punt lijkt te zijn dat ze er nu best wel intensief aan werken.

Hier kan je wat van zijn werk zien.

https://github.com/llvm-m...af3a06d63b63cda41243e1325

https://github.com/llvm-m...85e25fb5dadf26db3ad1d9e25

https://github.com/llvm-m...e3d63adc1daa815d69d00f9b0

Ik ben het met jou eens dat dit standaard aan hoort te staan. Voor de meeste gebruikers is het niet erg om een paar procent tot 10% performance-verlies te hebben maar de mindere veiligheid is wel een concreet probleem. Het gaat hierbij vooral om het beschermen van n00bs die niet eens weten wat een BIOS is en hoe ze daarin komen (wat overigens wordt verërgerd door OEM's die het nodig vinden om niet te melden hoe je in de BIOS komtHelp!!!! schreef op dinsdag 22 mei 2018 @ 10:24:

De intel oplossing waarbij ze de patch standaard uit laten staan in BIOS ivm de grote performancehit vind ik overigens niet ok. Hopelijk gaat AMD dit pad niet volgen.

[ Voor 43% gewijzigd door Verwijderd op 22-05-2018 12:47 ]

Staat dat niet op zo'n beetje ieder boot scherm? Volgens mij staat er altijd wel iets als Press F10 for Setup of iets van die strekking. Ik ken iig geen OEM die de Uefi / bios bewust niet vermelden tijdens het booten of in de documentatie.Verwijderd schreef op dinsdag 22 mei 2018 @ 12:39:

Het gaat hierbij vooral om het beschermen van n00bs die niet eens weten wat een BIOS is en hoe ze daarin komen (wat overigens wordt verërgerd door OEM's die het nodig vinden om niet te melden hoe je in de BIOS komt).

Verwijderd

Je zou het denken maar nee.Dennism schreef op dinsdag 22 mei 2018 @ 12:53:

[...]

Staat dat niet op zo'n beetje ieder boot scherm? Volgens mij staat er altijd wel iets als Press F10 for Setup of iets van die strekking.

Acer heeft het uitgeschakeld. Ik heb een laptop van Acer, je ziet daar enkel het logo op en je mag opzoeken met welke knop je het boot-menu of de BIOS laadt. Sterker nog, als je een ander besturingssysteem wil starten, zelfs via een live-USB, dan moet je eerst in een menu van de BIOS een wachtwoord invoeren alvorens je in een ander menu van de BIOS Safeboot uit te kunnen schakelen, tot die tijd is die optie 'greyed out'.

Tijd voor een Nederlands woord hiervoor!

Volgens mij stond er bij die laptop ook niets vermeld in de documentatie, niet in de papieren die je erbij kreeg. Er stond weinig informatie vermeld in de handleiding. Ik heb er echter niet erg aandachtig naar gekeken aangezien ik het niet de moeite waard vond na er vluchtig naar te hebben gekeken en te hebben besloten dat ik daar niets aan zou gaan hebben. Het is erg dun (een paar bladzijdes op een klein formaat), het is erg op n00bs gericht en er staat weinig zinvolle informatie in. "Eerst batterij opladen blablabla"

[ Voor 6% gewijzigd door Verwijderd op 22-05-2018 22:11 ]

Ohja, die bestaan ook nogVerwijderd schreef op dinsdag 22 mei 2018 @ 13:10:

[...]

Je zou het denken maar nee.

Acer heeft het uitgeschakeld.

Opzich logisch, een distro die een signed bootloader gebruikt moet dat ook oplossen trouwens.Ik heb een laptop van Acer, je ziet daar enkel het logo op en je mag opzoeken met welke knop je het boot-menu of de BIOS laadt. Sterker nog, als je een ander besturingssysteem wil starten, zelfs via een live-USB, dan moet je eerst in een menu van de BIOS een wachtwoord invoeren alvorens je in een ander menu van de bios Safeboot uit te kunnen schakelen, tot die tijd is die optie 'greyed out'.

Tijd voor een Nederlands woord hiervoor!

Van de 8 cores in de huidige lineup (2013) merk je amper iets. Sterker nog, zelfs de PS3 en Xbox 360 hadden meerdere threads (al dan niet gesimuleerd) en daar merkte je weinig van. Iedere keer zie je toch dat de huidige mainstream hardware op de desktop de meeste impact heeft op game ontwikkelaars. Daarnaast is gameload verdelen over 16 threads behoorlijk lastig. Je zult toch je data moeten syncen en daar zit de bottleneck. Vandaag de dag is daar gewoon geen echte oplossing voor en sterker nog, de Zen architectuur is zelfs in het nadeel in het scenario dat je al die threads gaat gebruiken en iedere frame alles weer bij elkaar moet komen.Verwijderd schreef op zondag 20 mei 2018 @ 20:28:

[...]

Aangezien bij consoles het vermogen laag moet zijn (hitte, klein volume, lawaai fan, prijs voeding...) ligt het voor de hand dat ze bij het programmeren uitgaan van 16 threads en 2,5-3,5 GHz. per thread. We weten zo goed als zeker dat de PS5 en de X2 (alleen gaat MS natuurlijk weer trollen met die naam) een Ryzen-CPU gaan krijgen.

16 threads op een dergelijke snelheid zou overigens een reusachtige stap zijn t.o.v. de huidige lineup. Een verdubbeling in threads, core snelheid en een veel betere IPC. Niet onmogelijk dus, maar het zou wel zo z'n impact hebben op de industrie.

[ Voor 13% gewijzigd door Paprika op 22-05-2018 13:28 ]

Valt bij de laatste op dat de 2700X toch iets te zwak blijft. Je ziet bijvoorbeeld in The Witcher wat microstutter terwijl de gpu load van de 8700K dan op 96% draait terwijl de 2700X op 79% blijft hangen. Even later zie je beide kanten 98% gpu weergeven. Dus de 2700X gaat wat slechter met het zware moment om. Dit is getest met een GTX 1080. Over 1-3 jaar zullen de effecten wat verder dramatiseren.

Verder zie ik dat de i3 duidelijk achter blijf top de 2600, de i3 stutter veel vaker en heftiger. Dit was wel te verwachten maar is toch even bevestigd...

[ Voor 12% gewijzigd door sdk1985 op 22-05-2018 14:59 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

De yields en clocks lijken me ook niet helemaal appels met appels.

De kans op 5GHz stabiele 8700K lijkt mij kleiner dan de kans op een 4,3GHz stabiele 2700X:

https://www.reddit.com/r/.../?st=jhhqai7j&sh=5458a74f

Daarnaast is er geen informatie over de kloksnelheid van het RAM geheugen. Dat kan een aardig verschil opleveren aldus diezelfde youtube channel:

Soms zie ik verschillen van 20%, maar goed ik ben geen lopende rekenmachine dus wat het gemiddeld scheelt geen idee.

YouTube: 2400Mhz vs 3600Mhz RAM Test in 8 Games (Ryzen 5 2600)

[ Voor 80% gewijzigd door madmaxnl op 22-05-2018 15:57 ]

Dat dachten de kopers van een Q6600 ook. Maar tegen de tijd dat dit bij trok had je de veel snellere i7 920 (en de goedkopere 875K) die zowel beter was als de Q6600 als de E6700/E6750 en de latere E8400.madmaxnl schreef op dinsdag 22 mei 2018 @ 15:28:

Kijk vooral niet naar de processor belasting... Over 1-3 jaar blijft een 8700K achter bij een 2700X.

Bij Far Cry 5 zie je dat de 2700X de gpu ook niet vol krijgt, de cpu hangt dan op slechts 17%. Dat is geen toeval, de game hangt daar op single threaded performance. Fc5 is een 'AMD game' dus wie weetkomt er nog een optimalisatie patch, echter de 8700K daadwerkelijk voorbij streven zie ik niet gebeuren. Maar goed in software kan in theorie alles

Qua games die nog moeten uitkomen is het erg koffiedik kijken. Tot heden zie ik zelf echter geen enkel teken dat we ineens een shift naar DX12/Vulkan krijgen. Daarnaast zien we ook dat in veel gevallen DX12 ook niet betekend dat je met een Nvidia kaart verbetering ziet. In Civ V doet DX12 bijvoorbeeld niets en in Battlefield 1 kost het performance. In die hoek hoef je het niet te zoeken en mid-range boeit het allemaal uberhaupt niet (gpu limited). Dus dan moet je er op gokken dat AMD binnen 1 tot 3 jaar terug is in high-end met een 'betaalbare' kaart én dat de games massaal gebruik gaan maken van DX12 en Vulkan. In beide afhankelijkheden heb ik zelf een hard hoofd...

[ Voor 6% gewijzigd door sdk1985 op 22-05-2018 16:01 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

En de FX-8150, FX-8350 vs de 2500K dan?sdk1985 schreef op dinsdag 22 mei 2018 @ 15:56:

[...]

Dat dachten de kopers van een Q6600 ook. Maar tegen de tijd dat dit bij trok had je de veel snellere i7 920 (en de goedkopere 875K) die zowel beter was als de Q6600 als de E6700/E6750 en de latere E8400.

Het is heel simpel, is er één thread 100% terwijl er nog andere threads staan te sufkutten dan is het alles behalve geoptimaliseerd. In de toekomst gaan CPUs nog veel meer threads krijgen. Dan gaan developers er niet meer komen met één thread in het honderd terwijl de rest op 10% zit.

Dat wint de 2500K, zeker met overclocks naar 4.6-4.8. Er zijn er niet veel die het testen, dit is uit 2017 met een i5 2400 (3.1 GHz...) vs 8350 op 4.0 GHz. De i5 wint, aldus de youtuber. YouTube: FX 8350 vs i5 2400 in 2017 | Which One You Should Have Bought 5 Year... Super betrouwbaar? Nee. Maar het geeft wel een indicatie dat de 8350 nu ineens niet magisch sneller is.

Daar ligt een taak voor de gameontwikkelaars om heel creatief te zijn want al jaren worden games opgesplitst in 20+ threads maar daarvan zijn er vaak 19 een stuk minder zwaar dan die ene. Bij de resource monitor (taakbeheer>prestatie>bron controle) kun je het aantal threads zien AFAIK. Bij GTAV stond er 28 als ik me niet vergis.Het is heel simpel, is er één thread 100% terwijl er nog andere threads staan te sufkutten dan is het alles behalve geoptimaliseerd. In de toekomst gaan CPUs nog veel meer threads krijgen. Dan gaan developers er niet meer komen met één thread in het honderd terwijl de rest op 10% zit.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Tja, maar zowel de PS4 als de XBONE draaien op Jaguar. IPC verschil met Zen is maar iets van 70 a 80%.Paprika schreef op dinsdag 22 mei 2018 @ 13:22:

[...]

Van de 8 cores in de huidige lineup (2013) merk je amper iets. Sterker nog, zelfs de PS3 en Xbox 360 hadden meerdere threads (al dan niet gesimuleerd) en daar merkte je weinig van. Iedere keer zie je toch dat de huidige mainstream hardware op de desktop de meeste impact heeft op game ontwikkelaars. Daarnaast is gameload verdelen over 16 threads behoorlijk lastig. Je zult toch je data moeten syncen en daar zit de bottleneck. Vandaag de dag is daar gewoon geen echte oplossing voor en sterker nog, de Zen architectuur is zelfs in het nadeel in het scenario dat je al die threads gaat gebruiken en iedere frame alles weer bij elkaar moet komen.

16 threads op een dergelijke snelheid zou overigens een reusachtige stap zijn t.o.v. de huidige lineup. Een verdubbeling in threads, core snelheid en een veel betere IPC. Niet onmogelijk dus, maar het zou wel zo z'n impact hebben op de industrie.

Qua GPU is het natuurlijk veel beter gesteld. De PS4 Pro heeft eigenlijk een Polaris 10 met 2xFP16. De XBONE X heeft een GPU die echt niet mis gestaan had in een mainstream systeem. 40CU, (eigenlijk 44CU maar vier staan uit) 384bit bus, 12GB GDDR5. Was waarschijnlijk een prachtige GTX1070 tegenhanger geweest als die chip ook was uitgebracht als dGPU. Natuurlijk loopt die voor geen ene meter in een console zonder extreme optimalisaties, maar daarom hebben consoles allang low level acces.

Ik zag trouwens ook dat deze tweede generatie op "16nm" word gebakken. Dat is dus TSMC waardoor er potentieel een boute bedrag verbonden zit aan AMD hun SoC verkopen aan Sony en MS.

Verder heb ik altijd begrepen dat als je eenmaal een zekere mate van parallellisatie introduceert in software, dat de moeilijkheid om extra threads aan te spreken eigenlijk verdwijnen. Dat is iets dat we de afgelopen drie jaar ook steeds meer zien in games. Het hek is van de dam qua aantal threads dat een game pakt. Gaan games eenmaal over vier heen, dan pakken ze al snel gewoon minstens 16 threads. Dat is tenminste het gedrag dat ik constant zie met games. De oudere stoppen vaak bij twee of vier, de nieuwere gooien een paar procent load op de meest threads. Natuurlijk doen de DX12 titels het helemaal goed met een goede verdeling over 16 threads.

Ik ben het dus niet helemaal met je eens dat het geen effect heeft. Een port van een game zal al snel flink wat threads aanspreken. Het is alleen zinloos omdat de game waarschijnlijk perfect draait op twee threads met console niveau instellingen, mits goed geoptimaliseerd. Het zou je vervolgens wel kunnen helpen als je ver voorbij console niveau instellingen gaat en bijvoorbeeld veel zwaardere physics effecten gaat draaien. Als die dan lekker op een andere core worden afgeschoven, dan helpt dat op PC.

Ik denk dat ook wel duidelijk is dat Sony bij AMD blijft voor de PS5. Van MS verwacht ik hetzelfde als ze nog mee blijven doen met XBOX. Omdat games in het algemeen op x86 CPU's draaien, zullen die ook nog wel even blijven als standaard voor de consoles. Vervolgens is AMD dan onverslaanbaar als leverancier van je primaire rekeneenheden. Alleen AMD kan zowel een CPU als GPU leveren, en dit doen ze voor het juist bedrag ook nog eens als een custom SoC. Voor de toekomstige consoles kan je zoiets als een Zen + Vega based SoC verwachten met waarschijnlijk GDDR6 voor zowel systeem als videogeheugen. Je werkt toch niet met sockets, dus je kan dit allemaal op een PCB zetten met geringe latency's.

De vraag zal eerder zijn of het op GoFlo 12nm of 7nm gebakken zal worden, of toch een TSMC node als AMD geen boete hoeft te betalen aan GoFlo.

[ Voor 3% gewijzigd door DaniëlWW2 op 22-05-2018 17:18 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

[ Voor 44% gewijzigd door Paprika op 22-05-2018 17:42 ]

Die settings in de spellen zijn erg random gekozen. Totaal niet logisch, je gaat bij een cpu test niet ineens mesh detail op het laagste niveau zetten en andere gpu bound dingen weer op high.sdk1985 schreef op dinsdag 22 mei 2018 @ 14:49:

Kwam trouwens een geinig channel tegen:

[video]

[video]

[video]

Valt bij de laatste op dat de 2700X toch iets te zwak blijft. Je ziet bijvoorbeeld in The Witcher wat microstutter terwijl de gpu load van de 8700K dan op 96% draait terwijl de 2700X op 79% blijft hangen. Even later zie je beide kanten 98% gpu weergeven. Dus de 2700X gaat wat slechter met het zware moment om. Dit is getest met een GTX 1080. Over 1-3 jaar zullen de effecten wat verder dramatiseren.

Verder zie ik dat de i3 duidelijk achter blijf top de 2600, de i3 stutter veel vaker en heftiger. Dit was wel te verwachten maar is toch even bevestigd...

Laat ik het zo stellen dat ik niet precies de waarde van deze testen inzie.

Over 1-3 jaar zullen de effecten minder zijn, tenzij je DX11 gaat gebruiken en 200fps verwacht.

Wat is het punt wat je precies probeert te maken? Het begint offtopic te raken. Zowel Intel als AMD hebben goede cpu's om op te gamen, je gaat daar niet de komende paar jaar een bottleneck zien waar dat met de FX series wel het geval was naar mijn mening.

Zolang je een cpu koopt met meer dan 8 threads dan zit je goed, hoewel 6 echte cores met of zonder MT een betere keuze is.

Games zoals AC Unity, AC Origins of the Witcher 3 heb ik het zelf ruimschoots kunnen ervaren. Unity ben ik al eens op ingegaan met de 60%+ load op alle 16 threads. En dan vroegen mensen zich af waarom het niet draaide op een quadcore.Paprika schreef op dinsdag 22 mei 2018 @ 17:39:

Welke game('s) hebben we het dan over (16 threads)? Zitten daar ook games bij die niet in de groep strategie en/of simulatie vallen?

Verder kan je natuurlijk BF1 aandragen, of the Division, of Crysis 3 als een zeer vroeg voorbeeld van een game die flink wat threads gebruikt, er er ook daadwerkelijk baad bij heeft. Die game haat quadcores. GTA 5 is ook een leuke die gewoon 16 threads kan aanspreken. Dit kan je ook allemaal online vinden.

Zie bijvoorbeeld:

YouTube: Ryzen 1700 vs i7 7700K | An Unbiased Look at Benchmarks

Ik kan heel lang doorgaan hoor. Er zijn maar weinig games uitgebracht de afgelopen jaren die niet enorm doorschalen met extra threads. Uitzonderingen zijn bijvoorbeeld HOI4 en City Skylikes, die dus voor geen ene meter draaien.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Wel slecht van Skylines. Daar zou 't makkelijk moeten kunnen.

[ Voor 93% gewijzigd door Paprika op 22-05-2018 19:07 ]

Ik zou juist willen beargumenteren dat Fortniter/PUBGer/LoLer/Dotaer/CSGOer/WoWer juist een specifiek genre van games zijn. Deze draaien allemaal op een aardappel @3GHz dus relevant voor benchmarking zijn ze eigenlijk ook niet.Paprika schreef op dinsdag 22 mei 2018 @ 18:57:

Voornamelijk AI/simulatie gedreven zo te lezen dan. Voor de mainstream Fortniter/PUBGer/LoLer/Dotaer/CSGOer/WoWer dus niet relevant.... Een echt kip-ei verhaal. Mainstream games hebben 't niet nodig dus liever 'n snelle Intel -> meeste mensen hebben een quad core dus we moeten daar op focussen.

Wel slecht van Skylines. Daar zou 't makkelijk moeten kunnen.

Daarnaast zijn er nog een aantal genres aan mainstream games. Die vragen in steeds grotere mate om flink wat CPU, en in steeds grotere mate is de quadcore daar niet meer voldoende voor. Daarin varieert het van lagere gemiddelde tot enorme framedrops.

Als we het dan over simulaties hebben, dan zou ik graag ArmA 3 aan willen dragen als het ultieme voorbeeld dat simulatie games niet per definitie gebruik maken van veel threads.

Verder is Paradox een beetje bijzonder omdat ze het concept van multithreading maar niet lijken te begrijpen. Met een 7700K @5GHz en een GTX1080Ti haal je in City Skylines alsnog geen stabiele 60fps.

[ Voor 6% gewijzigd door DaniëlWW2 op 22-05-2018 19:30 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

8 kernen die onderdoen voor een middelmatige quadcore van Intel of Ryzen vs. 8 serieuze kernen op 3-3,5 GHz. en SMT , dat is nogal een verschil! De performance zou minstens 2-3 keer zo hoog worden en qua vermogen is het ook prima te doen. Of dat het gebeurt moeten we afwachten maar wat zou dat toch de gaming kunnen verbeteren als developers er op een goede manier gebruik van leren maken. Tot nu toe hadden ze de hardware niet, hopelijk durft Sony het aan om wel met die hardware te komen en de developers de kans te geven om het te leren gebruiken.Paprika schreef op dinsdag 22 mei 2018 @ 13:22:

Van de 8 cores in de huidige lineup (2013) merk je amper iets.

Qua kosten zou het zeker mogelijk zijn, de vraag is of dat Sony de noodzaak ziet om die hardware te kopen. Zelfs 6c/12t zou al geweldig zijn in vergelijking met wat ze nu hebben. Ik denk dat je dan ook nog wel de factor 2 haalt.16 threads op een dergelijke snelheid zou overigens een reusachtige stap zijn t.o.v. de huidige lineup. Een verdubbeling in threads, core snelheid en een veel betere IPC. Niet onmogelijk dus, maar het zou wel zo z'n impact hebben op de industrie.

Dennism schreef op dinsdag 22 mei 2018 @ 13:15:

[...]

Ohja, die bestaan ook nogIk werk eigenlijk alleen met HP, IBM en Dell wat client machines betreft

Ze zijn het goedkoopst en ik stel weinig eisen aan laptops.

- 4c/8t check (al is het wat laag geklokt met 3,5/3,8 GHz)

- SSD check

- HD IPS check

- basic graphics

Naar het schijnt zijn ze goed genoeg en zijn ze tegenwoordig minder fragiel dan vroeger. Ik heb nog geen problemen gemerkt met ventilatie maar ik moet afwachten hoe dat over een jaar gaat zijn. De fan gaat enkel aan bij een serieuze CPU-load, niet bij licht gebruik (browser, video), dat is in ieder geval positief (minder snel stofophoping).

Voor mij is een laptop 100% een utility, ik gebruik het niet om te gamen en ik gebruik het niet voor multimedia, zware performance voor andere taken heb ik slechts af en toe nodig.

[quote]Opzich logisch, een distro die een signed bootloader gebruikt moet dat ook oplossen trouwens.

[/quote]

Ik probeerde Ubuntu 18.04 Mate uit op de laptop. ik kreeg enkel het desktopscherm te zien, geen knopjes of menu of zo. Op de desktop was het geen probleem en na het uitschakelen van de safe boot op de laptop was het ook geen probleem. Ik ben op zoek naar een goede Linux-distro voor op de laptop. Misschien iets met budgie? Kwestie van dat het voor productiviteit wel handig is als Windows niet de hele tijd lastig valt met updates (of Acer met idiote meldingen over batterijperformance 'verbeteren'

Ik gebruik dat ding thuis vaak dagenlang niet, zo gauw j het aanzet heb je weer dat update-gedoe, daar krijg ik het van op[ mijn heupen voordat je wat gedaan krijgt. Elke week zijn er wel weer nieuwe updates die het afsluiten en opstarten flink vertragen.

Het zou fijn zijn als MS (idem voor Mozilla overigens!) beveiliginsupdates zou loskoppelen van andere updates waar de meeste gebruikers niet op zitten te wachten. If something ain't broken...

[ Voor 35% gewijzigd door Verwijderd op 22-05-2018 19:45 ]

Als je dat van een game als WoW zegt, kan je dat van iedere game wel zeggenDaniëlWW2 schreef op dinsdag 22 mei 2018 @ 19:28:

Ik zou juist willen beargumenteren dat Fortniter/PUBGer/LoLer/Dotaer/CSGOer/WoWer juist een specifiek genre van games zijn. Deze draaien allemaal op een aardappel @3GHz dus relevant voor benchmarking zijn ze eigenlijk ook niet.

Ga je echter kijken naar hjigh end is er geen machine die WoW zal draaien in mythic raids op 1080P @ 60FPS+ zonder dips op de hoogste settings.

Nu is WoW imho inderdaad niet echt relevant voor benchmarks, omdat je alleen zaken kan benchen die geen performance nodig hebben en inderdaad op een tosti ijzer ook soepel draaien.

Echter denk ik dat over het algemeen de relevantie van die titels er wel is in benchmarks, zo hebben volgens mij bijv. pubg en fortnite bijv. ook aardig pittige hardware nodig om op hoge settings in hogere resolutie te spelen maar daarnaast ook de speler aantallen. Juist de populariteit van dat soort games maakt ze wat mij betreft relevant voor benchmarks. Als ik bijv. een systeem wil kopen om Pubg of fortnite spelen op 4K of 1440P en / of in 144Hz zijn juist die games om het algemeen imho een stuk relevanter dan AAA titels van EA/Ubisoft die even enigzins populair zijn maar vaak kort daarna nog maar door anderhalve man en een paar spreekwoordelijke paardekop gespeeld worden.

Ik denk dat dit mogelijk nog wel lastig is, ik meen ergens gelezen te hebben dat de bulk prijs die MS betaald heeft tussen de $100 en $75 heeft gezeten voor de One, One S en One X (start van de verkoop en de prijs later na de die-shrink en betere yields) en Sony voor de PS4 en PS4 Pro ook zo rond de $100, mogelijk ook hier wat minder na een tijdje met betere yields.Verwijderd schreef op dinsdag 22 mei 2018 @ 19:33:

Qua kosten zou het zeker mogelijk zijn, de vraag is of dat Sony de noodzaak ziet om die hardware te kopen. Zelfs 6c/12t zou al geweldig zijn in vergelijking met wat ze nu hebben. Ik denk dat je dan ook nog wel de factor 2 haalt.

Het lijkt me toch vrij lastig om een 8C/16T + een Vega GPU voordat budget in een SoC te stoppen.

[ Voor 20% gewijzigd door Dennism op 22-05-2018 20:09 ]

Verwijderd

Met respect, het zal vast niet gemakkelijk zijn maar we kunnen objectief vaststellen dat andere developers beter werk leveren qua optimalisatie. Zo bijzonder is PUBG niet in veel opzichten (voor de CPU zou het niet zwaarder dan bijvoorbeeld GTA5 moeten zijn en qua graphics is het niet bijzonder) en toch draait het gigantisch slecht.

Zijn de productiekosten van Ryzen zoveel hoger? De node is aanzienlijk kleiner, de yields zijn prima en naar het schijnt zou je een volle 16c/32t voor ongeveer $100 produceren, het lijkt me aannemelijk dat de kosten voor een 8c/16t minder dan de helft bedragen dan die van de 16c/32t (toch weer een paar extra stappen waarbij er wat mis kan gaan) waarmee de kosten voor een 8c/16t niet boven de $50 zouden moeten liggen. Dan heb je natuurlijk wel alleen nog maar de CPU. Geen idee wat de GPU zou kosten.Dennism schreef op dinsdag 22 mei 2018 @ 19:58:

Ik denk dat dit mogelijk nog wel lastig is, ik meen ergens gelezen te hebben dat de bulk prijs die MS betaald heeft tussen de $100 en $75 heeft gezeten voor de One, One S en One X (start van de verkoop en de prijs later na de die-shrink en betere yields) en Sony voor de PS4 en PS4 Pro ook zo rond de $100, mogelijk ook hier wat minder na een tijdje met betere yields.

Tegen de tijd dat dat spul uitkomt is het alweer een jaar later (eind 2019?), hopelijk zijn de productiekosten tegen die tijd laag genoeg dat het mogelijk is. Op zich interesseren consoles mij niet (ik heb een hekel aan vendor lock-in) maar voor de PC-gamers zou het echter wel leuk zijn als PC-gaming wat minder wordt afgeremd door die consoles.

Ik weet niet hoe het met jou zit, ik zou maar wat graag zien dat de CPU eens wat meer prioriteit zou krijgen, desnoods ten koste van de GPU. Die graphics zitten al op een redelijk hoog niveau, de CPU zit nog op niveau 0.

Een gebrekkige benutting van de CPU haalt je veel meer uit het spel dan het relatief kleine verschil in graphics. Het zou ook mooi zijn als developers eens betere algorithmen zouden ontwikkelen voor de PC (of andere voldoende krachtige CPU's). Maak maar eens een opties-menu zoals voor de graphics gebeurt.

Nog even over Acer, ze hebben nog steeds niemand in dienst die fatsoenlijk Engels beheerst. Bij een eerdere computer stond er bij het startscherm "no any devices found". In de BIOS van mijn laptop (Copyright Acer Inc.) staat er "Otherwise, touchpad will be no function". Dat kan toch niet bij zo'n groot bedrijf, een doorsnee 3-VMBO-leerling beheerst beter Engels dan de persoon die dit intypt voor de BIOS.

Edit

Als je denkt dat het niet gekker kan. Ik had als experiment van UEFI naar BIOS geschakeld, dan meldt de computer (BIOS?): "no bootable device" (ook herstart en het nog een keer geprobeerd). Daarna weer terug op UEFI gezet en het boot wel weer. What the fuck?

Er staat in de BIOS aangegeven dat UEFI wordt aanbevolen omdat Microsoft "dat aanbeveelt om de nieuwe features van Windows8 en hoger te gebruiken" maar blijkbaar is het niet eens mogelijk om via legacy BIOS te starten ondanks dat het als optie te selecteren is in de UEFI.

Het lijkt erop dat de fout voor dit probleem bij Microsoft ligt en niet bij Acer.

https://docs.microsoft.co...-mode-or-legacy-bios-mode

[ Voor 55% gewijzigd door Verwijderd op 22-05-2018 22:52 ]

Nieuwswaarde is dat die video's inzichtelijk maken hoe de diverse cpu's nu draaien (tijdje na launch), verder illustreerde hij ook mooi de quad vs 6core en zat er als kers op de taart ook nog antwoord op de grote vraag, hoe doet het beste van Intel (8700K 5 GHz) het tegen het beste van AMD (2700X 4.3 GHz).Sp3ci3s8472 schreef op dinsdag 22 mei 2018 @ 18:05:

[...]

Die settings in de spellen zijn erg random gekozen. Totaal niet logisch, je gaat bij een cpu test niet ineens mesh detail op het laagste niveau zetten en andere gpu bound dingen weer op high.

Laat ik het zo stellen dat ik niet precies de waarde van deze testen inzie.

Over 1-3 jaar zullen de effecten minder zijn, tenzij je DX11 gaat gebruiken en 200fps verwacht.

Wat is het punt wat je precies probeert te maken? Het begint offtopic te raken. Zowel Intel als AMD hebben goede cpu's om op te gamen, je gaat daar niet de komende paar jaar een bottleneck zien waar dat met de FX series wel het geval was naar mijn mening.

Zolang je een cpu koopt met meer dan 8 threads dan zit je goed, hoewel 6 echte cores met of zonder MT een betere keuze is.

Op het channel staat trouwens ook nog een video over 4,6,8 cores icm far cry 5.

Verder verwacht ik zelf dat er deze zomer nog wel een 1180 gaat komen (en een 1170) en ik gok weer op +35% indexatie waarde (tpu grafiekje, niet relatief maar aftrekken) en ik vrees dat de stock cpu's dan al door de mand gaan vallen. Je ziet immers nu al dips in gpu load veroorzaakt door tekorten aan cpu kracht in de bovenstaande runs.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Niet iedereen speelt op 720p/1080p (zeker niet met een 1080 lijkt me), die resoluties kan je ook prima af met een RX 580/GTX1060.sdk1985 schreef op dinsdag 22 mei 2018 @ 23:17:

[...]

Nieuwswaarde is dat die video's inzichtelijk maken hoe de diverse cpu's nu draaien (tijdje na launch), verder illustreerde hij ook mooi de quad vs 6core en zat er als kers op de taart ook nog antwoord op de grote vraag, hoe doet het beste van Intel (8700K 5 GHz) het tegen het beste van AMD (2700X 4.3 GHz).

Op het channel staat trouwens ook nog een video over 4,6,8 cores icm far cry 5.

Verder verwacht ik zelf dat er deze zomer nog wel een 1180 gaat komen (en een 1170) en ik gok weer op +35% indexatie waarde (tpu grafiekje, niet relatief maar aftrekken) en ik vrees dat de stock cpu's dan al door de mand gaan vallen. Je ziet immers nu al dips in gpu load veroorzaakt door tekorten aan cpu kracht in de bovenstaande runs.

Zodra er mooie schermen zijn ga ik naar een UWQHD scherm. Op die resolutie is een cpu limitatie de komende jaren geen probleem. Het is vrijwel zeker dat je eerder met een quadcore tegen een limitatie gaat aanlopen dan met een andere cpu, dat zie je nu al met Assasins Creed, dat gat zal alleen maar groter worden.

Volgens mij is ook dat compleet logisch, ik heb iig nog geen machines gezien die "zomaar" kunnen wisselen tussen Uefi en Bios.. Even snel uit mijn hoofd maakt Uefi gebruik van GPT en Bios van MBR en hebben ze beide verschillende bootloaders. Je kiest dan voor de installatie van je OS of je wil gaan installeren met Bios support of met Uefi support (volgens mij zijn er wel wat tools die een bestaande installatie kunnen converteren, ik heb ze echter nog nooit gebruikt). Zomaar Uefi uitzetten en bios aanzetten heb ik in ieder geval nog nooit zien werken.Verwijderd schreef op dinsdag 22 mei 2018 @ 21:58:

Als je denkt dat het niet gekker kan. Ik had als experiment van UEFI naar BIOS geschakeld, dan meldt de computer (BIOS?): "no bootable device" (ook herstart en het nog een keer geprobeerd). Daarna weer terug op UEFI gezet en het boot wel weer. What the fuck?

Er staat in de BIOS aangegeven dat UEFI wordt aanbevolen omdat Microsoft "dat aanbeveelt om de nieuwe features van Windows8 en hoger te gebruiken" maar blijkbaar is het niet eens mogelijk om via legacy BIOS te starten ondanks dat het als optie te selecteren is in de UEFI.

Het lijkt erop dat de fout voor dit probleem bij Microsoft ligt en niet bij Acer.

https://docs.microsoft.co...-mode-or-legacy-bios-mode

Verwijderd

Hier komt die weer, van The Stilt.Dennism schreef op dinsdag 22 mei 2018 @ 13:53:

Ik vind 16 threads, zeker bij 2.5 - 3.5Ghz nogal wat, zeker daar ze voor zover ik begrijp console cpu's rond de 30W maximaal verbruik willen hebben.

Zoals je ziet is 2,9 GHz. mogelijk met 30W. Dit hangt natuurlijk wat af van de specifieke load maar het geeft een goede indicatie. Bedenk hierbij dat dit de GF '14 nm'. is en niet hun '12 nm' die iets zuiniger is. Mogelijk is het tegen die tijd weer zuiniger en in theorie zouden ze zelfs GF/TSMC 7 nm. kunnen gebruiken (bij Polaris wachtte AMD niet lang met dat te verkopen aan Sony en MS).

Maar goed, laten we ons ajb. niet blindstaren op die 30 W. Er is geen goede reden dat 65 W niet zou kunnen en dan kan je zelfs 3,7 GH.z halen. Ik weet dat het een traditie is dat consolebakjes zo klein mogelijk zijn en een slechte voeding en koeling hebben maar daar kan iets aan worden gedaan, Maak het iets groter (hoger vooral), stop er een goede heatsink en 140 mm. fans in en een iets minder prutserige voeding. Zoveel maakt het niet uit voor de kosten.

4c/8t zou teleurstellend zijn voor ons PC-gamers. Zijn we eindelijk door AMD verlost van de quadcore CPU's nadat Intel jarenlang hun monopolie misbruikte en dan zitten we alsnog een volle generatie consoles (of 2, in ieder geval een periode van minstens 6 jaar, de PS4 is er al sinds eind 2013) vast aan quadcore CPU's tenzij developers eindelijk eens apare algorithmes ontwikkelen voor de PC.ik zou eerder 6C/12T verwachten en misschien zelfs wel 4C/8T

6C zou kunnen maar dan zou AMD ofwel 2 goede kernen weggooien ofwel aardig wat beschadigende stukken hebben. We weten dat het laatste niet het geval is. AMD zou natuurlijk 2 kernen kunnen utischakelen om het vermogen lager te houden maar daar wordt niemand vrolijk van, behalve misschien de managers van Sony en MS.

[ Voor 6% gewijzigd door Verwijderd op 23-05-2018 18:36 ]

Als (ex) game developer snap ik dit argument niet. Op hogere resoluties moet vooral de GPU meer werk doen. De physics, AI, e.d. en het voorbereiden van de data voor de GPU veranderen niet significant qua werk. Dus op een hogere resolutie wordt hoe dan ook de GPU de bottleneck. Op een lagere resolutie zie je dus veel beter de impact die de CPU echt heeft.DaniëlWW2 schreef op maandag 21 mei 2018 @ 11:44:

[...]

Niet nodig. Met uitzondering van de G.Skill Sniper X zijn alle 3200MT/s+ setjes B-die. Die extreem hoge setjes zijn cherry picks die je toch nooit kan draaien op die snelheid met een gemiddelde chip. Dat geld ook voor Intel chips. Met een 2700X zou ik blij zijn als je 3600MT/s haalt of 3466MT/s met strakke timings. In principe kan je hiervoor ook een 3200MT/s C14 setje voor kopen. Die zijn niet goedkoper dan 3400MT/s C16 of 3600MT/s C17. Zijn namelijk dezelfde kwaliteit chips met lossere timings en hogere clockspeeds. Het enige dat je krijgt bij een hoger geclocked setje is het XMP profiel. Dat werkt de helft van de tijd toch niet, dus who cares?

Verder alweer de 720P test?

Dit komt nu al jaar terug, en elke keer is de enige logische conclusie dat het onzin is. Om maar even een voorbeeld te pakken. Neem AC Origins. Die game kan je net spelen op een quadcore in de relatief lege omgevingen. Ga je Alexandrië binnen, dan krijg je een diavoorstelling op een quadcore. Dat is je 720P test in actie. De quadcore CPU loopt gewoon 100% op alle cores en vormt een enorme bottleneck. 720P testen gaat dat nooit detecteren, zeker als je niet benchmarked op locaties waar de CPU load zwaar is. Om dat eens te demonstreren wederom een van de zeer weinige reviews die werkelijk wat zinvols heeft getest...

[video]

"Gewoon" je Titan Xp en 1080P, maar in CPU intensieve gebieden liepen de Ryzen 1600(X) al weg van de 7600K. Dat is hier de trend die al jaren bezig is, en dat is waarom je geen quadcore meer moet kopen. Dat was vorig jaar zo, en dat is dit jaar nog veel meer zo.

Het voorbeeld wat je geeft zou je dus juist moeten detecteren op 720p als de CPU echt de bottleneck is. Immers zal in dit geval de GPU je niet limiteren.

Een TItan XP op 1080p draaien is natuurlijk ook niet snel de bottleneck. Maar op 720p is je GTX960 dat ook niet meer. Zelfde test voor je CPU eigenlijk.