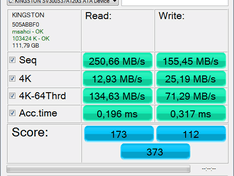

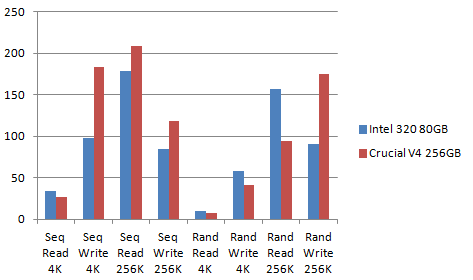

@Malantur: ik denk dat Xbench je een vertekend beeld geeft. Ik vermoed dat deze benchmark vooral bedoeld is voor hardeschijven, en geen goede I/O benchmark. Ter referentie, kijk eens wat tracebenchmarks doen op de Crucial

V4 met goedkopere Phison controller:

http://www.anandtech.com/...rt-bp3-msata-ssd-review/5

De Phison controller zie je vooral terug op USB sticks. Ook hoor ik diverse geluiden dat de prestaties over tijd flink kunnen degraderen. Desondanks kan het een overweging zijn voor simpele systemen. Toch heb ik dan liever een kleinere maar veel betrouwbaardere SSD, afgezien van het verschil in prestaties.

Maar ook naief. Zeker als de huidige firmware goed draait wil je eigenlijk geen grote wijzigingen in de firmware doorvoeren. Die moet je dan weer opnieuw valideren en beta-versies van uitbrengen en pas uitbrengen als het bewezen stabiel is.

De verbeteringen in de nieuwe Crucial M4 firmware (na 000F) proberen de betrouwbaarheid te vergroten, waarschijnlijk door de

window of opportunity te verkleinen waarin de mapping tables kwetsbaar zijn voor corruptie. Dat zal vast ingrijpende wijzigingen in de firmware teweeg hebben gebracht die kennelijk niet goed genoeg gevalideerd is door de eigen tests van Crucial. Een wijze les geleerd voor zowel ons gebruikers, als voor Crucial denk ik.

Phuncz schreef op zaterdag 02 februari 2013 @ 09:08:

Het feit is dat er veel mensen hun Crucial M4 hebben zien falen dankzij firmware-bugs. Dit terwijl, zoals CiPHER al regelmatig aanhaalt, de Crucial M4 door gebrek aan de meer ingewikkelde features (capacitors, RAIN,...) eigenlijk veel minder firmware-bugs zou moeten hebben, omdat het minder complex is.

Ik zou het net iets anders verwoorden; de Marvell 9174 is een simpele controller met weinig 'extra' features, maar de firmware heeft zichzelf wel uitontwikkeld en althans de 000F firmware is bewezen stabiel als zoveel gebruikers dit draaien en er geen golf van klachten kwam, zoals wel het geval was met Sandforce zeker in de vorige jaren - dan kun je wel stellen dat de firmware redelijk stabiel is.

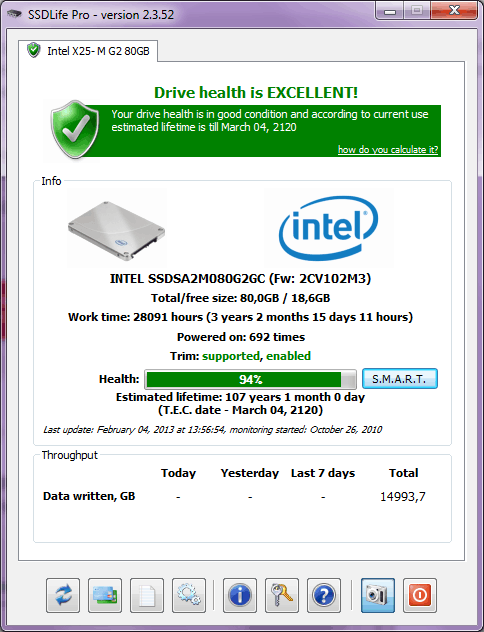

De potentie van de controller is echter beperkt, omdat het de hardware-features mist om echt betrouwbaar te kunnen zijn. Dus eigenlijk zou de Crucial M4 juist vaker moeten falen dan Intel 320 en Crucial M500 - althans op papier. Maar zoals we weten zijn firmware bugs de grootste factor, en dat kan ervoor zorgen dat de Crucial M500 of Intel 320 in de praktijk onveiliger zouden kunnen zijn. Dit laatste was ook min of meer het geval waarbij de Intel 320 een bug had in reactie tot onverwacht stroomverlies. Je zou zeggen dat juist dit scenario wel goed getest was door Intel, maar kennelijk niet goed genoeg. Je hebt dus theorie, en je hebt praktijk.

De Crucial M500 heeft wel meer beveiligingen zoals NAND RAID5 en power-safe capacitors wat

in theorie de SSD veel veiliger maakt. Maar het kan prima zijn dat bij de introductie de dan geleverde firmware nog allerlei bugs bevat die de SSD kan doen crashen in specifieke situaties. Dat was met de Crucial M4 ook zo (5000 uren bug). Ik denk echter wel dat Crucial zijn best zal doen om de M500 firmware goed op orde te krijgen cq houden. Wat natuurlijk hoop geeft is dat Crucial wacht met de M500 totdat de firmware beter op orde is, terwijl OCZ dezelfde controller (Marvell 9184) al reeds uitbracht als de Vertex4 ook al was de firmware nog niet op orde (hoge failure, klachten, write performance throttle). Datzeflde gebeurde ook met de Marvell 9174 meen ik.

Echter hebben de gebruikers al meermaals firmware met kritieke bugs voorgeschoteld gekregen maar de voorlaatste update heeft het gros van de slachtoffers gemaakt, deze is maanden aangeboden geweest en Crucial wist dat het fout liep.

Het is zeker curieus waarom Crucial de situatie zo lang heeft doen laten voortduren. Wat is er mis met firmware terugtrekken en de voorgaande goedwerkende firmware als 'laatste' op hun website aan te bieden? Had zeker veel gebruikers een hoop ellende kunnen besparen en dat ben je dan ook verplicht als bedrijf naar je gebruikers toe IMO.

Maar, er is geen echt alternatief. Dat Sandforce heb ik geen vertrouwen in dat zoveel complexiteit zal overleven. Bovendien is die complexiteit tegenwoordig nutteloos, omdat zelfs zonder trucjes SSDs nu schoon aan de haak 500MB/s+ snelheden behalen ook voor write. Zonder SATA bottleneck zou dat iets van 4GB/s read / 500MB/s write kunnen zijn, voor een 256GB SSD. Dus hoezo heb je compressie/dedup nodig en al die complexiteit als je zonder die shit al uitstekende prestaties haalt? Scheelt je een hoop ellende met simpelere firmware en dus een betrouwbaarder product.

Zit heel veel waarheid in. Maar er kunnen redenen zijn dat je toch wilt updaten. Denk aan firmware updates zoals Intel 320 '8MB bug' of Crucial M4 '5000 uren bug', maar ook security-updates voor je browser.

Bugfixes die 'conservatief' en dus minimaal invasief zijn, zijn denk ik wel een goed idee om te blijven volgen. Maar wat je eigenlijk niet wilt, zijn grote updates die de werking van de firmware veranderen en daardoor dus ook een grotere kans heeft op onvoorziene problemen ofwel regressies.

Hoe simpeler het storage-apparaat, des te minder de noodzaak voor het updaten van de firmware. Hardeschijven hebben maar zelden firmwareupdates omdat hun werking een stuk simpeler is. Sterker nog, veel hardeschijffabrikanten gebruiken firmware-code die sinds de jaren 80 in gebruik zijn, heb ik mij laten vertellen. Ofwel, de nodige terughoudendheid in fundamentele veranderingen in de firmware is vanzelfsprekend in deze branch.

Het is dus mijn stelling dat complexiteit voor zoveel mogelijk in software thuis hoort. Het opslagapparaat moet zo betrouwbaar, snel maar vooral zo simpel mogelijk gemaakt worden voor slechts één doel: het opslaan van gegevens en deze vervolgens weer kunnen uitlezen. Niets meer, niets minder.

:fill(white):strip_exif()/i/2005337204.jpeg?f=thumbmini)

:strip_icc():strip_exif()/u/363314/avator3.jpg?f=community)

:strip_exif()/u/69695/hp.gif?f=community)

:strip_exif()/u/17028/ico_sphere.gif?f=community)

/u/223246/abduction_android_game_small.png?f=community)

:strip_icc():strip_exif()/u/157053/crop574c68cea92df_cropped.jpeg?f=community)

/u/200133/artemis_square_e_60-60.png?f=community)

/u/92946/crop62436ae94df63_cropped.png?f=community)

:strip_icc():strip_exif()/u/172708/crop56372738e93da_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/55093/UPpharoah.jpg?f=community)

/u/413002/keyboard.png?f=community)

:strip_exif()/u/45096/Jumpman.gif?f=community)

:strip_icc():strip_exif()/u/438947/crop575c94eea6d14.jpeg?f=community)

:strip_exif()/u/109452/AMD.gif?f=community)

/u/374519/strikesngutters.png?f=community)

:strip_icc():strip_exif()/u/78991/Image2.jpg?f=community)