Dat zit hem puur in de fragmentatie van de schijf zelf en hoe goed jij voor je partities zorgt. Windows gebruikt min of meer de logica van het eerste vak dat vrij is. Dus als jij 10GB van je schijf vult met bijvoorbeeld je vakantie foto's. Vervolgens delete je +- 1000 foto's die je dubbel had dan ontstaat er +- 1000 gaten. Kom je vervolgens met een bestand aan dan is er een (in mijn ervaring grote) kans dat het bestand van 10mb gerust over 1000 stukken wordt verspreid. Ik heb zelfs bestanden van 1 MB gezien met meer dan 50 fragments.

Dat alles is op te lossen en voorkomen met een beetje slim partitie beleid en defragmentatie. Ik laat zelf mijn files regelmatig sorteren op alfabet (binnen elke map). Op die manier is de reistijd van de lees/schrijf kop altijd het kortste binnen één programma. Dus op cluster 21M staat Cities XL en op 23M staat C&C Red Alert 3. Aan de andere kant van de partitie staat Wargame European escalation.

Zeker voor het besproken doel hier (unrar/rar power) is een partitie van +- 100 GB geen issue. Dan kan je bovendien "short stroken".

Ik download met 28 connecties van usenet en dan komt het eigenlijk nog netjes op de disk terecht. Kwestie van even de article cache verhogen (ik heb hem altijd groter dan 200MB staan). Werkt overigens ook voor torrents.

Verder gaat een harddisk seeken als een bezetene als je leest en schrijft vanaf dezelfde disk.

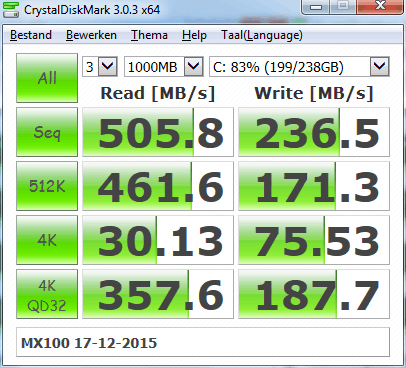

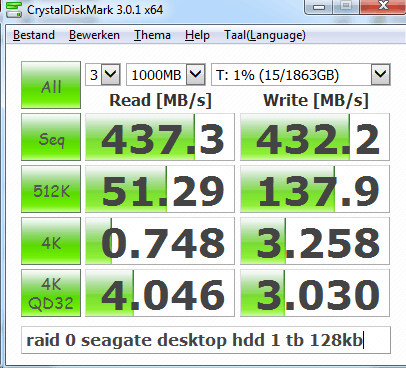

Je moet inderdaad niet dezelfde stap op dezelfde disk uitvoeren. Een hard disk zakt dan in van 220+mb/s naar 20mb/s. Je download dus schijf A, in mijn geval met 14 MB/s. Vervolgens ga je uitpakken naar een andere disk. Als schijf A een SSD is dan kun je met een goedkope raid array vervolgens met meer dan 440 MB/s uitpakken. Natuurlijk moet de cpu dat toestaan. Klinkt verder ook als veel stappen maar je kunt natuurlijk alles automatiseren. Persoonlijk is bij mij alles geautomatiseerd, van nzb zoeken tot het hernoemen van het bestand en in de juiste submap zetten.

Zolang de bron niet de array zelf is, is dus niet trager zoals te zien in de eerder geplaatste afbeelding. Mijn suggestie was de doelschijf te upgraden naar een raid 0.

Dat de data er sequentieel op staat is ook pure onzin natuurlijk. Als je een jaar lang zit te usenetten is je hele disk één grote gatenkaas en staan de 'sequentiële rars' gewoon kriskras overal verdeeld.

Ik weet niet hoeveel stappen jij maakt. Ik heb zelf mogelijk een wat uitgebreidere post processing.

Download / par2 disk (bandbreedte/cpu limited)

Unrar disk / post processing start (=renamen, subtitles, nfo, enz)

archive disk

Ik zou natuurlijk een SSD kunnen gebruiken om de download /par te combineren met de unrar disk maar ik vermoed eigenlijk dat ik er qua snelheid dan niets op vooruit ga. Het nadeel dat ik dan introduceer is dat de ssd snel gaat slijten. Die schijven gaan gerust 6 jaar mee

.

Als schijf 2 niet je einddoel is dan is hij het grootste deel van de tijd leeg en heb je dus ook geen fragmentatie. Je moet dan wel je usenet een privé partitie geven aan het begin van de schijf. Als schijf 2 wel je eind doel is dan zat je vroeger natuurlijk met dezelfde bottleneck. In dat geval is het niet gek om eens in de zoveel tijd eens een automatische defrag er overheen te gooien. Dan bedoel ik iets als O&O defrag space of complete/name. Windows defrag maakt het alleen maar erger.

Brad Pitt schreef op maandag 28 december 2015 @ 00:59:

[...]

Dat vind ik inderdaad echt ongelooflijk. Vrijwel altijd is het meeste van de 16GB hier geheel useless.

Bij sabnzbd een cache van 2GB ingesteld maar ik zie gewoon constant disk access, werkt dus ook niet*

* ook bij iets downloaden van bijv. 1GB is er constant disk activiteit terwijl dat, imho, pas moet ná het downloaden en parren

* ook bij iets downloaden van bijv. 1GB is er constant disk activiteit terwijl dat, imho, pas moet ná het downloaden en parren

Het idee van de cache bij sabnzbd is dat het een

article cache is. Zodra het bestand compleet is dan wordt het weggeschreven. Meer dan +- 200 MB heeft dus totaal geen nut. Meestal zijn die dingen +- 30 MB. Bij uTorrent kun je wel daadwerkelijk de disk access beperken omdat er vaak bestanden van x GB in de torrent zitten.

Ben overigens wel zeer benieuwd hoeveel jij hebt gedownload volgens Sabnzbd. Dan kan ik eens een inschatting maken hoe lang ik met een SSD zou doen

. Die BX200 480 GB is best betaalbaar

.

[

Voor 14% gewijzigd door

sdk1985 op 28-12-2015 03:56

]

:fill(white):strip_exif()/i/2005337204.jpeg?f=thumbmini)

:strip_icc():strip_exif()/u/363314/avator3.jpg?f=community)

:strip_exif()/u/417802/crop563540b38fe2f_cropped.gif?f=community)

:strip_exif()/u/154471/crop5e09176a82484.gif?f=community)

:strip_exif()/u/109452/AMD.gif?f=community)

:strip_exif()/u/142654/crop56fcd30735d45_cropped.gif?f=community)

/u/92946/crop62436ae94df63_cropped.png?f=community)

:strip_exif()/u/137941/ClockSpeedMeter.gif?f=community)

/u/4501/crop5bdb35c450e89.png?f=community)

:strip_icc():strip_exif()/u/157053/crop574c68cea92df_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/201712/crop5f651efa26417.jpeg?f=community)

:strip_icc():strip_exif()/u/664938/twava1_60.jpg?f=community)

:strip_exif()/u/128173/crop59a1592e54731_cropped.gif?f=community)

:strip_exif()/u/6897/IGKIPU.gif?f=community)

:strip_icc():strip_exif()/u/158536/850RGot.jpg?f=community)

/u/200133/artemis_square_e_60-60.png?f=community)

:strip_icc():strip_exif()/u/454512/crop56da14dba10bd_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/9637/crop60115ded088a3.jpeg?f=community)

:strip_icc():strip_exif()/u/30381/Monion_Driver60x60.jpg?f=community)