Ehm, de hibernation file is gewoon net zo groot als het RAM, niet 1,5 keer  Maar het kan alsnog een flinke besparing opleveren inderdaad.

Maar het kan alsnog een flinke besparing opleveren inderdaad.

Zijn er op dit moment eigenlijk m.2 ssd's behalve de XP941 die echt de moeite zijn t.o.v. sata ssd's?

Nadeel van de XP941 is wel dat ie duur is.

Nadeel van de XP941 is wel dat ie duur is.

En nu de "trol"/hoofd vraag...

Welk soort m.2 wil je ?

?

Welk soort m.2 wil je

[ Voor 5% gewijzigd door Swordlord op 23-08-2014 10:24 ]

Ik vermoed begin 2015 dat de M.2 fun times gaan beginnen:

De XP941 is een OEM-drive dus die is eigenlijk niet bedoeld voor retail. Maar Samsung komt ook niet bepaald snel met een retailversie op de proppen. Maar ook, performance die bijna 3x zo hoog ligt als een SATA SSD (max throughput dan), mag ook wel iets meer kosten.

[ Voor 26% gewijzigd door Phuncz op 23-08-2014 11:44 ]

Yep deze heb ik ook uitgezet, enige wat ik niet heb uitgezet is het fetch-gebeuren.Snowwie schreef op zaterdag 23 augustus 2014 @ 03:29:

[...]

Heb je Hibernation mode ook uitgezet? Deze beslaat namelijk standaard 1,5x je hoeveelheid ram op je ssd.

Uitzetten doe je zo: Open CMD (als administrator) en voer in : powercfg.exe -h off

Maar die files uit de roaming mappen e.d. moeten niet verplaatst worden?

Ik dacht dat in die mappen namelijk ook tijdelijke files van games en dergelijke geplaatst worden, en dat lijkt me nou niet bepaald nodig om op de ssd te houden?

Na wat zoeken ben ik op deze forumpost gestuit:RedJD schreef op zaterdag 23 augustus 2014 @ 15:09:

[...]

Yep deze heb ik ook uitgezet, enige wat ik niet heb uitgezet is het fetch-gebeuren.

Maar die files uit de roaming mappen e.d. moeten niet verplaatst worden?

Ik dacht dat in die mappen namelijk ook tijdelijke files van games en dergelijke geplaatst worden, en dat lijkt me nou niet bepaald nodig om op de ssd te houden?

http://forums.anandtech.com/showthread.php?t=2172265

Dit beantwoord eigenlijk mijn vraag ook gelijk, ik zal het gewoon houden op programma's e.d. installeren op de ssd samen met windows. Ik verplaats hooguit de downloads en documenten folder naar mijn andere hd!

"The only thing I don't keep on the SSDs are games, and large datafiles (including photos, audio, and video).

Everything else I keep on the SSD. There are lots of tweaks people suggest (including moving temp folders off the SSD) but these always hurt performance. The entire point of the SSD is that random reads/writes occur very quickly. If I wanted my temp folder on a spining platter, I wouldn't have purchased an SSD in the first place!"

Knap dat je nog extra moet zoeken op andere sites naar iets wat bijna om de pagina hier wordt verkondigd door vele inclusief mijzelf haha

Misschien klinkt het lomp, maar ik geef mijn SSD's geen speciale behandelingen, geen tweaks, niks nada noppes aan genade... ik gebruik gewoon die krengen waarvoor ze gemaakt zijn. Dat is een opslag apparaat zijn voor mijn OS en alles wat ermee te maken heeft + nog wat games..

Downloads van browser komen vaak ooknog als eerste terecht op men SSD..

Ondanks dit "lomp" gedrag, heeft men nieuwste SSD,een M500, na 2000 draaiuren pas 1.3TB aan data geschreven.

Het toont wel beetje aan hoe onterecht panisch sommige mensen doen over de writecycles bij normaal gebruik.

Misschien klinkt het lomp, maar ik geef mijn SSD's geen speciale behandelingen, geen tweaks, niks nada noppes aan genade... ik gebruik gewoon die krengen waarvoor ze gemaakt zijn. Dat is een opslag apparaat zijn voor mijn OS en alles wat ermee te maken heeft + nog wat games..

Downloads van browser komen vaak ooknog als eerste terecht op men SSD..

Ondanks dit "lomp" gedrag, heeft men nieuwste SSD,een M500, na 2000 draaiuren pas 1.3TB aan data geschreven.

Het toont wel beetje aan hoe onterecht panisch sommige mensen doen over de writecycles bij normaal gebruik.

Ze hadden het toen al goed (link is uit 2011). Het "probleem" was toen dat SSD nog niet al te groot waren en je dus met een ruimtegebrek zat, en dat ze per GB toch al snel 1 euro 50 waren.RedJD schreef op zaterdag 23 augustus 2014 @ 15:40:

[...]

Na wat zoeken ben ik op deze forumpost gestuit:

http://forums.anandtech.com/showthread.php?t=2172265

Dit beantwoord eigenlijk mijn vraag ook gelijk, i

Nu heb je al een hele goede 256 GB SSD voor 90 piek en spelen al die zaken niet meer. Het gaat nu puur om de performance. Je kan overigens indexing beter gewoon aanzetten mocht je dat weg-getweakt hebben, want met indexing aan gaat de boel echt beduidend sneller.

Tsja, ik wil gewoon wat meer zekerheid en een wat duidelijkere onderbouwing voor ik een definitief besluit wilde maken

Ik heb indexing inderdaad uitgezet, ik zal deze weer aanzetten ^^

Ik heb indexing inderdaad uitgezet, ik zal deze weer aanzetten ^^

Verwijderd

Zorgen voor een ssd zijn niet nodig maar een back-up maken blijft wel belangrijk , zijn juist de momenten als alles goed gaat en misschien minder oplet op je back-up dat het fout kan gaan. Is natuurlijk niet specifiek ssd , dat zie je bij Synology ook maar heb je een back-up dan ben je niet kwetsbaarRedJD schreef op zaterdag 23 augustus 2014 @ 16:59:

Tsja, ik wil gewoon wat meer zekerheid en een wat duidelijkere onderbouwing voor ik een definitief besluit wilde maken

Ik heb indexing inderdaad uitgezet, ik zal deze weer aanzetten ^^

Daar zit ook een voordeel in met het gebruik van een tweede D partitie voor data en programs , back-up kun je dan splitsen in een C systeem backup en een data backup van D . Een Systeem back-up is in mijn ogen niet interessant om vaak uit te voeren . Wel de D data back-uppen wanneer er nieuwe data bij komt of na updaten van files . Buiten dat het is de C de partitie die random writes en reads krijgt te verduren , dat is niet de D . Nu maakt het niet veel uit maar sequentieel files komen dan van D en op zo een manier kun je zelfs effectief een hd gebruiken

Verwijderd

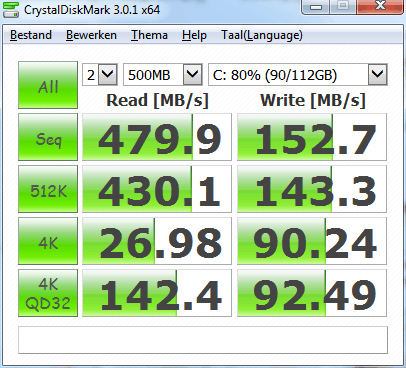

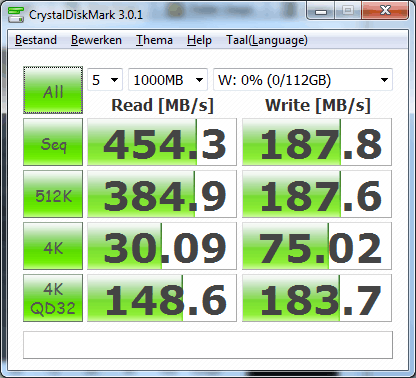

Wat voor waarde moet ik hier nu aan toekennen? Dit is met Rapid Mode van Samsung Magician enabled. Wordt ik nu in de maling genomen door de applicatie..

Bij rapid wordt het RAM geheugen gebruikt als buffer voor de SSD.

Je ziet nu dus de snelheid van je RAM geheugen.

Je ziet nu dus de snelheid van je RAM geheugen.

Hey iedereen;

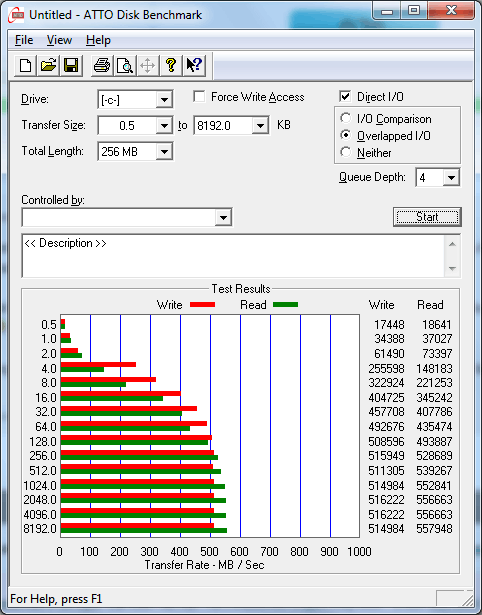

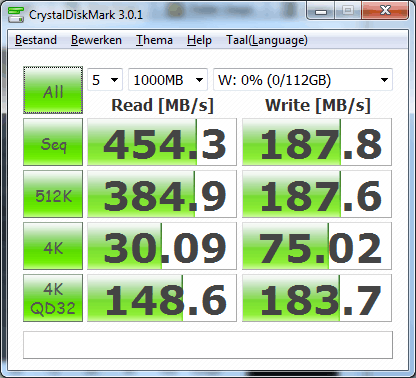

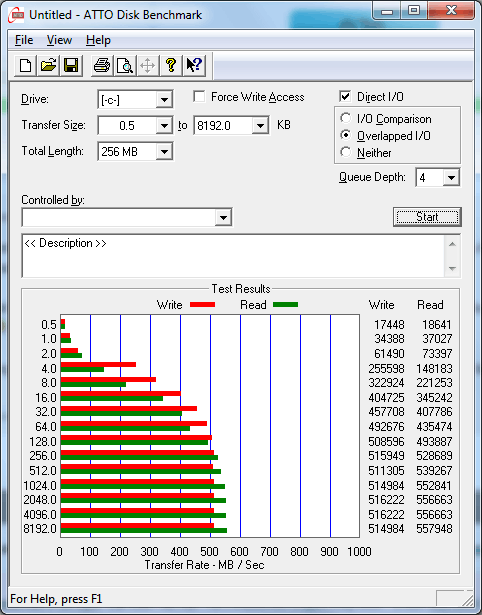

Ik heb net een nieuw (redelijk overkill) systeempje samengesteld (denk aan i7 4790K, 32GB Ballistic, 2x R9 290 4GB en 4x SSD in raid0)

Ik keek erg uit naar de snelheid van m'n RAID setje, maar hier klopt ergens iets niet.

het zijn 4x Sandisk Ultra Plus 256GB.

Alle 4 op de intel chipset van m'n MSI Xpower AC bordje.

RAID0 aangemaakt via BIOS (sorry, UEFI) --> 1024GB aan SSD storage. so far, so good.

Als ik echter kijk naar de snelheden die ik haal, gaat hij max rond de 700-800MB/sec (ATTO haalt een enkele keer 1GB/sec)

Dit zou toch een stuk meer moeten zijn?

Enig idee wat ik over het hoofd kijk?

Ik gebruik Windows 8.1 pro trouwens

Ik heb net een nieuw (redelijk overkill) systeempje samengesteld (denk aan i7 4790K, 32GB Ballistic, 2x R9 290 4GB en 4x SSD in raid0)

Ik keek erg uit naar de snelheid van m'n RAID setje, maar hier klopt ergens iets niet.

het zijn 4x Sandisk Ultra Plus 256GB.

Alle 4 op de intel chipset van m'n MSI Xpower AC bordje.

RAID0 aangemaakt via BIOS (sorry, UEFI) --> 1024GB aan SSD storage. so far, so good.

Als ik echter kijk naar de snelheden die ik haal, gaat hij max rond de 700-800MB/sec (ATTO haalt een enkele keer 1GB/sec)

Dit zou toch een stuk meer moeten zijn?

Enig idee wat ik over het hoofd kijk?

Ik gebruik Windows 8.1 pro trouwens

Alle ssd's op SATA600 aangesloten en niet SATA300?

alles op dezelfde controller volgens mij. volgens het boekje (ja, dat heb ik gelezen deze keer  ) zijn poort 1-6 Sata600 6gbps poorten

) zijn poort 1-6 Sata600 6gbps poorten

de SSDs hangen aan poort 3-4-5-6

de SSDs hangen aan poort 3-4-5-6

[ Voor 11% gewijzigd door Zer0CooL op 01-09-2014 21:04 ]

Verwijderd

Zo, hier honderd en tien draaiuren terug een intel 320 series 120GiB sata 300 in mijn 'kleine'systeempje gezet, heb hier meerdere machines in de woonkamer staan.

Na het lezen van CIPHER z'n blogs denk ik wel een goede aankoop te hebben gedaan, ikke 62€ terruggezet en ja, de machine 'voelt' lekker.

Ooit heel lang gelden in een andere machine een raptor gezet wat toen al je van het was, maar de SSD gaat het in mijn beleving toch wel 'winnen'.

Ik bedoel, je hoort het ding niet, er zit in het 'kleine' systeempje een mechanische HDD voor opslag maar het valt me nu pas op dat als ik iets zoek op die schijf dat er mechanisch lawaai te horen is..

Naja, ik ben om.

Het andere beest gaat ook een SSD als systeem schijf hebben.

Voor de liefhebber het "andere beest' weegt 46 Kg en heeft 'maar' 41 aansluitingen.

Na het lezen van CIPHER z'n blogs denk ik wel een goede aankoop te hebben gedaan, ikke 62€ terruggezet en ja, de machine 'voelt' lekker.

Ooit heel lang gelden in een andere machine een raptor gezet wat toen al je van het was, maar de SSD gaat het in mijn beleving toch wel 'winnen'.

Ik bedoel, je hoort het ding niet, er zit in het 'kleine' systeempje een mechanische HDD voor opslag maar het valt me nu pas op dat als ik iets zoek op die schijf dat er mechanisch lawaai te horen is..

Naja, ik ben om.

Het andere beest gaat ook een SSD als systeem schijf hebben.

Voor de liefhebber het "andere beest' weegt 46 Kg en heeft 'maar' 41 aansluitingen.

Ook intel RST driver er op etc? Je kunt wat andere kanalen en kabels proberen ook.Zer0CooL schreef op maandag 01 september 2014 @ 21:04:

alles op dezelfde controller volgens mij. volgens het boekje (ja, dat heb ik gelezen deze keer) zijn poort 1-6 Sata600 6gbps poorten

de SSDs hangen aan poort 3-4-5-6

Ik ben nu andere kabels aan het testen, en in poort 1-4 ipv 3-6.

als ik de intel rst driver probeer te installeren klaagt hij dat m'n systeem niet geschikt is hiervoor vreemd genoeg.

Ik heb een nieuwe array gemaakt met stripe=128 ipv de oorspronkelijke 32.

Ben dus nu Windows aan het herinstalleren (nogmaals)

Now we're talking...

andere kabeltjes, andere poorten, intel RST driver (dit keer de juiste) en het begint er al wat op te lijken...

als ik de intel rst driver probeer te installeren klaagt hij dat m'n systeem niet geschikt is hiervoor vreemd genoeg.

Ik heb een nieuwe array gemaakt met stripe=128 ipv de oorspronkelijke 32.

Ben dus nu Windows aan het herinstalleren (nogmaals)

Now we're talking...

andere kabeltjes, andere poorten, intel RST driver (dit keer de juiste) en het begint er al wat op te lijken...

[ Voor 24% gewijzigd door Zer0CooL op 02-09-2014 00:12 . Reden: info toegevoegd ]

Ik zit met een dilemma. Ik heb hier een Dell (Mobile Intel QM57 Express-chipset (SATA 2 helaas  ), Intel Core i5 520M 8GB DDR3 1333MHz), hier heb ik een Samsung 840 EVO 250GB ingezet. Deze start nu op met BIOS en staat op AHCI. Nu ondersteund deze Dell BIOS en UEFI. Nu heb ik zoveel gelezen over BIOS en UEFI (het zou sneller zijn, last van Secure Boot, etc.) Wat is nu wijsheid: De nieuwe Windows 8.1 Pro installatie installeren met BIOS en AHCI of UEFI en AHCI voor de beste resultaten met de Samsung 840 EVO (sneller dan 300 MB/s gaan we toch niet lezen en schrijven

), Intel Core i5 520M 8GB DDR3 1333MHz), hier heb ik een Samsung 840 EVO 250GB ingezet. Deze start nu op met BIOS en staat op AHCI. Nu ondersteund deze Dell BIOS en UEFI. Nu heb ik zoveel gelezen over BIOS en UEFI (het zou sneller zijn, last van Secure Boot, etc.) Wat is nu wijsheid: De nieuwe Windows 8.1 Pro installatie installeren met BIOS en AHCI of UEFI en AHCI voor de beste resultaten met de Samsung 840 EVO (sneller dan 300 MB/s gaan we toch niet lezen en schrijven  ).

).

Nintendo Network ID: Oo_Morris_oO | PSN: Oo_Morris_oO.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Best een mooi teken dat zelfs de 256GB nog mooi meekan van die PCIe x4 SSD. Ik kan niet wachten op de PCIe 3.0 x4 SSD van Crucial, gezien er een Marvell chipset op til is.

Ja inderdaad, mooie ontwikkelingen, eindelijk weer wat echt nieuws op SSD gebied. Vraag me wel af hoeveel je ervan in de praktijk gaat merken.

Ben tot nu toe wel heel tevreden over de marvell drives dus even kijken of ze ook op PCIe gebied weer tot de top gaan behoren.

2015 wordt waarschijnlijk duur jaar voor mij.

* PCIe SSD's (PCIe 3.0, NVMe)

* Skylake

* Freesync monitor

* 20nm GPU's

Ben tot nu toe wel heel tevreden over de marvell drives dus even kijken of ze ook op PCIe gebied weer tot de top gaan behoren.

2015 wordt waarschijnlijk duur jaar voor mij.

* PCIe SSD's (PCIe 3.0, NVMe)

* Skylake

* Freesync monitor

* 20nm GPU's

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Met wat browsen en alledaagse zooi zal het inderdaad niet veel nut hebben maar dat kunnen we ook zeggen van DDR3 -> DDR4 RAM. Het zal nu wel evolutie zijn, maar eentje die al lange tijd zéér traag ging (pre-SSD-tijdperk). Sowieso vooral omdat de industrie nog niet gebruik kan maken van de snelheid van SSD's doordat de meeste mensen nog steeds met HDD werkt.

Waar we nu 100'en IOPS met HDD's halen, zijn 100.000 IOPS op een PCIe SSD al geen uitzondering meer. Met NVMe wordt dat nog eens feller. Vooral games zouden anders gebruik gaan kunnen maken van storage, maar dat zie ik pas gebeuren als de consoles om zijn naar SSD. Ook het OS en de filesystem zal efficiënter kunnen werken als deze gericht worden op SSD als basis.

Waar we nu 100'en IOPS met HDD's halen, zijn 100.000 IOPS op een PCIe SSD al geen uitzondering meer. Met NVMe wordt dat nog eens feller. Vooral games zouden anders gebruik gaan kunnen maken van storage, maar dat zie ik pas gebeuren als de consoles om zijn naar SSD. Ook het OS en de filesystem zal efficiënter kunnen werken als deze gericht worden op SSD als basis.

Removed

[ Voor 98% gewijzigd door 1337LutZ op 07-09-2014 17:13 . Reden: Nieuwe topic. ]

Inderdaad, maar het zal nog minimaal zo'n 4 jaar duren voordat de consoles 'out of te box' van SSD's voorzien zijn, gezien de huidige generatie er pas net is (bijna een jaar nu). Het gros van de desktops en laptops in de modale klasse, die nu nieuw in de winkel liggen hebben nog steeds alleen HDD als opslag.Phuncz schreef op zaterdag 06 september 2014 @ 16:17:

Met wat browsen en alledaagse zooi zal het inderdaad niet veel nut hebben maar dat kunnen we ook zeggen van DDR3 -> DDR4 RAM. Het zal nu wel evolutie zijn, maar eentje die al lange tijd zéér traag ging (pre-SSD-tijdperk). Sowieso vooral omdat de industrie nog niet gebruik kan maken van de snelheid van SSD's doordat de meeste mensen nog steeds met HDD werkt.

Waar we nu 100'en IOPS met HDD's halen, zijn 100.000 IOPS op een PCIe SSD al geen uitzondering meer. Met NVMe wordt dat nog eens feller. Vooral games zouden anders gebruik gaan kunnen maken van storage, maar dat zie ik pas gebeuren als de consoles om zijn naar SSD. Ook het OS en de filesystem zal efficiënter kunnen werken als deze gericht worden op SSD als basis.

Nintendo Network ID: Oo_Morris_oO | PSN: Oo_Morris_oO.

Spijtig eigenlijk dat ze de nieuwe generatie consoles niet standaard voorzien hadden van flash-opslag. Maar misschien is het plan deze volgend jaar met een geupdate versie te voorzien van 60GB en 120GB SSD's (wat meer provisioning), want je maakt me niet wijs dat HDD's zoveel goedkoper zijn. Ook de betrouwbaarheid is bij SSD's hoger dus buiten capaciteitsverschillen, lijkt het me niet handig met de hoge mate van streaming media om consoles nog met grote HDD's te lanceren.

Bij consumer PC's eigenlijk een grootdeels zelfde verhaal, maar daar kan 60GB bij de meeste klanten niet door de beugel (die gaan al over de rooie met 250GB HDD's voor hun low-end internet PC).

Bij consumer PC's eigenlijk een grootdeels zelfde verhaal, maar daar kan 60GB bij de meeste klanten niet door de beugel (die gaan al over de rooie met 250GB HDD's voor hun low-end internet PC).

Aangezien beide consoles hard pushen op digitale content verwacht ik voorlopig nog niet flash geheugen uit de fabriek rollen.Phuncz schreef op maandag 08 september 2014 @ 10:09:

Spijtig eigenlijk dat ze de nieuwe generatie consoles niet standaard voorzien hadden van flash-opslag. Maar misschien is het plan deze volgend jaar met een geupdate versie te voorzien van 60GB en 120GB SSD's (wat meer provisioning), want je maakt me niet wijs dat HDD's zoveel goedkoper zijn. Ook de betrouwbaarheid is bij SSD's hoger dus buiten capaciteitsverschillen, lijkt het me niet handig met de hoge mate van streaming media om consoles nog met grote HDD's te lanceren.

Bij consumer PC's eigenlijk een grootdeels zelfde verhaal, maar daar kan 60GB bij de meeste klanten niet door de beugel (die gaan al over de rooie met 250GB HDD's voor hun low-end internet PC).

De PCI SSD oplossingen zijn intressant, vraag me alleen af hoeveel je er in normaal gebruik nu nog echt van gaat merken.

Het opstarten van Windows zal sneller gaan, maar Windows heeft nu al een zeer korte opstarttijd. Die 2 seconden zullen het hem niet doen. Windows 7 zelf start op een doorsnee SSD al binnen 10 seconden op en Windows 8 nog sneller. De tijd gaat hem meer zitten in de POST.De PCI SSD oplossingen zijn interessant, vraag me alleen af hoeveel je er in normaal gebruik nu nog echt van gaat merken.

De laadtijden in games zullen korter zijn alhoewel we 1 punt vergeten: kan de CPU een datastroom van bijna 2 gig per seconden laden en decomprimeren? Omdat gamedatabestanden vaak gecomprimeerd zijn.

Daarentegen zie ik wel een gat in de markt voor zware servers. Die zullen er heel blij mee zijn.

Ja maar afhankelijk van de compressie. Hoe zwaarder de compressie, hoe meer werk de CPU moet doen. Echter worden bij game files niet te zware compressie toegepast anders trekken de consoles het niet.jimh307 schreef op vrijdag 12 september 2014 @ 17:06:

De laadtijden in games zullen korter zijn alhoewel we 1 punt vergeten: kan de CPU een datastroom van bijna 2 gig per seconden laden en decomprimeren? Omdat gamedatabestanden vaak gecomprimeerd zijn.

Dit laat zien waarom ik geloof dat SSD's in M.2 vorm dominanter zullen worden:

(SanDisk Ultra II 240GB, review)

Ook gezien de 240GB al het limiet van SATA-600 haalt met de transferrate en zelfs al bijna het maximale IOPS haalt, toont aan dat het al een tijd niet meer efficient is om SSD's in een 2,5" doosje te steken.

Sindsd afgelopen weekend ben ik voorbereid voor de nieuwste PCIe 3.0 x4 NVMe SSD's op M.2 formaat, door een upgrade van het moederbord (Asus Maximus VII Impact), nu nog de SSD's hopelijk aan het begin van volgend jaar, zodat ik dat ene laatste 2,5" doosje met lucht en twee nutteloze kabels ook uit mijn PC kan halen.

(SanDisk Ultra II 240GB, review)

Ook gezien de 240GB al het limiet van SATA-600 haalt met de transferrate en zelfs al bijna het maximale IOPS haalt, toont aan dat het al een tijd niet meer efficient is om SSD's in een 2,5" doosje te steken.

Sindsd afgelopen weekend ben ik voorbereid voor de nieuwste PCIe 3.0 x4 NVMe SSD's op M.2 formaat, door een upgrade van het moederbord (Asus Maximus VII Impact), nu nog de SSD's hopelijk aan het begin van volgend jaar, zodat ik dat ene laatste 2,5" doosje met lucht en twee nutteloze kabels ook uit mijn PC kan halen.

Verwijderd

Ik hoor opeens wat berichten van Samsung EVO's die na verloop van tijd onbetrouwbaar zouden worden. Ik weet niet helemaal wat ik ervan moet denken, maar het volgt wel het patroon van eerdere problemen die we met andere SSD's hebben gezien.

Hebben jullie er wat van meegekregen?

Hebben jullie er wat van meegekregen?

[ Voor 35% gewijzigd door Verwijderd op 17-09-2014 10:16 ]

Als je nu een paar links geeft van evo's die onbetrouwbaar zijn geworden, dan kunnen we wat beter een oordeel vormen.

Als ik zo wat rondgoogle op "evo onbetrouwbaar" krijg ik in ieder geval niets.

Als ik zo wat rondgoogle op "evo onbetrouwbaar" krijg ik in ieder geval niets.

Verwijderd

Zie editReepje schreef op woensdag 17 september 2014 @ 10:12:

Als ik zo wat rondgoogle op "evo onbetrouwbaar" krijg ik in ieder geval niets.

Nu heb ik sinds kort een MBPr met een PCI SSD, en dat gaat wel lekker qua snelheden:jimh307 schreef op vrijdag 12 september 2014 @ 17:06:

[...]

Het opstarten van Windows zal sneller gaan, maar Windows heeft nu al een zeer korte opstarttijd. Die 2 seconden zullen het hem niet doen. Windows 7 zelf start op een doorsnee SSD al binnen 10 seconden op en Windows 8 nog sneller. De tijd gaat hem meer zitten in de POST.

De laadtijden in games zullen korter zijn alhoewel we 1 punt vergeten: kan de CPU een datastroom van bijna 2 gig per seconden laden en decomprimeren? Omdat gamedatabestanden vaak gecomprimeerd zijn.

Daarentegen zie ik wel een gat in de markt voor zware servers. Die zullen er heel blij mee zijn.

DiskSpeedTest by cyberhulp, on Flickr

DiskSpeedTest by cyberhulp, on FlickrMerk ik er veel van? Joah, het ding is rap, maar ik kan nu niet zeggen dat ik het verschil echt merk ik gebruik tov de ssd in mijn desktop.

All I can say, er zijn inderdaad meer mensen die bij het gebruik van hd tune niet een mooi recht blauw lijntje krijgen, hetgeen te verwachten zou zijn. Dit zou ook kunnen liggen aan de cache die de EVO gebruikt, constant meelopende processen waardoor de cache al dan niet vol zit en andere factoren. De drives zelf doen het goed, maar, als je hdtune draait krijg je dus geen recht blauw lijntje. Tja. Issue met de benchmark, issue met de gebruiker of issue met de SSD. Ik stem voor het eerste.

Hier in dit topic Samsung EVO SSD eigenaars wordt het probleem al gediscussieerd...

Ik weet zelf ook nog niet welke conclusies ik moet trekken van alle gegevens die worden aangeleverd.

Heb sterk de neiging om ook te zeggen, zolang de omstandigheden niet gelijk zijn iedere keer, kennis en kunde van de benchmarker fatsoenlijk is, kunnen dergelijk sterke claims nog niet gemaakt worden.

Liefst zou ik dus zien dat iemand een uitgebreide analyse naar zo iets doet, in plaats van 10 tallen mensen die random dingen posten.

Ik weet zelf ook nog niet welke conclusies ik moet trekken van alle gegevens die worden aangeleverd.

Heb sterk de neiging om ook te zeggen, zolang de omstandigheden niet gelijk zijn iedere keer, kennis en kunde van de benchmarker fatsoenlijk is, kunnen dergelijk sterke claims nog niet gemaakt worden.

Liefst zou ik dus zien dat iemand een uitgebreide analyse naar zo iets doet, in plaats van 10 tallen mensen die random dingen posten.

[ Voor 27% gewijzigd door Swordlord op 17-09-2014 10:43 ]

Reepje schreef op woensdag 17 september 2014 @ 10:12:

Als ik zo wat rondgoogle op "evo onbetrouwbaar" krijg ik in ieder geval niets.

offtopic:

Voor computer gerelateerde dingen moet je in het Engels zoeken om nuttige resultaten te krijgen

Voor computer gerelateerde dingen moet je in het Engels zoeken om nuttige resultaten te krijgen

After the first glass you see things as you wish they were. After the second you see things as they are not. Finally you see things as they really are, and that is the most horrible thing in the world...

Oscar Wilde

Verwijderd

Het is meer dan alleen een blauw lijntje, de vraag is of dat maatgevend is.Reepje schreef op woensdag 17 september 2014 @ 10:32:

De drives zelf doen het goed, maar, als je hdtune draait krijg je dus geen recht blauw lijntje. Tja. Issue met de benchmark, issue met de gebruiker of issue met de SSD. Ik stem voor het eerste.

Iemand heeft een interessante vaststelling gedaan, waarbij oudere data structureel langzamer gelezen wordt.

[ Voor 20% gewijzigd door Verwijderd op 17-09-2014 19:57 ]

hmmm heb thuis een 840 evo en pro, zal zo eens dezelfde error scan starten

Mja, als ik die error scan bekijk zie ik groen voor fast, red voor slow. Damaged blocks is 0,0%.

Ik gok dat de 840 EVO gewoon net zo traag is als de oude 840, maar dat die "SLC cache" enkele gigabytes aan writes kan cachen. Na verloop van tijd raakt die cache vol en verhuist die data naar trage TLC storage en is de snelheid daarvan weer net zo traag als de ouderwetse 840.

Bij een benchmark schrijf je een paar gigabyte aan testdata en gebruik je dat om te testen. Die data staat in de SLC cache en is lekker snel, zorgt voor goede benchmarkresultaten en dus goede reviews.

Ik gok dat de 840 EVO gewoon net zo traag is als de oude 840, maar dat die "SLC cache" enkele gigabytes aan writes kan cachen. Na verloop van tijd raakt die cache vol en verhuist die data naar trage TLC storage en is de snelheid daarvan weer net zo traag als de ouderwetse 840.

Bij een benchmark schrijf je een paar gigabyte aan testdata en gebruik je dat om te testen. Die data staat in de SLC cache en is lekker snel, zorgt voor goede benchmarkresultaten en dus goede reviews.

Verwijderd

De Pro lijkt vooralsnog niet beïnvloed, het gaat om schijven met TLC-geheugen. Testen kan daarentegen geen kwaad.MrDrako schreef op donderdag 18 september 2014 @ 15:24:

hmmm heb thuis een 840 evo en pro, zal zo eens dezelfde error scan starten

Dat is inderdaad de volgende vraag, of trage data ook onbetrouwbare data is, al dan niet op termijn. Het probleem nu is vooral dat van oudere data de performance onderuit kukelt._JGC_ schreef op donderdag 18 september 2014 @ 15:47:

Mja, als ik die error scan bekijk zie ik groen voor fast, red voor slow. Damaged blocks is 0,0%.

Dat zou kunnen, maar is volgens mij niet wat de gegevens suggereren. Als je naar het tweede plaatje kijkt zie je dat oudere data steeds trager en trager wordt. Bij jouw verhaal zou je waarschijnlijk een meer binair patroon zien waarbij data opeens trager wordt als het een bepaalde leeftijd bereikt, maar het lijkt er meer op dat de retentie problemen kent en dat mogelijk het ECC-mechanisme moet ingrijpen om de boel weer vlot te trekken. Meer ingrijpen van ECC is tragere reads, al kan er ook iets anders gaande zijn.Ik gok dat de 840 EVO gewoon net zo traag is als de oude 840, maar dat die "SLC cache" enkele gigabytes aan writes kan cachen. Na verloop van tijd raakt die cache vol en verhuist die data naar trage TLC storage en is de snelheid daarvan weer net zo traag als de ouderwetse 840.

Let ook op dat het expliciet om reads gaat en niet om writes. Als je de data herschrijft is de snelheid weer goed, dus sommige mensen fixen de boel door te defragmenteren (ja, echt).

Dat klopt helemaal, maar 2 GB/s is wel heel veel.Phuncz schreef op vrijdag 12 september 2014 @ 17:19:

[...]

Ja maar afhankelijk van de compressie. Hoe zwaarder de compressie, hoe meer werk de CPU moet doen. Echter worden bij game files niet te zware compressie toegepast anders trekken de consoles het niet.

Misschien een idee om NTFS-compressie te testen op zo'n snelle PCI-SSD. Dan kun je kijken of je CPU 2 GB/s aan LZ77 (lichte, de NTFS compressie) kan verstouwen.

Voor Skyrim is een SSD een geschenk uit de hemel terwijl de Skyrim-bestanden ook gecomprimeerd zijn. Dit op mijn (oude) Core i7 2600k.

Een LZ77 benchmark haalt op mijn CPU 385 MB/s. Als we uitgaan van 2 GB/s dan zou je CPU dus echt heel erg snel moeten zijn, maar zou je het merken?

Maar dat is dan ook een verouderde, single-core-belastende compressie die waarschijnlijk geen gebruik maakt van moderne extensies evenals een relatief kleine hoeveelheid geheugen. Ik verwacht dat modernere technieken, toegespitst op hedendaagse hardware, hier ook wel meer mee kunnen doen.

Als ik naar de grafiek kijk, zie ik geen significant verband tussen oude en nieuwe data.

Ik zie wel dat de "snelste" data op week 17 en 25 zitten.

De data op week 0,1, en 2 zitten hoog, maar week 17, 25 en 29 zitten hoger of net zo hoog.

Er is dus duidelijk geen verband tussen leeftijd en snelheid

De oudste data op de ssd zal het besturingssysteem zijn. Dat zijn veel kleine bestanden en die zullen dus relatief langzaam zijn. Zouden deze nog langzamer worden, dan zal windows dus "significant" langzamer opstarten na verloop van tijd.

En dit gebeurd niet. Wat mij betreft case closed.

edit. Wat me opvalt, is dat de data van 91 weken oud niet de snelste, maar ook bij verre niet de langzaamste is. Bovendien moet dit wel een pre-produktie exemplaar zijn, want augustus 2013 verschenen de eerste evo's. Dat is bijna 60 weken geleden.

Ik zie wel dat de "snelste" data op week 17 en 25 zitten.

De data op week 0,1, en 2 zitten hoog, maar week 17, 25 en 29 zitten hoger of net zo hoog.

Er is dus duidelijk geen verband tussen leeftijd en snelheid

De oudste data op de ssd zal het besturingssysteem zijn. Dat zijn veel kleine bestanden en die zullen dus relatief langzaam zijn. Zouden deze nog langzamer worden, dan zal windows dus "significant" langzamer opstarten na verloop van tijd.

En dit gebeurd niet. Wat mij betreft case closed.

edit. Wat me opvalt, is dat de data van 91 weken oud niet de snelste, maar ook bij verre niet de langzaamste is. Bovendien moet dit wel een pre-produktie exemplaar zijn, want augustus 2013 verschenen de eerste evo's. Dat is bijna 60 weken geleden.

[ Voor 17% gewijzigd door Reepje op 18-09-2014 23:49 ]

@Reepje: het blijkt verrassend lastig te bepalen hoe oud een bestand precies is. Wanneer je een jaren oud bestand overneemt van een andere schijf wordt onder bepaalde omstandigheden de timestamps van de oude schijf aangehouden. Wanneer wat precies gebeurt weet ik niet, maar in ieder geval zitten er wel eens maffe uitschieters bij zoals deze.

Maar hé, het 840 EVO snelheidsprobleem met oude files is een hele interessante ontdekking! Het lijkt erop dat ze bij Samsung een SSD hebben weten te maken welke juist writes nodig heeft om snel te blijven. Ik heb er de afgelopen uren aardig wat over gelezen en het is hoogst interessant hoe die dingen presteren in allerlei situaties. Bestanden die een tijdlang niet zijn herschreven vanuit het OS worden na verloop van tijd geleidelijk zeer moeizaam terug te lezen. Zoals wel meer mensen ben ik wat huiverig over de Hdtune screenshots, maar het sequentieel lezen van grote bestanden blijkt volgens tests (handmatig en geautomatiseerd) van diverse mensen zelfs via de reguliere OS API's zó traag te worden dat de gemiddelde ouderwetse mechanische HDD uit het jaar nul het sneller zou doen. Wanneer de bestanden worden herschreven zijn ze weer met normale SSD-snelheden uit te lezen.

Tijdens het lezen kwamen ook een hoop verwerpingen van het issue voorbij die ik allemaal kan weerleggen:

*"Het ligt aan de low-level access van programma's als Hdtune." Dit is niet waar, want zelfs met handmatig kopiëren van bestanden is het zichtbaar. Op Overclock.net zijn drie tooltjes geschreven die bestanden sequentieel doorlezen via de normale OS API's en het probleem doet zich net zo hard voor. Oudere bestanden komen in die tools ook heel duidelijk bovendrijven als bestanden die het traagst worden gelezen.

*"Ik heb gedefragmenteerd maar het lost niks op." Men is defragmentatietools gaan gebruiken als een makkelijke manier om bestaande bestanden opnieuw weg te schrijven. Vergeet alleen niet dat een defragmentatietool niet gegarandeerd alle bestanden verplaatst; als je niks ziet veranderen kan dat heel goed betekenen dat je filesystem gewoon niet zo sterk gefragmenteerd was en daardoor bestanden niet zijn verplaatst.

*"Het zijn maar benchmarks, staar je er niet blind op, je merkt het toch niet." Hoewel ongetwijfeld waar als je SSD's onderling vergelijkt op snelheid, raakt deze uitspraak kant noch wal als je ziet dat een SSD uit de nieuwste generatie sequentiele leessnelheden van soms amper 60 MB/s neerzet.

*"Dat komt gewoon doordat oude bestanden uit het SLC-gedeelte van de EVO worden gehaald om plaats te maken voor nieuwe files." Natuurlijk komt het hier niet door; als je de trage files herschrijft zouden er andere uit het SLC-gedeelte moeten worden gehaald. Je zou het probleem verplaatsen. Echter is na rewrite van de files alle data op de schijf op normale snelheden te bereiken. En het lijkt mij sterk dat meer dan de helft van de schijf kan worden volgeschreven zonder de SLC-cache op te vullen; er moet data in TLC-geheugen staan en tóch snel worden gelezen na rewrite. Bovendien melden enkele mensen dat de 'oude' 840 het euvel ook vertoont: oude bestanden lezen veel minder snel dan nieuwe bestanden. En die nieuwe bestanden staan dus ook gewoon op TLC, want de oude 840 heeft alleen maar TLC.

*"Het komt doordat andere processen ook IO genereren tijdens het testen." Dat doen die andere programma's dan wel iets té consequent precies op het moment dat er oudere bestanden worden gelezen. Ongeacht in welke folder de bestanden staan, ongeacht hoe vaak je het herhaalt. De correlatie is veel te sterk om dergelijke bronnen van noise nog serieus te kunnen overwegen.

*"Er wordt verkeerd getest. De SSD moet enige tijd rust krijgen om interne processen zoals Garbage Collection te laten werken." Klopt als een bus! Let wel dat de tweede test om deze reden dus in theorie juist langzamer zou moeten uitvallen dan wanneer je even wacht voordat je weer test. Zo redenerende is het verschil tussen voor en na dus in feite nog groter dan dat je ziet in de "verkeerd uitgevoerde" tests.

Het wordt een interessante tijd.

Maar hé, het 840 EVO snelheidsprobleem met oude files is een hele interessante ontdekking! Het lijkt erop dat ze bij Samsung een SSD hebben weten te maken welke juist writes nodig heeft om snel te blijven. Ik heb er de afgelopen uren aardig wat over gelezen en het is hoogst interessant hoe die dingen presteren in allerlei situaties. Bestanden die een tijdlang niet zijn herschreven vanuit het OS worden na verloop van tijd geleidelijk zeer moeizaam terug te lezen. Zoals wel meer mensen ben ik wat huiverig over de Hdtune screenshots, maar het sequentieel lezen van grote bestanden blijkt volgens tests (handmatig en geautomatiseerd) van diverse mensen zelfs via de reguliere OS API's zó traag te worden dat de gemiddelde ouderwetse mechanische HDD uit het jaar nul het sneller zou doen. Wanneer de bestanden worden herschreven zijn ze weer met normale SSD-snelheden uit te lezen.

Tijdens het lezen kwamen ook een hoop verwerpingen van het issue voorbij die ik allemaal kan weerleggen:

*"Het ligt aan de low-level access van programma's als Hdtune." Dit is niet waar, want zelfs met handmatig kopiëren van bestanden is het zichtbaar. Op Overclock.net zijn drie tooltjes geschreven die bestanden sequentieel doorlezen via de normale OS API's en het probleem doet zich net zo hard voor. Oudere bestanden komen in die tools ook heel duidelijk bovendrijven als bestanden die het traagst worden gelezen.

*"Ik heb gedefragmenteerd maar het lost niks op." Men is defragmentatietools gaan gebruiken als een makkelijke manier om bestaande bestanden opnieuw weg te schrijven. Vergeet alleen niet dat een defragmentatietool niet gegarandeerd alle bestanden verplaatst; als je niks ziet veranderen kan dat heel goed betekenen dat je filesystem gewoon niet zo sterk gefragmenteerd was en daardoor bestanden niet zijn verplaatst.

*"Het zijn maar benchmarks, staar je er niet blind op, je merkt het toch niet." Hoewel ongetwijfeld waar als je SSD's onderling vergelijkt op snelheid, raakt deze uitspraak kant noch wal als je ziet dat een SSD uit de nieuwste generatie sequentiele leessnelheden van soms amper 60 MB/s neerzet.

*"Dat komt gewoon doordat oude bestanden uit het SLC-gedeelte van de EVO worden gehaald om plaats te maken voor nieuwe files." Natuurlijk komt het hier niet door; als je de trage files herschrijft zouden er andere uit het SLC-gedeelte moeten worden gehaald. Je zou het probleem verplaatsen. Echter is na rewrite van de files alle data op de schijf op normale snelheden te bereiken. En het lijkt mij sterk dat meer dan de helft van de schijf kan worden volgeschreven zonder de SLC-cache op te vullen; er moet data in TLC-geheugen staan en tóch snel worden gelezen na rewrite. Bovendien melden enkele mensen dat de 'oude' 840 het euvel ook vertoont: oude bestanden lezen veel minder snel dan nieuwe bestanden. En die nieuwe bestanden staan dus ook gewoon op TLC, want de oude 840 heeft alleen maar TLC.

*"Het komt doordat andere processen ook IO genereren tijdens het testen." Dat doen die andere programma's dan wel iets té consequent precies op het moment dat er oudere bestanden worden gelezen. Ongeacht in welke folder de bestanden staan, ongeacht hoe vaak je het herhaalt. De correlatie is veel te sterk om dergelijke bronnen van noise nog serieus te kunnen overwegen.

*"Er wordt verkeerd getest. De SSD moet enige tijd rust krijgen om interne processen zoals Garbage Collection te laten werken." Klopt als een bus! Let wel dat de tweede test om deze reden dus in theorie juist langzamer zou moeten uitvallen dan wanneer je even wacht voordat je weer test. Zo redenerende is het verschil tussen voor en na dus in feite nog groter dan dat je ziet in de "verkeerd uitgevoerde" tests.

Het wordt een interessante tijd.

Verwijderd

Heel veel duidelijker kan een trend niet wordenReepje schreef op donderdag 18 september 2014 @ 23:33:

Er is dus duidelijk geen verband tussen leeftijd en snelheid

Wie zeg dat dat niet gebeurt? In je haast de boel te ontkennen ben je juist op iets gestuit dat mensen ook zien gebeuren, ware het niet dat het effect bij opstarten minder merkbaar is doordat de accesstimes (precies waar de winst van een SSD bij opstarten zit) wel nog steeds hetzelfde zijn. Bij het kopiëren van bestanden - sequentieel werk dus - hebben mensen vastgesteld dat de performance onderuit gedonderd is tot sub-HDD-snelheden. Zelfs zonder tooltjes is het te zien.En dit gebeurd niet. Wat mij betreft case closed.

Het gaat over de 840 en 840 EVO. Zoek maar even op wanneer de 840 werd geïntroduceerd. Alles met TLC lijkt beïnvloed, MLC toont zich vooralsnog in orde.edit. Wat me opvalt, is dat de data van 91 weken oud niet de snelste, maar ook bij verre niet de langzaamste is. Bovendien moet dit wel een pre-produktie exemplaar zijn, want augustus 2013 verschenen de eerste evo's. Dat is bijna 60 weken geleden.

Kan ik aan een Perc 6/i gewone sata ssds hangen of moet het per se sas zijn? Er hoeven geen andere discs aan, alleen 2x 512GB in raid1 ofzo

Verwijderd

Mocht Reepje nog twijfelen, Samsung erkent inmiddels dat er iets aan de hand is en zoekt een oplossing.

De redactie is inmiddels ook op de hoogte.

De redactie is inmiddels ook op de hoogte.

Ik heb vanavond een Samsung 840 Evo SSD van 120 Gb in mijn 5-jaar-oude Samsung R510 laptop geïnstalleerd. Dit op de plek van de dvd-brander door middel van een hdd-bay.

Via Reflect mijn oude C-schijf gekopieerd naar de SSD en vervolgens de boot sequence aangepast. Op zich redelijk verrast startte mijn laptop relatief snel op en lijkt alles goed te werken. Hij heeft automatisch de schijfletter naar C:\ aangepast en de oude C-schijf een andere letter gegeven.

Nu werkt alles dus best goed. Toch vraag ik me af of dit wel de juist manier is. Kan het kwaad om met een gekloonde schijf verder te werken, of ga ik hier later problemen mee krijgen?

Het is/was natuurlijk het beste om een schone Windows-installatie uit te voeren, maar de laksheid heeft mij in dit geval verleid dit (nog even) niet te doen.

Via Reflect mijn oude C-schijf gekopieerd naar de SSD en vervolgens de boot sequence aangepast. Op zich redelijk verrast startte mijn laptop relatief snel op en lijkt alles goed te werken. Hij heeft automatisch de schijfletter naar C:\ aangepast en de oude C-schijf een andere letter gegeven.

Nu werkt alles dus best goed. Toch vraag ik me af of dit wel de juist manier is. Kan het kwaad om met een gekloonde schijf verder te werken, of ga ik hier later problemen mee krijgen?

Het is/was natuurlijk het beste om een schone Windows-installatie uit te voeren, maar de laksheid heeft mij in dit geval verleid dit (nog even) niet te doen.

https://www.booksformanagers.nl

Als je windows 7 hebt, draai dan even de windows experience index opnieuw. Daadoor herkent windows de ssd als een ssd en zal de juiste instellingen toepassen (bij mijn weten is dit dat de schijfdefragmentatie wordt uitgezet).

Omdat je een erg kleine ssd gekocht hebt, kan je de pagefile ook wat kleiner maken daar krijg je wat ruimte door. Ook schijfopruiming draaien (vinkje bij windows update opschonen, vinkje bij backups servicepacks; en bij "meer opties" systeemherstel opschonen) dan heb je een beetje meer plek.

Omdat je een erg kleine ssd gekocht hebt, kan je de pagefile ook wat kleiner maken daar krijg je wat ruimte door. Ook schijfopruiming draaien (vinkje bij windows update opschonen, vinkje bij backups servicepacks; en bij "meer opties" systeemherstel opschonen) dan heb je een beetje meer plek.

Verwijderd

Volgens mij weet je alle antwoorden alGuitarJJ schreef op dinsdag 23 september 2014 @ 21:41:

Nu werkt alles dus best goed. Toch vraag ik me af of dit wel de juist manier is. Kan het kwaad om met een gekloonde schijf verder te werken, of ga ik hier later problemen mee krijgen?

Het is/was natuurlijk het beste om een schone Windows-installatie uit te voeren, maar de laksheid heeft mij in dit geval verleid dit (nog even) niet te doen.

Plus ik zou de SSD op de plek van de HDD zetten en de HDD in de caddy indien dat simpel te realiseren is bij een schone installatie. Soms is namelijk de SATA aansluiting van de optische drive een tragere SATA poort.

Vroeger, toen de Batavieren nog met zijn vijven waren.

Helaas, het gaat nog om Windows Vista...Reepje schreef op dinsdag 23 september 2014 @ 22:47:

Als je windows 7 hebt, draai dan even de windows experience index opnieuw. Daadoor herkent windows de ssd als een ssd en zal de juiste instellingen toepassen (bij mijn weten is dit dat de schijfdefragmentatie wordt uitgezet).

Omdat je een erg kleine ssd gekocht hebt, kan je de pagefile ook wat kleiner maken daar krijg je wat ruimte door. Ook schijfopruiming draaien (vinkje bij windows update opschonen, vinkje bij backups servicepacks; en bij "meer opties" systeemherstel opschonen) dan heb je een beetje meer plek.

Ik kreeg er geen installatie-cd bij, maar de oude schijf heeft een afgesloten partitie met daarop de beginstaat van de laptop. Het wordt dan denk ik nog lastig om Vista te herinstalleren op de SSD.

Ik zat ook al te kijken naar een goedkope versie van Windows 7, maar de prijs valt me ook wat tegen. Sinds dit jaar geen student meer, dus surfspot/slim werkt helaas niet meer voor mij

Toevallig nog een student hier die niet van plan is komende tijd een Windows-versie aan te gaan schaffen?

Bedankt voor de tip. Zal daar nog eens naar kijken!MegaTronics schreef op woensdag 24 september 2014 @ 07:18:

Plus ik zou de SSD op de plek van de HDD zetten en de HDD in de caddy indien dat simpel te realiseren is bij een schone installatie. Soms is namelijk de SATA aansluiting van de optische drive een tragere SATA poort.

https://www.booksformanagers.nl

I know, ben een dag laat met dit te posten, maar moet toch even mijn ei kwijt.

nieuws: Samsung brengt 15 oktober fix uit voor snelheidsdegradatie 840 EVO-ssd's

Want na het lezen hiervan kreeg ik toch weer eens de kriebels over TLC nand geheugen. Dat er concessies gedaan werden bij het gebruik van TLC nand dat was over het algemeen bekend.

Het was bekend dat data retentie lastiger zou zijn, dat de programmeer cycles traag waren, door de kleine marges van programeren, ga zo door ga zo door.

Maar is TLC nand met de huidige technieken niet flawed by design te benoemen?

Want schijnbaar is het toch zo gevoelig voor signaal degradatie, dat een een controller tot zijn thermal throtteling wordt gepushed door de overmaat van ECC werk.

Dit zijn dingen die hadden voorspeld kunnen worden of zelfs al getest kunnen zijn in een validatie periode, ofniet?

Ik ben geen SSD engineer, maar toch zet ik mijn vraagtekens.

Daarbij, is het al sinds de release van TLC nand een andere grote vraag die veel mensen richting Samsung hebben.

Waar gaat die prijswinst van TLC nand nou heen? TLC nand zou goedkoper moeten zijn om te produceren, het zou een revolutie moeten brengen in prijzen, daarbij hebben ze het hele proces van begin tot einde in handen, ze zouden met gemak de goedkoopste kunnen zijn.

Blijven ze nou kunstmatig net iets boven de goedkoopste concurrenten gezien de meeste consumenten het toch kopen als zoete broodjes?

Niks tegen Samsung, marketing en sales is vaak anders dan de mening van de engineering. Dus respect voor de engineers wat ze doen met hun MLC nand drives en hun nieuwe v-nand drives...

Bijna aan het einde... ahum...

Ik zal geen drive met TLC nand aan wie dan ook aanraden nog voor de komende tijden, niet dat ik het nog deed gezien de prijzen van de Crucials, maar het maakt me niet uit hoe goedkoop ze worden, al blazen ze de rest van de concurrentie eindelijk eens omver met de prijzen.

Het is heel grof gezegd nu wel bewezen hoe onbetrouwbaar het is, als de engineers van Samsung zelfs niet konden voorzien hoeveel ECC TLC nand zou nodig hebben om uberhaupt goed te functioneren...

En Sandisk, ik had verwachtingen voor jullie Ultra II drive met TLC nand, dat heel leuk dynamisch in SLC kon functioneren, maar ook die ga ik nu toch met andere ogen erna kijken...

Misschien als TLC zich nog eens een goed bewijst dat het functioneel en betrouwbaar is, dan kom ik misschien nog wel eens kijken...

Tot die tijd

* Swordlord zwaait TLC vaarwel

nieuws: Samsung brengt 15 oktober fix uit voor snelheidsdegradatie 840 EVO-ssd's

Een kleine rant, maar ook direct uitlokking tot nadenken en discussie.PC Perspective suggereert dat het probleem te maken heeft met de controller die te heet zou worden door error-correcting code. Hoe ouder de data hoe meer ecc-werk de controller te verduren krijgt en hoe hoger de temperatuur. De controller zou bij een bepaald punt teruggefloten worden door de Dynamic Thermal Guard Protection, met prestatiedegradatie tot gevolg.

Want na het lezen hiervan kreeg ik toch weer eens de kriebels over TLC nand geheugen. Dat er concessies gedaan werden bij het gebruik van TLC nand dat was over het algemeen bekend.

Het was bekend dat data retentie lastiger zou zijn, dat de programmeer cycles traag waren, door de kleine marges van programeren, ga zo door ga zo door.

Maar is TLC nand met de huidige technieken niet flawed by design te benoemen?

Want schijnbaar is het toch zo gevoelig voor signaal degradatie, dat een een controller tot zijn thermal throtteling wordt gepushed door de overmaat van ECC werk.

Dit zijn dingen die hadden voorspeld kunnen worden of zelfs al getest kunnen zijn in een validatie periode, ofniet?

Ik ben geen SSD engineer, maar toch zet ik mijn vraagtekens.

Daarbij, is het al sinds de release van TLC nand een andere grote vraag die veel mensen richting Samsung hebben.

Waar gaat die prijswinst van TLC nand nou heen? TLC nand zou goedkoper moeten zijn om te produceren, het zou een revolutie moeten brengen in prijzen, daarbij hebben ze het hele proces van begin tot einde in handen, ze zouden met gemak de goedkoopste kunnen zijn.

Blijven ze nou kunstmatig net iets boven de goedkoopste concurrenten gezien de meeste consumenten het toch kopen als zoete broodjes?

Niks tegen Samsung, marketing en sales is vaak anders dan de mening van de engineering. Dus respect voor de engineers wat ze doen met hun MLC nand drives en hun nieuwe v-nand drives...

Bijna aan het einde... ahum...

Ik zal geen drive met TLC nand aan wie dan ook aanraden nog voor de komende tijden, niet dat ik het nog deed gezien de prijzen van de Crucials, maar het maakt me niet uit hoe goedkoop ze worden, al blazen ze de rest van de concurrentie eindelijk eens omver met de prijzen.

Het is heel grof gezegd nu wel bewezen hoe onbetrouwbaar het is, als de engineers van Samsung zelfs niet konden voorzien hoeveel ECC TLC nand zou nodig hebben om uberhaupt goed te functioneren...

En Sandisk, ik had verwachtingen voor jullie Ultra II drive met TLC nand, dat heel leuk dynamisch in SLC kon functioneren, maar ook die ga ik nu toch met andere ogen erna kijken...

Misschien als TLC zich nog eens een goed bewijst dat het functioneel en betrouwbaar is, dan kom ik misschien nog wel eens kijken...

Tot die tijd

* Swordlord zwaait TLC vaarwel

[ Voor 9% gewijzigd door Swordlord op 26-09-2014 18:09 ]

TLC is niet flawed, de negatieve gevolgen van TLC zal bij Samsung al heus wel duidelijk zijn geweest voor zij besloten dit in gebruik te nemen in hun ssd's. TLC is gewoon erg goedkoop om te maken vergeleken met SLC of MLC.

ECC is hard nodig om data leesbaar te houden op langer termijn in ssd's, ook zal de firmware bestanden moeten verversen. Waarschijnlijk gaan ze dit in hun update toevoegen.

ECC is hard nodig om data leesbaar te houden op langer termijn in ssd's, ook zal de firmware bestanden moeten verversen. Waarschijnlijk gaan ze dit in hun update toevoegen.

Verwijderd

Ik ben het met je eens hoor. De techniek lijkt toch nog niet zo volwassen en stabiel te zijn als werd voorgespiegeld en zelfs een enorme speler als Samsung gaat ermee op zijn neus. Tegelijk zijn de prijzen helemaal niet zo interessant.Swordlord schreef op vrijdag 26 september 2014 @ 18:01:

Misschien als TLC zich nog eens een goed bewijst dat het functioneel en betrouwbaar is, dan kom ik misschien nog wel eens kijken...

Van wat ik begrijp is het niet goedkoper om te maken, alleen kan je meer data in hetzelfde geheugen kwijt. Per saldo moet dat op hetzelfde uitkomen, namelijk goedkopere schijven, maar dat is wel een nuanceverschil.royb3 schreef op vrijdag 26 september 2014 @ 18:10:

TLC is gewoon erg goedkoop om te maken vergeleken met SLC of MLC.

Dat de prijzen niet interessant zijn, licht vooral aan de marges van Samsung vrees ik. Een crucial mx100 met MLC geheugen kost minder dan een ssd met TLC geheugen van samsung van dezelfde grootte.

Verwijderd

Samsung hoeft ook niet, mensen kopen ze toch wel voor een hogere prijs omdat ze op papier wat vlotter zijn. Een fabrikant is ook wel gek dan minder te vragen.royb3 schreef op vrijdag 26 september 2014 @ 18:19:

Dat de prijzen niet interessant zijn, licht vooral aan de marges van Samsung vrees ik. Een crucial mx100 met MLC geheugen kost minder dan een ssd met TLC geheugen van samsung van dezelfde grootte.

Op zich heb ik wel veel vertrouwen in Samsung maar dat TLC liet ik toch al links liggen. Waarom zou ik zoiets kopen als ik ook Crucial MLC kan krijgen en het snelheidsverschil marginaal is en ook de prijs niet echt uitmaakt.

(Niet dat crucial perfect is maar toch.)

(Niet dat crucial perfect is maar toch.)

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Dat ECC nodig is is een welbekend feit, dat speelt al sinds de HDD's een cruciale rol in het goed en vooral snel aanleveren van data...royb3 schreef op vrijdag 26 september 2014 @ 18:10:

ECC is hard nodig om data leesbaar te houden op langer termijn in ssd's, ook zal de firmware bestanden moeten verversen. Waarschijnlijk gaan ze dit in hun update toevoegen.

Zoals ik het interpreteer, is het wearleveling protocol wat Samsung toepast bij de TLC drives wel een heel erg passief gerichte wear leveling. Dus als data ergens staat, dan laat het er lekker staan en sectoren die in rotatie zitten mogen eerst heel wat P/E's verwerken voor de rest aan de beurt is... Dit voorkomt hogere write amplification, omdat data niet vaak verplaatst hoef te worden en de keuze hiervoor was vast logisch gezien de P/E beperkingen van TLC.

Een voor ssd's over algemeen "normaal" actief wear leveling protocol is dat al het NAND gelijkmatig door hun P/E cycles wordt gehaald. Het is niet dat direct altijd netjes opnieuw wordt begonnen zodra een rondje is gedaan, maar P/E cycles worden wel binnen een marge gelijk aan elkaar gehouden.

Als Samsung besluit naar dit systeem over te gaan, dan zal het al enigszins rotatie in oude data teweeg brengen, dus wat minder ECC issues... Mits je de drive genoeg gebruikt...

Want gebruik je de drive niet zo intensief, dan kom je niet snel genoeg door je volledige NAND rotatie heen, om je snelheid hoog te houden.

De opvatting: Ach als data oud is, even opnieuw schrijven, klinkt als een goede oplossing, maar ik denk dat meeste mensen hier te basaal over denken...

Want zo zit je wel opeens heel veel ongewenste write amplification op je NAND te introduceren wat niet erg netjes is en eigenlijk vermeden zou worden... Want zo krijg je in de levensduur van een stuk data, dat hij misschien 10 keer of wel meer herschreven moet worden...

Basaal tegen argument direct wel: Als je je drive toch zo weinig gebruikt dat een standaard actief wearleveling protocol de data niet fris genoeg houd, dan zal die extra write amplification van al die data rondschuiven ook geen pijn doen.

[ Voor 15% gewijzigd door Swordlord op 27-09-2014 20:54 ]

Overweeg mijn 120 GB Intel 520 te upgraden naar een wat grotere MX100.

Is er iemand met een MX100 die even een HDtachje kan doen?

http://www.majorgeeks.com/mg/getmirror/hdtach,1.html (XP sp3 compatability mode)

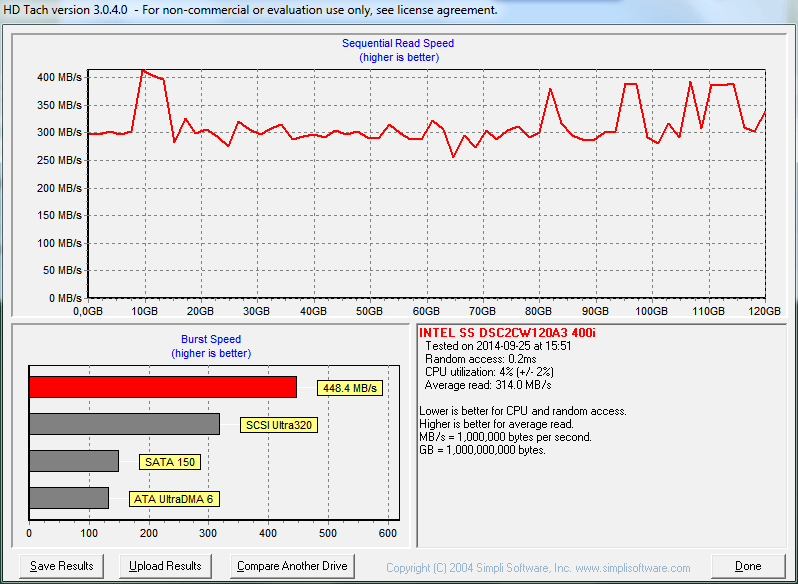

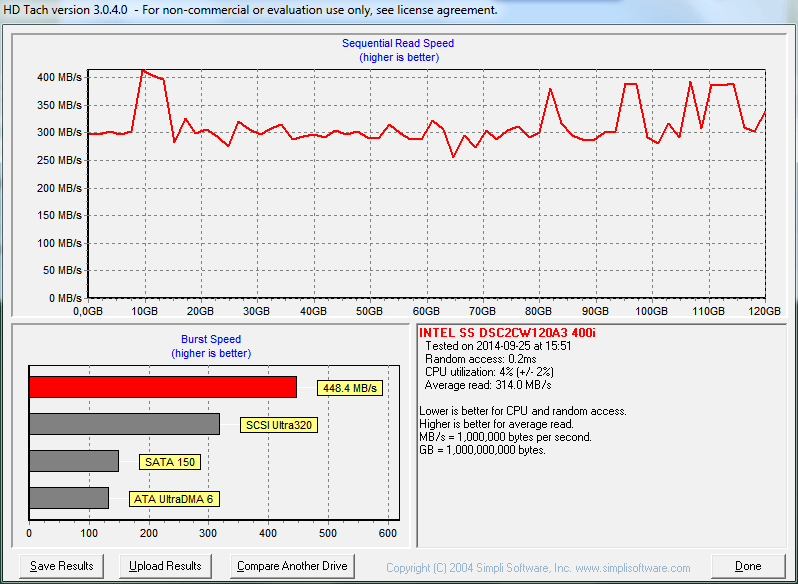

Intel 520

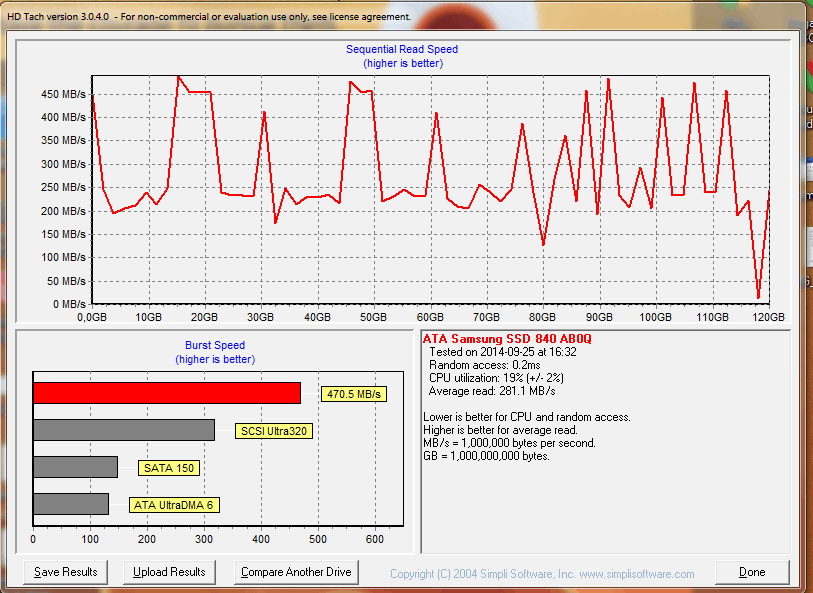

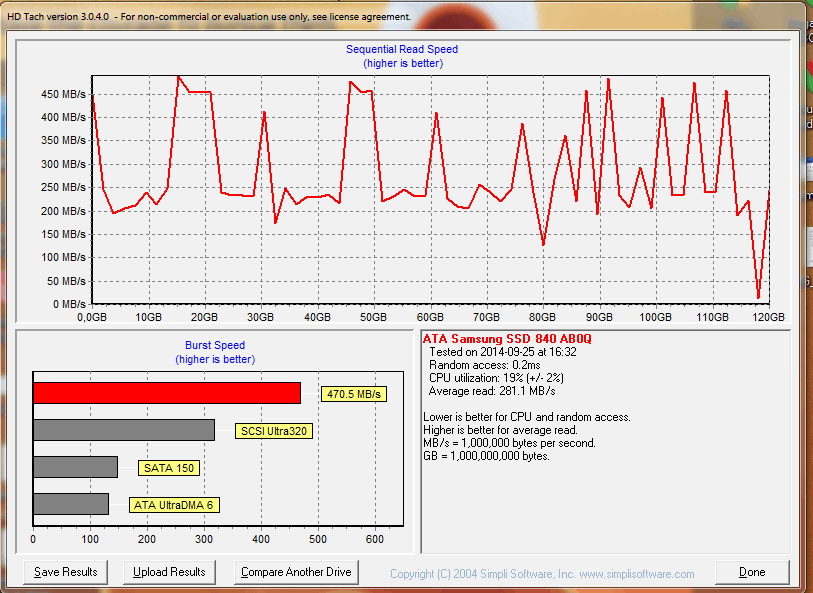

Samsung 840

Is er iemand met een MX100 die even een HDtachje kan doen?

http://www.majorgeeks.com/mg/getmirror/hdtach,1.html (XP sp3 compatability mode)

Intel 520

Samsung 840

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Je moet rekening houden in je vergelijkingen met wat is de staat van de drives.

Een lege drive zal namelijk vaak hogere snelheden teruggeven dan eentje die al flink gevuld is.

Omdat een drive bij een leeg adres niet echt data hoeft op te zoeken en terug te geven, kan dit en doet hij dit ook op max snelheid.

Zomaar even HDtachjes vergelijken gaat dus niet.

Een lege drive zal namelijk vaak hogere snelheden teruggeven dan eentje die al flink gevuld is.

Omdat een drive bij een leeg adres niet echt data hoeft op te zoeken en terug te geven, kan dit en doet hij dit ook op max snelheid.

Zomaar even HDtachjes vergelijken gaat dus niet.

[ Voor 106% gewijzigd door Swordlord op 28-09-2014 09:48 ]

In dit geval hadden ze beide +- 20 GB vrij  . Alleen de Intel is een jaartje ouder (en een beetje mishandelt, die heeft met 0 bytes vrij gestaan met dank aan Shadowplay

. Alleen de Intel is een jaartje ouder (en een beetje mishandelt, die heeft met 0 bytes vrij gestaan met dank aan Shadowplay  ). Ik ga er eigenlijk van uit dat de pieken de lege stukken zijn. Dat zag ik in ieder geval ook op HDtune toen de 520 net nieuw was (+- 150MB eraf op stuk waar al iets op stond).

). Ik ga er eigenlijk van uit dat de pieken de lege stukken zijn. Dat zag ik in ieder geval ook op HDtune toen de 520 net nieuw was (+- 150MB eraf op stuk waar al iets op stond).

Maar ben dus inderdaad opzoek naar iemand met een MX100 waar dus flink wat op staat. Het liefst 80%. De 840 kan er in ieder geval niet tegen zo blijkt. (Die 520 werd overigens ook trager toen er maar 5 GB vrij was).

Maar ben dus inderdaad opzoek naar iemand met een MX100 waar dus flink wat op staat. Het liefst 80%. De 840 kan er in ieder geval niet tegen zo blijkt. (Die 520 werd overigens ook trager toen er maar 5 GB vrij was).

[ Voor 69% gewijzigd door sdk1985 op 28-09-2014 14:26 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Aangezien de SSD's van tegenwoordig al een zeer lang leven hebben, weet iemand ook hoe lang een SSD het gemiddeld uithoudt als je em in een Raid 0 configuratie zet zonder trim?

Verwijderd

Hier de mijne ;sdk1985 schreef op zaterdag 27 september 2014 @ 22:19:

Overweeg mijn 120 GB Intel 520 te upgraden naar een wat grotere MX100.

Is er iemand met een MX100 die even een HDtachje kan doen?

http://www.majorgeeks.com/mg/getmirror/hdtach,1.html (XP sp3 compatability mode)

Crucial M4

Het is me niet echt duidelijk hoeveel HDD sloten mijn laptop heeft. Dit lijkt me de snelste weg om daar antwoord op te vinden. Ik ga met zo'n 30 minuten de SSD plaatsen, tot die tijd ben ik nog een backup aan het maken de HDD. Windows installeer ik via een USB geheugenstick.

Is het verstandig de SSD op de plek van de huidige HDD te plaatsen en heeft de laptop twee HDD plaatsen vrij? Dat ziet er wel zo uit, al hoor ik vaak dat er en HDD caddy nodig is en zodoende de DVD eruit gaat. Hieronder een foto daarvan.

Is het verstandig de SSD op de plek van de huidige HDD te plaatsen en heeft de laptop twee HDD plaatsen vrij? Dat ziet er wel zo uit, al hoor ik vaak dat er en HDD caddy nodig is en zodoende de DVD eruit gaat. Hieronder een foto daarvan.

...

Je plaatst best een SSD op de plek van een (bestaande) HDD, minder kans dat je dan gelimiteerd bent, iets wat nogal eens gebeurd voor bv. optische drives.

Nou ik ben de beroerste niet, ondanks dat ik al dat gehype over een programma van meer dan 10 jaar oud wel wat overdreven vind.sdk1985 schreef op zaterdag 27 september 2014 @ 22:19:

Overweeg mijn 120 GB Intel 520 te upgraden naar een wat grotere MX100.

Is er iemand met een MX100 die even een HDtachje kan doen?

http://www.majorgeeks.com/mg/getmirror/hdtach,1.html (XP sp3 compatability mode)

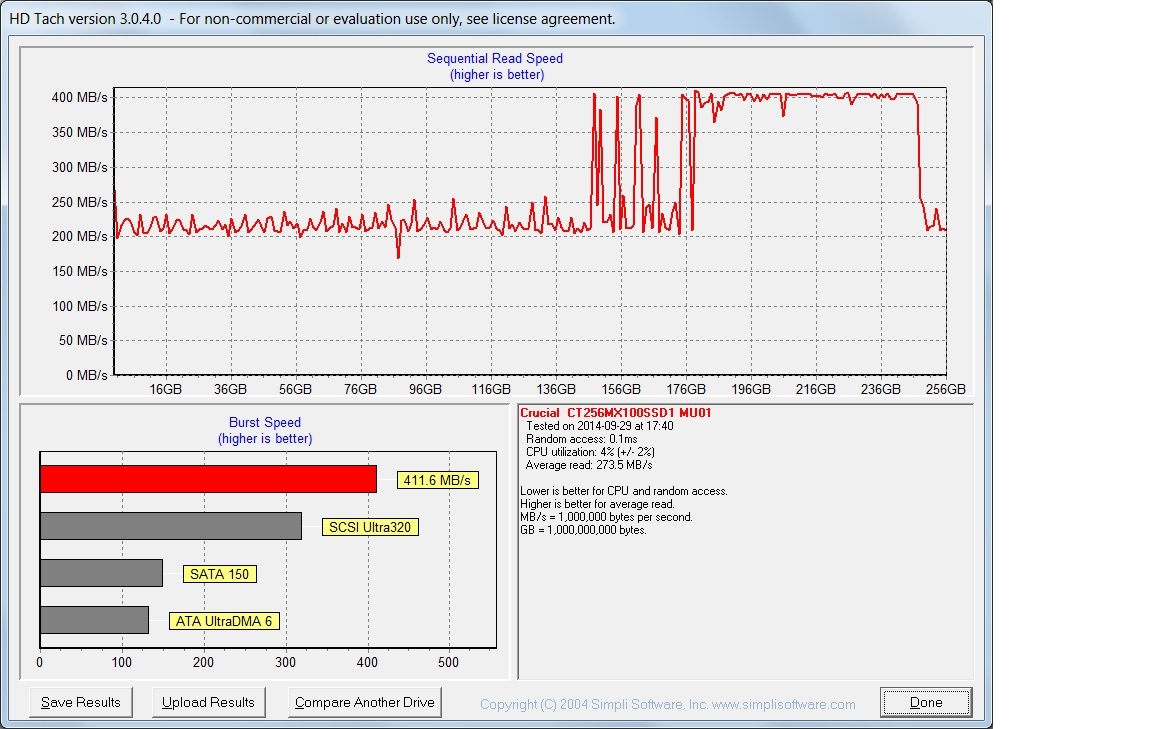

Hier is dan de hdtach van de mx100. De schijf is redelijk vol (159 GB), en het is een van de oudste in gebruik omdat ik een van de eersten was die deze heeft gekocht.

Even maar meteen wat conclusies. Zowel voor oude als jonge data zien we een enorm verlies aan snelheid. Het is zelfs zo dat deze ssd een slechter grafiek heeft dan je intel520 ! En ook veel slechter dan een samsung 840 evo. We dienen ogenblikkelijk groot alarm te slaan

[ Voor 3% gewijzigd door Reepje op 29-09-2014 17:45 ]

Bedankt. Ik heb je advies opgevolgd. De SSD zit nu op de plek waar de HDD zat en de HDD in het vrije slot. Windows herkend de schijven, maar het is met Windows 8 een ramp om de bios te benaderen of Windows te installeren. Om hoofdpijn van de krijgen.Phuncz schreef op maandag 29 september 2014 @ 17:09:

Je plaatst best een SSD op de plek van een (bestaande) HDD, minder kans dat je dan gelimiteerd bent, iets wat nogal eens gebeurd voor bv. optische drives.

...

@Reepje

Kom je met Crystaldisk en of HD Tune wel op normale snelheden uit dan? Die 273 MB/s is niet te pruimen .

.

Ik kam op HDtach uit het volgende nieuwsbericht: nieuws: Samsung brengt 15 oktober fix uit voor snelheidsdegradatie 840 EVO-ssd's

Kom je met Crystaldisk en of HD Tune wel op normale snelheden uit dan? Die 273 MB/s is niet te pruimen

Ik kam op HDtach uit het volgende nieuwsbericht: nieuws: Samsung brengt 15 oktober fix uit voor snelheidsdegradatie 840 EVO-ssd's

[ Voor 80% gewijzigd door sdk1985 op 29-09-2014 18:05 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

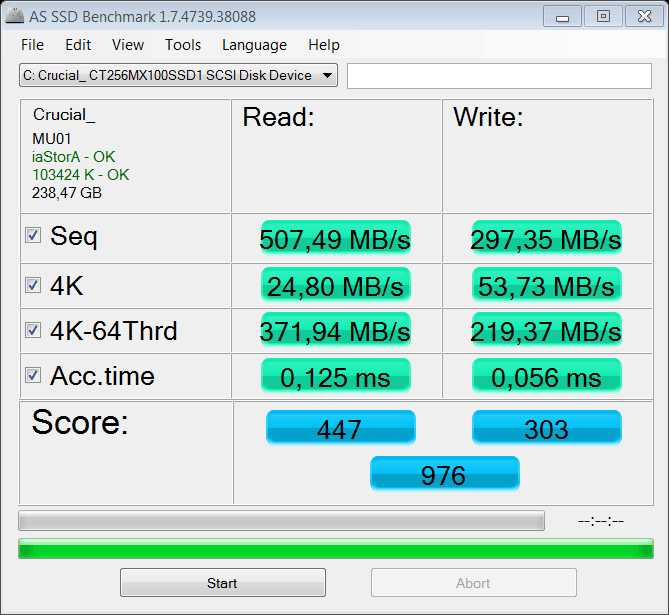

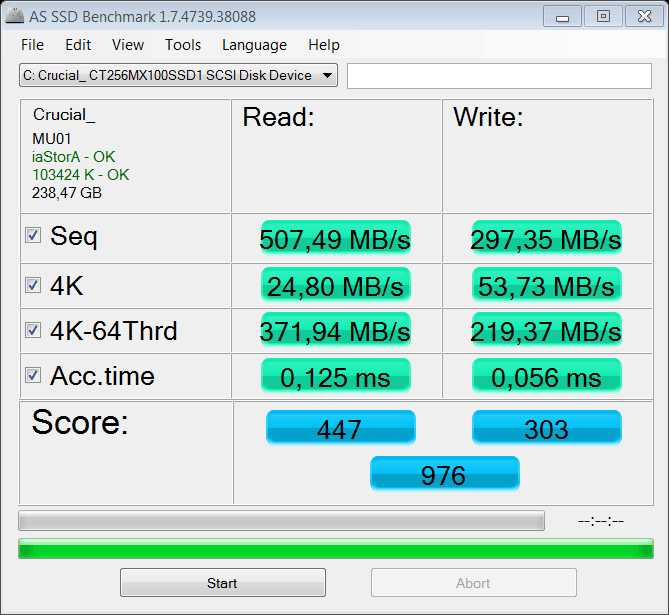

Is as ssd ook goed? Deze laat zelfs iets beter waarden zien als toen die nieuw was, zie mijn review over de mx100. productreview: Crucial MX100 256GB review door Reepje

De huidige as ssd ziet er zo uit:

De huidige as ssd ziet er zo uit:

Ben niet zo heel erg fan van AS-SSD omdat op een normale hdd testen daarmee eindeloos lang duurt. Dus die benchmark draai ik eigenlijk nooit. Maar dat is wel een wereld van verschil...

Heb wel crystal disk, hdtune en atto van een lege 840 evo (die ik bij iemand heb ingebouwd en dus niet meer in bezit heb ).

).

Vreemd genoeg weigert hdtune vandaag zijn scherm te laten zien, het blijft bij een icoontje in de taakbalk .

.

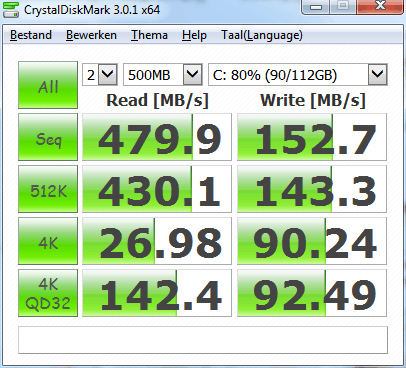

Van de Intel na 2 jaar:

Atto:

Crystaldisk ( Had het idee dat hij nieuw beter scoorde):

edit:

Crystal disk in 2012:

Wil er natuurlijk niet op achteruit gaan bij een upgrade naar een Mx100 of 840 evo.

Heb wel crystal disk, hdtune en atto van een lege 840 evo (die ik bij iemand heb ingebouwd en dus niet meer in bezit heb

Vreemd genoeg weigert hdtune vandaag zijn scherm te laten zien, het blijft bij een icoontje in de taakbalk

Van de Intel na 2 jaar:

Atto:

Crystaldisk ( Had het idee dat hij nieuw beter scoorde):

edit:

Crystal disk in 2012:

Wil er natuurlijk niet op achteruit gaan bij een upgrade naar een Mx100 of 840 evo.

[ Voor 47% gewijzigd door sdk1985 op 29-09-2014 18:59 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Doe niet zo moeilijk en ga reviews opzoeken, waar trace tests worden toegepast...

Jouw manier van vergelijken is eerlijk gezegd redelijk hopeloos...

Je ging al de fout in met focussen op HDtach, zoals ik eerder al zei.

En puur vergelijken op Crystaldiskmark geeft een snelle indicatie maar zegt Niks over hoe de drive echt presteerd,wantt bijna alle SSD's in benchmarks zoals crystaldiskmark en of hdtune/hdtach laten tegenwoordig hetzelfde resultaat zien, behalve als er echt afwijkende specs zijn.

Omdat voor simpele workloads ze allemaal zo goed als even snel zijn

Jouw manier van vergelijken is eerlijk gezegd redelijk hopeloos...

Je ging al de fout in met focussen op HDtach, zoals ik eerder al zei.

En puur vergelijken op Crystaldiskmark geeft een snelle indicatie maar zegt Niks over hoe de drive echt presteerd,wantt bijna alle SSD's in benchmarks zoals crystaldiskmark en of hdtune/hdtach laten tegenwoordig hetzelfde resultaat zien, behalve als er echt afwijkende specs zijn.

Omdat voor simpele workloads ze allemaal zo goed als even snel zijn

[ Voor 25% gewijzigd door Swordlord op 29-09-2014 18:57 ]

Zucht...........Swordlord schreef op maandag 29 september 2014 @ 18:53:

Doe niet zo moeilijk en ga reviews opzoeken, waar trace tests worden toegepast...

Jouw manier van vergelijken is eerlijk gezegd redelijk hopeloos...

want de hoekstenen van SSD performance van bijna alle SSD's in benchmarks zoals crystaldiskmark en of hdtune/hdtach laten tegenwoordig hetzelfde resultaat zien, behalve als er echt afwijkende specs zijn.

Omdat voor simpele workloads ze allemaal zo goed als even snel zijn

1) Het is niet mijn manier van vergelijken. Zoals gezegd kwam tweakers.net met HDtach, ik heb dat programma verder nog nooit gebruikt.

2) Reviews hebben voor dit scenario totaal geen nut omdat bij een review alle ssd's in nieuwstaat zijn. Het probleem waarvan Samsung zelf aangeeft dat het bestaat komen komt daarbij niet aan het licht.

3) Die dips naar is 60 MB/s zeker wel iets dat je gaat merken. Is verder ook totaal niet acceptabel.

4) Los daar van is een "lichte workload" verder volledig persoonlijk, ik zit op 33980 GB writes ~~ 39 GB/dag. Als het je allemaal niets uit maakt wat je hardware doet dan hoef je ook niet op tweakers te komen. Persoonlijk doe ik liever wel onderzoek naar het beste product voor ik het aanschaf.

5) Dat goed benchmarken lastig is betekent niet dat je het maar helemaal niet moet proberen.

[ Voor 34% gewijzigd door sdk1985 op 29-09-2014 19:09 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Een oude 840 zal in crystaldisk mark gewoon benchen op 500MB/s read...

Want die test data is nieuw.

Dus ookal zou de drive al sinds release in gebruik zijn. Je ziet het niet...

Die bug van de 840 is nou opzicht redelijk uniek.

Daarbij, je kan wel blijven vragen aan mensen voor hun screenshots... Zolang de variabelen niet gelijk zijn. Is de vergelijking nutteloos...

Als opeens screenshot van een drive die zonder trim heeft gefunctioneerd komt dat zal lekker rommelen met het beeld dat gevormd wordt.

Want die test data is nieuw.

Dus ookal zou de drive al sinds release in gebruik zijn. Je ziet het niet...

Die bug van de 840 is nou opzicht redelijk uniek.

Daarbij, je kan wel blijven vragen aan mensen voor hun screenshots... Zolang de variabelen niet gelijk zijn. Is de vergelijking nutteloos...

Als opeens screenshot van een drive die zonder trim heeft gefunctioneerd komt dat zal lekker rommelen met het beeld dat gevormd wordt.

[ Voor 38% gewijzigd door Swordlord op 29-09-2014 19:08 ]

En daarom vroeg ik dus om een HDtach bench van de MX100 ipv een Crystaldisk mark...

Waarom vroeg ik later toch om een Crystalmark? Omdat Reepje wel erg laag scoort wat de verdenking creëert dat er weinig van die HDtach klopt.

Verder is die 840 bug helemaal niet zo uniek. Ik heb destijds op de sandforce met HD tune ook een verschil van +- 100 MB/s kunnen vaststellen op blokken die al beschreven waren. Alleen Samsung maakt het nu dus wel heel bont.

Waarom vroeg ik later toch om een Crystalmark? Omdat Reepje wel erg laag scoort wat de verdenking creëert dat er weinig van die HDtach klopt.

Verder is die 840 bug helemaal niet zo uniek. Ik heb destijds op de sandforce met HD tune ook een verschil van +- 100 MB/s kunnen vaststellen op blokken die al beschreven waren. Alleen Samsung maakt het nu dus wel heel bont.

[ Voor 5% gewijzigd door sdk1985 op 29-09-2014 19:10 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Dat is omdat HDtach op LBA niveau functioneert... Hij wilt sector per sector aanroepen...

Maar een SSD werkt niet puur sector voor sector... Dit geeft dus andere resultaten terug dan je zou willen, afhankelijk hoe de controller omgaat met die low level requests...

Maar een SSD werkt niet puur sector voor sector... Dit geeft dus andere resultaten terug dan je zou willen, afhankelijk hoe de controller omgaat met die low level requests...

he he, wordt er eentje wakker.sdk1985 schreef op maandag 29 september 2014 @ 19:06:

erg laag scoort wat de verdenking creëert dat er weinig van die HDtach klopt.

Vraag die overblijft is hoe je dan wel normaal iets kunt zeggen over een SSD die niet leeg is.

Hoe betrouwbaar zijn de grafieken van HD tach of HD Tune Pro 5.5? Even hardop denken... Ook al is er geen direct relatie tussen waar het OS denkt dat bestanden staan, als je maar genoeg sampled breng je toch de prestaties over de hele ssd in kaart. Of niet?

Hoe betrouwbaar zijn de grafieken van HD tach of HD Tune Pro 5.5? Even hardop denken... Ook al is er geen direct relatie tussen waar het OS denkt dat bestanden staan, als je maar genoeg sampled breng je toch de prestaties over de hele ssd in kaart. Of niet?

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Die methode is heel simpel. zet een ssd in je computer en krijg het wow gevoel, zo snel. Blijf vervolgens werken met je computer. Als de ssd na verloop van tijd razend langzaam wordt, dan merk je dat gewoon. Heb je helemaal geen benchmark grafiekje voor nodig.sdk1985 schreef op maandag 29 september 2014 @ 19:15:

Vraag die overblijft is hoe je dan wel normaal iets kunt zeggen over een SSD die niet leeg is.

Dat is ook het rare met de 840 bug. De oudste files op de meeste ssd's zijn je windows files. Razendsnel opstarten is best wel leuk. Maar als na verloop van tijd deze oude files langzamer als op een hdd gelezen worden, zal de computer natuurlijk ook sloom opstarten. Raar, want in de praktijk gebeurde dit niet, totdat een gozer HDtach op een evo losliet en de bug wel ontdekt werd.

Read performance valt over et algemeen niet terug, jah de 840 en de Prut A-sync nand sandforce drives vormen de uitzondering.sdk1985 schreef op maandag 29 september 2014 @ 19:15:

Vraag die overblijft is hoe je dan wel normaal iets kunt zeggen over een SSD die niet leeg is.

Om te kijken wat write doet: Dat had ik je al eens gezegd, reviews: steady state benchmarks.

SSD's die volstaan met random data, die daarna een nieuwe write workload krijgen te verwerken...

Dan komt aan het licht hoe de controller en firmware alles verwerkt en kan dan soms ook verklaringen geven waarom een bepaalde SSD langzamer schrijft naarmate hij volerl staat met bepaalde data.

Mijn HD Tach van een 830. Lekker strak! O, sorry, wel sata 2.

https://www.dropbox.com/s...sung%20SSD%20830.jpg?dl=0

https://www.dropbox.com/s...sung%20SSD%20830.jpg?dl=0

[ Voor 13% gewijzigd door JantjeKoud op 29-09-2014 19:37 ]

Mensen, let bij het HD Tach testje wel op het volgende. Het gaat er bij de 840-bug om dat de grafiek *drie* lagen laat zien:

*Meer dan 400 MB/s voor onbeschreven gebieden. Dit is de SATA-bottleneck.

*Toch zeker wel minimaal 200-300 MB/s voor relatief nieuwe bestanden (ongeveer zo snel als je in CrystalDiskMark ziet). Dit is de normale readsnelheid van je SSD.

*Supertrage <200 MB/s gebieden voor oude bestanden (doorgaans meer aan het begin van de schijf, dus links op de grafiek). Dit is de bug in werking, de leessnelheid kan tot ver onder de 100 MB/s dalen.

En inderdaad zijn er diverse mensen in het topic op Overclock.net die een merkbaar snelheidsverschil merkten na oude bestanden te hebben herschreven (veelal door met specifieke settings een specifiek defragmentatieprogramma te draaien).

*Meer dan 400 MB/s voor onbeschreven gebieden. Dit is de SATA-bottleneck.

*Toch zeker wel minimaal 200-300 MB/s voor relatief nieuwe bestanden (ongeveer zo snel als je in CrystalDiskMark ziet). Dit is de normale readsnelheid van je SSD.

*Supertrage <200 MB/s gebieden voor oude bestanden (doorgaans meer aan het begin van de schijf, dus links op de grafiek). Dit is de bug in werking, de leessnelheid kan tot ver onder de 100 MB/s dalen.

En inderdaad zijn er diverse mensen in het topic op Overclock.net die een merkbaar snelheidsverschil merkten na oude bestanden te hebben herschreven (veelal door met specifieke settings een specifiek defragmentatieprogramma te draaien).

Zelfs mijn pas gekochte built to order laptop (3 HDD's en 1 msata) heeft op de caddy aansluiting... sata2 ! beetje zonde om daar een ssd in te prikken.Luxicon schreef op maandag 29 september 2014 @ 16:43:

Is het verstandig de SSD op de plek van de huidige HDD te plaatsen en heeft de laptop twee HDD plaatsen vrij? Dat ziet er wel zo uit, al hoor ik vaak dat er en HDD caddy nodig is en zodoende de DVD eruit gaat. Hieronder een foto daarvan.

[afbeelding]

Als jouw caddy aansluiting wel sata3 heeft, doen natuurlijk !

Had ik het geweten, xnotebooks vermeldde dat toen niet, had ik de dvd laten zitten i.p.v. een caddy er bij te krijgen.

http://tweakers.net/gallery/45440/sys | Als het in de manual staat is dat fout.... (Creative ZEN scherm perikelen)

Eerlijk gezegd weet ik niet hoe ik dat zou controleren, maar ik heb de SSD op de plek van de oude HDD gezet en de oude HDD in het lege slot.

...

Ondertussen bij techreport:

Micron's M600 solid-state drive reviewed

Wel interessant idee om hun NAND via firmware zo te tweaken dat het als SLC én MLC kan worden gebruikt. Goed voor de resultaten? Mwoah. De auteur denkt er hetzelfde over als ik:

Micron's M600 solid-state drive reviewed

Oftewel: Enterprise materiaal.Although Crucial used to mirror Micron's offerings, the MX100 marked the beginning of a divergence. Having identical lineups created too much confusion and pricing overlap, Micron told us, so the two brands will do their own thing moving forward.

Wel interessant idee om hun NAND via firmware zo te tweaken dat het als SLC én MLC kan worden gebruikt. Goed voor de resultaten? Mwoah. De auteur denkt er hetzelfde over als ik:

Even if it's not a perfect solution to limited NAND-level parallelism, Dynamic Write Acceleration is clearly effective, and the underlying technology is very slick. It will be interesting to see how on-the-fly switching manifests in future Micron SSDs, including those sold under the Crucial banner.

...and your ass will follow

Nagenoeg weinig spannends sinds de M500, ik wacht op hun PCIe SSD's waar nog nuttige verschillen te vinden zijn.

Anandtech laat zien dat de MX100 (en M550 en M500) geen volledige powerloss beveiliging hebben, maar alleen de data beschermen die al op de SSD staat.

Zo had ik het nog niet begrepen...In the MX100 review, I was still under the impression that there was full power-loss protection in the drive, but my impression was wrong. The client-level implementation only guarantees that data-at-rest is protected, meaning that any in-flight data will be lost, including the user data in the DRAM buffer. In other words the M500, M550 and MX100 do not have power-loss protection -- what they have is circuitry that protects against corruption of existing data in the case of a power-loss.

Ik had een vraagje, op het internet zie ik veel mensen hogere as ssd-scores halen dan mijn mx100 256gb..

Mijn ssd: (178gb van 238gb beschikbaar)

Dus mijn vraag was dan eigenlijk: heb ik iets verkeerds ingesteld? Of kan er nog wat aan gesleuteld worden

Grtz,

Ersin

Mijn ssd: (178gb van 238gb beschikbaar)

Dus mijn vraag was dan eigenlijk: heb ik iets verkeerds ingesteld? Of kan er nog wat aan gesleuteld worden

Grtz,

Ersin

Ryzen 5 3600. Aorus x570 PRO. Corsair H100i Capellix. AMD 6900XT. CM MasterCase Maker 5 CASE . Logitech G903. Logitech G213. Samsung 970 EVO PLUS M.2. G.Skill Flare X 3200MHz 16GB. Corsair RM750 2019. Acer XF240H 144hz + BenQ 2450H.

Het is maar een tikkie "langzamer" dan wat een moderne computer neerzet. Ook al zou je op een of andere manier wel een score van 950 halen, het verschil in snelheid merk je niet.

Waarom is het langzamer? Misschien een oudere computer, misschien heb je een laptop, energiebesparende functies ingesteld.

Waarom is het langzamer? Misschien een oudere computer, misschien heb je een laptop, energiebesparende functies ingesteld.

Was al langer bekend wat betreft powerloss protection op micron drives.

Dat data in dram verloren gaat is in principe niet erg, is bij een harddisk met writeback cache niet anders. Vraag is dan alleen wat de ssd doet met applicaties die uncached writes doen.

Dat data in dram verloren gaat is in principe niet erg, is bij een harddisk met writeback cache niet anders. Vraag is dan alleen wat de ssd doet met applicaties die uncached writes doen.

Test met anti-virus uit?Erso schreef op dinsdag 30 september 2014 @ 21:55:

Ik had een vraagje, op het internet zie ik veel mensen hogere as ssd-scores halen dan mijn mx100 256gb..

Mijn ssd: (178gb van 238gb beschikbaar)

[afbeelding]

Dus mijn vraag was dan eigenlijk: heb ik iets verkeerds ingesteld? Of kan er nog wat aan gesleuteld worden

Grtz,

Ersin

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Yep, enkel windows defender/securuty essentials draaide.. weet niet als dat iets uitmaakt.

Ryzen 5 3600. Aorus x570 PRO. Corsair H100i Capellix. AMD 6900XT. CM MasterCase Maker 5 CASE . Logitech G903. Logitech G213. Samsung 970 EVO PLUS M.2. G.Skill Flare X 3200MHz 16GB. Corsair RM750 2019. Acer XF240H 144hz + BenQ 2450H.

Met de benchmarks scoor ik zoals anderen met de MX100. Met AS SSD had ik ook een score van 967. Met de iops variant had ik iets meer dan 1000. Het rare is wel dat ik erg laag scoor met 4k (niet qd32). Dat is echt drastisch minder. Vanavond kan ik wel screenshots plaatsen van verschillende tests.

Wat me ook opvalt is dat ik met HD tach structureel (300MB/s als gemiddelde bovenlijn) lager scoor dan toen de EFI-partitie nog op de oude HDD geplaatst was (toen was 400MB/s de gemiddelde bovenlijn). Daarbij is Windows opnieuw geïnstalleerd. Dat verliep vlekkeloos. De oude HDD is tijdelijk ontkoppeld.

Wat ook vreemd is is dat het schrijven erg veel trager is met de schijfcache uitgeschakeld. Ik las dat dat juist pro-snelheid is.

Wat me ook opvalt is dat ik met HD tach structureel (300MB/s als gemiddelde bovenlijn) lager scoor dan toen de EFI-partitie nog op de oude HDD geplaatst was (toen was 400MB/s de gemiddelde bovenlijn). Daarbij is Windows opnieuw geïnstalleerd. Dat verliep vlekkeloos. De oude HDD is tijdelijk ontkoppeld.

Wat ook vreemd is is dat het schrijven erg veel trager is met de schijfcache uitgeschakeld. Ik las dat dat juist pro-snelheid is.

[ Voor 5% gewijzigd door Luxicon op 01-10-2014 09:38 ]

...

Haha... Write cache uit was pro-snelheid 6 jaar terug ofzo... Met bepaalde barefoot controllers

Tis alleen de optimalisatie guides zijn nooit geupdate... Mensen blijven de oude guides copy pasten..

Tis alleen de optimalisatie guides zijn nooit geupdate... Mensen blijven de oude guides copy pasten..

[ Voor 31% gewijzigd door Swordlord op 01-10-2014 10:05 ]

Hier mijn HDtach, met twee Samsung 830's in Raid 0. Wat doet dit programma anders dan al dat andere benchmark spul? Leest het alleen bestaande data uit oid?

||| F1-aeroblog || Battlelog |||

Aha, dus dat is intussen een antiek iets.Swordlord schreef op woensdag 01 oktober 2014 @ 10:02:

Haha... Write cache uit was pro-snelheid 6 jaar terug ofzo... Met bepaalde barefoot controllers

Tis alleen de optimalisatie guides zijn nooit geupdate... Mensen blijven de oude guides copy pasten..

Dat ziet er goed uit. Heb je er veel data opstaan en zitten daar ook kleine bestanden bij?fynrd1 schreef op woensdag 01 oktober 2014 @ 15:02:

Hier mijn HDtach, met twee Samsung 830's in Raid 0. Wat doet dit programma anders dan al dat andere benchmark spul? Leest het alleen bestaande data uit oid?

[afbeelding]

Ik heb zelf niet stabiele snelheden bij de HD Tach en de resultaten zijn minder dan een MX100 hoort te presteren. Voordat de EFI-partitie op de SSD geïnstalleerd was was HD Tach sneller en was de gemiddelde bovenlijn 400 MB/s. Het valt me op dat m'n MX100 op bepaalde gebieden duidelijk minder scoort dan z'n collega's. Ik ben zeer tevreden, maar ook benieuwd hoe dat zou kunnen komen. De schijf is nu 50% vol.

De 4K prestaties zijn duidelijk minder, zo ook de 512B bij de iops test

...

Wat voor mainboard en sata controller heb je dan ?