PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Interessant, al blijf ik wel van mening dat het logischer is dat developers gewoon voor een fatsoenlijk scherp beeld zorgen, zodat je niet daarna kunstmatig weer scherper moet maken. Desnoods met een slider in het spel.Help!!!! schreef op vrijdag 12 juli 2019 @ 13:43:

Techspot Testing AMD's new Radeon Image Sharpening: Is It Better than Nvidia's DLSS?

Bottom Line

Radeon Image Sharpening is genuinely impressive. It doesn’t require any developer implementation and it works well by sharpening the image which can be useful in a variety of situations.

Overall zie ik dit echter niet als bijzonder zinvolle toevoeging in de huidige staat, omdat het niet op DX11 werkt, en het een globale setting is. Alleen als je een 4k display hebt dan begrijp ik dat zoiets handig kan zijn zodat je op lagere resolutie kan renderen en nog fatsoenlijk beeld hebt. Maar voor degene die native resolutie draaien zou het overbodig horen te zijn bij fatsoenlijk ontworpen spellen, en wil je het zeker niet als globale setting hebben.

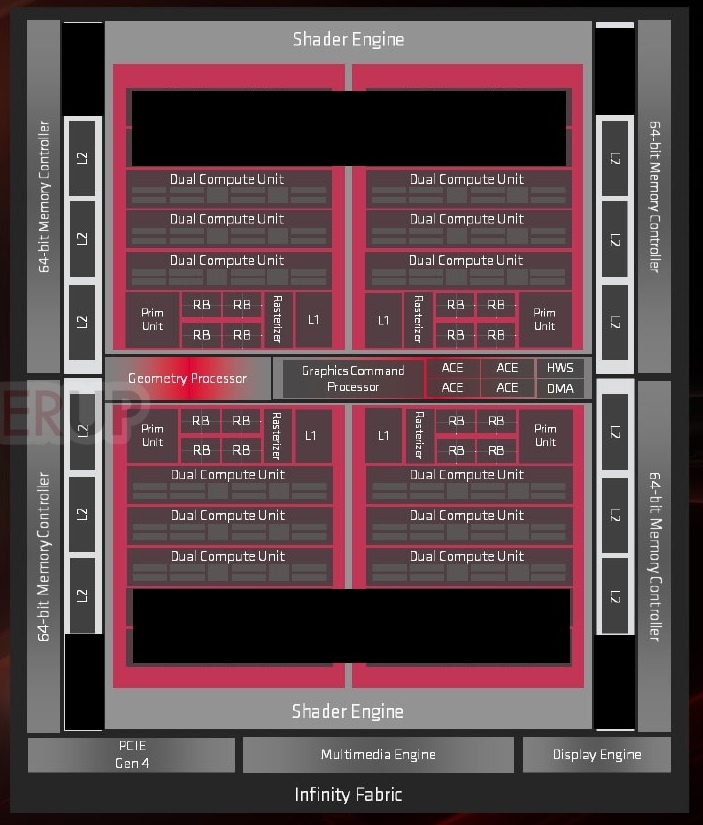

Waar komt die 64 CU toch elke keer vandaan?CerandoX.nl schreef op vrijdag 12 juli 2019 @ 13:06:

[...]

Let the waiting game begin, again.Daar komt hopelijk snel een Navi-vervanger voor.

64CU en 12GB zou erg mooi zijn.

Verwijderd in "CJ's AMD Radeon Info & Nieuwsdiscussietopic - Deel 143"

Die komt van geruchten en berekeningen. Misschien zijn die niet waar en de berekeningen niet goed, dat weet ik niet.XWB schreef op vrijdag 12 juli 2019 @ 14:09:

[...]

Waar komt die 64 CU toch elke keer vandaan?

Verwijderd in "CJ's AMD Radeon Info & Nieuwsdiscussietopic - Deel 143"

[ Voor 14% gewijzigd door CerandoX.nl op 12-07-2019 14:36 ]

Wat voor punt wil je hier nou mee maken? Hoe profiteert AMD bij het baiten van Nvidia? Ze hebben immers hun eigen prijs moeten verlagen. Zal dat ingecalculeerd zijn? Vast wel, maar als Nvidia niks had gedaan had je dus gewoon meer mogen betalen voor Navi. Of denk je echt dat AMD de prijs alsog gedrukt had als er geen antwoord kwam?DaniëlWW2 schreef op vrijdag 12 juli 2019 @ 10:00:

Het was gewoon wel gepland, jebaited.

[YouTube: Did AMD Really 'Jebait' NVIDIA? Radeon VP Scott Herkelman Interview!]

AMD schiet er echt geen klap mee op door nvidia een andere sku op de markt te laten positioneren ter counter. Ze hebben meer schade gedaan door überhaupt de prijzen initieel te hoog in te zetten en dat weet Nvidia net zo goed. Het toont meer aan hoe makkelijk Nvidia op dit moment antwoord heeft op AMD en hoeveel grip ze hebben op de markt. Afgekeurde 104 en 106 dies zal nvidia na 9 maanden wel in stockpile hebben liggen die wel als Super kaart verkocht kunnen worden. Kwestie van gebruiken wat je eerder niet kon verkopen en AMD is nu feitelijk minder hoog op de prestatieladder binnengekomen.

Again, hoe profiteert AMD hiervan? Ze drukken nu ook hun eigen marge en roepen vervolgens we hebben ze waar we ze willen hebben muhahaha. Er zit geen enkele logica in dit verhaal buiten dat ze nu van Nvidia bevestigd krijgen dat die nog lang niet het onderste uit de kan te halen om voorop te blijven. Ze hebben een antwoord letterlijk binnen een paar weken al in de winkel liggen.Vervolgens gaat hij het gewoon uitleggen. Het was een analyse van Turing, de conclusie dat er nog marges op Turing zaten qua prestatie en prijs. Ze zette RX5700 series in de markt, wachten op de prijzen van de Turing refresh nodig, en reageerde door eronder gaan zitten. Precies wat ik dus al zei.]

Joepie, AMD kan twee discutabele geprijsde kaarten (2060 en 2070) verslaan bijna een jaar later op waarde voor je geld niveau. Het is gewoon triest dat het al jaren de gang van zaken is dat AMD producten uitbrengt als antwoord op ipv een eigen strategie volgt. RTX was vanaf release al te duur, maarja wat wil je als niemand je product kan counteren. AMD zou andersom exact hetzelfde doen.Het resultaat is dat de RTX2060, RTX2070 en RTX2060S allemaal zijn verslagen op perf/prijs. De RTX2070S is veel te duur voor de meerwaarde over de RX5700XT.

Point being dat AMD veel meer aandeel heeft dan Steam zegt? Volgens mij komen de andere bronnen regelmatig voorbij en heeft AMD nog steeds hopeloze achterstand met net 22% van de discrete markt. Steam ziet er dus niet tientallen procenten naast.Vervolgens gaat hij ook nog even in waarom de Steam hardware survey dus onbetrouwbaar is. Simpelweg meerdere steam accounts op een PC, vaak in een iCafes.

AMD heeft veel te lang liggen slapen en staat al jaren zwaar onder druk in de GPU markt, dat is de realiteit.

Scott erkent wel een groot deel van de AMD problemen in dit filmpje. Hij klaagt bv terecht over de benaming van Radeon producten.Dit is samen met de inconsistente lineup van AMD de afgelopen generatie precies de reden dan AMD de b-keuze is geworden voor het grote publiek. Het is niet raat dat veel aftermarket merken Radeom ook niet pushen als er weinig omzet uit te halen is.

- Ze hebben vrijwel nooit meer een volledige line-up per generatie.

- de benaming van producten gaan letterlijk all over te place.

- Verkrijgbaarheid is ook een serieus probleem.

- Game prestaties zijn ook niet altijd consistent. Soms heel goed en soms ook ondermaats. DX11 titels maakten pijnlijk duidelijk dat AMD gewoon een hardware probleem had en dat er frequent serieuze optimalisaties nodig waren. Fine wine is een mooie benaming voor moet nog verbeterd worden op driver niveau.

Definieer GPU markt, want in mijn ogen is dat meer dan alleen de Windows machientjes.sjekneck schreef op vrijdag 12 juli 2019 @ 14:40:

[...]

AMD heeft veel te lang liggen slapen en staat al jaren zwaar onder druk in de GPU markt, dat is de realiteit.

.

Dan leg ik mijn argument dat ik al weken geleden uiteenzette, nog maar een keertje uit.sjekneck schreef op vrijdag 12 juli 2019 @ 14:40:

[...]

Wat voor punt wil je hier nou mee maken? Hoe profiteert AMD bij het baiten van Nvidia? Ze hebben immers hun eigen prijs moeten verlagen. Zal dat ingecalculeerd zijn? Vast wel, maar als Nvidia niks had gedaan had je dus gewoon meer mogen betalen voor Navi. Of denk je echt dat AMD de prijs alsog gedrukt had als er geen antwoord kwam?

AMD had de RX5700 series zo kunnen lanceren, maar wat leverde dat op? Nvidia is soms zo enorm voorspelbaar. Iedereen met ook alleen maar wat publieke kennis en een beetje inschattingsvermogen, kon je vertellen dat Nvidia makkelijk een snellere refesh kon neerzetten voor minder om de RX5700 series meteen buiten spel te zetten. Nvidia heeft ook een lange geschiedenis van reageren op ATi/AMD launches met nieuwe SKU's en/of lagere prijzen.

Bij AMD hebben ze voor het eerst sinds 2014 eens een echt competitieve architectuur. Om je dan meteen bij launch al op prijs/prestatie te laten verslaan, terwijl je bijna een jaar te laat bent, gaat niet. Ze moesten dus wat doen, en daar helpt het dat Nvidia zo voorspelbaar is. Dus zette ze de RX5700 series iets goedkoper neer dan de Nvidia tegenhangers en wachten ze af. Nvidia is zo voorspelbaar om die Turing refresh te positioneren zodat deze de RX5700 series verslaat, zonder door te hebben dat AMD dit ingecalculeerd heeft.

Nvidia haar leiderschap (Jen-Hsun Huang dus) komt ondertussen ook steeds minder realistisch over. Ze zijn onderhand zo heilig overtuigd van hun superioriteit en dat iedereen, alles maar zal pikken. Nou, Turing pikken mensen dus niet. Ze lopen helemaal niet zo goed en hun omzet uit GeForce is keihard gekelderd. Ze zijn er gewoon vol ingelopen en die vermoedens sprak ik al uit voordat "jebaited" kwam. Nota bene lijkt AMD de werkelijke prestaties van de RX5700 series nog wat te hebben onderschat. De blower koelers helpen daar ook niet bij want het is allang bekend dat axiaal gekoelde modellen die beduidend koeler draaien, in de regel hogere boostclocks behalen. Er zijn nu ook al genoeg voorbeelden voorbij gekomen van RX5700XT's met de blower, die flink hoger kunnen clocken als je de ventilator maar flink laat draaien.

AMD is ook niet klaar nu. Nee, er zijn nog meerdere chipnamen opgedoken. Er wordt ook al maanden gespoken over minstens drie Navi chips, waarvan eentje groter zou zijn dan Navi 10. Zie bijvoorbeeld:

https://www.tomshardware....avi-14-navi-21,39684.html

Een grotere RDNA chip dan Navi 10, zal al snel de RTX2080S gaan verslaan. Niet een klein beetje ook. AMD is zich op prijzen daar nu al voor aan het bereiden. $499 en $599 kan zomaar, waar zelfs de $499 al de RTX2080S verslaat. Dit hoop ik, maar $50 a $100 duurder kan ook.

Waarom zou AMD dit doen? Nou omdat ze jarenlang nauwelijks iets echt concurrentes hebben gehad buiten mainstream. Ze hebben marktaandeel nodig op de plek waar het geld verdient word, de high end markt. Dat zijn de RX5700 series ook in prestaties in de Nvidia gedomineerde markt, high end. Dat de mainstream branding van "70" eraan is gehangen, neemt niet weg dat ze high end zijn. Daarboven komt nog een enthousiast en daaronder minstens een mainstream chip.

Prijzen dan. Tja, ik had zelf graag nog wel $50 eraf gezien voor de RX5700 series, maar dit is acceptabel voor wat deze chips zijn in de huidige markt. Een markt gedomineerd door Nvidia, niet AMD, waar AMD met betere prijs/perf komt dan Nvidia. Het ging om de RTX Super afslaan, en dat hebben ze gedaan. Er extreem onder gaan zitten, helpt ook niks. De keiharde prijzenoorlog heeft ATi/AMD al geprobeerd. Mensen bleken alsnog Nvidia te kopen terwijl er bij ATi/AMD geen geld meer binnenkwam. Dat resultaat zag je in 2014. Het kost al snel vier jaar om een nieuwe GPU architectuur te ontwikkelen. De ontwikkeling van Fiji uit 2015 is waarschijnlijk dan ook begonnen toen ATi/AMD, Nvidia afmaakte met TeraScale vs. Fermi. Het probleem wat als alsnog mensen Fermi kochten.

Verder is Ray Tracing dus echt zinloos. De hardware die nu op Turing chips zit, kan zelfs de simpelste RT effecten niet aan. Er is geen magisch drivertrucje dat dit wel even op zal lossen. Nu een Turing kopen voor RTX is geldverspilling. Niet alleen omdat de framerate al snel door de helft gaat in die paar games waar je RTX effecten hebt.

Als laatste dan de kille realiteit voor de RTG. Ze zijn niet meer afhankelijk van gamers die hun producten toch niet kochten voor insert drogredenering. Nauwelijks gamers die Vega kochten, en ook wel terecht. Weet je wie Vega 10 chips kocht? Apple. Naast Apple nu ook Google voor Google Stadia. Weet je wie RDNA chips met de miljoenen zal afnemen? Sony en Microsoft. Als AMD dan maar 30% marktaandeel heeft in de discrete gaming markt, best. Als ik een goede Radeon kan krijgen voor minder dan een Nvidia, best. De opbouw naar het punt dat de gemiddelde consument eens een Radeon zal kopen, gaat jaren duren. In de tussentijd zal de RTG een aantal maal moeten presteren.

Laat Nvidia ze het nu makkelijk maken want Nvidia zet in op RTX. Ze moeten de volgende generatie, relatief meer op RTX inzetten dat shader/rasterisation. Anders blijft het gat zo enorm en is RTX wederom zinloos. Nvidia gaat alleen naar 7nm van Samsung. De kans dat Nvidia daar ook even 700mm2 chips kan laten produceren, is niet bepaald goed. Ik zie het Nvidia heel moeilijk krijgen om met iets snellers dan de RTX2080Ti te komen in shader/rasterisation. Dat is de kans voor de RTG.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Natuurlijk brengen ze dat zo naar buiten, moet natuurlijk wel positief lijken voor de shareholders

En wat stopt Nvidia van om AMD in een briljante valstrik te leiden door hun producten ook €50 goedkoper te maken? Want als je producten goedkoper maken nadat een concurrent iets doet een briljante valstrik is, dan kan Nvidia dat ook.DaniëlWW2 schreef op vrijdag 12 juli 2019 @ 15:49:

[...]

Dan leg ik mijn argument dat ik al weken geleden uiteenzette, nog maar een keertje uit.

Precies, er is helemaal niks wat Nvidia stopt om dat te doen, behalve dat ze het waarschijnlijk niet nodig vinden.

$499 kan ja. $599 ook. Of $699. Of $799. Het kan allemaal. Maar waarom zou AMD in hemelsnaam een $500 RTX2080S killer op de markt brengen? Als we het toch hebben over dingen die mensen voorspeld hebben: Ik had voorspeld dat AMD echt geen $250 RTX2070 killer op de markt zou zetten. Woohoo, ik had gelijkEen grotere RDNA chip dan Navi 10, zal al snel de RTX2080S gaan verslaan. Niet een klein beetje ook. AMD is zich op prijzen daar nu al voor aan het bereiden. $499 en $599 kan zomaar, waar zelfs de $499 al de RTX2080S verslaat. Dit hoop ik, maar $50 a $100 duurder kan ook.

Nogmaals, de prijzen van kaarten worden slecht beperkt bepaald door de kosten om die te maken, de prijzen worden bepaald door het punt waarbij de financiele jongens verwachten dat de winst het hoogst is. Sterker nog, jij bent zelf degene hier die meerdere malen heeft gezegd dat het heel logisch is dat AMD niet goedkoop kaarten in de markt zet, omdat de consument toch Nvidia koopt. Waarom zou dat dan nu voor de RTX2080S concurrent anders zijn?

Dat is wel heel pessimistisch, maar ik ben het grotendeels met je eens. Er is alleen één grote maar: Als RTX zinloos is, waarom gaat AMD dan ook raytracing inbouwen? Waarom gaan volgende consoles het ook doen? Want het lijkt me sterk als volgende consoles meer rekenkracht gaan krijgen als een RTX2080S/RTX2080TI nu hebben.Verder is Ray Tracing dus echt zinloos. De hardware die nu op Turing chips zit, kan zelfs de simpelste RT effecten niet aan. Er is geen magisch drivertrucje dat dit wel even op zal lossen. Nu een Turing kopen voor RTX is geldverspilling. Niet alleen omdat de framerate al snel door de helft gaat in die paar games waar je RTX effecten hebt.

Ik defineer daarmee de gpu producten die een bedrijf gezond laten draaien. De markt buiten discrete gpu's brengen zoveel winst voor AMD dan? Ik zie het nog steeds niet terug in de cijfers:*Edmin schreef op vrijdag 12 juli 2019 @ 15:39:

[...]

Definieer GPU markt, want in mijn ogen is dat meer dan alleen de Windows machientjes.

AMD: AMD annual revenue for 2018 was $6.475B, a 23.26% increase from 2017.

Nvidia: NVIDIA annual revenue for 2018 was $9.714B, a 40.58% increase from 2017.

Die "windows machientjes" leveren Nvidia meer omzet en operationele winst dan heel AMD draait zelfsmet die extra's buiten de pc markt om. Daarom zeg ik dat AMD ligt te slapen.

Steamsurvey is ansich niet representatief voor hoe de thuisgebruiker dat interpreteerd en ook niet informatief voor wie daar logische conclusies uit zou willen trekken.DaniëlWW2 schreef op vrijdag 12 juli 2019 @ 10:00:

Vervolgens gaat hij ook nog even in waarom de Steam hardware survey dus onbetrouwbaar is. Simpelweg meerdere steam accounts op een PC, vaak in een iCafes.

Je kan nl niet zien welke games/programma`s er gespeeld worden met welke hardware.

(iemand met een snelle kaart kan bv best meestal 2d platformers spelen en maar af en toe bv Wolfenstein)

Veel hardware zit standaard in laptops en thin client achtige/oem computers, ook zoals hij zegt gamed iemand wel eens op iemand anders z`n pc (zeker in thuis/familie situaties)

Maar anyway kan AMD zich hier achter blijven verbergen ?

Hoe komt het dat AMD costeffective is en in alle consoles zit maar totaal niet vertegenwoordigd is in bv iCafes ?

Konden ze geen deal met MS of met Sony maken en desnoods Samsung om die PC`s te leveren als een soort XBOX/Playstation met PC/Windows functies ?

Daarentegen is de Gameworks achtige schandalen regen die we een aantal jaren geleden hadden inmiddels met schitterende droge Zon volledig afwezig geworden, dus denk ik dat het wel goed komt met AMD van nu af aan. (tenzij je het hebt over Raytracing maar die "techniek" is niet patenteerbaar aangezien het gewone wiskunde is, tenzij nVidia bv Pythagoras weet te contracteren.)

How do you save a random generator ?

Volgensmij ben je sowieso appels met peren aan het vergelijken.sjekneck schreef op vrijdag 12 juli 2019 @ 16:42:

[...]

Ik defineer daarmee de gpu producten die een bedrijf gezond laten draaien. De markt buiten discrete gpu's brengen zoveel winst voor AMD dan? Ik zie het nog steeds niet terug in de cijfers:*

AMD: AMD annual revenue for 2018 was $6.475B, a 23.26% increase from 2017.

Nvidia: NVIDIA annual revenue for 2018 was $9.714B, a 40.58% increase from 2017.

Die "windows machientjes" leveren Nvidia meer omzet en operationele winst dan heel AMD draait zelfsmet die extra's buiten de pc markt om. Daarom zeg ik dat AMD ligt te slapen.

AMD FY 2018 loopt tm 31.12.2018

NV FY 2018 loopt tm 31.01.2018

AMD FY 2018 is ongeveer NV FY 2019 en dan is het verschil in Revenue volgensmij nog stuk groter.

Echter bij NV is revenue al in laatste kwartaal 2018 flink ingestort en 19Q1 was ook dramatisch lager dan een jaar eerder. Dit meen ik als gevolg einde mining hype en waarschijnlijk slechte turing verkopen.

Ik geloof op dit moment meer in AMD's potentieel dan NV's maar we zullen zien.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Klopt. AMD was echter niet anders. Oké, Nvidia omzet is harder ingestort dat kwartaal dan AMD, maar nog steeds bijna 2x de omzet en 10x de winst.Help!!!! schreef op vrijdag 12 juli 2019 @ 17:44:

[...]

Volgensmij ben je sowieso appels met peren aan het vergelijken.

AMD FY 2018 loopt tm 31.12.2018

NV FY 2018 loopt tm 31.01.2018

AMD FY 2018 is ongeveer NV FY 2019 en dan is het verschil in Revenue volgensmij nog stuk groter.

Echter bij NV is revenue al in laatste kwartaal 2018 flink ingestort en 19Q1 was ook dramatisch lager dan een jaar eerder. Dit meen ik als gevolg einde mining hype en waarschijnlijk slechte turing verkopen.

Nee AMD met NvidiaHelp!!!! schreef op vrijdag 12 juli 2019 @ 17:44:

[...]

Volgensmij ben je sowieso appels met peren aan het vergelijken.

AMD FY 2018 loopt tm 31.12.2018

NV FY 2018 loopt tm 31.01.2018

AMD FY 2018 is ongeveer NV FY 2019 en dan is het verschil in Revenue volgensmij nog stuk groter.

Echter bij NV is revenue al in laatste kwartaal 2018 flink ingestort en 19Q1 was ook dramatisch lager dan een jaar eerder. Dit meen ik als gevolg einde mining hype en waarschijnlijk slechte turing verkopen.

Ik geloof op dit moment meer in AMD's potentieel dan NV's maar we zullen zien.

Niet helemaal hetzelfde. Nvidia heeft net de grote opvolger van Pascal geintroduceerd waar AMD vooral in de aanloop naar Zen 2 zat en nog met oude GPU architectuur zat. Toch twee verschillende sentimenten die normaal gesproken driver in sales zijn.Sissors schreef op vrijdag 12 juli 2019 @ 18:04:

[...]

Klopt. AMD was echter niet anders. Oké, Nvidia omzet is harder ingestort dat kwartaal dan AMD, maar nog steeds bijna 2x de omzet en 10x de winst.

Het zal interessant zijn om 20Q2 en verder van nvidia te zien m.n. of de Gaming revenue gaat herstellen (nu met Super).

Ook de vergelijking met AMD zal interessant zijn. NV de Supers. AMD heeft Zen 2 en Navi.

[ Voor 3% gewijzigd door Help!!!! op 12-07-2019 18:29 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Ik hoop toch echt dat AMD betere gegevens heeft over hoeveel chips ze precies laten produceren en aan wie ze ze verkopen. Lijkt me toch een dingetje voor een basale bedrijfsvoering.enchion schreef op vrijdag 12 juli 2019 @ 16:59:

[...]

Steamsurvey is ansich niet representatief voor hoe de thuisgebruiker dat interpreteerd en ook niet informatief voor wie daar logische conclusies uit zou willen trekken.

Je kan nl niet zien welke games/programma`s er gespeeld worden met welke hardware.

(iemand met een snelle kaart kan bv best meestal 2d platformers spelen en maar af en toe bv Wolfenstein)

Veel hardware zit standaard in laptops en thin client achtige/oem computers, ook zoals hij zegt gamed iemand wel eens op iemand anders z`n pc (zeker in thuis/familie situaties)

Maar anyway kan AMD zich hier achter blijven verbergen ?

Maar AMD zal precies weten hoeveel ze verkopen. Ze zullen ook weten hoe accuraat de statistieken zijn en hieruit zelf hun eigen interne gegevens over marktaandeel hebben. Ik denk dat AMD heel goed weet hoeveel Nvidia precies verkoopt, idem voor Nvidia over AMD. Waarschijnlijk beter dan die rapporten over marktaandeel. Als AMD dus zegt dat de Steam Hardware Survey niet betrouwbaar is en redenen geeft, dan zie ik weinig redenen om hier veel twijfel bij te plaatsen. Al helemaal omdat de hardware survey hier ook al vaak geanalyseerd is waar telkens de conclusie is dat de getallen niet betrouwbaar zijn.

Nvidia heeft een heel programma voor iCafes.Hoe komt het dat AMD costeffective is en in alle consoles zit maar totaal niet vertegenwoordigd is in bv iCafes ?

Konden ze geen deal met MS of met Sony maken en desnoods Samsung om die PC`s te leveren als een soort XBOX/Playstation met PC/Windows functies ?

https://www.nvidia.com/content/apac/icafe/en/partners.html

Dit lijkt me een kwestie van ondersteuning aan kleinere bedrijven die simpelweg te goed is om te negeren en voor Radeon te gaan.

Ik verwacht ook wel dat AMD kan winnen. Genoeg mensen die zeer pisnijdig waren over de prijzen van Turing. Verder kan Navi potentieel meeliften op het succes van Ryzen 3000. Ik verwacht alleen geen grote veranderingen, tenminste niet dit jaar. AMD die haar 30% marktaandeel weer herstelt, zou denk ik al een goed resultaat zijn. Zo ziet het er nu namelijk uit.Daarentegen is de Gameworks achtige schandalen regen die we een aantal jaren geleden hadden inmiddels met schitterende droge Zon volledig afwezig geworden, dus denk ik dat het wel goed komt met AMD van nu af aan. (tenzij je het hebt over Raytracing maar die "techniek" is niet patenteerbaar aangezien het gewone wiskunde is, tenzij nVidia bv Pythagoras weet te contracteren.)

2020 kan veel interessanter worden. Nvidia verwacht ik eigenlijk pas op haar vroegst in de zomer met de 7nm Turing opvolger. Nu heeft Turing waarschijnlijk wel wat laaghangend fruit. Waar een Turing speciale ALU's (Cuda cores dus) heeft voor integer (compute), FP32 en dan Tensor cores voor RT denoising en FP16, doet AMD FP16, FP32 en integer met dezelfde ALU's (Streaming Processors).

Ik zie Nvidia potentieel de FP32 ALU's verbeteren zodat ze ook FP16 en integer kunnen doen. Dat scheelt gewoon heel veel transistoren. Transistoren die ze kunnen steken in relatief meer RT cores en tensor cores. Wederom, Nvidia is best voorspelbaar. Ongeveer 30% erbij, generatie voor generatie is normaal. Geheel niet toevallig is 30% ook ongeveer wat je zal winnen met een node shrink.

Het probleem is dat Nvidia zich zo zwaar heeft gecommitteerd aan hun implementatie van basale ray tracing, RTX, dat ze eigenlijk niet genoeg hebben aan 30% erbij. Nee, ik zie ze eerder streven om het prestatieverlies van RTX, substantieel te verminderen. Dat kost heel wat extra transistoren. Transistoren die ze dan niet meer in in shader/rasterisation kunnen stoppen. De vraag is hoe ver Nvidia wil gaan om RTX maar te verbeteren. Ik zou ergens niet verbaast zijn als je in shader/rasterisation, geen 30% erbij meer gaat zien bij de volgende Nvidia generatie.

De enige manier die ik zie hoe Nvidia dit kan voorkomen, is als ze een enorme stap zetten in de efficiëntie van hun ray tracing hardware. Lukt ze dat niet, dan gaat het heel erg intersant worden waar de balans komt te liggen tussen RT en shader/rasterisation.

Ga ik helemaal pessimistisch doen dan is er nog dit. Nvidia doet sinds Kepler eigenlijk ook "tick tock". Kepler was beiden, maar Maxwell was alleen een "tock" en Pascal weer een "tick" en Turing een "tock". Is de volgende architectuur een "tick", dan heeft Nvidia een probleem. Iets substantieel sneller maken dan TU-102 gaat toch al een uitdaging worden op 7nm.

Dit opent potentieel de kans voor de RTG om helemaal in te lopen. Er zitten zeer waarschijnlijk nog een paar Navi's eraan te komen. De vraag is alleen hoe groot de grootste Navi gaat zijn. Ik zie een RTX2080S wel verslagen worden door een grotere Navi. De vraag is of AMD een 450mm2+ chip aan het voorbereiden is die het echt kan opnemen tegen de RTX2080Ti.

Komt AMD daarmee, dan hebben ze een volwaardige lijn tegenover Turing. Wordt Turing dan vervangen, dan kan AMD waarschijnlijk met een altijd waardeloze rebrand, waarschijnlijk nog redelijk competitief blijven. Uiteraard hoop ik op een volledige RDNA2 lijn in 2020, maar daar ben ik niet zeker van. Ben bang dat de Navi opvolging wel eens een combinatie van nieuw en rebrand kan zijn.

[ Voor 5% gewijzigd door DaniëlWW2 op 12-07-2019 19:31 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Het is een hele simpele berekening, de RX 5700 XT heeft 40CU's, een logische vergroting is bijvoorbeeld 50%, waardoor je dus 50% meer CU's krijgt, totaal dus 60CU's en ook een 50% grotere geheugenbus, dus 384 bit.CerandoX.nl schreef op vrijdag 12 juli 2019 @ 14:26:

[...]

Die komt van geruchten en berekeningen. Misschien zijn die niet waar en de berekeningen niet goed, dat weet ik niet.

Als je dan vervolgens de klokfrequentie van de GPU iets lager laat dan hoeft het verbruik bijvoorbeeld maar 30% hoger te liggen op iets van 280W. Daarmee kun je wel zo'n 40% hogere prestaties als een RX 5700 XT halen en krijg je prestaties die precies tussen de RTX 2080 en RTX 2080 Ti in liggen.

Standaard marketing geleuter wat elk bedrijf doet. Daar prik je toch wel doorheen? AMD moet gewoon reageren op nVidia ze hebben simpelweg geen keuze. Ze hebben niet (duidelijk) een beter product en ook niet een betere naam. Hierdoor moet je dus altijd reageren op je concurrent. nVidia hoeft dit niet perse, zij kunnen een product met een mindere prijs/prestatie alsnog beter verkopen dan AMD.DaniëlWW2 schreef op vrijdag 12 juli 2019 @ 10:00:

Vervolgens gaat hij het gewoon uitleggen. Het was een analyse van Turing, de conclusie dat er nog marges op Turing zaten qua prestatie en prijs. Ze zette RX5700 series in de markt, wachten op de prijzen van de Turing refresh nodig, en reageerde door eronder gaan zitten. Precies wat ik dus al zei.

Als AMD nVidia zogenaamd beet heeft genomen dan zou nVidia weer moeten reageren. En dat hebben ze niet gedaan en zijn ze volgens mij ook helemaal niet van plan. AMD moest simpelweg reageren door de Supers en een prijsverlaging toepassen. AMD heeft echter de prijs op nVidia aangepast, waarbij de prijs/prestatie dicht bij nVidia licht. nVidia hoeft nu dus niks te doen.

Zouden ze nVidia beet willen nemen hadden ze de prijs zover moeten verlagen dat nVidia hier weer op moest reageren. Maar dat hebben ze duidelijk niet gedaan. AMD zit daar ook helemaal niet op te wachten natuurlijk, zoals elk bedrijf maken ze liever winst op het product dan verlies.

[ Voor 49% gewijzigd door Verwijderd op 12-07-2019 22:12 ]

Waarom is het bedroevend?Skybullet schreef op zaterdag 13 juli 2019 @ 09:31:

maar bedroevend is het zeker

En bedoel je niet end-of-sale?

Ik denk dat hij de Radeon VII bedoelt. Maar die was sowieso DOA tbh, alleen wat die-hard fans hebben die gekocht.Verwijderd schreef op zaterdag 13 juli 2019 @ 09:55:

De GPU zelf is niet EOL, zijn alleen maar enkele videokaart modellen. Ze gebruiken nu gewoon dezelfde GPU alleen is er minder uitgeschakeld. Maar de winst per verkochte GPU zou best wel eens hoger zijn geworden, met uitzondering van de oude GTX 2060 die een kleine prijsverlaging heeft gekregen.

Je vergelijkt echter AMD's 2018 met Nvidia's 2017 en kijkt niet diepersjekneck schreef op vrijdag 12 juli 2019 @ 18:06:

Nee AMD met Nvidia. En idd fair is het niet want AMD doet ook nog eens CPU. Het verschil is nog steeds giga.

Nvidia's fiscale jaar is genummerd naar het jaar waarin het eindigt, niet het jaar waar het over gaat. FY'19 = 2018.

Voor 2018 zat Nvidia op $11,7b, 21% meer dan 2017 (die $9,7b waar jij het over hebt).

Het gros daarvan (een slordige 10 miljard) komt uit GPU's. $6,25b van die omzet is gaming GPU's ("Windows machientjes"), 13% meer dan het jaar ervoor.

De overige 4 miljard komen uit "Professional visualization" (Quadro, $1,1b, 21% hoger dan 2017) en datacenter (Tesla, $3b, +52%). Dat is waar ze hun marges halen. Ga maar eens door de jaarlijkse cijfers heen. Gaming/desktop GPU's zijn al jaren groeiende, maar dat leunt vooral op puur volume.

FY'17 (2016 dus, het jaar van Pascal) is waarschijnlijk het leukste voorbeeld. Ze hadden toen 38% meer omzet, $6,9b tegenover $5b het jaar ervoor. De netto inkomsten is echter waar het leuk was: niet verdubbeld, maar bijna verdrievoudigd. Van $614m naar $1,66b. Eventjes 171% erbij. GPU (alles samen) had 39% meer omzet, specifiek datacenter had 145% meer omzet. Het is jammer dat ze geen exacte cijfers geven, maar zelfs zonder die details is het niet lastig om te zien waar de winst vandaan komt. Omzet is leuk en aardig, maar uiteindelijk draait het om winst. Hetzelfde zie je in FY'18: 40% meer omzet, dubbele aan winst en de grootste groei zit in datacenter.

Nvidia haalt uit die $11,7b zo'n $4,1b winst. AMD haalt uit hun $6,5b met pijn en moeite $0,3b (zal het maar even met dezelfde significantie weergeven voor het effect

AMD is qua omzet sinds 2014 van $3,9 -> $4,3 -> $5,2 -> $6,4 gegaan (+10%, +21%, +23%). De winst (nou ja, verlies tot dit jaar

AMD haalt het dus weldegelijk allemaal uit Windows machientjes en dan vooral uit de CPU's. Epyc groeit wel, maar dat is zo'n tak waar het enkele jaren duurt, daar wordt niet elke 1-2 jaar vernieuwd.

Op GPU gebied doet AMD niet veel op dit moment, maar over het geheel genomen liggen ze absoluut niet te slapen. Ze moeten tegen twee reuzen opboksen en het gevecht met de blauwe reus ging in 2018 hartstikke lekker. Hun FY'19 wordt er één om in de gaten te houden, want hopelijk zet deze trend zich voort met Zen 2. En dat voedt hopelijk een impuls in Radeon. Is het een goede keus om niet het gevecht met de "big die" producten aan te gaan? Vanuit financiëel standpunt wel, vanuit een marketing standpunt niet, omdat dat de mindshare niet ten goede komt. Zie je hier op het forum ook: "hahahaha AMD komt pas een jaar later op kleinere node met iets vergelijkbaars HUEHUEHUE". Schijt aan de vooruitgang die ze weldegelijk boeken, of de prijs/prestatie verhouding van hun producten. Geen halo product, dus niet goed genoeg.

Zou Nvidia het redden puur op GeForce? Vast wel, hun marktaandeel is groot genoeg. Maar GeForce is niet de reden dat ze zo lekker draaien de laatste jaren, dat zit vooral in datacenter. En al helemaal niet die peperdure krengen, het zijn de mid-range en laptop GPU's waar de "Windows machientjes" tak het van moet hebben. In hun eigen woorden:

Wie had dat gedacht, GPU's die meer kosten dan een gehele high-end gaming PC zijn niet populair? En ik dacht dat de Ares/Mars en vergelijkbare producten vroeger altijd met miljoenen exemplaren over de toonbank gingen...quote: NvidiaGaming GPU growth was fueled by Turing-based GPUs for desktops and by gaming notebooks based on our Max-Q technology. We experienced significant volatility in our Gaming revenue during fiscal year 2019. We believe demand for our desktop gaming GPU products used by end users for cryptocurrency mining and its after-effects have distorted trends in Gaming revenue. We also believe that deteriorating macroeconomic conditions, particularly in China have impacted consumer demand for our GeForce gaming GPU products. In addition, sales of certain high-end GeForce gaming GPUs using our new Turing architecture that we released during fiscal year 2019 were lower than we expected for the launch of a new architecture

In dat geval, Radeon VII was duidelijk niet een GPU voor de retail gaming markt, dat was wel duidelijk vanaf het begin. Daarnaast is ook hier de GPU niet EOL, hooguit de Radeon VII, de GPU blijft gewoon gebruikt worden op de professionele markt, waar die ook voor bedoeld is.Sissors schreef op zaterdag 13 juli 2019 @ 10:43:

[...]

Ik denk dat hij de Radeon VII bedoelt. Maar die was sowieso DOA tbh, alleen wat die-hard fans hebben die gekocht.

[ Voor 18% gewijzigd door Verwijderd op 13-07-2019 11:15 ]

Precies. Ze kunnen heel dicht in de buurt komen met de 5700 XT qua performance (afhankelijk van het spel natuurlijk). Waarom zouden ze dan de Radeon VII verkopen een product waar voor die prijs nauwelijks marge op zit gok ik.Verwijderd schreef op zaterdag 13 juli 2019 @ 11:13:

[...]

In dat geval, Radeon VII was duidelijk niet een GPU voor de retail gaming markt, dat was wel duidelijk vanaf het begin. Daarnaast is ook hier de GPU niet EOL, hooguit de Radeon VII, de GPU blijft gewoon gebruikt worden op de professionele markt, waar die ook voor bedoeld is.

Voltage/Frequency Scaling Test Furmark 720p No AA Clock speed scaling @ 24,5-25C ambient:

Qua Voltage/Frequency scaling zie je dat de sweetspot rond de 900mv zit en de range zit zo tussen de 850-950mv daar onder en daar boven krijg je gewoon net wat minder MHz per mv terug. Als ik kijk naar de Resultaten met mijn Radeon VII kom ik ongeveer op hetzelfde uit die was tussen de 850-925 ook het meest efficient kan mogelijk te maken hebben met de eigenschappen van het TSMC 7nm process.750mv = 1370-T1460MHz 216FPS @ 202 Watt 84-92-96c @ 1549RPM crash at 1380-T1470MHz) - 1,8266MHz per mv

800mv = 1500-T1580MHz 234FPS @ 227 Watt 86-97-98c @ 1774RPM crash at 1510-T1585MHz) - 1,875MHz per mv

850mv = 1600-T1690MHz 250FPS @ 247 Watt 86-99-100c @ 2075RPM crash at 1605-T1695MHz) - 1,882MHz per mv

875mv = 1645-T1730MHz 254FPS @ 263 Watt 84-98-96c @ 2199RPM crash at 1655-T1740MHz) - 1,880MHz per mv

900mv = 1695-T1780MHz 261FPS @ 280 Watt 89-104-100c @ 2320RPM crash at 1710-T1790MHz) - 1.9MHz per mv

925mv = 1750-T1830MHz 267FPS @ 292 Watt 85-101-98c @ 2606RPM crash at 1760-T1840MHz) - 1.892MHz per mv

950mv = 1795-T1875MHz 272FPS @ 303 Watt 83-100-96c @ 2866RPM crash at 1800-T1885MHz) - 1.8895MHz per mv

975mv = 1820-T1900MHz 276FPS @ 324 Watt 85-104-96c @ 2930RPM crash at 1825-T1915MHz) - 1,866MHz per mv

1000mv = 1860-T1950MHz 277FPS @ 339 Watt 83-102-94c @ 3640RPM crash at 1880-T1980MHz) - 1.86MHz per mv

* 925+mv test @ 900MHz memory because of bandwith bottleneck

Stock 1590-1619-T2063MHz 247FPS 86-104-100c @ 937-950mv 297 watt 2320RPM

Ik krijg vanmiddag als het goed is een 2e 5700 XT 50th binnen. Ik ben benieuwd hoe die zicht onderling verhouden. Bij de RX 480 dat er behoorlijk wat verschil tussen de ene en de andere chip. Bij de Vega kaarten lag het wat dichter bij elkaar maar ook daar was verschil te zien.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ga je met de tijd een andere cooler op plaatsen? Deze beestjes smeken ervoorAstennu schreef op zaterdag 13 juli 2019 @ 13:17:

Ik heb eindelijk mijn tijd gehad om de Voltage/Frequency scaling te testen:

Voltage/Frequency Scaling Test Furmark 720p No AA Clock speed scaling @ 24,5-25C ambient:

[...]

Qua Voltage/Frequency scaling zie je dat de sweetspot rond de 900mv zit en de range zit zo tussen de 850-950mv daar onder en daar boven krijg je gewoon net wat minder MHz per mv terug. Als ik kijk naar de Resultaten met mijn Radeon VII kom ik ongeveer op hetzelfde uit die was tussen de 850-925 ook het meest efficient kan mogelijk te maken hebben met de eigenschappen van het TSMC 7nm process.

Ik krijg vanmiddag als het goed is een 2e 5700 XT 50th binnen. Ik ben benieuwd hoe die zicht onderling verhouden. Bij de RX 480 dat er behoorlijk wat verschil tussen de ene en de andere chip. Bij de Vega kaarten lag het wat dichter bij elkaar maar ook daar was verschil te zien.

Nah met low voltage is het niet nodig dan is de stock cooler stil genoeg.Esthar schreef op zaterdag 13 juli 2019 @ 13:43:

[...]

Ga je met de tijd een andere cooler op plaatsen? Deze beestjes smeken ervoor

Ik ben zelf gewoon fan van blowers. Ik vind de looks geweldig de warme lucht is ook meteen de kast uit. En mijn kast is heel compact dus die hitte wil ik er niet in hebben.

Beetje zonde om een 50th anni te kopen en dan die cooler er af te halen ^^

Ik maak gewoon een low voltage silent mode voor games die niet veel performance nodig hebben (bv SC2) en dan een voor games die wel meer performance willen hebben met de stock fan speeds. Als ik Apex aan het doen ben vind ik hem niet storend.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Undervolt is leuk; 30 tot 60w eraf schaven, maar ook dat is niet gegarandeerd. Mijn RX590 komt standaard op 1150mv. Gaming wise krijg ik 'm terug naar 1090mv en dat is watergekoeld / max temp op 60 graden met een verbruik van ruim 250W voor de GPU alleen (Furmark torture). Echter ga ik dingen zoals Radeon Record gebruiken, dan crashed het zaakje instant. Pas op 1110mv / 1400Mhz core clock 'werkt' het.

Je kunt AMD niet kwalijk nemen voor het bouwen van technologie dat het maximale uit de chip haalt. Zo verkopen ze gewoon meer high-end modellen en is het kopen van een midrange en deze in de buurt laten komen van een high-end model een stuk minder interessant. De FX's ga je ook niet meer terugzien, in de zin dat je een chip met 3.5Ghz base koopt en deze manueel even op 4.8 ~ 5.2Ghz laat draaien.

AMD verloor daardoor aanzienlijk sales op higher end modellen.

Ryzen =! aan Navi.Verwijderd schreef op zaterdag 13 juli 2019 @ 15:37:

Ik denk dat een andere koeler, qua performance op gebied van OC'en weinig (meer) zal uithalen. De frequency curve is door AMD zelf al 'zoveel mogelijk' benut, zoals je terug kunt zien in de Ryzens. Met zo'n auto boost / XFR dingetje op de GPU zal de GPU met in acht neming van workload, current en temperatuur zelf opschalen daar waar het kan en binnen de perken is. Een manueele OC zal weinig meer uit gaan halen.

Undervolt is leuk; 30 tot 60w eraf schaven, maar ook dat is niet gegarandeerd. Mijn RX590 komt standaard op 1150mhz. Gaming wise krijg ik 'm terug naar 1090mv en dat is watergekoeld / max temp op 60 graden met een verbruik van ruim 250W voor de GPU alleen (Furmark torture). Echter ga ik dingen zoals Radeon Record gebruiken, dan crashed het zaakje instant. Pas op 1110mv / 1400Mhz core clock 'werkt' het.

Je kunt AMD niet kwalijk nemen voor het bouwen van technologie dat het maximale uit de chip haalt. Zo verkopen ze gewoon meer high-end modellen en is het kopen van een midrange en deze in de buurt laten komen van een high-end model een stuk minder interessant. De FX's ga je ook niet meer terugzien, in de zin dat je een chip met 3.5Ghz base koopt en deze manueel even op 4.8 ~ 5.2Ghz laat draaien.

AMD verloor daardoor aanzienlijk sales op higher end modellen.

De cooler beperkt de chip aardig. Op H2O hebben ze 2100 MHz gehaald met Navi. Lukt mij misschien ook wel met de fan op max maar dat is niet werkbaar qua herrie.

Ik heb bij mijn RX480's (iets van 3-4 van getest) en Vega kaarten (waar ik er 10 van getest heb) er altijd veel af kunnen halen met een UV zonder prestaties in te leveren. Sterker nog mijn 56 had 64 prestaties maar met een 80 watt lager verbruik. Maar de ene chip is de andere inderdaad niet het verschilt per kaart.

De Ryzen Chips zijn veel beter afgesteld out of the box. Voor de niet overclocker super maar voor ons tweakers heel saai. Er is daar weinig winst te behalen vooral bij Ryzen 3000.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Volgens een developer: "on AMD and Intel Vulkan is a lot faster."

De 2e kaart is ook binnen en getest:Astennu schreef op zaterdag 13 juli 2019 @ 13:17:

Ik heb eindelijk mijn tijd gehad om de Voltage/Frequency scaling te testen:

Voltage/Frequency Scaling Test Furmark 720p No AA Clock speed scaling @ 24,5-25C ambient:

[...]

Qua Voltage/Frequency scaling zie je dat de sweetspot rond de 900mv zit en de range zit zo tussen de 850-950mv daar onder en daar boven krijg je gewoon net wat minder MHz per mv terug. Als ik kijk naar de Resultaten met mijn Radeon VII kom ik ongeveer op hetzelfde uit die was tussen de 850-925 ook het meest efficient kan mogelijk te maken hebben met de eigenschappen van het TSMC 7nm process.

Ik krijg vanmiddag als het goed is een 2e 5700 XT 50th binnen. Ik ben benieuwd hoe die zicht onderling verhouden. Bij de RX 480 dat er behoorlijk wat verschil tussen de ene en de andere chip. Bij de Vega kaarten lag het wat dichter bij elkaar maar ook daar was verschil te zien.

Het verschil is ongeveer 50MHz temps van deze kaart zijn een stukje lager en daardoor zijn de clocks wat constanter. Verbruik zit niet ver uit elkaar dus denk dat de cooler beter contact maakt misschien is de base plate van deze cooler wat beter.Card Nr2

Furmark 720p No AA Clock speed scaling @ 24,5-25C ambient:

750mv = 1331-1365-T1420MHz 213FPS @ 102-115/199 Watt 87-93-98c @ 1397RPM crash at 1380-T1430MHz) - 1,820MHz per mv

800mv = 1456-1480-T1550MHz 230FPS @ 122-134/219 Watt 83-91-94c @ 1862RPM crash at 1494-T1560MHz) - 1,850MHz per mv

850mv = 1574-1584-T1645MHz 247FPS @ 138-154/244 Watt 84-95-96c @ 2075RPM crash at 1591-T1650MHz) - 1,863MHz per mv

875mv = 1597-1642-T1715MHz 253FPS @ 146-165/256 Watt 83-95-94c @ 2288RPM crash at 1655-T1720MHz) - 1,876MHz per mv

900mv = 1678-1690-T1740MHz 259FPS @ 155-175/273 Watt 86-101-98c @ 2292RPM crash at 1700-T1760MHz) - 1.877MHz per mv

925mv = 1695-1718-T1780MHz 265FPS @ 168-185/285 Watt 83-98-94c @ 2606RPM crash at 1720-T1790MHz) - 1.857MHz per mv

950mv = 1753-1766-T1830MHz 270FPS @ 177-192/301 Watt 83-100-92c @ 2876RPM crash at 1772-T1840MHz) - 1.859MHz per mv

975mv = 1775-1803-T1830MHz 273FPS @ 185-211/317 Watt 83-102-94c @ 2949RPM crash at 1814-T1870MHz) - 1,849MHz per mv

1000mv = 1796-1834-T1910MHz 277FPS @ 195-225/334 Watt 83-103-94c @ 3349RPM crash at 1851-T1920MHz) - 1.834MHz per mv

*800+mv test @ 900MHz memory because of bandwith bottleneck

Stock-2 1650-1665-T2063MHz 256FPS 89-107-98c @ 956-975mv 300 watt 2275RPM

Memory wil bij deze kaart ook niet lekker boven de 900MHz (920MHz gaat ook niet lekker)

Ik hoop dat het toch iets met de drivers te maken heeft want nVidia kaarten kunnen wel heel goed overclocken qua memory. En als je naar de reviews kijkt en naar mijn eigen resultaten doen de Navi kaarten dat tot nu toe helemaal niet.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik merk alleen dat mijn gpu usage met anti-lag "aan" niet op 99% staat maar dat dit vaak terugzakt.

Dit komt door de anti-lag setting.

Hebben jullie hier dezelfde ervaringen mee en/of een oplossing daarvoor?

Of hoort het gewoon bij de techniek van de anti-lag setting?

Overigens vind ik de anti-lag functie meer waard dan dat mijn gpu niet volledig gebruikt wordt (en misschien daardoor lagere fps).

[ Voor 3% gewijzigd door HugoBoss1985 op 14-07-2019 13:10 ]

Dat hoort bij hoe het werkt. Je zult waarschijnlijk een paar frames per seconde "missen", echter zullen dat ook juist de frames zijn die toch niet nuttig waren. Hangt af van hoe je speelt; zonder VSync zouden dat de frames zijn die tearing veroorzaken, met VSync zouden ze gedropt zijn.HugoBoss1985 schreef op zondag 14 juli 2019 @ 13:02:

De nieuw "anti-lag" functie is echt een enorme verbetering in input lag.

Ik merk alleen dat mijn gpu usage met anti-lag "aan" niet op 99% staat maar dat dit vaak terugzakt.

Dit komt door de input lag setting.

Hebben jullie hier dezelfde ervaringen mee en/of een oplossing daarvoor?

Of hoort het gewoon de techniek van de anti-lag?

Ik vind de anti-lag functie meer waard dan dat mijn gpu niet volledig gebruikt wordt (en misschien daardoor lagere fps).

Daarnaast is "GPU usage" een foute benaming. Wat er gemeten wordt is eerder iets van "busy time" of iets in die trant, niet daadwerkelijk gebruik van alle delen van de GPU. Vandaar dus dat dat zakt, omdat er nu kleine pauzes zijn.

Het is inderdaad vergelijkbaar met de symptomen van een cpu bottleneck!Sissors schreef op zondag 14 juli 2019 @ 13:12:

Lijkt mij kloppend dat dat gebeurd. Mat anti-lag aan gaat je GPU op je CPU zitten wachten, waardoor hij dan dus niks aan het doen is. En daardoor worden je framerates slechter en instabieler normaal gesproken, ben dus benieuwd wat die doen. Voordeel is dan inderdaad iets minder input lag, iets waar ik zelf nog nooit last van heb gehad, maar goed.

Ik heb er niet echt last van gehad totdat ik de anti-lag aanzette en het verschil merkte.

Maarja dat had ik ook met een upgrade van een 75hz freesync naar een 144hz freesync monitor

Je weet niet wat je mist zegmaar.

Ik begrijp niet hoe die frames niet nuttig kunnen zijn aangezien ik nog ruim onder de 141 fps limiet blijf en dus niet alles uit mijn 144hz scherm haal.Werelds schreef op zondag 14 juli 2019 @ 13:14:

[...]

Dat hoort bij hoe het werkt. Je zult waarschijnlijk een paar frames per seconde "missen", echter zullen dat ook juist de frames zijn die toch niet nuttig waren. Hangt af van hoe je speelt; zonder VSync zouden dat de frames zijn die tearing veroorzaken, met VSync zouden ze gedropt zijn.

Daarnaast is "GPU usage" een foute benaming. Wat er gemeten wordt is eerder iets van "busy time" of iets in die trant, niet daadwerkelijk gebruik van alle delen van de GPU. Vandaar dus dat dat zakt, omdat er nu kleine pauzes zijn.

Met de bewuste game (Hunt: Showdown).

Ik speel zonder Vsync (Vsync setting in driver "altijd uit" en ingame ook geen Vsync of frame limiter) en met Freesync en max fps op 141 in de driver.

Ik zei "gpu usage" omdat de AMD monitoring overlay het ook zo noemt... ik ken ook geen andere benaming daarvoor.

En ik was ook niet bewust van het bestaan van een andere term daarvoor.

[ Voor 44% gewijzigd door HugoBoss1985 op 14-07-2019 13:43 ]

Die is er helaas ook niet. De term is inmiddels dusdanig ingeburgerd dat hij overal wordt gebruikt, maar vanaf het moment dat we met unified shaders werken is deze wat mij betreft al niet meer toereikendHugoBoss1985 schreef op zondag 14 juli 2019 @ 13:40:

Ik zei "gpu usage" omdat de AMD monitoring overlay het ook zo noemt... ik ken ook geen andere benaming daarvoor.

En ik was ook niet bewust van het bestaan van een andere term daarvoor.

100% GPU usage is gewoon onmogelijk. Zelfs 99%. Dat zou betekenen dat alle ROP's, alle TMU's, alle SP's, alle geometry engines, (voeg hier nog maar een hoop dingen in) behalve 1 enkel onderdeeltje in gebruik zouden zijn. Dat gebeurt in de praktijk niet en is in sommige architecturen zelfs letterlijk onmogelijk

Mijn punt is echter dat je niet zo zeer moet "schrikken" van een drop in GPU usage. Dat zegt helemaal niets. Sterker nog, als je met 90% GPU usage 135 FPS zou halen en met 99% 139, dan is die 135 bijna 100% zeker een stuk vloeiender voor het oog.

Vergeet ook niet dat "FPS" niet veel zegt. Frametimes zijn veel belangrijker.

De term in de overlay is trouwens "GPU UTIL" (foutje van mij), maar inderdaad is GPU Usage de term die meestal gebruikt wordt.Werelds schreef op zondag 14 juli 2019 @ 13:54:

[...]

Die is er helaas ook niet. De term is inmiddels dusdanig ingeburgerd dat hij overal wordt gebruikt, maar vanaf het moment dat we met unified shaders werken is deze wat mij betreft al niet meer toereikend

100% GPU usage is gewoon onmogelijk. Zelfs 99%. Dat zou betekenen dat alle ROP's, alle TMU's, alle SP's, alle geometry engines, (voeg hier nog maar een hoop dingen in) behalve 1 enkel onderdeeltje in gebruik zouden zijn. Dat gebeurt in de praktijk niet en is in sommige architecturen zelfs letterlijk onmogelijk

Mijn punt is echter dat je niet zo zeer moet "schrikken" van een drop in GPU usage. Dat zegt helemaal niets. Sterker nog, als je met 90% GPU usage 135 FPS zou halen en met 99% 139, dan is die 135 bijna 100% zeker een stuk vloeiender voor het oog.

Vergeet ook niet dat "FPS" niet veel zegt. Frametimes zijn veel belangrijker.

Toch is mijn ervaring dat MSI Afterburner, GPU-Z en de AMD overlay een gpu usage / gpu util / etc van zo'n 99% aangeven wanneer er geen (cpu) bottleneck is.

Dus ik bedoel alleen maar dat ik die info gewend ben van videokaart (gpu daarvan) monitoring software.

Edit: wanneer er duidelijk een cpu bottleneck is; wanneer FPS niet gecapped worden door een fps limiet of vsync.

Frametimes zijn inderdaad belangrijker, ik heb ook liever een hogere minimum fps met goede frametimes dan een hoger maximum.

Framedrops onder de 60 fps vind ik vervelender dan een verschil tussen 135 fps en 139 fps

Ik zal eens verder kijken, volgens mij zijn mijn CPU frametimes hoger (slechter) wanneer ik anti-lag inschakel.

[ Voor 3% gewijzigd door HugoBoss1985 op 14-07-2019 14:16 ]

[ Voor 103% gewijzigd door HugoBoss1985 op 14-07-2019 14:10 ]

Mja dat is normaal want de GPU gaat dan wachten tot de CPU er klaar voor is en andersom alles wordt in sync gebracht om de latency zo laag mogelijk te maken. Dus het klopt dat je FPS dan lager kan zijn maar je latency is beter. En dat is waar het uiteindelijk om gaat toch?HugoBoss1985 schreef op zondag 14 juli 2019 @ 13:02:

De nieuw "anti-lag" functie is echt een enorme verbetering in input lag.

Ik merk alleen dat mijn gpu usage met anti-lag "aan" niet op 99% staat maar dat dit vaak terugzakt.

Dit komt door de anti-lag setting.

Hebben jullie hier dezelfde ervaringen mee en/of een oplossing daarvoor?

Of hoort het gewoon bij de techniek van de anti-lag setting?

Overigens vind ik de anti-lag functie meer waard dan dat mijn gpu niet volledig gebruikt wordt (en misschien daardoor lagere fps).

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Het vermoeden heb ik wel. De GPU verteld dan aan zowel je monitor als aan de CPU op wat voor snelheid ze moeten lopen. De GPU is in het hele geheel als ware de dirigent drummer, die het ritme aangeeft.

---

Een andere vraag en ik ben vooral benieuwd wat jij hiervan zegt @DaniëlWW2. Ik kijk nu op mindfactory en de Vega's worden voor 250 (56) en 350 euro (64) verkocht. Op deze kaarten zit 8 GB HBM2 geheugen. Kunnen we voor de 5800(XT) hopelijk de terugkomst van HMB2 geheugen krijgen? Dat scheelt toch snel tientallen wattage als we uitgaan van 12GB vram.

[ Voor 111% gewijzigd door Maulwurfje op 14-07-2019 16:20 ]

Potentieel zou het kunnen. RDNA lijkt snel genoeg om de hele Turing lijn aan te kunnen. Ga je alleen voor een RTX2080Ti concurrent, dan zou de enkele tientallen watts die je met HBM2 bespaart, gestoken kunnen worden in meer core clockspeed waardoor je chip kan zijn. Ik zou alleen eerder denken dat een potentiële RX5900 series, uitgerust zou worden met 16GB HBM2. Ik denk dat een speculatieve RX5800 series eerder met een 384bit bus en 12GB GDDR6 zal zijn.Maulwurfje schreef op zondag 14 juli 2019 @ 15:36:

Een andere vraag en ik ben vooral benieuwd wat jij hiervan zegt @DaniëlWW2. Ik kijk nu op mindfactory en de Vega's worden voor 250 (56) en 350 euro (64) verkocht. Op deze kaarten zit 8 GB HBM2 geheugen. Kunnen we voor de 5800(XT) hopelijk de terugkomst van HMB2 geheugen krijgen? Dat scheelt toch snel tientallen wattage als we uitgaan van 12GB vram.

Ik zou "utalisation" eerder nemen als een waarde die aangeeft of alle rekenclusters op een GPU, daadwerkelijk iets doen. Ik weet niet eens of dat helemaal klopt, maar dat lijkt een iets betere verklaring. Verder geeft het eigenlijk weinig relevants aan. Ik gebruik het vooral om te zien waar mijn Vega echt moeite heeft. Dan bedoel ik dibs onder de 90%.HugoBoss1985 schreef op zondag 14 juli 2019 @ 14:07:

[...]

De term in de overlay is trouwens "GPU UTIL" (foutje van mij), maar inderdaad is GPU Usage de term die meestal gebruikt wordt.

Toch is mijn ervaring dat MSI Afterburner, GPU-Z en de AMD overlay een gpu usage / gpu util / etc van zo'n 99% aangeven wanneer er geen (cpu) bottleneck is.

Dus ik bedoel alleen maar dat ik die info gewend ben van videokaart (gpu daarvan) monitoring software.

Edit: wanneer er duidelijk een cpu bottleneck is; wanneer FPS niet gecapped worden door een fps limiet of vsync.

Frametimes zijn inderdaad belangrijker, ik heb ook liever een hogere minimum fps met goede frametimes dan een hoger maximum.

Framedrops onder de 60 fps vind ik vervelender dan een verschil tussen 135 fps en 139 fps

Ik zal eens verder kijken, volgens mij zijn mijn CPU frametimes hoger (slechter) wanneer ik anti-lag inschakel.

Er bestaan zoals @Werelds terecht opmerkt, genoeg architecturen die ware 100% utilisatie botweg niet eens kunnen. GCN kon het bijvoorbeeld niet, Turing kan het ook niet. RDNA zou in theorie dichtbij kunnen komen, maar dan is het nog de vraag hoe je precies de workloads gaat verdelen. Nogal een uitdaging is dat.

Neem een RX5700XT op 1800MHz. Je hebt 2560 Streaming Processoren op die chip zitten. RDNA SP's doen berekeningen in een cycle en krijgen elke cycle een nieuwe set berekeningen. Die moeten met een clockspeed van 1800MHz dus 1800 keer per seconde worden voorzien van een rekenopdracht. Dat zijn dus 4.608.000 berekeningen per seconde. Deze worden verdeeld in groepen (wavefronts) van 64 threads als RDNA backwards compatibility instructies van GCN krijgt, of 32 threads als specifieke RDNA instructies worden gebruikt.

De instructies in deze wavefronts worden ook nog eens ingedeeld aan de hand van het object dat je in de frame wil renderen. De kans dat alle getallen werkelijk kloppen en je elke keer groepen van 64 of 32 kan maken en je dus echt 100% haalt, is statistisch gezien vrijwel onmogelijk. Dat is dan voor een van de 1800 maal per seconde. Je zal constant wavefronts hebben die niet uit de volledige 64 of 32 threads bestaan. Dat is ook niet erg, zo lang je maar in de buurt komt.

GCN had daar nu juist veel moeite mee in veel games omdat GCN veel complexer was. GCN had namelijk altijd wavefronts van 64 en verdeelde deze in vier blokken van maximaal 16. Deze blokken van 16 werden een per clockcycle verdeeld binnen een CU. In totaal duurde het uitrekenen van maximaal 64 threads, 5 cycles. Had je minder dan 64 threads, dan duurde het nog steeds vijf cycles. Een RDNA CU doet diezelfde 64 threads in een cycle.

Zijn we er niet want er zijn in RDNA ook nog special function units die eens per vier clockcycles iets doen. Ook doen de SP's van RDNA, compute berekeningen voor bijvoorbeeld physics effecten. Komen er voor een clockcycle, te veel compute berekeningen, dan zullen niet alle ROP's genoeg instructies hebben gekregen om de 3D objecten te renderen. Zo haal je alsnog geen 100%. Laat compute nu eigenlijk steeds belangrijker worden voor GPU's.

Dit was in ieder geval GCN met vier maal zestien. RDNA heeft twee blokken (SIMD) van 32 die parallel kunnen functioneren, GCN kon per cycle, maar een van de vier SIMD's van instructies voorzien.

PS: Ik hoop dat je het nog snapt. Ik had zelf ook even nodig voordat ik het begreep.

[ Voor 69% gewijzigd door DaniëlWW2 op 14-07-2019 19:17 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Gigabyte Aorus X570 Master / AMD Ryzen 9 5900X / G.Skill Trident Z 4000@3800 32GB / PowerColor Red Devil Radeon RX 7900 XTX 24GB | Tesla M3 LR '21

Ik ben lui.

Temperaturen en behaalde boostclock?

Ik ben namelijk steeds meer informatie bij elkaar aan het schrapen. Ik begin te vermoeden dat 2000MHz werkelijk mogelijk is op veel chips, als ze maar koel blijven, zonder gedoe met powerlimieten.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

© ocf81 1981-infinity

Live the dream! | Politiek Incorrecte Klootzak uitgerust met The Drive to Survive

Bestrijd de plaag die woke heet! | Servitisatie plaveit de weg naar slavernij. Kies je eigen weg!

[ Voor 17% gewijzigd door Olaf van der Spek op 15-07-2019 12:08 ]

Ik geloof dat ik iets aan verwijzingen naar navi 14 in linux code voorbij heb zien komen, en wat speculatie dat dat een 20CU kaart zou zijn a ~1800 mhz, pakweg 120w of zo?Olaf van der Spek schreef op maandag 15 juli 2019 @ 12:07:

Is er al iets bekend over lower end / minder prijzige Navi's?

Voor mij is dat nog iets te snel/hongerig, als ik 120w OK zou vinden kan ik ook prima een 570 tweaken.

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

https://www.pcgamer.com/s...mds-radeon-rx-5700-cards/

Gegarandeerde support, en in tegenstelling tot de Raijintek nog fans meegeleverd ook (goed, wil je tijdens gamen absolute stilte dan zal je er noctua's op moeten schroeven).

Blij mee want ik zit met een maximum lengte van 315mm in de fractal design define c case

EDIT:

De totale lengte is moeilijk te vinden. Ik heb Arctic maar even gemaild

[ Voor 9% gewijzigd door Nox op 15-07-2019 23:10 ]

Overlever van KampeerMeet 4.1

"Als David Attenborough een film van jou zou moeten maken zou hij het moeilijk krijgen." - TDW

Poeh, wel even ~90 euro extra kosten, tenzij je voor de lagere modelletjes gaat. Voor dat soort bedragen zou ik toch even wachten op de AIB kaartjes.Nox schreef op maandag 15 juli 2019 @ 22:38:

In het kader van AIB's die lang duren en custom koeling:

https://www.pcgamer.com/s...mds-radeon-rx-5700-cards/

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Hoe kom je aan die 90 euro? Een extreme IV is 55-60 euro. Een twin turbo 3 is 40-45 eurovectormatic schreef op dinsdag 16 juli 2019 @ 08:11:

[...]

Poeh, wel even ~90 euro extra kosten, tenzij je voor de lagere modelletjes gaat. Voor dat soort bedragen zou ik toch even wachten op de AIB kaartjes.

Overlever van KampeerMeet 4.1

"Als David Attenborough een film van jou zou moeten maken zou hij het moeilijk krijgen." - TDW

Valt mee, in de pricewatch staan veel van die modellen voor 50 eu of mindervectormatic schreef op dinsdag 16 juli 2019 @ 08:11:

[...]

Poeh, wel even ~90 euro extra kosten, tenzij je voor de lagere modelletjes gaat. Voor dat soort bedragen zou ik toch even wachten op de AIB kaartjes.

Dat zijn de prijzen op de website van arctic, had even verzuimd om in de pricewatch te kijken (had ook niet verwacht dat het zoveel zou schelen)Nox schreef op dinsdag 16 juli 2019 @ 09:59:

[...]

Hoe kom je aan die 90 euro? Een extreme IV is 55-60 euro. Een twin turbo 3 is 40-45 euro

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Ha, ja dat verbaasde mij ook.vectormatic schreef op dinsdag 16 juli 2019 @ 11:40:

[...]

Dat zijn de prijzen op de website van arctic, had even verzuimd om in de pricewatch te kijken (had ook niet verwacht dat het zoveel zou schelen)

Overlever van KampeerMeet 4.1

"Als David Attenborough een film van jou zou moeten maken zou hij het moeilijk krijgen." - TDW

[Twitter: https://twitter.com/KOMACHI_ENSAKA/status/1151112093631799296]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Is dat een dual chip kaart dan?DaniëlWW2 schreef op dinsdag 16 juli 2019 @ 20:16:

Nieuws dan. Arcturus lijkt een 128CU, Vega te zijn voor machine learning. Het is ook geen Vega 10 of Vega 20, nieuwe chip.

[Twitter]

Het lijkt een chip te zijn. Deze ga je alleen niet terugzien als gaming chip.

Wel goed om te zien dat AMD kennelijk zo'n monster kan maken. Deze zal makkelijk over de 600mm2 gaan op 7nm.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Kunnen het ook geen kleinere CU's zijn ?DaniëlWW2 schreef op dinsdag 16 juli 2019 @ 20:33:

[...]

Het lijkt een chip te zijn. Deze ga je alleen niet terugzien als gaming chip.

Wel goed om te zien dat AMD kennelijk zo'n monster kan maken. Deze zal makkelijk over de 600mm2 gaan op 7nm.

Het zou een Vega zijn. 64SP's per CU. Verder is het een ML kaart. Waarschijnlijk zijn die SP's eerder groter dan kleiner dan die van RDNA. Ze moeten potentieel nog meer soorten berekeningen kunnen.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Dat zou nog kunnen ja. Maak er een dedicated accelerator van en sloopt bijna alle grafische functies eruit als overbodig.madmaxnl schreef op woensdag 17 juli 2019 @ 05:44:

Zou goed kunnen, maar er zijn ook genoeg features die ze weg kunnen laten, zoals TrueAudio, Tesselation, VCE, DCC en nog wel een aantal.

Wachten. Alle RX5700's zijn op het moment identiek buiten de stikker om. Kan het geluid je niks schelen, dan kan je er nu eentje kopen. Je kan ook altijd undervolten. Ik zelf zit ook te wachten.DeBers schreef op woensdag 17 juli 2019 @ 16:25:

Ik wil gaan upgraden naar de nieuwe 5700 series die uit zijn gekomen. RX 5700 om precies te zijn. Wat is de beste timing? Moet ik nog eve wachten tot er meer partner GPUs op de markt zijn of is de saphire versie die nu te koop is al een hele goeie?

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Hoe lang moet ik dan wachten?DaniëlWW2 schreef op woensdag 17 juli 2019 @ 16:56:

[...]

Dat zou nog kunnen ja. Maak er een dedicated accelerator van en sloopt bijna alle grafische functies eruit als overbodig.

[...]

Wachten. Alle RX5700's zijn op het moment identiek buiten de stikker om. Kan het geluid je niks schelen, dan kan je er nu eentje kopen. Je kan ook altijd undervolten. Ik zelf zit ook te wachten.

Ik heb zojuist mijn huidige videokaart verkocht

Ongeveer een maand. Maar dit hoort hier niet maar: AMD Navi Ervaringen TopicDeBers schreef op woensdag 17 juli 2019 @ 17:10:

[...]

Hoe lang moet ik dan wachten?

Ik heb zojuist mijn huidige videokaart verkocht

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ekwb brengt 25-07 een full cover blok uit voor de 5700(XT) voor de open loop gebruikers.DaniëlWW2 schreef op woensdag 17 juli 2019 @ 16:56:

Wachten. Alle RX5700's zijn op het moment identiek buiten de stikker om. Kan het geluid je niks schelen, dan kan je er nu eentje kopen. Je kan ook altijd undervolten. Ik zelf zit ook te wachten.

AMD Ryzen 5800X,BeQuiet Darkrock Pro4, Asus B550-E ROG Strix, AMD 6800XT, 32Gb G.Skill TridentZ 3600MHz, Seasonic Focus Plus Gold 850W, Kingston KC3000 1 TB, Samsung Evo 960 500Gb, Samsung Evo 850 1Tb / Samsung 860 Evo 1 Tb, be quiet! Light Base 600 LX

-24CU

-Max 1900MHz

-Lijkt 4GB VRAM te hebben

[Twitter: https://twitter.com/KOMACHI_ENSAKA/status/1149727775240019968]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik heb hoopNitroX infinity schreef op maandag 27 mei 2019 @ 21:52:

https://www.reddit.com/r/...navi_pcb_that_was_leaked/

[...]

Nog wat speculaas van mijn kant;

Met 25% betere ipc en waarschijnlijk ook zo'n 25% hogere kloksnelheden, denk ik dat de 75W kaart een gpu gaat hebben met zo'n 1536 shaders om rond het niveau van de RX 580 te zitten. En ik denk dat die zo rond dezelfde oppervlakte als de RX 560 zal zitten (~120mm²)

Graphene; a material that can do everything, except leave the lab. - Asianometry

Nu je het zegt, ik denk dat je echt een punt hebt en het gewoon echt kan.

Ik heb nu redelijk wat gemodde Navi 10 resultaten gezien en elke keer merk ik op dat onder de 70c, die chips echt gaan presteren. Thermal density lijkt ook heel anders aangepakt te zijn door de RTG. Waar het Zen 2 team laat zien dat ze echt een server chiplet hebben gemaakt die toevallig nog redelijk clockt, lijkt de RTG meer haar best te hebben gedaan om voor maximale clockspeeds te gaan. Je moet alleen wel de temperatuur onder controle krijgen.

Ga je eenmaal onder die 70c voor de RX5700XT, dan lijkt 2000MHz met stock voltages (210 a 220W) of 1850MHz+ met 1000mv (170 a 180W), geen uitzondering. Ga je dan kijken naar een chip die ongeveer twee derde formaat is, en offer je wat clockspeed op, dan zou 75W max gewoon kunnen op een 24CU chip. Met 1800MHz en 24CU's zou je zelfs met GCN, al rond de RX580 moeten zitten, uitgaande van vrij lineaire schaling. Nu is RDNA een stuk sneller per clock, waardoor je de RX580 waarschijnlijk al rond 1600Mhz, misschien iets meer zou moeten kunnen matchen met 24CU's, wederom uitgaande van lineaire schaling. Het laatste beetje vermogen haal je uit 4GB i.p.v 8GB VRAM.

Nu hopen dat een dergelijke kaart er ook echt gaat komen. Dat zou nog eens een 75W model zijn, zelfs als de RX580 niet helemaal gematched word, niet die waardeloze GTX1650...

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

[ Voor 31% gewijzigd door Ridge op 18-07-2019 09:34 ]

www.tradealliance.nl

2100mhz, onder de 100 graden met stock cooler. Gewoon insane hoeveel marge erop zit.DaniëlWW2 schreef op maandag 15 juli 2019 @ 09:54:

[...]

Ik ben lui.

Temperaturen en behaalde boostclock?

Ik ben namelijk steeds meer informatie bij elkaar aan het schrapen. Ik begin te vermoeden dat 2000MHz werkelijk mogelijk is op veel chips, als ze maar koel blijven, zonder gedoe met powerlimieten.

Excuus dat ik zo laat reageer, was vanwege werk er even een aantal dagen niet

Gigabyte Aorus X570 Master / AMD Ryzen 9 5900X / G.Skill Trident Z 4000@3800 32GB / PowerColor Red Devil Radeon RX 7900 XTX 24GB | Tesla M3 LR '21

Wow. Jouw chip lijkt dan behoorlijk wat te tolereren qua temperatuur.Xadeon schreef op vrijdag 19 juli 2019 @ 00:44:

[...]

2100mhz, onder de 100 graden met stock cooler. Gewoon insane hoeveel marge erop zit.

offtopic:

Excuus dat ik zo laat reageer, was vanwege werk er even een aantal dagen niet

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Power limit +20% boost 2000 MHz+

Fan 50% max temp 91c

Ik ben toch vrij pessimistisch over de 75w, 24CUs is 60% van de 5700XT, als je dat even lineair schaalt kom je op een TBP van 135w uit, clock speeds zitten ook zodanig in het zelfde vlak dat dat niet heel veel verschil gaat maken. Dan zou AMD die "5600XT" zodanig kwa voltage moeten gaan tweaken dat je op ~135w nog een goeie 60w kwijt raakt...DaniëlWW2 schreef op woensdag 17 juli 2019 @ 22:15:

[...]

Nu je het zegt, ik denk dat je echt een punt hebt en het gewoon echt kan.

Ik heb nu redelijk wat gemodde Navi 10 resultaten gezien en elke keer merk ik op dat onder de 70c, die chips echt gaan presteren. Thermal density lijkt ook heel anders aangepakt te zijn door de RTG. Waar het Zen 2 team laat zien dat ze echt een server chiplet hebben gemaakt die toevallig nog redelijk clockt, lijkt de RTG meer haar best te hebben gedaan om voor maximale clockspeeds te gaan. Je moet alleen wel de temperatuur onder controle krijgen.

Ga je eenmaal onder die 70c voor de RX5700XT, dan lijkt 2000MHz met stock voltages (210 a 220W) of 1850MHz+ met 1000mv (170 a 180W), geen uitzondering. Ga je dan kijken naar een chip die ongeveer twee derde formaat is, en offer je wat clockspeed op, dan zou 75W max gewoon kunnen op een 24CU chip. Met 1800MHz en 24CU's zou je zelfs met GCN, al rond de RX580 moeten zitten, uitgaande van vrij lineaire schaling. Nu is RDNA een stuk sneller per clock, waardoor je de RX580 waarschijnlijk al rond 1600Mhz, misschien iets meer zou moeten kunnen matchen met 24CU's, wederom uitgaande van lineaire schaling. Het laatste beetje vermogen haal je uit 4GB i.p.v 8GB VRAM.

Nu hopen dat een dergelijke kaart er ook echt gaat komen. Dat zou nog eens een 75W model zijn, zelfs als de RX580 niet helemaal gematched word, niet die waardeloze GTX1650...

Ik zie ze zon ding best op ~100-110w krijgen, de RX560 had uiteindelijk ook minder millivoltjes dan een RX570 nodig, want een paar honderd MHz lager, maar ik zie ze echt geen 60w goedmaken, zeker niet met AMDs voltage strategie...

Als ik nu enige haast zou hebben met een nieuwe GPU zou ik ook gewoon mijn 560 vervangen door een 570, en die netjes undervolten ipv gaan wachten op navi, drivers voor polaris zijn as good as it gets, en hoewel navi natuurlijk ook te undervolten/tweaken is, is op het RX570 niveau het absolute verschil kwa opgenomen vermogen ook niet super dramatisch meer na een beetje tweaken. Daarnaast verwacht ik niet dat als AMD met een 5600 komt, deze kwa prijs een beetje tof is, dan is een RX570 nu een betere deal.

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Volgens mij waren al die modded dus met registery edits (vrijspelen van voltages e.d) en custom water cooling. Als je alleen al het laaste pakt kwa prijs, kan je al beter een 2080 halen lijkt mij.DaniëlWW2 schreef op woensdag 17 juli 2019 @ 22:15:

[...]

Nu je het zegt, ik denk dat je echt een punt hebt en het gewoon echt kan.

Ik heb nu redelijk wat gemodde Navi 10 resultaten gezien en elke keer merk ik op dat onder de 70c, die chips echt gaan presteren. Thermal density lijkt ook heel anders aangepakt te zijn door de RTG. Waar het Zen 2 team laat zien dat ze echt een server chiplet hebben gemaakt die toevallig nog redelijk clockt, lijkt de RTG meer haar best te hebben gedaan om voor maximale clockspeeds te gaan. Je moet alleen wel de temperatuur onder controle krijgen.

Ga je eenmaal onder die 70c voor de RX5700XT, dan lijkt 2000MHz met stock voltages (210 a 220W) of 1850MHz+ met 1000mv (170 a 180W), geen uitzondering. Ga je dan kijken naar een chip die ongeveer twee derde formaat is, en offer je wat clockspeed op, dan zou 75W max gewoon kunnen op een 24CU chip. Met 1800MHz en 24CU's zou je zelfs met GCN, al rond de RX580 moeten zitten, uitgaande van vrij lineaire schaling. Nu is RDNA een stuk sneller per clock, waardoor je de RX580 waarschijnlijk al rond 1600Mhz, misschien iets meer zou moeten kunnen matchen met 24CU's, wederom uitgaande van lineaire schaling. Het laatste beetje vermogen haal je uit 4GB i.p.v 8GB VRAM.

Nu hopen dat een dergelijke kaart er ook echt gaat komen. Dat zou nog eens een 75W model zijn, zelfs als de RX580 niet helemaal gematched word, niet die waardeloze GTX1650...

24CU's in 75W betekent gewoon dat de klokfrequentie heel flink omlaag moet, zo laag dat het voor AMD niet interessant is omdat hierdoor de verkoopprijs ook flink omlaag moet. Een realistisch verbruik is iets van 120W en dan ga je al uit van een klokfrequentie van een RX5700. Als je de klokfrequenties van de RX 5700 XT pakt kom je zelf uit op zo'n 140W. De performance per watt moet dus 100% beter zijn dan een RX 5700 XT, om 24 CU's binnen de 75W te krijgen, dat is gewoon totaal onrealistisch als je bedenkt dat het om dezelfde architectuur gaat en hetzelfde productieproces.DaniëlWW2 schreef op woensdag 17 juli 2019 @ 22:15:

[...]

Nu je het zegt, ik denk dat je echt een punt hebt en het gewoon echt kan.

Ik heb nu redelijk wat gemodde Navi 10 resultaten gezien en elke keer merk ik op dat onder de 70c, die chips echt gaan presteren. Thermal density lijkt ook heel anders aangepakt te zijn door de RTG. Waar het Zen 2 team laat zien dat ze echt een server chiplet hebben gemaakt die toevallig nog redelijk clockt, lijkt de RTG meer haar best te hebben gedaan om voor maximale clockspeeds te gaan. Je moet alleen wel de temperatuur onder controle krijgen.

Ga je eenmaal onder die 70c voor de RX5700XT, dan lijkt 2000MHz met stock voltages (210 a 220W) of 1850MHz+ met 1000mv (170 a 180W), geen uitzondering. Ga je dan kijken naar een chip die ongeveer twee derde formaat is, en offer je wat clockspeed op, dan zou 75W max gewoon kunnen op een 24CU chip. Met 1800MHz en 24CU's zou je zelfs met GCN, al rond de RX580 moeten zitten, uitgaande van vrij lineaire schaling. Nu is RDNA een stuk sneller per clock, waardoor je de RX580 waarschijnlijk al rond 1600Mhz, misschien iets meer zou moeten kunnen matchen met 24CU's, wederom uitgaande van lineaire schaling. Het laatste beetje vermogen haal je uit 4GB i.p.v 8GB VRAM.

Nu hopen dat een dergelijke kaart er ook echt gaat komen. Dat zou nog eens een 75W model zijn, zelfs als de RX580 niet helemaal gematched word, niet die waardeloze GTX1650...

Ik heb even een vergelijkingstabel aangemaakt op HWI. Hierin zie je prestaties van alle Navi en Polaris kaarten. Ik ga van 1080p ultra uit.Verwijderd schreef op vrijdag 19 juli 2019 @ 11:09:

[...]

24CU's in 75W betekent gewoon dat de klokfrequentie heel flink omlaag moet, zo laag dat het voor AMD niet interessant is omdat hierdoor de verkoopprijs ook flink omlaag moet. Een realistisch verbruik is iets van 120W en dan ga je al uit van een klokfrequentie van een RX5700. Als je de klokfrequenties van de RX 5700 XT pakt kom je zelf uit op zo'n 140W. De performance per watt moet dus 100% beter zijn dan een RX 5700 XT, om 24 CU's binnen de 75W te krijgen, dat is gewoon totaal onrealistisch als je bedenkt dat het om dezelfde architectuur gaat en hetzelfde productieproces.

75 W TDP lijkt mij wel lastig voor elkaar te krijgen. De kloksnelheden moeten dan echt drastisch omlaag. In het onderstaande tabel heb ik met lineaire opschaling gerekend. We weten niet hoe goed Navi 14 omgaat met haar voltages. Als AMD ervoor kiest om nog lager dan de RX 5700 te gaan (1,05V) dan kunnen de kloksnelheden vermoed ik wel met 200 Mhz omhoog (richting 1350). Maar RX 580 prestaties in een 75 W kaart is niet haalbaar.

@DaniëlWW2 De GTX 1650 toegevoegd. Het lijkt er op dat theoretisch een 75 W Navi 14 de iets betere papieren heeft. In mijn berekening zit 8GB geheugen en zeer lage kloksnelheden (de klok/voltage curve loopt niet lineair).

| Prestatie index | TDP | Kloksnelheid (boost) | Die size | |

| RX 5700 8GB (40CU) | 108,5 | 180 W | 1625 Mhz | 251 mm |

| RX 5700 8GB (24CU) | 65,1 | 108 W | 1625 Mhz | <150 mm |

| RX 580 8GB | 65,7 | 185 W | 1340 Mhz | 232 mm |

| RX 5700 8GB (24CU) @75W | 45,3 | 75W | 1130 Mhz | <150 mm |

| GTX 1650 4GB | 45,9 | 75W | 1665 Mhz | 200 mm |

[ Voor 10% gewijzigd door Maulwurfje op 19-07-2019 15:08 ]

Argh, het kriebelt bij mij ook! Maar de nieuwsberichten over de Navi 20 van volgend jaar doen me toch twijfelen. Als dat echte high-end kaarten worden, dan zou ik liever daarop wachten. Mijn VEGA56 is tenslotte nog niet echt outdated.Ridge schreef op donderdag 18 juli 2019 @ 09:34:

Blij mee van AMD zelf - super snelle levering voor €436,99 inc. shipping

[Afbeelding]

Iemand nog enig nieuws daarover?

Ryzen 7 9800X3D - Gigabyte X870E AORUS ELITE WIFI7 - G.Skill Flare X5 F5-6000 (32GB) - Sapphire Nitro+ RX9070XT

Ik denk dat je onderschat hoe moeilijk een videokaart schaalt met extra vermogen.Maulwurfje schreef op vrijdag 19 juli 2019 @ 14:09:

[...]

Ik heb even een vergelijkingstabel aangemaakt op HWI. Hierin zie je prestaties van alle Navi en Polaris kaarten. Ik ga van 1080p ultra uit.

75 W TDP lijkt mij wel lastig voor elkaar te krijgen. De kloksnelheden moeten dan echt drastisch omlaag. In het onderstaande tabel heb ik met lineaire opschaling gerekend. We weten niet hoe goed Navi 14 omgaat met haar voltages. Als AMD ervoor kiest om nog lager dan de RX 5700 te gaan (1,05V) dan kunnen de kloksnelheden vermoed ik wel met 200 Mhz omhoog (richting 1350). Maar RX 580 prestaties in een 75 W kaart is niet haalbaar.

@DaniëlWW2 De GTX 1650 toegevoegd. Het lijkt er op dat theoretisch een 75 W Navi 14 de iets betere papieren heeft. In mijn berekening zit 8GB geheugen en zeer lage kloksnelheden (de klok/voltage curve loopt niet lineair).

Prestatie index TDP Kloksnelheid (boost) Die size RX 5700 8GB (40CU) 108,5 180 W 1625 Mhz 251 mm RX 5700 8GB (24CU) 65,1 108 W 1625 Mhz <150 mm RX 580 8GB 65,7 185 W 1340 Mhz 232 mm RX 5700 8GB (24CU) @75W 45,3 75W 1130 Mhz <150 mm GTX 1650 4GB 45,9 75W 1665 Mhz 200 mm

Ik heb even gezocht naar een afbeelding van Polaris 10 omdat die duidelijker was, maar deze van Vega zal moeten voldoen. Helaas, want die van Polaris was veel duidelijker.

Voorbij de 190W schaalt een Vega gewoon minder hard met extra vermogen. Elke videokaart heeft zo'n punt. Navi 10 haar punt zit waarschijnlijk rond de 1000mv/180W. Dat punt vertaalt zich afhankelijk van hoe koel je de chip houdt, tot ergens tussen de 1800-1900MHz. Ik besefte me meteen met de aankondiging van Navi 10 al dat de RX5700XT "hot clocked" zou zijn met een 225W TBP rating terwijl de RX5700 op 180W bleef steken.

De RX5700XT is voorbij de efficiëntie curve gegaan zodat die net wat sneller is. Dat is ook normaal. De beste chips worden zo vaak zo gebinned. De RX5700 is dus je beginpunt en ook het punt waar ik begon.

Ik begon met de constatering dat een 24CU chip ongeveer 2/3de is. Dan zou je op 1000mv met 1800MHz, waarschijnlijk ergens tussen de 110-120W uitkomen als je op 180W rekent voor een RX5700. Reductie van 8GB naar 4GB VRAM levert je waarschijnlijk nog eens 10-15W op. Dan zit je rond de 100W, misschien iets meer.

Vervolgens volgt de constatering dat Navi 14 waarschijnlijk de mainstream chip is. AMD zal die in serieuze oplagen laten produceren, waarschijnlijk met meer dan twee SKU's. Waarom zou AMD precies niet de meest waardeloze chips die niet eens fatsoenlijk 1000mv/1700MHz+ doen, niet op 950mv binnen en verkopen als 75W ITX chips? Ik vermoed dat ongeveer 1600MHz haalbaar zou moeten zijn. Dan heb je waarschijnlijk je RX580 met 75W. Haal je dat niet, dan heb je een RX570 met 75W verbruik. Nog steeds veel beter dan een GTX1650.

Ik zeg ook niet dat deze chip er zal komen. Ik zeg dat het mogelijk is dat deze chip er kan komen. Dat is wederom een subtiel, maar belangrijk verschil.

[ Voor 3% gewijzigd door DaniëlWW2 op 19-07-2019 16:34 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.