Precies wat ik zei, normaal lopen ze voor en zijn ze er als eerste bij, nu laten ze DXR lopen.Verwijderd schreef op dinsdag 13 november 2018 @ 01:05:

[...]

Dat is niet waar! TrueAudio, tessellation, GCN, HBM, TressFX, Rapid Packed Packed Math...

Een waslijst met innovaties van AMD waarmee ze eerder waren of die AMD als eerste (asynchronous compute) goed uitvoerde.

Nvidia probeerde iets soortgelijks als GCN bij Fermi maar dat mislukte voor hen.

De 'oude rotten' hier zullen mijn lijstje nog wat kunnen aanvullen.

ik denk dat de dubbele ontkenning in je eerdere statement voor verwarring zorgdeSpankmasterC schreef op dinsdag 13 november 2018 @ 08:52:

[...]

Precies wat ik zei, normaal lopen ze voor en zijn ze er als eerste bij, nu laten ze DXR lopen.

Life is not the opposite of Death, Death is the opposite of Birth. Life is eternal.

Waar, maar zoals ik vorig jaar al zei lijkt AMD vooralsnog qua graphics vooral hier en daar wat te testen en te proberen. Nu er wat tijd is verstreken ben ik er van overtuigd dat Vega precies is wat ze voor ogen hadden: er zitten wat nieuwigheden in waar ze zelf mee aan de slag wilden, maar verder is het een product dat bestaat om toch nog iets boven Polaris te hebben. Polaris is en blijft een solide product en hoewel ze er geen bakken geld mee verdienen, zal het wel genoeg zijn om de productie te rechtvaardigen.SpankmasterC schreef op dinsdag 13 november 2018 @ 00:31:

Klinkt als een valide standpunt. Aan de andere kant is het niets voor AMD om niet haantje de voorste te zijn als het komt op het ondersteunen van nieuwe technieken.

Maar liever toch dat ze hun focus houden op dingen die er wel toe doen, voorlopig lijkt DXR nog niet heel nuttig.

Hun focus ligt volledig op Zen en ik denk dat er iedereen het er inmiddels wel over eens is dat ze dat uitzonderlijk goed hebben uitgevoerd. En dat is waarschijnlijk ook wel de beste move; hun middelen zijn immers relatief beperkt vergeleken met zowel het blauwe als groene team. De graphics tak is jarenlang juist het enige winstgevende deel geweest; ik vermoed dat die nu op +- 0 winst/verlies staat. Hoewel ik heel graag weer een top GPU van AMD zou zien, moet ik toegeven dat de huidige situatie zakelijk waarschijnlijk de beste is. Laat die graphics tak maar even hangen, het markt aandeel zal voorlopig niet veel veranderen met Nvidia's achterlijke prijzen. Zen's mega R&D periode loopt langzaamaan op z'n eind, ik vermoed (en hoop) dat we over een jaar of 2-3 iets soortgelijks aan de graphics kant zien. Er is daar minder werk nodig; de architectuur is in de basis nog steeds heel goed.

AMD's eerste hardware implementatie van DXR zal verder waarschijnlijk ook wel "all the way" gaan. Waar de recente GPU's op fysiek gebied nog wel iets te wensen over laten, is er niets mis met de implementaties van de DX features. En als je naar de geschiedenis kijkt, heeft AMD/ATI toch echt wel een goede reputatie wat dat betreft. Dingen als AA en AF heb ik al vaker genoemd, maar als je voor de gein eens naar een iets lager niveau kijkt zie je dat ook. Zo hebben ze jaren goede resultaten geboekt met VLIW architecturen, waar Nvidia daar niet toe in staat was.

Is er iemand die weet welke belangrijke GPU('s) van Nvidia VLIW was/waren zonder het te gaan Googlen?

Lees zijn reactie nog eens, dat is precies wat hij zegtVerwijderd schreef op dinsdag 13 november 2018 @ 01:05:

Dat is niet waar! TrueAudio, tessellation, GCN, HBM, TressFX, Rapid Packed Packed Math...

Een waslijst met innovaties van AMD waarmee ze eerder waren of die AMD als eerste (asynchronous compute) goed uitvoerde.

GCN, TressFX en TrueAudio vallen echter niet in die categorie. Dat zijn respectievelijk een architectuur, een software algoritme dat geen specifieke features vereist en een geheel ander soort product dat weinig met graphics te maken heeft.

@Werelds Misschien al wat eerder dan 2-3 jaar.

Ik hou nu al bewust een tijdje twee mogelijke scenario's voor Navi aan, en het meest recente aan "leaks" lijkt meer op wat ik scenario twee zou noemen. Dat is dat AMD na Vega de oorspronkelijke GCN based Navi gedumpt zou hebben en tempo heeft gemaakt met "next gen" wat nu Navi heet. Dat zou aansluiten bij "leaks" van "Navi 12" in H1/2019 en "Navi 10" in H2/2019 en "Navi 20" in 2020 die echt enthousiast level zou moeten zijn.

Verder vermoed ik dat AMD niet eens extreem veel zal hoeven doen om de RTG een beetje op orde te krijgen. GCN (de architectuur dus) haar primaire probleem lijkt grotendeels te bestaan uit weinig workloads kunnen geven aan de CU's. Die "Super SMID" aanpak waar AMD zowel SMID als VLIW zou kunnen toepassen, zou potentieel al moeten helpen.

De CU's zie ik eigenlijk ook niet veel veranderen als ze veel beter voorzien kunnen worden van workloads. Ik blijf het ook opvallend vinden hoe Nvidia generatie op generatie, steeds meer richting GCN haar CU ontwerp en functies op lijkt te schuiven, maar het nooit voor elkaar krijgt om alle functies van een GCN CU te implementeren met een flexibele rekeneenheid die efficiënt meerdere soorten berekeningen kan uitvoeren. Turing is daar natuurlijk een recent en goed voorbeeld van.

Verder gebruikt Nvidia toch pas vanaf Kelper VLIW? Nee, niet opgezocht.

Ik hou nu al bewust een tijdje twee mogelijke scenario's voor Navi aan, en het meest recente aan "leaks" lijkt meer op wat ik scenario twee zou noemen. Dat is dat AMD na Vega de oorspronkelijke GCN based Navi gedumpt zou hebben en tempo heeft gemaakt met "next gen" wat nu Navi heet. Dat zou aansluiten bij "leaks" van "Navi 12" in H1/2019 en "Navi 10" in H2/2019 en "Navi 20" in 2020 die echt enthousiast level zou moeten zijn.

Verder vermoed ik dat AMD niet eens extreem veel zal hoeven doen om de RTG een beetje op orde te krijgen. GCN (de architectuur dus) haar primaire probleem lijkt grotendeels te bestaan uit weinig workloads kunnen geven aan de CU's. Die "Super SMID" aanpak waar AMD zowel SMID als VLIW zou kunnen toepassen, zou potentieel al moeten helpen.

De CU's zie ik eigenlijk ook niet veel veranderen als ze veel beter voorzien kunnen worden van workloads. Ik blijf het ook opvallend vinden hoe Nvidia generatie op generatie, steeds meer richting GCN haar CU ontwerp en functies op lijkt te schuiven, maar het nooit voor elkaar krijgt om alle functies van een GCN CU te implementeren met een flexibele rekeneenheid die efficiënt meerdere soorten berekeningen kan uitvoeren. Turing is daar natuurlijk een recent en goed voorbeeld van.

Verder gebruikt Nvidia toch pas vanaf Kelper VLIW? Nee, niet opgezocht.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Zo snel ontwikkel je geen GPUDaniëlWW2 schreef op dinsdag 13 november 2018 @ 12:32:

@Werelds Misschien al wat eerder dan 2-3 jaar.

Ik hou nu al bewust een tijdje twee mogelijke scenario's voor Navi aan, en het meest recente aan "leaks" lijkt meer op wat ik scenario twee zou noemen. Dat is dat AMD na Vega de oorspronkelijke GCN based Navi gedumpt zou hebben en tempo heeft gemaakt met "next gen" wat nu Navi heet. Dat zou aansluiten bij "leaks" van "Navi 12" in H1/2019 en "Navi 10" in H2/2019 en "Navi 20" in 2020 die echt enthousiast level zou moeten zijn.

Ik geloof er in elk geval niet in. Wel denk ik dat ze met TSMC hun chips waarschijnlijk beter onder controle kunnen houden.

Niemand gebruikt op dit moment nog VLIW (qua architectuur; wel qua instructies).Verder gebruikt Nvidia toch pas vanaf Kelper VLIW? Nee, niet opgezocht.

Ik weet heel goed dat er vier jaar voor een GPU architectuur staat, als het niet meer is.Werelds schreef op dinsdag 13 november 2018 @ 12:36:

[...]

Zo snel ontwikkel je geen GPU

Ik geloof er in elk geval niet in. Wel denk ik dat ze met TSMC hun chips waarschijnlijk beter onder controle kunnen houden.

Ik vraag me alleen af waar het omschakelpunt was waar AMD, de middelen die voor Zen waren, naar de RTG heeft overgebracht. We weten dat AMD twee CPU teams heeft die elkaar afwisselen. Vervolgens weten we eigenlijk ook dat Zen de komende jaren nog de basis van AMD haar CPU lijn zal worden. Menig x86 CPU architectuur die het een decennium of meer heeft volgehouden met jaarlijkse iteraties. Iets revolutionairs dat Zen gaat vervangen, hoeven we dan ook niet te verwachten.

Dat opent de tijdlijn. De Zen architectuur moet ergens eind 2015/begin 2016 zijn voltooid. Vanaf dat punt kan een deel van het personeel voor Zen, vrij zijn gekomen voor andere taken. We weten dat een deel van het Zen team is overgeplaatst naar de RTG. Dat kan zomaar al in H1/2016 zijn gebeurd.

Tweede vraag is waar Koduri mee bezig was. R&D budget van de RTG zal er niet plezierig uit hebben gezien voor 2016, maar Koduri lijkt me nou ook niet het type dat helemaal niks probeert voor de toekomst. Ik sluit eigenlijk niet uit dat Polaris en Vega bewust met minimale inzet zijn ontwikkeld terwijl er op de achtergrond al meer werd nagedacht en ontwikkeld aan een GCN vervanger. Kwamen de Zen mensen er in 2016 bij, en sinds 2016 loopt het R&D budget van AMD ook in rap tempo op. Natuurlijk zal een fors deel naar Zen +/2/3/4 zijn gegaan, maar een groter deel is denk ik naar de RTG gevloeid.

Is er onder Koduri in 2015 al wat in gang gezet, dan is 2019/2020 niet onrealistisch.

Strikvraag dit.[...]

Niemand gebruikt op dit moment nog VLIW (qua architectuur; wel qua instructies).

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Eh, ja, ik had de "niet" gemist.superwashandje schreef op dinsdag 13 november 2018 @ 10:20:

[...]

ik denk dat de dubbele ontkenning in je eerdere statement voor verwarring zorgde

Navi gaat al de nieuwe architectuur gebruiken en de investeringen in RTG zijn al vermeerderd. Voor Navi lijkt het erop dat AMD gefaseerd de GPU's gaat uitbrengen, eerst een baby-versie (halverwege 2019 op zijn vroegst) en daarna de GPU's die wij graag willen hebben (2020). Mijn gok zou ook zijn dat AMD voor de opvolger van Navi weer alle tiers tegelijkertijd uitbrengt. Gezien de jonge node (TSMC 7 nm.) en de nieuwe architectuur wil AMD het voor Navi nog eerst bij enkel de baby-versie houden.Werelds schreef op dinsdag 13 november 2018 @ 10:54:

Zen's mega R&D periode loopt langzaamaan op z'n eind, ik vermoed (en hoop) dat we over een jaar of 2-3 iets soortgelijks aan de graphics kant zien. Er is daar minder werk nodig; de architectuur is in de basis nog steeds heel goed.

We kunnen opzoeken wat de datum van dat patent is? Het is mogelijk dat AMD er al wat langer aan werkte en dit al een tijd van plan was. Ik weet niet waar Daniël op baseert dat voor Navi aanvankelijk GCN gepland zou zijn, daar had AMD toch niets over losgelaten? Wat AMD wel losliet: next gen, wat net zo goed op het geheugen als op de architectuur zou kunnen slaan. We dachten aan een multi-die GPU, dat bleek helaas met de huidige beperkingen niet mogelijk te zijn, misschien bedoelden ze wel dat Navi geen GCN-architectuur zou hebben.Werelds schreef op dinsdag 13 november 2018 @ 12:36:

[...]

Zo snel ontwikkel je geen GPU

Ik geloof er in elk geval niet in.

[ Voor 88% gewijzigd door Verwijderd op 13-11-2018 20:21 ]

Dus...

https://videocardz.com/79...s-pricing-and-performance

https://videocardz.com/79...s-pricing-and-performance

AMD Radeon RX 590 final specs, pricing and performance

Is het een rebrand, of toch net genoeg voor een refresh?Paprika schreef op dinsdag 13 november 2018 @ 22:39:

Dus...

https://videocardz.com/79...s-pricing-and-performanceAMD Radeon RX 590 final specs, pricing and performance

Het blijft een matig product, maar de RX590 zal waarschijnlijk de beste mainstream videokaart worden en voorlopig ook wel blijven. Ik vraag me eigenlijk meer af of er op termijn ook een "RX575 4GB" gaat komen.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

krijg flashbacks naar de x850xt die ook zo een refresh was van de x800 en daarna de 7970 die r9 280x werd, hoewel bij de laatste de clocks volgens mij identiek bleven!?

N47h4N|The secret to creativity is knowing how to hide your sources| Dyslexic atheists don't believe in doG! | ˙ʞuɐlq ʇɟǝl ʎllɐuoᴉʇuǝʇuᴉ sɐʍ ǝɔɐds sᴉɥ┴ ®

R9 280X had een boost van 1000mhz en 1100mhz voor de veel aftermarket modellen, tegenover 925mhz van de 7970 en 1050mhz bij de 7970ghz edition. Ook stond et geheugen op 1500mhz zoals bij de GHZ edition.

De RX 590 is in ieder geval nog op een andere node... maar jammer dat ie niet op 7nm met GDDR6 zit...

De RX 590 is in ieder geval nog op een andere node... maar jammer dat ie niet op 7nm met GDDR6 zit...

[ Voor 20% gewijzigd door DoubleYouPee op 14-11-2018 12:11 ]

Verwijderd

Videocardz laat steken vallen, het was al bekend (WCCFTech) welke boost een aantal modellen krijgen en het is dus ook bekend dat minstens 1680 MHz mogelijk is voorde RX 590, in ieder geval bij 1 model.

De RX 580 was een rebrand, de RX 590 is een refresh maar wel een verdomd saaie refresh. Een iets hogere klokfrequentie maar niet eens sneller geheugen terwijl dat verschil zou moeten maken.

2,5 jaar later een beetje extra performance voor een minstsens evenveel hogere prijs

Laat Navi maar snel komen, zelfs die baby-versie van Navi (Navi12) is veel interessanter.

Ik klaag niet snel over rebranding/refreshing want in het verleden ging de prijs aanzienlijk omlaag bij dezelfde performance. Nu is zelfs dat niet meer het geval. Zeer begrijpelijk, AMD kan daar weinig aan doen maar houd de mensen niet voor de gek met die rare marketing. De RX 580 had er niet moeten komen, de RX 590 had gewoon RX 485 moeten heten en AMD had al helemaal niet RX 470 kaarten moeten verkopen onder de naam RX 480 (China) en RX 560 kaarten met minder CU's moeten verkopen zonder dat dit duidelijk wordt vermeld. Waar het Zen-team enorm veel goodwill opbouwt door transparant en eerlijk te zijn terwijl ze goede producten leveren besmeurt de RTG-marketing de reputatie van AMD.

De RX 580 was een rebrand, de RX 590 is een refresh maar wel een verdomd saaie refresh. Een iets hogere klokfrequentie maar niet eens sneller geheugen terwijl dat verschil zou moeten maken.

2,5 jaar later een beetje extra performance voor een minstsens evenveel hogere prijs

Laat Navi maar snel komen, zelfs die baby-versie van Navi (Navi12) is veel interessanter.

Ik klaag niet snel over rebranding/refreshing want in het verleden ging de prijs aanzienlijk omlaag bij dezelfde performance. Nu is zelfs dat niet meer het geval. Zeer begrijpelijk, AMD kan daar weinig aan doen maar houd de mensen niet voor de gek met die rare marketing. De RX 580 had er niet moeten komen, de RX 590 had gewoon RX 485 moeten heten en AMD had al helemaal niet RX 470 kaarten moeten verkopen onder de naam RX 480 (China) en RX 560 kaarten met minder CU's moeten verkopen zonder dat dit duidelijk wordt vermeld. Waar het Zen-team enorm veel goodwill opbouwt door transparant en eerlijk te zijn terwijl ze goede producten leveren besmeurt de RTG-marketing de reputatie van AMD.

Of RX 270/275 die een HD 7870 was (maar volgens mij wel wat hoger klokkend als je overklokte).SAiN ONeZ schreef op woensdag 14 november 2018 @ 11:33:

krijg flashbacks naar de x850xt die ook zo een refresh was van de x800 en daarna de 7970 die r9 280x werd, hoewel bij de laatste de clocks volgens mij identiek bleven!?

[ Voor 105% gewijzigd door Verwijderd op 14-11-2018 15:10 ]

@Verwijderd

Wat "baby-navi" betreft, als Polaris 11/21 de RX460/560 is, moet ik me bij Navi 12 dan iets nog lagers voorstellen? een RX650?

Persoonlijk ben ik wel benieuwd naar Navi 11, zeg maar kwa power/diesize wat de 560 nu is, maar dan op 7nm, dus fors hogere performance.

Wat "baby-navi" betreft, als Polaris 11/21 de RX460/560 is, moet ik me bij Navi 12 dan iets nog lagers voorstellen? een RX650?

Persoonlijk ben ik wel benieuwd naar Navi 11, zeg maar kwa power/diesize wat de 560 nu is, maar dan op 7nm, dus fors hogere performance.

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Verwijderd

Enige goede is is dat ze de clocks een stuk hoger hebben weten te krijgen en de TDP op 180W blijft.

Ter vergelijking doet een RX580 op 1500Mhz ~ 200 tot 220W afhankelijk van load. Dat is zga gelijk aan die van een 1070Ti ofzo.

Ter vergelijking doet een RX580 op 1500Mhz ~ 200 tot 220W afhankelijk van load. Dat is zga gelijk aan die van een 1070Ti ofzo.

[ Voor 39% gewijzigd door Verwijderd op 14-11-2018 15:58 ]

Als ik het betreffende artikel op WCCFTech goed gelezen heb, gaat zou Navi 12 juist een veel krachtiger kaart worden dan de x60 serie want ze stellen dat deze vergelijkbaar zou zijn met de Vega56. Behoorlijk high-end in mijn ogen.vectormatic schreef op woensdag 14 november 2018 @ 15:23:

@Verwijderd

Wat "baby-navi" betreft, als Polaris 11/21 de RX460/560 is, moet ik me bij Navi 12 dan iets nog lagers voorstellen? een RX650?

Persoonlijk ben ik wel benieuwd naar Navi 11, zeg maar kwa power/diesize wat de 560 nu is, maar dan op 7nm, dus fors hogere performance.

Ik zit zelf te wachten op een opvolger voor mijn RX460 die dankzij 7nm veel meer prestaties zou weten te halen uit max. 75W verbruik (hetzelfde waar jij dus op wacht @vectormatic), maar Navi 12 is dat niet, als ik WCCFTech goed interpreteer (en als zij gelijk hebben uiteraard, want het is een site die je met een bus zout moet nemen). Zelf snapte ik dan ook niet wat @Verwijderd met baby-navi bedoelde. Als het vergelijkbaar is met Vega56 vind ik het meer een uit de kluiten gewassen puber die op de sportschool zit; lijkt mij een RX680 te worden:

Quote uit het artikel:

Now I do know that the Navi 12 GPU will have 40 CUs, what I do not know is if they are going to have the same number of stream processors as GCN does – in which case the core count is going to be 2560 sps. That does seem likely to be the case because from what I have heard the card slots in somewhere around the Vega 56 depending on the clock rate but much cheaper!

[ Voor 20% gewijzigd door FairPCsPlease op 14-11-2018 19:00 ]

Verwijderd

Volgens de geruchten zou het 40 CU's krijgen. De vraag is wat 1 CU inhoudt omdat het een nieuwe architectuur is maar stel (een grote als...!) dat die CU ongeveer evenveel transistors bevat als de huidige (GCN) dan zou de die van Navi12 net iets groter gaan zijn dan de helft van de RX 480, heel erg klein dus. Qua performance zou het ergens tussen de RX 580 en de Vega56 landen, want 4 CU's meer dan de RX 580, aanzienlijk hogere klokfrequentie, nieuwe architectuur...vectormatic schreef op woensdag 14 november 2018 @ 15:23:

@Verwijderd

Wat "baby-navi" betreft, als Polaris 11/21 de RX460/560 is, moet ik me bij Navi 12 dan iets nog lagers voorstellen? een RX650?

De kosten hangen sterk samen met de grootte van de die, het geheugen en het vermogen. Dit lijkt een kaart te worden die aan 75-100 W genoeg heeft. Ik denk dat het interesssant is om op Navi10/11 te wachten, die zal waarschijnlijk een betere prijs/kwaliteit verhouding gaan leveren.

Qua segmentering zou een Navi12 in dat geval het beste als een *60-kaart kunnen worden gezien (iets groter maar dichter bij de *60 dan bij de *70. Als de naamgeving bij Navi analoog is met die van Polaris dan zou de Navi10 de volle Navi worden en de Navi11 een cut van de volle Navi worden zoals de RX 570 en RX 580 zich tot elkaar verhouden. Ik wil niet eens speculeren hoe het met Navi20 zit, we zijn nog steeds aan het wachten op een Vega20, wat dat ook is.

@FairPCsPlease

Met "baby" verwijs ik ernaar dat het een soort van opvolger van de RX 460 is (net iets groter als AMD's bewering klopt dat de TSMC 7 nm. node exact 50% van de ruimte nodig heeft, veronderstellende dat 1 CU dan goed te vergelijken is met 1 CU nu), de bottom of the barrel kaart van die generatie, totdat ze daar weer een cut van gaan verkopen zoals ze met de RX 550 deden. Ik gebruik at met een enigszins negatieve connotatie omdat relatief gezien dit de duurdere kaarten zijn, zo'n RX 460/560 levert erg weinig waarde per bestede € ten opzichte van een RX 470/570, maar als je ook maar heel erg weinig performance nodig hebt of je hebt een OEM-bak met een 200/250W voeding dan kan dat prima zijn. WCCFTech spreekt van performance "up to Vega56", niet van Vega56 performance. Een belangrijk verschil. Stel echter dat het Vega56 performance zou krijgen, je moet het binnen de generatie zien, niet de vorige generatie (Polaris en Pascal) erbij betrekken. Immers zal voor elk prijssegment de performance verhoudingsgewijs evenveel omhoog gaan, ook bij Nvidia die waarschijnlijk eveneens in 2019 de stap gaat zetten naar TSMC 7nm.

Zie het als volgt, of dat er een grotere of kleinere GPU op zit, allerlei kosten die je voor de betere kaart moet maken moet je ook voor die mindere kaart maken: ontwerp PCB, maken PCB, heel die distributieketen, materiaalkosten, transportkosten (vliegtuig/schip...)...

Of dat zo'n fabriek met al die dure machines een kleinere PCB maakt of een grotere PCB maakt relatief weinig uit voor de kosten, zo'n 50% kleinere PCB kost dan misschien 80% zoveel om te maken.

Er is enige schaling maar die schaling is verre van recht evenredig.

Dat is de reden dat die kaarten met kleine GPU's relatief (dus t.o.v. wat ze leveren) duur zijn. Bij kaarten met grotere GPU's betaal je dan vaak weer meer omwille van yield-problemen en omdat er een soort van enthusiast-premie bovenop komt. De kaarten ertussen in leveren de beste waarde/€.

offtopic:

Vanuit milieu-perspectief is die kaart met een wat grotere GPU ook beter als dat betekent dat je 1 keer per 4 jaar een grafische kaart koopt in plaats van 1 keer per 2 jaar.

Vanuit milieu-perspectief is die kaart met een wat grotere GPU ook beter als dat betekent dat je 1 keer per 4 jaar een grafische kaart koopt in plaats van 1 keer per 2 jaar.

[ Voor 62% gewijzigd door Verwijderd op 15-11-2018 08:33 ]

@Verwijderd Dank voor de heldere toelichting.

offtopic: eigenlijk moet ik wachten tot 2020 met kopen van een Navi. Ik heb 4 jaar met mijn HD6670 gedaan, als ik tot 2020 wacht, heb ik eveneens 4 jaar met mijn RX460 gedaan. 4 jaar is een mooie tijd inderdaad.

offtopic: eigenlijk moet ik wachten tot 2020 met kopen van een Navi. Ik heb 4 jaar met mijn HD6670 gedaan, als ik tot 2020 wacht, heb ik eveneens 4 jaar met mijn RX460 gedaan. 4 jaar is een mooie tijd inderdaad.

Verwijderd

FairPCsPlease schreef op donderdag 15 november 2018 @ 07:57:

offtopic: eigenlijk moet ik wachten tot 2020 met kopen van een Navi. Ik heb 4 jaar met mijn HD6670 gedaan, als ik tot 2020 wacht, heb ik eveneens 4 jaar met mijn RX460 gedaan. 4 jaar is een mooie tijd inderdaad.

offtopic:

Ik ben nu al 2,5 jaar aan het wachten omdat ik Polaris net tekort vond schieten en ik Vega begin 2017 had verwacht, het kwam eind 2017 en toen kreeg je die 'mining'-crisis. Nu moet ik op Navi wachten.

Hoe lang ik met de volgende kaart zal doen hangt af van het performance-niveau maar ik heb er geen probleem mee om pas later single-speler spellen te kopen, dan krijg je direct zeer goede performance omdat de kaart die je dan koopt overkill is. Met multiplayer-spellen is dat helaas wat lastiger geworden, ik weet bijvoorbeeld niet of dat BFX (willekeurig getal) nog zo leuk is wanneer een volgend deel uitkomt wat aanslaat. Ik wil in ieder geval van de volgende kaart dat die vrijwel alle spellen die er nu zijn (m.u.v. de zeer slecht geoptimaliseerde spellen/engines zoals Assassin's Creed) met zeer hoge instellingen >>100 FPS aankan bij 1440p ultrawide aangezien mijn volgende monitor waarschijnlijk die resolutie gaat hebben (dat of 4k). Met 1 performance-niveau hoger zit ik dan beter. Ik wacht op de grotere Navi, ik vermoed dat dat de Navi10 zal zijn.

Ik ben nu al 2,5 jaar aan het wachten omdat ik Polaris net tekort vond schieten en ik Vega begin 2017 had verwacht, het kwam eind 2017 en toen kreeg je die 'mining'-crisis. Nu moet ik op Navi wachten.

Hoe lang ik met de volgende kaart zal doen hangt af van het performance-niveau maar ik heb er geen probleem mee om pas later single-speler spellen te kopen, dan krijg je direct zeer goede performance omdat de kaart die je dan koopt overkill is. Met multiplayer-spellen is dat helaas wat lastiger geworden, ik weet bijvoorbeeld niet of dat BFX (willekeurig getal) nog zo leuk is wanneer een volgend deel uitkomt wat aanslaat. Ik wil in ieder geval van de volgende kaart dat die vrijwel alle spellen die er nu zijn (m.u.v. de zeer slecht geoptimaliseerde spellen/engines zoals Assassin's Creed) met zeer hoge instellingen >>100 FPS aankan bij 1440p ultrawide aangezien mijn volgende monitor waarschijnlijk die resolutie gaat hebben (dat of 4k). Met 1 performance-niveau hoger zit ik dan beter. Ik wacht op de grotere Navi, ik vermoed dat dat de Navi10 zal zijn.

[ Voor 45% gewijzigd door Verwijderd op 15-11-2018 08:42 ]

@Verwijderd @FairPCsPlease

Dank voor de toelichting! Ik wist niet dat Navi 12 volgens geruchten 40 CUs zou krijgen.

40 CUs zou een vrij forse boost zijn voor een x60 kaart (maar die zitten sinds ~260x ook al op hetzelfde niveau). Als ik even een pen en een bierviltje er bij mag pakken, mijn 560 stookt 45w (power limit) voor 14 CUs (en aanverwante HW in de GPU zelf) op ~1150 MHz. 40 CUs raam ik dan op ~130w. Als we dan aannemen dat 7nm 50% zuiniger is (meen dat ik dat getal ooit ergens gezien heb), kom je op 65w uit voor 40 CUs op ~1150 MHz (en pakweg 580 hoeveelheden aan GFLOPS). Dan heb je binnen PCIe spec nog pakweg 10 watt over om je VRMs en ( ram ICs in the proppen, ik denk dat dat net te krap is, en dat die 1150 mhz hoger gaat uitpakken, dan verwacht ik toch een 6-pin aansluiting.

ram ICs in the proppen, ik denk dat dat net te krap is, en dat die 1150 mhz hoger gaat uitpakken, dan verwacht ik toch een 6-pin aansluiting.

We gaan het zien, maar ik heb wel goede hoop dat er een mooie <75w kaart gaat komen, de vraag is wanneer.

Kwa upgrades weet ik niet zo goed wanneer mijn 560 gewisseld gaat worden, voorlopig vind ik dit snel genoeg (anders had ik die 560 niet gekocht), ik verwacht dat Borderlands 3 of Doom 2 de drivers voor een upgrade gaan worden.

Dank voor de toelichting! Ik wist niet dat Navi 12 volgens geruchten 40 CUs zou krijgen.

40 CUs zou een vrij forse boost zijn voor een x60 kaart (maar die zitten sinds ~260x ook al op hetzelfde niveau). Als ik even een pen en een bierviltje er bij mag pakken, mijn 560 stookt 45w (power limit) voor 14 CUs (en aanverwante HW in de GPU zelf) op ~1150 MHz. 40 CUs raam ik dan op ~130w. Als we dan aannemen dat 7nm 50% zuiniger is (meen dat ik dat getal ooit ergens gezien heb), kom je op 65w uit voor 40 CUs op ~1150 MHz (en pakweg 580 hoeveelheden aan GFLOPS). Dan heb je binnen PCIe spec nog pakweg 10 watt over om je VRMs en (

We gaan het zien, maar ik heb wel goede hoop dat er een mooie <75w kaart gaat komen, de vraag is wanneer.

Kwa upgrades weet ik niet zo goed wanneer mijn 560 gewisseld gaat worden, voorlopig vind ik dit snel genoeg (anders had ik die 560 niet gekocht), ik verwacht dat Borderlands 3 of Doom 2 de drivers voor een upgrade gaan worden.

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Verwijderd

Let erop dat het een nieuwe architectuur wordt (volgens de geruchten), het is mogelijk dat een CU dan groter of kleiner wordt. Maar de naam suggereert voor mij ook dat het een kleine kaart wordt, de RX 460 is een Polaris 12.

Sommige mensen (mijzelf incluis) houden niet van 2e hands spullen kopen, verder heb je gelijk.Verwijderd schreef op dinsdag 13 november 2018 @ 01:05:

Ere wie ere toekomt: WCCFTech had de primeur.

https://wccftech.com/amds...ed-in-all-product-ranges/

Eerlijk gezegd zou ik dan eerder een tweedehands lowend kaart overwegen als ik die kan vinden. Of misschien een tweedehands Fury (niet een geweldige reputatie maar een prima kaart als je weet wat je doet) als de prijs goed is.

Mijn sentiment is hetzelfde: screw die 590, ik wacht op een kaart die zeer geschikt is voor 1440-p gaming. Ik vind het prima als AMD eerst een lowend-Navi (ongeveer (50/100)*(40/36) uitbrengt maar dan moet de prijs er ook naar zijn, deze kaart zou dichter bij een *60 kaart zitten dan bij een *70 kaart qua GPU-grootte. Als dat vanaf €150 kost, prima (overbrugging naar een high-end kaart van 2-3 jaar later), als het vanaf €300 kost, nope. Bij €200 en een aannemlijk verhaal (hogere productiekosten door 7 nm) wil ik er ook nog wel over nadenken.

Is een dubbele ontkenning, "het is niets voor AMD om niet haantje de voorste te zijn", jullie zeggen dus feitelijk hetzelfde.Dat is niet waar! TrueAudio, tessellation, GCN, HBM, TressFX, Rapid Packed Packed Math...

Een waslijst met innovaties van AMD waarmee ze eerder waren of die AMD als eerste (asynchronous compute) goed uitvoerde.

Nvidia probeerde iets soortgelijks als GCN bij Fermi maar dat mislukte voor hen.

De 'oude rotten' hier zullen mijn lijstje nog wat kunnen aanvullen.

edit:

damn die automatische push van tweakers forum, ik dacht echt op de laatste reactie te reageren, totdat ik post, en blijkt die reactie al tig reacties daarna te hebben.....

damn die automatische push van tweakers forum, ik dacht echt op de laatste reactie te reageren, totdat ik post, en blijkt die reactie al tig reacties daarna te hebben.....

[ Voor 5% gewijzigd door zion op 15-11-2018 12:30 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Nee.DaniëlWW2 schreef op donderdag 15 november 2018 @ 13:08:

De Pond gaat ook onderuit op het moment. Ga er overigens wel vanuit dat je garantie per 29 maart 2019 vervalt...

Ten eerste ga je een contract aan op het moment van aanschaf. Daar hebben ze zich aan te houden.

Daarnaast is het *extreem* onwaarschijnlijk dat het VK juist die wetten gaat laten vallen. Ze zullen ze vervangen door equivalente exemplaren, die niet direct aan de EU directives gebonden zijn zoals nu het geval is.

Zelf in bezit geweest van een AMD RX Vega 64 Limited Edition. Deze kaart was aangeschaft bij: https://www.overclockers.co.uk Omdat ik nieuwsgierig was naar de garantie periode, omdat ik de kaart wilde verkopen, heb ik op de website van Sapphire een ticket aangemaakt. Daar kreeg ik bericht dat mijn kaart nog 14 september 2019 garantie had.

De datum is afgeleid van de fabricage datum van de kaart en afgeleid van het serial number . In mijn geval had de kaart twee jaar garantie.

De datum is afgeleid van de fabricage datum van de kaart en afgeleid van het serial number . In mijn geval had de kaart twee jaar garantie.

https://support.microsoft...windows-10-update-history

Windows 10, version 1809

Windows Server 2019

Windows Server, version 1809

Note: AMD no longer supports Radeon HD2000 and HD4000 series graphic processor units (GPUs).

After updating to Window 10, version 1809, Microsoft Edge tabs may stop working when a device is configured with AMD Radeon HD2000 or HD4000 series video cards.

Customers may get the following error code: "INVALID_POINTER_READ_c0000005_atidxx64.dll".

Some users may also experience performance issues with the lock screen or the ShellExperienceHost. (The lock screen hosts widgets, and the ShellExperienceHost is responsible for assorted shell functionality).

Workaround: To ensure a seamless update experience, we are blocking devices with AMD Radeon HD2000 and HD4000 series graphics processors from being offered Window 10, version 1809.

Next Steps: Microsoft is investigating this issue.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Hmm ik ben benieuwd of de ATi Radeon Xpress X1200 (chipset GPU van 2007) nog werkt met Windows 10 1809, deze werkte namelijk op 1803 met de Vista driver

Dus indien je GPU niet meer ondersteund is, probeer het met een oudere Windows driver, het zou maar kunnen werken

Dus indien je GPU niet meer ondersteund is, probeer het met een oudere Windows driver, het zou maar kunnen werken

Officiële melding over Vega 8 mobile drivers support door AMD.

https://www.reddit.com/r/...utm_source=reddit-android

https://www.reddit.com/r/...utm_source=reddit-android

Verwijderd

Neem het met een flinke korrel zout, hier wat Navi-geruchten van iemand die hier vaker is aangehaald.

Hij zou deze informatie hebben gekregen van iemand die in die industrie werkt.

De geruchten:

- Tussen maart en juni krijg je een eerste Navi kaart en een cut hiervan.

- De volledige kaart: 96 CPU's, ongeveer het performance-niveau van een GTX RTX 2070, MSRP van $300

- De cut: ongeveer het performance-niveau van een GTX 1070, MSRP van $200

- Q4 2019 de grotere broer

- Nieuwe architectuur, maar met veel GCN-elementen, naar zijn vermoeden om de software die reeds bestaat compatibel te houden met deze kaart aangezien de developers nu eenmaal weinig hun best doen om AMD te helpen.

Gelukkig hebben we hier geen hype-jar, anders zou ik flink wat geld moeten doneren.

Hij zou deze informatie hebben gekregen van iemand die in die industrie werkt.

De geruchten:

- Tussen maart en juni krijg je een eerste Navi kaart en een cut hiervan.

- De volledige kaart: 96 CPU's, ongeveer het performance-niveau van een GTX RTX 2070, MSRP van $300

- De cut: ongeveer het performance-niveau van een GTX 1070, MSRP van $200

- Q4 2019 de grotere broer

- Nieuwe architectuur, maar met veel GCN-elementen, naar zijn vermoeden om de software die reeds bestaat compatibel te houden met deze kaart aangezien de developers nu eenmaal weinig hun best doen om AMD te helpen.

Gelukkig hebben we hier geen hype-jar, anders zou ik flink wat geld moeten doneren.

[ Voor 5% gewijzigd door Verwijderd op 21-11-2018 20:00 ]

Hoezo? we hebben al een AMD kaart met performance van de RTX 2070.Verwijderd schreef op woensdag 21 november 2018 @ 15:44:

Gelukkig hebben we hier geen hype-jar, anders zou ik flink wat geld moeten doneren.

Oke, niet voor €300, maar wel voor €450. Niet echt iets om hyped van te worden.

Die grote broer misschien wel, maar dan hebben we het nog over een jaar vanaf nu.

Verwijderd

De prijs is nu net hetgeen wat relevant is aangezien je nu €300 betaalt voor een 2,5 jaar oude Polaris kaart en Nvidia €500-600 rekent voor die 2070. Het lagere vermogen is ook erg prettig.DoubleYouPee schreef op woensdag 21 november 2018 @ 15:56:

[...]

Hoezo? we hebben al een AMD kaart met performance van de RTX 2070.

Oke, niet voor €300, maar wel voor €450. Niet echt iets om hyped van te worden.

Die grote broer misschien wel, maar dan hebben we het nog over een jaar vanaf nu.

[ Voor 3% gewijzigd door Verwijderd op 21-11-2018 15:59 ]

Waarom zouden ze hun marge enorm verkleinen door zover onder de prijs van hun concurrent te gaan zitten? Tenzij tegen die tijd de RTX2070 naar $350, is het niet logisch voor AMD om een vergelijkbare kaart voor $300 te verkopen. Dus dat gaat ook niet gebeuren. Als ze een kaart hebben die vergelijkbaar is met een RTX2070, en als die tegen die tijd nog dezelfde prijs heeft als nu, dan moet je blij zijn als ze hem voor $450 verkopen. Dan zitten ze al een veruit betere keuze dan een RTX2070, en hebben ze veel betere marges dan wanneer ze die voor $300 verkopen.

Dat is tenzij er goede redenen zijn om ondanks de lagere prijs alsnog voor de Nvidia te gaan, bijvoorbeeld als die Navi 500W verstookt. Dan moeten ze hem wel goedkoop neerzetten om hem nog te verkopen. Maar ik zou er niet vanuit gaan dat dit daadwerkelijk gaat gebeuren.

Dat is tenzij er goede redenen zijn om ondanks de lagere prijs alsnog voor de Nvidia te gaan, bijvoorbeeld als die Navi 500W verstookt. Dan moeten ze hem wel goedkoop neerzetten om hem nog te verkopen. Maar ik zou er niet vanuit gaan dat dit daadwerkelijk gaat gebeuren.

[ Voor 8% gewijzigd door Sissors op 21-11-2018 16:06 ]

Dat het goedkoper wordt is natuurlijk altijd fijn, maar er zijn veel mensen met een 1440p of 1440p ultrawide freesync monitor, die al sinds begin 2017 wachten op een AMD (dus freesync) kaart die gelijk komt met 1080ti.Verwijderd schreef op woensdag 21 november 2018 @ 15:59:

[...]

De prijs is nu net hetgeen wat relevant is aangezien je nu €300 betaalt voor een 2,5 jaar oude Polaris kaart en Nvidia €500-600 rekent voor die 2070. Het lagere vermogen is ook erg prettig.

Volgens die geruchten kan je dus nog een jaar wachten... dan loopt AMD dus 3 jaar achter. Niet echt iets om hyped van te worden als je het mij vraagt.

Maar goed, voor het mid-range segment zou het natuurlijk wel goed nieuws zijn.

[ Voor 8% gewijzigd door DoubleYouPee op 21-11-2018 16:17 ]

Ik ga ervanuit dat er dan inmiddels een RTX/GTX3070 op de markt isSissors schreef op woensdag 21 november 2018 @ 16:06:

Waarom zouden ze hun marge enorm verkleinen door zover onder de prijs van hun concurrent te gaan zitten? Tenzij tegen die tijd de RTX2070 naar $350, is het niet logisch voor AMD om een vergelijkbare kaart voor $300 te verkopen. Dus dat gaat ook niet gebeuren. Als ze een kaart hebben die vergelijkbaar is met een RTX2070, en als die tegen die tijd nog dezelfde prijs heeft als nu, dan moet je blij zijn als ze hem voor $450 verkopen. Dan zitten ze al een veruit betere keuze dan een RTX2070, en hebben ze veel betere marges dan wanneer ze die voor $300 verkopen.

Dat is tenzij er goede redenen zijn om ondanks de lagere prijs alsnog voor de Nvidia te gaan, bijvoorbeeld als die Navi 500W verstookt. Dan moeten ze hem wel goedkoop neerzetten om hem nog te verkopen. Maar ik zou er niet vanuit gaan dat dit daadwerkelijk gaat gebeuren.

AMD 9950X3D - X670E-Hero - G.Skill Royal Neo 48GB 6400 CL26 1:1 - RTX 5090 Astral LC 32GB - 9100Pro 2TB - BeQuit 1500w - Corsair 6500D - LG 3440P 240Hz WOLED

Verwijderd

Te vroeg! Als de gemelde datum (maart tot juni) klopt. Ik verwacht geen nieuwe Nvidia-kaarten in dat segment voor Q4 2019 en dat is al extreem snel. Echter moet AMD wel anticiperen op die nieuwe kaarten en dan kan je net zo goed direct de prijs op dat niveau zetten als je wil voorkomen dat klanten pissed worden. Dat klanten nu zo pissed zijn op Nvidia kan AMD helpen als AMD laat zien een straight shooter te zijn.Q_7 schreef op woensdag 21 november 2018 @ 16:26:

[...]

Ik ga ervanuit dat er dan inmiddels een RTX/GTX3070 op de markt isDan zou 300$ voor RTX2070 performance wel kunnen kloppen omdat nVidia gigantisch voor ligt.

Die mensen overdrijven schromelijk.DoubleYouPee schreef op woensdag 21 november 2018 @ 16:15:

[...]

Dat het goedkoper wordt is natuurlijk altijd fijn, maar er zijn veel mensen met een 1440p of 1440p ultrawide freesync monitor, die al sinds begin 2017 wachten op een AMD (dus freesync) kaart die gelijk komt met 1080ti.

Met een Vega64/2070 kan je ook prima 1440p en 1440p ultrawide aan, met >100 FPS (ook 1440p ultrawide). Je komt waarschijnlijk ruim boven de 100 FPS als je geen ultra-obsessie hebt.

Het is niet dat je het verschil tussen zeer hoog en ultra ziet bij juist die instellingen waarvoor de impact op de FPS hoog is (MSAA, schaduwen...) terwijl je met je >100 FPS aan het schieten bent in een FPS-spel. Als je stil staat en zeer aandachtig kijkt dan zie je het verschil misschien maar is dat het grote verschil in FPS waard?

Verder, zoals je hebt gelezen vermeldt hij dat eind 2019 een kaart uitkomt die richting 2080 Ti presteert, waarschijnlijk net iets minder. Dat is geen middensegment en een jaar is nu ook weer niet heel erg lang na de laatste 2,5 jaar.

offtopic:

Dat noem ik een glas wat half vol zit na 2,5 jaar enkel Polaris en Vega, een 'mining'-crisis, eerdere geruchten dat eind 2019 Navi uitkomt en pas eind 2020 Navi+ en last but not least de corruptie van Samsung, Hynix en Micron. De prizjen van RAM zijn redelijk gedaald en zullen nog wat verder dalen voordat Zen2 uitkomt, de prijs van SSD's is gehalveerd (helaas voor mij nadat ik mijn 480 GB SSD kocht ), de CPU's en GPU's gaan naar de 7 nm. node en AMD brengt - volgens dit gerucht - in 1 jaar tijd op alle segmenten een kaart uit met een verbeterde architectuur en op 7 nm. Als nu nog LG in 2019 of 2020 de prijs van de 1440p ultrawide monitor met FreeSync verlaagt naar rond de €600 dan ben ik helemaal tevreden.

), de CPU's en GPU's gaan naar de 7 nm. node en AMD brengt - volgens dit gerucht - in 1 jaar tijd op alle segmenten een kaart uit met een verbeterde architectuur en op 7 nm. Als nu nog LG in 2019 of 2020 de prijs van de 1440p ultrawide monitor met FreeSync verlaagt naar rond de €600 dan ben ik helemaal tevreden.

Dat noem ik een glas wat half vol zit na 2,5 jaar enkel Polaris en Vega, een 'mining'-crisis, eerdere geruchten dat eind 2019 Navi uitkomt en pas eind 2020 Navi+ en last but not least de corruptie van Samsung, Hynix en Micron. De prizjen van RAM zijn redelijk gedaald en zullen nog wat verder dalen voordat Zen2 uitkomt, de prijs van SSD's is gehalveerd (helaas voor mij nadat ik mijn 480 GB SSD kocht

Omdat ze ook dan nog genoeg marge hebben en hun marktaandeel kunnen vergroten, zeker nu de Nvidia-klanten nogal pissed zijn omdat de prijzen van die RTX-kaarten zo hoog zijn. De meer interessante vraag is voor mij hoe Nvidia hierop reageert. Gaan zij ook hun prijs sterk verlagen? Hoe ver kan Nvidia gaan? Is Nvidia bereid om verlies te nemen met hun gigantisch grote GPU en relatief lage yields?Sissors schreef op woensdag 21 november 2018 @ 16:06:

Waarom zouden ze hun marge enorm verkleinen door zover onder de prijs van hun concurrent te gaan zitten?

7 nm. TSMC! Dit wordt juist een relatief zuinige GPU voor het performance-niveau in vergelijking met wat Nvidia levert aangezien Nvidia nog op de oude node zit.bijvoorbeeld als die Navi 500W verstookt.

[ Voor 47% gewijzigd door Verwijderd op 21-11-2018 19:57 ]

Dat het op een nieuwe node zit betekend niet dat het energieverbruik laag is. Daar spelen veel meer zaken een rol bij. Nu verwacht ik overigens niet die 500W, maar zoiets is wel de enige reden waarom AMD hem veel goedkoper dan concurrentie zou verkopen.

Marktaandeel vergroten is geen echte reden. Primair omdat je de beste keuze bent als je significant goedkoper bent dan je concurrent. Er is weinig voordeel meer als je gigantisch veel goedkoper bent dan de concurrent. Secundair omdat als nu AMD die voor $300 zou uitbrengen morgen Nvidia de prijs van de RTX2070 naar $350 ofzo veranderd.

Dus er zijn twee opties: Of AMD biedt hem heel goedkoop aan, Nvidia volgt, en Nvidia heeft minder R&D budget door lagere marges. Of AMD biedt hem gewoon iets onder de prijs van Nvidia aan, en AMD heeft veel meer R&D budget (ervan uitgaande dat ze hem inderdaad goedkoop kunnen produceren*). Gezien momenteel hoe scheef het is tussen AMD en Nvidia is het veel logischer voor AMD om hun eigen winst te proberen te verhogen als die van Nvidia proberen te verlagen.

* De RTX2070 heeft een kleinere die size als de enige AMD kaart die nog redelijk vergelijkbaar is, de Vega64. Het verschil is niet heel groot, maar ik zou er ook niet vanuit gaan dat AMD vergelijkbare performance uit een veel kleinere die weet te krijgen. En 7nm zal ook geen goedkoop proces zijn per mm2.

TL;DR: Onder prijs van je concurrent gaan zitten is logisch. Gigantisch ver eronder gaan zitten heeft eigenlijk bijzonder weinig voordeel en is imo wishful thinking.

Marktaandeel vergroten is geen echte reden. Primair omdat je de beste keuze bent als je significant goedkoper bent dan je concurrent. Er is weinig voordeel meer als je gigantisch veel goedkoper bent dan de concurrent. Secundair omdat als nu AMD die voor $300 zou uitbrengen morgen Nvidia de prijs van de RTX2070 naar $350 ofzo veranderd.

Dus er zijn twee opties: Of AMD biedt hem heel goedkoop aan, Nvidia volgt, en Nvidia heeft minder R&D budget door lagere marges. Of AMD biedt hem gewoon iets onder de prijs van Nvidia aan, en AMD heeft veel meer R&D budget (ervan uitgaande dat ze hem inderdaad goedkoop kunnen produceren*). Gezien momenteel hoe scheef het is tussen AMD en Nvidia is het veel logischer voor AMD om hun eigen winst te proberen te verhogen als die van Nvidia proberen te verlagen.

* De RTX2070 heeft een kleinere die size als de enige AMD kaart die nog redelijk vergelijkbaar is, de Vega64. Het verschil is niet heel groot, maar ik zou er ook niet vanuit gaan dat AMD vergelijkbare performance uit een veel kleinere die weet te krijgen. En 7nm zal ook geen goedkoop proces zijn per mm2.

TL;DR: Onder prijs van je concurrent gaan zitten is logisch. Gigantisch ver eronder gaan zitten heeft eigenlijk bijzonder weinig voordeel en is imo wishful thinking.

[ Voor 6% gewijzigd door Sissors op 21-11-2018 18:37 ]

Verwijderd

Jij komt nu met een algemene statement maar het gaat hier om dit ene concrete geval. In dit geval gaat het wel degelijke zuiniger zijn gezien de grootte die die die gaat hebben en de grootte die de die van de 1080/2070 heeft. Vergelijk maar eens de die-groottes van diverse AMD- en Nvidia-kaarten en zet dit af tegen de TDP, combineer dat met hoe groot deze die waarschijnlijk ongeveer gaat worden, ergens halverwege tussen de RX 580 en de Vega64 en je komt uit op een kaart die relatief zuinig is voor dat performance-niveau, zuiniger dan de 2070. En daar hoef je nog niet eens voor te ondervolten.Sissors schreef op woensdag 21 november 2018 @ 18:36:

Dat het op een nieuwe node zit betekend niet dat het energieverbruik laag is.

Ter referentie: bij de Vega56 is slechts 1/8ste van de GPU uitgeschakeld, dit komt uit op een 6/8ste zo'n grote GPU indien een CU ceteris paribus even groot blijft bij deze aangepaste architectuur.

Dat is nog even afwachten maar aangezien het volgens dit gerucht nog veel GCN-elementen zou hebben is het niet heel erg ver gezocht dat die CU niet al te grondig wordt veranderd.

Realistisch gezien is er een grote kans dat de die kleiner wordt dan wat ik aangaf omdat de kans groot is dat deze die minder groot hoeft te zijn omdat de architectuur minder compute-focused is. Het patent van de mogelijke nieuwe architectuur is openbaar, iedereen kan het lezen.

Natuurlijk wel, AMD heeft dat grotere marktaandeel nodig om betere software-support te krijgen. De hardware kan nog zo goed zijn, zonder software-support haal je lang niet alles uit die hardware. Als AMD developers zo ver wil krijgen dat ze de open source oplosingen van AMD gebruiken of in ieder geval geen problematische Gameworks-code gebruiken dan helpt het erg veel als je 50-60% marktaandeel hebt in plaats van 25-30% marktaandeel.Marktaandeel vergroten is geen echte reden.

Twijfelachtig want Nvidia heeft zo'n sterke branding in vergelijking met AMD dat AMD een best wel groot prijsverschil nodig zou hebben om de Nvidia-fanboys te overtuigen om ook AMD eens een kans te geven.Primair omdat je de beste keuze bent als je significant goedkoper bent dan je concurrent. Er is weinig voordeel meer als je gigantisch veel goedkoper bent dan de concurrent.

Dat is speculatie (ook ik zie Nvidia eerder de prijs verlagen dan Intel, mr. Leather Jacket lijkt over meer realiteitszin te beschikken dan de bazen van Intel) maar de vraag is hoe ver Nvidia de prijs kan laten dalen. Nvidia zal in ieder geval deze keer (dat was anders voor Pascal en Maxwell!) veel hogere kosten hebben voor hetzelfde performance-niveau dan AMD omwille van de grootte van de die en omdat ze er ook nog eens al die RTX-kernen en Tensor-kernen op stoppen die ongeveer de die nog groter maken!Secundair omdat als nu AMD die voor $300 zou uitbrengen morgen Nvidia de prijs van de RTX2070 naar $350 ofzo veranderd.

Heel goedkoop is een ander verhaal, AMD zal ervoor zorgen dat ze geen verlies maken met deze kaarten en waarschijnlijk zullen ze inzetten op een gezonde winstmarge zodat ze weer meer kunnen investeren in RTG.

Eigen winst verhogen gaat niet lukken door de prijs hoog te maken gezien de veel sterkere branding van Nvidia: Nvidia komt daarmee weg, AMD niet!

Tenslotte, heb jij al eens opgezocht wat het verschil in grootte is tussen TSMC 7 nm. en GF14 nm. Dat is gigantisch! Volgens AMD een factor 2 en dat zou best kunnen kloppen gezien de vergelijking tussen 8 kernen op Rome en 8 kernen op Zen1.

[ Voor 6% gewijzigd door Verwijderd op 21-11-2018 19:55 ]

Ik heb dat niet zelf opgezocht, mijn persoonlijke ervaring is dat we elke keer te horen krijgen dat de volgende technologie gigantisch veel beter en sneller is, en in de praktijk het een mooie upgrade is maar niet meer dan dat. (En dan bedoel ik niet van wat ik op Tweakers lees maar wat ik in de dagelijkse praktijk op mijn werk mee maak).

Dat Nvidia met een hogere prijs weg komt was niet het punt. Ze komen namelijk wel met een wat hogere prijs weg, maar niet met een gigantisch veel hogere prijs. Daarom zou redelijk ruim onder de prijs van Nvidia gaan zitten voldoende zijn, (dus bijvoorbeeld €450 vs €520), en hoef je niet je eigen marges om zeep te helpen. Mij lijkt het vooral een hele hoop wishfull thinking dat AMD met een enorme marge Nvidia zou gaan verslaan. Ik denk dat we vooral blij moeten zijn als ze een goed alternatief weten neer te zetten.

Maar goed, daar gaan we toch niet uitkomen, en we zullen het zien over een half jaar.

Dat Nvidia met een hogere prijs weg komt was niet het punt. Ze komen namelijk wel met een wat hogere prijs weg, maar niet met een gigantisch veel hogere prijs. Daarom zou redelijk ruim onder de prijs van Nvidia gaan zitten voldoende zijn, (dus bijvoorbeeld €450 vs €520), en hoef je niet je eigen marges om zeep te helpen. Mij lijkt het vooral een hele hoop wishfull thinking dat AMD met een enorme marge Nvidia zou gaan verslaan. Ik denk dat we vooral blij moeten zijn als ze een goed alternatief weten neer te zetten.

Maar goed, daar gaan we toch niet uitkomen, en we zullen het zien over een half jaar.

Ik zie in de PW nu RX 550 kaarten met 640 shaders staan*, heb ik iets gemist ofzo? Ik kan me geen nieuws daarover herinneren. Ook op wikipedia staan ze in de lijst;

Wikipedia: List of AMD graphics processing units

Lijken geen cut-downs van de RX 560 te zijn, dus die 512 shaders versie was een cut-down chip?

*Link

Wikipedia: List of AMD graphics processing units

Lijken geen cut-downs van de RX 560 te zijn, dus die 512 shaders versie was een cut-down chip?

*Link

[ Voor 22% gewijzigd door NitroX infinity op 21-11-2018 23:19 ]

Graphene; a material that can do everything, except leave the lab. - Asianometry

Verwijderd

Het is handig om dat wel te doen alvorens je een mening vormt want de prijs die AMD kan en zal vragen hangt samen met de oppervlakte van de die. Dit zou best wel eens een midlevel kaart kunnen worden met een diesize die ongeveer net zo groot is als de RX 580 dankzij de veel kleinere node en de nieuwe architectuur.Sissors schreef op woensdag 21 november 2018 @ 20:30:

Ik heb dat niet zelf opgezocht

Nogmaals, de TSMC 7 nm. node is veel kleiner is dan de TSMC 12/14 NM node, niet een beetje kleiner. Dat is een onbetwistbaar feit, geen speculatie. We hebben het bewijs al gezien.

Dat is verdomd klein voor 8 kernen per vierkantje! Het is bekend hoe groot die PCB is en hoe groot de Ryzen-PCB's zijn, het is ook bekend welk deel van die PCB's wordt gebruikt voor de die. Dit is een gemakkelijk invul-oefening.

AMD had eerder een fors kleinere node voor hun grafische kaart dan Nvidia maar in die tijd maakten ze de fout dat ze hun software nog niet in orde hadden, deze keer is dat geen probleem.

Je werkt niet je eigen marge om zeep wanneer aantal_verkopenW*winst_X > aantal_verkopenY*winst_Z met X<Z en W>Y.Dat Nvidia met een hogere prijs weg komt was niet het punt. Ze komen namelijk wel met een wat hogere prijs weg, maar niet met een gigantisch veel hogere prijs. Daarom zou redelijk ruim onder de prijs van Nvidia gaan zitten voldoende zijn, (dus bijvoorbeeld €450 vs €520), en hoef je niet je eigen marges om zeep te helpen.

Nvidia komt weg met een aanzienlijk hogere prijs. €220 voor een RX 580 en €290 voor de GTX 1060 en veel mensen kiezen nog voor de GTX 1060, €220 voor een RX 580 en €450 voor een GTX 1060, dan gaan die mensen misschien eens nadenken over AMD. Mensen zijn weinig rationeel, de meeste mensen gedragen zich als domme schapen en zijn enorm beïnvloedbaar door marketing, dat is de reden dat er met zoveel geld wordt gesmeten voor die marketing. Nvidia hun branding is verschrikkelijk sterk en dominant. Na 10-20 jaar bangmakerij dat je van alles mist voor gaming als je niet een Nvidia-kaart hebt (PhysX, rookeffectjes, Gameworks-toestanden, nu die raytracing) zijn mensen gaan geloven dat ze per se een Nvidia-kaart nodig hebben voor gaming. Niet de goed geïnformeerde mensen, wel de doorsnee gamer. Dat Nvidia de halo-producten heeft helpt ook niet. Daar kwam nog eens bovenop dat de 200-serie en 300-serie een nogal hoog vermogen out of the box (wel goed aan te passen) hadden en ook bij Polaris had dat vermogen wat lager moeten en kunnen zijn.

AMD zal niet die GPU's zonder een leuke winstmarge verkopen maar als ze ruim onder de prijs kunnen zitten terwijl ze een lekkerre winstmarge pakken en het marktaandeel flink vergroten dan is het hallelujah voor AMD. 1 keer meer winst maken is leuk, een flink groter marktaandeel krijgen en de volgende keer weer een hoop extra klanten hebben garandeert ook een leuke toekomstige geldstroom zolang je het niet verpest. Uiteindelijk zullen die winstmarges bij AMD ook wel weer hoger worden wanneer ze een kans daarvoor zien maar dat kan AMD zich pas permitteren wanneer ze weer X jaar ongeveer 50% van het marktaandeel hebben, nu moet AMD een hoop scepsis overwinnen door veel meer waarder voor het geld te bieden. Overigens zijn de prijzen bij AMD-kaarten vaak fors hoger in Nederland en gelden de genoemde prijzen slechts voor de referentiekaarten, indien dit gerucht klopt. Een goede aftermarket-kaart is al snel €50-100 duurder bij een dergelijke kaart. Als die MSRP $300 wordt dan ga je hier gemakkelijk €350 betalen voor een Navi-kaart. Altijd nog veel beter dan wat we de laatste tijd hadden verwacht en het zal lastig worden voor Nvidia om die prijs te halen met hun 2070-kaart want die die is bijna net zo groot als die van de 1080 Ti omdat er al die tensor-kernen en RTX-kernen op zitten. Nvidia zal echter in dat geval wel de prijs van de 2070 verlagen en AMD moet er dus voor zorgen dat na die prijsverlaging het gat nog groot genoeg is terwijl ze wel nog winst maken per verkochte kaart zodat er weer meer in R&D geïnvesteerd kan worden.

[ Voor 20% gewijzigd door Verwijderd op 22-11-2018 20:50 ]

Ik zat in het verkeerde topic, dus hier nieuwe poging

Hoe zit dat nu eigenlijk met de nieuwe GPU's die volgend jaar verwacht worden? Kunnen we inschatten hoe concurrentieel deze gaan zijn of is het nog te vroeg?

Hoe zit dat nu eigenlijk met de nieuwe GPU's die volgend jaar verwacht worden? Kunnen we inschatten hoe concurrentieel deze gaan zijn of is het nog te vroeg?

Ryzen 7 9800X3D - Gigabyte X870E AORUS ELITE WIFI7 - G.Skill Flare X5 F5-6000 (32GB) - Sapphire Nitro+ RX9070XT

Begin Januari (CES) kunnen we misschien een glimp krijgen over het potentieel. Maar anders waarschijnlijk pas rondom de tijd van de E3.Dreifarben schreef op maandag 26 november 2018 @ 22:12:

Ik zat in het verkeerde topic, dus hier nieuwe poging

Hoe zit dat nu eigenlijk met de nieuwe GPU's die volgend jaar verwacht worden? Kunnen we inschatten hoe concurrentieel deze gaan zijn of is het nog te vroeg?

How do you save a random generator ?

Tja, lees stukjes hierboven. De ene zegt dat zeer waarschijnlijk over half jaar AMD iets heeft wat alles op zijn kop gooit en t/m mid-high end segment Nvidia compleet wegvaagt in prijs/kwaliteit. Ik ben wat skeptischerDreifarben schreef op maandag 26 november 2018 @ 22:12:

Ik zat in het verkeerde topic, dus hier nieuwe poging

Hoe zit dat nu eigenlijk met de nieuwe GPU's die volgend jaar verwacht worden? Kunnen we inschatten hoe concurrentieel deze gaan zijn of is het nog te vroeg?

Ik had bovenstaande post van @Verwijderd gemist, en tegen beter weten in wil ik toch op iets reageren.

Ik ben altijd nogal skeptisch over beloftes van foundries, in de praktijk is het vaak een leuke stap, maar niet zo groot als ze claimen. Maar klopt wel dat oppervlakte van puur de logica waarschijnlijk wel redelijk accuraat wordt voorspeld.Het is handig om dat wel te doen alvorens je een mening vormt want de prijs die AMD kan en zal vragen hangt samen met de oppervlakte van de die. Dit zou best wel eens een midlevel kaart kunnen worden met een diesize die ongeveer net zo groot is als de RX 580 dankzij de veel kleinere node en de nieuwe architectuur.

Nogmaals, de TSMC 7 nm. node is veel kleiner is dan de TSMC 12/14 NM node, niet een beetje kleiner. Dat is een onbetwistbaar feit, geen speculatie. We hebben het bewijs al gezien.

Jouw argumentatie heeft één probleem. Tien jaar geleden had je helemaal gelijk gehad. Want elke keer als Intel weer een nog grotere chip (in aantal transistoren) had gemaakt, kwam er een nieuwe technologie om de kosten te beperken. Maar zo werkt het tegenwoordig nauwelijks meer. De oppervlakte neemt wel af, maar de kosten per transistor weinig, omdat de kosten per oppervlakte omhoog schieten. Bijvoorbeeld van: https://www.icknowledge.c...20Nodes%20-%20Revised.pdf

Ook bijvoorbeeld van EEtimes (wel een ouder artikel al overigens):

https://www.eetimes.com/a...id=1326864&image_number=1

[ Voor 60% gewijzigd door Sissors op 27-11-2018 10:02 ]

Verwijderd

Tegen beter weten in?

Als jij iets zinvols zegt dan ben ik de eerste om je gelijk te geven.

Ik heb het even opgezocht, de RX 480 heeft een die die 232 mm² groot is, Ryzen heeft een die die 192 mm², Vega heeft een diesize van 486 mm². 486/232=2,09.

Laat de productiekosten van een even grote Vega $40-50 hoger zijn, dat maakt niet het grote verschil. Het is relevant maar er wordt dan ook een MSRP van $300 gemeld terwijl die voor de RX 480 nog $239 was, de kostenverhoging is al meegenomen en daar zit dan ook nog wat ruimte in voor het duurder geworden geheugen. Als je ergens een beer op de weg wil zien dan zou ik het eerder bij de prijs van het geheugen zoeken gezien de kartelvorming van Samsung, Hynix en Micron.

Aan ieder van ons om te bepalen in hoeverre wij dat geloven. Het sluit aan bij wat we al wisten:

- De nieuwe architectuur die AMD wou gebruiken (mogelijk aangepast) is bekend, iedereen van ons kan zelf het patent lezen aangezien patenten openbaar zijn en een aantal van ons (ik ook) hebben het gelezen. Dan weet je nog niet wanneer die gebruikt wordt maar dat er een nieuw architectuur wordt vermeld is dus niet gek.

- De timeline sluit aan bij wat andere geruchten meldden (WCCFTech).

- Technisch gezien is het zeker mogelijk om met zo'n diesize die performance te geven.

Als jij iets zinvols zegt dan ben ik de eerste om je gelijk te geven.

Dat klopt - de productiekosten zouden tot dubbel zo hoog kunnen worden in vergelijking met GF 14 nm, dat hebben wij hier inmiddels sinds minstens een jaar uitgebreid besproken, dat heeft vooral te maken met dat er meer lagen worden gebruikt , je ziet overigens in diezelfde grafiek dat de kosten per transistor wel lager liggen - maar er speelt meer dan enkel de productiekosten van de GPU. Die productiekosten zijn sowieos niet overweldigend hoog, zo kost een Ryzen-CPU waarschijnlijk minder dan $50 voor puur de productie. Het feit dat het vermogen zoveel lager ligt is ook heel erg belangrijk, voor zowel de kosten (de PCB rondom de GPU) als hoe goed het functioneert. Dat de die-area kleiner is leidt ook tot beter yields (als je 50% oppervlakte op TSMC 7 nm vergelijkt met 100% oppervlakte op GF 14 nm).Sissors schreef op dinsdag 27 november 2018 @ 09:39:

De oppervlakte neemt wel af, maar de kosten per transistor weinig, omdat de kosten per oppervlakte omhoog schieten.

Ik heb het even opgezocht, de RX 480 heeft een die die 232 mm² groot is, Ryzen heeft een die die 192 mm², Vega heeft een diesize van 486 mm². 486/232=2,09.

Laat de productiekosten van een even grote Vega $40-50 hoger zijn, dat maakt niet het grote verschil. Het is relevant maar er wordt dan ook een MSRP van $300 gemeld terwijl die voor de RX 480 nog $239 was, de kostenverhoging is al meegenomen en daar zit dan ook nog wat ruimte in voor het duurder geworden geheugen. Als je ergens een beer op de weg wil zien dan zou ik het eerder bij de prijs van het geheugen zoeken gezien de kartelvorming van Samsung, Hynix en Micron.

De geruchten staan hier vermeld: Verwijderd in "CJ's AMD Radeon Info & Nieuwsdiscussietopic - Deel 143"Dreifarben schreef op maandag 26 november 2018 @ 22:12:

Ik zat in het verkeerde topic, dus hier nieuwe poging

Hoe zit dat nu eigenlijk met de nieuwe GPU's die volgend jaar verwacht worden? Kunnen we inschatten hoe concurrentieel deze gaan zijn of is het nog te vroeg?

Aan ieder van ons om te bepalen in hoeverre wij dat geloven. Het sluit aan bij wat we al wisten:

- De nieuwe architectuur die AMD wou gebruiken (mogelijk aangepast) is bekend, iedereen van ons kan zelf het patent lezen aangezien patenten openbaar zijn en een aantal van ons (ik ook) hebben het gelezen. Dan weet je nog niet wanneer die gebruikt wordt maar dat er een nieuw architectuur wordt vermeld is dus niet gek.

- De timeline sluit aan bij wat andere geruchten meldden (WCCFTech).

- Technisch gezien is het zeker mogelijk om met zo'n diesize die performance te geven.

[ Voor 75% gewijzigd door Verwijderd op 27-11-2018 12:58 ]

Het ziet er zeer hoopvol uit voor het algemene succes van AMD, ik hoop dat het gaat uitkomen want dit laat wel zien dat AMD ondanks zijn uitdagingen toch zeer innoverend en vooruitstrevend kan zijn.

Verwijderd

HBM en TrueAudio was bijvoorbeeld ook zeer innoverend, daar heeft het nooit aan gelegen bij AMD. Zelf vind ik vooral TrueAudio geweldig (conceptueel gezien en omdat ik een audiofiel ben), ik zou graag zien dat dit nog veel verder uitgewerkt wordt en standaard gebruikt wordt. Zo gauw ik een Navi-kaart heb ga ik eens Thief kopen (bij de eerste de beste goede sale).Phuncz schreef op vrijdag 30 november 2018 @ 17:46:

Het ziet er zeer hoopvol uit voor het algemene succes van AMD, ik hoop dat het gaat uitkomen want dit laat wel zien dat AMD ondanks zijn uitdagingen toch zeer innoverend en vooruitstrevend kan zijn.

[ Voor 3% gewijzigd door Verwijderd op 30-11-2018 18:15 ]

Wat een topvideo.Verwijderd schreef op vrijdag 30 november 2018 @ 17:25:

Speculatie van AdoredTV over de plannen van AMD.

[YouTube: AMD - The (Evolving) Master Plan]

Ongelooflijke geniale gedachte op 47:30.

Verwijderd

Meerdere geheugen-controllers op die I/O-die. Ja, dat is geen gek idee. Het kost niet heel erg veel om dat te doen (GF 14 nm.) maar je kan op die manier wel alles erop aansluiten en wanneer je wil meerdere vormen van geheugen. Dus GDDR6 voor de lage klasse Navi, HBM voor de grote broer en HBM/GDDR6+DDR4 voor de APU's zodat het grafische deel een apart stuk geheugen krijgt wat vlak daarnaast op de chip zit. Met de schaalverkleining naar TSMC 7 nm. komt er veel ruimte vrij (ze zouden iets meer dan 100 mm 2 kunnen gebruiken als ze de GPU hetzelfde performanceniveau geven en met 4 CPU-kernen werken), meer dan genoeg om 4 GB HBM kwijt te kunnen. GDDR6 zou dan weer interessant zijn voor de consoles aangezien je bij de consoles niet beperkt bent tot het kleine oppervlakte van een CPU-socket.Saturnus schreef op zondag 2 december 2018 @ 19:18:

[...]

Wat een topvideo.

Ongelooflijke geniale gedachte op 47:30.

Uhm...MC's zijn juist wel duur om te bakken. Die krengen zijn in verhouding tot wat ze doen vrij groot.Verwijderd schreef op zondag 2 december 2018 @ 21:51:

Het kost niet heel erg veel om dat te doen (GF 14 nm.)

Met de MC zelf ben je er ook nog niet, want je moet ook de fysieke interfaces hebben en dan wordt het pas echt leuk. Knal je meerdere MC's in die chip, moet je ook daar op voor bereid zijn.

Ter illustratie presenteer ik u een Raven Ridge (Ryzen 3 2300U), via Wikichip:

En een enkele Zeppelin:

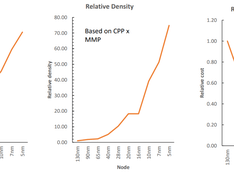

Of een GPU, in dit geval Polaris omdat daar een mooie schematische afbeelding van bestaat (klik voor volledig formaat):

Het is geen echte die-shot, maar daarom juist ook mooi om te gebruiken. Zie je links, boven en onder die regelmatige blokken? Telkens een blokje van 4 kleinere blokjes, samen met iets wat zelf wel een processor lijkt? Dat zijn de GDDR PHY blokken. Er zijn er 8.

Rechtsboven zit waarschijnlijk de display I/O, rechtsonder de PCIe PHY.

Vergelijk nu het benodigde oppervlak van dit alles eens met de gehele GPU?

Het kan zeker wel, maar dan wordt het ook een vrij complexe chip die dan ook geschikt moet zijn voor al die verschillende geheugen implementaties. De fysieke kant van dat verhaal wordt lastig als je GDDR en HBM naast elkaar wil hebben. Ik reken er persoonlijk eerlijk gezegd niet op, ik denk dat dat het niet waard is, vooral vanwege de fysieke connecties

Edit: even m'n beste Paint skills toegepast

Rood = GDDR PHY, geel = display I/O, blauw = PCIe

Die laatste twee kan ik best fout mee zitten. Mijn gok is vooral gebaseerd op hoe ze er uit zien; rechtsboven is deels onregelmatig, deels regelmatig. Het regelmatige deel (rechts) vermoed ik dat de controllers zijn, links zitten de klokgenerators en dergelijke.

[ Voor 11% gewijzigd door Werelds op 03-12-2018 11:01 ]

Verwijderd

Op basis van dit citaat.sdk1985 schreef op maandag 3 december 2018 @ 01:55:

Met andere woorden; Nvidia had verwacht door wat stock achter te houden dat het probleem zichzelf zou oplossen. Alleen dat gaat trager dan verwacht omdat AMD tegelijkertijd 5x zoveel RX 580's de keten in pompt. Nu kan het twee kwartalen duren voor de stock op is. Impliciet geeft dit aan dat dit wellicht ook twee kwartalen vertraging geeft aan de 2060.

Ik denk dat je die 10/90 en 50/50 niet al te serieus moet nemen (AMD had 25-30% van de markt) maar als illustratie moet zien. Maar goed, als het klopt dat AMD meer kaarten heeft verkocht na het crashen van die crypto'currencies' dan wijst dat er ook op dat ze tijdens die crypto-hype bewust de voorraad beperkten zoals hier werd gesuggereerd door meerdere mensen: om te voorkomen dat de tweedehands markt al te groot zou worden na het ineenstorten en dat is deze keer inderdaad niet gebeurd, in ieder geval in Nederland afgaande op het aanbod en de prijzen.Huang: Take a moment — let me just — the 1060 is the number one selling GPU in the world, and the 580 is the number 24. The gaming demand is such that the 580 demand is relatively small. If they decide to build a whole bunch of GPUs, 580s, for crypto, and then they shove that into the channel, then the market would be disproportionate, to us. Usually we would see — call it 90 percent us and 10 percent them. Now all of sudden the inventory in the channel could be very different. It could be 50 percent them and 50 percent us. Do you see what I’m saying? But there are so many people writing about inventories, Dean. Why waste your life on it?

Ook maar eens gekeken dan. Tja, ik geloofde geen seconde wat voor werd gesteld voor de GPU's en @Werelds somt al aardig een aantal redenen op waarom het niet zomaar gaat gebeuren. Vervolgens zie ik de economische winst van het voorstel ook niet. Waarom zou je een aparte GPU chiplet ontwikkelen en deze combineren met een controlechip die zowel GDDR6 als HBM2 doet? Het gaat om twee producten voor twee markten met andere volumes en eisen. Als je een beetje oplet wat AMD nu doet, dan zie je dat AMD de splitsing tussen HPC en gaming eigenlijk al heeft gemaakt.

AMD kan gewoon een flinke monolithische GPU ontwikkelen voor de HPC markt met een HBM2 controller, zie Vega 20 bijvoorbeeld. Maar Vega 20 is denk ik pas het begin. Die kaarten ondersteunen xGMI en kunnen in clusters van 2x4 GPU's opereren met 200GB/s bandbreedte. Het is een HPC product waardoor je alle rekenkracht zal kunnen gebruiken die de GPU's bieden, en schaling tot en met acht Vega 20's zou uitstekend zijn. De implicatie lijkt me duidelijk. Vega 20 is eindelijk een serieuze instap in de HPC markt met een specifiek product. Het is een onderdeel van AMD haar instap in de wereld van supercomputers en AI. De strategie van AMD is die instap maken met clusters van kleinere, maar krachtige chips die over uitstekende chip naar chip communicatie beschikken. Daar kan AMD op termijn met een Epyc Rome achtige MCM komen voor een eigen supercomputer ontwerp samen met Epyc CPU's. Denk bijvoorbeeld aan een concurrent voor Nvidia haar DGX1. Ik vermoed zo dat de semi-custom divisie van AMD daar mee bezig is.

Navi en "Next Gen" zie ik juist de andere kant op gaan. Zeer weinig developers die uberhaupt interesse hebben in goede Crossfire/SLI ondersteuning, laat staan multi GPU ondersteuning in DX12. Daar gaat gewoon geen MCM komen. Het is ook een andere markt met veel grotere volumes, en veel lagere marges. Er is dus weinig ruimte voor exotische ontwerpen. Voor deze markt is het technisch mogelijk om bepaalde zaken in chipletvorm te produceren, maar niet de chiplets van Zen 2 met een centrale controlechip. Nee, ik zou eerder denken aan Intel haar EMIB. Een centrale GPU chiplet en de I/O, geheugencontrollers en PCI erom heen in aparte chiplets. AMD kan het waarschijnlijk zelfs zonder interposer wat weer kosten scheelt. Dat zal het weer aantrekkelijker maken voor mainstream GPU's waar de marges toch al klein zijn.

AMD kan gewoon een flinke monolithische GPU ontwikkelen voor de HPC markt met een HBM2 controller, zie Vega 20 bijvoorbeeld. Maar Vega 20 is denk ik pas het begin. Die kaarten ondersteunen xGMI en kunnen in clusters van 2x4 GPU's opereren met 200GB/s bandbreedte. Het is een HPC product waardoor je alle rekenkracht zal kunnen gebruiken die de GPU's bieden, en schaling tot en met acht Vega 20's zou uitstekend zijn. De implicatie lijkt me duidelijk. Vega 20 is eindelijk een serieuze instap in de HPC markt met een specifiek product. Het is een onderdeel van AMD haar instap in de wereld van supercomputers en AI. De strategie van AMD is die instap maken met clusters van kleinere, maar krachtige chips die over uitstekende chip naar chip communicatie beschikken. Daar kan AMD op termijn met een Epyc Rome achtige MCM komen voor een eigen supercomputer ontwerp samen met Epyc CPU's. Denk bijvoorbeeld aan een concurrent voor Nvidia haar DGX1. Ik vermoed zo dat de semi-custom divisie van AMD daar mee bezig is.

Navi en "Next Gen" zie ik juist de andere kant op gaan. Zeer weinig developers die uberhaupt interesse hebben in goede Crossfire/SLI ondersteuning, laat staan multi GPU ondersteuning in DX12. Daar gaat gewoon geen MCM komen. Het is ook een andere markt met veel grotere volumes, en veel lagere marges. Er is dus weinig ruimte voor exotische ontwerpen. Voor deze markt is het technisch mogelijk om bepaalde zaken in chipletvorm te produceren, maar niet de chiplets van Zen 2 met een centrale controlechip. Nee, ik zou eerder denken aan Intel haar EMIB. Een centrale GPU chiplet en de I/O, geheugencontrollers en PCI erom heen in aparte chiplets. AMD kan het waarschijnlijk zelfs zonder interposer wat weer kosten scheelt. Dat zal het weer aantrekkelijker maken voor mainstream GPU's waar de marges toch al klein zijn.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik zie die relatie eigenlijk totaal niet. De meest logische verklaring blijft dat er sprake was van een beperkte oplage en het dus rendabeler was om deze direct aan grote partijen te slijten. Waarom zou het 'feit' dat AMD nu meer RTX 580's de retail keten in pusht betekenen dat ze in het verleden de productie beperkt hebben, laat staan voor de hele specifieke angst dat de tweede hands markt te groot zou worden?Verwijderd schreef op maandag 3 december 2018 @ 12:45:

[...]

Op basis van dit citaat.

[...]

Ik denk dat je die 10/90 en 50/50 niet al te serieus moet nemen (AMD had 25-30% van de markt) maar als illustratie moet zien. Maar goed, als het klopt dat AMD meer kaarten heeft verkocht na het crashen van die crypto'currencies' dan wijst dat er ook op dat ze tijdens die crypto-hype bewust de voorraad beperkten zoals hier werd gesuggereerd door meerdere mensen: om te voorkomen dat de tweedehands markt al te groot zou worden na het ineenstorten en dat is deze keer inderdaad niet gebeurd, in ieder geval in Nederland afgaande op het aanbod en de prijzen.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

https://wccftech.com/amd-pledges-to-take-on-nvidias-high-end-turing-with-7nm-radeon-gpus-in-2019/

"AMD CEO Lisa Su – Nov 27, 2018 – 22nd Annual Credit Suisse Technology, Media & Telecom Conference

“We believe, we will be very competitive overall and that includes the high-end of the GPU market. Obviously there are new products out there from our competition. We will have our set of new products as well and we will be right there in the mix”

“As it relates to ray tracing in particular I think it’s an important technology, but as with all important technologies it takes time to really have the ecosystem adopt [it]. And we’re working very closely with the ecosystem on both hardware and software solutions and expect that ray tracing will be an important element especially as it gets more into the mainstream, frankly, of the market.”

– Transcripted by Wccftech.com"

"AMD CEO Lisa Su – Nov 27, 2018 – 22nd Annual Credit Suisse Technology, Media & Telecom Conference

“We believe, we will be very competitive overall and that includes the high-end of the GPU market. Obviously there are new products out there from our competition. We will have our set of new products as well and we will be right there in the mix”

“As it relates to ray tracing in particular I think it’s an important technology, but as with all important technologies it takes time to really have the ecosystem adopt [it]. And we’re working very closely with the ecosystem on both hardware and software solutions and expect that ray tracing will be an important element especially as it gets more into the mainstream, frankly, of the market.”

– Transcripted by Wccftech.com"

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

>20:50.

Mocht het waar zijn, of er dicht bij in de buurt komen, dan is AMD 'minder ver weg' dan het nu lijkt.

Performance/watt verbeteringen van 2,5 à 3 maal tegenover AMD's huidige kaarten en prijs/prestatie verbeteringen van ook zo'n 2,5 maal tegenover de huidige kaarten van nVidia en AMD lijkt mij niet echt realistisch.

7nm, chiplets en NAVI, waarschijnlijk een architectuur puur gericht op gamen.Verwijderd schreef op woensdag 5 december 2018 @ 00:00:

Performance/watt verbeteringen van 2,5 à 3 maal tegenover AMD's huidige kaarten en prijs/prestatie verbeteringen van ook zo'n 2,5 maal tegenover de huidige kaarten van nVidia en AMD lijkt mij niet echt realistisch.

Dat kan dit behoorlijke verschil t.o.v. het huidige aanbod verklaren. D.m.v. de chiplet aanpak zijn de chips aanzienlijk goedkoper geworden om te produceren. Dit komt voornamelijk door het steeds complexer worden van de productieprocessen en daarbij is het steeds minder interessant geworden om een monolitische chip te produceren t.b.v. productiekosten. Het is een hele andere aanpak en kan een drastische vooruitgang verklaren samen met 7nm en een nieuwe architectuur.

Tja, de perf/watt verbeteren over Polaris/Vega is niet zo moeilijk. De boel niet extreem overvolten helpt al enorm. Daarnaast schijnt de GGDR5 geheugencontroller van Polaris niet bepaald efficiënt te zijn. Daar zit met de overstap naar GDDR6 waarschijnlijk ook al flink wat winst. Blijkt Navi geen GCN meer te zijn, maar een efficiëntere nieuwe GPU architectuur dan mag je ook wel een flinke stap verwachten. GCN is uiteindelijk een in vroeg 2012 geïntroduceerde architectuur waar maar weinig aan verbeterd is.

Overigens zou de naamgeving wel weer typisch AMD zijn.

RX 3080

RX 3070

RX 3060

Zet dat eens af tegen:

RTX 2080

RTX 2070

RTX 2060

Overigens zou de naamgeving wel weer typisch AMD zijn.

RX 3080

RX 3070

RX 3060

Zet dat eens af tegen:

RTX 2080

RTX 2070

RTX 2060

[ Voor 12% gewijzigd door DaniëlWW2 op 05-12-2018 01:44 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Mocht het waar zijn, dan heb ik een 3700X volgend jaar.Saturnus schreef op dinsdag 4 december 2018 @ 23:39:

[YouTube: Ryzen 3000, Radeon 3000 Series LEAKS - It's Game On!]

>20:50.

Mocht het waar zijn, of er dicht bij in de buurt komen, dan is AMD 'minder ver weg' dan het nu lijkt.

3 maal? Hoe kom je daar nou bij?Verwijderd schreef op woensdag 5 december 2018 @ 00:00:

Performance/watt verbeteringen van 2,5 à 3 maal tegenover AMD's huidige kaarten en prijs/prestatie verbeteringen van ook zo'n 2,5 maal tegenover de huidige kaarten van nVidia en AMD lijkt mij niet echt realistisch.

Zet een Vega 64 op 1000 of 1050mv en je zit al bijna op 200W zonder prestaties te verliezen. Zo unrealistisch is dat dus zeker niet.

[ Voor 37% gewijzigd door DoubleYouPee op 05-12-2018 10:01 ]

Hoe ik daar bij kom? Het staat er gewoon, reken maar na.

Een RX 580 van ~225W terug brengen naar 75W zodat er geen PEG connector nodig is, is nu eenmaal een factor drie.

En ja natuurlijk kun je winst halen door de spanning te verlagen en en ook de kloksnelheid te verlagen. Qua performance/watt helpt dat heel veel. Klokfrequentie is immers linear met verbruik en spanning zelfs kwadratisch. Maar voor AMD is hogere kloksnelheid veel interessanter, want daarmee kun je je product een hogere prijs geven en dus met meer winst verkopen.

Een RX 580 van ~225W terug brengen naar 75W zodat er geen PEG connector nodig is, is nu eenmaal een factor drie.

En ja natuurlijk kun je winst halen door de spanning te verlagen en en ook de kloksnelheid te verlagen. Qua performance/watt helpt dat heel veel. Klokfrequentie is immers linear met verbruik en spanning zelfs kwadratisch. Maar voor AMD is hogere kloksnelheid veel interessanter, want daarmee kun je je product een hogere prijs geven en dus met meer winst verkopen.