Klinkt voor mij als vooruitgang waarbij in een klap alle oude GPUs ouderwets gaan wordenVerwijderd schreef op dinsdag 4 september 2018 @ 15:21:

bij DLSS wil ik eerst afwachten of dat het wel of niet grafische defecten geeft. Als en slechts dan als DLSS geen grafische defecten geeft bij upscaling is het fair om Nvidia met DLSS te testen vs. AMD zonder.

In het kort: die features mogen naar mijn mening standaard aan zijn als je grafisch dezelfde of betere performance hebt en de FPS speelbaar is.

Inmiddels speculeer ik dat Nvidia die DLSS ook wil gebruiken om met een lagere resolutie AA toe te passen en dat dan met die 'AI' te upscalen naar een hogere resoltuie (dat ligt in lijn met dat Nvidia en AMD al een tijdje te optie geven om bij kleinere figuren (afstand) de resolutie voor AA te verlagen), dat is Prima als het goed werkt maar dat wacht ik eerst nog even af, op dit moment hebben we enkel de cijfers die Nvidia gaf, geen plaatjes.

Helaas mogen ze er nog niet (gedetailleerd) over berichten i.v.m. de NDA, maar werkelijk iedere website (Anandtech, HotHardware, Guru3D, LegitReviews, GamersNexus, ...) die een artikel heeft geplaatst na het zien van 1 of meerdere live demo(s) is positief. Zoals altijd zullen plaatjes moeten aantonen hoe of wat, maar ik denk dat de kracht van DLSS echt zwaar door jullie wordt onderschat.

[ Voor 5% gewijzigd door Paprika op 04-09-2018 18:20 ]

Wil beter begrijpen hoe dat neural network getrained word en of dit ook in Multi player games goed werkt.

In die demo is het dan weer jammer dat ze een 1080Ti met een 2080Ti vergelijken.

Had dan een een 2080Ti met en zonder DLSS neergezet.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

YouTube: Real Time Ray Tracing from a Smartphone GPU - 6 GIGARAYS

Ik weet niet waar je die 6 Gigarays vandaan haalt, maar de daar gelinkte PowerVR chip haalt 300 miljoen ray's/sec tegenover de volgens mij 6 miljard die 6 Gigaray's/sec zouden moeten zijn.Nature schreef op dinsdag 4 september 2018 @ 18:54:

Kan AMD niet een simpele chip toevoegen voor raytracing? Een mid-end PowerVR mobile GPU kan ook 6 gigarays doen schijnt het.

YouTube: Real Time Ray Tracing from a Smartphone GPU - 6 GIGARAYS

https://www.imgtec.com/blog/powervr-gr6500-ray-tracing/

The first member of the Wizard family is PowerVR GR6500. This ray tracing processor is based on a latest generation, quad-cluster PowerVR Rogue design, with all the bells and whistles of our recently-launched PowerVR Series6XT GPU processors, including:

Full-blown graphics and compute performance: four Unified Shading Clusters (USCs), with 128 ALU cores delivering more than 150 GFLOPS (FP32) or 300 GFLOPS (FP16) at 600 MHz

Unmatched real-world ray tracing performance: Up to 300 MRPS (million rays per second), 24 billion node tests per second and 100 million dynamic triangles per second at 600 MHz

PowerGearing G6XT for advanced power management and dynamic resource allocation

PVR3C™ triple compression technologies (PVRTC and ASTC for texture compression, PVRIC for frame buffer compression, PVRGC for geometry compression)

Deep Color support for very high image quality at Ultra HD resolutions and beyond

PowerVR GR6500 is designed to provide leading support for a range of APIs such as OpenGL ES 3.1/2.0/1.1, OpenGL 3.x, Direct3D 11 Level 10_0, OpenCL 1.2, and OpenRL 1.x.

Het nut is de toegenomen rekenkracht de rest is altijd mooi meegenomen maar we weten allemaal dat 9 van de 10 keer met de ideeën in de praktijk weinig gebeurd. Bij pascal zat een sloot features waar ik persoonlijk nooit of zelden gebruik van heb gemaakt (denk aan Ansel en aan die viewport angles). De performance spreekt echter voor zich.Astennu schreef op maandag 3 september 2018 @ 18:08:

[...]

Ik zeg toch nergens dat DLSS negatief is?

Dat is imo het enige echt nuttige nieuwe aan de hele nieuwe serie van nVidia. RT kan je niet eens op 1080p gebruiken omdat het te zwaar is. (onder de 60fps is voor mij een no go).

Dus goede AA is zeker een voordeel maar ik heb zelf liever een hoge FPS met een beetje AA dan super goede AA en shitty FPS dus SSAA gebruik ik bv nooit.

Wat de prestaties precies worden is afwachten. Mijn voorspelling was 35% indexatie waarde (dus 54% omgekeerd). Meer is altijd mooi meegenomen maar gezien de afwezigheid van AMD in high-end is daar weinig reden toe. Ondertussen heeft Nvidia natuurlijk wel wat slides gepubliceerd die het e.e.a. impliceren. Verder lijken de prijzen flink hoger te liggen. Wat dat betreft heeft Nvidia heel wat speelruimte om verder te gaan dan die 35%, dat zou immers de hogere prijs dan 'verantwoorden'. Nog een paar weken geduld en dan zal er ongetwijfeld een review op techpowerup verschijnen.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Verwijderd

Ik onderschat het niet maar het probleem is dat het slechts gaat om demo's die al dan niet cherrypicked zijn. DLSS is een goede nieuwe hardware/software toepassing maar bij zoiets radicaal nieuws krijg je ook gemakkelijk kinderziektes. We hebben bij de raytracing, waarbij een soort van AI wordt gebruikt die wellicht vergelijkbaar is met wat voor DLSS wordt gebruikt, gezien dat er nog best serieuze gebreken zijn met onrealistische licht-effecten. Ik wil eerst even zien of dat dat bij DLSS niet het geval is.Paprika schreef op dinsdag 4 september 2018 @ 18:18:

[...]

Klinkt voor mij als vooruitgang waarbij in een klap alle oude GPUs ouderwets gaan worden. Laten we even kijken naar wat we in ieder geval weten: genoeg mensen uit de press zijn skeptisch over raytracing, echter geen enkele website heeft ook maar 1 negatieve vermelding gemaakt wat betreft DLSS, sterker nog, de meesten zijn extreem positief en iedere press bezoeker heeft toegang gehad tot exclusieve hands-on demos zoals:

[video]

Helaas mogen ze er nog niet (gedetailleerd) over berichten i.v.m. de NDA, maar werkelijk iedere website (Anandtech, HotHardware, Guru3D, LegitReviews, GamersNexus, ...) die een artikel heeft geplaatst na het zien van 1 of meerdere live demo(s) is positief. Zoals altijd zullen plaatjes moeten aantonen hoe of wat, maar ik denk dat de kracht van DLSS echt zwaar door jullie wordt onderschat.

Ik wacht in spanning op een uiteenzetting van David Kanter wanneer de dieshots bekend zijn en het is opgehelderd hoe het precies werkt.

Zou het dan zin hebben als AMD dat voor Navi al zou doen?Nature schreef op dinsdag 4 september 2018 @ 18:54:

Kan AMD niet een simpele chip toevoegen voor raytracing? Een mid-end PowerVR mobile GPU kan ook 6 gigarays doen schijnt het.

YouTube: Real Time Ray Tracing from a Smartphone GPU - 6 GIGARAYS

Los van de vraag of dat het mogelijk is als dat niet gepland was door AMD. Zoals Asten aangaf, dit is vooral voor de developers zodat die kunnen leren hoe je die nieuwste middelware van Nvidia gebruikt, voor de meeste gamers die een Nvidia-kaart gebruiken is het naar mijn inschatting minstens voor de komende 3 jaar niet interessant (te lage FPS, teveel defecten). Tegen de tijd dat een *60 kaart van Nvidia het kan met >60 FPS en geloofwaardig licht wordt het leuk.

[ Voor 26% gewijzigd door Verwijderd op 04-09-2018 22:04 ]

DLSS en raytracing werken in z'n geheel anders, waarbij de laatste niets met deep learning te maken heeft. Toen de eerste keer tijdens de presentatie deep learning en machine learning werden genoemd moest ik een beetje grinneken (oh jee, weer een partij die de hype termen misbruikt), maar na de uitleg hoe en wat klopt het wel. Gezien de machine die NVIDIA gebruikt voor het hun deeplearning techniek acht ik de kans zeer klein dat hier onrealistische effecten uit gaan komen. Raytracing is nog altijd een berekening. DLSS is dat eigenlijk niet en meer een aanname op basis van een zeer intensief getraind model. Ik denk dat het samengevat erop neer komt dat ze een zeer hoge resolutie renderen, dan een lage resolutie en deze blijven verbeteren totdat ie heel veel op de ultieme variant lijkt. Dit blijven ze doen totdat het 'altijd' een goede benadering is en de 'waarden' die het algoritme gebruikt zijn dan per game verschillend.Verwijderd schreef op dinsdag 4 september 2018 @ 21:59:

[...]

We hebben bij de raytracing, waarbij een soort van AI wordt gebruikt die wellicht vergelijkbaar is met wat voor DLSS wordt gebruikt, gezien dat er nog best serieuze gebreken zijn met onrealistische licht-effecten. Ik wil eerst even zien of dat dat bij DLSS niet het geval is.

Uiteraard mag je skeptisch zijn, maar voor het eerst sinds de announcement van Eyefinity zie ik nieuwe tech in GPU land waarbij ik zelf alles behalve skeptisch ben over de toegevoegde waarde en de potentiële accuraatheid. De vraag die ik heb is hoeveel games ze gaan uitrollen hiermee op de lange termijn, vooral de niet-AAA titels en of partijen als Blizzard bij ze gaan aankloppen voor al hun veel gespeelde 'legacy' games.

Voor mij geldt dat de performance benchmarks niet eens meer zo relevant zijn, als NVIDIA inderdaad veel R&D tijd hierin heeft gestoken over de jaren heen en ze het nu "release ready" vinden (er was al ruim een jaar geleden een live demo van het concept door 2 mannen die al heel lang een R&D functie hebben bij NVIDIA) dan kan dit wel eens voor een grote beweging gaan zorgen in de industrie en ik kan dan ook bijna niet wachten om dit zelf eens uit te proberen. Dit zou, bij een positief resultaat, tevens het bewijs zijn dat NVIDIA haar strategie over de laatste jaren de juiste was en dat gaat hun stock nogmaals explosief groeien.

Sinds de announcement is het bedrijf nog eens 30 miljard meer waard geworden op de beurs en dat is niet geteld vanaf het dal maar vanaf hun vorige hoogste piek ooit en die stijging is meer dan AMD haar huidige marktwaarde...

576 Tensor cores, 72 RT cores...The new GeForce RTX 2080 Ti, 2080 and 2070 GPUs are packed with features never before seen in a gaming GPU, including:

• New RT Cores to enable real-time ray tracing of objects and environments with physically accurate shadows, reflections, refractions and global illumination.

• Turing Tensor Cores to perform lightning-fast deep neural network processing.

• New NGX neural graphics framework integrates AI into the overall graphics pipeline, enabling AI algorithms to perform amazing image enhancement and generation.

ComputerBase over de handson opstelling:

In addition, ComputerBase had the opportunity to take a look at the new DLSS deep-learning super-sampling. So a comparison system was set up, which showed the infiltrator demo of Epic. On one monitor was the demo with the classic TAA, on the other with the new DLSS. And indeed, the result with DLSS looked much better - in two ways.

At first, the anti-aliasing itself was much better. The TAA treated some edges very well in the demo, but some less, so the picture flickers. With DLSS, however, the edges are almost always better smoothed, so the picture appears calmer. In addition, the demo with TAA loses a bit of sharpness. The problem does not show up with DLSS. And last but not least there are smaller picture elements that are no longer displayed correctly with TAA, but with DLSS already. Finally, the DLSS in Epic's Infiltrator demo is visibly better than the Temporal Anti-Aliasing. Whether DLSS looks better in current games, however, has yet to show.

[ Voor 74% gewijzigd door Paprika op 04-09-2018 22:43 ]

[ Voor 30% gewijzigd door Help!!!! op 05-09-2018 18:27 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Ik blijf nu twijfelen maar ga toch beginnen de knoop door te hakken. Heb een amd freesync scherm en zoek dus in de richting van AMD maar ik hoor telkens dat die kaarten erg warm worden, zeker de gygabite versie. Deze staat nu echter aan 470 euro op caseking. Is die warmte nu echt een probleem of zou ik er gewoon voor moeten gaan?

Worden schrijvers betaald per woord?

Met wat undervolten en een goeie airflow vind het eigenlijk heel erg meevallen. Heb een lekke radiator dus heb de luchtkoeler er weer terug geplaatst maar heb nog niet echt de neiging gehad om de watercooling weer in elkaar te zetten.Larmoth schreef op woensdag 5 september 2018 @ 19:57:

https://www.caseking.de/g...192-mb-hbm2-gcgb-222.html

Ik blijf nu twijfelen maar ga toch beginnen de knoop door te hakken. Heb een amd freesync scherm en zoek dus in de richting van AMD maar ik hoor telkens dat die kaarten erg warm worden, zeker de gygabite versie. Deze staat nu echter aan 470 euro op caseking. Is die warmte nu echt een probleem of zou ik er gewoon voor moeten gaan?

Wauw, mooi prijsje! Zag dat de 56 varianten ook weer goed geprijsd waren bij Caseking.Larmoth schreef op woensdag 5 september 2018 @ 19:57:

https://www.caseking.de/g...192-mb-hbm2-gcgb-222.html

Ik blijf nu twijfelen maar ga toch beginnen de knoop door te hakken. Heb een amd freesync scherm en zoek dus in de richting van AMD maar ik hoor telkens dat die kaarten erg warm worden, zeker de gygabite versie. Deze staat nu echter aan 470 euro op caseking. Is die warmte nu echt een probleem of zou ik er gewoon voor moeten gaan?

Ben wel benieuwd hoe de gigabyte 64 zich verhoudt tot de Asus Strix, over de gigabyte ook geen hele goeie dingen gehoord.

[ Voor 39% gewijzigd door DoubleYouPee op 05-09-2018 22:22 ]

Dit is ook nog mijn struikelblok. Overal reviews te vinden en allemaal eigen mening. Had graag eens ervaringsdeskundigen op tweakers gehoordDoubleYouPee schreef op woensdag 5 september 2018 @ 22:17:

Aardige deal inderdaad, helemaal nu de goeie varianten (powercolor en sapphire) weer 100 euro duurder zijn en casekings wel naar NL verstuurd.

Ben wel benieuwd hoe de gigabyte 64 zich verhoudt tot de Asus Strix, over de gigabyte ook geen hele goeie dingen gehoord.

Deze review in het ervaringen topic is wel erg goed, helaas staat daar de Gigabyte daar niet bij:Larmoth schreef op woensdag 5 september 2018 @ 22:34:

[...]

Dit is ook nog mijn struikelblok. Overal reviews te vinden en allemaal eigen mening. Had graag eens ervaringsdeskundigen op tweakers gehoord

YouTube: FIGHT! RX Vega 64 Nitro vs Red Devil vs Strix vs reference!

Maar van wat ik gehoord heb is deze niet beter dan de Asus.

Jammer dat ze met een i7 7700k testen. Had liever gezien dat ze een R5 2600x of een i7 8700k hadden gepakt. Het zal misschien niet in elk spel uitmaken maar ze wilen generational performance zien. Als er dan een bottleneck ergen zit en je kan die weghalen met een snellere cpu dan had ik dat gedaan.

Verwijderd

Crysis3 kan nog steeds niet met de maximale grafische instellingen worden gedraaid met een Vega64 kaart als je de FPS boven de 60 wil houden. Wanneer komt de dag dat het wel kan?

Ik vind die FPS vooral veel te variabel, dat is misschien nog wat hinderlijker dan dat die zo laag zakt. Ik merk dat bij mijn eigen grafische kaart ook wanneer ik dit spel speel. Sommige spellen slagen er goed in om de FPS ongeveer constant te houden zonder VSync te gebruiken of het naar boven toe te begrenzen met een maximum, Crysis is een van die spellen waarbij dat niet lukt (tessellation van water onder de grond en zo?).

In dit specifieke geval omdat hij graag alles uitgebreid toelicht zodat mensen niet hoeven te speculeren hoe het werd getest en waarom (afwegingen, motieven...) op deze manier werd getest. Wellicht ook om zich preventief in te dekken tegen kritiek die later komt. Je hoeft niet alles te lezen, je kan ook direct naar de grafiekjes kijken. Het is veel meer een probleem dat het op zoveel pagina's staat terwijl het ook op 1 pagina zou passen maar dat heeft blijkbaar met advertentie-inkomsten te maken.Olaf van der Spek schreef op woensdag 5 september 2018 @ 20:05:

[...]

Worden schrijvers betaald per woord?Zoveel data die best in een tabel zou kunnen wordt keer op keer uitgeschreven. Geldt ook voor Tweakers nieuwsberichten eigenlijk.

Voor zo ver ik het begrijp doet Kyle Bennet dit tegenwoordig slechts als hobby. Het is niet zo relevant of dat nieuwsberichten uitgebreid zijn of niet, het gaat erom of dat ze met minder woorden dezelfde informatie zouden kunnen geven. Ik ben het wel met jou eens dat het weinig zin heeft om in woorden op te schrijven wat je ook in tabellen kan lezen.

[ Voor 72% gewijzigd door Verwijderd op 06-09-2018 06:43 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

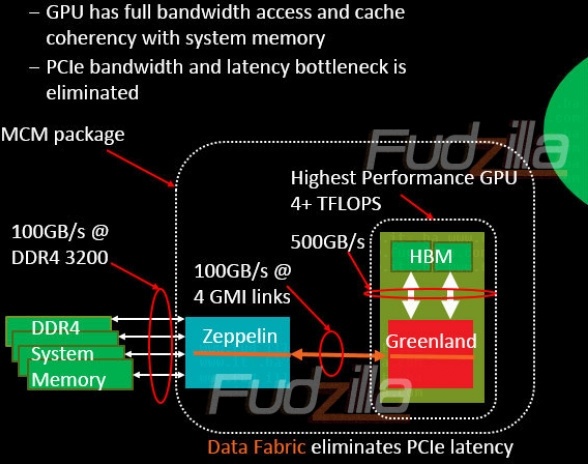

Dus inderdaad toch dat Gen-Z geen tegenhanger van NVlink is omdat het veel meer kan. xGMI is dus de directe tegenhanger.

Nu terug de vega 64 voor 589.65.

Twijfelen ..tussen?Larmoth schreef op donderdag 6 september 2018 @ 17:58:

Ah man ik ga blijven twijfelen hahaha

Nu terug de vega 64 voor 589.65.

Verwijderd

[ Voor 3% gewijzigd door Verwijderd op 07-09-2018 15:30 ]

Verwijderd

De vruchten van de AMD console hardware ?Verwijderd schreef op vrijdag 7 september 2018 @ 13:59:

Interessante onthulling: bij een Ubisoft-demo van Assassin's Creed werd een 100% AMD-computer gebruikt. Zouden AMD en Ubisoft stiekem intensief zijn gaan samenwerken (Far Cry 5)? Best een belangrijke partner, ook al hebben veel mensen hier enige antipathie tegen Ubisoft. Bij Gamecom waren er veel systemen met AMD-CPU's. Dat gaat de goede kant uit. Nu de OEM's nog.

Verwijderd

Dat zou kunnen. Nu nog die Unreal engine aanpakken. Eens regelen dat standaard Gameworks-features uitstaan zodat amateurs die niet weten wat ze doen (#PUBG) niet de performance om zeep helpen.Verwijderd schreef op vrijdag 7 september 2018 @ 19:31:

[...]

De vruchten van de AMD console hardware ?

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Goed plaatje bij HWI:

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Zou daar niet te veel waarde aan hechten. Als je de geschatte omzet van Radeon (300 miljoen vd 1000 omzet) deelt door de 10 miljoen units volgens Peddie dan kom je op 30 dollar per verkochte gpu aan omzet (geen winst). Bij Nvidia kon je op minstens 125 dollar per John Peddie unit. Dat kan alleen kloppen als je de APU's gaat meetellen en dan nog is het de vraag of dat klopt aangezien de succesvolle Ryzen serie in eerste instantie geen APU's had. Komt er op neer dat het niet klopt niet, het appels met peren vergelijken is, of een combinatie van die twee.

[ Voor 6% gewijzigd door sdk1985 op 08-09-2018 14:32 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

https://www.computerbase....eon-rx-vega-untersucht/2/

Fiji vs Vega - 64CU vs 56CU

In het begin (Vega Founder Edition) was Fiji nog wel eens sneller op gelijke clocks. Dat is nu gelukkig voorbij met de huidige drivers is Vega toch een goede 7-13% sneller dan de voorganger (afhankelijk van de resolutie).

Frametimes zijn in sommige gevallen 80% beter.

Ik ga toch eens wat meer dingen uit proberen om te zien of ik deze kaart nog wat verder kan pushen.

Het was al een oudere review maar heb hem toen de tijd gemist. Maar ik hoopte al dat ze de boel bij Vega konden fixen want er waren genoeg aanpassingen in de architectuur gedaan waardoor Vega efficienter zou moeten zijn en vooral sneller zou moeten zijn dan Fiji (op gelijke clocks) maar dat is nu dus gelukkig ook het geval.

Er zitten wel tests tussen waar Fiji soms 1% sneller is maar ook genoeg waar vega dan 8% pakt. Vooral bij 4K gebeurd dat wel eens. Bij 1080P is Vega meer in het voordeel.

Op 4K is het verschil wel kleiner. Dat laat mij af vragen inhoeverren er toch een bandwith bottelnek is bij Vega. Het HBM geheugen is namelijk op 1000MHz geclockt en de core op slechts 1050 wat voor Vega laag is. Als je core dan 1600 MHz gaat draaien heb je ineens aardig wat extra data die door de chip heen gaat.

Bij tests zie ik tot nu toe wel een nette stijging als ik de core van Vega overclock. De Vega LC die ik nu heb kan helaas geen hoge HBM clocks halen dus kan helaas niet met 1100MHz HBM testen. Als ik dan 1700MHz core draai crashed de boel bij 1050MHz ook al.

Edit:

Ook mooi om te zien dat er wel games zijn waar het aantal CU's wel goed schaalt BV overwatch 1080p 9-10%. In andere games is het weer 4-6%.

Maar die extra cu's zijn nuttiger dan ik dacht. Zou wel kunnen dat het voordeel op 1600MHz kleiner wordt (als de geheugen interface voor een bottleneck zou zorgen)

[ Voor 41% gewijzigd door Astennu op 12-09-2018 18:11 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Dus toch weer 'slechte' day 1 drivers? Zonde vanwege de reviews en de invloed die dat heeft op aankopen.Astennu schreef op woensdag 12 september 2018 @ 18:02:

Ik was mijn kennis over de GCN architectuur weer even aan het opfrissen en toen kwam ik deze tegen:

https://www.computerbase....eon-rx-vega-untersucht/2/

Fiji vs Vega - 64CU vs 56CU

In het begin (Vega Founder Edition) was Fiji nog wel eens sneller op gelijke clocks. Dat is nu gelukkig voorbij met de huidige drivers is Vega toch een goede 7-13% sneller dan de voorganger (afhankelijk van de resolutie).

Frametimes zijn in sommige gevallen 80% beter.

Ja en nee want met nieuwere reviews zie je nog steeds wel een beetje dat beeld. (verbruik gewoon te hoog gezien de prestaties. Maar het is wel wat verbeterd)Verwijderd schreef op woensdag 12 september 2018 @ 21:30:

[...]

Dus toch weer 'slechte' day 1 drivers? Zonde vanwege de reviews en de invloed die dat heeft op aankopen.

Ik vraag mij af of de rasterizer wel helemaal lekker werkt. Zou mij niets verbazen als ze die in Navi verbeteren. Want anders had hij in alle gevallen sneller moeten zijn.

Navi wordt denk ik ook geen compute architectuur maar weer zoals Polaris game only. Met wel de beste eigenschappen van Vega - de zwakkere punten.

Stiekem hoop ik op een grotere overhaul maar weet niet of dat realistisch is gezien het beperkte budget van de Radeon technology group.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Die komt met "next-gen" na NaviAstennu schreef op woensdag 12 september 2018 @ 22:33:

[...]

Stiekem hoop ik op een grotere overhaul maar weet niet of dat realistisch is gezien het beperkte budget van de Radeon technology group.

2020-2021

Verwijderd

Die overhaul komt er wel maar waarschijnlijk nog niet voor Navi. 2020-2021?Astennu schreef op woensdag 12 september 2018 @ 22:33:

[...]

Ja en nee want met nieuwere reviews zie je nog steeds wel een beetje dat beeld. (verbruik gewoon te hoog gezien de prestaties. Maar het is wel wat verbeterd)

Ik vraag mij af of de rasterizer wel helemaal lekker werkt. Zou mij niets verbazen als ze die in Navi verbeteren. Want anders had hij in alle gevallen sneller moeten zijn.

Navi wordt denk ik ook geen compute architectuur maar weer zoals Polaris game only. Met wel de beste eigenschappen van Vega - de zwakkere punten.

Stiekem hoop ik op een grotere overhaul maar weet niet of dat realistisch is gezien het beperkte budget van de Radeon technology group.

Dat verwacht ik inderdaad ook. Maar we gaan het zien. Wat AMD voor elkaar kan krijgen.Verwijderd schreef op woensdag 12 september 2018 @ 22:36:

[...]

Die overhaul komt er wel maar waarschijnlijk nog niet voor Navi. 2020-2021?

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Lijkt mij een prima optie.Larmoth schreef op woensdag 5 september 2018 @ 19:57:

https://www.caseking.de/g...192-mb-hbm2-gcgb-222.html

Ik blijf nu twijfelen maar ga toch beginnen de knoop door te hakken. Heb een amd freesync scherm en zoek dus in de richting van AMD maar ik hoor telkens dat die kaarten erg warm worden, zeker de gygabite versie. Deze staat nu echter aan 470 euro op caseking. Is die warmte nu echt een probleem of zou ik er gewoon voor moeten gaan?

Als je de easy manier wilt om stroom te besparen gewoon power saver kiezen ipv balanced. Dan krijg veel betere performance per watt. Door het zelf te tweaken kan je er nog net wat meer uit halen maar power save doe al 90-95% van het werk als je geen custom wilt gebruiken.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Waarom zou je de Gigabyte halen als de Sapphire net zo duur isAstennu schreef op vrijdag 14 september 2018 @ 11:06:

[...]

Lijkt mij een prima optie.

Als je de easy manier wilt om stroom te besparen gewoon power saver kiezen ipv balanced. Dan krijg veel betere performance per watt. Door het zelf te tweaken kan je er nog net wat meer uit halen maar power save doe al 90-95% van het werk als je geen custom wilt gebruiken.

https://www.caseking.de/s...192-mb-hbm2-gcsp-186.html

[ Voor 8% gewijzigd door DoubleYouPee op 14-09-2018 12:01 ]

Ik had verder niet naar alternatieven gekeken. Ik zou zelf ook voor de sapphire gaan als ik tussen die twee moet kiezen. Maar als ik helemaal mag kiezen ga ik gewoon voor Refferenced maar dat ben ikDoubleYouPee schreef op vrijdag 14 september 2018 @ 12:01:

[...]

Waarom zou je de Gigabyte halen als de Sapphire net zo duur is

https://www.caseking.de/s...192-mb-hbm2-gcsp-186.html

Al zijn deze wel veel stiller. Vind die refferenced kaarten gewoon mooier.

In alle gevallen (ook met de Vega 64 LC die ik nu heb) draai ik wel op lagere voltages dan stock.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Op het moment dat ik game ben ik niet het uiterlijk van de kaart in de kast aan het bewonderen. Geef mij maar een stille kaart die goed de hitte afvoert. In ieder geval hebben die referentie kaarten een goede PCB, in tegenstelling tot de concurrent waarbij componenten wel eens voortijdig slijten.Astennu schreef op vrijdag 14 september 2018 @ 12:04:

[...]

Ik had verder niet naar alternatieven gekeken. Ik zou zelf ook voor de sapphire gaan als ik tussen die twee moet kiezen. Maar als ik helemaal mag kiezen ga ik gewoon voor Refferenced maar dat ben ik

Al zijn deze wel veel stiller. Vind die refferenced kaarten gewoon mooier.

Mja voor mij is dat anders. Ik verzamel ze ook. Daarnaast is mijn kast heel klein en compact. Een blower werkt dan veel beter. Warmte gaat dan de kast uit. Die dual en triple fans gaan relatief hard draaien in die kast en cpu wordt dan veel warmer.Verwijderd schreef op zaterdag 15 september 2018 @ 03:18:

[...]

Op het moment dat ik game ben ik niet het uiterlijk van de kaart in de kast aan het bewonderen. Geef mij maar een stille kaart die goed de hitte afvoert. In ieder geval hebben die referentie kaarten een goede PCB, in tegenstelling tot de concurrent waarbij componenten wel eens voortijdig slijten.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Ik zou ook voor een kaart met een blower-koeler kiezen als ik een ITX-kast zou hebben. Zelf heb ik liever een grote midtower-kast omwille van praktische redenen (ruimte/hardware-compatibiliteit, temperatuur en herrie). Ik ben het er overigens mee eens dat AMD mooie referentiekaarten maakt, als ze ook een editie met open koelers en een goede (dus ook grote) heatsink zouden uitbrengen dan zou ik niet twijfelen...Astennu schreef op zaterdag 15 september 2018 @ 10:52:

[...]

Mja voor mij is dat anders. Ik verzamel ze ook. Daarnaast is mijn kast heel klein en compact. Een blower werkt dan veel beter. Warmte gaat dan de kast uit. Die dual en triple fans gaan relatief hard draaien in die kast en cpu wordt dan veel warmer.

[ Voor 14% gewijzigd door Verwijderd op 15-09-2018 17:33 ]

Wat ik heb is dus een hele compacte mATX eerdere versie van die kast was ITX. Maar nu kan er net een mATX bord in. Dus er is niet veel ruimte. Ik had voorheen altijd een tower maar wilde iets wat ik relatief makkelijk op kon pakken en mee kon nemen en vond het ook leuk om een keer een compacte high end machine te maken.Verwijderd schreef op zaterdag 15 september 2018 @ 17:32:

[...]

Ik zou ook voor een kaart met een blower-koeler kiezen als ik een ITX-kast zou hebben. Zelf heb ik liever een grote midtower-kast omwille van praktische redenen (ruimte/hardware-compatibiliteit, temperatuur en herrie). Ik ben het er overigens mee eens dat AMD mooie referentiekaarten maakt, als ze ook een editie met open koelers en een goede (dus ook grote) heatsink zouden uitbrengen dan zou ik niet twijfelen...

Maar deze pak je zo met een hand op dus dat is gelukt

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Helaas zijn er zover ik weet geen aftermarket blower style koelers. Denk dat je zelfs in een ITX kast toch beter af bent met een goede normale koeler.Verwijderd schreef op zaterdag 15 september 2018 @ 17:32:

[...]

Ik zou ook voor een kaart met een blower-koeler kiezen als ik een ITX-kast zou hebben. Zelf heb ik liever een grote midtower-kast omwille van praktische redenen (ruimte/hardware-compatibiliteit, temperatuur en herrie). Ik ben het er overigens mee eens dat AMD mooie referentiekaarten maakt, als ze ook een editie met open koelers en een goede (dus ook grote) heatsink zouden uitbrengen dan zou ik niet twijfelen...

Ik ga zelf voor de Morpheus II Core Edition in mijn ITX kast, die past daarin met 2 120mm noctua fans van 15mm dik.

Het gaat overigens om een RX 470 van MSI met al een aftermarker koeler, maar als ik deze koeler er op weet te krijgen is dat natuurlijk een stuk beter

Afhankelijk van hoe die kast in elkaar zit zeker niet. In mijn kast werkt een blower veel beter dan een dual fan. Alle hitte bleef in de kast hangen. Die dual fan moest vervolgens ook hard gaan werken en de CPU werd extra heet.Sp3ci3s8472 schreef op zaterdag 15 september 2018 @ 19:34:

[...]

Helaas zijn er zover ik weet geen aftermarket blower style koelers. Denk dat je zelfs in een ITX kast toch beter af bent met een goede normale koeler.

Ik ga zelf voor de Morpheus II Core Edition in mijn ITX kast, die past daarin met 2 120mm noctua fans van 15mm dik.

Het gaat overigens om een RX 470 van MSI met al een aftermarker koeler, maar als ik deze koeler er op weet te krijgen is dat natuurlijk een stuk beter.

Sommige zitten wat beter in elkaar qua warmte afvoer of plaatsing van de kaart zodat hij koude lucht bij de zijkant van de kast kan aanzuigen maar dat is niet altijd zo.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik heb de Node 202, fans zijn vooral voor de static pressure. Hoop in ieder geval dat het genoeg isAstennu schreef op zaterdag 15 september 2018 @ 20:36:

[...]

Afhankelijk van hoe die kast in elkaar zit zeker niet. In mijn kast werkt een blower veel beter dan een dual fan. Alle hitte bleef in de kast hangen. Die dual fan moest vervolgens ook hard gaan werken en de CPU werd extra heet.

Sommige zitten wat beter in elkaar qua warmte afvoer of plaatsing van de kaart zodat hij koude lucht bij de zijkant van de kast kan aanzuigen maar dat is niet altijd zo.

Verwijderd

Als je het doet zoals deze baas...Sp3ci3s8472 schreef op zaterdag 15 september 2018 @ 19:34:

Het gaat overigens om een RX 470 van MSI met al een aftermarker koeler, maar als ik deze koeler er op weet te krijgen is dat natuurlijk een stuk beter.

Hij heeft ook zelf een geweldige kast gemaakt. Ik hoop wel dat die PCB het na enkele jaren nog uithoudt.

@Astennu

Helaas is de trend in de laatste jaren dat veel kasten van voor (inclusief de zijkant) weinig lucht aanzuigen. Dat is geen probleem als je een 8400 met een 1050 Ti of een 24000g in je kast plaatst maar als er een ietwat zwaardere CPU en grafische kaart in komt...

Dat is gelukkig iets verbeterd sinds dat Fractal het plastic voor vervangde met een mesh en andere bedrijven dit ook deden.

[ Voor 86% gewijzigd door Verwijderd op 16-09-2018 20:29 ]

Verwijderd

https://www.jonpeddie.com/store/add-in-board-report

Natuurlijk is het makkelijk om veel bugs opgelost te hebben als je weinig nieuwe hardware released, maar dan nog, dit is wel een erg lekker kort lijstje. (Ik weet nog dat het veel langer was)

Het lijkt een beetje een stilte voor de storm van de eindejaars release, laats zij Terry Makedon al:

Op de feedback pagina van AMD staan de volgen features om op de stemmen: (votes - feature)I think this year end release will be really cool with new exciting stuff

- 5480 - Performance Metrics controls: size, positions, font, colors, and transparency

- 3601 - Virtual Super Resolution for wider aspect ratio displays

- 3340 - Global Radeon Chill settings

- 2142 - Radeon WattMan overclock limiting notifications

- 2031 - Enhanced Sync support in Radeon Overlay

- 1783 - Radeon ReLive basic video editing

- 1628 - Performance Metrics frametime logging support

- 1627 - Radeon WattMan support in Radeon Overlay

- 1627 - Performance Metrics Lower Sample Interval

- 1624 - Radeon WattMan support in AMD Link

VSR en Global Radeon Chill zouden ook vet zijn. Sowieso begrijp ik niet dat we onze oude games op 300FPS+ laten draaien zonder enig nut.

Ook hebben we nog niet alles terug gezien van de overnamen op HiAlgo. Dynamisch de resolutie omlaag gooien bij een te lage framerate zou echt een killer feature zijn voor de mobile APU's. (Wellicht leuk voor als ze de 2800H nog even zijn moment geven) Dit was de techdemo: YouTube: Universal HiAlgo BOOST (ver 4.0) tech demo

Anyway, AMD is echt heel goed bezig met de drivers en de extra software. Ook op linux gaan ze bizar hard, mischien heeft dat met Steam Play te maken, maar aan alle kanten zit het met de drivers van AMD wel goed.

Het is haast jammer dat er zo weinig nieuwe hardware is, zelfs een verse Polaris zou nu leuk zijn tegen de juiste prijs. Polaris refresh op 12nm zou nog beter zijn, dat zou lekker de tijd vullen.

Zou wel fijn zijn als ik afterburner+rivatuner kan ditchen ja.. maar dan moet het ook wel echt hetzelfde kunnen, incl info over andere componenten etc.Toettoetdaan schreef op donderdag 20 september 2018 @ 12:37:

Die frametime logging support zal er wel inkomen, AMD heeft net een nieuwe versie van hun frametime tool aangekondigd: https://gpuopen.com/ocat-1-2/

VSR en Global Radeon Chill zouden ook vet zijn. Sowieso begrijp ik niet dat we onze oude games op 300FPS+ laten draaien zonder enig nut.

Je kan overigens met Radeon FRTC gewoon een FPS cap inzetten zodat je niet op 300+ etc. komt

Klopt, het gaat zowel aan de open source als closed source variant goed. AMD heeft 8.5x meer gecommit aan de Linux kernel dan Nvidia. Ook wel logisch, ze maken ook chipsets en cpu's waar dingen voor nodig zijn.Toettoetdaan schreef op donderdag 20 september 2018 @ 12:37:

Anyway, AMD is echt heel goed bezig met de drivers en de extra software. Ook op linux gaan ze bizar hard, mischien heeft dat met Steam Play te maken, maar aan alle kanten zit het met de drivers van AMD wel goed.

Het is haast jammer dat er zo weinig nieuwe hardware is, zelfs een verse Polaris zou nu leuk zijn tegen de juiste prijs. Polaris refresh op 12nm zou nog beter zijn, dat zou lekker de tijd vullen.

https://www.phoronix.com/...IDIA-Intel-Kernel-Contrib

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Waarschijnlijk yields, of dat ie uncut te dicht tegen de 290 aan zou schurken.. tussen een 380x en een 290 zit maar een gat van ~20%.SpankmasterC schreef op donderdag 20 september 2018 @ 21:04:

Wat is eigenlijk het verhaal achter de R9 285? Waarom werd Tonga eerst als cut uitgebracht en pas een heel stuk later volledig? Uberhaupt, wat is het verhaal achter die chip? Waarom was hij zo groot, zo'n enorme side-grade? Wat was het nut van het uitbrengen van die chip?

Waarom het ding dan is uitgebracht... ik kom niet veel verder dan TDP (zuiniger dan Tahiti), het niet een 2e keer willen rebadgen van Tahiti (zoals wel gedaan met pitcairn) en gewoon het doorontwikkelen van GCN. Als ik wikipedia mag geloven is naast Tonga Fiji (R9 Fury) de enige 3rd gen GCN chip, wie weet was Tonga wel een test-run voor Fury?

En als laatste, Tahiti was in de 3xx serie ook niet meer te verkopen geweest, 250w TDP om een GTX960 (van pakweg 120w) te verslaan... en een 384 bits memory bus...

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Volgens wikipedia;SpankmasterC schreef op donderdag 20 september 2018 @ 21:04:

Wat is eigenlijk het verhaal achter de R9 285? Waarom werd Tonga eerst als cut uitgebracht en pas een heel stuk later volledig? Uberhaupt, wat is het verhaal achter die chip? Waarom was hij zo groot, zo'n enorme side-grade? Wat was het nut van het uitbrengen van die chip?

Dus een boel nieuwe tech.GCN 3rd generation

GCN 3rd generation was introduced in 2014 with the Radeon R9 285 and R9 M295X, which have the "Tonga" GPU. It features improved tessellation performance, lossless delta color compression in order to reduce memory bandwidth usage, an updated and more efficient instruction set, a new high quality scaler for video, and a new multimedia engine (video encoder/decoder). Delta color compression is supported in Mesa. However, its double precision performance is worse compared to previous generation.

Graphene; a material that can do everything, except leave the lab. - Asianometry

Zou deze Nitro+ dan geen betere optie zijn?Gipsy King schreef op vrijdag 21 september 2018 @ 10:10:

Voor de mensen die graag een goedkope Vega 64 op te kop willen tikken, zag net dat Mindfactory in DE ze nu heeft voor 449 EUR : https://www.mindfactory.d...x16--Retail-_1229293.html

https://www.mindfactory.d...Full-Retail-_1235216.html

Zou kunnen , maar wat voorn performance krijg je meer voor die 100 Euro extra ?GroeneThee schreef op vrijdag 21 september 2018 @ 10:43:

[...]

Zou deze Nitro+ dan geen betere optie zijn?

https://www.mindfactory.d...Full-Retail-_1235216.html

Ben ik nog niet achter maar volgens mij is de koeling van de Nitro+ wel een stuk beter?Gipsy King schreef op vrijdag 21 september 2018 @ 10:45:

[...]

Zou kunnen , maar wat voorn performance krijg je meer voor die 100 Euro extra ?

Inderdaad. Maar 100€? dat is wel heel veel. Dan zou ik de Gigabyte nemen en hopen op een superchip die je goed kan undervolten...en anders maar een paar fps minder.GroeneThee schreef op vrijdag 21 september 2018 @ 10:46:

[...]

Ben ik nog niet achter maar volgens mij is de koeling van de Nitro+ wel een stuk beter?

Omdat de volledige Tonga-chip door Apple werd gebruikt in de iMac 5K. Alle volledig functionele die's gingen daar dus heen en pas later hield AMD er zelf wat van over om als 380X te verkopen.SpankmasterC schreef op donderdag 20 september 2018 @ 21:04:

Wat is eigenlijk het verhaal achter de R9 285? Waarom werd Tonga eerst als cut uitgebracht en pas een heel stuk later volledig? Uberhaupt, wat is het verhaal achter die chip? Waarom was hij zo groot, zo'n enorme side-grade? Wat was het nut van het uitbrengen van die chip?

Erg toffe GPU is het, wat mij betreft heeft ie destijds niet genoeg credit gekregen. Hij heeft bizar veel ACE's in verhouding tot shaders, afaik heeft AMD dit sindsdien niet meer gedaan. Vandaag draait Tonga in DX12 en Vulkan nog behoorlijk goed, en het verbruik is niet eens zo gek hoog als je de die-size van 359mm^2 in het achterhoofd houdt.

[ Voor 5% gewijzigd door Trygve op 21-09-2018 11:11 ]

Klopt, een 380x zit op hetzelfde niveau als een 470x, met niet bizar veel meer stroomverbruik maar wel op een 28nm chip ipv 14nm, best indrukwekkendr100 schreef op vrijdag 21 september 2018 @ 11:09:

[...]

Erg toffe GPU is het, wat mij betreft heeft ie destijds niet genoeg credit gekregen. Hij heeft bizar veel ACE's in verhouding tot shaders, afaik heeft AMD dit sindsdien niet meer gedaan. Vandaag draait Tonga in DX12 en Vulkan nog behoorlijk goed, en het verbruik is niet eens zo gek hoog als je de die-size van 359mm^2 in het achterhoofd houdt.

Het is dat ik voor mn nieuwe build naar een klein mITX kastje wil gaan en een 14nm chip dus een must is, maar anders zou een 2e hands tonga hoog op de lijst staan met de huidige GPU prijzen

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Verwijderd

Dank je, maar met die Gigabyte Vega kaart moet je voorzichtig zijn, die is niet stabiel out of the box (volgens mij ook vrij slecht gekoeld) dus de koper gaat zelf moeten tunen.Gipsy King schreef op vrijdag 21 september 2018 @ 10:10:

Voor de mensen die graag een goedkope Vega 64 op te kop willen tikken, zag net dat Mindfactory in DE ze nu heeft voor 449 EUR : https://www.mindfactory.d...x16--Retail-_1229293.html

Als je de Gigabyte Vega64 ondervolt en onderklokt dan kan het best een geschikte keuze zijn: je krijgt wat minder performance maar je betaalt ook >20% minder.GroeneThee schreef op vrijdag 21 september 2018 @ 10:43:

[...]

Zou deze Nitro+ dan geen betere optie zijn?

https://www.mindfactory.d...Full-Retail-_1235216.html

[ Voor 29% gewijzigd door Verwijderd op 21-09-2018 17:36 ]

AMD haar mainstream strategie met Polaris lijkt dus haar vruchten af te werpen want ze blijven marktaandeel pakken. Sinds Polaris twee jaar geleden werd gelanceerd heeft AMD 10% marktaandeel gewonnen. Natuurlijk hebben de miners ook geholpen, maar het gaat erom dat AMD al haar inventaris eens kon verkopen en er dan op zal verdienen.

https://www.3dcenter.org/...e-im-zweiten-quartal-2018

Ja, de waarden voor 2Q/2018 kloppen niet in deze grafiek, maar de grafiek zelf wel.

[ Voor 22% gewijzigd door DaniëlWW2 op 21-09-2018 19:41 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Geïntegreerde grpahics.

Dus terwijl een hoop critici in de 'pers' zeuren dat AMD niet meer meedoet omdat het geen concurrentie biedt voor de beste Nvidia-kaarten (1080 ti, nu ook 2080 en 2080 ti) pakt AMD wel meer marktaandeel. LOL

Toch zal ik blij zijn als AMD weer in alle segmenten tegelijkertijd een kaart gaat uitbrengen.

[ Voor 63% gewijzigd door Verwijderd op 21-09-2018 23:05 ]

De hoeveelheid chips zegt dus imho niet zoveel, casual gamers gaan langzamerhand meer AMD kopen maar de fanatieke gamer schuift waarschijnlijk geen millimeter op.

Ook vind ik de jump vanaf de release van Vega erg vaag, het is niet zo dat we die makkelijk konden kopen toen hij uitkwam.

Worden renderfarms ook meegerekend ofzo ?

[ Voor 5% gewijzigd door enchion op 22-09-2018 01:07 ]

How do you save a random generator ?

https://www.phoronix.com/...x=AMD-Polaris-2019-0x6FDF

[ Voor 3% gewijzigd door DaniëlWW2 op 22-09-2018 22:13 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Waarom zouden ze zowel NAVI als Polaris op 7nm gaan maken wanneer ze die capaciteit nodig hebben voor Epyc-Rome, Ryzen3 en Vega-voor-developertoepassingen.Verwijderd schreef op zondag 23 september 2018 @ 02:41:

Het is zeker teveel gehoopt dat het een Polaris op 7 nm is?

Moet gewoon een OEM zijn, met misschien meer/minder geheugen.

Met Epyc-Rome kunnen ze een gigantische uppercut uitdelen aan intel, waarom zouden ze dan die capaciteit willen gebruiken om een licht tikje aan nvidia uit te delen.

How do you save a random generator ?

Maar goed als ze er wat extra shaders aan plakken en het voordeel van het geoptimaliseerde proces gebruiken om het verbruik wat te drukken en er GDDR5x op plakken kan het een chip zijn die prima prestaties neer zet richting de Vega 56 alleen dan goedkoper.

Er zit immers een grotere versie van Polaris in de Xbox One X. al acht ik de kans dat ze dit daadwerkelijk doen wel klein maar het zou niet eens een slechte zet zijn meer shaders en een gelijke of iets lagere clockspeed op een beter proces (waardoor je een lager voltage kan gebruiken) kan toch zorgen voor een vrij efficiënte chip.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Over welke capaciteit heb je het?enchion schreef op zondag 23 september 2018 @ 03:13:

Met Epyc-Rome kunnen ze een gigantische uppercut uitdelen aan intel, waarom zouden ze dan die capaciteit willen gebruiken om een licht tikje aan nvidia uit te delen.

Zie jij AMD honderden miljoenen dollars en kostbare tijd van engineers besteden aan een tape-out van een Polaris met wat hogere clocks waarbij het resultaat zal zijn dat de chip bijna twee keer zo duur is om te maken? Juist ja.Verwijderd schreef op zondag 23 september 2018 @ 02:41:

Het is zeker teveel gehoopt dat het een Polaris op 7 nm is?

[ Voor 11% gewijzigd door DaniëlWW2 op 23-09-2018 19:02 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

[ Voor 91% gewijzigd door Lord_Dain op 25-09-2018 11:00 ]

https://wccftech.com/amd-radeon-polaris-30-gpu-family/Astennu schreef op zondag 23 september 2018 @ 16:56:

Inderdaad eerder 12nm.

Maar goed als ze er wat extra shaders aan plakken en het voordeel van het geoptimaliseerde proces gebruiken om het verbruik wat te drukken en er GDDR5x op plakken kan het een chip zijn die prima prestaties neer zet richting de Vega 56 alleen dan goedkoper.

Er zit immers een grotere versie van Polaris in de Xbox One X. al acht ik de kans dat ze dit daadwerkelijk doen wel klein maar het zou niet eens een slechte zet zijn meer shaders en een gelijke of iets lagere clockspeed op een beter proces (waardoor je een lager voltage kan gebruiken) kan toch zorgen voor een vrij efficiënte chip.

WCCF tech komt nu ook met het gerucht over 12nm.

Ik ben benieuwd.... Ik hoop alleen wel dat ze meer shaders toevoegen anders komt die kaart onvoldoende mee.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ligt er natuurlijk helemaal aan hoe ze het ding positioneren, als ze 15% extra clocks er op kunnen zetten, en de polaris drivers sinds 480/580 release ook nog wat volwassener zijn geworden kan een simpele 670/680 combo het best goed gaan doen in de reviews, prijs is dan de beslissende factor.Astennu schreef op maandag 24 september 2018 @ 14:26:

Ik ben benieuwd.... Ik hoop alleen wel dat ze meer shaders toevoegen anders komt die kaart onvoldoende mee.

Persoonlijk zou ik een 670, met 4gb en dezelfde clocks als een 570 maar lager TDP, best zien zitten. Als het ding dan voor de origineel bedoelde prijs van ~$170 gekocht kan worden...

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

GF14nm naar GF12nm schijnt relatief goedkoop te zijn (hetzelfe. En Polaris doet het nog goed (Vega M is gewoon Polaris met HBM2), dus een RX585 of een RX590 zou een leuk bruggetje zijn tot de 7nm kaarten erzijn.

Het is een relatief goedkope manier om een RX580 +10/15% de deur uit te doen waar OEM's en gebruikers blij van worden. Je hebt het dan ineens over een 250euro kaart die in de buurt komt van een 400euro GTX 1070. Plak er nog een leuke nieuwe driver feature bij en je hebt een complete release.

Je kunt er ook een lossoldeeren van een oude kaartLopendeVogel schreef op maandag 24 september 2018 @ 09:54:

Weet iemand een Nederlandse webshop waar ik dit wel kan vinden?

Tja, het zou potentieel mee kunnen komen met de GTX2060. Vega dreigt door de prijzen van Turing ook gewoon competitief te worden. Volgend jaar beiden vervangen voor Navi.Astennu schreef op maandag 24 september 2018 @ 14:26:

[...]

https://wccftech.com/amd-radeon-polaris-30-gpu-family/

WCCF tech komt nu ook het gerucht over 12nm.

Ik ben benieuwd.... Ik hoop alleen wel dat ze meer shaders toevoegen anders komt die kaart onvoldoende mee.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Edit: of misschien zelfs 2816 shaders voor een RX 680, aangezien de Scorpio Engine ook 44 CU's heeft waarvan 4 zijn uitgeschakeld. Dan zou de RX 670 bijvoorbeeld 2560 shaders uit de 40 ingeschakelde CU's kunnen krijgen.

[ Voor 56% gewijzigd door Trygve op 24-09-2018 15:07 ]

Mja dan is je stroomverbruik gewoon slechter. Grotere chips op lagere clocks zijn over het algemeen zuiniger dan een kleine chip op hogere clocks (uitgaande van dezelfde architectuur)vectormatic schreef op maandag 24 september 2018 @ 14:43:

[...]

Ligt er natuurlijk helemaal aan hoe ze het ding positioneren, als ze 15% extra clocks er op kunnen zetten, en de polaris drivers sinds 480/580 release ook nog wat volwassener zijn geworden kan een simpele 670/680 combo het best goed gaan doen in de reviews, prijs is dan de beslissende factor.

Persoonlijk zou ik een 670, met 4gb en dezelfde clocks als een 570 maar lager TDP, best zien zitten. Als het ding dan voor de origineel bedoelde prijs van ~$170 gekocht kan worden...

Dus eigenlijk wil je de clockspeeds gelijk houden en vooral wat breeder gaan.

Of 44 CU's dat je op 2816 uit komt alla Hawaii.r100 schreef op maandag 24 september 2018 @ 14:48:

Als ze á la Scorpio van de Xbox One X de volgende Polaris met 2560 shaders uitbrengen en daar GDDR5X of GDDR6 aan plakken, dan heb ik daar ook geen bezwaar tegen

Edit: of misschien zelfs 2816 shaders voor een RX 680, aangezien de Scorpio Engine ook 44 CU's heeft waarvan 4 zijn uitgeschakeld. Dan zou de RX 670 bijvoorbeeld 2560 shaders uit de 40 ingeschakelde CU's kunnen krijgen.

Eventueel met een 384 bit bus (al denk ik dat GDDR5x / 6 goedkoper is) en dan heb je aardig wat extra performance en zou je hem ook nog iets efficiënter kunnen maken.

Zodra de 2050/2060 van nVidia komen zullen de huidige polaris chips het qua prestaties en verbruik lastig gaan krijgen.

Door niet te hoog te locken kan je dit tegen gaan. nVidia gebruikt ook core voltages van 1.1v of iets lager. AMD 1.2 en soms 1.25v dat is gewoon te hoog dat zie je terug in je verbruik en zo veel hoger worden je clocks er niet van. Performance per watt zakt.

Enige nadeel van mijn plan is wel dat die chip duurder is. Een grotere chip en sneller geheugen kost geld.

Een chip hoger clocken niet dat kost je klant geld. (En jezelf indirect ook want reviewers rekenen je er wel op af en klanten ook dus verkoop je minder)

Maar ik vrees dat het gewoon een refresh is met hogere clocks. Maar ik hoop op 40 of 44 CU's. Dan kunnen ze in een segment springen wat een beetje tussen de 1060 en de 1070 in gaat zitten net onder de 1070 en de Vega 56 maar wel een stuk goedkoper.

Haha idd tov de 2070 is die Vega 64 ineens niet zo duur meer. En qua prestaties zitten ze denk ik ook in hetzelfde segment. Alleen verbruikt vega dan nog wel veel te veel. Waar Turning wel efficienter is geworden dan Pascal.DaniëlWW2 schreef op maandag 24 september 2018 @ 14:45:

[...]

Tja, het zou potentieel mee kunnen komen met de GTX2060. Vega dreigt door de prijzen van Turing ook gewoon competitief te worden. Volgend jaar beiden vervangen voor Navi.

[ Voor 58% gewijzigd door Astennu op 24-09-2018 15:18 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Mag ik er een schepje bovenop doen?r100 schreef op maandag 24 september 2018 @ 14:48:

Als ze á la Scorpio van de Xbox One X de volgende Polaris met 2560 shaders uitbrengen en daar GDDR5X of GDDR6 aan plakken, dan heb ik daar ook geen bezwaar tegen

Edit: of misschien zelfs 2816 shaders voor een RX 680, aangezien de Scorpio Engine ook 44 CU's heeft waarvan 4 zijn uitgeschakeld. Dan zou de RX 670 bijvoorbeeld 2560 shaders uit de 40 ingeschakelde CU's kunnen krijgen.

3072 shaders, 384bit geheugenbus, 12GiB GDDR6, 12nm en die extra transistoren van Vega waardoor de kloksnelheid omhoog kan; 1600MHz

Graphene; a material that can do everything, except leave the lab. - Asianometry

Ja, dit bestaat waarschijnlijk al. Het heet Navi.NitroX infinity schreef op maandag 24 september 2018 @ 17:04:

[...]

Mag ik er een schepje bovenop doen?

3072 shaders, 384bit geheugenbus, 12GiB GDDR6, 12nm en die extra transistoren van Vega waardoor de kloksnelheid omhoog kan; 1600MHz

Die 44CU Polaris zou ik graag zien, maar die gaat waarschijnlijk in de weg zitten me Navi waardoor het een beetje zinloos is om die te introduceren, of Navi.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Maar dan is het geen Polaris chip meer. Dan is het eerder een cut down Vega.NitroX infinity schreef op maandag 24 september 2018 @ 17:04:

[...]

Mag ik er een schepje bovenop doen?

3072 shaders, 384bit geheugenbus, 12GiB GDDR6, 12nm en die extra transistoren van Vega waardoor de kloksnelheid omhoog kan; 1600MHz

386Bit GDDR6 is overkill voor Polaris met dat aantal shaders. 256Bit is dan meer dan genoeg. GDDR5x is denk ik zal zat of 384Bit GDDR5.

Maar ik denk dat GDDR5x met 256bit goedkoper is dan GDDR5 met 384 bit.

Wat hij noemt zijn zelfs 48 CU's. Ik denk inderdaad dat dat met Navi pas komt.DaniëlWW2 schreef op maandag 24 september 2018 @ 17:29:

[...]

Ja, dit bestaat waarschijnlijk al. Het heet Navi.

Die 44CU Polaris zou ik graag zien, maar die gaat waarschijnlijk in de weg zitten me Navi waardoor het een beetje zinloos is om die te introduceren, of Navi.

Aangezien die volgend jaar moet komen en AMD het meeste omzet haalt uit die RX4/5 lijn (Vega is meer Datacenter)

Zou een polaris refresh op 12nm met gewoon extact hetzelfde aantal shaders het meest logische zijn. Iets hogere clocks verbruik vergelijkbaar of 10-20 watt hoger en klaar is kees en uitzingen tot Navi. (dat is mijn vrees) Maar iets is beter dan niets i guess.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

High-end Navi is iets voor 2021 toch? https://wccftech.com/excl...avi-gpu-roadmap-cost-zen/DaniëlWW2 schreef op maandag 24 september 2018 @ 17:29:

[...]

Ja, dit bestaat waarschijnlijk al. Het heet Navi.

Verwijderd

Er is nog zeer weinig bekent van Navi, 99% van wat je nu op internet tegenkomt over Navi zijn speculaties.Olaf van der Spek schreef op maandag 24 september 2018 @ 18:17:

[...]

High-end Navi is iets voor 2021 toch? https://wccftech.com/excl...avi-gpu-roadmap-cost-zen/

Maar in 2020 zou AMD een nieuwe architectuur lanceren volgens AMD’s eigen roadmap. (Dus geen GCN meer)

[ Voor 4% gewijzigd door Verwijderd op 24-09-2018 20:10 ]

Ik heb het niet over high-end.Olaf van der Spek schreef op maandag 24 september 2018 @ 18:17:

[...]

High-end Navi is iets voor 2021 toch? https://wccftech.com/excl...avi-gpu-roadmap-cost-zen/

Verder ken ik dat artikel. Het probleem is dat het wccftech is, a.k.a "WC tech". De site is alles behalve betrouwbaar dus neem ik alles van hun met een flinke lading zout.

Maar ik bijt wel.

Dit zou ik Navi scenario 2 willen noemen. Scenario 1 is dat Navi de laatste GCN architectuur is die in H1/2019 uit word gebracht. Een 7nm, mainstream chip die vergelijkbaar presteert met Vega. HBM2 vervangen voor GDDR6, minder CU's en hogere clockspeeds. Niks innovatiefs als product, maar je kan er 2019 mee doorkomen zonder nog meer dieprode cijfers en verlies van marktaandeel dat Polaris en Vega net terug hebben gewonnen. De naar mijn mening teleurstellende Turing zou het voor AMD alleen maar makkelijker maken om met een GCN Navi goed te verkopen.

Ik heb alleen geen idee wat de RTG gaat doen. Het zou goed kunnen dat na de Vega ramp, Koduri moest vertrekken en Navi vlak voor de tape-out is geschrapt en dat er nu in versnelt tempo word gewerkt aan "Next-Gen" die eigenlijk in 2020 uit zou moeten komen. Dit zou dan nu Navi heten. Ik weet alleen dat de roadmaps van AMD vager zijn gemaakt nadat Koduri vertrokken is, en ja dat was kennelijk mogelijk want RTG marketing en communicatie is gewoon beroerd. Verder lijkt meer R&D budget en personeel beschikbaar te zijn voor de RTG nu Zen 2 ook allang voltooid is en een deel van dat personeel kennelijk overgeplaatst is naar de RTG.

In totaal budget gaat het de goede kant op, maar ik heb geen breakdown gezien waar de budgetten naartoe gaan. Zie:

https://www.overclock3d.n...nce_this_time_last_year/1

https://www.overclock3d.n...ost_22_in_the_past_year/1

Wat je wel redelijk kan analyseren en inschatten is dat Zen 2 waarschijnlijk het lot van de RTG zal bepalen. AMD heeft wanhopig een "oorlogskas" nodig om verregaande, diepgaande investeringen te doen in de RTG om hun achterstand in te lopen op gebied van high-end gaming, Deep Learning en de softwarestacks voor Deep Learning. Zen 2 kan hiervoor zorgen omdat Zen 2 bestemd lijkt voor grootsheid. Daarmee bedoel ik zowel Athlon als Opteron grootheid bij elkaar en veel groter komt het niet dan die twee voor AMD. Door het falen van het 10nm productieproces van Intel kan Zen 2 zomaar de beste CPU ooit worden voor AMD. AMD begint ook nog eens met de uitrol met Epyc 2, een product waar ze makkelijk duizenden dollars winst per CPU op gaan maken. Verkoop daar maar miljoenen exemplaren van en dat gaat optellen.

Zen 2 haar succes is ook sterk verbonden aan AMD haar marktwaarde en dus overlevingskansen op lange termijn. Die is nu dankzij de enorme koersstijging meer dan $30 miljard, maar dat is nog steeds een kleintje vergeleken met Intel of Nvidia. Het is waarschijnlijk niet genoeg om doormiddel van een aandelenemissie nu de benodigde miljarden op te halen. Nog niet, want Zen 2 kan hier ook bij helpen.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Waarom niet Navi zoals jij hem hier beschrijft achterwegen laten en Vega 20 (7nm) ook naar consumenten brengen? Vega 20 is reeds al gespot en de die size wordt geschat op ~360mm2. De helft van een TU102 dus qua prijs moet dat toch wel interessant gemaakt kunnen worden?DaniëlWW2 schreef op maandag 24 september 2018 @ 20:29:

Scenario 1 is dat Navi de laatste GCN architectuur is die in H1/2019 uit word gebracht. Een 7nm, mainstream chip die vergelijkbaar presteert met Vega. HBM2 vervangen voor GDDR6, minder CU's en hogere clockspeeds. Niks innovatiefs als product, maar je kan er 2019 mee doorkomen zonder nog meer dieprode cijfers en verlies van marktaandeel dat Polaris en Vega net terug hebben gewonnen. De naar mijn mening teleurstellende Turing zou het voor AMD alleen maar makkelijker maken om met een GCN Navi goed te verkopen.

Lijkt me sterk dat 7nm waffers het dubbele kosten van een 12nm waffer bij TSMC. Let wel, als de yields gelijk zijn bij beide processen dan is die Vega 20 op 7nm alsnog goedkoper als de TU102 op 12nm.

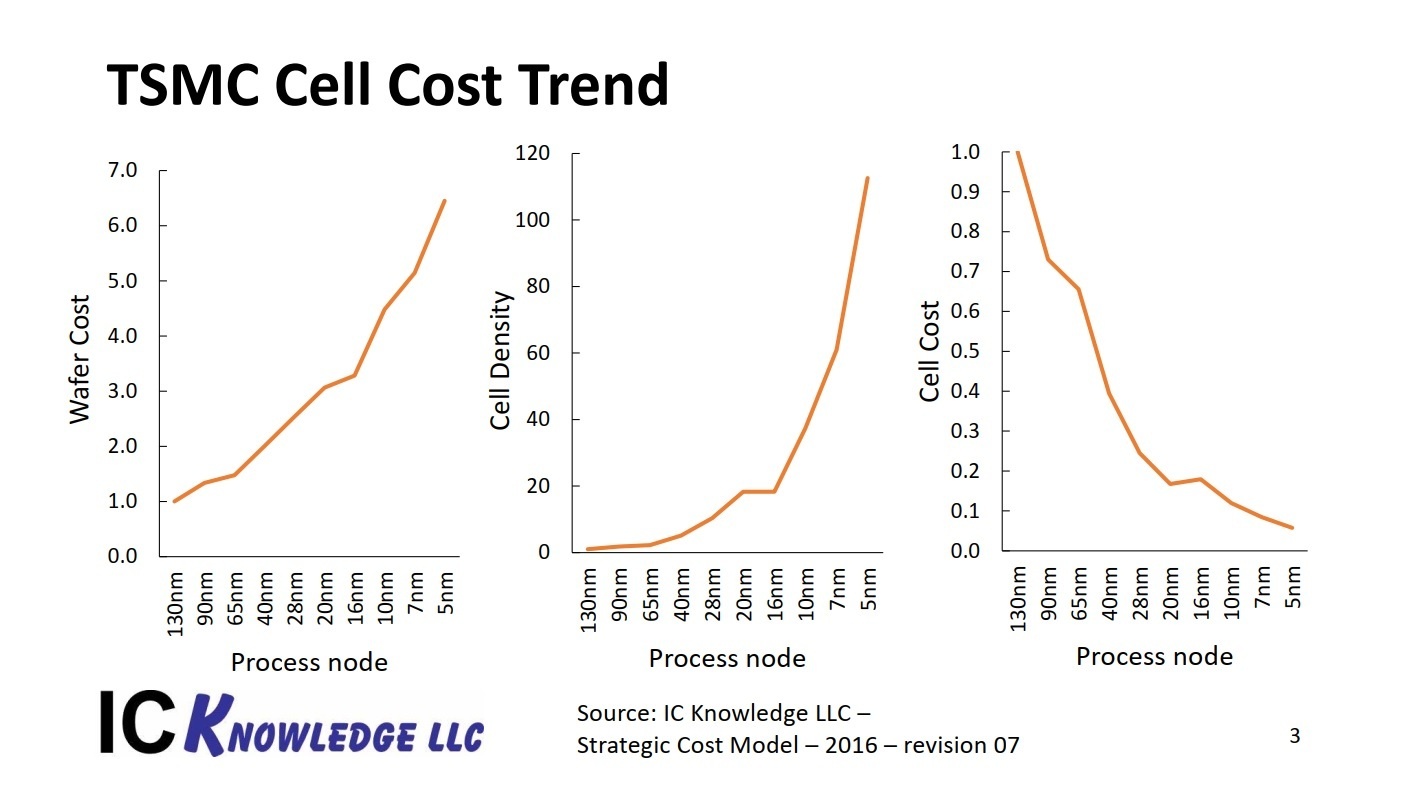

Uh, die 7nm wafers kosten dus wel bijna twee keer zoveel.madmaxnl schreef op dinsdag 25 september 2018 @ 01:09:

[...]

Waarom niet Navi zoals jij hem hier beschrijft achterwegen laten en Vega 20 (7nm) ook naar consumenten brengen? Vega 20 is reeds al gespot en de die size wordt geschat op ~360mm2. De helft van een TU102 dus qua prijs moet dat toch wel interessant gemaakt kunnen worden?

Lijkt me sterk dat 7nm waffers het dubbele kosten van een 12nm waffer bij TSMC. Let wel, als de yields gelijk zijn bij beide processen dan is die Vega 20 op 7nm alsnog goedkoper als de TU102 op 12nm.

Verder heeft Vega 20, vier HBM2 stacks die de prijs al enorm op zullen drijven. Heb je ook een bredere geheugenbus en waarschijnlijk nog andere HPC features. De chip zal sneller zijn dan Vega 10, maar waarschijnlijk niet veel sneller zijn voor gaming. Die chip zou als RX niet goedkoper zijn dan Vega 10. Mocht deze wonderbaarlijk wel presteren in gaming, dan is het een high-end en dan verschijnt die misschien. Zou er niet op rekenen.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Waffers?madmaxnl schreef op dinsdag 25 september 2018 @ 01:09:

[...]

Waarom niet Navi zoals jij hem hier beschrijft achterwegen laten en Vega 20 (7nm) ook naar consumenten brengen? Vega 20 is reeds al gespot en de die size wordt geschat op ~360mm2. De helft van een TU102 dus qua prijs moet dat toch wel interessant gemaakt kunnen worden?

Lijkt me sterk dat 7nm waffers het dubbele kosten van een 12nm waffer bij TSMC. Let wel, als de yields gelijk zijn bij beide processen dan is die Vega 20 op 7nm alsnog goedkoper als de TU102 op 12nm.

Waarom zou 7nm, rekening houdende met yields, niet veel duurder kunnen zijn dan 12nm?

Cell cost is lager, dan is 7nm toch alsnog goedkoper?DaniëlWW2 schreef op dinsdag 25 september 2018 @ 09:24:

Uh, die 7nm wafers kosten dus wel bijna twee keer zoveel.

[Afbeelding]

[ Voor 18% gewijzigd door Olaf van der Spek op 25-09-2018 09:27 ]

Verwijderd

Kijk je niet naar de verkeerde grafiek?Verwijderd schreef op dinsdag 25 september 2018 @ 09:42:

Ik zie in die grafiek een stijging van ongeveer 3 naar ongeveer 5 bij de sprong van 16 nm. naar 7 nm. , dat is een stijging van ongeveer 67%. Fors, maar toch nog wel een aanzienlijk stuk verwijderd van 2.

Ja, wafers kosten meer maar je krijgt er ook meer (chips) voor terug.

De kosten per cell (transistor?) gaan omlaag volgens de rechter grafiek.

Verwijderd

Wafer cost. Ik reageerde op deze opmerking van Daniel.Olaf van der Spek schreef op dinsdag 25 september 2018 @ 09:45:

[...]

Kijk je niet naar de verkeerde grafiek?

Uh, die 7nm wafers kosten dus wel bijna twee keer zoveel.

Dat lijkt mij inderdaad belangrijker.De kosten per cell (transistor?) gaan omlaag volgens de rechter grafiek.

Verder, de kosten van de GPU bedragen maar een deel van de kosten van de grafische kaart. Hoeveel betaalden de AIC's (@The Source) ongeveer voor de GPU's van Vega56/Vega64. Een ballpark-figure zou handig zijn. Stel dat ze €100 betaalden voor de Vega56 GPU en dat dat nu €115 zou worden nadat je het kleinere oppervlakte hebt weggestreept tegenover de hogere kosten per vierkante millimeter. For the sake of the argument. Dat lijkt me niet zo'n probleem als het vermogen veel lager ligt bij dezelfde performance.

Ik geloof niet dat er een Vega op '7 nm' komt voor gaming maar als die er zou komen dan zou die wel beter presteren omdat je minder problemen hebt met hitte en het dus sneller klokt. Het zou echter inderdaad niet veel goedkoper worden dan de huidige Vega-kaarten.

[ Voor 20% gewijzigd door Verwijderd op 25-09-2018 09:54 ]

Nee want die prijsverlaging per cel is gering. Vega 20 is ook geen refresh waar ze Vega 10 doodleuk op 7nm produceren. Nee, het is een andere chip. We weten in ieder geval al dat er een bredere geheugenbus is, en waarschijnlijk heeft Vega 20 beduidend meer transistoren dan Vega 10. Verder gaat de grafiek uit van 100% yield, en dat ga je niet halen. Vega 20 is waarschijnlijk de grootste chip die nu op 7nm gebakken zal worden, en die zal logischerwijs ook de slechte yields hebben.Olaf van der Spek schreef op dinsdag 25 september 2018 @ 09:25:

[...]

Waffers?

Waarom zou 7nm, rekening houdende met yields, niet veel duurder kunnen zijn dan 12nm?

[...]

Cell cost is lager, dan is 7nm toch alsnog goedkoper?

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

De man die Koduri opvolgde (van Nvidia afkomstig als ik me niet vergis) gaf laatst in een interview aan dat de performance per W voor hem het belangrijkste punt van focus is. Het zou me niet verbazen als onder hem de spanning eindelijk wordt verlaagd. Het is alleen jammer dat de reviewers niet wat meer kijken naar wat je uit de kaart kan halen met het aanpassen van de spanning en de klokfrequentie. Het zal best dat de meeste gebruikers het niet doen maar het is essentiële informatie voor de mensen die er geen moeite mee hebben om het zelf een beetje te tunen.Astennu schreef op maandag 24 september 2018 @ 15:05:

Door niet te hoog te locken kan je dit tegen gaan. nVidia gebruikt ook core voltages van 1.1v of iets lager. AMD 1.2 en soms 1.25v dat is gewoon te hoog dat zie je terug in je verbruik en zo veel hoger worden je clocks er niet van. Performance per watt zakt.

In dat geval komt het goed. Het moet heel erg gek lopen als Zen2 geen succes (financieel en performance) wordt voor AMD. Zeker nu Intel de ene na de andere blunder begaat en TSMC voorloopt op Intel qua node.DaniëlWW2 schreef op maandag 24 september 2018 @ 20:29:

Wat je wel redelijk kan analyseren en inschatten is dat Zen 2 waarschijnlijk het lot van de RTG zal bepalen.

[ Voor 81% gewijzigd door Verwijderd op 25-09-2018 10:22 ]

Was Vega wel zo'n ramp tho?DaniëlWW2 schreef op maandag 24 september 2018 @ 20:29:

[...]

Ik heb het niet over high-end.

Verder ken ik dat artikel. Het probleem is dat het wccftech is, a.k.a "WC tech". De site is alles behalve betrouwbaar dus neem ik alles van hun met een flinke lading zout.

Maar ik bijt wel.

Dit zou ik Navi scenario 2 willen noemen. Scenario 1 is dat Navi de laatste GCN architectuur is die in H1/2019 uit word gebracht. Een 7nm, mainstream chip die vergelijkbaar presteert met Vega. HBM2 vervangen voor GDDR6, minder CU's en hogere clockspeeds. Niks innovatiefs als product, maar je kan er 2019 mee doorkomen zonder nog meer dieprode cijfers en verlies van marktaandeel dat Polaris en Vega net terug hebben gewonnen. De naar mijn mening teleurstellende Turing zou het voor AMD alleen maar makkelijker maken om met een GCN Navi goed te verkopen.

Ik heb alleen geen idee wat de RTG gaat doen. Het zou goed kunnen dat na de Vega ramp, Koduri moest vertrekken en Navi vlak voor de tape-out is geschrapt en dat er nu in versnelt tempo word gewerkt aan "Next-Gen" die eigenlijk in 2020 uit zou moeten komen. Dit zou dan nu Navi heten. Ik weet alleen dat de roadmaps van AMD vager zijn gemaakt nadat Koduri vertrokken is, en ja dat was kennelijk mogelijk want RTG marketing en communicatie is gewoon beroerd. Verder lijkt meer R&D budget en personeel beschikbaar te zijn voor de RTG nu Zen 2 ook allang voltooid is en een deel van dat personeel kennelijk overgeplaatst is naar de RTG.

In totaal budget gaat het de goede kant op, maar ik heb geen breakdown gezien waar de budgetten naartoe gaan. Zie:

https://www.overclock3d.n...nce_this_time_last_year/1

https://www.overclock3d.n...ost_22_in_the_past_year/1

Wat je wel redelijk kan analyseren en inschatten is dat Zen 2 waarschijnlijk het lot van de RTG zal bepalen. AMD heeft wanhopig een "oorlogskas" nodig om verregaande, diepgaande investeringen te doen in de RTG om hun achterstand in te lopen op gebied van high-end gaming, Deep Learning en de softwarestacks voor Deep Learning. Zen 2 kan hiervoor zorgen omdat Zen 2 bestemd lijkt voor grootsheid. Daarmee bedoel ik zowel Athlon als Opteron grootheid bij elkaar en veel groter komt het niet dan die twee voor AMD. Door het falen van het 10nm productieproces van Intel kan Zen 2 zomaar de beste CPU ooit worden voor AMD. AMD begint ook nog eens met de uitrol met Epyc 2, een product waar ze makkelijk duizenden dollars winst per CPU op gaan maken. Verkoop daar maar miljoenen exemplaren van en dat gaat optellen.

Zen 2 haar succes is ook sterk verbonden aan AMD haar marktwaarde en dus overlevingskansen op lange termijn. Die is nu dankzij de enorme koersstijging meer dan $30 miljard, maar dat is nog steeds een kleintje vergeleken met Intel of Nvidia. Het is waarschijnlijk niet genoeg om doormiddel van een aandelenemissie nu de benodigde miljarden op te halen. Nog niet, want Zen 2 kan hier ook bij helpen.

Qua Gaming kaart wel maar hij was gemaakt voor het datacenter en volgens mij doet de Instinct lijn het best aardig?

Ik ga op dit moment er voor de veiligheid nog steeds van uit dat Navi mogelijk nog GCN gebruikt 7nm met 64 CU's zou een kaart op kunnen leveren die net wat sneller is als Vega maar wel goedkoper te maken als je het maar in grote aantallen doet.

Voor AMD ziet het er op de CPU markt erg goed uit met Zen2. Een nog betere architectuur waar de zwaktes van Zen1 aangepakt kunnen worden die gemaakt wordt op 7nm waar intel moeite blijft houden met 10nm. Ze hebben nu de kans om Intel komend jaar voorbij te gaan qua performance op de Desktop en in de servermarkt.

Vega 20 is een compute chip en die extra transistors heb je niet nodig in een gaming chip. Dat zie je al bij vega dat is ook een compute chips maar Vega 20 als het goed is nog wat meer. Die zijn beide gemaakt voor het datacenter. Dus dat zie ik niet snel gebeuren. De antwoorden van Lisa geven dat ook wel een beetje aan. Maar dat er wel gewerkt wordt aan een 7nm Gaming chip maar dat is dan Navi.madmaxnl schreef op dinsdag 25 september 2018 @ 01:09:

[...]

Waarom niet Navi zoals jij hem hier beschrijft achterwegen laten en Vega 20 (7nm) ook naar consumenten brengen? Vega 20 is reeds al gespot en de die size wordt geschat op ~360mm2. De helft van een TU102 dus qua prijs moet dat toch wel interessant gemaakt kunnen worden?

Lijkt me sterk dat 7nm waffers het dubbele kosten van een 12nm waffer bij TSMC. Let wel, als de yields gelijk zijn bij beide processen dan is die Vega 20 op 7nm alsnog goedkoper als de TU102 op 12nm.

Sommige revieuw sites hebben dat met Vega wel gedaan maar niet alle. En de meeste mensen gebruiken kaarten out of the box dus opzich ook wel terecht dat ze zo testen.Verwijderd schreef op dinsdag 25 september 2018 @ 09:57:

Een logisch verhaal, de grootste chip voor de kaarten waarbij de winstmarges zeer hoog zijn. Ondertussen kan TSMC het productieproces verbeteren waardoor we over pak hem beet 2-3 jaar ook een grote chip bij de gaming-kaarten kunnen krijgen.

[...]

De man die Koduri opvolgde (van Nvidia afkomstig als ik me niet vergis) gaf laatst in een interview aan dat de performance per W voor hem het belangrijkste punt van focus is. Het zou me niet verbazen als onder hem de spanning eindelijk wordt verlaagd. Het is alleen jammer dat de reviewers niet wat meer kijken naar wat je uit de kaart kan halen met het aanpassen van de spanning en de klokfrequentie. Het zal best dat de meeste gebruikers het niet doen maar het is essentiële informatie voor de mensen die er geen moeite mee hebben om het zelf een beetje te tunen.

Wie weet wordt het nu inderdaad beter. Met CPU's is AMD al jaren bezig om ze efficiënter te maken. Dat starte eigenlijk al met Kaveri, steamroller en Excavator deden er steeds een schepje boven op. Zen weer een grote en ik verwacht bij Zen2 ook weer een verbeterde performance per watt.

Bij GPU's is dat een beetje geweest bij Polaris bij Vega was het weer een stap de verkeerde kant op. De Polaris refresh verbruikte ook weer meer want daar zijn ze ook vol op clockspeeds gegaan.

Gebruikers kijken denk ik als eerste toch nog naar prestaties dan geluid productie en dan verbruik. Maar het is wel een punt wat steeds belangrijker wordt. Vind ik zelf ook. Ik tweak het zelf nog wel maar ik hoop dat AMD het nu ook anders gaat doen. Dan maar langzamer dan intel. Goede prijsstelling goed verbruik en een stillere cooler en je hebt een mooi en interessant product.

[ Voor 16% gewijzigd door Astennu op 25-09-2018 10:25 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Dit is voor mij een en/en verhaal. Je test het out of the box voor de n00bs en je geeft in dezelfde review aan wat eruit gehaald kan worden met een beetje tuning. Een Ja, sommige reviewers hebben het wel getuned maar je merkte dat sommigen van hen niet wisten hoe je dat aan moet pakken.Astennu schreef op dinsdag 25 september 2018 @ 10:20:

Sommige revieuw sites hebben dat met Vega wel gedaan maar niet alle. En de meeste mensen gebruiken kaarten out of the box dus opzich ook wel terecht dat ze zo testen.

Soms kan het hand in hand gaan, een lager vermogen en een hogere performance. Als je op architectuurniveau onnodig extra vermogen voorkomt dan heb je een lager vermogen bij dezelfde performance en een hogere performance bij hetzelfde vermogen.Bij GPU's is dat een beetje geweest bij Polaris bij Vega was het weer een stap de verkeerde kant op. De Polaris refresh verbruikte ook weer meer want daar zijn ze ook vol op clockspeeds gegaan.

Gebruikers kijken denk ik als eerste toch nog naar prestaties dan geluid productie en dan verbruik. Maar het is wel een punt wat steeds belangrijker wordt. Vind ik zelf ook. Ik tweak het zelf nog wel maar ik hoop dat AMD het nu ook anders gaat doen. Dan maar langzamer dan intel. Goede prijsstelling goed verbruik en een stillere cooler en je hebt een mooi en interessant product.

Ik kijk zelf naar alle drie de factoren omdat het vermogen mede de gebruikskosten bepaalt. Het is niet een heel erg groot aandeel maar als je een kaar 4+ jaar gebruikt dan is het wel handig om er rekening mee te houden. Echter koop ik enkel nog AMD-kaarten dus valt er voor mij weinig te kiezen.

Vega was lastiger te tweaken. Ik weet nog wel dat ik een paar dagen lekker bezig ben geweest om alles uit te vogelen vooral hoe je onder die 1050mv grens moest komen. Dus ik kan mij voorstellen dat de reviewers daar op dag 1 ook nog niet achter waren. Maar het zou wel mooi zijn als ze daar mee mee doen echter zie ik dat niet snel gebeuren. Kost ze te veel tijd.Verwijderd schreef op dinsdag 25 september 2018 @ 10:36:

[...]

Dit is voor mij een en/en verhaal. Je test het out of the box voor de n00bs en je geeft in dezelfde review aan wat eruit gehaald kan worden met een beetje tuning. Een Ja, sommige reviewers hebben het wel getuned maar je merkte dat sommigen van hen niet wisten hoe je dat aan moet pakken.

[...]

Soms kan het hand in hand gaan, een lager vermogen en een hogere performance. Als je op architectuurniveau onnodig extra vermogen voorkomt dan heb je een lager vermogen bij dezelfde performance en een hogere performance bij hetzelfde vermogen.

Ik kijk zelf naar alle drie de factoren omdat het vermogen mede de gebruikskosten bepaalt. Het is niet een heel erg groot aandeel maar als je een kaar 4+ jaar gebruikt dan is het wel handig om er rekening mee te houden. Echter koop ik enkel nog AMD-kaarten dus valt er voor mij weinig te kiezen.

Voor mij is AMD momenteel ook de enige optie. nVidia na GPP is een no go. Dan maar een minder snelle kaart i dont care. + mijn getweakte vega 64 LC is erg snel kom geen performance te kort op 1440p.

Intel zou ook terug komen naar de grafische markt maar daar verwacht ik in het begin weinig van hooguit een kaart die in het RX560 / RX570/580 segment mee doet. En drivers die nog werk nodig hebben. Die zullen ook 1-2 generatie nodig hebben om de boel beter op orde te krijgen.

+ ik vind intel ook niet echt een geweldige toko dus houd het liever bij AMD. Volgend jaar de Intel CPU er uit voor een Zen2. Met 8 of meer cores heb je dan ook genoeg snelheid voor de komende 3 jaar. (als ik zie hoe lang mijn 4790K mee gegaan is... pas bij de 8600K vervangen.)

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik weet de GPU kosten niet.Verwijderd schreef op dinsdag 25 september 2018 @ 09:50:

[...]

Wafer cost. Ik reageerde op deze opmerking van Daniel.

[...]

[...]

Dat lijkt mij inderdaad belangrijker.

Verder, de kosten van de GPU bedragen maar een deel van de kosten van de grafische kaart. Hoeveel betaalden de AIC's (@The Source) ongeveer voor de GPU's van Vega56/Vega64. Een ballpark-figure zou handig zijn. Stel dat ze €100 betaalden voor de Vega56 GPU en dat dat nu €115 zou worden nadat je het kleinere oppervlakte hebt weggestreept tegenover de hogere kosten per vierkante millimeter. For the sake of the argument. Dat lijkt me niet zo'n probleem als het vermogen veel lager ligt bij dezelfde performance.

Ik geloof niet dat er een Vega op '7 nm' komt voor gaming maar als die er zou komen dan zou die wel beter presteren omdat je minder problemen hebt met hitte en het dus sneller klokt. Het zou echter inderdaad niet veel goedkoper worden dan de huidige Vega-kaarten.

Ik weet wel dat GPU + Memory de grootste kosten zijn.

3rde kosten factor is de koeling, echter gok ik dat dit ongeveerd hetzelfde is als de PCB met alle aansluitingen. Ik zal wel eens navragen hoe de verhoudingen liggen.

Verwijderd

Bedankt.The Source schreef op dinsdag 25 september 2018 @ 11:13:

[...]

Ik weet de GPU kosten niet.

Ik weet wel dat GPU + Memory de grootste kosten zijn.

3rde kosten factor is de koeling, echter gok ik dat dit ongeveerd hetzelfde is als de PCB met alle aansluitingen. Ik zal wel eens navragen hoe de verhoudingen liggen.

Leg eens uit wat precies het probleem was om dit te bepalen? Uiteraard omdat er meer nodig was dan enkel de klokfrequentie verlagen maar wat precies? Ik heb er zelf niet mee kunnen spelen maar ik begrijp dat het lastig was dat de software van AMD een eigen willetje heeft en dat je ook andere parameters ('vermogen'?) moet wijzigen. Ik weet dat jij jouw ervaringen hebt gedeeld in de Vega-ervaringen draad maar een beknopte samenvatting maakt het wat overzichtelijker.Astennu schreef op dinsdag 25 september 2018 @ 10:44:

[...]

Vega was lastiger te tweaken. Ik weet nog wel dat ik een paar dagen lekker bezig ben geweest om alles uit te vogelen vooral hoe je onder die 1050mv grens moest komen.

Ik verwijt de reviewers niet dat ze dat niet in een dag tijd uitvogelen en ik vind het ook niet een probleem als ze het helemaal niet zelf uitgevogeld krijgen (niet iedereen heeft die 'bèta'-genen