How do you save a random generator ?

There fixed itenchion schreef op dinsdag 29 januari 2019 @ 11:14:

nVidia kan altijd nog naar GlobalFoundries Samsung ?

Ironisch juist op een tijdstip dat wellicht 99.99% denkt waarom zou nVidia in godsnaam een overstap naar Samsung nog maar overwegen laat staan effectief uitvoeren.

PS: voor dat men de fix te bruut vindt: GlobalFoundries heeft 7nm al lang opgegeven en is dus niet langer een valide kandidaat hoe grappig/ironisch het ook zou zijn.

[ Voor 18% gewijzigd door lightdestroyer op 29-01-2019 17:00 ]

Softbank Sells Entire $3.6 Billion Nvidia Investment

Hun buildup schijnt ergens tot medio 2017 te zijn geweest dus toch nog wel leuk rendementje maar die waren denk ik toch liever een half jaartje geleden uitgestapt.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Dat is lastig te voorspellen, maar ik verwacht dit jaar geen 7 nm high-end GPU van Nvidia. Een high-end Navi GPU komt toch pas op z'n vroegst in 2020 op de markt, en tot die tijd kan Turing zich prima meten met de Radeon VII.Verwijderd schreef op zaterdag 9 februari 2019 @ 01:25:

[...]

Ik ben benieuwd wat Nvidia gaat doen, plannen ze voor rond dezelfde tijd een nieuwe generatie kaarten op 7 nm. of wachten ze tot eind 2020 of beging 2021? Hoe dan ook, voor mij geen Nvidia.

En het is ook niet bekend of Nvidia wil wachten op 7 nm EUV voor zijn volgende generatie GPU's.

https://www.guru3d.com/ar...ormance_benchmarks,8.html

[ Voor 63% gewijzigd door Gekke Jantje op 13-02-2019 16:38 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

https://www.techpowerup.c...ng-resolution-limitations

Interessante DLSS tests met side by side IQ vergelijking plaatjes met sliders:

https://www.techpowerup.c...lysis/Battlefield_V_DLSS/

https://www.techpowerup.c...ce_Analysis/Metro_Exodus/

[ Voor 45% gewijzigd door Help!!!! op 14-02-2019 09:33 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

[ Voor 44% gewijzigd door Paprika op 14-02-2019 11:24 ]

MSI GeForce GTX 1660 Ti VENTUS XS and TU116 GPU pictured

https://videocardz.com/80...xs-and-tu116-gpu-pictured[ Voor 34% gewijzigd door -The_Mask- op 14-02-2019 19:27 ]

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

YouTube: RTX Global Illumination On vs. Off: Metro Exodus Technical Analysis

[ Voor 41% gewijzigd door Verwijderd op 14-02-2019 19:50 ]

Wat ik jammer vind aan de vergelijking (ze melden het wel dacht ik) is dat het verschil extra groot is doordat er zonder RTX GI helemaal geen GI meer inzit.Verwijderd schreef op donderdag 14 februari 2019 @ 19:48:

Voor wie het interessant vindt, GamersNexus heeft een video waarin ze voor Metro met en zonder dat vergelijken.

YouTube: RTX Global Illumination On vs. Off: Metro Exodus Technical Analysis

CryEngine (en Crysis) heeft al heel lange tijd GI maar dan met voxels.

Het zou erg mooi zijn als er een echte vergelijking tussen die twee technieken was en welke de beste trade of heeft qua performance/image quality.

Verwijderd

[ Voor 25% gewijzigd door Gekke Jantje op 15-02-2019 06:50 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

https://www.realworldtech.com/physx87/

[ Voor 22% gewijzigd door Verwijderd op 15-02-2019 07:47 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Sterker nog, volgens mij wordt AMD juist bevoordeeld door Nvidia haar implementatie van RTX in games. Nvidia betaald die developer studio's gewoon voor de implementatie van real time ray tracing. Een functie die de meeste gamers gewoon uit zetten omdat het te veel frames kost.Paprika schreef op vrijdag 15 februari 2019 @ 10:29:

Hoezo is AMD hierin benadeeld? Het merendeel van de NVIDIA gamers heeft ook geen Turing kaart.

Onderdeel van de implementatie die vrijwel iedereen uitzet, is dat de game een goede DX12 implementatie nodig zal hebben. En bedankt Nvidia want dan gaan Polaris en Vega kaarten regelmatig voorbij de Pascal tegenhangers. Het meest recente voorbeeld is dat de BF5 DX12 implementatie nu gewoon goed werkt wat bij launch zeker niet zo was. Vindt mijn Ryzen+Vega systeem leuk dus bedankt Nvidia.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

In de vorige metro game was het buiten ook gewoon licht en in de tunnels is het stik donker. Het is echter wel zo dat je nu vaker naar buiten gaat.Verwijderd schreef op vrijdag 15 februari 2019 @ 07:38:

Het gaat wat verder dan enkel de graphics, een deel van de charme van een FPS-spel wat richting horror leunt is dat donker netjes donker is wat het geval is bij de eerste Metro, zelfs al zou het minder goed uitgewerkt zijn dan met RTX-GI. Los daarvan gaat het voor mij ook om het principe dat AMD nu weer als tweederangsplatform wordt behandeld door een developer (aangezien het geen GI krijgt). Nu zou ik sowieso langer wachten met een speellicentie voor een dergelijk spel te kopen (het is singleplayer, het maakt weinig uit als je het 2 jaar later speelt) maar nu ga ik ook als criterium hanteren dat mijn toekomstige AMD-kaart dit spel met RTX-GI (en PhysX uiteraard maar dat lost Ryzen waarschijnlijk wel op, ondanks de gimping door Nvidia via X87) moet kunnen draaien met >>60 FPS. Prima, dan wacht ik wel 3-5 jaar en koop ik een speellicentie voor €4.

https://www.realworldtech.com/physx87/

Nvidia Highlight zit er blijkbaar ook in.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

Die zijn eveneens benadeeld. Developertijd die anders allicht gebruikt zou zijn om voor iedereen iets netjes uit te werken is nu gebruikt voor een zeer kleine minderheid van de gamers.Paprika schreef op vrijdag 15 februari 2019 @ 10:29:

Hoezo is AMD hierin benadeeld? Het merendeel van de NVIDIA gamers heeft ook geen Turing kaart.

[ Voor 10% gewijzigd door Verwijderd op 15-02-2019 12:28 ]

Dat geldt voor iedere nieuwe techniek. Als dit leidend zou zijn dan zat je nu nog naar games te kijken zonder shaders...Verwijderd schreef op vrijdag 15 februari 2019 @ 12:26:

Ik hoop dat Daniël zijn voorspelling (goede DX12-support en deze keer niet een slappe patch) uitkomt.

[...]

Die zijn eveneens benadeeld. Developertijd die anders allicht gebruikt zou zijn om voor iedereen iets netjes uit te werken is nu gebruikt voor een zeer kleine minderheid van de gamers.

Dat is geen voorspelling maar een simpele deductie. Lekker de RTX SDK implementeren op een game die niet fatsoenlijk draait op DX12. Gaat niet gebeuren.Verwijderd schreef op vrijdag 15 februari 2019 @ 12:26:

Ik hoop dat Daniël zijn voorspelling (goede DX12-support en deze keer niet een slappe patch) uitkomt.

Je kan ook flink wat tijd besparen door gewoon geen DX12 ondersteuning in te bouwen.[...]

Die zijn eveneens benadeeld. Developertijd die anders allicht gebruikt zou zijn om voor iedereen iets netjes uit te werken is nu gebruikt voor een zeer kleine minderheid van de gamers.

Dump alle licht en physics effecten ook meteen, net zoals hoge resolutie textures, AA en dump alle culling technieken ook meteen maar. Dan hou je een spuuglelijke game over en haal je 5fps. Geweldig...

Zie je nu echt niet in dat dit zinloos is? Grafische kwaliteit ontwikkelen is tijdrovend en complex. Wees blij dat er nog studio's zijn die dit doen en nog steeds innoveren. Het is echt niet meer vanzelfsprekend dat er echt moeite word gedaan om de kwaliteit van de gameplay, laat staan grafische kwaliteit te verhogen in videogames.

Nota bene heb ik Metro Exodus niet eens gevolgd, maar de game is kennelijk vandaag uitgebracht. Even snel naar Guru3D gegaan en ja hoor, de AMD kaarten presteren hardstikke goed want DX12. Wat een schok...

https://www.guru3d.com/ar...ormance_benchmarks,6.html

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Of zouden ze de 1660TI ook gewoon op 300+ euro gooien? Hopelijk eronder, maar Nvidia's prijzen tegenwoordig...

[ Voor 9% gewijzigd door Goron op 15-02-2019 16:35 ]

Ik denk wel competitief, maar niet aantrekkelijk.Goron schreef op vrijdag 15 februari 2019 @ 16:30:

Denken jullie dat de 1660 TI competitief geprijsd gaat zijn? Ben opzoek naar iets net wat sterker dan de rx580 (~210euro) maar er is eigenlijk niets ertussen tot de vega56 en rx2080 die op 360+ euro beginnen.

Of zouden ze de 1660TI ook gewoon op 300+ euro gooien? Hopelijk eronder

Mechwarrior Online: Flapdrol

Hoe zie je dat? Een competitieve prijs die niet aantrekkelijk is?haarbal schreef op vrijdag 15 februari 2019 @ 16:43:

[...]

Ik denk wel competitief, maar niet aantrekkelijk.

Een GTX 1660 Ti 6GB krijgt een prijs van 279 dollar mee dat is met de huidige dollar-euro koers 300 euro incl. BTW. Daar zullen de goedkoopste versies dus vanaf te krijgen zijn. En dan heb je natuurlijk ook nog duurdere versies die totaal oninteressant zijn natuurlijk, omdat ze (bijna) de prijs hebben van een videokaart met snellere GPU.Goron schreef op vrijdag 15 februari 2019 @ 16:30:

Denken jullie dat de 1660 TI competitief geprijsd gaat zijn? Ben opzoek naar iets net wat sterker dan de rx580 (~210euro) maar er is eigenlijk niets ertussen tot de vega56 en rx2080 die op 360+ euro beginnen.

Of zouden ze de 1660TI ook gewoon op 300+ euro gooien? Hopelijk eronder, maar Nvidia's prijzen tegenwoordig...

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Mijn glazen bol zegt me ongeveer een GTX1070 voor €300+.Goron schreef op vrijdag 15 februari 2019 @ 16:30:

Denken jullie dat de 1660 TI competitief geprijsd gaat zijn? Ben opzoek naar iets net wat sterker dan de rx580 (~210euro) maar er is eigenlijk niets ertussen tot de vega56 en rx2080 die op 360+ euro beginnen.

Of zouden ze de 1660TI ook gewoon op 300+ euro gooien? Hopelijk eronder, maar Nvidia's prijzen tegenwoordig...

We weten dat de GTX1660Ti 1536 Cuda Cores heeft terwijl de RTX2060 er 1920 heeft. 20% cut dus waardoor je waarschijnlijk net boven een GTX1070 gaat uitkomen. MSRP zou $279 zijn, dus €300+ hier. Als jij dat interesant vind, vooral doen. Ik zou het dus niet eens overwegen voor zo'n schamele performance upgrade.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

Ik heb er geen probleem mee dat ze investeren in nieuwe technieken, graag. Het liefst zoals Crytek dat deed en dan niet terugkrabbelen bij een tweede deel van het spel omdat de consoles het anders niet kunnen draaien. Alleen is het de vraag of dat raytracing de beste investering voor nu is. Voor over 3-6 jaar, sure. Nu? Misschien eerst nog wat meer uit de shaders halen?

Dat is niet zo moeilijk. Kijk naar de prijs van de 1070 Ti vs. die van de Vega56 en je hebt je antwoord. De 1660 Ti wordt ingezet tegen de RX 590 zoals de 1070 Ti werd ingezet tegen de Vega56.Goron schreef op vrijdag 15 februari 2019 @ 16:30:

Denken jullie dat de 1660 TI competitief geprijsd gaat zijn?

Het is niet de bedoeling om hier aankoopadvies te vragen/geven maar ik geef wel mee dat het in essentie om 3 jaar oude kaarten gaat.

[ Voor 62% gewijzigd door Verwijderd op 15-02-2019 18:35 ]

Price/performance die beter is dan de concurrentie rond dat prijspunt, maar niet beter dan de 2060.-The_Mask- schreef op vrijdag 15 februari 2019 @ 17:03:

Hoe zie je dat? Een competitieve prijs die niet aantrekkelijk is?

Mechwarrior Online: Flapdrol

Kan mij moeilijk voorstellen dat die geen betere prijs/prestatie gaat hebben. De GPU is duidelijk kleiner en goedkoper te maken o.a. doordat die geen tensor en raytracing cores heeft. Het is dus logisch dat de prijs/prestatie beter gaat zijn.haarbal schreef op vrijdag 15 februari 2019 @ 18:13:

[...]

Price/performance die beter is dan de concurrentie rond dat prijspunt, maar niet beter dan de 2060.

Daarnaast weten we dat de RTX 2060 een prijs krijgt die 25% hoger ligt en het aantal cudacores is ook 25% hoger. Aangezien cores niet zorgen voor een perfecte schaling zullen de prestaties bij dezelfde frequenties niet 25% hoger liggen.

De prijs/prestatie gaat dus alleen slechter zijn als de frequentie van de GPU flink lager gaat zijn. Dat zie ik niet gebeuren. Ik verwacht eerder nog iets hoger omdat de GPU simpeler is en kleiner. Ik ga er dan ook vanuit dat de prijs/prestatie een klein beetje beter gaat zijn dan de RTX 2060.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Sinds wanneer heb jij er een probleem mee als Nvidia de verkeerde beslissing neemt? Zeker als ze voor deze beslissing ook nog eens DX12 moeten gaan pushen waar AMD relatief meer baat bij heeft? Weet wat je wenst hoor.Verwijderd schreef op vrijdag 15 februari 2019 @ 17:55:

@Paprika en @DaniëlWW2

Ik heb er geen probleem mee dat ze investeren in nieuwe technieken, graag. Het liefst zoals Crytek dat deed en dan niet terugkrabbelen bij een tweede deel van het spel omdat de consoles het anders niet kunnen draaien. Alleen is het de vraag of dat raytracing de beste investering voor nu is. Voor over 3-6 jaar, sure. Nu? Misschien eerst nog wat meer uit de shaders halen?

Nvidia is oh zo makkelijk te voorspellen als je de grote lijnen eenmaal ziet. Het bedrijf is al bijna twintig jaar bezig om steeds het volgende grote ding in grafische ontwikkelingen, te ontwikkelen. Het moet veel transistoren innemen zodat het niet kan werken op geïntegreerde chips. Zo probeert Nvidia telkens hun bestaansrecht te behouden. Of het nu unified shaders waren, GPGPU of nu ray tracing is verder niet relevant.

Wel relevant is dat Nvidia er enorm belang bij heeft om ray tracing keihard te pushen. Nvidia ontwikkeld haar GPU chips altijd top down. Ze ontwerpen eerst de grootste chip en schalen die altijd naar beneden. Nvidia architecturen zijn ook altijd schaalbaar en modulair in ontwerp. Dit doen ze omdat het de kosten enorm drukt en ze alle R&D voor de grootste chip kunnen hergebruiken voor de rest van een nieuwe lijn.

Dit moeten ze doen omdat ook Nvidia financiële grenzen heeft. Zeker nu de Pascal bubbel voorbij is en de omzet flink terugloopt zal Nvidia door moeten zetten met naar beneden schalen. Nvidia kan nu haar R&D nog over miljoenen chips uitsmeren, maar dat gaat de komende jaren moeilijker worden. De APU staat al klaar om het €100 en lagere segment volledig op te slokken. Zeker AMD gaat daar ook niet stoppen. Die zullen rustig werken tot minstens het €150 segment. Dat zijn miljoenen chips minder voor Nvidia om hun R&D kosten over te spreiden. Komt nog eens bij dat Nvidia een relatief grote klant zal zijn bij TSMC. Nvidia produceert vrijwel altijd grote chips en dat zijn nu eenmaal veel meer wafers dan een vergelijkbaar aantal voor kleine mobiele SoC's. Ongetwijfeld zullen ze enige korting kunnen bedwingen op de prijs per wafer. Zakt Nvidia haar afgenomen volume, dan verdwijnen die kortingen.

Dit gaat een vicieuze cirkel worden voor Nvidia als ze niks doen. Daarom is Nvidia opeens van closed source en conservatief naar open source en progressief gegaan. Die ontwikkeling is niet mals. Opeens is het Nvidia dat meer doet om low level API's geadopteerd te krijgen dan AMD. Ze moeten wel want ze willen een flink marktaandeel behouden en bedienen met ray tracing. Dat stopt de opmars van de APU weer voor jaren en jaren.

Ergo de komende generaties van Nvidia hardware gaan proportioneel meer inzetten op ray tracing dan shaders. Natuurlijk blijft Nvidia shader prestaties verbeteren, maar dat is niet meer de primaire focus. Die focus zal komen te liggen op realtime ray tracing daadwerkelijk mogelijk maken. Eerst met wat effecten en acceptabele framerates. Daarna elke generatie meer en betere ray tracing. Daar zullen de extra transistoren die vrijkomen bij elke die shrink dan ook primair naartoe gaan.

AMD gaat de komende generaties meer de remmende factor worden in innovatie, niet Nvidia. DX12 pushen? Zeker, maar ray tracing waarschijnlijk niet. AMD heeft van Nvidia een enorme kans gekregen om in te lopen op shader prestaties en die gaan ze grijpen. AMD kan de komende generaties gewoon telkens met een lijn van kleinere chips komen die ze goedkoper in de markt zetten dan de Nvidia tegenhanger. Nvidia kan er niks aan doen omdat ze gecommitteerd zijn aan ray tracing adoptie en dus met grotere chips en smallere marges gaan werken. Voor AMD zullen twee of drie discrete chipontwerpen de komende generaties genoeg zijn terwijl Nvidia waarschijnlijk naar vier of vijf chips zal moeten kijken om maar kosten te drukken. Dat doen ze nu al met Turing en dat gaat niet veranderen. AMD kan in principe wegkomen met eentje voor het €100-€200 segment, eentje voor €200-€300 en eentje voor €300-€400. Die laatste gaat het Nvidia echt moeilijk maken omdat Nvidia hier de meeste ray tracing hardware zal toevoegen terwijl AMD niks doet. Hier gaat AMD, Nvidia keihard bevechten op prijs/shader prestaties.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Vanwege de veel lagere productiekosten en het weglaten van rtx had ik gehoopt op echt betere price/performance.-The_Mask- schreef op vrijdag 15 februari 2019 @ 18:26:

Ik ga er dan ook vanuit dat de prijs/prestatie een klein beetje beter gaat zijn dan de RTX 2060.

Mechwarrior Online: Flapdrol

Verwijderd

- voor 1080p volstaat zelfs de RX 570 met 4 GB al als je de instellingen iets aanpast en de RX 580 en GTX 1060 6 GB voor 1080p zonder compromissen en ook nog redelijk 1440p

- wil je 1440p zonder compromissen (visuele kwaliteit of FPS) dan ga je hoger moeten mikken: GTX 1070 Ti of Vega56, misschien GTX 1070. Dadelijk ook die 2060 of zo.

Wil je dan echt meer besteden aan een iets betere '1080p-kaart', ook al is de performance/prijs iets beter?

Dan toch beter 1-2 segmenten hoger kopen en dan wellicht het liefst een segment waarbij je voor de komende paar jaar 1440p met hoge instellingen en een hoge FPS kan spelen? Of 1-2 segmenten lager en genoegen nemen met 1080p.

[ Voor 3% gewijzigd door Verwijderd op 15-02-2019 18:45 ]

Dan zouden ze hun RTX 2060 uit de markt prijzen. Daarnaast is het natuurlijk voor nVidia ook niet nodig. Ze hebben met een GTX 1660 Ti, Vega 56 prestaties tegen een fractie van de kosten.haarbal schreef op vrijdag 15 februari 2019 @ 18:43:

[...]

Vanwege de veel lagere productiekosten en het weglaten van rtx had ik gehoopt op echt betere price/performance.

Dan zul je zien dat jouw bericht maar van toepassing is op één game, terwijl er miljoenen games zijn die allemaal verschillend presteren. Je kunt dus nooit hetgeen zeggen wat jij nu doet omdat het voor elke game anders is. Ook voor elk persoon trouwens omdat iedereen verschillende games speelt.Verwijderd schreef op vrijdag 15 februari 2019 @ 18:44:

Als je dan kritisch kijkt:

[ Voor 34% gewijzigd door -The_Mask- op 15-02-2019 19:23 ]

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Vergelijkings plaatje van SVOGI in CryEngine (kan niet binnen img tags helaas):

https://imgsli.com/MTQzOA

Nu vraag ik mij serieus af of GI via raytracing dan de goede manier is (op dit moment van spreken, misschien verandert dit over 5 jaar).

Bronnen:

https://forums.unrealengi...for-epic/659-svogi/page11

https://www.gamersnexus.n...rk-built-in-vs-game-tests

Nog een leuke toevoeging van Nvidia zelf... :P:

[ Voor 8% gewijzigd door Sp3ci3s8472 op 15-02-2019 19:30 ]

Volgens mij heeft een rx580 wel moeite om bijvoorbeeld in Witcher 3 60frames te halen op 1080p. Dus iets meer speling zou wel nice zijn voor games als Cyberpunk2070 in de toekomst. Ik hoop gewoon dat de 1660 TI op rx580 prijs/performance zit maar 25% sneller en 25% duurder. Daar is nu gewoon niks te koop. De rx590 is z'n meerprijs tov de 580 niet waard.Verwijderd schreef op vrijdag 15 februari 2019 @ 18:44:

Met betrekking tot die prijs/performance discussie, performance/prijs is belangrijk maar wel in samenhang met het minimale performance-niveau wat je nodig hebt of wil. Als je dan kritisch kijkt:

- voor 1080p volstaat zelfs de RX 570 met 4 GB al als je de instellingen iets aanpast en de RX 580 en GTX 1060 6 GB voor 1080p zonder compromissen en ook nog redelijk 1440p

- wil je 1440p zonder compromissen (visuele kwaliteit of FPS) dan ga je hoger moeten mikken: GTX 1070 Ti of Vega56, misschien GTX 1070. Dadelijk ook die 2060 of zo.

Wil je dan echt meer besteden aan een iets betere '1080p-kaart', ook al is de performance/prijs iets beter?

Dan toch beter 1-2 segmenten hoger kopen en dan wellicht het liefst een segment waarbij je voor de komende paar jaar 1440p met hoge instellingen en een hoge FPS kan spelen? Of 1-2 segmenten lager en genoegen nemen met 1080p

Maar goed we zullen het snel weten hoe de kaart is lijkt me, er zijn al fotos van de MSi versie

https://www.techpowerup.c...ds-for-gtx-1660-ti-launch

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

Nee hoor! TW3 haalt gemakkelijk 60 FPS @1080p. Zelfs met ultra-instellingen (eventueel dat Hairworks wat beperken op driver-niveau) als ik me niet vergis maar who gives a fuck? Alles met ultra-instellingen spelen is een n00b-fout, als je weet wat de verschillende instellingen doen en een beetje configureert dan krijg je een fors hogere FPS zonder dat je visueel verschil merkt. Ook de GTX 1060 kan gemakkelijk 60+ FPS halen bij dit spel. Het beste voor een dergelijk spel is om veel instellingen (niet alle instellingen!) een standje lager te zetten en dan met een FPS van rond de 80-90 het spel te spelen. Dan heb je uitstekende graphics en een goede FPS>Goron schreef op vrijdag 15 februari 2019 @ 23:46:

[...]

Volgens mij heeft een rx580 wel moeite om bijvoorbeeld in Witcher 3 60frames te halen op 1080p.

We weten natuurlijk niet wat voor hardware dat spel nodig heeft maar het argument dat je graag wat meer hebt voor toekomstige spellen snijdt hout. Alleen wacht dan op de zogenaamde 7nm. producten die in 2019 komen. Juist als dat belangrijk voor je is dan moet je aan het begin van een nieuwe node kopen (of wanneer om een andere reden het gat in performance groot is tussen twee generaties), niet 3 jaar na de start van de laatste node. Idem voor mensen die minder te besteden hebben en maximale waarde per € willen hebben.Dus iets meer speling zou wel nice zijn voor games als Cyberpunk2070 in de toekomst.

Een RX580 zit net rond of onder de 60fps in de Witcher 3. Spreek uit persoonlijke ervaring en het was een beetje een van de redenen waarom ik heel snel naar een Vega ging. Die game is werkelijk enorm en de variatie in framerates is serieus. In Novigrad of in de dichte bossen van Velen kan je het bijvoorbeeld wel vergeten. Helemaal als je ook nog eens grafische mods gaat draaien zoals ik doe.Goron schreef op vrijdag 15 februari 2019 @ 23:46:

[...]

Volgens mij heeft een rx580 wel moeite om bijvoorbeeld in Witcher 3 60frames te halen op 1080p. Dus iets meer speling zou wel nice zijn voor games als Cyberpunk2070 in de toekomst. Ik hoop gewoon dat de 1660 TI op rx580 prijs/performance zit maar 25% sneller en 25% duurder. Daar is nu gewoon niks te koop. De rx590 is z'n meerprijs tov de 580 niet waard.

Het probleem is dat alles boven de RX580 gewoon een waardeloze prijs/kwaliteit heeft of zal krijgen. Ik zou gewoon wachten tot Cyberpunk komt en dan een kaart kopen. Voor nu gewoon the Witcher 3 spelen en een beetje spelen met een paar instellingen van ultra naar high. Dan haal je wel 60fps+.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Blijkbaar zijn die tensor cores te traag om op 1440p 144hz DLSS te doen op de 2080 Ti. In plaats van dat komt Nvidia met een of ander vaag verhaal waarom het alleen aankan als de GPU zwaar belast is (wat geen enkele tech journalist zal geloven).Help!!!! schreef op donderdag 14 februari 2019 @ 09:30:

Interessant verhaaltje over DLSS resolutie limitaties.

https://www.techpowerup.c...ng-resolution-limitations

Interessante DLSS tests met side by side IQ vergelijking plaatjes met sliders:

https://www.techpowerup.c...lysis/Battlefield_V_DLSS/

https://www.techpowerup.c...ce_Analysis/Metro_Exodus/

Goed verhaal! Fijn dat je dit nieuwtje plaatst.Gekke Jantje schreef op zaterdag 16 februari 2019 @ 15:02:

Gaat lekker met Metro, wanneer Hairworks in beeld komt kost het ook geen fps. Nvidia heeft de boel een stuk beter geoptimaliseerd, zelfde geldt voor Advanced Physx. Super.

Daar heb je dus een ervaringen topic voor.

[ Voor 95% gewijzigd door Gekke Jantje op 16-02-2019 19:51 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

[ Voor 3% gewijzigd door Verwijderd op 16-02-2019 21:03 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Het is geen mening maar een feit.Verwijderd schreef op zaterdag 16 februari 2019 @ 21:03:

Laten we rustig wachten met een mening hierover te vormen totdat de gamers het kunnen spelen in plaats van enkel een paar techtubers en journalisten en 'journalisten'.

[ Voor 25% gewijzigd door dion_b op 18-02-2019 22:00 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

Je kan niet wanneer een spel net uit is en nog niet eens gespeeld kan worden door de gamers - op wat reviewers en techtubers na - al een goede mening vormen over hoe het werkt, dat duurt weken of maanden. Zie Final Fantasy 15 waarvan pas vele weken later duidelijk werd dat Hairworks nog aan stond wanneer je het uitzette voor dieren die buiten beeld waren.

Grafisch is het dik in orde. Mooiste game tot nu toe.

[YouTube: Metro: Exodus]

[ Voor 23% gewijzigd door Gekke Jantje op 17-02-2019 12:58 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Je kunt het toch gewoon spelen?Verwijderd schreef op zaterdag 16 februari 2019 @ 21:03:

Laten we rustig wachten met een mening hierover te vormen totdat de gamers het kunnen spelen in plaats van enkel een paar techtubers en journalisten en 'journalisten'.

Verwijderd

Ja, maar nog niet zo lang en nog een relatief kleine groep gamers wegens de exclusiviteit van die Epyc winkel. Vaak zie je bij spellen dat het een paar weken tot maanden duurt voordat alles aan het licht komt.

Geen idee, ik haal Nvidia's eigen voxel GI implementatie erbij als voorbeeld naast dat van CryEngine. Dat lijkt goed te werken, ik zou graag een keer een vergelijking zien van beide techieken.Gekke Jantje schreef op zaterdag 16 februari 2019 @ 19:35:

Bedankt voor de mededeling, echter is dit net zo veel nieuws als het negatieve over Gameworks wat hier beproken word. Sterker nog dat viel meestal in herhaling. Nu werkt Gameworks efficienter en dat is toch wre een nieuwtje.

Heb je dan gemeten dat Gameworks efficienter werkt dan daarvoor? Indien nee, dan blijft het een gevoelskwestie/mening en geen feit. Grote kans dat het gewoon beter lijkt te werken om dat je een snellere gpu hebt of een gpu die op bepaalde punten niet tegen een bottleneck aanloopt waar je oude dat wel deed.

Wie is we? Is dit een uitnodiging voor mij om op de man te gaan spelen of ga je gewoon je post aanpassen met een wat vriendelijkere inhoud?-The_Mask- schreef op zondag 17 februari 2019 @ 09:45:

We weten de specs al enkele weken en al jaren is bekend dat passmark een benchmark van niks is.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Zelfde artikel staat dat de launch dates van hardocp niet klopten en de juist zijn volgens hun 22 feb voor de 1660 Ti, begin maart voor de 1660 en eind maart voor de 1650.

Tot slot staat er nog een keer dat de 1660 1280 CUDA cores krijgt, de 1660 Ti 1536 en de RTX 2060 1920 (die is natuurlijk al uit).

Duiding: FF XV is niet de ideale benchmark, maar zou een 1660 Ti inderdaad GTX 1070 prestaties leveren voor $279 dollar dan is dat wel een Polaris (RX 590, MSRP $280) killer. Die is immers 20 tot 40% trager dan een GTX 1070 met dezelfde adviesprijs.

In de praktijk heb je momenteel overigens al een RX 580 voor minder dan 180 euro inclusief 2 games dus ben benieuwd wat ze met de prijs van de lagere modellen gaan doen.

[ Voor 79% gewijzigd door sdk1985 op 17-02-2019 17:16 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Verwijderd

[ Voor 19% gewijzigd door Verwijderd op 17-02-2019 18:49 ]

Als je gern tot misschien maar een paar fps performance verlies ziet en bij The Witcher 3 wel dan weer ik feitelijk genoeg en is het gewoon een feit. Nvidia optimaliseert ook al die effecten Zoals Physx en Hairworks.Sp3ci3s8472 schreef op zondag 17 februari 2019 @ 16:35:

[...]

Geen idee, ik haal Nvidia's eigen voxel GI implementatie erbij als voorbeeld naast dat van CryEngine. Dat lijkt goed te werken, ik zou graag een keer een vergelijking zien van beide techieken.

Heb je dan gemeten dat Gameworks efficienter werkt dan daarvoor? Indien nee, dan blijft het een gevoelskwestie/mening en geen feit. Grote kans dat het gewoon beter lijkt te werken om dat je een snellere gpu hebt of een gpu die op bepaalde punten niet tegen een bottleneck aanloopt waar je oude dat wel deed.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

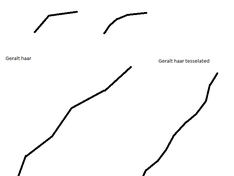

Ik wil je best geloven, maar het hangt gewoon van veel meer factoren af. Het kan prima zijn dat het tesselation level itt TW3 standaard een stuk lager staat. Daarnaast heeft Geralt van TW3 een grandiose haardos en de characters in Metro misschien maar 1 korte haar?Gekke Jantje schreef op zondag 17 februari 2019 @ 19:12:

[...]

Als je gern tot misschien maar een paar fps performance verlies ziet en bij The Witcher 3 wel dan weer ik feitelijk genoeg en is het gewoon een feit. Nvidia optimaliseert ook al die effecten Zoals Physx en Hairworks.

Op zijn minst zou je een benchmark kunnen draaien om te testen hoeveel % impact het heeft. Je zou ook nu het opensource is in de sourcecode kunnen kijken en zien of er bepaalde commits zijn waaruit je kan afleiden dat ze inderdaad iets hebben gedaan om de performance te verbeteren.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

We is gewoon iedereen die het topic volgt. De specs zijn gewoon langs gekomen, geen idee wat daar vreemd aan is. Passmark is ook al een hele oude benchmark en de mening daarover is ook altijd hetzelfde. Ik zou zeggen kijk de volgorde van de videokaarten of CPU's maar eens. Deze discussie, als je het al een discussie kunt noemen, is echt al heel vaak gevoerd.sdk1985 schreef op zondag 17 februari 2019 @ 16:55:

[...]

Wie is we? Is dit een uitnodiging voor mij om op de man te gaan spelen of ga je gewoon je post aanpassen met een wat vriendelijkere inhoud?

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Je snapt het punt van @sdk1985 niet.-The_Mask- schreef op zondag 17 februari 2019 @ 20:33:

[...]

We is gewoon iedereen die het topic volgt. De specs zijn gewoon langs gekomen, geen idee wat daar vreemd aan is. Passmark is ook al een hele oude benchmark en de mening daarover is ook altijd hetzelfde. Ik zou zeggen kijk de volgorde van de videokaarten of CPU's maar eens. Deze discussie, als je het al een discussie kunt noemen, is echt al heel vaak gevoerd.

Hij maakt dezelfde opmerking is die ik een tijd geleden ook tegen je maakte. De toon van bijna al je posts is belerend/negatief/bot/ongezellig. Maakt niet uit dat je gelijk hebt, je klinkt als een botte hork.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Een konijn heeft waarschijnlijk een strand (haar) dat een keer gebogen wordt. Het haar van Geralt heeft strands die tig keer gebogen worden om het realistischer te maken.Gekke Jantje schreef op zondag 17 februari 2019 @ 19:49:

Je bedoeld meer tessellation in the Witcher 3. En nee een stuk of wat mutanten die op je afkomen hebben ern pak meer haar in zijn totaal. En zoals ik al zij kost het hooguit een paar fps. Het heeft gelijk effect bij het in en uitschakelen. Alleen al een konijn heeft meer haar dan Geralt.

Heb even een filmpje bekeken met een aantal mutants erin, en zoals ik verwachte die strands zijn hooguit een of 2-3 keer gebogen en daarna getessaleert. Daarnaast zijn die beesten behoorlijk kalend als je het mij vraagt.

Bronnen:

https://www.youtube.com/watch?v=PmfHhz88QiU

https://developer.nvidia....vidia-hairworks-witcher-3

Dit is in ieder geval mijn laatste reactie op jou wat betreft dit gespreksonderwerp. Het is weer de typische discussie manier van discussie voeren met jou, jij beweert iets zonder enige onderbouwing, feiten of metingen en laat het aan andere over het tegendeel te bewijzen.

Ik wil best met jou een discussie aangaan over dit onderwerp maar kom dan met een goede onderbouwing en zorg dat je tenminste enige basis kennis van de materie hebt.

[ Voor 1% gewijzigd door Sp3ci3s8472 op 17-02-2019 21:20 . Reden: bron 2 ]

Jij beweist overigen ook geen tegendeel wat fps impact beteft in Metro. De fps blijft aardig gelijk terwijl bij TW3 de fps bij dieren wat ook net stoo is aardig ver inkakt zoals bij ern grorp wolven of een beer. Zelfde geldt voor Garalt, en dan met name ingebouwen als Garalt dicht bij op het beeld komt

Zoals hier ook zie je dat de fps ook mooi stabiel blijft, dit is niet een hairworks aan en uit test. Dat zal ik later nog wel posten als het niet te oftopic is hier.

YouTube: Metro Exodus: Glorious Kill | Opgenomen met GeForce

[ Voor 62% gewijzigd door Gekke Jantje op 17-02-2019 21:56 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

Minstens zo belangrijk is de nauwkeurigheid. Als je bijvoorbeeld 32 bits gebruikt wanneer je het verschil tussen 16 en 32 bits niet ziet terwijl je met die 16 bits wel een aanzienlijk hogere FPS kan krijgen (bij Vega en later bij AMD bijna 2 keer zo hoog) of simpelweg meer haren kan tekenen met dezelfde FPS en het aantal haren is al snel belangrijker voor het visuele effect dan de nauwkeurigheid. Het is niet voor niets dat het haar van Lara Croft in Tomb Raider met het open platform-agnostische TressFX er zo goed uitziet met een lage impact op de performance (tenzij je een oude GPU hebt). Nu zijn de technieken niet helemaal hetzelfde maar dat doet er in deze context volgens mij weinig toe.Sp3ci3s8472 schreef op zondag 17 februari 2019 @ 21:19:

[...]

Een konijn heeft waarschijnlijk een strand (haar) dat een keer gebogen wordt. Het haar van Geralt heeft strands die tig keer gebogen worden om het realistischer te maken.

Heb even een filmpje bekeken met een aantal mutants erin, en zoals ik verwachte die strands zijn hooguit een of 2-3 keer gebogen en daarna getessaleert. Daarnaast zijn die beesten behoorlijk kalend als je het mij vraagt.

Hetzelfde verhaal als met die extreme tesellation waarbij het niet alleen minder effectief wordt maar op een gegeven moment ook minder geloofwaardig wordt en de FPS gigantisch doet zakken.

In zekere zin ook hetzelfde verhaal als met Crysis wat doodleuk onder de grond water tekende wat bewoog. Moet je nagaan hoe goed die engine is dat ondanks dat de performance nog zo indrukwekkend was. Een beetje handig programmeren maakt een groot verschil, met software kunnen we waarschijnlijk nog minstens zoveel vooruitgang boeken als met hardware op dit moment en spellen zoals Doom demonstreren dat.

[ Voor 19% gewijzigd door Verwijderd op 17-02-2019 22:22 ]

Je negeert echter de kern van het punt dat er gemaakt wordt johGekke Jantje schreef op zondag 17 februari 2019 @ 21:35:

Het gaat er om dat het minder tot geen impact heeft op de performance.

Heeft het minder impact doordat het beter loopt, doordat de instellingen normaal staan (geen 64xT op elk haartje zoals in TW3 het geval was pre-patch) of doordat het minder gebruikt wordt?

Welk van die 3 het is, doet er weldegelijk toe. Zo zijn er genoeg games geweest die alleen een "aan/uit" instelling hadden voor MSAA. Als dat in game A 8 samples betekent en in game B 2 samples, maakt dat veel verschil uit voor de performance, maar dan kun je niet zeggen dat MSAA in B beter geoptimaliseerd is. De devs van game B zijn duidelijk slimmer en snappen dat 8 meestal te veel is (hoewel 2 vaak ook te weinig is, 4 is nog steeds de sweet spot

Je hebt gelijk, de framerate lijkt er nauwelijks door beïnvloed te worden.Zoals hier ook zie je dat de fps ook mooi stabiel blijft, dit is niet een hairworks aan en uit test. Dat zal ik later nog wel posten als het niet te oftopic is hier.

YouTube: Metro Exodus: Glorious Kill | Opgenomen met GeForce

Het is echter ook duidelijk dat dit niet te vergelijken is met TW3. Alleen al Geralt z'n baard had gemiddeld zo'n 6000 haren en z'n hele character render je gemiddeld met pakweg 30000 haren1. In jouw filmpje kun je de individuele haren tellen en hoewel ik geen zin heb om ze te gaan tellen, durf ik wel te stellen dat dat slechts in de honderden zit.

Is dat beter geoptimaliseerd te noemen? Vind ik niet. Dat is precies het punt dat ik hierboven met MSAA als voorbeeld probeerde te maken.

Is het slimmer ontwerpen van de models om de performance goed te houden door de devs? Zeker! Maar dat is optimalisatie van de game, niet van HairWorks.

1: van https://www.geforce.com/w...rmance-and-tweaking-guide

On average, 10,000 to 40,000 strands of tessellated hair are applied to HairWorks-enhanced models at combat view distances, with up to 60,000 applied to the game's furriest creatures. Up close, when creatures are futilely trying to end Geralt's life, hair counts are cranked up to ensure maximum fidelity, bringing the 40,000 average up to 125,000 in some cases. As they then flee for their lives, hair counts are dynamically scaled back until the enemy is a mere dot in the distance. On Geralt, hair counts average at 30,000, and scale up to 115,000, with around 6,000 hairs just for his beard.

-The_Mask- schreef op zondag 17 februari 2019 @ 20:33:

[...]

We is gewoon iedereen die het topic volgt. De specs zijn gewoon langs gekomen, geen idee wat daar vreemd aan is. Passmark is ook al een hele oude benchmark en de mening daarover is ook altijd hetzelfde. Ik zou zeggen kijk de volgorde van de videokaarten of CPU's maar eens. Deze discussie, als je het al een discussie kunt noemen, is echt al heel vaak gevoerd.

Strekking:Blaat schreef op zondag 17 februari 2019 @ 20:38:

[...]

Je snapt het punt van @sdk1985 niet.

Hij maakt dezelfde opmerking is die ik een tijd geleden ook tegen je maakte. De toon van bijna al je posts is belerend/negatief/bot/ongezellig. Maakt niet uit dat je gelijk hebt, je klinkt als een botte hork.

Over de strekking zijn we het duidelijk oneens. Ik maak melding dat de 1660 Ti op passmark is opgedoken. Zo ver mij bekend is dat niet eerder opgemerkt en dus heeft dat nieuwswaarde. Of passmark de ideale benchmark is en of deze resultaten uberhaupt kloppen is een hele andere discussie. Het slaat werkelijk waar nergens op om te impliceren dat omdat het passmark is er niets over geschreven mag worden. Als jij geen waarde hecht aan passmark, doe dat dan vooral niet maar ga anderen niet aanspreken op het plaatsen van een link naar passmark.

TLDR: Ga het anderen niet verbieden en laat dat soort berichten lekker achterwegen @-The_Mask-.

Inhoud:

Wie niet begrijpt dat passmark een nuttige synthetic is geeft daarmee eigenlijk aan dat hij niet snapt wat een synthetic is en wat je ermee kan. Een synthetic heeft zowel voor als nadelen en het is gewoon een kwestie van de resultaten leren lezen. Natuurlijk is een praktijk benchmark van de game die jij speelt op de settings die jij speelt met de hardware configuratie die jij speelt de ultieme maatstaf van performance. Echter, daarmee kun je op hoog level geen vergelijkingen maken, zeker niet over de jaren heen. Ik zal wat betreft Passmark wel een mini onderzoekje uitvoeren om dit punt te verduidelijken.

Toon:

Het primaire punt achter mijn originele vraag is dat ik niet met zekerheid kan vaststellen, zonder iemand fysiek te zien, of iemand nu bewust problemen zoekt, daadwerkelijk een afwijkende mening heeft, of dat wij moeten accepteren dat wij nu en dan 'onbedoeld' geschoffeerd worden.

Wellicht kan @-The_Mask- dat zelf aangeven. Moeten wij hier rekening mee houden? Of ga jij met 'ons' rekening houden en voortaan je berichten van wat meer inhoud en wat minder verwijten te voorzien? Of gaan we voortaan gewoon mijn post negeren zoals @DaniëlWW2 doet, dat is natuurlijk ook een optie.

[ Voor 64% gewijzigd door dion_b op 18-02-2019 22:08 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

In de eerste plaats is het belangrijk te begrijpen dat passmark een synthetic is. Het is een test die erop gericht is alleen de gpu te testen. Daaruit volgt dat de resultaten van een dergelijke test nooit 1 op 1 zijn toe te passen op de praktijk. In de praktijk spelen immers andere factoren een rol. Bijvoorbeeld; het systeem, de drivers en eventuele game optimalisaties.

Dat gezegd hebbende test een goede syntetic de ruwe rekenkracht van een product en is er eigenlijk altijd wel een zogenaamde correlatie te vinden tussen die ruwe rekenkracht en de uiteindelijke prestaties. Daarom zijn synthetics niet per definitie nutteloos.

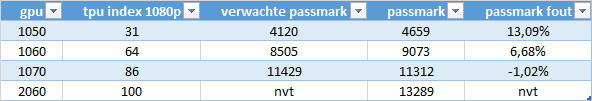

Zo'n correlatie bestaat natuurlijk ook bij passmark en die is eigenlijk vrij eenvoudig te vinden. Startpunt is de recente RTX 2060 review van tpu (https://www.techpowerup.c..._Founders_Edition/33.html ). Ik kies techpowerup omdat die wat mij betreft een goede suite van verschillende games hebben getest en de resultaten daarvan keurig statistisch hebben verwerkt in een indexatie waarde. Voor nu stellen we techpowerup dus even gelijk aan de praktijk prestaties. Binnen TPU pak ik willekeurig de 1070, 1060 en 1050 en ga ik de index waarde gebruiken om de verwachte passmark score terug te rekenen. Vervolgens bepaal ik de grootte van de afwijking tussen de verwachte score en de officiele passmark score.

Resultaat is deze tabel:

Dus op basis van de 13289 punten komt de 86% van de GTX 1070 op 11429 punten terwijl passmark hem op 11312 heeft gezet. Zoals verwacht is er geen 1 op 1 relatie met de resultaten van techpowerup, maar dat kan ook bijna niet. Immers bevat passsmark zelf meetfouten (iedereen kan het testen, ook als het systeem slecht werkt of tegelijk iets anders doet) én is het een synthetic. Maar het zit dicht genoeg in de buurt om in te schatten dat bij score X de praktijk Y zal genereren. Zeker als je daarbij nog gaat corrigeren voor generatie verschillen. (Op die manier kun je ook leren werken met de cpu passmark score, door hyperthreading/smt te compenseren).

Als ik deze resultaten zo zie, exacte uitkomst was voor mij ook van te voren niet bekend, dan zegt het normaliter eigenlijk nog meer dan de gelekte final fantasy benchmark. Dus zo'n passmark score kan best wel nuttig zijn.

In navolging van @haarbal moet ik hieraan wel toevoegen dat je dit soort tests met een korreltje zout moet nemen. Dus als iets binnen een paar procent van elkaar zit dan kun je passmark niet gebruiken om te concluderen dat de één sneller is dan de andere. Daarvoor moet er een significant verschil zijn.

edit:@Verwijderd zie bovenstaand dus de gevraagde discussie over passmark

[ Voor 10% gewijzigd door sdk1985 op 19-02-2019 00:01 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Vergelijken tussen de 2060 en 1660Ti zou misschien kunnen, maar de huidige 1660 Ti passmark score is zo laag dat ik niet denk dat we er iets aan hebben.

Mechwarrior Online: Flapdrol

Hmm die 780 Ti is ook iets sneller dan de GTX 970. Maar die scores zitten eerlijk gezegd wat te dicht bij elkaar in de buurt (200 punten, 2%), dus dan heb je snel een meetfout te pakken. Daar is het niet precies genoeg voor. Heb het niet uitgezocht maar ik verwacht dat het score verschil minimaal 10% moet zijn voor het zinnig wordt.haarbal schreef op maandag 18 februari 2019 @ 01:27:

Ik ben geen fan van passmark, hij zegt bijvoorbeeld dat een 780Ti beter is dan een gtx 970, die weer beter zou zijn dan een rx 580. Ik zou liever de omgekeerde volgorde hebben.

Vergelijken tussen de 2060 en 1660Ti zou misschien kunnen, maar de huidige 1660 Ti passmark score is zo laag dat ik niet denk dat we er iets aan hebben.

Verder ben ik het er mee eens dat de huidige 1660 Ti score niet van 8645 niet zinnig lijkt te zijn, vooral omdat hij onder de 1060 scoort. De sample size van 2 is daar een goede verklaring voor.

[ Voor 9% gewijzigd door sdk1985 op 18-02-2019 01:53 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Ach je negeert zelf ook dingen, waarschijnlijk omdat het het even niet uitkomt. En je redenaties/analyses (alhoewel wel vaak interessant) kloppen m.i. vaak genoeg niet (helemaal) of zijn onvoldoende genuanceerd. Niet iedereen heeft zin om daar dan 20 posts op door te gaan.sdk1985 schreef op maandag 18 februari 2019 @ 00:16:

Toon:

Het primaire punt achter mijn originele vraag is dat ik niet met zekerheid kan vaststellen, zonder iemand fysiek te zien, of iemand nu bewust problemen zoekt, daadwerkelijk een afwijkende mening heeft, of dat wij moeten accepteren dat wij nu en dan 'onbedoeld' geschoffeerd worden.

Wellicht kan @-The_Mask- dat zelf aangeven. Moeten wij hier rekening mee houden? Of ga jij met 'ons' rekening houden en voortaan je berichten van wat meer inhoud en wat minder verwijten te voorzien? Of gaan we voortaan gewoon mijn post negeren zoals @DaniëlWW2 doet, dat is natuurlijk ook een optie.

NOFI, ik denk dat er een aantal mensen hier er sowieso goed aan zouden doen om hun analyses / meningen wat minder stellig op te schrijven en niet altijd het laatste woord te moeten hebben. Is beter voor de sfeer.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

De meeste mensen deugen!

Geen modbreak en deze is niet mee gemod, blijkbaar nog ontopic. Beetje feedback wil ik best op reageren.Help!!!! schreef op maandag 18 februari 2019 @ 09:17:

[...]

Ach je negeert zelf ook dingen, waarschijnlijk omdat het het even niet uitkomt. En je redenaties/analyses (alhoewel wel vaak interessant) kloppen m.i. vaak genoeg niet (helemaal) of zijn onvoldoende genuanceerd. Niet iedereen heeft zin om daar dan 20 posts op door te gaan.

Systematisch, zet deze wel op dm

An sich goed dat je dit uitspreekt. Onwijs offtopic maar toch wel nuttig dat het allemaal een keer is uitgesproken wat mij betreft. Dat is ook de reden dat ik hier nu tijd aan besteed en dat probeer ik zo constructief mogelijk te doen.NOFI, ik denk dat er een aantal mensen hier er sowieso goed aan zouden doen om hun analyses / meningen wat minder stellig op te schrijven en niet altijd het laatste woord te moeten hebben. Is beter voor de sfeer.

Met de boodschap ben ik het echter niet eens;

Het hele idee van een forum is dat je daar een mening kan en mag plaatsen. Dat mag best een duidelijke mening zijn, sterker nog dat geniet de voorkeur. Dat oeverloos genuanceer kom je nergens mee. Bovendien, wat valt er nu te nuanceren over videokaarten. Dus nee ik zie persoonlijk jou liever een duidelijke (tegen)stelling in nemen dan dat we allemaal super genuanceerd worden en niks meer mogen/durven te posten. Juist een tegenstelde mening mogen hebben is een vorm van respect.

Wat betreft het laatste woord;

je hoeft niet elke mening die afwijkt onderuit te schoppen dan wel een poging daartoe te doen. De pilaren van een punt onderuit proberen te zagen, zonder daar een eigen mening aan toe te voegen; dat gedrag is wat de extra reacties oplevert. Je kunt het ook constructief houden en waar nodig een duidelijk afwijkende stelling innemen. Nu zie je vaak meerdere users op een stelling springen zonder dat daarbij wordt vermeld wat uiteindelijk het doel is en dan ontstaan er 4-5 nieuwe discussies.

Dat dit gebeurd is verder ook niet heel vreemd. Het aanvallende gedrag is een klassiek voorbeeld van 'tribalism'. Mensen identificeren zich met merk X en zodra er iets negatiefs verschijnt dan krijgen ze het gevoel dat te moeten beschermen/voorkomen. Het is eigenlijk al te triest voor woorden dat er een apart AMD, Nvidia en Intel topic is omdat iedereen anders elkaar dagelijks de haren in vliegt. Wat mij betreft praten we gewoon over videokaart nieuws en processor nieuws. Heb ik ook weleens voorgesteld maar daar was geen animo voor. Blijft wat mij betreft nog steeds de beste optie. Als je het apart houdt dan leren we het nooit

Betreft de accuraatheid;

blijkbaar wordt ik hier ter verantwoording geroepen op de kwaliteit van de inhoud van mijn posts. Wil jij ook een rapport cijfer over je laatste 100 posts, en ga je andere ook beoordelen?

Persoonlijk vind ik het vooral vreemd dat jouw wens is dat ik voorspelingen niet plaats om zo te voorkomen dat het een lange discussie wordt. Ik vind dat de omgekeerde wereld. Al zouden ze niet uitkomen, dan nog moet het kunnen.

@Verwijderd heeft hier overigens nog weleens een goede suggestie voor gedaan; een apart topic voor voorspellingen. Maar dat is verder niet opgepakt.

[ Voor 44% gewijzigd door sdk1985 op 19-02-2019 00:51 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Tja vroeger zag je dat de AMD tweakers primair in het AMD/ Radeon topic bleven en in dit topic wat andere users actief waren. Als je in het hol van de leeuw iets enigsinds negatiefs over AMD/Radeon durfde te posten dan kreeg je meteen 5+ users achter je aan. Die eerste groep heeft het ondertussen behoorlijk verstierd door hier steeds actiever te worden, vermoedelijk omdat er gewoon weinig nieuws was. In 'hun eigen' topic staat al tijden permanent een topic warning mbt negativiteit:Cassius schreef op maandag 18 februari 2019 @ 11:21:

Als lezer; dit topic heeft zo vaak haantjes gedrag en e-pikkie gehuil dat het snel een privéfeestje wordt vermoed ik.

Hier geldt dat blijkbaar niet. Negativiteit aankaarten levert mij zojuist een gemodde post op.Let op:

We krijgen de laatste tijd vanuit verschillende hoeken klachten over de gevoerde toon in deze topicserie. Laten we het een beetje gezellig houden. Probeer alleen op de feiten te reageren en je statements te onderbouwen met bronnen. Dram daarbij niet door, als een ander ook na onderbouwing een andere mening toegedaan blijft is daar niets mis mee. Laat sneren en op de man teksten achterwege, dan blijft het voor iedereen leuk.

Ondertussen zijn de meeste users van het Nvidia topic er mee opgehouden. Verder niet vreemd. Dit is letterlijk het enige dat ik heb gepost in het nvidia nieuws topic in aanvang van deze discussie:

Blijkbaar is het niet mogelijk dat te posten zonder kritiek te krijgen. Als moderatie dat niet recht kan trekken dan houdt het inderdaad een keer op. Misschien wordt het eens tijd voor reddit ofzosdk1985 schreef op zondag 17 februari 2019 @ 02:26:

Heej de 1660 Ti staat op videocardbenchmark.net https://www.videocardbenc...e-GTX-1060-3GB/4045vs3566 Sample van 2 het is te hopen dat dit een laptop variant was want hij scoort onder de 1060 3GB.

Hoe dan ook heb ik @dion_b aangeschreven en we gaan wel zien of daar een structurele oplossing uitkomt. Ik heb dit niet voor niets aangekaart, het geduld is gewoon een keertje op en ook ik zit echt niet te wachten op die zij-discussies. Maar laten we de rest dan maar via DM afhandelen anders wordt morgen alles hier weggeknipt en dan begint de cyclus volgende week weer opnieuw.

[ Voor 36% gewijzigd door dion_b op 19-02-2019 00:55 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

.

Hier mijn feitje waarover ik het had.

[ Voor 23% gewijzigd door Gekke Jantje op 20-02-2019 13:25 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Bedoel je met dat feitje dat het hooguit een paar fps scheelt?Gekke Jantje schreef op woensdag 20 februari 2019 @ 13:19:

Hier word nog het een en ander over Gameworks in Metro Exodus besproken. Hairworks geeft wel een performance hit maar niet zo extreme als met andere games en de hit is ook niet op iedere GPU even groot.

.

[YouTube: Metro Exodus Optimization, Nvidia GameWorks Strikes Again!]

Hier mijn feitje waarover ik het had.

[Afbeelding]

[Afbeelding]

Daar zijn deze screenshots geen goed voorbeeld van aangezien er geen complexe scene wordt gerendert. Zou zomaar kunnen zijn dat je hier met een CPU bottleneck zit.

Een screenshot waarbij je horizontaal naar een scene kijkt waarbij er meer meerdere van die beesten tevoorschijn komen zegt meer denk ik.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Nee het gaat om Hairworks on and off zoals ook getest in de videoreview er boven, zie je ook verder niets tot weinig op de achtergrond. Bij meerdere beesten zie ik overigens het zelfde effect, en de impact word normaal gesproken zwaarder als je er dichter op staat. Overigens is het heel moeilijk te beoordelen als je een horizontale video of screenshot maakt want er kan van alles in beeld gaan warrelen zoals Physx effecten van rook tot allemaal sneeuw wat in opwaait of een ander beest zonder haar geeft ook al direct invloed op de performance.Blaat schreef op woensdag 20 februari 2019 @ 14:20:

[...]

Bedoel je met dat feitje dat het hooguit een paar fps scheelt?

Daar zijn deze screenshots geen goed voorbeeld van aangezien er geen complexe scene wordt gerendert. Zou zomaar kunnen zijn dat je hier met een CPU bottleneck zit.

Een screenshot waarbij je horizontaal naar een scene kijkt waarbij er meer meerdere van die beesten tevoorschijn komen zegt meer denk ik.

[ Voor 23% gewijzigd door Gekke Jantje op 20-02-2019 15:11 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Stuk beter, nu ben je op onderzoek uit gegaan. Maar je negeert de punten die ik en Werelds maken. Zie hieronder mijn glorieuze paint skills:Gekke Jantje schreef op woensdag 20 februari 2019 @ 13:19:

Hier word nog het een en ander over Gameworks in Metro Exodus besproken. Hairworks geeft wel een performance hit maar niet zo extreme als met andere games en de hit is ook niet op iedere GPU even groot.

.

[YouTube: Metro Exodus Optimization, Nvidia GameWorks Strikes Again!]

Hier mijn feitje waarover ik het had.

[Afbeelding]

[Afbeelding]

Ik heb het filmpje bekeken en de haren van de beeste hebben 1 of 2 buigingen max

Het animeren/shaden/tesselaten van 10k-40k haren van Geralt met meer buigingen kost meer performance. Dan een 100-1000 haren van een aantal mutants. Dat is ons punt, zoals de reviewer uit jouw youtube filmpje aangeeft kost het nog steeds 13% Nvidia en 27% AMD in de one percent lows. Wat een beste impact is voor zo'n effect waar hij terrecht aangeeft dat het er zoveel beter uitziet omdat de ontwikkelaar niet eens de moeite heeft genomen om dezelfde kleur haren te nemen op het moment dat Hairworks uitstaat.

De wiskunde achter het animeren van strands en vergelijkbare effecten is overigens niet heel speciaal. Je kan hier niet heel veel meer aan optimaliseren door het een keer slim te schrijven (en ik ga er van uit dat ze dat bij Nvidia een stuk beter kunnen dan mijn opdrachtjes die ik op de uni moets maken).

Ik heb voornamelijk spring/cloth simulaties gemaakt

Je kan het optimalisatie noemen dat ze simpelere strands hebben gepakt en er minder van hebben totaal (of het percentage parent/child strands is anders, dus meer childs). Dan zou ik je helemaal gelijk geven; maar dat is niet hetzelfde als het optimaliseren van Hairworks als een techniek en is met de gegevens die we hebben onmogelijk te bewijzen.

Als je dat wil doen moet je eigenlijk de Hairworks SDK van het moment van TW3 pakken en dat vergelijken met de Hairworks SDK van dit moment. Je wil dan bij beide scenes hetzelfde aantal haren en met dezelfde complexiteit. Dan pas kan je meten of er inderdaad een verbetering is.

[ Voor 1% gewijzigd door Sp3ci3s8472 op 20-02-2019 15:45 . Reden: spring cloth ]

Ik ben het ook wel met jullie eens dat hairworks in Metro Exodus minder complex is, er worden een pak minder haren dicht op elkaar weergegeven zoals op Garalt het geval is en, overigens is het haar van Garalt ook veel dunner. Ik heb nog maar eens een close up gemaakt en dan ziet het er ook echt niet mooi uit.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Je geeft het zelf nu ook aan, HairWorks is niet beter geoptimaliseerd, ze gebruiken het gewoon minder, waardoor de impact minder isGekke Jantje schreef op woensdag 20 februari 2019 @ 15:52:

@Sp3ci3s8472

Ik ben het ook wel met jullie eens dat hairworks in Metro Exodus minder complex is, er worden een pak minder haren dicht op elkaar weergegeven zoals op Garalt het geval is en, overigens is het haar van Garalt ook veel dunner. Ik heb nog maar eens een close up gemaakt en dan ziet het er ook echt niet mooi uit.

[Afbeelding]

Ik heb even snel door het filmpje gekeken en dit is weldegelijk een typische GameWorks titel. Tessellation wordt weer eens fout toegepast. Veel te hoge sample counts, waardoor AMD er enorm (en onnodig) door benadeeld wordt. En hoewel HairWorks geen grote impact heeft op gemiddelde framerates, zijn de 1% lows wel significant lager (vooral bij AMD, maar dat komt gegarandeerd wederom door misbruik van tessellation). 12,5% lagere 1% lows is pijnlijk en dat is ook te zien (spring naar 13:45 in het filmpje). Microstuttering, joepie (is ook duidelijk te zien in het grafiekje).

De mutanten hebben gewoon weinig haar door de straling waarschijnlijk, maar als je dan weer een hond ziet in Metro Exodus die heeft weer veel haar zonder dikke hit, meer meer en mooier dan die wolven in TW 3. Als ik er weer een tegen kom moet ik maar weer de feiten bewijzen dat het wel beter geoptimaliseerd isWerelds schreef op woensdag 20 februari 2019 @ 17:36:

[...]

Je geeft het zelf nu ook aan, HairWorks is niet beter geoptimaliseerd, ze gebruiken het gewoon minder, waardoor de impact minder is

Ik heb even snel door het filmpje gekeken en dit is weldegelijk een typische GameWorks titel. Tessellation wordt weer eens fout toegepast. Veel te hoge sample counts, waardoor AMD er enorm (en onnodig) door benadeeld wordt. En hoewel HairWorks geen grote impact heeft op gemiddelde framerates, zijn de 1% lows wel significant lager (vooral bij AMD, maar dat komt gegarandeerd wederom door misbruik van tessellation). 12,5% lagere 1% lows is pijnlijk en dat is ook te zien (spring naar 13:45 in het filmpje). Microstuttering, joepie (is ook duidelijk te zien in het grafiekje).

@Werelds

Ik zie dat al optimalisatie

[ Voor 6% gewijzigd door Gekke Jantje op 20-02-2019 18:24 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

Kijk eens op 14:27-14:28

Nogal forse texture pop-in voor ultra-settings en dichtbij.

Teleurstellend dat de developer ervoor koos om zoveel instellingen te groeperen. Volgens Tim zou je waarschijnlijk betere performance halen met dezelfde effecten voor bepaalde zaken (haar en tessellation) zonder Gameworks.

Dat lijkt het terugkerende thema te zijn: te hoge sample counts waarmee het voor zowel AMD als Nvidia slechter werkt maar meer voor AMD en oudere generaties Nvidia-GPU's. De interessante en terugkerende vraag: waarom? Zijn de Nvidia-ingenieurs incompetent? Nee, zoveel is zeker. Doen ze het omdat het een extra FPS-voordeel geeft? Mogelijk. Worden er fouten gemaakt door developers die de code niet goed gebruiken? Mogelijk. Fouten maak je sneller wanneer het niet je eigen code is en veel developers zijn sowieso niet goed in het schrijven van code en hebben te weinig mensen in dienst die dat goed kunnen. Ik speculeer dat beide een rol speelt.Werelds schreef op woensdag 20 februari 2019 @ 17:36:

[...]

Je geeft het zelf nu ook aan, HairWorks is niet beter geoptimaliseerd, ze gebruiken het gewoon minder, waardoor de impact minder is

Ik heb even snel door het filmpje gekeken en dit is weldegelijk een typische GameWorks titel. Tessellation wordt weer eens fout toegepast. Veel te hoge sample counts, waardoor AMD er enorm (en onnodig) door benadeeld wordt.

Voor wie het niet in de gaten heeft (de nieuwkomers hier), juist die 1% FPS is belangrijk. Je wil zo'n regelmatig mogelijke framerendertijd hebben: niet gemiddeld 10-17 ms en dan ineens een frame die 50-110 ms kost. Die haperingen zorgen ervoor dat de input die je geeft later wordt verwerkt waardoor het karakter niet fijn wordt aangestuurd door de speler omdat de reactie op je input ineens later komt dan dat je verwacht.En hoewel HairWorks geen grote impact heeft op gemiddelde framerates, zijn de 1% lows wel significant lager (vooral bij AMD, maar dat komt gegarandeerd wederom door misbruik van tessellation). 12,5% lagere 1% lows is pijnlijk en dat is ook te zien (spring naar 13:45 in het filmpje). Microstuttering, joepie (is ook duidelijk te zien in het grafiekje).

Ook voor de nieuwkomers: die tessellation was uitgevonden door RTG (opgekocht door AMD) maar Nvidia overdreef dat vervolgens gigantisch.

Ik vind dit best mooi (ik kijk ernaar uit om over pak hem beet 5-8 maanden dit spel te gaan spelen nadat Navi uit is gekomen), ik vraag me wel af of dat je daar niet TressFX voor kon gebruiken en hoe de performance dan zou zijn.Blaat schreef op woensdag 20 februari 2019 @ 16:13:

Dan vind ik dat ze in TW3 toch wel wat meer hun best hebben gedaan op hairworks dan hier.

[Afbeelding]

[ Voor 20% gewijzigd door Verwijderd op 20-02-2019 19:45 ]

Stond onder de video... maar kon het hier niet mee oneens zijn "DLSS = doesn't look so sharp".

Het is beter om je resolution scale aan te passen, dat ziet er beter uit.

Graag, want tot nu toe zie ik het nietGekke Jantje schreef op woensdag 20 februari 2019 @ 18:12:

De mutanten hebben gewoon weinig haar door de straling waarschijnlijk, maar als je dan weer een hond ziet in Metro Exodus die heeft weer veel haar zonder dikke hit, meer meer en mooier dan die wolven in TW 3. Als ik er weer een tegen kom moet ik maar weer de feiten bewijzen dat het wel beter geoptimaliseerd is

Die paar honderd haren op die paar mutanten die door het beeld vliegen zorgen alsnog voor flink wat microstuttering, dus ik zie niet in hoe dieren met meer haren beter lopen

RTG opgekocht door AMD? Ik geloof dat je ATI bedoeltVerwijderd schreef op woensdag 20 februari 2019 @ 18:46:

YouTube: Metro Exodus Optimization, Nvidia GameWorks Strikes Again!

Ook voor de nieuwkomers: die tessellation was uitgevonden door RTG (opgekocht door AMD) maar Nvidia overdreef dat vervolgens gigantisch.

Met welke videokaart speel je dan gezien je flink wat microstuttering krijgt? Ik heb er op de GTX 1080 Ti in ieder geval geen last van. Is overigens te zien in mijn geposte filmpje als ik een mutant kill.Werelds schreef op woensdag 20 februari 2019 @ 20:12:

[...]

Graag, want tot nu toe zie ik het niet

Die paar honderd haren op die paar mutanten die door het beeld vliegen zorgen alsnog voor flink wat microstuttering, dus ik zie niet in hoe dieren met meer haren beter lopen

[...]

RTG opgekocht door AMD? Ik geloof dat je ATI bedoelt

Nvidia zei dat ze het gaan oplossen, de vraag is alleen wanneer.Sp3ci3s8472 schreef op woensdag 20 februari 2019 @ 20:12:

[YouTube: Battlefield V DLSS Tested, The Biggest RTX Fail Of Them All]

Stond onder de video... maar kon het hier niet mee oneens zijn "DLSS = doesn't look so sharp".

Het is beter om je resolution scale aan te passen, dat ziet er beter uit.

https://www.nvidia.com/en...-your-questions-answered/

[ Voor 36% gewijzigd door Gekke Jantje op 20-02-2019 22:46 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Waar ik in eerste instantie DLSS zeker voor de korte termijn de meest interessante innovatieve nieuwe feature vond, denk ik nu toch dat het helaas een redelijk moeizaam verhaal gaat worden.

Er lijken toch wel wat te veel haken en ogen aan om dit goed en breed inzetbaar te kunnen maken. De kwaliteit van de textures moet echt wel verbeterd worden.

Ben benieuwd naar de updates die nvidia gaat brengen.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Of ben ik nu waus.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Je weet toch dat het perfect is bij launch of gewoon bagger, mislukt en onwaardig om ooit nog naar te kijken?Blaat schreef op donderdag 21 februari 2019 @ 09:37:

Het idee van deep learning is toch ook dat het naarmate het meer gebruikt wordt steeds beter wordt? Lijkt mij logisch dat de eerste implementaties minder goed zijn.

Of ben ik nu waus.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

nVidia fine wine dan maar?

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Verwijderd

Een beetje?Blaat schreef op donderdag 21 februari 2019 @ 09:37:

Het idee van deep learning is toch ook dat het naarmate het meer gebruikt wordt steeds beter wordt? Lijkt mij logisch dat de eerste implementaties minder goed zijn.

Of ben ik nu waus.

Er zijn grenzen aan hoeveel beter het kan worden. Het is mogelijk dat het algorithme (nog) niet goed genoeg is en dat het niet veel beter dan dit kan worden, het is ook mogelijk dat het met meer werk van die 'AI'-computers in de komende maanden beter wordt. Alleen mensen die de code kennen kunnen dit beoordelen. Zoals ik het begrijp is DLSS in essentie upscaling waarbij kleuren worden gegokt voor pixels die liggen tussen pixels waarvan de kleuren wel bekend zijn. De simpelste benadering is dat je het gemiddelde neemt van de kleuren, Nvidia gebruikt een ingewikkelder algorithme maar hoe ze het precies doen daar hebben we het raden naar. Voor zo ver ik het begrijp hebben ze een of andere formule met parameters (of meerdere formules), gokken ze in eerste instantie de waardes (initialisatie op een willekeurige waarde), vullen ze die pixels in, vergelijken ze het resultaat met wanneer je het echt met die hogere resolutie rendert etc. Hoe beter die formules hoe beter het resultaat, hoe meer samples hoe dichter je bij het maximaal te behalen resultaat komt. Hoe dan ook, je blijft in essentie gokken wat de kleur is van die onbekende pixels dus het zal altijd kwaliteitverlies opleveren, de vraag is alleen hoeveel kwaliteitsverlies je hebt.

We moeten overigens ook niet uit het oog verliezen dat de hoeveelheid hardware (Tensor-units) die beschikbaar is voor DLSS nogal klein is. Dat kan ook een beperking geven want die paar Tensor-cores moeten wel in pak hem beet 10-20 ms. dat rekenwerk uitvoeren voor alle onbekende pixels.

[ Voor 8% gewijzigd door Verwijderd op 21-02-2019 10:53 ]

DLSS is en blijft AA in post-processing. Het zal altijd aan dingen komen waar het niet aan dient te komen. Ik heb het gevoel dat ik dat al eerder heb gezegd..Help!!!! schreef op donderdag 21 februari 2019 @ 09:28:

Editiorial NVIDIA: Image Quality for DLSS in Metro Exodus to Be Improved in Further Updates, and the Nature of the Beast

Waar ik in eerste instantie DLSS zeker voor de korte termijn de meest interessante innovatieve nieuwe feature vond, denk ik nu toch dat het helaas een redelijk moeizaam verhaal gaat worden.

Er lijken toch wel wat te veel haken en ogen aan om dit goed en breed inzetbaar te kunnen maken. De kwaliteit van de textures moet echt wel verbeterd worden.

Ben benieuwd naar de updates die nvidia gaat brengen.

Het maakt niet uit hoe lang ze het netwerk trainen, het zal altijd een benadering van de doel resolutie blijven. En omdat het op volledig gerenderde buffers werkt kunnen ze ook onmogelijk rotzooi op textures vermijden.

Leuk idee, maar het is gewoon niet de toekomst. Het idee achter TAA heeft veel meer potentie. Gebruik die neurale netwerken om uit te vogelen waar MSAA niet meer genoeg is en SMAA (of in Nvidia's geval FXAA

- 4xMSAA (meer is echt niet nodig) nog minder impact heeft

- dat de PPAA stap niet meer 100% PP is maar een beetje informatie heeft over waar dingen als alpha textures (hekwerk) gebruikt worden en dat dáár een beetje vaseline overheen gaat in plaats van over het hele frame

Dan gaat de IQ een stuk meer vooruit

Het heeft niets met de implementatie te maken, maar alles met het trainen van het netwerk aan Nvidia's kant. De game stuurt niets naar Nvidia als jij speelt, dus het wordt niet door gebruikers getraind (kan ook bijna nietBlaat schreef op donderdag 21 februari 2019 @ 09:37:

Het idee van deep learning is toch ook dat het naarmate het meer gebruikt wordt steeds beter wordt? Lijkt mij logisch dat de eerste implementaties minder goed zijn.

Of ben ik nu waus.

Het simpelste voorbeeld om je een idee te geven van hoe machine-/deep-learning werken is een spam filter. Het is een alledaags dingetje, waar al tientallen jaren ML voor toegepast wordt. Het is tegelijkertijd ook zowel simpeler als lastiger dan je wellicht denkt. Waarschuwing: hier is weer eens één van mijn muurtjes. Voor de programmeurs onder ons, wat volgt is een simplistische uitleg van een Naive Bayes filter

Stel dat je een simpel spam filter wilt hebben voor tekst (email, comments) dat probeert te "zien" of het spam is. De simpelste oplossing is gewoon keihard naar wat trefwoorden te zoeken, maar dan ga je geheid tegen false positives aanlopen. Voer jij "pay" als spam-term in, dan ga je false positives op legitieme betalingen krijgen. Dat is dus niet de oplossing, je wilt iets slimmers.

Als je naar spam kijkt, zul je vanzelf zien dat bepaalde woorden vaak samen voorkomen in spam berichten. Ook zijn er woorden die nóóit een indicatie van spam (of ham, wat de gangbare term voor non-spam is) zijn. Dat zijn stopwoorden en de meest voorkomende woorden in elke taal: denk aan lidwoorden, tussenvoegsels, aanwijzende woorden, enzovoort. Een gemiddelde lijst in het Engels bevat dus woorden als 'the', 'a', 'in', 'on'. Er is in elk geval een duidelijk verband tussen de gebruikte woorden en de waarschijnlijkheid dat iets spam of ham is.

De volgende stap is het verzamelen van een flinke berg aan stukken tekst waarvan je zeker weet dat ze spam of ham zijn. Als je dat eenmaal hebt, moet je dat als input aan een stukje code geven, samen met de classificatie (spam of ham) van dat stuk tekst. Wat die code vervolgens doet is die tekst analyseren, alle stopwoorden er uit gooien en de verbanden van overige woorden opslaan. Een heel simplistische aanpak die vaak verrassend effectief is tegen langere stukken tekst is simpelweg tellen hoe vaak een specifiek woord voorkomt in een stuk tekst en bijhouden wat de verhouding is tot het geheel. Zo zal een legitiem stuk tekst over leningen het woord lening wel meer dan eens gebruiken, maar lang niet zo vaak als in spam. Zo kan het dus best zijn dat uit jouw training data blijkt dat "lening" in spam gemiddeld 10% van het geheel omvat, terwijl dat in legitieme tekst slechts 4% is. Krijg je vervolgens een stuk tekst waar "lening" 8% van het geheel is, dan is het waarschijnlijker dat die tekst spam is dan dat het ham is.

Dit is één van de eenvoudigste (en meest voorkomende) voorbeelden van machine learning. Dit is hoe email spam filters ooit begonnen. Uiteraard is dit niet genoeg en als het puur op de tekst aan komt zul je niet alleen naar woorden moeten kijken; je moet kijken hoe vaak en in welke volgorde woorden samen voor komen, welke zinnen samen voor komen, enzovoort.

Waarschijnlijk heb je probleem #1 ook al ontdekt: je moet al genoeg data hebben vóór je begint. Heb je niet genoeg tekst waarvan je zeker weet wat het is, kom je nergens. Dat is ook meteen Nvidia's grootste probleem: van een benchmark zouden ze eigenlijk een nagenoeg perfect netwerk moeten kunnen creëren, omdat elke run *bijna* identiek is. Ik zeg bijna, want zelfs in de meest statische benchmarks zijn er altijd kleine factoren waardoor een frame net iets anders uit ziet. Sterker nog, tussen een 2080 Ti en een 2080 zul je al verschil zien door het verschil in rendertijden. Wat Nvidia waarschijnlijk wel probleemloos klaar kan spelen is een nagenoeg perfect DLSS resultaat produceren voor een 2080 Ti die op 2160p rendert en dat vervolgens voor DLSS op diezelfde chip gebruiken. Echter zal dat resultaat niet 100% toepasselijk zijn voor een 2080, dus moeten ze de twee combineren. Dat is waar DL verder gaat dan ML. Met DL moet je ook een punt van oorsprong hebben, maar vervolgens ga je met wat je geleerd hebt nog eens kijken naar je data en probeer je nog accurater te worden. En dan voer je een soortgelijke set data in die net iets anders is om weer wat meer te leren.

Probleem #2 is dat je goed moet bepalen wat je "leerpunten" zijn. In het voorbeeld van het spamfilter is het tellen een goed begin, maar vervolgens moet je er maar op komen dat je naar de verbanden tussen woorden moet kijken. En dat de volgorde wellicht van belang is. En dat bepaalde combinaties van woorden wellicht vaak naast een andere combinatie staan. En dat er wellicht overmatig gebruik van hoofdletters en leestekens is. En...en, en, en.

Probleem #3 is dat je nooit 100% zeker bent dat je output accuraat is. Naarmate je model meer "leert" wordt die waarschijnlijkheid hoger, maar 100% zeker kun je niet zijn. Het zijn en blijven statistisch geïnformeerde beslissingen.

Het idee achter ML en DL is (hoop ik

In het geval van DLSS kun je voor een benchmark uiteraard vrij accuraat de upscaled resultaten leren. Dus 2160p resultaat voor een 1440p rendering: dan "leer" je het verschil tussen de twee en bepaal je hoe je het best van 1440p naar 2160p komt. Echter moet je dan ook rekening houden met verschillende grafische instellingen, rendertijden, verschillen in culling, enzovoort. Maar voor een open game als Metro kán dat gewoon niet. Je kunt onmogelijk alle mogelijke frame overal in de game als invoer genereren, dus DLSS zal altijd artefacten bevatten.

Dank voor deze heldere uitleg!Werelds schreef op donderdag 21 februari 2019 @ 11:12:

[...]

DLSS is en blijft AA in post-processing. Het zal altijd aan dingen komen waar het niet aan dient te komen. Ik heb het gevoel dat ik dat al eerder heb gezegd..

Het maakt niet uit hoe lang ze het netwerk trainen, het zal altijd een benadering van de doel resolutie blijven. En omdat het op volledig gerenderde buffers werkt kunnen ze ook onmogelijk rotzooi op textures vermijden.

Leuk idee, maar het is gewoon niet de toekomst. Het idee achter TAA heeft veel meer potentie. Gebruik die neurale netwerken om uit te vogelen waar MSAA niet meer genoeg is en SMAA (of in Nvidia's geval FXAA) toegepast moet worden. Nu werkt TAA nog min of meer door gewoon 2xMSAA toe te passen en dan PPAA over het hele frame te smeren. Als ze nou eens zorgen dat:

- 4xMSAA (meer is echt niet nodig) nog minder impact heeft

- dat de PPAA stap niet meer 100% PP is maar een beetje informatie heeft over waar dingen als alpha textures (hekwerk) gebruikt worden en dat dáár een beetje vaseline overheen gaat in plaats van over het hele frame

Dan gaat de IQ een stuk meer vooruit

[...]

Het heeft niets met de implementatie te maken, maar alles met het trainen van het netwerk aan Nvidia's kant. De game stuurt niets naar Nvidia als jij speelt, dus het wordt niet door gebruikers getraind (kan ook bijna niet).

Het simpelste voorbeeld om je een idee te geven van hoe machine-/deep-learning werken is een spam filter. Het is een alledaags dingetje, waar al tientallen jaren ML voor toegepast wordt. Het is tegelijkertijd ook zowel simpeler als lastiger dan je wellicht denkt. Waarschuwing: hier is weer eens één van mijn muurtjes. Voor de programmeurs onder ons, wat volgt is een simplistische uitleg van een Naive Bayes filter