Wacht ff af als er eenmaal genoeg voorraad is zakt die prijs vanzelf, zoals altijdXWB schreef op vrijdag 22 februari 2019 @ 15:42:

De eerste Nederlandse prijzen gaan vanaf € 299:

https://www.alternate.nl/...VIDIA-GeForce/GTX-1660-Ti

Dat vergelijken ze in het filmpje van Hardware Unboxed. Het ziet er beter uit als je 4k neemt met een lagere resolutie scale tussen de 75-85%, de fps is dan vergelijkbaar met DLSS en het beeld is een stuk scherper.Verwijderd schreef op vrijdag 22 februari 2019 @ 14:47:

De relevante vragen: hoe zijn de FPS en grafische kwaliteit met 4k met lagere instellingen zonder dit gekunstel en 1440p met hogere instellingen.

edit

Wat Daniël zei

/edit

DLSS wordt misschien nog een beetje beter maar het punt van Werelds is dat er een plafond is aan hoe goed het kan worden. Je zal dus problemen blijven houden met die textures.

[...]

Nvidia erkent dat de prijs te hoog wordt met die RTX- en Tensor-kernen terwijl de performance-winst twijfelachtig is en gaat daarom ook weer kaarten zonder dat spul verkopen?

Nvidia geeft ook aan dar de voordelen ook nadelen heeft. Het zal nooit perfect zijn. Net als met compressies en dergelijke. Het voordeel is een beter beeld dan wanneer je grafische instellingen gaat terugschroeven voor meer fps. Hopelijk gaat het nog net zo mooi worden als in de demo's waarbij je meer fps overhoud. De verschillen in beeldkwaliteit valen mij al niet meer op als je gewoon met de game bezig bent.Verwijderd schreef op vrijdag 22 februari 2019 @ 14:47:

De relevante vragen: hoe zijn de FPS en grafische kwaliteit met 4k met lagere instellingen zonder dit gekunstel en 1440p met hogere instellingen.

edit

Wat Daniël zei

/edit

DLSS wordt misschien nog een beetje beter maar het punt van Werelds is dat er een plafond is aan hoe goed het kan worden. Je zal dus problemen blijven houden met die textures.

[...]

TAAIs ook geen oplossing voor meer fps en zonder andere dingen als textures en schaduwen terug te schroeven. Liever wat minder scerp water zoals nu in Metro dan grotere texturen bijvoorbeeld.

@Werelds

Je weet wel wat ik bedoel, je hebt gewoon 4k als de monitor op die resolutie is ingesteld.

En indd alleen het water is wat minder scherp zoals je op de plaatjes kunt zien op Guru3d.

DLSS is een leuk extratje viir meer fps en bijna geen zichtbaar detail verlies.

[ Voor 21% gewijzigd door Gekke Jantje op 27-02-2019 06:30 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Nee de goedkoopsten zitten rond de 300 euro, eventueel de goedkoopste KFA2, PNY of Inno3D die een tientje minder is, maar de goedkoopste Gigabyte, Zotac, EVGA, MSI zitten op 300 euro. Hetzelfde zie je ook bij de RTX 2060, goedkoopste fabrikanten zitten net een tientje onder de 375 euro, terwijl die hier wat bekendere fabrikanten allemaal beginnen vanaf de MSRP.calsonic schreef op vrijdag 22 februari 2019 @ 15:59:

[...]

Wacht ff af als er eenmaal genoeg voorraad is zakt die prijs vanzelf, zoals altijd

Mja, zoals ik al eerder heb gezegd, er zijn nog jaren nodig voordat dit allemaal echt boeiend wordt.Paprika schreef op vrijdag 22 februari 2019 @ 13:15:

Volgens mij is het voornamelijk de combinatie van raytracing en DLSS die voor de instabiele frametimes zorgt. Het zorgt gewoon voor een te grote belasting voor de huidige generatie.

Zelfs op 1440p heb je dan wel wat raytracing, maar het spel doet bijvoorbeeld ook geen soft-shadows meer van enige point-lights. Je hebt alleen schaduw van GI, je zaklamp doet geen reet. Dat is ook gewoon vreemd, want juist in een spel als dit is de zaklamp belangrijk voor het gevoel dat je in de game hebt. Wat ze nu klaarspelen met RT kost ze minder moeite qua mapping, maar hetzelfde effect hadden ze kunnen bereiken door zelf diffuse lichtbronnen in de maps te plaatsen...en dan had je tenminste fatsoenlijke soft-shadows kunnen hebben van lichtbronnen die je zelf in de hand hebt. Stel je voor dat Doom 3 dit had gehad...

Voordat we die twee dingen kunnen combineren, zijn we makkelijk 2-3 jaar verder. Dat vereist niet zomaar het dubbele aan rekenkracht, dat is wel een factor 4-6 meer, omdat de lichtbronnen elkaar gaan beïnvloeden. En dan is het nog steeds niet genoeg voor reflecties.

Ik ben in elk geval nog steeds niet onder de indruk. Leuk, BF V doet reflecties (soort van), iets waar je in die specifieke game 0,0% van de tijd naar gaat zitten kijken. Als ze nou accuraat genoeg waren om mee om een hoekje te gluren wellicht wel, maar dat gaat dan weer niet omdat dat nog niet te doen is. En dan heb je Metro, waar "de zon" raytraced is en inderdaad veel nauwkeurigere resultaten geeft...maar alle andere lichtbronnen doen niets meer.

offtopic:

Dank je

Dank je

Je beseft hopelijk dat je met DLSS eigenlijk helemaal geen 4K hebt?Gekke Jantje schreef op vrijdag 22 februari 2019 @ 14:06:

Echter heb je zonder DLSS nog minder fps op 4k.

Minder scherp water? Dat is wel het minste wat verneukt wordt. Dat een voorwerp waar je wellicht recht naar kijkt super wazig wordt (zoals die knuffelbeer) vind ik toch wel knap storend. Echt, dat ding ziet er uit als een model+texture van 10 jaar geleden met DLSSGekke Jantje schreef op vrijdag 22 februari 2019 @ 19:46:

TAAIs ook geen oplossing voor meer fps en zonder andere dingen als textures en schaduwen terug te schroeven. Liever wat minder scerp water zoals nu in Metro dan grotere texturen bijvoorbeeld.

Na het lezen van jouw post heb ik dat filmpje eens even opgezocht. Dat is dus wat ik al dacht. Traditioneel upscalen geeft over het geheel een mooier resultaat. Ook daar zijn dingen niet helemaal lekker, maar het heeft minder problemen dan DLSS.Sp3ci3s8472 schreef op vrijdag 22 februari 2019 @ 18:18:

Dat vergelijken ze in het filmpje van Hardware Unboxed. Het ziet er beter uit als je 4k neemt met een lagere resolutie scale tussen de 75-85%, de fps is dan vergelijkbaar met DLSS en het beeld is een stuk scherper.

Niet NVIDIA specifiek, maar wel ietsje relevanter hier voorlopig:

[ Voor 71% gewijzigd door Paprika op 23-02-2019 21:22 ]

Is het verschil tussen deze twee echt alleen de koeler? Zou het de meerprijs dan waard zijn voor gamen?

pricewatch: Gigabyte GeForce GTX 1660 Ti OC 6G

of

pricewatch: Gigabyte GeForce GTX 1660 Ti Gaming OC 6G

pricewatch: Gigabyte GeForce GTX 1660 Ti OC 6G

of

pricewatch: Gigabyte GeForce GTX 1660 Ti Gaming OC 6G

Dunno, ik vond 3 fans een beetje overdreven voor een ~140W kaart, dus heb er 1 met 2 fans besteld.

deze zit er nog tussen trouwens:

pricewatch: Gigabyte GeForce GTX 1660 Ti Windforce OC 6G

deze zit er nog tussen trouwens:

pricewatch: Gigabyte GeForce GTX 1660 Ti Windforce OC 6G

[ Voor 50% gewijzigd door haarbal op 23-02-2019 23:13 ]

Mechwarrior Online: Flapdrol

ohw dan is die wellicht de betere keuze van de 3haarbal schreef op zaterdag 23 februari 2019 @ 23:05:

Dunno, ik vond 3 fans een beetje overdreven voor een ~140W kaart, dus heb er 1 met 2 fans besteld.

deze zit er nog tussen trouwens:

pricewatch: Gigabyte GeForce GTX 1660 Ti Windforce OC 6G

[ Voor 3% gewijzigd door Alexknl op 23-02-2019 23:51 ]

Gigabyte zelf geeft een core clock verschil aan van 1860 om 1800 Mhz. Die Windforce doet dan weer 1845. Micro-marktsegmentatie.Alexknl schreef op zaterdag 23 februari 2019 @ 22:41:

Is het verschil tussen deze twee echt alleen de koeler? Zou het de meerprijs dan waard zijn voor gamen?

pricewatch: Gigabyte GeForce GTX 1660 Ti OC 6G

of

pricewatch: Gigabyte GeForce GTX 1660 Ti Gaming OC 6G

Man hopes. Genius creates. Ralph Waldo Emerson

Never worry about theory as long as the machinery does what it's supposed to do. R. A. Heinlein

Wat zouden jullie doen? 2070 of 1660ti? 2070 is voor +- 530 euro te verkrijgen en 1660 straks voor 295. Toch een behoorlijk prijsverschil.

Ik wil graag 1440p kunnen spelen met minimaal 60 FPS bij moderne games (shooters, rts etc) dus denk dat de 1660 net te kort gaat doen en weinig toekomstvast is. Wat denken jullie?

Ik wil graag 1440p kunnen spelen met minimaal 60 FPS bij moderne games (shooters, rts etc) dus denk dat de 1660 net te kort gaat doen en weinig toekomstvast is. Wat denken jullie?

Voor 1440p en >60fps is een 1660Ti denk ik te weinig.

Het gat is wel een stuk groter dan 10%. En sterker nog, de grootste performance bump die je in een custom 2060 review gaat tegenkomen is nog geen 7%.KhaZ schreef op woensdag 27 februari 2019 @ 19:56:

Ik zeg RTX 2060 met een 5-10% OC, dan heb je een RTX 2070 voor €150 minder.

Ja wil je RTX 2070 prestaties halen uit een RTX 2060 moet je echt extreem overklokken, dat gaat niet lukken met luchtkoeling.

Ik sta momenteel voor dezelfde vraag... ter vervanging van mijn R9 390...Workaholic schreef op woensdag 27 februari 2019 @ 19:50:

Wat zouden jullie doen? 2070 of 1660ti? 2070 is voor +- 530 euro te verkrijgen en 1660 straks voor 295. Toch een behoorlijk prijsverschil.

Ik wil graag 1440p kunnen spelen met minimaal 60 FPS bij moderne games (shooters, rts etc) dus denk dat de 1660 net te kort gaat doen en weinig toekomstvast is. Wat denken jullie?

Maar hoe meer benchmarks ik bekijk hoe meer ik naar een RTX2080 begin te kijken... ik vind de upgrade van de 2070 niet groot genoeg over een 2060. Dus ik hoop met wat meer uit te geven ook iets beter future proof te zijn met een 2080...

Maar als jullie mij van gedacht kunnen veranderen, laat maar weten!

Je betaald ongeveer 100% meer voor een RTX 2080 in vergelijking met een RTX 2060 en je krijgt ongeveer 45% meer prestaties.

Jup I know... is zeker niet de beste bang for the buck. Maar ALS Ray-Tracing er door komt is het een verschil tussen wel & niet speelbaar op 1440p...Verwijderd schreef op donderdag 28 februari 2019 @ 13:41:

Je betaald ongeveer 100% meer voor een RTX 2080 in vergelijking met een RTX 2060 en je krijgt ongeveer 45% meer prestaties.

Bijkomend als je alles op ultra zet in bv Shadow Of the Tomb Raider kom je er niet met een RTX2060 op 1440p >60fps...

Of ben ik fout geïnformeerd?

Ik heb maar bang als ik nu een RTX2060 aanschaf ik er niet echt lang mee ga doen... En zou toch graag minimaal 3 jaar met een GPU doen...

Natuurlijk is een 2070 iets sneller dan een 2060 maar iets dit verschil €150 waard? Het lijkt me van niet:Paprika schreef op donderdag 28 februari 2019 @ 12:30:

[...]

Het gat is wel een stuk groter dan 10%. En sterker nog, de grootste performance bump die je in een custom 2060 review gaat tegenkomen is nog geen 7%.

https://bit-tech.net/revi...0-gamingpro-oc-review/11/

Je kunt een 2070 natuurlijk ook overklokken...KhaZ schreef op donderdag 28 februari 2019 @ 15:31:

[...]

Natuurlijk is een 2070 iets sneller dan een 2060 maar iets dit verschil €150 waard? Het lijkt me van niet:

https://bit-tech.net/revi...0-gamingpro-oc-review/11/

https://www.bit-tech.net/...rtx-2070-armor-review/11/

True..mitsumark schreef op donderdag 28 februari 2019 @ 16:40:

[...]

Je kunt een 2070 natuurlijk ook overklokken...

https://www.bit-tech.net/...rtx-2070-armor-review/11/

Geen idee. Maar waarom zou je alles op standaard ultra instellingen zetten en niet even een paar instellingen omlaag zetten, waarbij het verschil toch niet of amper zichtbaar is.Witte_200 schreef op donderdag 28 februari 2019 @ 15:02:

[...]

Bijkomend als je alles op ultra zet in bv Shadow Of the Tomb Raider kom je er niet met een RTX2060 op 1440p >60fps...

Of ben ik fout geïnformeerd?

Ook weer waar. Maar zo kan je je natuurlijk ook gaan afvragen waarom je upgrade in de eerste plaatsVerwijderd schreef op donderdag 28 februari 2019 @ 16:52:

[...]

Geen idee. Maar waarom zou je alles op standaard ultra instellingen zetten en niet even een paar instellingen omlaag zetten, waarbij het verschil toch niet of amper zichtbaar is.

Ach, Ik wacht sowieso nog even af wat heel het Ray-Tracing gebeuren gaat doen.

En vermits deze post eigenlijk in een aankoopadvies topic thuis horen ga ik hier niets meer over zeggen

Bedankt voor het meedenken!

Verwijderd

Alles op ultra-instellingen zetten is inderdaad nogal een n00b-fout. Als je niet wil nadenken en gegarandeerd de beste graphics wil hebben en je bent bereid om daar flink extra voor te betalen, prima, maar als je wat kosten wil besparen of wat minder herrie in je systeem wil dan zet je een hoop instellingen een stand lager maar uiteraard niet alle instellingen aangezien niet alle instellingen een relevant verschil maken.

Vraag ik me ook af, en ik zie hier op ultra een max geheugengebruik van ergens in de 3gb op 2560x1440 dus dat is al geen probleem. Ik denk eeder dat er met de AA is geromneld want die 60 fps moet wel op ultra haalbaar zijn (met een OC) gezien de reviews. Persoonlijk vind ik 60 fps ook voldoende voor games als Tomb Raider.Verwijderd schreef op donderdag 28 februari 2019 @ 16:52:

[...]

Geen idee. Maar waarom zou je alles op standaard ultra instellingen zetten en niet even een paar instellingen omlaag zetten, waarbij het verschil toch niet of amper zichtbaar is.

[ Voor 20% gewijzigd door Gekke Jantje op 01-03-2019 07:24 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Hoe bedoel je, "met AA gerommeld"? Wil je zeggen als je AA wat lager instelt dat de 2060 het dan veel beter doet op 1440p ultra?Gekke Jantje schreef op vrijdag 1 maart 2019 @ 07:13:

[...]

Vraag ik me ook af, en ik zie hier op ultra een max geheugengebruik van ergens in de 3gb op 2560x1440 dus dat is al geen probleem. Ik denk eeder dat er met de AA is geromneld want die 60 fps moet wel op ultra haalbaar zijn (met een OC) gezien de reviews. Persoonlijk vind ik 60 fps ook voldoende voor games als Tomb Raider.

Op welke review doel je juist? Als ik naar die van Techspot kijk dan zit de Average FPS maar net op 63fps... Maar ik weet niet op welke instellingen zijn Shadow of the Tomb raider zetten...

Klopt gemiddeld 60 fps, na mijn idee moet dat voor dit soort games prima speelbaar zijn. Het is niet echt een snelle fps game. Het kan natuurlijk zijn dat jij er geen genoegen mee neemt. Zoals Metro Exodus ook speel ik met maar gemiddeld 60 fps af en in sommige gebieden raakt de fps onder de 50 fps. Echter begin ik me pas te storen als ik een fps programma er bij aan heb en daar dan op ga letten.Witte_200 schreef op vrijdag 1 maart 2019 @ 09:08:

[...]

Hoe bedoel je, "met AA gerommeld"? Wil je zeggen als je AA wat lager instelt dat de 2060 het dan veel beter doet op 1440p ultra?

Op welke review doel je juist? Als ik naar die van Techspot kijk dan zit de Average FPS maar net op 63fps... Maar ik weet niet op welke instellingen zijn Shadow of the Tomb raider zetten...

Edit

Ik doelde op de review van Guru3d die test met ultra present.

[ Voor 4% gewijzigd door Gekke Jantje op 01-03-2019 09:55 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Dan zit het echt tussen de oren. Daarnaast is frametimes veel belangrijker, 60 fps kan bij slechte frametimes verschrikkelijk voelen. Terwijl 40 fps met perfecte frametimes en gesynchroniseerd aan de refreshrate van het scherm in veel games prima is.

Helemaal mee eens... Bijkomend gaat mijn Monitor toch niet voorbij de 60fps en heeft ook geen variable refresh rates mogelijkheden... Dus meer dan 60fps is voor mij persoonlijk zeker niet nodig...Gekke Jantje schreef op vrijdag 1 maart 2019 @ 09:53:

[...]

Klopt gemiddeld 60 fps, na mijn idee moet dat voor dit soort games prima speelbaar zijn. Het is niet echt een snelle fps game. Het kan natuurlijk zijn dat jij er geen genoegen mee neemt. Zoals Metro Exodus ook speel ik met maar gemiddeld 60 fps af en in sommige gebieden raakt de fps onder de 50 fps. Echter begin ik me pas te storen als ik een fps programma er bij aan heb en daar dan op ga letten.

Edit

Ik doelde op de review van Guru3d die test met ultra present.

De grote vraag voor mij zit hem in het hele Ray tracing gebeuren... Gaat dit aanslaan of niet? En als het aan slaat lijkt de RTX2060 mij wat te langzaam... Maar ja, daarvoor zou die glazen bol goed van pas komen natuurlijk...

Edit: Ik begrijp dus nog altijd niet zo goed voor wie deze kaart eigenlijk bedoelt is. Mijn persoonlijk gevoel zegt voor Full HD gamers die Ray Tracing willen gebruiken. Want voor 1440p gaat dit niet lukken, en het stoort mij dan enorm dat er in de kaart cores in gebouwd zijn die nooit gebruikt zullen/kunnen worden...

Maar opnieuw, correct me if I'm wrong.

[ Voor 15% gewijzigd door Witte_200 op 01-03-2019 10:22 ]

Verwijderd

Ook bij een lage RR van 60 Hz wordt de inputlag lager bij een hogere FPS dan 60. In een mindere mate dan wanneer je monitor een hogere RR zou hebben maar voldoende dat je het waarneemt. Of dat het uitmaakt weet je alleen door het te proberen, zet de instellingen eens wat lager en meet de FPS en zie of dat het met 90 FPS voor jou beter speelt. Zie de derde alinea.

De FPS is inderdaad een nogal povere maat omdat 1 seconde zoveel frames bevat en je een sterke variatie in framerendertijd kan hebben, ook als de FPS 60 of zelfs 100 is. Stel dat je per 100 frames 90 frames hebt die in 13 ms worden gerenderd, 6 die in 20 ms worden gerenderd, 2 die in 40 ms worden gerenderd en 2 die in 110 ms worden gerenderd, dan is de gemiddelde framerendertijd 15,9 seconde en zit je op 63 FPS. Op papier niet slecht maar ik denk niet dat je dit als lekker speelbaar ervaart.

Hoe sterk het voor individu X de speelbaarheid beïnvloedt hangt af van die persoon zijn reactievermogen en dat verschilt enorm sterk tussen mensen. Er zijn mensen voor wie een 40 FPS met een consistente framrendertijd al volstaat en er zijn mensen die het verschil kunnen vertellen tussen 110 en 100 FPS wanneer de framerendertijd even consistent is.

Verder nog maar eens de opmerking die overbodig zou moeten zijn: stop met die ultra-obsessie en geniet van dezelfde graphics met een hogere FPS en meer consistente framerendertijd. Of houd jezelf voor de gek, zet alles op ultra en krijg een slechter resultaat.

De FPS is inderdaad een nogal povere maat omdat 1 seconde zoveel frames bevat en je een sterke variatie in framerendertijd kan hebben, ook als de FPS 60 of zelfs 100 is. Stel dat je per 100 frames 90 frames hebt die in 13 ms worden gerenderd, 6 die in 20 ms worden gerenderd, 2 die in 40 ms worden gerenderd en 2 die in 110 ms worden gerenderd, dan is de gemiddelde framerendertijd 15,9 seconde en zit je op 63 FPS. Op papier niet slecht maar ik denk niet dat je dit als lekker speelbaar ervaart.

Hoe sterk het voor individu X de speelbaarheid beïnvloedt hangt af van die persoon zijn reactievermogen en dat verschilt enorm sterk tussen mensen. Er zijn mensen voor wie een 40 FPS met een consistente framrendertijd al volstaat en er zijn mensen die het verschil kunnen vertellen tussen 110 en 100 FPS wanneer de framerendertijd even consistent is.

Verder nog maar eens de opmerking die overbodig zou moeten zijn: stop met die ultra-obsessie en geniet van dezelfde graphics met een hogere FPS en meer consistente framerendertijd. Of houd jezelf voor de gek, zet alles op ultra en krijg een slechter resultaat.

[ Voor 26% gewijzigd door Verwijderd op 01-03-2019 11:54 ]

nVidia's nieuwe idee om je tot een meer high end kaart te bewegen:

NVIDIA Explains How Higher Frame Rates Can Give You an Edge in Battle Royale Games

https://www.nvidia.com/en...he-edge-in-battle-royale/

Leuk idee voor de reviews: De KD ratio van een kaart testen...

NVIDIA Explains How Higher Frame Rates Can Give You an Edge in Battle Royale Games

https://www.nvidia.com/en...he-edge-in-battle-royale/

Leuk idee voor de reviews: De KD ratio van een kaart testen...

[ Voor 41% gewijzigd door Help!!!! op 07-03-2019 18:40 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Help!!!! schreef op donderdag 7 maart 2019 @ 18:38:

nVidia's nieuwe idee om je tot een meer high end kaart te bewegen:

NVIDIA Explains How Higher Frame Rates Can Give You an Edge in Battle Royale Games

https://www.nvidia.com/en...he-edge-in-battle-royale/

Leuk idee voor de reviews: De KD ratio van een kaart testen...

Het gaat lekker met de verkoop van Turing als ze deze BS gaan uitdragen. Natuurlijk duikt PcPer weer op om de BS te verspreiden zonder enige vorm van kritiek. Er bestaat bijvoorbeeld het concept van low settings waardoor je niet alleen hogere framerates haalt, maar ook groter contrast hebt tussen doelen en de omgeving. Dat helpt ook met je K/D...

Heb ik het nog niet gehad over basale wetenschappelijke principes die in acht genomen horen te worden voordat je willekeurig met getallen gaat gooien...

[ Voor 24% gewijzigd door DaniëlWW2 op 07-03-2019 18:56 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik wil graag op mijn 1440p 144hz beeldscherm de maximale framerates gaan halen. Ik zit nu op een gtx 1070 maar met de zwaardere games hang ik dan toch vaak tussen de 80-90 fps.

Als ik voor de 144fps ga, welke kaart die nu op de markt ligt is dan minimaal het vereiste. Ik zit namelijk te overwegen om mijn 1070 te dumpen en er een nieuwe voor terug te kopen.

Als ik voor de 144fps ga, welke kaart die nu op de markt ligt is dan minimaal het vereiste. Ik zit namelijk te overwegen om mijn 1070 te dumpen en er een nieuwe voor terug te kopen.

Kijk anders even 3 posts boven je.RTM93 schreef op zaterdag 9 maart 2019 @ 07:10:

Ik wil graag op mijn 1440p 144hz beeldscherm de maximale framerates gaan halen. Ik zit nu op een gtx 1070 maar met de zwaardere games hang ik dan toch vaak tussen de 80-90 fps.

Als ik voor de 144fps ga, welke kaart die nu op de markt ligt is dan minimaal het vereiste. Ik zit namelijk te overwegen om mijn 1070 te dumpen en er een nieuwe voor terug te kopen.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Waar overigens gewoon een kern van waarheid in zit maar dat staat los van een RTX. Ook komt Nvidia met cijfers zonder enige feiten.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Ik denk dat een fatsoenlijke monitor met lage inputlag en een fatsoenlijke muis, na skill, het belangrijkste zijn. Een snellere videokaart zorgt er enkel voor dat je "mooier" je K/D-ratio haalt...

MacBook Pro 16” M4 Pro | PC (Ryzen 9800X3D / RTX5090 / 64GB) | PS5 Pro | Switch 2 | LG 77G2 | B&W 700 S2 | Nikon Z8 + 14-30, 24-120, 100-400 | iPhone 16 Pro Max | Tesla Model Y

Een snelle CPU en GPU hebben direct invloed op je inputlag...MazeWing schreef op zaterdag 9 maart 2019 @ 13:33:

Ik denk dat een fatsoenlijke monitor met lage inputlag en een fatsoenlijke muis, na skill, het belangrijkste zijn. Een snellere videokaart zorgt er enkel voor dat je "mooier" je K/D-ratio haalt...

Indd een lage inputlag is ook belangrijk maar dan wel met minimaal 100hz. 60hz is te langzaam merk ik voor shooters en ik ben maar gemiddeld goed. Mensen die zeggen dat er geen verschil is hebben nog nooit snelle shooters gespeelt boven de 60hz.MazeWing schreef op zaterdag 9 maart 2019 @ 13:33:

Ik denk dat een fatsoenlijke monitor met lage inputlag en een fatsoenlijke muis, na skill, het belangrijkste zijn. Een snellere videokaart zorgt er enkel voor dat je "mooier" je K/D-ratio haalt...

Edit

50% beter is na mijn idee ook gewoon overdreven marketing geneuzel.

[ Voor 6% gewijzigd door Gekke Jantje op 09-03-2019 16:21 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

hoge hz muis, dan kan smoothing ook uit, snelle cpu, snelle gpu, snelle monitor, alles helpt om de totale inputlag omlaag te krijgen zodat je die links-rechts strafende klootviolen makkelijker kunt raken.

Muis is de 1e upgrade die je zou moeten doen vanaf een "gewoon" systeem denk ik, meeste bang/buck.

Muis is de 1e upgrade die je zou moeten doen vanaf een "gewoon" systeem denk ik, meeste bang/buck.

[ Voor 4% gewijzigd door haarbal op 09-03-2019 14:57 ]

Mechwarrior Online: Flapdrol

Ik lees een hoop tekst maar niet een videokaart die aan mijn behoeftes voldoen. Dus mijn vraag staat nog.

[ Voor 40% gewijzigd door dion_b op 09-03-2019 22:48 ]

Een vraag die niet in dit topic thuis hoort  .

.

The only thing you need; a jar of "Elbow Grease" (TM) ! Apply it liberally and it will make any job a breeze.

Er wordt gerefereerd naar de topicwarning. Waarin staat dat dit topic niet is bedoeld voor aankoopadvies.RTM93 schreef op zaterdag 9 maart 2019 @ 19:22:

[...]

Ik lees een hoop tekst maar niet een videokaart die aan mijn behoeftes voldoen. Dus mijn vraag staat nog.

Als je dat al niet eens terug kan lezen hoor je niet thuis op dit forum.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Dan ligt de fout bij mij en keek ik verkeerd. Ik dacht dat ik al die tijd al in dat topic zat.Blaat schreef op zaterdag 9 maart 2019 @ 19:57:

[...]

Er wordt gerefereerd naar de topicwarning. Waarin staat dat dit topic niet is bedoeld voor aankoopadvies.

Als je dat al niet eens terug kan lezen hoor je niet thuis op dit forum.

Verwijderd

Dit lijkt mij de juiste plaats voor aankoopadvies op dit forumpje.

Componenten Aankoopadvies

Componenten Aankoopadvies

Compared to Pascal, Turing improved power-efficiency once more, and the GTX 1660 is no exception. Zotac's GTX 1660 uses only 108 W during gaming, which is even more impressive when you consider how much gaming performance the card has in it. Even compared to the latest Turing RTX GPUs, the GTX 1660 achieves 10% better performance per watt. Against AMD's Radeon RX 590, which was just recently released and uses a 12 nm production process too, the GTX 1660 is 2.5x more power-efficient; that's 250%!

De GTX1660 OCed wel lekker voor zijn segment zeg.

[ Voor 46% gewijzigd door Paprika op 14-03-2019 17:38 ]

Jammer dat ze alleen Unigine Heaven laten zien met de OC. Ik vind de enorme sprong dusdanig opvallend dat ik me afvraag of het niet Unigine Heaven specifiek is. Het lijkt het in het algemeen een serieuze geheugenbrandbreedte bottleneck te zijn, maar puur op een benchmark kan je dat moeilijk vaststellen. Klopt het, dan doet de 192bit i.p.v de 256bit bus waarschijnlijk meer pijn dan de vermindering aan CUDA cores. Zou toch een mooi inzicht zijn op Turing haar sterktes en zwaktes.Paprika schreef op donderdag 14 maart 2019 @ 17:31:

[Afbeelding]

[...]

[Afbeelding]

[Afbeelding]

[Afbeelding]

De GTX1660 OCed wel lekker voor zijn segment zeg.

Sinds release vraag ik me eigenlijk al af hoe de balans tussen FP en INT eigenlijk gaat in Turing. Ook vroeg ik me meteen af of de 128 CUDA core SM's van Maxwell/Pascal stiekem helemaal niet zo efficiënt waren aangezien Turing het met wat extra cache en de helft aan FP cores afkon. Je ziet games waarvan bekend is dat ze veel GPU compute doen, ook veel beter draaien op Turing, maar games die minder zijn draaien ook niet minder dan op Pascal.

In het algemeen doet de kaart ook precies wat verwacht mocht worden. Verslaat de RX590 en is zuiniger. Aangezien ik persoonlijk de RX590 als de grootste aanfluiting van 2018 beschouw, en er is flinke competitie voor die titel, is dat niet veel. Blijf 20% meer voor een hogere MSRP, generatie op generatie, gewoon belachelijk vinden.

Om dat meteen maar toe te lichten voordat dit weer begint. Uiteindelijk ben ik meer geïnteresseerd in de techniek dan de prestaties of prijs. De perf/price van Turing beschouw ik als belabberd, en met reden. Kwalijker vind ik dat Nvidia met "realtime" raytracing kwam met zulke gigantische prestatieregressies. Vervolgens het echte breekpunt voor mij is DLSS. Noem iets niet Deep Learning Supersampling als het resultaat meer lijkt op FXAA. Dat laatste "triggert" met een beetje.

[ Voor 11% gewijzigd door DaniëlWW2 op 14-03-2019 20:47 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Zoiets?DaniëlWW2 schreef op donderdag 14 maart 2019 @ 19:08:

[...]

Jammer dat ze alleen Unigine Heaven laten zien met de OC. Ik vind de enorme sprong dusdanig opvallend dat ik me afvraag of het niet Unigine Heaven specifiek is. Het lijkt het in het algemeen een serieuze geheugenbrandbreedte bottleneck te zijn, maar puur op een benchmark kan je dat moeilijk vaststellen. Klopt het, dan doet de 192bit i.p.v de 256bit bus waarschijnlijk meer pijn dan de vermindering aan CUDA cores. Zou toch een mooi inzicht zijn op Turing haar sterktes en zwaktes.

[ Voor 5% gewijzigd door Paprika op 14-03-2019 20:04 ]

Zoiets ja.

Maar als ik de Palit pak dan kom ik op 15% extra core en 22,5% extra memoryclock uit. Helaas is die overview gebaseerd op 2560x1440p. Dan ga je al langzaam naar een geheugen bottleneck waardoor het niet erg representatief is voor waar ik naar zoek. Het verklaard de bijna 1/1 schaling tussen core clocks en prestaties wel, maar niet de vraag of de GTX1660 nu tegen een grotere geheugen bottleneck aanloopt. Ik ga wel eens rondkijken of ik het kan vinden want ik ben benieuwd.

edit: binnen een paar minuten ben ik er denk ik al achter. Zoals altijd gewoon naar Anandtech gaan.

https://www.anandtech.com...ew-feat-evga-xc-gaming/15

Lijkt inderdaad zwaarder op geheugen te zijn dan puur op clocks. De sterkste indicatie is denk ik niet eens de geheugen OC, maar meer GDDR5 vs GDDR6. De GTX1660 is ook maar een zeer geringe cut down van Tu-116, maar het prestatieverschil met de GTX1660Ti is zeker merkbaar.

[ Voor 24% gewijzigd door DaniëlWW2 op 14-03-2019 20:21 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ja, en fp16DaniëlWW2 schreef op donderdag 14 maart 2019 @ 19:08:

Sinds release vraag ik me eigenlijk al af hoe de balans tussen FP en INT eigenlijk gaat in Turing. Ook vroeg ik me meteen af of de 12 CUDA core SM's van Maxwell/Pascal stiekem helemaal niet zo efficiënt waren aangezien Turing het met wat extra cache en de helft aan FP cores afkon. Je ziet games waarvan bekend is dat ze veel GPU compute doen, ook veel beter draaien op Turing, maar games die minder zijn draaien ook niet minder dan op Pascal.

YouTube: GTX 1660 Ti Analysis

Als je naar die slide kijkt lijkt het of je aan een int32, fp32 en een fp16 instructie tegelijk kan werken.

Mechwarrior Online: Flapdrol

Ook mijn RTX2080 schaalt veel beter met een geheugen- dan een core overclock. Mijn core wil niet eens heel hard, maar mijn geheugen wel (flink boven gemiddeld ook nog eens) en uit eigen testen blijkt dat dat ook veel belangrijker is

Ik heb die block diagrams uiteraard ook al gezien. Ik doel alleen op wat anders.haarbal schreef op donderdag 14 maart 2019 @ 20:25:

[...]

Ja, en fp16

YouTube: GTX 1660 Ti Analysis

Als je naar die slide kijkt lijkt het of je aan een int32, fp32 en een fp16 instructie tegelijk kan werken.

Wat mij zo opviel met Turing is dat Nvidia na jaren van steeds algemenere en breed inzetbare ALU's, opeens overging naar vier aparte typen fixed function rekenkernen ging. FP cores doen alleen FP32, INT cores alleen compute berekeningen, RT cores alleen ray tracing berekeningen en Tensor cores doen FP16, DLSS en denoising voor de RT cores.

Ik kan het moeilijk als efficiënt ervaren. Waarom kunnen die RT cores niet bijvoorbeeld ook FP16 doen? Waarom moeten er nog extra Tensor cores aan te pas komen voor die functie? Waarom kunnen de FP cores alleen FP32 en niet ook 2x FP16 of zelfs 1x FP16? 1x FP16 werd al ondersteund door Tonga, Fiji en Polaris. Waarom aparte INT en FP cores? Kan Nvidia geen ALU ontwerpen die iets meer dan een functie naar behoren kan uitvoeren?

Is dit een onrealistische verwachting? Nee, niet als je naar Vega kijkt. Er is veel mis met Vega, maar een Vega ALU kan gewoon verschillende INT, FP16 en FP32 berekeningen uitvoeren. Vega faalt net zoals de andere recente GCN's in het fatsoenlijk loads plaatsen op haal ALU's. Verder is het verbruik veel te hoog.

Als ik het in iets grotere context plaats dan zie je dit ook bij de CPU's gebeuren. Van wat ik heb begrepen heeft AMD in haar Zen architectuur bewust een splitsing tussen FP en INT pijplijnen aangebracht omdat dit makkelijker ontwikkelen is. Skylake heeft deze scheiding niet waardoor Skylake merkbaar sneller is als er puur FP of INT berekeningen worden uitgevoerd. Hierbij hou ik zeker rekening met de financiële ellende waar AMD jaren in verkeerde en de prioriteit voor Zen over Radeon. Ik vind het dan ook tekenend dat de RTG het jaren geleden wel voor elkaar heeft gekregen om hun ALU's meerdere dingen te laten doen, en Nvidia nog steeds niet.

Ik zou bijna gaan denken dat Nvidia, Turing als een halve haastklus heeft ontwikkeld en van plan is om veel elementen snel te vervangen. Het is dat, of Nvidia heeft gefaald om een flexibele ALU te ontwikkelen en heeft bewust gekozen voor deze simpele, maar ogenschijnlijk inefficiënte aanpak. Dat zit me gewoon dwars.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Shadow of the Tomb Raider RTX Patch Now Available: RTX and DLSS Enabled

https://www.techpowerup.c...and-dlss-enabled#comments

https://www.techpowerup.c...and-dlss-enabled#comments

https://www.techpowerup.c...the_Tomb_Raider_RTX_DLSS/Shadow of the Tomb Raider comes with three RTX settings options:

Medium: Enables shadows for selected point lights only.

High: Enables additional spot and directional lights, including the sun, replacing traditional shadow maps.

Ultra: Improves on this by adding translucent shadows and additional rays for a higher quality result, at a significant performance cost.

First and foremost is RTX raytracing, which improves the quality and realism of shadows in SOTTR. Looking at our comparison screenshots I can definitely spot differences and the shadows look more real, especially the soft shadows look amazing. However, given that the game makes great use of shadow maps already (when RTX is off), the increase in quality ends up more looking more like one additional shadow quality setting — not like a game transforming experience. Still, RTX shadows are a great vehicle for developers to get their feet wet with RTX and to experiment without making huge code changes. The next step forward would be doing not only shadows but rendering all lighting with RTX, which can yield amazing results, as we've seen in yesterday's GTC presentation.

Performance cost of RTX raytracing is comparable to other titles and in the 30-50% range, depending on the actual scene — definitely not negligible. Also the game has a few bugs related to settings and the performance difference between "RTX High" and "RTX Ultra" is almost non-existent. This is similar to what we've seen in Battlefield V's first version of RTX raytracing and suggests that Eidos still has some optimizing to do. In Battlefield, the developer DICE, was able to gradually reduce the RTX performance hit over several patches (NVIDIA's developer relations helped a lot here). Given how important RTX is to NVIDIA I have no doubts that we'll see the same happen in Shadow of the Tomb Raider. As mentioned before, I'd consider this more of a test run for future titles and to introduce developers to the tech, so they can make great things in their next game — the learned knowledge won't be lost.

DLSS on the other hand does very good in Shadow of the Tomb Raider. We see around 35% performance gained at 4K, which is quite significant and nearly offsets the performance hit from RTX. Image quality seems very decent — not sure if it's due to good DLSS training data or because the art style of Shadow of the Tomb Raider tends to work better with DLSS. Of course if you peep at individual pixels and do side-by-side image comparison, you'll always be able to make out areas where DLSS looks blurry. Personally I find DLSS-on vs. DLSS-off really hard to tell apart, which made organizing my screenshots a bit difficult because the differences are small.

[ Voor 117% gewijzigd door Paprika op 19-03-2019 18:54 ]

Betere shadows in Shadow of the TombraiderPaprika schreef op dinsdag 19 maart 2019 @ 18:48:

Shadow of the Tomb Raider RTX Patch Now Available: RTX and DLSS Enabled

https://www.techpowerup.c...and-dlss-enabled#comments

[...]

https://www.techpowerup.c...the_Tomb_Raider_RTX_DLSS/

[...]

Op sommige punten ziet het er mooier uit, op andere is het iets minder overtuigend als je de performance impact ziet en het vergelijkt met de oude situatie.

Wat vind je van de DLSS resultaten?Sp3ci3s8472 schreef op dinsdag 19 maart 2019 @ 19:43:

[...]

Betere shadows in Shadow of the Tombraider.

Op sommige punten ziet het er mooier uit, op andere is het iets minder overtuigend als je de performance impact ziet en het vergelijkt met de oude situatie.

https://www.techpowerup.c...mb_Raider_RTX_DLSS/3.html

Nog een leuk projectje van ze:We see around 35% performance gained at 4K, which is quite significant and nearly offsets the performance hit from RTX. Image quality seems very decent. I am not sure if this due to good DLSS training data or because the art style of Shadow of the Tomb Raider tends to work better with DLSS. Of course, if you look at individual pixels and do side-by-side image comparisons, you'll always be able to make out areas where DLSS looks blurry. Personally, I find DLSS-on vs. DLSS-off really hard to tell apart, which made organizing my screenshots a bit difficult because the differences are small.

https://github.com/NVlabs/SPADE

https://nvlabs.github.io/SPADE/

[ Voor 53% gewijzigd door Paprika op 19-03-2019 22:12 ]

Beter dan bij Metro, maar lastig om te zien omdat de screenshots niet op volle resolutie zijn. Om eerlijk te zijn vind is het niet mijn stijl, maar dat is niet DLSS specifiek. Als ik oude spellen zoals FF8 speel en daar texture filtering aanzet dan ziet het er niet meer uit.Paprika schreef op dinsdag 19 maart 2019 @ 21:23:

[...]

Wat vind je van de DLSS resultaten?

https://www.techpowerup.c...mb_Raider_RTX_DLSS/3.html

[...]

Nog een leuk projectje van ze:

https://github.com/NVlabs/SPADE

https://nvlabs.github.io/SPADE/

Hetzelfde geld voor Doom (jaja) upscaling is leuk maar het blurred bepaalde delen en je verliest detail.

Technieken als FXAA/TXAA/MLAA vind ik ook minder, SMAA hangt van het spel af.

Je merkt met DLSS dat je detail in textures verliest en contrast. Daardoor niet mijn smaak en kan ik er niet een eerlijk oordeel over geven.

Voorbeeld van wat ik wel fantastisch vind zijn project als deze:

https://twitter.com/Ze_PilOt/status/1083775305423167488

https://www.youtube.com/watch?time_continue=11&v=OaEgc46FNWE

https://venturebeat.com/2019/01/18/machine-learning-is-rescuing-old-game-textures-in-zelda-and-final-fantasy/

Het is niet perfect, maar een betere plek om het in te zetten. En je kan veel specifieker tweaken denk ik. Daarnaast is er geen beter bron materiaal beschikbaar waar dat met DLSS wel het geval is (je kan namelijk de resolutie van het spel verhogen).

Dat schilderen is tof!

[ Voor 4% gewijzigd door Sp3ci3s8472 op 20-03-2019 00:57 ]

TAA is ook niet mooi maar zal ook wel game afhankelijk zijn zoals ik RE2 gebruik ik liever SMAA of FXAA

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

HW News - Intel Snags Key NVIDIA Engineer

Volgens mij wel een van de bekendste Nvidia gezichten die ze nu ineens verliezen aan Intel.

't Begon ook wel tijd te worden voor Tom. Ruim 10 jaar bij hetzelfde techbedrijf is voor niemand goed (zowel niet voor de werkgever als de werknemer).

[ Voor 4% gewijzigd door Paprika op 31-03-2019 13:48 ]

Dat valt toch wel mee? Ik werk bij een tech bedrijf en gemiddeld werken de meeste mensen hier veel langer dan 10 jaar. En dat zijn niet alleen de 'gewone' ingenieurs, maar ook degene hoger op. En bij iets als GPUs is het nou ook niet alsof er zoveel alternatieven zijn om bij te werken.

Bij ons halen ze dat, gelukkig, niet. Idem voor onze concurrenten.Sissors schreef op zondag 31 maart 2019 @ 16:00:

Dat valt toch wel mee? Ik werk bij een tech bedrijf en gemiddeld werken de meeste mensen hier veel langer dan 10 jaar.

https://www.businessinsid...f-23-years-per-employee-4

Hij heeft een achtergrond in CPUs en dat geeft mogelijkheden genoeg (AMD, Intel, Samsung, ARM, Quadcom, Apple, Google, ...). Juist voldoende afwisseling zorgt voor nieuwe inzichten.En bij iets als GPUs is het nou ook niet alsof er zoveel alternatieven zijn om bij te werken.

"In other news

[ Voor 18% gewijzigd door Paprika op 31-03-2019 20:23 ]

Paprika schreef op zondag 31 maart 2019 @ 19:34:

[...]

Bij ons halen ze dat, gelukkig, niet. Idem voor onze concurrenten.

https://www.businessinsid...f-23-years-per-employee-4

offtopic:

Of dat gelukkig of niet is zullen we hier maar niet gaan bediscussieren, dat is nogal offtopic. Echter als je als bedrijf gemiddeld je personeel na 2 jaar al weer kwijt bent, dan doe je volgens mij echt iets verkeerds

Of dat gelukkig of niet is zullen we hier maar niet gaan bediscussieren, dat is nogal offtopic. Echter als je als bedrijf gemiddeld je personeel na 2 jaar al weer kwijt bent, dan doe je volgens mij echt iets verkeerds

Doe mij er maar eentje!Paprika schreef op zondag 31 maart 2019 @ 19:34:

[...]

Bij ons halen ze dat, gelukkig, niet. Idem voor onze concurrenten.

https://www.businessinsid...f-23-years-per-employee-4

[...]

Hij heeft een achtergrond in CPUs en dat geeft mogelijkheden genoeg (AMD, Intel, Samsung, ARM, Quadcom, Apple, Google, ...). Juist voldoende afwisseling zorgt voor nieuwe inzichten.

"In other news..."

[YouTube: Introducing GeForce RTX R.O.N. – World’s First Holographic Gaming Assistant]

Toch geweldig idee die anti troll modus, want lang level DoomGuy!

Zou wel mooi zijn als Nvidia Ampere GPU's weer goedkoper maakt.

Edit

Ik had de verkeerde link gepost. Ik snap dus wel dat men hondsdol werd.

https://nl.hardware.info/...ente-gpu-ter-wereld-maken

Edit

Ik had de verkeerde link gepost. Ik snap dus wel dat men hondsdol werd.

https://nl.hardware.info/...ente-gpu-ter-wereld-maken

[ Voor 72% gewijzigd door Gekke Jantje op 05-04-2019 11:56 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Doen ze hoogstwaarschijnlijk alleen als AMD met een goede tegenhanger komt; of als mensen geen dure RTX kaarten meer kopen.Gekke Jantje schreef op donderdag 4 april 2019 @ 15:21:

Zou wel mooi zijn als Nvidia Ampere GPU's weer goedkoper maakt.

https://www-firstpost-com...-performance-6193041.html

Oh site doet gewoon aan slecht onderzoek. Het bronartikel waar ze naar linken spreekt daar helemaal niet over daarin hebben ze het juist over Navi prijzen:

https://www.ultragamerz.c...vidia-ampere-vs-amd-navi/

offtopic:

Firstpost.com slogan: First post, then check facts!

Firstpost.com slogan: First post, then check facts!

offtopic:

Edit: Wat ik toch even wil benoemen is dat mijn kritiek op het artikel en de site is, niet op jou.

Edit: Wat ik toch even wil benoemen is dat mijn kritiek op het artikel en de site is, niet op jou.

[ Voor 5% gewijzigd door Sp3ci3s8472 op 04-04-2019 23:32 ]

Enige wat ik daar op kan zeggen is dit:

Lees verdorie de bron artikelen eens mensen. Vooral als het van clickbait ad-revenue sites komt. Het domein is firstpost.com - dat zegt al genoeg. Die kun je gewoon onmogelijk serieus nemen.

Lees verdorie de bron artikelen eens mensen. Vooral als het van clickbait ad-revenue sites komt. Het domein is firstpost.com - dat zegt al genoeg. Die kun je gewoon onmogelijk serieus nemen.

Sorry voor de dubbelpost door het dubbelzien na mijn hoornvlies transplantatie.

[ Voor 77% gewijzigd door Gekke Jantje op 04-04-2019 20:26 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Wat een baggerbron. Niks persoonlijks, maar wat een onzin...

Een kijken wat ik zo snel kan vinden:

-7nm van Samsung? Die geruchten gaan al een tijdje maar daar horen we voorlopig denk ik nog niks over.

-Goedkoper door 7nm? No way, die wafers zijn al snel tweemaal zo duur.

-Ik denk dat AMD nog steeds niet weet wat de precieze MSRP voor hun Navi SKU's gaat worden. Hoe moet Nvidia dan al weten wat Ampère volgend jaar moet kosten?

-Geen RT cores zodat het goedkoper zal zijn en dan RX noemen, AMD haar branding en niet RTX? Right.

Ja ik begrijp dat het een zeer slechte copy paste is, maar zo waardeloos is deze bron dat je dit leest.

Of zou het toch deze zijn die de spreekwoordelijke laatste nagel is?

Ben ik ook nog niet begonnen over site naam, schrijfstijl, subtiele maar duidelijke bias in de tekst, clickbait, algemene aannames of wensdenken. Maar er zijn nu wel genoeg woorden verspilt hieraan.

Een kijken wat ik zo snel kan vinden:

-7nm van Samsung? Die geruchten gaan al een tijdje maar daar horen we voorlopig denk ik nog niks over.

-Goedkoper door 7nm? No way, die wafers zijn al snel tweemaal zo duur.

-Ik denk dat AMD nog steeds niet weet wat de precieze MSRP voor hun Navi SKU's gaat worden. Hoe moet Nvidia dan al weten wat Ampère volgend jaar moet kosten?

-Geen RT cores zodat het goedkoper zal zijn en dan RX noemen, AMD haar branding en niet RTX? Right.

Ja ik begrijp dat het een zeer slechte copy paste is, maar zo waardeloos is deze bron dat je dit leest.

Of zou het toch deze zijn die de spreekwoordelijke laatste nagel is?

Gaat dus om Navi, niet Ampère.According to Ultragamerz, Nvidia’s 7 nm Ampere cards, which apparently include the “RX” 3060, RX 3070 and RX 3080 will be priced at $129, $200 and $250. If this is true, we’re looking at an incredible price reduction. Sadly, even Ultragamerz notes that these prices simply seem too good to be true.

Ben ik ook nog niet begonnen over site naam, schrijfstijl, subtiele maar duidelijke bias in de tekst, clickbait, algemene aannames of wensdenken. Maar er zijn nu wel genoeg woorden verspilt hieraan.

[ Voor 9% gewijzigd door DaniëlWW2 op 04-04-2019 20:33 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Hahaha

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Overigens ondanks wat AMD fans willen denken, exact hetzelfde verhaal wat dus over Navi rondgaat is net zo inhoudsloos. Zowel AMD als Nvidia zijn geen goede doelen, en verkopen hun kaarten op een prijspeil waarbij ze verwachten het meeste winst te maken. In één jaar de prijs/performance met een factor 2 veranderen is extreem onwaarschijnlijk.

Oh? Waar dan? Jij ziet blijkbaar een ander "artikel" dan wij. Nvidia "hint" helemaal nergens naar. Sterker nog, de beetjes "informatie" die er over Ampère in de bronartikelen staan, stellen alleen dat het een 7nm GPU gebakken door Samsung wordt...volgens de geruchten.Gekke Jantje schreef op donderdag 4 april 2019 @ 20:25:

Nvidia hint er naar.

Die firstpost.com (of Tech2? huh?) site is de enige die daar op "hint" en dat doen ze door niet te lezen, maar gewoon dollar tekens te zien en "willen" dat dat Nvidia is. Dit is wat zij schrijven:

According to Ultragamerz? Even kijken wat Ultragamerz dan schrijft:According to Ultragamerz, Nvidia’s 7 nm Ampere cards, which apparently include the “RX” 3060, RX 3070 and RX 3080 will be priced at $129, $200 and $250. If this is true, we’re looking at an incredible price reduction. Sadly, even Ultragamerz notes that these prices simply seem too good to be true.

Het kan aan mij liggen, maar Ultragamerz schrijft toch echt dat RX 3060/3070/3080 Navi kaarten zijn en dat is waar die prijzen op slaan. In het stukje van Nvidia wordt verder nergens gerept over prijzen of zelfs prestaties.7nm Nvidia Ampere GPUs Coming 2020 | Ampere vs AMD Navi

If you follow the news, you have probably heard that AMD is going to release their next-gen Navi 7nm GPUs really soon but, there haven’t been a lot of rumors about Nvidia’s next-gen GPUs. The latest rumors claim that Nvidia Ampere is going to be released next year and it’ll be Nvidia’s 7nm GPU series.

Nvidia Ampere Release Date

According to the latest rumors, Nvidia is going to be using Samsung’s 7nm extreme ultraviolet lithography (EUV) process to produce 7nm next-gen Ampere GPUs and it is said that Ampere is going to be released sometime in 2020. Unfortunately, that’s all we have about Nvidia’s next-gen 7nm GPUs but, there are a few assumptions that we can make. For example, one assumption we can make is the fact that Nvidia Ampere is most likely going to feature Ray Tracing cores. Of course, Ray Tracing in the next-generation of Nvidia GPUs is probably going to be more optimized then RTX in Turning GPUs and we will probably be able to get 60 FPS at 1080p with games running with Ray Tracing set to ultra.

Next-Gen AMD Navi GPUs Latest Rumors

According to the latest rumors, AMD’s next-generation of 7nm GPUs are going to blow away the competition. The latest reports claim that AMD is going to release the lower-end Navi cards, the RX 3060 and RX 3070 in 2019 while the RX 3080 is going to be released in 2020. The RX 3060 and RX 3070 are going to cost $129 and $200 while the RX 3080 is going to cost you $250. It is rumored that the RX 3060 and RX 3070 are going to be able to perform like the RX 580 and Vega 56 while the RX 3080 is going to be able to perform like the Nvidia RTX 2070. These prices seem extremely unrealistic as RTX 2070 performance from a $250 GPU seems way too good to be true.

Als je nou voor de verandering gewoon eens toe geeft dat je zelf ook niet doorgeklikt hebt en je post dus gewoon fout was, geen probleem. Maar nu ga je meteen weer in de verdediging met meer onwaarheden.

Dat zegt dan ook niemand. Wij vallen vooral over het feit dat @Gekke Jantje een waardeloze clickbait site aanhaalt die op hun beurt een artikel plaatsen met daarbij bronnen die ze zelf niet eens kunnen lezen.Sissors schreef op donderdag 4 april 2019 @ 20:57:

Overigens ondanks wat AMD fans willen denken, exact hetzelfde verhaal wat dus over Navi rondgaat is net zo inhoudsloos. Zowel AMD als Nvidia zijn geen goede doelen, en verkopen hun kaarten op een prijspeil waarbij ze verwachten het meeste winst te maken. In één jaar de prijs/performance met een factor 2 veranderen is extreem onwaarschijnlijk.

Het voegt niet alleen helemaal niets toe aan de discussie, het is gewoon onjuiste informatie.

Het zou wel mooi zijn als Apple de prijzen van hun iPhones verlaagt naar €329. Ze hinten er naar.

Moet ik echt de quotes uit het AMD topic gaan halen van degene die exact dat zeggen? En ook op andere plaatsen ben ik dat vaak genoeg tegen gekomen, dat AMD een kaart met RTX2070 performance zou brengen voor $250.

Instaedit: https://www.google.com/se...&sourceid=chrome&ie=UTF-8

Kijk eens alle mensen die denken/claimen dat dat gaat gebeuren

Ik zie liever dat AMD zijn kaarten prijst zodat ze met die van Nvidia concureren. Het lijkt mij best naief om te denken dat je RTX 2070 performance gaat krijgen voor die prijs, net zo naief om te denken dat de AMD fans dat denken (AMD heeft immers de Vega kaarten ook niet voor een dubbeltje op de markt gezet). Zoals Werelds al zegt, daar gaat het niet om; en ook al zouden sommige mensen geloven dat AMD die kaarten voor die prijs gaan leveren dan is dat hun mening en lijkt het me nogal raar om de rest van de AMD fans meteen onder die groep te scharen.Sissors schreef op donderdag 4 april 2019 @ 20:57:

Overigens ondanks wat AMD fans willen denken, exact hetzelfde verhaal wat dus over Navi rondgaat is net zo inhoudsloos. Zowel AMD als Nvidia zijn geen goede doelen, en verkopen hun kaarten op een prijspeil waarbij ze verwachten het meeste winst te maken. In één jaar de prijs/performance met een factor 2 veranderen is extreem onwaarschijnlijk.

Met wat geluk krijgen we 2070 performance voor 400-450 euro wat vergelijkbaar is met een Vega64. Hoger heeft geen zin want je bied niks nieuws tegenover de Vega kaarten en lager lijkt mij niet slim als Nvidia toch zo hoog zit met zijn prijzen.

Hehe dit dus, precies wat ik gister op de FP ook maar niet uitgelegd kreeg, AMD is ook niet gek, en zou zichzelf zelfs compleet de das omdoen, want een all out pricewar met nvidia kúnnen ze niet eens winnen.Sp3ci3s8472 schreef op donderdag 4 april 2019 @ 23:26:

[...]

Ik zie liever dat AMD zijn kaarten prijst zodat ze met die van Nvidia concureren. Het lijkt mij best naief om te denken dat je RTX 2070 performance gaat krijgen voor die prijs, net zo naief om te denken dat de AMD fans dat denken (AMD heeft immers de Vega kaarten ook niet voor een dubbeltje op de markt gezet). Zoals Werelds al zegt, daar gaat het niet om; en ook al zouden sommige mensen geloven dat AMD die kaarten voor die prijs gaan leveren dan is dat hun mening en lijkt het me nogal raar om de rest van de AMD fans meteen onder die groep te scharen.

Met wat geluk krijgen we 2070 performance voor 400-450 euro wat vergelijkbaar is met een Vega64. Hoger heeft geen zin want je bied niks nieuws tegenover de Vega kaarten en lager lijkt mij niet slim als Nvidia toch zo hoog zit met zijn prijzen.

Dus mochten ze met iets concurerends komen, dan zal die prijs (zoals AMD gewoon) op -5 á -10% liggen van de Nvidia kaart waar ze mee willen concureren, niet op -50%....

(het niks nieuws gedeelte geen mening over btw, als ze stiller zijn met lagere TDPs hebben ze toch iets voor op Vega, maar qua performance of USP's heb je ws gelijk ja).

[ Voor 6% gewijzigd door zion op 05-04-2019 08:53 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Kan in beide draadjes gepost worden, maar deze stond hoger in de lijst.

[ Voor 14% gewijzigd door Paprika op 05-04-2019 17:44 ]

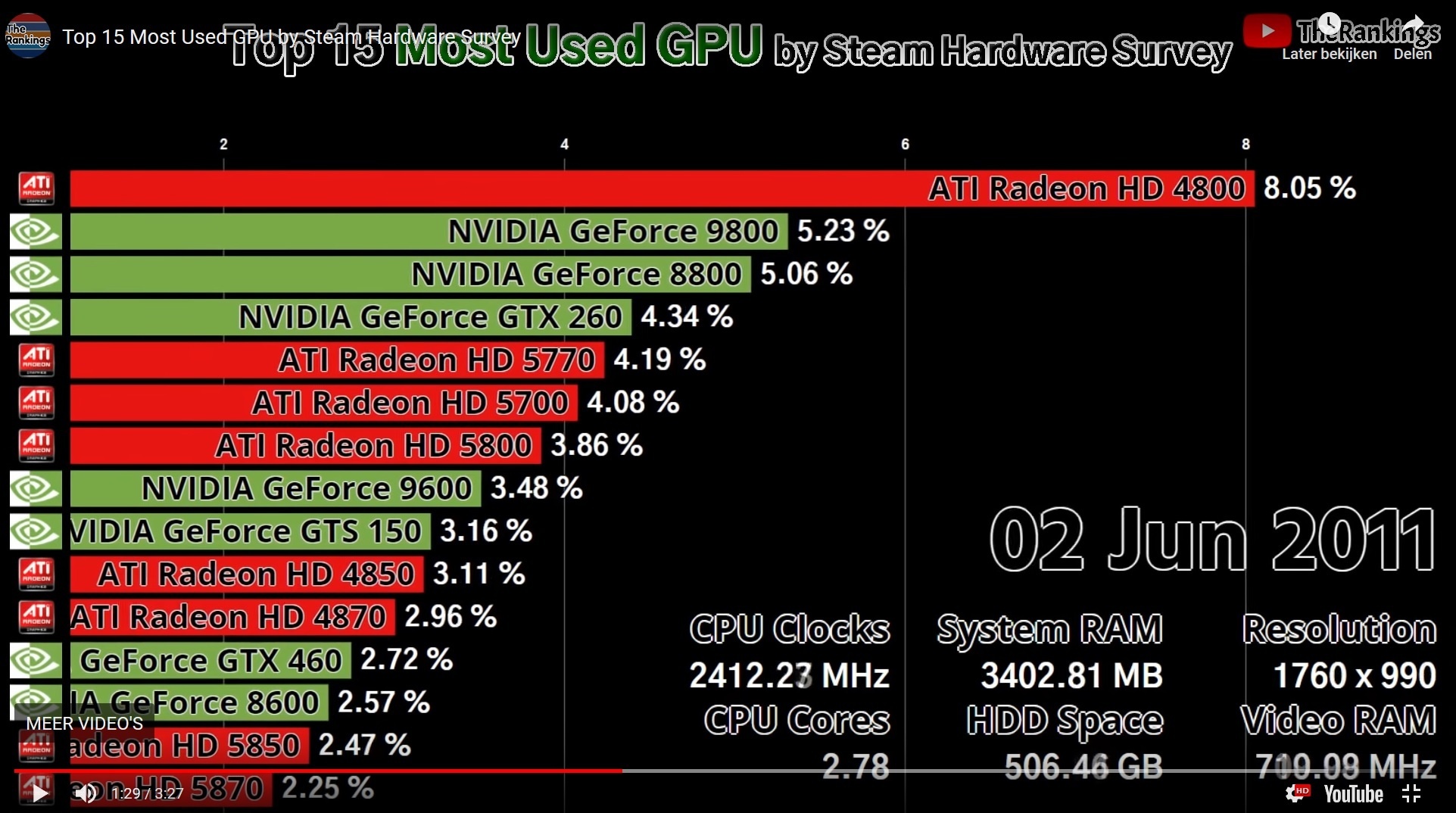

Toch een beetje schrikbarend als je kijkt naar het gebrek aan Polaris kaarten aan het einde. Dat was een goede kaart; de schuld kan niet alleen bij de miners hebben gelegen lijkt mij?Paprika schreef op vrijdag 5 april 2019 @ 17:41:

[YouTube: Top 15 Most Used GPU by Steam Hardware Survey]

Kan in beide draadjes gepost worden, maar deze stond hoger in de lijst.Zo zie je toch dat AMD prima GPUs kan verkopen als ze maar een goed product hebben...

[Afbeelding]

Dit geeft vooral aan hoe onbetrouwbaar de Steam Hardware Survey nu eigenlijk is.Paprika schreef op vrijdag 5 april 2019 @ 17:41:

[YouTube: Top 15 Most Used GPU by Steam Hardware Survey]

Kan in beide draadjes gepost worden, maar deze stond hoger in de lijst.Zo zie je toch dat AMD prima GPUs kan verkopen als ze maar een goed product hebben...

[Afbeelding]

Bijvoorbeeld komt de HD7900 eindelijk eens in de top tien terecht, in juli 2015.

Een andere is dat er pas in 2011 de HD4850 en HD 4870 los verschijnen terwijl HD4800 series er al twee jaar was. Of deze moment opname:

Hoe kan de HD5770 meer zijn dan de hele HD5700 series? Hoe kan HD5800 series minder zijn dan HD5850 + HD5870? Of hoe kan HD4850 + HD 4870 nog steeds niet in de buurt zijn van HD4800 series? Ja ik weet dat de HD4830, HD4860 en de HD4890 ook bestonden, maar zelfs dan nog. Het totaal voor de HD4800 series liep toen al licht af volgens Steam en toen verschenen de HD4850 en HD4870 opeens pas in de top tien.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Dat is een driver dingetje.DaniëlWW2 schreef op vrijdag 5 april 2019 @ 18:14:

[...]

Dit geeft vooral aan hoe onbetrouwbaar de Steam Hardware Survey nu eigenlijk is.

Bijvoorbeeld komt de HD7900 eindelijk eens in de top tien terecht, in juli 2015.

Een andere is dat er pas in 2011 de HD4850 en HD 4870 los verschijnen terwijl HD4800 series er al twee jaar was. Of deze moment opname:

[Afbeelding]

Hoe kan de HD5770 meer zijn dan de hele HD5700 series? Hoe kan HD5800 series minder zijn dan HD5850 + HD5870? Of hoe kan HD4850 + HD 4870 nog steeds niet in de buurt zijn van HD4800 series? Ja ik weet dat de HD4830, HD4860 en de HD4890 ook bestonden, maar zelfs dan nog. Het totaal voor de HD4800 series liep toen al licht af volgens Steam en toen verschenen de HD4850 en HD4870 opeens pas in de top tien.

Op een moment voor drie verschillende chips, systematisch percentages die niet overeen kunnen komen is een driver dingetje? Kom op.

Het kan niet dat je voor HD4800 een te laag percentage hebt en op hetzelfde meetpunt en voor HD5700 en HD5800 te hoog als je het afzet tegenover specifieke SKU's. Het kan ook niet dat Steam 3,5 jaar na release eindelijk eens herkend dat er mensen waren die een HD7900 kochten. Hebben we het nog niet eens gehad over HD7800. Die waren ook vrij populair en zijn helemaal afwezig in de top tien.

Ga ik nu even naar die pagina dan blijkt dat het percentage DX8 of eerder GPU's is toegenomen met 0,52%. Sinds wanneer neemt het aantal GPU's uit 2001 of daarvoor nog toe? Het gaat hier ook nog eens om Steam. Veel games die niet minstens DX9 vragen zullen er echt niet zijn. DX12 GPU's namen weer eens af want ook helemaal nergens op slaat.

https://store.steampowered.com/hwsurvey/videocard/

Dit soort getallen kunnen alleen maar voortkomen uit elke maand steekproeven nemen waar Valve van hoopt dat ze representatief zijn. Nou dat zijn ze mooi niet want elke keer is het weer raak als de Steam Hardware Survey naar voren komt. Dit is gewoon geen betrouwbare bron en iedereen die even kritisch naar de percentages kijkt zal zich dit moeten beseffen...

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

@DaniëlWW2, ik denk dat je de series als andere exemplaren moet zien en niet als een summary van alle kaarten uit een reeks. Je zag dit ook frequent in monitoring tools terwijl ze nu series niet eens meer rapporteren. Of het accuraat is allemaal dat betwijfel ik ook, maar er is ondanks dat toch echt een duidelijk patroon zichtbaar.

Het patroon onderken ik ook wel, maar de percentages neem ik absoluut niet serieus.Paprika schreef op vrijdag 5 april 2019 @ 19:57:

@DaniëlWW2, ik denk dat je de series als andere exemplaren moet zien en niet als een summary van alle kaarten uit een reeks. Je zag dit ook frequent in monitoring tools terwijl ze nu series niet eens meer rapporteren. Of het accuraat is allemaal dat betwijfel ik ook, maar er is ondanks dat toch echt een duidelijk patroon zichtbaar.

Je kan het ook niet verklaren door HD4800, HD5700 en HD5800 te nemen als verzameling van de andere SKU's. Dan noem je bijvoorbeeld de HD5800 gewoon de HD5830. Zelfs dan geloof ik er nog niks van. Ik denk bijvoorbeeld niet dat mensen echt die kreupele miskleun van een HD5830 kochten i.p.v de veel betere HD5850 die niet veel duurder was. Daarnaast zou de HD5830 ook nog eens beperktere oplage zijn geweest om baggerchips te redden...

Ik kijk veel liever naar de getallen van Jon Peddie Research. Op het moment ook weer Maxwell flashbacks...

Zou leuk zijn als AMD Navi 10 uitbracht, het echt RTX2070 level performance was en echt $250 (circa €270 met BTW) was. €350-€400 kan AMD ook nog heel goed mee wegkomen voor zo'n kaart. Moet die er wel zijn en eens niet op 1,2v gebinned worden waarna het een verkapte vlammenwerper is voor een paar procent extra prestaties. How to make a decent product worse noemen we dat.

[ Voor 4% gewijzigd door DaniëlWW2 op 06-04-2019 13:12 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Op miners systemen staat ook geen steam geïnstalleerd. Steam is gewoon betrouwbaar en dat kun je ook wel uit marktaandelen elders weghalen.

[ Voor 43% gewijzigd door Gekke Jantje op 06-04-2019 10:34 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Dat is niet waar. Gamecafes worden vaak meer dan 1x geteld bijvoorbeeld. Ik zou graag zien dat ze stats uitbrachten voor alleen Europa en Noord Amerika.Gekke Jantje schreef op zaterdag 6 april 2019 @ 10:30:

Op miners systemen staat ook geen steam geïnstalleerd. Steam is gewoon betrouwbaar en dat kun je ook wel uit marktaandelen elders weghalen.

Ieder systeem word vaker geteld als je mee doet. 1 of 2 keer per jaar. Bij een ga.e Cafe is dat ook niet anders.418O2 schreef op zaterdag 6 april 2019 @ 10:35:

[...]

Dat is niet waar. Gamecafes worden vaak meer dan 1x geteld bijvoorbeeld. Ik zou graag zien dat ze stats uitbrachten voor alleen Europa en Noord Amerika.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

De enige manier hoe dit ooit betrouwbaar gaat zijn is als Steam elke keer als je het programma opstart, automatisch controleert welke hardware je hebt, dit koppelt aan je account, elke login op een andere PC ook registreert en accounts die op veel verschillende PC's inloggen automatisch uitsluit. Nee dank je Valve.418O2 schreef op zaterdag 6 april 2019 @ 10:35:

[...]

Dat is niet waar. Gamecafes worden vaak meer dan 1x geteld bijvoorbeeld. Ik zou graag zien dat ze stats uitbrachten voor alleen Europa en Noord Amerika.

Vervolgens zouden alle videokaarten ook nog eens een serienummer moeten hebben dat uitleesbaar is op de PC en Steam moet dat uit kunnen lezen. Dat is er dus niet en gaat ook niet gebeuren. Steam kan dus nooit verifiëren of een videokaart opduikt bij meerdere accounts. Krijgt ook lang niet iedereen die hardware survey. Ik krijg die altijd in juli, maar anderen krijgen het niet eens. Het is dus steekproefsgewijs en het lijken veel te weinig steekproeven te zijn voor een accurate reflectie.

Het is dus een zeer onbetrouwbare bron, zelfs los van game cafe's. Dataverzameling klopt niet en als je dan ook nog eens overduidelijk zeer vreemde percentages ziet dan ben je wel klaar.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Dat gast niet automatisch.DaniëlWW2 schreef op zaterdag 6 april 2019 @ 10:50:

[...]

De enige manier hoe dit ooit betrouwbaar gaat zijn is als Steam elke keer als je het programma opstart, automatisch controleert welke hardware je hebt, dit koppelt aan je account, elke login op een andere PC ook registreert en accounts die op veel verschillende PC's inloggen automatisch uitsluit. Nee dank je Valve.

Vervolgens zouden alle videokaarten ook nog eens een serienummer moeten hebben dat uitleesbaar is op de PC en Steam moet dat uit kunnen lezen. Dat is er dus niet en gaat ook niet gebeuren. Steam kan dus nooit verifiëren of een videokaart opduikt bij meerdere accounts. Vervolgens krijgt ook lang niet iedereen die hardware survey. Ik krijg die altijd in juli, maar anderen krijgen het niet eens. Het is dus steekproefsgewijs en het lijken veel te weinig steekproeven te zijn voor een accurate reflectie.

Het is dus een zeer onbetrouwbare bron, zelfs los van game cafe's. Dataverzameling klopt niet en als je dan ook nog eens overduidelijk zeer vreemde percentages ziet dan ben je wel klaar.

Je krijgt de optie om om je systeem te laten scannen, en of je er wel of niet aan mee wil doen. Het is gewoon betrouwbaar en geen systeem word overgeslagen.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Nee hoor, zou alleen maar betrouwbaar zijn als elk serienummer (GPU) uniek diende te zijn bij elke steam-inlog, en alleen dan in de statistieken verwerken, maar dan loop je ten eerste keihard tegen AVG/GDPR aan, en ten tweede log ik op 4 verschillende systemen in op steam (laptop Main, laptop Sec, PC main, PC sec) en dan die 4 wel/niet via VPN, dus dat zijn dan nog 4* min. 5 voorkeurslocaties, dan heb ik per computer nog minimaal 2 user accounts waarmee ik inlog die hij beide als andere computer beschouwd dus sta ik al zeker 48 keer geregistreerd als zijnde "Unique Login".Gekke Jantje schreef op zaterdag 6 april 2019 @ 10:30:

Op miners systemen staat ook geen steam geïnstalleerd. Steam is gewoon betrouwbaar en dat kun je ook wel uit marktaandelen elders weghalen.

dan is N=1 dus opeens al N=48, dan heb ik het nog niet eens over semi-openbare computers.

Nee, dit is feit tegen struisvogel discussie, is Nvidia (nog) dominant? Ja. Reflecteert Steam dit correct? Nee.Gekke Jantje schreef op zaterdag 6 april 2019 @ 10:57:

Ach ook goed. Dit is toch een eigen mening discussie.

[ Voor 13% gewijzigd door zion op 06-04-2019 10:59 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Ach ook goed. Dit is toch een eigen mening discussie. Ik log mij ook regelmatig in op andere systemen maar de jaarlijkse scan heb ik dan nog nooit opgemerkt.

Edit

Kom maar met feiten dan en die heb je waarschijnlijk niet. Overigens kunnen het net zo goed AMD systemen zijn in de game cafe's

Het mag dan niet perfect zijn.

https://www.extremetech.c...the-steam-hardware-survey

Edit

Kom maar met feiten dan en die heb je waarschijnlijk niet. Overigens kunnen het net zo goed AMD systemen zijn in de game cafe's

Het mag dan niet perfect zijn.

https://www.extremetech.c...the-steam-hardware-survey

[ Voor 97% gewijzigd door Gekke Jantje op 06-04-2019 11:20 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Die doen vaak bij elke reboot een clean install via een image. Die stats Zijn gewoon niet representatiefGekke Jantje schreef op zaterdag 6 april 2019 @ 10:40:

[...]

Ieder systeem word vaker geteld als je mee doet. 1 of 2 keer per jaar. Bij een ga.e Cafe is dat ook niet anders.

Prima maar een mening is geen feit. Daarnaast word een systeem niet na iedere clean install direct door steam gevraagt om een enquête.

[ Voor 60% gewijzigd door Gekke Jantje op 06-04-2019 11:26 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Je begint dus helemaal niet op N=1, maar N=4, er is niks mis mee als elk van jouw systemen apart wordt geteld als je wil weten hoeveel GPUs worden gebruiktzion schreef op zaterdag 6 april 2019 @ 10:54:

[...]

Nee hoor, zou alleen maar betrouwbaar zijn als elk serienummer (GPU) uniek diende te zijn bij elke steam-inlog, en alleen dan in de statistieken verwerken, maar dan loop je ten eerste keihard tegen AVG/GDPR aan, en ten tweede log ik op 4 verschillende systemen in op steam (laptop Main, laptop Sec, PC main, PC sec) en dan die 4 wel/niet via VPN, dus dat zijn dan nog 4* min. 5 voorkeurslocaties, dan heb ik per computer nog minimaal 2 user accounts waarmee ik inlog die hij beide als andere computer beschouwd dus sta ik al zeker 48 keer geregistreerd als zijnde "Unique Login".

dan is N=1 dus opeens al N=48, dan heb ik het nog niet eens over semi-openbare computers.

En daarnaast, ik heb geen idee hoe betrouwbaar die Steam statistieken zijn, maar de argumenten die hier erbij worden gehaald gaan gewoon nergens over. Leuk dat jij de hele handel met VPN doet met verschillende locaties, maar veruit het merendeel van de gebruikers gaat geen VPN op zijn game systeem zetten. Net als dat game cafés ook heel leuk zijn, maar dat is allemaal ruis in de marge (en ja, ik weet dat ze in Azië populairder zijn als hier, maar nog steeds is het verwaarloosbaar). Om het er nog niet over te hebben dat het alleen een probleem is als game cafés om één of andere reden bijvoorbeeld een sterke voorkeur voor AMD hebben.

Nou, nee, ik game er op maximaal 2, en sowieso, het hele punt was dat Steam niet accuraat was, dus is het wel degelijk relevant. volgens je eigen argument is heel steam ruis, en dat is precies wat ik probeerde over te laten komen, het is op zijn best een indicatie. Maar goed, deze discussie is al zo vaak gevoerd, en al zo vaak wordt het welles nietes, dus wat mij betreft maakt eenieder zijn eigen conclusie maar gebruik het dan gewoon niet als leidraad, daar is het te controversieel voor.Sissors schreef op zaterdag 6 april 2019 @ 11:46:

[...]

Je begint dus helemaal niet op N=1, maar N=4, er is niks mis mee als elk van jouw systemen apart wordt geteld als je wil weten hoeveel GPUs worden gebruikt

En daarnaast, ik heb geen idee hoe betrouwbaar die Steam statistieken zijn, maar de argumenten die hier erbij worden gehaald gaan gewoon nergens over. Leuk dat jij de hele handel met VPN doet met verschillende locaties, maar veruit het merendeel van de gebruikers gaat geen VPN op zijn game systeem zetten. Net als dat game cafés ook heel leuk zijn, maar dat is allemaal ruis in de marge (en ja, ik weet dat ze in Azië populairder zijn als hier, maar nog steeds is het verwaarloosbaar). Om het er nog niet over te hebben dat het alleen een probleem is als game cafés om één of andere reden bijvoorbeeld een sterke voorkeur voor AMD hebben.

(overigens sluit ik meestal mijn VPN af hoor zoals elk normaal mens als ik alléén aan het gamen ben, dus heb je zeker gelijk dat gamen over VPN geen standaard practice is, maar als je 5 systemen simultaan operationeel hebt, en één zit niet op VPN dan ben je beveiligingstechnisch net zo onbeschermd als dat je géén VPN draait, dus zit mijn gamePC ook wel eens achter VPN tijdens gamen, en dat is helemaal geen punt met de meeste spellen die ik doe)

[ Voor 13% gewijzigd door zion op 06-04-2019 12:41 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Je hebt Steam draaien op 4 PCs ook al game je maar op 2? Het zal vast, maar ook dat is ruis in de marge. De meeste mensen doen dat niet. Ook hoe zou volgens mijn argumentatie heel Steam ruis zijn? Het enige wat ik heb geschreven is dat het aantal mensen die continue met VPN zijn locatie wijzigt (overigens geen idee of je dan volgens Steam een nieuwe installatie hebt, lijkt me eigenlijk vreemd, maar goed) en het aantal game cafés niet groot genoeg zijn om de Steam statistieken onnauwkeurig te maken.

(Overigens beveiligingstechnisch doet een VPN heel weinig tenzij je op een onbeveiligd Wifi netwerk zit of een paar andere uitzonderingssituaties).

(Overigens beveiligingstechnisch doet een VPN heel weinig tenzij je op een onbeveiligd Wifi netwerk zit of een paar andere uitzonderingssituaties).

En wie hier heeft de DXR drivers al uitgeprobeerd?

Ik lees op Reddit dat je op een 1080 TI nog best lekker kan ray-tracen. BFV 1440p @ high RTX medium -> 60fps stable.

Ik ga het morgen checken

Ik lees op Reddit dat je op een 1080 TI nog best lekker kan ray-tracen. BFV 1440p @ high RTX medium -> 60fps stable.

Ik ga het morgen checken

[ Voor 3% gewijzigd door XanderDrake op 16-04-2019 18:47 ]

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

Hier even getest met de GTX 1080 Ti maar het draait 90 tot 100% slomer dan een RTX 2080. Ik kreeg 25-35 fps in Battlefield 5 Rotterdam map met ultra instellingen op 2560x1440.XanderDrake schreef op dinsdag 16 april 2019 @ 18:45:

En wie hier heeft de DXR drivers al uitgeprobeerd?

Ik lees op Reddit dat je op een 1080 TI nog best lekker kan ray-tracen. BFV 1440p @ high RTX medium -> 60fps stable.

Ik ga het morgen checken

Voor ray tracing zie ik liever dat een fabrikant komt met een aparte ray tracing kaart want het word wat te veel qua extra benodigde hardeware op een enkele videokaart.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Dat wordt sowieso geen succes, een speciale kaart die maar voor enkele games gebruikt zal worden. Net zoals een dedicated physics kaart ook nooit iets is geworden. Het wordt pas een succes als er geen speciale hardware voor nodig is.

Verleden bied geen garantie voor de toekomst. Het zal wel met ray tracing veel betere performance kunnen leveren.Verwijderd schreef op woensdag 17 april 2019 @ 12:06:

Dat wordt sowieso geen succes, een speciale kaart die maar voor enkele games gebruikt zal worden. Net zoals een dedicated physics kaart ook nooit iets is geworden. Het wordt pas een succes als er geen speciale hardware voor nodig is.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Jij denkt werkelijk dat een speciale kaart voor ray tracing die honderden euro's kost een succes wordt? Terwijl er zeer weinig games zijn en het voordeel beperkt is. Delicated physics kaart was al geen succes en de kracht die daarvoor nodig is, is een stuk kleiner, de meerprijs wordt hier dus ook nog vele malen groter. Waarom zou dan zoiets werken? Zoals gezegd het wordt pas een succes als het volledig geïntegreerd is in de hardware, zodat er geen meerkosten zijn en je geen hardware hebt die niks aan het doen is bij games die het niet ondersteunen.

[ Voor 22% gewijzigd door Verwijderd op 17-04-2019 12:42 ]

Ik zeg niet dat een aparte RT kaart gaat komen, echter zie ik wel liever een aparte RT kaart want het moet mogelijk zijn met veel betere performance dan waneer je alles in een enkele gpu stopt. Om nog 5 jaar te moeten wachten op 100 fps 1440p ultra met ray tracing duurt me wat te lang. Het zal waarschijnlijk geen succes worden ook al zijn de prestaties 100% beter.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Let op:

Dit topic is bedoeld om de nieuwste ontwikkelingen op het gebied van nVidia GPU's te bespreken. Dit topic is dus uitdrukkelijk niet bedoeld voor persoonlijk aankoopadvies of troubleshooting!

Voor discussies over de nieuwste serie, klik aub door naar [NVIDIA GeForce RTX 40XX] Levertijden & Prijzen zodat dit topic over nieuws blijft gaan.

Zware videokaarten trekken een zware last op de voeding van een PC. Dit is niet de plek voor discussies over voedingen, dat kan in Voeding advies en informatie topic - Deel 34 - en lees daar sowieso de topicstart voordat je post, grote kans dat je vraag al behandeld is.

Dit topic is bedoeld om de nieuwste ontwikkelingen op het gebied van nVidia GPU's te bespreken. Dit topic is dus uitdrukkelijk niet bedoeld voor persoonlijk aankoopadvies of troubleshooting!

Voor discussies over de nieuwste serie, klik aub door naar [NVIDIA GeForce RTX 40XX] Levertijden & Prijzen zodat dit topic over nieuws blijft gaan.

Zware videokaarten trekken een zware last op de voeding van een PC. Dit is niet de plek voor discussies over voedingen, dat kan in Voeding advies en informatie topic - Deel 34 - en lees daar sowieso de topicstart voordat je post, grote kans dat je vraag al behandeld is.

:strip_icc():strip_exif()/u/469413/crop6449781d98758_cropped.jpg?f=community)

:strip_exif()/u/211274/bestabstractwallpapers5.gif?f=community)

:strip_icc():strip_exif()/u/990411/crop5bc04095902b6_cropped.jpeg?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

:strip_icc():strip_exif()/u/892237/crop630a6bab7d2b7_cropped.jpg?f=community)

/u/27299/hoofd.png?f=community)

:strip_icc():strip_exif()/u/77667/crop56b7832c3f349_cropped.jpeg?f=community)

/u/97317/kz.png?f=community)

:strip_icc():strip_exif()/u/304653/crop68b4ad60494fd_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/572357/tennessee_flag.jpg?f=community)

/u/400/defember100.png?f=community)

/u/324913/crop56a24cce05cd3_cropped.png?f=community)

:strip_exif()/u/233284/crop573f69b75d616.gif?f=community)

/u/32637/crop677ea9d840dae_cropped.png?f=community)

:strip_icc():strip_exif()/u/408498/crop5e9315d49f8d7.jpeg?f=community)

:strip_icc():strip_exif()/u/145751/check-in-minion-small2.jpg?f=community)

:strip_icc():strip_exif()/u/531/crop5bc26deb6d424_cropped.jpeg?f=community)