Helemaal helder verhaal.zeroday schreef op zaterdag 4 april 2020 @ 22:02:

@Q zoals je in het andere forumdeel ziet op de nerd foto heb ik ook nog wel de beschikking over wat andere kant en klare NAS systeempjes. de QNAP die ik thuis heb staan vind ik een drama ding. Ik kan het maar geen fijn OS vinden. Teveel aan elkaar geplakt met allerlei UI's en daarbij zoveel extra's dat ik me teveel moet aanpassen.Daarnaast heb ik veel te maken gehad met wat 2 en 4 Bay NASjes waarbij er met 1 NAS een keer de RAID5 corrupted raakte waardoor alle data verdween .. (dus niet eens een HDD die failde maar gewoon de gehele raid5 wat dan op basis van de door de fabrikant gebouwde firmware niet eens fatsoenlijk meer te repareren was.. ) .. Daarom wil ik zelf wat meer in control zijn

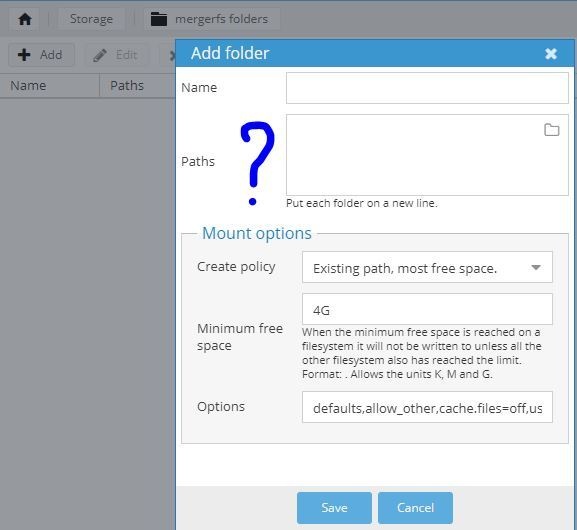

Ik heb liever een linux distri met daarop bijv. een NAS OS zoals Unraid/OMV of bijv. Freenas waarbij ik op dit moment nog geen ervaring heb met Unraid en Freenas. Betalen voor unraid zou inderdaad gezien het prijskaartje best kunnen.

Grootste gemis aan mijn kant is de kennis/mogelijkheid om 'extra' HDD's aan de gen8 te kunnen hangen zodat je bijv. dus meer disken kan toevoegen zodat je met ZFS of wat dan ook kan werken. (dus wat heb je nodig om extern bijv. UNRAID meer disken te kunnen aanbieden, want ik heb best wel veel oude HDD's liggen die het naar mijn idee gerust nog wat jaar blijven doen.

Aangezien ik wel meer dan 3 HDD's ter beschikking heb, kan ik wat gaan testen en ook zien in hoeverre de RAID5 uitgebreid kan worden als ik elke keer een HDD vervang en dan de raid expand

Ik ben dan ook aan het testen en zit niet vast aan een OS. Mij is het nu om het even. Ik wil er ook maar 2 dingen mee: opslag via SMB en NFS en meer hoeft het apparaat niet te doen. (ja SNMP is leuk)

Omdat je behoeften zo relatief eenvoudig zijn - en zover ik inschat prima met Linux overweg kunt - vraag ik me af of je heel veel gaat winnen met een NAS OS.

Gewoon zelf een Linux distro op je Gen8 gooien:

- met MDADM (of ZFS) een RAID array aanmaken

- dan met SAMBA en NFS wat shares aanbieden

- Nog even apt install ssmtp om mailtjes te sturen en klaar.

Past ook goed bij je behoefte om zelf een beetje in controle te blijven

Extra schijven koppelen aan je Gen8, dat wordt erg lastig. Ik zie alleen maar smerige of halfbakken opties. Als je naar meer dan 4 schijfjes wilt groeien moet je denk ik echt aan de DIY zelfbouw NAS gaan.

/u/1176/crop635f8931b2b68_cropped.png?f=community)

:strip_icc():strip_exif()/u/220842/crop584a90da6a595_cropped.jpeg?f=community)

/u/116997/mozilla2.png?f=community)

/f/image/XyclccEFbDmyyp8tmE8Dp2Zi.png?f=fotoalbum_large)

/f/image/IkCDgiOyO9qyEq9KV3Hix3x1.png?f=fotoalbum_large)

/u/292867/crop5630e1f334453_cropped.png?f=community)

/u/200133/artemis_square_e_60-60.png?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_exif()/u/54579/Static.gif?f=community)

:strip_exif()/u/396800/D-_3427da0a9c293b63f2a66dea2e642102.gif?f=community)

:strip_exif()/u/31994/Orlygot.gif?f=community)

:strip_icc():strip_exif()/u/307988/crop5d386ba3e3a93_cropped.jpeg?f=community)

/u/286685/crop58fcf863c48a5.png?f=community)

/u/428050/crop5be93b7c1c370_cropped.png?f=community)

/u/380617/crop5ea17f1cefb4c_cropped.png?f=community)

:strip_exif()/u/164293/logo.gif?f=community)

:strip_icc():strip_exif()/u/200296/crop6893856e4e7de_cropped.jpg?f=community)

:strip_exif()/u/49248/DPCkoeienUD.gif?f=community)

:no_upscale():strip_icc():fill(white):strip_exif()/f/image/FU1Sp2Tpd0k80TOUELEu0zlP.jpg?f=user_large)