Even niets...

Thnx voor t meedenken

Hoeveel SATA aansluitingen heeft je huidige moederbord? De meeste moderne moederborden hebben er volgens mij 6 dus ik zou altijd voor een case gaan waar je minimaal 6 schijven in kwijt kunt.gastje01 schreef op woensdag 13 april 2016 @ 10:48:

De Fractal Design Node 304 lijkt uit dit lijstje de beste keuze, maar wellicht ben ik een belangrijke concurrent vergeten. Iemand suggesties?

Mijn stuff -> http://gathering.tweakers.net/forum/view_message/43289117

Op dit moment 4/4 in gebruik. Maar dit is een oud (lees: gratis gekregen) moederbord wat ik heb gebruikt om eens te experimenteren met t zelfbouw NAS idee, vooral of ik t aandurfde om mijn bestaande Synology te vervangen. Hoe oud het ook is, het is al stukken sneller dan wat ik had.janser01 schreef op woensdag 13 april 2016 @ 13:18:

[...]

Hoeveel SATA aansluitingen heeft je huidige moederbord? De meeste moderne moederborden hebben er volgens mij 6 dus ik zou altijd voor een case gaan waar je minimaal 6 schijven in kwijt kunt.

Ik heb op dit moment 4 Schijven in gebruik (4+4+2+1,5TB) en de bedoeling is dat dit 4 x 4TB gaat worden, ik verwacht niet dat ik meer opslag nodig ga hebben dan dat

Ik dacht dat ook met mijn DS411j met 4x4Tb. Krijg ik nooooooooit vol. Nu onlangs een Xpenology in elkaar gezet, 4x5TB+4x4TB. Kunnen we weer even vooruitgastje01 schreef op woensdag 13 april 2016 @ 14:42:

[...]

ik verwacht niet dat ik meer opslag nodig ga hebben dan datmaar het kan inderdaad nooit kwaad om wat achter de hand te hebben.

[ Voor 15% gewijzigd door janser01 op 13-04-2016 14:52 ]

Mijn stuff -> http://gathering.tweakers.net/forum/view_message/43289117

Even korte situatieschets: Lian Li PC-A71F case Asrock B75-Pro-3M (i3), 8GB RAM en 10 2TB schijven in RAID 6 en nog 1 2TB Operating System disk. De volgende schijven maken deel uit van de RAID array:

9 x WDC WD20EARS-00J2GB0

1 x WDC WD20EZRX-00D8PB0

De afwijkende WD20EZRX werd geplaatst ter vervangen van een falende WD20EARS vorig jaar.

Een M1115 (IT mode) stuurt 8 schijven aan en de 2 overige via het moederbord.

Operating system info: Slackware 14.1 met eigen gecompilede 3.18.20-smp kernel.

root@darkstar4:~# cat /proc/mdstat

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4] [multipath]

md0 : active raid6 sdd1[10](F) sdj1[2] sdk1[5] sda1[1] sde1[3] sdh1[6] sdf1[11](F) sdg1[7] sdb1[9] sdc1[8]

15628115456 blocks level 6, 64k chunk, algorithm 2 [10/8] [_UUU_UUUUU]

unused devices: <none>

root@darkstar4:~# mdadm --detail /dev/md0

/dev/md0:

Version : 0.90

Creation Time : Sat Oct 9 07:53:36 2010

Raid Level : raid6

Array Size : 15628115456 (14904.13 GiB 16003.19 GB)

Used Dev Size : 1953514432 (1863.02 GiB 2000.40 GB)

Raid Devices : 10

Total Devices : 10

Preferred Minor : 0

Persistence : Superblock is persistent

Update Time : Thu Apr 14 09:17:17 2016

State : clean, degraded

Active Devices : 8

Working Devices : 8

Failed Devices : 2

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 64K

UUID : f512d680:c6458956:fbe53745:38f0c41a

Events : 0.32549

Number Major Minor RaidDevice State

0 0 0 0 removed

1 8 1 1 active sync /dev/sda1

2 8 145 2 active sync /dev/sdj1

3 8 65 3 active sync /dev/sde1

4 0 0 4 removed

5 8 161 5 active sync /dev/sdk1

6 8 113 6 active sync /dev/sdh1

7 8 97 7 active sync /dev/sdg1

8 8 33 8 active sync /dev/sdc1

9 8 17 9 active sync /dev/sdb1

10 8 49 - faulty /dev/sdd1

11 8 81 - faulty /dev/sdf1

root@darkstar4:~#De disk layout is als volgt: drie disks achteraan boven, en de resterende 7 disks vooraan. Er draaien drie case fans (twee 140mm intake vooraan en 1 120mm outtake aan CPU). (Bedankt Q voor de scripts!)

root@darkstar4:~# /root/tools/show-hdd-temp.sh ____________________________________ | /dev/sde: 33 | | /dev/sdk: 34 | | /dev/sdj: 33 /dev/sdi: 31 | |___________________________________| | | | /dev/sdf: 34 | | /dev/sdg: 36 | | /dev/sdh: 36 | | /dev/sdb: 36 | | /dev/sdc: 35 | | /dev/sda: 33 | | /dev/sdd: 35 | |___________________________________| root@darkstar4:~#

Na het verhuizen van mijn fileserver naar mijn nieuwe bergruimte begonnen mijn 2 casefans vooraan zeer veel lawaai te maken. Ik had ze tijdelijk afgekoppeld. Blijkt dat dit geen goed idee was. Sommige schijven liepen op tot 45°C - 50°C. De fans draaien terug en koelen voldoende, maar met veel lawaai. Deze worden dit weekend vervangen door een combinatie van Noctua

Volgens SMART lijkt alles redelijk in orde, echter is er duidelijk miserie te vinden in de logs voor schijven /dev/sdd en /dev/sdf:

root@darkstar4:~# /root/tools/showsmart.py ----------------------------------------------------------- | DEVICE | TEMP | POWERON | REALLOC. | PENDING | CRC ERR. | ----------------------------------------------------------- | sda | 33 | 5939 | 0 | 0 | 0 | | sdb | 36 | 47091 | 0 | 0 | 0 | | sdc | 35 | 47472 | 0 | 0 | 0 | | sdd | 35 | 47539 | 0 | 0 | 0 | | sde | 33 | 47641 | 0 | 0 | 0 | | sdf | 34 | 47530 | 0 | 0 | 0 | | sdg | 36 | 47544 | 1 | 0 | 0 | | sdh | 36 | 47548 | 0 | 0 | 0 | | sdi | 31 | 5959 | 0 | 0 | 0 | | sdj | 34 | 47632 | 0 | 0 | 0 | | sdk | 34 | 47553 | 0 | 344 | 0 | ----------------------------------------------------------- root@darkstar4:~# egrep "sd[df]" /var/log/messages | grep -v smartd Apr 10 18:05:13 darkstar4 kernel: [ 1.597545] sd 0:0:5:0: [sdf] 3907029168 512-byte logical blocks: (2.00 TB/1.81 TiB) Apr 10 18:05:13 darkstar4 kernel: [ 1.597613] sd 0:0:3:0: [sdd] 3907029168 512-byte logical blocks: (2.00 TB/1.81 TiB) Apr 10 18:05:13 darkstar4 kernel: [ 1.632377] sd 0:0:5:0: [sdf] Write Protect is off Apr 10 18:05:13 darkstar4 kernel: [ 1.632861] sd 0:0:3:0: [sdd] Write Protect is off Apr 10 18:05:13 darkstar4 kernel: [ 1.643788] sd 0:0:5:0: [sdf] Write cache: enabled, read cache: enabled, supports DPO and FUA Apr 10 18:05:13 darkstar4 kernel: [ 1.644386] sd 0:0:3:0: [sdd] Write cache: enabled, read cache: enabled, supports DPO and FUA Apr 10 18:05:13 darkstar4 kernel: [ 1.720878] sdf: sdf1 Apr 10 18:05:13 darkstar4 kernel: [ 1.722385] sdd: sdd1 Apr 10 18:05:13 darkstar4 kernel: [ 1.785130] sd 0:0:5:0: [sdf] Attached SCSI disk Apr 10 18:05:13 darkstar4 kernel: [ 1.786556] sd 0:0:3:0: [sdd] Attached SCSI disk Apr 10 18:05:13 darkstar4 kernel: [ 6.364155] md: adding sdd1 ... Apr 10 18:05:13 darkstar4 kernel: [ 6.381469] md: adding sdf1 ... Apr 10 18:05:13 darkstar4 kernel: [ 6.425142] md: bind<sdf1> Apr 10 18:05:13 darkstar4 kernel: [ 6.436932] md: bind<sdd1> Apr 10 18:05:13 darkstar4 kernel: [ 6.465676] md: running: <sdk1><sdj1><sda1><sde1><sdh1><sdd1><sdg1><sdf1><sdb1><sdc1> Apr 10 18:05:13 darkstar4 kernel: [ 6.491591] md/raid:md0: device sdd1 operational as raid disk 0 Apr 10 18:05:13 darkstar4 kernel: [ 6.499005] md/raid:md0: device sdf1 operational as raid disk 4 Apr 10 18:50:00 darkstar4 kernel: [ 1.598387] sd 0:0:5:0: [sdf] 3907029168 512-byte logical blocks: (2.00 TB/1.81 TiB) Apr 10 18:50:00 darkstar4 kernel: [ 1.598472] sd 0:0:3:0: [sdd] 3907029168 512-byte logical blocks: (2.00 TB/1.81 TiB) Apr 10 18:50:00 darkstar4 kernel: [ 1.633237] sd 0:0:5:0: [sdf] Write Protect is off Apr 10 18:50:00 darkstar4 kernel: [ 1.633679] sd 0:0:3:0: [sdd] Write Protect is off Apr 10 18:50:00 darkstar4 kernel: [ 1.644638] sd 0:0:5:0: [sdf] Write cache: enabled, read cache: enabled, supports DPO and FUA Apr 10 18:50:00 darkstar4 kernel: [ 1.645198] sd 0:0:3:0: [sdd] Write cache: enabled, read cache: enabled, supports DPO and FUA Apr 10 18:50:00 darkstar4 kernel: [ 1.721746] sdf: sdf1 Apr 10 18:50:00 darkstar4 kernel: [ 1.726157] sdd: sdd1 Apr 10 18:50:00 darkstar4 kernel: [ 1.784835] sd 0:0:5:0: [sdf] Attached SCSI disk Apr 10 18:50:00 darkstar4 kernel: [ 1.790418] sd 0:0:3:0: [sdd] Attached SCSI disk Apr 10 18:50:00 darkstar4 kernel: [ 6.368128] md: adding sdd1 ... Apr 10 18:50:00 darkstar4 kernel: [ 6.386079] md: adding sdf1 ... Apr 10 18:50:00 darkstar4 kernel: [ 6.443455] md: bind<sdf1> Apr 10 18:50:00 darkstar4 kernel: [ 6.454530] md: bind<sdd1> Apr 10 18:50:00 darkstar4 kernel: [ 6.478145] md: running: <sdk1><sdj1><sda1><sde1><sdd1><sdh1><sdf1><sdg1><sdc1><sdb1> Apr 10 18:50:00 darkstar4 kernel: [ 6.515604] md/raid:md0: device sdd1 operational as raid disk 0 Apr 10 18:50:00 darkstar4 kernel: [ 6.528721] md/raid:md0: device sdf1 operational as raid disk 4 Apr 10 20:12:58 darkstar4 kernel: [ 1.597031] sd 0:0:3:0: [sdd] 3907029168 512-byte logical blocks: (2.00 TB/1.81 TiB) Apr 10 20:12:58 darkstar4 kernel: [ 1.597071] sd 0:0:5:0: [sdf] 3907029168 512-byte logical blocks: (2.00 TB/1.81 TiB) Apr 10 20:12:58 darkstar4 kernel: [ 1.631890] sd 0:0:5:0: [sdf] Write Protect is off Apr 10 20:12:58 darkstar4 kernel: [ 1.632214] sd 0:0:3:0: [sdd] Write Protect is off Apr 10 20:12:58 darkstar4 kernel: [ 1.642688] sd 0:0:3:0: [sdd] Write cache: enabled, read cache: enabled, supports DPO and FUA Apr 10 20:12:58 darkstar4 kernel: [ 1.643325] sd 0:0:5:0: [sdf] Write cache: enabled, read cache: enabled, supports DPO and FUA Apr 10 20:12:58 darkstar4 kernel: [ 1.719735] sdd: sdd1 Apr 10 20:12:58 darkstar4 kernel: [ 1.721398] sdf: sdf1 Apr 10 20:12:58 darkstar4 kernel: [ 1.782909] sd 0:0:3:0: [sdd] Attached SCSI disk Apr 10 20:12:58 darkstar4 kernel: [ 1.785551] sd 0:0:5:0: [sdf] Attached SCSI disk Apr 10 20:12:58 darkstar4 kernel: [ 6.339090] md: adding sdf1 ... Apr 10 20:12:58 darkstar4 kernel: [ 6.348027] md: adding sdd1 ... Apr 10 20:12:58 darkstar4 kernel: [ 6.406474] md: bind<sdd1> Apr 10 20:12:58 darkstar4 kernel: [ 6.412316] md: bind<sdf1> Apr 10 20:12:58 darkstar4 kernel: [ 6.442247] md: running: <sdj1><sdk1><sda1><sde1><sdh1><sdf1><sdd1><sdg1><sdb1><sdc1> Apr 10 20:12:58 darkstar4 kernel: [ 6.451746] md: unbind<sdd1> Apr 10 20:12:58 darkstar4 kernel: [ 6.460955] md: export_rdev(sdd1) Apr 10 20:12:58 darkstar4 kernel: [ 6.485496] md/raid:md0: device sdf1 operational as raid disk 4 Apr 11 10:26:50 darkstar4 kernel: [51271.528818] md: export_rdev(sdd1) Apr 11 10:26:50 darkstar4 kernel: [51271.749114] md: bind<sdd1> Apr 12 04:40:53 darkstar4 kernel: [116946.501101] sd 0:0:5:0: [sdf] CDB: Apr 12 04:40:54 darkstar4 kernel: [116946.615209] sd 0:0:5:0: [sdf] CDB: Apr 12 04:41:02 darkstar4 kernel: [116954.563228] sd 0:0:5:0: [sdf] Apr 12 04:41:02 darkstar4 kernel: [116954.563232] sd 0:0:5:0: [sdf] CDB: Apr 12 04:41:43 darkstar4 kernel: [116996.444750] sd 0:0:5:0: [sdf] CDB: Apr 12 04:42:14 darkstar4 kernel: [117027.435416] sd 0:0:5:0: [sdf] CDB: Apr 12 04:42:15 darkstar4 kernel: [117027.640390] sd 0:0:5:0: [sdf] CDB: Apr 12 04:42:15 darkstar4 kernel: [117027.851541] sd 0:0:5:0: [sdf] CDB: Apr 12 04:42:15 darkstar4 kernel: [117028.087974] sd 0:0:5:0: [sdf] CDB: Apr 12 04:42:17 darkstar4 kernel: [117029.852425] sd 0:0:5:0: [sdf] Apr 12 04:42:17 darkstar4 kernel: [117029.852429] sd 0:0:5:0: [sdf] CDB: Apr 12 04:42:18 darkstar4 kernel: [117031.353073] sd 0:0:5:0: [sdf] Apr 12 04:42:18 darkstar4 kernel: [117031.353078] sd 0:0:5:0: [sdf] CDB: Apr 12 23:15:19 darkstar4 kernel: [183844.099784] sd 0:0:5:0: [sdf] CDB: Apr 13 08:45:18 darkstar4 kernel: [218059.277961] sd 0:0:5:0: [sdf] CDB: Apr 13 13:45:19 darkstar4 kernel: [236068.829370] sd 0:0:5:0: [sdf] CDB: Apr 14 05:15:19 darkstar4 kernel: [291895.259944] sd 0:0:5:0: [sdf] CDB: root@darkstar4:~# egrep "sd[df]" /var/log/syslog | grep -v smartd Apr 10 19:27:45 darkstar4 kernel: [ 2281.653802] blk_update_request: I/O error, dev sdd, sector 3907028928 Apr 10 19:27:45 darkstar4 kernel: [ 2281.653813] md/raid:md0: Disk failure on sdd1, disabling device. Apr 10 20:12:58 darkstar4 kernel: [ 6.447193] md: kicking non-fresh sdd1 from array! Apr 11 20:39:25 darkstar4 kernel: [88044.077726] blk_update_request: I/O error, dev sdd, sector 3907028928 Apr 11 20:39:25 darkstar4 kernel: [88044.077736] md/raid:md0: Disk failure on sdd1, disabling device. Apr 12 04:41:02 darkstar4 kernel: [116954.563243] blk_update_request: I/O error, dev sdf, sector 2571665184 Apr 12 04:42:17 darkstar4 kernel: [117029.852439] blk_update_request: I/O error, dev sdf, sector 2563792576 Apr 12 04:42:18 darkstar4 kernel: [117031.353088] blk_update_request: I/O error, dev sdf, sector 3907028928 Apr 12 04:42:18 darkstar4 kernel: [117031.353092] blk_update_request: I/O error, dev sdf, sector 3907028928 Apr 12 04:42:18 darkstar4 kernel: [117031.353098] md/raid:md0: Disk failure on sdf1, disabling device. root@darkstar4:~#

Even de SMART info erbij halen uit /var/log/messages en /var/log/syslog:

Apr 14 08:51:43 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], initial Temperature is 36 Celsius (Min/Max ??/36) root@darkstar4:~# egrep "sd[df]" /var/log/messages | grep -v "Apr 10" | grep smartd Apr 11 00:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], self-test in progress, 40% remaining Apr 11 00:13:11 darkstar4 smartd[1015]: Device: /dev/sdf [SAT], SMART Usage Attribute: 9 Power_On_Hours changed from 36 to 35 Apr 11 02:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], self-test in progress, 20% remaining Apr 11 02:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], skip scheduled Short Self-Test; 20% remaining of current Self-Test. Apr 11 02:13:11 darkstar4 smartd[1015]: Device: /dev/sdf [SAT], starting scheduled Short Self-Test. Apr 11 04:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], Temperature changed -1 Celsius to 32 Celsius (Min/Max 32!/34) Apr 11 04:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], previous self-test completed without error Apr 11 04:13:10 darkstar4 smartd[1015]: Device: /dev/sdf [SAT], previous self-test completed without error Apr 11 12:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], not capable of SMART self-check Apr 11 12:13:10 darkstar4 smartd[1015]: Device: /dev/sdd [SAT], Temperature changed -1 Celsius to 31 Celsius (Min/Max 31!/34) Apr 11 12:13:10 darkstar4 smartd[1015]: Device: /dev/sdf [SAT], Temperature changed -1 Celsius to 32 Celsius (Min/Max 32!/41) Apr 11 16:44:52 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], opened Apr 11 16:44:52 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], WDC WD20EARS-00J2GB0, S/N:WD-WCAYY0234909, WWN:5-0014ee-204d32f1e, FW:80.00A80, 2.00 TB Apr 11 16:44:52 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], found in smartd database: Western Digital Caviar Green (Adv. Format) Apr 11 16:44:52 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], could not enable SMART Attribute Autosave. Apr 11 16:44:53 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], enabled SMART Automatic Offline Testing. Apr 11 16:44:53 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], is SMART capable. Adding to "monitor" list. Apr 11 16:44:53 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], opened Apr 11 16:44:53 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], WDC WD20EARS-00J2GB0, S/N:WD-WCAYY0234808, WWN:5-0014ee-2af7df87a, FW:80.00A80, 2.00 TB Apr 11 16:44:53 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], found in smartd database: Western Digital Caviar Green (Adv. Format) Apr 11 16:44:53 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], enabled SMART Attribute Autosave. Apr 11 16:44:54 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], enabled SMART Automatic Offline Testing. Apr 11 16:44:54 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], is SMART capable. Adding to "monitor" list. Apr 11 16:44:56 darkstar4 smartd[4568]: Device: /dev/sdd [SAT], initial Temperature is 32 Celsius (Min/Max ??/32) Apr 11 16:44:56 darkstar4 smartd[4568]: Device: /dev/sdf [SAT], initial Temperature is 33 Celsius (Min/Max ??/33) Apr 11 17:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +2 Celsius to 34 Celsius (Min/Max 34!/34!) Apr 11 17:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed +2 Celsius to 35 Celsius (Min/Max 35!/35!) Apr 11 17:44:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +1 Celsius to 35 Celsius (Min/Max 34/35!) Apr 11 17:44:57 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed +1 Celsius to 36 Celsius (Min/Max 35/36!) Apr 11 17:44:57 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 200 to 100 Apr 11 19:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 11 22:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed -2 Celsius to 33 Celsius (Min/Max 33!/35) Apr 12 01:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed +2 Celsius to 38 Celsius (Min/Max 35/38!) Apr 12 01:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed +1 Celsius to 39 Celsius (Min/Max 35/39!) Apr 12 02:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +3 Celsius to 36 Celsius (Min/Max 33/36!) Apr 12 02:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], starting scheduled Short Self-Test. Apr 12 02:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 02:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], starting scheduled Short Self-Test. Apr 12 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], previous self-test completed without error Apr 12 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed +1 Celsius to 40 Celsius (Min/Max 35/40!) Apr 12 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 35/40!) Apr 12 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], previous self-test completed without error Apr 12 03:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 35/40) Apr 12 03:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 100 to 200 Apr 12 04:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 12 04:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 12 05:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 05:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 12 06:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +1 Celsius to 37 Celsius (Min/Max 33/37!) Apr 12 06:44:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +1 Celsius to 38 Celsius (Min/Max 33/38!) Apr 12 06:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (2 checks skipped) Apr 12 06:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 07:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 12 07:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 12 08:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 12 08:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 12 09:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 09:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed -5 Celsius to 35 Celsius (Min/Max 35/40) Apr 12 10:15:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 10:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 10:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 12 10:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 11:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed -1 Celsius to 34 Celsius (Min/Max 34!/40) Apr 12 11:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 12 11:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 12 12:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 12 12:44:59 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 200 to 100 Apr 12 12:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 12 13:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed -5 Celsius to 33 Celsius (Min/Max 33/38) Apr 12 13:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 12 13:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 14:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 14:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 15:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 12 15:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 12 17:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 17:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature changed +5 Celsius to 39 Celsius (Min/Max 34/40) Apr 12 18:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 12 18:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 12 19:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 12 19:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 12 20:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 12 20:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 21:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +5 Celsius to 38 Celsius (Min/Max 33/38) Apr 12 21:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 100 to 200 Apr 12 21:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 23:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 12 23:15:20 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 12 23:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 12 23:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 200 to 100 Apr 13 00:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 200 to 100 Apr 13 00:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 00:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 01:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 13 02:14:59 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], starting scheduled Short Self-Test. Apr 13 02:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 13 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], previous self-test completed without error Apr 13 03:14:59 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 100 to 200 Apr 13 03:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 13 05:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 13 05:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 13 06:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 13 07:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 13 08:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 13 08:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 100 to 200 Apr 13 08:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 08:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 09:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 13 09:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 13 09:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 10:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 13 10:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 11:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 13 11:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 13 11:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 12:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 12:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 13 13:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 13 13:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 14:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 13 14:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 13 14:45:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 13 15:45:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 13 15:45:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 13 16:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed -5 Celsius to 33 Celsius (Min/Max 33/38) Apr 13 16:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 13 16:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 13 16:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 13 17:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 200 to 100 Apr 13 17:14:57 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 18:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], Temperature changed +5 Celsius to 38 Celsius (Min/Max 33/38) Apr 13 19:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 20:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 20:44:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 100 to 200 Apr 13 21:14:57 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 200 to 100 Apr 13 21:44:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], SMART Usage Attribute: 7 Seek_Error_Rate changed from 100 to 200 Apr 13 21:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], previous self-test was interrupted by the host with a reset Apr 13 21:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 22:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 22:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 22:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 13 22:45:03 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 13 23:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 13 23:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 13 23:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 14 00:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 14 00:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 14 00:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 00:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 14 00:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 14 01:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 14 01:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 02:14:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], starting scheduled Short Self-Test. Apr 14 02:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is in SLEEP mode, suspending checks Apr 14 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], previous self-test completed without error Apr 14 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], is back in ACTIVE or IDLE mode, resuming checks (1 check skipped) Apr 14 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 14 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 02:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], starting scheduled Short Self-Test. Apr 14 03:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 03:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], previous self-test completed without error Apr 14 03:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 04:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 04:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 05:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 14 05:15:19 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self Test Log Failed Apr 14 05:15:20 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 14 05:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 14 05:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read SMART Self-Test Log worked again, warning condition reset after 1 email Apr 14 06:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Temperature 40 Celsius reached limit of 40 Celsius (Min/Max 34/40) Apr 14 07:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of SMART self-check Apr 14 08:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], read SMART Attribute Data worked again, warning condition reset after 1 email Apr 14 08:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], Read Summary SMART Error Log failed Apr 14 08:51:40 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], opened Apr 14 08:51:40 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], WDC WD20EARS-00J2GB0, S/N:WD-WCAYY0234909, WWN:5-0014ee-204d32f1e, FW:80.00A80, 2.00 TB Apr 14 08:51:40 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], found in smartd database: Western Digital Caviar Green (Adv. Format) Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], enabled SMART Attribute Autosave. Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], enabled SMART Automatic Offline Testing. Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], is SMART capable. Adding to "monitor" list. Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], opened Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], WDC WD20EARS-00J2GB0, S/N:WD-WCAYY0234808, WWN:5-0014ee-2af7df87a, FW:80.00A80, 2.00 TB Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], found in smartd database: Western Digital Caviar Green (Adv. Format) Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], enabled SMART Attribute Autosave. Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], enabled SMART Automatic Offline Testing. Apr 14 08:51:41 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], is SMART capable. Adding to "monitor" list. Apr 14 08:51:43 darkstar4 smartd[23037]: Device: /dev/sdd [SAT], initial Temperature is 35 Celsius (Min/Max ??/35) Apr 14 08:51:43 darkstar4 smartd[23037]: Device: /dev/sdf [SAT], initial Temperature is 36 Celsius (Min/Max ??/36) root@darkstar4:~# egrep "sd[df]" /var/log/syslog | grep -v "Apr 10" | grep smartd Apr 11 18:44:58 darkstar4 smartd[4575]: Device: /dev/sdd [SAT], failed to read SMART Attribute Data Apr 12 03:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], not capable of Offline or Self-Testing. Apr 12 05:14:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 12 06:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 12 08:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 12 19:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 12 23:15:19 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 02:15:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 02:15:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], execute Short Self-Test failed. Apr 13 02:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 03:15:00 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 08:45:18 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 13:45:19 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 14:44:59 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 15:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 13 23:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 14 01:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 14 05:14:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data Apr 14 07:44:58 darkstar4 smartd[4575]: Device: /dev/sdf [SAT], failed to read SMART Attribute Data

Ook nog eventjes de SMART data van beide schijven erbij halen:

root@darkstar4:/var/log# smartctl -A /dev/sdd smartctl 5.43 2012-06-30 r3573 [i686-linux-3.18.20-smp] (local build) Copyright (C) 2002-12 by Bruce Allen, http://smartmontools.sourceforge.net === START OF READ SMART DATA SECTION === SMART Attributes Data Structure revision number: 16 Vendor Specific SMART Attributes with Thresholds: ID# ATTRIBUTE_NAME FLAG VALUE WORST THRESH TYPE UPDATED WHEN_FAILED RAW_VALUE 1 Raw_Read_Error_Rate 0x002f 200 200 051 Pre-fail Always - 0 3 Spin_Up_Time 0x0027 166 163 021 Pre-fail Always - 8675 4 Start_Stop_Count 0x0032 100 100 000 Old_age Always - 280 5 Reallocated_Sector_Ct 0x0033 200 200 140 Pre-fail Always - 0 7 Seek_Error_Rate 0x002e 200 200 000 Old_age Always - 0 9 Power_On_Hours 0x0032 035 035 000 Old_age Always - 47539 10 Spin_Retry_Count 0x0032 100 100 000 Old_age Always - 0 11 Calibration_Retry_Count 0x0032 100 100 000 Old_age Always - 0 12 Power_Cycle_Count 0x0032 100 100 000 Old_age Always - 130 192 Power-Off_Retract_Count 0x0032 200 200 000 Old_age Always - 96 193 Load_Cycle_Count 0x0032 190 190 000 Old_age Always - 31458 194 Temperature_Celsius 0x0022 117 109 000 Old_age Always - 35 196 Reallocated_Event_Count 0x0032 200 200 000 Old_age Always - 0 197 Current_Pending_Sector 0x0032 200 200 000 Old_age Always - 0 198 Offline_Uncorrectable 0x0030 200 200 000 Old_age Offline - 0 199 UDMA_CRC_Error_Count 0x0032 200 200 000 Old_age Always - 0 200 Multi_Zone_Error_Rate 0x0008 200 200 000 Old_age Offline - 0 root@darkstar4:/var/log# smartctl -l selftest /dev/sdd smartctl 5.43 2012-06-30 r3573 [i686-linux-3.18.20-smp] (local build) Copyright (C) 2002-12 by Bruce Allen, http://smartmontools.sourceforge.net === START OF READ SMART DATA SECTION === SMART Self-test log structure revision number 1 Num Test_Description Status Remaining LifeTime(hours) LBA_of_first_error # 1 Short offline Completed without error 00% 47531 - # 2 Short offline Completed without error 00% 47508 - # 3 Short offline Completed without error 00% 47484 - # 4 Extended offline Completed without error 00% 47461 - # 5 Short offline Completed without error 00% 47441 - # 6 Short offline Completed without error 00% 47417 - # 7 Extended offline Completed without error 00% 47400 - # 8 Short offline Completed without error 00% 47369 - # 9 Short offline Completed without error 00% 47345 - #10 Short offline Completed without error 00% 47322 - #11 Short offline Completed without error 00% 47298 - #12 Short offline Completed without error 00% 47274 - #13 Short offline Completed without error 00% 47253 - #14 Short offline Completed without error 00% 47229 - #15 Short offline Completed without error 00% 47205 - #16 Short offline Completed without error 00% 47182 - #17 Short offline Completed without error 00% 47158 - #18 Short offline Completed without error 00% 47140 - #19 Short offline Completed without error 00% 47095 - #20 Short offline Completed without error 00% 47071 - #21 Short offline Completed without error 00% 47047 - root@darkstar4:/var/log# smartctl -A /dev/sdf smartctl 5.43 2012-06-30 r3573 [i686-linux-3.18.20-smp] (local build) Copyright (C) 2002-12 by Bruce Allen, http://smartmontools.sourceforge.net === START OF READ SMART DATA SECTION === SMART Attributes Data Structure revision number: 16 Vendor Specific SMART Attributes with Thresholds: ID# ATTRIBUTE_NAME FLAG VALUE WORST THRESH TYPE UPDATED WHEN_FAILED RAW_VALUE 1 Raw_Read_Error_Rate 0x002f 200 200 051 Pre-fail Always - 0 3 Spin_Up_Time 0x0027 162 158 021 Pre-fail Always - 8866 4 Start_Stop_Count 0x0032 100 100 000 Old_age Always - 330 5 Reallocated_Sector_Ct 0x0033 200 200 140 Pre-fail Always - 0 7 Seek_Error_Rate 0x002e 200 200 000 Old_age Always - 0 9 Power_On_Hours 0x0032 035 035 000 Old_age Always - 47531 10 Spin_Retry_Count 0x0032 100 100 000 Old_age Always - 0 11 Calibration_Retry_Count 0x0032 100 100 000 Old_age Always - 0 12 Power_Cycle_Count 0x0032 100 100 000 Old_age Always - 177 192 Power-Off_Retract_Count 0x0032 200 200 000 Old_age Always - 148 193 Load_Cycle_Count 0x0032 190 190 000 Old_age Always - 31617 194 Temperature_Celsius 0x0022 118 106 000 Old_age Always - 34 196 Reallocated_Event_Count 0x0032 200 200 000 Old_age Always - 0 197 Current_Pending_Sector 0x0032 200 200 000 Old_age Always - 0 198 Offline_Uncorrectable 0x0030 200 200 000 Old_age Offline - 0 199 UDMA_CRC_Error_Count 0x0032 200 200 000 Old_age Always - 0 200 Multi_Zone_Error_Rate 0x0008 200 200 000 Old_age Offline - 0 root@darkstar4:/var/log# smartctl -l selftest /dev/sdf smartctl 5.43 2012-06-30 r3573 [i686-linux-3.18.20-smp] (local build) Copyright (C) 2002-12 by Bruce Allen, http://smartmontools.sourceforge.net Probable ATA device behind a SAT layer Try an additional '-d ata' or '-d sat' argument. root@darkstar4:/var/log# smartctl -l selftest /dev/sdf smartctl 5.43 2012-06-30 r3573 [i686-linux-3.18.20-smp] (local build) Copyright (C) 2002-12 by Bruce Allen, http://smartmontools.sourceforge.net Smartctl: Device Read Identity Failed: scsi error aborted command A mandatory SMART command failed: exiting. To continue, add one or more '-T permissive' options. root@darkstar4:/var/log# smartctl -l selftest /dev/sdf smartctl 5.43 2012-06-30 r3573 [i686-linux-3.18.20-smp] (local build) Copyright (C) 2002-12 by Bruce Allen, http://smartmontools.sourceforge.net === START OF READ SMART DATA SECTION === Read SMART Log Directory failed. Error SMART Error Self-Test Log Read failed: Input/output error Smartctl: SMART Self Test Log Read Failed root@darkstar4:/var/log#

Ik heb een vermoeden dat schijf /dev/sdf er het slechtst aan toe is aangezien de SMART info regelmatig niet kan gelezen worden (kan je zien in laatste console output).

Schijf /dev/sdd lijkt volgens SMART wel perfect in orde.

Je kan bij beide schijven zien dat er op zeer frequente basis short en long selftests gedaan worden. Dit zijn mijn entries in /etc/smartd.conf voor beide schijven:

1

2

3

4

5

6

7

8

9

10

11

12

| # Short selftests every day at the same hour, except for the OS disk. Long selftests on a different day each # time at 3pm. The OS disk gets its long self-test on the first day of the month at 3am. The raid disks get the long # self-test the 2nd, 4rd, 6th, ... day of each month at 3am. One long self-test per month per disk. Daily short tests. # For each drive, log every major event, ignore constant temperature changes but do report on sudden changes of 5 degrees, # also when the limits of 40 and 45C are reached. Mail everything to the data user in case something does come up. # Do not wake up disks that are spun down but ensure that after 24 skips (2 days as smartd polls every 2 hours now) # force a spin-up + check. Suppress the logs to be filled with messages that it skipped a test. # /etc/rc.d/rc.smartd was created to control smartd. 7200seconds is mentioned there as the default SMARTD polling time # instead of the default 1800seconds (30 minutes) /dev/sdd -d sat -a -I 194 -I 231 -W 5,40,45 -o on -S on -s (S/../.././02|L/../08/./03) -n standby,24q /dev/sdf -d sat -a -I 194 -I 231 -W 5,40,45 -o on -S on -s (S/../.././02|L/../12/./03) -n standby,24q |

Op zich kan ik natuurlijk niet klagen aangezien 8 van mijn 10 schijven in RAID 6 reeds 5,5 jaar probleemloos 24/7 draaien (kan je zien op de LifteTime(hours).

Ik ben dus van plan om schijven /dev/sdd en /dev/sdf te vervangen. Ik heb /dev/sdd reeds geprobeerd opnieuw bij te voegen bij de array (om een forced rebuild te doen) maar die werd er na enkele uren terug uitgekickt.

Wat ik echter niet goed begrijp is dat zowel de /dev/sdd en /dev/sdf een exact dezelfde sector hebben die I/O errors geeft:

root@darkstar4:/var/log# egrep "sd[df]" /var/log/messages /var/log/syslog | grep -i sector /var/log/syslog:Apr 10 19:27:45 darkstar4 kernel: [ 2281.653802] blk_update_request: I/O error, dev sdd, sector 3907028928 /var/log/syslog:Apr 11 20:39:25 darkstar4 kernel: [88044.077726] blk_update_request: I/O error, dev sdd, sector 3907028928 /var/log/syslog:Apr 12 04:41:02 darkstar4 kernel: [116954.563243] blk_update_request: I/O error, dev sdf, sector 2571665184 /var/log/syslog:Apr 12 04:42:17 darkstar4 kernel: [117029.852439] blk_update_request: I/O error, dev sdf, sector 2563792576 /var/log/syslog:Apr 12 04:42:18 darkstar4 kernel: [117031.353088] blk_update_request: I/O error, dev sdf, sector 3907028928 /var/log/syslog:Apr 12 04:42:18 darkstar4 kernel: [117031.353092] blk_update_request: I/O error, dev sdf, sector 3907028928 root@darkstar4:/var/log#

De eventueel foute sectoren bevinden zich helemaal op het einde van de harde schijven:

root@darkstar4:~/tools# fdisk -l /dev/sdd Disk /dev/sdd: 2000.4 GB, 2000398934016 bytes 255 heads, 63 sectors/track, 243201 cylinders, total 3907029168 sectors Units = sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk identifier: 0x693b3289 Device Boot Start End Blocks Id System /dev/sdd1 64 3907029167 1953514552 fd Linux raid autodetect root@darkstar4:~/tools# fdisk -l /dev/sdf Disk /dev/sdf: 2000.4 GB, 2000398934016 bytes 255 heads, 63 sectors/track, 243201 cylinders, total 3907029168 sectors Units = sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk identifier: 0xfe307ca8 Device Boot Start End Blocks Id System /dev/sdf1 64 3907029167 1953514552 fd Linux raid autodetect root@darkstar4:~/tools#

Het grote voordeel is dat zelfs al zou mijn RAID array falen, ik een backup heb van de belangrijkste data. Muziek en films beschouw ik puur als optioneel.

Wat is jullie advies/analyse? Ik heb ondertussen volledig nieuwe Noctua case fans liggen (die de stock fans zullen vervangen) dus die komen er dit weekend in. Ik stel voor om met prioriteit /dev/sdf te vervangen gezien SMART ook niet meer correct werkt en de schijf regelmatig in SLEEP mode lijkt te staan volgens de logs (dit terwijl deze schijven nooit downspinnen). Echter lijkt alles redelijk in orde met /dev/sdd.

Ik overweeg ook stilaan om uiteindelijk alle schijven hun welverdiende rust toe te kennen en te beginnen investeren in 4TB schijven, met een mogelijke switch naar FreeNAS/ZFS RAIDZ/RAIDZ2, alhoewel ik ook wel perfect tevreden met Linux software raid 6. Ik draai ondertussen al meer dan 10 jaar Linux software RAID (eerst RAID 5 met 4 160GB schijven en nadien RAID 6 met 10 2TB schijven) en heb nooit corruptie komende van controllers of software mogen ondervinden (voor zover ik gemerkt heb). Echter denk ik er ook aan mijn fileserver approach wat matuurder te maken en te beginnen investeren in een meer toekomstbestendig technologie (software matig in dit geval). Het spreekt natuurlijk voor zich dat ik - aangezien ik al de belangrijkste data regelmatig backup - ik ook geen nodeloze kosten wil doen als enkel schijven /dev/sdd en /dev/sdf eventueel kunnen vervangen worden. Ik zou 3 schijven kunnen kopen om de twee disks te vervangen (indien nodig) en nog eentje als spare te hebben. Echter moest er dan nog een andere disk failen is het best "eieren voor mijn geld" te nemen te starten met 5x4TB in RAIDZ (geen zin om direct 10 4TB disks te kopen).

Nogmaals sorry voor de lange post en ik weet niet goed in welke mate ik advies nodig heb, laat staan waar ik advies voor vraag, maar jullie advies gebaseerd op bovenstaande logdata is meer dan welkom.

Ik heb zo'n Fractal node 304 en er passen prima 6 schijven in. je moet die kast alleen niet op zijn kant gaan zettenjanser01 schreef op woensdag 13 april 2016 @ 13:18:

[...]

Hoeveel SATA aansluitingen heeft je huidige moederbord? De meeste moderne moederborden hebben er volgens mij 6 dus ik zou altijd voor een case gaan waar je minimaal 6 schijven in kwijt kunt.

Je geeft aan dat er 2 op je moederbord zitten aangesloten, zijn het toevallig de 2 disken die nu aan het gek doen zijn? Dan zou je een eventueel moederbord/moederbord controller kunnen verdenken. Aan de SMART waardes is in ieder geval niets te zien.Ashe schreef op donderdag 14 april 2016 @ 10:21:

Dit wordt een lange reactie. Sorry hoor. Het is weer zover...

Even korte situatieschets: Lian Li PC-A71F case Asrock B75-Pro-3M (i3), 8GB RAM en 10 2TB schijven in RAID 6 en nog 1 2TB Operating System disk. De volgende schijven maken deel uit van de RAID array:

9 x WDC WD20EARS-00J2GB0

1 x WDC WD20EZRX-00D8PB0

De afwijkende WD20EZRX werd geplaatst ter vervangen van een falende WD20EARS vorig jaar.

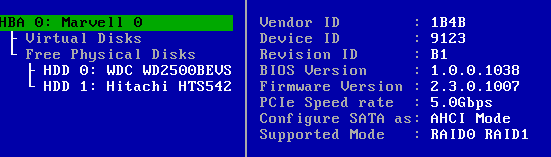

Een M1115 (IT mode) stuurt 8 schijven aan en de 2 overige via het moederbord.

AMD Ryzen 7 5900x | Custom WC | ASUS ROG Strix X570-E Gaming | 32GB Corsair DDR4-3600MHz | Samsung 970 nvme 1TB | Samsung 860 EVO 2TB | AMD RX 6900XT 16GB | 1x Asus RoG XG27AQDMG | 1x LG UltraGear 27GL850

Bedankt om mee te denken! Zowel schijf /dev/sdd als /dev/sdf zijn aangesloten op de IBM M1115. Verder zijn ze elk ook geconnecteerd op een verschillende drive bay connector op de kaart.rikadoo schreef op donderdag 14 april 2016 @ 11:42:

[...]

Je geeft aan dat er 2 op je moederbord zitten aangesloten, zijn het toevallig de 2 disken die nu aan het gek doen zijn? Dan zou je een eventueel moederbord/moederbord controller kunnen verdenken. Aan de SMART waardes is in ieder geval niets te zien.

Een eventueel probleem met de kaart heb ik min of meer uitgesloten aangezien ik zou vermoeden dat dan de andere schijven ook raar zouden beginnen doen.

Zou het de moeite waard zijn om vanavond een van de schijven af te koppelen en rechtstreeks op het mobo aan te sluiten?

Persoonlijk staat mij echter tegen dat dit geen hotswappable bays zijn, wat inhoudt dat een schijf vervangen een rotkarwei wordt met mogelijk wat downtime. De enige oplossingen met 12 hotswappable bays die ik echter tegenkom zijn 2U of 3U rackservers met flink hogere kosten. Daarnaast komt de machine in een kantooromgeving te staan, dus wil ik het formaat en vooral ook geluid van een rackserver liever vermijden.

Mijn vraag is dus of er wellicht mooie compacte ATX/mATX cases zijn met 12x3.5" bays. Iets in de trant van een Synology DS2415+ zeg maar. Zo niet, zijn er hier toevallig mensen met ervaring met een "volle" Node 804? (ik heb zelf een Node 304 zonder draaiende schijven en ben daar gematigd positief over)

Edit: Ik realiseer me net dat de Node 804 slechts 10x3.5" aankan. Voor de rest verandert dat echter niets aan de vraag.

[ Voor 5% gewijzigd door narotic op 14-04-2016 20:20 ]

- = Step Into The Pit | Industrial Strength = -

Ja kan je proberen, wellicht toch iets geks met de kabels. Weet niet of het verwisselen van plek bij een raid set uitmaakt, heb ik geen verstand van verder, weet dat het bij een raidset op xpenology niet uitmaakt iig.Ashe schreef op donderdag 14 april 2016 @ 12:01:

[...]

Bedankt om mee te denken! Zowel schijf /dev/sdd als /dev/sdf zijn aangesloten op de IBM M1115. Verder zijn ze elk ook geconnecteerd op een verschillende drive bay connector op de kaart.

Een eventueel probleem met de kaart heb ik min of meer uitgesloten aangezien ik zou vermoeden dat dan de andere schijven ook raar zouden beginnen doen.

Zou het de moeite waard zijn om vanavond een van de schijven af te koppelen en rechtstreeks op het mobo aan te sluiten?

AMD Ryzen 7 5900x | Custom WC | ASUS ROG Strix X570-E Gaming | 32GB Corsair DDR4-3600MHz | Samsung 970 nvme 1TB | Samsung 860 EVO 2TB | AMD RX 6900XT 16GB | 1x Asus RoG XG27AQDMG | 1x LG UltraGear 27GL850

Even los van je NAS vragen, heb je ook aan de backup oplossing voor die 80TB gedacht? Raid != backup. Als die NAS het begeeft zullen je onderzoekers niet blij zijn als je geen back-up hebt!narotic schreef op donderdag 14 april 2016 @ 20:06:

Voor een kleine onderzoeksafdeling ben ik een economische NAS aan het samenstellen die als het even kan 80TB aan effectieve capaciteit biedt.

Voor huis tuin en keuken gebruik is consumer grade hardware leuk. Maar als je dit soort dingen wilt gaan optuigen dan raad ik echt wel server grade oplossing aan.

Mijn stuff -> http://gathering.tweakers.net/forum/view_message/43289117

Deze NAS is juist voornamelijk bedoeld als backup voor de workstations. Daarnaast kan een groot deel van de data altijd opnieuw gedownload/berekend worden in het allerergste geval.janser01 schreef op donderdag 14 april 2016 @ 21:42:

[...]

Even los van je NAS vragen, heb je ook aan de backup oplossing voor die 80TB gedacht? Raid != backup. Als die NAS het begeeft zullen je onderzoekers niet blij zijn als je geen back-up hebt!

Voor huis tuin en keuken gebruik is consumer grade hardware leuk. Maar als je dit soort dingen wilt gaan optuigen dan raad ik echt wel server grade oplossing aan.

Persoonlijk zou ik ook liever naar (low-end) enterprise oplossingen kijken, maar de IT ondersteuning (rackspace, minimaal 1Gbit/s netwerk, bureaucratie etc.) daarvoor is helaas niet beschikbaar.

Edit: Laat ik er voor de duidelijkheid nog wel aan toevoegen dat ik voor mijn gevoel alleen qua case/voeding/koeling "vastzit" aan consumer-grade onderdelen, voor de rest zit ik te denken aan een Xeon E3, SuperMicro moederbord, ECC geheugen en een Perc H200 (of vergelijkbaar).

[ Voor 14% gewijzigd door narotic op 14-04-2016 23:22 ]

- = Step Into The Pit | Industrial Strength = -

Even niets...

- = Step Into The Pit | Industrial Strength = -

Dat zijn iig 10 hotswappable bays, wel binnen de case.

Stil met 10 disks is investeren in stille fans, ik zou het ook juist niet te klein zoeken.

Zware Unit in "Het grote DIY RAID NAS topic deel 3"

[ Voor 19% gewijzigd door tweedebas op 15-04-2016 09:46 ]

http://www.supermicro.com/products/chassis/

Niet het goedkoopst, maar ze zijn er wel. Van ITX tot 8U.

De vraag is vooral, wat wil je bereiken? Je kan vrij goedkoop hotswap bays kopen, je kan zoals tweedebas terecht opmerkt voor een setup gaan waar je relatief makkelijk bij je schijven kan via de zijkant, maar niet puur hotswap.

Legio mogelijkheden...

Even niets...

De Lian Li Q26 kwam ik net ook tegen en is inderdaad een nette optie inclusief de hotswap backplanes. Maar de Fractal Design R5 kan blijkbaar met extra cage 13x3.5" huisvesten tegen de 10x3.5" in de Q26.tweedebas schreef op vrijdag 15 april 2016 @ 09:45:

Kan je niet iets gaan opzetten in de trant van Zware Unit?

Dat zijn iig 10 hotswappable bays, wel binnen de case.

Stil met 10 disks is investeren in stille fans, ik zou het ook juist niet te klein zoeken.

Zware Unit in "Het grote DIY RAID NAS topic deel 3"

Hun tower chassis (743, 745 series) vind ik met maximaal 8x3.5" en die zijn al ietwat aan de prijs. Ze hebben ook een paar leuke rack oplossingen, maar ik hou niet echt van het idee om zo een machine op zijn kant te zetten (en dan nog de 80mm fans...). Ik hoor echter graag ervaringen van mensen op dit vlak.FireDrunk schreef op vrijdag 15 april 2016 @ 09:50:

Supermicro verkoopt ook gewoon tower chassis?

http://www.supermicro.com/products/chassis/

Niet het goedkoopst, maar ze zijn er wel. Van ITX tot 8U.

Idealiter een compacte oplossing voor 12x3.5" hotswappable bays met backplanes (bij voorkeur SFF-8087) en redundante voeding. Met andere woorden, zeg maar een nette low-end 2U/3U oplossing (bijv. ThinkServer RD650 of HP DL380g9) maar dan in een andere form factor (bijv. zoals de eerder genoemde 12-bay synology) ivm ruimte en geluid.De vraag is vooral, wat wil je bereiken? Je kan vrij goedkoop hotswap bays kopen, je kan zoals tweedebas terecht opmerkt voor een setup gaan waar je relatief makkelijk bij je schijven kan via de zijkant, maar niet puur hotswap.

Legio mogelijkheden...

Ik begrijp echter dat dat gewoon niet bestaat, dus zal ik op een paar punten in moeten leveren. De suggestie van tweedebas valt inderdaad prima in de richting waarin ik zat te denken. Een iets andere mogelijkheid waar ik aan denk is een case met 9x5.25" en daar vervolgens 3 3.5" drive enclosures in te plaatsen. Ik had echter gehoopt dat ik wellicht een nette kant-en-klare kast met deze specificaties over het hoofd had gezien.

- = Step Into The Pit | Industrial Strength = -

Even niets...

Netter bedoel ik o.a. dat ik zeker weet dat alles past en ook bijv. SFF-8087 ipv tig losse SATA kabels (ik kom alleen 5.25" hotswap bays tegen met SATA). Maar ik ben het met je eens dat dit uiteindelijk geen echte struikelblokken zijn. "makkelijk bereikbaar" is op zich ook wel voldoende, met een beetje geluk komt het minder dan eens per jaar voor dat een schijf vervangen moet worden en dan kan die extra minuut er wel vanaf.FireDrunk schreef op vrijdag 15 april 2016 @ 10:50:

Wat bedoel je met "netter" ? Want 3 maal een 5-in-3 hotswap bay vindt ik voor jouw use-case een prima oplossing? Moet het echt hotswap zijn, of mag het ook 'makkelijk bereikbaar' zijn? Want dan komt de Lian Li case toch best aardig in de buurt.

In ieder geval, alvast bedankt voor het meedenken en de suggesties.

- = Step Into The Pit | Industrial Strength = -

Ik weet niet wat je budget is maar uitgaande van de genoemde toepassing is het wellicht slimmer om gewoon een Synology of een QNAP oplossing neer te zetten. Dat zijn uitbreidbare fire-and-forget oplossingen met hot swappable bays. Ze zijn stil (te krijgen) en zuinig. Netwerk aggregatie is een peuleschil (een DS 1815+ heeft volgens mij 4x1Gb poorten) want zo te horen wil je veel bandbreedte om je back ups te draaien en je hebt garantie en support mocht het eens echt mis gaan... Ja ze zijn relatief duurder maar je krijgt er ook heel veel zekerheid voor terug. Hang het ding verder aan een UPS en je hebt een hele degelijke oplossing.narotic schreef op donderdag 14 april 2016 @ 23:08:

[...]

Deze NAS is juist voornamelijk bedoeld als backup voor de workstations. Daarnaast kan een groot deel van de data altijd opnieuw gedownload/berekend worden in het allerergste geval.

Persoonlijk zou ik ook liever naar (low-end) enterprise oplossingen kijken, maar de IT ondersteuning (rackspace, minimaal 1Gbit/s netwerk, bureaucratie etc.) daarvoor is helaas niet beschikbaar.

Edit: Laat ik er voor de duidelijkheid nog wel aan toevoegen dat ik voor mijn gevoel alleen qua case/voeding/koeling "vastzit" aan consumer-grade onderdelen, voor de rest zit ik te denken aan een Xeon E3, SuperMicro moederbord, ECC geheugen en een Perc H200 (of vergelijkbaar).

Hiermee wil ik zeggen, staar je niet blind op een eigen DIY oplossing omdat het ontzettend leuk is om zo'n ding samen te stellen, te bouwen en in te richten.

[ Voor 3% gewijzigd door janser01 op 15-04-2016 11:42 ]

Mijn stuff -> http://gathering.tweakers.net/forum/view_message/43289117

Dat begrijp ik, je zou naar een X-Case kunnen kijken, en dan met wat kunst en vlieg grepen het ding op zijn kant zetten. Op zich moeten die bakken daar wel tegen kunnen.narotic schreef op vrijdag 15 april 2016 @ 11:04:

[...]

Netter bedoel ik o.a. dat ik zeker weet dat alles past en ook bijv. SFF-8087 ipv tig losse SATA kabels (ik kom alleen 5.25" hotswap bays tegen met SATA). Maar ik ben het met je eens dat dit uiteindelijk geen echt struikelblokken zijn. Aangezien "makkelijk bereikbaar" op zich ook wel voldoende, met een beetje geluk komt het minder dan eens per jaar voor dat een schijf vervangen moet worden en dan kan die extra minuut er wel vanaf.

In ieder geval, alvast bedankt voor het meedenken en de suggesties.

Even niets...

Een valide punt en ik heb er ook even naar gekeken omdat ik het eigenlijk nou ook weer niet zo leuk vind om een ding samen te stellen wat niet voor mijzelf isjanser01 schreef op vrijdag 15 april 2016 @ 11:40:

[...]

Ik weet niet wat je budget is maar uitgaande van de genoemde toepassing is het wellicht slimmer om gewoon een Synology of een QNAP oplossing neer te zetten. Dat zijn uitbreidbare fire-and-forget oplossingen met hot swappable bays. Ze zijn stil (te krijgen) en zuinig. Netwerk aggregatie is een peuleschil (een DS 1815+ heeft volgens mij 4x1Gb poorten) want zo te horen wil je veel bandbreedte om je back ups te draaien en je hebt garantie en support mocht het eens echt mis gaan... Ja ze zijn relatief duurder maar je krijgt er ook heel veel zekerheid voor terug. Hang het ding verder aan een UPS en je hebt een hele degelijke oplossing.

Hiermee wil ik zeggen, staar je niet blind op een eigen DIY oplossing omdat het ontzettend leuk is om zo'n ding samen te stellen, te bouwen en in te richten.

- = Step Into The Pit | Industrial Strength = -

Maar ik vraag me werkelijk af waarom jullie lokale IT support niets kan betekenen, of zitten er geen storage mensen bij jullie c.q. budget?

Een systeem als dit voor deze toepassing ergens in een niet-server ruimte neerzetten vind ik niet echt chique. Als er geld is om een systeem als dit neer te zetten, is er ook geld om een disk chassis aan het SAN er bij te hangen (als er een SAN is) en op die manier jullie gewoon te helpen.

Offtopic:Q schreef op vrijdag 15 april 2016 @ 13:27:

@Narotic, ik snap dat dit een techniek vraag is en ook leuk om zelf op te zetten. Tevens weet ik niet wat jouw functie/rol hier in is.

Maar ik vraag me werkelijk af waarom jullie lokale IT support niets kan betekenen, of zitten er geen storage mensen bij jullie c.q. budget?

Een systeem als dit voor deze toepassing ergens in een niet-server ruimte neerzetten vind ik niet echt chique. Als er geld is om een systeem als dit neer te zetten, is er ook geld om een disk chassis aan het SAN er bij te hangen (als er een SAN is) en op die manier jullie gewoon te helpen.

Het is binnen een kleine onderzoeksgroep in een enorme publieke universiteit (wees gerust, niet in Nederland

Op voormalige werkplekken heb ik ook gezien hoe storage/compute chique ingericht kan worden (bijv. Lustre cluster storage, tape backup, Sun Grid Engine op de workstations, etc.), maar dat vereist een capabele IT afdeling. Ik heb nog niet veel met de huidige IT afdeling te maken gehad, maar mijn indruk tot nu toe is dat ze voornamelijk "Google for Education" accountjes beheren en netwerkkabeltjes uitdelen. Ik ben het er helemaal mee eens dat zoiets zelf bouwen en in een hoekje hosten verre van chique is (en zal dat ook aangeven), maar ik vrees dat het de enige mogelijkheid is om binnen afzienbare tijd een half fatsoenlijke oplossing te hebben.

- = Step Into The Pit | Industrial Strength = -

Afgelepen week flink aan het shoppen geweest voor 4TB WD-Re disken, totaal 48 kunnen bemachtigen

Gevolg dat ik een aardige mix van oudere disken (1 tot 6 jaar oud) heb liggen die ik voor een schappelijke prijs tekoop wil gaan zetten. Beetje lastig om dat te kunnen bepalen.

Totdat bleek dat dat het geen eenmalige prijs was, maar dat ze dat PER MAAND wilden zien... Daar zijn dus 2 USB-schijven voor in de plaats gekomen. Nee, dat biedt niet dezelfde performance of garanties als een enterprise-oplossing, maar als je storage zo duur is dat je geen geld meer hebt om onderzoek te doen heb je die storage ook niet meer nodig

TB of TiB? Als je alles in Windows of Linux op aan het tellen bent dan is het 99% zeker TiB en kom je met een 80 TB NAS dus flink ruimte tekortnarotic schreef op donderdag 14 april 2016 @ 20:06:

Voor een kleine onderzoeksafdeling ben ik een economische NAS aan het samenstellen die als het even kan 80TB aan effectieve capaciteit biedt.

Er zijn grofweg twee soorten 8 TB-schijven: SMR en 'gewoon', helaas zijn de gewone duurder. SMR op iets dat niet weet dat je SMR hebt heeft een negatieve impact op je sustained write en (dus) je rebuilds.

Waarmee ga je backups maken? 80 TB is niet niks...

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Leuk / interesant om die context te zien. Ik heb wel het idee dat je met dit soort vraagstukken niet langs de helpdesk moet maar eigenlijk beter kunt koffie drinken met de sysadmin IT mensen daar. Ik doe nu grote aannamen over jouw situatie en wat je wel/niet hebt gedaan, daar ben ik me van bewust. Volgens mij zouden de 'echte' sysadmins het nog wel leuk vinden ook om jullie hier mee te helpen, als ze een beetje een goede instelling hebben.narotic schreef op vrijdag 15 april 2016 @ 14:45:

[...]

Offtopic:

Het is binnen een kleine onderzoeksgroep in een enorme publieke universiteit (wees gerust, niet in Nederland). In dit geval heb ik een adviserende rol om een aanbesteding voor te bereiden, voornamelijk omdat ik er als "tweaker" simpelweg het meeste vanaf weet. Ik ben verder absoluut geen sysadmin van beroep, dus eigenlijk zou ik me hier helemaal niet mee bezig hoeven te houden.

Op voormalige werkplekken heb ik ook gezien hoe storage/compute chique ingericht kan worden (bijv. Lustre cluster storage, tape backup, Sun Grid Engine op de workstations, etc.), maar dat vereist een capabele IT afdeling. Ik heb nog niet veel met de huidige IT afdeling te maken gehad, maar mijn indruk tot nu toe is dat ze voornamelijk "Google for Education" accountjes beheren en netwerkkabeltjes uitdelen. Ik ben het er helemaal mee eens dat zoiets zelf bouwen en in een hoekje hosten verre van chique is (en zal dat ook aangeven), maar ik vrees dat het de enige mogelijkheid is om binnen afzienbare tijd een half fatsoenlijke oplossing te hebben.

Gaan ze een Ceph cluster voor je bouwen !

Heel eerlijk: ik zou eigenlijk alleen voor zelfbouw kiezen in jouw context als het echt niet anders kan. Zo'n QNAP of misschien een tandje groter, is wel wat duurder maar het resulteert in meer tijd voor je 'echte' werk

[ Voor 3% gewijzigd door Q op 15-04-2016 16:33 ]

Ik ben het daar volledig mee eens. Sterker nog, zodra er iets mis is mag jij telkens komen opdraven. M.a.w. jij komt daar nooit en te nimmer meer vanaf. Zo'n QNAP of Synology daar komt elke IT boer om de hoek nog wel uit hoe dat is ingericht.Q schreef op vrijdag 15 april 2016 @ 16:32:

[...]

Heel eerlijk: ik zou eigenlijk alleen voor zelfbouw kiezen in jouw context als het echt niet anders kan. Zo'n QNAP of misschien een tandje groter, is wel wat duurder maar het resulteert in meer tijd voor je 'echte' werk

Dus het is ook een stukje zelf bescherming. Je weet hoe het gaat; zodra je het kunt spellen ben je ook expert...en dus ook de Sjaak.

Mijn stuff -> http://gathering.tweakers.net/forum/view_message/43289117

De 80TB is voornamelijk gebaseerd op (1) totale storage van de workstations (7x12TB) en (2) het maximale wat zo ongeveer in een enkel systeem kan. Het totale gebruik op de workstations is volgens mij nog <20TB, maar aangezien het van aanbesteding tot daadwerkelijke levering maanden kan duren is het niet makkelijk om er later even snel wat schijven bij te plaatsen. Vandaar de voorkeur om het "op de groei" te kopen zodat het voor de komende paar jaar in orde is.Paul schreef op vrijdag 15 april 2016 @ 16:18:

TB of TiB? Als je alles in Windows of Linux op aan het tellen bent dan is het 99% zeker TiB en kom je met een 80 TB NAS dus flink ruimte tekortIk weet niet hoe goed de data te comprimeren is, dat kan nog een hoop schelen. Verder wil je ZFS niet te vol schrijven want dan kan het zijn huishouden niet meer doen. Ik weet niet hoeveel ruimte je precies vrij wilt houden maar met 12 schijven ben je er dus nog niet

SMR wil ik vermijden, dus dan blijven al snel de WD Red's over als relatief economische optie (helaas is het niet echt een optie in dit geval om de schijven uit WD My Book's te trekken). Deze machine is overigens juist bedoeld voor regelmatige backups van de workstations, ook zodat die meer performance kunnen bieden met een onveilige RAID0 setup.Er zijn grofweg twee soorten 8 TB-schijven: SMR en 'gewoon', helaas zijn de gewone duurder. SMR op iets dat niet weet dat je SMR hebt heeft een negatieve impact op je sustained write en (dus) je rebuilds.

Waarmee ga je backups maken? 80 TB is niet niks...

Ik heb redelijk wat ervaring met FreeBSD/Linux+ZFS en ben meer op mijn gemak met de CLI dan web-interfaces, dus voor mij persoonlijk lijkt het me makkelijker een oplossing qua software te kiezen die ik al ken dan dat ik mijn weg moet vinden in een nieuw platform (inclusief interoperabiliteit met de Ubuntu workstations). Daarnaast is mijn rol voornamelijk voor de keuze van hardware en de inrichting van de software, niet zozeer voor het dagelijks onderhoud.Q schreef op vrijdag 15 april 2016 @ 16:32:

Heel eerlijk: ik zou eigenlijk alleen voor zelfbouw kiezen in jouw context als het echt niet anders kan. Zo'n QNAP of misschien een tandje groter, is wel wat duurder maar het resulteert in meer tijd voor je 'echte' werk

[ Voor 3% gewijzigd door narotic op 15-04-2016 17:10 ]

- = Step Into The Pit | Industrial Strength = -

voor thuisgebruik ben ik mischien wel een buitenbeentje maargoed.narotic schreef op vrijdag 15 april 2016 @ 17:02:

[...]

De 80TB is voornamelijk gebaseerd op (1) totale storage van de workstations (7x12TB) en (2) het maximale wat zo ongeveer in een enkel systeem kan. Het totale gebruik op de workstations is volgens mij nog <20TB, maar aangezien het van aanbesteding tot daadwerkelijke levering maanden kan duren is het niet makkelijk om er later even snel wat schijven bij te plaatsen. Vandaar de voorkeur om het "op de groei" te kopen zodat het voor de komende paar jaar in orde is.

[...]

SMR wil ik vermijden, dus dan blijven al snel de WD Red's over als relatief economische optie (helaas is het niet echt een optie in dit geval om de schijven uit WD My Book's te trekken). Deze machine is overigens juist bedoeld voor regelmatige backups van de workstations, ook zodat die meer performance kunnen bieden met een onveilige RAID0 setup.

[...]

Ik heb redelijk wat ervaring met FreeBSD/Linux+ZFS en ben meer op mijn gemak met de CLI dan web-interfaces, dus voor mij persoonlijk lijkt het me makkelijker een oplossing qua software te kiezen die ik al ken dan dat ik mijn weg moet vinden in een nieuw platform (inclusief interoperabiliteit met de Ubuntu workstations). Daarnaast is mijn rol voornamelijk voor de keuze van hardware en de inrichting van de software, niet zozeer voor het dagelijks onderhoud.

mijn workstation heeft 25TB , voor zijn backup heb ik een cold storage van 37.5tb hp dl180 g6, 25x 1.5tb 2.5inch sata rack formaat.

Dit is een 2u rack, plek voor 25 schijven, zou je daar 2tb in proppen, en 2 van die servers hebben, dan zit je al op 100tb in 4u, voor in verhouding een redelijke prijs

Ben niet slim, maar wel dom

met een switch heb je een buffer nodig, omdat met een switch gebruikt wordt gemaakt van een bus switch, welke dus daadwerkelijk als een relais je poorten om switch, niet geschakelde poorten bufferd, en zodra hij hier weer naar toe schakelt de buffer weer leeg maakt.FireDrunk schreef op zaterdag 19 maart 2016 @ 11:27:

Het ligt een beetje aan de intelligentie van de CPU / Software die op de expander zelf zit. Er is niet echt een standaard firmware volgens mij voor expanders, dus elke fabrikant maakt zijn eigen firmware.

Het lijkt mij dat routeren moeilijker is op verschillende snelheden (je zit met buffers, intelligent schakelen, voorang geven, noem het maar op) terwijl 1 op 1 de snelheid behouden dit allemaal net wat makkelijker maakt.

Maar dat is pure speculatie.

Wil je het zeker weten, mail de fabrikant

met een hub, word er puur gekeken waar de data heen moet, de data versturen naar de ontvanger wachten op een ACK, slave op hold zetten, , en dan de data naar de andere poort sturen.

wat voor een flinke vertraging zorgt.

maar als ik het snel zo zie, naar die SAS expenders, zijn ze bijna allemaal uitgevoerd als switch

Ben niet slim, maar wel dom

De vraag "waarmee" blijft staannarotic schreef op vrijdag 15 april 2016 @ 17:02:

Deze machine is overigens juist bedoeld voor regelmatige backups van de workstations

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Bedoel je qua netwerk/software? De details zal ik uit moeten werken met de gebruikers en de persoon die dagelijks beheer zal doen, maar ik zat te denken aanPaul schreef op zaterdag 16 april 2016 @ 11:47:

[...]

De vraag "waarmee" blijft staanVoldoende opslagcapaciteit is één, maar je moet de data ook nog van A naar B krijgen, en dan zit je met zaken als schedules, retentie, monitoring...

- automatische ZFS snapshots op de workstations met oplopende intervallen van (bijv. 15 min/1 uur/dagelijks/wekelijks)

- incrementele backups richting de server (minimaal 1x elke nacht, wellicht vaker)

- tot ongeveer 1 maand retentie; dit is relatief lang, maar het voordeel van een kleine groep van technisch onderlegde gebruikers is dat bijv. een paar ruimtevretende snapshots ook eerder handmatig verwijderd kunnen worden als ruimte een probleem wordt

- met 7 workstations is trunking de moeite waard; uitgaande van effectief 4x100MB/s, kom je al over de 30TB per dag. Ik ga er vanuit dat een RAID array van >10 schijven die throughput ook makkelijk aankan.

- een scratch dataset op de workstations waar tijdelijke data opgeslagen wordt zonder backup. Vuistregel: data die sneller dan met 1Gbit/s (her)berekend kan worden hoort niet in de backup.

- echt belangrijke data (code, documenten, etc.) hoort natuurlijk ook offsite. Maar dat soort data is normaliter al verspreid over (publieke) svn/git repositories, cloud storage, 1 of meer laptops, etc.

- = Step Into The Pit | Industrial Strength = -

In het geval van een aanbesteding kun je natuurlijk ook de aanvraag uitzetten bij een van de vele (kleinere!) IT-providers, evt. gespecialiseerd in storage (voor het advies / de voorgestelde oplossing hoef je ze niet te betalennarotic schreef op vrijdag 15 april 2016 @ 17:02:

[...]

De 80TB is voornamelijk gebaseerd op (1) totale storage van de workstations (7x12TB) en (2) het maximale wat zo ongeveer in een enkel systeem kan. Het totale gebruik op de workstations is volgens mij nog <20TB, maar aangezien het van aanbesteding tot daadwerkelijke levering maanden kan duren is het niet makkelijk om er later even snel wat schijven bij te plaatsen. Vandaar de voorkeur om het "op de groei" te kopen zodat het voor de komende paar jaar in orde is.

[...]

SMR wil ik vermijden, dus dan blijven al snel de WD Red's over als relatief economische optie (helaas is het niet echt een optie in dit geval om de schijven uit WD My Book's te trekken). Deze machine is overigens juist bedoeld voor regelmatige backups van de workstations, ook zodat die meer performance kunnen bieden met een onveilige RAID0 setup.

[...]

Ik heb redelijk wat ervaring met FreeBSD/Linux+ZFS en ben meer op mijn gemak met de CLI dan web-interfaces, dus voor mij persoonlijk lijkt het me makkelijker een oplossing qua software te kiezen die ik al ken dan dat ik mijn weg moet vinden in een nieuw platform (inclusief interoperabiliteit met de Ubuntu workstations). Daarnaast is mijn rol voornamelijk voor de keuze van hardware en de inrichting van de software, niet zozeer voor het dagelijks onderhoud.

Wow, ik zie dat de SFF versie voor minder dan 150 euro op ebay staat. Paar reepjes geheugen en schijven erbij en je hebt een uitstekende storage oplossing voor een appel en een ei, helemaal als stroomverbruik en geluid niet van belang is (cold storage). Het is dat ik prive meer noodzaak heb aan rekenkracht dan opslag, anders...itcouldbeanyone schreef op vrijdag 15 april 2016 @ 20:02:

voor thuisgebruik ben ik mischien wel een buitenbeentje maargoed.

mijn workstation heeft 25TB , voor zijn backup heb ik een cold storage van 37.5tb hp dl180 g6, 25x 1.5tb 2.5inch sata rack formaat.

Dit is een 2u rack, plek voor 25 schijven, zou je daar 2tb in proppen, en 2 van die servers hebben, dan zit je al op 100tb in 4u, voor in verhouding een redelijke prijs

Gezien de titel van dit topic weet ik niet of het vloeken in de kerk is, maar ik denk dat je als serieuze thuisgebruiker vaak goedkoper en beter af bent met 2e hands enterprise spul dan met zelfbouw.

- = Step Into The Pit | Industrial Strength = -

Ik vermoed dat je het verschil kwijt bent in duurdere schijven. En trays, zo te zien zitten er bij een hoop op Ebay geen of weinig trays bij.narotic schreef op vrijdag 15 april 2016 @ 08:45:

Wow, ik zie dat de SFF versie voor minder dan 150 euro op ebay staat. Paar reepjes geheugen en schijven erbij en je hebt een uitstekende storage oplossing voor een appel en een ei

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

Een Lian Li PC-D8000 kan zonder geknutsel 20 schijven hebben. En met een 4 in 3 module nog 4 extra. Mijn plaatje in het ZFS topic laat zien dat er zelfs 36 stuks in passen. Die 20 zijn zonder backplanes niet hotswap maar dat kan wel met de los verkrijgbare hotswap backplanes. Al vond ik dat niet nodig want met de zijplaat eraf kan je overal makkelijk bij.narotic schreef op vrijdag 15 april 2016 @ 17:02:

De 80TB is voornamelijk gebaseerd op (1) totale storage van de workstations (7x12TB) en (2) het maximale wat zo ongeveer in een enkel systeem kan. Het totale gebruik op de workstations is volgens mij nog <20TB, maar aangezien het van aanbesteding tot daadwerkelijke levering maanden kan duren is het niet makkelijk om er later even snel wat schijven bij te plaatsen. Vandaar de voorkeur om het "op de groei" te kopen zodat het voor de komende paar jaar in orde is.

Er passen ook 2 voedingen in, als je een moederbord hebt wat daarmee overweg kan.

Enige wat ie niet is is compact want het is een log vierkant zwart niet te tillen monster met wieltjes.

Met 20x 6T in 2x 10 disk RAIDZ2 bv kom je een eind richting/voorbij je doel van 80T. Ik zou er dan nog 2 pools van maken liefst. Ik zou de 8T SMR schijven met ZFS nog even vermijden, dus gewone 6T schijven nemen.

Ik ben zoals je zegt sowieso van plan SMR schijven te vermijden, maar wat is er mis met de 8TB WD Reds? Tenzij ik me heel erg vergis zijn dat gewoon PMR schijven die per TB ongeveer net zoveel kosten (als je prijs/port etc. ook meerekent).

[ Voor 5% gewijzigd door narotic op 18-04-2016 22:04 ]

- = Step Into The Pit | Industrial Strength = -

Maar als je doel 80T is en je hebt een D8000 kast kan je ook met 6T schijven je doel halen.

Da's dan inderdaad gewoon even rekenen wat het handigste/goedkoopste/meest wenselijk is.

Bij die Proliant krijg je 8 drivebays er bij. De andere 16 moet je los aanschaffen. maar wel een mooie kast inderdaad.

[ Voor 20% gewijzigd door riwi op 18-04-2016 22:11 ]