Goedemorgen,

Ik weet niet of ik hier juist post, maar ik wil ook graag een eigen NAS/VMware server bouwen. Ik ben alleen niet meer zo op de hoogte van de hedendaagse hardware etc. Ik heb de config ongeveer gepikt van mijn collega en ben eigenlijk wel benieuwd of jullie nog op en aanmerkingen hebben.

Ik installeer ESXi.

VMs

3x linux

1x windows

Af en toe backtrack

Soms nog wat extra om te kloten

Verder gebruik ik geen RAID. Ik kan het prima verdelen over verschillende disken en maak altijd een externe backup.

Board:

Zotac H67 WIFI (Socket 1155, WiFi)

-Vanwege de 6 SATA aansluitingen. Wifi heb ik trouwens niet perse nodig!

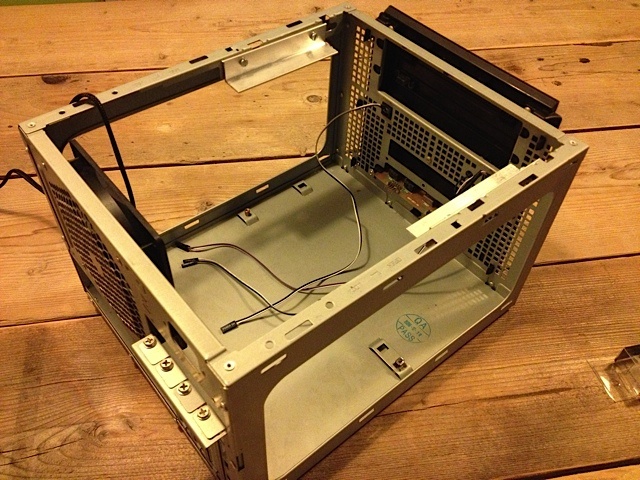

Case:

Fractal Design Array R2 Mini ITX NAS Behuizing 300W Zwart

-Mooi, klein, zuinig en 6 disken.

Geheugen:

Kingston 8GB PC3-10666 ValueRAM DDR3 SDRAM (2x 4GB, 1333MHz, CL9)

-Meer en sneller krijg ik er volgens mij niet in met deze config.

CPU:

Intel Core i5 3570K (Socket 1155, Boxed)

-Ik zie door de bomen het bos niet meer, wat is nou het beste model in ongeveer deze prijsklasse?

-Zit hier nou ook een cooler bij?

Disken:

Western Digital 250GB VelociRaptor (SATA-600, 3.5")

-Naar mijn mening hoe sneller hoe beter voor de VMs en ESXI installatie.

Western Digital 2TB Caviar Green (SATA-600, 3.5", 5400RPM, 64MB)

-Voor data, ik er nog nog een liggen, dus start met 4TB

Ik ben benieuwd of jullie nog tips en aanmerkingen hebben. Ik wil ook niet meer dan 750 euro uitgeven. Deze configuratie kost 650 euro

Ik weet niet of ik hier juist post, maar ik wil ook graag een eigen NAS/VMware server bouwen. Ik ben alleen niet meer zo op de hoogte van de hedendaagse hardware etc. Ik heb de config ongeveer gepikt van mijn collega en ben eigenlijk wel benieuwd of jullie nog op en aanmerkingen hebben.

Ik installeer ESXi.

VMs

3x linux

1x windows

Af en toe backtrack

Soms nog wat extra om te kloten

Verder gebruik ik geen RAID. Ik kan het prima verdelen over verschillende disken en maak altijd een externe backup.

Board:

Zotac H67 WIFI (Socket 1155, WiFi)

-Vanwege de 6 SATA aansluitingen. Wifi heb ik trouwens niet perse nodig!

Case:

Fractal Design Array R2 Mini ITX NAS Behuizing 300W Zwart

-Mooi, klein, zuinig en 6 disken.

Geheugen:

Kingston 8GB PC3-10666 ValueRAM DDR3 SDRAM (2x 4GB, 1333MHz, CL9)

-Meer en sneller krijg ik er volgens mij niet in met deze config.

CPU:

Intel Core i5 3570K (Socket 1155, Boxed)

-Ik zie door de bomen het bos niet meer, wat is nou het beste model in ongeveer deze prijsklasse?

-Zit hier nou ook een cooler bij?

Disken:

Western Digital 250GB VelociRaptor (SATA-600, 3.5")

-Naar mijn mening hoe sneller hoe beter voor de VMs en ESXI installatie.

Western Digital 2TB Caviar Green (SATA-600, 3.5", 5400RPM, 64MB)

-Voor data, ik er nog nog een liggen, dus start met 4TB

Ik ben benieuwd of jullie nog tips en aanmerkingen hebben. Ik wil ook niet meer dan 750 euro uitgeven. Deze configuratie kost 650 euro

:strip_icc():strip_exif()/u/254090/download.jpg?f=community)

/u/116116/crop5d1f40b3361f4_cropped.png?f=community)

:strip_icc():strip_exif()/u/4824/i.jpeg?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

(

(

:strip_exif()/u/24321/motor1.gif?f=community)

:strip_icc():strip_exif()/u/96747/gnu_linux_poster_60.jpg?f=community)

:strip_icc():strip_exif()/u/146731/crop562615a0aa64c.jpeg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_icc():strip_exif()/u/32546/crop5e623cef01555.jpeg?f=community)

/u/46983/multitasking.png?f=community)

:strip_exif()/u/396800/D-_3427da0a9c293b63f2a66dea2e642102.gif?f=community)

/u/231803/ramdisk2.png?f=community)

:strip_icc():strip_exif()/u/26028/penguin.jpg?f=community)

:strip_icc():strip_exif()/u/13869/loc.jpg?f=community)