lightdestroyer schreef op donderdag 9 november 2017 @ 07:58:

[...]

Het is niet dat het de eerste keer is dat ze dit doen.. iedereen is wellicht al het chipset debacle vergeten..

nVidia is toen ook van de markt geduwd (illegaal zo bleek later.. maar een zak met geld loste dat "probleempje" wel op...)

Als klant blijf je dan achter met 1 grote monopolist en een speler die blij us als hij al mag meedoen.. met alle gevolgen vandien. Alsof je mag blij zijn met de huidige chipsets.. lets face it: nog steeds usb2 headers??? Aparte duurdere chipsets xodat jr wel een multiplier hoger kan zetten.. yay

Of dat Intel heeft geprobeerd om Nvidia uit de PCI-E toegang te drukken, waarmee ze meteen failliet zouden zijn. Ik ben bekent met de meeste zakenpraktijken van zowel Intel, als Nvidia. Draai echt niet voor niks een all AMD systeem.

Als dat de toekomst van discrete/mid-end kaarten gaat worden..

Het is niet dat nVidia dit al niet jaren geleden zag aankomen (het is hen al eerder overkomen)

Hence hun push naar andere markten en ARM chips.

Wanneer de x86 markt nog verder zag stagneren (amper snellere cpu's, gpu's wegens geen concurrentie en nu al armzalige chipsets) zou het kunnen dat uiteindelijk de intelAMD socs het moeten afleggen tegen Apple/Quallcom/Samsung/nVidia en is AMD direct hun laatste troef kwijt hun x86 licentie.

En intel de noodzaak om AMD nog in leven te laten daar ze ver van een grote speler zijn op de soc markt.

Eigenlijk bezie ik heel deze actie van AMD als een oude man die potentieel zijn eigen graf graaft.

Ik zie nu al op reis dat ik constant op mn gsm werk/gebruik en mn surface letterlijk nog niet aangeraakt heb. Ik denk er serieus aan om mn volgende reis deze zelf volledig thuis te laten..

Hell hoeveel mensen betalen nu al niet elke 2 jaar het dubbele van hun laptop/pc die dan nog eens 6 jaar moet meegaan..

In dat opzicht scoort de shield super:support kodi support android en je krijgt een mooi marktaandeel in de toekomstige markt..

AMD heeft tot nu toe in die richting nog niets gedaan, toont niet echt de wil vsn innovativiteit due je als kleine speler nodig hebt.

Intel faalde ook tot nu toe, maar wie weet binnenkort poging nr3?

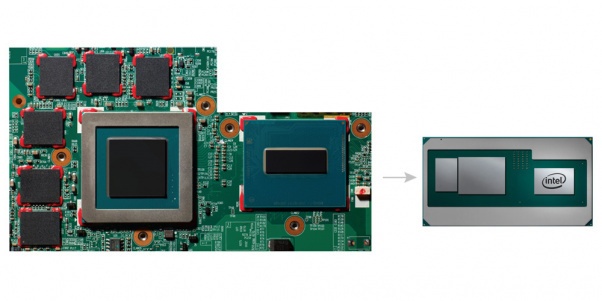

Ik ben er ook niet blij mee, maar begrijp de redenering van AMD wel. De gemiddelde consument is allergisch voor niet Intel. Ze kennen AMD niet eens. Heb je ook nog het eindeloze "AMD sucks" van mensen die werkelijk geen flauw idee hebben waar ze het over hebben. Dan moet je op een gegeven moment iets gaan doen als bedrijf. Als AMD nu via Intel een gigantische sprong kan maken in marktaandeel van GPU's dan is dat pure winst op termijn. Die gecombineerde Intel/AMD chip zal goedkoper zijn dan een Intel CPU en Nvidia GPU. De chip zelf, en dan ook nog goedkopere en kleinere moederborden. Het gaat voor AMD niet eens om er een miljard per jaar aan verdienen ofzo. Ik kwam tegen dat 10% van de mobiele laptopmarkt ongeveer $300 miljoen aan omzet waard zou zijn. Voor AMD is dat niet mals, zelfs als ze maar de helft zelf krijgen.

Nee, het gaat erom Nvidia in te halen door het lage en middensegment te veroveren, en ze er ook uit te houden. Menige game die dan beter op AMD zal draaien dan Nvidia vanwege optimalisaties. Het is ook de sleutel tot DX12 implementatie als de standaard.

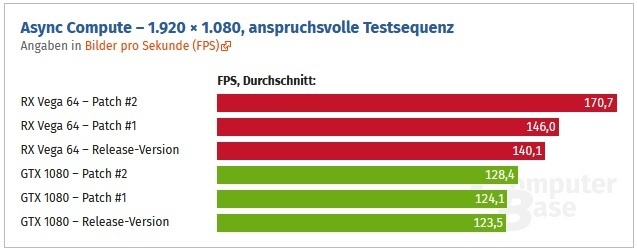

Nu Lisa Su de RTG ook bestuurt, verwacht ik ook de nodige veranderingen. Ik zou niet verbaast zijn als Vega de laatste Radeon monsterchip gaat zijn van AMD die we gaan zien in de komende jaren. De chip was overhyped, slecht geëxecuteerd, duur en zal weinig opleveren. Voor HPC taken is het wel een monster. Ik heb het al vaak gezegd, en ik blijf erbij. RX Vega 64 had nooit uitgebracht moeten worden. Reserveer al die chips voor HPC, en breng alleen de RX Vegs 56 uit, en gooi daar geen 1,2v tegenaan waarna die chips vrijwel meteen oververhit raken en downclocken.

Ik zou niet verbaast zijn als we weer een aantal jaar "HD38xx-HD58xx" krijgen. Geef Nvidia maar het absolute topsegment met hun dure monsterchips. Wij pakken alles daaronder en gaan volume draaien. Met Navi zou het moeten kunnen, ook qua prijs gezien de schaalbaarheidsgeruchten. Hoogste segment Navi is dan puur voor HPC, tenzij AMD echt met iets heel erg goeds komt dat Nvidia verslaat.

Aan de CPU kant denk ik dat de stagnatie van x86 meer te maken heeft met de enorme problemen die Intel heeft met nieuwe nodes, dan met echt technische barrières. Die laatste zijn ook enorm geworden, en spelen echt wel een rol, maar bij Intel speelt er meer. Ze hadden allang op 10nm moeten zitten volgens hun eigen roadmaps, en laatst waren er weer geruchten dat Cannon Lake nog een jaar uitgesteld zou gaan worden. Dan heeft AMD vrij spel om ze echt in te halen qua node met Zen 2. Zeker aangezien AMD onder Lisa Su een duidelijke strategie volgt. Ze kondigen niet meer maanden van tevoren aan wat ze gaan doen, of hoe snel het is. Nee, ze kondigen iets aan, houden bewust de prestaties geheim, en dan opeens vlak voor launch bam.

AMD heeft wel wat geprobeerd met ARM, namelijk servers maken, maar liep tegen problemen aan en legde toen de focus op Epyc. Terecht lijkt me, want de vraag naar meer en krachtigere servers zal blijven bestaan. De SoC divisie is nu eigenlijk de belangrijkste geworden voor AMD, en niet consumenten. Ze zijn redelijk vergelijkbaar qua omzet met de consumenten, maar bij de SoC zit potentieel veel meer groei. Epyc, Instinct MI25, console chips, Tesla, of nu Intel. Iedereen die een custom SoC wil, en een zak met geld heeft, kan bij AMD terecht. Waren er ook nog geruchten een tijdje terug dat AMD nu ook SoC GPU chips direct aan miners levert.

Dan Raja Koduri naar Intel. VERRADER.

(eigenlijk zit daar wel een kern van waarheid in

(eigenlijk zit daar wel een kern van waarheid in  )

)

Nah, hij gaat werken aan Nervana, de Intel AI chip in ontwikkeling tegenover Nvidia. Daar zit geld, en dat wil Intel hebben. Ze zijn niet alleen. Nvidia gaat daar nu uitgedaagd worden door Google die al flink bezig zijn, AMD en Intel.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

:fill(white):strip_exif()/i/2001668195.jpeg?f=thumbmini)

:strip_exif()/i/2001589189.png?f=thumbmini)

:strip_exif()/i/2001589233.png?f=thumbmini)

:fill(white):strip_exif()/i/2001589239.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2001589243.jpeg?f=thumbmini)

/u/324913/crop56a24cce05cd3_cropped.png?f=community)

:strip_icc():strip_exif()/u/92491/crop64a1593f33a7b_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/486359/crop5679254888b42_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/106305/crop5fef6b1a0c373_cropped.jpeg?f=community)

:strip_exif()/u/211274/bestabstractwallpapers5.gif?f=community)

:strip_icc():strip_exif()/u/293840/duif4.jpg?f=community)

:strip_icc():strip_exif()/u/7205/duke3.jpg?f=community)

:strip_icc():strip_exif()/u/45765/3dfx2.jpg?f=community)

:strip_icc():strip_exif()/u/342731/crop55cb221bc1b5c.jpeg?f=community)

/u/34200/crop6554f56fe2075_cropped.png?f=community)

:strip_icc():strip_exif()/u/168777/crop68f8f033b4e5f_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/496922/Balance%252060x60.jpg?f=community)

:strip_exif()/u/5079/tweak.gif?f=community)

/u/266427/41_2_6060.png?f=community)

:strip_icc():strip_exif()/u/280016/crop58a99242b659f_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/451377/crop55c27effefbb4_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/291146/crop5d31533862205_cropped.jpeg?f=community)

:strip_exif()/u/327460/cowboy.gif?f=community)

/u/400/defember100.png?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

:strip_exif()/u/547445/crop55bceb262206f.gif?f=community)