The only thing you need; a jar of "Elbow Grease" (TM) ! Apply it liberally and it will make any job a breeze.

Die prijs kun je nu nog proberen te krijgen omdat er genoeg ongeïnformeerde mensen zijn die niets weten over de 3000 reeks maar wel de prijzen ervan ineens betaalbaarder zien worden dan 3 maand ervoor. En hierdoor verleid kunnen worden.

Maar daar de 3070 al beter gaat zijn dan de 2080ti. Gesteld 50% beter. Zelfs al is het dan 30% dan zit je met de 3070 aan een recentere grafische kaart die splinternieuw is. die ietsie pietsie beter is.

350 - 400€ zie ik dan op termijn de markt er nog wel voor. Misschien zelfs 450 indien de 3000 reeks echt enorm moeilijk te verkrijgen is en AMD binnenkort hun kaart ook niet echt goed verkrijgbaar is.

Maar 500 en meer vragen voor zo'n kaart, neen dat gaat passé zijn. Op de uitzondering die de regel bevestigt na natuurlijk.

Als je een 1080p monitor koopt met 144Hz dan wil je, volgens mij, gewoon op de hoogste settings spelen zonder framedrops. Idealiter draait het spelletje dan 1080p 144fps gemiddeld of hoger. Dan kun je inderdaad beperkt zijn door de processor. Ik heb het eerder reeds aangegeven: als je een 1440p 144Hz scherm koopt en deze combineert met een 2070, 2080, de super varianten daarvan of de 2080Ti en je wil Doom Eternal spelen op maximale grafische kwaliteit, dan haalt geen van deze videokaarten gemiddeld 144Hz.

Zie, gemiddelde van 12 ganes. Die 3070 die gelijkaardig of iets beter moet presteren, haalt dat ook niet. Het verhaal wordt nog eens anders als je gaat praten over 1080p 240Hz of over de binnenkort beschikbare 360Hz panelen. G-sync of freesync proberen schommelingen op te vangen, maar als je mikt op maximale kwaliteit en een minimum gemiddelde gelijkaardig aan het aantal hertz, dan koop je een duurdere GPU.

Geef gerust advies over de combinatie processor en videokaart, maar loop niet te bepalen met welke monitor mensen moeten gamen.

Het is maar waar je interesses en eisen liggen:

Nee, joh. De RTX3070 zal ongeveer gelijk presteren aan een RTX 2080Ti en zal daar dus zeker geen 30-50% overheen gaan.RenegadexRIPxx schreef op zondag 6 september 2020 @ 11:30:

Maar daar de 3070 al beter gaat zijn dan de 2080ti. Gesteld 50% beter. Zelfs al is het dan 30% dan zit je met de 3070 aan een recentere grafische kaart die splinternieuw die ietsie pietsie beter is.

Nogmaals, mensen moeten lekker zelf weten wat ze doen. Er is niemand die zegt dat iets niet mag. Maar als jij mooier beeld wil hebben, dan ben je gewoon beter af om een 1440p monitor te hebben dan renderen op 4k en downscalen naar 1080p. Ik begrijp niet echt hoe daar een discussie over kan zijn.Flying schreef op zondag 6 september 2020 @ 11:31:

Geef gerust advies over de combinatie processor en videokaart, maar loop niet te bepalen met welke monitor mensen moeten gamen.

Het is maar waar je interesses en eisen liggen:

[Afbeelding]

En wat misschien iets persoonlijker is, maar ik zou altijd 100FPS op 1440p met medium-high presets prefereren boven 100FPS op 1080p met ulra presets.

Onder de streep lijkt het mij niet vreemd als iemand zich zorgen maakt dat de 3600 een bottleneck is voor zijn nieuwe GPU van €500-€800 te vragen of hij wel echt op 1080p gaat gamen.

[ Voor 10% gewijzigd door Sissors op 06-09-2020 12:01 ]

Zelfs boardpartners hebben de grootste moeite gehad met paper launches.

Ben zelf ook wel hyped gezien ik zelf nog op de gtx1080 zit en de 2080 serie over heb geslagen omdat de gains te klein waren en rtx voor mij geen toegevoegde waarde was.

En met mij zijn er nog miljoenen anderen die op de 10xx serie zijn blijven plakken, dus als de prestaties serieus x 1.7 gaan en de prijs halveert gaat nvidia deze kaarten niet aan kunnen leveren voor meerdere maanden.

Ik heb eerder dit mee gemaakt met de hypetrain ben niet overtuigd in ieder geval.

Ik wil base performance omhoog zien zonder dlss en rtx dit zei ik bij de 20xx serie ook had liever een 1680/90 gezien met dezelfde performance als de 2080ti zonder rtx.

Ik speel mijn games op low settings juist omdat ik hogere fps wil hebben de eyecandy doet mij niets als ik online game.

Beiden! Game voornamelijk op 4K tv, maar m'n pc monitor is helaas nog 1080p. 1080p games zullen CIV6 en Total War: Rome 2. 60 Hz is voor mij overigens prima bij de 4K games.Sissors schreef op zondag 6 september 2020 @ 10:04:

[...]

Waarom niet? 3600 is een prima CPU. Op welke resolutie speel je? Als het 1080p is, tja, dan zou het weleens je FPS kunnen gaan beperken, maar dan kom je al snel op de vraag waarom je in hemelsnaam een 3080 zou kopen voor 1080p.

Zal de benchmarks maar even afwachten.

Het is mij ook niet duidelijk waarom de CPU op 1080p een bottleneck kan zijn, maar vervolgens niet op 4K. Iemand een gemakkelijke uitleg?

[ Voor 3% gewijzigd door Vinnie84 op 06-09-2020 13:09 ]

NVIDIA GeForce RTX 3080: 168% of RTX 2080 performance

Stel ik ben de cpu, jij de gpu. Ik zeg tegen jou schilder deze muur van 4 bij 4, of ik zeg schilder deze muur van 8 bij 8. Dan ben ik niet langer bezig, maar jij wel.Vinnie84 schreef op zondag 6 september 2020 @ 13:05:

Het is mij ook niet duidelijk waarom de CPU op 1080p een bottleneck kan zijn, maar vervolgens niet op 4K. Iemand een gemakkelijke uitleg?

Mechwarrior Online: Flapdrol

Tuurlijk, dat begrijp ik. Maar als de bottleneck al in 1080p is, waarom dan niet in een hogere resolutie Zoals 4K?haarbal schreef op zondag 6 september 2020 @ 13:20:

[...]

Stel ik ben de cpu, jij de gpu. Ik zeg tegen jou schilder deze muur van 4 bij 4, of ik zeg schilder deze muur van 8 bij 8. Dan ben ik niet langer bezig, maar jij wel.

Omdat je GPU zoveel mogelijk FPS eruit probeert te pompen... Dan zit je op 300 FPS op 1080p.. dat kan een issue zijn voor de cpu om bij te benen (verschillende berekeningen in game)Vinnie84 schreef op zondag 6 september 2020 @ 13:23:

[...]

Tuurlijk, dat begrijp ik. Maar als ik de bottleneck al in 1080p is, waarom dan niet in een hogere resolutie Zoals 4K?

Je kan ook gewoon een FPS limit instellen als je op 1080p zit te gamen. Iets van 120fps ofzo. Dan kan je cpu het mogelijk wel weer bijbenen.

Bij bijvoorbeeld 4K speelt de videokaart een grotere rol en ben je meer videokaart afhankelijk. Lees dit onderstaande stukje. Heb ik even van Reddit geplukt.Vinnie84 schreef op zondag 6 september 2020 @ 13:23:

[...]

Tuurlijk, dat begrijp ik. Maar als ik de bottleneck al in 1080p is, waarom dan niet in een hogere resolutie Zoals 4K?

So imagine that the CPU is a professor assigning papers, and the GPU is the student who has to write them.

1080p is like the professor assigning a 5 paragraph open ended essay. No big deal, quick and easy for the GPU to complete. Give it back to the professor to grade and say "Okay done, give me the next assignment". This means the professor has to grade really frequently and have new prompts ready to go just about every class period, if not more often.

4k is like the CPU/professor assigning a 25-30 page in-depth research paper. It takes the GPU/student A LOT longer to complete something of that scale, so the professor doesn't have to grade nearly as much, and doesn't need to hand out new prompts very often because that one takes so long to complete.

This is how CPU/GPU work together to build the world. The CPU basically says "hey I need you to make this world", the GPU renders and says "Got it, next please", and then it repeats. If the GPU takes longer amount of time before it asks for the next frame, the CPU has to give less instruction.

AMD Ryzen 9 5900X • Gigabyte X570 Aorus PRO • G.Skill Ripjaws V F4-3600C16D-32GVKC • AMD Radeon RX 6900 XT • Samsung 850 EVO 1TB • Intel 660p 2TB • Corsair Obsidian 500D RGB SE • Corsair RM750x

Step dat op 1080 de CPU 100 instructies per seconde aan de GPU kan doorgeven, waarbij de GPU slechts 75% van de tijd mee bezig is om ze uit te voeren. De GPU kan meer aan, maar de CPU kan simpelweg niet meer dan 100 instructies doen en is 100% belast.Vinnie84 schreef op zondag 6 september 2020 @ 13:23:

[...]

Tuurlijk, dat begrijp ik. Maar als de bottleneck al in 1080p is, waarom dan niet in een hogere resolutie Zoals 4K?

Op 4k moet de GPU bijvoorbeeld dubbel zoveel werk verrichten om die 100 instructies te kunnen uitvoeren, oftewel 2x75% belasting. Dat kan natuurlijk niet, de GPU kan maar 100% belast worden. Het aantal instructies dat van de CPU aangenomen kan worden ligt daarmee lager dan 100. En op die manier is de CPU dus minder dan 100 instructies per seconde bezig, en daalt het CPu verbruik naar onder de 100%.

In het eerste geval is je CPU de bottleneck en op 100% bezig, in het tweede geval is je GPU de bottleneck.

Programmer's Drinking Song: 99 little bugs in the code, 99 bugs in the code, Fix one bug, compile it again, 100 little bugs in the code. (go to start if bugs>0)

Klinkt logisch!Pikkemans schreef op zondag 6 september 2020 @ 13:26:

[...]

Omdat je GPU zoveel mogelijk FPS eruit probeert te pompen... Dan zit je op 300 FPS op 1080p.. dat kan een issue zijn voor de cpu om bij te benen (verschillende berekeningen in game)

Je kan ook gewoon een FPS limit instellen als je op 1080p zit te gamen. Iets van 120fps ofzo. Dan kan je cpu het mogelijk wel weer bijbenen.

Wat is een goede manier om de FPS limiet in te stellen?

[ Voor 9% gewijzigd door dion_b op 08-09-2020 09:40 ]

Als je echter van 24 inch 1080p naar 32 inch 1440p haat word je beeld niets mooier alleen groter. De dot-pitch blijft immers exact hetzelfde. ga je voor 27 inch dan is het wel een puntje.Sissors schreef op zondag 6 september 2020 @ 10:28:

[...]

Als je doel is mooier beeld, dan ben je een stuk beter af om een 1440p monitor te kopen, dan om een dure GPU te kopen zodat je kan renderen op 4k en dan downscalen naar je 1080p scherm.

En ik ga ook gewoon een 3080 kopen en zal voorlopig op 1080 blijven er is immers nog geen scherm met mijn wensen beschikbaar op 1440p (ips 32 inch flat 144hz en gsync compatible).

En zo gek is die gedachte helemaal niet. bij de 2080TI werd hetzelfde gezegd. En toen kwam echter RDR2 die niet eens 120 fps haalt op 1080p ultra. en een aantal andere recente games kunnen het ook niet. en dat zal met de komst van consoles alleen maar meer en meer worden. 3080 op 1080p is dus niets mis mee en meer toekomstbestendig als 1440p.

Of iemand medium settings 1440p of ultra settings 1080p mooier vind is dan weer een persoonlijk verhaal. Ik kies voor het 2de gezien ik nog op 24 inch zit. Moet er wel bij vertellen dat ik 1080p over 24 inch onacceptabel vind.

Verder werkt downscalen op 1080p of render resolutie opschroeven wel mar meer als van 100 naar 35% kan ik niet meer zien dis 4k downscalen is echt nutteloos wat mij betreft 1440p heeft wel nut. Al werkt het niet met alles. sommige games worden er duidelijk wazig van.

Tja dat is nou net vraag en aanbod. De Vraag is er alleen voor 500 of minder. Het is immers 2de hands en volgens wat er nu bekend is is de nieuwe kaart even snel en sneller in andere delen met meer feateus voor 500. Dus als dat waar is moeten mensen met een 2080TI die hem willen verkopen in hun handjes knijpen met een bod van 500. Ik zou het er niet voor geven.TRAXION schreef op zondag 6 september 2020 @ 10:45:

Maar ik kwam richting dit topic vanwege alle vraag advertenties in v&a waarbij mensen verwachten een 2080ti te kunnen bemachtigen voor minder de 500 euro en zelfs gtx1080 gevraagd word voor €150,-.

Dit is toch niet realistisch?

Ik wil eerst de benchmarks zien ik geloof best dat er 50% gains zijn met rtx en dlss vanwege de tensor core upgrade.

Of het aanbod er zal zijn is een ander punt maar de vraag is er alleen voor die prijs en die vind ik veel te redelijk en als ik van plan was een 3090 of 3090 te kopen zou ik er dan ook direct op in gaan.

Tja ik zit hier ook met een 1070 al tijden te wachten op iets dat echt een wow effect heeft zonder een oh no prijs. Mijn gamer hart zegt nu 3080 maar mijn portemonnee nog altijd 3070 gelukkig zegt mijn grijze massa wacht even op rdna2. We gaan wel zien wat het gaat worden maar dat de 1070 eruit moet is een feit na 4 jaar.TRAXION schreef op zondag 6 september 2020 @ 12:48:

Ben zelf ook wel hyped gezien ik zelf nog op de gtx1080 zit en de 2080 serie over heb geslagen omdat de gains te klein waren en rtx voor mij geen toegevoegde waarde was.

En met mij zijn er nog miljoenen anderen die op de 10xx serie zijn blijven plakken, dus als de prestaties serieus x 1.7 gaan en de prijs halveert gaat nvidia deze kaarten niet aan kunnen leveren voor meerdere maanden.

Top, dank voor de uitleg.Brainstorm schreef op zondag 6 september 2020 @ 13:28:

[...]

Step dat op 1080 de CPU 100 instructies per seconde aan de GPU kan doorgeven, waarbij de GPU slechts 75% van de tijd mee bezig is om ze uit te voeren. De GPU kan meer aan, maar de CPU kan simpelweg niet meer dan 100 instructies doen en is 100% belast.

Op 4k moet de GPU bijvoorbeeld dubbel zoveel werk verrichten om die 100 instructies te kunnen uitvoeren, oftewel 2x75% belasting. Dat kan natuurlijk niet, de GPU kan maar 100% belast worden. Het aantal instructies dat van de CPU aangenomen kan worden ligt daarmee lager dan 100. En op die manier is de CPU dus minder dan 100 instructies per seconde bezig, en daalt het CPu verbruik naar onder de 100%.

In het eerste geval is je CPU de bottleneck en op 100% bezig, in het tweede geval is je GPU de bottleneck.

Dank voor het delen!RobinNL schreef op zondag 6 september 2020 @ 13:27:

[...]

Bij bijvoorbeeld 4K speelt de videokaart een grotere rol en ben je meer videokaart afhankelijk. Lees dit onderstaande stukje. Heb ik even van Reddit geplukt.

[...]

Ipc van 20% op de cuda cores geloof ik ook nog wel maar het is niet dat we 8096 cudacores krijgen.

Wat ik veel interessanter vind deze generatie is pcie4 icm rtx-io wat dynamic loading mogelijk maakt.

Maar we gaan het wel zien als de kaarten daadwerkelijk in een user case gebruikt word.

Het zijn er ook geen 8096 voor de RTX3080. Nee, het zijn er 8704.TRAXION schreef op zondag 6 september 2020 @ 14:06:

Mijn vermoeden is dat rtx/dlss 1.7x sneller word gezien er veel meer tensor cores in de nieuwe die verwerkt wordt.

Ipc van 20% op de cuda cores geloof ik ook nog wel maar het is niet dat we 8096 cudacores krijgen.

Wat ik veel interessanter vind deze generatie is pcie4 icm rtx-io wat dynamic loading mogelijk maakt.

Maar we gaan het wel zien als de kaarten daadwerkelijk in een user case gebruikt word.

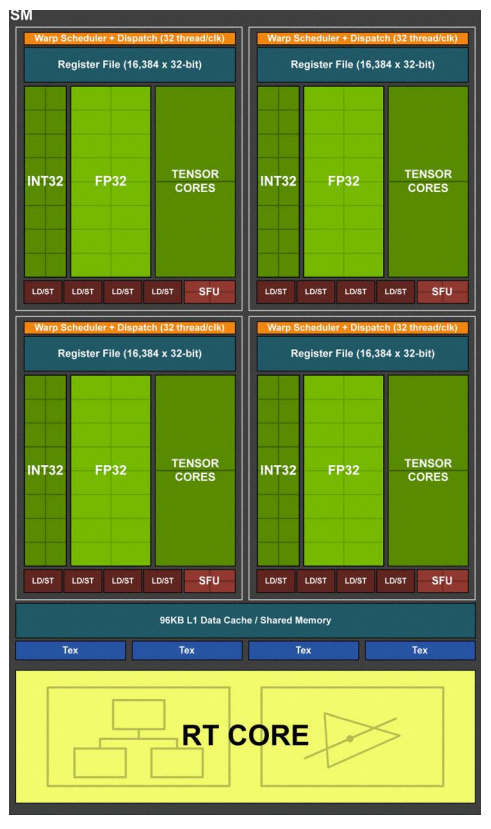

Je hebt er meestal alleen weinig aan. Zoals @Werelds al uitlegde is het INT of FP per warp. Een videokaart werkt op het principe van het groeperen van berekeningen. Zowel AMD als Nvidia hebben een formaat van maximaal 32 threads gekozen per rekencluster. Nvidia noemt die blokken van maximaal 32 threads, warps en AMD noemt ze waves.

Ampere kan in tegenstelling tot Turing wel weer maximaal 32 FP32 threads doen. Dit kan Ampere alleen als er geen enkele INT thread in die warp zit, want dan gaat de boel terug naar maximaal 16 FP32 en 16 INT32 threads per clock cycle. Het probleem is dat Nvidia eigenlijk ook al heeft aangeven dat er weinig situaties zijn waar dit wat extra gaat opleveren. Het lijkt op SM basis in totaal iets van 30% extra op te gaan leveren over Turing. Dat betekent ook niet dat 30% van alle warps ook echt 32 FP32 threads hebben. Het zal een gemiddelde zijn en het gaat sterk per game verschillen.

Hierom kan je Nvidia hun eigen benchmarks of die van Digital Foundry dus niet geloven. Die zullen geselecteerd zijn voor maximaal effect.

Ampere

Turing

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Zo diep had ik het nog niet bekeken, dus zoals je aangeeft hierboven vermoed ik dat de benchmarks redelijk cherry picked zijn.DaniëlWW2 schreef op zondag 6 september 2020 @ 15:06:

[...]

Het zijn er ook geen 8096 voor de RTX3080. Nee, het zijn er 8704.

Je hebt er meestal alleen weinig aan. Zoals @Werelds al uitlegde is het INT of FP per warp. Een videokaart werkt op het principe van het groeperen van berekeningen. Zowel AMD als Nvidia hebben een formaat van maximaal 32 threads gekozen per rekencluster. Nvidia noemt die blokken van maximaal 32 threads, warps en AMD noemt ze waves.

Ampere kan in tegenstelling tot Turing wel weer maximaal 32 FP32 threads doen. Dit kan Ampere alleen als er geen enkele INT thread in die warp zit, want dan gaat de boel terug naar maximaal 16 FP32 en 16 INT32 threads per clock cycle. Het probleem is dat Nvidia eigenlijk ook al heeft aangeven dat er weinig situaties zijn waar dit wat extra gaat opleveren. Het lijkt op SM basis in totaal iets van 30% extra op te gaan leveren over Turing. Dat betekent ook niet dat 30% van alle warps ook echt 32 FP32 threads hebben. Het zal een gemiddelde zijn en het gaat sterk per game verschillen.

Hierom kan je Nvidia hun eigen benchmarks of die van Digital Foundry dus niet geloven. Die zullen geselecteerd zijn voor maximaal effect.

Ampere

[Afbeelding]

Turing

[Afbeelding]

Ik wacht wel af wat de kale resultaten zijn zonder dlss en rtx.

Ik wil gewoon 200fps op bf6 1440p low settings.

Of nvidia moet stiekem nog een 1860/70/80, in de pijplijn hebben welke gewoon 3080 performance heeft zonder tensor/rtx cores.

Ach ja, dat was de 3080 die er 50% over ging gaan.choogen schreef op zondag 6 september 2020 @ 11:50:

[...]

Nee, joh. De RTX3070 zal ongeveer gelijk presteren aan een RTX 2080Ti en zal daar dus zeker geen 30-50% overheen gaan.

Dan nog is het een kaart die 2 jaar oud is. Doet de 3070 hetzelfde en soms beter in sommige punten, is het een nieuwe kaart inclusief garantie en is de nieuwprijs daarvan 519€ indien je ze te pakken krijgt.

Waarom zou 500€ dan een goede prijs zijn op de tweedehandse markt voor die ti? Zoals gezegd 350 - 400€ lijkt dan logischer met in het begin tgv slechte verkrijgbaarheid 450€. En ik zou mijn pollekes kussen indien je een zot tegenkomt die er 500€ voor wilt geven.

Dan ga je voorlopig naast de pot plassen als je op zoek bent naar een 3080 en je 2080TI redelijk wilt verkopen.mitsumark schreef op zondag 6 september 2020 @ 16:04:

Laten we echte benchmarks afwachten voordat we de waarde van een 2080ti gaan "inschatten".

Ja, of niet.MaXeRs schreef op zondag 6 september 2020 @ 16:14:

[...]

Dan ga je voorlopig naast de pot plassen als je op zoek bent naar een 3080 en je 2080TI redelijk wilt verkopen.

We weten namelijk niet wat redelijk is.

[ Voor 7% gewijzigd door mitsumark op 06-09-2020 16:21 ]

Soms kan je het instellen in de game zelf maar het is altijd mogelijk om dat via de driver software te doen. Welke methode het beste is hangt volgens mij van een paar dingen af.Vinnie84 schreef op zondag 6 september 2020 @ 13:41:

[...]

Klinkt logisch!

Wat is een goede manier om de FPS limiet in te stellen?

Hier een uitgebreid filmpje daarover.

Kunnen we niet gewoon stoppen met dit.mitsumark schreef op zondag 6 september 2020 @ 16:20:

[...]

Ja, of niet.

We weten namelijk niet wat redelijk is.

Verkopers bepalen hun prijs en kopers bepalen hun prijs.

Als die twee dingen bij elkaar komen dan komt er een deal tot stand.

Indien niet dan moet een van de twee opschuiven richting de ander.

Simpel as that.

En dat 20XX eigenaren niet zo maar honderden euro's willen afschrijven in een paar maanden begrijp ik ook wel.

En het goede nieuws is, dat als ze hem niet kwijtraken tegen de door hun gewenste prijs dan kun je altijd nog gewoon doorgamen met zo een kaart. Zal zeker niet het einde van de wereld zijn.

Er is altijd wel iets beters, maar dat wil niet zeggen dat je dat betere ook altijd wilt. (voor het geld dat je daarvoor over hebt)

Of wat een cpu had gedaan als we de tensor core eruit laten en daat 16 extra fp32 in zouden proppen.

We zullen het helaas nooit weten.

Het lijkt me echt geweldig als je ooit dit soort custom design layouts on demand zou kunnen bestellen puur om te testen. Ze zullen het vast inhouse wel doen maar die resultaten zien nooit het daglicht.

De op TSMC GA100 heeft trouwens 12288 van wat ik net even van de die shot berekend heb. dus nog een volle 20% meer dan de 3090 en lijk 40 GB HBM2 te krijgen.

Als ze echt moeten kunnen ze dus nog een extra duit in de zak doen tegen amd. Ben benieuwd of er benches komen waaruit we het samsung vs TSMC procede kunnen berekenen.

[ Voor 25% gewijzigd door computerjunky op 06-09-2020 19:27 ]

Volgens mij alleen bij de Nvidia shop:JoepD schreef op zondag 6 september 2020 @ 19:48:

Een vraagje tussendoor: Waar zijn de Founders Edition kaarten van nVidia straks te koop? Gewoon in de bekende webshops?

https://www.nvidia.com/nl-nl/geforce/buy/

Hè? Hoe wil jij dat van een die shot "berekend" hebben? GA100 heeft 6912 FP32 ALU's en 6912 INT32 ALU's. Hij lijkt geen 40 GB HBM2 te krijgen, dat heeft hij. Het ding is al maanden geleden officiëel uitgebracht. En nee, daar kun je niets uit afleiden hij zit enkel in DGX.computerjunky schreef op zondag 6 september 2020 @ 19:21:

De op TSMC GA100 heeft trouwens 12288 van wat ik net even van de die shot berekend heb. dus nog een volle 20% meer dan de 3090 en lijk 40 GB HBM2 te krijgen.

Als ze echt moeten kunnen ze dus nog een extra duit in de zak doen tegen amd. Ben benieuwd of er benches komen waaruit we het samsung vs TSMC procede kunnen berekenen.

Nou dan presteerde die waarschijnlijk minder. Maar het gaat niet gebeuren want Nvidia gebruikt al heel erg lang warp32 en AMD is met RDNA effectief overgegaan op warp32, ze noemen het alleen wave32. Dat is gewoon de standaard. Maar het zegt toch afdoende dat Nvidia nog steeds 16 INT32 ALU's als afdoende beschouwd?computerjunky schreef op zondag 6 september 2020 @ 19:21:

Toch ben ik benieuwd wat onder de streep bet verschil geweest zou zijn als ze 24x FP32 x4 +24 INT32 hadden gedaan ipv de huidige 32x FP32 en 16x INT32

Dat RDNA nu een CU heeft waar de ALU's max 32x FP32, 32x INT32, 64x FP16 of 64x INT16 per clock cycle kunnen, tja dat is AMD voor je. Die stoppen al jaren meer veelzijdige hardware in een chip. Daar duurt het meestal alleen langer voordat games er gebruik van maken. Nieuwe ronde, nieuwe kansen met de PS5 en XSX, maar het is afwachten. AMD zou namelijk maar wat graag zien dat developers half precision (dus 16 bit) gaan gebruiken waar het maar kan. Immers 2x voor RDNA.

Nvidia is alleen verdomd goed in precies inschatten (en afdwingen want marktpositie) wat games nodig hebben als ze een nieuwe chip lanceren en afdoende zijn voor de effectieve levensduur van die chip. Langzaam maar zeker beginnen Pascal chips namelijk terrein te verliezen ten opzichte van Turing. De leren jasjes man suggereerde ook echt niet zomaar dat je nu veilig kan upgraden van Pascal.

Dat weten we wel, namelijk veel slechtere RT dan in Turing en geen DLSS. Oh en omdat Nvidia waarschijnlijk nog steeds warp32 gebruikt en dit steeds meer de defacto standaard is, tja heel wat extra ALU's die dus helemaal niks doen.Of wat een cpu had gedaan als we de tensor core eruit laten en daat 16 extra fp32 in zouden proppen.

We zullen het helaas nooit weten.

GA100 is maanden geleden al gelanceerd en simpelweg niet vergelijkbaar met de rest van Ampere. Het is eigenlijk nauwelijks Ampere meer, maar meer haar eigen architectuur die wat zaken van Ampere leent. Zeker nu GA100 op TSMC zit en de rest op Samsung.Het lijkt me echt geweldig als je ooit dit soort custom design layouts on demand zou kunnen bestellen puur om te testen. Ze zullen het vast inhouse wel doen maar die resultaten zien nooit het daglicht.

De op TSMC GA100 heeft trouwens 12288 van wat ik net even van de die shot berekend heb. dus nog een volle 20% meer dan de 3090 en lijk 40 GB HBM2 te krijgen.

Als ze echt moeten kunnen ze dus nog een extra duit in de zak doen tegen amd. Ben benieuwd of er benches komen waaruit we het samsung vs TSMC procede kunnen berekenen.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik zou er niet op rekenen, zeker nu AMD ook hardware ray tracing krijgt en de consoles het hebben gaat de hoeveelheid games die het gebruiken flink toenemen. Daarnaast zitten de RT cores ingebakken in de die waardoor je echt een compleet andere chip nodig hebt en die dus z'n eigen lijnen bij de fab moet geven. Op de higher end zijn die dies al gevoeliger voor fouten (een slechte 3080 die kun je gebruiken als een 3070 of zelfs 3060 afhankelijk van schade), Dit is vermoedelijk ook al waarom je in de 20 series geen 1670 of 1680 had. De 1660 en 1650 chips zijn veel makkelijker in massa te produceren. Ook zouden ze hun eigen 30XX verkopen kanibaliseren door mensen een (goedkopere) uitgeklede optie te bieden en zouden ze hun board partners frustreren door meer sku's in de markt te brengen waar weer AIB designs voor moeten komen. Ten slotte hebben zelfs de retailers er een hekel aan omdat ze dan meer voorraad moeten aanbouwen van kaarten die ze mogelijk niet verkopen.TRAXION schreef op zondag 6 september 2020 @ 15:15:

[...]

Zo diep had ik het nog niet bekeken, dus zoals je aangeeft hierboven vermoed ik dat de benchmarks redelijk cherry picked zijn.

Ik wacht wel af wat de kale resultaten zijn zonder dlss en rtx.

Ik wil gewoon 200fps op bf6 1440p low settings.

Of nvidia moet stiekem nog een 1860/70/80, in de pijplijn hebben welke gewoon 3080 performance heeft zonder tensor/rtx cores.

Dus nee, ik durf er gif op in te nemen dat je geen highend Ampere GPU zonder RT en DLSS krijgt. Bij de 20 series was die kans er nog maar bij 30 is die uitgedoofd.

De markt voor 1060 kaarten consorten is vele malen groter dan 2060 en hoger, meeste mensen geven 250 euro uit aan een gpu en vinden het wel welletjes enkel de fanatiekelingen kopen kaarten van 500+ en weet nu al dat 90% van de markt toch uit de kaarten tot 250 euro zit.Centurius schreef op zondag 6 september 2020 @ 21:38:

[...]

Ik zou er niet op rekenen, zeker nu AMD ook hardware ray tracing krijgt en de consoles het hebben gaat de hoeveelheid games die het gebruiken flink toenemen. Daarnaast zitten de RT cores ingebakken in de die waardoor je echt een compleet andere chip nodig hebt en die dus z'n eigen lijnen bij de fab moet geven. Op de higher end zijn die dies al gevoeliger voor fouten (een slechte 3080 die kun je gebruiken als een 3070 of zelfs 3060 afhankelijk van schade), Dit is vermoedelijk ook al waarom je in de 20 series geen 1670 of 1680 had. De 1660 en 1650 chips zijn veel makkelijker in massa te produceren. Ook zouden ze hun eigen 30XX verkopen kanibaliseren door mensen een (goedkopere) uitgeklede optie te bieden en zouden ze hun board partners frustreren door meer sku's in de markt te brengen waar weer AIB designs voor moeten komen. Ten slotte hebben zelfs de retailers er een hekel aan omdat ze dan meer voorraad moeten aanbouwen van kaarten die ze mogelijk niet verkopen.

Dus nee, ik durf er gif op in te nemen dat je geen highend Ampere GPU zonder RT en DLSS krijgt. Bij de 20 series was die kans er nog maar bij 30 is die uitgedoofd.

https://store.steampowere...e-Survey-Welcome-to-Steam

45% van alle steam gebruikers heeft een 1060 pak een amd equivalent erbij en je zal zien dat 90% van de gebruikers een kaart heeft onder 1060 specs.

Dus je kan wel denken maar uiteindelijk bepaald de markt welke kaart er nodig is, maar goed ben al vanaf dat de matrox g400 uitkwam hyped en sinds die tijd elke release meegemaakt van elke ati/amd en nvidia kaart.

Ik ken deze marketing ondertussen wel uiteindelijk valt het altijd tegen, dit is gewoon het marketings moment welke gigantisch uitgemolken wordt.

Deze kaarten zullen vast sneller zijn dan de vorige gen maar ik verwacht geen wonders als nvidia ergens goed in is is het het melken van hun tech ze geven elke keer een klein beetje extra idem met intel dat is gewoon de enige manier om hun research eruit te krijgen.

Dus totdat AMD met een flinke knaller komt verwacht ik niet de gains zoals die nu aangegeven worden en gaan, zoals ik eerder aangaf rtx en dlss zullen flink profiteren van de extra die ruimte maar kwa rauwe performance verwacht ik niet meer dan 10% ipc verbetering.

Maar over enkele dagen gaan we het zien

Je zou je bijna afvragen waarom AMD dan nog moeite neemt om een high-end videokaart te ontwikkelen.TRAXION schreef op zondag 6 september 2020 @ 21:51:

[...]

De markt voor 1060 kaarten consorten is vele malen groter dan 2060 en hoger, meeste mensen geven 250 euro uit aan een gpu en vinden het wel welletjes enkel de fanatiekelingen kopen kaarten van 500+ en weet nu al dat 90% van de markt toch uit de kaarten tot 250 euro zit.

https://store.steampowere...e-Survey-Welcome-to-Steam

45% van alle steam gebruikers heeft een 1060 pak een amd equivalent erbij en je zal zien dat 90% van de gebruikers een kaart heeft onder 1060 specs.

Ja dat is de mid-range en low end markt, let eens goed op wat ik schreef.TRAXION schreef op zondag 6 september 2020 @ 21:51:

[...]

De markt voor 1060 kaarten consorten is vele malen groter dan 2060 en hoger, meeste mensen geven 250 euro uit aan een gpu en vinden het wel welletjes enkel de fanatiekelingen kopen kaarten van 500+ en weet nu al dat 90% van de markt toch uit de kaarten tot 250 euro zit.

https://store.steampowere...e-Survey-Welcome-to-Steam

45% van alle steam gebruikers heeft een 1060 pak een amd equivalent erbij en je zal zien dat 90% van de gebruikers een kaart heeft onder 1060 specs.

Dus je kan wel denken maar uiteindelijk bepaald de markt welke kaart er nodig is, maar goed ben al vanaf dat de matrox g400 uitkwam hyped en sinds die tijd elke release meegemaakt van elke ati/amd en nvidia kaart.

Ik ken deze marketing ondertussen wel uiteindelijk valt het altijd tegen, dit is gewoon het marketings moment welke gigantisch uitgemolken wordt.

Deze kaarten zullen vast sneller zijn dan de vorige gen maar ik verwacht geen wonders als nvidia ergens goed in is is het het melken van hun tech ze geven elke keer een klein beetje extra idem met intel dat is gewoon de enige manier om hun research eruit te krijgen.

Dus totdat AMD met een flinke knaller komt verwacht ik niet de gains zoals die nu aangegeven worden en gaan, zoals ik eerder aangaf rtx en dlss zullen flink profiteren van de extra die ruimte maar kwa rauwe performance verwacht ik niet meer dan 10% ipc verbetering.

Maar over enkele dagen gaan we het zien

Daarnaast is de verwachting dat je deze generatie raytracing krijgt tot en met de X50's. Ervan uitgaande dat ze het model van de oude generatie aanhouden krijg je dan een RTX 3060 voor zo'n $349, mogelijk een RTX 3050 Ti/Super voor $299 en een RTX 3050 voor $249. Oftewel precies dat prijspunt dat jij noemde, waarbij de 3050 waarschijnlijk de performance zal hebben van een RTX 2060.Dus nee, ik durf er gif op in te nemen dat je geen highend Ampere GPU zonder RT en DLSS krijgt. Bij de 20 series was die kans er nog maar bij 30 is die uitgedoofd.

De vorige generatie waren kaarten met de performance om ray tracing te doen met RT cores simpelweg niet goedkoop genoeg te krijgen waardoor ze geen keus hadden dan een GTX variant te lanceren in de budget markt. Deze generatie is dat anders, en is het een stuk goedkoper en efficiënter voor alle betrokken partijen om één lijn van producten te hebben. Dat leer je al in een HBO klas marketing.

Marketing en strategie zijn 2 verschillende takken van sport.Centurius schreef op zondag 6 september 2020 @ 23:16:

[...]

Ja dat is de mid-range en low end markt, let eens goed op wat ik schreef.

[...]

Daarnaast is de verwachting dat je deze generatie raytracing krijgt tot en met de X50's. Ervan uitgaande dat ze het model van de oude generatie aanhouden krijg je dan een RTX 3060 voor zo'n $349, mogelijk een RTX 3050 Ti/Super voor $299 en een RTX 3050 voor $249. Oftewel precies dat prijspunt dat jij noemde, waarbij de 3050 waarschijnlijk de performance zal hebben van een RTX 2060.

De vorige generatie waren kaarten met de performance om ray tracing te doen met RT cores simpelweg niet goedkoop genoeg te krijgen waardoor ze geen keus hadden dan een GTX variant te lanceren in de budget markt. Deze generatie is dat anders, en is het een stuk goedkoper en efficiënter voor alle betrokken partijen om één lijn van producten te hebben. Dat leer je al in een HBO klas marketing.

De markt bepaald de vraag en als bedrijf zijnde bedien je de markt.

Als het over efficiëntie zou gaan zou ieder bedrijf nog maar 1 lijn maken waardoor je markt zo smal is dat er geen keuze is.

Nvidia heeft al jaren verschillende dies in hun gpu lijnen dit is echt niet een volle core en de afgekeurde cores gaan door als lager nummer.

Zelfde architectuur jazeker maar een compleet ander ontwerp om meer dies uit het silicum te kunnen halen.

Of dacht je dat een Intel i3 dezelfde core heeft als een i9 die afgekeurd is?

Daarnaast is het als bedrijf zeer onverstandig om alles te gokken op 1 ontwerp.

Er is meer dan de gaming markt, clusters vol gpus met meer taken dan enkel 3d weergave.XWB schreef op zondag 6 september 2020 @ 22:30:

[...]

Je zou je bijna afvragen waarom AMD dan nog moeite neemt om een high-end videokaart te ontwikkelen.

Welke vele malen betere marges hebben dan een gaming kaart.

Tensor cores zijn ontwikkeld voor andere taken,

https://www.nvidia.com/en-us/data-center/tensor-cores/

Dat er toepassing ontwikkeld worden welke doorsijpelen naar de gaming markt is niet vreemd.

Dat het nu in consoles komt is ook prachtig en de toepassing geweldig.

Is het nodig? Immers zonder kunnen we nog steeds prachtig een spelletje spelen.

Kijk naar andere markten en je ziet dat technologie bijna altijd van de prosumer doorstroomt naar de consumer market wat hier niets anders is.

Adaptatie is waar het probleem ligt hele volksstammen spelen nog oude games of geven simpelweg niets om rtx maar willen gewoon een spelletje spelen.

Ik koop normaal gesproken elke generatie een nieuwe kaart en heb dit vanaf mijn eerste voodoo 3dfx kaart gedaan de 20xx serie is de eerste die ik overgeslagen heb omdat rtx mij te weinig doet.

Games zien er al machtig mooi uit en ik kies voor meer fps.

De mensen met rtx kaarten die ik ken hebben rtx steevast uitstaan in multiplayer games omdat ze nadeel ondervinden ten opzichte van mensen die op low settings spelen.

Maar goed zoals ik al zei pas als ik harde cijfers zie ben ik overtuigd.

Maar het minimaliseren van de hoeveelheid productlijnen is absoluut wel iets dat ieder bedrijf wil. Waarom denk je dat Apple maar een beperkt aantal iPhones tegelijkertijd in productie heeft?TRAXION schreef op maandag 7 september 2020 @ 00:47:

[...]

Marketing en strategie zijn 2 verschillende takken van sport.

De markt bepaald de vraag en als bedrijf zijnde bedien je de markt.

Als het over efficiëntie zou gaan zou ieder bedrijf nog maar 1 lijn maken waardoor je markt zo smal is dat er geen keuze is.

Nvidia heeft al jaren verschillende dies in hun gpu lijnen dit is echt niet een volle core en de afgekeurde cores gaan door als lager nummer.

Zelfde architectuur jazeker maar een compleet ander ontwerp om meer dies uit het silicum te kunnen halen.

Of dacht je dat een Intel i3 dezelfde core heeft als een i9 die afgekeurd is?

Daarnaast is het als bedrijf zeer onverstandig om alles te gokken op 1 ontwerp.

De markt bepaalt de vraag, maar welke vraag is er voor een GTX 2660/70/80 wanneer je de RTX 3050 al voor het $249 of lager prijspunt kunt krijgen? Er is een reden dat Nvidia de gpu's niet naarbeneden laat gaan naar x10. Er is geen vraag voor. Vorige generatie was er een vraag omdat de goedkoopste RTX gpu te duur was. Deze keer is dat door de performance verbeteringen anders. Als ze het willen kunnen ze zelfs de bestaande 2060 lijn gewoon laten doorproduceren en het 3050 noemen zoals wel vaker gedaan is in GPU land. Wanneer de markt RTX gpu's kan krijgen voor de prijs die ze willen betalen is er geen vraag naar een uitgeklede variant. En Nvidia gaat niet de verkopen van z'n mid-end of zelfs high-end kaarten (zoals jij lijkt te denken met een GTX 2680) kanibaliseren door een productlijn die meer geld kost en minder oplevert.

Een 3050 zal net als de 2060 onvoldoende rt cores hebben om een scène op 30 fps neer te zetten bij 1080pCenturius schreef op maandag 7 september 2020 @ 01:19:

[...]

Maar het minimaliseren van de hoeveelheid productlijnen is absoluut wel iets dat ieder bedrijf wil. Waarom denk je dat Apple maar een beperkt aantal iPhones tegelijkertijd in productie heeft?

De markt bepaalt de vraag, maar welke vraag is er voor een GTX 2660/70/80 wanneer je de RTX 3050 al voor het $249 of lager prijspunt kunt krijgen? Er is een reden dat Nvidia de gpu's niet naarbeneden laat gaan naar x10. Er is geen vraag voor. Vorige generatie was er een vraag omdat de goedkoopste RTX gpu te duur was. Deze keer is dat door de performance verbeteringen anders. Als ze het willen kunnen ze zelfs de bestaande 2060 lijn gewoon laten doorproduceren en het 3050 noemen zoals wel vaker gedaan is in GPU land. Wanneer de markt RTX gpu's kan krijgen voor de prijs die ze willen betalen is er geen vraag naar een uitgeklede variant. En Nvidia gaat niet de verkopen van z'n mid-end of zelfs high-end kaarten (zoals jij lijkt te denken met een GTX 2680) kanibaliseren door een productlijn die meer geld kost en minder oplevert.

Zelfs een 2080 super was behoorlijk slecht met rt enkel de 2080ti kon een aardige scène neerzetten met acceptabele fps.

Nvidia probeert de markt af te dwingen een bepaalde route in net als dat ze dat met PHYSX deden.

Begrijp me niet verkeerd ik ben nvidia fan vanwege hun drivers heb al vanaf de tnt2 serie nvidia enkel de fx series overgeslagen.

En tussendoor een verdwaalde amd/ati kaart.

Maar als ik perse een kaart moet nemen met technologie die ik niet ga gebruiken en Amd komt met een knappe kaart met gelijkwaardige prestaties zonder rtx voor een prijs die 30% lager ligt stap ik toch weer een keer over naar het rode kamp.

Ik wil geen tensor cores als ik er geen gebruik van ga maken.

En verwacht zeker wel dat er nog een ampere architectuur kaart uitkomt zonder rt cores.

Hebben ze immers ook met turing gedaan.

Juist, en net als PhysX hebben ze er een erg korte transitie periode aan geplakt en het daarna door de hele linie geplaatst. PhysX was daarbij een stuk minder waardevol als een leap in grafische kwaliteit dan ray tracing is. Nvidia probeert de markt af te dwingen? Misschien, maar de markt wil echt wel ray tracing kaarten voor een betaalbaar bedrag hebben. Daarin ben je zeker een minderheid op die markt.TRAXION schreef op maandag 7 september 2020 @ 01:32:

[...]

Een 3050 zal net als de 2060 onvoldoende rt cores hebben om een scène op 30 fps neer te zetten bij 1080p

Zelfs een 2080 super was behoorlijk slecht met rt enkel de 2080ti kon een aardige scène neerzetten met acceptabele fps.

Nvidia probeert de markt af te dwingen een bepaalde route in net als dat ze dat met PHYSX deden.

Begrijp me niet verkeerd ik ben nvidia fan vanwege hun drivers heb al vanaf de tnt2 serie nvidia enkel de fx series overgeslagen.

En tussendoor een verdwaalde amd/ati kaart.

Maar als ik perse een kaart moet nemen met technologie die ik niet ga gebruiken en Amd komt met een knappe kaart met gelijkwaardige prestaties zonder rtx voor een prijs die 30% lager ligt stap ik toch weer een keer over naar het rode kamp.

Ik wil geen tensor cores als ik er geen gebruik van ga maken.

En verwacht zeker wel dat er nog een ampere architectuur kaart uitkomt zonder rt cores.

Hebben ze immers ook met turing gedaan.

Wat betreft de concurrent? AMD stopt in Big Navi hun eigen implementatie van hardware versnelde ray tracing. Dat was al bevestigd toen de PS5 en XSX beide bevestigd werden dat ze het ondersteunden. Dit is een evolutie die je niet tegenhoudt, die strijd was verloren toen de console markt omging.

Sinds DLSS 2 is de 2060 een zeer capabele kaart op 1080p met ray tracing. De verwachting is dat we met Ampere een DLSS 3 gaan krijgen waar nog een efficiëntie slag geslagen is waardoor de 2060/mogelijke 3050 net als de andere RTX kaarten een zeer minimale impact krijgt door ray tracing in te schakelen.

Realtime ray tracing is niet het nieuwe PhysX, het is een veel grotere sprong voorwaarts.

Ik kan dit niet meer serieus nemenCenturius schreef op maandag 7 september 2020 @ 01:48:

[...]

Juist, en net als PhysX hebben ze er een erg korte transitie periode aan geplakt en het daarna door de hele linie geplaatst. PhysX was daarbij een stuk minder waardevol als een leap in grafische kwaliteit dan ray tracing is. Nvidia probeert de markt af te dwingen? Misschien, maar de markt wil echt wel ray tracing kaarten voor een betaalbaar bedrag hebben. Daarin ben je zeker een minderheid op die markt.

Wat betreft de concurrent? AMD stopt in Big Navi hun eigen implementatie van hardware versnelde ray tracing. Dat was al bevestigd toen de PS5 en XSX beide bevestigd werden dat ze het ondersteunden. Dit is een evolutie die je niet tegenhoudt, die strijd was verloren toen de console markt omging.

Sinds DLSS 2 is de 2060 een zeer capabele kaart op 1080p met ray tracing. De verwachting is dat we met Ampere een DLSS 3 gaan krijgen waar nog een efficiëntie slag geslagen is waardoor de 2060/mogelijke 3050 net als de andere RTX kaarten een zeer minimale impact krijgt door ray tracing in te schakelen.

Realtime ray tracing is niet het nieuwe PhysX, het is een veel grotere sprong voorwaarts.

Denk niet dat je doorhebt wat PhysX heeft veranderd.

PhysX veranderde statische content naar dynamische content beïnvloed door verschillende beïnvloedbare variabelen.

Maar goed als je denkt dat rtx de grootste stap is in het grafische wereldje denk ik dat ik teveel verandering heb gezien vanaf de eerste doom en quake of ut games.

Leap in grafische kwaliteit, niet spel performance. Begrijpend lezen lijkt echt een probleem. Daarnaast noemde ik realtime ray tracing niet de grootste stap. Slechts groter dan PhysX. En dat komt doordat het zowel een enorme stap is als het feit dat Nvidia dit niet exclusief kan maken zoals ze met PhysX wel konden.TRAXION schreef op maandag 7 september 2020 @ 01:54:

[...]

Ik kan dit niet meer serieus nemen

Denk niet dat je doorhebt wat PhysX heeft veranderd.

PhysX veranderde statische content naar dynamische content beïnvloed door verschillende beïnvloedbare variabelen.

Maar goed als je denkt dat rtx de grootste stap is in het grafische wereldje denk ik dat ik teveel verandering heb gezien vanaf de eerste doom en quake of ut games.

Daarnaast hoef je mij niet te geloven, de engineers, marketeers en managers van Nvidia, AMD, Intel, Sony en Microsoft vinden het allemaal groot genoeg dat ze het in hun producten willen hebben.

Maargoed je bent overduidelijk door argumenten heen, ik laat het hierbij.

Tensor cores in het algemeen zijn geweldig omdat deze nog vele andere toepassingen hebben dan alleen raytracing, raytracing alleen is niet waarom tensor cores zo interessant zijn.Centurius schreef op maandag 7 september 2020 @ 02:05:

[...]

Leap in grafische kwaliteit, niet spel performance. Begrijpend lezen lijkt echt een probleem. Daarnaast noemde ik realtime ray tracing niet de grootste stap. Slechts groter dan PhysX. En dat komt doordat het zowel een enorme stap is als het feit dat Nvidia dit niet exclusief kan maken zoals ze met PhysX wel konden.

Daarnaast hoef je mij niet te geloven, de engineers, marketeers en managers van Nvidia, AMD, Intel, Sony en Microsoft vinden het allemaal groot genoeg dat ze het in hun producten willen hebben.

Maargoed je bent overduidelijk door argumenten heen, ik laat het hierbij.

Maar goed zoals ik al eerder zei over een aantal weekjes zullen we het resultaat zien, ik zit schijnbaar niet op dezelfde hypetrain.

Ik ben momenteel nog steeds niet overtuigd.

Raytracing maakt of breekt een game niet in mijn opinie.

Persoonlijk hoop ik dat we straks een tegenhanger krijgen in de vorm van een console welke closed source is gezien ik pc gaming steeds minder interessant vind worden vanwege cheaters.

Edit* begrijpend lezen is niet moeilijk maar grafische kwaliteit is meer dan een stukje belichting en of reflectie daarvan.

[ Voor 4% gewijzigd door TRAXION op 07-09-2020 02:20 ]

Er is net een 2080 Ti online gekomen voor €1.250,-RenegadexRIPxx schreef op zondag 6 september 2020 @ 15:55:

[...]

Ach ja, dat was de 3080 die er 50% over ging gaan.

Dan nog is het een kaart die 2 jaar oud is. Doet de 3070 hetzelfde en soms beter in sommige punten, is het een nieuwe kaart inclusief garantie en is de nieuwprijs daarvan 519€ indien je ze te pakken krijgt.

Waarom zou 500€ dan een goede prijs zijn op de tweedehandse markt voor die ti? Zoals gezegd 350 - 400€ lijkt dan logischer met in het begin tgv slechte verkrijgbaarheid 450€. En ik zou mijn pollekes kussen indien je een zot tegenkomt die er 500€ voor wilt geven.

Graag reël bieden.

laat iedereen toch lekker vragen wat ie wil.

zal eens een balletje opgooien, maar ik kan niks belovenDaniëlWW2 schreef op zaterdag 5 september 2020 @ 17:11:

[...]

Ja dat heb ik dus helemaal gemist. Maar mentale aantekening gemaakt en weer wat geleerd.

Implicerend is het dan ook dat games zelden meer dan 16 INT32 threads per warp zullen hebben.

[...]

Weet je, daar hebben we kantoormensen voor.

@Intergalactic doe er eens wat mee zou ik zeggen.

𝙸𝚗 𝚜𝚙𝚊𝚌𝚎 𝚗𝚘 𝚘𝚗𝚎 𝚌𝚊𝚗 𝚑𝚎𝚊𝚛 𝚢𝚘𝚞 𝚜𝚌𝚛𝚎𝚊𝚖 | Tweakers Discord | Stats.fm | Discogs

Sorry hoor, maar dit is een ad van iemand die weet dat de waarde niet meer is dan 350-450 en vervolgens hoopt dat er een onwetend iemand langskomt die dat ding koopt voor 1000euro.hully schreef op maandag 7 september 2020 @ 07:40:

ik heb wel het idee dat hier veel mensen zich beklagen/bescheuren over de 2080Ti prijzen omdat ze tegen beter in hopen dat ze er een voor 300 euro of zo kunnen oppikken.

laat iedereen toch lekker vragen wat ie wil.

Zelf vind ik het gewoon walgelijk gedrag.

NDA loopt op de 14e af voor FE's en de 17e voor partner kaarten.Emperor_ schreef op maandag 7 september 2020 @ 08:18:

Weet iemand wanneer reviewers hun kaarten ontvangen om te benchmarken en wanneer er een driver beschikbaar komt om te gaan testen? Ik ben erg benieuwd naar de reviews en hoop dat dit voor de release te kunnen bestuderen.

[ Voor 26% gewijzigd door S95Sedan op 07-09-2020 08:21 ]

Maak je toch niet zo druk. Jij hoeft hem toch niet te kopen?S95Sedan schreef op maandag 7 september 2020 @ 08:20:

[...]

Sorry hoor, maar dit is een ad van iemand die weet dat de waarde niet meer is dan 350-450 en vervolgens hoopt dat er een onwetend iemand langskomt die dat ding koopt voor 1000euro.

Zelf vind ik het gewoon walgelijk gedrag.

Laat iedereen lekker vragen wat hij/zij wil en de markt bepaalt zelf wel of dit wel of niet redelijk is.

Als er iemand hem wel koopt voor die prijs dan zal het die persoon dat waard zijn geweest.

Jij wilt blijkbaar dat er niet aan uitgeven TOP. moet je vooral niet doen en wachten tot er iemand de door jou gewenste prijs vraagt. Als dat gebeurt, MOOi.

ALs dan niet gebeurt, dan zijn jouw verwachtingen mogelijk niet reeel.

Overigens zie ik 5 advertenties daaronder dezelfde aorus 2080Ti aangeboden worden voor 750, dus deze verkoper zal inderdaad mogelijk de waarde van zijn kaart iets te hoog inschatten.

Komt hij zelf wel achter (of niet).

Zoals ik al eerder heb opgemerkt.

Het is niet de gek die vraagt, het is de gek die geeft.

Zijn we nu een keer klaar met deze nutteloze discussie?

OM de markt te testen meteen ook maar even een vraag voor een tweedehands 2080Ti op V&A gezet.

Kijken wat de markt doet.

Even daar mijn limiiet gesteld.

Of ik er dan een krijg zal blijken. Ik zal in ieder geval niemand (kunnen) verplichten om de door mij gevraagde kaart voor het door mij gevraagde bedrag te verkopen.

[ Voor 21% gewijzigd door killerbee1958 op 07-09-2020 11:12 ]

Volgens mij haal je dingen door elkaar. Je doet geen raytracing met Tensor cores maar met RT cores. Tensor cores worden gebruikt voor A.I. waaronder DLSS.TRAXION schreef op maandag 7 september 2020 @ 02:18:

[...]

Tensor cores in het algemeen zijn geweldig omdat deze nog vele andere toepassingen hebben dan alleen raytracing, raytracing alleen is niet waarom tensor cores zo interessant zijn.

Het was gisteravond laat ik bedoelde uiteraard RT cores.biggydeen2 schreef op maandag 7 september 2020 @ 11:10:

[...]

Volgens mij haal je dingen door elkaar. Je doet geen raytracing met Tensor cores maar met RT cores. Tensor cores worden gebruikt voor A.I. waaronder DLSS.

Tensor cores is veel meer mee te doen toepassingen zoals dlss maar ook denoising etc alles met een neural netwerk kan je trainen door deze in te zetten.

Ik zie dan ook meer potentie in Tensor cores dan RT cores.

Ai die zich ontwikkeld naar de speler en waarschijnlijk vele andere mogelijkheden die op dit moment nog niet bedacht/bekend zijn.

Tuurlijk RT cores hebben voor ontwerpers van omgevingen etc gigantische voordelen ten opzichte van fixed lighting points maar voordat dit mainstream is zal de adaptatie van rtx veel groter moeten zijn op het pc platform.

Ik snap de stap voor consoles gezien daar elke gebruiker dezelfde hardware zal hebben en het ontwerpen voor 1 of 2 systemen (xbox/ps) uiteindelijk gigantische winsten kan boeken.

Als ik kijk naar hoe lang het duurde voordat directx implementaties gebruikt werden was je al jaren verder voordat deze mogelijkheden benut werden.

Vooralsnog was het mij de 2080ti niet waard om een aantal refracties en schaduwen die iets realistischer waren voor 50% extra geld.

Maar goed waar het in den beginne van mijn relaas ging ik verwacht geen verbetering van 60% bij een 3080, misschien met dlss en raytracing ja natuurlijk omdat deze nieuwe vele malen meer van deze cores heeft, ik wil de performance non raytracing dlss weten en daarop zal mijn keuze bepaald worden.

*edit misschien ben ik wel te pessimistisch doordat de afgelopen jaren het enkel maar incredemental updates zijn geweest zowel op het gebied van cpu en gpu, in de gouden tijden was een nieuwe architectuur minstens 2x zo snel zowel bij gpu's als cpu's.

[ Voor 7% gewijzigd door TRAXION op 07-09-2020 11:34 ]

Ik wil niet vervelend zijn 2080 TiWhySoSerious schreef op maandag 7 september 2020 @ 07:34:

[...]

Er is net een 2080 Ti online gekomen voor €1.250,-€35 onder de prijs waar ie nu nieuw voor te kopen is

[...]

to linux or not ,that's my quest... | 5800X | 32GB 3800C15 | X570-Pro | 980 1TB | 7900XTX | PVoutput | Fiets

Ah, het verkopen van de oude voorraad tegen betere prijzen is begonnen.

Nog steeds duurder dan een 3080 maar wel direct leverbaar dus misschien kan dat de prijs rechtvaardigen.

(mag elke koper voor zichzelf bedenken. For the record, ik zou het nog steeds niet doen voor die prijs, ik wacht dan wel)

[ Voor 24% gewijzigd door killerbee1958 op 07-09-2020 11:37 ]

De prijs welke het al vanaf het begin had moeten wezenkillerbee1958 schreef op maandag 7 september 2020 @ 11:35:

[...]

Ah, het verkopen van de oude voorraad tegen betere prijzen is begonnen.

Die hele mining hype heeft de prijzen negatief beïnvloed voor de gewone consument.

Typisch voorbeeldje marktwerking welke ontkoppeld is door een onverwachte ontwikkeling.

Zoals velen al aangegeven hebben bedankt betatesters van de turing serie.

Thanks, heb het even doorgeven aan de vriendelijke meneer.

Tweakers4Tweakers!

V&A aangeboden: HP / Nvidia GeForce RTX 2080

Gebruikte HP (Nvidea) RTX 2080 8GB videokaart

Gebruikte HP (Nvidea) RTX 2080 8GB videokaart, (Deze is ook geschikt voor de HP Z serie workstations, en heeft in tegenstelling tot vele RTX2080 kaarten geen öpstaande rand" zodat hij ook past in deze systemen en de plaat voor de warmtegeleiding ook dicht kan. Let op, deze videokaart kost nog steeds ca 3600 Euro bij andere aanbieders, 750 Euro is dus een absoluut koopje!

Let op, de link naar de aanbieder (centralpint) heb ik bij de productspecs neergezet. ik krijg veel reacties dat deze kaart goedkoper zou zijn,. maar dat is dus NIET het geval, u hoeft me daar dus NIET op te attenderen. Wilt u de kaart kopen dan hoor ik het graag natuurlijk.

Vaste prijs. Afdingen word niet op prijs gesteld. Ook niet als andere tweakers goedkoper zijn. Mijn bedrijf staat voor meer dan alleen een prijs, ik lever service, productkennis, snelheid, garantie en een echt positieve tweakers ervaring. Ook dat is waarde!

Dit is ook nog eens met een blower shroud erop (ouch), ofwel een bak herrie.Paprika schreef op maandag 7 september 2020 @ 12:00:

Ik vind de V&A aanbiedingen eigenlijk niet nieuwsdiscussie waardig, maar deze schoot er wel echt even uit voor mij.

V&A aangeboden: HP / Nvidia GeForce RTX 2080

Gebruikte HP (Nvidea) RTX 2080 8GB videokaart

[...]

Echt een koopje

Let op, deze videokaart kost nog steeds ca 3600 Euro bij andere aanbieders, 750 Euro is dus een absoluut koopje!Paprika schreef op maandag 7 september 2020 @ 12:00:

Ik vind de V&A aanbiedingen eigenlijk niet nieuwsdiscussie waardig, maar deze schoot er wel echt even uit voor mij.

V&A aangeboden: HP / Nvidia GeForce RTX 2080

Gebruikte HP (Nvidea) RTX 2080 8GB videokaart

[...]

3600 euro...

-- My Gaming Rig Power -- -- <SG> Diabolic --

De benchmarks laten toch duidelijk zien dat de 3080 80% sneller is dan de 2080. Haal daar 20% vanaf want cherrypicked (wat al extreem ruim is) en je komt op 60%+ uit. In de synthetische benchmark compubench is de 3080 40% sneller dan de 2080ti.TRAXION schreef op maandag 7 september 2020 @ 11:26:

[...]

Maar goed waar het in den beginne van mijn relaas ging ik verwacht geen verbetering van 60% bij een 3080, misschien met dlss en raytracing ja natuurlijk omdat deze nieuwe vele malen meer van deze cores heeft, ik wil de performance non raytracing dlss weten en daarop zal mijn keuze bepaald worden.

*edit misschien ben ik wel te pessimistisch doordat de afgelopen jaren het enkel maar incredemental updates zijn geweest zowel op het gebied van cpu en gpu, in de gouden tijden was een nieuwe architectuur minstens 2x zo snel zowel bij gpu's als cpu's.

Op 1440p is de vraag of het verschil nog steeds zo groot is. Maar 50% sneller dan de 2080 is gewoon zeer realistisch op basis van wat we nu hebben gezien (qua specs en benchmarks). 50% sneller dan de 2080 is 30% sneller dan de 2080ti voor bijna de helft van de prijs. De laatste keer dat we een dergelijke performance leap hebben gezien is echt een hele tijd geleden. Ik snap de negatieve insteek dan ook niet zo.

Betreft deze 'speciale' HP uitvoering, die natuurlijk als OEM part niet echt los te koop isXtr3me4me schreef op maandag 7 september 2020 @ 12:09:

[...]

Let op, deze videokaart kost nog steeds ca 3600 Euro bij andere aanbieders, 750 Euro is dus een absoluut koopje!

3600 euro...

Ik houd gewoon rekening met een realistisch scenario en dat is dat bij de reviews blijkt dat nvidia het allemaal wat mooier en cherrypicked heeft voorgesteld.

Er zullen vast ook wel weer wat addertjes onder het gras vandaan komen.

RT en DLSS worden nu wel degelijk een factor in de mindset vd kopers, desalniettemin ben ik nog sceptisch over het echte potentieel in deze generatie en dan ook vooral geinteresseerd in traditionele shader performance winst.

Desalniettemin denk ik dat dit sinds lange tijd weer echt interessante kaarten worden op het stroomverbruik en hitteafgifte na.

Mijn 1080Ti heb ik alweer 3jr en 4mnd naar volle tevredenheid. Eén van de betere pc aankopen ooit en nu wel tijd voor een upgrade, zeker gezien mijn grotere monitor.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Dat is een afzetter. Ik zat gisteren even te kijken naar 2e hands SSD's.. Hij biedt er één aan met 'geclaimde' 1850 werkuur voor iets van 18 euro onder de nieuwprijs.Paprika schreef op maandag 7 september 2020 @ 12:00:

Ik vind de V&A aanbiedingen eigenlijk niet nieuwsdiscussie waardig, maar deze schoot er wel echt even uit voor mij.

V&A aangeboden: HP / Nvidia GeForce RTX 2080

Gebruikte HP (Nvidea) RTX 2080 8GB videokaart

[...]

Ik wil resultaten zonder dlss/raytracing als ik een game speel is het online op low settings, mijn eisen pakketje is misschien anders dan anderen daar ik competitief speel.biggydeen2 schreef op maandag 7 september 2020 @ 12:15:

[...]

De benchmarks laten toch duidelijk zien dat de 3080 80% sneller is dan de 2080. Haal daar 20% vanaf want cherrypicked (wat al extreem ruim is) en je komt op 60%+ uit. In de synthetische benchmark compubench is de 3080 40% sneller dan de 2080ti.

Op 1440p is de vraag of het verschil nog steeds zo groot is. Maar 50% sneller dan de 2080 is gewoon zeer realistisch op basis van wat we nu hebben gezien (qua specs en benchmarks). 50% sneller dan de 2080 is 30% sneller dan de 2080ti voor bijna de helft van de prijs. De laatste keer dat we een dergelijke performance leap hebben gezien is echt een hele tijd geleden. Ik snap de negatieve insteek dan ook niet zo.

Dus als de huidige benchmarks vergeleken worden met de 20xx serie met dlss en rtx krijg je hele andere resultaten als dat de benchmarks gedaan worden zonder aangezien de helft van de architectuur op dat moment niet aangesproken word.

En het grote verschil deze generatie is dat het aantal tensor en rt cores flink vergroot zijn en ja uiteraard krijg je dan een flinke boost bij de huidige generatie heb je een performance impact van tientallen procenten zodra je rtx inschakeld omdat er eigenlijk te weinig cores beschikbaar zijn ten opzichte van de mainthread.

Ik zit inderdaad met een beetje dezelfde mindset het concept van rtx is geweldig maar zoals de vorige generatie heeft laten zien is dat de techniek behoorlijk zwaar is waardoor de performance er behoorlijk onder lijdt vermoed doordat de vergroting van cores het enigssinds recht trekt.Help!!!! schreef op maandag 7 september 2020 @ 12:16:

@TRAXION / all

Ik houd gewoon rekening met een realistisch scenario en dat is dat bij de reviews blijkt dat nvidia het allemaal wat mooier en cherrypicked heeft voorgesteld.Zoals altijd.

Er zullen vast ook wel weer wat addertjes onder het gras vandaan komen.

RT en DLSS worden nu wel degelijk een factor in de mindset vd kopers, desalniettemin ben ik nog sceptisch over het echte potentieel in deze generatie en dan ook vooral geinteresseerd in traditionele shader performance winst.

Desalniettemin denk ik dat dit sinds lange tijd weer echt interessante kaarten worden op het stroomverbruik en hitteafgifte na.

Mijn 1080Ti heb ik alweer 3jr en 4mnd naar volle tevredenheid. Eén van de betere pc aankopen ooit en nu wel tijd voor een upgrade, zeker gezien mijn grotere monitor.

Uiteindelijk draai ik 90% van de spellen die ik draai zonder rtx en neem dit in overweging mee in de aanschaf.

Tuurlijk zou ik graag 4k 120 fps full detail racing games willen spelen maar een fps gaat direct terug naar de laagste settings zodra ik door de single player ben

Dat begrijp ik maar borderlands 3 en doom ondersteunen beiden geen RTX of DLSS. En daarin is de 3080 80% sneller op 4k. -20% cherrypicking (erg veel) dan zit je op 60%+. Dus wat dat betreft is het veelbelovend. Ook heeft Nvidia al aangegeven dat de performance ook in standaard rasterization games zo groot gaat zijn. Ik geloof niet dat ze daarmee flink lopen te bluffen en dat de performance een stuk lager uitvalt. Want dan gaat iedereen afwachten wat AMD gaat doen.TRAXION schreef op maandag 7 september 2020 @ 12:22:

[...]

Ik wil resultaten zonder dlss/raytracing als ik een game speel is het online op low settings, mijn eisen pakketje is misschien anders dan anderen daar ik competitief speel.

Dus als de huidige benchmarks vergeleken worden met de 20xx serie met dlss en rtx krijg je hele andere resultaten als dat de benchmarks gedaan worden zonder aangezien de helft van de architectuur op dat moment niet aangesproken word.

En het grote verschil deze generatie is dat het aantal tensor en rt cores flink vergroot zijn en ja uiteraard krijg je dan een flinke boost bij de huidige generatie heb je een performance impact van tientallen procenten zodra je rtx inschakeld omdat er eigenlijk te weinig cores beschikbaar zijn ten opzichte van de mainthread.

Zoals Help!!!! Al aangeeft is nvidia geweldig goed in cherrypicking en is doom altijd als een geweldig goed geoptimaliseerde game geweest.biggydeen2 schreef op maandag 7 september 2020 @ 12:33:

[...]

Dat begrijp ik maar borderlands 3 en doom ondersteunen beiden geen RTX of DLSS. En daarin is de 3080 80% sneller op 4k. -20% cherrypicking (erg veel) dan zit je op 60%+. Dus wat dat betreft is het veelbelovend. Ook heeft Nvidia al aangegeven dat de performance ook in standaard rasterization games zo groot gaat zijn. Ik geloof niet dat ze daarmee flink lopen te bluffen en dat de performance een stuk lager uitvalt. Want dan gaat iedereen afwachten wat AMD gaat doen.

Maar er zijn honderden andere spellen welke mogelijk niet zo geoptimaliseerd zijn voor deze architectuur, nvidia presteert het met driver optimalisaties tot 40% performance gains te krijgen bij bepaalde spellen terwijl andere spellen dezelfde performance neer blijven zetten door een andere architectuur van de game engine.

Beetje hetzelfde met auto's die op de testbaan met superdunne bandjes etc 1:30 behalen maar uiteindelijk met stadsverkeer amper de 1:20 halen.

Pas als de nda ervan af gaat en we benchmarks krijgen over een breder spectrum zal ik overtuigd wezen tot die tijd is de marketing van de 30xx serie overtuigend een van de betere sinds lange tijd.

Maar als de geschiedenis zich herhaald krijgen we straks weer hetzelfde als vorige generaties dat het verschil tussen de 20 tot 80% is afhankelijk van de game en engine.

Als een game als battlefield 50% gains heeft ten opzichte van de 20xx serie ben ik overtuigd en juich ik nvidia toe met hun aangepaste ontwerp tot die tijd ben ik sceptisch.

Ik wilde eerst wachten, maar vraag mij af of dit een goede beslissing is.

https://nl.hardware.info/...t-bescheiden-prijskaartje

heb je meer dan 2080ti performance nodig dan?CerandoX.nl schreef op maandag 7 september 2020 @ 12:52:

Ik vind het kwalijk dat AMD volgens de info van Coreteks weer niet mee kan komen met Nvdia's high-end modellen zoals de 3080, laat staan de 3090. Nvidia heeft het met de 30000-serie gewoon goed voor elkaar.

Ik wilde eerst wachten, maar vraag mij af of dit een goede beslissing is.

https://nl.hardware.info/...t-bescheiden-prijskaartje

Als AMD een betere prijs/kwaliteitverhouding bied voor wat je nodig hebt... Who cares dat ze niet kunnen meekomen met de 3080 of 3090....

Kwalijk kun je ze het verder niet nemen. Ze hebben een enorm veel kleiner budget....

Daarnaast: laat je niet gek maken. Van beide kaarten hebben we geen onafhankelijke benchmarks.

Je moet de laatste van Moore's Law Is Dead maar een luisteren, daar zit wel in. AMD hoeft niet persé op snelheid te concurreren. Als ze 10 - 15 % trager zijn dan een 3080 maar dan een stuk zuiniger met 16 GB Vram tegen ongeveer dezelfde prijsCerandoX.nl schreef op maandag 7 september 2020 @ 12:52:

Ik vind het kwalijk dat AMD volgens de info van Coreteks weer niet mee kan komen met Nvdia's high-end modellen zoals de 3080, laat staan de 3090. Nvidia heeft het met de 30000-serie gewoon goed voor elkaar.

Ik wilde eerst wachten, maar vraag mij af of dit een goede beslissing is.

https://nl.hardware.info/...t-bescheiden-prijskaartje

Ryzen 5950x + 32GB GSKILL @3600 op Rog Strix Gaming E x570 + Asrock Phantom Gaming 6800XT+ Gigabyte Aorus FV43U Zwart + DS1621+ + DS414 + MacbookPro 16" 2021 + Mac Mini M4 Pro + Tesla MY RWD 2023 BYD

Het liefst wel meer dan 2080 Ti performance ja, want de 2080 Ti kon ook niet alle games op 4K/60 draaien. Natuurlijk zullen ze minder budget hebben, maar ben al twee keer blij gemaakt met een dode mus in de Radeon VII en 5700 XT. Dit zou de derde keer worden, wel door mijn eigen hoge verwachtingen om eerlijk te zijn. Op het laatste punt heb je zeker gelijk, het valt allemaal te bezien hoe de kaarten het gaan doen.Waah schreef op maandag 7 september 2020 @ 13:02:

[...]

heb je meer dan 2080ti performance nodig dan?

Als AMD een betere prijs/kwaliteitverhouding bied voor wat je nodig hebt... Who cares dat ze niet kunnen meekomen met de 3080 of 3090....

Kwalijk kun je ze het verder niet nemen. Ze hebben een enorm veel kleiner budget....

Daarnaast: laat je niet gek maken. Van beide kaarten hebben we geen onafhankelijke benchmarks.

Die kijk ik regelmatig en ja dat zou mogelijk prima zijn, maar zou als ik AMD was nu wel binnen een week met een presentatie komen, anders zijn ze mogelijk te laat.winwiz schreef op maandag 7 september 2020 @ 13:18:

[...]

Je moet de laatste van Moore's Law Is Dead maar een luisteren, daar zit wel in. AMD hoeft niet persé op snelheid te concurreren. Als ze 10 - 15 % trager zijn dan een 3080 maar dan een stuk zuiniger met 16 GB Vram tegen ongeveer dezelfde prijs

[ Voor 46% gewijzigd door CerandoX.nl op 07-09-2020 14:54 ]

Als de amd kaarten zoveel trager zijn gaat niemand ze kopen. Dat verschil kan makkelijk al 3070 niveau zijn. Tussen de 2080 en 2080 Ti zat 15% prestatieverschil. Bij de 2080 super was het zelf nog maar 10% verschil. Bovendien heeft ray tracing bij amd impact op de shaders. Ray tracing is geen pure gimmick meer, dus voor die impact zal amd ook moet compenseren.winwiz schreef op maandag 7 september 2020 @ 13:18:

[...]

Je moet de laatste van Moore's Law Is Dead maar een luisteren, daar zit wel in. AMD hoeft niet persé op snelheid te concurreren. Als ze 10 - 15 % trager zijn dan een 3080 maar dan een stuk zuiniger met 16 GB Vram tegen ongeveer dezelfde prijs

Waarom zou niemand een kaart kopen die een paar procent trager zijn dan een 3080? Dat is nog meer dan snel genoeg voor de meesten, en met een goed prijskaartje worden er meer kaarten in het <500 euro segment verkocht, dan in het >500 euro segment.dragonlords1 schreef op maandag 7 september 2020 @ 15:11:

[...]

Als de amd kaarten zoveel trager zijn gaat niemand ze kopen. Dat verschil kan makkelijk al 3070 niveau zijn. Tussen de 2080 en 2080 Ti zat 15% prestatieverschil. Bij de 2080 super was het zelf nog maar 10% verschil. Bovendien heeft ray tracing bij amd impact op de shaders. Ray tracing is geen pure gimmick meer, dus voor die impact zal amd ook moet compenseren.

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Klinkt voor mij als een marketing mock-up. Ik zat vanochtend nog naar de EVGA site te kijken en daar kwam ik toen al deze tegen die 1:1 is behalve de GPU:XWB schreef op maandag 7 september 2020 @ 15:28:

EVGA teased with 2.1 GHz clock

En daarom heeft de FTW3 Ultra 3x 8-pin aansluiting.

[ Voor 9% gewijzigd door Paprika op 07-09-2020 15:34 ]

Even hierover, naast dat sommige fabrikanten hadden bespaart op koeling bij de 5700 XT, was er iets inherent mis met de die GPU? Ja hij haalde niet echt GTX 2080 snelheden, maar dat was ook niet het doel.CerandoX.nl schreef op maandag 7 september 2020 @ 14:45:

Natuurlijk zullen ze minder budget hebben, maar ben al twee keer blij gemaakt met een dode mus in de Radeon VII en 5700 XT.

Volgens mij verkocht de RX 5700 serie in het algemeen ook redelijk goed, begreep ik.

Ik vraag dit hier, want ik denk dat we met de komende positionering van AMD tegenover de nVidia 3000 serie ongeveer hetzelfde kunnen verwachten.

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

Waarschijnlijk maakte de relatief kleine chip hem lastiger om te koelen dan een grotere Nvidia chip die evenveel vermogen nodig had.XanderDrake schreef op maandag 7 september 2020 @ 15:52:

[...]

Even hierover, naast dat sommige fabrikanten hadden bespaart op koeling bij de 5700 XT, was er iets inherent mis met de die GPU? Ja hij haalde niet echt GTX 2080 snelheden, maar dat was ook niet het doel.

Volgens mij verkocht de RX 5700 serie in het algemeen ook redelijk goed, begreep ik.

Ik vraag dit hier, want ik denk dat we met de komende positionering van AMD tegenover de nVidia 3000 serie ongeveer hetzelfde kunnen verwachten.

En het probleem van de 5700XT is meer drivers dan hardware. Al laat de hardware wel zien dat iedereen die denkt dat AMD aankomt met een 3080 concurrent die niet zeker een vergelijkbare hoeveelheid stroom trekt zichzelf voor de gek houdt.

AMD laat pas iets horen als de reviews uit zijn gok ik. Daarnaast zullen ze op de hype train van Zen 3 misschien mee willen. Hoewel het daarover ook stiller is dan normaal.CerandoX.nl schreef op maandag 7 september 2020 @ 14:45:

[...]

Het liefst wel meer dan 2080 Ti performance ja, want de 2080 Ti kon ook niet alle games op 4K/60 draaien. Natuurlijk zullen ze minder budget hebben, maar ben al twee keer blij gemaakt met een dode mus in de Radeon VII en 5700 XT. Dit zou de derde keer worden, wel door mijn eigen hoge verwachtingen om eerlijk te zijn. Op het laatste punt heb je zeker gelijk, het valt allemaal te bezien hoe de kaarten het gaan doen.

[...]

Die kijk ik regelmatig en ja dat zou mogelijk prima zijn, maar zou als ik AMD was nu wel binnen een week met een presentatie komen, anders zijn ze mogelijk te laat.

De 5700 series verkocht inderdaard best goed, mede doordat Ryzen zo goed is. Dat heeft AMD best geholpen; althans dat is wat de meesten denken. Het probleem was inderdaaad de drivers de eerste paar maanden

Je weet best dat de meerderheid op 1080 a 1440 zit en dat je dan met 2060S - 2070(S) met als vervanger een snellere 3060, wanneer deze komt, prima bemeten zit. Laat staan met 3080 isch, en dus ook met de toekomstige tegenhangers van AMD. We zullen het de komende maanden gaan. De kans dat je binnen 2 maanden een 3080 o.i.k. kan scoren is redelijk klein en tegen die tijd zullen we ook weten wat er tegenover staat.dragonlords1 schreef op maandag 7 september 2020 @ 15:11:

[...]

Als de amd kaarten zoveel trager zijn gaat niemand ze kopen. Dat verschil kan makkelijk al 3070 niveau zijn. Tussen de 2080 en 2080 Ti zat 15% prestatieverschil. Bij de 2080 super was het zelf nog maar 10% verschil. Bovendien heeft ray tracing bij amd impact op de shaders. Ray tracing is geen pure gimmick meer, dus voor die impact zal amd ook moet compenseren.

Ryzen 5950x + 32GB GSKILL @3600 op Rog Strix Gaming E x570 + Asrock Phantom Gaming 6800XT+ Gigabyte Aorus FV43U Zwart + DS1621+ + DS414 + MacbookPro 16" 2021 + Mac Mini M4 Pro + Tesla MY RWD 2023 BYD

Nvidia Working On AI Coach That Makes Players Better At Games

https://videocardz.com/ne...-aots-benchmark-leaks-out

22% sneller dan 2080 ti

35% sneller dan 2080 super

45% sneller dan 2080 (schatting)

CPU lijkt wel op stock speeds te lopen. Geen idee of dit nog een bottleneck kan zijn.

22% zou realistischer zijn dan zou de 3070 iets onder de 2080ti komen zoals elke serie sinds de 6xx serie is dit zo.biggydeen2 schreef op maandag 7 september 2020 @ 20:54:

Niet helemaal goed te vergelijken maar de RTX3080 is gespot in Ashes of Singularity benchmark op 4k:

https://videocardz.com/ne...-aots-benchmark-leaks-out

22% sneller dan 2080 ti

35% sneller dan 2080 super

45% sneller dan 2080 (schatting)

CPU lijkt wel op stock speeds te lopen. Geen idee of dit nog een bottleneck kan zijn.

Nu is het nog de vraag hoe rtx/dlss zich verhoudt tussen de 3070 en de 3080 gezien de laatste een grotere core en gddr6x met dus een grotere geheugen bandbreedte.

Vind het wel jammer dat de 3080 geen SLI meer ondersteunt. Dat wordt voor mij misschien de door slag gevende factor van AMD VS Nvidia, als amd een kaart heeft die wel crossfire gaat ondersteunen en even snel als de 3080 is dan ga ik daarvoor. Tenzij de 3090 50-60% sneller is dan een 3080 dan neem ik die gewoon.

The first casualty in war is always the truth...

Vandaar het "speciale"Paprika schreef op maandag 7 september 2020 @ 12:16:

[...]

Betreft deze 'speciale' HP uitvoering, die natuurlijk als OEM part niet echt los te koop is. Op de foto lijkt die IO shield wel flink verbogen?

Jammer dat de advertentie stopt bij "Ik kan een". Nu ben ik wel benieuwd naar wat deze meneer kan.

Precies! Als de AMD kaart qua performance tussen de 3070 en 3080 zit maar wel ongeveer hetzelfde prijskaartje heeft als de 3070? Ik denk dat veel PC gebruikers nog net rond de €500 willen betalen maar dat €700 iets te veel is. Ik hoop zo dat AMD zich wel kan meten met de 3080 al was het alleen maar om de prijzen een beetje schappelijk te houden. De 3090 boeit niet zo want het €1500 segment is een stuk kleiner.Jeroenneman schreef op maandag 7 september 2020 @ 15:17:

[...]

Waarom zou niemand een kaart kopen die een paar procent trager zijn dan een 3080? Dat is nog meer dan snel genoeg voor de meesten, en met een goed prijskaartje worden er meer kaarten in het <500 euro segment verkocht, dan in het >500 euro segment.

Wise men speak because they have something to say; Fools because they have to say something

Verwijderd

AoS.is wel vaak cpu bound, of dat op 4K met deze kaarten ook nog is weer ik niet, maar dit is denk ik niet de beste titel om prestaties te vergelijken.biggydeen2 schreef op maandag 7 september 2020 @ 20:54:

Niet helemaal goed te vergelijken maar de RTX3080 is gespot in Ashes of Singularity benchmark op 4k:

https://videocardz.com/ne...-aots-benchmark-leaks-out

22% sneller dan 2080 ti

35% sneller dan 2080 super

45% sneller dan 2080 (schatting)

CPU lijkt wel op stock speeds te lopen. Geen idee of dit nog een bottleneck kan zijn.

Dat gaat hem niet worden. Laten we eerlijk zijn, voor elke gpu generatie is er veel hype en de laatste keren dat AMD echt heeft geleverd waren de HD5870 en HD7970.JohnnyV76 schreef op dinsdag 8 september 2020 @ 08:01:

[...]

Precies! Als de AMD kaart qua performance tussen de 3070 en 3080 zit maar wel ongeveer hetzelfde prijskaartje heeft als de 3070? Ik denk dat veel PC gebruikers nog net rond de €500 willen betalen maar dat €700 iets te veel is. Ik hoop zo dat AMD zich wel kan meten met de 3080 al was het alleen maar om de prijzen een beetje schappelijk te houden. De 3090 boeit niet zo want het €1500 segment is een stuk kleiner.

Dit wordt weer zo'n typische 'big navi kan de RTX3080 bijhouden als AMD echt zou willen' en dan zal je zien dat ze net de RTX3070 kunnen verslaan voor dezelfde prijs. En dan nog hopen dat de drivers stabiel zijn

Ik ben echt voor de underdog, maar ik ben na al deze jaren wel een beetje klaar met het hypen van AMD gpu's die keer op keer toch weer tegenvallen

De 3090 is een Titan/pro kaart vermomd als gamer kaart. Dat is ook de reden dat als er een 3080ti komt ik eerder verwacht dat het dezelfde kaart is als de 3090, maar dan met 12gb ipv 24 GB. De 3080 met 20gb voor 1000 zou heel hun pro markt omver halen. De 3090 doet dat al soort van.JohnnyV76 schreef op dinsdag 8 september 2020 @ 08:01:

[...]

Precies! Als de AMD kaart qua performance tussen de 3070 en 3080 zit maar wel ongeveer hetzelfde prijskaartje heeft als de 3070? Ik denk dat veel PC gebruikers nog net rond de €500 willen betalen maar dat €700 iets te veel is. Ik hoop zo dat AMD zich wel kan meten met de 3080 al was het alleen maar om de prijzen een beetje schappelijk te houden. De 3090 boeit niet zo want het €1500 segment is een stuk kleiner.

NVIDIA DLSS 2.1 Supersampling Brings VR Support

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Deze getallen zijn ook vervalst door Nvidia?Jumpiefox schreef op dinsdag 8 september 2020 @ 01:19:

Iemand hier toevallig ook Doom eternal benchmarks van een 2080ti vergeleken met de 3080..die niet van Nvidia zelf af komen? Je ziet op youtube dat de 2080ti veel hoger fps draait dan wat Nvidia in hun "benchmark" lieten zien. Denk dat die 15-25% improvement veel realistischer is dan wat men atm denkt van een 3080vs 2080ti misschien zelfs minder in non-optimized/cherry picked games?. Maar goed blijft speculatie..we gaan het zien. Spannend allemaal.

https://browser.geekbench.com/v5/compute/1456542

Je weet ook wat deze getalletjes inhouden?Paprika schreef op dinsdag 8 september 2020 @ 09:59:

[...]

Deze getallen zijn ook vervalst door Nvidia?

[Afbeelding]

https://browser.geekbench.com/v5/compute/1456542

Tuurlijk scoort deze kaart veel beter in int32 benches aangezien hij er ook dubbel zoveel heef, deze benchmarks geven compute power aan.

Gaming hangt af van iets meer dan parallel data verwerken, dat is een samenhang van elementen dus winst behalen werkt 1 op 1 met het aantal % cores dat is toegenomen gaming daarintegen is een samenspel waarbij als er 1 partij op zich laat wachten alles moet wachten.

Het gaat om gamebenches, en in mijn geval dlss/rtx off vergelijking.

De 30xx serie is gewoon wat de 20xx serie had moeten wezen

Ja, ik weet prima wat het inhoud, bedankt. Jij wil op low spelen, dus wat maakt het voor jou eigenlijk uit? Die vergelijkingen heb je al gehad, maar dan zijn ze weer nep en cherry picked.TRAXION schreef op dinsdag 8 september 2020 @ 10:18:

[...]

Je weet ook wat deze getalletjes inhouden?

Tuurlijk scoort deze kaart veel beter in int32 benches aangezien hij er ook dubbel zoveel heef, deze benchmarks geven compute power aan.