| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Het factory OC verhaal is nooit zo relevant omdat de nieuwe kaarten ook weer een factory oc mee kunnen krijgen

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Een GTX 680 is een klasse kleiner dan de 280, 480 en 580.

Even los van in welke volgorde en wanneer ze uitkomen is het

280 -> 480 -> 580 -> 780 -> 980 Ti

NIL -> 460 -> 560 Ti -> 680 -> 980

Van GT200 is geen mid-size chip gemaakt. Daarnaast is de 500 serie een refresh en mag je dus verwachten dat die minder vooruitgang toont en dat is ook zo.

Ik weet dat sommige van jullie (hoi sdk1985

Qua tijdlijn lijkt het te kloppen omdat Nvidia zo'n rare releases heeft gedaan. Kijkend naar de mid range chips, dan zie je dat GK104 ongeveer twee keer zo rap is als GF114. Bij GM204 is dat iets minder, maar dat is vooral omdat die weer wat meer GPGPU kracht terug brengt en dus gaming performance op offert. Daar heb je het eerder over 50%.

Kijk je naar GK110 tegenover GF110 zie je zo rond de 70-80% vooruitgang. GM200 tegenover GK110 is minder duidelijk; dat varieert van 50% tot 100% afhankelijk van de resolutie.

Naar G92 (of eerder) kijken heeft geen nut, omdat Nvidia toen nog niet zo belachelijk groot aan het bakken was. Daarnaast stelt GT200 geen ruk voor, het is een opgerekte G80/G92 waar ze niet 100% rendement uit hebben weten halen. Het is in vrijwel alle opzichten G92, maar dan 75% tot 100% uitvergroot. En daar halen ze met pijn en moeite 50% meer performance uit.

Ik snap dat jullie willen kijken naar de tijdlijn, maar de tijdlijn zegt geen reet over wat je nu kan verwachten. Dan moet je toch echt kijken naar wat Nvidia uit die shrinks en architecturen haalt op bepaalde groottes, en waarom. Sowieso mag je ofwel de 480, ofwel de 580 simpelweg niet mee tellen omdat de één een refresh van de ander is. Maar als ik dan toch bezig ben; GK110 (780) is eigenlijk ook een refresh, dus die moet je vergelijken met GF110 (580). Maar GK104 (680) moet je dan weer vergelijken met GF104. Beide geen refresh

Daarnaast vergeten jullie allemaal het feit dat we het hier over een nieuwe node hebben. Architectuur weten we nog niet zeker, maar op basis van GP100 durf ik te stellen dat we vooral veel Maxwell krijgen. Maar als Nvidia bijvoorbeeld op de GK104 toer gaat en een hoop GPGPU er uit sloopt, dan zou 32% ronduit slecht zijn. Zelfs zonder dat is 32% teleurstellend. Dat zou een verdomd laag rendement betekenen ten opzichte van GM204, tenzij GP104 een flink stuk kleiner is.

Dit heb ik nagezocht op basis van de performance summary van Techpowerup. In de bron staan de linkjes naar elke test. Dat is 8 jaar GPU historie.Die 30% is historisch gezien inderdaad niet gek. De 980 was 33% sneller dan de 780. De 780 15% sneller dan de GTX 680 (zelfde architectuur). De 680 was 33% sneller dan de GTX 580. De GTX 580 was 17% sneller dan de GTX 480 (zelfde architectuur). De GTX 480 was 35% sneller dan de GTX 280. Daar komt inderdaad een redelijk stabiel patroon van +- 33% naar voren. Dus dat is een hele veilige, maar goede voorspelling.

Ik vindt de percentages te gelijkwaardig om van toeval te spreken. Ik heb sterk het vermoeden dat het volgende bij Nvidia gebeurd: Er komt een nieuwe architectuur/nm, het doel is circa 35% gains. Vervolgens is het afwachten hoe goed de nieuwe reeks wordt, ook voor Nvidia. Recent bleek dat ze de nieuwe kaart 10-12 maanden in het lap emuleren om hem te finetunen. Dus dan kun je nog heel wat veranderen.

Stel dat de nieuwe architectuur super goed is dan pakken ze een minichip om de nieuwe x80 te voorzien. Dat levert immers meer geld op. Hoe meer het tegen valt, des te groter de chip. Hoogst waarschijnlijk hadden ze rond de GTX 680 een bovengemiddelde "win" te pakken. Waardoor ze met een kleinere chip afkonden. Vervelend voor de consument, goed voor de aandeelhouders. Andere jaren hadden ze grotere slurpers nodig (er was ooit een tijd dat Nvidia als power hungry bekend stond).

Dus als Pascal zou tegenvallen dan zouden we een soort Tesla P100 monster zien als GTX 1080, lukt hij super goed dan wordt het een soort energie zuinig mini ding a la de GTX 750. Vervolgens worden de clocks exact getuned om die 35% te halen. Dit zijn natuurlijk opzettelijk twee extremen, het kan er ook prima tussen zitten. Het punt is dat wat er ook met die architectuur gebeurd, het blijft circa 35%. Zo is het in ieder geval tot nu toe gegaan.

Natuurlijk kunnen er altijd externe redenen zijn om de strategie aan te passen, zoals AMD die suggereert voor 250 dollar GTX 980 ti performance te leveren. Er zijn zat andere redenen te verzinnen (VR pushen, AMD het leven zuur maken, AMD die eerder launched, enz). Maar cetris paribus is die +35% de meest logische uitkomst.

Om een lang verhaal kort te maken: ik verwacht dat het grootste deel van de winst van de trippple " win" die we nu hebben (architectuur, die shrink en nieuw geheugen) omgetoverd gaat worden in marge. Alleen AMD kan dat voorkomen.

Of dat gaat gebeuren? Geen idee! Aan de ene kant kan AMD enorm profiteren om mee te gaan in de marge stijging. Aan de andere kant is het marktaandeel nu echt te laag, AMD kennende geven ze niet zo veel om marge. Dus wat dat betreft zouden die weleens iets 'geks' in petto kunnen hebben. Dat wordt echt afwachten. Ik kan beide keuzes op dit moment respecteren.

[ Voor 18% gewijzigd door sdk1985 op 02-05-2016 04:12 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Tja, je kunt op chips kijken, of je kunt gewoon kijken naar waar je als consument mee te maken krijgt. De prijs en de positionering zoals Nvidia die verzint.Werelds schreef op maandag 02 mei 2016 @ 01:31:

Jullie kijken echter verkeerd naar die cijfers.

Een GTX 680 is een klasse kleiner dan de 280, 480 en 580.

Even los van in welke volgorde en wanneer ze uitkomen is het

280 -> 480 -> 580 -> 780 -> 980 Ti

NIL -> 460 -> 560 Ti -> 680 -> 980

Van GT200 is geen mid-size chip gemaakt. Daarnaast is de 500 serie een refresh en mag je dus verwachten dat die minder vooruitgang toont en dat is ook zo.

Ik weet dat sommige van jullie (hoi sdk1985) het hier niet mee eens zijn, maar dit is wel de werkelijkheid. Een 680 is geen opvolger van een 580. Een 680 is een mid-size chip en daarmee de opvolger van de 560 Ti. Dat maakt de sprong eigenlijk nog veel indrukwekkender, totdat je kijkt waarom dat is: 0,0 GPGPU "grunt".

De 680 is gewoon de logische opvolger van de 580. Hoe Nvidia dat achter de schermen met de chips knutselt, dat mogen ze zelf uitzoeken.

Als een mid-size chip, presteert zoals een high-end chip, waarom zou je er dan geen high-end opvolger van maken? Altijd maar krampachtig vasthouden aan welke chip er in een kaart zit...heeft totaal geen nut.

Dan kun je langs de zijlijn gaan roepen "Oeh, ik wil geen 500 euro betalen voor een mid-size chip", maar daar heeft Nvidia dan (terecht) schijt aan. Het gaat om de prestaties, en de positionering tov vroegere producten en de concurrentie. En als je daarnaar kijkt, dan zie je gewoon een bijna lineare toename van rond de 20-30% per generatie voor de topkaart (Ti's uitgezonderd).

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Waarom 780 -> 980? Chronologisch klopt dat niet, de 980 kwam bijna exact een jaar na de 780 Ti uit, met de 780 heb je het over 18 maanden. En qua positionering? Ook niet, want de 980 is een flink stuk lager ingezet dan de 780. Sterker nog, de 780 werd hoger ($699) ingezet dan zelfs een 980 Ti ($649).sdk1985 schreef op maandag 02 mei 2016 @ 03:55:

Dan haal ik toch mijn eigen quote maar even van stal

780 en 680 behoren verder níet tot dezelfde architectuur op de manier waarop de 480 en 580 dat zijn. Een 780 is een grotere versie van een 680, met daarin de GPGPU capaciteit weer terug ingevoerd. De basis van een 780 is hetzelfde, maar de opbouw is volledig anders. Een 580 is een refresh van een 480 en nagenoeg identiek. Het is een idioot scheve vergelijking waarbij je alleen kijkt naar de gemiddelde gaming prestaties op een specifieke resolutie, niet naar het bijbehorend stroom verbruik, warmte ontwikkeling en de algehele prestaties (met ook GPGPU prestaties). Als GK110 een opgerekte GK104 was geweest had dat ding een veel grotere impact gehad. Daarnaast houd je totaal geen rekening met het feit dat de hele GF10x reeks kapot was. Geen enkele chip in die "generatie" was een volledige chip, ze hadden allemaal uitgeschakelde clusters en laten dus niet zien wat de architectuur eigenlijk kan.

Mijn punt is niet dat je de chips niet chronologisch kunt of mag vergelijken, of op basis van positionering. Dat mag best.

Mijn punt is dat jullie speculeren en conclusies proberen te trekken op een manier die als een tang op een varken slaat. Het slaat echt helemaal nergens op, want juist de laatste 4 "generaties" zit geen enkele logica in. Speculeren kan best, maar gebruik dan de juiste gegevens. GF10x is waardeloos als vergelijkingsmateriaal omdat het allemaal kapotte chips zijn. Als je tijdens het speculeren uit gaat van een succesvol productie proces kun je GF10x dus niet gebruiken.

Fout. Nogmaals, je kijkt alleen naar de laatste 4 generaties, waar Nvidia hele rare sprongen heeft gemaakt. Je vergelijkt constant volledig willekeurig refreshes met non-refreshes; waarom heb je de GTX 285 overgeslagen? Ga ook eens verder terug. Even los daarvan: een GTX 480 is niet 33% sneller dan een 280; een 280 is 33% langzamer dan een 480. 100% / 67% = 149% - een GTX 480 is dus 49% sneller dan een 280. En ja, ook dit is belangrijk, omdat je anders verkeerd naar de cijfers kijkt.Ik vindt de percentages te gelijkwaardig om van toeval te spreken. Ik heb sterk het vermoeden dat het volgende bij Nvidia gebeurd: Er komt een nieuwe architectuur/nm, het doel is circa 35% gains. Vervolgens is het afwachten hoe goed de nieuwe reeks wordt, ook voor Nvidia. Recent bleek dat ze de nieuwe kaart 10-12 maanden in het lap emuleren om hem te finetunen. Dus dan kun je nog heel wat veranderen.

Waarom? Men neme: A op 100%, B op 80%, C op 70%. A is dan 100/80 = 25% sneller dan B, 100/70 = 43% sneller dan C. 43 - 25 = 18, niet 10% zoals het volgens jouw woorden zou zijn. B is in dit geval 80/70 = 14% sneller dan C. Kijk maar naar de daadwerkelijke framerates van de 480 tegenover de 280.

Ook hier weer: waarom Ti's uitgezonderd? Titans wel ja, die zitten gewoon 30-40% hoger qua voor 0,0 prestaties, dus die zijn nutteloos. Maar Ti's zijn geen opgefokte versies of wat dan ook; een 980 Ti is gewoon GM200, een andere chip dan 980. Een 780 Ti is gewoon een volledige GK110 (waar de 780 een gecastreerde chip is).Jeroenneman schreef op maandag 02 mei 2016 @ 12:09:

Tja, je kunt op chips kijken, of je kunt gewoon kijken naar waar je als consument mee te maken krijgt. De prijs en de positionering zoals Nvidia die verzint.

De 680 is gewoon de logische opvolger van de 580. Hoe Nvidia dat achter de schermen met de chips knutselt, dat mogen ze zelf uitzoeken.

Als een mid-size chip, presteert zoals een high-end chip, waarom zou je er dan geen high-end opvolger van maken? Altijd maar krampachtig vasthouden aan welke chip er in een kaart zit...heeft totaal geen nut.

Dan kun je langs de zijlijn gaan roepen "Oeh, ik wil geen 500 euro betalen voor een mid-size chip", maar daar heeft Nvidia dan (terecht) schijt aan. Het gaat om de prestaties, en de positionering tov vroegere producten en de concurrentie. En als je daarnaar kijkt, dan zie je gewoon een bijna lineare toename van rond de 20-30% per generatie voor de topkaart (Ti's uitgezonderd).

Een refresh (shrink en/of tweak in architectuur) is doorgaans goed voor 10-40% aan prestaties. Als het slechts één van de twee is zit je aan het lage eind van dat spectrum, als het beide is zit je aan het hoge eind. Point in question: G92a (beide; makkelijk 25% winst), G92b (shrink, 10%), GT200b (shrink, 10-15% in het gunstigste geval), GF110 (tweak, 15%).

Daarnaast heb je de architecturen. Dit kán alleen al goed zijn voor een sprong van 50% in prestaties. En dit is waar chip grootte er weldegelijk toe doet, hoe hard jullie ook schreeuwen dat dat niet zo is. Bear with me.

Fermi (GF100) was pakweg 50% sneller dan Tesla (GT200

Point in question? GF10x.

- GF104 -> GF100 = +45%

- GF114 -> GF110 = +30%

- GF100 -> GF110 = +10%

- GF104 -> GF114 = +25%

GF104 had 1 van de 8 SMs uitgeschakeld, ofwel 48 SP's (12,5%). GF100 had 1 van de 16 SMs uitgeschakeld, ofwel 32 SP's (6,25%). GF114 en GF110 zijn beide volledige chips. Als je dat even weg rekent en onthoudt dat beide ook op hogere kloksnelheden draaiden (22% en 10% voor GF114 en GF104 respectievelijk) zie je dat dat beide eigenlijk niet beter presteren dan de vorige "generatie" (zie ook 570 vs 480; die zijn gelijk aan elkaar). Nog veel belangrijker is dat GF110 behoorlijk minder stroom verbruikte dan GF100, terwijl GF114 min of meer op hetzelfde verbruik zit. Met andere woorden, Performance Per Watt van GF114 is gelijk aan GF104, terwijl GF110 het 25% beter doet dan de vorige "generatie".

Nu kom ik eindelijk (sorry

Dit zie je ook terug in GK104 tegenover GK110 (90% groter, 90% meer shaders...en dan zelfs op 1440p net geen 50% winst) en GM204 tegenover GM200 (50% groter, 37,5% meer shaders en dan 25% performance).

Daarnaast is de 500 serie dus helemaal geen "nieuwe generatie". De prestaties zijn niet beter geworden, de architectuur is niet anders, het is geen die shrink. Het is exact dezelfde chip als een jaar eerder, maar nu met de juiste materialen waardoor het ding doet wat Nvidia oorspronkelijk voor ogen had. Dus nee, "chronologisch", "generatie", "positionering" zijn allemaal ongeldige methodes als je wil speculeren over wat een nieuwe chip gaat doen. Je moet toch echt kijken naar de vorige chips, niet hun positionering.

Of je moet rekening houden met het feit dat Nvidia dit net zo hard kan verkloten als met Fermi en dat de GP104 die we gaan zien dus ook meteen een kapotte chip kan worden die helemaal niet indrukwekkend is

[ Voor 12% gewijzigd door Werelds op 02-05-2016 15:17 ]

Nou, aangezien jij duidelijk wél weet hoe het werkt met chips en verschillende processen: Waarom wachten we nog op die benchmarks? Blijkbaar kun jij al bij voorbaat uitrekenen hoe krachtig Pascal gaat zijn.

Geweldig! Ik stel voor dat je dan nu wereldkundig maakt precies hoeveel fps de GTX 1080 zal halen bij de nieuwste titels.

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Ik rijk je juist een rationele logica aan. Het is geen technische verklaring, maar een bedrijfskundige. Net als dat Intel gerunned wordt door een stel accountants en advocaten heb ik een donkerbruin vermoeden dat ze ook wat bij Nvidia in te brengen hebben.Werelds schreef op maandag 02 mei 2016 @ 15:00:

[...]

Mijn punt is dat jullie speculeren en conclusies proberen te trekken op een manier die als een tang op een varken slaat. Het slaat echt helemaal nergens op, want juist de laatste 4 "generaties" zit geen enkele logica in. Speculeren kan best, maar gebruik dan de juiste gegevens. GF10x is waardeloos als vergelijkingsmateriaal omdat het allemaal kapotte chips zijn. Als je tijdens het speculeren uit gaat van een succesvol productie proces kun je GF10x dus niet gebruiken.

Nogmaals, mijn hele redenatie draait erom dat het niet relevant is hoe goed de architectuur lukt. Het idee is dat binnen wat mogelijk is het x80 model een bepaalde performance boost vertegenwoordig. Intel heeft decennia lang geprobeerd zich aan de eigen Moore's Law te houden tot het punt dat het een doelstelling op zich werd (en hij is bijgesteld, en vervolgens alsnog werd losgelaten vorig jaar). Het lijkt erop dat Nvidia ook met een bepaalde doelstelling werkt.

Je mag van mij best de percentages bij elke grafiek omdraaien, ze zijn alleen elke keer van opvolger - voorganger gepakt (ivm makkelijk controleren).

Maar goed, als consument zie ik ook liever een geweldig succes en een $150 chip die GTX 980 Ti prestaties haalt. Alleen zo lang AMD dit niet aanbied is Nvidia niet gebaat bij een dergelijke launch.

Verder ben ik het met de tekst hierboven eens. Het is altijd makkelijk andere af te vallen die een poging doen een onderbouwde voorspelling te doen. Echter in dat geval verwacht ik wel een tegenvoorspelling. Ik heb nu een omgekeerde 35% voorspelt voor het nieuwe x80 model. Kom maar op met een onderbouwd getal. Over niet al te lange tijd weten we wie er het dichtste bij zat.

[ Voor 12% gewijzigd door sdk1985 op 02-05-2016 15:30 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Verschil is dat ik niet beweer dat ik dat kan. Ik heb al eerder wat voorzichtige ruwe cijfers gepost (hier) op basis van de technische gegevens waar we al zeker van kunnen zijn (28nm -> 16nmFF+ is overigens ook een grotere sprong dan we de laatste 10 jaar hebben gezien, iets waar iedereen ook doodleuk aan voorbij gaat), maar het is nog steeds natte vinger werk.Jeroenneman schreef op maandag 02 mei 2016 @ 15:22:

[...]

Nou, aangezien jij duidelijk wél weet hoe het werkt met chips en verschillende processen: Waarom wachten we nog op die benchmarks? Blijkbaar kun jij al bij voorbaat uitrekenen hoe krachtig Pascal gaat zijn.

Geweldig! Ik stel voor dat je dan nu wereldkundig maakt precies hoeveel fps de GTX 1080 zal halen bij de nieuwste titels.

"Gokken" dat we 30% winst gaan zien omdat dat bij 1 of 2 "generaties" zo uit kwam is gewoon onzin als die "generaties" geen generaties zijn. Een 580 staat niet tot een 480 als een 780 tot een 680. Tussen de 780 en 680 zit een wereld van verschil, terwijl een 580 en 480 nagenoeg identiek zijn; het verschil daar kwam puur doordat de 580 geen kapotte chip was. Nogmaals, vergelijk een 570 met een 480. Dan heb je het over exact dezelfde chips met iets andere materialen. 0,0 winst qua prestaties.

Ik beweer ook niet dat we geen slappe +30% gaan zien. Ik zeg alleen dat de logica die we in dit topic zien nergens op slaat. Product komt eerst, positionering pas daarna. Als Nvidia voor die +30% wil gaan zullen ze daar ook de chip voor ontworpen moeten hebben. En een GP104 die op GM204 voortborduurt, maar dan met twee keer zo veel transistors op grofweg dezelfde grootte gaat die 30% in theorie gewoon keihard voorbij.

Ik snap volledig wat je probeert te doen, maar waarom sla je de helft dan over?sdk1985 schreef op maandag 02 mei 2016 @ 15:27:

Ik rijk je juist een rationele logica aan. Het is geen technische verklaring, maar een bedrijfskundige. Net als dat Intel gerunned wordt door een stel accountants en advocaten heb ik een donkerbruin vermoeden dat ze ook wat bij Nvidia in te brengen hebben.

Nogmaals, je positioneert een 980 ($549) tegenover een 780 ($649) en negeert de 780 Ti ($699). Vervolgens zet je ook een 580 tegenover een 480, maar je zet dan de 780 Ti niet tegenover de 780 (wat exact dezelfde situatie is; zelfs het tijdsbestek verschilt niet zo veel).

Ik weet ook niet waarom jij en vele anderen zo gefocust zijn op die denkbeeldige grens op $549. Een 8800 GTX kostte ook gewoon $599 hoor. De GTS (gecastreerde chip kuchkuch) kostte $499. GTX 280? $649. Er is geen enkele reden om de Ti varianten over te slaan, integendeel. De 480 t/m 680 zaten op hun respectievelijke prijzen omdat AMD Nvidia gedwongen had zo "laag" te zakken.

En dat bedrijfskundige gaat hier niet helemaal op. Waar het voor Intel een stuk lastiger is zulke winsten te halen, is het dat voor Nvidia en AMD niet op 16nmFF+. Ik zeg het hierboven al, als Nvidia voor die "standaard" 30% van jou wil gaan dan betekent dat dat de accountants ook het ontwerp dicteren. Als ze voortborduren op het Maxwell ontwerp en GP104 gewoon een ~300mm² chip wordt zoals z'n voorgangers gaat hij die 30% in theorie met gemak voorbij.

Of denk je dat de accountants vervolgens mogen bepalen dat de chip niet harder dan 800 MHz mag tikken omdat hij anders te snel is?

Edit:

Zie de link hierboven. Ik beweer helemaal niet dat we 100% of zelfs 75% winst gaan zien, ik zeg alleen dat technisch gezien 30% wel heel slecht zou zijn. Alleen al op basis van kloksnelheden kom je al akelig dicht daar bij in de buurt. Of GP104 wordt een stuk kleiner dan iedereen verwacht...meer zoals Polarissdk1985 schreef op maandag 02 mei 2016 @ 15:27:

Verder ben ik het met de tekst hierboven eens. Het is altijd makkelijk andere af te vallen die een poging doen een onderbouwde voorspelling te doen. Echter in dat geval verwacht ik wel een tegenvoorspelling. Ik heb nu een omgekeerde 35% voorspelt voor het nieuwe x80 model. Kom maar op met een onderbouwd getal. Over niet al te lange tijd weten we wie er het dichtste bij zat.

[ Voor 10% gewijzigd door Werelds op 02-05-2016 15:56 ]

Alleen zie je die winst niet één of twee generaties, maar bijna sinds de 8800GTX.Werelds schreef op maandag 02 mei 2016 @ 15:51:

[...]

"Gokken" dat we 30% winst gaan zien omdat dat bij 1 of 2 "generaties" zo uit kwam is gewoon onzin als die "generaties" geen generaties zijn. Een 580 staat niet tot een 480 als een 780 tot een 680. Tussen de 780 en 680 zit een wereld van verschil, terwijl een 580 en 480 nagenoeg identiek zijn; het verschil daar kwam puur doordat de 580 geen kapotte chip was. Nogmaals, vergelijk een 570 met een 480. Dan heb je het over exact dezelfde chips met iets andere materialen. 0,0 winst qua prestaties.

En daar zit het toverwoord "theoretisch". Als Nvidia zelf al doorheeft dat GP104 ver voorbij GM204 gaat, dan gaan ze hem gewoon flink afremmen. Lagere kloksnelheid, agressieve Boostsnelheden, weinig speelruimte. Het is niet in hun belang om consumenten opeens een 60% snellere kaart te leveren.Werelds schreef op maandag 02 mei 2016 @ 15:51:

Ik beweer ook niet dat we geen slappe +30% gaan zien. Ik zeg alleen dat de logica die we in dit topic zien nergens op slaat. Product komt eerst, positionering pas daarna. Als Nvidia voor die +30% wil gaan zullen ze daar ook de chip voor ontworpen moeten hebben. En een GP104 die op GM204 voortborduurt, maar dan met twee keer zo veel transistors op grofweg dezelfde grootte gaat die 30% in theorie gewoon keihard voorbij.

Ik denk dat dat precies is wat we bedoelen. Nvidia kan prima kijken naar wat AMD doet, en daarop de snelheden aanpassen. Het is totaal niet in hun belang om veel sneller te zijn, ze moeten namelijk de volgende generatie ook nog winst kunnen boeken! Misschien vervelend voor consumenten, maar zo werken bedrijven nu eenmaal. Nvidia hoeft maar marginaal sneller te zijn dan AMD, en ze kunnen prima de prijs dicteren. Waarom zou je dan gelijk alle performance uit je product gratis prijsgeven, als je het ook kunt uitsmeren over meerdere generaties (of, zoals momenteel, consumenten premiumprijzen laten betalen, voor een mid-range chip)Werelds schreef op maandag 02 mei 2016 @ 15:51:

Ik snap volledig wat je probeert te doen, maar waarom sla je de helft dan over?

Nogmaals, je positioneert een 980 ($549) tegenover een 780 ($649) en negeert de 780 Ti ($699). Vervolgens zet je ook een 580 tegenover een 480, maar je zet dan de 780 Ti niet tegenover de 780 (wat exact dezelfde situatie is; zelfs het tijdsbestek verschilt niet zo veel).

Ik weet ook niet waarom jij en vele anderen zo gefocust zijn op die denkbeeldige grens op $549. Een 8800 GTX kostte ook gewoon $599 hoor. De GTS (gecastreerde chip kuchkuch) kostte $499. GTX 280? $649. Er is geen enkele reden om de Ti varianten over te slaan, integendeel. De 480 t/m 680 zaten op hun respectievelijke prijzen omdat AMD Nvidia gedwongen had zo "laag" te zakken.

En dat bedrijfskundige gaat hier niet helemaal op. Waar het voor Intel een stuk lastiger is zulke winsten te halen, is het dat voor Nvidia en AMD niet op 16nmFF+. Ik zeg het hierboven al, als Nvidia voor die "standaard" 30% van jou wil gaan dan betekent dat dat de accountants ook het ontwerp dicteren. Als ze voortborduren op het Maxwell ontwerp en GP104 gewoon een ~300mm² chip wordt zoals z'n voorgangers gaat hij die 30% in theorie met gemak voorbij.

Of denk je dat de accountants vervolgens mogen bepalen dat de chip niet harder dan 800 MHz mag tikken omdat hij anders te snel is?

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Iets met 28nm en nog altijd 2 680s (ja Werelds, zelfde week als de jouwe, heb je hem nog?).

Ik ben het absoluut met je eens, alleen vind ik dat de 8800GTS/GTX/Ultra (aka G80) nou niet echt een plek verdienen in de categorie "klein"...Werelds schreef op maandag 02 mei 2016 @ 01:31:

Naar G92 (of eerder) kijken heeft geen nut, omdat Nvidia toen nog niet zo belachelijk groot aan het bakken was.

Mijn punt is echter dat A: de cijfers niet kloppen, en B: de generaties niet kloppen. Even los van het verhaal ná de 580, slaat sdk1985 bijvoorbeeld de 285 over. Als je GF110 mee telt, moet je GT200b ook meetellen. Daarnaast zijn sommige van die generaties simpelweg geen generaties. Nogmaals, een 580 is geen nieuwe generatie, het is dezelfde chip maar dan zonder defecten. Geen verschillen in de architectuur, geen shrink, alleen betere materialen.Jeroenneman schreef op maandag 02 mei 2016 @ 15:58:

Alleen zie je die winst niet één of twee generaties, maar bijna sinds de 8800GTX.

Al sinds de 8800 GTX? Een 9800 GTX presteert nagenoeg identiek aan een 8800 GTX. Qua prijs zat hij een stuk lager, maar het is weldegelijk een nieuwe generatie. Wat doe je daar dan mee? Of wil je de 8800 GT (eerste kaart met G92) als nieuwe generatie nemen? Kan ook, maar waar vergelijk je die dan mee? De hele 9800 generatie deed het niet beter dan de vorige generatie, behalve dan qua stroom verbruik.

GTX 285 ten opzichte van de 280 dan maar? Heb je het met pijn en moeite over 5% dankzij net iets hogere clocks. Zit echter wel weer 6 maanden tussen, waarbij de laatste een shrink is en minder verbruikt.

Hier heb je overigens de daadwerkelijke cijfers uit sdk1985's lijst, met gecorrigeerde percentages gebaseerd op de TPU benchmarks van de nieuwere kaart ten tijde van release. Cijfers neem ik van de 1080p/1200p Performance Summary, omdat ze niet allemaal een "All Resolutions" hebben.

- 980 > 780 = +29,9% (architectuur)

- 780 > 680 = +20,5% (grotere chip)

- 680 > 580 = +23,5% (node + architectuur)

- 580 > 480 = +14,9% (tweak/fix)

- 480 > 280 = +53,9% (node + architectuur)

- 280 > 8800 = +37,0% (node + opgeblazen architectuur, was geen echt nieuwe architectuur)

Daar zit verrekte weinig structuur in. Gemiddeld is het dan wel 29%, maar het gaat alle kanten uit. Even op mijn manier doen? Ik hoef pas te corrigeren vanaf de 680.

- 980 Ti > 780 Ti = +35,1% (architectuur)

- 980 > 680 = +56,3% (architectuur)

- 780 Ti > 580 = +81,8% (node + architectuur)

- 680 > 560 Ti = +69,5% (node + architectuur)

- 580 > 280 = +78,6% (node + architectuur, bonus cijfer: dit is wat de 480 had moeten zijn)

- 580 > 480 = +14,9% (tweak/fix)

- 480 > 280 = +53,9% (node + architectuur)

- 280 > 8800 = +37,0% (node + opgeblazen architectuur)

Enige vreemde uitschieter is 980 > 680. Dat is meer dan die 15-40% die ik aan geef voor alleen een nieuwe architectuur op dezelfde node. Maar die is technisch 100% te verklaren: 35% grotere die. En als je de 580 neemt in plaats van de 480, is ook de sprong vanaf de 280 in lijn met de sprong daarna van Fermi naar Kepler. Voor de rest zitten de sprongen nu veel dichter bij elkaar. Wij zitten nu op de mid-size sprong; dat is dus 560 Ti -> 680 -> 980 -> 1080(?).

Wij krijgen nu sowieso een nieuwe node. En dat is waar de grootste winst zit. Ondanks het feit dat GT200 niet vernieuwend was, liet de nieuwe node wel toe dat ze de architectuur op veel grotere schaal toe konden passen. G80 was 434mm², G92a was 324mm², G92b was 260mm², GT200 was 576mm². Transistors? 681, 754, 754 en 1400 (miljoenen). 1400/754 = 85,7%...zie je de link? De architectuur in GP100 is niet echt vernieuwend, maar ik heb al eerder aangegeven dat ik verwacht dat GP104 er anders uit ziet en dat we een GP102 of iets dergelijks krijgen als grote "game" chip.

Is 30% onmogelijk? Absoluut niet. En het kan best dat ik volledig fout zit. Maar als dat zo is dan wordt GP104 een verdomd vreemde chip, die veel kleiner is dan we van Nvidia gewend zijn. Of hij presteert ondermaats voor z'n afmetingen.

Daar schrikken ze ook meteen veel mensen mee af. Als ik even met je mee denk, ga jij dus gewoon uit van een GP104 ten grootte van ergens tussen GK104 en GM204 in. Zelfs in de grootte van GK104 krijgen ze meer dan 7 miljard transistors geperst. 50% meer dan GM204.En daar zit het toverwoord "theoretisch". Als Nvidia zelf al doorheeft dat GP104 ver voorbij GM204 gaat, dan gaan ze hem gewoon flink afremmen. Lagere kloksnelheid, agressieve Boostsnelheden, weinig speelruimte. Het is niet in hun belang om consumenten opeens een 60% snellere kaart te leveren.

Dus jij denkt dat ze vervolgens de chip gewoon gaan knijpen naar clocks (ruim) onder de GHz? Lijkt me sterk. Dat staat ook slecht, aangezien kloksnelheden de laatste 10 jaar alleen maar hoger zijn geworden.

Echter kan Nvidia in dit geval niet zomaar afwachten. Het is al te laat om nog zulke wijzigingen aan te brengen, productie moet al in gang zijn gezet als de geruchten qua datums kloppenIk denk dat dat precies is wat we bedoelen. Nvidia kan prima kijken naar wat AMD doet, en daarop de snelheden aanpassen. Het is totaal niet in hun belang om veel sneller te zijn, ze moeten namelijk de volgende generatie ook nog winst kunnen boeken! Misschien vervelend voor consumenten, maar zo werken bedrijven nu eenmaal. Nvidia hoeft maar marginaal sneller te zijn dan AMD, en ze kunnen prima de prijs dicteren. Waarom zou je dan gelijk alle performance uit je product gratis prijsgeven, als je het ook kunt uitsmeren over meerdere generaties (of, zoals momenteel, consumenten premiumprijzen laten betalen, voor een mid-range chip)

Paprika schreef op maandag 02 mei 2016 @ 16:54:

Ook ik begin langzaam weer eens hier te lezen, nadat de GPU wereld laatste jaren (naar mijn gevoel) erg stil heeft gestaan...

Iets met 28nm en nog altijd 2 680s (ja Werelds, zelfde week als de jouwe, heb je hem nog?).

Nee

Eerst vervangen door een MSI 770, omdat ik die DCU2 op m'n 680 zat was, takke herrie. En nu zit ik op een 970.

Wel voor Nvidia's standaarden tegenwoordigIk ben het absoluut met je eens, alleen vind ik dat de 8800GTS/GTX/Ultra (aka G80) nou niet echt een plek verdienen in de categorie "klein"...

484mm² valt nog reuze mee, vergeleken met die 576, 529, 520, 561 en nu zelfs 601 die daarna volgden

En dat was ook aan het eind van de levensduur van 90nm. Niet aan het begin zoals Fermi of Kepler. Shrink binnen een jaar naar 324mm²

En dat was ook aan het eind van de levensduur van 90nm. Niet aan het begin zoals Fermi of Kepler. Shrink binnen een jaar naar 324mm²

De GeForce 7-serie kaarten verdienen dan ook geen seconde aandacht...Al sinds de 8800 GTX? Een 9800 GTX presteert nagenoeg identiek aan een 8800 GTX. Qua prijs zat hij een stuk lager, maar het is weldegelijk een nieuwe generatie.

'

'Even Wikipedia erbij genomen, wat werd die arme 8800GT (of eigenlijk G92) toch misbruikt. Eerst door z'n opgefokte broer (de 8800GTS) en broertje (de 8600GTS), dan als 9800GT (65nm), 9800GTX (65nm), 9600GSO (65nm), 9800GT (55nm), 9800GT Green Edition (55nm/75W), 9800GTX+ (55nm), GTS 150 (55nm), GTS 250 (65nm), GTS 250 Green Edition (65nm), GTS 240 (65nm), GTS 250 (55nm), GTS 250 Green Edition (55nm), GTS240 (55nm), GT 230 (v2, 55nm).

Ik neem aan dat ze nu allebei nu de volledige spec incl. featurelevels etc. etc. zullen ondersteunen.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Waarom dat?madmaxnl schreef op maandag 02 mei 2016 @ 21:12:

Je kunt nu al met grote zekerheid stellen dat nVidia DX12 gaat boycotten en bagatelliseren.

Ja daar ben ik ook heel benieuwd naar. Dit bepaalt ook de langdurige waarde van een straks kostbare Pascal in aanschaf.Help!!!! schreef op maandag 02 mei 2016 @ 18:06:

Tussen al het analyse geweld door, ben ik vooral benieuwd hoe goed de DX12 implementatie en prestaties van de Pascal chips zal zijn. En hoe Polaris en Pascal op dit punt nu zullen scoren.

Ik neem aan dat ze nu allebei nu de volledige spec incl. featurelevels etc. etc. zullen ondersteunen.

Is er al genoeg real life testmateriaal(een echte game) waar je dit een beetje mee kan testen? Het liefst meerdere games die goed zijn geoptimaliseerd voor WIndows zijn handig lijkt me. Zonder deze games geeft een benchmark ook alleen maar een synthetische en theoretische waarde waarvan je maar moet afwachten wat je er aan hebt.

Yippie kayak, other buckets!

NVIDIA teases GeForce 1000 series with “Order of 10” campaign (update: countdown has started!)

countdown naar ''release''?

wat denken jullie hiervan? Ik ben toch bang dat ik in alle hype dadelijk een GTX1070 ga halen en dan na computex blijkt dat AMD beter is.. heb been geduld meer..

[ Voor 19% gewijzigd door spartacusNLD op 03-05-2016 08:33 ]

Ryzen 7 7800X3D - Gigabyte B850 AORUS ELITE - Sapphire Nitro+ Radeon RX 9070 XT - Fractal Design Meshify 3 - Arctic Liquid Freezer III Pro 280 - Kingston Fury Beast 32GB - WD_Black 2TB

Hopelijk heb ik goed gegokt en is de eerste lichting kaarten niet al te buggy

I hear voices in my head, they counsel me, they understand.

Hier een mooi stukje over AMD: (onzin in t begin ff snel skippen)Trevor schreef op dinsdag 03 mei 2016 @ 08:42:

Ik zal wel moeten (1080 dan) want ik heb gisteren mijn 980 verkocht in de verwachting dat die tweedehands echt gaat kelderen. AMD heeft mij gewoon de afgelopen weken niet kunnen overtuigen dat ze competitief gaan zijn in het hoogste segment, die lijken meer op het middensegment te gaan richten.

Hopelijk heb ik goed gegokt en is de eerste lichting kaarten niet al te buggy

[YouTube: https://www.youtube.com/watch?v=g9JlMp4EAkg]

jarjar is sith confirmed

we gaan het zien.. hopelijk is de GTX1070 een stuk sterker als de 980.. als het verschil niet groot genoeg is koop ik ergens op de V&A een 980

[ Voor 4% gewijzigd door spartacusNLD op 03-05-2016 08:46 ]

Ryzen 7 7800X3D - Gigabyte B850 AORUS ELITE - Sapphire Nitro+ Radeon RX 9070 XT - Fractal Design Meshify 3 - Arctic Liquid Freezer III Pro 280 - Kingston Fury Beast 32GB - WD_Black 2TB

Ashes of the Singularity.jmk schreef op maandag 02 mei 2016 @ 23:10:

Is er al genoeg real life testmateriaal(een echte game) waar je dit een beetje mee kan testen? Het liefst meerdere games die goed zijn geoptimaliseerd voor WIndows zijn handig lijkt me. Zonder deze games geeft een benchmark ook alleen maar een synthetische en theoretische waarde waarvan je maar moet afwachten wat je er aan hebt.

Frostbite heeft verder het DX12 path klaar, zal waarschijnlijk wel in de volgende Battlefield komen.

UE4 heeft ook al een tijdje DX12 klaar, maar PC builds schakelen nog niet alles in. Async Compute wordt niet of nauwelijks gebruikt, terwijl dat op de XBO wel het geval is. Dat heeft alles met Nvidia te maken, ik verwacht dat Epic dat gaat "aankondigen" als Nvidia er met Pascal wel goed mee om kan gaan.

Hitman, Rise of the Tomb Raider hebben ook allebei DX12 ondersteuning, Deus Ex en Forza zullen het ook ondersteunen. En dingen als Ark, Star Citizen..maar of je daar nu waarde aan moet hechten?

http://orderof10.com/humanityshallbeenlightened

Het telt af naar het Press Event op vrijdag. GTX 10xx-series aankondiging?

En dat nvidia devs onder druk zou zetten om geen async compute te gebruiken... laat ze eerst eens games maken die gewoon goed werken onder dx12, die niet buggy zijn en niet langzamer dan dx11.

Mechwarrior Online: Flapdrol

Meer in de developers lijkt mij.haarbal schreef op dinsdag 03 mei 2016 @ 11:19:

Ik ben tot nu toe teleurgesteld in dx12

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Hitman problemen zijn al lang opgelost joh, met uitzondering van een bug met Fiji en Tonga waar je met sommige monitors een framerate lock hebt (iets raars in de aansturing aan AMD's kant)haarbal schreef op dinsdag 03 mei 2016 @ 11:19:

Ik ben tot nu toe teleurgesteld in dx12. Alleen in ashes is dx12 leuk, als je een amd kaart of een langzame cpu hebt. Tombraider en hitman kan je beter onder dx11 spelen, ook met amd kaarten.

En dat nvidia devs onder druk zou zetten om geen async compute te gebruiken... laat ze eerst eens games maken die gewoon goed werken onder dx12, die niet buggy zijn en niet langzamer dan dx11.

Fiji is dacht ik ook een grote refreshed oid Tonga chip niet?Werelds schreef op dinsdag 03 mei 2016 @ 12:29:

Hitman problemen zijn al lang opgelost joh, met uitzondering van een bug met Fiji en Tonga waar je met sommige monitors een framerate lock hebt (iets raars in de aansturing aan AMD's kant)

NVIDIA & Samsung Settle All Patent Infringement Disputes

Uitkomst was te verwachten nadat de eerste patenten van Nvidia werden afgekeurd en een aantal van Samsung werden goedgekeurd.Roughly a year and a half ago, NVIDIA opened up a patent infringement case against Samsung and Qualcomm, claiming that the various GPUs used by the two firms violated various NVIDIA patents. In response, Samsung opened up their own counter-suit, claiming that NVIIDA and its partners were violating Samsung patents. Since then, things have not progressed well for NVIDIA, with the US International Trade Commission (ITC) ruling that Samsung’s GPUs don’t infringe on NVIDIA’s patents, while also ruling that NVIDIA’s GPUs did infringe on Samsung’s patents.

Welke benchmarks heb jij gezien die ik niet heb gezien?Trevor schreef op dinsdag 03 mei 2016 @ 08:42:

Ik zal wel moeten (1080 dan) want ik heb gisteren mijn 980 verkocht in de verwachting dat die tweedehands echt gaat kelderen. AMD heeft mij gewoon de afgelopen weken niet kunnen overtuigen dat ze competitief gaan zijn in het hoogste segment, die lijken meer op het middensegment te gaan richten.

Hopelijk heb ik goed gegokt en is de eerste lichting kaarten niet al te buggy

Ik wil niet wachten op de benchmarks maar heel snel instappen. En dan zal ik toch een gok moeten wagen. Als er eind mei (ik verwacht rond die tijd de definitieve keuze en bestelling te gaan doen) info vrij komt dat polaris wel competitief is dan laat ik mij graag overhalen. Maar als ik moet gokken zonder direct verdere kennis.... dan gok ik op de 1080

(Let wel, ik beweer nergens dat het slim is wat ik doe

edit: Ik verwacht dat AMD met Vega de aansluiting in de topkaarten van Nvidia gaat zoeken, maar dus pas ergens volgend jaar. Maar het is gewoon allemaal persoonlijke interpretatie op basis van de nieuwsberichten die ik elke dag op zoek over Polaris en Pascal. Kan er dus nogmaals gruwelijk naast zitten uiteindelijk, but for me that's part of the game

[ Voor 20% gewijzigd door ArthurMorgan op 03-05-2016 15:40 ]

I hear voices in my head, they counsel me, they understand.

Beide hebben een GCN 1.2 architectuur. Waar Hawaii (R9 290(X), 390(X)) GCN 1.1 is.Nature schreef op dinsdag 03 mei 2016 @ 15:12:

[...]

Fiji is dacht ik ook een grote refreshed oid Tonga chip niet?

7970 en R9 280(X) zijn GCN 1.0.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik heb bij Polaris 10 vs GTX 10X0 een beetje het gevoel wat we ook bij de HD4870 vs GTX280 hadden.Trevor schreef op dinsdag 03 mei 2016 @ 15:37:

Geen benchmarks, maar meer de sfeer die ze opriepen met hun opmerking VR voor de massa te willen ontsluiten. Dat lijkt me meer richting op het midden met mooie prijzen voor hun kaarten (3 tot 400 dollar?) terwijl ik het gevoel krijg dat nvidia zich meer op het niveau erboven richt met de 1080.

Ik wil niet wachten op de benchmarks maar heel snel instappen. En dan zal ik toch een gok moeten wagen. Als er eind mei (ik verwacht rond die tijd de definitieve keuze en bestelling te gaan doen) info vrij komt dat polaris wel competitief is dan laat ik mij graag overhalen. Maar als ik moet gokken zonder direct verdere kennis.... dan gok ik op de 1080

(Let wel, ik beweer nergens dat het slim is wat ik doe)

edit: Ik verwacht dat AMD met Vega de aansluiting in de topkaarten van Nvidia gaat zoeken, maar dus pas ergens volgend jaar. Maar het is gewoon allemaal persoonlijke interpretatie op basis van de nieuwsberichten die ik elke dag op zoek over Polaris en Pascal. Kan er dus nogmaals gruwelijk naast zitten uiteindelijk, but for me that's part of the game

AMD ging daar voor een kleinere core met relatief veel performance voor zijn oppervlakte waardoor de prijs prestatie erg goed was. nVidia was de performance king die generatie maar was wel een stuk duurder de prijs prestatie verhouding was veel slechter: http://www.techpowerup.com/reviews/Diamond/HD_4870/23.html

Het zou mij niet verbazen als we een soor gelijke situatie krijgen. Polaris 10 is sneller dan Fury X en de Titan X van nVdia voor een lagere prijs +-400 dollar. Maar nVidia is een stuk sneller met zijn GTX1080 maar daar betaal je dan gewoon een stuk meer voor. en dan de snelste Polaris 10 qua prestaties meer in de buurt zit van de GTX1070.

Bij Vega verwacht ik ook iets wat meer bij de top prestaties van Big Pascal in de buurt moet gaan komen. Maar we zullen het allemaal wel gaan zien. Voorlopig blijft het speculeren en afwachten.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Zoals Astennu al zegt, zelfde GCN revisie inderdaad.Nature schreef op dinsdag 03 mei 2016 @ 15:12:

Fiji is dacht ik ook een grote refreshed oid Tonga chip niet?

Nvidia zet z'n high end chips natuurlijk ook liever af op de pro markt dan op de consumenten markt, qua marge.. Weet je toevallig of er ergens omzet van nvidia gesplitst is in consumenten gpu's en pro gpu's? Ik ben benieuwd naar wat de verhouding nu is. Gezien de populariteit van gpu compute lijkt me dat nvidia's afzet op de pro/compute markt alleen maar toeneemt tov de consumentenmarkt?sdk1985 schreef op maandag 02 mei 2016 @ 15:27:

[...]

Ik rijk je juist een rationele logica aan. Het is geen technische verklaring, maar een bedrijfskundige. Net als dat Intel gerunned wordt door een stel accountants en advocaten heb ik een donkerbruin vermoeden dat ze ook wat bij Nvidia in te brengen hebben.

Nogmaals, mijn hele redenatie draait erom dat het niet relevant is hoe goed de architectuur lukt. Het idee is dat binnen wat mogelijk is het x80 model een bepaalde performance boost vertegenwoordig. Intel heeft decennia lang geprobeerd zich aan de eigen Moore's Law te houden tot het punt dat het een doelstelling op zich werd (en hij is bijgesteld, en vervolgens alsnog werd losgelaten vorig jaar). Het lijkt erop dat Nvidia ook met een bepaalde doelstelling werkt.

Je mag van mij best de percentages bij elke grafiek omdraaien, ze zijn alleen elke keer van opvolger - voorganger gepakt (ivm makkelijk controleren).

Maar goed, als consument zie ik ook liever een geweldig succes en een $150 chip die GTX 980 Ti prestaties haalt. Alleen zo lang AMD dit niet aanbied is Nvidia niet gebaat bij een dergelijke launch.

Verder ben ik het met de tekst hierboven eens. Het is altijd makkelijk andere af te vallen die een poging doen een onderbouwde voorspelling te doen. Echter in dat geval verwacht ik wel een tegenvoorspelling. Ik heb nu een omgekeerde 35% voorspelt voor het nieuwe x80 model. Kom maar op met een onderbouwd getal. Over niet al te lange tijd weten we wie er het dichtste bij zat.

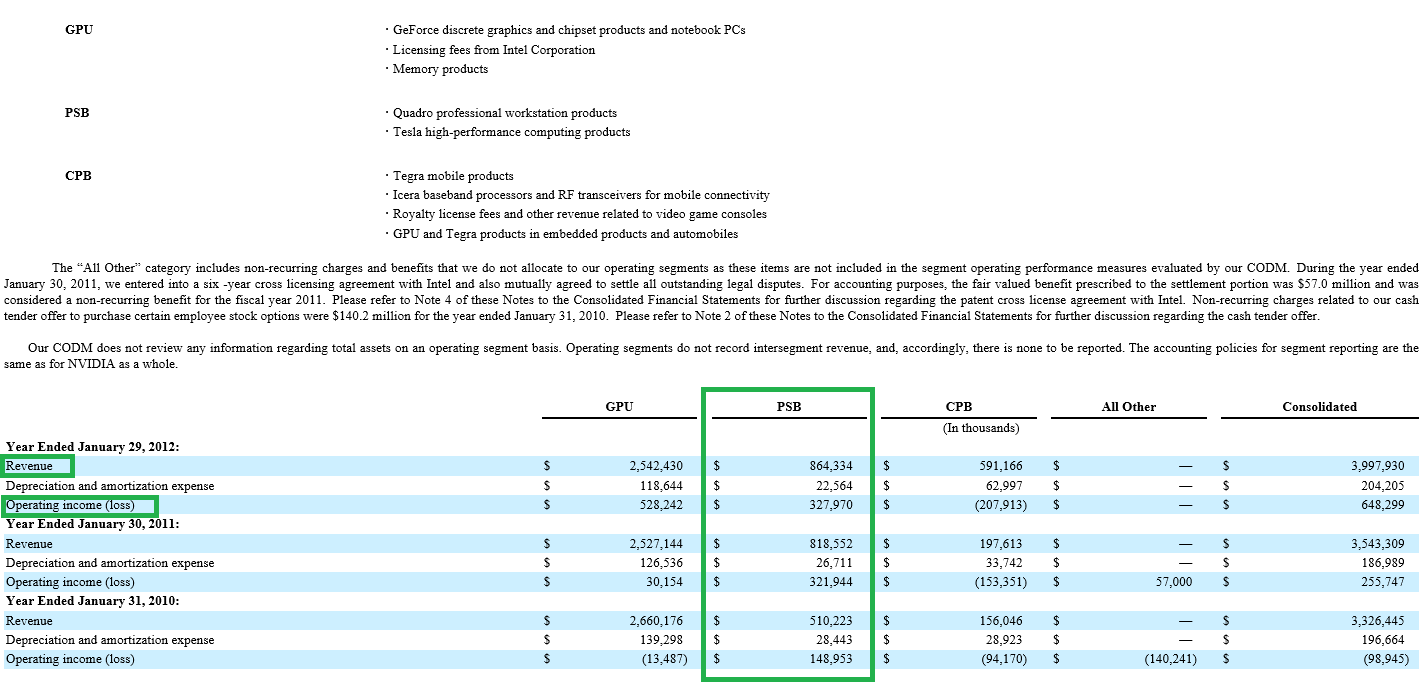

Zo ver ik weet was 2012 het laatste jaar waarbij de pro markt apart werd vermeld. Dat was ook tevens het jaar van het financiële success genaamd Fermi, de GPU divisie begon toen ook flink knaken te verdienen (528 miljoen). In tegenstelling tot de twee jaren ervoor waarbij alleen de Pro markt iets opleverde. CPB heeft vooral veel geld gekost.maratropa schreef op dinsdag 03 mei 2016 @ 17:31:

[...]

Nvidia zet z'n high end chips natuurlijk ook liever af op de pro markt dan op de consumenten markt, qua marge.. Weet je toevallig of er ergens omzet van nvidia gesplitst is in consumenten gpu's en pro gpu's? Ik ben benieuwd naar wat de verhouding nu is. Gezien de populariteit van gpu compute lijkt me dat nvidia's afzet op de pro/compute markt alleen maar toeneemt tov de consumentenmarkt?

[ Voor 5% gewijzigd door sdk1985 op 03-05-2016 17:46 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

thnxsdk1985 schreef op dinsdag 03 mei 2016 @ 17:44:

[...]

Zo ver ik weet was 2012 het laatste jaar waarbij de pro markt apart werd vermeld. Dat was ook tevens het jaar van het financiële success genaamd Fermi, de GPU divisie begon toen ook flink knaken te verdienen (528 miljoen). In tegenstelling tot de twee jaren ervoor waarbij alleen de Pro markt iets opleverde. CPB heeft vooral veel geld gekost.

[afbeelding]

Iig, als je als nvidia en chip hebt en die als Tesla of Quadro etc kunt wegzetten voor 4k+ of voor 700 euro als gtx dan snap ik wel wat finance kiest, vooral als de goedkopere chips de concurrent bijhouden..

Tegenwoordig zie je dan ook dat de nieuwe GPU tak (pro en consumenten) 1.1 miljard operationele winst draait. Dus veel meer dan de 528+328 =856 uit 2012. Op tegra draaien ze echter 250 mijoen verlies en All other kost nog eens 100 miljoen. Nvidia doet waarschijnlijk een poging zijn horizon aan het verbreden in plaats van alleen binnen GPU te denken. Voorlopig lukt het nog niet echt

[ Voor 8% gewijzigd door sdk1985 op 03-05-2016 18:01 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Ik heb dat gevoel niet, op een kleiner proces bakken als met de 4870 zit er niet meer in, en de kleinere pascal varianten zullen denk geen ruimte verspillen aan fp64, waar zou het verschil in productiekosten/prestaties gemaakt moeten worden?Astennu schreef op dinsdag 03 mei 2016 @ 16:20:

[...]

Ik heb bij Polaris 10 vs GTX 10X0 een beetje het gevoel wat we ook bij de HD4870 vs GTX280 hadden.

AMD ging daar voor een kleinere core met relatief veel performance voor zijn oppervlakte waardoor de prijs prestatie erg goed was. nVidia was de performance king die generatie maar was wel een stuk duurder de prijs prestatie verhouding was veel slechter: http://www.techpowerup.com/reviews/Diamond/HD_4870/23.html

Het zou mij niet verbazen als we een soor gelijke situatie krijgen. Polaris 10 is sneller dan Fury X en de Titan X van nVdia voor een lagere prijs +-400 dollar. Maar nVidia is een stuk sneller met zijn GTX1080 maar daar betaal je dan gewoon een stuk meer voor. en dan de snelste Polaris 10 qua prestaties meer in de buurt zit van de GTX1070.

Bij Vega verwacht ik ook iets wat meer bij de top prestaties van Big Pascal in de buurt moet gaan komen. Maar we zullen het allemaal wel gaan zien. Voorlopig blijft het speculeren en afwachten.

Mechwarrior Online: Flapdrol

Het is niet helemaal hetzelfde als toen. Maar zoals het er nu uit ziet is Polaris +-232mm2. GP104 zou rond de 300mm2 zitten. Daar zou dan al een klein prijs verschil zitten. Wellicht ook qua pcb of memory interface / memory chips. Maar dat is nog te vroeg om daar iets over te zeggen.haarbal schreef op dinsdag 03 mei 2016 @ 18:54:

[...]

Ik heb dat gevoel niet, op een kleiner proces bakken als met de 4870 zit er niet meer in, en de kleinere pascal varianten zullen denk geen ruimte verspillen aan fp64, waar zou het verschil in productiekosten/prestaties gemaakt moeten worden?

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Vergeet niet dat in die $500m ook $300m van Intel zit, dat schuiven ze doodleuk onder GPU. Daarnaast kwam het grootste deel uit notebook design wins volgens Nvidia zelf. Zo'n financieel succes was Fermi niet; in totaal zo'n $250m uit $5000m (FY2011 + FY2012, de twee Fermi jaren), waar AMD $200m uit $3000m haaldesdk1985 schreef op dinsdag 03 mei 2016 @ 17:44:

[...]

Zo ver ik weet was 2012 het laatste jaar waarbij de pro markt apart werd vermeld. Dat was ook tevens het jaar van het financiële success genaamd Fermi, de GPU divisie begon toen ook flink knaken te verdienen (528 miljoen). In tegenstelling tot de twee jaren ervoor waarbij alleen de Pro markt iets opleverde. CPB heeft vooral veel geld gekost.

[afbeelding]

[ Voor 6% gewijzigd door Werelds op 04-05-2016 01:00 ]

Omdat Pascal zeer waarschijnlijk niet of minder goed als AMD gebruik kan maken van Asynchronous Compute. Aangezien AMD met GCN, en dus Asynchronous Compute, in alle huidige en komende consoles zit mogen we er wel vanuit gaan dat deze feature gebruikt gaat worden, mits nVidia geen roet in het eten gooit. nVidia zal dus waarschijnlijk het gebruik van ASync gaan ontmoedigen en zoveel mogelijk bagatelliserende PR de wereld in sturen. Als ze dan dadelijk ASync voor elkaar hebben en het wellicht zelfs beter voor elkaar hebben dan AMD dan is ASync en DX12 opeens, 'je van het'.

Eerst tesselation tegenhouden/boycotten en vervolgens 32/64x tesselation sample rates forceren

Mechwarrior Online: Flapdrol

Als dit hét is zou ik misschien gewoon Polaris crossfire moeten overwegen...

I hear voices in my head, they counsel me, they understand.

Dit is de GTX 1080, als er ook een GTX 1080 Ti komt zal die allicht weer een stuk boven 980 Ti performance zitten. Hoe dan ook het blijft even afwachten, ook wat er qua drivers gaat gebeuren.Trevor schreef op donderdag 05 mei 2016 @ 18:39:

Is dat niet wat tegenvallend? Of zijn mijn verwachtingen te hoog, of gaan de custom kaarten hier fors boven komen?

Als dit hét is zou ik misschien gewoon Polaris crossfire moeten overwegen...

Bij release was een GTX 970 een stukje sneller dan de R9 290, door nieuwere drivers is de R9 290 nu gelijk of nog wat beter dan de GTX 970. De GTX 780 is naar verhouding in loop der tijd alleen maar afgenomen in performance relatief tot andere kaarten.

http://www.3dmark.com/3dm11/11061015

Fury X doet daar ergens rond de 13000-17000 punten, afhankelijk van de rest van 't systeem. 9000 seems low-ish, maar dat komt door CPU. Graphics score zou gelijk liggen met Fury X, 19.500 om 19.600.Sp3ci3s8472 schreef op donderdag 05 mei 2016 @ 19:34:

Blijkbaar is dit de GTX1070 score.

http://www.3dmark.com/3dm11/11061015

[ Voor 15% gewijzigd door Racing_Reporter op 05-05-2016 19:58 ]

Als je dit leest, heb je teveel tijd.

Ben ik met je eens, vond het ook een rare score. Het kan er aan liggen dat de clocksnelheid maar 545 is, met normale clocks zal hij een stuk hoger score.Racing_Reporter schreef op donderdag 05 mei 2016 @ 19:57:

[...]

Fury X doet daar ergens rond de 13000-17000 punten, afhankelijk van de rest van 't systeem. 9000 seems low-ish, maar dat komt door CPU. Graphics score zou gelijk liggen met Fury X, 19.500 om 19.600.

Wat ook opvalt is dat er geen 8gb ram opzit, vertelt ook weer iets over de geheugenbus configuratie (of ze durven het niet aan om 8gb erop te zetten met de laatste 512mb op trage snelheid

Nee dat is niet het geheugen van de videokaart maar van het systeem.Sp3ci3s8472 schreef op donderdag 05 mei 2016 @ 20:10:

[...]

Ben ik met je eens, vond het ook een rare score. Het kan er aan liggen dat de clocksnelheid maar 545 is, met normale clocks zal hij een stuk hoger score.

Wat ook opvalt is dat er geen 8gb ram opzit, vertelt ook weer iets over de geheugenbus configuratie (of ze durven het niet aan om 8gb erop te zetten met de laatste 512mb op trage snelheid).

Nee system memory staat onderin bij general is 6GB DDR3Pazienza schreef op donderdag 05 mei 2016 @ 21:27:

[...]

Nee dat is niet het geheugen van de videokaart maar van het systeem.

Ik zie het, my bad!Nature schreef op donderdag 05 mei 2016 @ 21:43:

[...]

Nee system memory staat onderin bij general is 6GB DDR3

Dan nog, 7.5 Gb moet genoeg zijn.

[ Voor 8% gewijzigd door Pazienza op 05-05-2016 21:50 ]

Dat zou betekenen dat als ik nu een EVGA gtx 970 zou kopen ik hem later in kan ruilen voor een GTX1070...

wel raar dat de SC versie niet inruilbaar is

[ Voor 13% gewijzigd door spartacusNLD op 05-05-2016 22:14 ]

Ryzen 7 7800X3D - Gigabyte B850 AORUS ELITE - Sapphire Nitro+ Radeon RX 9070 XT - Fractal Design Meshify 3 - Arctic Liquid Freezer III Pro 280 - Kingston Fury Beast 32GB - WD_Black 2TB

Als je het lijstje onder 'Available Step-Up Products' bekijkt dan staat daar nog geen GTX1070 bij. Dus ik denk nu nog niet, later waarschijnlijk wel. Anders even overleggen met EVGA. Geen ervaring met de step-up ondanks dat mijn laatste 5 kaarten allemaal EVGA waren.spartacusNLD schreef op donderdag 05 mei 2016 @ 22:03:

Dat zou betekenen dat als ik nu een EVGA gtx 970 zou kopen ik hem later in kan ruilen voor een GTX1070...

Iets anders: die 7,5 GB is bizar, dat moet een driver/software foutje zijn, denk ik (de GTX970 staat gewoon als 4GB in 3D Mark...).

[ Voor 12% gewijzigd door Cascade op 05-05-2016 22:32 ]

Dit zijn de inkomsten naast de Pro markt (Quadro/Tesla). Die bedroegen al langer een redelijk stabiele 300M per jaar. Bij AMD ontbreekt dat onderscheid (51 voor 2011 en 105 voor 2012 voor de gehele GPU tak). Om de appel peer vergelijking te voorkomen moet er dus in ieder geval een miljoen of 600 bij aan de kant van Nvidia.Werelds schreef op woensdag 04 mei 2016 @ 01:00:

[...]

Vergeet niet dat in die $500m ook $300m van Intel zit, dat schuiven ze doodleuk onder GPU. Daarnaast kwam het grootste deel uit notebook design wins volgens Nvidia zelf. Zo'n financieel succes was Fermi niet; in totaal zo'n $250m uit $5000m (FY2011 + FY2012, de twee Fermi jaren), waar AMD $200m uit $3000m haalde

Maar goed, het is bij dit verhaal niet zo relevant wat AMD deed. Het was ook geen AMD vs Nvidia post. Fermi was voor Nvidia zelf een keerpunt om naast die 300M uit de Pro markt weer eens een significant overschot aan de consumenten kant te halen. Dat lukte de jaren daarvoor namelijk totaal niet (30, -13 en 1). Vandaar dat Fermi voor Nvidia een financieel succes was.

Overigens wel een beetje jammer dat je niet op tijd een beredeneerde tegenvoorspelling hebt gepost. Had leuk geweest om de tech berekening naast de business berekening te leggen. Nu beginnen de eerste resultaten al binnen te stromen (of heb ik hem gemist?).

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Welke prijs zal ik ongeveer van uit moeten gaan? rond de 400euro voor pre order zal het wel wezen neem ik aan.

De gtx970 was €350 bij de release dus ik ga er zelf vanuit dat de 1070 in dezelfde prijsrange zal zitten.Minaaj schreef op vrijdag 06 mei 2016 @ 01:35:

Heb in december mijn i7 920 vervangen voor een i7 6700k en ddr4, destijds expres gewacht op de nieuwe nvidia kaarten en hopelijk kan ik mijn 670 GTX binnenkort vervangen met een GTX 1070.

Welke prijs zal ik ongeveer van uit moeten gaan? rond de 400euro voor pre order zal het wel wezen neem ik aan.

De prijs is helemaal afhankelijk van AMD en als nVidia deze generatie ook nog met een high-end GeForce Pascal chip komt. Als AMD's volledige Polaris 10 chip zich kan meten met een niet volledige GP104 chip aka GTX1070 en AMD de prijs rond de 350 euro zet, zal nVidia een vergelijkbare prijs moeten vragen. (En ga er maar vanuit dat ze op dit moment aardig weten wat de prestatie en prijspunt is van elkaars nieuwe generatie.)calsonic schreef op vrijdag 06 mei 2016 @ 11:01:

[...]

De gtx970 was €350 bij de release dus ik ga er zelf vanuit dat de 1070 in dezelfde prijsrange zal zitten.

Mocht er echter geen high-end Pascal GeForce GPU komen deze generatie, net als bij de 600 serie dus, dan kan nVidia er best wel eens voor kiezen alles wat omhoog te schuiven qua prijs. Maar dat is dus ook afhankelijk van wat AMD te bieden heeft.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Als Nvidia eerst is dan is de normale prijs van $549 en $329 de meest logische, eventueel gecorrigeerd voor inflatie (maar die is momenteel erg laag). Ik heb het hier over dollars omdat de koers nogal wisselt de laatste jaren.

De euro naar dollar is momenteel x0.87 dus dat is voor ons een stuk gunstiger dan halverwege 2015 (toen de GTX 970 eerder duurder werd dan goedkoper). Op het oude niveau zijn we echter nog lang niet. Rond de introductie van de GTX 970 die Calsonic aanhaalt was de koers nog een stuk gunstiger (0.76)

Maar goed, indien Nvidia eerder is maar AMD daarna met een soort 4870 komt dan kan er natuurlijk altijd nog een prijs/refresh reactie volgen (GTX 260 216 sp). Dus wat AMD doet kan zeker de prijs beïnvloeden.

[ Voor 53% gewijzigd door sdk1985 op 06-05-2016 15:13 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

http://orderof10.com/humanityshallbeenlightened

ben benieuwd wat ze zo laten zien.

edit: lol niks gebeurd

[ Voor 30% gewijzigd door spartacusNLD op 06-05-2016 19:01 ]

Ryzen 7 7800X3D - Gigabyte B850 AORUS ELITE - Sapphire Nitro+ Radeon RX 9070 XT - Fractal Design Meshify 3 - Arctic Liquid Freezer III Pro 280 - Kingston Fury Beast 32GB - WD_Black 2TB

Witte pixels.spartacusNLD schreef op vrijdag 06 mei 2016 @ 18:24:

3 uur vannacht is er een twitch stream.. toch raar dat de timer over +-30 min afloopt

http://orderof10.com/humanityshallbeenlightened

ben benieuwd wat ze zo laten zien.

Nope helemaal niets te zien....

The website is too busy to show the webpage

HTTP 408/HTTP 409

[ Voor 17% gewijzigd door calsonic op 06-05-2016 19:02 ]

Ryzen 7 7800X3D - Gigabyte B850 AORUS ELITE - Sapphire Nitro+ Radeon RX 9070 XT - Fractal Design Meshify 3 - Arctic Liquid Freezer III Pro 280 - Kingston Fury Beast 32GB - WD_Black 2TB

Men zegt dat dit de volgende site is

[ Voor 33% gewijzigd door jeku13 op 06-05-2016 19:06 ]

Serieus, een timer voor een evenementje waarmee je een T-shirt kunt winnen?

Ja idd LB....Pazienza schreef op vrijdag 06 mei 2016 @ 19:08:

[...]

Serieus, een timer voor een evenementje waarmee je een T-shirt kunt winnen?

https://www.twitch.tv/nvidia

[ Voor 6% gewijzigd door calsonic op 06-05-2016 19:12 ]

Denk ik eerder de 50 tickets voor het VIP event vanavond. De T-shirts zijn een leuke troostprijs.Pazienza schreef op vrijdag 06 mei 2016 @ 19:08:

[...]

Serieus, een timer voor een evenementje waarmee je een T-shirt kunt winnen?

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

"May our framerates be high and our temperatures low."

inderdaad pff.. ging er van uit dat de timer de tijd aangaf voor de stream zelf..Pazienza schreef op vrijdag 06 mei 2016 @ 19:08:

Serieus, een timer voor een evenementje waarmee je een T-shirt kunt winnen?

Als dat net zo'n domper gaat worden....madmaxnl schreef op vrijdag 06 mei 2016 @ 20:15:

Voorboden van hoe spectaculair hun nieuwe Pascal kaarten gaan zijn?

Maar tbh ik verwacht het niet

[ Voor 7% gewijzigd door calsonic op 06-05-2016 20:19 ]

http://www.guru3d.com/new...am-event-later-today.htmlColinZ schreef op vrijdag 06 mei 2016 @ 20:10:

[...]

inderdaad pff.. ging er van uit dat de timer de tijd aangaf voor de stream zelf..

Dan heb je niet goed opgelet. Het was al bekend dat de echte aankondiging pas om 3 uur 's nachts zou zijn voor ons Nederlanders.

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Hmm inderdaad gemist dan. Blijf het wel vreemd vinden. Een countdown alleen maar voor een of andere zoektocht die alleen relevant is voor mensen ter plekke.Jeroenneman schreef op vrijdag 06 mei 2016 @ 21:15:

[...]

http://www.guru3d.com/new...am-event-later-today.html

Dan heb je niet goed opgelet. Het was al bekend dat de echte aankondiging pas om 3 uur 's nachts zou zijn voor ons Nederlanders.

Als de gelekte firestrike scores juist zijn, met redelijke drivers en een normaal getuned systeem zijn uitgevoerd, dan heeft de IPC aardig ingeboet (28xx vs 2560 sp verklaart niet genoeg) en is het vooral een "smalle" chip die z'n winst uit de hoge klokfrequenties haalt (dat is ook een verdienste natuurlijk). Afhankelijk van prijs, verdere overklokbaarheid en andere kleine wijzigingen (dx12 semi soft ac?) zullen we moeten zien wat het waard is tov van GM200(4).

Het lijkt wat dat betreft wederom op 780Ti->980.

[ Voor 4% gewijzigd door edward2 op 06-05-2016 23:25 ]

Niet op voorraad.

De 1080 is sneller dan GTX980 SLI, is sneller dan een Titan X. Finfet heeft zijn werk gedaan, de 1080 loopt op 2144 mhz.

De mogelijkheid met Ansel om een camera vrij te bewegen ingame en screenshots te maken, erg leuk voor ingame fotografie wat groter begint te worden (en ik voorzie HACKS!!).

Realistisch audio weergave via GameWorks, audio die interactie heeft met objecten in een scene (dit handelen ze af met raytracing).

[ Voor 4% gewijzigd door Sp3ci3s8472 op 07-05-2016 03:54 ]

Edit:

Nvidia gaat dus eindelijk opensource, ben benieuwd. Het werd tijd.

[ Voor 35% gewijzigd door Sp3ci3s8472 op 07-05-2016 04:28 ]

Met de performance zat ik er dus flink naast, met de prijs gelukkig niet.

Die demo van Epic games zag er overigens ook bizar goed uit. Multipass viewport ook leuk voor multimonitor. Leuke show

[ Voor 65% gewijzigd door sdk1985 op 07-05-2016 04:23 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

GTA VI - All aboard the hype train!!

Ryzen 7 5700X 16GB RTX 5060 1TB NVMe

Die demo van Epic was leuk maar niet speciaal, dat monster was leuker. Huidige gpus zouden dit ook kunnen renderen, en vergeet niet het was maar 1 character in beeld tegelijk. Als het er nu meer warensdk1985 schreef op zaterdag 07 mei 2016 @ 04:21:

Wauw 379 dollar voor sneller dan Titan X @ GTX 1070. GPU historie deze stream... GTX 1080 599 dollar voor 2x Titan X.

Met de performance zat ik er dus flink naast, met de prijs gelukkig niet.

Die demo van Epic games zag er overigens ook bizar goed uit. Multipass viewport ook leuk voor multimonitor. Leuke show.

Performance was inderdaad een stuk meer dan je dacht, was ook wel te verwachten met de stap van 28nm naar 16nm.

Tom heeft de show gestolen (of niet

Edit:

Heb je de clocksnelheid gezien? Dat verklaart namelijk een hoop.Sir_Hendro schreef op zaterdag 07 mei 2016 @ 04:24:

De GTX 1080 heeft dus iets van 2500 cuda cores en de Titan X had er 3000 nog wat. Dus 2x zo snel ondanks minder cuda cores? Ik vind het knap. De prijzen zijn erg netjes! Kom maar op met Pascal

[ Voor 19% gewijzigd door Sp3ci3s8472 op 07-05-2016 04:28 ]

GTA VI - All aboard the hype train!!

Tom zal voorlopig geen promotie maken

Performance was inderdaad wel te verwachten met de holy trinity. Ik had er echter op gerekend dat ze voor het geld zouden kiezen. Daarmee heb ik Nvidia blijkbaar tekort gedaan. De Titax-X gaan ze in ieder geval niet meer verkopen nu

Ben benieuwd hoe AMD hier op reageert. Polaris voor 200 dollar? Goede tijden voor PC gaming

[ Voor 33% gewijzigd door sdk1985 op 07-05-2016 04:35 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Ryzen 7 5700X 16GB RTX 5060 1TB NVMe

En nog zuiniger is ook?

Dat belooft veel goeds voor een mogelijke GTX 1060. GTX 980 lvl performance voor 250 euro en <150W?

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Ik vermoed dat de GTX980Ti in V&A een mooie duik naar beneden gaat maken.

[ Voor 28% gewijzigd door The Source op 07-05-2016 06:21 ]

Het is niet des Nvidia om zo'n stappen te maken, zonder de hoofdprijs te vragen. Zou AMD nog verder zijn?

Daarnaast: de vraag naar een videokaart gaat nu 2 maanden echt instorten, en de resale waarde van de Maxwell kaarten of Fiji is echt in één klap gehalveerd nu. Daar moet Nvidia toch redenen voor hebben.

"Omdat het kan" geloof ik niet. Daarvoor is Nvidia veel te bedreven in marketing en product positionering.

Also: hoe fkin snel gaat de 1080Ti zijn? gTX Titan X in Sli?

| Old Faithful | i7 920 @ (3,3Ghz) / X58 UD4P / GTX960 (1,550Mhz) / CM 690 | NOVA | i5 6600K (4,4Ghz) / Z170 Pro Gaming / GTX 960 (1,500Mhz) / NZXT S340

Nu afwachten op wanneer de customkaarten in Nederland verkrijgbaar gaan worden. Gezien de garantie en dergelijk wil ik bij zo een eerste batch toch wel echt alleen in Nederland kopen.

De clocksnelheid is wel echt een stuk hoger nog dan verwacht. Ben benieuwd of de customs daar overheen gaan en zoja hoeveel.

/edit: http://www.geforce.com/hardware/10series/geforce-gtx-1080

daar staat trouwens 1733 als clocksnelheid...

[ Voor 10% gewijzigd door ArthurMorgan op 07-05-2016 07:04 ]

I hear voices in my head, they counsel me, they understand.

En ook leuk om te zien dat alle mensen die de videocardz website altijd de grond inboren nu op hun nummer gezet worden...

Nvidia hulde!

[ Voor 88% gewijzigd door br00ky op 08-05-2016 08:39 ]

Even afwachten totdat de 1070 of wellicht toch de 1080 in nl op voorraad is en dan de 970 voor een 200 Euro verkopen?

Dit topic is bedoeld om de nieuwste ontwikkelingen op het gebied van nVidia GPU's te bespreken. Dit topic is dus uitdrukkelijk niet bedoeld voor persoonlijk aankoopadvies of troubleshooting!

Voor discussies over de nieuwste serie, klik aub door naar [NVIDIA GeForce RTX 40XX] Levertijden & Prijzen zodat dit topic over nieuws blijft gaan.

Zware videokaarten trekken een zware last op de voeding van een PC. Dit is niet de plek voor discussies over voedingen, dat kan in Voeding advies en informatie topic - Deel 34 - en lees daar sowieso de topicstart voordat je post, grote kans dat je vraag al behandeld is.

/u/331213/crop56ef13408ff38_cropped.png?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

/u/400/defember100.png?f=community)

:strip_exif()/u/327460/cowboy.gif?f=community)

:strip_icc():strip_exif()/u/445363/crop56757510392f8_cropped.jpeg?f=community)

/u/396485/crop6890b57485ba1_cropped.png?f=community)

:strip_icc():strip_exif()/u/18666/crop5f81ab3ab9d53.jpeg?f=community)

:strip_icc():strip_exif()/u/240280/5.jpg?f=community)

:strip_icc():strip_exif()/u/451377/crop55c27effefbb4_cropped.jpeg?f=community)

:strip_exif()/u/211274/bestabstractwallpapers5.gif?f=community)

/u/34200/crop6554f56fe2075_cropped.png?f=community)

/u/4501/crop5bdb35c450e89.png?f=community)

:strip_exif()/u/48035/crop600e9e6471232.gif?f=community)

:strip_icc():strip_exif()/u/469413/crop6449781d98758_cropped.jpg?f=community)

:strip_exif()/u/186029/crop5eb41ba83051f_cropped.gif?f=community)

/u/32673/crop60a226f7c0ff5.png?f=community)

/u/343341/crop6095457d39560_cropped.png?f=community)

:strip_icc():strip_exif()/u/7205/duke3.jpg?f=community)

:strip_icc():strip_exif()/u/408341/crop5807df685ecb8_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/185900/betty.jpg?f=community)

:strip_icc():strip_exif()/u/336851/Titanfall%25202.jpg?f=community)

:strip_exif()/u/5079/tweak.gif?f=community)

:strip_exif()/u/20422/narsexy.gif?f=community)

:strip_icc():strip_exif()/u/324515/crop627103b05ba2e_cropped.jpg?f=community)