Die bron hoeft niet percé betrouwbaar te zijn. Het gaat meer om de specs die goed kunnen kloppen gezien er heel wat meer bronnen zijn die het zelfde vertellen qua specs. Tik maar eens in. Wat niet hoeft te kloppen is de geheugen bus, daar heb ik namelijk wel mijn twijfels over. De rest kan heel goed kloppen.

Verwijderd

Tjah als je het zo gaat bekijken kunnen het AMD topic en nvidia topic net zo goed sluiten want dit allemaal is vooral gebaseerd op geruchten als wat ik poste. Verder heb ik hier wel redelijk geloof in want deze site poste ook gewoon goede specs van de gk104 en thaiti. Verder geloof ik het ook wel omdat het allemaal past in een 500+mm2 chip, maar ik maak er geen feit van want dat kan pas tot hij gezien is. Ik denk dat dit soort topics dan ook niet interessant voor jou zijn.SirNobax schreef op donderdag 05 april 2012 @ 13:49:

[...]

@hieronder

Ik kan ook GK110 specs uit m'n duim zuigen die "Goed kunnen kloppen", als iedereen dat gaat doen zal het ook op verschillende plekken op het internet opduiken. Zolang er maar genoeg mensen troep op het internet plaatsen zal er vast wel eentje bijzitten die redelijk in de buurt zat.

Misschien vind je deze bron betrouwbaarder?

http://videocardz.com/316...eatures-4gb-512bit-memory

[ Voor 38% gewijzigd door Verwijderd op 05-04-2012 18:35 ]

Verwijderd

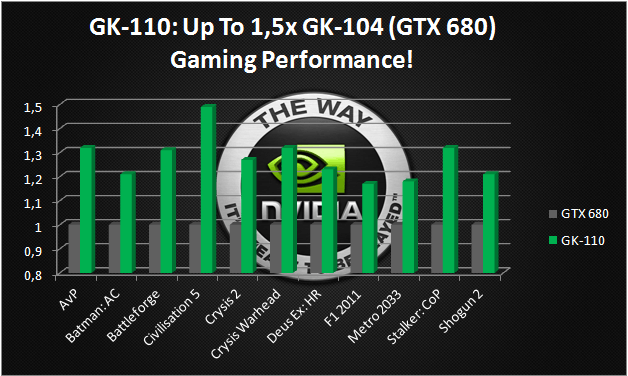

Dit lijkt in mijn ogen ook wel wat meer dan 25%

Edit. Maar goed wat hebben we straks nog aan nvidia kaarten als

alle consoles AMD cpu en GPU krijgen. Ik zie het nog wel gebeuren dat de games

niet goed gaan werken op nvidia kaarten.

[ Voor 27% gewijzigd door Verwijderd op 05-04-2012 18:40 ]

Bullshit, het gaat gewoon beter werken op AMD kaarten omdat het beter geoptimaliseerd is. I.t.t. wat nVidia bijvoorbeeld doet. Het corrumperen van engine/code zodat het slechter op AMD hardware loopt waardoor het vaak ook op nVidia hardware slechter loopt maar in verhouding AMD er juist het hardst op achteruit gaat. Zoals tesselation onder map in Crysis 2.Verwijderd schreef op donderdag 05 april 2012 @ 18:32:

[...]

Dit lijkt in mijn ogen ook wel wat meer dan 25%

Edit. Maar goed wat hebben we straks nog aan nvidia kaarten als

alle consoles AMD cpu en GPU krijgen. Ik zie het nog wel gebeuren dat de games

niet goed gaan werken op nvidia kaarten.

Als nVidia er op vooruit gaat en AMD niet op achter uit is er niks mis. Daarbij moet het geen er berekend wordt wel nuttig c.q. zichtbaar zijn. Tesselation onder map of dusdanige hoeveelheid tesselation dat een paar tanden lager geen verschil uit maakt is dat dus niet.

http://www.techpowerup.co...X-680-as-GTX-670-Ti-.htmlRutger Mulder schreef op donderdag 22 maart 2012 @ 00:48:

[...]

Die kon je er zelf ook wel bij zoeken, dit is gewoon mierenneuken.

Voor de vaste lezers van dit topic is het gewoon overduidelijk dat de GK104 als mid range geplanned stond.

Dit gecombineerd met eerdere observaties die ik mbt de shaders en stroom aansluitingen maakte halen je (argmentsloze) standpunt toch wel onderuit

Midrange is volgens Nvidia overigens een 8600gt,gts250, gts450, enz.

[ Voor 25% gewijzigd door sdk1985 op 05-04-2012 19:39 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Wat is dat nu voor onzin?

Een 360 heeft een ATI (nee, geen AMD!) GPU, PS3 heeft een Nvidia GPU. 360 games zien er vaak beter uit dan PS3 titels en draaien vaak ook veel soepeler, ondanks het feit dat de PS3 eigenlijk iets krachtiger is (elke console eigenaar zal dan ook aanraden een 360 te kopen tenzij er PS3 exclusives zijn die je wil spelen). Draaien de meeste crossplatform titels nu beter op ATI/AMD? Nee.

Tijd om eens met Mel Gibson te gaan praten

Een 360 heeft een ATI (nee, geen AMD!) GPU, PS3 heeft een Nvidia GPU. 360 games zien er vaak beter uit dan PS3 titels en draaien vaak ook veel soepeler, ondanks het feit dat de PS3 eigenlijk iets krachtiger is (elke console eigenaar zal dan ook aanraden een 360 te kopen tenzij er PS3 exclusives zijn die je wil spelen). Draaien de meeste crossplatform titels nu beter op ATI/AMD? Nee.

Tijd om eens met Mel Gibson te gaan praten

Maar dat komt vooral omdat de meeste crossplatform titels worden geport naar de PS3, dus imho niet echt een goede vergelijking. buiten het feit dat een console geen PC isWerelds schreef op donderdag 05 april 2012 @ 19:26:

Wat is dat nu voor onzin?

Een 360 heeft een ATI (nee, geen AMD!) GPU, PS3 heeft een Nvidia GPU. 360 games zien er vaak beter uit dan PS3 titels en draaien vaak ook veel soepeler, ondanks het feit dat de PS3 eigenlijk iets krachtiger is (elke console eigenaar zal dan ook aanraden een 360 te kopen tenzij er PS3 exclusives zijn die je wil spelen). Draaien de meeste crossplatform titels nu beter op ATI/AMD? Nee.

Tijd om eens met Mel Gibson te gaan praten

Het blijft gewoon een feit dat op de PC nvidia kaarten het vaak iets beter doen omdat de games daarvoor geoptimaliseerd zijn. Dit is bijvoorbeeld weer andersom bij de total war serie. Daar krijg je ook een AMD logo te zien ipv een NVIDIA logo als je de game opstart

Verwijderd

Nee dat is het niet, alleen sommigen hebben nogal extreem veel moeite om de onzin er uit te vissen.Verwijderd schreef op donderdag 05 april 2012 @ 18:25:

[...]

Tjah als je het zo gaat bekijken kunnen het AMD topic en nvidia topic net zo goed sluiten want dit allemaal is vooral gebaseerd op geruchten als wat ik poste.

Onzin zoals dit.

Dat artikel is gebaseerd op dezelfde lulkoek van OBR-Hardware, net als die vorige.Verwijderd schreef op donderdag 05 april 2012 @ 18:25:

[...]

Ik denk dat dit soort topics dan ook niet interessant voor jou zijn.

Misschien vind je deze bron betrouwbaarder?

http://videocardz.com/316...eatures-4gb-512bit-memory

En nee, hoor, ik zit hier prima.

Even afgezien van de typo in de titel, neem ik aan dat dit het "Nieuwsdiscussie Topic" is, en mijn aandeel in deze discussie, is dus dat de bron, OBR-Hardware, waar andere hun artikel over hebben geschreven, als onzin klinkt, met uitspraken zoals "Launch month is ........ber! and is not December or November", "There are really lot of CUDAs" en melden dat er een 512-bit geheugenbus word gebruikt, wat zeer onlogisch zou zijn als de kaart maar 25% sneller is als een GK104.

Pentaxiaan

Mijn reactie ging over Lupp's "Ik zie het nog wel gebeuren dat de games niet goed gaan werken op nvidia kaarten.". Dat is gewoon onzin van de bovenste plank. Dat is nu niet gebeurd en zal ook niet gebeuren. Mijn punt daarbij is juist dat op dit moment ATI/AMD ook het hoofdplatform is - alles wordt ontwikkeld voor een 360 en vervolgens geport naar PC en PS3, maar vrijwel al die games lopen zeker niet beter op AMD; vaak het tegenovergestelde.EJPostema schreef op donderdag 05 april 2012 @ 19:44:

[...]

Maar dat komt vooral omdat de meeste crossplatform titels worden geport naar de PS3, dus imho niet echt een goede vergelijking. buiten het feit dat een console geen PC is

Het blijft gewoon een feit dat op de PC nvidia kaarten het vaak iets beter doen omdat de games daarvoor geoptimaliseerd zijn. Dit is bijvoorbeeld weer andersom bij de total war serie. Daar krijg je ook een AMD logo te zien ipv een NVIDIA logo als je de game opstart

Ssst, dat weet ik ook wel

Verwijderd

Bij welke games doet nvidia dat dan, zo dat hij slechter op beide kaarten draait?madmaxnl schreef op donderdag 05 april 2012 @ 19:22:

[...]

Bullshit, het gaat gewoon beter werken op AMD kaarten omdat het beter geoptimaliseerd is. I.t.t. wat nVidia bijvoorbeeld doet. Het corrumperen van engine/code zodat het slechter op AMD hardware loopt waardoor het vaak ook op nVidia hardware slechter loopt maar in verhouding AMD er juist het hardst op achteruit gaat. Zoals tesselation onder map in Crysis 2.

Als nVidia er op vooruit gaat en AMD niet op achter uit is er niks mis. Daarbij moet het geen er berekend wordt wel nuttig c.q. zichtbaar zijn. Tesselation onder map of dusdanige hoeveelheid tesselation dat een paar tanden lager geen verschil uit maakt is dat dus niet.

Nu moet ik wel zeggen nu amd ook goede tessellation heeft voor crysis 2. Niet in het begin maar na nieuwere kaarten wel weer. Momenteel ontlopen ze elkaar daar niet zo veel met de 7000 series.

Juist dan zorgt AMD er juist voor dat het beter op nvidia draait. Nvidia heeft gewoon iets betere tesselation en dan krijgen ze door betere hardware de schuld. Foute wereld dit.Werelds schreef op donderdag 05 april 2012 @ 20:04:

[...]

Mijn reactie ging over Lupp's "Ik zie het nog wel gebeuren dat de games niet goed gaan werken op nvidia kaarten.". Dat is gewoon onzin van de bovenste plank. Dat is nu niet gebeurd en zal ook niet gebeuren. Mijn punt daarbij is juist dat op dit moment ATI/AMD ook het hoofdplatform is - alles wordt ontwikkeld voor een 360 en vervolgens geport naar PC en PS3, maar vrijwel al die games lopen zeker niet beter op AMD; vaak het tegenovergestelde.

Ik heb één keer hier een artikel over gelezen zonder bronnen van ene Charlie. Ik heb hier mijn bedenkingen bij omdat hij nog al vaker van dit soort leugens schreef. Ik denk dat je dit ook met een korrel zout kunt nemen want bewijs heeft hij niet en er zijn verder later ook geen dingen meer over verschenen bij andere sites.

[ Voor 33% gewijzigd door Verwijderd op 05-04-2012 22:24 ]

Zou inderdaad wel grappig zijn als HWI 'm online gooide3XPER7 schreef op donderdag 05 april 2012 @ 20:13:

[...]

Ssst, dat weet ik ook welWil even zien of deze net als die vroege slide van de HD7970 ook elders opgepikt wordt (hoe dan ook

)

Verwijderd

Of tweakers, zoals laatst met de gtx680 en eerdere hd7970. Klopte ook niets van.

Maar goed geruchten hoort nu eenmaal ook bij het nieuws.

Maar goed geruchten hoort nu eenmaal ook bij het nieuws.

Kunt hem daar en hier zo bij de redactie neer kwakken. Of bij BOUWEENPC. Heeft er ook een handje van.TomasH schreef op donderdag 05 april 2012 @ 22:11:

[...]

Zou inderdaad wel grappig zijn als HWI 'm online gooide.

[ Voor 53% gewijzigd door Verwijderd op 05-04-2012 22:25 ]

Verwijderd

Vergeet niet dat je er zelf ook goed in bent he.TomasH schreef op donderdag 05 april 2012 @ 22:11:

[...]

Zou inderdaad wel grappig zijn als HWI 'm online gooide.

Dat is niet zo kijk maar terug.Verwijderd schreef op donderdag 05 april 2012 @ 22:23:

Of tweakers, zoals laatst met de gtx680 en eerdere hd7970. Klopte ook niets van.

Verwijderd

nieuws: AMD: HD7970 gemiddeld bijna de helft sneller dan GTX580Verwijderd schreef op donderdag 05 april 2012 @ 22:32:

[...]

Vergeet niet dat je er zelf ook goed in bent he.

[...]

Dat is niet zo kijk maar terug.

Maar goed ook hier staat bij geruchten

Wel dus, gemiddeld 45%sneller. Maar dat is helemaal waar op 25x16. Zoek maar eens benchmarks op die na dat de kaart uit kwam verschenen op deze resolutie.

[ Voor 8% gewijzigd door Verwijderd op 05-04-2012 22:37 ]

Het punt bij crysis 2 is meer het overbodige water dat gerendered wordt onder de grond en andere overdreven complexe zaken, dat is gewoon een rottig truukje dat effect heeft alle kaarten maar bij AMD eerst wat meer omdat ze minder tesselation kracht hadden.Verwijderd schreef op donderdag 05 april 2012 @ 22:06:

[...]

Bij welke games doet nvidia dat dan, zo dat hij slechter op beide kaarten draait?

Nu moet ik wel zeggen nu amd ook goede tessellation heeft voor crysis 2. Niet in het begin maar na nieuwere kaarten wel weer. Momenteel ontlopen ze elkaar daar niet zo veel met de 7000 series.

[...]

Juist dan zorgt AMD er juist voor dat het beter op nvidia draait. Nvidia heeft gewoon iets betere tesselation en dan krijgen ze door betere hardware de schuld. Foute wereld dit.

Ik heb één keer hier een artikel over gelezen zonder bronnen van ene Charlie. Ik heb hier mijn bedenkingen bij omdat hij nog al vaker van dit soort leugens schreef. Ik denk dat je dit ook met een korrel zout kunt nemen want bewijs heeft hij niet en er zijn verder later ook geen dingen meer over verschenen bij andere sites.

Hier heb je het artikel

Verwijderd

Dat van crysis wist ik maar heb je ook een bron dat dat van nvida af komt, moet willlig bij crysis 2?Redblader schreef op donderdag 05 april 2012 @ 22:36:

[...]

Het punt bij crysis 2 is meer het overbodige water dat gerendered wordt onder de grond en andere overdreven complexe zaken, dat is gewoon een rottig truukje dat effect heeft alle kaarten maar bij AMD eerst wat meer omdat ze minder tesselation kracht hadden.

Hier heb je het artikel

Amd heeft trouwens ook dit soort truukjes gehad bij bencmark progamma's en ook een aantal games.

Uiteindelijk hebben ze gewoon alle 2 van dit soort streken. Is het niet met games dan wel weer ergens anders mee om mensen proberen bij de tegenpartij weg te lokken.

[ Voor 11% gewijzigd door Verwijderd op 05-04-2012 22:46 ]

Verwijderd

Die slides zijn 100% echt hoor.Verwijderd schreef op donderdag 05 april 2012 @ 22:36:

[...]

nieuws: AMD: HD7970 gemiddeld bijna de helft sneller dan GTX580

Maar goed ook hier staat bij geruchten

Verwijderd

Ja de slide bestaat wel, zo is de slide hier boven ook 100% echt omdat hij bestaat alleen kloppen de getallen niet in real life.

[ Voor 7% gewijzigd door Verwijderd op 05-04-2012 22:50 ]

Verwijderd

De slides zijn 100% echt en de waardes kloppen ook 100%, moet ook wel want het komt ook benchmarkguide van AMD. Als er onzin in zou staan zou dat alleen maar ellende geven aangezien reviewers dan op hele andere waardes komen en zich dan af gaan vragen wat ze verkeerd doen.

Verwijderd

Dan zou ik nog maar eens goed naar de benchmarks kijken op de zelfde instellingen.

Je kan dan direct zien dat er niets van klopt qua fps. Zoals in BF3 als voorbeeld. Max fps ligt sowieso hoger en AVG ook te hoog. Is gewoon fake rommel om mensen gek te maken, of te wel marketing.

Deze discussie ga ik ook niet verder aan want ik ben niet blind.

Je kan dan direct zien dat er niets van klopt qua fps. Zoals in BF3 als voorbeeld. Max fps ligt sowieso hoger en AVG ook te hoog. Is gewoon fake rommel om mensen gek te maken, of te wel marketing.

Deze discussie ga ik ook niet verder aan want ik ben niet blind.

[ Voor 10% gewijzigd door Verwijderd op 05-04-2012 23:03 ]

Verwijderd

Ik vergat nog te melden dat sommigen dan ook weer moeite hebben om iets wat wel klopt te geloven als hun dat niet bevalt.Verwijderd schreef op donderdag 05 april 2012 @ 19:53:

[...]

Nee dat is het niet, alleen sommigen hebben nogal extreem veel moeite om de onzin er uit te vissen.

Verwijderd

Eén voorbeeld welke al redelijk twijfelachtig is. Zie bijv. Battleforge hier;

en dan hier;

8% vs 58% sneller....

Enfin, zou kunnen dat de slides echt waren, maar dan natuurlijk wel zo geconstrueerd dat ze zo goed mogelijk voor AMD eruit kwamen. Gebeurd die kant op, maar ook andersom en zo gaat het nu eenmaal...

en dan hier;

8% vs 58% sneller....

Enfin, zou kunnen dat de slides echt waren, maar dan natuurlijk wel zo geconstrueerd dat ze zo goed mogelijk voor AMD eruit kwamen. Gebeurd die kant op, maar ook andersom en zo gaat het nu eenmaal...

[ Voor 81% gewijzigd door Verwijderd op 06-04-2012 10:45 ]

Behalve dat de kans er best wel in zit dat ook de instellingen heel anders zijn. Resolutie alleen zegt vrij weinig.

Verwijderd

Klopt, misschien heeft AMD wel MLAA toegepast (wat ik ook eerst dacht te zien), maar dat is niet zeker, dit kan ook veel invloed hebben op de uitslagen...

Verwijderd

Natuurlijk laat AMD zichzelf er goed uit komen bij iets wat ze zelf maken dat lijkt mij vrij logisch. Ik heb nog nooit een fabrikant gezien die zichzelf zo slecht mogelijk voordeed als die iets wou verkopen.Verwijderd schreef op vrijdag 06 april 2012 @ 10:39:

Enfin, zou kunnen dat de slides echt waren, maar dan natuurlijk wel zo geconstrueerd dat ze zo goed mogelijk voor AMD eruit kwamen. Gebeurd die kant op, maar ook andersom en zo gaat het nu eenmaal...

Verwijderd

Natuurlijk, is ook logisch, maar wel onrealistisch helaas... En dan nog zitten er uitslagen tussen die behoorlijk twijfelachtig zijn, zie het voorbeeld wat ik gegeven heb. Ik heb net als Lupp in dit geval sterk mijn twijfels of de uitslagen van die slides allemaal wel echt zo uit de benchmarks gerold zijn, maar dat zullen we nooit weten...Verwijderd schreef op vrijdag 06 april 2012 @ 11:15:

[...]

Natuurlijk laat AMD zichzelf er goed uit komen bij iets wat ze zelf maken dat lijkt mij vrij logisch. Ik heb nog nooit een fabrikant gezien die zichzelf zo slecht mogelijk voordeed als die iets wou verkopen.

EDIT; Zo klopt trouwens Civ 5 ook voor geen meter als ik TPU wederom vergelijk... (10% vs 60% sneller...)

[ Voor 11% gewijzigd door Verwijderd op 06-04-2012 11:31 ]

Verwijderd

Leuke test;

http://www.computerbase.d...x-680-sli-vs.-hd-7970-cf/

Gaat erg gelijk op, lang geleden dat we Nvidia eens een keer minder stroom zien verbruiken in dit soort tests...

Bij de conclusie gaat de lichte voorkeur uit naar Nvidia vanwege meer microstutter problemen bij AMD.

http://www.computerbase.d...x-680-sli-vs.-hd-7970-cf/

Gaat erg gelijk op, lang geleden dat we Nvidia eens een keer minder stroom zien verbruiken in dit soort tests...

Bij de conclusie gaat de lichte voorkeur uit naar Nvidia vanwege meer microstutter problemen bij AMD.

[ Voor 51% gewijzigd door Verwijderd op 06-04-2012 11:43 ]

Het punt met die reviewer's guides is dat ze altijd heel erg specifieke instellingen voor alles hebben. Kijk maar eens naar http://www.hardocp.com/ar...e_gtx_680_reviewers_guide

Staat evenveel bullshit in en die cijfertjes komen even min overeen met de werkelijkheid als die uit de 7970 slides. Er wordt ook altijd vies uitgehaald naar elkaar waarbij partij A beweert dat partij B allerlei smerige dingen in de driver doet terwijl zij dat zelf niet doen. Wij weten wel beter natuurlijk, want dat doen ze allebei

Staat evenveel bullshit in en die cijfertjes komen even min overeen met de werkelijkheid als die uit de 7970 slides. Er wordt ook altijd vies uitgehaald naar elkaar waarbij partij A beweert dat partij B allerlei smerige dingen in de driver doet terwijl zij dat zelf niet doen. Wij weten wel beter natuurlijk, want dat doen ze allebei

dion_b schreef op vrijdag 06 april 2012 @ 09:17:

[modbreak]Allebei: deze discussie gaat de verkeerde kant op

Er zijn wat - nog niet onafhankelijk bevestigde - benchmarks. Jullie verschillen beide van mening over de betekenis/betrouwbaarheid ervan. Prima, constateer dat en laat het erbij.[/modbreak]

nieuws: TSMC kampt met 28nm-tekorten

http://semiaccurate.com/2...nvidias-financial-parade/

(Bij S|A even de eerste vier alinea's overslaan ivm bashen...)

http://semiaccurate.com/2...nvidias-financial-parade/

(Bij S|A even de eerste vier alinea's overslaan ivm bashen...)

Verwijderd

Jammer, daarom ook dat de prijzen hoog blijven aan beide kanten. Volgens mij zijn die slechte yields voor niemand goed.

Dat wordt 500 euro per kaart tot einde van het jaar...

https://www.youtube.com/channel/UCl2XLRJ3VgCspwNG4_XCrkQ

Azerty heeft zijn prijzen weer omlaag gegooid (€ 454,48), en afuture naar € 452,90.

edit: voor de EVGA gtx 680 pricewatch: EVGA GeForce GTX 680

edit: voor de EVGA gtx 680 pricewatch: EVGA GeForce GTX 680

[ Voor 45% gewijzigd door Roerbakeitje op 06-04-2012 14:54 ]

Zelfde verhaal als met de Radeon HD 5870 destijds. Uitstekende videokaarten door nieuw 40nm procedé, maar direct schaarste. AMD heeft ervan geleerd in die zin dat ze de premium nu wel vanaf dag 1 vragen. Bij de HD 5870 zag je de prijzen na launch klimmen van €330 naar €380 voor een leverbare videokaart.. Ik geef ze groot gelijk, alhoewel ik wel wacht op lagere prijzen voordat ik overweeg om te upgraden.Verwijderd schreef op vrijdag 06 april 2012 @ 14:44:

Jammer, daarom ook dat de prijzen hoog blijven aan beide kanten. Volgens mij zijn die slechte yields voor niemand goed.

Goud is geen geld

Hoezo? enkel nvidia kampt met slechte yields.Verwijderd schreef op vrijdag 06 april 2012 @ 14:44:

Jammer, daarom ook dat de prijzen hoog blijven aan beide kanten. Volgens mij zijn die slechte yields voor niemand goed.

TSMC kampt gewoon met een veel te hoge vraag tegenover hun productie capaciteit.

zoals elk nieuwsbericht zei: TSMC kampt met tekort aan productiecapaciteit. Dat is niet hetzelfde als yield problemen bij hun klanten.

Verwijderd schreef op vrijdag 06 april 2012 @ 15:58:

Welk probleem heeft AMD dan als ze niet voledoende gpu's kunnen leveren aan TSMC?

Verwijderd

Ik snap het verschil dan niet, want beide lijken de zelfde problemen te hebben als ik dit zo lees.Door Willem de Moor vrijdag 6 april 2012 12:11

De Taiwanese chipbakker TSMC zou nog tot het najaar met productietekorten kampen voor zijn 28nm-producten. Onder meer Qualcomm, AMD en Nvidia, die 28nm-chips van de fabrikant afnemen, zouden te lijden hebben onder de tekorten.

De productiecapaciteit van Taiwan Semiconductor Manufacturing Company blijkt onvoldoende om aan de vraag naar 28nm-chips te voldoen, zo meldt Digitimes. Dat zou deels komen doordat de yields, het aantal functionele chips per wafer, nog niet bijster goed zijn, maar ook de waferproductie laat te wensen over. Een bestaande 300mm-wafer-fabriek wordt vanaf deze maand aangepast voor de productie van 28nm-chips, maar deze upgrade zal nog enige tijd duren. TSMC zou in dit jaar vergeleken met 2011 ongeveer 10 procent meer productie kunnen draaien. Ongeveer een kwart van de productiecapaciteit betreft 300mm-wafers, deels geschikt voor 28nm-productie.

Qualcomm, een van de afnemers van 28nm-chips, heeft als reactie op TSMC's tekorten een deel van de productie uitbesteed bij concurrent United Microelectronics. Desondanks kampt het bedrijf met een vraag naar processors die groter is dan wat het kan leveren. Ook AMD, dat met de Radeon HD 79xx-videokaarten naar 28nm-gpu's is overgestapt, kan onvoldoende gpu's leveren. Datzelfde geldt voor Nvidia, dat met de eerste Kepler-gpu's, de GTX 680, naar 28nm switchte. Ook daarvan zijn er te weinig chips en hetzelfde geldt voor de rest van de geplande Kepler-gpu's.

[ Voor 3% gewijzigd door Verwijderd op 06-04-2012 16:10 ]

We weten dat nvidia kampt met yields (zie Nvidia press conference).Verwijderd schreef op vrijdag 06 april 2012 @ 16:00:

Door Willem de Moor vrijdag 6 april 2012 12:11

De Taiwanese chipbakker TSMC zou nog tot het najaar met productietekorten kampen voor zijn 28nm-producten. Onder meer Qualcomm, AMD en Nvidia, die 28nm-chips van de fabrikant afnemen, zouden te lijden hebben onder de tekorten.

De productiecapaciteit van Taiwan Semiconductor Manufacturing Company blijkt onvoldoende om aan de vraag naar 28nm-chips te voldoen, zo meldt Digitimes. Dat zou deels komen doordat de yields, het aantal functionele chips per wafer, nog niet bijster goed zijn, maar ook de waferproductie laat te wensen over. Een bestaande 300mm-wafer-fabriek wordt vanaf deze maand aangepast voor de productie van 28nm-chips, maar deze upgrade zal nog enige tijd duren. TSMC zou in dit jaar vergeleken met 2011 ongeveer 10 procent meer productie kunnen draaien. Ongeveer een kwart van de productiecapaciteit betreft 300mm-wafers, deels geschikt voor 28nm-productie.

Al de anderen hebben geen lage yields warning afgegeven (dus yields zijn daar niet bar bar slecht), slechts een tekort omdat TSMC niet genoeg kan leveren omdat ze veel te weinig productie capaciteit hebben voor hun aantal klanten.

Maw: ze hebben beperkte oplage door te weinig 28nm machienerie (een groot stuk van hun 300mm productielijn moet nog geconverteerd worden van 40nm).

Sommige klanten hebben slechtere tot veel slechtere yields waardoor ze nog minder krijgen uit het aantal beschikbare wafers.

Dit is gewoon slecht nieuws voor alle fabrikanten die hun 2012 lineup bij TSMC hebben. (Het resultaat is dat Nvidia grotere problemen heeft dan de rest als ze dezelfde wafer oplage krijgen, maar dat elke fabrikant gewoon veeeeeel misloopt).

Dit verklaard ineens waarom we niet snel een >400mm chip van gpu fabricanten moeten verwachten.

[ Voor 19% gewijzigd door Devpartner op 06-04-2012 16:10 ]

Die eerste vier regels geven juist een uitermate goede reden waarom nVidia een 'Pay per good Die' regeling had voor 40nm, waar de 'Pay per Wafer' regeling de norm is. Het is evenzeer ook de reden geweest waarom AMD een Pay per good Die regeling had met GF aangaande 32nm, eveneens een tijdelijke regeling. Is het dan ook bashen als je stelt dat yields van GF's 32nm voor Llano producten superslecht waren?Toettoetdaan schreef op vrijdag 06 april 2012 @ 13:02:

http://semiaccurate.com/2...nvidias-financial-parade/

(Bij S|A even de eerste vier alinea's overslaan ivm bashen...)

FQ1 2013 zal in ieder geval interessant zijn met dit in het achterhoofd, maar dan zullen we eerst nog een maandje moeten wachten.

Verwijderd

AMD levert geen gpu's aan TSMC, maar andersom....Verwijderd schreef op vrijdag 06 april 2012 @ 15:58:

Welk probleem heeft AMD dan als ze niet voledoende gpu's kunnen leveren aan TSMC?

Simpel uitgelegd; Beide kampen (AMD & Nvidia) zullen een tekort aan gpu's hebben omdat er te weinig productiecapaciteit is. Echter heeft AMD het voordeel dat hun yields beter zijn en dus meer werkende gpu's per wafer daadwerkelijk kunnen verkopen. Nvidia heeft dus zeg maar een 'dubbel' probleem; én te weinig capaciteit in de vorm van wafers, én lagere yields per wafer.

[ Voor 7% gewijzigd door Verwijderd op 06-04-2012 17:24 ]

Oke, de tweede alinea voegt nog wel wat aan het verhaal toe, maar misschien moet ik verduidelijken waarom ik zeg dat je de eerste vier alinea's beter kunt overslaan.dahakon schreef op vrijdag 06 april 2012 @ 17:09:

[...]

Die eerste vier regels geven juist een uitermate goede reden waarom nVidia een 'Pay per good Die' regeling had voor 40nm, waar de 'Pay per Wafer' regeling de norm is. Het is evenzeer ook de reden geweest waarom AMD een Pay per good Die regeling had met GF aangaande 32nm, eveneens een tijdelijke regeling. Is het dan ook bashen als je stelt dat yields van GF's 32nm voor Llano producten superslecht waren?

Persoonlijk vind ik namelijk de informatie die ze daar uit een qoute van een document weten te slepen best waardevol, maar als je eerst aan het begin van het bericht door dat oude-koeien-uit-de-sloot-halen en ander gebash heen moet graven dan wordt de aangeboden informatie een stuk minder serieus genomen.

Tenminste ik vind dat artikel nu een behoorlijk Charlie haat nVidia gehalte hebben, terwijl als Anandtech het had gepost het artikel waarschijnlijk veel serieuzer genomen zou worden.

Maar goed nogmaals, dat is wel persoonlijk

PS3 is krachtiger vanwege zijn CPU niet vanwege zijn GPU. De GPU in de Xbox360 is iets krachtiger maar niet veel. Daarnaast betwijfel ik of het allemaal beter uit ziet op een Xbox360 dan op een PS3. Daarnaast zijn bijna alle consoles games zowel op PS3 als Xbox360 beschikbaar als ze ook voor de PC beschikbaar zijn.Werelds schreef op donderdag 05 april 2012 @ 19:26:

Wat is dat nu voor onzin?

Een 360 heeft een ATI (nee, geen AMD!) GPU, PS3 heeft een Nvidia GPU. 360 games zien er vaak beter uit dan PS3 titels en draaien vaak ook veel soepeler, ondanks het feit dat de PS3 eigenlijk iets krachtiger is (elke console eigenaar zal dan ook aanraden een 360 te kopen tenzij er PS3 exclusives zijn die je wil spelen). Draaien de meeste crossplatform titels nu beter op ATI/AMD? Nee.

Tijd om eens met Mel Gibson te gaan praten

Voorbeeldje waar het geen ik zeg wel van toepassing KAN zijn.

"Why the Radeons are doing so extremely well can only be speculated about at the moment. On the one hand it seems like Assault on Dark Athena has affinity for Arithmetic power - a plus for Radeons. On the other hand the developing platform of Escape from Butcher Bay had been the Xbox 360. The graphics processor of the console, the Xenos, is similar to current Radeon-HD models - so optimizations for this chip should also affect the RV770 and the other Radeon graphics chips. In matters of visual quality we didn't see any differences between AMD and Nvida graphics cards (see the gallery for comparative screensots). Another possibility for the good Radeon results is that Ati already optimized the drivers while Nvidia still has to do that."

Op 1280x1024 is een HD3870 sneller dan een GTX285

Bron

Enfin laten we de discussie maar achter ons laten, er is namelijk geen eenduidige conclusie die met zekerheid getrokken kan worden.

[ Voor 47% gewijzigd door madmaxnl op 06-04-2012 18:48 ]

Nee hoor, RSX heeft meer shader power; het probleem is echter hetzelfde als met VLIW5 in Cypress. Het vergt flink wat meer werk om alles er uit geperst te krijgen. Xenos is een stuk flexibeler en makkelijker te gebruiken - niet in het minst omdat MS gewoon weet wat ze doen op dat gebied. De PS3 devkit is gewoon complex. Als je interesse hebt kun je altijd eens op Beyond3D kijken, daar zijn meerdere malen threads en dergelijke langs gekomen die iets dieper er op in gaan. Enige waar Xenos *technisch* gezien voorligt is met het EDRAM en de 8 vertex units, voor de rest heeft RSX meer rauwe kracht.madmaxnl schreef op vrijdag 06 april 2012 @ 18:33:

[...]

PS3 is krachtiger vanwege zijn CPU niet vanwege zijn GPU. De GPU in de Xbox360 is iets krachtiger maar niet veel. Daarnaast betwijfel ik of het allemaal beter uit ziet op een Xbox360 dan op een PS3. Daarnaast zijn bijna alle consoles games zowel op PS3 als Xbox360 beschikbaar als ze ook voor de PC beschikbaar zijn.

Simpel voorbeeld is Mafia 2, daar waren wat problemen met gras en bloed en dat was echt niet omdat de PS3 niet krachtig genoeg was vergeleken met de 360

Enfin, doet er verder ook niet toe - punt is dat ongeacht welke GPU er in de nieuwe consoles komt, dat gaat op de PC niets uitmaken. De onderliggende API's zijn gewoon anders en daar ligt de grootste bottleneck.

[ Voor 10% gewijzigd door Werelds op 06-04-2012 19:40 ]

Simpel voorbeeld is GPGPU?Werelds schreef op vrijdag 06 april 2012 @ 19:38:

voor de rest heeft RSX meer rauwe kracht.

Simpel voorbeeld is Mafia 2

Je hoort vaak genoeg over organisaties, bedrijven, overheden etc. dat ze PS3 clusters hebben staan voor GPGPU taken, eerlijk gezegd heb ik nog nooit van X360s die voor dat soort doeleinden worden gebruikt. Zegt genoeg over de rauwe krachtvergelijking tussen de twee lijkt mij.

En misschien ook over de betrouwbaarheid van de consoles..Snorro schreef op zaterdag 07 april 2012 @ 13:46:

[...]

Simpel voorbeeld is GPGPU?

Je hoort vaak genoeg over organisaties, bedrijven, overheden etc. dat ze PS3 clusters hebben staan voor GPGPU taken, eerlijk gezegd heb ik nog nooit van X360s die voor dat soort doeleinden worden gebruikt. Zegt genoeg over de rauwe krachtvergelijking tussen de twee lijkt mij.

Als je 30 xbox 360's hebt staan kun je er elke week 1 vervangen..

PS3 zal toch echt vooral vanwege Cell voor GPGPU taken worden ingezet en niet vanwege de DX9 (non-GPGPU-capabele) GPU die in die kast zit.

De PS3 is/was met name geschikt omdat er een vlotte processor in zit en omdat er Linux op kon. Hoe dat tegenwoordig aangepakt wordt nu er geen Linux meer op kan weet ik eigenlijk niet precies...

holy sh*t ik wist niet dat ik op het PS3 en Xbox 360 topic zat te kijken met nutteloze discussies! Misschien is het weer tijd voor wat nieuws ? srry voor de offtopic maar come on guys..

[ Voor 12% gewijzigd door Jasper 99 op 07-04-2012 20:43 ]

Allemaal leuk die keiharde dikke performance en hoge prijzen maar ik ben meer geïnteresseerd in de lager geprijsde kaarten die Nvidia op de markt wil gaan zetten.

Een goede vervanger voor de GTX560 bijvoorbeeld tegen een bak minder stroomverbruik zou leuk zijn.

Is hier al info over?

Een goede vervanger voor de GTX560 bijvoorbeeld tegen een bak minder stroomverbruik zou leuk zijn.

Is hier al info over?

[ Voor 4% gewijzigd door Blaat op 07-04-2012 17:57 ]

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Eindelijk een review die mijn mening deelt.Verwijderd schreef op vrijdag 06 april 2012 @ 11:40:

Leuke test;

http://www.computerbase.d...x-680-sli-vs.-hd-7970-cf/

Gaat erg gelijk op, lang geleden dat we Nvidia eens een keer minder stroom zien verbruiken in dit soort tests...

Bij de conclusie gaat de lichte voorkeur uit naar Nvidia vanwege meer microstutter problemen bij AMD.

zie o.a.

Paprika in "[Centraal] Multi-monitor setup"

en

Paprika in "CJ's Radeon Nieuwsdiscussietopic - Deel 122"

Al is dit natuurlijk wel slecht....

Jasper 99 schreef op zaterdag 07 april 2012 @ 14:40:

holy shit ik wist niet dat ik op het PS3 en Xbox 360 topic zat te kijken met nutteloze discussies! Misschien is het weer tijd voor wat nieuws ? srry voor de offtopic maar come on guys..

offtopic:

Je eigen gezever is nog meer off topic dan al het andere, maar goed...

Je eigen gezever is nog meer off topic dan al het andere, maar goed...

Om dan toch nog iets 'nieuws' te brengen.

http://semiaccurate.com/2...hips-up-a-custom-gtx-680/

Een iets andere GTX680 dan de doorsnee non-reference versies.

ik snap dat plaatje niet helemaal zegt dat niet meer over de benchmark dan over de kaarten? een 680 sneller dan 2x 7970 en 2 x 680 sli ? dan is het toch gewoon een nuteloze benchmark of mis ik iets ?Paprika schreef op zaterdag 07 april 2012 @ 19:05:

[...]

Eindelijk een review die mijn mening deelt.

zie o.a.

Paprika in "[Centraal] Multi-monitor setup"

en

Paprika in "CJ's Radeon Nieuwsdiscussietopic - Deel 122"

[afbeelding]

Al is dit natuurlijk wel slecht....

Super vet kaartje! Ziet er mooi uit, ik zou bijna me reference willen verkopen als al deze non reference modellen uitkomen maarjadahakon schreef op zaterdag 07 april 2012 @ 20:24:

[...]

offtopic:

Je eigen gezever is nog meer off topic dan al het andere, maar goed...

Om dan toch nog iets 'nieuws' te brengen.

http://semiaccurate.com/2...hips-up-a-custom-gtx-680/

Een iets andere GTX680 dan de doorsnee non-reference versies.

offtopic:

hey iemand moet er wat van zeggen je mag het gezever noemen maarja

hey iemand moet er wat van zeggen je mag het gezever noemen maarja

Fixed. Beide merken hebben er slechte dual-GPU ondersteuning, maar de dip van de GTX680 SLI-setup is wel extreem.Jasper 99 schreef op zaterdag 07 april 2012 @ 20:46:

[...]

dan is het toch gewoon een nuteloze benchmark driver of mis ik iets ?

[ Voor 20% gewijzigd door Paprika op 07-04-2012 21:32 ]

Verwijderd

http://nl.hardware.info/n...e-videokaart-van-colorfulJasper 99 schreef op zaterdag 07 april 2012 @ 20:46:

[...]

Super vet kaartje! Ziet er mooi uit, ik zou bijna me reference willen verkopen als al deze non reference modellen uitkomen maarja

offtopic:

hey iemand moet er wat van zeggen je mag het gezever noemen maarja

Verwijderd

Maar het begin van de lijn van de hd7970 is ook niet echt geweldig, maargoed dat is geen dual-gpuPaprika schreef op zaterdag 07 april 2012 @ 21:32:

[...]

Fixed. Beide merken hebben er slechte dual-GPU ondersteuning, maar de dip van de GTX680 SLI-setup is wel extreem.

Lijkt alsof de buffer daar bleef hangen, maar daar merkte je tijdens de race dus niets van  .

.

Lijkt alsof ze te laat beginnen met de meting... Kan natuurlijk niet gezien de tijden die vast zitten aan de metingen.Verwijderd schreef op zaterdag 07 april 2012 @ 23:44:

[...]

Maar het begin van de lijn van de hd7970 is ook niet echt geweldig, maargoed dat is geen dual-gpu

Wacht hier ook op, hoorde dat ie misschien in mei uitkwam, maar dat was slechts een gerucht.Wolf schreef op zaterdag 07 april 2012 @ 17:57:

Allemaal leuk die keiharde dikke performance en hoge prijzen maar ik ben meer geïnteresseerd in de lager geprijsde kaarten die Nvidia op de markt wil gaan zetten.

Een goede vervanger voor de GTX560 bijvoorbeeld tegen een bak minder stroomverbruik zou leuk zijn.

Is hier al info over?

Laatste gerucht is de zomer voor 660 (670 in mei oid).Cobaltos schreef op zondag 08 april 2012 @ 23:55:

[...]

Wacht hier ook op, hoorde dat ie misschien in mei uitkwam, maar dat was slechts een gerucht.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Er waren ook geruchten dat er een aantal GPU's een rebrand gingen krijgen. Heeft iemand al iets gehoord van welke GPU's dat gaan worden?

Low-end's.. Van die OEM kaartjes a la GT520 enzo.

GT 620 en GT 605.Daantje20 schreef op maandag 09 april 2012 @ 15:27:

Er waren ook geruchten dat er een aantal GPU's een rebrand gingen krijgen. Heeft iemand al iets gehoord van welke GPU's dat gaan worden?

Verwijderd

Nieuwe beta 301.24

http://www.nvidia.co.uk/Download/Find.aspx?lang=en-uk

New in R300 Drivers:

•New GPU Support – Adds support for the new GeForce GTX 680, the fastest, most efficient GPU ever built. Explore GeForce GTX 680 and its new SMX architecture on GeForce.com.

•Performance Boost – Increases performance for GeForce 400 Series and 500 Series GPUs in several PC games vs. GeForce 296.10 WHQL-certified drivers. Results will vary depending on your GPU and system configuration:

GeForce GTX 570/580:

◦Up to 23% in Just Cause 2 with SLI

◦Up to 21% in The Elder Scrolls V: Skyrim

◦Up to 17% in StarCraft II with SLI

◦Up to 14% in Far Cry 2 with SLI

◦Up to 9% in Bulletstorm

◦Up to 7% in Civilization V

◦Up to 6% in Deus Ex: Human Revolution with SLI

◦Up to 6% in Dragon Age 2 with SLI

◦Up to 5% in Metro 2033 with SLI

◦Up to 5% in Total War: Shogun 2

GeForce GTX 560/560 Ti:

◦Up to 20% in The Elder Scrolls V: Skyrim

◦Up to 15% in Just Cause 2 with SLI

◦Up to 13% in Far Cry 2 with SLI

◦Up to 12% in Bulletstorm

◦Up to 11% in Civilization V

◦Up to 10% in StarCraft II with SLI

◦Up to 9% in Batman: Arkham City

◦Up to 4% in Deus Ex: Human Revolution with SLI

◦Up to 4% in Dragon Age 2 with SLI

◦Up to 4% in Metro 2033 with SLI

◦Up to 4% in Total War: Shogun 2

•NVIDIA FXAA Technology – shader-based anti-aliasing technology available from the NVIDIA Control Panel that enables ultra-fast anti-aliasing in hundreds of PC games. FXAA delivers similar quality to 4x multi-sample antialiasing (MSAA) but is up to 60% faster, enabling substantially higher performance in games. FXAA is supported on all GeForce 8-series and later GPUs. Note: This feature is disabled for games that already have built-in support for FXAA. Visit GeForce.com to learn more.

•NVIDIA Adaptive Vertical Sync – dynamically enables vertical sync based on your current frame rates for the smoothest gaming experience. Adaptive VSync is supported on all GeForce 8-series and later GPUs. Visit GeForce.com to learn more.•NVIDIA Frame Rate Target – dynamically adjusts frame rate to a user specified target. Support for this feature is enabled via third party applications via NVAPI. Visit GeForce.com to learn more.

•NVIDIA Surround Technology – Adds the following new Surround capabilities. Visit GeForce.com to learn more.

◦Add in a fourth accessory display to get access to your email, web, or other applications while you game.

◦Maximize an application to a single physical display when in Surround mode (enabled by default).

◦Confine the Windows Taskbar to the center display (enabled by default).

◦Enable bezel peeking – a feature which enables users to temporarily ‘peak’ behind the monitor bezels using a hotkey (Ctrl + Alt + . This feature is designed to be used in conjunction with bezel corrected resolutions.

. This feature is designed to be used in conjunction with bezel corrected resolutions.

◦Add or remove resolutions from the list of Surround resolutions (only those selected will be available to applications).

◦Full center display acceleration for single wide display modes (center display must be connected to the master GPU).

•NVIDIA SLI Technology – Adds or updates the following SLI profiles:◦Alan Wake

◦Call of Juarez: The Cartel

◦Counter-Strike: Global Offensive

◦Deus Ex: Human Revolution - The Missing Link

◦Left 4 Dead

◦Orcs Must Die!

◦Portal 2◦Risen 2: Dark Waters

◦The Darkness II

•NVIDIA 3D Vision – Adds or updates the following 3D Vision profiles:◦All Zombies Must Die! – rated Fair

◦Ghosts 'n Goblins Online – rated Good

◦Oil Rush – rated 3D Vision Ready

◦Postal III – rated Good

◦Rayman Origins – rated Good

◦SevenCore – rated Fair

◦Stacking – rated Good

◦Unigine Heaven Benchmark v3.0 – rated 3D Vision Ready

◦Wargame: European Escalation – rated Good

◦Warp – rated Good

◦Wings of Prey – rated Fair

◦Krater – rated Poor

Other Details

•Installs PhysX System Software v9.12.0213.

•Installs HD Audio v1.3.12.0.

•Supports OpenGL 4.2

•Supports DisplayPort 1.2 for GeForce GTX 680.

•Supports multiple languages and APIs for GPU computing: CUDA C, CUDA C++, CUDA Fortran, OpenCL, DirectCompute, and Microsoft C++ AMP.

•Supports single GPU and NVIDIA SLI technology on DirectX 9, DirectX 10, DirectX 11, and OpenGL, including 3-way SLI, Quad SLI, and SLI support on SLI-certified Intel and AMD motherboards.

http://www.nvidia.co.uk/Download/Find.aspx?lang=en-uk

New in R300 Drivers:

•New GPU Support – Adds support for the new GeForce GTX 680, the fastest, most efficient GPU ever built. Explore GeForce GTX 680 and its new SMX architecture on GeForce.com.

•Performance Boost – Increases performance for GeForce 400 Series and 500 Series GPUs in several PC games vs. GeForce 296.10 WHQL-certified drivers. Results will vary depending on your GPU and system configuration:

GeForce GTX 570/580:

◦Up to 23% in Just Cause 2 with SLI

◦Up to 21% in The Elder Scrolls V: Skyrim

◦Up to 17% in StarCraft II with SLI

◦Up to 14% in Far Cry 2 with SLI

◦Up to 9% in Bulletstorm

◦Up to 7% in Civilization V

◦Up to 6% in Deus Ex: Human Revolution with SLI

◦Up to 6% in Dragon Age 2 with SLI

◦Up to 5% in Metro 2033 with SLI

◦Up to 5% in Total War: Shogun 2

GeForce GTX 560/560 Ti:

◦Up to 20% in The Elder Scrolls V: Skyrim

◦Up to 15% in Just Cause 2 with SLI

◦Up to 13% in Far Cry 2 with SLI

◦Up to 12% in Bulletstorm

◦Up to 11% in Civilization V

◦Up to 10% in StarCraft II with SLI

◦Up to 9% in Batman: Arkham City

◦Up to 4% in Deus Ex: Human Revolution with SLI

◦Up to 4% in Dragon Age 2 with SLI

◦Up to 4% in Metro 2033 with SLI

◦Up to 4% in Total War: Shogun 2

•NVIDIA FXAA Technology – shader-based anti-aliasing technology available from the NVIDIA Control Panel that enables ultra-fast anti-aliasing in hundreds of PC games. FXAA delivers similar quality to 4x multi-sample antialiasing (MSAA) but is up to 60% faster, enabling substantially higher performance in games. FXAA is supported on all GeForce 8-series and later GPUs. Note: This feature is disabled for games that already have built-in support for FXAA. Visit GeForce.com to learn more.

•NVIDIA Adaptive Vertical Sync – dynamically enables vertical sync based on your current frame rates for the smoothest gaming experience. Adaptive VSync is supported on all GeForce 8-series and later GPUs. Visit GeForce.com to learn more.•NVIDIA Frame Rate Target – dynamically adjusts frame rate to a user specified target. Support for this feature is enabled via third party applications via NVAPI. Visit GeForce.com to learn more.

•NVIDIA Surround Technology – Adds the following new Surround capabilities. Visit GeForce.com to learn more.

◦Add in a fourth accessory display to get access to your email, web, or other applications while you game.

◦Maximize an application to a single physical display when in Surround mode (enabled by default).

◦Confine the Windows Taskbar to the center display (enabled by default).

◦Enable bezel peeking – a feature which enables users to temporarily ‘peak’ behind the monitor bezels using a hotkey (Ctrl + Alt +

◦Add or remove resolutions from the list of Surround resolutions (only those selected will be available to applications).

◦Full center display acceleration for single wide display modes (center display must be connected to the master GPU).

•NVIDIA SLI Technology – Adds or updates the following SLI profiles:◦Alan Wake

◦Call of Juarez: The Cartel

◦Counter-Strike: Global Offensive

◦Deus Ex: Human Revolution - The Missing Link

◦Left 4 Dead

◦Orcs Must Die!

◦Portal 2◦Risen 2: Dark Waters

◦The Darkness II

•NVIDIA 3D Vision – Adds or updates the following 3D Vision profiles:◦All Zombies Must Die! – rated Fair

◦Ghosts 'n Goblins Online – rated Good

◦Oil Rush – rated 3D Vision Ready

◦Postal III – rated Good

◦Rayman Origins – rated Good

◦SevenCore – rated Fair

◦Stacking – rated Good

◦Unigine Heaven Benchmark v3.0 – rated 3D Vision Ready

◦Wargame: European Escalation – rated Good

◦Warp – rated Good

◦Wings of Prey – rated Fair

◦Krater – rated Poor

Other Details

•Installs PhysX System Software v9.12.0213.

•Installs HD Audio v1.3.12.0.

•Supports OpenGL 4.2

•Supports DisplayPort 1.2 for GeForce GTX 680.

•Supports multiple languages and APIs for GPU computing: CUDA C, CUDA C++, CUDA Fortran, OpenCL, DirectCompute, and Microsoft C++ AMP.

•Supports single GPU and NVIDIA SLI technology on DirectX 9, DirectX 10, DirectX 11, and OpenGL, including 3-way SLI, Quad SLI, and SLI support on SLI-certified Intel and AMD motherboards.

Die EVGA GTX680 SC+ haalt met gemak 1330mhz core  En dat op 'slechts' 1.095v!

En dat op 'slechts' 1.095v!

MSI lanceert gtx 680 twin frozr

Ben benieuwd hoeveel hij gaat kosten en wanneer hij fatsoenlijk leverbaar is

http://msi.com/news-media/news/1403.html

Ben benieuwd hoeveel hij gaat kosten en wanneer hij fatsoenlijk leverbaar is

http://msi.com/news-media/news/1403.html

'I reject your reality and substitute my own'

Inderdaad, de prijs zal voor mij bepalen of ik voor de Twin Frozr III ga of gewoon voor de referentie kaart.

en op een andere spanning (want die gaat mee omhoog bij turboboost).Verwijderd schreef op dinsdag 10 april 2012 @ 16:13:

Dat is dus incl. boost zoals ik het snel las in de review op hardwarecanucks...

Het is gewoon een reference pcb dus zou niet weten waarom je deze MSI boven een ander model met non-reference koeler zou verkiezen...

http://fudzilla.com/home/...gtx-680-twin-frozr-iii-oc

http://fudzilla.com/home/...gtx-680-twin-frozr-iii-oc

Boost is gerelateerd aan het design van de GTX680, geef het een naam, feit is dat de kaart 1330mhz doet en dat is netjes (hoe die dat doet maakt mij geen ruk uit, zolang ie het maar doet zodra het gevraagd wordt).

Dus als je 1.1v instelt in Afterburner en locked ga je icm boost toch nog een hoger voltage krijgen volgens jullie? Dat is dan voor het eerst...

Dus als je 1.1v instelt in Afterburner en locked ga je icm boost toch nog een hoger voltage krijgen volgens jullie? Dat is dan voor het eerst...

Dat gebeurt niet, je kan alleen je minimale volt instellen op welke hij dus steeds zal blijven of ie t nodig heeft of niet. Vandaar dat ik het ook raar vind dat ze zo veel betere resultaten krijgen in de hardwarecanucks review ...t!n0 schreef op donderdag 12 april 2012 @ 16:31:

Boost is gerelateerd aan het design van de GTX680, geef het een naam, feit is dat de kaart 1330mhz doet en dat is netjes (hoe die dat doet maakt mij geen ruk uit, zolang ie het maar doet zodra het gevraagd wordt).

Dus als je 1.1v instelt in Afterburner en locked ga je icm boost toch nog een hoger voltage krijgen volgens jullie? Dat is dan voor het eerst...

Punt is dat jij niks te vragen hebtt!n0 schreef op donderdag 12 april 2012 @ 16:31:

Boost is gerelateerd aan het design van de GTX680, geef het een naam, feit is dat de kaart 1330mhz doet en dat is netjes (hoe die dat doet maakt mij geen ruk uit, zolang ie het maar doet zodra het gevraagd wordt).

GPU boost bepaalt zelf wanneer het zin heeft om de clocks omhoog te duwen en met hoeveel. Nu zal het voor de Twin Frozr wel meevallen omdat ze daar wel zullen cherrypicken, maar daar bovenop is het ook nog zo dat er ontzettend veel verschil tussen de chips zit. Ik heb met de mijne bijvoorbeeld pech; draait in 3D altijd op 1175mV en +120/+75 is mijn limiet. Anderen halen dan weer 100 op de core meer en zelfs meer dan 200 meer op het geheugen; en ze moeten zelf het voltage op 1175mV forceren

Ik vraag de max van mijn kaart en dat levert ie icm een bepaald voltage en temperatuur, dus heb zeker wel wat te vragen (of de max via boost bereikt wordt of niet doet niet ter zake).

Zover ik heb begrepen is temperatuur de belangrijke factor die op da moment de max clock bepaald, niets anders als met andere kaarten dus (i.e. max op lucht, water en ln2 is bij dezelfde kaart altijd anders)

Zover ik heb begrepen is temperatuur de belangrijke factor die op da moment de max clock bepaald, niets anders als met andere kaarten dus (i.e. max op lucht, water en ln2 is bij dezelfde kaart altijd anders)

Nee, je vraagt de max en hoopt dat ie niet de gelockte max-TDP haaltt!n0 schreef op donderdag 12 april 2012 @ 19:26:

Ik vraag de max van mijn kaart en dat levert ie icm een bepaald voltage en temperatuur, dus heb zeker wel wat te vragen (of de max via boost bereikt wordt of niet doet niet ter zake).

Nee, dat is dus helemaal niet zo. De eerste factor is je FPS en enige limiet die daar voor loopt. Als jij een frame-rate target, frame-rate limiter of V-Sync (adaptive of niet) gebruikt en je zit aan die limiet, doet GPU boost helemaal niks. Pas als je FPS dropt doet hij iets; wat in sommige gevallen dan al te laat is, want een game als BF3 wil toch nog wel onder de 60 vallen. Met een permanente overclock die je zelf in de hand hebt kun je er voor zorgen dat dat minimum iets hoger ligt, terwijl met GPU boost de mosterd pas na de maaltijd komtt!n0 schreef op donderdag 12 april 2012 @ 19:26:

Ik vraag de max van mijn kaart en dat levert ie icm een bepaald voltage en temperatuur, dus heb zeker wel wat te vragen (of de max via boost bereikt wordt of niet doet niet ter zake).

Zover ik heb begrepen is temperatuur de belangrijke factor die op da moment de max clock bepaald, niets anders als met andere kaarten dus (i.e. max op lucht, water en ln2 is bij dezelfde kaart altijd anders)

Misschien nuttig om te vermelden dat ik meer doel op benchen (wat ik zelf het meest doe).

Dan gebruik je dus absoluut geen limiters

Dan is de enige overgebleven factor dus temperatuur? Die kun je gemakkelijk beïnvloeden en daarmee dus de max clock.

Als ik ernaast zit hoor ik het graag want ik wil gewoon weten of ik met deze kaart lekker punten kan scoren op hwbot (sta op het punt 1 te bestellen namelijk)

(sta op het punt 1 te bestellen namelijk)

Dan gebruik je dus absoluut geen limiters

Dan is de enige overgebleven factor dus temperatuur? Die kun je gemakkelijk beïnvloeden en daarmee dus de max clock.

Als ik ernaast zit hoor ik het graag want ik wil gewoon weten of ik met deze kaart lekker punten kan scoren op hwbot

Verwijderd schreef op vrijdag 06 april 2012 @ 11:40:

Leuke test;

http://www.computerbase.d...x-680-sli-vs.-hd-7970-cf/

Gaat erg gelijk op, lang geleden dat we Nvidia eens een keer minder stroom zien verbruiken in dit soort tests...

Bij de conclusie gaat de lichte voorkeur uit naar Nvidia vanwege meer microstutter problemen bij AMD.

http://www.hardocp.com/ar...0_sli_video_card_review/9Memory Capacity and Bandwidth

We know exactly what you guys are thinking. The Radeon HD 7970 has 3GB of VRAM, the GeForce GTX 680 has 2GB; the Radeon HD 7970 has 264GB/sec of memory bandwidth and the GeForce GTX 680 has 192GB/sec of memory bandwidth. You'd expect Radeon HD 7970 CrossFireX to simply blow GeForce GTX 680 SLI out of the water at 5760x1200. The simple fact is, it does not, and in fact GeForce GTX 680 SLI provides a better gameplay experience with better performance. Amazing, but true. Obviously AMD’s driver engineers need to figure out how to utilize the hardware more efficiently, because at the moment, NVIDIA is taking AMD to school.

There is one interesting game to look at right now for video card memory usage, and that is Battlefield 3 multiplayer. There is a big difference between the VRAM usage in single player and multiplayer. When we cranked this game up in a 64 player server at the highest in-game settings we saw it get near to 5 GB of VRAM usage on Radeon HD 7970 at 4X AA at 5760x1200. This game seems certainly capable of maximizing VRAM usage on video cards in multiplayer in NV Surround or Eyefinity resolutions. It makes us really want to try out 4GB, or higher video cards. A couple of 4GB GTX 680 video cards are looking real interesting to us right now in this game, and from what rumors we have heard, Galaxy is very likely to make this happen for us.

SLI smoothness vs. CrossFireX smoothness

We don't know what other descriptive word to use, other than "smoothness" to describe the difference we feel between SLI and CrossFireX when we play games. We've expressed this difference in gameplay feeling between SLI and CrossFireX in the past, in other evaluations, and we have to bring it up again because it was very apparent during our testing of 680 SLI versus 7970 CFX.

We can't communicate to you "smoothness" in raw framerates and graphs. Smoothness, frame transition, and game responsiveness is the experience that is provided to you as you play. Perhaps it has more to do with "frametime" than it does with "framerate." To us it seems like SLI is "more playable" at lower framerates than CrossFireX is. For example, where we might find a game playable at 40 FPS average with SLI, when we test CrossFireX we find that 40 FPS doesn't feel as smooth and we have to target a higher average framerate, maybe 50 FPS, maybe 60 FPS for CrossFireX to feel like NVIDIA's SLI framerate of 40 FPS. Only real-world hands on gameplay can show you this, although we can communicate it in words to you. Even though this is a very subjective realm of reviewing GPUs, it is one we surely need to discuss with you.

The result of SLI feeling smoother than CrossFireX is that in real-world gameplay, we can get away with a bit lower FPS with SLI, whereas with CFX we have to aim a little higher for it to feel smooth. We do know that SLI performs some kind of driver algorithm to help smooth SLI framerates, and this could be why it feels so much better. Whatever the reason, to us, SLI feels smoother than CrossFireX.

Personally speaking here, when I was playing between GeForce GTX 680 SLI and Radeon HD 7970 CrossFireX, I felt GTX 680 SLI delivered the better experience in every single game. I will make a bold and personal statement; I'd prefer to play games on GTX 680 SLI than I would with Radeon HD 7970 CrossFireX after using both. For me, GTX 680 SLI simply provides a smoother gameplay experience. If I were building a new machine with multi-card in mind, SLI would go in my machine instead of CrossFireX. In fact, I'd probably be looking for those special Galaxy 4GB 680 cards coming down the pike. After gaming on both platforms, GTX 680 SLI was giving me smoother performance at 5760x1200 compared to 7970 CFX. This doesn't apply to single-GPU video cards, only between SLI and CrossFireX.

Beetje 't zelfde verhaal hier overigens, viel me nu pas op.

Verwijderd

Als ze het dan goed willen doen moeten ze ook met onderbouwing komen, gewoon even de tijd tussen de frames meten.Even though this is a very subjective realm of reviewing GPUs, it is one we surely need to discuss with you.

ExactlyVerwijderd schreef op zaterdag 14 april 2012 @ 11:31:

[...]

Als ze het dan goed willen doen moeten ze ook met onderbouwing komen, gewoon even de tijd tussen de frames meten.

Weet niet of ze al langsgekomen waren maar nog enkele 4GB kaarten aangekondigd:

http://www.guru3d.com/new...x-680-4gb-edition-photos/

http://www.guru3d.com/new...phantom-4gb-in-the-works/

http://www.guru3d.com/new...x-680-4gb-edition-photos/

http://www.guru3d.com/new...phantom-4gb-in-the-works/

pas maar op wat je zegt... er was ook een GTX 480 die 1GHZ haalde op een stock luchtkoeler en dat was er 1... Of al die kaarten moeten cherry picked zijn.t!n0 schreef op dinsdag 10 april 2012 @ 12:07:

Die EVGA GTX680 SC+ haalt met gemak 1330mhz coreEn dat op 'slechts' 1.095v!

Ik had zelf altijd pech gehad met videokaarten en clock frequenties..zelfs de lightning clockte hier voor geen meter over en vrat veeeel te veel stroom... alleen de positieve verhalen lees je.

Nu ik 3d vision heb zit ik er toch aan te denken om over te gaan op een 680... FPS cut in half is echt shit in games

[ Voor 45% gewijzigd door A87 op 14-04-2012 14:14 ]

https://www.youtube.com/channel/UCl2XLRJ3VgCspwNG4_XCrkQ

http://techreport.com/articles.x/21516/11Verwijderd schreef op zaterdag 14 april 2012 @ 11:31:

[...]

Als ze het dan goed willen doen moeten ze ook met onderbouwing komen, gewoon even de tijd tussen de frames meten.

dat microstutter verhaaltje is vast al vaak langsgekomen hier, maar ze hebben het erover dat wat je met fraps meet niet is wat wordt weergegeven, de gpu draait (met dedicated hardware) een algoritme om frames soms iets te vertragen als dat soepeler is. Ten koste van wat lag.

Mechwarrior Online: Flapdrol

Positieve review van HardOCP over nvidia's Adaptive Vsync:

http://www.hardocp.com/ar...vsync_technology_review/3

http://www.hardocp.com/ar...vsync_technology_review/3

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Verwijderd

Ben er ook wel te spreken over, stuk minder mouse lag, of lag over het algemeen. Heb verder ook niet zo'n best scherm.

Wilt iemand een PNY gtx 580 kopen? 41.231 euro excl. BTW of 49.064,89 incl. BTW.

http://www.centralpoint.n...tm_campaign=tweakersclick

http://www.centralpoint.n...tm_campaign=tweakersclick

Roerbakeitje schreef op dinsdag 17 april 2012 @ 22:47:

Wilt iemand een PNY gtx 580 kopen? 41.231 euro excl. BTW of 49.064,89 incl. BTW.

http://www.centralpoint.n...tm_campaign=tweakersclick

offtopic:

Hierbij kan ik wel een mooie opmerking plaatsen, maar dan krijgen we weer van die krijsende kinderen in dit topic dus ik laat het maar voor wat het is.

Hierbij kan ik wel een mooie opmerking plaatsen, maar dan krijgen we weer van die krijsende kinderen in dit topic dus ik laat het maar voor wat het is.

[ Voor 3% gewijzigd door madmaxnl op 17-04-2012 23:02 ]

totally worth it!Roerbakeitje schreef op dinsdag 17 april 2012 @ 22:47:

Wilt iemand een PNY gtx 580 kopen? 41.231 euro excl. BTW of 49.064,89 incl. BTW.

http://www.centralpoint.n...tm_campaign=tweakersclick

Verwijderd

Beetje crappy reviews van Fud, maar de kaart is bijzonder fraai;

http://www.fudzilla.com/h...tx-680-phantom-2gb-tested

http://www.fudzilla.com/h...tx-680-phantom-2gb-tested

:strip_icc():strip_exif()/u/326608/crop5d26079bc4d20_cropped.jpeg?f=community)

:strip_exif()/u/327460/cowboy.gif?f=community)

:strip_icc():strip_exif()/u/287731/crop6270fa65746ea_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/344104/crop5d33716c680b5_cropped.jpeg?f=community)

/u/12038/crop69547035714ff_cropped.png?f=community)

/u/200133/artemis_square_e_60-60.png?f=community)

/u/180271/av.png?f=community)

:strip_icc():strip_exif()/u/192015/crop609667eb665d7_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/100224/paladin-small.jpg?f=community)

:strip_icc():strip_exif()/u/445363/crop56757510392f8_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/230054/crop60192459d7f49_cropped.jpeg?f=community)

:strip_exif()/u/233284/crop573f69b75d616.gif?f=community)

:strip_icc():strip_exif()/u/304653/crop68b4ad60494fd_cropped.jpg?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

:strip_icc():strip_exif()/u/162646/ja.jpg?f=community)

:strip_icc():strip_exif()/u/313945/1282927574N2556.jpg?f=community)

/u/400/defember100.png?f=community)