Verwijderd

Wat is er dan verkeerd om je ook op de GPGPU markt te richten? Of ze dat in een andere GPU moeten verwerken is een andere vraag, maar het design aanpassen is sowieso veel te laat.Verwijderd schreef op woensdag 30 september 2009 @ 14:40:

Behalve dat de nadruk van GT300 nog veel meer dan GT200 op GPGPU ligt. Ik kan bijna niet geloven dat het weer een RV770 vs GT200 verhaal wordt. Wat voor markten denken ze aan te gaan spreken hiermee? Hoe strategisch is dat?

Als het sneller is dan hardwarematige implementatie, waarom niet. Ik zeg wel als, dus dat moeten we nog even afwachten.babbaloerie schreef op woensdag 30 september 2009 @ 16:23:

In principe gaan we dus weer terug naar de software renderers?

Misschien zijn ze druk bezig met de eerste Fermi drivers?jayjay1986 schreef op woensdag 30 september 2009 @ 16:33:

even hele stomme opmerking tussendoor maar is het al iemand opgevallen dat de nieuwe driver van nvidia nog steeds niet uit is ? en de laatste was van 23 augustus 2009 en er zijn op de nvidia site ook geen beta drivers. Wat voor nvidia in zijn schild of zijn ze gewoon laat vanwege de vakantieperiode ''lol'' .

Volgens mij stond ook op Guru3D dat ze ray tracing demo's gaan showen.

Misschien nog wat voorbarig, maar misschien slaat AMD hier wel de plank mis. Als NVIDIA en Intel al straks een GPU hebben die ray tracing aan kan, zal het gat tussen AMD en de rest wel heel groot worden.(Niet alleen qua FPS, maar ook qua kwaliteit)

http://www.techarp.com/showarticle.aspx?artno=88&pgno=5

http://www.techarp.com/showarticle.aspx?artno=88&pgno=6

http://www.techarp.com/showarticle.aspx?artno=88&pgno=7

Eensch !Illidan schreef op woensdag 30 september 2009 @ 14:14:

Als je daarmee beweert dat er nooit een goed moment is om hardware te kopen, is die stelling imo onzinnig. Tuurlijk komt er vroeg of laar weer nieuwe hardware, dat is niet het punt, maar in mijn ervaring is goeie (en dus ook slechte) timing wel degelijk mogelijk.

Misschien heeft nVidia wel een voor hen logische andere mening over hoe ze zich willen positioneren met hun GPU'sCJ schreef op woensdag 30 september 2009 @ 14:51:

Vergeet niet dat de Fermi al een tijd lang in ontwikkeling was. De ontwikkeling van GT300 zat waarschijnlijk al in een ver gevorderd stadium, zodat het waarschijnlijk al te laat om te reageren op de smalldie strategy van AMD. Fermi zie ik zelf als een flink opgepompte GT200. AMD pronkt met het feit dat ze met Cypress een GPU voor gamers door gamers ontworpen hebben, die toevallig ook goed overweg kan met gpu computing. NV laat nu duidelijk zien dat de gamersmarkt op gelijke hoogte staat met andere markten zoals de professionele markt. Ze moeten ook wel, want je gaat natuurlijk niet je eigen product af kraken. Het enige wat ze kunnen doen is achter de schermen hard door werken aan kleinere GPUs die toch erg goed presteren, terwijl de PR afdeling de grote GPUs probeert te verkopen als 'the best thing ever'. Aan de andere kant zijn ze koppig genoeg om hun eigen koers te varen en door te blijven gaan met grote GPUs. Ach... zo lang ze maar goed presteren en voor redelijke prijzen te koop zijn, dan hebben we er allemaal baat bij.

.....

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Helaas. Er zitten nog wat 'fouten' in de specs.Cin- schreef op woensdag 30 september 2009 @ 17:25:

Nog enkele interessante links (en deze keer een deftige bron?)

http://www.techarp.com/showarticle.aspx?artno=88&pgno=5

http://www.techarp.com/showarticle.aspx?artno=88&pgno=6

http://www.techarp.com/showarticle.aspx?artno=88&pgno=7

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Just hours before Nvidia decided to share the Fermi, GT300 specification with the world, we managed to get most of the spec and share it with you.

The chip has three billion transistors, a 384-bit memory interface and 512 shader cores, something that Nvidia plans to rename to Cuda cores.

The chip is made of clusters so the slower iterations with less shaders should not be that hard to spin off. Each cluster of the chip has 32 Cuda cores meaning that Fermi has 16 clusters.

Another innovation is 1MB of L1 cache memory divided into 16KB Cache - Shared Memory as well as 768KB L2 of unified cache memory. This is something that many CPUs have today and as of this day Nvidia GPUs will go down that road.

The chip supports GDDR5 memory and up to 6 GB of it, depending on the configuration as well as Half Speed IEEE 754 Double Precision. We also heard that the chip can execute C++ code directly and, of course, it's full DirectX 11 capable.

Nvidia’s next gen GPU is surely starting to look like a CPU. Looks like Nvidia is doing reverse Fusion and every generation they add some CPU parts on their GPU designs.

Bron: Fudzilla

Ik wil niet overkomen als een ATi fanboy (integendeel, ik heb nog nooit iets van AMD/Ati gekocht), maar ik vind dat Fudzilla de laatste tijd wel heel pro nvidia gaat, met uitspraken zoals "ja 5870 is mooie kaart, maar duur", terwijl ik het echt als een redelijk goedkope kaart zie (net iets hoger dan GTX 285). Maar als dat waar is, worden het hele mooie kaarten, maar voor iemand zoals ik, die helemaal niks met CUDA, GPGPU enz. doet, wordt dit wel teveel van het goede, de 5850 kan alles goed afspelen, en ik denk niet dat de GTX 360 -200 zal gaan kosten...Cin- schreef op woensdag 30 september 2009 @ 19:17:

3.0 billion transistors

Just hours before Nvidia decided to share the Fermi, GT300 specification with the world, we managed to get most of the spec and share it with you.

The chip has three billion transistors, a 384-bit memory interface and 512 shader cores, something that Nvidia plans to rename to Cuda cores.

The chip is made of clusters so the slower iterations with less shaders should not be that hard to spin off. Each cluster of the chip has 32 Cuda cores meaning that Fermi has 16 clusters.

Another innovation is 1MB of L1 cache memory divided into 16KB Cache - Shared Memory as well as 768KB L2 of unified cache memory. This is something that many CPUs have today and as of this day Nvidia GPUs will go down that road.

The chip supports GDDR5 memory and up to 6 GB of it, depending on the configuration as well as Half Speed IEEE 754 Double Precision. We also heard that the chip can execute C++ code directly and, of course, it's full DirectX 11 capable.

Nvidia’s next gen GPU is surely starting to look like a CPU. Looks like Nvidia is doing reverse Fusion and every generation they add some CPU parts on their GPU designs.

Bron: Fudzilla

Ik begrijp wat je bedoelt en ik ben iemand die liever ook gewoon x aantal euro neerlegt voor pure game performance. Echter, en pin me hier maar op vast, gaat NVIDIA iets uit hun hoge hoed toveren. Niets voor niets lijkt het concept veel op dat van Larabee.(Ray tracing anyone?)M4gick schreef op woensdag 30 september 2009 @ 19:21:

[...]

Ik wil niet overkomen als een ATi fanboy (integendeel, ik heb nog nooit iets van AMD/Ati gekocht), maar ik vind dat Fudzilla de laatste tijd wel heel pro nvidia gaat, met uitspraken zoals "ja 5870 is mooie kaart, maar duur", terwijl ik het echt als een redelijk goedkope kaart zie (net iets hoger dan GTX 285). Maar als dat waar is, worden het hele mooie kaarten, maar voor iemand zoals ik, die helemaal niks met CUDA, GPGPU enz. doet, wordt dit wel teveel van het goede, de 5850 kan alles goed afspelen, en ik denk niet dat de GTX 360 -200 zal gaan kosten...

Verwijderd

voor real time ray tracing moet je echt de manier hoe gfx kaarten werken veranderen.Bejit schreef op woensdag 30 september 2009 @ 19:39:

[...]

Ik begrijp wat je bedoelt en ik ben iemand die liever ook gewoon x aantal euro neerlegt voor pure game performance. Echter, en pin me hier maar op vast, gaat NVIDIA iets uit hun hoge hoed toveren. Niets voor niets lijkt het concept veel op dat van Larabee.(Ray tracing anyone?)

Verwijderd

Een recent voorbeeld van de traagheid van dit soort dingen is Physics op de GPU, we hebben het er met z'n allen al jaren over maar er zijn maar een handje vol games die het ooit toegepast hebben. Voordat we het op grote school gaan zien zijn we nog wel een paar jaar verder, en tegen de tijd dat physics op de GPU voor het eerst daadwerkelijk de gameplay zal beïnvloeden zitten we dik in het volgende decennium.

Verwijderd

Niets, ik stel alleen de vraag; hoe groot is de markt, wat zijn de concurrenten op de markt, wat zijn alternatieven voor mensen die geinteresseerd zijn in GPGPU. En wanneer heb ik gezegd dat ze het design moeten aanpassen????? Lees nou eens goed, ik stel alleen de vraag met als oogmerk om jullie meningen daarover te horen.Verwijderd schreef op woensdag 30 september 2009 @ 16:32:

[...]

Wat is er dan verkeerd om je ook op de GPGPU markt te richten? Of ze dat in een andere GPU moeten verwerken is een andere vraag, maar het design aanpassen is sowieso veel te laat.

[...]

We heben een paar initiatieven gezien in de wetenschappelijke wereld om simulaties te draaien met CUDA. Ik denk dat daar veel potentie ligt aangezien tijd van supercomputers ontzettend veel geld kost.

Het effiecient leren aanspreken van de GPU kost tijd en moeite, maar code optimaliseren voor multi-processor PowerCell systemen (bijvoorbeeld) ook. Veel hangt af van het software gedeelte: of Nvidia zelf advies en hulp geeft aan partijen die hun GPU's voor andere dingen dan rendren willen gebruiken. Volgens mij doen ze dat ook.

GT300 ziet er interessant uit, zacht gezegd.

Voor de mensen die discussieren over ray-tracing: http://www.beyond3d.com/content/articles/94/

Ray-tracing vs rasterisation. Tempert het soms wat ongebreidelde entoushiasme over ray tracing als de gedoodverfde opvolger van het 'hopeloos ouderwetse' rasterisatie. Er zijn dingen die ray tracing niet goed kan en er zijn dingen die met rasterisatie niet goed kunnen.

[ Voor 17% gewijzigd door Verwijderd op 30-09-2009 21:01 ]

edit: linkje vergeten

http://www.tomshardware.c...ization,review-31636.html

[ Voor 30% gewijzigd door Edmin op 30-09-2009 21:37 ]

Verwijderd

http://www.nvidia.com/object/gpu_technology_conference.html

Gaat voor 90% over CUDA en GPGPU computing

Computer says no

[trollmode]Moshe85 schreef op woensdag 30 september 2009 @ 22:18:

Whitepaper over "Fermi" http://www.nvidia.com/con...rchitectureWhitepaper.pdf

Gaat voor 90% over CUDA en GPGPU computing

Je kunt er ook Tetris op spelen met 30fps

[/trollmode]

Maar nu even serieus. Als de specs die nu zijn 'vrijgegeven' enigsinds kloppen, dan zal de kaart een leuke prestatie neer kunnen zetten. De vraag blijft echter inderdaad of nVidia de kaart goedkoop genoeg kan maken om echt te kunnen concureren. Daarnaast blijft het vooral de vraag of ze het lagere segment goed kunnen bedienen van betaalbare DX11 kaarten. Dat ziet er eigenlijk iets minder rooskleurig uit voor het moment. Er zal vast een DX11 versie a la GTX360 komen van de Fermi-chip, maar die zal waarschijnlijk moeite hebben om te concureren met de HD5850 (op prijs in ieder geval). Daarnaast is er nog geen echte midrange-chip met DX11 support bekent, die in de klasse van een HD5770 valt. Dat is echter wel de prijsklasse waar de grote verkopen normaal te vinden zijn.

Verwijderd

Hoe gaan ze die L2 cache coherent houden met zoveel threads?

[ Voor 32% gewijzigd door Verwijderd op 30-09-2009 22:34 ]

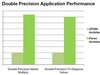

Dat komt waarschijnlijk deels omdat de GT200 veel minder Double Precision performance had dan men had verwacht. Deze chip kwam namelijk maar met 30 Double Precision shader-units (dacht tot vanochtend nog even dat dit 40 waren, maar werd even rechtgezetVerwijderd schreef op woensdag 30 september 2009 @ 22:30:

Wowzes mina wat een nadruk op double precision performance zeg.

Nu zullen ze waarschijnlijk erg duidelijk willen maken dat Double Precision op de Fermi wel hoge performance heeft, opdat bedrijven het vertrouwen in de GPU zullen behouden.

Verwijderd

Denk eerder dat die dan tegenover de HD5870 komt.dahakon schreef op woensdag 30 september 2009 @ 22:24:

GTX360 komen van de Fermi-chip, maar die zal waarschijnlijk moeite hebben om te concureren met de HD5850 (op prijs in ieder geval).

Wat betreft de rest wat er onder komt dat zijn DX10.1 en DX10 kaarten.

Verwijderd

Ja en doble precision performance is voor de wetenschappelijke hoek erg van belang.dahakon schreef op woensdag 30 september 2009 @ 22:34:

[...]

Dat komt waarschijnlijk deels omdat de GT200 veel minder Double Precision performance had dan men had verwacht. Deze chip kwam namelijk maar met 30 Double Precision shader-units (dacht tot vanochtend nog even dat dit 40 waren, maar werd even rechtgezet) waardoor Double Precision berekeningen niet echt geweldig liepen op de GT200, in tegenstelling tot Single Precision.

Nu zullen ze waarschijnlijk erg duidelijk willen maken dat Double Precision op de Fermi wel hoge performance heeft, opdat bedrijven het vertrouwen in de GPU zullen behouden.

Ik zie ook DP FMA. Ze hebben echt alles op GPGPU gegooid zeg.

Toch blijf ik het GT300 noemen. GPU's moeten een getal zijn en geen woord.

En dan nog vraag ik me af of het meer is dan een die-shrink. De GT218 was ook niet bepaald een klapper.Verwijderd schreef op woensdag 30 september 2009 @ 22:39:

[...]

Denk eerder dat die dan tegenover de HD5870 komt.

Wat betreft de rest wat er onder komt dat zijn DX10.1 en DX10 kaarten.

http://www.pcgameshardwar...01-card-reviewed/Reviews/

[ Voor 39% gewijzigd door Edmin op 30-09-2009 22:46 ]

leugens!

http://www.hardwarecanuck...rkham-asylum-aa-features/

Miss you CJ....:'( en nee... ik kan niet aan samples komen

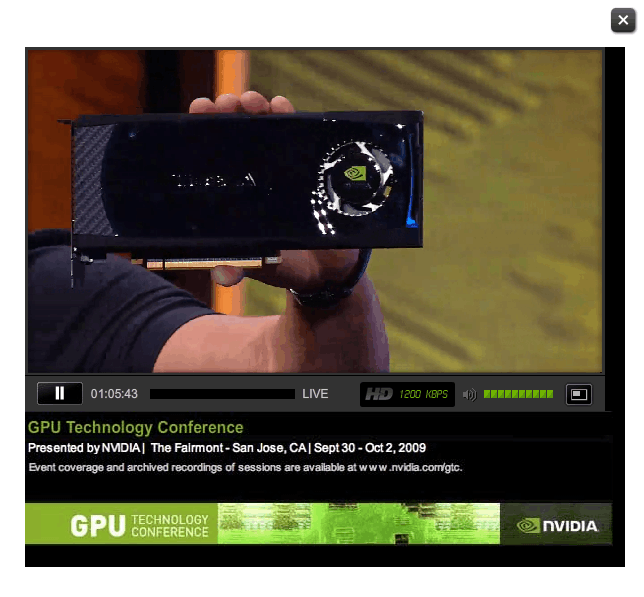

Nvidia's CEO, Jensen Huang just posted the first official picture of Fermi rendering a Bugatti car and the slide confirms that the new GPU has 3 billion transistors. The car looks realistic and it is probably rendered at real time, but at press time we've only seen a picture of it.

The focus is definitely on GPU computing power of this chip. The Bugatti was done with raytracing and 2.5 million rays and it looks seriously realistic to the point that it's astonishing.

Since we're attending the keynote, we will update with more details in real time, so stay tuned.

bron

Ryzen 9 9950X3D, ASRock X870E Tachi Lite, Arctic Liquid Freezer III 420, Kingston Fury Beast DDR5 6400, Powercolor Red Devil 9070XT, Crucial T700 2TB, FSP Hydro Ti Pro 1000W, BeQuiet 802

Verwijderd

Hmmm, ik had ergens Furby gehoort...Illidan schreef op woensdag 30 september 2009 @ 23:20:

first official picture of Fermi rendering

[ Voor 21% gewijzigd door Illidan op 30-09-2009 23:56 ]

Ryzen 9 9950X3D, ASRock X870E Tachi Lite, Arctic Liquid Freezer III 420, Kingston Fury Beast DDR5 6400, Powercolor Red Devil 9070XT, Crucial T700 2TB, FSP Hydro Ti Pro 1000W, BeQuiet 802

Verwijderd

Volgens RappieRappie was de HD5870 ongeveer even stil als de HD4890 Toxic.Illidan schreef op woensdag 30 september 2009 @ 23:54:

Waarom zetten ATI en nV altijd van die kleine k*t koelertjes op hun kaarten? Voor een paar euro meer; monteer er meteen een fatsoenlijke fan op, dat maakt het product zoveel beter. Als fabrikanten zoals MSI en Asus etc dat kunnen, kunnen zij dat beslist ook en ws veel goedkoper.

@lltech4 klein... daar zit zeker nog een X2 in.

Hij lijkt me niet erg groot?

Verwijderd

Maar verder ziet het er allemaal er wel leuk en stoer uit, maar ik vindt dat de FPS getallen in games toch meer zeggen dan het 3 keer zo snel renderen van een Bugatti

Join het DPC Whatpulse team Intel/ATI.AMD Powered PC!

Ik had een vraagje.

hoe krijg je hier in godsnaam 2 Sly bridges op?

Miss you CJ....:'( en nee... ik kan niet aan samples komen

Verwijderd

Deze specs gaan natuurlijk over de gtx380 en niet over de gtx360. Nvidia gaat namelijk eerst aan de performance chip werken en wil natuurlijk die specs als eerste laten zien. Volgens Cj wordt deze 30% sneller als de hd5870. Maar met de hd5870 op 1ghz core is het verschil slechts 10%.

De prijs van zon gtx380 wordt natuurlijk erg hoog. Nvidia releast nooit een topmodel zonder idioot hoge prijs. En aangezien deze chip nog opgeblazener is dan de gt200 zullen de productiekosten ook niet niks zijn. Zeker als je bedenkt dat ze 40nm nog niet onder de knie hebben en gaan rommelen met 384-bit geheugenbussen (Deze zal dus misschien wel niet op de gtx360 zitten).

Dus ik ben bang dat de gt300 erg duur wordt en je vooral gaat betalen voor cuda-mogelijkheden in plaats van game-performance. Ik gok dat de gtx360 bijna evensnel wordt als de hd5870.

Maar waar ATI voordeelhad met GDDR5 gaat ATI daar nu niet zoveel op vooruit.

fermi krijgt nu GDDR5 en daarmee moet toch wel een bijna verdubbeling in bandbreedte te halen zijn. En dan die cache nog.

Double float is aanzienlijk vooruitgegaan.

1,5 keer zoveel transistoren. potentie om dus ook in die mate sneller te zijn. Mocht er een duidelijker performance verschil zijn 30% of meer. Dan kan de prijs ook stuk duurder zijn. En dan is het niet een tegenhanger van de HD5870 of HD5870x2. Maar een alternatief wat daar tussen in valt. En daar zal dan ook de prijs punt mee bepaald worden.

Corretjes zijn C++. Dat is handig voor programmeurs. Maar het is ook belangrijk waarin ze uitblinken en waar in niet. Uiteraard is het een nV SM5.0 nV ISA C++ variant.

Kijk naar uit wanneer de verschillen uitgebreid geannaliseerd worden. Wat ik me nu afvraag. Is dit gevolg van OpenCL en DX11 compute shaders. Of is C++ support iets extra's. Wat ATI niet heeft.

Sowieso gaan nV en ATI GPU evolueren naar Generalpurpouse cores. Dus het eind van het traject voor ATI en nV is dus een GPU met vooral veel Cores Full C++ capable en heleboel van die dingetjes. En minder fixed logic.

Wordt dus steeds meer een Larrabee achtig iets maar dan niet x86 IA32/ EMT64. Maar iets excotisch.

Eer de voordelen van Larrabee tot uiting komen. Kan dat ook al grotendeels met SM5.0 en helemaal met toekomstige SM6.0 Compute shaders. Misschien is Larrabee net te laat of als het snel oppakt net op tijd.

Wordt spannend.

X399 Taichi; ThreadRipper 1950X; 32GB; VEGA 56; BenQ 32" 1440P | Gigbyte; Phenom X4 965; 8GB; Samsung 120hz 3D 27" | W2012SER2; i5 quadcore | Mac mini 2014 | ATV 4g | ATV 4K

tja dat zal backplate verwijderen worden..neliz schreef op donderdag 01 oktober 2009 @ 03:53:

(naast de holes in het PCB)

Ik had een vraagje.

hoe krijg je hier in godsnaam 2 Sly bridges op?

[afbeelding]

Zie ik he tdaar goed 1x 6 pin? leuke TDP iig dan. (er van uit gaande GTX380)

en maar 1 DVI uitgang?... zal wel low budget kaart zijn dan.

http://www.youtube.com/watch?v=79mvSWRocq4 miss leuk voor de liefhebber

http://www.youtube.com/wa...8NjUslrwM&feature=related

http://www.bit-tech.net/n...rst-fermi-card-pictured/1 foto's andere hoek

hier zit 8 pin aan andere zijde.. dus wel 6+8?

[ Voor 26% gewijzigd door Xenomorphh op 01-10-2009 08:43 ]

There are 10 kinds of people in the World...Those who understand binary, and those who dont!

Verwijderd

Idd onder full load tijdens een game word hij maar echt niet warm en je hoord hem nouwlijksVerwijderd schreef op donderdag 01 oktober 2009 @ 00:05:

[...]

Volgens RappieRappie was de HD5870 ongeveer even stil als de HD4890 Toxic.

@lltech4 klein... daar zit zeker nog een X2 in.

pas vanaf 40% fanspeed word hij luidruchtig terwel hij nooit boven de 30% uit komt tijdens gamen

Dit is een warmte teste van mijn zelf onder cod4 1920x1200 4xAA 16xAF

Ontopic

Nvidia gaat het toch nog redelijk goed doen denk ik als ik het nieuws van de laatste tijd allemaal

mag geloven

[ Voor 15% gewijzigd door Verwijderd op 01-10-2009 09:44 ]

- een miljoen keer een paar euro....Illidan schreef op woensdag 30 september 2009 @ 23:54:

Waarom zetten ATI en nV altijd van die kleine k*t koelertjes op hun kaarten? Voor een paar euro meer; monteer er meteen een fatsoenlijke fan op, dat maakt het product zoveel beter. Als fabrikanten zoals MSI en Asus etc dat kunnen, kunnen zij dat beslist ook en ws veel goedkoper.

- fabrikanten houden zo juist de mogelijkheid tot productdifferentiatie.

Verwijderd

Verwijderd

Had je de webcast gisteren gevolgd dan was je dat duidelijk gewordenVerwijderd schreef op donderdag 01 oktober 2009 @ 10:18:

Ik vraag me echt af of cGPU voordelen heeft buiten HPC. Ik kan geen toepassing bedenken waarbij consumenten hier iets aan hebben. Wat voor massieve parallele workload draaien wij nu eigenlijk? Ik zit nu te denken: wow gaaf, tot ik me bedenk: wat heb ik er nu eigenlijk aan ?

Niet bij iedereen deed de webcast hetVerwijderd schreef op donderdag 01 oktober 2009 @ 10:23:

[...]

Had je de webcast gisteren gevolgd dan was je dat duidelijk geworden

Kreeg zelf de hele tijd http error's tijdens laden van de webcast.

Computer says no

Bij mij ookMoshe85 schreef op donderdag 01 oktober 2009 @ 10:47:

[...]

Niet bij iedereen deed de webcast het

Kreeg zelf de hele tijd http error's tijdens laden van de webcast.

Uit de PDF van nV blijkt dat de double precision performance 4,2x GT200 is.dahakon schreef op woensdag 30 september 2009 @ 22:34:

Dat komt waarschijnlijk deels omdat de GT200 veel minder Double Precision performance had dan men had verwacht. Deze chip kwam namelijk maar met 30 Double Precision shader-units (dacht tot vanochtend nog even dat dit 40 waren, maar werd even rechtgezet) waardoor Double Precision berekeningen niet echt geweldig liepen op de GT200, in tegenstelling tot Single Precision.

Nu zullen ze waarschijnlijk erg duidelijk willen maken dat Double Precision op de Fermi wel hoge performance heeft, opdat bedrijven het vertrouwen in de GPU zullen behouden.

Dit gegeven combineren met het volgende:

Leidt mij ertoe te geloven dat Fermi dus 324Gflops double precision heeft?CJ schreef op woensdag 30 september 2009 @ 13:53:

GT200 heeft 30 double precision shader units. De GPU bestaat uit 10 clusters van 24. Elke cluster heeft 3 double precision units (die dus feitelijk uit hun neus staan te vreten tijdens het gamen). Deze GPU zit op ongeveer 77 Gflops double precision.

De double precision rekenkracht ligt dus bij AMD op 1/5de van de single precision rekenkracht. Dit is al sinds de RV670 generatie zo. Cypress XT zit dan op zo'n 544Gflop double precision. RV770 zat op 240 Gflop DP. *typo corrected*

Dat is nog steeds (fors) minder dan de CypressXT, of zie ik het nu mis?

It seems that males are allowed to exist after all, because they help females get rid of deleterious mutations...

Verwijderd

Als de juiste software er voor geschreven wordt, heeft het wel voordelen ten opzichte van de huidige generatieVerwijderd schreef op donderdag 01 oktober 2009 @ 10:18:

Ik vraag me echt af of cGPU voordelen heeft buiten HPC. Ik kan geen toepassing bedenken waarbij consumenten hier iets aan hebben. Wat voor massieve parallele workload draaien wij nu eigenlijk? Ik zit nu te denken: wow gaaf, tot ik me bedenk: wat heb ik er nu eigenlijk aan ?

- Encoding

- Decoding

- L1 Cache

- L2 Cache

- Minder te communiceren met de CPU? over de PCI-X poort. (dacht zoiets te hebben gelezen)

Maar zoals CJ ook al aan gaf is dit niet echt super interessant voor de Gamers onder ons. Zoals het er nu uit ziet gaat Nvidia haar GPU Q1 2010 lanceren. denk geplaats tussen 5870 en de 5870X2 en dan is er natuurlijk ook nog de 5890 achter de hand. Ik snap wel waarom ze deze weg inslaan, gezien dat Larrabee er ook zit aan te komen en ook voornamelijk op x86 loopt toch? En het blijft natuurlijk marketing misschien wel geen Eyefinity maar toch ....

Then timing is just as valid, because while Fermi currently exists on paper, it's not a product yet. Fermi is late. Clock speeds, configurations and price points have yet to be finalized. NVIDIA just recently got working chips back and it's going to be at least two months before I see the first samples. Widespread availability won't be until at least Q1 2010.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Nvida disables PhysX support Print E-mail

Written by Nick Farrell

Thursday, 01 October 2009 09:53

Image

If you use ATI cards

Nvidia, which once said it would enable processing of physics effects made using PhysX API on any GPU, is now doing the opposite.

According to Xbit, the company recently started to disable PhysX support on systems that use ATI Radeon graphics cards for rendering and Ageia PhysX or Nvidia GeForce processors for physics effects computing. While it was not easy to make both ATI Catalyst or Nvidia ForceWare drivers or Nvidia PhysX system software work on the same system, apparently some people had managed it and this annoyed the Green Goblin.

PhysX is an open software standard any company can freely develop hardware or software that supports it. An Nvidia service person was quoted as saying that while for a variety of reasons, some development expense, some quality assurance and some business reasons Nvidia will not support GPU accelerated PhysX with Nvidia GPUs while GPU rendering is happening on non-Nvidia GPUs.

All this is strange as it has pushed PhysX as an open standard that can be used even by its arch-rival ATI. In fact there is an element of cutting its nose off to spite its face. PhysX support seems now to be limited to the installed base of the GeForce and does not allow to use it on machines featuring even other graphics accelerators. Those who need PhysX should only upgrade to Nvidia graphics boards if keeping the old card for PhysX we guess.

bron

originele bron

[ Voor 4% gewijzigd door Illidan op 01-10-2009 12:10 ]

Ryzen 9 9950X3D, ASRock X870E Tachi Lite, Arctic Liquid Freezer III 420, Kingston Fury Beast DDR5 6400, Powercolor Red Devil 9070XT, Crucial T700 2TB, FSP Hydro Ti Pro 1000W, BeQuiet 802

Verwijderd

Ik vind het juist wel grappig dat jij hier nog eens meekomt terwijl het maanden geleden al is gemeld...Illidan schreef op donderdag 01 oktober 2009 @ 12:09:

Dan ga je dit ook niet leuk vinden:

Nvida disables PhysX support If you use ATI cards

Verwijderd

in de gaten gehouden.

Verwijderd

Dat weet je helemaal nog niet. Want er is nog niets. Daarbij, als je alles leest, weet je ook, dat 'binnen kort' nog een geruime tijd weg is.Verwijderd schreef op donderdag 01 oktober 2009 @ 12:23:

Hehehe toch is het allemaal nog wel een beetje anti nvidia reacries hier terwel nvidia toch nog met iets goeds gaat komen binnenkort. Sorry jongens maar het is gewoon zo want toen ik gebannend was heb ik dat nouwlettend

in de gaten gehouden.

[ Voor 9% gewijzigd door Verwijderd op 01-10-2009 12:26 ]

Verwijderd

Oke het is nog niet getest maar ik weer wel zeker dat hij sneller zal zijn dan de 5870

En dan nu niet komen van jah maar er komt nog een 5870x2 uit, want dat mog ook niet toen de gtx295 uit kwam

http://www.hardware.info/...Vidia_demonstreert_Fermi/

[ Voor 38% gewijzigd door Verwijderd op 01-10-2009 12:29 ]

Verwijderd

Nee dat weet je niet. Want er is niets bekend over zijn game performance.Verwijderd schreef op donderdag 01 oktober 2009 @ 12:27:

Dat weet ik wel gezien want er de laatste tijd over nvidia's gt300 is gepost

http://www.hardware.info/...Vidia_demonstreert_Fermi/

CJ in "[Algemeen] nVidia Nieuws & Discussie Top..."

Je weet het dus niet. klaar.Verwijderd schreef op donderdag 01 oktober 2009 @ 12:27:

Oke het is nog niet getest maar ik weer wel zeker dat hij sneller zal zijn dan de 5870

En dan nu niet komen van jah maar er komt nog een 5870x2 uit, want dat mog ook niet toen de gtx295 uit kwam

http://www.hardware.info/...Vidia_demonstreert_Fermi/

[ Voor 43% gewijzigd door Verwijderd op 01-10-2009 12:30 ]

Verwijderd

Waarom wisten veel het dan wel over de 5870 terwel daar ook nieg niets over bekend was, heel er tipisch en pro ati achtig

[ Voor 9% gewijzigd door Verwijderd op 01-10-2009 12:31 ]

Verwijderd

Omdat het daar wel over bekend was? Of heb jij de TS(en plural) van het nieuws topic niet gelezen met de Vantage scores?Verwijderd schreef op donderdag 01 oktober 2009 @ 12:30:

Oke ik denk dan dat hij sneller zal zijn wat ook wel zo is nvidia kennende

Waarom wisten veel het dan wel over de 5870 terwel daar ook nieg niets over bekend was ?

pardon? ik ga juist voor redelijkheid, er is nog niets bekend dus ga ik er geen uitspraken over doen.heel er tipisch en pro ati achtig

[ Voor 16% gewijzigd door Verwijderd op 01-10-2009 12:32 ]

Verwijderd

net zoals bij de hd5870 wat geen 160% performance winst was tegenover de 4870 ?

[ Voor 25% gewijzigd door Verwijderd op 01-10-2009 12:33 ]

Verwijderd

Wacht? Ga je me nu dingen opleggen?Verwijderd schreef op donderdag 01 oktober 2009 @ 12:32:

Oke dan wil ik nu van jou horen denk jij dat de gt300 sneller zal zijn dan de hd5870.als het gaat om speculaties ?

Verwijderd

[ Voor 30% gewijzigd door Verwijderd op 01-10-2009 12:35 ]

Overigens heeft Fermi een 8-pins + 6-pins connector. De foto's laten slechts een enkele 8 pins zien, maar er bevindt zich nog een 6-pins op de kaart.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Verwijderd

Daarbij: Ik ga meestal uit van CJ zijn info, die heeft het zo goed als altijd bij het rechte eind gehad(zolang ik het volg dan

[ Voor 71% gewijzigd door Verwijderd op 01-10-2009 12:37 ]

Verwijderd

In theorie is hij gewoon sneller, en als dat zo is klopt dat 9 van de 10 keer ook wel.

Ook al wil jij het liever niet horen blijkt wel

Edit

En als het zo ver is kom ik er nog wel ff weer op trug

[ Voor 14% gewijzigd door Verwijderd op 01-10-2009 12:39 ]

Verwijderd

Dat is BS, het ging om dat nvidia met iets goedkomt, wie weet hoe overdreven duur ie word of hoe laat ie daadwerkelijk te krijgen is, laatstaan dat hoveel % sneller dat ie gaat zijn. Er is nog -zeer- weinig bekend. Specs alleen is niet zalig makend(2900 512bits bus etc).Verwijderd schreef op donderdag 01 oktober 2009 @ 12:38:

Maar goed nu weet ik het wel gezien de specificaties wel echt zijn.

In theorie is hij gewoon sneller, en als dat zo is klopt dat 9 van de 10 keer ook wel.

Ook al wil jij het liever niet horen blijkt wel

Oh en -in theory- sneller? Waarom is de RV770 al dan niet sneller, die heeft toch meer FLOPS? misschien omdat theoretische snelheid niets zegt over gamesnelheid?

[ Voor 12% gewijzigd door Verwijderd op 01-10-2009 12:42 ]

Verwijderd

NVIDIA details next-generation Fermi GPU architecture

[ Voor 25% gewijzigd door Verwijderd op 01-10-2009 12:55 ]

Verwijderd

Is toch allemaal niet waar

[ Voor 6% gewijzigd door Verwijderd op 01-10-2009 12:51 ]

We wachten mooi af tot we reviews krijgen of leaks voor de tijd

Verwijderd

Het gaat echt een GPGPU monster worden. Die 16 concurrent threads is echt super handig. Loop er soms zelf tegen aan dat je de hele tijd waits moet doen omdat je volgende stuk niet op GPU kan. Is er al een indicatie naar de TDP?Verwijderd schreef op donderdag 01 oktober 2009 @ 12:46:

Hier nog wat nieuws over de nieuwe GT300 van NVIDIA

NVIDIA details next-generation Fermi GPU architecture

Verwijderd

Ik vind grappig dat je denkt dat ik iedere regel bij hou die maanden geleden gemeld is...ik vind nog grappiger dat jij dat wel doetVerwijderd schreef op donderdag 01 oktober 2009 @ 12:15:

[...]

Ik vind het juist wel grappig dat jij hier nog eens meekomt terwijl het maanden geleden al is gemeld...

Ryzen 9 9950X3D, ASRock X870E Tachi Lite, Arctic Liquid Freezer III 420, Kingston Fury Beast DDR5 6400, Powercolor Red Devil 9070XT, Crucial T700 2TB, FSP Hydro Ti Pro 1000W, BeQuiet 802

Verwijderd

De gtx280 staat er tegen over dus het is ook een beetje nv nieuws

http://www.hardware.info/userreview/wmdomWNwnmlj/view/

[ Voor 20% gewijzigd door Verwijderd op 01-10-2009 13:15 ]

Wat ik interessant vindt is dit stukje:Verwijderd schreef op donderdag 01 oktober 2009 @ 12:46:

Hier nog wat nieuws ( geruchten ) over de GT300 van NVIDIA

NVIDIA details next-generation Fermi GPU architecture

Dit is nieuw voor mij. Kan iemand hier iets meer over zeggen?The big difference is that Radeon HD 5870 is out today, etailing for £300. The higher-end Fermi cards will cost at least as much, we imagine, because fitting 3bn transistors - and yes, NVIDIA and AMD count them differently - must mean a die-size that's appreciably larger than HD 5870's 334mm². Power-draw may well be a concern, as well.

Ik vind de reactie van Nvidia voorspelbaar, maar het klopt ergens niet.neliz schreef op woensdag 30 september 2009 @ 23:13:

nvidia reageert op hun Batman:Arkham Asylum AA Snafu met?

leugens!

http://www.hardwarecanuck...rkham-asylum-aa-features/

Zeg zeggen dat ze hebben geholpen in-game AA ondersteuning te realiseren voor nvidia kaarten en dat als ati wat moeite had genomen er voor ati kaarten ook in-game AA ondersteuning zou zijn.

Maar als je dan dit leest:

Dan blijkt dat in-game AA gewoon mogelijk is op ati kaarten, maar dat het spel deze optie niet geeft wanneer een ati kaart is gedetecteerd...quote: AMDThis was confirmed by AMD testing through alterting the game to not detect ATI id’s: “By tricking the application, we were able to get in-game AA option where our performance was significantly enhanced.

Of mis ik iets?

Verwijderd

De developers zijn uit op geld, Nvidia blijft pushen naar naamsbekendheid. AMD loopt er een beetje achteraan maar zijn weer sterk met prijs + prestatie winnen daar nu grond. Maar je moet toch echt wel eerst bij de developers kijken .... Nvidia functioneerd een beetje als een grote bank, die bonussen uitdeelt. Het is sowieso van de zotte dat je een speciaal stukje hardware tegenwoordig moet kopen voor een bepaald stukje techniek\ondersteuning.daan! schreef op donderdag 01 oktober 2009 @ 13:31:

[...]

Ik vind de reactie van Nvidia voorspelbaar, maar het klopt ergens niet.

Zeg zeggen dat ze hebben geholpen in-game AA ondersteuning te realiseren voor nvidia kaarten en dat als ati wat moeite had genomen er voor ati kaarten ook in-game AA ondersteuning zou zijn.

Maar als je dan dit leest:

[...]

Dan blijkt dat in-game AA gewoon mogelijk is op ati kaarten, maar dat het spel deze optie niet geeft wanneer een ati kaart is gedetecteerd...

Of mis ik iets?

Weet wel dat het allemaal zakelijk is, maar vind het niet verstandig van de mensen die spellen maken je hoopt toch op een zo'n groot mogelijke database? En dan vinden mensen het allemaal zo raar dat er zo veel piraterij te ronde is? Nog even en ik stap over op een console

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Verwijderd

Gezien hun gpGPU aanpak, misschien doen ze het over de shaders?CJ schreef op donderdag 01 oktober 2009 @ 13:50:

Sappig gerucht, Tesselation gebeurt softwarematig op Fermi. Bron: Rys @ B3D. Zou verklaren waarom er geen tesselation blocks zichtbaar zijn in de huidige diagrammen. Of NV laat nog niet alles zien.

[ Voor 16% gewijzigd door neliz op 01-10-2009 14:14 ]

Miss you CJ....:'( en nee... ik kan niet aan samples komen

Asus C6E / Ryzen 9 5950X / Radeon RX 9070 XT Red Devil / G.Skill Flare X 32GB / Noctua NH-U12A / FSP Hydro Ti PRO 1000W

[quote]

GT300 is basically Larrabee done wrong for the wrong reasons. Amusingly though, it misses both of the attempted targets. R870 should pummel it in DX10/DX11 performance, but if you buy a $400-600 GPU for ripping DVDs to your Ipod, Nvidia has a card for you. Maybe. Yield problems notwithstanding.

GT300 will be quarters late, and without a miracle, miss back to school, the Windows 7 launch, and Christmas. It won't come close to R870 in graphics performance, and it will cost much more to make. This is not an architecture that will dig Nvidia out of its hole, but instead will dig it deeper. It made a Laughabee.[/quote]

Mocht de "software" tesselator een flinke performance impact hebben dan hebben ze een probleem denk ik, op dit moment is de HPC markt echt nog niet groot genoeg om dat te compenseren.

[ Voor 3% gewijzigd door mdcobra op 01-10-2009 15:06 . Reden: oude info! ]

Verwijderd

Die is van 14 Mei 2009?mdcobra schreef op donderdag 01 oktober 2009 @ 14:23:

The Inquirer gaat even GT300 bashen: http://www.theinquirer.ne...nvidia-gt300-architecture.

[...]

Ik denk dat het hier nog wat te vroeg voor is, maar mocht de "software" tesselator een flinke performance impact hebben dan hebben ze echt een probleem, op dit moment is de HPC markt echt nog niet groot genoeg om dat te compenseren.

Las ik ergens. Kan iemand dit bevestigen?Volgens de eerste geruchten ontbreekt de tesselation unit in deze GPU, deze units zijn ook niet zichtbaar op de die schema's die nvidia heeft getoond. Dit zou dus betekenen dat tesselation op deze gpu's softwarematig moet gebeuren en dat komt natuurlijk niet ten goede aan de prestaties.

Sure, software tesselation is for you!Omnyakom1 schreef op donderdag 01 oktober 2009 @ 16:14:

Las ik ergens. Kan iemand dit bevestigen?

Miss you CJ....:'( en nee... ik kan niet aan samples komen

Ik krijg de indruk dat bijna alles via de shader cores gerealiseerd wordt, in dat geval zal de 3d performance maar magertjes zijn.CJ schreef op donderdag 01 oktober 2009 @ 13:50:

Sappig gerucht, Tesselation gebeurt softwarematig op Fermi. Bron: Rys @ B3D. Zou verklaren waarom er geen tesselation blocks zichtbaar zijn in de huidige diagrammen. Of NV laat nog niet alles zien.

//edit

totdat ik dit diagram zag :

[ Voor 11% gewijzigd door oeLangOetan op 01-10-2009 16:35 ]

Aan de andere kant betekend het misschien betere performance in "oude" games die niet geoptimaliseerd zijn voor paralelle data executie (lees, op de GT200 manier)oeLangOetan schreef op donderdag 01 oktober 2009 @ 16:30:

Ik krijg de indruk dat bijna alles via de shader cores gerealiseerd wordt, in dat geval zal de 3d performance maar magertjes zijn.

Miss you CJ....:'( en nee... ik kan niet aan samples komen

Even in lekentaal, dan mag je het geen dx11 kaart noemen dus kan me niet voorstellenoeLangOetan schreef op donderdag 01 oktober 2009 @ 16:30:

[...]

Ik krijg de indruk dat bijna alles via de shader cores gerealiseerd wordt, in dat geval zal de 3d performance maar magertjes zijn.

//edit

totdat ik dit diagram zag :

[afbeelding]

[ Voor 40% gewijzigd door Omnyakom1 op 01-10-2009 16:40 ]

DX11 mag je implementeren zoals je wilt, kijk naar larabee daar zullen een minimum van fixed function units in zitten, het grootste deel van het renderen zal gebeuren door de cpu-achtige cores.Omnyakom1 schreef op donderdag 01 oktober 2009 @ 16:39:

[...]

Even in lekentaal, dan mag je het geen dx11 kaart noemen dus kan me niet voorstellen

Ja, leuk en aardig allemaal maar van de Larrabee hebben we dus nog niets gezien. Ik betwijfel ten zeerst of het überhaupt menig serieus gamer z'n aandacht zal weten te trekken.oeLangOetan schreef op donderdag 01 oktober 2009 @ 16:52:

[...]

DX11 mag je implementeren zoals je wilt, kijk naar larabee daar zullen een minimum van fixed function units in zitten, het grootste deel van het renderen zal gebeuren door de cpu-achtige cores.

In een tijdvak waarin nog CPU's nog steeds de grootste bottleneck vormen in gaming prestaties kan ik me niet voorstellen de processor nog meer te belasten met onnodige core architecturen en applicaties die andere dedicated hardware 10x beter en efficiënter kan doen.

Natuurlijk zal in de toekomst alles meer aan 1 soort chip toegewijd zal worden, maar waar Intel nu is met hun Larrabee is nog slechts het beginfase. Een current-gen grafische kaart daarmee verglijken gaat er bij mij niet in.

Het zal het procedé verkleining ook alleen maar vertragen omdat men bij de volgende 35/30nm chip al die geïntegreerde functies opnieuw onder de loep moet bekijken en testen op een kleiner product. Ik zeg eerst verkleinen en efficiëntie verhogen en dan pas allemaal andere 2e processen erbij plakken. En bij die fase zijn ze nog lang niet beland.

Zelfde bij nVidia, ze hebben nog geen fatsoenlijk werkend chip op 40nm getoond en praten nu al over CUDA en andere shit waar niemand een fuck om geeft. Laat die onzin lekker bij de Quadro afdeling achter.

[ Voor 9% gewijzigd door Omnyakom1 op 01-10-2009 17:45 ]

uhhm, van Larrabee is al aardig wat geshowed hoor. Vrij recent nog zelfs op het IDFOmnyakom1 schreef op donderdag 01 oktober 2009 @ 17:31:

[...]

Ja, leuk en aardig allemaal maar van de Larrabee hebben we dus nog niets gezien. Ik betwijfel ten zeerst of het überhaupt menig serieus gamer z'n aandacht zal weten te trekken.

In een tijdvak waarin nog CPU's nog steeds de grootste bottleneck vormen in gaming prestaties kan ik me niet voorstellen de processor nog meer te belasten met onnodige core architecturen en applicaties die andere dedicated hardware 10x beter en efficiënter kan doen.

Zoek maar ff op de Frontpage klik. Draaide laatst een raytraced scene uit ET:QW en al eerder lieten ze CS:S al draaiend zien op een Larrabee. Echter echte performance cijfertjes zijn er niet. Mijn aandacht heeft het in ieder geval wel

Daarnaast Larrabee is een GPU geen CPU

[ Voor 4% gewijzigd door Meekoh op 01-10-2009 17:51 ]

Computer says no

Dr Lup blijf nou a.u.b. een keer weg met al je geblaat over "fan boy's" etc. aangezien er maar weinig mensen hier op zitten wachten en ik er in ieder geval ontzettend moe van jouw word... neem trouwens ook eens de topic regels nog eens door aangezien je die duidelijk niet hebt gelezen.

Verwijderd

SECURITEH schreef op donderdag 01 oktober 2009 @ 18:06:

[...]

Dr Lup blijf nou a.u.b. een keer weg met al je geblaat over "fan boy's" etc. aangezien er maar weinig mensen hier op zitten wachten en ik er in ieder geval ontzettend moe van jouw word... neem trouwens ook eens de topic regels nog eens door aangezien je die duidelijk niet hebt gelezen.

Ontopic

GPU Computing Overview

http://www.youtube.com/wa...XRw&feature=youtube_gdata

[ Voor 3% gewijzigd door Verwijderd op 01-10-2009 18:26 ]

Check de aansluitingen van de PCIe power connectoren en het soldeer op het bord.. wat klopt er niet?

edit:

duidelijker shot dat het bord is afgeknipt om bij de koeler te passen:

Koeler dekt exhaust af:

GPU #7

[ Voor 46% gewijzigd door neliz op 01-10-2009 18:49 ]

Miss you CJ....:'( en nee... ik kan niet aan samples komen

Verwijderd

Nee, maar als je een kaart kunt laten zien die dat draait toon je in elk geval aan dat dat ding echt is en ook echt games kan renderen, en dus geen vaporware is. Inmiddels met de IDF e.d. is dat wat minder een issue, maar ik kan me voorstellen dat dat toen wel een reden geweest kan zijn om dat te tonen.

[ Voor 53% gewijzigd door Verwijderd op 01-10-2009 18:52 ]

![]() Dit topic is gesloten.

Dit topic is gesloten.

![]()

:fill(white):strip_exif()/i/1251364830.jpeg?f=thumbmini)

:strip_exif()/u/82954/unox.gif?f=community)

:strip_icc():strip_exif()/u/317261/crop566fe8e7746f5_cropped.jpeg?f=community)

/u/280031/crop604f2972849a5_cropped.png?f=community)

/u/400/defember100.png?f=community)

:strip_icc():strip_exif()/u/10014/assassin.jpg?f=community)

:strip_icc():strip_exif()/u/167062/1777paard.jpg?f=community)

:strip_icc():strip_exif()/u/142351/IT_crowd60.jpg?f=community)

:strip_icc():strip_exif()/u/939/crop5729ac029c082_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/184349/IllidanTw.jpg?f=community)

:strip_icc():strip_exif()/u/80624/crop56269c878c330.jpeg?f=community)

:strip_icc():strip_exif()/u/300055/google.jpg?f=community)

:strip_exif()/u/2104/wtg2.gif?f=community)

/u/127119/crop560e75548d472.png?f=community)

:strip_exif()/u/50018/evil2.gif?f=community)

:strip_icc():strip_exif()/u/253405/NVD.jpg?f=community)