nV drivers uninstallen en dan Driver Cleaner Pro eroverheen (nVidia VGA drivers verwijderen). Werkt primajoswillems86 schreef op woensdag 04 januari 2006 @ 09:11:

Ik weet dat het beter is, maar dat het niet perse hoeft.

Iemand anders nog een optie?

Ik neem alleen aan dat je ook een nieuw mobo etc. erin gooit? Als je vorige mobo nForce3 was is het mogelijk de install mee te nemen (moet je ook alle oude nForce drivers weggooien). In de andere gevallen is een re-install misschien een betere optie, hoewel je met Driver Cleaner een heel eind kunt komen.

Je moet de drivers uiteraard weghalen voordat je andere spullen installeert

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Total offtopic, maar als je niet geinstalled met een ander moederbord en een andere videokaart is dat alleen maar een goed idee om snel je pc weer in de lucht te hebben. Stabiliteit, snelheid en voorspelbaarheid leiden ontzettend onder een transplantatie. Zie het maar als afstotingsverschijnselen bij een transplantatie, je accepteert het omdat het een grote verbetering is, maar het is niet ideaal.joswillems86 schreef op woensdag 04 januari 2006 @ 09:11:

Ik weet dat het beter is, maar dat het niet perse hoeft.

Iemand anders nog een optie?

Rekeningrijden is onvermijdelijk, uitstel is struisvogelpolitiek.

Een hele nieuwe installatie is natuurlijk beter, maar daar heb ik op het moment gewoon ff de tijd niet voor. Als het werkt zoals ik het wil, kan ik weer even vooruit, zodat ik over een paar dagen een nieuwe installatie kan uitvoeren.

Maar goed, ik zou blij zijn als het kon, want na laaaaang wachten zou de kaart vandaag dan eindelijk komen, maar de postbode kwam een barebone brengen (een die in niet besteld heb, gewoon op het verkeerde adres bezorgd dus

Gloednieuwe systeem staat al een paar maanden langs me te wachten, alleen maar om de videokaart (heb nu agp, nieuwe moederbord heeft dus pci-e)

Mag ik nog langer wachten...

[ Voor 12% gewijzigd door j86 op 04-01-2006 10:16 ]

Ik raad je toch aan alles opnieuw er op te zetten. Anders heb je nog de prestatie van een oud systeem. Het scheeld heel veel als je een reinstall doet. Ook al je windows een half jaar hebt lopen merk je het als je een clean install hebt.joswillems86 schreef op woensdag 04 januari 2006 @ 10:15:

Oke, dat met Driver Cleaner dacht ik ook, dus dat moet vast wel werken.

Een hele nieuwe installatie is natuurlijk beter, maar daar heb ik op het moment gewoon ff de tijd niet voor. Als het werkt zoals ik het wil, kan ik weer even vooruit, zodat ik over een paar dagen een nieuwe installatie kan uitvoeren.

Maar goed, ik zou blij zijn als het kon, want na laaaaang wachten zou de kaart vandaag dan eindelijk komen, maar de postbode kwam een barebone brengen (een die in niet besteld heb, gewoon op het verkeerde adres bezorgd dus)!

Gloednieuwe systeem staat al een paar maanden langs me te wachten, alleen maar om de videokaart (heb nu agp, nieuwe moederbord heeft dus pci-e)

Mag ik nog langer wachten...

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

NetjesVerwijderd schreef op woensdag 04 januari 2006 @ 11:13:

yes yes 10k

[afbeelding]

alles gewoon stock cooling.....

[ Voor 21% gewijzigd door Astennu op 04-01-2006 11:30 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

ik ga nog maar eens wat proberen

3dMark05 is iig lang niet zo CPU-limited dan ik dacht..

There are 11 kind of people in the world, ones that can read binary, ones that can't and ones that complain about my signature

PC Specs | Mo Murda Squad Clan

Lol lang nietVerwijderd schreef op woensdag 04 januari 2006 @ 12:08:

ik heb nu gewoon alle std voltages gebruikt, ik weet niet wat het echte max is van dat geheugen... mss is 2.0v al teveel.

ik ga nog maar eens wat proberen

[ Voor 5% gewijzigd door Astennu op 04-01-2006 12:18 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Probeer als je geheugen niet verder wilt eens iets minder volt te geven dan stock, werkt goed (vooral i.s.m. met verhoogd voltage voor core). Max clocks 3D stabiel die ik tot nu toe met stock hsf heb gehaald is 790 core (1.5v) en 900 mem (2.165v)

[ Voor 119% gewijzigd door Viss op 04-01-2006 13:15 ]

Ik dacht al zo iets. Maar igg 2.137 volt kan prima. K heb het weken lang getest en dat ging prima. Ik zou het wel in kleinere stapjes opvoeren. Maar ik denk dat je veel meer kan halen dan die 850 ik denk wel 900.Viss schreef op woensdag 04 januari 2006 @ 12:51:

Stock mem X1800XT is ook 2.01v, OC-tool leest voltages verkeerd uit, (pic = stock volts, ATItool geeft goede voltages weer). Probeer als je geheugen niet verder wil eens iets minder dan stock volt erop...

[afbeelding]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Niet op voorraad.

[ Voor 72% gewijzigd door Format-C op 04-01-2006 15:13 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Maja over 2 maanden hebben ze toch een X1900XT of een G71

Ondanks dat je vaak hoort zeggen dat de X1800XT betere IQ heeft dan de 7800GTX...

[ Voor 22% gewijzigd door Aight! op 04-01-2006 15:26 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Maar firefox zegt het zelf ook. De HQ settings van ATi zijn beter dan die van nvidia. En als je Nvidia op HQ zet heb je geen shimmering maar wel 20% peformance drop. Zet je de ATi lager verandert er na genoeg niets aan immage quality en ook niet aan de prestatie. Ik denk als je de Ati ook zo zou instellen dat de IQ hetzelfde is van de GTX dat je dan ook 10% a 20% boost zou zien.Aight! schreef op woensdag 04 januari 2006 @ 15:20:

Raar dat toch nu al 2 man toch voor hun 7800GTX en 7800GTX 512 mb kiezen dan de X1800XT.

Maja over 2 maanden hebben ze toch een X1900XT of een G71

Ondanks dat je vaak hoort zeggen dat de X1800XT betere IQ heeft dan de 7800GTX...

Hij wil zelf liever iets minder IQ en meer speed. Ik wil juist het omgedraaide. Dus het is net wat je wilt. Wil je speed Buy NV wil je IQ Buy ATi. Bij de G71 en de R580 moeten we nog kijken wat het dan wordt. Nvidia zal die 700 Mhz core ( die 700 mhz hoor je op het net ik wil het eerst nog zien ) wel nodig hebben om die 48 shaders van ATi bij te houden op 650 mhz.

Nvidia had toch iets van 2 shaders units per rob ? en er zitten 16 robs in ? dus dat zijn er al 32 en die overige 8 pipe hebben er 1 ? of hoe zat dat ?ik heb me niet echt in die NV40 en G70 verdiept.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Moet kunnen lijkt me. Die snelheid is al gehaalt op 110nm, en NV gaat nu pas over op 90nm, dus de snelheid zal nog wel omhoog gaan!Astennu schreef op woensdag 04 januari 2006 @ 16:11:

die 700 mhz hoor je op het net ik wil het eerst nog zien

De G71 heeft wel 32 pipes tov 16 van X1900 (toch?).wel nodig hebben om die 48 shaders van ATi bij te houden op 650 mhz.

Het is nog maar de vraag waar de nadruk komt te liggen bij games: pixels of shaders.

The Inq schat dat (gezien de 160 miljoen die NV geeft aan TWIMTBP) dat het meer de NV kant op zal gaan

[ Voor 19% gewijzigd door XanderDrake op 04-01-2006 16:18 ]

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

vreemde manier van redeneren..XanderDrake schreef op woensdag 04 januari 2006 @ 16:16:

Het is nog maar de vraag waar de nadruk komt te liggen bij games: pixels of shaders.

The Inq schat dat (gezien de 160 miljoen die NV geeft aan TWIMTBP) dat het meer de NV kant op zal gaan.

je kan een textures toch niet zomaar vervangen voor een shader en vice versa >_>

Verwijderd

Op Nvnews forum zie ik het omgekeerde, 2 man (Riptide en Fatalty1) die hun 7800GTX/512 verkocht hebben en een X1800XT hebben gehouden. Beide kaarten hebben hun sterke punten, het is maar net wat jij het belangrijkst vindt en op dat moment de voorkeur aan geeft.Raar dat toch nu al 2 man toch voor hun 7800GTX en 7800GTX 512 mb kiezen dan de X1800XT

[ Voor 4% gewijzigd door Verwijderd op 04-01-2006 16:40 ]

Het gaat vooral om de berekening per pixel, hiero, afkomstig van The Inq:Bever! schreef op woensdag 04 januari 2006 @ 16:23:

vreemde manier van redeneren..

je kan een textures toch niet zomaar vervangen voor een shader en vice versa >_>

Grappig genoeg benadrukt dit wat Astennu zei, Snelheid => NV, IQ => ATi.ATI believes that you need many more pixel operations per clock than the pixel itself. Nvidia disagrees. It believes in a totally different ratio. With the birth of the R580, ATI believes that you should have three to one ratio as R580 has 48 Shaders and 16 pixel pipelines. You don’t need much mathematics to figure out that ATI preaches a three to one ratio.

As the G71 will be able to process 32 pixels per clock, it will physically have 32 pipelines but will have just 16 ROPs. This is no surprise to us as Nvidia's G70, Geforce 7800 GTX actually has 24 pipelines and 16 ROPs.

This means that Nvidia and ATI will take completely new approaches, where Nvidia will try to convince everyone that you need more raw pixels than pixel operations.

Je kan namelijk met de G71 sneller gaan op één bepaalde hoge resolutie maar langzamer als er veel berekeningen zijn per pixel nodig zijn. De X1900 gaat weer langzamer op een hoge resolutie, maar sneller als er veel berekening per pixel vereist zijn.

Ik moet zeggen, de volgende "graphics oorlog" dit wordt aanzienlijk boeiender dan degene die nu aan de gang is, het zijn namelijk 2 totaal verschillende methoden!

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

Verwijderd

Waar Ati absoluut niet op moet gaan vertrouwen is dat gamedevs wel eventjes gaan programmeren op een manier die in het voordeel is van de R580 (véél shaders), want dan weet ik al hoe het gaat. Get In The Game is (nog steeds) een lachertje t.o.v. het miljoenenproject genaamd TWIMTBP.

[ Voor 20% gewijzigd door Verwijderd op 04-01-2006 17:00 ]

Verwijderd

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

Berekeningen van The Inq kan je met een flinke dosis zout nemen. Elke week hebben ze weer iets anders, en met de berekeningen van de laatste tijd (verhoudingen ALU:TEX) klopt ook niet veel.XanderDrake schreef op woensdag 04 januari 2006 @ 16:37:

[...]

Het gaat vooral om de berekening per pixel, hiero, afkomstig van The Inq:

[...]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Zie FEAR, BF2, en CoD2.

Een 7800GTX 256MB komt in de oudere games misschien in de buurt van de XT, maar in de nieuwste games niet.

Het is zowieso al raar dat een kaart die 7700 3Dmarks scoort (7800GTX) in sommige games de Radeon X1800XT (die 9300 scoort) bij kan houden.

[ Voor 27% gewijzigd door Format-C op 04-01-2006 17:50 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Jah maar die krijgen toch de kaarten, die kopen die heus niet zelf.Verwijderd schreef op woensdag 04 januari 2006 @ 16:35:

[...]

Op Nvnews forum zie ik het omgekeerde, 2 man (Riptide en Fatalty1) die hun 7800GTX/512 verkocht hebben en een X1800XT hebben gehouden. Beide kaarten hebben hun sterke punten, het is maar net wat jij het belangrijkst vindt en op dat moment de voorkeur aan geeft.

Fatalty1 tenmiste, en hij heeft toch een deal met Abit....

Abit levert vooral ATI GPU's, zie ook de X800XL 512 MB met zijn kop erop,

Verwijderd

[ Voor 44% gewijzigd door Verwijderd op 04-01-2006 17:51 ]

idd, dan zullen het waarschijnlijk allebei cadeautjes geweest zijn en hebben ze dus een nog eerlijkere/kostenonafhankelijke keuze kunnen makenVerwijderd schreef op woensdag 04 januari 2006 @ 17:49:

Wat maakt 't uit in het geval het cadeautjes waren?

It seems that males are allowed to exist after all, because they help females get rid of deleterious mutations...

Ik denk ook dat Fatalty1 ook moet laten zien dat hij zjin eigen Fatalty1 reeks bespeelt.Verwijderd schreef op woensdag 04 januari 2006 @ 17:49:

Wat maakt 't uit in het geval het cadeautjes waren? (Riptide koopt zijn kaarten iig zelf btw, van Fatalty1 weet ik niet)

Ik hoor hem nu al zeggen:

'Ik ben alleen zo goed geworden op deze hardware...'

Maja ik vind het een beetje hetzelfde verhaal met de X800XT PE en de 6800 Ultra, ze zijn allebei goed, een slechte keuze kan je niet maken.

Jep, maar dit soort dingen gaan veranderen bij de volgende generatieAight! schreef op woensdag 04 januari 2006 @ 18:36:

Maja ik vind het een beetje hetzelfde verhaal met de X800XT PE en de 6800 Ultra, ze zijn allebei goed, een slechte keuze kan je niet maken.

Ook bij de 7800GT vs. X1800XL. De X1800XL molt de 7800GT gewoonweg in 3dmark2005. Als ik scores zie van 9200 voor een X1800XL OCed, dat is gewoon weg een utopie om te halen op een 7800GT.RappieRappie schreef op woensdag 04 januari 2006 @ 17:33:

Het is zowieso al raar dat een kaart die 7700 3Dmarks scoort (7800GTX) in sommige games de Radeon X1800XT (die 9300 scoort) bij kan houden.

Maaaaar in games is het toch redelijk anders! De GT wint/speelt gelijk bij toch een redelijke hoeveelheid games, ook nieuwe!

Hephaestus: Xeon 2680 v2 - 64GB ECC Quad - WD Blue 3D 1TB

Virtualis: Ryzen 3700X - 16GB DDR4 - Gigabyte 1080 Ti OC - Sandisk 2TB - Valve Index

Agon:Valve Steam Deck 64GB

Non scholae sed vitae discimus Seneca

[ Voor 41% gewijzigd door Format-C op 04-01-2006 20:20 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

http://www.eqscomputers.c...rboard.php?model=A79K9-CF

Dat werd tijd

Model A79K9-CF (PC Partner Model : (Coming Soon))

Northbridge Chipset ATI Radeon Xpress 200 (ATI RD580)

Southbridge Chipset ATI IXP450

Socket Type Socket 939

Form Factor ATX

CPU Platform AMD Athlon 64 / Athlon 64 FX* / Athlon 64 X2 Dual Core*

Front Side Bus (FSB) 2000 MTs (1000 MHz)

Memory Support 4 x Dual Channel DDR400

AGP Slot -

PCI Slot 2 x PCI

PCI Express 16X 2 x PCI Express 16X (CrossFire)

PCI Express 1X 2 x PCI Express 1X

Onboard VGA -

-

-

TV-Out -

LAN Adapter Dual Lan (LAN + GigaBit LAN)

IDE Connector 2 x ATA-133

Serial ATA Connector 2 x SATA-150 RAID / 2 x SATA-300 RAID

RAID (Hardware) RAID 0 / 1

Floppy Connector 1 x FDD Port

FireWire IEEE1394 VIA VT6307

Port 1 - Back Panel

Port 2~3 - Cable Bracket

USB 2.0 8 x USB 2.0

Port 1~4 - Back Panel

Port 5~8 - Cable Bracket

Sound Chipset 7.1 HD Audio

Realtek ALC880

High Definition 8 Channel HD

SPDIF Cable Bracket

Com Port Back Panel x 1 Port

Cable Bracket x 1 Port

LPT Port YES

Hardware Monitoring YES

PCB Size 305 mm x 244 mm

Die Asus A8R-MVP is klote voor OC dus ik wil weer een Abit gaan proberen dat zijn planken waar ik nog nooit veel problemen mee heb gehad. Met Asus en DFI en Epox wel. Jammer dat het niet zo goed gaat met Abit.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik wacht wel mooi op de M2 mobo's(crossfire), vind het nu nutteloos om up te graden.

Dan is Crossfire ook een beetje meer door gebroken hoop ik.

[ Voor 29% gewijzigd door Aight! op 04-01-2006 21:53 ]

Verwijderd

Aan de andere kant, zijn die nieuwe kaarten uberhaubt al niet meer dan snel genoeg voor ''oudere'' games? zelfs met mijn x800xt-pe kan ik alle games nog behoorlijk spelen (een nieuwe high-end kaart kopen doe ik echt nooit meer, kost echt asociaal veelXanderDrake schreef op woensdag 04 januari 2006 @ 17:08:

FEAR is inderdaad "het" spel voor de R580! Zat ik ook te denken. By far het zwaarste spel beschikbaar. Opzich wel een klein voordeel voor ATi; de engine van die game is über, en zal zeker op nieuw gebruikt worden. Maar inderdaad de "oudere" games zullen, denk ik, niet zoveel sneller gaan dan bij de X1800 serie.

Trouwens wel een hele tijd geleden dat ik hier wat heb gepost.

[ Voor 7% gewijzigd door Verwijderd op 04-01-2006 21:53 ]

op 1024 768 trekt mijn X800XL ook alles nog met evt AA en AF maar hoger wordt al moeilijker. NFS MW draait net op 1280 1024 met 4x AAA (plus TAA) 8x AF

BF2 lukt dan ook nog net, maar veel hoger moet ik niet gaan.

Ik vind M2 pas nutteloos ik heb een Dual core 2x1mb cache en 2x1gb ram DDR en dat mag dan allemaal wegAight! schreef op woensdag 04 januari 2006 @ 21:52:

dat komt door Fatality1

Ik wacht wel mooi op de M2 mobo's(crossfire), vind het nu nutteloos om up te graden.

Dan is Crossfire ook een beetje meer door gebroken hoop ik.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Jah maar die heb ik nog nietAstennu schreef op woensdag 04 januari 2006 @ 22:43:

[...]

Ik vind M2 pas nutteloos ik heb een Dual core 2x1mb cache en 2x1gb ram DDR en dat mag dan allemaal weg

Kan ik beter over een maand nieuwe shit kopen dan nu.

Daarnaast heb ik nog meer kosten dan alleen hardware zoals een paar maanden geleden.

Op jezelf wonen, en bijna elke avond in de kroeg vind je beurs niet erg prettig.

Dan nog een fucking auto...en nu ook die ziekenfonds erbij.

kan niet elke maand nieuwe dingen kopen helaas.

[ Voor 20% gewijzigd door Aight! op 04-01-2006 23:24 ]

Verwijderd

Blijkbaar hoef je je geen zorgen te maken:Astennu schreef op dinsdag 03 januari 2006 @ 08:36:

Dit zou erg jammer zijn als dat zo is. Want als dit waar is is het geen RD580 voor mij. Ik ga niet me Opteron 170 en me geheugen vervangen om naar M2 te gaan. Ik kan me haast niet voorstellen dat er geen RD580 zou komen voor S939. Ik denk niet dat veel mensen een M2 kopen als ze een goed S939 systeem kunnen krijgen voor een veel lagere prijs. En toch even snel is. Dus ik denk dat er wel wat fabricanten zullen zijn die RD580 naar S939 brengen. Maar het kan best dat de meeste em voor de M2 zullen maken. Maar ik hoop dat dit niet het geval is.

http://www.theinquirer.net/?article=28716

Edit: sorry, niet gereload; was uit het bovenstaande ook al op te maken.

[ Voor 5% gewijzigd door Verwijderd op 04-01-2006 23:56 ]

Inq maakt weer fouten ze hebben RD480 in hun artiekel staan en het is RD580.Verwijderd schreef op woensdag 04 januari 2006 @ 23:53:

[...]

Blijkbaar hoef je je geen zorgen te maken:

http://www.theinquirer.net/?article=28716

Edit: sorry, niet gereload; was uit het bovenstaande ook al op te maken.

En over die 10k2 score op 500 mhz is wel nice. Maar hij loopt geen 500 maar 675 ( voor de XTX dan ) Dus daar komt nog wel 2 a 3k bij

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ummm, dit is wel een heel erg vrije interpretatie van wat ik heb gezegdAstennu schreef op woensdag 04 januari 2006 @ 16:11:

Maar firefox zegt het zelf ook. De HQ settings van ATi zijn beter dan die van nvidia. En als je Nvidia op HQ zet heb je geen shimmering maar wel 20% peformance drop. Zet je de ATi lager verandert er na genoeg niets aan immage quality en ook niet aan de prestatie. Ik denk als je de Ati ook zo zou instellen dat de IQ hetzelfde is van de GTX dat je dan ook 10% a 20% boost zou zien.

Allereerst is er geen merkbaar IQ verschil tussen nV Quality en ATi HQ mipmaps. Het is dus niet zo dat de "gewone" HQ settings van ATi beter zijn dan die van nV. Dit uiteraard met ATi's HQ-AF buiten beschouwing gelaten, hier heb ik niet mee gebenchmarkt, maar dit brengt wel een mooie IQ verbetering met zich mee. Daarbij is er normaal gesproken optisch ook weinig verschil tussen nV Q en nV HQ.

Het enige verschil is dat er in een beperkte set games, onder bepaalde omstandigheden met nV Q shimmering kan optreden. In geen van de door mij geteste games heb ik dit echter ervaren. Het schijnt wel op sommige stukken in HL2 en BF2 op te treden, maar die games speel ik niet en heb ik dus ook niet getest. Ook heb ik geen idee of dit ondertussen al gecorigeerd is in de drivers. Iemand anders zou daar dus uitsluitsel over moeten geven (Edward2 misschien?).

Believe me, op 1920x1200 ga je ieder stukje performance belangrijk vindenHij wil zelf liever iets minder IQ en meer speed. Ik wil juist het omgedraaide.

Ik zou bij een reso van 1280x1024 wel voor de X1800XT gaan, gezien ook de zwakkere punten van ATi (w.o. HDR) daarbij snel genoeg zijn om speelbaar te blijven, en de kleinere AA drop daar erg goed uitkomt

Dat hangt er helemaal van af welke games en op welke grafische instellingen... op 4xAA wint de X1800XT over het algemeen sowieso wel, maar op de andere instellingen is het vaak stuivertje wisselen, ook bij nieuwere games.RappieRappie schreef op woensdag 04 januari 2006 @ 17:33:

Een 7800GTX 256MB komt in de oudere games misschien in de buurt van de XT, maar in de nieuwste games niet.

Ik heb het al vaker gezegd, maar de score op 1024x768 noAA/noAF zegt eigenlijk erg weinig over de werkelijke capaciteiten van een videokaart. Kijk bijvoorbeeld eens hoe hoog een X1600XT scoort (~5300 punten: op het niveau van de X800XL en 6800GT), iets wat niet of nauwelijks ten uitdrukking komt in game-benchmarks.Het is zowieso al raar dat een kaart die 7700 3Dmarks scoort (7800GTX) in sommige games de Radeon X1800XT (die 9300 scoort) bij kan houden.

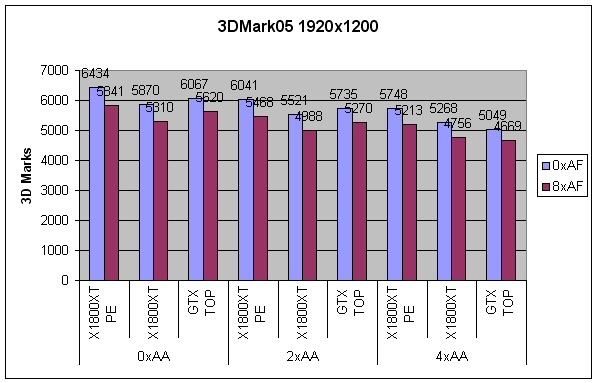

3DMark05 is wel goed als vergelijkingsreferentie, maar dan moet je naast de laagste ook wel op bruikbare resoluties testen. Dit zijn mijn resultaten op 1920x1200:

[ Voor 11% gewijzigd door Cheetah op 05-01-2006 11:44 ]

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Verwijderd

In Fear blijkt dat de X1600XT net zo snel is als de 6800GS met AA, terwijl de 6800GS de kaart is met 256bit en meer ROPS. Ik weet zeker dat over een jaar de score van 3dmark05 beter overeen komt met de spellen.Ik heb het al vaker gezegd, maar de score op 1024x768 noAA/noAF zegt eigenlijk erg weinig over de werkelijke capaciteiten van een videokaart. Kijk bijvoorbeeld eens hoe hoog een X1600XT scoort (~5300 punten: op het niveau van de X800XL en 6800GT), iets wat niet of nauwelijks ten uitdrukking komt in game-benchmarks.

En dynamic branching zal deze trend alleen maar versnellen.

3dmark05 is nu voor de meeste spellen niet zo representatief, maar het verklapt wel de potentie in de X1600/X1900 line-up. Je mag ook verwachten dat 3dmark06 nog meer shader gericht is waardoor het voordeel van X1600XT alleen nog maar groter word t.o.v. 6800GS. Als 3dmark06 dynamic branching gebruikt durf ik niet uit te sluiten dat de X1600 over de 7800 line-up heen zal gaan. ( In 3Dmark-05 is de 9600pro ook over de fx5950 gewalst)

[ Voor 3% gewijzigd door Verwijderd op 05-01-2006 15:40 ]

Ligt er echt aan met wat voor CPU, met een A64 4000+ en standaard X1900XTX speeds650/775 haal je geen 11K.CJ schreef op woensdag 04 januari 2006 @ 22:59:

VR-Zone komt met het gerucht dat een R580 op 500 Mhz zo'n 10k2 scoort in 3DM05.

3dmark '05 is met deze snelle kaarten en SLI/X-Fire erg CPU gevoelig.

Vraagje over F.E.A.R., ik benchmark nu telkens met de standaard ingbakken "test" , voor mijn gevoel is deze nogal nVidia vriendelijk. Iemand een betere methode van F.E.A.R. benchamarken? (geen FRAPS).

[ Voor 22% gewijzigd door GfMike op 05-01-2006 13:52 ]

Verwijderd

Hoe bedoel je Nvidia vriendelijk? Een poosje geleden heb ik hier FEAR resultaten laten zien op een X1800XT, en ben nog geen 7800GTX/512 tegengekomen die dit geëvenaard heeft.GfMike schreef op donderdag 05 januari 2006 @ 13:51:

Vraagje over F.E.A.R., ik benchmark nu telkens met de standaard ingbakken "test" , voor mijn gevoel is deze nogal nVidia vriendelijk. Iemand een betere methode van F.E.A.R. benchamarken? (geen FRAPS).

(1600x1200/4xAA/8xHQAF = min26 - avg42 - max97)

FEAR is ook meteen zo'n beetje de enige game waarin de X1600XT de 6800GS onder bepaalde omstandigheden (serieus) voorbij kan gaanVerwijderd schreef op donderdag 05 januari 2006 @ 13:00:

In Fear blijkt dat de X1600XT net zo snel is als de 6800GS met AA, terwijl de 6800GS de kaart is met 256bit en meer ROPS. Ik weet zeker dat over een jaar de score van 3dmark05 beter overeen komt met de spellen.

Verder ben ik er ook niet van overtuigd dat het algemene ATi overwicht in FEAR ligt aan shader performance, gezien de 7800GTX 512 met zijn 24 pixel pipelines @550mhz aanmerkelijk meer pixel shading power heeft dan de X1800XT, maar het op 4xAA toch verliest. Daarnaast is HDR (wat eveneens zeer pixel shader intensief is) nog steeds het domein van nVidia...

Er zit duidelijk een groot verschil in nV's en ATi's AA-implementatie, en FEAR heeft - evenals veel andere games - aanmerkelijk meer voordeel van ATi's implementatie. Ik zou de performanceverschillen eerder daar zoeken dan in pure shader power. Dit is trouwens ook duidelijk in de 0xAA situaties, waarin de GTX512 weer een duidelijk overwicht heeft.

3DMark05 scores op 1024x768 noAA/noAF zeggen gewoon vrij weinig over de potentie van een kaart, en over de ingame prestaties op hogere resoluties met AA/AF.3dmark05 is nu voor de meeste spellen niet zo representatief, maar het verklapt wel de potentie in de X1600/X1900 line-up. Je mag ook verwachten dat 3dmark06 nog meer shader gericht is waardoor het voordeel van X1600XT alleen nog maar groter word t.o.v. 6800GS. Als 3dmark06 dynamic brenching gebruikt durf ik niet uit te sluiten dat de X1600 over de 7800 line-up heen zal gaan. ( In 3Dmark-05 is de 9600pro ook over de fx5950 gewalst)

Bij gebruik van Dyanamic Branching zou de X1K serie een flinke boost krijgen t.o.v. de Geforce6/7 serie. Betreffende de shaders, zie mijn ideeen daarover hierboven.

Je gevoel klopt niet... mijn ingame benchmarks met FRAPS vertellen ongeveer hetzelfde verhaal als fear's eigen performancetest (sterker nog: met fraps ingame ziet het er voor nV zelfs juist iets beter uit dan met de performancetest). En de X1800XT is flink in het voordeel, dus ik snap niet helemaal waarom je de test als "nVidia vriendelijk" zou willen bestempelenGfMike schreef op donderdag 05 januari 2006 @ 13:51:

Vraagje over F.E.A.R., ik benchmark nu telkens met de standaard ingbakken "test" , voor mijn gevoel is deze nogal nVidia vriendelijk. Iemand een betere methode van F.E.A.R. benchamarken? (geen FRAPS).

[ Voor 3% gewijzigd door Cheetah op 05-01-2006 15:23 ]

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

ok, ik zal mijn test gegevens thuis eens hierop nazien, de x1900xtx komt hier met gemak over, maar de 7800gtx 512 dacht ik ook. ik gebruik geen Soft Shadows. rest op max detail.Verwijderd schreef op donderdag 05 januari 2006 @ 15:14:

[...]

Hoe bedoel je Nvidia vriendelijk? Een poosje geleden heb ik hier FEAR resultaten laten zien op een X1800XT, en ben nog geen 7800GTX/512 tegengekomen die dit geëvenaard heeft.

(1600x1200/4xAA/8xHQAF = min26 - avg42 - max97)

Denk dat mijn gevoel er naast zit. ik kan dus gerust de standaard test gebruiken.

Verwijderd

Is 1900XTX dan juist sneller of langzamer dan 11k?Ligt er echt aan met wat voor CPU, met een A64 4000+ en standaard X1900XTX speeds650/775 haal je geen 11K.

Deze zin kun je nameljk op twee manieren opvatten

Om nog even terug te komen op de 7600. nVidia heeft nu officieel de GeForce Go 7600 gelanceerd. Vaak kan je hier al iets meer afleiden over de desktop kaarten....Hacku schreef op maandag 02 januari 2006 @ 20:52:

Het was de bedoeling dat de 7600 eerder zou uitkomen, maar omdat de prestaties van de X1600 tegenvielen wachtte nVidia nog maar even

Memory Interface: 128-bit

Geheugenbandbreedte: 16 GB/s, dus 500 Mhz GDDR3

Fill Rate (Billion pixels/sec: 3.6, dus vermoedelijk 8 pipelines op 450 Mhz

Vertices/Second (millions): 550, dus 4 vertexshaders op 550Mhz of 5 vertexshaders op 440Mhz

Dit lijkt bijna op een GF6600GT, maar dan met 8 ROPs ipv 4 ROPs en 1 of 2 vertexshaders meer.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Verwijderd

De 7800GTX/512 resultaten die ik gezien heb gaven allemaal een min fps van ~21/22 en avg ~36/38 op mijn settings. (ik praat trouwens wel over een X1800XT @ XTPE)GfMike schreef op donderdag 05 januari 2006 @ 16:43:

[...]

ok, ik zal mijn test gegevens thuis eens hierop nazien, de x1900xtx komt hier met gemak over, maar de 7800gtx 512 dacht ik ook. ik gebruik geen Soft Shadows. rest op max detail.

Denk dat mijn gevoel er naast zit. ik kan dus gerust de standaard test gebruiken.

Breek je een NDA als je hier even vluchtig tussen neus en lippen door vermeldt wat de avg is van de X1900XTX?

Hoe oud ben jij Mike? Vertel even je leeftijd

[ Voor 7% gewijzigd door Verwijderd op 05-01-2006 17:59 ]

49

Twee getalen, je mag zelf kiezen welk getal bij welke vraag hoort, heb ik ook geen NDA verbroken

Je hebt gelijk voor wat betreft de 7800GTX 512mb, die haalt met de standaard drivers settings en met een A64 4000+ op 1600x1200 AA4xAF8x Max detail geen soft shadows: Avg 36fps, de X1800XT 512MB het zelfde systeem 39fps, (standaard speeds)

[ Voor 54% gewijzigd door GfMike op 05-01-2006 18:07 ]

Verwijderd

[ Voor 27% gewijzigd door Verwijderd op 05-01-2006 18:10 ]

Nog even geduld, na 24 jan begrijp je me zin welVerwijderd schreef op donderdag 05 januari 2006 @ 16:57:

[...]

Is 1900XTX dan juist sneller of langzamer dan 11k?

Deze zin kun je nameljk op twee manieren opvatten

Wat XT PE betreft, is dat wel een standaard kaart die ATI fabriceerd of een TOP versie zoals Asus doet.Verwijderd schreef op donderdag 05 januari 2006 @ 18:08:

Valt me toch een beetje tegen, ~17% sneller als de huidige XTPE.

Je moet hem met de X1800XT vergelijken niet met de PE vind ik.

Kan zijn dat mijn 4000+ parten speelt. helaas ondersteund F.E.A.R geen 1920x1200

Verwijderd

Het laatste.GfMike schreef op donderdag 05 januari 2006 @ 18:11:

[...]

Wat XT PE betreft, is dat wel een standaard kaart die ATI fabriceerd of een TOP versie zoals Asus doet.

Ik vergelijk echter nogal snel met een "XTPE" aangezien het overgrote deel van de huidige XT's makkelijk op XTPE speeds loopt (en het is meer een vergelijk voor mezelf). Wat betreft de overklokbaarheid van de X1900 kan ik nog niets zeggen natuurlijk.

[ Voor 20% gewijzigd door Verwijderd op 05-01-2006 18:25 ]

Ja botox doet wonderen

@Apple

De X1900XTX kan ook overgeklokt worden zoals je zelf ook al opmerkt, ik zelf vergelijk altijd de standaard speeds, niet de overgeklokte speeds.

Dus dan ga je toch denken wat de X1900 tegen zou houden. Je ziet dat de X1600 dus in fear vol uit kan gaan. En die 12 shaders units goed kan gebruiken. Maar de X1900 heeft er met zijn 48 " te veel " Natuurlijk kunnen we nog niets zeggen over de kaart omdat i niet uit is. Maar Omdat CJ het er over ahd dat Fear een ratio van 11:1 qua shaders kon gebruiken vraag ik me het wel af.

Zo i zo in veel games zul je die 48 shaders bij lange na niet gebruiken. Mischien bij games als Unreal 3 wel. Maar even tot de 24e wachten dan.

En @ FireFox waarom denk je dat ik een een X1900 XTX wil voor me Dell 24" die ik volgende maand ga kopen

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Ik speel ook op 1920x1200 AF8x maar dan zonder AA, gaat prima met een X1800XT en 7800GTX.

op zo'n hoge resolutie heb je toch bijna geen zichtbare jaggies.

Tenzij je perfectionist bent

N47h4N|The secret to creativity is knowing how to hide your sources| Dyslexic atheists don't believe in doG! | ˙ʞuɐlq ʇɟǝl ʎllɐuoᴉʇuǝʇuᴉ sɐʍ ǝɔɐds sᴉɥ┴ ®

Even terug scrollen. CJ zei dat het 7:1 was. Een aantal andere nieuwe games 5:1. En de meeste oudere games 3:1.Astennu schreef op donderdag 05 januari 2006 @ 18:37:

Maar Omdat CJ het er over ahd dat Fear een ratio van 11:1 qua shaders kon gebruiken vraag ik me het wel af.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

AhCJ schreef op donderdag 05 januari 2006 @ 19:55:

[...]

Even terug scrollen. CJ zei dat het 7:1 was. Een aantal andere nieuwe games 5:1. En de meeste oudere games 3:1.

En over die 1920 reso. Ik gebruik op 1600-1200 nog AA

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

You got mailRappieRappie schreef op donderdag 05 januari 2006 @ 19:14:

Apple, kan ik je ff wat vragen via mail?

Met een X800XL draai ik op 1280 4x AAA (plus temp) 8x AF nog soepel hoorAstennu schreef op donderdag 05 januari 2006 @ 20:35:

[...]

Ahmaar toch Die X1900 is 3:1 dus dan had ik nog steed iets meer verwacht. Dan zal unreal wel op 11:1 kunnen zitten of zo.

En over die 1920 reso. Ik gebruik op 1600-1200 nog AAdus ja. Ik wil dan ook AAA gaan gebruiken om de hekken wat mooier te krijgen en natuurlijk 16x HQ AF

. Maar dat zal zelfs voor een X1900 te veel gevraagt zijn. Bij NFS MW kom ik nu niet hoger dan 1024 met 4x aa en 8x AF en rest vol uit. Als ik hoger ga wil je fps soms te veel rond de 40 en iets lager zitten waardoor de gameplay slecht word. Want bij dat soort games wil je een stabiele 40+ fps. Hopelijk gaat een X1900 hier veel bij helpen.

Heel af en toe een schokje maar dat komt denk ik omdat ik Teamspeak en winamp ook aan heb, en ik nog geen dual core heb

Wat voor pc heb jij Krizzie als ik vragen mag? Misschien scheelt processor en geheugen heel wat in NFSMW, wat ik me overigens niet serieus kan voorstellen... * Jejking krabt zich op zijn hoofd

Trouwens, ik heb ergens het vermoeden dat de volgende aanname verkeerd is: de R580 heeft een 16x3-design, waar de 9x00 en de X8xx nog een 8, 12, of 16 x 1-design hadden? Correct me if I am wrong, maar ik denk dat ik dan weet waar ik op ga letten als de R580 in de winkels ligt

O ja, de R600 is unified, dus hij heeft geen losse shaderpools en dergelijke. Vraag ik me af: stel dat er een R600LE op de markt komt, wat zou er dan aan gekortwiekt kunnen zijn? Gewoon het aantal unified rekenunits zelfs? Want anders zou er geen unlockability meer overblijven volgens mij, tenminste ik kan niks anders verzinnen. Was ik gewoon eens nieuwsgierig naar

Niet op voorraad.

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Wat vind jij soepel ? Gebruik fraps maar eens. Soepel vind ik min FPS van +40 nu is mijn min fps 35 of zo. Dus dat is nog acceptabel. Ik heb dus wel ingame alles maxed out.Krizzie schreef op donderdag 05 januari 2006 @ 20:46:

[...]

Met een X800XL draai ik op 1280 4x AAA (plus temp) 8x AF nog soepel hoor

Heel af en toe een schokje maar dat komt denk ik omdat ik Teamspeak en winamp ook aan heb, en ik nog geen dual core heb

Allerlaatste hardware ? grootste portomonee ?Jejking schreef op donderdag 05 januari 2006 @ 21:12:

Ik wilde net zeggen Astennu, mijn X800XL trekt 1024x768x32 met alle details aan met 6xAA+3xTAA + 16xAF nog vrij goed (okee, 1280x1024 is dan weer wat te hoog gegrepen maar goed ik klaag niet), wat doe jij dan verkeerd, de persoon met de allergrootste portemonnee op heel GoT met de laatste hardware?

offtopic:

Wat voor pc heb jij Krizzie als ik vragen mag? Misschien scheelt processor en geheugen heel wat in NFSMW, wat ik me overigens niet serieus kan voorstellen... * Jejking krabt zich op zijn hoofd

Trouwens, ik heb ergens het vermoeden dat de volgende aanname verkeerd is: de R580 heeft een 16x3-design, waar de 9x00 en de X8xx nog een 8, 12, of 16 x 1-design hadden? Correct me if I am wrong, maar ik denk dat ik dan weet waar ik op ga letten als de R580 in de winkels ligt

O ja, de R600 is unified, dus hij heeft geen losse shaderpools en dergelijke. Vraag ik me af: stel dat er een R600LE op de markt komt, wat zou er dan aan gekortwiekt kunnen zijn? Gewoon het aantal unified rekenunits zelfs? Want anders zou er geen unlockability meer overblijven volgens mij, tenminste ik kan niks anders verzinnen. Was ik gewoon eens nieuwsgierig naar

En kom maar op met die X1900

Er staat BTW dat er 2 versies komen:

X1900 XT @ 625-725

X1900 XTX @ 650-775

Bijde hebben 512 mb geheugen. De eerste gaat 629 euro kosten en de 2e was 719. Dit zijn wel preorder prijzen. Maar toch bijna 100 euro meer voor 25 en 50 mhz meer

[ Voor 8% gewijzigd door Astennu op 05-01-2006 23:00 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Voor zover ik weet (en dat weet ik 100% zeker) is er sowieso al 1 in nederland ook, een X1900XTXedward2 schreef op donderdag 05 januari 2006 @ 21:22:

De X1900XT's verschijnen al in de webshops zie rage3d.

Als je uitgaat van het rijtje:Jejking schreef op donderdag 05 januari 2006 @ 21:12:

Trouwens, ik heb ergens het vermoeden dat de volgende aanname verkeerd is: de R580 heeft een 16x3-design, waar de 9x00 en de X8xx nog een 8, 12, of 16 x 1-design hadden? Correct me if I am wrong, maar ik denk dat ik dan weet waar ik op ga letten als de R580 in de winkels ligt

R100: 2x3, R200: 4x1, R300: 8x1, R420: 16x1, R520: 16x1, NV30: 4x2, NV40: 16x1, dan is R580 gewoon 16x1 en is G70 eigenlijk 24x0,67.

Het eerste getal stond namelijk voor het aantal pipelines (of beter gezegd Fragment Pipes) en het tweede getal voor het aantal texture units per pipeline. Het beste is dus om gewoon die hele "Pipelines X TMUs" configuratie te vergeten aangezien de texture units steeds minder belangrijk worden. Wil je dat toch doen, dan is R580 dus gewoon een 16x1 en is RV530 eigenlijk een 4x1.

Die 3 bij de R580 staat voor het aantal shaderprocessors per ROP. En de ROP is uiteindelijk bepalend voor het aantal kleur en z-samples dat er per cycle bewerkt kan worden.

Unified architectures werken dus WEL met losse shaderpools. Dat is juist het hele idee achter het USM. Xenos heeft 3 pipelines met elk 16 ALUs, dus 48 ALUs in totaal. Elke pipeline is eigenlijk een array van shaderengines die zowel pixelshaderbewerkingen als vertexshaderbewerkingen kan doen. Dit kan onafhankelijk van elkaar gebeuren.O ja, de R600 is unified, dus hij heeft geen losse shaderpools en dergelijke. Vraag ik me af: stel dat er een R600LE op de markt komt, wat zou er dan aan gekortwiekt kunnen zijn? Gewoon het aantal unified rekenunits zelfs? Want anders zou er geen unlockability meer overblijven volgens mij, tenminste ik kan niks anders verzinnen. Was ik gewoon eens nieuwsgierig naar

R580 is eigenlijk een soort van omgekeerde Xenos, dus 16 pipelines met elk 3 ALUs, maar die minder flexibel is, want deze kunnen alleen maar pixelshaderbewerkingen doen. In totaal dus ook 48 ALUs.

De verwachting is dat R600 waarschijnlijk 4 shader arrays heeft (dus 4 pipelines met elk 16 ALUs) voor een totaal van 64 ALUs. De shaderunit van Xenos heeft zo'n 200M transistoren + nog eens 100M voor de speciale FSAA hardware, dus 4 arrays lijkt logisch of misschien zelfs meer. Bij een "R600LE" variant zou dus gewoon een pipeline uitgeschakeld kunnen worden, zodat er 16 ALUs uitgeschakeld worden.

ATi is trouwens ook al bezig met een Xenos variant voor handhelds, dus met unified shaders (misschien 1 pipeline met 16 ALUs).

------

Overigens kreeg ik net te horen dat nVidia de X1300Pro gaat counteren met de GeForce 7300GS. 4 pipelines net als de X1300Pro. Xpert Vision heeft er eentje met 1.4ns op stapel staan. En ik geloof dat nVidia een tijdje geleden nog bang was voor de X1300Pro. Ben benieuwd of ze 'm flink hoog hebben kunnen klokken.

[ Voor 7% gewijzigd door CJ op 06-01-2006 00:23 ]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Ontopic:

Gaat de R580 nou kwa prijs richting de 7800-512?

Dadelijk gaan ze ook nog een wedstrijdje doen wie de duurste kaart op de markt kan brengen.

Edit: Specs even aangepast

[ Voor 5% gewijzigd door Krizzie op 06-01-2006 01:14 ]

Verwijderd

nVidia meent alles te kunnen counteren met snelheid, maar bij budget kaarten zijn het de features die het 'm doen. Als de 7300GS geen soort gelijks heeft als Avivo is het niets meer dan een veredelde GF6600 o.i.d.Overigens kreeg ik net te horen dat nVidia de X1300Pro gaat counteren met de GeForce 7300GS. 4 pipelines net als de X1300Pro. Xpert Vision heeft er eentje met 1.4ns op stapel staan. En ik geloof dat nVidia een tijdje geleden nog bang was voor de X1300Pro. Ben benieuwd of ze 'm flink hoog hebben kunnen klokken.

Features bij budgetkaarten is iets wat de meeste reviewers veel te licht meewegen. Bij de X1300pro is een groot percentage van de transistors besteed aan features als Avivo terwijl bij 90% van de X1300 reviews deze features onder de tafel wordt geschoven. (10 pagina's performance tests, paar woorden over Avivo)

Reken daar maar niet op. Dit zijn pre oder prijzen. Ik hoop alleen niet dat de prijs verhoudingen kloppen want die XTX is wel veel duuder en heeft waarschijnlijk gewoon 1.26ns geheugen en dezelfde core. Met maar 25 mhz voor de core extra en maar 50 ( 100 DDR ) Meer voor het geheugen. Dat vind ik geen 90 euro waard. Mischien wel als er 1.1 ns geheugen op zou zitten daardoor ik 1 GHz kan klocken maar dat verwacht ik niet.Krizzie schreef op vrijdag 06 januari 2006 @ 00:54:

@ Jejking, zie specs in me sig, oc is wel een beetje veranderd (moet me kast maar eens gaan ontstoffen temps zijn een beetje te hoog.

Ontopic:

Gaat de R580 nou kwa prijs richting de 7800-512?Nee toch!

Dadelijk gaan ze ook nog een wedstrijdje doen wie de duurste kaart op de markt kan brengen.

Edit: Specs even aangepast

Ik ben benieuwd hoe dit gaat aflopen. 4 Pipes is niet veel. Het verbaast me dat ATi de X1300 Pro niet op 500 of 550 MHz clockt want dat zouden ze wel kunnen als je de X1600 bekijkt. Okeey tis wel iets anders maar het is ongeveer een R520 core. Dus ik ben benieuwd wat die 7300 GS,7600 en de G71 gaan doen.Verwijderd schreef op vrijdag 06 januari 2006 @ 01:06:

[...]

nVidia meent alles te kunnen counteren met snelheid, maar bij budget kaarten zijn het de features die het 'm doen. Als de 7300GS geen soort gelijks heeft als Avivo is het niets meer dan een veredelde GF6600 o.i.d.

Features bij budgetkaarten is iets wat de meeste reviewers veel te licht meewegen. Bij de X1300pro is een groot percentage van de transistors besteed aan features als Avivo terwijl bij 90% van de X1300 reviews deze features onder de tafel wordt geschoven. (10 pagina's performance tests, paar woorden over Avivo)

CJ hoe dit dat denk je met de G71 ? Want de G70 had 16 robs met ieder 2 shaders ? en wat hadden die overige Pipes dan ?daar zaten alleen shaders in. Maar had i dan 2 volledige shaders ? Dus 24x2 = 48 ?. Want over de G71 hoor je wel eens dat die 24 Robs zou krijgen met dan weer 8 losse pipes voor de shaders. Ik gok eerder op 16 Robs met 16 losse pipes voor shaders. Maar ik heb me daar niet zo in verdiept.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Geen zin om Rage3D door te spitten

╔╗╔═╦╗

║╚╣║║╚╗

╚═╩═╩═╝

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Het waren franse webshops dus ik wens je suc6Thund3r schreef op vrijdag 06 januari 2006 @ 11:05:

Link naar die webshops met X1900's?(Buitelands/NL)?

Geen zin om Rage3D door te spitten

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

De X1800 gaat er uit die is EOL. Dus ik denk dat die richting de 475-500 gaat. En de X1900 XT er voor 550 komt te zitten. Met dan iets van 600 voor de XTX. Maar dit is een grote gok hoorKrizzie schreef op vrijdag 06 januari 2006 @ 12:18:

Ik denk eerder tegen de €600,- de X1800XT is bij de meeste winkels ook nog €530,- of duurder. Die zakt bij launch waarschijnlijk niet meteen richting de €400,- hoor.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Reken maar niet op 1,1ns op XTX. ATI streeft dit keer naar beschikbaarheid en daar is 1,1ns nog niet ver genoeg voor.Het waren franse webshops dus ik wens je suc6zo i zo ik ga niet voor die prijsen pre orderen ik durf te wedden dat ze hier gewoon voor 550 euro komen te liggen. Die XTX mischien meer als daar ook echt zeldzaam 1.1 ns onder ligt.

Ik heb het idee dat de G71 wacht op het moment dat 1,1ns net ver genoeg is voor massa levering.

[ Voor 15% gewijzigd door Verwijderd op 06-01-2006 13:03 ]

Neeh ik verwacht het ook niet. Maar anders ga ik geen 90 euro extra betalen. Daar wil ik wel iets voor terrug zien. Want verder zijn de XT en XTX hetzelfde. Alleen de clocks verschillen en dat is mij geen 90 euro waard. Mischien zijn de XTX handpicked. En kunnen die nog veder clocken.Verwijderd schreef op vrijdag 06 januari 2006 @ 13:02:

[...]

Reken maar niet op 1,1ns op XTX. ATI streeft dit keer naar beschikbaarheid en daar is 1,1ns nog niet ver genoeg voor.

Ik heb het idee dat de G71 wacht op het moment dat 1,1ns net ver genoeg is voor massa levering.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

De X1300Pro loopt op 600Mhz core...Astennu schreef op vrijdag 06 januari 2006 @ 10:54:

[...]

Ik ben benieuwd hoe dit gaat aflopen. 4 Pipes is niet veel. Het verbaast me dat ATi de X1300 Pro niet op 500 of 550 MHz clockt want dat zouden ze wel kunnen als je de X1600 bekijkt. Okeey tis wel iets anders maar het is ongeveer een R520 core. Dus ik ben benieuwd wat die 7300 GS,7600 en de G71 gaan doen.

De 7300GS heeft echter wel de verbeterde pixelshaderunits die de G70 ook heeft, dus 2 volledige ALUs, terwijl de X1300Pro 1 volledige en 1 mini heeft. Als de 7300GS snel genoeg geklokt is dan moet de X1300Pro geen probleem zijn. Overigens is de 7300GS dus gewoon een opgefokte/getweakte 6200.

De 7600 is dus blijkbaar een 6600GT met de vernieuwde ALUs uit de G70 om de snelheid te verhogen en meer vertexshaders. We zagen dat die vernieuwde ALUs inderdaad voor een snelheidsboost zorgden bij de NV40 naar G70 stap, maar of dit genoeg is om de X1600XT bij te houden is de vraag.... 16 full ALUs vs 12 full + 12 mini.

G70 had 16 ROPs, 16 Texture Mapping Units en 24 Fragment Shaders. Elke Fragment Shader had 2 ALUs (dus eigenlijk 2 volwaardige shaderengines), in totaal dus 48 ALUs. Er gaan inderdaad geruchten dat het aantal ROPs omhoog gaat naar 24, maar of dit nou zo slim is....CJ hoe dit dat denk je met de G71 ? Want de G70 had 16 robs met ieder 2 shaders ? en wat hadden die overige Pipes dan ?daar zaten alleen shaders in. Maar had i dan 2 volledige shaders ? Dus 24x2 = 48 ?. Want over de G71 hoor je wel eens dat die 24 Robs zou krijgen met dan weer 8 losse pipes voor de shaders. Ik gok eerder op 16 Robs met 16 losse pipes voor shaders. Maar ik heb me daar niet zo in verdiept.

Een voordeel van het verhogen van het aantal ROPs is dat je op hogere resoluties kan werken. Een ROP bepaald hoeveel pixels er per klokcycle naar je color of z/buffer weggeschreven kunnen worden. Elke ROP kan 1 pixel per clockcycle verwerken. Heb je dus 16 ROPs, dan duurt het vullen van een 1024x768 buffer (786432 pixels) zo'n 49152 clockcyles met 16 ROPs. Je ziet dus dat als je meer ROPs hebt, je ofwel sneller de framebuffer vult op gelijke resoluties of gemakkelijk naar hogere resoluties kan gaan zonder dat de snelheid drastisch omlaag gaat.

Er is echter een grote maar.... Hoe meer ROPs je hebt hoe sneller de aanwezige bandbreedte opgeslokt gaat worden. Kort gezegd zijn 16 ROPs nog ruim voldoende en zal meer eigenlijk pas nuttig worden als we of a) sneller geklokt GDDR4 gebruiken vanaf zo'n 1.4Ghz of b) overstappen naar een 512-bit memory interface.

Als een shader unit z'n taak sneller af heeft dan een ROP, wat voorkomt in scenarios met weinig shader gebruik, dan is het aan ROPs dus de beperkende factor en zal R580 nooit sneller zijn dan R520 (behalve dan door de iets hogere kloksnelheid).

Als er echter enorm veel shaders (of lange shaders) gebruikt worden, dan zijn het de ROPs die dus moeten wachten op de shaderunits en zal de R580 in het extreme geval zelfs tot 3x sneller kunnen zijn dan R520.

Als je kijkt naar games als Far Cry, F.E.A.R., Call Of Duty, BattleField 2, dan zie je vast wel een tendens naar welke kant we op gaan.

Vaak is het nu al het geval dat de ROPs uit hun neus zitten te vreten. Waarom denk je dat nVidia voor de GF6600GT gegaan is naar 4 ROPs + 8 pixelshaders? Of met de G70 naar 16 ROPs en 24 Pixelshaders? De GF6600GT had dus een 1:2 verhouding ROP:SHADER en ondervond daar geen problemen van. Een G71 kan dus ook best naar een 1:2 verhouding gaan en dan 16 ROPs en 32 pixeshaders hebben. 24 ROPs zou het ding alleen maar in veel gevallen laten snakken naar bandbreedte.

[ Voor 4% gewijzigd door CJ op 06-01-2006 14:41 ]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

http://ir.ati.com/phoenix...icle&ID=800914&highlight=ATI and Avivo™ Technology Deliver the Best Visual Experience for Notebook PCs at Every Price Point

ATI Raises the Digital Entertainment Bar for Mainstream and Thin-and-Light Notebooks

MARKHAM, Ontario--(BUSINESS WIRE)--Jan. 5, 2006-- ATI Technologies Inc. (NASDAQ:ATYT) (TSX:ATY) today announced Mobility™ Radeon® X1400 and Mobility™ Radeon® X1300 graphics processors-taking the mainstream and thin-and-light notebook segments to new levels of visual realism, performance and power management. Both Mobility Radeon GPUs feature ATI's new Avivo™ technology to deliver the best visual quality to notebooks at every price point available.

Following closely on the heels of Mobility™ Radeon® X1600, Mobility Radeon X1400 and Mobility Radeon X1300 deliver maximum affordability without compromising features and performance. Designed with cutting-edge 90 nanometer (nm) fabrication processes, both GPUs include Shader Model 3.0 support for today's latest games along with a new multi-threaded 3D architecture for lightning-fast graphics.

Delivering the maximum performance and portability, Mobility Radeon X1400 meets the space savings and low power requirements of today's thinnest and lightest notebook designs, while Mobility Radeon X1300 rounds out the offering in the mainstream notebook segment.

Nieuwsflash: ATi OCUR preview @ Anandtech

Lees hier meer: http://www.anandtech.com/tradeshows/showdoc.aspx?i=2662Although their GPU teams have gone through their ups and downs, the one group at ATI that has consistently done well is their multimedia team. While they have always been quite competitive in the PC multimedia space, nothing is even remotely close to what they are showing off at this year's CES.

At the show ATI is demonstrating the world's first and only CableCard HDTV tuner for PCs, and we were fortunate enough to get a hands-on demo of it.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

En hoe moet ik het dan voor de R580 zien ? die krijgt dan 48 volledige en 48 halve ? Want zo is het nu met de X1800 wel die heeft 16 hele en 16 halve ( halve = die mini shaders waar jij het over had )

De G71 krijgt 64 hele shaders. Met dan die 16 robs. Alleen dan komt de grote vraag. Hoe bruikbaar zijn die mini shaders van ATi tov een volledige. Want nu zie je BV in B&W2 dat de ATi kaarten niet vooruit komen. En de G70 wel. Die heeft nu ook wel een groot shader power voordeel. Aleen ATi heeft een hogere clock speed. Echter schijnt de G71 700 mhz te gaan lopen. Dus meer dan de R580 nu doet. Ik vraag me echt af wel van de 2 gaat winnen.

Ik denk de G70 in alle oude games zoals UT 2K4. ( Dat zie je nu ook met de X1800 VS GTX ) En de R580 in moderne games als fear BF2 en unreal 3 de G71 iets voorbij zal gaan. Maar ik denk dat het erg close zal worden gezien de extreme clockspeed van de G71 ( Of i ook echt 700 mhz krijgt is nog wel de vraag ).

Edit:

Wat is die X1400 nou ? als ik naar de specs krijg lijkt het gewoon een hoger geclockte X1300. Hij heeft evenveel pipes shaders en transistors.

[ Voor 7% gewijzigd door Astennu op 06-01-2006 14:54 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

[ Voor 22% gewijzigd door Splinter Cell op 06-01-2006 14:59 ]

Verwijderd

misschien leg je te veel nadruk op de corespeed e.d. Ik denk dat de kaart met de beste geheugen-management de overwinning zal binnenhalen, hier liggen namelijk de grootste bottlenecks.De G71 krijgt 64 hele shaders. Met dan die 16 robs. Alleen dan komt de grote vraag. Hoe bruikbaar zijn die mini shaders van ATi tov een volledige. Want nu zie je BV in B&W2 dat de ATi kaarten niet vooruit komen. En de G70 wel. Die heeft nu ook wel een groot shader power voordeel. Aleen ATi heeft een hogere clock speed. Echter schijnt de G71 700 mhz te gaan lopen. Dus meer dan de R580 nu doet. Ik vraag me echt af wel van de 2 gaat winnen.

De geheugencontroller van de ATI kaart heef 8x32 bit. Heeft G70/71 ook 8x32bit of 4x64bit configuratie?

@ Astennu: Je zit goed met het feit dat de G70 eigenlijk meer shaderpower heeft dan de R520. Daarom is de G70 op gelijke kloksnelheden sneller dan een R520.

G70 heeft 24x2 volledige ALUs, dus 48.

R520 heeft 16 volledige ALUs + 16 mini ALUs

De R520 is echter gebouwd voor hoge snelheden en heeft een threadingarchitecture + ringbus om dit verschil te compenseren.

Als G71 32 pixelshaderpipelines krijgt, dan zitten er inderdaad 64 volledige ALUs in.

R580 heeft er dan 48 volledige ALUs + 48 mini ALUs.

Bij gelijke kloksnelheden kan het dus best heel erg close worden, afhankelijk van hoe efficient de architectuur is. Tenzij G71 flink veel verbeterd heeft aan z'n dynamic branching, verwacht ik dat R580 een stuk efficienter zal blijken in de nieuwste SM3.0 games, aangezien R580 ook 48 dynamic branching units heeft (3 per fragment pipeline) en de G71 er dan geloof ik op 32 blijft hangen.

Waar de Mobility X1300 en Mobility X1400 nou precies op gebaseerd zijn is onduidelijk. Het heeft 105M transistoren dus je zou zeggen dat het de RV515 core is. Maar er staat ook bij dat ze beide een 256-bit ring bus controller hebben en dat heeft de RV515 niet. Maar gezien een dergelijke ringbus controller meer transistoren zou opnemen, denk ik dat dit een typo is, want de normale desktop X1300 heeft ook geen ringbus.

Het zou kunnen zijn dat ATi stiekem al aan het experimenteren is met de RV505. Dus Mobility Radeon X1300 zou dan RV505 kunnen zijn (want 0.08u proces, dus minder stroomverbruik) en X1400 zou dan RV515 kunnen zijn. Maar goed, binnenkort waarschijnlijk wel meer duidelijkheid hierover.

[ Voor 3% gewijzigd door CJ op 06-01-2006 15:45 ]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

En je ziet trouwens ook dat de G70 goed schaalde @ clockspeeds. Want de GTX 512 wmet zijn 550 mhz sloeg de X1800 XT als een mug dood tegen het raam. Laat staan een 32 pipe setup met 150 MHz meer. In denk dat in de oudere games fataal word voor de R580 TOV de G71 maar in de modernere games met veel shaders verwerkingen weer andersom. Of denk zie ik wat over het hooft? want in non shader games is een R580 net zo snel als een R520.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Ik vraag me toch af wat van dit gerucht klopt, zelfs 750mhz. werd beweerd. Gebruikt Nvidia een "speciaal" .09 wonder procedé die een hogere clockspeed mogelijk maakt, zelfs met 32 pipelines = meer hitte, dan Ati's procedé?Echter schijnt de G71 700 mhz te gaan lopen.

Ze zitten toch bij dezelfde chipbakker?

[ Voor 23% gewijzigd door Verwijderd op 06-01-2006 16:10 ]

Het ligt ook aan de hoeveelheid moeite die de IHV stopt in het ontwikkelen voor een bepaald proces.Verwijderd schreef op vrijdag 06 januari 2006 @ 16:09:

[...]

Ik vraag me toch af wat van dit gerucht klopt, zelfs 750mhz. werd beweerd. Gebruikt Nvidia een "speciaal" .09 wonder procedé die een hogere clockspeed mogelijk maakt, zelfs met 32 pipelines = meer hitte, dan Ati's procedé?

Ze zitten toch bij dezelfde chipbakker?

ATi: 110nm, 160M transistoren, komt niet veel verder dan 430Mhz

nV: 110nm, 300M transistoren, haalt vaak met wel rond de 490Mhz (cherry picked GTX512 niet mee gerekend die 550Mhz+ kunnen halen)

Wat 110nm betreft heeft ATi er ook weinig moeite in gestopt. R430 was gewoon een simpele dieshrink om kosten te besparen. nV daarentegen heeft de hele G70 architectuur ervoor geoptimaliseerd. Daarnaast wordt het proces natuurlijk ook steeds rijper en kan TSMC op meer ervaring leunen.

Als G71 zo'n 360M transistoren heeft op 750Mhz op 90nm+lowk dan zou me dat helemaal niet verbazen.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Verwijderd

Die 48 mini ALU's doen niet zoveel, vandaar miniCJ schreef op vrijdag 06 januari 2006 @ 15:44:

Als G71 32 pixelshaderpipelines krijgt, dan zitten er inderdaad 64 volledige ALUs in.

R580 heeft er dan 48 volledige ALUs + 48 mini ALUs.

Waarom denk je dynamic branching zo belangrijk gaat worden? Het is maar een onderdeel van SM3, niet elk SM3 game doet per definitie veel dynamic branching. We zien dit duidelijk aan de huidige sm3 games waar de G70 512MB met de R520 goed meekan (understatement) ondanks de "mindere" dynamic branching capaciteiten van de G70.Bij gelijke kloksnelheden kan het dus best heel erg close worden, afhankelijk van hoe efficient de architectuur is. Tenzij G71 flink veel verbeterd heeft aan z'n dynamic branching, verwacht ik dat R580 een stuk efficienter zal blijken in de nieuwste SM3.0 games, aangezien R580 ook 48 dynamic branching units heeft (3 per fragment pipeline) en de G71 er dan geloof ik op 32 blijft hangen.

Rauwe shader power lijkt me veel belangrijker dan dynamic branching in de huidige situatie en in de nabije toekomst. En daar zou de G71 in moeten uitblinken.

Ken je toevallig toekomstige games die echt massaal gebruik gaan maken van dynamic branching?

Wordt dat dan niet eerder iets voor de R600 en G80?

Dan doet ATi het niet echt geweldig met hun 650 MHz dan zou ik als ik hun was toch proberen de X1900 XT @ 700 te laten draaien. Want deze was nog wel gemaakt voor hoge core speeds. En nu gaat de G71 daar zo ff overheen.CJ schreef op vrijdag 06 januari 2006 @ 16:18:

[...]

Het ligt ook aan de hoeveelheid moeite die de IHV stopt in het ontwikkelen voor een bepaald proces.

ATi: 110nm, 160M transistoren, komt niet veel verder dan 430Mhz

nV: 110nm, 300M transistoren, haalt vaak met wel rond de 490Mhz (cherry picked GTX512 niet mee gerekend die 550Mhz+ kunnen halen)

Wat 110nm betreft heeft ATi er ook weinig moeite in gestopt. R430 was gewoon een simpele dieshrink om kosten te besparen. nV daarentegen heeft de hele G70 architectuur ervoor geoptimaliseerd. Daarnaast wordt het proces natuurlijk ook steeds rijper en kan TSMC op meer ervaring leunen.

Als G71 zo'n 360M transistoren heeft op 750Mhz op 90nm+lowk dan zou me dat helemaal niet verbazen.

Edit:

En zijn die mini shaders echt zo zwak/waardeloos ? Want anders had ATi die wel vervangen door 2 volledige. Want die zitten er sinds de X800 in ? of is dit al sinds de R300 core ?

[ Voor 9% gewijzigd door Astennu op 06-01-2006 17:16 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Dat is natuurlijk dikke bullshit. @ Astennu: Ze zitten er al sinds de R300 (dus 2002) in en ze zijn fully featured. Enige verschil is:Verwijderd schreef op vrijdag 06 januari 2006 @ 16:24:

[...]

Die 48 mini ALU's doen niet zoveel, vandaar mini

ALU 1:

- 1 Vec3 ADD + Input Modifier

- 1 Scalar ADD + Input Modifier

ALU 2:

- 1 Vec3 ADD / MULL / MADD

- 1 Vec3 ADD / MULL / MADD

Daarnaast heef elke pixelcore ook nog eens de beschikking over een Branch Execution Unit met 1 Flow Control Intruction. In R580 is dat dus x3.

Het is 'maar' een onderdeel van SM3.0...?Waarom denk je dynamic branching zo belangrijk gaat worden? Het is maar een onderdeel van SM3, niet elk SM3 game doet per definitie veel dynamic branching. We zien dit duidelijk aan de huidige sm3 games waar de G70 512MB met de R520 goed meekan (understatement) ondanks de "mindere" dynamic branching capaciteiten van de G70.

Rauwe shader power lijkt me veel belangrijker dan dynamic branching in de huidige situatie en in de nabije toekomst. En daar zou de G71 in moeten uitblinken.

Ken je toevallig toekomstige games die echt massaal gebruik gaan maken van dynamic branching?

Wordt dat dan niet eerder iets voor de R600 en G80?

Ik geloof dat zelfs nVidia ooit eens dynamic branching hevig evangeliseerde bij de developers (natuurlijk alleen maar omdat ATi het toendertijd nog niet hardwarematig kon). Een aantal devs die nu al heftig dynamic branching in hun (aankomende) games gebruiken zijn Bioware, Sigil Games, Petroglyph, CryTek, Rockstar Studios, Microsoft Games Studios, Remedy (zowel HDR + AA en dynamic branching). En veel games die nu under development zijn voor de Xbo360 maken gebruik van dynamic branching, simpelweg omdat de ATi Xenos daar goed in is. Ports zullen dus hoogstwaarschijnlijk beter draaien op de R5x0 generatie dan op de NV4x/G7x generatie.

Ongetwijfeld zal nVidia straks ook een betere dyn. branching performance hebben, maar in de tussentijd hebben al massa's mensen een GF6/7 die daar niet snel genoeg in is en op dezelfde modus moeten lopen als de X8x0 generatie. Ik geloof dat een X1600XT zelfs een 7800GTX kan bijbenen wanneer het op branching aan komt. Een scenario als dat de 9600XT een FX5950U verslaat in 3DM05 en sneller is in HL2 in DX9 mode schiet me nu weer te binnen.

@ Astennu, waarom zou een X1900 op hogere kloksnelheden moeten draaien? Kijk naar X1300Pro en X1600XT. Beide 600 Mhz, beide 4 ROPs, beide 4 texture mapping units... maar X1600 heeft 3 pixelshaderengines per ROP. En je ziet dat op dezelfde snelheden een X1600XT in shaderintensieve games soms wel tot 2x sneller is dan een X1300Pro:

BF2 No AA, 1280x960

X1600XT: 59,1

X1300Pro: 30,3

Everquest 2, No AA, 1280x960

X1600XT: 30,4

X1300Pro: 16,3

Far Cry, No AA, 1280x960

X1600XT: 63,5

X1300Pro: 34,5

Dus het verdriedubbelen van het aantal pixelshaderengines per pipe zou zelfs zonder speedboost voor een performanceboost moeten kunnen zorgen.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

van R520 > R580 is het verschil een stuk kleiner dan van RV515 > RV530. Maar ik hoop dat de R580 zulke goede resultaten gaat behalen. Want ik zet me geld er wel op in. Maar ik denk niet dat je resultaten zal zien als van X1300 > X1600 maar ik hoop wel dat je op resoluties boven de 1920 genoeg hebt aan de 16 robs om de shaders aan het werk te houden en dus hele goede frame rates neer te zetten want die 3x extra shader power zou zekers genoeg moeten zijn om 2048 resoluties speelbaar te maken nu alleen hopen dat de rest dat ook mogelijk maakt.

Want Firefox heeft nu laten zien dat de 7800 GTX op het moment beter is op reso's boven de 1600-1200. En dat is nou juist het gene wat ik strax wil gaan gebruiken.

Want wat je nu bij de X1300 en de X1600 in 3dmark goed terug kunt zien zou je bij de X1800 > X1900 dus niet zien. daar zou er maar iets van 2-4 K bij komen en bij de X1300 > X1600 is het echt bijna 100% sneller in 3DMark 2005.

[ Voor 12% gewijzigd door Astennu op 06-01-2006 18:08 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Dit was met rauwe HDR performance, met AA/AF zonder HDR is het verhaal anders. Ik vraag me nog steeds af of we hier (FP HDR) een driverboost kunnen verwachten, aangezien FP HDR weinig met shaders te doen heeft zover ik weet, de blending capaciteiten is puur hardware. De R580 zal hier dus niet veel verbetering laten zien als er op driverlevel niets verandert.Want Firefox heeft nu laten zien dat de 7800 GTX op het moment beter is op reso's boven de 1600-1200.

[ Voor 12% gewijzigd door Verwijderd op 06-01-2006 18:30 ]

Verwijderd

Wat betreft de GF6 serie kun je nVidia niet zo veel verwijten, het ging hun vooral om het getal "3" op de doos voor leuke marketing. Daarnaast was de GF6 een wederopstanding van nVidia na het fx-debakel op op zich zelf een behoorlijke prestatie was.Ongetwijfeld zal nVidia straks ook een betere dyn. branching performance hebben, maar in de tussentijd hebben al massa's mensen een GF6/7 die daar niet snel genoeg in is en op dezelfde modus moeten lopen als de X8x0 generatie.

Maar dat de GF7 geen goede dynamic branching heeft mag je nV kwalijk nemen. Als blijkt dat GF7 niet kan meekomen met X1000 serie dan is de GF7 met de fx-serie te vergelijken.

Tuurlijk kunnen ze er meer uitpersen dan 400 MHz, op zekers... maar wie zegt ook dat het nut heeft? De Ramdac-units zijn er alleen maar voor de weergave van 2D, en aangezien die grafisch gezien totaal geen kracht vergen heeft het dus geen zin om die speeds omhoog te gooienSplinter Cell schreef op vrijdag 06 januari 2006 @ 14:57:

Wat ik dus niet snap. Waarom flikkeren ze de Ramdac snelheid van de videokaarten ook niet meteen omhoog? Ze kunnen er toch wel meer uitpersen dan die 400 mhz..

Voor de rest: ik las net een review over een Xpertvision X1600Pro, en in een aantal games was de maximaal speelbare resolutie 800x600 @ lowdetail, anders zou de framerate niet hoog genoeg zijn... Hmm, sounds like sérious driver-issues

In bepaalde apps walst ie dan weer over de 6600GT heen met mooie marges, en het ding clockt over als een gek, van 575/650 (was al standaard ge-OC'ed) naar 653/724!

Maar goed, to the point, als je ziet dat de X1600XT iets van 10-15% sneller is dan een X1600Pro, die op zijn beurt weer marginaal sneller is dan een 6600GT, dan vrees ik dat de 7600(GT?) over de X1600-series heen gaat walsen... Ik denk dat ATi toch zware tijden tegemoet gaat, mits er in de lineup bepaalde dingen drástisch gaan veranderen zoals het gat tussen X1600XT en X1800XL

Vind ik geen kloppende vergelijking... De FX was ontworpen voor DirectX9 (Get Ready!Verwijderd schreef op vrijdag 06 januari 2006 @ 18:30:

Wat betreft de GF6 serie kun je nVidia niet zo veel verwijten, het ging hun vooral om het getal "3" op de doos voor leuke marketing. Daarnaast was de GF6 een wederopstanding van nVidia na het fx-debakel op op zich zelf een behoorlijke prestatie was.

Maar dat de GF7 geen goede dynamic branching heeft mag je nV kwalijk nemen. Als blijkt dat GF7 niet kan meekomen met X1000 serie dan is de GF7 met de fx-serie te vergelijken.

[ Voor 26% gewijzigd door Jejking op 06-01-2006 18:38 ]

[ Voor 20% gewijzigd door Astennu op 06-01-2006 19:09 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

![]() Dit topic is gesloten.

Dit topic is gesloten.

![]()

:strip_exif()/u/14387/Animation-2.gif?f=community)

:strip_exif()/u/2062/jannie2.gif?f=community)

/u/34200/crop6554f56fe2075_cropped.png?f=community)

:strip_icc():strip_exif()/u/7205/duke3.jpg?f=community)

/u/139379/format-c.png?f=community)

:strip_icc():strip_exif()/u/118853/Nintendo_Player_t-shirt_lin.jpg?f=community)

:strip_icc():strip_exif()/u/109762/crop63cfada0dde8a_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/10014/assassin.jpg?f=community)

:strip_icc():strip_exif()/u/182/crop66d4984812e9a_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/112011/crop64ec918860c01_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/136848/rsz_pure2.jpg?f=community)

:strip_icc():strip_exif()/u/27328/crop5f9ab9c63a754.jpeg?f=community)

:strip_icc():strip_exif()/u/57026/drag0nico.jpg?f=community)

:strip_icc():strip_exif()/u/160898/v_pestcontrol_256x256.jpg?f=community)