LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ze riepen ook dat de R520 de GTX dik zou inmaken...CJ schreef op donderdag 22 december 2005 @ 23:31:

[...]

Ik zit hier echt voor jan met de korte achternaamen te posten he?

8 posts boven je staat het antwoord zelf door ATi gegeven....

[...]

En nee je post niet voor jan met de korte achternaam.

Het is alleen dat ik ATI's marketing afdeling niet zo erg vertrouw.

Source gaf namelijk in het vorige topic (volgens mij

Koel om te zien hoe Far Cry hier van profiteert! Dat spel is in de meeste gevallen zo CPU gelimiteerd & er is bijna sprake van een fps verdubbeling in sommige gevallen met die nieuwe driversCJ schreef op donderdag 22 december 2005 @ 02:22:

Check dit eens. De ultieme 2005 Catalyst guide... Een vergelijking van Cat 5.1 tot aan Cat 5.13. Het geeft een leuk beeld hoe ATi vooruitgang heeft geboekt in de framerate-race met nVidia. Catalyst 5.12 brach al een aantal leuke dual core optimalisaties... Catalyst 5.13 gaat nog een stap verder....

Echt waanzinnig hoeveel in bepaalde games de performance omhoog vliegt op CPU gebonden resoluties.

Maar hoe doet nvidia het tov ati in het multi-proc gebeuren? Heeft alleen ati zo'n enorme winst?

Alone at last

Just nostalgia and I

We were sure to have a blast

En op conference calls met investeerders laat ATi vaak niet z'n marketingafdeling spreken. De zaken worden daar doorgaans zeer helder, open en duidelijk verteld om geen verkeerd beeld te geven aan de investeerders. Zo zijn ze ook duidelijk dat ze op dit moment nog niet het beoogde doel hebben kunnen halen van verkopen, dat nVidia op dit moment wel de snelste kaart heeft in de high end, en dat ze ook in het middensegment ze nog iets achter lopen maar dat ze daar nu wel aan het inlopen zijn dankzij de GT en GTO reeks en de X1600. Geen enkele marketingpraat die hier om heen lult of het mooier probeert te maken dan het is.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Maar de meeste benchmarks worden met singlecore procs gedaan, veelal flinke A64 FXen om de processor niet langer als bottleneck te laten functioneren. Je liet zien dat ATI met de nieuwe drivers extreme winst boekte icm een dualcore proc. Als je dus uitgaat van zeg een 4800+ (X2 2.4ghz met 2x 1mb cache) en de X1800XT, de 7800GTX 256 & 512, welke kaart komt dan als winnaar uit de bus? Nu denk ik niet dat dit extreem belangrijk is, aangezien de meeste mensen geen dualcore hebben, maar dit wordt waarschijnlijk wel het systeem om de videokaarten op te benchen & reputatie (ie hoge FPS

Alone at last

Just nostalgia and I

We were sure to have a blast

Oke dat wist ik dan even niet.CJ schreef op vrijdag 23 december 2005 @ 09:53:

Als je nu een review pakt van een X1800XT vs 7800GTX met beide de laatste drivers dan verslaat de X1800XT de 7800GTX in de meeste gevallen. De GTX512 is dan wel iets sneller dan de X1800XT, maar is nu bijna net zo zeldzaam als de GF6800Ultra Extreme. Bijna paperlaunch dus, behalve in de eerste week. Daarnaast is de X1800XT ook sneller in datgene waar ATi zei dat het veel sneller in zou zijn, namelijk de belangrijke SM3.0 functie dynamic branching.

En op conference calls met investeerders laat ATi vaak niet z'n marketingafdeling spreken. De zaken worden daar doorgaans zeer helder, open en duidelijk verteld om geen verkeerd beeld te geven aan de investeerders. Zo zijn ze ook duidelijk dat ze op dit moment nog niet het beoogde doel hebben kunnen halen van verkopen, dat nVidia op dit moment wel de snelste kaart heeft in de high end, en dat ze ook in het middensegment ze nog iets achter lopen maar dat ze daar nu wel aan het inlopen zijn dankzij de GT en GTO reeks en de X1600. Geen enkele marketingpraat die hier om heen lult of het mooier probeert te maken dan het is.

Misschien was me vraag ook wel een beetje erg kort door de bocht gesteld.

Ja klopt. Maar er is een verschil. De 7800GTX512 blijkt nu een launch te zijn die meer op een paperlaunch lijkt dan echte beschikbaarheid zoals ze dat bij de gewone GTX wel gedaan hebben. Prijzen van rond de $749 en dan ook nog eens op weinig plekken meer te krijgen, zijn precies de praktijken waarvan ATi beschuldigt werd door het nVidia kamp.Okyah schreef op vrijdag 23 december 2005 @ 09:59:

De 7800GTX 256 is wel ouder dan de X1800XT, dus dat deze trager is is niet onverwacht, toch? De 7800GTX 512 is de kaart die de X1800XT moet verslaan & dit lijkt hij toch wel te doen?

In die prijsklasse die zo'n €150 hoger ligt mag je ook wel verwachten dat een product die hoger is geprijst dan sneller is... nVidia heeft hiermee gewoon een nieuw segment gecreeerd, de onbereikbare ultra extreme high end.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

endaar hebben wij als consument geen onder aan. dat is gewoon pimpen met wat je kunt maar niet in massa'a kunt maken.CJ schreef op vrijdag 23 december 2005 @ 11:07:

[...]

Ja klopt. Maar er is een verschil. De 7800GTX512 blijkt nu een launch te zijn die meer op een paperlaunch lijkt dan echte beschikbaarheid zoals ze dat bij de gewone GTX wel gedaan hebben. Prijzen van rond de $749 en dan ook nog eens op weinig plekken meer te krijgen, zijn precies de praktijken waarvan ATi beschuldigt werd door het nVidia kamp.

In die prijsklasse die zo'n €150 hoger ligt mag je ook wel verwachten dat een product die hoger is geprijst dan sneller is... nVidia heeft hiermee gewoon een nieuw segment gecreeerd, de onbereikbare ultra extreme high end.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

ok bedankt, ik dacht dat omdat de all in wonder dat geloof ik wel heeftroertnl schreef op vrijdag 23 december 2005 @ 12:53:

dat zal je idd met je geluidskaart moeten doen

[ Voor 3% gewijzigd door maurits187 op 23-12-2005 12:55 ]

Om even te nuanceren: op 4xAA...CJ schreef op vrijdag 23 december 2005 @ 09:53:

Als je nu een review pakt van een X1800XT vs 7800GTX met beide de laatste drivers dan verslaat de X1800XT de 7800GTX in de meeste gevallen.

Op noAA en vaak ook 2xAA is de GTX (zeker de TOP varianten) vaak sneller, of gaat het gelijk op. Ook met HDR is de GTX vaak sneller.

Maar goed ik kom hier zeer binnenkort nog vrij uitgebreid op terug. Ik ga dit weekend eens mijn GTX TOP tegenover mijn X1800XT zetten met de recentste drivers van beide (Forceware 81.98 vs Cat 5.13), en dan zullen we wel zien

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Op 1280x1024 heb je misschien gelijk, maar als je op 1600x1200 en vooral zoals ik op 1920x1200 speelt laten aardig wat moderne games die resolutie in combinatie met 4xAA niet toe, zeker niet met HDR ingeschakeld...CJ schreef op vrijdag 23 december 2005 @ 15:42:

Die nuance is volgens mij wel heel belangrijk... Ik ga er namelijk van uit dat elk normaal denkend persoon die een 7800 dan wel X1800 koopt doorgaans toch wel 4xAA en 16xAF gebruikt. En je mag ook verwachten dat je dit in de meeste games gewoon aan kan zetten. Dus in de tests die belangrijk zijn (snelheid met 4xAA/16xAF) wint de X1800XT het nu vaak.

De snelheid op 2xAA en noAA is dan zeer belangrijk.

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Ik heb het idee dat ATi resoluties optimaliseerd. Want boven de 1600-1200 dropt X1800 erg. Bij nvidia is dit stukken minder. En de X1800 hoeft niet zo erg te droppen. Dus er is nog genoeg voor ATi om te doen. Want met de 24" en grotere schermen gaan mensen die resoluties ook gebruiken.FirefoxAG schreef op vrijdag 23 december 2005 @ 15:59:

[...]

Op 1280x1024 heb je misschien gelijk, maar als je op 1600x1200 en vooral zoals ik op 1920x1200 speelt laten aardig wat moderne games die resolutie in combinatie met 4xAA niet toe, zeker niet met HDR ingeschakeld...

De snelheid op 2xAA en noAA is dan zeer belangrijk.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Ik vat em even niet

Any way al mensen met een X1600 en of CF ? want met de X1600 kun je dat al maken.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Als ik zo de X1800XT soap volg is de r520 toch echt wel synchron geplanned met de G70.Okyah schreef op vrijdag 23 december 2005 @ 09:59:

De 7800GTX 256 is wel ouder dan de X1800XT, dus dat deze trager is is niet onverwacht, toch? De 7800GTX 512 is de kaart die de X1800XT moet verslaan & dit lijkt hij toch wel te doen?

Dat ze 4 tot 5 maanden hebben zitten zoeken naar 'n design probleem is een ander verhaal.

Het zijn dus puur mekaars tegenpolen. Waar 7800 'n sucses nummer is geworden, doordat de competitie zwaar in de problemen zat. nV heeft het deze ronde gewoon makkelijk gehad. Competitie weg val of extreem verlaat.

R580 en G71 zijn ook weer mekaar's tegenpolen En met 'n maand relase tolerantie is dat ook synchroon release.

De R520 heeft wat innovatievere spect's maar niet omdat ie zo nieuw design is het design is net zo oud als G70 Alleen produktie is nogal verlaat wegens grote problemen.

De g70 traject is in verhouden gewoon normaal verlopen.

X399 Taichi; ThreadRipper 1950X; 32GB; VEGA 56; BenQ 32" 1440P | Gigbyte; Phenom X4 965; 8GB; Samsung 120hz 3D 27" | W2012SER2; i5 quadcore | Mac mini 2014 | ATV 4g | ATV 4K

Verwijderd

Dit is volledig onzin. De G70 is een geoptimaliseerde nV40 core, niks revolutionairs. Van de R520 is alleen al de ring memory controller een ware revolutie, built for the future.De R520 heeft wat innovatievere spect's maar niet omdat ie zo nieuw design is het design is net zo oud als G70

Verder geeb flame hoor, alleen een foutje herstellen.

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Ik heb het over die blueprint die ze naar chip foundery sturen dat is ongeveer in gelijke tijdspanne gebeurt. Dus de implementatie design age. Niet wat het inhoud of het van de grond af nieuw isTijgert schreef op zaterdag 24 december 2005 @ 00:53:

[...]

Dit is volledig onzin. De G70 is een geoptimaliseerde nV40 core, niks revolutionairs. Van de R520 is alleen al de ring memory controller een ware revolutie, built for the future.

Verder geeb flame hoor, alleen een foutje herstellen.

.

Onzin? innovatief is een relatief begrip. Die nextgen mem controler is innovatief en ten tweede die innovatie zet ook zoden aan de dijk.

En voor ATI is het 'n heel nieuw design aangezien dit ook hun eerste SM3.0 Architektuur is. Dus geen optimalisatie van 'n oude Design. 'n friss begin meer gericht op de toekomst. Al maakt dit niet veel uit. Iets goeds uitbouwen brengt ook resultaat. Daarnaast het gross van het volk houd hun PC'tje met kaart wel langer dan die ene jaar denk aan 3 á 5. En dan zijn teokomst gerichte features zeker belangrijk.

Zo boeid het niet voor die geek die zijn 7800GT vervangt voor 'n 7800GTX512.

Maar ik van 'n 8500DV naar X1800XL wel.

X399 Taichi; ThreadRipper 1950X; 32GB; VEGA 56; BenQ 32" 1440P | Gigbyte; Phenom X4 965; 8GB; Samsung 120hz 3D 27" | W2012SER2; i5 quadcore | Mac mini 2014 | ATV 4g | ATV 4K

Dat is wel een hele grote stapSuperG schreef op zaterdag 24 december 2005 @ 08:01:

[...]

Ik heb het over die blueprint die ze naar chip foundery sturen dat is ongeveer in gelijke tijdspanne gebeurt. Dus de implementatie design age. Niet wat het inhoud of het van de grond af nieuw is

.

Onzin? innovatief is een relatief begrip. Die nextgen mem controler is innovatief en ten tweede die innovatie zet ook zoden aan de dijk.

En voor ATI is het 'n heel nieuw design aangezien dit ook hun eerste SM3.0 Architektuur is. Dus geen optimalisatie van 'n oude Design. 'n friss begin meer gericht op de toekomst. Al maakt dit niet veel uit. Iets goeds uitbouwen brengt ook resultaat. Daarnaast het gross van het volk houd hun PC'tje met kaart wel langer dan die ene jaar denk aan 3 á 5. En dan zijn teokomst gerichte features zeker belangrijk.

Zo boeid het niet voor die geek die zijn 7800GT vervangt voor 'n 7800GTX512.

Maar ik van 'n 8500DV naar X1800XL wel.

Edit:

ATi is lekker bezig met dat CCC

[ Voor 9% gewijzigd door Astennu op 24-12-2005 13:45 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Alhoewel uit de geruchten viel op te maken dat de R580 snel zou komen, zou ik me als ik net een R520XT had gekocht, me toch wel een beetje genomen voelen als de R580 inderdaad in goede availability op 24 januari gereleased wordt.

Er zou dan hooguit twee maanden zitten tussen het enigzins available zijn vd R520 en de launch vd R580.

Maar ik ben benieuwd want op zich wil ik mijn huidige kaart wel inruilen tegen die tijd.

De winst tussen een R520XT en de 7800GTX en daarbij in aanmerking genomen de snelle komst van de R580 en de availability/prijs van de 520XT vond ik de 520XT niet interessant genoeg.

De 7800GTX512 heeft geen nieuwe tech en is absurd duur dus dat vond ik ook geen optie.

De R580XT zou daarentegen wel net het verschil kunnen maken. Maar uiteraard vlak ik de opvolger vd G70 ook niet uit.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

XTX ?? waarom niet gewoon XL en XTATI R580 Comes in 3 versions

ATI R580 is still scheduled for launch on 24th January with rapid cards availability on the day of launch, and the official name stays the same: Radeon X1900 series. According to this post there will be 3 flavours at the start: Radeon X1900XT, Radeon X1900XTX maybe a higher clocked version and Radeon X1900XT Crossfire. ATi R580 has 16 pipelines but features 48 shader processors now instead of 16 previously on the R520 therefore some performance boost is expected. X1900 will support Avivo and Shader Model 3.0. The R580 uses a 90nm process and is pin-to-pin compatible to the current R520 PCB, so basically the R520 core can be replaced to the R580 with no modifications needed. The cooling design remains the same as well.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Ik heb al aardig wat levels Farcry met HDR + AA achter de rug, dit maakt heel veel goed.Help!!!! schreef op zaterdag 24 december 2005 @ 14:58:

[...]

Alhoewel uit de geruchten viel op te maken dat de R580 snel zou komen, zou ik me als ik net een R520XT had gekocht, me toch wel een beetje genomen voelen als de R580 inderdaad in goede availability op 24 januari gereleased wordt.

[ Voor 10% gewijzigd door Verwijderd op 24-12-2005 15:12 ]

Nou dat laatste hoop ik niet.Verwijderd schreef op zaterdag 24 december 2005 @ 15:09:

[...]

Ik heb al aardig wat levels Farcry met HDR + AA achter de rug, dit maakt heel veel goed.Eer dat de R580 in de NL winkels ligt zijn we een maand of 3 verder.

En dit keer zijn er imo ook wel aanwijzingen dat de availability beter zou kunnen zijn. Met name doordat het design schijnbaar niet totaal anders is dan de R520 en nog belangrijker, doordat ze voor de R580 wel gewoon de complete designcycle op een normale manier doorlopen hebben.

Ach dit keer ben ik wel redelijk optimistisch over de leverbaarheid.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Idd reken er maar op dat je em begin/half februarie massaal in de winkels hebt liggen. ( Mits hij de 4e week van januarie gelanseerd word. ). Maar ik ga er zekers een halen. Daar na wordt het R600 ( eventueel nog de R590 Die shrink ) En ik gok dat dat wel een half jaar tot jaar duurt.Help!!!! schreef op zaterdag 24 december 2005 @ 15:19:

[...]

Nou dat laatste hoop ik niet.

En dit keer zijn er imo ook wel aanwijzingen dat de availability beter zou kunnen zijn. Met name doordat het design schijnbaar niet totaal anders is dan de R520 en nog belangrijker, doordat ze voor de R580 wel gewoon de complete designcycle op een normale manier doorlopen hebben.

Ach dit keer ben ik wel redelijk optimistisch over de leverbaarheid.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Wanneer kwam de R600?

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Wat waren de specifikatie verbeteringen t.o.v. de R580? Alleen Die shrink?

En even over iets heel anders... die nieuwe OC bios.

Als je die flashed, zijn dan de voltages ook meteen aangepast aan die hogere snelheid of blijven die gewoon wat het stock was?

Ik vraag dit omdat ik voor 700MHz core toch een tikkeltje prik erbij moet doen en ik dat dan standaard wil hebben, anders is het onverkoopbaar of erger... onbootbaar (je weet het niet he)

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Klopt ben beniewd hoe snel dat gaat worden. Maar de R580 kan 200% sneller zijn dan de X1800 XT. Maar dat zal i wel niet zijn

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

prestatie R580 = R530xt / R515pro x R520xt = 5000/2800x 9000 = 16000 punten in 3dmark05Klopt ben beniewd hoe snel dat gaat worden. Maar de R580 kan 200% sneller zijn dan de X1800 XT. Maar dat zal i wel niet zijnMaar de X1800 heeft maar 16 shaders pipes en de R580 heeft er 48 dus als je games hebt die veel shaders gebruiken is i makkelijk 2x zo snel ( en de drivers + game goed mee werken )

Het voordeel van de extra vertex in de X1600xt zal enigzins ongedaan worden gemaakt door de hogere klok van de R580 t.o.v. R530

Nu zal bij dit soort scores de CPU ook wat kunnen drukken, ook de geheugnbandbreedte zal minder opschalen waardoor met een dual-core CPU 15000 haalbaar lijkt.

Om dit even naast de G70/G71 te zetten:

G70 @ 550 haalt 10000.

G71 met 32pipes ( weet niet of dit zo is) is ongeveer 13000

Dit opklokken tot 660Mhz geeft ook 16000.

Echter de G70 heeft nog minder speling qua geheugenbandbreedte aangezien er al 1,1ns gebruikt wordt. De kaart zal met 32pipes, 660Mhz waarschijnlijk niet verder komen dan 14000/14500 o.i.d.

Ben benieuwd hoeveel van deze speculatieronde nog overeind staat over pakweg 2 maanden.

[ Voor 34% gewijzigd door Verwijderd op 24-12-2005 17:32 ]

Trouwens, mijn R520 zal over een week of 2 water gekoeld zijn, maar wat zijn veilige voltage voor water koeling?

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Tja ligt aan de temps rond de 40c zou ik tot 1.5v gaan. mischien 1.6 maar ik denk dat hij dan wel vervelend gaat doen.Tijgert schreef op zaterdag 24 december 2005 @ 17:57:

Beter... eerst zien hoe de prijzen zich gaan verhouden.

Trouwens, mijn R520 zal over een week of 2 water gekoeld zijn, maar wat zijn veilige voltage voor water koeling?

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik heb ze niet gezien. Niemand denkt daar gewoon aan :\ wel vaag.jimbojansen90 schreef op zaterdag 24 december 2005 @ 19:26:

ff vraagje tussendoor.. zijn er nou al X1600 XT Crossfire reviews?! (google niet kunnen vinden)

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Nee, ik had het over de R580 en zijn clockspeeds.Astennu schreef op zaterdag 24 december 2005 @ 15:00:

Ik zal em maar even quoten:

[...]

XTX ?? waarom niet gewoon XL en XTThe Souce had het ook al over zo iets XT en XTX R520. Het zal wel de tegenhanger van de TOP worden.

De normale versies gaan trouwens volgende week al in mass production, en de CF versie van de R580 gaat 2 weken later in mass production.

Owh dan had ik het verkeerd. Ik ben benieuwd over de leverbaarheid. Ik denk dat het deze keer wel goed komt.The Source schreef op zondag 25 december 2005 @ 00:23:

[...]

Nee, ik had het over de R580 en zijn clockspeeds.

De normale versies gaan trouwens volgende week al in mass production, en de CF versie van de R580 gaat 2 weken later in mass production.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Mijn kaart haalt geen hogere snelheiden op 1,5 dan op 1,4, dus voor mij heeft het geen nut. Atitool geeft vanaf 1,45 volt aan dat het gevaarlijk hoog is, ik zou dus voor dagelijks gebruik niet boven de 1,4 gaan (in jouw geval)Astennu schreef op zaterdag 24 december 2005 @ 18:31:

[...]

Tja ligt aan de temps rond de 40c zou ik tot 1.5v gaan. mischien 1.6 maar ik denk dat hij dan wel vervelend gaat doen.

Verwijderd

http://www.driverpack.ru/...category&id=232&Itemid=20

Dit zijn de enige drivers die ik zonder enig gezeik werkend heb gekregen op mijn windows 2003 R2 x64 bak met X850. Alle talen zijn eruit gestript zodat het nog maar 10 MB weegt. Verder wordt het uitstekende ATi Tray Tools meegeleverd.

In tegenstelling tot de Omega's zijn deze er altijd wel gewoon voor 64-bit.

Nja aan gevaarlijk hoog heb ik schijtm277755 schreef op zondag 25 december 2005 @ 01:11:

[...]

Mijn kaart haalt geen hogere snelheiden op 1,5 dan op 1,4, dus voor mij heeft het geen nut. Atitool geeft vanaf 1,45 volt aan dat het gevaarlijk hoog is, ik zou dus voor dagelijks gebruik niet boven de 1,4 gaan (in jouw geval)

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

ik vind het volgende toch iéts realistischerVerwijderd schreef op zaterdag 24 december 2005 @ 17:18:

[...]

prestatie R580 = R530xt / R515pro x R520xt = 5000/2800x 9000 = 16000 punten in 3dmark05

Het voordeel van de extra vertex in de X1600xt zal enigzins ongedaan worden gemaakt door de hogere klok van de R580 t.o.v. R530

Nu zal bij dit soort scores de CPU ook wat kunnen drukken, ook de geheugnbandbreedte zal minder opschalen waardoor met een dual-core CPU 15000 haalbaar lijkt.

Om dit even naast de G70/G71 te zetten:

G70 @ 550 haalt 10000.

G71 met 32pipes ( weet niet of dit zo is) is ongeveer 13000

Dit opklokken tot 660Mhz geeft ook 16000.

Echter de G70 heeft nog minder speling qua geheugenbandbreedte aangezien er al 1,1ns gebruikt wordt. De kaart zal met 32pipes, 660Mhz waarschijnlijk niet verder komen dan 14000/14500 o.i.d.

Ben benieuwd hoeveel van deze speculatieronde nog overeind staat over pakweg 2 maanden.

Let's see if we can't use what we know now to make some estimates...

The X1300PRO is 4 pipes processing 1 pixel each. Gets 3k in 05

The X1600PRO (which I now loathe ) is 4 pipes processing 3 pixels each. Gets 4k in 05 (PROvsPRO because same mem) (33.33% increase in perf)

The R520 is 16 pipes processing 1 pixels each. Gets 8.7k in 05

If the R580 is 16 pipes processing 3 pixels each meaning going from 16x1 (r520) to 16x3 (r580?)....taking into account the increase in 05 score from 4x1 to 4x3, if they both end up having the same memory, the R580 would get 11.6k stock in 05. Thats assuming same clocks and same memory on an average system. (8700 x 1.333333333333)

In a much faster system and assuming higher core and mem clocks than the current XT (both of which are expected), we should see the R580 scoring 12.8k stock in 05. (9600 x 1.33333333333333)

bron: http://www.xtremesystems.org/forums/showthread.php?t=84128

Verwijderd

Leuke schatting, maar ze maken één fout:ik vind het volgende toch iéts realistischer:

Let's see if we can't use what we know now to make some estimates...

The X1300PRO is 4 pipes processing 1 pixel each. Gets 3k in 05

The X1600PRO (which I now loathe ) is 4 pipes processing 3 pixels each. Gets 4k in 05 (PROvsPRO because same mem) (33.33% increase in perf)

The R520 is 16 pipes processing 1 pixels each. Gets 8.7k in 05

If the R580 is 16 pipes processing 3 pixels each meaning going from 16x1 (r520) to 16x3 (r580?)....taking into account the increase in 05 score from 4x1 to 4x3, if they both end up having the same memory, the R580 would get 11.6k stock in 05. Thats assuming same clocks and same memory on an average system. (8700 x 1.333333333333)

In a much faster system and assuming higher core and mem clocks than the current XT (both of which are expected), we should see the R580 scoring 12.8k stock in 05. (9600 x 1.33333333333333)

Ze vergelijken X1600pro met X1300pro omdat ze hetzelfde geheugen hebben, maar ze vergeten dat de X1600pro maar op 500Mhz core loopt en X1300pro op 600Mhz core. Er zit dus nog een omrekenfactor van 600/500 = 1,2 in het voordeel van de X1600

Als we hetzelfde verhaal toepassen van xtremesystems dan is het 4k*1,2/3k = 1,6 (geen 1,33)

1,6* R520 = 1,6* 8700 = 14k

toch wat meer dan 11.6k

X1600Pro @ 500/800 = 3816

X1600Pro @ 600/800 = 3995

X1600Pro @ 500/900 = 4026

X1600Pro @ 600/900 = 4262

Je ziet hier dat een X1600Pro gewoon naar geheugenbandbreedte snakt, terwijl een XT dat eigenlijk niet is omdat-ie 1.4Ghz geheugen heeft.

Over G71 hoor ik nu ook wat andere dingen. Als je The Source's opmerking hoort over dat CATZ-gebeuren en dat het gelijk is aan de G70, dan zou je bijna haast denken dat het gewoon een dieshrink is voor een speedboost. Dus 24 pipes op een veel hogere snelheid. Of eventueel 24 ROPs ipv 16 ROPs. Dit werd ook op bepaalde forums nu geopperd als mogelijkheid.

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

UHmmm interessant. Ik ben ook beneiuwd naar de G71 wat diie nou gaat doen. De R580 is nog wel redelijk in te schatten. Maar het verbaast me dat die X1600 mem als limiet heeft. Ik dacht toch dat de core niet al te snel was. Nu vraag ik me dus af wat er zou gebeuren als die een 256 bit bus had gehad.CJ schreef op maandag 26 december 2005 @ 14:57:

De core van een X1600Pro overklokken van 500 naar 600 Mhz geeft helaas weinig performance boost. Dus dat verhaaltje gaat eigenlijk niet goed op Wagnef. Het geheugen 100 Mhz overklokken geeft een grotere boost..

X1600Pro @ 500/800 = 3816

X1600Pro @ 600/800 = 3995

X1600Pro @ 500/900 = 4026

X1600Pro @ 600/900 = 4262

Je ziet hier dat een X1600Pro gewoon naar geheugenbandbreedte snakt, terwijl een XT dat eigenlijk niet is omdat-ie 1.4Ghz geheugen heeft.

Over G71 hoor ik nu ook wat andere dingen. Als je The Source's opmerking hoort over dat CATZ-gebeuren en dat het gelijk is aan de G70, dan zou je bijna haast denken dat het gewoon een dieshrink is voor een speedboost. Dus 24 pipes op een veel hogere snelheid. Of eventueel 24 ROPs ipv 16 ROPs. Dit werd ook op bepaalde forums nu geopperd als mogelijkheid.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

X1600Pro, 128-bit met 800Mhz geheugen = 12.8GB/s

X1600Pro, 256-bit met 800Mhz geheugen = 25,6GB/s

X1600XT, 128-bit met 1.38Mhz geheugen = 22,1GB/s

Een 256-bit memory interface is eigenlijk alleen leuk als je langzaam geheugen gebruikt en toch veel bandbreedte wilt hebben. Maar het maakt de core wel een stuk ingewikkelder/groter en het PCB een stuk duurder omdat er meer traces van core naar het geheugen moeten worden geplaatst (dus dikker PCB -> duurder). Zoals je ziet heeft een X1600XT al veel bandbreedte om de 4 ROPs mee te voeden. De bottleneck ligt hier bij oudere games verder vooral bij de 4 ROPs en 4 Texture Units.

De X1600Pro mist zoals je ziet gewoon veel aan bandbreedte. De X1600XT heeft daar minder last van (bijna 2x zo veel als de Pro).

X1600Pro CrossFire

2K1 single: 17345, dual: 16254 -> -6,3%

2K3 single: 6982, dual: 9144 -> +31%

2K5 single: 3816, dual: 6451 -> +69,5%

Zoals je ziet, hoe meer shaders, des te beter de X1600 presteert. 2K1 leunde erg op textures. 2K5 is heel erg shadergericht. Single heeft-ie namelijk 4 ROPs, 12 pixelshaderengines. Dual heeft-ie 8 ROPs en 24 pixelshaderengines. De performancetoename neemt dus relatief meer toe bij verdubbeling van de pixelshaderengines in shaderintensieve apps. Als RV560 8 ROPs heeft en 24 pixelshaderengines, dan heb je hier nu ongeveer een leuke inschatting van de performance.

[ Voor 7% gewijzigd door CJ op 26-12-2005 15:51 ]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

3dmark 2006 misschien ?Astennu schreef op maandag 26 december 2005 @ 17:27:

Idd ziet er heel erg goed uit. In de nieuwere games zal de R580 echt veel sneller zijn. Maar ik denk dat je dat niet echt terrug ziet in 3dmark..

Jah msichien wel als ze dan eindelijk eens van die 1024 af gaan stappen. Ik bedoel 3dmark is op het moment van uitkomen meestal voor high end pc's geweest. De mid range konden het meestal niet draaien. Dus bij een 06 high end pc hoort wel 1280.

Maar ik ben benieuwd. Je ziet ook dat games al Fear en B&W 2 heel veel shaders gebruiken. Dus daar kunnen de R580 en de X1600 hun echte kracht laten zien.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Edit:

[ Voor 21% gewijzigd door Upke dupke op 26-12-2005 20:14 ]

Ghehe dat is wel erg ziekUpke dupke schreef op maandag 26 december 2005 @ 20:06:

Er heeft een foto van 3D mark 06 op de website van VR zone gestaan, met als onderschrift dat een 7800 GTX in SLI 11 FPS of zo haalde in de benchmark. Ga na hoe snel de R580 dan zou zijn

Edit:

[afbeelding]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Gemiddelt door cpu limmit jaKrizzie schreef op dinsdag 27 december 2005 @ 01:48:

9*00 naar X*00 was zeker geen 100% sneller, meer in de richting van 50% gemiddeld.

MAar de 9800 XT had 8 pipes 4 vertex @ 412 mhz. Met 380 mhz geheugen

En de X800 XT had 16 pipes 6 vertex @ 500 mhz met 500 MHz geheugen.

En in de echt zwaardere ( toen nieuwe games ) was i zekers wel 2x zo snel. Nu in games als fear en HL2 zal het nog wel meer zijn. Maar het verschil tussen X850 XT en de X1800 XT is stukken kleiner dat is eerder 50% of minder.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

http://www.gamepc.com/lab...tent.asp?id=a8rmvp&page=1There are two aspects which really stood out to me as dynamite features regarding the A8R-MVP. First off, the Radeon Xpress 200 Crossfire Edition runs amazingly cool during heavy loads, much cooler compared to the nForce4 product line. Thus, the board runs completely passively, and only with simple heatsinks (no heatpipes). Thus, the A8R-MVP may appeal to quiet PC users. The chipset’s cool running nature may also apply to another important aspect of the motherboard, it’s overclockability. The A8R-MVP is a fantastic overclocker, and was more tolerant of bus speed and voltage changes compared to any Athlon64 platform we’ve tested in recent memory. This board doesn’t have the appearance of an overclocking champ, nor does Asus boast about this feature, which makes it that much more attractive.

Er gaat bij mij ineens een lampje branden... misschien gaat 3DMark2006 wel de monsterslag voor ATi worden waar CJ het over had, vanwege de extra features die de R(V)5xx nu heeft.Upke dupke schreef op maandag 26 december 2005 @ 20:06:

Er heeft een foto van 3D mark 06 op de website van VR zone gestaan, met als onderschrift dat een 7800 GTX in SLI 11 FPS of zo haalde in de benchmark. Ga na hoe snel de R580 dan zou zijn

We weten allemaal dat de huidige Nvidia-kaarten (6xxx en 7xxx) niet al te sterk zijn in Dynamic Branching (typisch iets SM3.0-achtigs). Als ze bij ATi slim zijn stimuleren ze Futuremark onder het motto van 'next-generation benchmarking', om flink veel Dynamic Branching-code te gebruiken in hun nieuwe bench. En mocht Futuremark nog niet 'overtuigd' zijn, dan gooien ze er misschien wel een flinke zak met dollars tegenaan, wie zal het zeggen? Mocht dit gaan gebeuren, dan weet ik wel wie de vloer aanveegt met wie in 3DMark2006. Tot zover Jejking's glazen bol

O ja, ik hoop ook dat Futuremark die optie disabled waarvan ik de naam even kwijt ben, waardoor Nvidia-kaarten hun werk gewoon normaal doen in plaats van een omweg om de performance op peil te houden. Ik geloof dat anders de performance met iets van 7-10% afneemt

het volgende:

ik heb een deal met een PC zaak; ik ruil mijn Asus 7800GTX 256Mb in tegen een Sapphire Radeon X1800XT 512MB en betaal een klein beetje bij. 100 euries.

Is dat een goeie deal of niet? (Ik krijg de nieuwwaarde voor mijn 7800GTX terug.

En even over het overklokken; klokken die X1800XT 512's een beetje lekker? In welke regionen van kloksnelheden moet ik denken?

En aan wat voor 3Dmark 05 scores?

Bedankt.

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

PCF filtering is een goed alternatief met gelijkaardige resultaten, bovendien ondersteunt de Radeon X1600 en X1300 pcf (de X1800 heeft jammergenoeg niet de volledige ondersteunging, enkel fetch4, misschien kan het met een shader opgelost worden) en alle kaarten van ati die zullen uikomen zullen de feature ook ondersteunen.Jejking schreef op woensdag 28 december 2005 @ 12:10:

[...]

O ja, ik hoop ook dat Futuremark die optie disabled waarvan ik de naam even kwijt ben, waardoor Nvidia-kaarten hun werk gewoon normaal doen in plaats van een omweg om de performance op peil te houden. Ik geloof dat anders de performance met iets van 7-10% afneemtAndere renderingpath vind ik gewoon not done, en zéker niet als Futuremark zichzelf nog een zichzelf-respecterend onafhankelijk benchmarksoftwareproducent wil blijven noemen

.

De R520 architectuur zal waarschijnlijk extra tot zijn recht komen in 3dmark06 die bovendien over enkele maanden gaat uitkomen.

Verwijderd

De meeste XT's doen wel 700/800 en hoger, al dan niet met een aangepaste bios (XTPE bios met iets hogere Vcore). Met jouw CPU score je dan rond de 10K.RappieRappie schreef op woensdag 28 december 2005 @ 12:14:

En even over het overklokken; klokken die X1800XT 512's een beetje lekker? In welke regionen van kloksnelheden moet ik denken?

En aan wat voor 3Dmark 05 scores?

Bedankt.

Tzal mij eens benieuwen of ik veel IQ verschil zie.

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Ik had van iemand gehoord dat de R520 in de nieuwe 3dM tot wel zo'n 2x sneller kon zijn vanwege lange shaders, veel dynamic branching en gebruik van HDR + AA. Maar wellicht dat G71 daar verandering in kan brengen, want er gaat nu een gerucht de ronde dat nVidia nu ook op de ATi tour gaat en ook HDR + AA gaat brengen op de manier zoals ATi dat doet.Jejking schreef op woensdag 28 december 2005 @ 12:10:

[...]

Er gaat bij mij ineens een lampje branden... misschien gaat 3DMark2006 wel de monsterslag voor ATi worden waar CJ het over had, vanwege de extra features die de R(V)5xx nu heeft.

Dan iets anders. C|net heeft een berichtje over de nieuwe Intel 975 chipset die nu dus officieel ook CrossFire ondersteunt, maar geen SLi (net als de 955 chipset).

http://reviews.cnet.com/I...ntium+Extreme+Edition+955The second source of irritation is that the 975X Express chipset currently supports only ATI's CrossFire technology, not Nvidia's SLI. The reason depends on whom you ask. Intel told us it submitted 975X boards to Nvidia for SLI certification; Nvidia maintained that it hadn't received them at the time of this writing. He said, she said aside, all we really know is that it's too bad your PC and component purchasing options are now more confusing because these two vendors haven't found a way to work together.

[ Voor 40% gewijzigd door CJ op 28-12-2005 13:20 ]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Boeien !!! Punt 1 dan, punt 2 is veel intressanterRappieRappie schreef op woensdag 28 december 2005 @ 12:42:

Op zich een wel leuke vooruitgang dan. Van 8200 nu naar 10k straks.

Tzal mij eens benieuwen of ik veel IQ verschil zie.

En welk monster zou dit nu zijn?

http://www.xbitlabs.com/n...splay/20051227220826.html

/edit

Kloks:

- X1900XTX: 650/1550

- X1900XT & CF: 625/1450

450W voeding aanbevolen voor single kaart, 550W voor CF.

[ Voor 29% gewijzigd door XWB op 28-12-2005 13:24 ]

Technical PR Officer @ MSI Europe. My thoughts and opinions may not reflect the ones of my employer.

Verwijderd

Ik heb berekend dat de R580 1.16 x R520 oppervlak heeft. dit betekend ongeveer 370 Miljoen transistors voor de R580. Het verschil vind ik redelijk klein aangezien de R580 veel meer shader-pipes heeft.

Nu je dit ziet begrijp je ook dat de R580 qua kostprijs de R520 zeker kan vervangen en de R520 geen bestaandsrecht meer heeft. Het is dus minimaal 30% meer prestatie met slechts 16% meer transistors

Ook de warmte-afgifte zal hooguit 20% meer zijn waardoor dezelfde koelers van de R520 bruikbaar zijn.

De geheugensnelheden vallen me wat tegen, het is volgens mij nog gewone 1,26ns geheugen. Het 1,1ns zal dan wel schaars zijn.

Als je bedenkt dan de X1600pro 800Mhz geheugen,128 bit en 500Mhz core heeft, en de X1900XTX ongeveer 4x1600pro is qua geheugenbandbreedte, (256 bit 1550Mhz geheugen) dan zou de X1900 vanaf 500Mhz al geheugenbandbreedte tekort hebben.

Uit CJ eerdere post:

Een verklaring is misschien dat de X1600 in verhouding meer vertex-pipes heeft waardoor er meer bandbreedte overblijft voor de X1900XTXX1600Pro @ 500/800 = 3816

X1600Pro @ 600/800 = 3995

X1600Pro @ 500/900 = 4026

X1600Pro @ 600/900 = 4262

[ Voor 39% gewijzigd door Verwijderd op 28-12-2005 13:55 ]

Nja dat geheugen clockt zo 1600 mhz. En vaak nog een heel stuk meer. Dus daar ben ik opzig wel tevreden over. Maar ik denk dat meer memory speed niet overbodig was geweest. Aangezien mijn XL ook al heel veel baat heeft bij een memmory clock van 600 mhz. Maar die extra shaders pipes gaan echt veel helpen in de modernere games. Ik kijk al uit naar de revieuwsVerwijderd schreef op woensdag 28 december 2005 @ 13:40:

Wat wel interresant is, is het verschil in core-oppervlak.

Ik heb berekend dat de R580 1.16 x R520 oppervlak heeft. dit betekend ongeveer 370 Miljoen transistors voor de R580. Het verschil vind ik redelijk klein aangezien de R580 veel meer shader-pipes heeft.

Nu je dit ziet begrijp je ook dat de R580 qua kostprijs de R520 zeker kan vervangen en de R520 geen bestaandsrecht meer heeft. Het is dus minimaal 30% meer prestatie met slechts 16% meer transistors

Ook de warmte-afgifte zal hooguit 20% meer zijn waardoor dezelfde koelers van de R520 bruikbaar zijn.

De geheugensnelheden vallen me wat tegen, het is volgens mij nog gewone 1,26ns geheugen. Het 1,1ns zal dan wel schaars zijn.

Als je bedenkt dan de X1600pro 800Mhz geheugen,128 bit en 500Mhz core heeft, en de X1900XTX ongeveer 4x1600pro is qua geheugenbandbreedte, (256 bit 1550Mhz geheugen) dan zou de X1900 vanaf 500Mhz al geheugenbandbreedte tekort hebben.

Uit CJ eerdere post:

[...]

Een verklaring is misschien dat de X1600 in verhouding meer vertex-pipes heeft waardoor er meer bandbreedte overblijft voor de X1900XTX

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Dus ook FP16blending HDR + AA voor de G71? En die kaart komt in Februari? Zou dit de reden kunnen zijn dat Ubisoft de Farcry HDR+AA patch pas in februari uitbrengt? (volgens sommige komt de patch dus officieël in febr uit)CJ schreef op woensdag 28 december 2005 @ 13:13:

er gaat nu een gerucht de ronde dat nVidia nu ook op de ATi tour gaat en ook HDR + AA gaat brengen op de manier zoals ATi dat doet.

Een andere verklaring zou ik even niet weten daar de beta patch die ik heb alweer dateert uit oktober en gewoon goed werkt. Die patch had er allang officiëel moeten zijn. De X1K eigenaren worden dus gewoon onthouden van HDR in die game.

Oftewel, weer een van de vele game companies die er bij Nvidia tot aan de elleboog in lijkt te zitten.

[ Voor 25% gewijzigd door Verwijderd op 28-12-2005 19:25 ]

Ik wil graag weten of dat ding een dual slot of single slot cooler heeft.

TNX.

(Op de site van Sapphire staat single slot cooler?

[ Voor 18% gewijzigd door Format-C op 28-12-2005 19:32 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

dualRappieRappie schreef op woensdag 28 december 2005 @ 19:31:

Is er iemand die een SAPPHIRE X1800XT 512MB heeft???

Ik wil graag weten of dat ding een dual slot of single slot cooler heeft.

TNX.

(Op de site van Sapphire staat single slot cooler?)

-Ik kan nergens plaatjes van het kreng vinden.

Edit:

En als je dat zegt vindt je hem.

Sorry, luitjes

[ Voor 70% gewijzigd door Format-C op 28-12-2005 19:37 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Even voor de duidelijkheid... ik heb patch 1.4beta hier (dankzij Edward -> thanxVerwijderd schreef op woensdag 28 december 2005 @ 19:13:

Dus ook FP16blending HDR + AA voor de G71? En die kaart komt in Februari? Zou dit de reden kunnen zijn dat Ubisoft de Farcry HDR+AA patch pas in februari uitbrengt? (volgens sommige komt de patch dus officieël in febr uit)

Een andere verklaring zou ik even niet weten daar de beta patch die ik heb alweer dateert uit oktober en gewoon goed werkt. Die patch had er allang officiëel moeten zijn. De X1K eigenaren worden dus gewoon onthouden van HDR in die game.

Oftewel, weer een van de vele game companies die er bij Nvidia tot aan de elleboog in lijkt te zitten.

De 7800GTX is met patch 1.4 beta HDR trouwens nog steeds een stuk sneller dan de X1800XT... de X1800XT roeleert weer in FEAR met AA

Zijn er trouwens meer mensen die problemen hebben met Catalyst 5.13 en OpenGL. Quake4 vertikt het te werken en CCC geeft een error... heb de drivers al 2x opnieuw geinstalleerd, maar ga Q4 nu maar benchen met Cat 5.12

En nog een vraag: hoe moet je ATitool gebruiken op een X1800XT... met Cat 5.13 vertelt die me doodleuk dat "No supported video cards were detected in your system" etc... "Core 0.00" & "Memory 0.00"

En zo ATitool niet kan, wat dan wel?

[ Voor 30% gewijzigd door Cheetah op 28-12-2005 20:45 ]

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ik heb al een ander tooltje (OverClocker).Astennu schreef op woensdag 28 december 2005 @ 21:07:

Ik heb gehoord dat de XT en ATi Tool niet altijd even goed werkt. moet je anders eens op XS of techpowerup forum kijken.

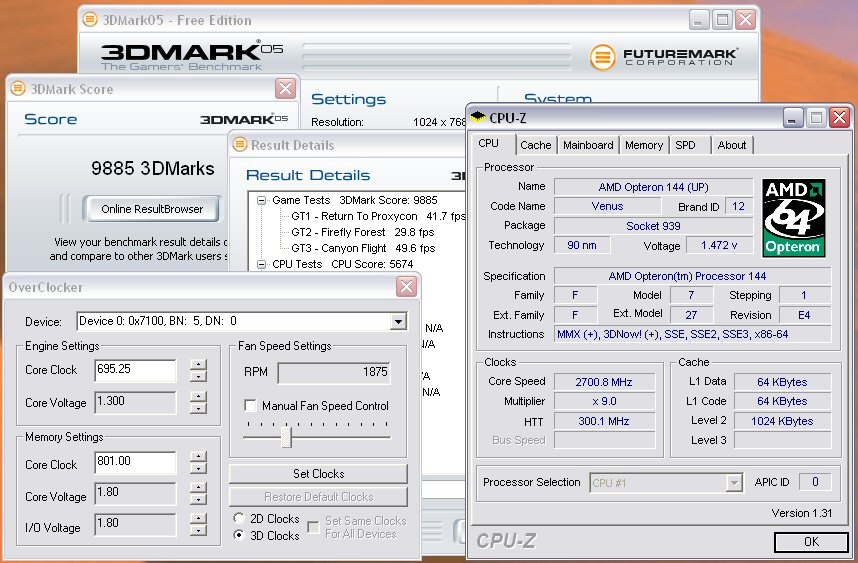

Voor de liefhebbers: eerste 3DMark05 result op 700/800 stock XT voltages

PE bios is dus niet eens nodig...

10k is appeltje eitje

[ Voor 10% gewijzigd door Cheetah op 28-12-2005 21:39 ]

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Very nice!FirefoxAG schreef op woensdag 28 december 2005 @ 21:36:

[...]

Ik heb al een ander tooltje (OverClocker).

Voor de liefhebbers: eerste 3DMark05 result op 700/800 stock XT voltages

PE bios is dus niet eens nodig...

[afbeelding]

10k is appeltje eitje

Waar heb je dat tooltje vandaan? (Edit: http://www.techpowerup.com/downloads/89 )

En hoe warm wordt je XT?

[ Voor 5% gewijzigd door Format-C op 28-12-2005 22:29 ]

Ducati 899 Panigale / CM MB511 RGB/ 7800X3D @ ML360R RGB/ RTX5090 Phantom/ Gbyte B650 GAMING PLUS/ 32GB G.Skill Z5 6000 CL30 / Team M2 1TB/ 990Pro M2 1TB/ MX500 1TB/ 5TB SATA / Gbyte WBAX200/ Corsair 1000w/ Scarlett Solo / AOC AG493UCX/ LG 65" OLED TV

Verwijderd

Ik had dat ook opgemerkt, maar dacht dat dit aan het feit lag dat ik in devmode speelde. Wat ook nog kan is dat de patch een soort cheatmode activeert, "oneindige" minutie is wel lekker voor een "reviewer".HDR etc. doet het gewoon, maar er zijn problemen met de weapon models. Wapens verbruiken geen ammo meer

In ieder geval lijken me dit zaken die bij wijze van spreken binnen 5 minuten op te lossen zijn, maar die patch ligt gewoon ergens onderin een bureaula te verstoffen bij Ubisoft.

[ Voor 6% gewijzigd door Verwijderd op 28-12-2005 22:42 ]

http://tweakers.net/meuktracker/11460

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Erm apple en ik hadden dat al getest en bewezen dat 10k te halen is met 700/800. En het PE bios is makkelijker in gebruik dan elke keer zo'n tooltje runnen....FirefoxAG schreef op woensdag 28 december 2005 @ 21:36:

[...]

Ik heb al een ander tooltje (OverClocker).

Voor de liefhebbers: eerste 3DMark05 result op 700/800 stock XT voltages

PE bios is dus niet eens nodig...

[afbeelding]

10k is appeltje eitje

De nieuwe ATi Tool zal nu ook wel beter werken. En dan kun je mischien ook meteen 1.37v proberenVerwijderd schreef op woensdag 28 december 2005 @ 23:13:

[...]

Erm apple en ik hadden dat al getest en bewezen dat 10k te halen is met 700/800. En het PE bios is makkelijker in gebruik dan elke keer zo'n tooltje runnen....

Edit:

De ARtifact scan lijkt nu ook een stuk beter te werken. Ik zal eens kijken of het nu wel te vertrouwen is en dat je niet met te lage clocks komt te zitten

Edit 2:

Core werkt igg goed. Bij het geheugen geeft i heel snel meldingen terwijl ik op 612 mhz games speel ( al 2 maanden ) Zegt i zelf bij 580 dat er fouten zijn. Voltage verhogingen maakte dit erger. En als ik dat doe kan ik juist verder clocken zonder dar ik probs in games krijg. Dus ik vraag me af of de scan al helemaal goed werkt maar het gaat igg de goede kant op !.

[ Voor 45% gewijzigd door Astennu op 28-12-2005 23:28 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Nope, ik runde al een paar maanden Patch 1.32 in devmode en deze probs ben ik zeker niet tegengekomen... verder functioneren een aantal wapens ook gewoon niet meer (volledig), en dat kan zeker niet de bedoeling zijn...Verwijderd schreef op woensdag 28 december 2005 @ 22:40:

Ik had dat ook opgemerkt, maar dacht dat dit aan het feit lag dat ik in devmode speelde. Wat ook nog kan is dat de patch een soort cheatmode activeert, "oneindige" minutie is wel lekker voor een "reviewer".

Thx, will doAstennu schreef op woensdag 28 december 2005 @ 23:12:

Mensen ATi Tool 0.25 Beta 11 !!! Met wat fixes voor de X1800 XT. Dus proberen maar !!!

http://tweakers.net/meuktracker/11460

<edit> helaas, zelfde error

Excuus, ik bedoelde mijn eerste resultsVerwijderd schreef op woensdag 28 december 2005 @ 23:13:

Erm apple en ik hadden dat al getest en bewezen dat 10k te halen is met 700/800. En het PE bios is makkelijker in gebruik dan elke keer zo'n tooltje runnen....

Het PE bios is in principe ook einde garantie, en daar is die kaart me toch echt een stuk te duur voor. Men kan tegenwoordig zien als die kaarten geflashed zijn door de eindgebruiker, en indien dat het geval is kan warranty worden geweigerd.

<edit2> Aaaaahhhhrg... ongelofelijk frustrerend getal </edit2>

[ Voor 21% gewijzigd door Cheetah op 29-12-2005 01:35 ]

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Ghehe het kan altijd erger. Zoals 9998 of 9999FirefoxAG schreef op donderdag 29 december 2005 @ 00:29:

[...]

Nope, ik runde al een paar maanden Patch 1.32 in devmode en deze probs ben ik zeker niet tegengekomen... verder functioneren een aantal wapens ook gewoon niet meer (volledig), en dat kan zeker niet de bedoeling zijn...

[...]

Thx, will do

<edit> helaas, zelfde error</edit>

[...]

Excuus, ik bedoelde mijn eerste results

Het PE bios is in principe ook einde garantie, en daar is die kaart me toch echt een stuk te duur voor. Men kan tegenwoordig zien als die kaarten geflashed zijn door de eindgebruiker, en indien dat het geval is kan warranty worden geweigerd.

<edit2> Aaaaahhhhrg... ongelofelijk frustrerend getal </edit2>

Edit:

Ik heb net een Asus A8R-MVP besteld als vervanger voor mijn DFI Ultra D. Ik ga toch maar eens een Xpress 200 chipset proberen. En als dat bevalt pak ik strax een RD580 mobo wat wat duurder mag zijn. Wat me opviel is dat ze bij de revieuws vaak oude drivers gebruiken zoals cat 5.1 en de 5.11. Waarom niet gewoon de 5.13? Het is me ook niet echt duidelijk of er veel verander aan die drivers. Nvidia heeft Forceware en Detenator drivers los gekoppeld. Alleen ATi heeft dat allemaal in de Catalyst drivers zitten. Dus ik ben nu wel benieuwd of die Xpress drivers vaak veranderen. Voor de IGP in elk geval wel want die proviteerd gewoon van de vga drivers. Aleen wat wordt er echt aan de chipset verandert ?

[ Voor 25% gewijzigd door Astennu op 29-12-2005 09:37 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Of je upt je 24/7 overclock even met 100mhzAstennu schreef op donderdag 29 december 2005 @ 08:41:

Ghehe het kan altijd erger. Zoals 9998 of 9999. Ik had toen 9222 gehaald. Maar idd nog 1 mhz core er bij en je bent er !!

.

Da's ook ruim voldoende

Hoe test ik dat?Hoe warm wordt jou kaart @ die 700-800 speeds ? in stressed toestand ? door bv RLTHDR.

Mijn 2D clocks staan ook op 702/801 (heb 2D en 3D gelijk getrokken) en hij wordt idle ~55C met alle koeling stock (dus auto), zonder fanspeedverhoging. In game verhoogt hij wel de fanspeed automatisch.

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Er is een programma dat heet RTLHDR. Dat is gewoon een HDR Demo die windowed draaid dus kun je CCC er naast houden of aan andere monitor tool en dan zie je hoe warm die wordt. Die RTLHDR is wel een echte stresstest. Daarmee wordt i net iets warmer dan in games. Ook ATi Tool stressed em heel erg alleen die werkt nog niet bij jou. Dat is wel jammer. En congrats met je 10k scoreFirefoxAG schreef op donderdag 29 december 2005 @ 09:47:

[...]

Of je upt je 24/7 overclock even met 100mhz

Da's ook ruim voldoende

[...]

Hoe test ik dat?

Mijn 2D clocks staan ook op 702/801 (heb 2D en 3D gelijk getrokken) en hij wordt idle ~55C met alle koeling stock (dus auto), zonder fanspeedverhoging. In game verhoogt hij wel de fanspeed automatisch.

Maar welke kaart vind je nu prettiger als je ze vergelijkt ? de GTX TOP of de X1800 TOP ? En dan qua snelheid en immage quality.

[ Voor 3% gewijzigd door Astennu op 29-12-2005 09:55 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Het moederbord dat ik heb is een Asus A8N-SLI Premium. Misschien is het dan toch verstandiger om de videokaart ook van Asus te kopen, of niet?

In principe heb ik met Sapphire ook altijd hele goede ervaringen. Help me out please!

edit: ow ja het prijsverschil tussen beide kaarten is te verwaarlozen. Wel heb ik gelezen dat de Asus Geforce 7800GT net zo goed, en soms beter zal presteren dan de X1800XL.. Als je dan naar de Geforce gaat kijken ben je wel ongeveer 85 euro goedkoper uit.. Iemand die dit kan bevestigen?

[ Voor 25% gewijzigd door Executor16 op 29-12-2005 10:43 ]

Btw verschil tussen ati en sapphire is dat sapphire 2x 400 MHz RAMDAC heeft ipv 1x 400 MHz RAMDAC

[ Voor 13% gewijzigd door Highlandd op 29-12-2005 10:45 ]

Edit:

Mijn fout ja.... ik d8 dat je het over de XT had

[ Voor 17% gewijzigd door Highlandd op 29-12-2005 13:59 ]

over wat heb jij het dan?Dondorp schreef op donderdag 29 december 2005 @ 10:49:

Ik zou als ik jou was niet die GT kopen, aangezien die 256mb heeft ipv 512 en dat maakt meestal wel een groot verschil, vooral bij straks als de nieuwe spellen komen

de ATI X1800XL en de Geforce 7800GT hebben allebei 256mb hoor

Maakt niet veel uit. Mischien dat je bij asus nog 1.4 ns mem er onder hebt zitten. bij Sapphire is dit in elk geval al 2.0. Maar volgens mij worden alle kaarten door sapphire gemaakt. Maar Asus staat er wel om bekend dat ze hun eigen kaarten maken. Maar ik zou de asus proberen als ik jou was alleen maar in de hoop betere chips te hebbenExecutor16 schreef op donderdag 29 december 2005 @ 10:35:

Ik zit heel erg te twijfelen tussen een Asus X1800 XL en een Sapphire X1800XL. Het enige verschil dat ik kan vinden is geloof ik dat de Asus 2 vga outs heeft en de Sapphire maar 1. En hoe het met TV-Out zit weet ik ook niet precies.

Het moederbord dat ik heb is een Asus A8N-SLI Premium. Misschien is het dan toch verstandiger om de videokaart ook van Asus te kopen, of niet?

In principe heb ik met Sapphire ook altijd hele goede ervaringen. Help me out please!

edit: ow ja het prijsverschil tussen beide kaarten is te verwaarlozen. Wel heb ik gelezen dat de Asus Geforce 7800GT net zo goed, en soms beter zal presteren dan de X1800XL.. Als je dan naar de Geforce gaat kijken ben je wel ongeveer 85 euro goedkoper uit.. Iemand die dit kan bevestigen?

ATi zelf maakt na genoeg geen kaarten alleen voor USA en Cannada. En dat zijn er maar heel weinig. De meeste worden door Sapphire gemaakt en die hebben allemaal 2x400 MHZ DAC zo ver ik weet.Dondorp schreef op donderdag 29 december 2005 @ 10:43:

Ik heb nu een nieuwe Sapphire Radeon X1800 XT 512 MB besteld maar ik vraag me nu af hoe goed die leverbaarheid is. Bij salland staat namelijk dat de levertijdindicatie langer dan 10 werkdagen is. Dat is toch ruim 10 dagen (heb hem 6 dagen gelden besteld) maar er staat nog steeds geen datum wanneer zij hem verwachten. Weet iemand dat dus?

Btw verschil tussen ati en sapphire is dat sapphire 2x 400 MHz RAMDAC heeft ipv 1x 400 MHz RAMDAC

GT ??? Dan heb je het over een 6600/6800/7800 of een X800 maar niet X1800Dondorp schreef op donderdag 29 december 2005 @ 10:49:

Ik zou als ik jou was niet die GT kopen, aangezien die 256mb heeft ipv 512 en dat maakt meestal wel een groot verschil, vooral bij straks als de nieuwe spellen komen

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Een Sapphire heeft ook 2x VGA out, echter denk ik 2x DVI of 1x DVI en 1x VGA.Executor16 schreef op donderdag 29 december 2005 @ 10:35:

Ik zit heel erg te twijfelen tussen een Asus X1800 XL en een Sapphire X1800XL. Het enige verschil dat ik kan vinden is geloof ik dat de Asus 2 vga outs heeft en de Sapphire maar 1. En hoe het met TV-Out zit weet ik ook niet precies.

Het moederbord dat ik heb is een Asus A8N-SLI Premium. Misschien is het dan toch verstandiger om de videokaart ook van Asus te kopen, of niet?

In principe heb ik met Sapphire ook altijd hele goede ervaringen. Help me out please!

edit: ow ja het prijsverschil tussen beide kaarten is te verwaarlozen. Wel heb ik gelezen dat de Asus Geforce 7800GT net zo goed, en soms beter zal presteren dan de X1800XL.. Als je dan naar de Geforce gaat kijken ben je wel ongeveer 85 euro goedkoper uit.. Iemand die dit kan bevestigen?

De Sapphire X1800XL kost nog maar 350E, en de Asus? Zo'n 7800GT kost toch geen 270 euro?!?

De X1800XT TOP van ASus is gewoon op voorraad bij oa Informatique: http://www.informatique.n...p.cgi?M=I&A=121964&FRS=ONDondorp schreef op donderdag 29 december 2005 @ 10:43:

Ik heb nu een nieuwe Sapphire Radeon X1800 XT 512 MB besteld maar ik vraag me nu af hoe goed die leverbaarheid is. Bij salland staat namelijk dat de levertijdindicatie langer dan 10 werkdagen is. Dat is toch ruim 10 dagen (heb hem 6 dagen gelden besteld) maar er staat nog steeds geen datum wanneer zij hem verwachten. Weet iemand dat dus?

Btw verschil tussen ati en sapphire is dat sapphire 2x 400 MHz RAMDAC heeft ipv 1x 400 MHz RAMDAC

De Gewone non-top XT 512 Bij meer bedrijven, Zercom/4Launch hebben ze iig zeker

http://www.zercom.nl//ind...30&c=2005&f=1&s=1&a=15628

[ Voor 29% gewijzigd door Pubbert op 29-12-2005 11:52 ]

╔╗╔═╦╗

║╚╣║║╚╗

╚═╩═╩═╝

Neeh idd die kost ook 370-380 euro. En veel sneller is i niet. De X1800 XL kan prima mee kopen en heeft ( vind ik )Betere immage quality. En met een beetje geluk clock je bijna XT speeds. Dus ik zou voor de X1800 XL gaan met een veel grotere feature set.Thund3r schreef op donderdag 29 december 2005 @ 11:34:

[...]

Een Sapphire heeft ook 2x VGA out, echter denk ik 2x DVI of 1x DVI en 1x VGA.

De Sapphire X1800XL kost nog maar 350E, en de Asus? Zo'n 7800GT kost toch geen 270 euro?!?

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Na wat lezen en zoeken ga ik toch 100% voor de X1800XL. Nu is mijn vraag nog steeds: Zal ik de Sapphire kopen of de Asus. Mijn ervaringen met Sapphire zijn erg goed maar aangezien ik een Asus mobo heb klinkt het goed als je ook een Asus videokaart hebtAstennu schreef op donderdag 29 december 2005 @ 11:37:

[...]

Neeh idd die kost ook 370-380 euro. En veel sneller is i niet. De X1800 XL kan prima mee kopen en heeft ( vind ik )Betere immage quality. En met een beetje geluk clock je bijna XT speeds. Dus ik zou voor de X1800 XL gaan met een veel grotere feature set.

Je raad 't nooit... ik start ATitool zojuist weer op om de artifacttester te proberen, en nu detecteert ie m'n kaart plotseling welAstennu schreef op donderdag 29 december 2005 @ 09:55:

Er is een programma dat heet RTLHDR. Dat is gewoon een HDR Demo die windowed draaid dus kun je CCC er naast houden of aan andere monitor tool en dan zie je hoe warm die wordt. Die RTLHDR is wel een echte stresstest. Daarmee wordt i net iets warmer dan in games. Ook ATi Tool stressed em heel erg alleen die werkt nog niet bij jou. Dat is wel jammer.

Thx... alleen moet ik daarvoor met de voltages lopen prutsen en daar heb'k niet zo'n zin inEn congrats met je 10k scoreop naar de 11

Ik heb net wel even lopen testen, en het lijkt er op dat 730/830 op stock volts (1.3core, 1.8mem) te doen moet zijn, dus deze zou met voltageaanpassingen keihard moeten kunnen gaan

Mja, ik zit heel erg te twijfelen.Maar welke kaart vind je nu prettiger als je ze vergelijkt ? de GTX TOP of de X1800 TOP ? En dan qua snelheid en immage quality.

In veel games die ik momenteel gebruik is de 7800GTX TOP op 1920x1200 vaak sneller (AoE III HDR, FarCry HDR, SS2 HDR). In FEAR ruled de X1800XT echter weer, die is op 4xAA even snel als de TOP op 2xAA, en de TOP dipt behoorlijk op 4xAA (X1800XT @1920x1200 4xAA 34fps AVG, 7800GTX TOP 22fps AVG: verschil >50%). En dat op de standaard 625/1500.

Ik ga later nog wat runs doen op 700/800...

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Zoals ik al zij een paar posts terrug. Ga voor de ASUS in de hoop dat je daar 1.4 ns mem modules hebt en mischien een goed clockende core. Want de Sappire hebben igg 2.0 en slechter kan het niet worden dan 2.0 nsExecutor16 schreef op donderdag 29 december 2005 @ 11:40:

[...]

Na wat lezen en zoeken ga ik toch 100% voor de X1800XL. Nu is mijn vraag nog steeds: Zal ik de Sapphire kopen of de Asus. Mijn ervaringen met Sapphire zijn erg goed maar aangezien ik een Asus mobo heb klinkt het goed als je ook een Asus videokaart hebt

730-830 is erg leukFirefoxAG schreef op donderdag 29 december 2005 @ 11:42:

[...]

Je raad 't nooit... ik start ATitool zojuist weer op om de artifacttester te proberen, en nu detecteert ie m'n kaart plotseling wel

[...]

Thx... alleen moet ik daarvoor met de voltages lopen prutsen en daar heb'k niet zo'n zin in

Ik heb net wel even lopen testen, en het lijkt er op dat 730/830 op stock volts (1.3core, 1.8mem) te doen moet zijn, dus deze zou met voltageaanpassingen keihard moeten kunnen gaan

[...]

Mja, ik zit heel erg te twijfelen.

In veel games die ik momenteel gebruik is de 7800GTX TOP op 1920x1200 vaak sneller (AoE III HDR, FarCry HDR, SS2 HDR). In FEAR ruled de X1800XT echter weer, die is op 4xAA even snel als de TOP op 2xAA, en de TOP dipt behoorlijk op 4xAA (X1800XT @1920x1200 4xAA 34fps AVG, 7800GTX TOP 22fps AVG: verschil >50%). En dat op de standaard 625/1500.

Ik ga later nog wat runs doen op 700/800...

Die HDR problemen zijn bekend SS2 dropt echt giga op me X1800. Maar dit kan mischien nog wel gefixt worden. Ik heb het idee dat het toch een beetje komt doordat alles op Nvidia hardware is geschreven. Vooral TWTBP games. En vaag genoeg doen de ATi titels het soms ook super slecht. Dus er is nog veel werkt aan de winkel. Maar wel interessant is dat Far Cry met 1.4 een grote Peformance bump krijgt in HDR en daar zie je toch dat er ook door de game makers veel gedaan kan worden om de X1800 sneller te laten lopen.

Maar wat vind je gewoon van de immage quality als je niet kijkt naar de FPS ? met HQ AF en dat soort dingen ? Hoe heb je die eigenlijk staan ? want HQ af staat soms standaard al aan. in de 5.13 volgens mij niet maar ik heb het wel eens gehad dat ik dacht van huh fps is een stuk lager

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Niet op voorraad.

Thx voor de tip, zojuist geinstalleerdedward2 schreef op donderdag 29 december 2005 @ 12:37:

patch 2.066 oid voor SS2 nemen.(maarja daar is geen..... voor he)

De artifacts zijn inderdaad gefixed. Aan de HDR performance is helaas niets veranderd...

Ik probeer de benches eerlijk te houden (nV Quality, ATi Balanced), dus ik heb de high-end features als HQ AF niet aanstaan tijdens het benchmarkenAstennu schreef op donderdag 29 december 2005 @ 12:13:

Maar wat vind je gewoon van de immage quality als je niet kijkt naar de FPS ? met HQ AF en dat soort dingen ? Hoe heb je die eigenlijk staan ? want HQ af staat soms standaard al aan. in de 5.13 volgens mij niet maar ik heb het wel eens gehad dat ik dacht van huh fps is een stuk lager

Ik game trouwens sowieso op een resolutie (1920x1200) waarop je vaak wat image quality moet opofferen

[ Voor 52% gewijzigd door Cheetah op 29-12-2005 13:30 ]

ASUS Max IV GENE-Z, Core i7 3770k, 16GB Kingston HyperX DDR3-1600, EVGA GTX970 FTW

Crucial M550 512GB SSD, 2TB WD HDD, LG GGW-H20L Blu/HD, Panasonic 40" AX630 UHD

Full Specz

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Dat is normaal je hebt een 2.6 En Firefox draaide met een 2.8 ghz opteron dus ook 1 mb cache tov 512 van de venice.Tijgert schreef op donderdag 29 december 2005 @ 13:54:

Darn, op een 2.6GHz Venice krijg ik met 725/825 'slechts' 9644 marks... raar hoor dat anderen dan over de 10K gaan... Ik wacht wel even op mijn Opty165 en tot ik 5.13 geinstalleerd heb...

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

![]() Dit topic is gesloten.

Dit topic is gesloten.

![]()

/u/34200/crop6554f56fe2075_cropped.png?f=community)

:strip_exif()/u/51038/okyahsaltozwaai.gif?f=community)

:strip_icc():strip_exif()/u/10014/assassin.jpg?f=community)

:strip_icc():strip_exif()/u/70924/crop592049be1128e_cropped.jpeg?f=community)

:strip_exif()/u/14387/Animation-2.gif?f=community)

:strip_icc():strip_exif()/u/42999/kamikaze.jpg?f=community)

:strip_exif()/u/5079/tweak.gif?f=community)

:strip_icc():strip_exif()/u/143173/0165574c.jpg?f=community)

/u/400/defember100.png?f=community)

/u/46804/crop5f989efcbb253.png?f=community)

:strip_icc():strip_exif()/u/78239/housecoolingintel.jpg?f=community)

:strip_icc():strip_exif()/u/182/crop66d4984812e9a_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/136848/rsz_pure2.jpg?f=community)

/u/139379/format-c.png?f=community)

:strip_exif()/u/50018/evil2.gif?f=community)

:strip_icc():strip_exif()/u/109762/crop63cfada0dde8a_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/22169/crop6668149e82e90_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/57026/drag0nico.jpg?f=community)

:strip_icc():strip_exif()/u/7205/duke3.jpg?f=community)