En toch zijn ze efficienter dan de Pascal kaarten...enchion schreef op maandag 24 september 2018 @ 02:03:

[...]

Is niet moeilijk als de helft van de transistors er alleen maar op zitten als heatspreader.

Daarnaast heb je ook nog de fast-startup bug etc. En dan ook nog gerenommeerde merken zoals Asus die een inferieure versie van Vega maken.DaniëlWW2 schreef op zondag 23 september 2018 @ 23:11:

[...]

Ik heb het helemaal niet over de RTX2080, dat is waarschijnlijk een verloren zaak, maar de RTX2070.

Dat is een chip met 78% van de traditionele shaders en rasterization van de RTX2080. Uitgaande van lineaire schaling zit die al dichtbij een GP104 of Vega 10. Vega 10 benchmarks zijn dan ook nog eens misleidend omdat vrijwel iedereen een Vega makkelijk efficiënter en sneller kan maken met undervolting. Als ze bij de RTG stoppen met hun 1200mv waanzin en de chips op 1000mv binnen, dan krijg je veel zuinigere en snellere producten.

Helaas komt Vega met een handleiding, maar een goede variant zoals Sapphire of Powercolor is daarna echt wel sneller dan de 1080. Helaas zijn er weinig reviewers die bekend zijn met de hele handleiding.

[ Voor 3% gewijzigd door DoubleYouPee op 24-09-2018 10:35 ]

De 8800GT is denk ik niet representatief meer voor hoe zaken nu gaan.Paprika schreef op zondag 23 september 2018 @ 23:20:

[...]

Om te beginnen wil ik even zeggen dat ik het niet volledig met je oneens ben, maar dat de schade volgens mij wel meevalt. NVIDIA heeft bewust een kaart (RTX2080) uitgebracht waarvoor er praktisch gezien directe concurrentie is van de goedkopere GTX2080Ti. Ik zie 't zo gebeuren dat ze een 8800GT-achtige kaart zouden uitbrengen die praktisch gezien hun hele line-up te niet doet, als dat is wat nodig is om over de hele markt te winnen.

Die chip kwam een halfjaar na de 8800GTS/GTX/Ultra/whatever op 65nm i.p.v 90nm. Dat was alleen een heel andere periode. Tape-out van een volledig nieuwe chip koste enkele tientallen miljoenen en G92 was niet radicaal anders dan G80. Het zal Nvidia waarschijnlijk niet eens $20 miljoen hebben gekost om G92 productie gereed te maken. G92b kwam er ook al snel achteraan op 55nm. Aangezien 55nm niet eens een volwaardig nieuw productieproces was, zal het nog goedkoper zijn geweest om G92 productie gereed te maken voor 55nm. Nvidia ging toen in anderhalf jaar van G80 op 90nm, via G92 op 65nm naar G92b op 55nm. Dat is ondenkbaar nu.

Voor een tape-out van een 7nm chip zal je honderden miljoenen dollars moeten betalen. Nvidia heeft gekozen voor drie aparte chips die RT cores hebben, en vermoedelijk nog een vierde zonder RT cores. Drie van die chips zijn ook nog eens groot, eentje is een monster 754mm2 monster. Wil je de 8800GT kant op dan zal je TU-102 moeten overzetten naar 7nm. Is het nog steeds een chip die waarschijnlijk over de 500mm2 zit. Absoluut geen mainstream materiaal.

De hele lijn productie gereed maken voor 7nm zal Nvidia waarschijnlijk meer dan $1 miljard kosten. En voor wat? Het blijven nog steeds grote chips en 7nm is ook veel kostbaarder om op te produceren. Daarnaast heb je veel, veel meer engineers nodig aan de kant van Nvidia voor elke chip. Het tweede artikel spreekt over 500 manjaren voor een midrange 7nm SoC terwijl een 16/12nm nog 200 manjaren was en 28nm was 100 manjaren.

Turing is dan ook alles behalve gemiddeld als chip. Om deze chips binnen een jaar naar 7nm te krijgen heb je duizenden zeer hoog gekwalificeerd personeel nodig. Nvidia zal haar personeelsbestand van engineers die werken aan tape-outs ruim moeten verdubbelen om het te bereiken in een jaar. Doe je er langer over, dan is het zinloos omdat de volgende generatie er dan aan zit te komen en je alleen maar deze nieuwe architectuur in de weg gaat zitten omdat duizenden mensen op de oude architectuur zitten. Dit gaat ook allemaal ten koste van R&D capaciteit of uitstel van andere lijnen zoals de volgende Deep Learing architectuur die er ongetwijfeld aan zit te komen om GP100 en GV100 af te lossen. Dat is de prioriteit van Nvidia, en die zie ik ze echt niet uitstellen omdat Turing naar 7nm moet.

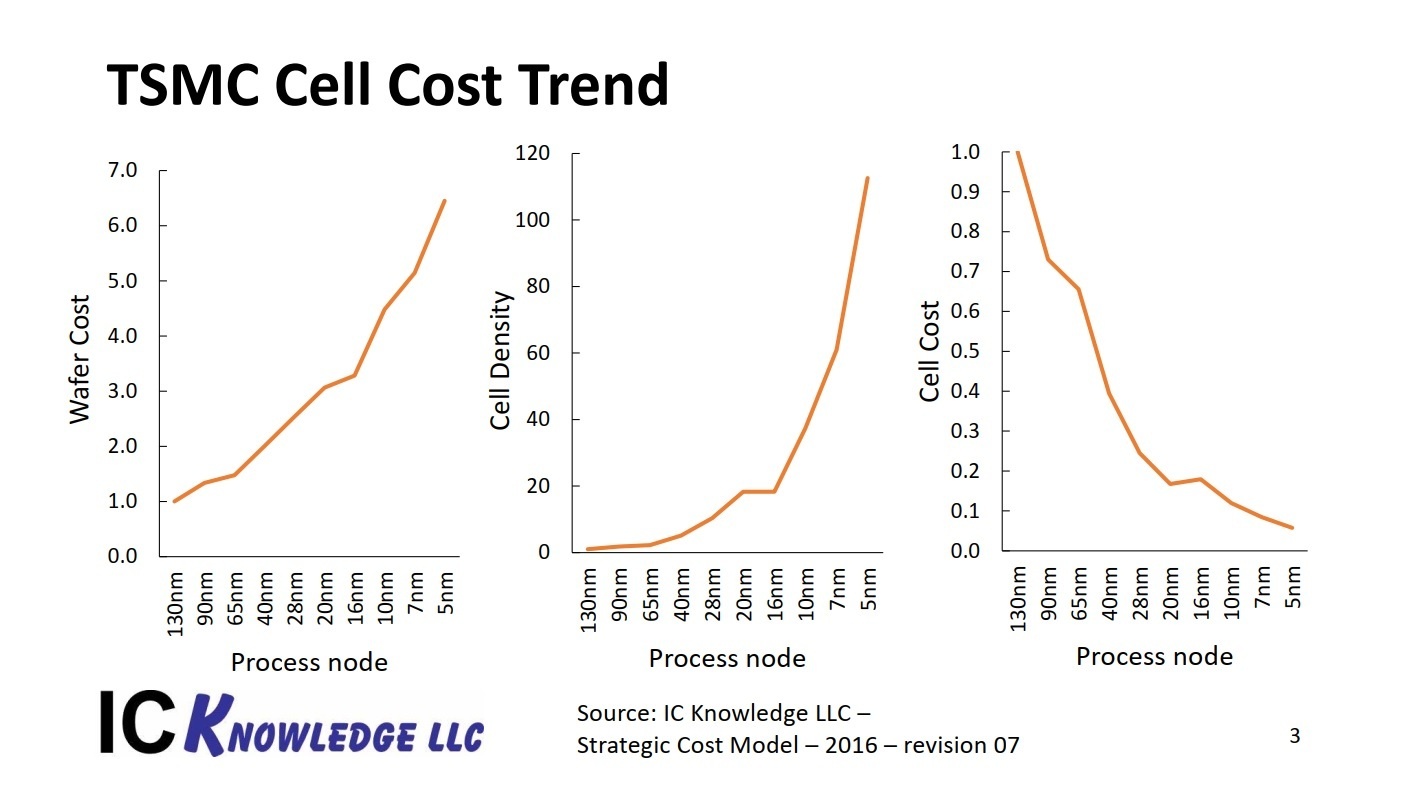

Nog even plaatje voor de kosten per wafer.

Zie ook:

https://semiengineering.com/how-much-will-that-chip-cost/

https://semiengineering.com/10nm-versus-7nm/

https://www.semiwiki.com/...-process-cost-trends.html

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

En dan kom je dus weer terug bij de RTX2070 kannibaliseren. Dat kan Nvidia niet doen omdat ze vol inzetten op RTX en dan hun eigen RTX producten gigantische uit de markt gaan prijzen met een vergelijkbaar presterende videokaart als de RTX2070, maar dan zonder RT cores.Paprika schreef op maandag 24 september 2018 @ 11:34:

@DaniëlWW2 uiteraard zou ik dat geval die kaart geen RTX ondersteuning hebben. Dat heeft de concurrerende AMD kaart namelijk ook niet.

De RTX2070 zal waarschijnlijk tussen de €600 en €700 gaan kosten, en om daar nu een vergelijkbaar presterende kaart van €300 naast te zetten lijkt me niet verstandig als het hele punt van Turing het pushen van ray tracing is.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

De MSRP is $ 499,-, dus laten we hopen van niet, of beter gezegd, laat Nvidia hopen van niet, want als de 2070's boven de € 599,- gaan kosten zijn ze mij iig voor eeuwig kwijt als klant. (en ik denk niet dat ik alleen sta).DaniëlWW2 schreef op maandag 24 september 2018 @ 11:47:

[...]

En dan kom je dus weer terug bij de RTX2070 kannibaliseren. Dat kan Nvidia niet doen omdat ze vol inzetten op RTX en dan hun eigen RTX producten gigantische uit de markt gaan prijzen met een vergelijkbaar presterende videokaart als de RTX2070, maar dan zonder RT cores.

De RTX2070 zal waarschijnlijk tussen de €600 en €700 gaan kosten, en om daar nu een vergelijkbaar presterende kaart van €300 naast te zetten lijkt me niet verstandig als het hele punt van Turing het pushen van ray tracing is.

Persoonlijk denk ik dan ook dat zodra er games uitkomen die DLSS/RT gaan ondersteunen, en de meerwaarde gaat meetellen, ze prima een gekannibaliseerde 2070 zónder DLSS/RT kunnen gaan uitbrengen voor minder, als goedkope tegenhanger, zonder dat hun high-end daar veel onder te lijden zal hebben.

@DaniëlWW2 hieronder: totdat mensen massaal Nvidia FE gaan kopen direct van nvidia's site (2070 € 639,- 2080 € 849,- op moment van schrijven) en de winkel verkopen zo erg tegenvallen dat iedereen massaal prijsverlagingen gaat doorvoeren ja, is natuurlijk niet houdbaar deze prijzen.

[ Voor 25% gewijzigd door zion op 24-09-2018 13:32 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Tja de RTX2080 heeft een MSRP van $699/$799 en ze kosten tussen de €850+ (een uitzondering op het moment) en €1000+. €600+ is denk ik zeer realistisch.zion schreef op maandag 24 september 2018 @ 13:14:

[...]

De MSRP is $ 499,-, dus laten we hopen van niet, of beter gezegd, laat Nvidia hopen van niet, want als de 2070's boven de € 599,- gaan kosten zijn ze mij iig voor eeuwig kwijt als klant. (en ik denk niet dat ik alleen sta).

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

In Duitsland heb je genoeg keuze tussen de 825 en 900 euro. Als je dat doorrekent vanaf $799 (680 euro, met btw dus vanaf 825) klopt dat wel. Dus reken maar 615 euro of meer voor een 2070. Doei zion!

799*0,85*121%=821,75Paprika schreef op maandag 24 september 2018 @ 13:31:

In Duitsland heb je genoeg keuze tussen de 825 en 900 euro. Als je dat doorrekent vanaf $799 (680 euro, met btw dus vanaf 825) klopt dat wel. Dus reken maar 615 euro of meer voor een 2070. Doei zion!

499*0,85*121%=513,25

What's your point?

@Paprika Hieronder, je spreekt jezelf tegen, de 2080 zit dus vanaf MSRP tot € 75 hoger, maar bij de 2070 zou het opeens vanaf € 125 hoger beginnen?

Je kan je reactie wel snel wijzigen, maar goed laat maar, doeg Vipeax!

[ Voor 22% gewijzigd door zion op 24-09-2018 13:42 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Die MSRP is nooit van toepassing geweest, zie ook Pascal... Je rekent met $799 voor de 2080, dan moet je ook rekenen met $599 voor de 2070. Geen enkele partner gaat een kaart uitbrengen voor dat fictieve MSRP bedrag.

@zion, de MSRP van de RTX2070 FE is gewoon $599, die van de RTX2080 is $799 en de RTX 2080 TI is $1199. Geen enkele vendor brengt kaarten uit onder de FE prijs. Dat was met Pascal het geval en gaat nu weer gewoon het geval zijn. Je berekening zou dus gewoon als volgt moeten zijn:

599*0.85*1.21 = 615 euro.

Die doei is vanuit NVIDIA perspectief. Niet direct zo beledigd zijn omdat je zelf zegt nooit een NVIDIA kaart te gaan kopen...

@zion, de MSRP van de RTX2070 FE is gewoon $599, die van de RTX2080 is $799 en de RTX 2080 TI is $1199. Geen enkele vendor brengt kaarten uit onder de FE prijs. Dat was met Pascal het geval en gaat nu weer gewoon het geval zijn. Je berekening zou dus gewoon als volgt moeten zijn:

599*0.85*1.21 = 615 euro.

Die doei is vanuit NVIDIA perspectief. Niet direct zo beledigd zijn omdat je zelf zegt nooit een NVIDIA kaart te gaan kopen...

[ Voor 115% gewijzigd door Paprika op 24-09-2018 13:43 ]

Inno3D is een beetje een vreemde hoor omdat ze net onder de FE MSRP zitten als je het omrekent.Paprika schreef op maandag 24 september 2018 @ 13:36:

Die MSRP is nooit van toepassing geweest, zie ook Pascal... Je rekent met $799 voor de 2080, dan moet je ook rekenen met $599 voor de 2070. Geen enkele partner gaat een kaart uitbrengen voor dat fictieve MSRP bedrag.

pricewatch: Inno3D GeForce RTX 2080 X2 OC

Zou trouwens wel een review van die willen zien. Kaart lijkt gewoon no nonsense te zijn met een fatsoenlijk hitteblok.

Maar ik zie zelfs Inno3D geen RTX2070 voor (veel) minder dan €600 lanceren. Misschien naar verloop van tijd dat je "budgetexemplaren" gaat krijgen voor €550. Of die goed zijn is een tweede.

[ Voor 3% gewijzigd door DaniëlWW2 op 24-09-2018 13:48 ]

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

In Duitsland doen ze het nog ietsje beter, maar ook daarmee ga je 't niet redden.DaniëlWW2 schreef op maandag 24 september 2018 @ 13:48:

[...]

Inno3D is een beetje een vreemde hoor.

pricewatch: Inno3D GeForce RTX 2080 X2 OC

Zie edit.Paprika schreef op maandag 24 september 2018 @ 13:48:

[...]

In Duitsland doen ze het nog ietsje beter, maar ook daarmee ga je 't niet redden.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Het meest belachelijke is nog wel dat die X2 goedkoper is dan hun eigen Jet Edition (blower fan) en ook goedkoper is dan de Turbo (blower fan) van ASUS.

Op de Nederlande site is ie nu geplaatst als zijnde 639,00 overigens.

[ Voor 17% gewijzigd door Paprika op 24-09-2018 14:16 ]

Misschien zijn die blower versies wel heel erg goed.Paprika schreef op maandag 24 september 2018 @ 14:01:

[...]

Het meest belachelijke is nog wel dat die X2 goedkoper is dan hun eigen Jet Edition (blower fan) en ook goedkoper is dan de Turbo (blower fan) van ASUS.

Moet ook wel opmerken dat ik de productnamen "Jet Edition" en "Turbo" uitstekend gekozen vind.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

De Finnen zijn er helemaal slecht aan toe (24% belasting).

Tja voor deze prijzen lekker links laten liggen 2e hands een 1080 Ti /1080/ 1070 TI / Vega 64 scoren zo lang het nog kan. Al zullen die ook snel weg zijn (in het geval van de 1080 Ti) omdat niet veel mensen dit soort bedragen over hebben voor zo weinig winst qua prestaties.

[ Voor 10% gewijzigd door Astennu op 24-09-2018 14:24 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Ind, mensen zien niet dat de enige kaart die sneller is dan pascal de 2080TI is, en die kost €1200+ en voor de custom varianten kan je er wel vanuit gaan dat ook die dik over de €1000 gaat kosten. Dus ind is de enige keuze de GTX 1080TI aan te schaffen of een Vega 64.Astennu schreef op maandag 24 september 2018 @ 14:23:

Tja voor deze prijzen lekker links laten liggen 2e hands een 1080 Ti /1080/ 1070 TI / Vega 64 scoren zo lang het nog kan. Al zullen die ook snel weg zijn (in het geval van de 1080 Ti) omdat niet veel mensen dit soort bedragen over hebben voor zo weinig winst qua prestaties.

DaniëlWW2 schreef op maandag 24 september 2018 @ 13:48:

[...]

Inno3D is een beetje een vreemde hoor omdat ze net onder de FE MSRP zitten als je het omrekent.

pricewatch: Inno3D GeForce RTX 2080 X2 OC

Zou trouwens wel een review van die willen zien. Kaart lijkt gewoon no nonsense te zijn met een fatsoenlijk hitteblok.

Maar ik zie zelfs Inno3D geen RTX2070 voor (veel) minder dan €600 lanceren. Misschien naar verloop van tijd dat je "budgetexemplaren" gaat krijgen voor €550. Of die goed zijn is een tweede.

offtopic:

Ik heb een 1080Ti van Inno3D en het is volgens mij een solide merk. Ik was eerst een beetje huiverig en mijn EVGA GTX 980 was me erg goed bevallen. Maar de koeler doet het prima en hij boost naar de 2GHz wanneer de Powerlimit wordt verhoogd naar 115%. De kaart wordt dan ~80C. Hij laat zich alleen niet heel erg veel extra overclocken, maar dat is meer afhankelijk van de silicon lottery.

Ik heb een 1080Ti van Inno3D en het is volgens mij een solide merk. Ik was eerst een beetje huiverig en mijn EVGA GTX 980 was me erg goed bevallen. Maar de koeler doet het prima en hij boost naar de 2GHz wanneer de Powerlimit wordt verhoogd naar 115%. De kaart wordt dan ~80C. Hij laat zich alleen niet heel erg veel extra overclocken, maar dat is meer afhankelijk van de silicon lottery.

Ryzen 7 9800X3D | ROG STRIX B650E-F | RTX 5080 AMP | 32GB G.Skill 6000Mhz C30 | Noctua NH-U12A | Samsung 990 Pro 1TB | Samsung 990 Pro 2TB | WD Red Plus 6TB | O11 Dynamic Evo | Corsair RM1000x

Jammer, was zaterdag in Polen (2070: PZ 2799,- / € 650,85), ben vrijdag in Zweden (2070: SEK 6899,- / € 666,69) en volgende week in Spanje (2070: € 639,-), dus, doei! NvidiaPaprika schreef op maandag 24 september 2018 @ 14:18:

[Afbeelding]

De Finnen zijn er helemaal slecht aan toe (24% belasting).

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Volgens mij zeggen alle reviews een beetje hetzelfde:

1: Een mooie architectuur

2: + voor de nieuwe technieken

3: DLSS veelbelovend

4: Te langzaam voor RTX aan de hand van wat ze gezien hebben bij de demo's

5: Er zijn nog geen games beschikbaar om DLSS en of RTX te testen

6: Performance winst minder dan voorgaande generaties

7: Maar vooral: De kaarten zijn veel te duur voor wat je onder de streep krijgt.

Een slecht product bestaat niet wel een product met een slechte prijs waardoor het een slechte deal is. Dit is zo'n deal.

1: Een mooie architectuur

2: + voor de nieuwe technieken

3: DLSS veelbelovend

4: Te langzaam voor RTX aan de hand van wat ze gezien hebben bij de demo's

5: Er zijn nog geen games beschikbaar om DLSS en of RTX te testen

6: Performance winst minder dan voorgaande generaties

7: Maar vooral: De kaarten zijn veel te duur voor wat je onder de streep krijgt.

Een slecht product bestaat niet wel een product met een slechte prijs waardoor het een slechte deal is. Dit is zo'n deal.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

we kunnen simpel weg misschien de conclusie trekken dat het ook een beetje een variant is op de raedon 4770 truk van vroeger?

Slecht product bestaat niet? Ik kan er wel wat bedenkenAstennu schreef op maandag 24 september 2018 @ 18:05:

Volgens mij zeggen alle reviews een beetje hetzelfde:

1: Een mooie architectuur

2: + voor de nieuwe technieken

3: DLSS veelbelovend

4: Te langzaam voor RTX aan de hand van wat ze gezien hebben bij de demo's

5: Er zijn nog geen games beschikbaar om DLSS en of RTX te testen

6: Performance winst minder dan voorgaande generaties

7: Maar vooral: De kaarten zijn veel te duur voor wat je onder de streep krijgt.

Een slecht product bestaat niet wel een product met een slechte prijs waardoor het een slechte deal is. Dit is zo'n deal.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Dan ben ik wel benieuwdsdk1985 schreef op maandag 24 september 2018 @ 22:35:

[...]

Slecht product bestaat niet? Ik kan er wel wat bedenken.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

YouTube: Wraptastic!! Voice Over nl Deel 1 (205Records)sdk1985 schreef op maandag 24 september 2018 @ 22:35:

[...]

Slecht product bestaat niet? Ik kan er wel wat bedenken.

Natuurlijk helemaal niet de bedoeling van je post, maar als je even voorbij de relative speed kijkt, en gewoon de benchmarks op de site bekijkt, zie je dat nu met deze identieke setup met allemaal verse benches de RTX2080 toch gewoon consequent 4-13% (wordt meer naarmate de resolutie hoger wordt) sneller is dan de 1080TI 11GB.Paprika schreef op dinsdag 25 september 2018 @ 02:15:NVIDIA GeForce RTX 2080 Ti PCI-Express Scaling

Dus gaat de hele "2080 is niet eens sneller dan 1080TI" rant toch echt niet op, en dat zónder DLSS.

De kaart is ook ongeveer 4-13% duurder, dus nieuwe kaart, nieuwe technieken, net zo duur (relatief).

Waarbij dus dan wel opgemerkt moet worden, dat als je op 1080P bijna geen winst hebt, zo'n ~4%, en bij 4K tot zo'n ~13% dus hoe hoger je resolutie, hoe beter je af bent met een 2080.

[ Voor 11% gewijzigd door zion op 25-09-2018 06:55 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Vergeet niet dat de 1080ti in die benches zeer, zeer waarschijnlijk een FE model is en dus met blower koeler. Een custom 1080ti (wat de meeste mensen kopen) gaat daar dan dus overheen en zit lijkt mij op hetzelfde niveau als een 2080. En aangezien de 2080 al met een goede 'custom' koeler komt, verwacht ik niet dat die nog veel verder komt.zion schreef op dinsdag 25 september 2018 @ 06:47:

[...]

Natuurlijk helemaal niet de bedoeling van je post, maar als je even voorbij de relative speed kijkt, en gewoon de benchmarks op de site bekijkt, zie je dat nu met deze identieke setup met allemaal verse benches de RTX2080 toch gewoon consequent 4-13% (wordt meer naarmate de resolutie hoger wordt) sneller is dan de 1080TI 11GB.

Dus gaat de hele "2080 is niet eens sneller dan 1080TI" rant toch echt niet op, en dat zónder DLSS.

De kaart is ook ongeveer 4-13% duurder, dus nieuwe kaart, nieuwe technieken, net zo duur (relatief).

Waarbij dus dan wel opgemerkt moet worden, dat als je op 1080P bijna geen winst hebt, zo'n ~4%, en bij 4K tot zo'n ~13% dus hoe hoger je resolutie, hoe beter je af bent met een 2080.

Edit:

Nog even heel snel een Palit 2080 met een MSI Game trio 1080ti vergeleken op TPU. TW3, BF1 en GTAV hadden vergelijkbare FPS op beide kaarten.

[ Voor 6% gewijzigd door Zeara op 25-09-2018 09:35 ]

De Deomo's hadden dan ook extra veel Rays om het overdreven te laten uitkomen puur voor marketing doeleinden, dit zal je dan ook niet terug zien in gamesAstennu schreef op maandag 24 september 2018 @ 18:05:

Volgens mij zeggen alle reviews een beetje hetzelfde:

1: Een mooie architectuur

2: + voor de nieuwe technieken

3: DLSS veelbelovend

4: Te langzaam voor RTX aan de hand van wat ze gezien hebben bij de demo's

5: Er zijn nog geen games beschikbaar om DLSS en of RTX te testen

6: Performance winst minder dan voorgaande generaties

7: Maar vooral: De kaarten zijn veel te duur voor wat je onder de streep krijgt.

Een slecht product bestaat niet wel een product met een slechte prijs waardoor het een slechte deal is. Dit is zo'n deal.

De performance winst zoals Maxwell kun je ok niet verwachten, en Turing ligt meer in lijn met de 900 series qua winst GTX 780Ti vergeleken met de GTX 980.

Ik ben vooral benieuwd hoe Turing mid range zich verhoud tegenover Pascal mid range.

[ Voor 3% gewijzigd door Gekke Jantje op 25-09-2018 09:26 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Mja op basis daar van ga je toch nu niet al een RTX kaart kopen? straks is het niet bruikbaar. Zeker met de huidige prijzen zou ik er ver van weg blijven. Dan moet nvidia eerst maar eens laten zien wat de meerwaarde van RTX is en dat het bruikbaar is. En dat zal nog even duren voordat die games uit zijn. Kan goed dat we over een half jaar pas kunnen zeggen oke het werk of nee we hebben 1-2 generaties nieuwere hardware nodig. ik ga van dat laatste uit. Om nu 850 of 1250 euro uit te geven om straks RTX games te gaan spelen terwijl je niet eens weet of het snel genoeg is is in mijn ogen heel onverstandig.Gekke Jantje schreef op dinsdag 25 september 2018 @ 09:25:

[...]

De Deomo's hadden dan ook extra veel Rays om het overdreven te laten uitkomen puur voor marketing doeleinden, dit zal je dan ook niet terug zien in games. Daarnaast was de echte performance ook niet te zien dus blijft dat ook nog eens speculeren. Beter wachten we de RTX games af als ze uit zien, en niet meer uit gaan van benchmarks en wat slecht geoptimaliseerde demo's.

De performance winst zoals Maxwell kun je ok niet verwachten, en Turing ligt meer in lijn met de 900 series qua winst GTX 780Ti vergeleken met de GTX 980.

Ik ben vooral benieuwd hoe Turing mid range zich verhoud tegenover Pascal mid range.

De GTX 980 was vaak ruim 10% sneller dat wordt nu niet eens gehaald. De TI's onderling zijn idd 30% sneller ook weinig. Maar omdat dat eerder ook gebeurd is maakt het dat nu nog niet goed! zeker niet voor deze Prijs! want daar zit het em. Waren ze even duur geweest als de afgelopen generatie was het top geweest. Maar nee je mag voor die 2080 meer betalen dan een 1080 Ti en hij is maar 10% sneller. Qua prijs schuiven ze de kaarten een heel segment omhoog.

Maar als jij het een goede deal vind go right ahead i wont stop you

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Ten eerste, het mooie van deze test is nou juist dat ze állemaal met hetzelfde systeem, met dezelfde drivers, met dezelfde instellingen zijn gedaan, ten tweede, die MSI is 0% goedkoper dan de FE editie, dus is zelfs duurder dan sommige 2080's, en is misschien wel net zo snel, maar dan 2 jaar verouderd ontwerp. met helemaal uitgekristalliseerde drivers, met nooit meer mogelijkheid door TR/DLSS/Driverupdates nog winst te halen....Zeara schreef op dinsdag 25 september 2018 @ 08:27:

[...]

Vergeet niet dat de 1080ti in die benches zeer, zeer waarschijnlijk een FE model is en dus met blower koeler. Een custom 1080ti (wat de meeste mensen kopen) gaat daar dan dus overheen en zit lijkt mij op hetzelfde niveau als een 2080. En aangezien de 2080 al met een goede 'custom' koeler komt, verwacht ik niet dat die nog veel verder komt.

Edit:

Nog even heel snel een Palit 2080 met een MSI Game trio 1080ti vergeleken op TPU. TW3, BF1 en GTAV hadden vergelijkbare FPS op beide kaarten.

Ik zou zeggen, ga ervoor, koop die, adviseer hem als best buy, maar of dat handig en/of verstandig is... tja....

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

De GTX 780 ti was gemiddeld 11-12% sneller dan de GTX 980 volgens de prestatie index van HWI, daar ga ik dan ook van uit omdat het een gemiddelde score is. Een slok op een borrel.

[ Voor 12% gewijzigd door Gekke Jantje op 25-09-2018 11:17 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

@Astennu, het ligt wel ook maar aan je eisen. Voor 'n mini-ITX opstelling ziet de pricewatch er zo uit:

https://tweakers.net/cate...Y3AEGWZtpfNi-OJ2BoP4BYow3 (en ja, de enige degelijke kaarten, de EVGAs, komen met een koeler die slechter is dan de nieuwe FE).

En nu kan ik oprecht zeggen dat de FE me in 't echt positief heeft verrast, al is 't eigenlijk maar 'n placeholder tot de andere kaarten uitkomen. Ik heb ook nog nooit een GPU gehad waarbij de gehele behuizing van 'n GPU als functie had 't afdragen van hitte.

Voor 'n 2080Ti verwacht ik overigens dat de FE koeler wel te zwak is om als stil te worden ervaren.

https://tweakers.net/cate...Y3AEGWZtpfNi-OJ2BoP4BYow3 (en ja, de enige degelijke kaarten, de EVGAs, komen met een koeler die slechter is dan de nieuwe FE).

En nu kan ik oprecht zeggen dat de FE me in 't echt positief heeft verrast, al is 't eigenlijk maar 'n placeholder tot de andere kaarten uitkomen. Ik heb ook nog nooit een GPU gehad waarbij de gehele behuizing van 'n GPU als functie had 't afdragen van hitte.

Voor 'n 2080Ti verwacht ik overigens dat de FE koeler wel te zwak is om als stil te worden ervaren.

[ Voor 9% gewijzigd door Paprika op 25-09-2018 11:24 ]

@Foritain heeft een review gedaan van de ASUS 2080(Ti) en daar zie je toch echt dat de 1080Ti en 2080 zo goed al on par zijn gemiddeld qua performance waarbij de ene iets beter performed dan de ander per game.zion schreef op dinsdag 25 september 2018 @ 06:47:

[...]

Natuurlijk helemaal niet de bedoeling van je post, maar als je even voorbij de relative speed kijkt, en gewoon de benchmarks op de site bekijkt, zie je dat nu met deze identieke setup met allemaal verse benches de RTX2080 toch gewoon consequent 4-13% (wordt meer naarmate de resolutie hoger wordt) sneller is dan de 1080TI 11GB.

Dus gaat de hele "2080 is niet eens sneller dan 1080TI" rant toch echt niet op, en dat zónder DLSS.

De kaart is ook ongeveer 4-13% duurder, dus nieuwe kaart, nieuwe technieken, net zo duur (relatief).

Waarbij dus dan wel opgemerkt moet worden, dat als je op 1080P bijna geen winst hebt, zo'n ~4%, en bij 4K tot zo'n ~13% dus hoe hoger je resolutie, hoe beter je af bent met een 2080.

productreview: Asus ROG Strix GeForce RTX 2080 OC Gaming review door Foritain - ik zie hier echt geen 4-13% voorsprong voor de RTX2080!

[ Voor 13% gewijzigd door Lord_Dain op 25-09-2018 11:11 ]

Fyi wat ik nog even moet verduidelijken in de reviews is dat de (OC) staat voor stevige custom kaarten welke ik voor elke chipset heb gebruikt, simpelweg omdat dat is wat mensen toch kopen en die baseline vergelijkingen met de nieuwe 'FE' die opeens stevig OC't eigenlijk maar vies zijn. Ik maak zsm nog een lijstje met welke kaart ik gebruik, in geval van de GTX 1080 Ti was dat de Aorus Xtreme.Lord_Dain schreef op dinsdag 25 september 2018 @ 11:09:

[...]

@Foritain heeft een review gedaan van de ASUS 2080(Ti) en daar zie je toch echt dat de 1080Ti en 2080 zo goed al on par zijn gemiddeld qua performance waarbij de ene iets beter performed dan de ander per game.

productreview: Asus ROG Strix GeForce RTX 2080 OC Gaming review door Foritain - ik zie hier echt geen 4-13% voorsprong voor de RTX2080!

Het ging mij puur om je statement over de 2080 rant.zion schreef op dinsdag 25 september 2018 @ 11:07:

[...]

Ten eerste, het mooie van deze test is nou juist dat ze állemaal met hetzelfde systeem, met dezelfde drivers, met dezelfde instellingen zijn gedaan, ten tweede, die MSI is 0% goedkoper dan de FE editie, dus is zelfs duurder dan sommige 2080's, en is misschien wel net zo snel, maar dan 2 jaar verouderd ontwerp. met helemaal uitgekristalliseerde drivers, met nooit meer mogelijkheid door TR/DLSS/Driverupdates nog winst te halen....

Ik zou zeggen, ga ervoor, koop die, adviseer hem als best buy, maar of dat handig en/of verstandig is... tja....

Maar... de oude kaarten zijn met andere drivers getest.

Anyway, mocht ik in de markt zijn... Dan zou ik ook eerder geneigd zijn naar een 2080, om de redenen die je noemt.RTX 2080 & 2080 Ti: 411.51 Press Driver

All other NVIDIA: 399.24 WHQL

All AMD: Catalyst 18.8.2 WHQL

Van de site:Zeara schreef op dinsdag 25 september 2018 @ 11:40:

[...]

Maar... de oude kaarten zijn met andere drivers getest.

[...]

Test System - VGA Rev. 2018.2

Processor: Intel Core i7-8700K @ 4.8 GHz

(Coffee Lake, 12 MB Cache)

Motherboard: ASUS Maximus X Hero

Intel Z370

Memory: G.SKILL 16 GB Trident-Z DDR4

@ 3867 MHz 18-19-19-39

Storage: 2x Patriot Ignite 960 GB SSD

Power Supply: Seasonic Prime Ultra Titanium 850 W

Cooler: Cryorig R1 Universal 2x 140 mm fan

Software: Windows 10 64-bit April 2018 Update

Drivers: GeForce 411.51 Press Driver

Display: Acer CB240HYKbmjdpr 24" 3840x2160

Benchmark scores in other reviews are only comparable when this exact same configuration is used.

All games and cards were tested with the drivers listed above, and no performance results were recycled between test systems. Only this exact system with exactly the same configuration was used.

All games are set to their highest quality setting unless indicated otherwise.

AA and AF are applied via in-game settings, not via the driver's control panel.

Each game is tested at these screen resolutions:

1920x1080: Most common monitor (22" - 26").

2560x1440: Highest possible 16:9 resolution for commonly available displays (27"-32").

3840x2160: 4K Ultra HD resolution, available on the latest high-end monitors.

https://www.techpowerup.c...CI-Express_Scaling/3.html

[ Voor 5% gewijzigd door zion op 25-09-2018 13:53 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

@zion Mijn opmerking aangaande drivers had betrekking op de reviews die ik had bekeken. Had ik wat duidelijker neer moeten zetten. Je hebt gelijk, in de PCIe test gebruiken ze allemaal dezelfde driver.

Blijf ik wel bij mijn statement. Ze zeggen niet expliciet welke 1080ti ze gebruiken. Dus ik ga er alsnog vanuit dat het een FE is. En dat het verschil tussen de 1080ti en de 2080 dus daardoor komt. En waarschijnlijk is elke custom 1080ti is dus net zo snel als een 2080 of met minimale verschillen.

Blijf ik wel bij mijn statement. Ze zeggen niet expliciet welke 1080ti ze gebruiken. Dus ik ga er alsnog vanuit dat het een FE is. En dat het verschil tussen de 1080ti en de 2080 dus daardoor komt. En waarschijnlijk is elke custom 1080ti is dus net zo snel als een 2080 of met minimale verschillen.

Waar zullen de huidige 1080ti kaarten tweedehands op eindigen? Ik denk rond de € 500,- einde van het jaar ongeveer?

Wat is jullie verwachting ongeveer?

Wat is jullie verwachting ongeveer?

Alleen zou ik niet uitgaan van HWI.... kijk eens naar TPU, daar is hij 6% trager. Welke review heb je het overigens over? Vast de eerste hit op google maar plaats bij zulke dingen een bron.Gekke Jantje schreef op dinsdag 25 september 2018 @ 11:09:

De GTX 780 ti was gemiddeld 11-12% sneller dan de GTX 980 volgens de prestatie index van HWI, daar ga ik dan ook van uit omdat het een gemiddelde score is. Een slok op een borrel.

https://www.techpowerup.c...A/GeForce_GTX_980/26.html

Lekker kaartje zeg. 3x HDMI, 3x DP en 1x VirtualLink (maximaal 4 schermen + VR bril over VirtualLink actief).

Op Reddit zag ik eerder deze week een foto van een kerel die nu al VirtualLink gebruikte i.c.m. een adapter van Apple. Dan kun je dus probleemloos 5 schermen kunnen draaien over 1 kaart.

[ Voor 35% gewijzigd door Paprika op 25-09-2018 18:00 ]

Ben laatst nog een 2080 tegengekomen voor 799 in Duitsland. Zie ook geen enkele reden om meer ervoor te betalen.DaniëlWW2 schreef op maandag 24 september 2018 @ 13:22:

[...]

Tja de RTX2080 heeft een MSRP van $699/$799 en ze kosten tussen de €850+ (een uitzondering op het moment) en €1000+. €600+ is denk ik zeer realistisch.

< dit stukje webruimte is te huur >

Nee gewoon de HWI review van de GTX 979 en 980.Sp3ci3s8472 schreef op dinsdag 25 september 2018 @ 17:04:

[...]

Alleen zou ik niet uitgaan van HWI.... kijk eens naar TPU, daar is hij 6% trager. Welke review heb je het overigens over? Vast de eerste hit op google maar plaats bij zulke dingen een bron.

https://www.techpowerup.c...A/GeForce_GTX_980/26.html

Prestatie index. . https://nl.hardware.info/...u-prestatiescore-20142015

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Daar is de 780Ti echter in elke index 8-11% langzamer dan de 980? Dat is echt het tegenovergestelde van wat je beweertGekke Jantje schreef op dinsdag 25 september 2018 @ 20:34:

[...]

Nee gewoon de HWI review van de GTX 979 en 980.

Prestatie index. . https://nl.hardware.info/...u-prestatiescore-20142015

...and your ass will follow

Dat kan vast niet kloppen want in mijn benchmark was hij wel sneller. Oh wachthidde212 schreef op dinsdag 25 september 2018 @ 21:05:

[...]

Daar is de 780Ti echter in elke index 8-11% langzamer dan de 980? Dat is echt het tegenovergestelde van wat je beweert

Verwijderd

Dat zie je ook voor de Vega-kaarten. In Duitsland hebben ze blijkbaar wat meer concurrentie of lagere inkoopprijzen. En twee procentpunt minder BTW maar dat is maar een zeer klein deel van het verschil!aex351 schreef op dinsdag 25 september 2018 @ 19:29:

[...]

Ben laatst nog een 2080 tegengekomen voor 799 in Duitsland. Zie ook geen enkele reden om meer ervoor te betalen.

Hoe dan ook, kijk eens bij Caseking, die leveren ook naar Nederland. Alleen vermeldt Tweakers dat niet (iets met dat zij hen niet betalen en die Nederlandse winkeltjes wel?).

[ Voor 16% gewijzigd door Verwijderd op 26-09-2018 00:30 ]

Dat bedelde ik dus ook en ik beweerde niet andershidde212 schreef op dinsdag 25 september 2018 @ 21:05:

[...]

Daar is de 780Ti echter in elke index 8-11% langzamer dan de 980? Dat is echt het tegenovergestelde van wat je beweert

[ Voor 5% gewijzigd door Gekke Jantje op 26-09-2018 08:34 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Wat is 4-13% nou? zeker gezien het prijs verschil. En dat is dan meestal vergeleken met een 1080 Ti FE. De non refferenced zijn daar snel 8-10% sneller dus waar is je verschil dan?zion schreef op dinsdag 25 september 2018 @ 06:47:

[...]

Natuurlijk helemaal niet de bedoeling van je post, maar als je even voorbij de relative speed kijkt, en gewoon de benchmarks op de site bekijkt, zie je dat nu met deze identieke setup met allemaal verse benches de RTX2080 toch gewoon consequent 4-13% (wordt meer naarmate de resolutie hoger wordt) sneller is dan de 1080TI 11GB.

Dus gaat de hele "2080 is niet eens sneller dan 1080TI" rant toch echt niet op, en dat zónder DLSS.

De kaart is ook ongeveer 4-13% duurder, dus nieuwe kaart, nieuwe technieken, net zo duur (relatief).

Waarbij dus dan wel opgemerkt moet worden, dat als je op 1080P bijna geen winst hebt, zo'n ~4%, en bij 4K tot zo'n ~13% dus hoe hoger je resolutie, hoe beter je af bent met een 2080.

De 2080 FE is al overclocked tov de straks stock 2080 kaarten. En dan krijg je nog wel factory OC kaarten maar het is de vraag hoeveel sneller die zijn ik verwacht dat dat verschil tov de FE deze generatie wat kleiner is eerder 3-5%.

DLSS is zeker interessant maar welk spel kan het op dit moment nu meteen? > Geen.

Tegen de tijd dat aardig wat games het ondersteunen is de RTX 3xxx er denk ik al bijna want deze chips zijn heel groot en duur om te bakken. Dus nVidia zal zo snel mogelijk naar 7nm willen zodat ze dezelfde prijzen kunnen vragen voor kleinere en uiteindelijk (want 7nm is momenteel nog duur omdat het zo nieuw is) goedkopere chips.

Voor mij voelt de RTX 2xxx generatie echt als een stoort van tussenstap. De techniek is nu beschikbaar voor de Dev's mensen kunnen er een beetje aan proeven. Maar bij de RTX 3xxx generatie wordt het pas echt bruikbaar omdat RT dan nog sneller kan en de software support er ook is in games die nu in de winkel liggen. Nu zijn er alleen wat beta's die wij niet als klant kunnen spelen dus op dit moment heb je niets aan DLSS en RTX.

Dus als je iets in de trant van Geforce 780, 980, 1070/1080 of R9 290X, Fury, Vega kaart hebt gewoon lekker nog een jaartje door spelen met je huidige kaart dan zijn de 7nm kaarten beschikbaar en dan krijgen we weer een grotere sprong in prestaties. Maar goed dat is hoe ik er over denk hoe je het niet mee eens te zijn

9 van de 10 sites gebruikt een 1080 Ti FE.Zeara schreef op dinsdag 25 september 2018 @ 14:08:

@zion Mijn opmerking aangaande drivers had betrekking op de reviews die ik had bekeken. Had ik wat duidelijker neer moeten zetten. Je hebt gelijk, in de PCIe test gebruiken ze allemaal dezelfde driver.

Blijf ik wel bij mijn statement. Ze zeggen niet expliciet welke 1080ti ze gebruiken. Dus ik ga er alsnog vanuit dat het een FE is. En dat het verschil tussen de 1080ti en de 2080 dus daardoor komt. En waarschijnlijk is elke custom 1080ti is dus net zo snel als een 2080 of met minimale verschillen.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

+3 Ben het 100% met je eens, heb ook nooit wat anders beweerd.Astennu schreef op woensdag 26 september 2018 @ 08:44:

Voor mij voelt de RTX 2xxx generatie echt als een stoort van tussenstap. De techniek is nu beschikbaar voor de Dev's mensen kunnen er een beetje aan proeven. Maar bij de RTX 3xxx generatie wordt het pas echt bruikbaar omdat RT dan nog sneller kan en de software support er ook is in games die nu in de winkel liggen. Nu zijn er alleen wat beta's die wij niet als klant kunnen spelen dus op dit moment heb je niets aan DLSS en RTX.

Dus als je iets in de trant van Geforce 780, 980, 1070/1080 of R9 290X, Fury, Vega kaart hebt gewoon lekker nog een jaartje door spelen met je huidige kaart dan zijn de 7nm kaarten beschikbaar en dan krijgen we weer een grotere sprong in prestaties. Maar goed dat is hoe ik er over denk hoe je het niet mee eens te zijn

Wat ik alleen continu blijf beargumenteren is dat mensen overdreven negatief zijn over de 20xx series, en dat als je genoodzaakt ben nu te upgraden het toch de beste keus is, als je niet de 2e hands markt aan wil boren.

Dus: nu upgraden? Vooral niet doen!

Geen optie? (defecte videokaart?/nieuw spel wat je niet meer kan spelen?/Nieuwe monitor die nog maar 30FPS haalt?), koop een Vega64 voor € 488,-

De enige 1080TI's die namelijk gelijk/nipt beter scoren dan de 2080 zijn allemaal rond de € 900,-(+) en dus gewoon duurder dan de 2080, zonder vooruitzicht op nog een performance boost, waar die bij de 2080 bijna gegarandeerd is (dankzij DLSS en driveroptimalisaties)

[ Voor 8% gewijzigd door zion op 26-09-2018 09:10 ]

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Als dat allemaal geen optie is en je wilt op 4K gamen tja dan kan je idd kiezen dussen ene goedkope 1080 Ti en zelf een beetje overclocken of een 2080.zion schreef op woensdag 26 september 2018 @ 08:54:

[...]

+3 Ben het 100% met je eens, heb ook nooit wat anders beweerd.

Wat ik alleen continu blijf beargumenteren is dat mensen overdreven negatief zijn over de 20xx series, en dat als je genoodzaakt ben nu te upgraden het toch de beste keus is, als je niet de 2e hands markt aan wil boren.

Dus: nu upgraden? Vooral niet doen!

Geen optie? (defecte videokaart?/nieuw spel wat je niet meer kan spelen?/Nieuwe monitor die nog maar 30FPS haalt?), koop een Vega64 voor € 488,-Dan is een 2080 de betere keus boven de 1080TI. (imo)

De enige 1080TI's die namelijk gelijk/nipt beter scoren dan de 2080 zijn allemaal rond de € 900,-(+) en dus gewoon duurder dan de 2080, zonder vooruitzicht op nog een performance boost, waar die bij de 2080 bijna gegarandeerd is (dankzij DLSS en driveroptimalisaties)

Maar met dit soort prijzen begin ik toch steedsmeer te denken dat console gaming zo slecht nog niet is. 400 euro en je bent klaar dan heb je een PS 4 Pro of Xbox One X en dat ziet er ook erg mooi uit. Dat is nog niet de helft van alleen de 2080 en dan moet je de rest van de PC nog.

Helaas vind ik RTS heel erg leuk en dat werkt niet op een console

Al hoor je wel eens dat muis en toetsenbord een optie zou gaan worden zodra dat kan kun je ook RTS games gaan spelen op een console.

Maar goed totaal offtopic.

Anway qua hardware is de RTX 2xxx serie niet slecht qua prijs gewoon wel.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Vergeet niet dat je dan ook een beetje leuke TV wiltAstennu schreef op woensdag 26 september 2018 @ 10:10:

[...]

Als dat allemaal geen optie is en je wilt op 4K gamen tja dan kan je idd kiezen dussen ene goedkope 1080 Ti en zelf een beetje overclocken of een 2080.

Maar met dit soort prijzen begin ik toch steedsmeer te denken dat console gaming zo slecht nog niet is. 400 euro en je bent klaar dan heb je een PS 4 Pro of Xbox One X en dat ziet er ook erg mooi uit. Dat is nog niet de helft van alleen de 2080 en dan moet je de rest van de PC nog.

Das een non-argument, bij een 2080(TI) wil je natuurlijk ook minimaal een G-Sync HDR 4K 144Hz scherm á € 2500,-Zeara schreef op woensdag 26 september 2018 @ 10:12:

[...]

Vergeet niet dat je dan ook een beetje leuke TV wiltIk weet niet hoe groot het verschil tussen een 4k tv van 500-600 euro of een van 100-1200... Of je gaat meteen voor een OLED natuurlijk...

10-08-1999 - 10-08-2022, 23 jaar zion @ Tweakers.net

systeem

Fair enough ja.zion schreef op woensdag 26 september 2018 @ 10:32:

[...]

Das een non-argument, bij een 2080(TI) wil je natuurlijk ook minimaal een G-Sync HDR 4K 144Hz scherm á € 2500,-

Plus, voor het geld van een 2080 en zeker voor een ti kun je makkelijk een console en TV kopen.

Bij de buren: Nvidia stelt levering RTX 2080 Ti nog verder uit.

Ik heb nog nooit zo'n rommelige launch gezien als met deze videokaarten...

Ik heb nog nooit zo'n rommelige launch gezien als met deze videokaarten...

AMD Ryzen 9 5900X • Gigabyte X570 Aorus PRO • G.Skill Ripjaws V F4-3600C16D-32GVKC • AMD Radeon RX 6900 XT • Samsung 850 EVO 1TB • Intel 660p 2TB • Corsair Obsidian 500D RGB SE • Corsair RM750x

Dat is denk ik ook weer overdreven. Het begint onderhand wel erg te lijken op de lancering van RX Vega.RobinNL schreef op woensdag 26 september 2018 @ 11:22:

Bij de buren: Nvidia stelt levering RTX 2080 Ti nog verder uit.

Ik heb nog nooit zo'n rommelige launch gezien als met deze videokaarten...

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Presentatie enkel over Raytracing, embargo die meerdere keren (?) wordt verschoven, benchmarks 1 dag van tevoren dus je hebt geen idee wat je gaat (of hebt) kopen, 2080 Ti wordt naar eind september verschoven en nu naar oktober.DaniëlWW2 schreef op woensdag 26 september 2018 @ 11:31:

[...]

Dat is denk ik ook weer overdreven. Het begint onderhand wel erg te lijken op de lancering van RX Vega.

Er moet ergens wel iets mis zijn gegaan.

AMD Ryzen 9 5900X • Gigabyte X570 Aorus PRO • G.Skill Ripjaws V F4-3600C16D-32GVKC • AMD Radeon RX 6900 XT • Samsung 850 EVO 1TB • Intel 660p 2TB • Corsair Obsidian 500D RGB SE • Corsair RM750x

Mja je wil ook een goede monitor die kost ook snel 500-800 euro als niet meer.Zeara schreef op woensdag 26 september 2018 @ 10:12:

[...]

Vergeet niet dat je dan ook een beetje leuke TV wiltIk weet niet hoe groot het verschil tussen een 4k tv van 500-600 euro of een van 100-1200... Of je gaat meteen voor een OLED natuurlijk...

Daarnaast kan je je console ook gewoon op je Monitor aansluiten en gewoon achter een bureau zitten met je controller hoeft natuurlijk niet op de bank voor een TV.

Oled TV's heb je al onder de 1500 euro is aardig wat geld maar alles bij elkaar ben je dan nog geen 2K kwijt.

En kan je geweldig films kijken. Dat is op een game pc met 27"schermpje toch even anders.

Maar je hoeft natuurlijk geen 1500 euro uit te geven. Voor 500-600 euro heb je ook al best aardige TV quality wise vergelijkbaar met PC schermen van rond de 300-400 euro alleen dan wel 49" ipv 27.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Heb jij je eigen post wel gelezen.Gekke Jantje schreef op woensdag 26 september 2018 @ 08:34:

[...]

Dat bedelde ik dus ook en ik beweerde niet anders

Maar met dit soort prijzen begin ik toch steeds meer te denken dat hardlopen zo slecht nog niet is. Voor 10 euro een paar schoenen van marktplaats en je bent klaar dan raak je na een tijdje misschien ook wat vet kwijt en zie je er potentieel zelfs mooier uit*. Dat is nog niet de helft van de helft van de helft van de helft van de helft van de helft van alleen de 2080 (850/26 = 13.28 euro) en dan moet je de rest van de PC nog.Astennu schreef op woensdag 26 september 2018 @ 10:10:

[...]

Maar met dit soort prijzen begin ik toch steedsmeer te denken dat console gaming zo slecht nog niet is. 400 euro en je bent klaar dan heb je een PS 4 Pro of Xbox One X en dat ziet er ook erg mooi uit. Dat is nog niet de helft van alleen de 2080 en dan moet je de rest van de PC nog.

* is niet op jou (Astennu) of iemand anders gericht, maar in z'n algemeenheid

[ Voor 5% gewijzigd door Paprika op 26-09-2018 20:30 ]

Mja die vergelijking klopt niet echt. Hardlopen is niet gamen.Paprika schreef op woensdag 26 september 2018 @ 20:28:

[...]

Maar met dit soort prijzen begin ik toch steeds meer te denken dat hardlopen zo slecht nog niet is. Voor 10 euro een paar schoenen van marktplaats en je bent klaar dan raak je na een tijdje misschien ook wat vet kwijt en zie je er potentieel zelfs mooier uit*. Dat is nog niet de helft van de helft van de helft van de helft van de helft van de helft van alleen de 2080 (850/26 = 13.28 euro) en dan moet je de rest van de PC nog.

* is niet op jou (Astennu) of iemand anders gericht, maar in z'n algemeenheid.

Xbox en PS kunnen veel games van de PC draaien. PC, en PS hebben beide exclusives die de ander niet heeft. Maar veel populair spul is wel voor beide te krijgen (op RTS en MOBA na) Maar voor die games heb je vaak niet perse een RTX 2080 of zwaarder nodig.

Het zal aan mij liggen maar ik vind pc gaming met dit soort prijzen wel steeds minder leuk worden als hardwareliefhebber. Het is gewoon niet meer te doen om het beste van het beste aan te schaffen of je moet echt serieus veel geld investeren. Het gat tov de prijzen van consoles is de afgelopen 5 jaar gigantisch gegroeid waar het verschil eerst aanzienlijk kleiner was. Ik vind dat gewoon erg jammer

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Het zijn beide vrijetijdsbestedingen.Astennu schreef op woensdag 26 september 2018 @ 21:02:

[...]

Mja die vergelijking klopt niet echt. Hardlopen is niet gamen

.

Meh, dat valt nog best mee als je het vergelijkt met andere hobby's, daar zijn de kosten soms nog veel hoger als je "het beste van het beste" wilt hebben, de vraag is, heb je dat werkelijk nodig?Het is gewoon niet meer te doen om het beste van het beste aan te schaffen of je moet echt serieus veel geld investeren.

maybe we sit down and talk about the revolution and stuff

but it doesn't work like that

you can't turn back now there's no way back

you feel the power to destroy your enemy..

Verwijderd

Ik kijk wel op een afstandje met mijn 2e handse i7-6850K en Titan X op 1440p monitor.

Hobbel er op mijn gemak achteraan al die nieuw ontwikkelingen.

Dat high end spul schrijft nog sneller af dan een auto.

Hobbel er op mijn gemak achteraan al die nieuw ontwikkelingen.

Dat high end spul schrijft nog sneller af dan een auto.

Tja dan kan je ook gewoon thuis Push-ups gaan doen heb je nog minder voor nodigZer0 schreef op woensdag 26 september 2018 @ 22:42:

[...]

Het zijn beide vrijetijdsbestedingen.

.

[...]

Meh, dat valt nog best mee als je het vergelijkt met andere hobby's, daar zijn de kosten soms nog veel hoger als je "het beste van het beste" wilt hebben, de vraag is, heb je dat werkelijk nodig?

Zo kan je natuurijk bezig blijven.

Wat heb je werkelijk nodig tja. Je kan games ook op low met 20 fps werkt ook prima. Dus waar leg je dan de grens. Tijden zijn gewoon veranderd. Maar mag dat toch wel jammer vinden?

En dat is er helaas niet meer bij.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Klein verschil, de kans dat je je lijf sloopt met die 2080 is een stuk kleiner dan met die afgetrapte hardloop schoenenPaprika schreef op woensdag 26 september 2018 @ 20:28:

[...]

Maar met dit soort prijzen begin ik toch steeds meer te denken dat hardlopen zo slecht nog niet is. Voor 10 euro een paar schoenen van marktplaats en je bent klaar dan raak je na een tijdje misschien ook wat vet kwijt en zie je er potentieel zelfs mooier uit*. Dat is nog niet de helft van de helft van de helft van de helft van de helft van de helft van alleen de 2080 (850/26 = 13.28 euro) en dan moet je de rest van de PC nog.

Dat is toch eigenlijk altijd al zo geweest? De 8800 Ultra zat op 829 dollar. Wie dat wilde kon altijd al duizenden euro's/dollars/guldens besteden aan een computer. We hebben het i7 tijdperk gehad, het SLI tijdperk, de 1000+W voedingen, de titans, enz. Verschil is dat er nu meer mensen zijn die meer dan de standaard +- 1000-1500 euro aan een gaming build uitgeven dan zeg 10 jaar geleden. Wellicht heb je daarom het gevoel dat je ook mee moet doen terwijl dat er toen niet was?Astennu schreef op woensdag 26 september 2018 @ 21:02:

[...]

. Het is gewoon niet meer te doen om het beste van het beste aan te schaffen of je moet echt serieus veel geld investeren.

[ Voor 37% gewijzigd door sdk1985 op 27-09-2018 00:58 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Nog verder terug was dat wel minder. GeForce 2 ultra was ook. Relatief duur maar nog geen 1000 gulden. 9700 Pro iets van 450 euro. De andere prijzen weet ik zo niet meer heb denk ik nog wlr ergens oude facturen liggen.sdk1985 schreef op donderdag 27 september 2018 @ 00:54:

[...]

Klein verschil, de kans dat je je lijf sloopt met die 2080 is een stuk kleiner dan met die afgetrapte hardloop schoenen.

[...]

Dat is toch eigenlijk altijd al zo geweest? De 8800 Ultra zat op 829 dollar. Wie dat wilde kon altijd al duizenden euro's/dollars/guldens besteden aan een computer. We hebben het i7 tijdperk gehad, het SLI tijdperk, de 1000+W voedingen, de titans, enz. Verschil is dat er nu meer mensen zijn die meer dan de standaard +- 1000-1500 euro aan een gaming build uitgeven dan zeg 10 jaar geleden. Wellicht heb je daarom het gevoel dat je ook mee moet doen terwijl dat er toen niet was?

HD4870 was ook relatief goedkoop maar daar wel op gemaakt.

HD7970 had een msrp van 550 dollar. De GTX 580 en 680 waren 500msrp. Ik het het gevoel dat het daar vooral hard omhoog gegaan is.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

De Geforce 3 Ti 500 zat rond de duizend gulden, en de 295 van het rode kamp ging bij introductie over de 1300 euro.Astennu schreef op donderdag 27 september 2018 @ 06:59:

[...]

Nog verder terug was dat wel minder. GeForce 2 ultra was ook. Relatief duur maar nog geen 1000 gulden. 9700 Pro iets van 450 euro. De andere prijzen weet ik zo niet meer heb denk ik nog wlr ergens oude facturen liggen.

HD4870 was ook relatief goedkoop maar daar wel op gemaakt.

HD7970 had een msrp van 550 dollar. De GTX 580 en 680 waren 500msrp. Ik het het gevoel dat het daar vooral hard omhoog gegaan is.

maybe we sit down and talk about the revolution and stuff

but it doesn't work like that

you can't turn back now there's no way back

you feel the power to destroy your enemy..

1000 gulden was 454 euro dus dat valt nog wel in de lijn met wat het daar na was. Was inderdaad wel wat duurder dan eerdere kaarten.Zer0 schreef op donderdag 27 september 2018 @ 08:22:

[...]

De Geforce 3 Ti 500 zat rond de duizend gulden, en de 295 van het rode kamp ging bij introductie over de 1300 euro.

295 van het rode kamp?

De Geforce 295 was een Sandwich kaart met eigenlijk 2x een Geforce GTX 280/260. Ook die zat qua MSRP niet zo hoog.

Je bedoelt denk ik de R9 295X2 van AMD? ook dat is weer een Dual GPU kaart. En ja dat was ook al te gek het waren opzich wel twee kaarten in een. De optie om 2x een R9 290X los te kopen was goedkoper en bijna net zo snel.

R9 295X2 is niet heel erg populair geweest. De 3870 X2 en 4870 X2 relatief gezien wel. De HD7990 dual GPU was ook al relatief duur maar ook hier waren het weer 2 GPU's. En het is niet zo raar dat die 2x zo duur waren als een losse kaart met die GPU.

[ Voor 7% gewijzigd door Astennu op 27-09-2018 08:37 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Vroeger draaide games ook wel beter op de pc, tegenwoordig heb je zoveel grafische kracht nodig om op vergelijkbaar niveau te komen als een console. Vroeger waren de verbeteringen ook een stuk groter bij videokaarten, toen kon het nieuwe midrange model vergelijkbaar presteren met het huidige high-end model. De kaarten voor de echte hardware liefhebbers waren die met dubbele gpu chips..Astennu schreef op donderdag 27 september 2018 @ 08:35:

[...]

1000 gulden was 454 euro dus dat valt nog wel in de lijn met wat het daar na was. Was inderdaad wel wat duurder dan eerdere kaarten.

295 van het rode kamp?

De Geforce 295 was een Sandwich kaart met eigenlijk 2x een Geforce GTX 280/260. Ook die zat qua MSRP niet zo hoog.

Je bedoelt denk ik de R9 295X2 van AMD? ook dat is weer een Dual GPU kaart. En ja dat was ook al te gek het waren opzich wel twee kaarten in een. De optie om 2x een R9 290X los te kopen was goedkoper en bijna net zo snel.

R9 295X2 is niet heel erg populair geweest. De 3870 X2 en 4870 X2 relatief gezien wel. De HD7990 dual GPU was ook al relatief duur maar ook hier waren het weer 2 GPU's. En het is niet zo raar dat die 2x zo duur waren als een losse kaart met die GPU.

Laten we niet teveel verzanden in prijsvergelijkingen met een munt die al 20 jaar niet meer bestaat. Dat is wat krom. Daarnaast is er sprake van inflatie. Dus het is appels met peren vergelijken.

Niet mee eens. De meeste console games die aangemerkt staan als 4k lopen op 30fps en dan ook niet eens op echt 4k. Vaak wordt er dan nog checkerboarding gedaan of geupschaled vanaf 1600p oid.Brilsmurfffje schreef op donderdag 27 september 2018 @ 08:47:

[...]

Vroeger draaide games ook wel beter op de pc, tegenwoordig heb je zoveel grafische kracht nodig om op vergelijkbaar niveau te komen als een console.[...]

1600p 30fps heb je echt geen gruwelijk zware PC voor nodig, dat kan met een RX580 ook...

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

PC prijzen gingen toen de tijd netjes van guldens naar euro over. Niet zoals de horeca die alles veel duurder maakte. Ik heb daar toen nog heel goed op gelet en veel dingen om gerekend en dat werd toen voor PC onderdelen netjes gedaan dus die 2.2 klopt daar wel. Op z'n ergst was het 2x maar lang geen 1.5zion schreef op donderdag 27 september 2018 @ 09:34:

[...]

Nee, Fl 1000,- was +/- € 666,66 (toegegeven door NL staat dat omrekenfactor eerder 1,5 had moeten zijn ipv 2.2) * een heel conservatieve 1,5% inflatie over 18 jaar = € 667,- * 1,01518 = € 872,-

Dat is waar.Blaat schreef op donderdag 27 september 2018 @ 09:02:

[...]

Niet mee eens. De meeste console games die aangemerkt staan als 4k lopen op 30fps en dan ook niet eens op echt 4k. Vaak wordt er dan nog checkerboarding gedaan of geupschaled vanaf 1600p oid.

1600p 30fps heb je echt geen gruwelijk zware PC voor nodig, dat kan met een RX580 ook...

En slimme technieken zijn denk ik ook wel beter zie ook DLSS als je dan inderdaad 95% van de kwaliteit kan halen maar met veel hogere prestaties is dat zeker interessant. Daar zullen ze ook wel van dit soort truucjes gebruiken (lager renderen en dan upscalen om tot die prestaties te komen)

Bij een TV zit je ook verder weg de beelden bewegen. Als je het zo goed als niet kan zien dat het allemaal niet native 4K is vind ik het niet erg, Bij een PC scherm zit je vaak dichterbij en zie je dat soort dingen eerder. En is een hogere resolutie ook belangrijker. 27"1080p is voor mij een no go. Moet minimaal 1440p zijn.

[ Voor 45% gewijzigd door Astennu op 27-09-2018 09:44 ]

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

Verwijderd

Dat valt wel mee, meer dan een RX 480/580 is het niet wat er in een X1X zit.Brilsmurfffje schreef op donderdag 27 september 2018 @ 08:47:

[...]

Vroeger draaide games ook wel beter op de pc, tegenwoordig heb je zoveel grafische kracht nodig om op vergelijkbaar niveau te komen als een console.

Qua CU's meer maar een lagere klokfrequentie want beperkingen met vermogen, hitte en kostprijs.

In principe hoort die kaart op dit moment zo'n €240 te kosten?

Dat neemt niet weg dat momenteel de X1X een betere performance/€ levert maar met de nodige beperkingen. Redelijk goede graphics voor dat prijspunt maar een zwakke CPU, geen SSD...

De console zelf kost minder (dat was niet zo met de PS4 en de X1 in de laatste jaren) maar je betaalt wel aanzienlijk meer voor spellen, zit vast aan 30-40 FPS met 1440p upscaled met checkerboard-rendering (de goede weg zoals Asten aangeeft maar die techniek heeft nog teveel nadelen), je moet nog steeds spelen met een controller als je officiële support wil (niet handig voor RTS-spellen en FPS-spellen), de input-lag is groter (vanwege de zwakkere hardware), je hebt een abonnement nodig voor multiplayer wat aardig oploopt qua kosten over een duur van 6 jaar...

Zelf heb ik ook moeite met het gesloten eco-systeem en voor mij speelt mee dat ik een computer ook veel voor multimedia en voor zakelijke toepassingen gebruik.

Ik zie het niet zo zonnig voor een console als Asten maar ik denk dat ik zijn sentiment wel begrijp, zeker met de absurd hoge RAM-prijzen en de dure grafische kaarten op dit moment. Maar met die grafische kaarten komt het wel weer goed in 2019, voor de RAM zie ik dat niet gebeuren.

Verwijderd

DLSS is nu getest door HardwareUnboxed. Conclusie: upscaled naar 4k met DLSS geeft een minder goede beeldkwaliteit dan 4k zonder upscaling. Dat is logisch en dat werd verwacht maar nu weten we het zeker. Je krijgt de hogere FPS maar je hebt nog steeds niet echt 4k, nog los van de vraag of dat het spel wel 4k-textures bevat (meestal niet). Volgens hem zit de kwaliteit overigens wel dichter bij 4k dan bij 1440p. Bij de Infiltrator demo was de kwaliteit met DLSS (4k) vergelijkbaar met rendering @1800p upscaled naar 4k, en dat kan een 1080 Ti ook prima doen.

[ Voor 34% gewijzigd door Verwijderd op 28-09-2018 14:26 ]

Als we het toch over upscaling etc hebben, is er op de PC eigenlijk ondersteunen voor checkerborden, a-la wat de PS4 pro doet om "4K" te tonen? Vraag me af hoe dat zich zou verhouden tot DLSS upscale.

En als DLSS ongeveer gelijk is aan 1800p upscale wat een 1080Ti ook prima doet, is dat dus een verkoop argument minder..

En als DLSS ongeveer gelijk is aan 1800p upscale wat een 1080Ti ook prima doet, is dat dus een verkoop argument minder..

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Tegen een mooi prijsje (€ 530) een de Gigabyte 1080ti OC Windforce 11GB weten te bemachtigen met nog 26 maanden garantie. Gisteren ingebouwd en wat games gespeeld. Wat. Een. Beest. En dat op standaard clock speed.

Alles wat ik hiervoor speelde op mijn i5 8400K, 16gb met RX580 8gb, 1440p, wordt ingame gewoon +75% / 100% denk ik. Ik speelde WItcher 3 op high en kwam rond de 40-50 frames. Met de 1080ti knal ik naar de 90 fps met alles op ultra en volledig aan.

Zo ook met BF1, PUBG, BF4 en straks waarschijnlijk ook met BF5. Niet normaal wat een verschil met de RX580 serie. Welke toch te vergelijken is met de 1060. Ik had wel een stap verwacht, maar dit is echt een hele grote sprong. Post Scriptum moet ik nog testen, maar die zal ook best een sprong maken denk ik.

Ik kan wel weer een paar jaartjes vooruit denk ik zo!

Alles wat ik hiervoor speelde op mijn i5 8400K, 16gb met RX580 8gb, 1440p, wordt ingame gewoon +75% / 100% denk ik. Ik speelde WItcher 3 op high en kwam rond de 40-50 frames. Met de 1080ti knal ik naar de 90 fps met alles op ultra en volledig aan.

Zo ook met BF1, PUBG, BF4 en straks waarschijnlijk ook met BF5. Niet normaal wat een verschil met de RX580 serie. Welke toch te vergelijken is met de 1060. Ik had wel een stap verwacht, maar dit is echt een hele grote sprong. Post Scriptum moet ik nog testen, maar die zal ook best een sprong maken denk ik.

Ik kan wel weer een paar jaartjes vooruit denk ik zo!

[ Voor 6% gewijzigd door StealthyPeanut op 28-09-2018 14:48 ]

Checkerboard rendering is zeker mogelijk op de PC, alleen de potentiële performancewinst die hierbij behaald kan worden is minder groot dan bij de PS4. Dit is omdat de PS4 Pro een hardwarematige implementatie heeft van het upscaling algoritme, een feature speciaal toegevoegd aan de GPU door AMD op verzoek van Sony. Hiermee krijgt de PS4 Pro in wezen een "gratis" upscale naar 4K.vectormatic schreef op vrijdag 28 september 2018 @ 14:42:

Als we het toch over upscaling etc hebben, is er op de PC eigenlijk ondersteunen voor checkerborden, a-la wat de PS4 pro doet om "4K" te tonen? Vraag me af hoe dat zich zou verhouden tot DLSS upscale.

En als DLSS ongeveer gelijk is aan 1800p upscale wat een 1080Ti ook prima doet, is dat dus een verkoop argument minder..

De Xbox One X kan in principe ook checkerboard rendering doen (Microsoft noemt dat "sparse rendering" in hun PR praatjes), maar omdat die GPU krachtig genoeg is om native 4K te doen in veel titels en omdat de checkerboard upscale daar wel de nodige GPU resources zou opsnoepen, wordt dat in de praktijk eigenlijk niet gebruikt.

Dank, op de PC is het dus niet interessant, tot nvidia danwel amd HW support hiervoor in hun GPUs bakt, en dus geen alternatief voor DLSS of gewoon upscalenDevil N schreef op vrijdag 28 september 2018 @ 14:48:

[...]

Checkerboard rendering is zeker mogelijk op de PC, alleen de potentiële performancewinst die hierbij behaald kan worden is minder groot dan bij de PS4. Dit is omdat de PS4 Pro een hardwarematige implementatie heeft van het upscaling algoritme, een feature speciaal toegevoegd aan de GPU door AMD op verzoek van Sony. Hiermee krijgt de PS4 Pro in wezen een "gratis" upscale naar 4K.

De Xbox One X kan in principe ook checkerboard rendering doen (Microsoft noemt dat "sparse rendering" in hun PR praatjes), maar omdat die GPU krachtig genoeg is om native 4K te doen in veel titels en omdat de checkerboard upscale daar wel de nodige GPU resources zou opsnoepen, wordt dat in de praktijk eigenlijk niet gebruikt.

Master of the allen wrench Riding a mighty lawnmower for revenge In the realm of the screws he's the king And Lord of the Towel Rings

Ik heb zelf ook een nieuwe 1080ti, draaide de demo van Forza Horizon 4, 1200p alles op Ultra met 60fp en een load van 40% op de gpuStealthyPeanut schreef op vrijdag 28 september 2018 @ 14:44:

Tegen een mooi prijsje (€ 530) een de Gigabyte 1080ti OC Windforce 11GB weten te bemachtigen met nog 26 maanden garantie. Gisteren ingebouwd en wat games gespeeld. Wat. Een. Beest. En dat op standaard clock speed.

Alles wat ik hiervoor speelde op mijn i5 8400K, 16gb met RX580 8gb, 1440p, wordt ingame gewoon +75% / 100% denk ik. Ik speelde WItcher 3 op high en kwam rond de 40-50 frames. Met de 1080ti knal ik naar de 90 fps met alles op ultra en volledig aan.

Zo ook met BF1, PUBG, BF4 en straks waarschijnlijk ook met BF5. Niet normaal wat een verschil met de RX580 serie. Welke toch te vergelijken is met de 1060. Ik had wel een stap verwacht, maar dit is echt een hele grote sprong. Post Scriptum moet ik nog testen, maar die zal ook best een sprong maken denk ik.

Ik kan wel weer een paar jaartjes vooruit denk ik zo!

Heb je zelf al door dat je bij een 40% gpu load ook af had gekund met een 50% tragere kaart?Brilsmurfffje schreef op vrijdag 28 september 2018 @ 16:18:

[...]

Ik heb zelf ook een nieuwe 1080ti, draaide de demo van Forza Horizon 4, 1200p alles op Ultra met 60fp en een load van 40% op de gpu

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Future proof en deze kwam in een 700 kostende pc, dus eigenlijk een no-brainersdk1985 schreef op vrijdag 28 september 2018 @ 19:18:

[...]

Heb je zelf al door dat je bij een 40% gpu load ook af had gekund met een 50% tragere kaart?

In andere spellen kan hij wel harder aan het werk, Planet Coaster

Verwijderd

Truthbomb!sdk1985 schreef op vrijdag 28 september 2018 @ 19:18:

[...]

Heb je zelf al door dat je bij een 40% gpu load ook af had gekund met een 50% tragere kaart?

No offense Brilsmurf, misschien heb jij wel een goede reden hiervoor, maar veel mensen kunnen een beter gebalanceerd systeem hebben of besteden veel te veel aan hun grafische kaart voor wat zij ermee doen (1080p en niet het verschil merken tussen 100 en 200 FPS bijvoorbeeld

Futureproofing, prima, maar dan moet het wel gelden dat je aanzienlijk minder dan X% extra betaalt voor X% extra performance of zeker weten dat je bijvoorbeeld 5 jaar met je grafische kaart doet in plaats van 3 jaar of zo.

Meer ontopic weer.

Raytracing is compleet irrelevant voor de komende paar jaar, zelfs een 1080 Ti kan het niet aan met een fatsoenlijke resolutie en FPS. DLSS is leuk maar zeker niet de extra kosten waard in vergelijking met Pascal met de huidige prijzen. DLSS is een leuk idee maar het is zeker niet de extra kosten waard: je krijgt een verlies in grafische kwaliteit (vergelijkbaar met TAA, soms beter en soms slechter) en het wordt enkel ondersteund voor een klein aantal spellen. Een supercomputer moet als het ware het spel spelen zodat de drivers de juiste code kunnen krijgen voor DLSS. Als je een Nvidia-kaart wil kopen dan zou ik de 1080 Ti in de gaten houden en daarop happen wanneer de prijs daalt.vectormatic schreef op vrijdag 28 september 2018 @ 14:50:

[...]

Dank, op de PC is het dus niet interessant, tot nvidia danwel amd HW support hiervoor in hun GPUs bakt, en dus geen alternatief voor DLSS of gewoon upscalen

Ik zou echter ook eens kijken naar de Vega56 en daarvoor bij Caekings kijken (veel betere prijzen dan hier en ze leveren naar Nedlerand en hebben een Nederlandstalige website!). Ik zou vooral wachten op Navi (ongeacht of dat je een AMD- of Nvidia-kaart kiest, het aanbod bij Nvidia gaat dan ook beter worden!) maar dan kan je wel tot zo'n 9 maanden moeten wachten. Die keuze is aan jou. Als je de Vega56 kaart een beetje tunet dan heb je een hele leuke kaart met dezelfde performance maar een lager vermogen dan de 1070 Ti. De Sapphire Nitro is de beste (regelmatig voor €460 te koop bij Casekings) maar de Sapphire Pulse is ook ok.

[ Voor 73% gewijzigd door Verwijderd op 28-09-2018 21:08 ]

Installeren jullie het Geforce Experience gebeuren?

Cappen doe ik nu niet maar met bf5 misschien wel weer wat. Verder wil ik eigenlijk onder het spelen zien wat mij systeem doet qua fps cpu gpu ram percentages en temperaturen. Is dit via die overlay mogelijk of alleen fps?

En voegt het verder nog wat toe eigenlijk?

Cappen doe ik nu niet maar met bf5 misschien wel weer wat. Verder wil ik eigenlijk onder het spelen zien wat mij systeem doet qua fps cpu gpu ram percentages en temperaturen. Is dit via die overlay mogelijk of alleen fps?

En voegt het verder nog wat toe eigenlijk?

Geforce experience kan enkel FPS tonen.StealthyPeanut schreef op zaterdag 29 september 2018 @ 11:36:

Installeren jullie het Geforce Experience gebeuren?

Cappen doe ik nu niet maar met bf5 misschien wel weer wat. Verder wil ik eigenlijk onder het spelen zien wat mij systeem doet qua fps cpu gpu ram percentages en temperaturen. Is dit via die overlay mogelijk of alleen fps?

En voegt het verder nog wat toe eigenlijk?

Voor meer info heb je beter Rivatuner via MSI Afterburner of HWInfo.

Geforce experience is vooral handig als je iets zou willen opnemen/streamen.

Nee zeker niet. Heb er een hekel aan dat je je weer moet registreren wat ik BS vind.StealthyPeanut schreef op zaterdag 29 september 2018 @ 11:36:

Installeren jullie het Geforce Experience gebeuren?

Cappen doe ik nu niet maar met bf5 misschien wel weer wat. Verder wil ik eigenlijk onder het spelen zien wat mij systeem doet qua fps cpu gpu ram percentages en temperaturen. Is dit via die overlay mogelijk of alleen fps?

En voegt het verder nog wat toe eigenlijk?

Voordat je het weet heeft nvidia het weer zo geregeld dat je alleen updates en dat soort dingen krijgt via GE en losse drivers niet meer levert. Zit je straks weer vast aan een bloated driver/tooltjes pakket.

Ik bedank ervoor en geeft de voorkeur aan losse drivers waarbij ik alleen de hoogstnodige items installeer.

GE bevat wel een aantal interessante tools mits je die ook gebruikt.

FPS ingame en dat soort dingen doe ik gewoon via andere tools die vaak ook veel meer customization bieden.

GE kan dacht ik ook alleen FPS tonen.

Je kunt het natuurlijk gewoon een keer proberen om te zien of het iets toevoegd voor je.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Het kan even goed dat dat hij CPU-bound issdk1985 schreef op vrijdag 28 september 2018 @ 19:18:

[...]

Heb je zelf al door dat je bij een 40% gpu load ook af had gekund met een 50% tragere kaart?

En "GPU load" is incorrect, ongeacht welke tool je gebruikt. 100% GPU load betekent niet dat de GPU volledig belast is. Dat betekent dat 100% van de (in Nvidia's geval) SMs "werk hebben". Het betekent echter niet dat alle ALU's werk hebben (en dan neem ik ALU's zo breed als mogelijk: SP's, geometry units, texture units - de hele rataplan). Met andere woorden, "100%" in de ene game is iets anders dan in een andere game en je kunt met "100%" ook even goed op 40 FPS zitten als op 144 FPS

Dit is dus het geval met DLSS. Installeer je GFE niet, krijg je alleen geüpdate NN met driver releases.Help!!!! schreef op zaterdag 29 september 2018 @ 11:46:

Voordat je het weet heeft nvidia het weer zo geregeld dat je alleen updates en dat soort dingen krijgt via GE en losse drivers niet meer levert. Zit je straks weer vast aan een bloated driver/tooltjes pakket.

[ Voor 4% gewijzigd door Werelds op 30-09-2018 11:55 ]

Deze was volgens mij nog niet langsgekomen:

https://techreport.com/bl...with-tr-freesync-monitors

Ik kan bevestigen dat ik in de Windmill demo inderdaad geen tearing zie (getest met een 480 FPS camera) wanneer ik VSync aanzet en 45 FPS forceer op een FreeSync monitor.

https://techreport.com/bl...with-tr-freesync-monitors

Ik kan bevestigen dat ik in de Windmill demo inderdaad geen tearing zie (getest met een 480 FPS camera) wanneer ik VSync aanzet en 45 FPS forceer op een FreeSync monitor.

[ Voor 3% gewijzigd door Paprika op 30-09-2018 13:33 ]

staat een update bij dat het niet aan de kaart ligt maar windows:Paprika schreef op zondag 30 september 2018 @ 13:33:

Deze was volgens mij nog niet langsgekomen:

https://techreport.com/bl...with-tr-freesync-monitors

Ik kan bevestigen dat ik in de Windmill demo inderdaad geen tearing zie (getest met een 480 FPS camera) wanneer ik VSync aanzet en 45 FPS forceer op een FreeSync monitor.

Update 9/30/18 3:22 AM: After further research and the collection of more high-speed camera footage from our G-Sync displays, I believe the tear-free gameplay we're experiencing on our FreeSync displays in combination with GeForces is a consequence of Windows 10's Desktop Window Manager adding some form of Vsync to the proceedings when games are in borderless windowed mode, rather than any form of VESA Adapative-Sync being engaged with our GeForce cards. Pending a response from Nvidia as to just what we're experiencing, I'd warn against drawing any conclusions from our observations at this time and sincerely apologize for any misleading conclusions we've presented in our original article. The original piece continues below for posterity.

Ah, ik had dit artikel gelezen voordat de update erbij werd vermeld en had het nu pas gepost, jammer.TweakerVincent schreef op zondag 30 september 2018 @ 13:39:

[...]

staat een update bij dat het niet aan de kaart ligt maar windows

NVIDIA heeft ook een goede demo hiervoor overigens:

https://www.nvidia.com/coolstuff/demos#!/g-sync

Dan een andere:

NVFLASH 5.513.0 leaked for Turing cards, can crossflash EVGA 130% PL BIOS

Powerlimit increase door de EVGA bios te flashen!Nieuwe NVFlash build (geleaked door Palit dus toen is ie officieel vrijgegeven):

https://www.techpowerup.com/download/nvidia-nvflash/

GPU-Z versie pre-release (met bios-dump feature voor Turing GPUs):

https://www.techpowerup.c...chments/gpu-z-exe.107772/

EVGA reference PCB 2080Ti XC 130% power target bios:

https://1drv.ms/u/s!Ag_XVLcPG3PXdEB5IR1bmbk-4iQ

Mocht iemand een EVGA RTX2080 (niet Ti dus) bezitten, pas s.v.p. de powerlimit increase even toe (https://forums.evga.com/E...BIOS-Update-m2858793.aspx) en dump je bios m.b.v. GPU-Z en deel hem hier dan even...

[ Voor 89% gewijzigd door Paprika op 30-09-2018 14:09 ]

Ik had geen zin om te wachten en daarom maar een klein tooltje gemaakt om deze uit de updater executabels van EVGA te trekken. Bij dezen de 4 EVGA 130% PL biossen.

https://drive.google.com/...2YcPPllRcBM3t?usp=sharing

https://drive.google.com/...2YcPPllRcBM3t?usp=sharing

Wat een onzinnige toevoeging is dit nu weerWerelds schreef op zondag 30 september 2018 @ 11:55:

[...]

Het kan even goed dat dat hij CPU-bound is

En "GPU load" is incorrect, ongeacht welke tool je gebruikt. 100% GPU load betekent niet dat de GPU volledig belast is. Dat betekent dat 100% van de (in Nvidia's geval) SMs "werk hebben". Het betekent echter niet dat alle ALU's werk hebben (en dan neem ik ALU's zo breed als mogelijk: SP's, geometry units, texture units - de hele rataplan). Met andere woorden, "100%" in de ene game is iets anders dan in een andere game en je kunt met "100%" ook even goed op 40 FPS zitten als op 144 FPS

[...]

Dit is dus het geval met DLSS. Installeer je GFE niet, krijg je alleen geüpdate NN met driver releases.

Overigens kan ik mij een 100% load uberhaupt niet herinneren, meestal zit je in de praktijk op 97-99% op de rivatuner overlays. Neemt niet weg dat je in dat geval wel kei hard een gpu bottleneck te pakken hebt. Vuistregel, op basis van mijn ervaring, zit op 96%+.

EVGA is gestopt met dual bios? Mijn pascal EVGTA FTW heeft een switch en die tweede bios heeft standaard de hogere power limit en de fans blijven dan altijd draaien.Paprika schreef op zondag 30 september 2018 @ 13:40:

[...]

Ah, ik had dit artikel gelezen voordat de update erbij werd vermeld en had het nu pas gepost, jammer.

NVIDIA heeft ook een goede demo hiervoor overigens:

https://www.nvidia.com/coolstuff/demos#!/g-sync

Dan een andere:NVFLASH 5.513.0 leaked for Turing cards, can crossflash EVGA 130% PL BIOS

Powerlimit increase door de EVGA bios te flashen!

Nieuwe NVFlash build (geleaked door Palit dus toen is ie officieel vrijgegeven):

https://www.techpowerup.com/download/nvidia-nvflash/

GPU-Z versie pre-release (met bios-dump feature voor Turing GPUs):

https://www.techpowerup.c...chments/gpu-z-exe.107772/

EVGA reference PCB 2080Ti XC 130% power target bios:

https://1drv.ms/u/s!Ag_XVLcPG3PXdEB5IR1bmbk-4iQ

Mocht iemand een EVGA RTX2080 (niet Ti dus) bezitten, pas s.v.p. de powerlimit increase even toe (https://forums.evga.com/E...BIOS-Update-m2858793.aspx) en dump je bios m.b.v. GPU-Z en deel hem hier dan even...

[ Voor 31% gewijzigd door sdk1985 op 30-09-2018 16:47 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

DLSS is toch wel meer dan een simpele upscale? Hoe upscale je trouwens met een GTX 1080Ti van 1080p naar 4k of 1440p zonder dat alles super groot word?

[ Voor 4% gewijzigd door Gekke Jantje op 30-09-2018 16:53 ]

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Het is een simpele upscale van 1080p naar 4k bijvoorbeeld, alleen hebben ze met deep learning het net wat mooier gekregen dan bijvoorbeeld checkerboard rendering.Gekke Jantje schreef op zondag 30 september 2018 @ 16:52:

DLSS is toch wel meer dan een simpele upscale? Hoe upscale je trouwens met een GTX 1080Ti van 1080p naar 4k of 1440p zonder dat alles super groot word?

Tools zoals GeDoSaTo . De term die jij zoekt heet downsampling (renderen op hoge resolutie en dan op een lagere resolutie laten zien). Zowel Nvidia als AMD kunnen dit via de driver met Dynamic Super Resolution (DSR, Nvidia) of Virtual Super Resolution (VSR, AMD).

Sourcecode hier:

https://github.com/PeterTh/gedosato