PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

In mijn ogen bevestigt dat dat er weinig tot geen verbetering in power efficiency zal zitten tussen pascal en deze opvolger. Waarom zou je een kaart anders meer stroom laten gebruiken? Voor de performance kroon hoeven ze het niet te doen iig.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Lijkt het wel op idd.Blaat schreef op vrijdag 10 augustus 2018 @ 09:58:

[...]

In mijn ogen bevestigt dat dat er weinig tot geen verbetering in power efficiency zal zitten tussen pascal en deze opvolger. Waarom zou je een kaart anders meer stroom laten gebruiken? Voor de performance kroon hoeven ze het niet te doen iig.

Tussen maxwell en pascal herinner ik me heeft nvidia veel tijd en geld besteed aan het optimaliseren van de transistor layout. Daarnaast was dacht ik de tile based rendering een oorzaak vd efficientie.

Een 1080 presteerde meen ik vergelijkbaar of ietsje beter dan een 980Ti.

Denk dat het lastig is om nu 1080Ti prestaties te halen zonder ook grote stap op node gebied te zetten. Dan moet namelijk alles uit architectuur komen en dat lijkt me wel een beetje erg veel gevraagd.

Kan natuurlijk ook dat de architectuur nieuwe functionaliteit bevat die meer stroom gebruikt en/of het ontwerp behoorlijk anders is.

Anyway lijkt er inderdaad op dat verbetering power efficiency niet echt te verwachten valt.

Ben benieuwd.

Hier nog wat linkjes:

NVIDIA Allegedly Building Dual Fan GTX 2080 Founder’s Edition – Galax Confirms September Release & Touts “Breakthrough” Performance

NVIDIA GeForce GTX 20/11-series Rumor Roundup #2

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Ryzen 5950x + 32GB GSKILL @3600 op Rog Strix Gaming E x570 + Asrock Phantom Gaming 6800XT+ Gigabyte Aorus FV43U Zwart + DS1621+ + DS414 + MacbookPro 16" 2021 + Mac Mini M4 Pro + Tesla MY RWD 2023 BYD

Verwijderd

Nemen in het algemeen de stutter en microstutter af als je een framelimiter gebruikt wanneer je met twee grafische kaarten en 4k/5k...resolutie gamet?[b]Werelds schreef op woensdag 8 augustus 2018 @ 11:41:SLI/CFX is vooral boeiend op extreem hoge resoluties zoals waar @edward2 op speelt. Je frametijden liggen dan sowieso al een stuk hoger, maar zullen ook relatief constant zijn waardoor je een stuk minder microstuttering hebt. Wil je op 120/144 gamen, kun je juist beter geen SLI/CFX nemen omdat je juist dan waarschijnlijk dusdanige framerates kunt halen dat de frametijden juist wel erg variëren. En zelfs 1-2ms variatie kan dan al funest zijn, omdat dat het verschil kan maken tussen wel of geen tearing (zonder V-Sync) of tussen een frame input lag (met V-Sync). Op 144 Hz heb je immers slechts net geen 7ms tussen frames. 1ms is dan al meteen 14,29% van je totaal beschikbare tijd tussen frames.

Ik kan me voorstellen dat je dan minder variatie hebt omdat de twee kaarten het samen nog kunnen bijbenen zolang de taken tussen die kaarten per frame goed verdeeld zijn.

Ik heb het nooit echt vergeleken en met programma's geanalyseerd, maar spelende op 5K is de perf. gewoonweg te laag in veel games met 1 GPU. Maar zoals ik het nu allemaal heb ingesteld, ben ik behoorlijk tevreden met SLI, hoewel het wel minder wordt kwa support in nieuwere games.Verwijderd schreef op vrijdag 10 augustus 2018 @ 11:25:

[...]

Nemen in het algemeen de stutter en microstutter af als je een framelimiter gebruikt wanneer je met twee grafische kaarten en 4k/5k...resolutie gamet?

Ik kan me voorstellen dat je dan minder variatie hebt omdat de twee kaarten het samen nog kunnen bijbenen zolang de taken tussen die kaarten per frame goed verdeeld zijn.

Vwb de geruchten; lekker die prijs van de Titan RTX, om er meer dan 10% op vooruit te gaan moet ik €6000 neer leggen

Niet op voorraad.

Gebrek aan concurrentie.edward2 schreef op vrijdag 10 augustus 2018 @ 12:02:

Waarom is de Titan zo weer zo veel duurder...

Die ontbrak al langer op dat perf. vlak, zei het straks natuurlijk nog veel meer, maar de verschillen zijn nu wel erg groot. Voor €1500/stuk was ik misschien nog wel zo gek om er 2 te kopen, maar dit is echt te out of the question..

Niet op voorraad.

Elke Titan RTX zouden ze ook in het professionele marktsegment kunnen verkopen voor minimaal hetzelfde.

En er is geen concurrentie (van AMD).

Dus idd voor ons particulieren een absurde prijs, alleen zinvol voor de echte liefhebbers en mensen met zeer hoog disposable income. Het zou me niet verbazen, als de geruchten over deze kaart waar zijn dat ook de prijs waar is.

Aan de andere kant. Als de Titan RTX inderdaad accross the board 50% sneller is dan een 1080Ti dan kun jij denk ik beter je huidige kaarten (Titan's toch?) verkopen en één RTX nemen. Volgensmij levert dat een betere ervaring op dan SLI.

Of een maand of 10 geduld hebben totdat ze een 2080Ti op de markt brengen voor E900 a 1000.

[ Voor 21% gewijzigd door Help!!!! op 10-08-2018 13:14 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Ik zit nu met 2 1080Ti's custom gekoeld met een AIO-setje na m'n RXVega CF avontuur wat niet echt uit de verf gekomen was.

Dan zal er later idd wel een Ti/Titan variant komen die wat minder extreem geprijsd is.

Ik wil sowieso Metro Exodus met raytracing spelen, dus een vorm van een RTX zal er wel komen

[ Voor 11% gewijzigd door edward2 op 10-08-2018 13:34 ]

Niet op voorraad.

Een Titan RTX en de Ti's verkopen is misschien best interessant voor de liefhebber.

Denk dat het beste is als nVidia gewoon even gauw de launch doet,dan weten we tenminste in hoeverre de rumors kloppen.

Als een 2080 idd iets sneller is dan mijn 1080Ti ga ik wel over want het is leuk om weer wat nieuws te hebben. Enige is dat ik veel liever een custom kaart heb dan een FE. Maar misschien is de FE koeler nu ook wel prima en inclusief niet draaiende fans bij weinig belasting.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

De prijzen gaan ook niet zakken. Mensen die nu een tweedehands 1080Ti hebben gekocht voor 650 oid hebben daar absoluut geen miskoop aan gehad.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

De mogelijk later komende game Titan misschien wel, al zou ik ook wel eens met die HMB2 variant willen spelen, maar 3000 is gewoon te gek. Idd maar eens afwachten hoe het perf. en feature plaatje er echt uitziet.Help!!!! schreef op vrijdag 10 augustus 2018 @ 13:31:

^

Een Titan RTX en de Ti's verkopen is misschien best interessant voor de liefhebber.

Denk dat het beste is als nVidia gewoon even gauw de launch doet,dan weten we tenminste in hoeverre de rumors kloppen.

Als een 2080 idd iets sneller is dan mijn 1080Ti ga ik wel over want het is leuk om weer wat nieuws te hebben. Enige is dat ik veel liever een custom kaart heb dan een FE. Maar misschien is de FE koeler nu ook wel prima en inclusief niet draaiende fans bij weinig belasting.

Baal van het business model dat je eerst weer een tijd moet wachten voordat het huidige snelste consumer model eens echt gepasseerd gepasseerd wordt, maar wellicht een logisch gevolg omdat de Ti's bv. left overs zijn uit de prof. markt die uiteraard eerst bediend wordt.

Niet op voorraad.

Dat was Nvidia's special sauce voor Maxwell inderdaadHelp!!!! schreef op vrijdag 10 augustus 2018 @ 10:51:

Daarnaast was dacht ik de tile based rendering een oorzaak vd efficientie.

Pascal is vooral een verfijning qua procedé.

Hangt helemaal van de frame limiter af. Een geforceerde limiter vanuit een driver niet, daar heb je geen reet aan. Een frame limiter in-engine kan daar wel mee helpen; mits dat betekent dat er ook aan framepacing gedaan wordt. Dat laatste is hetgeen waar de stabiliteit vandaan komt, niet zo zeer de limiet op de framerate zelf. Er zijn genoeg games waar de frame limiter hetzelfde doet als die in een driver, wat gewoon min of meer neer komt op procrastineren in plaats van renderen omdat je anders te veel doet. Een degelijke limiter + pacer doet dat iets intelligenter.Verwijderd schreef op vrijdag 10 augustus 2018 @ 11:25:

Nemen in het algemeen de stutter en microstutter af als je een framelimiter gebruikt wanneer je met twee grafische kaarten en 4k/5k...resolutie gamet?

Ik kan me voorstellen dat je dan minder variatie hebt omdat de twee kaarten het samen nog kunnen bijbenen zolang de taken tussen die kaarten per frame goed verdeeld zijn.

Verwijderd

Omdat Nvidia ermee wegkomt en voldoende mensen de prijskaart van €3000 slikten.edward2 schreef op vrijdag 10 augustus 2018 @ 12:02:

Vwb de geruchten; lekker die prijs van de Titan RTX, om er meer dan 10% op vooruit te gaan moet ik €6000 neer leggen. Waarom is de Titan zo weer zo veel duurder...

Die Titan-kaarten hebben nooit bang for the € geleverd, verstandige gamers die per se de beste performance willen hebben wachten pak hem beet een half jaar op de *80ti.

Intel had ten tijde van hun monopolie een mooi antwoord op de vraag waarom ze een MSRP van $1800 plakten op hun 10c-CPU. "Om de elasticiteit van de markt te testen". Of iets wat hierop neerkomt (ze gebruikten letterlijk het woord elasticiteit), het ging om prijselasticiteit. Bron: Gordon Mah Ung van PCWorld. Het lijkt mij dat Nvidia hier precies hetzelfde doet, elke generatie gaat de prijs omhoog zolang de winst stijgt, enkel als voldoende mensen die de Titan-kaart kochten het niet meer doen dan zal de prijs niet langer stijgen en zelfs wat dalen.

Ach, X generaties later doe ik dat wel eens, dan kan je het tenminse in 1 keer fatsoenlijk doen in plaats van dat de FPS tankt doordat je een beetje raytracing aanzet.Dan zal er later idd wel een Ti/Titan variant komen die wat minder extreem geprijsd is.

Ik wil sowieso Metro Exodus met raytracing spelen, dus een vorm van een RTX zal er wel komen

De vraag is alleen hoeveel generaties we gaan moeten wachten, ook van die Ttitan verwacht ik weinig op dit vlak (lage FPS als je dat doet).

[ Voor 58% gewijzigd door Verwijderd op 10-08-2018 15:30 ]

Een framerate limiter vanuit rivatuner werkt als een trein voor o.a. rainbow six siege. Die game heeft namelijk het probleem dat meer fps ook relatief veel cpu kracht kost. Als er dan wat gebeurd dan krijg je een dip in je framerate. Door te beperkte blijft er cpu overhead over en zie je de frametimes met sprongen vooruit gaan.Werelds schreef op vrijdag 10 augustus 2018 @ 13:48:

[...]

Dat was Nvidia's special sauce voor Maxwell inderdaad

Pascal is vooral een verfijning qua procedé.

[...]

Hangt helemaal van de frame limiter af. Een geforceerde limiter vanuit een driver niet, daar heb je geen reet aan. Een frame limiter in-engine kan daar wel mee helpen; mits dat betekent dat er ook aan framepacing gedaan wordt. Dat laatste is hetgeen waar de stabiliteit vandaan komt, niet zo zeer de limiet op de framerate zelf. Er zijn genoeg games waar de frame limiter hetzelfde doet als die in een driver, wat gewoon min of meer neer komt op procrastineren in plaats van renderen omdat je anders te veel doet. Een degelijke limiter + pacer doet dat iets intelligenter.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Als ik kijk naar de geruchten vraag ik me af of die Titan wel een "gaming" kaart zal worden. De Titans waarvan je nog zou kunnen beargumenteren dat deze voor gaming zijn zitten zo rond de €1200 per kaart (bijv. de Titan Xp). De Compute georiënteerde Titan V met de GV100 "monster die" chip kost dan wel €3000, als ik deze geruchten zo zie verwacht ik hier dan eigenlijk ook weer een compute georiënteerde Titan als deze inderaad €3000 gaat kosten, waar natuurlijk wel op gegamed kan worden, maar die niet voor gaming op de markt gezet zal worden.edward2 schreef op vrijdag 10 augustus 2018 @ 12:02:

Vwb de geruchten; lekker die prijs van de Titan RTX, om er meer dan 10% op vooruit te gaan moet ik €6000 neer leggen. Waarom is de Titan zo weer zo veel duurder...

Qua chip zie ik het ook wel qua diesize, naam, prijs etc. Ik vermoed 12nm monsters, de gebruikelijke verbeterde compressietechnieken en een boost in geheugen bandbreedte met dank aan GDDR6. Aan de ALU kant gok op op niet langer kunstmatig kreupel gemaakte PF16 compute zodat er daadwerkelijk wat ray tracing kan plaatsvinden. Aangezien Nvidia onderhand beter hun GeForce lijn kan hernoemen naar RayForce, zal er toch wat ray tracing mogelijk moeten zijn, vermoed ik zo.

Op de achtergrond hoor ik nou echt niemand eens de overduidelijke implicatie van Nvidia hun ray tracing push uitspellen. Vrijwel niemand lijkt zich te beseffen dat ray tracing exclusief voor de low level API's gaat zijn. Aangezien Nvidia dit gaat pushen, betekent dit defacto het einde van DX11 als standaard, eindelijk. De hulp van Nvidia om AMD hardware eens zonder bottleneck laten draaien zullen ze bij de RTG ook kunnen waarderen.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ja daar kwam ik ook op terug in m'n volgende post. Het zal wel de opvolger of verbetering van de TitanV zijn.Dennism schreef op vrijdag 10 augustus 2018 @ 17:24:

[...]

Als ik kijk naar de geruchten vraag ik me af of die Titan wel een "gaming" kaart zal worden. De Titans waarvan je nog zou kunnen beargumenteren dat deze voor gaming zijn zitten zo rond de €1200 per kaart (bijv. de Titan Xp). De Compute georiënteerde Titan V met de GV100 "monster die" chip kost dan wel €3000, als ik deze geruchten zo zie verwacht ik hier dan eigenlijk ook weer een compute georiënteerde Titan als deze inderaad €3000 gaat kosten, waar natuurlijk wel op gegamed kan worden, maar die niet voor gaming op de markt gezet zal worden.

Voor de huidige 1080Ti/TitanX(P) gamers zit er dan waarschijnlijk niet veel bij voorlopig, behoudens raytracing en misschien wat andere features en hogere dx12/Vulcan perf.

Met Pascal ging je er uiteindelijk nog 20-30% op vooruit (van 980Ti naar 1080...)

[ Voor 3% gewijzigd door edward2 op 10-08-2018 17:44 ]

Niet op voorraad.

Ho even, R6S heeft daar last van omdat de engine brak is, niet omdat je meer frames probeert te renderen dan de CPU kan leveren.sdk1985 schreef op vrijdag 10 augustus 2018 @ 15:47:

[...]

Een framerate limiter vanuit rivatuner werkt als een trein voor o.a. rainbow six siege. Die game heeft namelijk het probleem dat meer fps ook relatief veel cpu kracht kost. Als er dan wat gebeurd dan krijg je een dip in je framerate. Door te beperkte blijft er cpu overhead over en zie je de frametimes met sprongen vooruit gaan.

Dat spel knoopt de netcode, physics en graphics op een rare manier aan elkaar, waarbij laatstgenoemde eigenlijk de laagste prioriteit krijgt. Combineer dat met de beperkte threading van het spel en een frame limiter werkt omdat je geen frames probeert te renderen die moeten wachten op netcode en physics ticks. Ja, je bent CPU-bound, maar dat is om een totaal andere reden dan waar wij het over hadden

Dit is een andere situatie dan waar ik het over had en hier kunnen geforceerde limits wel van pas komen, hoewel het nog steeds beter zou zijn als Ubi er zelf eens werk van maakte (door ofwel te pacen, ofwel verder dan 4 cores/"threads" te kunnen gaan)..hen kennende wordt dat echter pas als pasen en pinksteren op één dag vallen, met Sint Juttemis of als de hel bevriest

Jouw specifieke voorbeeld is overigens niet al te best. Even los van het feit dat je het in online games benchmarkt, doe je het vervolgens ook op verschillende maps én gebruik je verschillende periodes uit je data.

Ik geloof niet dat jij zou cherry-picken om je punt te maken, maar als je dit goed wil doen moet je gewoon de benchmark tool gebruiken. Dat is tenminste relatief constant (alleen de physics berekeningen vallen telkens nét iets anders uit). Zo krijg je een betere dataset om naast elkaar te leggen én bespaar je jezelf wat hoofdpijn

Verwijderd

Wellicht ging niemand erop in omdat het voor zich spreekt? Laten we hopen dat dit het einde van DX11 en OpenGL inluidt voor AAA-spellen.DaniëlWW2 schreef op vrijdag 10 augustus 2018 @ 17:34:

Op de achtergrond hoor ik nou echt niemand eens de overduidelijke implicatie van Nvidia hun ray tracing push uitspellen. Vrijwel niemand lijkt zich te beseffen dat ray tracing exclusief voor de low level API's gaat zijn. Aangezien Nvidia dit gaat pushen, betekent dit defacto het einde van DX11 als standaard, eindelijk. De hulp van Nvidia om AMD hardware eens zonder bottleneck laten draaien zullen ze bij de RTG ook kunnen waarderen.

[ Voor 11% gewijzigd door Verwijderd op 10-08-2018 17:59 ]

En eerst krijgen we zoals gebruikelijk weer een stammenstrijd omdat nVidia haar eigen variant heeft en MS een andere. Toch

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Als je als zelfstandige een prima uurtje factuurtje draait betaal je hiervoor geen BTW en ben je na drie dagen klaar. Ik vind het weinig schokkend. Interessant? Nee, daarvoor game ik te weinig en als ik game is het zelden een recente release. Een 1180/2080 vind ik ruim voldoende (en is eigenlijk al overbodig

[ Voor 41% gewijzigd door Paprika op 10-08-2018 18:58 ]

Multiplayer was het enige waarin ik geintereseerd was. De ingebouwde benchmark bleek helaas juist niet representatief voor online. Wetenschappelijk testen is mogelijk door alle maps op 1 na uit te schakelen en dan een solo terrorist hunt te starten (dan kun je de spawnplek kiezen) en dan een voorgeprogrammeerd trace af te leggen (autoit). Echter dat was voor mij totaal niet nodig. Heb een stuk of 20 traces opgeslagen en bekeken en elke keer kwam er hetzelfde uit. Het verschil tussen framerate limit X en geen framerate limit was dag en nacht. Als ik een bepaald beeld had willen verdraaien dan had ik de map name er niet bij gezetWerelds schreef op vrijdag 10 augustus 2018 @ 17:46:

[...]

offtopic:

Jouw specifieke voorbeeld is overigens niet al te best. Even los van het feit dat je het in online games benchmarkt, doe je het vervolgens ook op verschillende maps én gebruik je verschillende periodes uit je data.

Ik geloof niet dat jij zou cherry-picken om je punt te maken, maar als je dit goed wil doen moet je gewoon de benchmark tool gebruiken. Dat is tenminste relatief constant (alleen de physics berekeningen vallen telkens nét iets anders uit). Zo krijg je een betere dataset om naast elkaar te leggen én bespaar je jezelf wat hoofdpijn

Nadat ik zeker wist dat ik inderdaad een probleem had was de volgende vraag wat is voor mijn cpu de beste limit was. Online wil je gewoon geen rare dips en als je die wil krijgt dan moet je limit lager. Maar onder een bepaald punt zie je weinig effect meer. Uiteindelijk kwam ik op 80 fps, tegenwoordig heb ik een 8700K en cap ik op 120 fps

Maar goed lang verhaal kort kan ik voor rainbow six siege iedereen de framerate limiter aanraden, zelfs met een 8700K.

[ Voor 32% gewijzigd door sdk1985 op 10-08-2018 19:00 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Deze keer niet, waarschijnlijk dan.Help!!!! schreef op vrijdag 10 augustus 2018 @ 18:32:

Voor dat dat hele Raytracing impact heeft zijn we twee generaties verder. Daar hoef je de komende kaarten niet echt voor te kopen verwacht ik.

En eerst krijgen we zoals gebruikelijk weer een stammenstrijd omdat nVidia haar eigen variant heeft en MS een andere. Toch

RTX is niks meer dan Nvidia hun implementatie van Microsoft hun Ray tracing API die als aanvulling dient op DX12. AMD heeft ook gewoon een ray tracing API, maar die zit als onderdeel in zowel ProRender als Radeon GPU Profiler. Voor gaming is die tweede relevant. Die tweede is een debug tool om code voor AMD hardware te produceren die werkt. Wederom, low level API's werken op basis van geoptimaliseerde code van de developer, niet de videokaart fabrikant. Dergelijke tools zijn dus onmisbaar omdat je anders je game niet draaiden krijgt.

Verder reken er eigenlijk maar op dat BFV enige ray tracing zal hebben gezien de sponsoring door Nvidia. Of het ook voor AMD hardware zal werken, tja. Nee, er is waarschijnlijk geen hardwarematige reden waarom dat niet zou kunnen, tenminste niet voor Vega. Werelds heeft een tijdje geleden uitgelegd dat je voor dergelijke effecten naar FP16 compute moet kijken, en Vega heeft daar genoeg van voor basale ray tracing effecten. Zeker omdat RTX een hybride is tussen ray tracing en rasterization, zou het mogelijk moeten zijn.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Dit zal wel betekenen dat de nieuwe kaarten er al bijna zijn.

zal dat geen prijsfoutje zijn?Limitted schreef op zaterdag 11 augustus 2018 @ 09:44:

Een 1080 voor €290? https://www.sicomputers.nl/gf-gv-n1080ttoc-8gd.html

Dit zal wel betekenen dat de nieuwe kaarten er al bijna zijn.

349 euro

maar geloof ik ook niet echt?

Verwijderd

Worden de topkaarten vervangen voor RTX benaming?

Vond GTX wel lekker bekken.

We weten bijna niks. We horen alleen de wildste geruchten. Zinloos om er nu over te piekeren aangezien er maandag waarschijnlijk want antwoorden komen. Nee, dat is ook helemaal niet zeker.Verwijderd schreef op zaterdag 11 augustus 2018 @ 11:49:

Misschien lees ik er overheen, maar waarom naar RTX?

Worden de topkaarten vervangen voor RTX benaming?

Vond GTX wel lekker bekken.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Verwijderd

BedanktDaniëlWW2 schreef op zaterdag 11 augustus 2018 @ 11:53:

[...]

We weten bijna niks. We horen alleen de wildste geruchten. Zinloos om er nu over te piekeren aangezien er maandag waarschijnlijk want antwoorden komen. Nee, dat is ook helemaal niet zeker.

Dacht al ergens iets gemist te hebben.

Word tijd dat er eindelijk eens een opvolger komt...

Mijn Persoonlijk Nvidia Museum word zo wat completer haha.

Nvidia Geforce 256, Nvidia Geforce 275 en Geforce 295 (Dual GPU), Nvidia GTX 470, Nvidia GTX 570, Nvidia GTX 770, Nvidia GTX 950 & 970, kan dan nu mooi de GTX 1060 bij

de 750Ti is nog steeds in dagelijks gebruik

[ Voor 3% gewijzigd door Verwijderd op 11-08-2018 12:03 ]

Gezien de E3k rumored pricing wacht ik wel even op een Ti versie...

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Als dit klopt dan is dit een cut down Titan SKU, volgend jaar dus de Ti.Help!!!! schreef op zaterdag 11 augustus 2018 @ 13:47:

[...]

Gezien de E3k rumored pricing wacht ik wel even op een Ti versie...

Ja, deze zou cut down moeten zijn. 4352 Shading Units : 34 SM's = 128 shading units per SM. Dat is dus Maxwell/Pascal. Maar een volle chip van dit formaat zal hoogstwaarschijnlijk bestaan uit zes raster engines. GP102 bestond uit 30 SM's, en deze is 34 SM's. Nvidia die overstapt naar vier of acht raster engines komt ook niet uit op 34 SM's, en is eigenlijk niet logisch. 36 SM's komt wel uit met zes raster engines.

We kijken dus waarschijnlijk naar een Titan met twee uitgeschakelde SM's. Je kan er dus vanuit kan gaan dat er een nieuwe Titan X gaat verschijnen en de huidige Titan vervangen gaat worden voor een Ti die toevallig zeer vergelijkbaar zal presteren als de oude Titan.

Meer toevalligheden zijn dat GM200, de Maxwell Titan en Ti, over vier SM's per raster engine beschikten.

Pascal GP102 was vijf SM's per raster engine. Wat zou Volta/Turing/Ampère/whatever dan toch zijn?

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Eens. Vond het ook veel logischer dat ze op de topmodellen GTX plakken en op de lowend GT, maar dat is van vroegah.Verwijderd schreef op zaterdag 11 augustus 2018 @ 11:49:

Misschien lees ik er overheen, maar waarom naar RTX?

Worden de topkaarten vervangen voor RTX benaming?

Vond GTX wel lekker bekken.

RTX vind ik meer op de benaming van AMD lijken. Omdat ze al tijden de R gebruiken in combinatie met een nummer.

Vroeger zat midrange op GTS en dan high-end op GTX. Echter met de komst van de titans en later de 1080Ti is er in dollars een super segement boven high-end gekomen. Daar een andere combo op plakken is an sich zo gek nog niet.Sp3ci3s8472 schreef op zaterdag 11 augustus 2018 @ 20:18:

[...]

Eens. Vond het ook veel logischer dat ze op de topmodellen GTX plakken en op de lowend GT, maar dat is van vroegah.

RTX vind ik meer op de benaming van AMD lijken. Omdat ze al tijden de R gebruiken in combinatie met een nummer.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Soms.sdk1985 schreef op zaterdag 11 augustus 2018 @ 21:38:

[...]

Vroeger zat midrange op GTS en dan high-end op GTX. Echter met de komst van de titans en later de 1080Ti is er in dollars een super segement boven high-end gekomen. Daar een andere combo op plakken is an sich zo gek nog niet.

Niet dat dat veel wil zeggen, Nvidia heeft weinig regelmaat in hun pre- en suffixes gehad.

Waar jij nu waarschijnlijk aan denkt is de 8800 GTS. De G80 versie daarvan kon je krijgen met 320 en 640 MB geheugen en was een gecastreerde chip. Deze eerstgenoemde kun je qua prijs wel als mid-range classificeren, die kostte bijna de helft van de GTX. De gaten waren toen echter ook wel erg groot - je ging van $300, naar $450, naar $600. Niets er tussen in. Allemaal dezelfde chip, alleen licht gecastreerd. De 640 versie was gewoon high-end.

Daarvoor had je echter een GF2 GTS. Daar was niets mid-end aan. Dat was op dat moment gewoon de top chip en was voor die tijd ook gewoon duur ($349) - althans totdat 3DFX zichzelf definitief de nek om draaide met die 6000 op $600

En diezelfde chip klokten ze vervolgens nog twee keer over voor de Pro en Ti een jaar later.

En dan wordt het grappig, zo had je een 8600 GTS wat gewoon de top variant van G84 was - maar dat was verder wel gewoon low-end (echt een trage chip). Of een GTS 240/250, wat dan weer niets meer dan een G92b rebrand was - mid-end? Misschien. Het was de high-end van de vorige twee generaties. En dan had je nog een GTS 450, wat gewoon low-end was.

De huidige Ti's zijn ook helemaal geen segment "boven" de high-ends geworden, ik weet niet waar iedereen dat vandaan haalt. Titans wel, die zitten in een apart prijs segment. Maar een 1080 Ti had bij introductie een MSRP van $699. De GTX 280 zat op $649. De 8800 GTX had op papier een MSRP van $599. De 8800 Ultra? $830. 7800 GTX? $600. Zelfs de 6800 Ultra zat al op $500, je moet helemaal terug naar de tijd van ATI's 9700/9800 en Nvidia's stofzuigers om top prijzen van $400 te zien. Dat we nu zo'n $100 boven de prijzen van 2006 zitten is meer een kwestie van inflatie dan iets anders. Dat is geen verschil in segment - dan had de MSRP minimaal $800 moeten zijn zoals de 8800 Ultra.

Positionering gaat per definitie altijd op prijs en niet op welke chip je gebruikt. De prijs bepaalt je positie. Wat voor chip er bij de gegeven prijs wordt gebruikt volgt uit de omstandigheden (niveau concurrentie, niveau eigen techniek, enz). Als Nvidia morgen de chip van een 1050 kan verkopen als 1080 dan zouden ze dat meteen doen (en feitelijk hebben ze daar ook naartoe gewerkt sinds maxwell, zie de operationele marges op GeForce). Hoe beter de techniek en hoe slechter de producten van AMD, des te simpelere chips Nvidia kan gebruiken en des te meer winst er wordt gemaakt binnen de gegeven positionering.Werelds schreef op zaterdag 11 augustus 2018 @ 22:52:

[...]

Soms.

Niet dat dat veel wil zeggen, Nvidia heeft weinig regelmaat in hun pre- en suffixes gehad.

Waar jij nu waarschijnlijk aan denkt is de 8800 GTS. De G80 versie daarvan kon je krijgen met 320 en 640 MB geheugen en was een gecastreerde chip. Deze eerstgenoemde kun je qua prijs wel als mid-range classificeren, die kostte bijna de helft van de GTX. De gaten waren toen echter ook wel erg groot - je ging van $300, naar $450, naar $600. Niets er tussen in. Allemaal dezelfde chip, alleen licht gecastreerd. De 640 versie was gewoon high-end.

Daarvoor had je echter een GF2 GTS. Daar was niets mid-end aan. Dat was op dat moment gewoon de top chip en was voor die tijd ook gewoon duur ($349) - althans totdat 3DFX zichzelf definitief de nek om draaide met die 6000 op $600

En diezelfde chip klokten ze vervolgens nog twee keer over voor de Pro en Ti een jaar later.

En dan wordt het grappig, zo had je een 8600 GTS wat gewoon de top variant van G84 was - maar dat was verder wel gewoon low-end (echt een trage chip). Of een GTS 240/250, wat dan weer niets meer dan een G92b rebrand was - mid-end? Misschien. Het was de high-end van de vorige twee generaties. En dan had je nog een GTS 450, wat gewoon low-end was.

De huidige Ti's zijn ook helemaal geen segment "boven" de high-ends geworden, ik weet niet waar iedereen dat vandaan haalt. Titans wel, die zitten in een apart prijs segment. Maar een 1080 Ti had bij introductie een MSRP van $699. De GTX 280 zat op $649. De 8800 GTX had op papier een MSRP van $599. De 8800 Ultra? $830. 7800 GTX? $600. Zelfs de 6800 Ultra zat al op $500, je moet helemaal terug naar de tijd van ATI's 9700/9800 en Nvidia's stofzuigers om top prijzen van $400 te zien. Dat we nu zo'n $100 boven de prijzen van 2006 zitten is meer een kwestie van inflatie dan iets anders. Dat is geen verschil in segment - dan had de MSRP minimaal $800 moeten zijn zoals de 8800 Ultra.

Verder zijn die naamgevingen inderdaad gewisseld. Ik doelde op de tijd dat de prefix voor het type nummer stond. Dat was dus de geforce 200 serie met kaarten als de GT 220, de GTS 250 en de GTX 260. Waarbij GT low-end bedient, GTS mid-range (ja dat stopte vroeger bij 150 dollar) en GTX het high-end segment vertegenwoordigde. Geforce 400 had nog dezelfde logica maar met de komst van de 500 serie is afscheid genomen van de GTS prefix en zijn de mid-range kaarten onder GTX geschoven.

Dat de Ti onder enthusiast wordt geschoven is verder niet zo vreemd. Nvidia is bij de 780 weer van $499 naar $649 gesprongen en de 780 Ti kreeg ook die prijs mee. De 1080 zat in eerste instantie met zijn MSRP ook erg hoog ($599, $699 founders), dus dan ontstaat terecht de vraag of ze high-end niet gewoon duurder hebben gemaakt. Echter we hebben ook de price-cut gehad en de 1080 is officieel gewoon weer $499. Daarmee is qua prijs positionering de Ti met $699 voorlopig nog een klasse apart. Zit immers 40% verschil tussen. Maar goed als jij alleen de Titan enthusiast wil noemen dan mag dat

edit: Lol! Volgens de tabel van AdoredTV gaan ze de hele andere kant op. Ze maken daar heel high-end RTX met de RTX 2080, RTX 1070 en vervolgens de GTX 1060 en GTX 1050. Dan wordt GTX de nieuwe midrange. Als het klopt dan is dat een vreemde zet. GTX is nu al geassocieerd met high-end. Maar goed het is AdoredTV, heb nog geen voorspelling gezien van hem die uit kwam.

[ Voor 12% gewijzigd door sdk1985 op 11-08-2018 23:32 ]

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Echter is het dus door de jaren heen heel wisselend geweest wat voor prestaties je voor dat geld kreeg. Dat is min of meer waar ik op doelde.sdk1985 schreef op zaterdag 11 augustus 2018 @ 23:18:

Positionering gaat per definitie altijd op prijs en niet op welke chip je gebruikt. De prijs bepaalt je positie.

Aan de ene kant is dat goed, want het maakt het prijsverschil waardevoller. Aan de andere kant krijg je nu dus geen licht gecastreerde chips meer die op 90% performance draaien voor soms wel een derde goedkoper. Dat is waarom ik nog steeds eerst naar de chip kijken en daarna pas naar de prijs.

Je mist mijn punt volledig.Daarmee is qua prijs positionering de Ti met $699 voorlopig nog een klasse apart. Zit immers 40% verschil tussen. Maar goed als jij alleen de Titan enthusiast wil noemen dan mag dat. We hebben vroeger immers wel vaker x80 kaarten gezien met een MSRP van bijvoorbeeld $649. Maakt verder allemaal niet zo veel uit. Als die RTX er echt komt dan wordt vanzelf duidelijk of $699 onder RTX valt of niet.

Dat prijspunt waar de Ti's nu op zitten is niet nieuw. Jij noemde het een nieuw segment en dat is het niet. Dat segment hadden we bijna 15 jaar geleden ook al. Het is er alleen in 2010 en 2011 even niet geweest omdat Nvidia toen een ontzettend slecht product had. Als Fermi was geweest wat het had moeten zijn, had die ook gewoon op $649-$699 gezeten.

En ja, dat segment van 4 cijfers voor een Titan is zeker nieuw. Dat was vroeger voorbehouden aan de dual-GPU kaarten; en zelfs die haalden de 4 cijfers vaak niet eens.

[ Voor 5% gewijzigd door Werelds op 12-08-2018 19:53 ]

Ik heb regelmatig lijstjes met msrp geplaatst van de x80 serie waaruit blijkt dat die nauwelijks heeft bewogen. Dat zou dus geen discussie meer moeten opleveren.Paprika schreef op zondag 12 augustus 2018 @ 20:03:

@Werelds, fijn om te weten dat iemand anders ook tot de conclusie kwam dat de prijzen al heel lang zo zijn geweest. De GTX280 is dan nog 'n beetje speciaal omdat die binnen 'n maand van release 2 price cuts kreeg (door de AMD release) en vanaf mid juli was gezakt naar $399. Ik weet nog goed de rage van een aantal tweakers hier, maar dan moet je niet nieuwe hardware kopen als je weet dat er binnen 'n maand een goede concurrent op de markt gaat komen...

Je krijgt inderdaad in de hogere segmenten tegenwoordig veel perf per euro. Ik vond het de laatste jaren wel wat te voorspelbaar. Zal nu ook wel weer rond de bekende +35 worden (tpu vanaf 1080). Vroeger had je in mijn ervaring vaker kaarten die echt in der opruiming gingen zoals een evga gta 260 die ik voor 140 kon kopen. Of ik let gewoon niet goed opWerelds schreef op zondag 12 augustus 2018 @ 19:52:

[...]

Echter is het dus door de jaren heen heel wisselend geweest wat voor prestaties je voor dat geld kreeg. Dat is min of meer waar ik op doelde.

Aan de ene kant is dat goed, want het maakt het prijsverschil waardevoller. Aan de andere kant krijg je nu dus geen licht gecastreerde chips meer die op 90% performance draaien voor soms wel een derde goedkoper. Dat is waarom ik nog steeds eerst naar de chip kijken en daarna pas naar de prijs.

Nja als je ver genoeg terug gaat kom je bijvoorbeeld bij de 8800 ultra voor $829+. Als je de inflatie erbij pakt kom je op 1002 dollar. Die strak toen ook met kop en schouders boven de rest uit qua prijs. Het enthousiast segment is er wat mij betreft dus al langer. Je moet immers behoorlijk enthousiast zijn om zo'n bedrag uit te geven aan een videokaart[...]

Je mist mijn punt volledig.

Dat prijspunt waar de Ti's nu op zitten is niet nieuw. Jij noemde het een nieuw segment en dat is het niet. Dat segment hadden we bijna 15 jaar geleden ook al. Het is er alleen in 2010 en 2011 even niet geweest omdat Nvidia toen een ontzettend slecht product had. Als Fermi was geweest wat het had moeten zijn, had die ook gewoon op $649-$699 gezeten.

En ja, dat segment van 4 cijfers voor een Titan is zeker nieuw. Dat was vroeger voorbehouden aan de dual-GPU kaarten; en zelfs die haalden de 4 cijfers vaak niet eens.

Hostdeko webhosting: Sneller dan de concurrentie, CO2 neutraal en klantgericht.

Volgens Toms Hardware gaan ze toch een aardige duit kosten. Dit is wat ze zeggen: "TweakTown guestimates that there will be two variants, a less expensive $999 card and a $1,499 model with more RAM on board. Our sources say that pricing will be higher than the GTX 1080 Ti which carries a $699 MSRP". Toms HardwarePaprika schreef op vrijdag 10 augustus 2018 @ 18:47:

NVIDIA Titan RTX prijzen vallen reuze mee als je kijkt naar de staat van de markt. Zeker voor bedrijven in de AR en VR wereld (tijdens demo's wil je toch de meest soepele ervaring bieden aan je prospects) is dit een afschrijving van niks. Sterker nog, de gebruikte software is een factor duurder en moet jaarlijks worden vernieuwd.

Als je als zelfstandige een prima uurtje factuurtje draait betaal je hiervoor geen BTW en ben je na drie dagen klaar. Ik vind het weinig schokkend. Interessant? Nee, daarvoor game ik te weinig en als ik game is het zelden een recente release. Een 1180/2080 vind ik ruim voldoende (en is eigenlijk al overbodig). Er is altijd wel iemand met een betere pc, who cares. Succes met de aankoop van een huis, boot of auto als je daar problemen mee hebt.

https://www.tomshardware....dia-turing-faq,37067.html

De 8800GTX was $599 en de 8800 Ultra was $830. ATi? Lol nope.

De GTX280 was $650 en zakte zoals je zelf al aangaf in rap tempo door de HD4870 voor $299.

De GTX480 was $499 en was niet noemenswaardig veel sneller dan de $379 voor de HD5870.

De GTX580 was $499 en was niet veel sneller dan de $369 voor de HD6970.

De GTX680 was $499, kwam na de 7000 series en was iets sneller dan de HD7970 voor $550

De GTX780 was $649, de Ti was $699 en een totaal paniekproduct want de R9 290X voor $549, en zeker de 290 voor $399.

De GTX980 was $549, de Ti was $649. R9 Fury X zat ook op $649 maar was iets minder. Preventieve actie van Nvidia slaagde hier gewoon.

De GTX1080 was $699, de Ti was ook $699. RX Vega 64 was een jaar te laat, lange tijd niet te krijgen en faalde tegenover de Ti dus...

Ik zie een variabel patroon in Nvidia hun in prijsstelling.

Een paar jaar geleden waren de MSRP's van top SKU Nvidia kaarten structureel minstens $100 lager dan ze nu zijn. Dat was zo omdat ATi/AMD een concurrent product had. In de perioden dat ze niks konden, zoals de 8800 lijn, vroeg Nvidia de hoofdprijs. Dat is de afgelopen elf jaar niet de regel geweest. Nvidia rekende altijd een beste kaart premium, maar zeker geen $699. Nee, eerder $499 en dat was al dik $100 extra.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Tja, early adopter zijn doet nu eenmaal pijnPaprika schreef op zondag 12 augustus 2018 @ 20:03:

@Werelds, fijn om te weten dat iemand anders ook tot de conclusie kwam dat de prijzen al heel lang zo zijn geweest. De GTX280 is dan nog 'n beetje speciaal omdat die binnen 'n maand van release 2 price cuts kreeg (door de AMD release) en vanaf mid juli was gezakt naar $399. Ik weet nog goed de rage van een aantal tweakers hier, maar dan moet je niet nieuwe hardware kopen als je weet dat er binnen 'n maand een goede concurrent op de markt gaat komen...

Dat heb ik ook met G80 gemerkt

Dat zei ik dus al. Inclusief het aanhalen van de 8800 Ultra. Echter was dat ook de uitschieter. Zelfs de dual-GPU kaarten uit die tijd (7950 GX2, 9800 GX2, GTX 295) haalden dat soort prijzen niet. Dat enthusiast segment bestond zeker, echter niet direct vanuit Nvidia of AMD. Dat was voorbehouden aan de AIB's met hun gestoorde producten. Dingen als Ares en Marssdk1985 schreef op zondag 12 augustus 2018 @ 20:38:

Nja als je ver genoeg terug gaat kom je bijvoorbeeld bij de 8800 ultra voor $829+. Als je de inflatie erbij pakt kom je op 1002 dollar. Die strak toen ook met kop en schouders boven de rest uit qua prijs. Het enthousiast segment is er wat mij betreft dus al langer. Je moet immers behoorlijk enthousiast zijn om zo'n bedrag uit te geven aan een videokaart.

En daar speelt Nvidia op in. Dezelfde groep mensen die toen dat soort producten zou kopen, die duiken nu op de Titan. En daarnaast krijgen ze ook enkele van de die-hard fanboys zo ver.

Je mist nu wel de idioot goedkope G92DaniëlWW2 schreef op zondag 12 augustus 2018 @ 22:03:

@Werelds Daar moet denk ik wel een nuance bij. Nvidia verlaagt de prijzen voor de top SKU's als ze te maken hebben van serieuze concurrentie van het rode kamp, of tenminste serieuze concurrentie verwachten. Ik typ maar even de release MSRP's van de afgelopen elf jaar uit.

Dat was @Paprika maar dank jeDe GTX280 was $650 en zakte zoals je zelf al aangaf in rap tempo door de HD4870 voor $299.

Deze horen bij elkaar. Allemaal Kepler. Het is simpelweg het begin van Nvidia's nieuwe strategie met mid-range chip eerst, full-fat een jaar later voor consumenten. GK110 was al lang klaar begin 2012De GTX680 was $499, kwam na de 7000 series en was iets sneller dan de HD7970 voor $550

De GTX780 was $649, de Ti was $699 en een totaal paniekproduct want de R9 290X voor $549, en zeker de 290 voor $399.

OneensDat is de afgelopen elf jaar niet de regel geweest. Nvidia rekende altijd een beste kaart premium, maar zeker geen $699. Nee, eerder $499 en dat was al dik $100 extra.

Ze passen zich aan aan AMD als dat nodig is, vandaar dat GK104 met Tahiti concurreerde. Ze hadden toen al door dat AMD niet van plan was groter te gaan, dus werd GK110 achter gehouden. 2010/2011 zijn de uitzonderingen. GF100 was gewoon té slecht om meer van te maken.

[ Voor 50% gewijzigd door Werelds op 13-08-2018 09:39 ]

Fair enough. De 8800gt was alleen wel zo goedkoop omdat de HD3870 eraan zat te komen. Wederom niet zo snel als, maar snel genoeg om Nvidia te dwingen de prijzen fors te verlagen. $250 voor de release 8800gt vs de $219 voor de 3870. Verder kwam de 8800gt toch echt bewust twee weken voor de 3870 om deze te snel af te zijn. Een duidelijkere reactie op ATi kan je haast niet bedenken.

Verder was de 8800gt geen high end. Ja de prestaties waren high end verlegen met de vorige 8800's, maar de prijs en positionering was mainstream. De high end kaarten die de 8800 GTX en ultra echt vervingen waren de GTX260 en GTX280. Daarom sloeg ik de 8800gt en al die rebrands ook over.

Ik weet het. Dan alsnog besloot Nvidia te reageren op AMD door de midrange GK104 chip te positioneren als de high end, voor een lagere MSRP omdat de 7970 allang uit was, en je die toen ook echt al kon kopen.Deze horen bij elkaar. Allemaal Kepler. Het is simpelweg het begin van Nvidia's nieuwe strategie met mid-range chip eerst, full-fat een jaar later voor consumenten. GK110 was al lang klaar begin 2012

Toevalligerwijs waas 2008-2013 de periode dat ATi/AMD behoorlijk concurrent was met Terrascale en de eerste GCN's. Toen ATi kwam, gooide Nvidia de prijzen enorm omlaag. Toen AMD wegzakte, gingen bij Nvidia de prijzen omhoog.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Kleine correctie: de MSRP van de GTX1080 in 2016 was $550. Bij de introductie van de 1080Ti in 2017 werd die prijs verlaagd naar $500.DaniëlWW2 schreef op zondag 12 augustus 2018 @ 22:03:

De GTX1080 was $699,

Ik zie een variabel patroon in Nvidia hun in prijsstelling.

Het enige patroon dat ik dan zie voor de MSRP van de x80 variant is dat die juist vrij stabiel is en dat er enkel eens in de zoveel jaar $50 bovenop komt. Enige uitzondering op die regel is dan weer de prijs van de GTX 780.

Het volgende overzichtje komt van @sdk1985 uit een recent draadje: nieuws: Lenovo noemt komst GeForce GTX 1180-videokaart

1080: $549 (later $499)

980: $549

780: $649

680: $499

580: $499

480: $499

285: $400 / 295: $500

280: $649 (later $499)

(Natuurlijk is de MSRP vaak niet de prijs waarmee je als consument in Europa uiteindelijk te maken krijgt, maar dat is weer een andere discussie.)

De GTX1080 bij release was toch echt $699. Dat was de FE. De normale, betere GTX1080 had een MSRP van $599.choogen schreef op maandag 13 augustus 2018 @ 11:48:

[...]

Kleine correctie: de MSRP van de GTX1080 in 2016 was $550. Bij de introductie van de 1080Ti in 2017 werd die prijs verlaagd naar $500.

Zie: https://www.anandtech.com...0-founders-edition-review

Maar ik vind de correctie naar $599 best hoor. Bewijst mijn punt alleen maar meer dat Nvidia helemaal niet altijd voor de $649-$699 range gaat.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik vind het op zich gerechtvaardigd om naar de $100 goedkopere OEM/AIB prijzen te kijken ipv naar de FE edities, omdat Nvidia bij de lancering van de 10x0 series voor het eerst de referentiekaarten duurder maakte dan de kaarten van de AIB partners (met superieure koelers). Dus $600 voor de GTX 1080 lijkt me inderdaad een correct uitgangspunt.

Als ik een gokje moest wagen op de MSRP voor de nieuwe GTX/RTX 1180/2080, dan zou ik ook weer inzetten op $600. Dat is dan ook weer precies halverwege het bereik dat in AdoredTV's tabelletje voor deze kaart werd aangegeven ($499-$699).

[ Voor 17% gewijzigd door choogen op 13-08-2018 12:48 ]

Yes, dus wat gaat prijs nu doen?DaniëlWW2 schreef op maandag 13 augustus 2018 @ 10:12:

Toen ATi kwam, gooide Nvidia de prijzen enorm omlaag. Toen AMD wegzakte, gingen bij Nvidia de prijzen omhoog.

Tel daarbij op het eventuele GDDR6 geheugen, de duurdere componenten (pcb, capacitors, mosfets, etc).

De dump van goedkope 10 series zal snel voorbij zijn.

Ik maak echt geen illusies over de prijzen hoor.The Source schreef op maandag 13 augustus 2018 @ 12:48:

[...]

Yes, dus wat gaat prijs nu doen?

Tel daarbij op het eventuele GDDR6 geheugen, de duurdere componenten (pcb, capacitors, mosfets, etc).

De dump van goedkope 10 series zal snel voorbij zijn.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Inderdaad als je de opvolger van de 1080 voor 700 kan krijgen moet je in je handjes klappen. Het zou mij niets verbazen als ze straks 799-899 dollar gaan kosten.The Source schreef op maandag 13 augustus 2018 @ 12:48:

[...]

Yes, dus wat gaat prijs nu doen?

Tel daarbij op het eventuele GDDR6 geheugen, de duurdere componenten (pcb, capacitors, mosfets, etc).

De dump van goedkope 10 series zal snel voorbij zijn.

LET OP!!! dyslectisch Dus spelling kan verkeerd zijn!!! -- RIP CJ, The ATi Topic wont be the same without you.....

En ook jij slaat nu zowel GP102 (1080 Ti) als GM200 (980 Ti) over. Ik snap waarom en ik snap ook waarom sdk1985 zo vast houdt aan de markt positionering, maar jullie negeren beide volledig dat wat Nvidia *nu* doet anders is dan vroeger.choogen schreef op maandag 13 augustus 2018 @ 11:48:

1080: $549 (later $499)

980: $549

780: $649

680: $499

580: $499

480: $499

285: $400 / 295: $500

280: $649 (later $499)

GT200, GF100, GF110, GK110, GM200 en GP102 zijn allemaal grote chips. GP102 is de kleinste met 471mm² (uit m'n hoofd in volgorde: 576, 529, 520, 561, 601). En met uitzondering van de Fermi chips, zitten die allemaal op dat hoge prijspunt - Fermi niet omdat het zo'n ruk product was. De 680, 980 en 1080 zijn alle drie mid-range chips. Veel kleiner dan hun grotere broers.

De 295 hoort niet in dat rijtje thuis, dat is een dual-GPU kaart van ná de refresh. Waarom je de 285 (shrink van 280) wel mee neemt en de laatste 2 TI's niet, begrijp ik niet.

Bekijk het overzicht eens op deze manier (refreshes vet gedrukt):

1080 Ti: 2017 / Pascal / GP102 / Groot: $699

1080: 2016 / Pascal / GP104 / Klein: $549

980 Ti: 2015 / Maxwell / GM200 / Groot: $649

980: 2014 / Maxwell / GM204 / Klein: $549

780: 2013 / Kepler / GK110 / Groot: $649

680: 2012 / Kepler / GK104 / Klein: $499

580: 2011 / Fermi / GF110 / Groot: $499

480: 2010 / Fermi / GF100 / Groot: $499

285: 2009 / Tesla / GT200b / Groot: $399

280: 2008 / Tesla / GT200a / Groot: $649

8800 GT: 2007 / Tesla / G92 / GrootVoorDieTijd: $249

8800 GTX: 2H2006 / Tesla / G80 / GrootVoorDieTijd: $599

7900 GTX: 1H2006 / ??? / G71 / GrootVoorDieTijd: $500

7800 GTX: 2H2005 / ??? / G70 / GrootVoorDieTijd: $600

De 780 heb ik cursief gemaakt omdat ik er nog steeds van overtuigd ben dat Nvidia aanvankelijk een GK100 had willen doen, maar dat uiteindelijk niet heeft gedaan omdat ze weg konden komen met wat ze uiteindelijk gedaan hebben. Ik denk dus nog steeds dat dat een stille refresh van een nooit uitgebrachte GK100 is, zoals de GF110 een gefixte versie van GF100 is. Hun timing en positionering mogen dan niet constant geweest, hun chip nummers zijn dat voor het grootste deel wel. De benaming van G92 is een vreemde eend in de bijt (had G90 of G81 moeten zijn). GT200 is ook een vreemd ding, omdat dat eigenlijk een hele grote G92 is en onder de huidige benaming waarschijnlijk G90 zou zijn. Tegelijkertijd is G92 ook wel het meest meesterlijke product dat Nvidia ooit op de markt heeft gebracht - helemaal voor die prijs.

Je kunt de huidige cyclus niet meer vergelijken met vroeger. Waar je vroeger een jaar na een nieuwe chip een iets zuinigere en snellere versie kreeg, krijg je nu gewoon een geheel andere chip die niet te vergelijken is. Vroeger kreeg je ook van de mid-range een iets betere versie een jaar later, ook dat krijgen we niet meer. De 770 is een rebrand van de 680, geen refresh.

Het breekpunt ligt dan ook op Kepler. Vanaf dat moment is de huidige klein-groot cyclus begonnen, in plaats van de oude tick-tock cyclus.

Nogmaals, ik snap volledig waarom jullie naar de markt prijzen kijken. Je moet tegelijkertijd echter ook de veranderde cyclus meenemen. We zitten nu op een biënnale cyclus in plaats van een jaarlijkse. Met de 700-serie vond Nvidia het nog nodig om voor marketing redenen er een nieuw cijfertje op te plakken, maar zelfs zij doen dat nu niet meer. Als dat niet duidelijk genoeg is dat dingen nu anders gaan weet ik het ook niet meer

[ Voor 66% gewijzigd door Paprika op 13-08-2018 18:08 ]

En juist omdat er al een hele lange tijd geen high end kaarten voor MSRP beschikbaar zijn geweest denk ik dat de volgende generate wel 50-100 of misschien zelfs 200 dollar duurder zal zijn.Paprika schreef op maandag 13 augustus 2018 @ 18:01:

Het feit dat geen enkele AIB kaart voor de MSRP prijs beschikbaar is geweest bevestigt hoe onzinnig de lagere MSRP is. Zelfs de goedkoopste blower modellen van MSI, ASUS en EVGA hadden op z'n laagste een MSRP gelijk aan de FE kaarten. Juist door de insteek van de FE kaarten is de lagere MSRP een onzinnig bedrag geworden.

[Tinfoil Hat = ON]

Buiten dat bestaat natuurlijk de mogelijkheid dat NVidia meer concurrentie van AMD had verwacht en nu dat niet lijkt te gebeuren gaan ze hun chips meer versplinteren. Daarom krijgen we nu dus misschien de RTX kaarten die bij een eventuele serieuze concurrent gewoon de 1180 en 1180ti waren geweest voor dezelfde prijs als de pascal kaarten. Nu is er geen concurrentie dus gaat Nvidia wat met de namen omknoeien om de hogere prijs te rechtvaardigen.

[Tinfoil Hat = OFF]

Wie goed doet, die goed ontmoet.

Dat is mijn, en anderen hun punt niet. Het punt is dat Nvidia het afgelopen decennium regelmatig enorme chips heeft ontwikkeld en laten produceren om er vervolgens beduidend lagere prijzen voor te vragen dan ze de afgelopen jaren voor GP102, laat staan in 2016 voor GP104 vroegen. Dat heeft zeker niet alleen te maken met hogere kosten en het langzamere tempo van ontwikkelingen omdat die chips nu wel heel complex zullen worden met zoveel transistoren. Die prijsverhoging over de gehele linie heeft zeker ook met een gebrek aan concurrentie te maken. Nvidia maakt er zeker gebruik van de zwakte van de RTG om extra te verdienen. Dat kan je ook allemaal terugzien in de kwartaalcijfers van Nvidia. Dat was zeker in de periode 2008-2013 wel anders en dat drukte de prijzen die Nvidia kon vragen behoorlijk. Zeker voor GT200 en GF100 waren de hogere prijzen welkom geweest. Dat waren gewoon dure chips voor Nvidia, terwijl ATi met veel kleinere chips flink in kon hakken in Nvidia hun gehoopte marges.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Ik heb getwijfeld of ik wel of geen topic moest openen aangezien ik een verkapte aankoopadvies ga vragen hier, maar eigenlijk ook weer niet. Als het niet de bedoeling is in deze topic, sorry maar het leek mij wel op zijn plaats in dit topic.

Ik heb uiteraard zelf geprobeerd te googlen naar de antwoord op mijn vraag maar helaas niet gevonden.

Weet iemand wanneer de nieuwe Nvidia videokaarten worden gereleased? Ik las namelijk juli/augustus maar tot op heden nog niets gezien. De reden dat ik dit een beetje wil weten is namelijk omdat ik een nieuwe pc wil gaan samenstellen vanaf scratch, maar ik nog wel geduld heb om nog te wachten tot eind september ongeveer.

Denken jullie, net als ik dat de prijzen van de huidige top-videokaarten dan zullen zakken in prijs?

"A life without memes is not worth living." - Socrates

Bekijk mijn overzicht nog eens goed.DaniëlWW2 schreef op maandag 13 augustus 2018 @ 20:20:

Het punt is dat Nvidia het afgelopen decennium regelmatig enorme chips heeft ontwikkeld en laten produceren om er vervolgens beduidend lagere prijzen voor te vragen dan ze de afgelopen jaren voor GP102, laat staan in 2016 voor GP104 vroegen.

GP102 is niet onevenredig duur. GP102's MSRP ligt $50 hoger dan die van GT200, GK110 en GM200. En Fermi had gegarandeerd ook op $649 gezeten als het ding niet zo ondermaats was. Daarmee heb je het laatste decennium al afgedekt. Ik kan $50 niet "beduidend" lager noemen

De x4 chips zijn een heel ander verhaal. Rond Fermi zaten ze daarmee al in het prijssegment waar ze de 2e cutdown hadden (bijv. GTX 260), met Kepler verschoven ze dat richting de 1e cutdown (bijv. GTX 270). En daar hebben ze sindsdien ook gezeten, dat is ook alweer 6,5 jaar geleden. Daar zijn ze wel fors meer voor gaan vragen, een 8600/9600 zaten bijvoorbeeld een flinke klap lager op $150.

De grootste chips zijn nauwelijks verschoven, als je over Fermi heen kijkt. De kleinere chips daarentegen zijn wel omhoog geschoven, ten koste van de cutdowns. We krijgen ze soms nog wel (zie een 780/780 Ti), maar dat is meer een kwestie van de chips kwijt moeten dan iets anders.

Dit is waar je juist zit. Die $50 komt deels door hogere productie kosten en deels simpelweg omdat het kan.Dat heeft zeker niet alleen te maken met hogere kosten en het langzamere tempo van ontwikkelingen omdat die chips nu wel heel complex zullen worden met zoveel transistoren. Die prijsverhoging over de gehele linie heeft zeker ook met een gebrek aan concurrentie te maken.

Met 30 seconden zoekwerk kom je op het volgende nieuwsartikel uit: nieuws: Nvidia houdt evenement op 20 augustus en belooft 'verrassingen'Ferrando schreef op dinsdag 14 augustus 2018 @ 00:17:

Hoi Tweakers,

Ik heb getwijfeld of ik wel of geen topic moest openen aangezien ik een verkapte aankoopadvies ga vragen hier, maar eigenlijk ook weer niet. Als het niet de bedoeling is in deze topic, sorry maar het leek mij wel op zijn plaats in dit topic.

Ik heb uiteraard zelf geprobeerd te googlen naar de antwoord op mijn vraag maar helaas niet gevonden.

Weet iemand wanneer de nieuwe Nvidia videokaarten worden gereleased? Ik las namelijk juli/augustus maar tot op heden nog niets gezien. De reden dat ik dit een beetje wil weten is namelijk omdat ik een nieuwe pc wil gaan samenstellen vanaf scratch, maar ik nog wel geduld heb om nog te wachten tot eind september ongeveer.

Denken jullie, net als ik dat de prijzen van de huidige top-videokaarten dan zullen zakken in prijs?

Over de huidige videokaarten... Ik denk zelf dat ze een klein beetje in prijs worden verlaagd (tot +/- 100 euro), maar je hoeft niet te rekenen op honderden euro's korting. Maar zoals je hierboven leest houden anderen de kaarten van Nvidia langer in de gaten en weten waarschijnlijk ook beter hoeveel goedkoper de huidige kaarten kunnen worden.

Edit:

Nvidia heeft een uurtje geleden de onderstaande tweet geplaatst. Op 54 seconden komen de volgende nummers in deze volgorde naar boven: 2-0-8-0.

https://twitter.com/NVIDIAGeForce/status/1029164596903337984

[ Voor 6% gewijzigd door RobinNL op 14-08-2018 03:35 ]

AMD Ryzen 9 5900X • Gigabyte X570 Aorus PRO • G.Skill Ripjaws V F4-3600C16D-32GVKC • AMD Radeon RX 6900 XT • Samsung 850 EVO 1TB • Intel 660p 2TB • Corsair Obsidian 500D RGB SE • Corsair RM750x

https://i.redd.it/gxmyxo2c5yf11.png

https://i.redd.it/kmerrahh4yf11.png

Grote jongen, 12nm.

Samenvatting:

https://www.anandtech.com...n-turing-gpu-architecture

[ Voor 73% gewijzigd door Paprika op 14-08-2018 05:27 ]

Inderdaad, 754mm^2.

De uiteindelijke gamerkaarten zullen waarschijnlijk dezelfde (al dan niet cut down) GPU's krijgen. Voor gaming workloads vermoed ik dat het stroomverbruik in de praktijk ook wel mee zal vallen kijkend naar de die size. Grote delen van de GPU zullen in namelijk DX11 uit hun neus zitten eten.

Een dergelijke die size maakt de kostprijs de GPU echter wel gigantisch. Zelfs al zou er concurrentie zijn vermoed ik dat dit geen goedkope kaarten zouden worden.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Waarom zouden de game kaarten geen volta krijgen dan?Blaat schreef op dinsdag 14 augustus 2018 @ 07:26:

[...]

Inderdaad, 754mm^2.

De uiteindelijke gamerkaarten zullen waarschijnlijk dezelfde (al dan niet cut down) GPU's krijgen. Voor gaming workloads vermoed ik dat het stroomverbruik in de praktijk ook wel mee zal vallen kijkend naar de die size. Grote delen van de GPU zullen in namelijk DX11 uit hun neus zitten eten.

Een dergelijke die size maakt de kostprijs de GPU echter wel gigantisch. Zelfs al zou er concurrentie zijn vermoed ik dat dit geen goedkope kaarten zouden worden.

Wie goed doet, die goed ontmoet.

Omdat Volta geen RT cores heeft en raytracing duidelijk het nieuwe stokpaardje van nVidia gaat zijn.AtlAntA schreef op dinsdag 14 augustus 2018 @ 08:12:

[...]

Waarom zouden de game kaarten geen volta krijgen dan?

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Edit: Heb het al gevonden!

[ Voor 11% gewijzigd door MrNobody28 op 14-08-2018 09:04 ]

Verwijderd

Moet je alleen al is kijken wat tegenwoordig een mid-range kaartje kost bij zowel Nvidia als AMD, €300+.

We weten waarom Nvidia dit doet....... word tijd dat AMD het een en ander aan winst van de CPU afdeling overhevelt naar de GPU afdeling en dan hopen dat de prijzen wat zakken.

Never argue with an idiot. He will drag you down to his own level and beat you with experience.

Twee totaal verschillende bedrijven met 2 verschillen budgetten helaas ....Verwijderd schreef op dinsdag 14 augustus 2018 @ 09:16:

De prijzen worden te hoog.

Moet je alleen al is kijken wat tegenwoordig een mid-range kaartje kost bij zowel Nvidia als AMD, €300+.

We weten waarom Nvidia dit doet....... word tijd dat AMD het een en ander aan winst van de CPU afdeling overhevelt naar de GPU afdeling en dan hopen dat de prijzen wat zakken.

NVIDIA GeForce RTX 2080 ‘Turing GPU’ Ashes of the Singularity benchmarks leak out:

https://wccftech.com/nvidia-geforce-rtx-2080-benchmarks/

Lastly, its the simple fact that while it is very easy to fake names, it is almost impossible to fake the score – which is one of the highest (if not the highest) we have seen in the Crazy 4k and 5k setting. The benchmark session shown here actually outperforms a TITAN V – which is an absolutely mammoth GPU and should by all logic remain unchallenged by anything other than a Turing. You can tell that this is a single GPU setup because of the fact that the benchmark states so. All in all, I am fairly certain that these benchmarks are either of the Quadro family or the GeForce RTX 2080.

Edit: Leuk om de vers gelekte benchmark eens te vergelijken met deze oude 1080Ti resultaten voor AotS op 4K: https://www.techarp.com/r...rce-gtx-1080-ti-review/4/

Bijv. 36% sneller over "All Batches" !

Edit 2: benchmark verhaal van WCCFTech wordt ontkracht in deze video: YouTube: Nvidia Confirms RTX 2080 for Monday! Misschien was het dan geen RTX 2080 maar een RTX 2070?

[ Voor 80% gewijzigd door choogen op 16-08-2018 10:05 ]

Verwijderd

En het wordt geen 1180 maar 2080MrNobody28 schreef op dinsdag 14 augustus 2018 @ 09:03:

Als de 1180 waarschijnlijk eind augustus op de markt komt, hoeveel schatten jullie in dat de 1080 qua prijs zal dalen?

Edit: Heb het al gevonden!

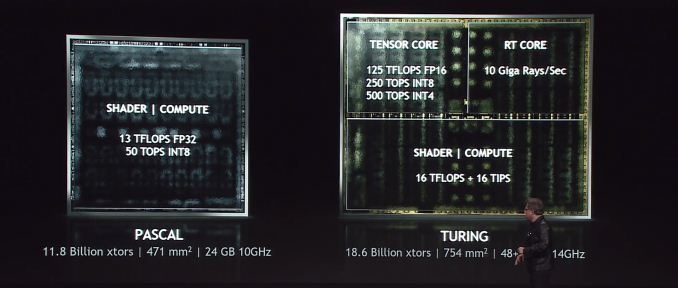

Denk dat die Ampere game chip wel behoorlijk anders moet zijn qua verhoudingen tussen de drie blokken als bovenstaande plaatje op schaal is.

Een 2080 of 2070 gaan ze vast niet op 754mm uitbrengen en hoeveel voegen Tensor en RT cores toe bij de huidige spellen? Vast niet superveel.

En daar wil je toch ook nog steeds een gezonde prestatie winst laten zien lijkt me. Dus dan zou er relatief stuk meer Shader | Compute in moeten zitten lijkt me.

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

YouTube: Nvidia Quadro RTX Turing launch event at SIGGRAPH 2018

qua consumenten, grappig is eigenlijk ook dat voor veel mensen deze graphics niet speciaal zijn. Ze hebben bijv met directx en shaders realtime al zo'n hoge qualiteit gehaald, veel mensen zal het niet boeien of het raytraced is of gewoon handig gefaked in directx/ogl/etc. ergens voelt het een beetje als de lat hoger leggen puur om weer wat te kunnen verkopen

[ Voor 49% gewijzigd door maratropa op 14-08-2018 11:55 ]

Op mij komt het hele RTX verhaal ook over om weer meer te kunnen verkopen. We hebben nu eigenlijk sinds de Radeon HD 7970 en Geforce GTX 680 generatie eigenlijk geen features gehad waardoor gamers zouden moeten upgraden. Natuurlijk, als jij 4K @ 60fps wilt hebben, dan voldoen deze kaarten niet meer. Maar ben je een gamer die nog op 1080P gamed en geef je niet heel erg veel om een constante 60fps of ultra instellingen, dan zou je nog prima uit de voeten kunnen met een HD 7970.maratropa schreef op dinsdag 14 augustus 2018 @ 11:40:

hier nog wat realtime raytraced porche beelden uit de presentatie

YouTube: Nvidia Quadro RTX Turing launch event at SIGGRAPH 2018

qua consumenten, grappig is eigenlijk ook dat voor veel mensen deze graphics niet speciaal zijn. Ze hebben bijv met directx en shaders realtime al zo'n hoge qualiteit gehaald, veel mensen zal het niet boeien of het raytraced is of gewoon handig gefaked in directx/ogl/etc. ergens voelt het een beetje als de lat hoger leggen puur om weer wat te kunnen verkopen

Wanneer je Ray Tracing gaat gebruiken en je creëert hier een aparte klasse videokaarten voor, zoals Geforce RTX, dan kun je gamers gaan dwingen om te upgraden naar een nieuwere kaart. Ze zouden zelfs binnen de nieuwe serie aan segmentatie kunnen gaan doen om nog meer te verkopen. Want waarom zou je een GTX 2060 willen hebben als je niet eens van de goddelijke effecten van Ray Tracing kunt genieten. Dan kun je maar beter €199,- extra uitgeven aan een RTX 2070.

Of die GTX 1080Ti, dat kan echt niet meer nu, die kan niet eens meer de nieuwste effecten aanvinken in de laatste games. Koop dan maar een RTX 2080, ook al is hij maar 8% sneller in oudere games.

Uiteindelijk denk ik dat Ray Tracing wel de toekomst is voor games, maar nVidia hyped het nu heel erg, omdat ze willen verkopen. Verwacht een hele hoop vergelijkingen met games, die zowel op de oude manier als met Ray Tracing worden gerenderd en waar de oude rendering methode met opzet extra lelijk wordt gemaakt.

Ryzen 7 9800X3D | ROG STRIX B650E-F | RTX 5080 AMP | 32GB G.Skill 6000Mhz C30 | Noctua NH-U12A | Samsung 990 Pro 1TB | Samsung 990 Pro 2TB | WD Red Plus 6TB | O11 Dynamic Evo | Corsair RM1000x

Het zal er ook aan liggen hoe zwaar Ray Tracing word ingezet in games en gelukkig ben je daar niet speciaal Nvidia voor nodig (op een exclusieve game na, waarschijnlijk Metro Exodus). Het kan goed mogelijk zijn dat Microsoft Ray Tracing geen speciale hardware vereist en dat je dan als nog wel alles op Pascal (GTX 1080 Ti) GPU's in kunt schakelen.hubhib schreef op dinsdag 14 augustus 2018 @ 12:23:

[...]

Of die GTX 1080Ti, dat kan echt niet meer nu, die kan niet eens meer de nieuwste effecten aanvinken in de laatste games. Koop dan maar een RTX 2080, ook al is hij maar 8% sneller in oudere games.

Uiteindelijk denk ik dat Ray Tracing wel de toekomst is voor games, maar nVidia hyped het nu heel erg, omdat ze willen verkopen. Verwacht een hele hoop vergelijkingen met games, die zowel op de oude manier als met Ray Tracing worden gerenderd en waar de oude rendering methode met opzet extra lelijk wordt gemaakt.

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

Ik koop er in iedergeval niet speciaal een nieuwe videokaart voor.

Verwijderd

Ik heb een speellicentie voor de eerdere twee Metro-spellen (je bezit immers geen spellen bij Steam), als Metro Exodus slecht draait op AMD-kaarten doordat de developer proprietary gimpware gebruikte dan koop ik het spel pas vele jaren later wanneer het wel soepel draait op AMD-kaarten, ik laat me niet chanteren om elke generatie een nieuwe Nvidia-kaart te kopen voor de laatste gimmick. In de huidige vorm (met de kwaliteit van de hardware zoals die nu is) is raytracing een gimmick, het duurt nog jaren voordat de hardware er klaar voor is om het op een serieuze manier te gebruiken.

@Verwijderd

[ Voor 81% gewijzigd door Edmin op 15-08-2018 13:16 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Verwijderd

Ja ik wacht sowieso wel op AMD’s nieuwe kaarten, heb er nooit problemen mee gehad en hun drivers met de features vind ik persoonlijk zeer goed en heb een freesync scherm.

Alleen moet het niet te lang gaan duren dus hoop dat ze voor de zomer 2019 wel al iets hebben wat beter is dan een RX 580 maar ook minder verbruikt.

Sorry ik weet dat het een Nvidia topic is.

Nee.Help!!!! schreef op dinsdag 14 augustus 2018 @ 18:27:

Iemand enig idee of we de 20e ook gelijk reviews krijgen of wordt dit weer een uitgebreid melkproces

Als de kaart op gamescom wordt gelanceerd dan krijgen editors waarschijnlijk de kaart mee naar huis. Die hebben dan ook nog tijd nodig om een review te schrijven. Om NV alle exposure op de GPU en technology te geven mogen dan nog geen custom card reviews gepubliceerd worden, wij mogen die wellicht ook niet versturen. In 2016 zat er 2 weken tussen de announcement en reviews van de reference kaart (FE) en 2 weken daarna kwamen de custom reviews online. En dan heb je nog de verschillende review dates voor de mogelijk verschillende GPU's.

Let wel... bovenstaande allemaal gebaseerd op eerdere jaren en aannames want mijn naam is haas

Vraag me ook af wat het precies toevoegd in Metro Exodus, persoonlijk vind ik de E3 trailer van 2017 er beter uitzien, ondanks dat het een build betreft uit een eerder stadium in de ontwikkeling van het spel. Dat kan natuurlijk ook door de lichtval die anders is zijn, maar toch.... Het is nu niet dat ik denk van ja dit is een goede implementatie.Gekke Jantje schreef op dinsdag 14 augustus 2018 @ 12:43:

[...]

Het zal er ook aan liggen hoe zwaar Ray Tracing word ingezet in games en gelukkig ben je daar niet speciaal Nvidia voor nodig (op een exclusieve game na, waarschijnlijk Metro Exodus). Het kan goed mogelijk zijn dat Microsoft Ray Tracing geen speciale hardware vereist en dat je dan als nog wel alles op Pascal (GTX 1080 Ti) GPU's in kunt schakelen.

Let wel dat de E3 trailer maar 1080p is en daardoor dus een stuk minder scherp dan de nieuwe trailer

Thx dudeRobinNL schreef op dinsdag 14 augustus 2018 @ 01:53:

[...]

Met 30 seconden zoekwerk kom je op het volgende nieuwsartikel uit: nieuws: Nvidia houdt evenement op 20 augustus en belooft 'verrassingen'

Over de huidige videokaarten... Ik denk zelf dat ze een klein beetje in prijs worden verlaagd (tot +/- 100 euro), maar je hoeft niet te rekenen op honderden euro's korting. Maar zoals je hierboven leest houden anderen de kaarten van Nvidia langer in de gaten en weten waarschijnlijk ook beter hoeveel goedkoper de huidige kaarten kunnen worden.

Edit:

Nvidia heeft een uurtje geleden de onderstaande tweet geplaatst. Op 54 seconden komen de volgende nummers in deze volgorde naar boven: 2-0-8-0.

https://twitter.com/NVIDIAGeForce/status/1029164596903337984

Bij een merendeel van de reacties in dit topic zie ik heel veel abracadabra langs komen

"A life without memes is not worth living." - Socrates

Als de volgende generatie echt ongeveer 100 dollar duurder wordt dan de huidige dan zou het me niks verbazen dat de prijs niks zakt. Ik zou v&a goed in de gaten houden als ik jou was. Daar zal je binnenkort vast een goede deal kunnen vinden voor een zgan kaart.Ferrando schreef op dinsdag 14 augustus 2018 @ 23:03:

[...]

Thx dude

Bij een merendeel van de reacties in dit topic zie ik heel veel abracadabra langs komenAnyways een pricedrop van om en nabij de 100 vind ik genoeg reden om te wachten aangezien ik toch geen haast heb met de aankoop.

Wie goed doet, die goed ontmoet.

Ben het er helemaal mee eens dat de game er zo minder mooi uit ziet tijdens die RT demo. Het gaat er om het gedrag van belichting wat natuurlijker moet zijn, zoals op objecten wat dan mee moet kleuren of van kleur veranderen, ik weet het niet zeker.Sp3ci3s8472 schreef op dinsdag 14 augustus 2018 @ 22:46:

[...]

Vraag me ook af wat het precies toevoegd in Metro Exodus, persoonlijk vind ik de E3 trailer van 2017 er beter uitzien, ondanks dat het een build betreft uit een eerder stadium in de ontwikkeling van het spel. Dat kan natuurlijk ook door de lichtval die anders is zijn, maar toch.... Het is nu niet dat ik denk van ja dit is een goede implementatie.

[video]

[video]

Let wel dat de E3 trailer maar 1080p is en daardoor dus een stuk minder scherp dan de nieuwe trailer

Asrock Z370 Extreme4 i9 9900k 16gb NightHawk 3200mhz MSI GTX1080Ti gaminingX 2 Evo 512gb m.2 over chipset pcie lanes Corair hx750i

Verwijderd

Nu zal de 1170/2070 misschien iets beter worden dan de 1080 maar op meer dan 25-30% vooruitgang per generatie hoeven we niet te rekenen en de generaties duren tegenwoordig best lang.

Tenslotte mijn ongezouten mening, lezen op eigen risico.

Nvidia gebruikt raytracing als marketing-middel en pressiemiddel om gamers te 'stimuleren' om Nvidia-kaarten te kopen zoals ze in het verleden daarvoor proprietary software (rookeffect in Ubisoft spellen, Gameworks...) gebruikten en overboard gingen met tessellation met de intentie de hardware van AMD te cripplen en het hun marketingslogan "Nvidia: The Way It Is Meant To Be Played" kracht bij te zetten, hiermee de boodschap gevende: you better buy an Nvidia card or else you will miss out.

Blender komt met Eevee best in de buurt. Het is nog lang geen 60fps in de meeste gevallen en je ziet dat juist met belichting en bepaalde manieren van shading Eevee er anders (lees minder realischtisch) uit ziet dan Cycles.Verwijderd schreef op woensdag 15 augustus 2018 @ 13:29:

voor die Star Wars demo werd het grootste deel al weggelaten aangezien je voor 'fotorealistische' (vraag een expert in Blender hoe hij daarover denkt) rendering nog steeds meerdere seconden nodig hebt per plaatje terwijl je bij een spel meer dan 60 frames per seconde nodig hebt.

Laat niet weg dat Eevee gigantisch krachtig is

nVidia kennende zullen ze het idd wel "maximaal" uitspelen.

Dat nieuwe features niet perse aanslaan en / of er geruime tijd over doen om nut te hebben is natuurlijk van alle tijden.

Los daarvan, en anders dan bij bijv. DX12 destijds, is het voor mij nog erg diffuus wat we uberhaupt ingame aan RT kunnen hebben. Is het puur mooiere effecten of kunnen bestaande effecten sneller getoond worden of beide

Daarom wacht ik rustig de launch af want dan zal er wel wat meer duidelijk worden.

Ben benieuwd wat voor vernieuwingen er nog meer zijn op feature gebied en vooral of deze gelijk meerwaarde kunnen bieden. (Ondersteuning FreeSync

Mocht ik een nieuwe kaart kopen dan zal dat eerder zijn vanwege reguliere prestatieverbetering en hobby dan RT.

[ Voor 15% gewijzigd door Help!!!! op 15-08-2018 13:53 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Verwijderd

Ik verwacht dat Nvidia de achterstand op AMD met Vulkan en DX12 heeft verminderd, ook omdat ze dit nodig hebben voor hun raytracing.Help!!!! schreef op woensdag 15 augustus 2018 @ 13:51:

Ben benieuwd wat voor vernieuwingen er nog meer zijn op feature gebied en vooral of deze gelijk meerwaarde kunnen bieden. (Ondersteuning FreeSync

)

Ironisch genoeg maken die 8c-CPUs die nu standaard zijn geworden het weer minder nodig voor Nvidia om Vulkan en DX12 te ondersteunen aangezien de CPU-overhead van het verdelen van de load over meerdere CPU-kernen bij DX11 geen probleem is bij 8c-CPU's en waarschijnlijk ook niet bij 6c-CPU's.

Ze zullen FreeSync niet gaan ondersteunen, helaas. Technisch gezien heeft Nvidia de code hiervoor al grotendeels klaar liggen want zulke code is nodig voor hun 'G-Sync' laptops die geen FPGA-modules bevatten. Dat roept een aantal interessante vragen op.

Dat is het beste advies voor elke gamer. Koop geen nieuwe kaart voor een nieuwe feature, een paar jaar later wordt dat pas echt goed ondersteund dus het is geen ramp als je wat later die feature krijgt.Dat nieuwe features niet perse aanslaan en / of er geruime tijd over doen om nut te hebben is natuurlijk van alle tijden.

- knip door CHBF -

Mocht ik een nieuwe kaart kopen dan zal dat eerder zijn vanwege reguliere prestatieverbetering en hobby dan RT.

Als ze HDMI 2.1 willen gaan ondersteunen komen ze toch niet onder freesync uit of wel? Achterblijven qua standaard kunnen ze namelijk niet.Verwijderd schreef op woensdag 15 augustus 2018 @ 14:12:

[...]

Ik verwacht dat Nvidia de achterstand op AMD met Vulkan en DX12 heeft verminderd, ook omdat ze dit nodig hebben voor hun raytracing.

Ironisch genoeg maken die 8c-CPUs die nu standaard zijn geworden het weer minder nodig voor Nvidia om Vulkan en DX12 te ondersteunen aangezien de CPU-overhead van het verdelen van de load over meerdere CPU-kernen bij DX11 geen probleem is bij 8c-CPU's en waarschijnlijk ook niet bij 6c-CPU's.

Ze zullen FreeSync niet gaan ondersteunen, helaas. Technisch gezien heeft Nvidia de code hiervoor al grotendeels klaar liggen want zulke code is nodig voor hun 'G-Sync' laptops. Dat roept een aantal interessante vragen op.

[...]

Dat is het beste advies voor elke gamer. Koop geen nieuwe kaart voor een nieuwe feature, een paar jaar later wordt dat pas echt goed ondersteund dus het is geen ramp als je wat later die feature krijgt.

Dat kan wel eens de doodsteek voor G-Sync zijn.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Nee, volgensmij is Freesync een niet verplicht item onder HDMI 2.1.

Helaas.

ps: nvidia gaat FS alleen maar ondersteunen als ze echt niet anders kunnen (Gedwongen worden of het heeft ook voor henzelf voordeel)

[ Voor 42% gewijzigd door Help!!!! op 15-08-2018 14:27 ]

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Volgens alle redditters klopt wat je zegt maar ik vind het niet zo duidelijk uit de bron die ze aanhalen naar voren komen. Wat ze zeggen is dat het "erop lijkt als je tussen de regels doorleest dat het optioneel is".Help!!!! schreef op woensdag 15 augustus 2018 @ 14:25:

@Blaat

Nee, volgensmij is Freesync een niet verplicht item onder HDMI 2.1.

Helaas.

ps: nvidia gaat FS alleen maar ondersteunen als ze echt niet anders kunnen (Gedwongen worden of het heeft ook voor henzelf voordeel)

Weinig doorslaggevend imo.

Zie thread op Reddit en de Bron.

Mijn naam is rood, mijn text is blauw. Jouw post wordt ge-edit, als je niet stopt met dat gemauw.

Ik verwacht dat het nog steeds optioneel blijkt te zijn maar hoop natuurlijk op een verplicht onderdeel

In het laatste geval kan het misschien nog in de drivers geblokkeerd worden

PC Specs

Asus ROG Strix B650E-E | AMD 9800X3D |TR Phantom Spirit 120 SE | G-Skill 32GB DDR5 6000C30 M-die | 4090 FE | LG 3840*1600p 160Hz | Corsair RM1000x Shift

Verwijderd

Puur vanuit een technisch perspectief zou het niet vreemd zijn als deze syncing-technologie optioneel is. Er zijn gamers die prefereren dat een dergelijke syncing-technologie niet wordt gebruikt omdat het een nadeel kan geven bij multiplayer. Je krijgt immers regelmatig net iets later een heel plaatje te zien in plaats van net iets eerder een plaatje waarbij een deel van het plaatje is vervangen door niet gegenereerde data (het plaatje met een flinke tear of meerdere tears erin). Als net op dat nieuwe deel van het plaatje iets te zien is wat nuttige informatie geeft (een tegenstander die je ziet of dat het doelwit in het vizier van je sniper is bijvoorbeeld) dan wil je dat niet bijvoorbeeld 2 ms later zien als je op het hoogste niveau zo'n spel met multiplayer speelt. Dat is de theorie. Praktisch gezien maakt het voor verreweg de meeste gamers geen enkel verschil en zijn zij beter af met FreeSync/G-Sync en het is zelfs de vraag of dat het op het hoogste niveau wel verschil maakt maar ik kan die gedachtengang van zulke gamers wel volgen.Help!!!! schreef op woensdag 15 augustus 2018 @ 14:38:

Het is inderdaad niet makkelijk te vinden en het officiele document is bij mijn weten niet publiek beschikbaar.

Ik verwacht dat het nog steeds optioneel blijkt te zijn maar hoop natuurlijk op een verplicht onderdeel

In het laatste geval kan het misschien nog in de drivers geblokkeerd worden

Misschien is die beste speler voldoende meer vaardig dan de andere spelers dat dat geen verschil maakt.