Tussen alle discussie over backup methodes door, nu maar eens een recovery ervaring.

Vorige week kwam ik tot de vervelende ontdekking dat mijn NAS nauwelijks nog bereikbaar was via synology apps / webinterface. Uiteindelijk wel verbinding gekregen en het leek dat Disk 2 niet helemaal in orde was.

Ik had er op dat moment 2 2TB disken in zitten, beide als los basic volume.

Direct besloten om dit maar als een mooi moment te zien om te upgraden naar 2x 4TB (Disk 1 begon namelijk ook aardig vol te raken) en al doende maar te zien wat er nog van Disk 2 te maken was.

Dus Disk 2 verwijderd en een nieuwe 4TB disk geplaatst. En volgens

dit stappenplan Disk 1 gecloned naar de nieuwe 4TB disk, om die vervolgens weer om te zetten naar een basic volume en daarmee de nieuwe Disk 1.

code:

1

2

3

4

5

6

7

| Verwijder Disk 2, plaats de disk die als vervanger van Disk 1 moet gaan dienen.

Start NAS en maak van Volume 1 een RAID 1 volume over de oude en nieuwe disk.

NAS uit, de twee schijven van plek wisselen, NAS weer aan

NAS uit, oude disk er uit.

NAS aan en via SSH/telnet: mdadm --grow --raid-devices=1 --force /dev/md2

Nu is de nieuwe Disk 1 weer een basic volume

Via Storage manager kan je dan het volume oprekken naar de volledige capaciteit van de nieuwe disk |

Ondertussen verschillende pogingen ondernomen om data van Disk 2 te halen (met behulp van USB->SATA behuizing). Clonen via Macrium Reflect ging absurd langzaam (<1MB/s), dus afgebroken. Mounten onder Ubuntu leek te werken, en data leek ook toegankelijk. Maar ook daar bleek het kopiëren van de data naar een andere USB disk tergend langzaam te gaan. Aangezien de disk netjes als USB Superspeed herkend werd, zou het daar niet aan moeten liggen en was er waarschijnlijk toch echt wat stuk aan de disk zelf.

Dat werd bevestigd toen ik wat van de moeizaam gekopieerde data probeerde te openen. Sommige bestanden werkten nog, maar verschillende bestanden waren corrupt. En in de systeemlogs van Ubuntu zag ik ook de nodige verontrustende meldingen langskomen over een bad sector count die maar op bleef lopen.

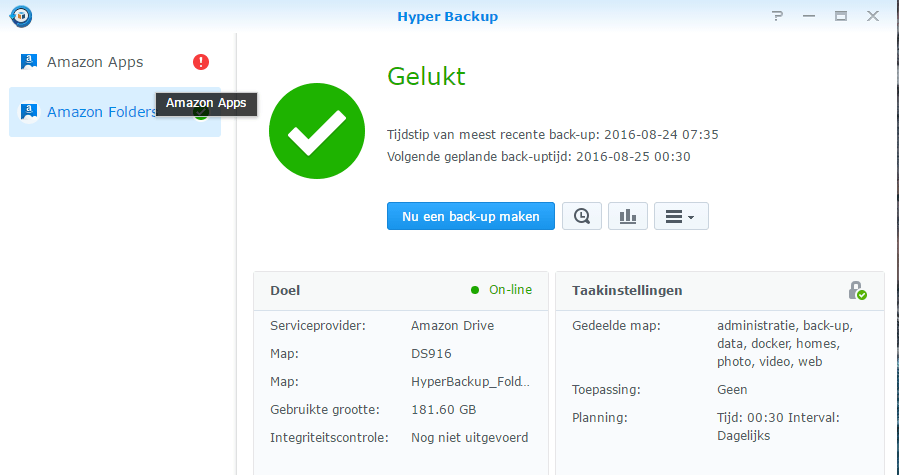

Ondertussen was de upgrade van Disk 1 klaar en zat de andere nieuwe 4TB disk geformateerd en wel op z'n plek als nieuwe Disk 2. Tijd voor data herstel uit backups.

Zo'n 75% van de ~1TB aan data had ik gelukkig nog in lokale backups staan (slordig, de laatste was van eind 2014). Dus dat was vlot hersteld. De rest zou dan uit Amazon Glacier moeten komen. Maar ja, dat zou dus wel eens een duur (of erg geduldig) grapje kunnen worden als je de verhalen zo links en rechts leest.

Uiteindelijk is dat heel erg meegevallen. Je kan (tegenwoordig?) in Amazon zelf een 'GB/h' retrieval limiet instellen, waarbij Amazon je ook laat zien wat daarbij de maximale maandelijkse kosten zijn. Na een beetje spelen met die instelling om een beeld te krijgen van de bijbehorende kosten, uiteindelijk een 10GB/h limiet ingesteld.

Die limiet werkt vervolgens een beetje

apart. Amazon heeft gemiddeld 3-5 uur nodig om bij een retrieval job de data op te halen. Daarna kan je client het dan downloaden. Voor het bepalen of je job binnen de limiet valt, kijkt Amazon daarom naar (job size)/4uur. Met een 10GB/u limiet, kan je dus jobs van max. 40GB starten.

Nu heeft de Glacier client ook een instelling om de retrieval limiet in te stellen. Maar daarvan was me een beetje onduidelijk hoe dat in elkaar stak. Aangezien ik geen zin had in geweigerde jobs door Amazon (want kost weer zoveel uur extra om opnieuw te doen), heb ik zelf steeds (via de Explore omgeving van de Glacier package) een setje folders uitgekozen dat zo tegen de 40GB uit kwam en die dan gestart.

Tikkeltje bewerkelijk, maar als je het een beetje handig plant kan je zo wel 3 of 4 jobs per dag starten. En zodoende was ik afgelopen woensdag dan ook klaar met het herstellen van zo'n 250GB data uit Glacier. Mooi op tijd om te voorkomen dat ik ook nog voor september retrieval kosten zou moeten betalen. Die zijn namelijk niet afhankelijk van hoeveel je download, maar wat je

piek was in die maand (dus in feite afhankelijk van de grootste gestarte job).

De rekening voor deze actie kwam uiteindelijk uit op $60.

:strip_exif()/u/10111/crop67d5f1a9809eb_cropped.gif?f=community)

:strip_icc():strip_exif()/u/4851/crop593a3f1161444_cropped.jpeg?f=community)

:strip_exif()/u/4143/crop673c629560e43_cropped.gif?f=community)

/u/88899/blues.png?f=community)

/u/69952/crop655644d76e368_cropped.png?f=community)

/u/197564/crop6072aa9bcdaaf.png?f=community)

:strip_exif()/u/117880/911_gt3rs_60.gif?f=community)

:strip_icc():strip_exif()/u/10337/crop5814ad4bebe9a_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/417607/janschiphorst1%2520copy.jpg?f=community)

:strip_icc():strip_exif()/u/311422/10110011000.jpg?f=community)

:strip_icc():strip_exif()/u/345735/ross.jpg?f=community)

/u/99291/logo-square.png?f=community)

:strip_icc():strip_exif()/u/80105/griffioen.jpg?f=community)

:strip_icc():strip_exif()/u/146731/crop562615a0aa64c.jpeg?f=community)

/u/182219/crop62fea26e8dbd3_cropped.png?f=community)