PSN: NjayNL | Star Citizen Referal code | Oculus Quest

Hier soortgelijke bevindingen. Voor een backup van 400 GB aan ruwe data was 38 uur nodig. Nu meen ik aan dat er bij het transport van NAS naar C2 wel wat datacompressie wordt toegepast, maar data valt niet altijd goed samen te drukken. Afbeeldingen, audio en video, desondanks helemaal niet gek. De upload van de verbinding zal het de grootste bottleneck zijn.Njay schreef op donderdag 5 juli 2018 @ 10:49:

Gisteren een test gedaan met Synolog C2 en hyper backup werkt prima ! 123gb in 13 uur

Yep ik verwacht hierna ook alleen maar incrementals te doenFrankHe schreef op donderdag 5 juli 2018 @ 13:24:

[...]

Hier soortgelijke bevindingen. Voor een backup van 400 GB aan ruwe data was 38 uur nodig. Nu meen ik aan dat er bij het transport van NAS naar C2 wel wat datacompressie wordt toegepast, maar data valt niet altijd goed samen te drukken. Afbeeldingen, audio en video, desondanks helemaal niet gek. De upload van de verbinding zal het de grootste bottleneck zijn.

PSN: NjayNL | Star Citizen Referal code | Oculus Quest

Dit stuk slaat op elke Synology NAS en elke toepassing. Ik adviseer mensen om NOOIT een j model te kopen, tenzij ze er hele specifieke en goed doordachte redenen voor hebben om juist dat model te kopen. In de praktijk krijgt vrijwel iedereen er spijt van na ontdekt te hebben wat er allemaal kan voor moois op hun Synology, behalve op hun j modelletje.Verwijderd schreef op maandag 2 juli 2018 @ 08:58:

Wie Synology versioning grootscheeps wil gebruiken kan dus beter niet de 218j kopen, maar die extra 70 euro uitgeven voor de 218 versie, en Btrfs gebruiken. De meerprijs betaal zich onmiddellijk terug in vermindere HDD kosten. Jammer dat je dat soort dingen past uitvindt wanneer je daadwerkelijk met zo'n apparaat zit te spelen…

DRoME LAN Gaming | iRacing profiel | Kia e-Niro 64kWh | Hyundai Ioniq 28kWh | PV 5.760Wp |

Maar goed dat ik dan een SE modelletje heb genomenArfman schreef op donderdag 5 juli 2018 @ 21:17:

[...]

Dit stuk slaat op elke Synology NAS en elke toepassing. Ik adviseer mensen om NOOIT een j model te kopen, tenzij ze er hele specifieke en goed doordachte redenen voor hebben om juist dat model te kopen. In de praktijk krijgt vrijwel iedereen er spijt van na ontdekt te hebben wat er allemaal kan voor moois op hun Synology, behalve op hun j modelletje.

Ik gebruik hem alleen voor fileshare, photostation en VPN toegang met 2 hdd's zonder raid of wat dan ook. Voldoet prima voor die 140 euro, echter wil ik nog wel een keer naar een 4 discs of meer NAS, maar niet omdat deze niet meer voldoet.

Wenn ist das Nunstruck git und Slotermeyer? Ja!... Beiherhund das Oder die Flipperwaldt gersput! The Hornets of Hades have descended upon me

Verwijderd

Inderdaad, wanneer je versioning gebruikt, dan is de j-versie niet de goede keuze. En dat had ik graag eerder geweten. MAAR... Er zijn meer zaken belangrijk dan alleen de technische kant. Ook de user interface, en de use-cases zijn belangrijk.

Het versie beheer is VEEL plezieriger en makkelijker in het gebruik bij Windows File History, dan bij de Synology NAS. Niet alleen dat het mooi in Windows is geintegreerd… Bij WFH krijg je ook previews van de files te zien, bij de Synology NAS weet je niets meer dan dat er een oudere versie is... Dan moet je dus alle oude versies downloaden, en allemaal naast elkaar openen om te zien welke jij wilt hebben.

Bij WFH kun je ook een preview van de folder krijgen, zodat je makkelijk kan zien wanneer er files zijn verwijderd of toegevoegd. Wederom veel lastiger in Synology.

Wanneer je 3-2-1 backups doet, dan is het opzichzelf prima om Windows File History direct op de NAS te hebben staan, en dan een (versioning) HyperBackup naar de derde locatie. En dan heb je geen versioning op de NAS zelf nodig. En dan is de j-versie van de Synology NAS'en prima geschikt, en heb je geen duurdere variant nodig.

Zou wel interessant zijn om te zien in hoeverre de duurdere variant ook signficant sneller is. Zowel de doorvoersnelheid als de accesstime zijn stukken langzamer bij versioning. Ik ben benieuwd of dat bij Btrfs versioning volledig opgelost wordt, of dat het nog steeds behoorlijk aan prestatie inboet… Ik heb zo het gevoel dat het database beheer nog steeds een grote bottleneck zal zijn.

Het principe was dat als jij 2GB backupruimte beschikbaar stelt je 1GB kunt backuppen. Er werd (zo uit mijn hoofd) gebruik gemaakt van RAID 96: https://www.qnap.com/nl-n...how.php?op=showone&cid=18 (wat meer info).

Het had zeker potentie. Helaas ging het uploaden erg langzaam. Heb nog een tijdje via het ontwikkelaarsteam getest met beta's getest op mijn Synology maar een upload van 100KB/s was het maximaal haalbare.

Nu zie ik dat er een nieuwe partij iets soortgelijks wil gaan opzetten: https://storj.io/ zijn er mensen die hier meer over weten? Je kunt op een wachtlijst gezet worden, maar blijkbaar lees ik wel dat er een en ander gereleashed is.

Een package is nog niet beschikbaar, je kunt het wel installeren via docker.

Zijn er meer mensen die tegen dit probleem aanlopen en hoe hebben jullie dat opgelost?

Bij een aantal back-ups stond versioning op "Vanaf de oudste versie"

Omdat er nu te veel opslag gebruikt wordt heb ik besloten die om te zetten naar "Smart Recycle"

Helaas worden de oudere versies niet verwijderd. Iemand een idee hoe ik dat geautomatiseerd op kan lossen, zonder dat ik handmatig versies moet verwijderen?

Mijn tactiek was enkele jaren geleden: geeft een maximaal aantal versies op. Vervolgens zullen de backups die dit getal overschrijden worden verwijderd. Vervolgens na deze stap de optie "Smart Recycle" weer aanzetten.GrasshopperNL schreef op maandag 17 september 2018 @ 07:56:

Ik heb een probleempje met hyper back-up

Bij een aantal back-ups stond versioning op "Vanaf de oudste versie"

Omdat er nu te veel opslag gebruikt wordt heb ik besloten die om te zetten naar "Smart Recycle"

Helaas worden de oudere versies niet verwijderd. Iemand een idee hoe ik dat geautomatiseerd op kan lossen, zonder dat ik handmatig versies moet verwijderen?

I don't suffer from insanity, I enjoy every minute of it.

Ik zag 10TB voor 5 euro per maand, inclusief BTW.

Nou weet ik dat iets wat te mooi om waar te zijn is, dat meestal ook is...

Maar wellicht zijn er mensen positief gesteld over hubiC?

Ryzen 5950x + 32GB GSKILL @3600 op Rog Strix Gaming E x570 + Asrock Phantom Gaming 6800XT+ Gigabyte Aorus FV43U Zwart + DS1621+ + DS414 + MacbookPro 16" 2021 + Mac Mini M4 Pro + Tesla MY RWD 2023 BYD

Ik heb het een tijdje geprobeerd. Reken op geen enkele support en geen enkele communicatie.Marcel_EA schreef op vrijdag 21 september 2018 @ 20:16:

Iemand ervaring met hubiC (icm Synology)?

Ik zag 10TB voor 5 euro per maand, inclusief BTW.

Nou weet ik dat iets wat te mooi om waar te zijn is, dat meestal ook is...

Maar wellicht zijn er mensen positief gesteld over hubiC?

Als het niet werkt is het dus erg jammer voor je.

Geen aanrader.

With so many things coming back in style, I can't wait till loyalty, intelligence and morals become a trend again.......

Op de site zelf bij aanmelden:

https://www.ovh.co.uk/subscriptions-hubic-ended/

Dat lijkt me te mooi om waar te zijn. Verwacht wel dat er een berichtje gestuurd gaat worden met een verwijzing naar een "fair use policy" wanneer je 10 TB vol zet met oncomprimeerbare data. Rekenen ze geen kosten voor het terughalen van data?Marcel_EA schreef op vrijdag 21 september 2018 @ 20:16:

Iemand ervaring met hubiC (icm Synology)?

Ik zag 10TB voor 5 euro per maand, inclusief BTW.

Nou weet ik dat iets wat te mooi om waar te zijn is, dat meestal ook is...

Maar wellicht zijn er mensen positief gesteld over hubiC?

Rekensommetje, 5 euro per maand is 60 euro per jaar. Herinvestering na drie jaar maakt 180 euro. Daar kan ik niet met goed fatsoen 10TB van maken. Dan blijf je ergens halverwege steken. Je hebt naast harde schijven namelijk ook nog een kast nodig die je ergens neer moet zetten, elektriciteit en dataverkeer inkopen, noem maar op. Met redundancy en dergelijk kom ik met de huidige prijzen uit op een netto opslag van pakweg 2TB voor 5 euro per maand. Dat is tenminste wanneer je een fatsoenlijke service wilt kunnen garanderen. Het is mogelijk dat deze partij in hun business model de gok neemt en hun provisioning heftig overboekt. Er van uitgaande dat er bijna niemand is die daadwerkelijk die 10TB zal wegschrijven. Wanneer je "over 36 maanden vanaf nu" pas richting die 10TB kruipt dan zou het financieel wellicht nog wel uit kunnen. Afgaande op een herinvestering tegen die tijd met (naar verwachting) aanzienlijke prijsdaling voor opslag.

Maar dan moet er in de tussentijd niet ergens een overstroming zijn die alle hardeschijffabrieken onderwater zet. Want dan gaat de prijs alleen nog maar omhoog. Voor mijn gevoel zit er een durfinvesteerder achter die wel van een gokje houdt.

Het foutrapport zegt het volgende:

Met daaronder nog een vijftigtal andere bestanden. Mailtje naar Synology is onderweg en ik ga morgen de SMART-waarden bekijken. Toch ben ik ondertussen erg benieuwd of anderen hier ervaring mee hebben. Op google vindt ik enkel gelijkwaardige verhalen welke te wijten waren aan een bug in Hyper Backup welke reeds is verholpen.Backup task was unable to run due to errors found at the backup destination.

The following files were found broken in the latest integrity check and cannot be restored.

There may be other broken files which were not detected this time.

If you have further questions, please contact Synology support.

Broken file(s):

Version: 2018-09-09 18:00:07+0200, shared folder: backup

File 47993113 2014-12-31 21:29:51 Bestandsgeschiedenis/Desktop-slaapkamer/Bartv/DESKTOP-L407087/Data/D/Gebruikers/Bart/Pictures/Mobiel/2014-12/IMG_1677 (2018_06_09 18_30_39 UTC).MOV

Ik heb momenteel een ds214 se met 2x3TB (SHR). Ik kon voor een prijsje een ds415+ kopen met 4x4TB.

Hoe kan ik het makkelijkste overstappen naar de ds415+, indien mogelijk met behoud van al mijn instellingen (en data uiteraard)?

DRoME LAN Gaming | iRacing profiel | Kia e-Niro 64kWh | Hyundai Ioniq 28kWh | PV 5.760Wp |

Starten met de ds214:

Eerste disk vervangen door een 4TB. Raid rebuilden.

Tweede disk vervangen door een 4TB. Raid rebuilden.

Daarna beide disks in de 415+. De ds415+ installeren (kan zonder dataverlies maar je hebt de twee 3TB schijven nog als backup!). Daarna de twee overige 4TB schijven erbij en je raid uitbreiden.

[ Voor 8% gewijzigd door job op 24-09-2018 16:05 ]

goed idee! hoe lang duurt het om de raid te rebuilden? vermoedelijk zal dit wel (een pak) trager gaan op de ds214se...?job schreef op maandag 24 september 2018 @ 15:48:

Andere optie:

Starten met de ds214:

Eerste disk vervangen door een 4TB. Raid rebuilden.

Tweede disk vervangen door een 4TB. Raid rebuilden.

Daarna beide disks in de 415+. De ds415+ installeren (kan zonder dataverlies maar je hebt de twee 3TB schijven nog als backup!). Daarna de twee overige 4TB schijven erbij en je raid uitbreiden.

Al heb ik het idee dat synology een rebuild bewust traag houdt (je kan via de command line rebuilding versnellen).

Hoe lang een rebuild duurt is ook afhankelijk van de hoeveellheid data.

Maar wees niet verbaasd als je per schijf minimaal halve dag kwijt bent.

Als voorbeeld: ik was voor een expand (is geen rebuild!) van mijn shr raid zo 12 uur kwijt per schijf.

Derde optie, mocht je haast hebben: leeg beginnen met de DS415+ data via lan overzetten en de config vanuit de 214se importeren.

Voordeel: geen rebuild dus snel je data overgezet.

Nadeel: een backup van je config is erg onvolledig. https://www.synology.com/...enter/system_configbackup

Zo moeten bijvoorbeeld packages opnieuw worden geinstalleerd en geconfigureerd en tig andere kleine klusjes moet je opnieuw instellen (reverse proxy, ssl certificaten, et cetera).

Keuze is dus tussen:

1. je nas het werk laten doen en lang wachten totdat het klaar is (rebuilden en schijven overzetten) via arfmans of mijn oplossing.

2. snel alles overzetten maar veel handwerk (opnieuw beginnen en configuratie import).

[ Voor 64% gewijzigd door job op 24-09-2018 22:20 ]

Oude setup:

- Productie HP N40L Xpenology RAID 5

- Backup onsite wekelijks via HyperBackup naar externe USB geen RAID

- Backup offsite dagelijks via HyperBackup naar 213J RAID 1

- Backup offsite wekelijks via Duplicati naar TransIP Stack

- Productie HP N40L Xpenology RAID 5

- Backup onsite dagelijks via HyperBackup naar 214SE RAID 1

- Backup offsite dagelijks via HyperBackup naar 213J RAID 1

- Backup onsite wekelijks via HyperBackup naar externe USB geen RAID

[ Voor 27% gewijzigd door Hari-Bo op 04-10-2018 11:47 ]

Bos Digitale Autoservice Onafhankelijke automotive dienstverlening; diagnose, codering, retrofit, sleutelservice, ECU en tuning. Projecten

Wilde mijn backup eens testen en heb een hele backup naar lokale disk gedownload. Hiervan probeer ik een set files met hyper backup explorer te restoren, maar dit is extreem traag. Na 10 minuten is er ongeveer 75MB restored.

Via de diskstation zelf is in 10 minuten 1+GB restored van een online source.

Mijn backups zijn compressed en encrypted.

Een backup van 500+GB duurt met deze snelheid 1.5 maand om te restoren. Het is voor nood situaties maar vind dit toch wel iets te langzaam.

Wil eigenlijk dat hij een beveiligde verbinding maakt met de NAS.

Ik dacht zelf eraan om op de 2e NIC verbinding van de NAS aan te sluiten op de router en die een VPN (welke software het slimst? dacht zelf OpenVPN.)

Op andere locatie Raspberry Pi met USB HDD en Open VPN software erop naar de NAS toe.

Op de NAS stel ik een back-up schema in naar de Raspberry Pi.

Op de vraag waarom een Raspberry Pi? Eigenlijk stroomverbruik en lekker klein en de snelheid is ruim voldoende.

Edit : Typo +

[ Voor 1% gewijzigd door Cave_Boy op 16-10-2018 11:40 . Reden: Typo ]

Maar hoe krijg ik dat voor elkaar.

Er zit maximaal DSM 5 op en daarop kan ik geen webdav of hyberbackup installeren.

Dus hoe ga ik zorgen dat ik wel daarnaartoe een backup kan maken?

Iemand een linkje waarmee ik kan starten uitzoeken?

With so many things coming back in style, I can't wait till loyalty, intelligence and morals become a trend again.......

Voorzover ik weet heeft DSM5 webdav ingebouwd, en is een losse Webdav App niet nodig (sinds dsm6 anders).Cyberpope schreef op donderdag 25 oktober 2018 @ 09:35:

Ik heb een DS210j al een paar jaar hier liggen en wilde deze nu inzetten als off-site backup.

Maar hoe krijg ik dat voor elkaar.

Er zit maximaal DSM 5 op en daarop kan ik geen webdav of hyberbackup installeren.

Dus hoe ga ik zorgen dat ik wel daarnaartoe een backup kan maken?

Iemand een linkje waarmee ik kan starten uitzoeken?

Daarbij kun je bij mijn weten ook gewoon bijv. webdav koppelen aan Filestation in DSM5 alsmede werkt cloud sync in dsm5 ook met webdav..

Hyperback-up is er inderdaad niet voor DSM5, enkel vanaf DSM6 en hoger..

Wellicht heb je wat aan mijn info..

Erg af te raden, en bovendien ook erg langzaam..Marcel_EA schreef op vrijdag 21 september 2018 @ 20:16:

Iemand ervaring met hubiC (icm Synology)?

Ik zag 10TB voor 5 euro per maand, inclusief BTW.

Nou weet ik dat iets wat te mooi om waar te zijn is, dat meestal ook is...

Maar wellicht zijn er mensen positief gesteld over hubiC?

En zoals sommige hier ook al aangaven, er is 0 support aanwezig...

Dit werkt tot op heden uitstekend, (ong. 3 maanden) hier zit nu een dikke 5TB aan encrypted hyper-backup data in..

iemand ook ervaringen hiermee.. ??

Bij mijn weten blijven EDU accounts bestaan, als je binnen 80 dagen een keer inlogt, dat er account activiteit moet plaats vinden..

Nou webdav krijg ik helemaal geen verbinding op. Dan kan hij de server niet vinden.FlorisVN schreef op donderdag 25 oktober 2018 @ 12:33:

[...]

Voorzover ik weet heeft DSM5 webdav ingebouwd, en is een losse Webdav App niet nodig (sinds dsm6 anders).

Daarbij kun je bij mijn weten ook gewoon bijv. webdav koppelen aan Filestation in DSM5 alsmede werkt cloud sync in dsm5 ook met webdav..

Hyperback-up is er inderdaad niet voor DSM5, enkel vanaf DSM6 en hoger..

Wellicht heb je wat aan mijn info..

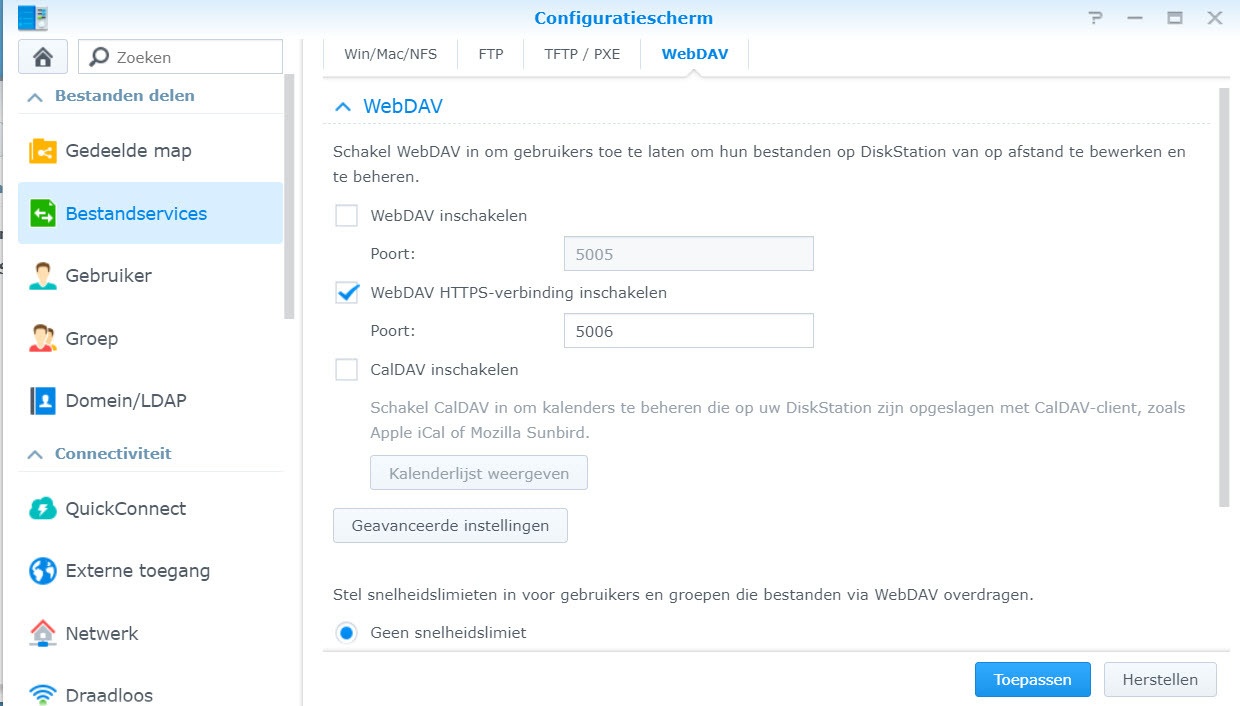

Webdav netjes aangezet in de settings

En rsync staat ook aan:

Als ik dan via hyperback een taak maak gaat het redelijk goed. Het eerste scherm kom ik door, of te wel hij maakt verbinding wat ik kan daar een doelmap kiezen op de DS210J die ik als backup wil gebruiken. Mij maakt dus zeker verbinding.

Maar loop ik dan alle schermen door, dan krijg ik na het laatste scherm een probleem.

Bij webdav : Geen toegang tot backup-bestemming

Bij Rsync : Kan geen verbinding maken met SSH service

Iemand enige tips?

Alle rechten staan goed. De user die ik gebruik heeft overal rechten op (maar echt alles om dat uit te sluiten).

Dit alles is nog binnen mijn eigen netwerk.

With so many things coming back in style, I can't wait till loyalty, intelligence and morals become a trend again.......

(En volgens mij moet een ssh account admin rechten hebben om uberhaupt connectie te maken.)

Ik ben verstopt zoek een ander :P

Ook een andere SSH poort geprobeerd... Allemaal hetzelfde effect.

En mijn backuser is administrator met alle rechten.

With so many things coming back in style, I can't wait till loyalty, intelligence and morals become a trend again.......

Anders even Synology support inschakelen ?

wellicht snelste oplossing..

Bij mijn weten wordt DSM5 wel ondersteund als doel voor een Hyperback-up vanuit DSM6.

Ik had gisteren hetzelfde. Toen geprobeerd via http (poort 5005) en dat werkt wel.Cyberpope schreef op vrijdag 26 oktober 2018 @ 10:40:

Nou webdav krijg ik helemaal geen verbinding op. Dan kan hij de server niet vinden.

Webdav netjes aangezet in de settings

[Afbeelding: synology webdev doel]

Iemand enige tips?

Dit alles is nog binnen mijn eigen netwerk.

FlorisVN schreef op donderdag 25 oktober 2018 @ 12:34:

[...]

Erg af te raden, en bovendien ook erg langzaam..

En zoals sommige hier ook al aangaven, er is 0 support aanwezig...

Sterker nog, het stopt zelfs ineens met werken zonder enige kennisgeving en op één of andere manier gaf de NAS ook geen melding.caspertje19 schreef op zaterdag 22 september 2018 @ 08:56:

Voor zover mij bekend in dit topic wat ik las, neemt hubic geen nieuwe klanten meer aan...

Op de site zelf bij aanmelden:

https://www.ovh.co.uk/subscriptions-hubic-ended/

Gelukkig kom ik er nu achter en niet als ik de data nodig heb, nu maar even op zoek naar wat anders.

If you hide your whole life, you'll forget who you even are. Uplay: TheWorstNL | Steam + Origin + PSN: The_Worst_NL

De huidige situatie is als volgt:

Tevens overweeg ik de externe HD weg te laten aangezien ik deze ook voor andere zaken kan gebruiken. Hoe kijken jullie hier tegenaan?

Ik zou eens in de zoveel tijd ook een backup van jouw laptop/iCloud files laten maken naar de Synology. Tevens zou ik waardevolle items - zeg foto's - ook eens in de zoveel tijd op je Synology zetten.Psvtje10 schreef op woensdag 28 november 2018 @ 10:46:

Zouden jullie feedback willen geven op mijn huidige backup strategie? Naar mijn eigen idee is deze zo goed als waterdicht maar wellicht zie ik iets over het hoofd.

Ja, volgens mij kan die wel weg. Je verliest dan de mogelijkheid van zeer snelle data-recovery, maar dat risico zou je kunnen lopen.Tevens overweeg ik de externe HD weg te laten aangezien ik deze ook voor andere zaken kan gebruiken. Hoe kijken jullie hier tegenaan?

Overigens wat ik mis in jouw overzicht is de controle op integriteit van jouw C2-backup. Zorg dat je eens in de zoveel tijd een controle uitvoert in het terugplaatsen van een of meer bestanden en misschien zelfs een volledige restore.

Dank, dat is een goed idee.DAzN schreef op woensdag 28 november 2018 @ 10:54:

[...]

Ik zou eens in de zoveel tijd ook een backup van jouw laptop/iCloud files laten maken naar de Synology. Tevens zou ik waardevolle items - zeg foto's - ook eens in de zoveel tijd op je Synology zetten.

[...]

Scherp! Ik heb dit niet in het overzicht gezet maar dit gebeurt periodiek, elke maand wordt gecheckt of alles nog is zoals het zou moeten zijn.Overigens wat ik mis in jouw overzicht is de controle op integriteit van jouw C2-backup. Zorg dat je eens in de zoveel tijd een controle uitvoert in het terugplaatsen van een of meer bestanden en misschien zelfs een volledige restore.

FrankHe schreef op donderdag 5 juli 2018 @ 13:24:

[...]

Hier soortgelijke bevindingen. Voor een backup van 400 GB aan ruwe data was 38 uur nodig. Nu meen ik aan dat er bij het transport van NAS naar C2 wel wat datacompressie wordt toegepast, maar data valt niet altijd goed samen te drukken. Afbeeldingen, audio en video, desondanks helemaal niet gek. De upload van de verbinding zal het de grootste bottleneck zijn.

Wat voor internetverbinding hebben jullie?Njay schreef op donderdag 5 juli 2018 @ 10:49:

Gisteren een test gedaan met Synolog C2 en hyper backup werkt prima ! 123gb in 13 uur

Overweeg de 1TB versie voor de belangrijkste data met een 200/40 verbinding.

Dus in het best case scenario duur het +55 uur voordat alles is geupload

Binnenkort een weekje op vakantie, dus mooi moment om dit proces in gang te zetten zonder er veel last van te hebben. (Er van uitgaande dat alles goed gaat en er verder geen handelingen meer moeten worden verricht)

Zijn jullie nog steeds tevreden met C2?

[ Voor 15% gewijzigd door Greatsword op 05-12-2018 17:59 ]

Werkt bij mij prima. Prijs is voor mijn gevoel heel 'ok' wanneer je het vergelijkt met wat er verder zoal op de markt is.Unidentified schreef op woensdag 5 december 2018 @ 17:45:

[...]

Wat voor internetverbinding hebben jullie?

Overweeg de 1TB versie voor de belangrijkste data met een 200/40 verbinding.

Dus in het best case scenario duur het +55 uur voordat alles is geupload

Binnenkort een weekje op vakantie, dus mooi moment om dit proces in gang te zetten zonder er veel last van te hebben. (Er van uitgaande dat alles goed gaat en er verder geen handelingen meer moeten worden verricht)

Zijn jullie nog steeds tevreden met C2?

Een functionaliteit die mij erg aanspreekt is de continuïteit bij een disaster recovery. In beginsel is een volledige restore natuurlijk geen leuke situatie maar wat ze slim hebben opgelost is de dynamische prioritisering van de restore. Je hoeft niet te wachten tot de restore is voltooid, je kunt al bestanden opvragen wanneer de restore loopt. En als je bestanden opvraagt die nog niet zijn gerestored dan worden die direct met de hoogste prioriteit opgehaald. Je kunt kortom vrijwel ongestoord doorwerken. Van zulke functionaliteit wordt ik wel blij. Heb het zelf nog niet nodig gehad en hopelijk heb ik het nooit nodig. Maar toch fijn om te weten dat ze daar goed over hebben nagedacht. Ik ben graag bereid om voor dit soort dingen te betalen, vandaar dat mijn backup bij C2 staat.

Ik zit hier op een ziggo van denk ik 120/120 , tot zover happy en gelukkig nog nooit te hoeven gebruikenUnidentified schreef op woensdag 5 december 2018 @ 17:45:

[...]

[...]

Wat voor internetverbinding hebben jullie?

Overweeg de 1TB versie voor de belangrijkste data met een 200/40 verbinding.

Dus in het best case scenario duur het +55 uur voordat alles is geupload

Binnenkort een weekje op vakantie, dus mooi moment om dit proces in gang te zetten zonder er veel last van te hebben. (Er van uitgaande dat alles goed gaat en er verder geen handelingen meer moeten worden verricht)

Zijn jullie nog steeds tevreden met C2?

PSN: NjayNL | Star Citizen Referal code | Oculus Quest

Nu ken ik wel de Backup Explorer. Daarin zie ik de bestanden die op de HiDrive gebackupped zijn. Dat is prima en daar kan ik ook terugzetten wat nodig is.

Maar wat nu als de NAS afbrand. Kan ik dan simpelweg op een nieuwe NAS de inloggegevens van HiDrive gooien in Hyper Backup en werkt dan de Backup Explorer weer?

Iemand daar ervaring mee?

Automatisch crypto handelen via een NL platform? Check BitBotsi !

Ik heb een thuisserver (een gewone pc met windows 10, gedeelde mappen met bestanden en geen user ingelogd) waarvan bepaalde mappen automatisch moeten worden gebackupped naar de diskstation.

Nu zag ik dat Cloudstation alleen werkt wanneer je ingelogd bent, dus dat is niet zo handig.

Vroeger gebruikte ik een DS207 met Cobian backup, geïnstalleerd als service op de server, maar dat is inmiddels wel erg verouderd.

Ik gebruik daarom nu (handmatig) Easeus Todo Backup (Free) met een usb-disk, maar wil eigenlijk dat het automatisch naar de NAS gaat en ik vind één groot beckup bestand niet heel handig wanneer je wat wil terugzoeken.

Volgende stap is om die backup dan weer veilig (vpn?) en encrypted naar een offsite diskstation te backuppen, maar dat komt daarna wel weer.

Ik wil dus bepaalde folders automatisch backuppen (incrementeel of differentieel), zonder ingelogde gebruiker. Ik kan niet ontdekken welk (liefst gratis) programma hier nu het handigst voor is.

[ Voor 3% gewijzigd door BounceMeister op 08-12-2018 23:30 ]

In jouw geval is Syncthing misschien nog makkelijker. Dit is meer een synchronisatie tool.

Ik draai beide op mijn Diskstation, maar op een pc moet dit ook geen enkel probleem zijn lijkt me. Zonder ingelogde user lijkt me instelbaar.

Ik wilde graag de SSD's uit het volume halen en als SSD cache instellen op de 818 dus heb met hyperbackup een back-up gemaakt om die later terug te kunnen zetten. Alleen dat terugzetten is helaas onwerkbaar traag gebleken, nog geen gigabyte per minuut by far. Encryptie had ik uit staan, dus dat kan het niet zijn, ze hebben verder een dubbele 10 gigabit glasvezelverbinding.

Dus ik vraag me af, wie heeft wel eens een restore gedaan met hyperbackup en hoe was dat qua snelheid?

Ik heb eerst gezocht naar een Windows backup-tool die als service draait, maar dat valt toch niet mee. Chielmi opperde twee programma's, maar die zijn niet gemakkelijk als service te draaien. Er komen dan tooltjes zoals "AlwaysUp" bij kijken, maar de werking daarvan vind ik vreemd, je kan namelijk de applicatie (die je als service draait) niet gewoon starten wanneer je wel bent ingelogd.

Vroeger gebruikte ik Cobian Backup (als service), maar dat is inmiddels al verouderd en niet meer ondersteund door de ontwikkelaar.

Edit,

Cloudstation is ook geen optie, die presteert het om een backup van ~3TB een dikke 500GB groter te maken dan het origineel bij de eerste keer backuppen.

[ Voor 10% gewijzigd door BounceMeister op 10-12-2018 08:13 ]

De grootste Nederlandstalige database met informatie over computers met zoekfunctie!!

Ben je hier nog verder mee gekomen? Ik zit aan dezelfde setup te denken.Cave_Boy schreef op dinsdag 16 oktober 2018 @ 10:30:

Heb zelf een Synology 918+. Ik wil eigenlijk dat deze bepaalde mappen gaat back-uppen naar een externe locatie. Nu heb ik zitten denken aan een Raspberry Pi met een USB schijf. Heeft iemand hier ervaring mee?

Wil eigenlijk dat hij een beveiligde verbinding maakt met de NAS.

Ik dacht zelf eraan om op de 2e NIC verbinding van de NAS aan te sluiten op de router en die een VPN (welke software het slimst? dacht zelf OpenVPN.)

Op andere locatie Raspberry Pi met USB HDD en Open VPN software erop naar de NAS toe.

Op de NAS stel ik een back-up schema in naar de Raspberry Pi.

Op de vraag waarom een Raspberry Pi? Eigenlijk stroomverbruik en lekker klein en de snelheid is ruim voldoende.

Edit : Typo +

Ik backup twee laptops naar mijn NAS. Het is daarnaast de primaire storage voor foto's (inclusief RAW) en grotere werkbestanden die niet op de laptop hoeven te staan.

Aan mijn NAS hangt nu een externe 5TB USB schijf. Met Hyper Backup maak ik daarop dagelijks een backup met versioning. Daar is nu een ruime 2TB van in gebruik.

In het geval van brand, blikseminslag of diefstal ben je dan redelijk de sjaak: Laptops, NAS, backups allemaal op dezelfde locatie.*

Mijn idee was nu ook om die USB schijf aan een RaspberryPi te hangen en die bij een familielid te stallen.

*De belangrijkste bestanden staan met behulp van Cloud Sync ook bij TransIP: Stack. Officieel ondersteunt Stack geen versioned backups en meer dan 2TB kost €600,- per jaar. Ik heb nog 1TB gratis en dat is een mooi extra vangnet.

Op de nas heb ik vpn server ingesteld. Een VPN gebruiker en ik kreeg bij toeval een mini pc met een z8350 erin en 4Gb ram. Ding heeft max verbruik van 6 watt maar heeft ook een stuk hogere doorvoer. De mini pc staat ergens anders en kan ik evt ook remote overnemen. De mini pc doet in dit geval VPN verbinding maken en om de zoveel tijd bepaalde mappen beveiligd op schijf zetten. Ik merkte dat de Rasperry Pi (ook nieuwste geprobeerd) daar behoorlijk moeite mee heeft. De doorvoer zonder encryptie ( ook VPN zo open mogelijk ) kan hoog zijn maar zodra je eigenlijk de encryptie op een normaal a hoger level zet gaat de doorvoer drastisch naar beneden. Het kan nog steeds goed bruikbaar zijn. Het is immers backup en loopt gewoon. Maar kreeg niet veel meer dan 1 a 2MB/s. Nu met mini pc is dit rond de 100MB/s in test opstelling en in werkelijkheid door limiet uploade kom ik uit op 6 a 7MB/sM-ThijZ schreef op vrijdag 25 januari 2019 @ 22:28:

[...]

Ben je hier nog verder mee gekomen? Ik zit aan dezelfde setup te denken.

Ik backup twee laptops naar mijn NAS. Het is daarnaast de primaire storage voor foto's (inclusief RAW) en grotere werkbestanden die niet op de laptop hoeven te staan.

Aan mijn NAS hangt nu een externe 5TB USB schijf. Met Hyper Backup maak ik daarop dagelijks een backup met versioning. Daar is nu een ruime 2TB van in gebruik.

In het geval van brand, blikseminslag of diefstal ben je dan redelijk de sjaak: Laptops, NAS, backups allemaal op dezelfde locatie.*

Mijn idee was nu ook om die USB schijf aan een RaspberryPi te hangen en die bij een familielid te stallen.

*De belangrijkste bestanden staan met behulp van Cloud Sync ook bij TransIP: Stack. Officieel ondersteunt Stack geen versioned backups en meer dan 2TB kost €600,- per jaar. Ik heb nog 1TB gratis en dat is een mooi extra vangnet.

Als mini pc die ik bij toeval kreeg is het trouwens een China bakje van 2cm hoog en 7 breed en lang. Hij is ook passief.

[ Voor 96% gewijzigd door Freakster86 op 18-06-2019 13:13 ]

Syno 918+ waar main data op staat (on-site)

Syno 213+ waar wekelijks backup (encrypted) naar toe gaat. Retentie van 6 wk (on-site)

Handmatige encrypted backup naar externe harde schijf (off-site)

Voor de backup tussen de 918 en 213 ben ik aan het kijken of BTRFS het meest geschikt is. Iemand tips?

Nu de vraag: in de backup set bevindt zich een folder waar vaak grote files worden geplaatst. Deze files worden ook meegebackupped. Maar ongeveer 80% van de tijd worden de files na een aantal weken ook weer verwijderd. Wat gebeurt er nu precies met de backups van deze files? Worden de backups na verloop van tijd ook verwijderd? Zo ja, wanneer? Zo nee.... dan wordt de backup toch alleen maar groter over de tijd???

Hyperbackup verwijderd geen individuele bestanden uit een reeds gemaakte set, maar kijkt wel in de set of een bestand reeds bestaat en of het is gewijzigd sinds de laatste run.

Als die map zo dynamisch is met tijdelijke bestanden, kun je er voor kiezen om die map uit te sluiten van de backup. Anders zul je inderdaad soms met een grote backup zitten, en soms met een kleinere.Smart Recycle: The system will retain every backup version until the specified number of versions is exceeded. When rotation is triggered, the system will first rotate the versions that do not meet any of the conditions; if all the existing versions meet the conditions below, the system will rotate the earliest version:

Hourly versions from the past 24 hours: Keep the earliest version created each hour.

Daily versions from the past 1 day to 1 month: Keep the earliest version created each day.

Weekly versions older than 1 month: Keep the earliest version created each week.

[ Voor 0% gewijzigd door DAzN op 18-07-2019 09:13 . Reden: @-tag toegevoegd ]

DAzN schreef op donderdag 18 juli 2019 @ 09:12:

@smeerbartje Als de bestanden zich in de set bevinden op het moment dat de backup wordt geschreven, dan blijven die bestanden in de set totdat de set voldoet aan de criteria van de rotatie. Alleen dan wordt de volledige set verwijderd, inclusief de bestanden die dan waarschijnlijk al lang niet meer bestaan.

Hyperbackup verwijderd geen individuele bestanden uit een reeds gemaakte set, maar kijkt wel in de set of een bestand reeds bestaat en of het is gewijzigd sinds de laatste run.

[...]

Als die map zo dynamisch is met tijdelijke bestanden, kun je er voor kiezen om die map uit te sluiten van de backup. Anders zul je inderdaad soms met een grote backup zitten, en soms met een kleinere.

Waarom wil je BTRFS gebruiken? Zover ik kan zien ondersteunt de 213+ geen BTRFS, dus die keuze lijkt mij eenvoudig.daily.data.inj schreef op zondag 14 juli 2019 @ 16:23:

Voor mijn backups wil ik de volgende backup strategie gebruiken.

Syno 918+ waar main data op staat (on-site)

Syno 213+ waar wekelijks backup (encrypted) naar toe gaat. Retentie van 6 wk (on-site)

Handmatige encrypted backup naar externe harde schijf (off-site)

Voor de backup tussen de 918 en 213 ben ik aan het kijken of BTRFS het meest geschikt is. Iemand tips?

https://www.synology.com/...ort_the_Btrfs_file_system

Verder is je regime ok, maar ik zou kijken naar een dagelijkse off-site backup. Dus zet die 213+ op een andere locatie of schrijf een dagelijkse backup van je belangrijke data naar een online dienst.

Zover ik kan zien niet. Ik kan de backup-integriteit controleren, bladeren tussen verschillende gemaakte backups en individuele bestanden herstellen. Maar het (automatisch) verwijderen van bestanden gaat niet.smeerbartje schreef op donderdag 18 juli 2019 @ 09:18:

Duidelijk verhaal. Is het mogelijk om een soort van "purge deleted files"-actie uit te voeren op de backup set? Zo niet, dan moet ik inderdaad deze "vluchtige" directory excluden van de backup set.

[ Voor 22% gewijzigd door DAzN op 18-07-2019 09:27 . Reden: samenvoegen van twee posts. ]

[ Voor 95% gewijzigd door DAzN op 18-07-2019 09:27 ]

DAzN schreef op donderdag 18 juli 2019 @ 09:12:

@smeerbartje Als de bestanden zich in de set bevinden op het moment dat de backup wordt geschreven, dan blijven die bestanden in de set totdat de set voldoet aan de criteria van de rotatie. Alleen dan wordt de volledige set verwijderd, inclusief de bestanden die dan waarschijnlijk al lang niet meer bestaan.

Hyperbackup verwijderd geen individuele bestanden uit een reeds gemaakte set, maar kijkt wel in de set of een bestand reeds bestaat en of het is gewijzigd sinds de laatste run.

[...]

Als die map zo dynamisch is met tijdelijke bestanden, kun je er voor kiezen om die map uit te sluiten van de backup. Anders zul je inderdaad soms met een grote backup zitten, en soms met een kleinere.

Niet uit de reeds gemaakte backup. Maar tijdens de volgende run wordt er gekeken wat de stand van zaken op dat moment is. Die tijdelijke bestanden zijn intussen weg, en worden niet meegenomen. Verder worden alleen de incrementele wijzigingen overgenomen. Dus de backup is niet zo gek veel groter dan de vorige keer, sterker, die grote bestanden zijn weg, dus hij is zelfs kleiner. Daarom is het verstandig om die grote bestanden, als ze niet zo veel waard zijn, uit te sluiten van de backup.smeerbartje schreef op donderdag 18 juli 2019 @ 09:37:

Ik dacht er nog even over na, maar is het niet gek dat bestanden echt NOOIT weg worden gegooid in de backup set? Dit is toch geen onderhoudbare situatie? Een backup set blijft immers groeien, aangezien verwijderde files NOOIT uit de backup set worden verwijderd.

In het ergste geval wordt de grote backup pas bij de 20e rotatie verwijderd.

Als die bestanden echt zo groot zijn, kun je overwegen extra alert te zijn bij de initiële backup. Die zal tenslotte alle bestanden bevatten, en zover ik weet, blijven die altijd in die set staan.

Ah oke.. dus ik begrijp goed dat na 20x een bakcup maken, dat DAN de verwijderde files wel worden verwijderd? Dus:DAzN schreef op donderdag 18 juli 2019 @ 09:43:

[...]

Niet uit de reeds gemaakte backup. Maar tijdens de volgende run wordt er gekeken wat de stand van zaken op dat moment is. Die tijdelijke bestanden zijn intussen weg, en worden niet meegenomen. Verder worden alleen de incrementele wijzigingen overgenomen. Dus de backup is niet zo gek veel groter dan de vorige keer, sterker, die grote bestanden zijn weg, dus hij is zelfs kleiner. Daarom is het verstandig om die grote bestanden, als ze niet zo veel waard zijn, uit te sluiten van de backup.

In het ergste geval wordt de grote backup pas bij de 20e rotatie verwijderd.

Als die bestanden echt zo groot zijn, kun je overwegen extra alert te zijn bij de initiële backup. Die zal tenslotte alle bestanden bevatten, en zover ik weet, blijven die altijd in die set staan.

- dag 1: grote file geplaatst, meegenomen in backup

- dag 2: grote file verwijderd

- dag 3: daily business

- dag 4: daily business

- dag 5: daily business

- dag 6: daily business

- dag ...

- dag 21: de grote file die op dag 2 is verwijderd op disk wordt daadwerkelijk verwijderd in de backup set.

Bijna.smeerbartje schreef op donderdag 18 juli 2019 @ 10:00:

[...]

Ah oke.. dus ik begrijp goed dat na 20x een bakcup maken, dat DAN de verwijderde files wel worden verwijderd? Dus:

Op dag 0 maak je een initële backup, waar die grote files wel of niet in zitten. Deze backup blijft bestaan.

Als de locatie van de grote files in de definitie van de backup-set zit, dan wordt die file inderdaad op dag 1 meegenomen. Op dag 2 bevindt die file zich niet meer op die locatie, en de wijziging (file is er niet) gaat mee in de incrementele backup van dag 2. De backup van dag 1, inclusief grote file blijft bestaan.

Het rotatiemchanisme bepaalt op grond van de criteria die ik eerder postte welke backups worden verwijderd. Waarschijnlijk inderdaad op dag 21 wordt de set van dag 1 verwijderd, waardoor ook die grote file niet meer te herstellen is.

DAzN schreef op donderdag 18 juli 2019 @ 11:03:

[...]

Bijna.

Op dag 0 maak je een initële backup, waar die grote files wel of niet in zitten. Deze backup blijft bestaan.

Als de locatie van de grote files in de definitie van de backup-set zit, dan wordt die file inderdaad op dag 1 meegenomen. Op dag 2 bevindt die file zich niet meer op die locatie, en de wijziging (file is er niet) gaat mee in de incrementele backup van dag 2. De backup van dag 1, inclusief grote file blijft bestaan.

Het rotatiemchanisme bepaalt op grond van de criteria die ik eerder postte welke backups worden verwijderd. Waarschijnlijk inderdaad op dag 21 wordt de set van dag 1 verwijderd, waardoor ook die grote file niet meer te herstellen is.

smeerbartje schreef op donderdag 18 juli 2019 @ 09:04:

Hey ik heb een vraag over Synology hyperbackup.

In de documentatie kan ik hier eigenlijk niets over vinden, vandaar dat ik het hier maar even vraag. Onder rotation settings heb ik "smart recycle" aangezet. Tevens het aantal versies op 20.

Of gewoon even 20x de backup runnen.smeerbartje schreef op donderdag 18 juli 2019 @ 09:18:

[..] Is het mogelijk om een soort van "purge deleted files"-actie uit te voeren op de backup set? Zo niet, dan moet ik inderdaad deze "vluchtige" directory excluden van de backup set.

Delidded 4770K 4.7GHz @ H220 || Gigabyte Z87X-UD4H || 16GB @ 2400MHz || Gigabyte GTX 760 || 2x128GB Samsung 830 @ RAID-0 & WD 3 TB || Iiyama XB2483HSU-B1 || Synology DS916+ 3x6TB + 120GB SSD Cache || Synology DS213+ 6TB backup

Thuis

4-bay NAS met 3 schijven in SHR

Offsite 1

Een offsite backup op een 2 bay NAS die 30 km verderop bij mijn ouders staat. Vice versa loopt er een backup van hun NAS op de mijne mee. Om dubbelingen te voorkomen, worden de backup bestanden natuurlijk uitgesloten van synchronisatie.

Inrichten was voor mij als semi-leek nog wel een gepuzzel. Uiteindelijk voor elkaar gekregen met Hyperbackup:

- 3x per week

- Port forwards op de routers ingesteld naar alternatieve poorten (niet op 6281) met restrictie op inkomende IP adressen

- Op beide NASsen aparte user-accounts ingesteld voor backup

- Backup rotation; Smart Recycle met 64 versies

Cloudbackup via iDrive.com. Die zal ik binnenkort nog eens goed evalueren. Mogelijk zijn er interessantere opties. Bij voorkeur via Hyperbackup.

Resumé:

NAS-1

DS414 met 3 schijven in SHR

Onsite (staat bij mij thuis)

Wordt via Hyperbackup gebackupd naar Volume 2 van NAS-2 (offsite). Hyperbackup Vault, waarin de backup van mijn ouders staat, wordt uiteraard uitgesloten van backup.

NAS-2

- DS215j met 2 schijven (2 volumes)

- Offsite (staat bij mijn ouders)

- PC van mijn ouders synchroniseert via Cloud Station Backup met Volume 1 van deze NAS. Zodat mijn ouders in principe niks met de NAS hoeven doen

- Volume 1 wordt via Hyperbackup gebackupd naar NAS-1

[ Voor 25% gewijzigd door Joris748 op 22-08-2019 11:57 ]

The choice is simple – do you do it in this life, or the next? In case of the former, why wait?

Heb nu een externe 10TB schijf aan m'n DS414 gehangen om daar versioned backups met Hyper Backup op op te slaan. Echter haal ik, uncompressed en unencrypted, maar 30-35MB/s aan snelheid. De CPU draait tegen 100%.

Misschien moet ik dan toch maar voor m'n alternatief plan gaan en een 2e NAS aanschaffen, waarbij ik de nieuwe, snellere NAS als primaire zou gaan gebruiken (met de 10TB uit de WD My Book erin) en de DS414 als target dmv Hyper Backup Vault.

Dat plan heeft echter geen zin als Vault evenveel CPU power nodig heeft...

Ik backup van mijn DS414 naar een offsite DS215j. Het data verkeer is encrypted.Buzz_Fuzz schreef op maandag 29 juli 2019 @ 13:29:

Heeft iemand een idee in hoeverre Hyper Backup Vault CPU power nodig heeft in vergelijking met Hyper Backup zelf?

Heb nu een externe 10TB schijf aan m'n DS414 gehangen om daar versioned backups met Hyper Backup op op te slaan. Echter haal ik, uncompressed en unencrypted, maar 30-35MB/s aan snelheid. De CPU draait tegen 100%.

Misschien moet ik dan toch maar voor m'n alternatief plan gaan en een 2e NAS aanschaffen, waarbij ik de nieuwe, snellere NAS als primaire zou gaan gebruiken (met de 10TB uit de WD My Book erin) en de DS414 als target dmv Hyper Backup Vault.

Dat plan heeft echter geen zin als Vault evenveel CPU power nodig heeft...

In de praktijk draait de DS414 op ca 70% en DS215j op ca 80-90% CPU tijdens een backup. Omdat de backup incrementeel is, draait hij bij mij hooguit 15 tot 30 minuten per run. Ik ga er niet bij staan wachten tot hij klaar is

The choice is simple – do you do it in this life, or the next? In case of the former, why wait?

Had zelf ook vergelijkbare issues met een zeer trage Hyper Backup naar een USB 3 schijf.Buzz_Fuzz schreef op maandag 29 juli 2019 @ 13:29:

Heeft iemand een idee in hoeverre Hyper Backup Vault CPU power nodig heeft in vergelijking met Hyper Backup zelf?

Heb nu een externe 10TB schijf aan m'n DS414 gehangen om daar versioned backups met Hyper Backup op op te slaan. Echter haal ik, uncompressed en unencrypted, maar 30-35MB/s aan snelheid. De CPU draait tegen 100%.

Misschien moet ik dan toch maar voor m'n alternatief plan gaan en een 2e NAS aanschaffen, waarbij ik de nieuwe, snellere NAS als primaire zou gaan gebruiken (met de 10TB uit de WD My Book erin) en de DS414 als target dmv Hyper Backup Vault.

Dat plan heeft echter geen zin als Vault evenveel CPU power nodig heeft...

Bij mijn setup heeft het volgende vinkje de boel flink versneld:

Heb al enige tijd wat issues met de 'Data scrub' van het BTRFS filesystem van mijn volume, deze stopt op onverklaarbare redenen, geen logging te vinden waarom.

Toch maar even een case aangemaakt bij Synology. Zij hebben meegekeken, volume dismountend en vermoeden een probleem in de schijven en/of stroomverlies (standaard antwoord?). Disken zijn gewoon groen, RAID check is goed idem met SMART. NAS hangt sinds het begin aan een UPS. De oplossing zie zij boden is 'even' Volume1 verwijderen en opnieuw aanmaken. Ofwel de NAS leegtrekken en opnieuw inspoelen.

Nou draait er dagelijks een backup naar USB maar dit is enkel voor de documenten, is er een manier of tips om met zo min mogelijk gedoe (lees Docker en Sonarr restore) dit uit te voeren? Online kom ik niet veel verder dan Hyper Backup gebruiken en dan 'even' terug zetten. Leuk voor files maar daar red ik m'n gehele config niet mee. Gezien ik bijna zeker ben dat de DSM config restore niet veel meer gaat doen dan de standaard account dingetjes.

if (!coffee) {

Work = false; }

hoelang gaat een 211 mee? en harde schijven wd20EARS?

ik zit net ff te kijken en hij draait al nonstop sinds 2011. :-O

zit een beetje rond te kijken en een 218play met 2x6tb of 8tb schiet lekker op

nass 227,-

6tb (2x) 380,- wd reds

8 tb (2x) 470 - wd reds

dus even upgraden en vernieuwen is eh 700 euro.

Zou een pricewatch: Seagate Backup Plus Hub 8TB Zwart ook een optie kunnen zijn om een fail-safe in te bouwen?

Scheelt een berg geld en als mn nass ooit poef zegt kan ik altijd nog upgraden.

De HUB 8Tb prik ik achterin in de nass in usb 2, schuif alles over wat ik niet kwijt wil (desnoods een kopie van de 4tb) en laat die ook 24/7 aan. (hebben die externe hdd's eigenlijk een sleepmode?)

(ik heb nog wat oudjes 256Gb/500GB met extra backup maar die zijn ook erg op leeftijd dus als backup misschien niet betrouwbaar meer.)

Edit: mn 1Tb vd pc word via cloud gebackupped

nass staat al niet meer in raid 0? dus 4tb en 2,5Tb aan de usb's vandaar die 6 of 8.

Alvast bedankt

[ Voor 6% gewijzigd door copykat op 06-08-2019 13:59 ]

Werken is best leuk maar er gaat zoveel vrijetijd in zitten dat mn hobby's onder druk komen. Kan niet wachten om van mn werk mn hobby te maken.....

Je bedoelt als alternatief voor een NAS met twee schijven in RAID 1?copykat schreef op maandag 5 augustus 2019 @ 20:44:

Zou een pricewatch: Seagate Backup Plus Hub 8TB Zwart ook een optie kunnen zijn om een fail-safe in te bouwen?

Nee ik zocht een "goedkopere" tussen oplossing om een extra backup te maken van mn huidige opslag capaciteit. Mn 8 jaar oude ds211 met 4tb en 2tb extern via nass usb, en mn data op interne schijf splitsen tussen backup via cloud en gewoon externe schijf.

De 218play kost inclusief 6TB (redwd 2x 6TB) 700euro en die zal er vast een keer moeten komen als mn 211 poef zegt.

Ik heb de hub 8TB gekocht en de "bijgeleverde backup software" is erg rudimentair dus ik kan niet even snel de mappen handmatig aanwijzen die ik wil backuppen. (ik zou dan 1/mnd een increment laten draaien)

Doe het nu gewoon handmatig met folder plus backup date.

Ik heb een actieve externe opslag folder gemaakt voor opruimen D schijf en een nass backup voor failsafe data op de nass.

En moet nu nog even uitzoek of ik via usb3 vd pc kan werken met een backup applicatie vd nass zodat indien de pc aanstaat er een incremental kan draaien op usb3.0. ( de nass kan via zijn eigen usb2 wel via vault backuppen maar ik las dat dat erg traag is en de cpu vd nass belast. die heeft t al moeilijk op zn oude leeftijd.. ;-) )

Werken is best leuk maar er gaat zoveel vrijetijd in zitten dat mn hobby's onder druk komen. Kan niet wachten om van mn werk mn hobby te maken.....

Ik begrijp eerlijk gezegd niet waarom Synology alles bouwt op BTRFS. RedHat is zelfs gestaakt met de ontwikkeling ervan en het is ook de reden dat ik altijd nog ouderwets voor ext4 volumes kies.naaitsab schreef op maandag 5 augustus 2019 @ 17:50:

[...]

Heb al enige tijd wat issues met de 'Data scrub' van het BTRFS filesystem van mijn volume, deze stopt op onverklaarbare redenen, geen logging te vinden waarom.

Toch maar even een case aangemaakt bij Synology.

BTRFS is nooit geworden wat het zou moeten zijn, namelijk een stabiel, betrouwbaar en gratis alternatief voor ZFS.

Ask yourself if you are happy and then you cease to be.

@copykat Da's een mooie leeftijd, ik heb niets dat ouder is dan dat, maar als je SMART data er ok uit ziet, zou ik niet gaan vernieuwen om te vernieuwen, tenzij je toch ruimte te kort begint te krijgen.

Het aanschaffen van die externe HDD als een fail-safe als je die nog niet had, is wel een goed idee.

Ik heb zelf vorige week m'n infrastructuur eens onder handen genomen en dat heeft me inderdaad wel wat gekost, maar als ik je een tip mag geven: koop 8-10TB WD Elements of MyBooks. Die zijn een stuk goedkoper dan losse interne WD Red schijven, maar bevatten eigenlijk dezelfde schijven. Zo heb ik 4x8TB WD Elements gekocht voor 150€/st op amazon.fr, terwijl "echte" WD Red schijven voor +-250€ over de toonbank gaan... (Hou de prijzen wat in de gaten, op amazon kan het nogal schommelen; momenteel staan ze bv terug aan 195€ ipv 150...)

Momenteel draaien die 4 schijven plus nog een 5e 8TB uit een oudere MyBook succesvol in 2 NAS'en.

Er zijn wel addertjes onder het gras, zoals TLER die af zou staan op deze schijven terwijl dit nefast zou zijn in een RAID setup, maar voor m'n secundaire backup-nas (m'n oude DS414) heb ik besloten geen RAID meer toe te passen en losse volumes te gebruiken. Daarnaast meen ik dat TLER in de Synology's irrelevant is owv hun mdraid implementatie.

Een tweede addertje is dat deze schijven (iig vwb de 8 en 10TB's) niet altijd zomaar zullen werken in PC's met oudere voedingen. Er zijn echter simpele workarounds voor zoals bv de eerste 3 pinnen van de sata power-connector aftapen (google "3.3v issue"). Voor de meeste Synology toestellen is dit echter ook irrelevant en werken de schijven zonder meer.

M'n huidige setup is nu:

PC (dataset1) -> DS418Play, hourly via Bvckup2

DS418Play (dataset1) -> DS414, nightly via Hyperbackup met versioning

PC (ssdimages) -> DS418Play, monthly via Macrium Reflect

DS418Play (ssdimages) -> DS414, monthly via Hyperbackup zonder versioning

DS418Play (dataset2) -> DS414, nightly via Hyperbackup zonder versioning

+-alles -> 10TB MyBook, manueel 2x per jaar via Bvckup2 & Veracrypt, off-site bewaard.

De Diskstations hebben 30-dagen prullenbak enabled. De DS418Play draait in RAID5, de DS414 heeft gwn 1 volume per schijf. Daarnaast heb ik dankzij BTRFS op de DS418Play snapshots enabled, tot 1 maand terug.

Overkill: mehbeh, maar atm heb ik toch plaats over... De 6TB schijven waren /TB duurder en ik vond online ook meer succesverhalen terug over het "shucken" van de 8TB versies.

Zal eens kijken naar de smartdata, was ff zoeken waar dat zit on de nass. Beide zijn groen geen fouten.alleen snelle test moet ik een uitgebreide test doen?Buzz_Fuzz schreef op maandag 12 augustus 2019 @ 16:08:

@copykat Da's een mooie leeftijd, ik heb niets dat ouder is dan dat, maar als je SMART data er ok uit ziet, zou ik niet gaan vernieuwen om te vernieuwen, tenzij je toch ruimte te kort begint te krijgen.

Het aanschaffen van die externe HDD als een fail-safe als je die nog niet had, is wel een goed idee.

Dat is nieuw voor me, ik dacht dat "nass" schijven aparte diskdrive , lagers en headmotors hadden voor langere levensduur. Maar als ze de zelfde zijn inderdaad, ontmantel een externe diskdrive , verkoop de behuizing en hop 100 euro verdient. (hebben ze ook de zelfde RPM en Cache?)Buzz_Fuzz schreef op maandag 12 augustus 2019 @ 16:08:

....maar als ik je een tip mag geven: koop 8-10TB WD Elements of MyBooks. Die zijn een stuk goedkoper dan losse interne WD Red schijven, maar bevatten eigenlijk dezelfde schijven. .....

Capaciteits probleem? eh ja beetje, zitten nu continu twee externe 3,5" aan de usb te lurken en raid is nu gewoon twee volumes.Buzz_Fuzz schreef op maandag 12 augustus 2019 @ 16:08:

Er zijn wel addertjes onder het gras, zoals TLER die af zou staan op deze schijven terwijl dit nefast zou zijn in een RAID setup, maar voor m'n secundaire backup-nas (m'n oude DS414) heb ik besloten geen RAID meer toe te passen en losse volumes te gebruiken. Daarnaast meen ik dat TLER in de Synology's irrelevant is owv hun mdraid implementatie.

Voor de meeste Synology toestellen is dit echter ook irrelevant en werken de schijven zonder meer.

TLER en NEFAST? eh wat betekend dat?

Ik heb voor de korte termijn nu een manual backup gemaakt op die externe 8TB schijf. (is nog bezig duurt best lang 7TB

Is Bitlocker een goed idee voor beveiliging wachtwoord enz van mijn externe schijf?

Hoe zou ik een manual incremental backup systeem kunnen draaien via usb poort van pc? (dus elke keer een check voor nieuwe status source (nass schijven) en dan op mn externe een kopie. Dus nieuw toevoegen en verwijderd ook verwijderen. MIRROR zegmaar? Seagate heeft niks van dien aard.

Als ik jou set up zie zou ik dus een nieuwe nass "moeten" kopen en 2 8TB externe WB elements voor doner te spelen met de schijven. Deze als nieuwe nass gebruiken als prime mediaserver/home-streamhost en databackup en de oude als extra backup voor mijn persoonlijke data en pc/laptopschijven?

Crashed de oude qua schijven gewoon nieuwe schijven klaar. (electronica nass body is ook 8 jaar...hoelang nog? synology service geeft geen zinnig antwoord

Mijn pc data schijf wordt geback-upped naar de cloud.maar voor mijn C schijf SSD is nu geen active backup alleen een schone instal backup. (zou nog een present kunnen maken.)

Werken is best leuk maar er gaat zoveel vrijetijd in zitten dat mn hobby's onder druk komen. Kan niet wachten om van mn werk mn hobby te maken.....

WD Reds zijn eigenlijk gewoon Greens (nu Blues?) met aangepaste firmware. Iemand mag mij corrigeren, maar er is volgens mij geen sprake van verschillende bearings of motoren. Enkel de Blacks draaien sneller, de Reds hebben TLER enabled, en garantietermijnen verschillen, denk ik, that's about it.copykat schreef op maandag 12 augustus 2019 @ 19:17:

[...]

Dat is nieuw voor me, ik dacht dat "nass" schijven aparte diskdrive , lagers en headmotors hadden voor langere levensduur. Maar als ze de zelfde zijn inderdaad, ontmantel een externe diskdrive , verkoop de behuizing en hop 100 euro verdient. (hebben ze ook de zelfde RPM en Cache?)

(Dan heb je bv nog Purples, wat eigenlijk ook gewoon Greens en dus Reds zijn, maar "designed for 24/7 writes in surveillance systems"... De meningen over de effectieve meerwaarde daarvan verschillen afhankelijk van welke bocht je op the interwebz neemt...)

Anyway, uit alles wat ik online vind, zijn de white-label schijven in de 8 en 10TB MyBooks en Elements identiek aan Red schijven, (die dan eigenlijk weer HGST Ultrastars zijn), maar dan soms met TLER af en soms met verschillende cache. Dat laatste lijkt af te hangen van het land van productie, 128 vs 256MB, maar dat verschil heb je ook bij "echte" Reds, bv WD80EFZX vs WD80EFAX. Echter ga je imho van dat verschil in een NAS die gewoon als storage & backup dienst doet niets merken.

Hoe het zit met de 6TB schijven, kan ik niet zeggen.

Je kan veel terugvinden op https://www.reddit.com/r/DataHoarder/ & https://www.reddit.com/r/8tbEasystore/

Zoek eens op wat productnamen en nummers. Bv op WD80EMAZ, dat zijn diegene die in mijn Elements te vinden waren. Die schijnen ook gewoon TLER enabled te hebben.

WD80EZZX zat in m'n MyBook.

WD100EZAZ zit nog in m'n andere MyBook.

Amazon is hier vaak het goedkoopst, maar hou de prijzen een tijdje in de gaten en vergelijk bv .de met .fr. Prijzen van de 8TB Elements & MyBooks lopen atm uiteen van 156 tot 195€. De 10TB van 212 tot 266€. De 6TB van 130 tot 156€. Vorige maand stonden de 8's zelfs even aan 139€.

TLER, Time Limited Error Recovery, zorgt ervoor dat de schijf bij moeilijkheden bij het lezen er sneller de brui aan geeft. In een RAID is dit positief omdat de array dan sneller diezelfde data die verspreid staat over de andere schijven kan ophalen. Dit schijnt echter enkel zo te zijn bij gebruik van hardware-RAID. Synology gebruikt software-RAID en heeft zelf al meegedeeld dat zij niets met TLER doen.copykat schreef op maandag 12 augustus 2019 @ 19:17:

[...]

TLER en NEFAST? eh wat betekend dat?

Is Bitlocker een goed idee voor beveiliging wachtwoord enz van mijn externe schijf?

In een non-raid setup, dus bv een gewone desktop environment waar de meesten Green/Blue/Black in steken, wil je juist dat de schijf zo lang mogelijk blijft proberen. TLER off.

En nefast betekent gewoon ongunstig

Geen ervaring met Bitlocker, ik heb Veracrypt gebruikt voor m'n externe.

Een uitgebreide smarttest zal de schijf testen op slechte sectoren. Kan je doen, maar duurde in mijn geval voor een 8TB schijf via WD Data Lifeguard 14u ...copykat schreef op maandag 12 augustus 2019 @ 19:17:

[...]

Zal eens kijken naar de smartdata, was ff zoeken waar dat zit on de nass. Beide zijn groen geen fouten.alleen snelle test moet ik een uitgebreide test doen?

De snelle test duurt enkele minuten. Geen idee wat die precies doet.

Het uitlezen van de smart-data zelf is eigenlijk ogenblikkelijk en in eerste instantie wil je dat doen. Als die geen red flags geeft, zou ik de schijven niet gaan trashen met een extended test. Als je maar backups hebt...

(Wat je wel wil doen, is die eventuele externe schijven eerst extended testen in hun behuizing zodat je die desnoods nog gewoon intact kan terugsturen naar de winkel.)

En ik loop hier wss al ver vooruit op de zaken, maar mss toch nog een heads-up: bij de MyBooks, maar mss ook bij de Elements, don't know, wordt de data door de controller van de externe behuizing geëncrypteerd. Als je de schijf daarna uit de behuizing haalt, zal die data niet meer te lezen zijn in een PC of ander dock bv. Formatteren is het enige dat je dan nog rest.

Sync-tooltjes genoeg hiervoor, maar ik ben grote fan van Bvckup2. Vind ik supersnel werken, slick UI, uitgebreide support, ondersteunt o.a. block-level copies zodat bij wijzigingen in 1 file niet telkens de volledige file wordt gekopieerd, delta-snapshots zodat niet telkens de target vanaf 0 moet herscanned worden als die toch nooit extern gewijzigd wordt, device tracking zodat de backup automatisch gaat lopen vanzodra je een specifieke disk aansluit, ...copykat schreef op maandag 12 augustus 2019 @ 19:17:

[...]

Hoe zou ik een manual incremental backup systeem kunnen draaien via usb poort van pc? (dus elke keer een check voor nieuwe status source (nass schijven) en dan op mn externe een kopie. Dus nieuw toevoegen en verwijderd ook verwijderen. MIRROR zegmaar? Seagate heeft niks van dien aard.

Voor Bvckup gebruikte ik Cobian.

Je moet nietscopykat schreef op maandag 12 augustus 2019 @ 19:17:

[...]

Als ik jou set up zie zou ik dus een nieuwe nass "moeten" kopen

(...)

.hoelang nog? synology service geeft geen zinnig antwoord

NAS toestellen zijn trouwens ook populair op de tweedehands markt, dus ik zou daar ook zeker eens kijken. Of zoals ik gedaan heb, een tweedekans-product op coolblue. 60€ goedkoper oid. Niets aan te zien, werkt perfect.

Hier zie je dat de laatste toestellen die nog DSM upgrades ontvangen momenteel de xx11 series zijn (dus de jouwe).

Wat je beschrijft, kan een mogelijke setup zijn, maar da's iets dat je zelf beter kan bepalen. Ook denken aan evt RAID en de ruimte die je daarmee verliest.

(En als je voor BTRFS zou gaan, denk eraan dat je daarmee ook nog eens 5% aan ruimte verliest door metadata-allocatie. Had ik niet op gerekend. 600GB, *poef*...

1 dingetje, de youtube tuto's lieten niet zien of je een al gevulde disk in zijn geheel kan encrypten. (bitlocker kan dit wel en daarna als je niet unmount heb je er geen omkijken naar. (hmm bitlocker is Win10 pro only dus

En is er nog volgorde in encrypten en omzetten naar een backup sync drive?

(bedenk me net als ik er een backupsync van maak dan is de schijf leeg maken vermoedelijk nodig.. week data transfer van 3,5Tb voor niks.....:-S

(ik gebruik Duplicati voor mn cloud backup werkt prima doet encrypten en incremental.)

Vraag me nu af of ik de zelfde kan gebruiken voor nass to Externe usb drive, kan zo snel niks over vinden is volgens mij specifiek voor encrypted cloud backup.)

Bedankt voor al je adviezen. Ga dit maar eens doornemen Edit is een oudje maar ff verder zoeken

[ Voor 8% gewijzigd door copykat op 13-08-2019 17:54 ]

Werken is best leuk maar er gaat zoveel vrijetijd in zitten dat mn hobby's onder druk komen. Kan niet wachten om van mn werk mn hobby te maken.....

Bij veracrypt mount je ook je encrypted disk en dan heb je er ook geen omkijken meer naar. Je schijf verschijnt eerst als unformatted disk waar windows je aan zal herinneren; uiteraard niet gaan formatteren. Na het mounten verschijnt er dan een extra schijf in je verkenner.

Je kan ook een encrypted file-container op een unencrypted schijf plaatsen. Voordeel daarvan is bv dat je die container gewoon kan verhuizen.

Permanent die schijf/partitie mounted aan je PC laten hangen, zou ik trouwens afraden. Een cryptolocker heeft zo al je encrypted files via de veracrypt mount ook mee...

Hetzelfde igv veracrypt file containers. Die mag dan zelf nog unmounted zijn, als je partitie waarop die zich bevindt gemount is, ben je alsnog alles kwijt.

Een gevulde disk encrypten (in-place encryption) is ook mogelijk, naar het schijnt, maar of dat sneller is dan format/encrypt/recopy betwijfel ik. In-place encryption moet read/encrypt/write gaan doen binnen dezelfde disk, en tenzij het om een SSD gaat, ben je wss toch beter af alles van de andere schijf opnieuw te kopieren.

Ik denk dat Duplicati via custom packages ook op Synology kan draaien, maar ik heb er geen ervaring mee.

Ik heb Duplicati een tijd terug enkel vanaf PC ff gebruikt, maar vond het niet stabiel of gebruiksvriendelijk werken.

kies nu tussen FreeFileSync en Freebackup V8 andere thread gemaakt voor de backupfiles tools Weet nog niet welke vd twee nou t makkelijkste werkt ff inlezen welke functies ik nu gebruiken ga en hoe.Buzz_Fuzz schreef op vrijdag 16 augustus 2019 @ 12:11:

Die link is redelijk oud ja. Bvckup2 is al lang uit beta en ook niet meer gratis

unencrypted schijf is inderdaad ook goed zie je gewoon op verkenner zonder "format question" en de backup container alleen encrypten. Goed idee.Bij veracrypt mount je ook je encrypted disk en dan heb je er ook geen omkijken meer naar. Je schijf verschijnt eerst als unformatted disk waar windows je aan zal herinneren; uiteraard niet gaan formatteren. Na het mounten verschijnt er dan een extra schijf in je verkenner.

Je kan ook een encrypted file-container op een unencrypted schijf plaatsen. Voordeel daarvan is bv dat je die container gewoon kan verhuizen.

Daar heb ik niet aan gedacht, goed dat je het zegt.Permanent die schijf/partitie mounted aan je PC laten hangen, zou ik trouwens afraden. Een cryptolocker heeft zo al je encrypted files via de veracrypt mount ook mee...

hmm , ok geld dit ook voor Duplicatie in de cloud?Hetzelfde igv veracrypt file containers. Die mag dan zelf nog unmounted zijn, als je partitie waarop die zich bevindt gemount is, ben je alsnog alles kwijt.

Duplicatie is bj mij nu door cloudspace gebrek aan het muiten, voor de rest liep het wel stabiel.Een gevulde disk encrypten (in-place encryption) is ook mogelijk, naar het schijnt, maar of dat sneller is dan format/encrypt/recopy betwijfel ik. In-place encryption moet read/encrypt/write gaan doen binnen dezelfde disk, en tenzij het om een SSD gaat, ben je wss toch beter af alles van de andere schijf opnieuw te kopieren.

Ik denk dat Duplicati via custom packages ook op Synology kan draaien, maar ik heb er geen ervaring mee.

Ik heb Duplicati een tijd terug enkel vanaf PC ff gebruikt, maar vond het niet stabiel of gebruiksvriendelijk werken.

conclusie:

kopieer werk van 4tb voor "niks" gedaan schijf stresstest

1 Backup-folder nass en backup pc folder aanmaken voor encryptie met Veracrypt

2 Veracrypt installeren en externe schijf de folder aanwijzen voor encryptie.

3 FreeFileSync of Syncbackfree v8 installeren script/ setup maken voor source mirror naar de encrypted folder. (als ik het goed begrijp encrypt Veracrypt automatisch de toegevoegde data als FFS of SBF dit er naar toe kopieert)

3 (stap gewijs kopieren van 6TB door FFS of SBF (beide of eentje kon profielen toevoegen elke keer wat in stukjes kopieren helpt te controleren.)

4 na volledige sync, schijf loskoppelen/ voeding uitschakelen en 1/mnd syncen. en weer loskoppelen.

1 ding moet ik nog uitzoeken: kan je twee gelijk genaamde folder van verschillende locaties zonder problemen laten mirroren (de source delete veroorzaakt ook een delete bij backup) naar 1 gelijk genaamde folder?

Ik ben namelijk bang dat wat in de ene folder staat gezien word als deleted ten opzichte van de andere folder. waardoor beide links elkaars backup deleten.

Dus f:- clips en d-clips mirror naar backup-clips?

Maakt de backup wat overzichtelijker.

[ Voor 6% gewijzigd door copykat op 17-08-2019 10:18 ]

Werken is best leuk maar er gaat zoveel vrijetijd in zitten dat mn hobby's onder druk komen. Kan niet wachten om van mn werk mn hobby te maken.....

Hier uiteindelijk het hele volume moeten verwijderen (volume1) en weer terug naar EXT4. Zeer kwalijk dat ze standaard iets aanbieden/selecteren wat ze A niet (kunnen) supporten en B nog steeds niet solide is en waarschijnlijk ook nooit gaat worden. Jammer dat je hier achter komt als het nat gaat. Zet dat dan gewoon bij de keuze tussen BTRFS en EXT4 bij het aanmaken van je eerste volume.Lethalis schreef op zaterdag 10 augustus 2019 @ 14:54:

[...]

Ik begrijp eerlijk gezegd niet waarom Synology alles bouwt op BTRFS. RedHat is zelfs gestaakt met de ontwikkeling ervan en het is ook de reden dat ik altijd nog ouderwets voor ext4 volumes kies.

BTRFS is nooit geworden wat het zou moeten zijn, namelijk een stabiel, betrouwbaar en gratis alternatief voor ZFS.

BTRFS is op papier mooi maar als er wat met je volume is dan ben je gewoon de sjaak. Een van de grote problemen van dit filesystem. Voor mij reden genoeg om de voordelen te laten voor wat ze zijn en terug te gaan naar een robuust filesystem. Na dit 'geintje' wat me een weekend heeft gekost ben ik er wel van genezen.

if (!coffee) {

Work = false; }

Duplicati doet versiebeheer, dacht ik(?) dus je kan altijd teruggaan, maar als diezelfde cloud folder ook als sync op je pc staat, mag je opnieuw naar je data fluiten, tenzij de cloud provider zelf ook nog eens aan versiebeheer doet. (Imho wordt het dan wel een hoop miserie om alles gerestored te krijgen.)copykat schreef op vrijdag 16 augustus 2019 @ 21:45:

[...]

hmm , ok geld dit ook voor Duplicatie in de cloud?

Ja, je opent veracrypt, je selecteert het device/partitie of de filecontainer die je wil openen, geeft je wachtwoord/key in en er zal een nieuwe schijf met bijhorende schijfletter in je verkenner verschijnen (je kiest die zelf). Alle verkeer via die schijfletter wordt automatisch encrypted/decrypted.copykat schreef op vrijdag 16 augustus 2019 @ 21:45:

[...]

(als ik het goed begrijp encrypt Veracrypt automatisch de toegevoegde data als FFS of SBF dit er naar toe kopieert)

Test je best eerst uit dan, met je gekozen tool.copykat schreef op vrijdag 16 augustus 2019 @ 21:45:

[...]

kan je twee gelijk genaamde folder van verschillende locaties zonder problemen laten mirroren (de source delete veroorzaakt ook een delete bij backup) naar 1 gelijk genaamde folder?

Ik ben namelijk bang dat wat in de ene folder staat gezien word als deleted ten opzichte van de andere folder. waardoor beide links elkaars backup deleten.

Je beschrijft niet exact hoe je sources eruit zien (verschillende devices?), maar iig, vwb Bvckup2, die vereist exclusieve toegang in de target folder, dus 1 target folder per sync-taak, waarbij een sync-taak uiteraard verschillende sources kan bevatten. Je kan geen 2e groep source-mappen laten syncen naar dezelfde target folder.

Dus in jouw geval kan je bv 2 taken opzetten.

/exthdd/folder/ => /backup/exthdd/

/nas/folder/ => /backup/nas/

Waarbij alles onder elke source folder onafhankelijk van elkaar in de overeenkomstige target folder wordt gerepliceerd.

Daarenboven kan je in veel synctools aangeven dat de exacte source directorystructuur moet gerepliceerd worden. Dus zelfs al gaat het bv om folders op eenzelfde device die je liever allemaal in 1 job steekt, dan krijg je bv

/my => /backup, met daaronder dan bv my/first/folder, my/second/folder, ...

De 2 zitten elkaar nooit in de weg, zolang je de tool maar goed opzet...

Wat jij denk ik beschrijft, is:

/my/first/folder => /backup

/my/second/folder => /backup

Dat is inderdaad om problemen vragen, tenzij je dus kan aangeven dat de volledige directorystructuur moet gespiegeld worden in /backup.

[ Voor 4% gewijzigd door Buzz_Fuzz op 17-08-2019 14:23 ]

Nee ik gebruik die transip sync folder niet. (wel geinstalleerd maar leeg.)Buzz_Fuzz schreef op zaterdag 17 augustus 2019 @ 14:17:

[...]

Duplicati doet versiebeheer, dacht ik(?) dus je kan altijd teruggaan, maar als diezelfde cloud folder ook als sync op je pc staat, mag je opnieuw naar je data fluiten, tenzij de cloud provider zelf ook nog eens aan versiebeheer doet. (Imho wordt het dan wel een hoop miserie om alles gerestored te krijgen.)

ik heb duplicatie in een aparte folder laten uploaden met versionering.

Zag wel dat je het volume meteen moet vastleggen. bijv: 2TB wat Veracrypt meteen "volschrijft".[...]

Ja, je opent veracrypt, je selecteert het device/partitie of de filecontainer die je wil openen, geeft je wachtwoord/key in en er zal een nieuwe schijf met bijhorende schijfletter in je verkenner verschijnen (je kiest die zelf). Alle verkeer via die schijfletter wordt automatisch encrypted/decrypted.

[...]

maakt het nog uit of de schijf in de pc of in de nass gemount wordt?

ik heb op twee plekken een folder "video" en bijv. "01 documentaires" daarin met verschillende inhoud. ik dacht die in de "mirror" folder gewoon samen te voegen. zodat er video-> 01 documentaires maar 1 keer voorkomt.Test je best eerst uit dan, met je gekozen tool.

Je beschrijft niet exact hoe je sources eruit zien (verschillende devices?), maar iig, vwb Bvckup2, die vereist exclusieve toegang in de target folder, dus 1 target folder per sync-taak, waarbij een sync-taak uiteraard verschillende sources kan bevatten. Je kan geen 2e groep source-mappen laten syncen naar dezelfde target folder.

En erg bedankt voor al je tijd, je helpt erg goed voor mijn beeldvorming te maken wat ik denk te willen en wat ik echt wil. (vooral het zo simpel en effectief mogelijk maken duurt effe als je er nooit mee van doen hebt gehad.)Dus in jouw geval kan je bv 2 taken opzetten.

/exthdd/folder/ => /backup/exthdd/

/nas/folder/ => /backup/nas/

Waarbij alles onder elke source folder onafhankelijk van elkaar in de overeenkomstige target folder wordt gerepliceerd.

Daarenboven kan je in veel synctools aangeven dat de exacte source directorystructuur moet gerepliceerd worden. Dus zelfs al gaat het bv om folders op eenzelfde device die je liever allemaal in 1 job steekt, dan krijg je bv

/my => /backup, met daaronder dan bv my/first/folder, my/second/folder, ...

De 2 zitten elkaar nooit in de weg, zolang je de tool maar goed opzet...

Wat jij denk ik beschrijft, is:

/my/first/folder => /backup

/my/second/folder => /backup

Dat is inderdaad om problemen vragen, tenzij je dus kan aangeven dat de volledige directorystructuur moet gespiegeld worden in /backup.

Ik denk dat ik 1 nass usb externe disk leeg maak en gebruik voor een system backup van win10 documentbackup zelf (1.250Tb max) via pc usb en dan los koppelen en veilig voor ransomware of fatal systemcrash.

(dit is mijn never returnable data by loss failsafe.)

De 8TB opsplits in 4TB expansion vd nass en 4Tb nass mirror. hangend aan de usb2.0 vd nass.

nass is echt een mediaserver dus weg is pech maar minder erg. (niet fijn maar geen home video's en foto's van je kinderen en familie die niet ergens anders ook staan.) heb ik een "died on the job" vd nass, nieuwe kopen terug kopieren en door...

Op deze manier heb ik én failsafe voor de nass én extra opslag via nass bereikbaar. én wat schijven over voor loskoppelen na backup. (die nu aan mn nass hangen ;-) )

Hyperbackup schijnt 1:1 backup te kunnen vd nass naar usb maar of er files verwijderd worden bij een volgende run om een 1:1 te behouden weet ik niet. hyperbackup kan mijn mirror taak doen voor de nass schijven.(ook voor deandere usb schijf hoop ik)

(scheelt pc aan houden bij een mirror taak)

gebruik ik de veracrypt voor mn system backup en FreeFilesync voor gelijkhouden van mn homevideo's en foto's tussen pc Data en nass.

Werken is best leuk maar er gaat zoveel vrijetijd in zitten dat mn hobby's onder druk komen. Kan niet wachten om van mn werk mn hobby te maken.....

Klopt, bij encrypted file-containers moet je de gewenste size opgeven waarna hij die gaat initialiseren met random data. (Wss kan je die size wel vergroten achteraf, maar ben het niet zeker.) Ik encrypt gewoon de volledige schijf zodat ik er genoeg ademruimte heb. De schijf is toch exclusief bedoeld als off-line off-site backup.copykat schreef op zaterdag 17 augustus 2019 @ 15:36:

[...]

Zag wel dat je het volume meteen moet vastleggen. bijv: 2TB wat Veracrypt meteen "volschrijft".

maakt het nog uit of de schijf in de pc of in de nass gemount wordt?

En die encrypted file-container kan je idd plaatsen waar je wil en mounten van waar je wil. Zo begrijp ik het toch. Windows ziet een gewoon bestand. (En een cryptolocker dus ook...)

I see... Da's iig geen standaard use-case voor backup & sync tooltjes...copykat schreef op zaterdag 17 augustus 2019 @ 15:36:

[...]

ik heb op twee plekken een folder "video" en bijv. "01 documentaires" daarin met verschillende inhoud. ik dacht die in de "mirror" folder gewoon samen te voegen. zodat er video-> 01 documentaires maar 1 keer voorkomt.

Als je gewoon puur een sync van docu1 & docu2 naar dezelfde folder wil doen, zie ik idd niet goed in hoe een sync tool, zoals je zelf al vreesde, moet gaan weten wat een delete in 1 van de 2 dan precies betekent. Dat gezegd zijnde, kan je, iig bij Bvckup2, soms wel pre- & post-sync taken opgeven. Mss kan je daarmee zelf een manuele merge-stap in elkaar steken.

Bv, een mirror taak opzetten, maar deletes uitschakelen, iets wat een goede sync tool wel kan aanbieden (one-way sync, keep removals), gevolgd door een script als post-sync taak dat een merge-listing maakt van de 2 source mappen en al het overbodige uit de target map verwijdert.

(Maar dan heb je nog altijd het probleem van verschillende timestamps. Bv de backup en de 2 source mappen bevatten dezelfde file. De backup file dateert van 2017, die in docu1 van 2019 en docu2 van 2018. De sync-taak loopt en doet eerst docu1 dan docu2. De tool zal zien dat docu1 nieuwer is dan de backup en de 2019 versie backuppen. De 2018 versie uit docu2 wordt overgeslaan wegens ouder dan de target. Docu2 zal nooit meer in sync zijn met de backup... Wil je dat, of wil je dat niet, hangt af van je use-case...)

TLDR: ben je niet gewoon beter dat je het probleem bij de bron aanpakt (maken dat er maar 1 source video folder is)?

Np. Probeer vooral zoveel mogelijk te automatiseren. Manuele stappen ga je uiteindelijk toch maar gaan uitstellen/overslaan.copykat schreef op zaterdag 17 augustus 2019 @ 15:36:

[...]

En erg bedankt voor al je tijd, je helpt erg goed voor mijn beeldvorming te maken wat ik denk te willen en wat ik echt wil. (vooral het zo simpel en effectief mogelijk maken duurt effe als je er nooit mee van doen hebt gehad.)

[...]

Wat betreft je "homevideo's en foto's". Je schrijft dat je die zal syncen naar de NAS, en dan vandaar veronderstel ik via Hyperbackup 1:1 (dus de "Local Storage (single version)" optie in Hyperbackup) zal mirroren naar de 4TB externe disk. Als het daarbij blijft, heb je dus wel geen bescherming tegen accidental deletions of cryptolockers...

Was ik al bang voor, vandaar dat ik een alternatieve versie bedacht.Buzz_Fuzz schreef op maandag 19 augustus 2019 @ 13:26:

I see... Da's iig geen standaard use-case voor backup & sync tooltjes...

Als je gewoon puur een sync van docu1 & docu2 naar dezelfde folder wil doen, zie ik idd niet goed in hoe een sync tool, zoals je zelf al vreesde, moet gaan weten wat een delete in 1 van de 2 dan precies betekent.

huidige externe aan nass hangende 2Tb leeg halen(naar 8TB kopieren)

De 2TB 3.5" gebruiken voor een win10 system en data schijf backup (Max 1.222Tb totaal.Dus een extra folder voor data die niet op de pc staat maar wel belangrijk is past ook nog. (500Gb) en dan heb ik 250Gb over voor incrementals van win10 system/documenten backup.

Dan kan de 8TB volledig gebruikt worden als media backup (4Tb nass) en nass uitbreiding.(geen backup maar nieuwe schijf dus relatief veilig voor crashes door hardware)

Hyperbackup kan de nass backup 1:1 voor zijn rekening brengen en is pc onafhankelijk)

(geen beveiliging voor ransomware maar dat geeft niet.)

Gevalletje uitdijende folder of video files tot aan "vol" en ik heb wat aan de usb2's gehangen omdat op te lossen ;-)(......)

TLDR: ben je niet gewoon beter dat je het probleem bij de bron aanpakt (maken dat er maar 1 source video folder is)?