Goed, het heeft even geduurd maar, daar issie!

The road to success is always under construction.

Arnold Palmer

Het teruglopen van het energiegebruik van computers en het oplopen van het vermogen van mooiere voedingen maakt dat er een steeds grotere kloof. Een mooie voeding kun je hier zien als een voeding met een beetje passend vermogen, passief gekoelde voeding, een voeding met een hoge efficiëntie, een voeding met hoge kwaliteit componenten en/of een voeding die modulair is. Zeker de combinatie maakt dat je al snel in het 400W segment terecht komt. Het alternatief, een PicoPSU, is leuk, maar met wat meer schijven al snel ook niet meer interessant. Nog los van dat de bouwkwaliteit toch minder is.

Even voor de beeldvorming. Een veel gebruikte optie is de

pricewatch: Seasonic G-Serie 360Watt . Nog altijd niet modulair. Kwalitatief zit de

pricewatch: Seasonic G-Serie 450Watt dan wat beter. Modulair, betere componenten. Maar ja, hoger vermogen en een hogere prijs.

Nu is deze trent niet iets van het laatste jaar. Maar eindelijk is het zover dat ik er wat aan kon doen. Met veel hulp van mux. Al jaren liep ik met het idee om dan maar meerdere computers op één voeding te draaien. En om meerdere redenen was dat toch problematisch/onhandig. Maar eindelijk was het moment daar! En de kandidaat was mijn server met gevirtualiseerde nas (vt-d, esxi, zfs, ecc, ..).

Zo zien jullie computers er toch ook uit??

Zo zien jullie computers er toch ook uit??

Het hele verhaal achter de combinatie en de uiteindelijke splitsing laat ik achterwege. Maar voor nu volstaat dat ik te maken heb met een Xeon 1220 (voor de server) en vijftal 3.5" schijven (voor de nas). Beide kanten van het verhaal zijn eigenlijk niet handig voor op een PicoPSU. Ze zorgen voor een te hoog piekvermogen. Maar tel het bij elkaar op en een normale (als in niet Qtec achtige voeding) vraagt zich af wie daar kriebelt...

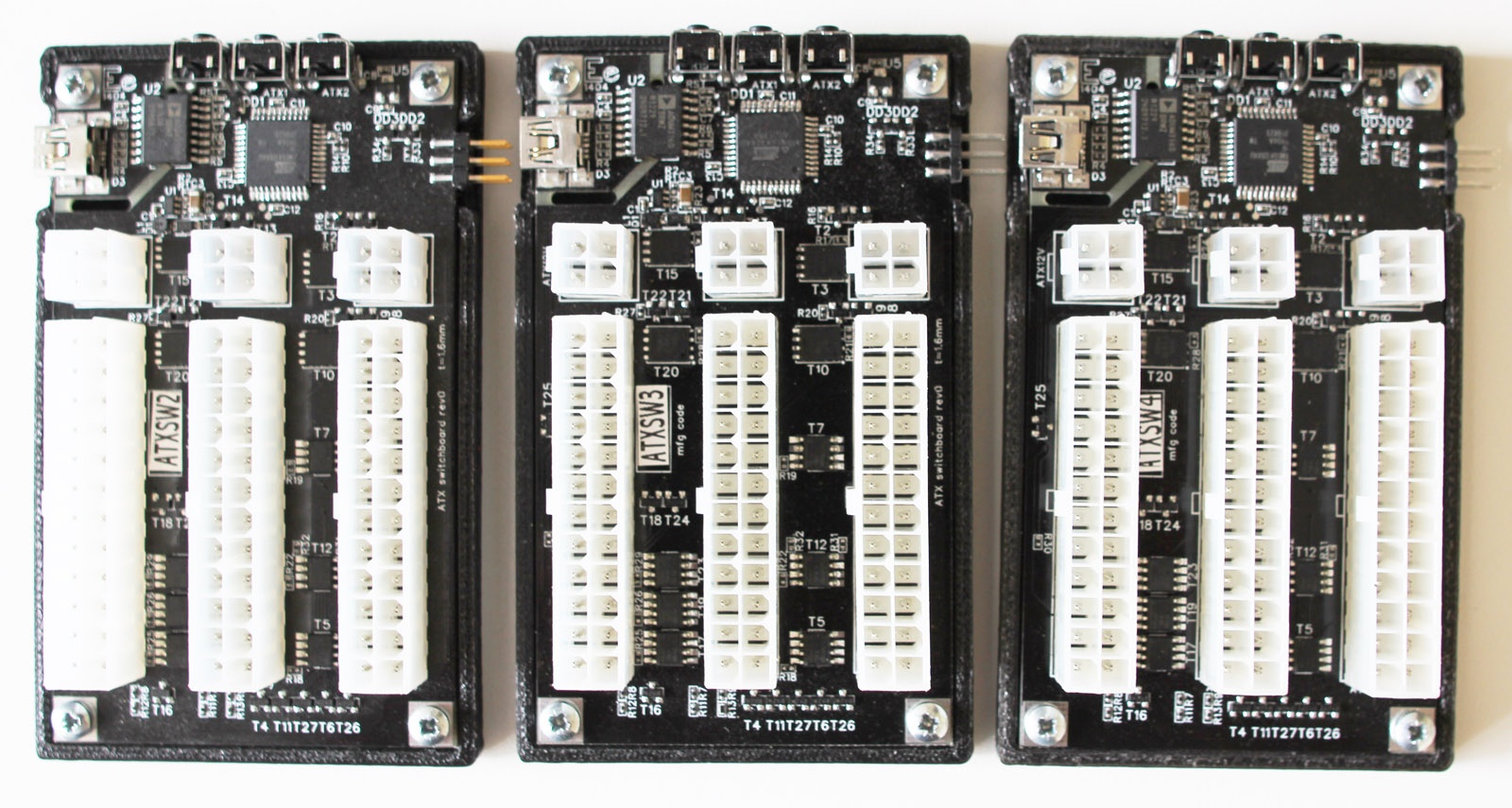

Nu is de weg naar succes er één met wat hobbeltjes. De bovenstaande foto ziet er iets anders uit, dan de foto een kleine twee weken geleden. Er waren wat problemen, bij het inschakelen van de server viel de nas uit. Daar bleken een aantal redenen voor te zijn, maar sinds gisteravond zijn die verholpen. Nu kunnen de nas en de server onafhankelijk van elkaar in en uitgeschakeld worden.

Goed, de details.

Allereerst was vast al opgevallen dat er daadwerkelijk twee computers in één behuizing zitten. Met wat kleine 3d printsels van mux, wat gaatjes en helaas ook de soms wat angstaanjagende geluiden is het ITX bord nu in de kast gemonteerd. Het ITX bord is de nas.

Om het netwerk op een veilige manier te kunnen gebruiken (als in, een ongelukje met een netwerkkabel trekt niet meteen het moederbord van de plek, maakt een short met andere ellende tot gevolg) is er een bracket gemaakt met twee netwerkkabels. Die kabels gaan intern naar de nas. Aan de achterkant van de behuizing kan ik nu gewoon op een 'normale', relatief veilige manier mijn netwerkkabels aansluiten.

Maar het ware meesterwerk ligt rechts. De switch. Vanaf de voeding komen een ATX en een P4 kabel en die gaan links in de switch. Ernaast zitten de ATX connectoren en (erachter) de P4 connectoren voor de NAS en server. Verder zittern er nog wat debugging tools bij. Tools die erg nuttig bleken voor het erm... debuggen.

Het grootste probleem was nog wel dat, hoewel de voeding qua piekvermogen het allemaal makkelijk aankan, de 12V lijn net iets teveel inzakt als de server erbij komt. Andersom is het geen punt. Om die reden zitten er bij de P4 connector op de NAS, op de 12V lijn, twee condensatoren die net genoeg zijn om de 12V dip op te vangen. De NAS blijft nu wel aan bij inschakeling van de server.

Goed, nu is dit nog niet helemaal het einde van het verhaal. Zoals te zien is, is kabel management nog echt een drama. Dat heeft ermee te maken dat ik ga proberen om de voeding te vervangen. Onderin ligt een Seasonic X-560. Het alternatief is al enige tijd in huis, de Seasonic Platinum 400W.

Helaas gaat dat vandaag niet meer gebeuren. En of het werkt, tja, dat is de vraag.

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_exif()/u/24321/motor1.gif?f=community)

:strip_icc():strip_exif()/u/265468/snor.jpg?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

/u/231803/ramdisk2.png?f=community)

/u/170728/owl.png?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

/u/527806/freebsd_black.png?f=community)