Aan de ene kant wel handig om de drives er zo in te kunnen steken, want die brackets van de Gen8 waren niet bepaald stevig. Was altijd bang ze per ongeluk te breken. Vooral bij het dichtklikken buigt het hendeltje behoorlijk door. Aan de andere kant staat het een stuk minder netjes als je het mij vraagt. En dat frontje vind ik heel erg jammer. Echt een behoorlijke downgrade.

Die NCQ bugs zijn echt heel erg naar voor NAS gebruik

Zit er steeds meer aan te denken om toch nog gauw een (derde) Gen8 mee te pakken

Absoluut is ECC belangrijk, ik vind dat eigenlijk elke computer het zou moeten hebben. Het is puur doordat intel het als een "Server" feature weg zet.Q schreef op donderdag 8 juni 2017 @ 00:05:

[...]

ECC geheugen voor een server is wel fijn, ongeacht of je ZFS draait of niet, dat maakt niets uit.

Als je zonder ECC geheugen gaat draaien, koop dan ook gewoon een synology of qnap. Zelfbouw, waarom dan nog.

Maar ook zonder het voordeel van ECC zie ik veel voordelen voor een microserver. Hij is bijvoorbeeld een stuk goedkoper (vind maar eens een 4-bay Synology of Qnap voor onder de 200 euro). En je hebt volledige controle over wat er op draait. Het hangt er vanaf wat je zoekt. Wil je er geen tijd aan besteden maar gewoon de schijven er in drukken en gaan, dan ben je met Synology beter uit. Wil je precies bepalen wat je er mee doet, dan is een microserver een fijne keus.

[ Voor 58% gewijzigd door GekkePrutser op 08-06-2017 10:45 ]

dat wordt door de beta testers gemeld.unezra schreef op woensdag 7 juni 2017 @ 23:38:

[...]

Waardoor trek je de conclusie dat het hele frontpaneel verwijderd moet worden? Ik vind het er best als een deurtje uit zien. Is dat niet alleen voor de foto gedaan? (Net zoals dat je de Gen8 vaak geheel zonder deurtje ziet in plaats van met opengeklapt deurtje.)

ze hebben op bepaalde punten kosten besparingen doorgevoerd... zo ook geen trays voor hdds meer

beta testers hebben het apparaat in April gekregen, ik verwacht dan niet veel wijzigingen meer

There are no secrets, only information you do not yet have

Nu is "Lights Out Management" niet exact hetzelfde als ILO maar ik gok dat over één van die poorten middels een PCI card alsnog ILO mogelijk is.

! Correctie: LAN-on-motherboard (LOM) is wat anders dan de LOM die ik hierboven beschrijf.

Heb je reeds een Gen8 MS upgraded met een Xeon CPU zie ik (los van de gemis van 32GB) geen reden voor vervanging mocht je dit als een lab server (VMware, HyperV etc.) willen gebruiken.

[ Voor 10% gewijzigd door Sorted op 10-06-2017 21:08 ]

het blijft stagneren na de sata driver opgehaald te hebben via een 2e usb stikje , driver word gewoon herkend als compatable dan komt er de ssd array in beeld en daarna steeds meling ' cant create partition ...'

eindeloos opnieuw array gemaakt maar helpt niets.

Server 2016 zou compatable zijn?

ook is me vaag wat nu de laatste bios is ik heb versie j06 11-2-2015 , kan geen enige overzicht krijgen op de HP site op de simpele zoektocht wat nu de laatse bios is.

heb alleen de ILO kunnen upgraden naar 2.53 verder lijkt er niets te kunnen

Ik heb bijna de server in de container gegooid , tis echt een mateloos complex apparaat wat me 2 weken tijd heeft gekost en nog even ver.

Weet niet wat nog meer te doen, mischien iemand zoeken die meer ervaring in dit ding heeft en die fisiek kan helpen of t ding blijft op de plank of beland in de container , jammer van t geld ik had toch gehoopt dat HP toch betere machines maakt.

voor de usb bootable te maken Rufus gebruikt, werkt perfect met andere machines daar kan t niet aan liggen denk ik zo.

[ Voor 5% gewijzigd door parcifal op 11-06-2017 23:30 ]

USB kan redelijk wat problemen veroorzaken, de virtual drive, usb etc word in provisioning soms C:\ gemaakt alles is voor de server bruikbaar als C:\ drive..,parcifal schreef op zondag 11 juni 2017 @ 23:25:

voor de usb bootable te maken Rufus gebruikt, werkt perfect met andere machines daar kan t niet aan liggen denk ik zo.

Probeer het eens door de drivers in de ISO te proppen (hier), dan in ILO de iso als virtual drive te mounten.

forceer met boot menu om daarvan te booten (of alsnog smart provisioning)

Soms pakt de provisioning dan de usbdisk als C:\ en de array als disk2 OID, en dan gaat de bootloader vrolijk op je usb stick en kun je nog niet booten.chaoscontrol schreef op maandag 12 juni 2017 @ 00:25:

Installeer via smart provisioning. F10 met startup o.i.d. Dan kies je voor de 2012R2 install maar dan werkt de 2016 iso ook.

[ Voor 45% gewijzigd door H00GiE op 12-06-2017 03:14 ]

"Wat gebeurt er als ik ook dit knopje dr...."

ik heb sucses nu eindelijk met server2008r2

dit ook met Rufus bootable maar dan met de server2008 raid driver op dezelfde stik

tot nu toe alles goed , moet alleen nog de juiste netwerk driver vinden

weet even niet welke maar heb geen tijd moet gelijk naar t werk, ga er vanavond mee verder

de dag begint goed nu -)

word vervolgt

[/quote]

klopt, ging ook een keer fout toen na herstart tijdens windows instaleren er automatisch weer van de usb werd geboot , toen begon dus alles weer opnieuw, handig om na elke herstart zelf even de keuze te maken via F11

het opstarten is ook een heel langdurige kwestie, vraag me af of dit niet versneld kan worden.

zitten er zulke trage chips en ROMs in de GEN8?

Niet echt, net na de eerste initialisatie doet elke pc een POST, dit staat natuurlijk voor de Power-On Self-Test.parcifal schreef op maandag 12 juni 2017 @ 17:28:

klopt, ging ook een keer fout toen na herstart tijdens windows instaleren er automatisch weer van de usb werd geboot , toen begon dus alles weer opnieuw, handig om na elke herstart zelf even de keuze te maken via F11

het opstarten is ook een heel langdurige kwestie, vraag me af of dit niet versneld kan worden.

zitten er zulke trage chips en ROMs in de GEN8?

Een server heeft een behoorlijk rigoureuze POST want zowat ALLES word onder de loep genomen, dit gebeurt natuurlijk omdat servers gebruikt worden op plekken waar betrouwbaarheid zeer op prijs word gesteld dit gaat zover dat er monetaire waarde word gehecht aan die betrouwbaarheid. Dan is het goedkoper om tijdens het Opstarten van een server GRONDIG onderzoek te doen naar de situatie/gezondheid van hardware, dan het over te slaan dan wel minder rigoureus te doen.

als je FASTBOOT op een normale pc zou uitzetten, POST MEM-TEST over je interne geheugen zou aanzetten en elke ROM zou uit gaan lezen op een normale pc zou dit ook erg lang duren.

Daarnaast is er een soort initialisatie periode die geforceerd langer duurt om zo alle hardware tijd te geven om volledig te kunnen initialiseren. zo'n systeem word voor alle servers in een keer gemaakt dus ook minder enterprise georiënteerde machines krijgen diezelfde pauze/wacht statussen in hun maag gesplitst.

Als laatste is een langzame post volgens mij ook nog eens energie zuiniger dan alles in een keer door rammen. zowel stroom als belasting op hardware.

[ Voor 4% gewijzigd door H00GiE op 12-06-2017 21:52 ]

"Wat gebeurt er als ik ook dit knopje dr...."

leuk zo waslijst aan netwerkdrivers en tools maar een leek kan daar niet echt uit op maken wat nodig is.

Alles installeren wat je daar tegenkomt gaat em ook vast niet worden met alle conflicten en gevolg ..

Ik dacht ik kijk even in de handleiding om te zien wat de diverse chips zijn voor netwerk ect maar niets, terwijl dat redelijk normaal is bij moederborden uit de doos.

Windows update draait nu met zo 190 updates te doen lol, enig tegenstribbellen bij activeren (hacken) maar dat is ook opgelost.

H00GiE; bedankt voor de uitleg daar zit idd wel wat in , hoop ook niet al te vaak te hoeven booten, servers probeer ik 24/7 online te houden.

een hier met 48 drives die is wel even bezig maar vooral om zoveel drives te checken, begrijpelijk.

Heb destijds bij een stel supermicro servers fastboot uit moeten zetten omdat EDAC anders de logs vol gooit met ECC fouten. Niet dat er fouten waren, maar foutdetectie ging compleet de mist in omdat er random data in het geheugen stond bij een koude start.

Hiernaast wil ik ook graag Virtueel een PFsense/sophos achtige constructie draaien.

Volgens mij heb ik hiervoor twee opties;

1-De firewall in HyperV draaien

2-WS16 virtualiseren in ESXI (een migratie van het huidige OS dus) en hiernaast nog een Vm met de firewall

Welke methode heeft bij jullie de voorkeur en kan de 1610 dit wel trekken?

In beide gevallen zal de Microserver dus rechtstreeks aan de WAN hangen, het leek me dus wel een vraag om hier te stellen

edit: nie tgeheel onbelangrijk, hoe ga ik dan om met ILO?

[ Voor 5% gewijzigd door spank_mojoo op 13-06-2017 15:38 ]

[ Voor 7% gewijzigd door Xfade op 13-06-2017 17:28 ]

Gewoon de Hypervisor kiezen die je het beste kent/het prettigst vindt werken. Beiden zullen voldoen. Zelf draai ik mijn Sophos UTM op een Xeon E3 die win2012r2 met Hyper-V draait waarvan ik 2 cpu cores heb toegewezen aan de firewall. Dat draait als de brandweer. Of de G1610T goed werkt zul je moeten testen. Met name de IDS (Snort) is behoorlijk cpu intensief.spank_mojoo schreef op dinsdag 13 juni 2017 @ 15:37:

Vraagje, ik heb momenteel WS16 als OS draaien.

Hiernaast wil ik ook graag Virtueel een PFsense/sophos achtige constructie draaien.

Volgens mij heb ik hiervoor twee opties;

1-De firewall in HyperV draaien

2-WS16 virtualiseren in ESXI (een migratie van het huidige OS dus) en hiernaast nog een Vm met de firewall

Welke methode heeft bij jullie de voorkeur en kan de 1610 dit wel trekken?

In beide gevallen zal de Microserver dus rechtstreeks aan de WAN hangen, het leek me dus wel een vraag om hier te stellen

edit: nie tgeheel onbelangrijk, hoe ga ik dan om met ILO?

iLO heeft een dedicated port op je Server dus die gewoon aan de LAN kant aansluiten en dan kun je m benaderen.

Ja ik kom ook wel op de pagina via de browser, maar remote console doet het niet. Met Firefox niet, Edge niet, standalone tool niet. De pc probeert wel wat (circeltje draait) maar dan houdt het op.Tomba schreef op dinsdag 13 juni 2017 @ 17:31:

[...]

iLO heeft een dedicated port op je Server dus die gewoon aan de LAN kant aansluiten en dan kun je m benaderen.

Dat antwoord was niet aan jou gerichtXfade schreef op dinsdag 13 juni 2017 @ 17:51:

[...]

Ja ik kom ook wel op de pagina via de browser, maar remote console doet het niet. Met Firefox niet, Edge niet, standalone tool niet. De pc probeert wel wat (circeltje draait) maar dan houdt het op.

Probeer het eens met Internet Explorer. Daarmee werkt bij mij de .net client.

Welke ILO versie?Xfade schreef op dinsdag 13 juni 2017 @ 17:11:

Hmm... Hoe kan ik iLO Remote Console gebruiken? In Firefox kan ik inloggen, (pop up toestaan etc) maar opent er niks, en ook de Stand-alone tool werkt/opent niks.

en welke Remote console gebruik je? (.NET, JAVA Web Start of JAVA Applet)

Als je Java JRE installeerd (ik gebruik zelf de NINITE installer voor JAVA 8),

dan kun je met de knop JAVA Web Start een bestandje (iLO-jirc.jnlp) openen en die maakt de verbinding.

Dit is browser onafhankelijk.

Om de .NET console te openen heb je IE / EDGE en een signed SSL Certificaat nodig. (een die niet self signed is)

Bij mij heeft de 3e optie (JAVA Applet) nog nooit gewerkt!

Mijn combinatie (remote console werkt):

Windows 10 / (Ninite) JAVA8 / Chrome > JAVA Web Start > download > bestand uitvoeren > Continue / Accept / Run (klikken) > beeld.

Weet wel dat de console zonder een ILO licentie niet werkt na de POST.

(of is dat inmiddels weer veranderd??)

[ Voor 15% gewijzigd door H00GiE op 13-06-2017 21:28 . Reden: ILO licentie?!? ]

"Wat gebeurt er als ik ook dit knopje dr...."

Als je nu vmware draait wn live migratie wilt doen dan gaat het hem niet worden. Gezien de verschillen tussen de CPUS.

Dus denk dat ik toch maar een SuperMicro SuperServer ga bestellen.

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Was het bij de gen8 ook niet, dus zou me verbazen als dit bij de gen10 wel een harde limiet is.Akemi schreef op woensdag 14 juni 2017 @ 10:50:

[...]

4x4TB drives max....... das jammer..... ben benieuwd of dit een hard limiet is.

Nee, een van de beta testers heeft hem al succesvol gebruikt met 5TB drives (WD5001F9YZ).Akemi schreef op woensdag 14 juni 2017 @ 10:50:

[...]

4x4TB drives max....... das jammer..... ben benieuwd of dit een hard limiet is.

Dus het ziet er naar uit dat dit gewoon de af-fabriek verkrijgbare opties zijn.

Verwijderd

Pfff ik mag wel zeggen EINDELIJK....Domino schreef op vrijdag 2 juni 2017 @ 07:24:

Op hss staat een aankondiging voor de gen 10.

Geen specificaties, als het al waar is. Het gaat om een uitnodiging voor een hp tech show aanstaande maandag.

https://www.hpe.com/nl/en...ver-gen10.1009955118.html

Mijn Gen7 N40L begint echt op zijn laatste benen te staan. Ik merk dat hij het gewoon niet meer bijhoudt qua cpu. Heeft dan ook behoorlijk wat services draaien waaronder Gatweay, Samba4/AD alle netwerk services, filesharing, media streamen, web server, mail server en nog een hand vol services.

Niet voor veel gebruikers, maar de CPU maakt regelmatig overuren op max.

Ik hoop dat de Gen10 ook redelijk geprijsd wordt. Gaan tussen de EUR460 en EUR666 kosten

Hier wat info over de processor: https://www.amd.com/en/opteron

[ Voor 16% gewijzigd door Verwijderd op 21-06-2017 14:43 ]

Je hebt de discussie de afgelopen weken gemist?Verwijderd schreef op woensdag 21 juni 2017 @ 14:37:

[...]

Pfff ik mag wel zeggen EINDELIJK....

https://www.hpe.com/nl/en...ver-gen10.1009955118.html

Mijn Gen7 N40L begint echt op zijn laatste benen te staan. Ik merk dat hij het gewoon niet meer bijhoudt qua cpu. Heeft dan ook behoorlijk wat services draaien waaronder Gatweay, Samba4/AD alle netwerk services, filesharing, media streamen, web server, mail server en nog een hand vol services.

Niet voor veel gebruikers, maar de CPU maakt regelmatig overuren op max.

Ik hoop dat de Gen10 ook redelijk geprijsd wordt. Gaan tussen de EUR460 en EUR666 kosten

Hier wat info over de processor: https://www.amd.com/en/opteron

Lees even terug zou ik zeggen. Maar al met al is het verhaal niet zo positief, helaas.

Hij heeft veel grote nadelen: Goedkopere constructie (geen deurtje meer, hele frontpanel clipt nu los), geen caddys voor de HDDs, geen iLO, de CPU is niet meer upgradebaar (want vastgesoldeerd). En nauwelijks sneller dan de instap G1610T van de oude Gen8, die uit 2013 komt.

Ook wel wat voordelen: Je hebt nu meer display outputs (2x displayport + vga) en 2 PCI-e slots. Bovendien 32GB geheugen maximaal nu. Mogelijk een extra SATA poort (er zijn alleen nog reviews van beta units dus het is niet zeker of die op het produktiemodel ook komt). En alle USB's zijn nu 3.0.

Ik heb zelf nog maar een extra Gen8 besteld nu die nog verkrijgbaar zijn voor rond de 200 euro. Vooral de iLO is voor mij belangrijk.

Edit: Ik zag ook het filmpje nu op de officiele HPE pagina die je linkte, die had ik nog niet gezien. Het ziet er uit dat ze hem nu veel meer als een HTPC zien.. Veel nadruk in de promotie op aansturen van 4K schermen en dat soort dingen. Denk dat de gemiddelde koper van een server niet zo veel waarde zal hechten aan 4K schermen en de DirectX 12 compatibiliteit maargoed. En voor huiskamergebruik vind ik hem nou weer net een beetje onhandig van formaat en opzichtig. Maar die positionering verklaart wel het een en ander.

Dat van die lampjes in de Optical bay is dan wel weer grappig, zitten er niet echt op maar ik zit toevallig al een tijdje te denken om daar een strip voor te maken met ledjes er in voor individuele HDD indicators en een bargraph voor CPU load enzo. Nu ik dat zo zie, ziet het er best cool uit dus waarschijnlijk ga ik daar na de zomer eens werk van maken. 3D printer heb ik en PCB's kosten bijna niks meer om te laten maken in China dus ik kan het heel netjes doen.

[ Voor 20% gewijzigd door GekkePrutser op 21-06-2017 16:07 ]

Met iets meer dan 500 EUR inclusief BTW, inclusief CPU maar zonder disks en geheugen is 'ie iets duurder dan de Gen8. Toch is het voor dat geld een enorm leuke server.

De DL20 heeft geen aparte ILO poort, maar wel 2 reguliere NIC's en full-blown ILO dat je shared op 1 van die 2 poorten kunt zetten. Je kunt ILO aan een apart VLAN koppelen waardoor je enkel de bandbreedte en het fysieke touwtje moet delen maar verder niet.

Verder nog wat andere toffe features als je NIC's vanuit het BIOS in een VLAN kunnen hangen, booten vanaf iSCSI en http (in dat laatste geval wil 'ie een ISO hebben), etc.

Eigenlijk zie ik bij de DL20 maar 2 echte nadelen:

- 19"

- 2 HDD bays

De DL20 voelt echt aan als het 19" broertje van de Microserver Gen8. Ik weet niet hoe bruikbaar 19" voor de meeste mensen hier thuis is, aan de andere kant, het ding is zo diep als een 19" switch en ongeveer half zo diep of nog iets minder dan een DL300-series.

Oh, hij kan 64G geheugen aan. Moet je d'r wel 4x16G in stoppen.

Ná Scaoll. - Don’t Panic.

Verwijderd

Kon je een 19"niet in een Ikea LACK kwijt? /edit: https://wiki.eth0.nl/index.php/LackRackunezra schreef op woensdag 21 juni 2017 @ 16:35:

De DL20 voelt echt aan als het 19" broertje van de Microserver Gen8. Ik weet niet hoe bruikbaar 19" voor de meeste mensen hier thuis is, aan de andere kant, het ding is zo diep als een 19" switch en ongeveer half zo diep of nog iets minder dan een DL300-series.

19" hoeft geen probleem te zijn als je hem in/onder een Lack tafeltje schroeft.Eigenlijk zie ik bij de DL20 maar 2 echte nadelen:

- 19"

- 2 HDD bays

2HDD bays is wel weinig. Enige serieuze optie is dan raid1. Je kan natuurlijk wel een iSCSI volume op een freenas apparaat als extra diskspace aanbieden, maar dat is voor velen al een kastje te veel.

Dat is dan weer wel lekker. Zeker als je een aantal VM's wil aanzwengelen.Oh, hij kan 64G geheugen aan. Moet je d'r wel 4x16G in stoppen.

Verwijderd

Ik had daar nog niet eens aan gedacht. De kast van de N40L bevalt mij prima. Echter ik loop tegen de limiet van de processor aan. Zie https://homeservershow.co...n54l-motherboard-upgrade/ voor opties._JGC_ schreef op woensdag 7 juni 2017 @ 10:04:

Zit er zelf wel aan te denken om tzt een Gen10 aan te schaffen als upgrade van mijn N40L. Hangt er even vanaf wat de prijs van die dingen wordt. Andere optie is om zoals jij zegt een ITX bord in de N40L te bouwen, de case ben ik tevreden over.

Als ik de laatste post uit die discussie lees, lijkt het toch niet zo makkelijk. Die gast geeft wel een heel mooi alternatief: https://www.bitfenix.com/global/en/products/chassis/prodigy/

Belgische leverancier: https://www.tones.be/particulier/product/prodigy-m-black

Duitse leverancier: https://www.caseking.de/b...use-schwarz-gebf-059.html

[ Voor 26% gewijzigd door Verwijderd op 21-06-2017 19:47 ]

Ik ben ook van plan om een DL 20 te kopen.. maar hoe is de geluid productie? 9 van de 10 pizza dozen maken behoorlijk geluid.unezra schreef op woensdag 21 juni 2017 @ 16:35:

Niet geheel toevallig deze week voor het eerst gespeeld met wat in feite zijn 19" broertje is, de DL20.

Met iets meer dan 500 EUR inclusief BTW, inclusief CPU maar zonder disks en geheugen is 'ie iets duurder dan de Gen8. Toch is het voor dat geld een enorm leuke server.

De DL20 heeft geen aparte ILO poort, maar wel 2 reguliere NIC's en full-blown ILO dat je shared op 1 van die 2 poorten kunt zetten. Je kunt ILO aan een apart VLAN koppelen waardoor je enkel de bandbreedte en het fysieke touwtje moet delen maar verder niet.

Verder nog wat andere toffe features als je NIC's vanuit het BIOS in een VLAN kunnen hangen, booten vanaf iSCSI en http (in dat laatste geval wil 'ie een ISO hebben), etc.

Eigenlijk zie ik bij de DL20 maar 2 echte nadelen:

- 19"

- 2 HDD bays

De DL20 voelt echt aan als het 19" broertje van de Microserver Gen8. Ik weet niet hoe bruikbaar 19" voor de meeste mensen hier thuis is, aan de andere kant, het ding is zo diep als een 19" switch en ongeveer half zo diep of nog iets minder dan een DL300-series.

Oh, hij kan 64G geheugen aan. Moet je d'r wel 4x16G in stoppen.

Ik weet nog niet hoe goed het geluid is als 'ie regulier in bedrijf is maar er zitten 4 kleine fannetjes in die bij het booten behoorlijk van zich laten horen en ongetwijfeld als het nodig is, voluit gaan en dus flink herrie maken.Frankie20 schreef op woensdag 21 juni 2017 @ 19:24:

[...]

Ik ben ook van plan om een DL 20 te kopen.. maar hoe is de geluid productie? 9 van de 10 pizza dozen maken behoorlijk geluid.

Ofwel, wil je een stille machine: koop een Microserver

Wil je een 19" machine waarbij het geluid niet uit maakt: koop een DL-series

Ná Scaoll. - Don’t Panic.

Booten maakt mij niet zo veel uit.. gaat met name als die aanstaat... Ik las in een review dat hij behoorlijk stil is.. dus was benieuwd wat voor geluidproductie was.unezra schreef op woensdag 21 juni 2017 @ 21:21:

[...]

Ik weet nog niet hoe goed het geluid is als 'ie regulier in bedrijf is maar er zitten 4 kleine fannetjes in die bij het booten behoorlijk van zich laten horen en ongetwijfeld als het nodig is, voluit gaan en dus flink herrie maken.

Ofwel, wil je een stille machine: koop een Microserver

Wil je een 19" machine waarbij het geluid niet uit maakt: koop een DL-series

Geluidsproductie zal af hangen van hoe druk 'ie is en wat zijn omgevingstemperatuur is.Frankie20 schreef op donderdag 22 juni 2017 @ 11:01:

[...]

Booten maakt mij niet zo veel uit.. gaat met name als die aanstaat... Ik las in een review dat hij behoorlijk stil is.. dus was benieuwd wat voor geluidproductie was.

Idle leek 'ie niet heel lawaaierig te zijn maar het blijven 4 kleine 1U fannetjes en bij booten hoor je goed hoe veel herrie ze *kunnen* maken. Hij zal ongetwijfeld redelijk stil te maken zijn, maar schrik niet als je 'm onder volle load in een kamer van 30 graden zet en opeens stijgt 'ie op...

Ná Scaoll. - Don’t Panic.

Voorbereidend op de installatie vraag ik mij af wat handig is m.b.t. de RAID configuratie i.c.m. een nog te kiezen hypervisor.

Ik heb 2 disken in gebruik op een andere NAS van 3TB per stuk, nu wil ik er 2 bij kopen, wellicht zelfs 4TB per stuk. Kan ik met die 2 nieuwe in RAID 1 of SHR zodadelijk makkelijk uitbreiden als die 'oude' HDD's uit mijn oude NAS komen?

Dus kan ik starten met 2 disken en uitbreiden naar 4 op hetzelfde volume of ga ik het mezelf lastig maken

Je wilt een hypervisor en de disken fysiek beschikbaar maken aan een xpenology (ik lees SHR als synology)? Dan is de b120 niet geschikt, je moet namelijk de gehele controller (inclusief sata5) door geven aan een vm voor passthru. Waar ga je dan de xpenology vm op zetten?

Daarnaast een fake raid kaart en xpenology in een (1) zin is vloeken. DSM regelt zelf zijn raid via mdadm.

Dubbel raid is vragen om problemen en niet aan te raden.

Verwijderd

https://www.supermicro.co...r/5028/sys-5028d-tn4t.cfm

Prijs is ook pittig. Bijv bij AheadIT komt een basis server op EUR1250,- ex BTW.

Alternatief een wat betaalbaarder optie: wenslijst: miniserver

[ Voor 26% gewijzigd door Verwijderd op 23-06-2017 09:23 ]

Verwijderd

Je kan ook je N40L gaan gebruiken als iscsi target vanaf die goedkopere Supermicro servere. Voor een paar tientjes een dual NIC in je N40L en je hebt een mooie storage bak en snelle cpu en veel mem in je hypervisor. N40L kun je nog meer schijven in kwijt als je wilt.Verwijderd schreef op vrijdag 23 juni 2017 @ 09:21:

Scheelt de helft ja, maar daar kan slechts 1 2,5"disk in.... Ik ga denk ik voor de opties in mijn wenslijstje: voor EUR750,- heb ik dan een erg leuke server. De schijven (1x 60Gb SSD + 1 x 250GB HDD + 2 x 2TB HDD) zet ik dan over uit m'n oude N40L.

Is mogelijk, maar je kan natuurlijk ook doen wat jij voorstelt ook leuk 😉

Waarom iSCSI?rookie no. 1 schreef op vrijdag 23 juni 2017 @ 14:58:

[...]

Je kan ook je N40L gaan gebruiken als iscsi target vanaf die goedkopere Supermicro servere. Voor een paar tientjes een dual NIC in je N40L en je hebt een mooie storage bak en snelle cpu en veel mem in je hypervisor. N40L kun je nog meer schijven in kwijt als je wilt.

Is mogelijk, maar je kan natuurlijk ook doen wat jij voorstelt ook leuk 😉

Ik heb juist een Microserver Gen8 met FreeNAS die NFS en SMB doet. Prima combinatie.

Deze week overigens geleerd dat de DL20 van iSCSI kan booten. Dat is dan wel weer hip. Misschien dat als ik zoiets ga doen, dat ik weer iSCSI ga inzetten. NFS booten kan niet en ik dacht dat van http booten enkel read-only dingen als ISO kan. (Wat dan weer minder nuttig is.)

Ná Scaoll. - Don’t Panic.

Persoonlijk koppel ik ik mijn twee microservers met Fibre Channel, dat werkt ongeveer hetzelfde als iSCSI (maar dan met dedicated hardware, glaskabels en zonder de TCP/IP laag).unezra schreef op vrijdag 23 juni 2017 @ 15:47:

[...]

Waarom iSCSI?

Ik heb juist een Microserver Gen8 met FreeNAS die NFS en SMB doet. Prima combinatie.

Deze week overigens geleerd dat de DL20 van iSCSI kan booten. Dat is dan wel weer hip. Misschien dat als ik zoiets ga doen, dat ik weer iSCSI ga inzetten. NFS booten kan niet en ik dacht dat van http booten enkel read-only dingen als ISO kan. (Wat dan weer minder nuttig is.)

Ik doe dat omdat ik dan op 1 bak al het beheer doe. De andere gooit alleen de rauwe schijven (of liever: partities) maar door. De hoofdserver ziet op die manier 8 drives lokaal. De filesystems, encryptiesleutels, SMB shares en toegangsrechten worden beheerd vanaf 1 server. Alleen SMART stats zie je niet, helaas. Maar met SMB is dat ook niet zo.

Ik vind dat een stuk handiger dan 2 losse NASsen op mijn netwerk hebben, al helemaal omdat ik alle drives combineer tot 1 groot filesystem.

Je zou natuurlijk SMB shares van de ene server door kunnen zetten naar de andere en daar opnieuw sharen maar dat lijkt me een stuk onhandiger en geeft misschien conflicten van de 2 daemons (client en server) die naar dezelfde data proberen te schrijven.

Plus dat Fibre Channel / iSCSI bewezen technieken zijn voor dit soort dingen. In datacenters van grote bedrijven doen ze het ook zo (alleen dan niet point to point maar naar een grote SAN van bijv. EMC^2). Wat mij ook aantrok aan deze oplossing is dat ik er dan ook wat meer ervaring mee heb in de praktijk. Want op mijn werk doe ik niets met die kant van het verhaal.

Mijn gedachte was: ESXi >> Xpenology (in een VM ja)>> DSM.Domino schreef op donderdag 22 juni 2017 @ 14:39:

Ik zie wat dingen die niet met elkaar rijmen in je post.

Je wilt een hypervisor en de disken fysiek beschikbaar maken aan een xpenology (ik lees SHR als synology)? Dan is de b120 niet geschikt, je moet namelijk de gehele controller (inclusief sata5) door geven aan een vm voor passthru. Waar ga je dan de xpenology vm op zetten?

Daarnaast een fake raid kaart en xpenology in een (1) zin is vloeken. DSM regelt zelf zijn raid via mdadm.

Dubbel raid is vragen om problemen en niet aan te raden.

Kan dat niet dan, daarvoor heb ik de Gen8 juist gekocht. Vanuit een VM heb je inderdaad meerdere disken aangeboden, die in de basis al in een RAID configuratie zitten. Of is het juist handig om maar 1 disk aan te bieden aan Xpenology, dan is het dus niet nodig om vanuit DSM ook nog eens met SHR aan de gang te gaan begrijp ik je goed?

[ Voor 3% gewijzigd door Praetorian op 23-06-2017 22:48 ]

Ik las alleen (wellicht verkeerd) dat je al een fysieke synology hebt. En dus twee fysieke disken in DSM als shr hebt geconfigureerd.

Zelfs dat kan onder esx, maar dan moet je de controller waaraan die disks hangen met vt-d passthru doorgeven aan de vm. En daar zit hem de crux. Dan hou je namelijk geen sas/sata kanaal meer over om de vm vanaf te starten. Of je geeft heel de i120 door of niet, dat is niet per disk/kanaal.

Mits ik het dus correct heb begrepen moet je nog een extra controller hebben om een datastore te creeren en de vm van te starten. Of om die extra controller door te geven met passthru.

Welke HW gebruik je voor die koppeling?GekkePrutser schreef op vrijdag 23 juni 2017 @ 17:06:

[...]

Persoonlijk koppel ik ik mijn twee microservers met Fibre Channel, dat werkt ongeveer hetzelfde als iSCSI (maar dan met dedicated hardware, glaskabels en zonder de TCP/IP laag).

There are no secrets, only information you do not yet have

:-) Mooie setup en goed verhaal.GekkePrutser schreef op vrijdag 23 juni 2017 @ 17:06:

[...]

Persoonlijk koppel ik ik mijn twee microservers met Fibre Channel, dat werkt ongeveer hetzelfde als iSCSI (maar dan met dedicated hardware, glaskabels en zonder de TCP/IP laag).

Ik doe dat omdat ik dan op 1 bak al het beheer doe. De andere gooit alleen de rauwe schijven (of liever: partities) maar door. De hoofdserver ziet op die manier 8 drives lokaal. De filesystems, encryptiesleutels, SMB shares en toegangsrechten worden beheerd vanaf 1 server. Alleen SMART stats zie je niet, helaas. Maar met SMB is dat ook niet zo.

Ik vind dat een stuk handiger dan 2 losse NASsen op mijn netwerk hebben, al helemaal omdat ik alle drives combineer tot 1 groot filesystem.

Je zou natuurlijk SMB shares van de ene server door kunnen zetten naar de andere en daar opnieuw sharen maar dat lijkt me een stuk onhandiger en geeft misschien conflicten van de 2 daemons (client en server) die naar dezelfde data proberen te schrijven.

Plus dat Fibre Channel / iSCSI bewezen technieken zijn voor dit soort dingen. In datacenters van grote bedrijven doen ze het ook zo (alleen dan niet point to point maar naar een grote SAN van bijv. EMC^2). Wat mij ook aantrok aan deze oplossing is dat ik er dan ook wat meer ervaring mee heb in de praktijk. Want op mijn werk doe ik niets met die kant van het verhaal.

Voor mij is een van de redenen waarom ik juist gebruik maak van NFS en SMB op de NAS, dat ik op mijn werk een conceptueel gezien vergelijkbare setup heb en de hardware is relatief goedkoop en simpel. Ook om wat praktijkervaring op te doen dus. (Al gebruik ik thuis Proxmox VM & FreeNAS, terwijl ik op mijn werk VMWare & NetApp gebruik.)

Wie weet dat ik ooit eens de geest krijg, wat geld investeer en ook een FC setup bouw. 2e hands is dat spul volgens mij redelijk betaalbaar en goed te krijgen.

Ná Scaoll. - Don’t Panic.

QLogic kaartjes. Type weet ik niet uit mijn hoofd. Ze kwamen uit een server op mijn werk die weggegooid werd. Elke server heeft er twee voor communicatie met de SAN (2 voor redundantie) en als servers vervangen worden dan bestellen ze ook weer nieuwe kaarten mee ivm de support. Het zijn heel dure kaarten dus dat verbaasde me wel.

Tweedehands kosten ze heel erg weinig (tientje ofzo) zoals unezra zegt, omdat ze normaal alleen samen met hele dure infrastructuur gebruikt worden die je thuis niet hebt. En bedrijven hebben geen interesse in tweedehands spul zonder support.

Let alleen wel op: juist omdat deze kaarten bijna altijd met een SAN werken, kunnen sommige modellen niet in target mode draaien. En dan heb je er niet zo veel aan voor point to point mode want een van de servers moet target zijn.

Omdat ze geen low profile bracket hadden heb ik die ook los moeten bestellen maar dat was ook goedkoop.

De software kant aan de target zijde op Linux was niet eenvoudig maar zoek op "targetcli", die software is het beste. Er zijn verschillende tutorials te vinden. Deze heb ik gebruikt. Volg die en pruts er een beetje mee en je komt er wel. De client kant is simpeler. Fiber kabel kostte ook een tientje nieuw.

[ Voor 13% gewijzigd door GekkePrutser op 24-06-2017 15:02 ]

Ik overweeg om de schijfset van mijn ML10v2 naar mijn Gen8 te plaatsen ivm stroomverbruik (de ml10 kan dan slapen). De ml10 heeft een SSD met daarop Windows en de disks zijn puur voor storage (NTFS uiteraard). Op de Gen8 draait momenteel ESXi. Ik kan me voorstellen dat ik, om de disks leesbaar te maken vanuit een Windows VM, ook zaken moet wijzigen in ESXi maar dat is voor latere zorg.

Ik draai een ESXI host (6.0u3) met hierop een Xpenology vm en een Ubuntu Server VM.

Ik heb voor de schijven losse arrays aangemaakt via de B120i. In Esxi datastores aangemaakt en Xpenology de raid laten opzetten.

Het probleem is op dit moment dat de ventilator van mijn Microserver continu op 50% draait, en ik het gevoel heb dat er een vliegtuig in de meterkast staat.

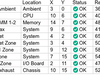

Dit zijn de temperaturen wat Ilo aangeeft:

Iemand enig idee?

volgens mij niet, de startprijs is lager dan $399 schrijven ze in wat videosmldot.be schreef op woensdag 21 juni 2017 @ 14:13:

Is de Gen10 al in Nederland te koop?

There are no secrets, only information you do not yet have

Met als primaire reden:

- Missen van ILO

- Geen Intel CPU maar weer AMD

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Zou gewoon moeten werken.oef! schreef op maandag 26 juni 2017 @ 12:47:

Weet iemand of het mogelijk is om een b120i-opgebouwde RAID10 naar een andere server met een b120i chipset te verhuizen en waar ik dan nog rekening mee moet houden?

Ik overweeg om de schijfset van mijn ML10v2 naar mijn Gen8 te plaatsen ivm stroomverbruik (de ml10 kan dan slapen). De ml10 heeft een SSD met daarop Windows en de disks zijn puur voor storage (NTFS uiteraard). Op de Gen8 draait momenteel ESXi. Ik kan me voorstellen dat ik, om de disks leesbaar te maken vanuit een Windows VM, ook zaken moet wijzigen in ESXi maar dat is voor latere zorg.

Als je de schijven in dezelfde volgorde in de nieuwe machine zet kun je in principe van elke SmartArray naar elke SmartArray migreren, mits de feature sets enzo overeenkomen. Dus ook een upgrade van een P410 naar P420 gaat op die manier maar ook een migratie van machine1 naar machine2. Er wordt maar een klein deel van de config op de controller opgeslagen, de rest op de schijven van de array zelf.

Ze worden volgens HPE rond Augustus bij de Nederlandse distribiteurs verwacht.mldot.be schreef op woensdag 21 juni 2017 @ 14:13:

Is de Gen10 al in Nederland te koop?

Raid sets zijn volgens mij te migreren tussen verschillende HP servers.oef! schreef op maandag 26 juni 2017 @ 12:47:

Weet iemand of het mogelijk is om een b120i-opgebouwde RAID10 naar een andere server met een b120i chipset te verhuizen en waar ik dan nog rekening mee moet houden?

Ik overweeg om de schijfset van mijn ML10v2 naar mijn Gen8 te plaatsen ivm stroomverbruik (de ml10 kan dan slapen). De ml10 heeft een SSD met daarop Windows en de disks zijn puur voor storage (NTFS uiteraard). Op de Gen8 draait momenteel ESXi. Ik kan me voorstellen dat ik, om de disks leesbaar te maken vanuit een Windows VM, ook zaken moet wijzigen in ESXi maar dat is voor latere zorg.

Maar, niet alleen zijn je NTFS partities in ESXi niet leesbaar (niet van het type VMFS), maar ook heb je als je de hele controller in passthrough modus zet geen ruimte voor 'n windows vm.

ESXi VMs (o.a. de VMX file) moeten op een gemounte VMFS partitie staan om door ESXi te kunnen worden gelezen.. ..en dat werkt alleen je een datastorage hebt op een schijf aan een 2e controller hebt die dus niet in passthrough staat. deze vm kan dan weer native de b120i benaderen (dmv passthrough) en dan zijn de NTFS partities op de schijven voor de VM WEL leesbaar.

Ik weet niet of de optical sata aansluiting onderdeel is van de b120i controller, anders kun je daar een DOM of een (mini) ssd gebruiken voor de logs en VM bestanden. en dan de hele b120i in passthrough zetten.

Ook weet ik niet of je de b120i controller in passthrough binnen meerdere VMs tegelijk kan gebruiken.

Als je beide servers op de zelfde manier wil gebruiken en de hardeschijven 1:1 wil overzetten zou ik voor een native windows installatie gaan net als op de ML.

Ikzelf gebruik in m'n ml10v2 een CIsco/LSI UCS-RAID9271CV-8i controller met 8 interne poorten + port 1+2 van de b120i (port 3+4 zijn sata 3gbit) deze LSI controllers passen met de lowprofile bracket ook "gewoon" in de gen8 MS. (de HP P420 (sata6g), HP p410 (sata 3g) of andere HP controllers kunnen ook.

Let op: ze moeten wel een mini-SAS aansluiting hebben om de HP bay van de MS gen8 direct aan te sluiten (die heeft namelijk een SFF 8087 / mini-SAS aansluiting)

Ook in de MS gen8 die ik verkocht heb zit nu een LSI MR9260-4i met 1 Mini-SAS poort.

Ik prefereer de LSI kaarten door MegaCli software die je kunt gebruiken in ESXi SSH verbinding terwijl de server aanstaat. (raidset aanmaken + wijzigen zonder reboot)

Ook kan een LSI kaart de logical disk als SSD markeren voor ESXi ook als de logical disk een raid set van meerdere SSD's is. (4x SSD in raid0 met een snelheid van ~1800MB/s)

een nadeel, zo'n LSI kaart word ERG warm. (102°C zonder actieve koeler of front fan in de ML10v2, nu 57°C met een 40mm cooler direct op de heatsink)

"Wat gebeurt er als ik ook dit knopje dr...."

Even wat ervaringen delen met de installatie van Openmediavault (en test installaties Ubuntu server, Freenas). Eerste installatie OMV ging goed, USB ISO erin, geduld, geduld, installeren op oude laptopschijf via interne USB/SATA kabel, RAID5 bouwen met oude schijven.

Data pompen, klaar.....Maar na een nacht vond ie het mooi geweest.

De USB/SATA kabel begaf het helaas. Bij een nieuwe installatie met nieuwe kabel bleef ie hangen bij het booten, geen USB installatie mogelijk. Af en toe wel de eerste Debian/OMV installatie stappen, maar hij vroeg plotseling om CD-ROM. Alles in de BIOS op USB eerst gezet, AHCI selecteren, maar helaas.

Uiteindelijk gelukt, wat blijkt een installatie USB maken met Unetbootin (in Linux) werkte niet, je moet blijkbaar echt met dd commando aan de gang om een goede USB-stick te krijgen. Dit was al aangegeven in de OMV documentatie, maar bij mijn gewone PC installaties was het nooit een probleem een installatie USB aan te maken met Unetbootin, nu dus wel.

dd if=XXX.iso of=/dev/sdX blijkt te werken, niet alleen voor OMV, maar ook FreeNAS & Ubuntu.

Nu OMV draaien en als ik eens meer geheugen erin wil doen eens ZFS proberen.

Hopelijk helpt deze ervaring anderen bij het troubleshooten bij installatieproblemen.

Maar waarom een USB naar SATA adapter? Je kan ook de interne SATA poort gebruiken, neem aan dat dat sneller is. Je kan daar alleen niet van booten als je hem in AHCI mode zet, maar als je je /boot partitie op SD kaart zet dan is dat al opgelost.

USB naar SATA leek me het simpelst vooralsnog. Traag met booten is ie toch wel en als ie loopt gaat ie snel genoeg. Mocht ik toch naar FreeNAS of NAS4free overstappen, dan is een USB stick voldoende (evt met mirror USB extern)GekkePrutser schreef op woensdag 28 juni 2017 @ 20:00:

Ik doe het eigenlijk altijd met dd, dat is veruit het simpelst mits je al op Linux zit op je desktop (tip: bs=1M maakt het een stuk sneller). Of op Windows met Win32DiskImager. De ISO moet dan wel voorbereid zijn op USB booten maar dat zijn ze bijna allemaal wel.

Maar waarom een USB naar SATA adapter? Je kan ook de interne SATA poort gebruiken, neem aan dat dat sneller is. Je kan daar alleen niet van booten als je hem in AHCI mode zet, maar als je je /boot partitie op SD kaart zet dan is dat al opgelost.

Verwijderd

Zijn er toevallig mirrors beschikbaar ergens?

Iemand enige ervaring met dit probleem?

Ik kom een SPP van april 2017 tegen op http://updater.saldabit.c...P2017040.2017_0420.14.iso. Niet gedownload of getest, maar naam filesize komt wel overeen.Verwijderd schreef op zaterdag 1 juli 2017 @ 16:03:

Sinds april is er blijkbaar een nieuwe service pack uitgebracht voor de g8. Dus ik denken die ga ik even downloaden, waarbij ik vergeten ben dat ze bij HP een stelletje **** zijn die niet weten wat klantenservice is en blijkbaar downloads hebben beperkt naar mensen met een support contract of iets dergelijks.

Zijn er toevallig mirrors beschikbaar ergens?

Desktop: i5-14600K, 32GB DDR5-6000, RTX 5070; Laptop: MacBook Pro M1 Pro 14" 16/512; Server: R9-7950X, 192GB DDR5-5600

Op homeservershow staan ook nog twee mirrors. Maar dacht ergens gelezen te hebben dat er geen updates voor de gen8 in dat service pack zaten.Verwijderd schreef op zaterdag 1 juli 2017 @ 16:03:

Sinds april is er blijkbaar een nieuwe service pack uitgebracht voor de g8. Dus ik denken die ga ik even downloaden, waarbij ik vergeten ben dat ze bij HP een stelletje **** zijn die niet weten wat klantenservice is en blijkbaar downloads hebben beperkt naar mensen met een support contract of iets dergelijks.

Zijn er toevallig mirrors beschikbaar ergens?

Ik lees her en der dat het lukt om deze draaiende te krijgen i.c.m. een i5 3470T. Alleen zie ik in Intel ARK dat deze geen ECC ondersteund. Hoe zit dit dan precies?

Andere optie is een E3-1220v2 maar is al snel 70-80 euro duurder dan een 3470T.

Steam: GAITii | PSN: GAITii | 3DS FC: 0361-7487-5231

Thanks! Zien om die te scoren!Jadang schreef op zondag 2 juli 2017 @ 21:29:

Zelf heb ik ook de i5-3470T in de Microserver Gen8 zitten. Het standaard ECC geheugen werkt verder prima met de CPU. In iLO wordt ook aangegeven dat het ondersteund wordt, ook al geeft Intel aan van niet.

[afbeelding]

[afbeelding]

Steam: GAITii | PSN: GAITii | 3DS FC: 0361-7487-5231

Zelf heb ik ook een i5 3470T in m'n servertje draaien. Werkt prima, al heb ik wat last van random reboot problemen maar ik betwijfel ten zeerste dat dit te wijten is aan de CPU switchGAITii schreef op zondag 2 juli 2017 @ 20:11:

Sta op het punt om een MicroServer Gen8 aan te schaffen.

Ik lees her en der dat het lukt om deze draaiende te krijgen i.c.m. een i5 3470T. Alleen zie ik in Intel ARK dat deze geen ECC ondersteund. Hoe zit dit dan precies?

Andere optie is een E3-1220v2 maar is al snel 70-80 euro duurder dan een 3470T.

Dit had ik ook.. Gewoon met de standaard G1610T. Ligt idd niet aan de CPU, HP heeft voor mij het moederboard vervangen (processor moest ik zelf van de oude overzetten). Toen was het opgelost.RavonsDaro schreef op maandag 3 juli 2017 @ 10:56:

[...]

Zelf heb ik ook een i5 3470T in m'n servertje draaien. Werkt prima, al heb ik wat last van random reboot problemen maar ik betwijfel ten zeerste dat dit te wijten is aan de CPU switch

Ik zou het zeker aanmelden want het wordt steeds erger. In het begin was het 1x in de paar weken. Uiteindelijk gebeurde het zo vaak dat het zelfs tijdens het BIOS bootproces al gebeurde. Wat ook wel makkelijk was want de hele discussie met de support over 'ligt het aan mijn OS/drivers' was daarmee in een keer afgesloten.

[ Voor 27% gewijzigd door GekkePrutser op 03-07-2017 12:48 ]

Hoe heb je dit geregeld qua garantie? Ik heb hem namelijk bij MAX ICT gekocht maar geen idee of dit onder hun valt of, of dat ik het beste langs HP kan gaan rollen.GekkePrutser schreef op maandag 3 juli 2017 @ 12:45:

[...]

Dit had ik ook.. Gewoon met de standaard G1610T. Ligt idd niet aan de CPU, HP heeft voor mij het moederboard vervangen (processor moest ik zelf van de oude overzetten). Toen was het opgelost.

Ik zou het zeker aanmelden want het wordt steeds erger. In het begin was het 1x in de paar weken. Uiteindelijk gebeurde het zo vaak dat het zelfs tijdens het BIOS bootproces al gebeurde. Wat ook wel makkelijk was want de hele discussie met de support over 'ligt het aan mijn OS/drivers' was daarmee in een keer afgesloten.

Ik heb gewoon contact met HP opgenomen. Had hem van Serversplus in Engeland, en ik woon in Ierland dus dat was wat lastiger geweest dan direct met HP.RavonsDaro schreef op maandag 3 juli 2017 @ 12:52:

[...]

Hoe heb je dit geregeld qua garantie? Ik heb hem namelijk bij MAX ICT gekocht maar geen idee of dit onder hun valt of, of dat ik het beste langs HP kan gaan rollen.

Dit was geen probleem voor HP. Ik kon er gewoon terecht. Moederboard werd per koerier opgestuurd en moest ook op die manier weer terug. Je hebt wel maar een jaar garantie op die manier (weet niet of het via Max ICT meer is)

[ Voor 6% gewijzigd door GekkePrutser op 03-07-2017 13:03 ]

Hier heeft iemand een PicoPSU er in gebouwd, maar er is maar een besparing van 6W, waarmee je de investering er nauwelijks uit krijgt.

[ Voor 3% gewijzigd door HaTe op 03-07-2017 13:30 ]

WP: ME PUHZ-SW75YAA + ERST30D-VM2ED | Solar: 17x TSM-340-DE06M.08 (5780Wp ~6200kWh), Azimuth 179°, Hellingshoek: 34° | PC specs

IshHaTe schreef op maandag 3 juli 2017 @ 13:29:

Zijn er mensen die hun best hebben gedaan om het energieverbruik van de Gen8 te verminderen? Is dat gelukt en hoe?

Hier heeft iemand een PicoPSU er in gebouwd, maar er is maar een besparing van 6W, waarmee je de investering er nauwelijks uit krijgt.

Grootste besparing op energie pak ik door hem s'nachts uit te laten. Verder wel alle zuinigheidopties in de BIOS aangezet.

Je kunt nog overgaan op PC3L geheugen, maar gezien de kostprijs daarvan haal je dat er nooit uit.

Ik bedacht me dat ik nog oude disks had liggen uit een vorige server en heb een proof of concept gedaan, ging verrassend soepel:H00GiE schreef op woensdag 28 juni 2017 @ 06:11:

[...]

Maar, niet alleen zijn je NTFS partities in ESXi niet leesbaar (niet van het type VMFS), maar ook heb je als je de hele controller in passthrough modus zet geen ruimte voor 'n windows vm.

ESXi VMs (o.a. de VMX file) moeten op een gemounte VMFS partitie staan om door ESXi te kunnen worden gelezen.. ..en dat werkt alleen je een datastorage hebt op een schijf aan een 2e controller hebt die dus niet in passthrough staat. deze vm kan dan weer native de b120i benaderen (dmv passthrough) en dan zijn de NTFS partities op de schijven voor de VM WEL leesbaar.

- Op een oude bak een schijf met NTFS geformatteerd

- Schijf in de Gen8 gezet

- "Geimporteerd" in SSA als een RAID0

- Deze met hulp van deze pagina als RDM geconfigureerd

- Gekoppeld aan een Windows VM.

Lijkt goed te werken.

Er was geen verdere configuratie nodig. De enige snag die ik mogelijk nog zie is dat ik de RAID set als geheel niet als een RDM kan toevoegen, kon ik niet testen omdat een andere disk ter plekke overleed en ik geen RAID1 kon bouwen.

Het lijkt me dat je de raid0 VD als RDM hebt gemount, dus ik verwacht dat als je een Striping Set (VD) toevoegd er GEEN verschil moet zijn. en dus de hele VD gemount word en dan dus op Filesystem Niveau word doorgelaten.oef! schreef op maandag 3 juli 2017 @ 22:21:

[...]

Ik bedacht me dat ik nog oude disks had liggen uit een vorige server en heb een proof of concept gedaan, ging verrassend soepel:

- Op een oude bak een schijf met NTFS geformatteerd

- Schijf in de Gen8 gezet

- "Geimporteerd" in SSA als een RAID0

- Deze met hulp van deze pagina als RDM geconfigureerd

- Gekoppeld aan een Windows VM.

Lijkt goed te werken.

Er was geen verdere configuratie nodig. De enige snag die ik mogelijk nog zie is dat ik de RAID set als geheel niet als een RDM kan toevoegen, kon ik niet testen omdat een andere disk ter plekke overleed en ik geen RAID1 kon bouwen.

RDM lijkt me bijna hetzelfde als passtrough maar dan op een FS level in plaats van hardware level, nooit nodig gehad maar klinkt wel handig!

ps. wat is dat toch met falende hardeschijven ik heb net een 4tb WD Blue na 11maanden gebruik mogen opsturen.

[ Voor 14% gewijzigd door H00GiE op 04-07-2017 14:30 ]

"Wat gebeurt er als ik ook dit knopje dr...."

Anders kun je ook nog vor een i3-3240 gaan, die zijn iets goekoper maar wel een hogere TDP. Die processoren ondersteunen ook ECC geheugen.GAITii schreef op zondag 2 juli 2017 @ 20:11:

Sta op het punt om een MicroServer Gen8 aan te schaffen.

Ik lees her en der dat het lukt om deze draaiende te krijgen i.c.m. een i5 3470T. Alleen zie ik in Intel ARK dat deze geen ECC ondersteund. Hoe zit dit dan precies?

Andere optie is een E3-1220v2 maar is al snel 70-80 euro duurder dan een 3470T.

[ Voor 4% gewijzigd door Praetorian op 12-07-2017 13:10 ]

Ik mis even het doel van je post en daarom doe ik er eentje achteraan

https://www.hpe.com/nl/en...ver-gen10.1009955118.html

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Nu valt mij in iLO op dat bij 'Information / System information / Storage', alle schijven het volgende aangeven:

Degraded (Smart error)

Dat vind ik niet heel prettig om te zien, iemand enig idee wat er aan de hand is?

S.M.A.R.T komt vanuit het OS, het lijkt erop dat het dus te maken heeft met ESXi 6.5.

[ Voor 11% gewijzigd door Praetorian op 20-07-2017 01:08 ]

Sinds een paar dagen staat hier een G1610T te ronken. Erg gaaf. Hij moet dienst gaan doen als NAS, download bak en knutselmachine. Dit wil ik via ESXi doen. Ik ben al een heel eind, maar zou graag mijn setup aan jullie voor willen leggen omdat ik - als behoorlijke leek - door de passthrough, sata ahci, iscsi en odd-drives het bos niet meer zie.

- ESXi 6.5 draait vanaf een USB-stick op het moederbord

- een SSD (120 gb) ingeprikt op de odd-drive, via de vrije sata poort op het moederbord. Sata controller op AHCI gezet in de bios, zodat de schijf zichtbaar is in ESXi.

- 1 datastore ter grootte van de volledige SSD. Hier wil ik de VMs laten draaien.

- een 3TB HDD in de 3.5" bay.

- 4 gb ram

Er draait nu 1 VM: Open Media Vault. Deze gebruikt 15gb van de datastore op de SSD en is de enige VM die direct toegang moet hebben tot de HDD. Daarom heb ik op deze schijf 1 datastore ter grootte vd hele schijf gemaakt en deze toegekend aan de VM. Dit lijkt te werken, OMV ziet de HDD en ik kan bestanden over het netwerk sturen. Bestanden van de Proliant downloaden gaat snel: 100 MB/s. Upload gaat nog te traag (20MB/s), maar dat zal vast een kwestie van finetunen zijn.

Mijn eerste gedachte was om de HDD via een pass through constructie aan OMV te geven, maar dat lijkt niet mogelijk te zijn. Ik begrijp hier eerlijk gezegd nog weinig van, maar vermoed dat dit komt omdat je eigenlijk de SATA-controller doorgeeft en daarmee ook de SSD waarop de VM draait? Ik kreeg het iig niet voor elkaar

Op wonderbaarlijke wijze de HDD als RDM doorgegeven aan OMV. Lees- en schrijfsnelheid ligt nu op 110+ MB/s bij een bestand van 10 gb!

Ben ik zo een beetje goed bezig? Of ben ik heel omslachtig aan het doen en kan het allemaal op een andere, betere manier?

[ Voor 4% gewijzigd door mr_MA op 20-07-2017 23:34 ]

De ODD connector is "maar" een SATA2 3G port, dus een snelle SSD is overbodig.mr_MA schreef op donderdag 20 juli 2017 @ 12:00:

Dag Proliant-goeroes,

Sinds een paar dagen staat hier een G1610T te ronken. Erg gaaf. Hij moet dienst gaan doen als NAS, download bak en knutselmachine. Dit wil ik via ESXi doen. Ik ben al een heel eind, maar zou graag mijn setup aan jullie voor willen leggen omdat ik - als behoorlijke leek - door de passthrough, sata ahci, iscsi en odd-drives het bos niet meer zie.

- ESXi 6.5 draait vanaf een USB-stick op het moederbord

- een SSD (120 gb) ingeprikt op de odd-drive, via de vrije sata poort op het moederbord. Sata controller op AHCI gezet in de bios, zodat de schijf zichtbaar is in ESXi.

- 1 datastore ter grootte van de volledige SSD. Hier wil ik de VMs laten draaien.

- een 3TB HDD in de 3.5" bay.

- 4 gb ram

Er draait nu 1 VM: Open Media Vault. Deze gebruikt 15gb van de datastore op de SSD en is de enige VM die direct toegang moet hebben tot de HDD. Daarom heb ik op deze schijf 1 datastore ter grootte vd hele schijf gemaakt en deze toegekend aan de VM. Dit lijkt te werken, OMV ziet de HDD en ik kan bestanden over het netwerk sturen. Bestanden van de Proliant downloaden gaat snel: 100 MB/s. Upload gaat nog te traag (20MB/s), maar dat zal vast een kwestie van finetunen zijn.

Mijn eerste gedachte was om de HDD via een pass through constructie aan OMV te geven, maar dat lijkt niet mogelijk te zijn. Ik begrijp hier eerlijk gezegd nog weinig van, maar vermoed dat dit komt omdat je eigenlijk de SATA-controller doorgeeft en daarmee ook de SSD waarop de VM draait? Ik kreeg het iig niet voor elkaar

Op wonderbaarlijke wijze de HDD als RDM doorgegeven aan OMV. Lees- en schrijfsnelheid ligt nu op 110+ MB/s bij een bestand van 10 gb!

Ben ik zo een beetje goed bezig? Of ben ik heel omslachtig aan het doen en kan het allemaal op een andere, betere manier?

En er is een probleem met de b120i (harddrive controller) driver (nog actueel?) in ESXi dat er voor zorgt dat de write speed om te huilen is. Ik weet niet zeker of dit in RDM nog steeds van toepassing is maar proberen kan geen kwaad.

De oplossing is/was de driver downgraden naar versie 088:

link voor meer info

Ikzelf ben geen fan van AHCI icm deze controller, ikzelf gebruik(te) losse schijven voor een RAID0 VirtualDisk, met dus de controller in raid modus. (Ja een Raid VD van één disk in RAID0 kan gewoon) ESXi "ziet" de disk dan ook als een normale schijf. In ILO krijgt de controller dan temperaturen van de disk doorgestuurd en zo blijft de koeler ook in auto mode kalm.

Ik heb inmiddels mijn G8 verkocht dus deze info is gebaseerd op ervaring van ruim anderhalf jaar geleden.

"Wat gebeurt er als ik ook dit knopje dr...."

Op je hardwarelaag RAID0 of RAID1 sets bestaande uit 1 disk bouwen word over het algemeen gezien als een Heel Slecht Idee (tm), zeker in combinatie met softraid. Nu heeft ESXi daar geen last van (ik meen dat het geen softraid kan) maar evengoed zet je er een laag tussen die geen enkele functie heeft en eigenlijk alleen maar nadelig is.H00GiE schreef op woensdag 26 juli 2017 @ 02:39:

[...]

Ikzelf ben geen fan van AHCI icm deze controller, ikzelf gebruik(te) losse schijven voor een RAID0 VirtualDisk, met dus de controller in raid modus. (Ja een Raid VD van één disk in RAID0 kan gewoon) ESXi "ziet" de disk dan ook als een normale schijf. In ILO krijgt de controller dan temperaturen van de disk doorgestuurd en zo blijft de koeler ook in auto mode kalm.

Technisch gezien werkt het, je OS krijgt gewoon enkele disks en kan op basis daarvan een RAID set bouwen of toegang wil krijgen tot enkele disks, maar je hebt een uitdaging als je die disks ooit 1:1 in een ander systeem met andere controller wilt stoppen.

Daarbij, maak je gebruik van iets als ZFS: ZFS wil direct toegang tot de disks, zonder welke vorm van inmenging van een RAID controller dan ook. (Dat is dus waarom ik daar waar ik ZFS gebruik op andere hardware dan een Microserver, zoals DL-series, ik de P410/P420 controller de prullenbak in heb gegooid en heb vervangen door een HBA. Meer specifiek: een LSI SAS 9207-8i.) Ik meen dat dit onder andere te maken heeft met het doorsturen van SMART waarden en die zijn best belangrijk.

De temperaturen kan ik helaas even niet nakijken. Daarvoor blijk je de Agentless Management Service (AMS) nodig te hebben en op FreeNAS zijn die voor zover ik kan vinden niet beschikbaar, op Proxmox heb ik ze domweg nog niet geïnstalleerd. (Ik weet wel dat onder andere hpacucli en hpasmcli het op Linux prima doen.)

Ná Scaoll. - Don’t Panic.

-Ankh- Camera Gear: Nikon D7000 | Nikon AF-S DX 16-85mm f3.5-5.6 AF-S DX VR & Tokina AT-X 116 Pro DX AF 11-16mm f2,8

FakeRaid Controllers mogen van mij compleet de prullenbak in, het is "gewoon" een intel chipset controller met een kanten randje van een firmware/driver.unezra schreef op woensdag 26 juli 2017 @ 06:58:

[...]

Op je hardwarelaag RAID0 of RAID1 sets bestaande uit 1 disk bouwen word over het algemeen gezien als een Heel Slecht Idee (tm), zeker in combinatie met softraid. Nu heeft ESXi daar geen last van (ik meen dat het geen softraid kan) maar evengoed zet je er een laag tussen die geen enkele functie heeft en eigenlijk alleen maar nadelig is.

Technisch gezien werkt het, je OS krijgt gewoon enkele disks en kan op basis daarvan een RAID set bouwen of toegang wil krijgen tot enkele disks, maar je hebt een uitdaging als je die disks ooit 1:1 in een ander systeem met andere controller wilt stoppen.

Daarbij, maak je gebruik van iets als ZFS: ZFS wil direct toegang tot de disks, zonder welke vorm van inmenging van een RAID controller dan ook. (Dat is dus waarom ik daar waar ik ZFS gebruik op andere hardware dan een Microserver, zoals DL-series, ik de P410/P420 controller de prullenbak in heb gegooid en heb vervangen door een HBA. Meer specifiek: een LSI SAS 9207-8i.) Ik meen dat dit onder andere te maken heeft met het doorsturen van SMART waarden en die zijn best belangrijk.

De temperaturen kan ik helaas even niet nakijken. Daarvoor blijk je de Agentless Management Service (AMS) nodig te hebben en op FreeNAS zijn die voor zover ik kan vinden niet beschikbaar, op Proxmox heb ik ze domweg nog niet geïnstalleerd. (Ik weet wel dat onder andere hpacucli en hpasmcli het op Linux prima doen.)

Het gaat ook niet om RAID, het gaat puur en alleen om een logische disk aanmaken in die controller, om zo bepaalde situaties/problemen te voorkomen.

Daarnaast vraagt @mr_MA om specifiek de support van de controller in ESXi, en die is Kortom Uitermate Teleurstellend. Maar op deze ducttape en tywrap manier kan het prima! Ik heb voor 2 jaar lang zo mijn MS G8 ~120MB/s aan data over samba naar windows PC-tjes laten knallen.

NOTE: Wanneer je de B120i in windows gebruikt is er ook gewoonweg geen probleem met doorvoersnelheid.

Zoals gezegt gaat het niet om een raidset bouwen bovenop de fakeraid logical disks (dat is inderdaad af te raden!!), het gaat ook niet om een mogelijke migratie. (En iedereen weet zou moeten weten dat je geen RAID1 set kan maken met een enkele disk...

Een goede ICT-er maakt backups, en als het op een migratie aankomt naar een compleet andere controller, prefereer ik een "schone" setup en migreer ik de data. Een upgrade naar nieuwe controller gaat bij mij bijna altijd gepaard met upgrade van capaciteit van drives.. Er moet namelijk een hele goede reden zijn om tussen controllers te (moeten) migreren.

Overigens kun je de raid0 logische disks van een B1xxi gewoon 1:1 naar een p222 en/of p420 migreren. (naar andere HP controllers uit een soortgelijke generatie moet ook kunnen.) Data en Metadata van de "array" blijft gewoon behouden. Letterlijk de mini-sas connector uit het moederbord in de nieuwe controller en weer verder.

Ik gebruikte de LSI 9260 4i in de G8 en gebruik nu een Cisco RAID9271CV-8i in mijn ML10v2 (ook een lsi) en zelfs daar had ik wat migratie problemen. één schijf bezweek zelfs tijdens het migreren. Ook hier waren backups cruciaal, 32 uur en een rebuild later (8tb+ migratie) was de server weer bereikbaar.

Dat kan wel eens behoorlijk goed uitpakken, wist je dat je deze kaarten kan flashen zodat je een hogere queue depth krijgt, dit kan zorgen voor hogere IOPS van je pool.Ankh schreef op woensdag 26 juli 2017 @ 09:29:

Ik heb een Dell H310 HBA (LSI) gekocht, deze heeft 8x SATA. Ga dit inrichten met 2x SSD in ZFS Mirror en 4x xTB in RAIDz. Eens zien hoe dit performt.

Meer info

[ Voor 6% gewijzigd door H00GiE op 26-07-2017 11:41 . Reden: reactie op ankh ]

"Wat gebeurt er als ik ook dit knopje dr...."

Op een extra P212/256 MB Controller heb ik 4 schijven met elk 4 Tb in raid 5 aangesloten. Hierop staan al mijn foto's en media.

Sinds afgelopen weekend ben ik klaar met het overzetten van alle data. Nu zijn er een aantal zaken die me opvallen.

- De Microserver is niet echt stil. De ventilator is best hoorbaar. Hoe kan ik die stiller krijgen?

- Ik heb het idee dat de 4 schijven constat blijven draaien. Is er een mogelijkheid om ze "stil" te zetten. Op google lees ik eea over spindown. Maar als ik het enegrie schema in Windows aanpas en de schijven na X minuten uit wil laten gaan dan gebeurd dat volgens mij niet.

- Ik kan de server via een taak wel uit laten gaan, maar hoe krijg ik 'm dan weer aan? Wil de server eigenlijk rond 18:00 aan laten gaan en dan na middernacht weer uit. Ook al eea gelezen over de powerstate in het bios en een tijdschakel klok. Maar is dat iets wat de server wel lekker vindt?

Tijdklok functie in de bios heeft de Gen 8 niet. Je kan hem een power on geven via de iLO interface of via WOL!Sparkiee schreef op woensdag 26 juli 2017 @ 11:30:

Ik heb sinds een paar weken een Microserver Gen8. Geweldig ding. Heb er 12 Gb ram in zitten en een Intel Xeon E3-1220 v2. Werkt geweldig, hele verbetering ten opzichte van de Synology 212. Op de aansluiting van de cdrom heb ik een SSD aangesloten met daarop Windows server 2012 R2. In AHCI modus.

Op een extra P212/256 MB Controller heb ik 4 schijven met elk 4 Tb in raid 5 aangesloten. Hierop staan al mijn foto's en media.

Sinds afgelopen weekend ben ik klaar met het overzetten van alle data. Nu zijn er een aantal zaken die me opvallen.

- De Microserver is niet echt stil. De ventilator is best hoorbaar. Hoe kan ik die stiller krijgen?

- Ik heb het idee dat de 4 schijven constat blijven draaien. Is er een mogelijkheid om ze "stil" te zetten. Op google lees ik eea over spindown. Maar als ik het enegrie schema in Windows aanpas en de schijven na X minuten uit wil laten gaan dan gebeurd dat volgens mij niet.

- Ik kan de server via een taak wel uit laten gaan, maar hoe krijg ik 'm dan weer aan? Wil de server eigenlijk rond 18:00 aan laten gaan en dan na middernacht weer uit. Ook al eea gelezen over de powerstate in het bios en een tijdschakel klok. Maar is dat iets wat de server wel lekker vindt?

Owner of DBIT Consultancy | DJ BassBrewer

De grote fan wordt gewoon bestuurd via de ACPI. Dus kan je met een fancontrol tooltje instellen. Ook in iLO heb je 3 opties (zo stil mogelijk, gemiddeld, best mogelijke koeling). Pas natuurlijk wel op voor oververhitting.Sparkiee schreef op woensdag 26 juli 2017 @ 11:30:

- De Microserver is niet echt stil. De ventilator is best hoorbaar. Hoe kan ik die stiller krijgen?

De kleine voedingsfan is echter totaal niet te besturen via software. De BIOS/ILO kan hem niet eens monitoren. Dus daar is niets aan te doen tenzij je je garantie op wil geven en met de hardware aan de slag wil gaan.

Vooral dat soort kleine fannetjes zijn vaak flinke herriebakken en deze valt op zich nog wel mee maar ik denk dat hij de grote wel overstemt als je de grote in stille modus zet. Ik heb de mijne op gemiddeld staan dus ik weet het niet precies.

Dit is één van de dingen die door onder andere AHCI modus zich voordoen.Sparkiee schreef op woensdag 26 juli 2017 @ 11:30:

Ik heb sinds een paar weken een Microserver Gen8. Geweldig ding....

...Sinds afgelopen weekend ben ik klaar met het overzetten van alle data. Nu zijn er een aantal zaken die me opvallen.

- De Microserver is niet echt stil. De ventilator is best hoorbaar. Hoe kan ik die stiller krijgen?

INFO

TRIM word in raid modus "gewoon" ondersteund in Windows server als de B120i drivers zijn geinstalleerd!

De p212 controller komt niet voor in de HCL, staat deze controller wel in ILO tussen hardware?

Als dat niet zo is kan ILO geen temperatuur van de hardware uitlezen, ILO beheerd de fanspeed en maakt dan aanpassingen om veiligheid en werkbare temperatuur te garanderen. Beetje het verhaal wat ik @mr_MA al vertelde.

Daarnaast gebruik je (tenzei dit een typfout is) de "warme" variant van de E3-1220 met een TDP van 69w niet de E3-1220L (tdp 17 W) dus is de server daadwerkelijk warm en die warmte moet wel afgevoerd worden.

[ Voor 39% gewijzigd door H00GiE op 28-07-2017 04:23 . Reden: cpu verhaal / TRIM ]

"Wat gebeurt er als ik ook dit knopje dr...."

Eens. FakeRaid moet dood.H00GiE schreef op woensdag 26 juli 2017 @ 11:23:

[...]

FakeRaid Controllers mogen van mij compleet de prullenbak in, het is "gewoon" een intel chipset controller met een kanten randje van een firmware/driver.

Er is ook geen enkel excuus om FakeRaid te gebruiken. Software RAID is meer dan prima (in fact, ik denk dat het in het overgrote deel van de gevallen beter is dan hardware RAID) en FakeRaid is niet eens een net-niet oplossing.

De ellende is dat je dan dus de RAID functionaliteit van de controller inschakeld en AHCI uit. Juist AHCI is in veel gevallen wat je wilt. Je kunt (zeker met ZFS) veel beter je disks aan een cheap-ass AHCI SATA controller hangen dan d'r FakeRaid tussen plakken.Het gaat ook niet om RAID, het gaat puur en alleen om een logische disk aanmaken in die controller, om zo bepaalde situaties/problemen te voorkomen.

Ik vind het een bijzondere oplossing zeg maar. Zou de oplossing eerder zoeken in een betere ondersteuning van de AHCI mode, dan mock arrays van 1 disk aanmaken en die aan je OS aanbieden.

Iedere ICTer weet ook dat je een controller *OF* in IT-mode / als HBA moet gebruiken *OF de volledige RAID functionaliteit moet inzetten. Niet RAID0/1 "arrays" van 1 disk op je controller aanmaken om die vervolgens via je OS aan te sturen of daar een RAID set van aan te maken.Daarnaast vraagt @mr_MA om specifiek de support van de controller in ESXi, en die is Kortom Uitermate Teleurstellend. Maar op deze ducttape en tywrap manier kan het prima! Ik heb voor 2 jaar lang zo mijn MS G8 ~120MB/s aan data over samba naar windows PC-tjes laten knallen.

NOTE: Wanneer je de B120i in windows gebruikt is er ook gewoonweg geen probleem met doorvoersnelheid.

Zoals gezegt gaat het niet om een raidset bouwen bovenop de fakeraid logical disks (dat is inderdaad af te raden!!), het gaat ook niet om een mogelijke migratie. (En iedereen weet zou moeten weten dat je geen RAID1 set kan maken met een enkele disk...)

Met md en andere softraid technieken gaat dat in de praktijk prima (maar je hebt opeens wel een vendor lock-in op je hardware, die disks MOETEN aan een HP RAID controller gehangen worden), met ZFS is het meer dan onverstandig omdat je SMART waardes niet meer doorkomen en ZFS daar dingen mee doet. (Maar ook zonder ZFS, je wil je SMART waardes van je disk kunnen uitlezen en niet een controller er tussen hebben zitten die probeert intelligent te doen.)

In een bedrijfssituatie, zeker, maar dit is het Microserver topic. Microservers worden over het algemeen thuis en in kleine bedrijven ingezet. Los van dat je hoe dan ook ook dan voor backups moet zorgen, als zo'n Microserver breekt wil ik de disks kunnen overschroeven in een willekeurig ander systeem met SATA poorten en doordraaien. Een afhankelijkheid van een HP RAID controller is dan niet heel prettig.Een goede ICT-er maakt backups, en als het op een migratie aankomt naar een compleet andere controller, prefereer ik een "schone" setup en migreer ik de data. Een upgrade naar nieuwe controller gaat bij mij bijna altijd gepaard met upgrade van capaciteit van drives.. Er moet namelijk een hele goede reden zijn om tussen controllers te (moeten) migreren.

Bedrijfsmatig ga ik nu een paar DL20's inzetten, die heeft nagenoeg dezelfde controller en die kan gelukkig ook in AHCI mode. Iets dat bij duurdere systemen niet kan. Je hebt dan vaak weinig keuze een losse HBA te kopen.

Backups zijn altijd noodzakelijk maar als mijn complete server sterft, wil ik de disks kunnen overprikken zonder meteen naar mijn backups te moeten grijpen.Overigens kun je de raid0 logische disks van een B1xxi gewoon 1:1 naar een p222 en/of p420 migreren. (naar andere HP controllers uit een soortgelijke generatie moet ook kunnen.) Data en Metadata van de "array" blijft gewoon behouden. Letterlijk de mini-sas connector uit het moederbord in de nieuwe controller en weer verder.

Ik gebruikte de LSI 9260 4i in de G8 en gebruik nu een Cisco RAID9271CV-8i in mijn ML10v2 (ook een lsi) en zelfs daar had ik wat migratie problemen. één schijf bezweek zelfs tijdens het migreren. Ook hier waren backups cruciaal, 32 uur en een rebuild later (8tb+ migratie) was de server weer bereikbaar.

Dus nee, ik vind het geen goed idee. Gewoon die controller in AHCI mode zetten en direct de disks aansturen.

Ná Scaoll. - Don’t Panic.

Daarom had ik hem ook gekocht ;-)H00GiE schreef op woensdag 26 juli 2017 @ 11:23:

[...]

[...]

Dat kan wel eens behoorlijk goed uitpakken, wist je dat je deze kaarten kan flashen zodat je een hogere queue depth krijgt, dit kan zorgen voor hogere IOPS van je pool.

Meer info

-Ankh- Camera Gear: Nikon D7000 | Nikon AF-S DX 16-85mm f3.5-5.6 AF-S DX VR & Tokina AT-X 116 Pro DX AF 11-16mm f2,8

In AHCI zetten heeft als gevolg dat de fan hoorbaar is.unezra schreef op woensdag 26 juli 2017 @ 12:11:

[...]

Backups zijn altijd noodzakelijk maar als mijn complete server sterft, wil ik de disks kunnen overprikken zonder meteen naar mijn backups te moeten grijpen.

Dus nee, ik vind het geen goed idee. Gewoon die controller in AHCI mode zetten en direct de disks aansturen.

Als een complete gen8 omvalt, dan lijkt het mij logisch dat je die met een zelfde server vervangt (gezien de kleine kans op sterven en de garantie/reparatie mogelijkheden) en dan kun je dus 1:1 migreren, zonder dataverlies.

Wederom je hebt niet ongelijk, zeker niet. Echter zou ik de lelijke oplossing kiezen om zo andere zaken te voorkomen, daarnaast gebruik ik zelf geen ZFS, en is daarom mijn mening misschien gekleurd.

Als "Raid mode" negatieve impact heeft voor ZFS (zoals je al zei), en je gebruikt ZFS, dan is "Raid mode" inderdaad een slecht plan. Maar ik kan niet inzien welke impact dat zou moeten hebben (en ik moet nog steeds lachen als ik RAID in context met de B120i noem...)

In dit geval door de juiste ESXi's drivers te gebruiken is er 100% support, en met RDM zit je in principe al met een (dunne) "laag" van ESXi ertussen. RDM is geen hardware passthrough!

"Wat gebeurt er als ik ook dit knopje dr...."

Dat mis ik nu eigenlijk best.

[ Voor 10% gewijzigd door Praetorian op 27-07-2017 00:01 ]

Moet even wat stroom kabeltjes hebben voor de 2 SSDs. Zit te kijken op Startech bijvoorbeeld, maar ben vergeten vanochtend te kijken...

-Ankh- Camera Gear: Nikon D7000 | Nikon AF-S DX 16-85mm f3.5-5.6 AF-S DX VR & Tokina AT-X 116 Pro DX AF 11-16mm f2,8

Nul. Als je de grote 4-pin molex connectoren bedoelt.Ankh schreef op donderdag 27 juli 2017 @ 09:07:

Hmm, ik ben nu op het werk. Maar weet iemand hoeveel vrije power kabels er nog standaard zijn?

Moet even wat stroom kabeltjes hebben voor de 2 SSDs. Zit te kijken op Startech bijvoorbeeld, maar ben vergeten vanochtend te kijken...

Er is alleen een kleine 'floppy drive stijl' power connector bovenin in de optical bay.

https://www.newegg.com/Pr...aspx?Item=N82E16812198025

https://www.newegg.com/Pr...aspx?Item=N82E16812816015

-Ankh- Camera Gear: Nikon D7000 | Nikon AF-S DX 16-85mm f3.5-5.6 AF-S DX VR & Tokina AT-X 116 Pro DX AF 11-16mm f2,8

Dank voor jullie uitgebreide reacties. (Ik was even op vakantie, excuus voor de traagheid)H00GiE en unezra schreven erg veel nuttige dingen, ondere andere op woensdag 26 juli 2017 @ 02:39:

Ikzelf ben geen fan van AHCI icm deze controller, ikzelf gebruik(te) losse schijven voor een RAID0 VirtualDisk, met dus de controller in raid modus. (Ja een Raid VD van één disk in RAID0 kan gewoon) ESXi "ziet" de disk dan ook als een normale schijf. In ILO krijgt de controller dan temperaturen van de disk doorgestuurd en zo blijft de koeler ook in auto mode kalm.

Nav het verhaal van H00GiE heb ik de boel eens op basis van de RAID0-setup opgetuigd. Zoals jullie al zeiden, zitten er voor- en nadelen aan deze setup. Het leek mij wel prettig dat je zonder tweaks (schijven RDM doorgeven) de boel kan draaien. Helaas viel de schrijf- en leessnelheid tegen, ook met de oude driver. Dit zijn mijn testresultaten - mocht iemand deze route ook willen bewandelen:

default driver in ESXI 6.5

write = 45 MB/s

read = 60 MB/s

driver versie 088

write = 65 MB/s

read = 112 MB/s

AHCI + vmfs

write = 20 MB/s

read = 100 MB/s

AHCI + RDM

write = 110 MB/s

read = 110 MB/s

De AHCI + RDM optie geeft de meest stabielere snelheid, erg weinig fluxtuatie. De andere setups schommelen nogal heen en weer.

Gezien het bovenstaande gaat ik de boel verderop zetten op basis van de RDM-optie. Begrijp ik het nou goed dat RDM een soort (psuedo-)passthrough is? Betekent dit dat als ik de schijf uit de machine haal, ik hem in een andere machine zou kunnen prikken? Dit is niet noodzakelijk, maar natuurlijk wel een mooi bijkomend voordeel...

Definitieve gegevens Erg netjes!mr_MA schreef op maandag 31 juli 2017 @ 09:56:

[...]

De AHCI + RDM optie geeft de meest stabielere snelheid, erg weinig fluxtuatie. De andere setups schommelen nogal heen en weer.

Gezien het bovenstaande gaat ik de boel verderop zetten op basis van de RDM-optie. Begrijp ik het nou goed dat RDM een soort (psuedo-)passthrough is? Betekent dit dat als ik de schijf uit de machine haal, ik hem in een andere machine zou kunnen prikken? Dit is niet noodzakelijk, maar natuurlijk wel een mooi bijkomend voordeel...

Wat ik nog bedenk, is heb je ook nog VD (raidmode) + RDM geprobeerd? of was dat je opstelling in de 088 driver mode? En heb je hardware buffer van de hardeschijven zelf aanstaan?? dit is een optie "Physical drive write cache" die je in de B120i raid config aan/uit kan zetten. Het lijkt erop met een drastisch lagere writespeed in raid mode dat die nog uitstaat.

Normaal gesproken als je een BBWC gebruikt kun je dit beter uitzetten, maar aangezien deze B120i ZM controller geen BBWC module slot heeft kun je de disk cache wel aanzetten. Risico is dat als de stroom uitvalt de cache leeg is en niet meer word weggeschreven, maar dat is in AHCI modus ook.

Ik ben eigenlijk wel nieuwsgierig hoe de performance is in raid mode met cache aan, en RDM.

Om terug te komen op je laatste vraag:

Ik heb zelf nog (ja dit gaat zeker nog gebeuren) te weinig met RDM gespeeld om 100% garantie te geven.

Maar zoals de theorie doet lijken, is AHCI + RDM volledig te gebruiken in een ander systeem (zelfs zonder ESXi en zonder HP controller)

Het rare is dat het op zich geen ████ zou mogen uitmaken AHCI of "RAID".

Je definieert een VD in die controller en ESXi snapt wat die met deze fysieke hardware aan moet.

(ook al zit hier die B120i tussen en een "driver" in ESXi)

RDM "mount" de volledige disk als VMDK container in ESXi.

ESXi gebruikt deze VMDK container weer in een VM als virtual disk en voegt daar een virtuele controller aan toe.

Een soort omgekeerde ISO: je mount een volledige partitie in een ISO en gebruikt het ISO bestand als virtuele disk. maar dan nu in R/W.

Je guest os (OMV) gebruikt dus een "vmware harddisk" aangesloten op een "vmware controller" en OMV geeft dus geen ████ om de fysieke hardware, dat doet ESXi

Ook ik heb nog h.e.e.a. nagekeken, de "bug"/feature dat als je de B120i controller uitzet, in AHCI en/of Legacy modus zet. de koeler met ?% word verhoogt zit zelfs in de allernieuwste ILO nog. Ook in de ML10 v2 servers. Ik gebruik de mijne totaal niet (LSI hw raid controller) maar heb 'm toch weer aangezet ivm fannoise!

[ Voor 15% gewijzigd door H00GiE op 31-07-2017 17:54 . Reden: FAN speed > B120i uit/AHCI/Legacy ]

"Wat gebeurt er als ik ook dit knopje dr...."

In dit topic horen alleen posts die betrekking hebben op HP Proliant Microservers. Onderwerpen als Synology/DSM en andere software horen hier niet thuis. Daarvoor graag in één van de Synology-topics posten. Berichten die off-topic zijn, kunnen worden getrashed.

:fill(white):strip_exif()/i/1371482327.jpeg?f=thumbmini)

:strip_exif()/i/2003756140.png?f=thumbmini)

:strip_exif()/i/2001654217.png?f=thumbmini)

:strip_exif()/i/2001630527.png?f=thumbmini)

:strip_exif()/i/2003456294.png?f=thumbmini)

:fill(white):strip_exif()/i/2003408610.jpeg?f=thumbmini)

:strip_exif()/i/2000899002.png?f=thumbmini)

:fill(white):strip_exif()/i/1304324994.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/1316014661.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/1370864779.jpeg?f=thumbmini)

:strip_exif()/u/119419/candc-60px.gif?f=community)

:strip_icc():strip_exif()/u/220842/crop584a90da6a595_cropped.jpeg?f=community)

/u/399077/crop5f1a98d8e9810_cropped.png?f=community)

/u/472627/crop5c83fe498b36e_cropped.png?f=community)

/u/327851/crop5aab95025cb0f_cropped.png?f=community)

/u/433/crop6746d51e1326a_cropped.png?f=community)

/u/121080/crop632d58c9f0cb4_cropped.png?f=community)

:strip_icc():strip_exif()/u/39096/crop5fb857f77b5aa_cropped.jpeg?f=community)

/u/115333/crop5f45784fcadad_cropped.png?f=community)

:strip_icc():strip_exif()/u/256183/crop5dc1ab4c09642_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/283762/crop58ea960fe514b_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/55461/88047.jpg?f=community)

:strip_icc():strip_exif()/u/295418/crop66c10595e4370_cropped.jpg?f=community)

:strip_exif()/u/282584/crop5a01958bebd01_cropped.gif?f=community)

:strip_icc():strip_exif()/u/373953/shin.jpg?f=community)

:strip_icc():strip_exif()/u/338322/crop65815b314a173.jpg?f=community)

:strip_icc():strip_exif()/u/740253/crop573df752b44e6_cropped.jpeg?f=community)

:strip_exif()/u/197379/crop607027f64d181.gif?f=community)