Bedenk wel dat alle vermelde prijzen exclusief BTW zijn. Ook zijn de vermelde prijzen bij servers alleen voor de kale behuizing, en zodra je dus processors, voedingen, schijven, controllers, geheugen etc. gaat toevoegen het vaak allemaal best duur wordt...thibautb schreef op donderdag 02 oktober 2014 @ 19:14:

heeft er iemand ervaring met http://www.serverhome.nl/ want die hebben wel heel wat scherpe prijzen.

Ik ben wel benieuwd naar de uitkomst, ZFS is toch juist gemaakt om deze corruptie te herstellen uit de pariteit data?MrBarBarian schreef op woensdag 01 oktober 2014 @ 17:16:

[...]

code:

pool: media state: ONLINE status: One or more devices has experienced an error resulting in data corruption. Applications may be affected. action: Restore the file in question if possible. Otherwise restore the entire pool from backup. see: http://zfsonlinux.org/msg/ZFS-8000-8A scan: scrub in progress since Wed Oct 1 14:50:48 2014 2.38T scanned out of 4.20T at 289M/s, 1h49m to go 0 repaired, 56.75% done

Hopelijk fixed de scrub het. Anders een mooie reden om de pools weer eens opnieuw te organiseren

Een scrub fixt alleen data met terugwerkende kracht, als deze nog niet is ingelezen.

Zodra data ingelezen wordt, wordt de checksum gecontroleerd, en zo nodig door via copies=2, mirrors of via RAIDZ(1/2) redundancy een fix uitgevoerd.

Dus als jij een melding ziet, er is corrupte data aan applicaties geleverd (of juist expres niet dus) gaat een scrub dat niet meer fixen...

Zodra data ingelezen wordt, wordt de checksum gecontroleerd, en zo nodig door via copies=2, mirrors of via RAIDZ(1/2) redundancy een fix uitgevoerd.

Dus als jij een melding ziet, er is corrupte data aan applicaties geleverd (of juist expres niet dus) gaat een scrub dat niet meer fixen...

[ Voor 81% gewijzigd door FireDrunk op 03-10-2014 11:30 ]

Even niets...

Helder, maar hoe is die data dan corrupt geraakt? Waarom zou ZFS deze niet eerder hebben kunnen herstellen?

In mijn geval is er een disk kapot gegaan. Deze heb ik vervangen, waarna deze melding verscheen. Het betreffende bestand heb ik verijderd, maar de melding bleef komen. Een scrub fixte steeds enkele mb's. Uiteindelijk heb ik de pool opnieuw gemaakt.Extera schreef op vrijdag 03 oktober 2014 @ 11:51:

Helder, maar hoe is die data dan corrupt geraakt? Waarom zou ZFS deze niet eerder hebben kunnen herstellen?

Ik vermoed dat de oorzaak van het probleem is dat de meeste schijven in de pool een sector size hadden van 512 byte en de nieuwe 4048 byte heeft. Ashift gezet, maar toen dus helaas dit probleem.

Ik zit/zat met het 'probleem' dat ik aardig wat oude schijven heb, waardoor het een beetje een warboel is allemaal.

Of de file zijn corrupt geraakt terwijl de pool Degraded was? Wel 'toeval' maargoed.

Wel balen!

Ook een voorbeeld hoe RAID geen backup is.

Was je nog in staat om de niet corrupte data van de pool te halen?

Backuppen is echt een probleem met zulke grote pools

Wel balen!

Ook een voorbeeld hoe RAID geen backup is.

Was je nog in staat om de niet corrupte data van de pool te halen?

Backuppen is echt een probleem met zulke grote pools

Het kan zijn dat een schijf corrupte data bevat en dat deel van een file nog niet gelezen is. Vooral databases lezen met grote offsets in files, waardoor grote delen van files (databases) niet aangeraakt hoeven worden.

Als je een file verwijderd, en er ontstaan nieuwe corrupte delen in andere files, is er wat anders aan de hand.

Als je een file verwijderd, en er ontstaan nieuwe corrupte delen in andere files, is er wat anders aan de hand.

Even niets...

aha!

Dus regelmatig scrubben had dit tijdig kunnen detecteren en repareren.

Dus regelmatig scrubben had dit tijdig kunnen detecteren en repareren.

Ik scrub wekelijks  Ik denk dus niet dat de file al corrupt was of gedurende de tijd dat dit gebeurt is toen de pool degradaded was.

Ik denk dus niet dat de file al corrupt was of gedurende de tijd dat dit gebeurt is toen de pool degradaded was.

Rest van de bestanden in de pool waren overigens prima in orde.

Rest van de bestanden in de pool waren overigens prima in orde.

Ik zal ook eens een duit in het zakje doen, met onderstaande hekkensluiter

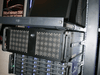

Mijn oude server bestond uit een Q6600 en 8GB memory, een Highpoint 2340 met 8x1TB in Raid5.

Daarnaast had ik een losse VMware server met gelijke hardware. Deze beide vervangen door een alles in 1 build.

Supermicro X9SCM-IIF, 32GB ECC Mem, Intel Xeon 1230v2 en een IBM 1015 met de 5x4TB's via passtrough doorgegeven een VMware.

Dit heeft stabiel en naar tevredenheid gedraaid, de FreeNAS VM nam echter 8GB memory in beslag, waardoor ik besluit de boel weer uit elkaar te trekken.

Het Asrock B75 bord diende toen met de 8x 1TB en 16GB memory als backup server. Deze 2 heb ik toen omgebouwd naar de huidige build.

Na veel google een geschikte, en betaalbare kaart gevonden welke door zowel ESX als FreeBSD worden ondersteund.

Read /Write performance is rond de 500 MB/s over iSCSI.

NFS is een ander verhaal. Na wat tuning haal ik hier nu +- 80MB/s Write, 550MB/s read.

De koppeling naar mijn LAN is uit noodzaak gedaan via PCI kaarten.

2 Intel Pro 1000GT's vormen een channel naar mijn LAN switch (HP 2900)

Het Asrock bord heeft slecht 2 PCI-E 16x sloten. Deze zijn nu beide in gebruik door de 10Gb NIC en de IBM HBA.

Ik twijfel nog over een upgrade van het moederbord.

Eigenlijk wil ik een supermicro met IPMI en ECC, dit is echter weer een kostbare upgrade.

Mogelijk kies ik voor een desktop board met meer PCI-E sloten zodat ik in ieder geval de storage kan upgraden (extra HBA)

en de 2 Intel PCI NICs kan vervangen voor een Quadport NIC.

De VMware server zit in een Ri-vier RV-416N waar de fans van zijn vervangen door Noiseblockers.

Dit geld ook voor de fans van de RVS4-06A. De fans van de HP 2900 heb ik zelf vervangen voor stille 40mm fans.

Het bovenste patchpaneel heeft 24 CAT6 kabels afgemonteerd, de andere kant van deze bundel zijn RJ45 afgemonteerd.

Een server sluit ik aan op de bundel, waarna ik hem patch op de HP switch.

Het onderste paneel is voor de toekomst, daar komen de aansluitingen van de huis-bekabeling op.

Edit: 5x 4TB toegevoegd aan de pool.

2x 5x4TB zRaid nu

| System specifications | |

| Component | Value |

|---|---|

| Case | Ri-vier RVS4-06A |

| Processor | Intel Celeron G2020 |

| RAM | 24 GB |

| Motherboard | ASRock B75 Pro3-MM |

| LAN | Myricom 10G-PCIE-8A-C (B2B iSCSI to VMware)) |

| LAN | 2x Intel Gigabit Pro 1000GT (Channel to LAN) |

| PSU | Seasonic G-Serie 450Watt |

| Controller | IBM M1015 |

| Disk | 5 x Seagate Desktop HDD.15 4TB (zRaid) |

| Disk | 5 x WD Green WD40EZRX (zRaid) |

| SSD | 2 x Crucial M500 120GB |

| Brutto storage | 40 TB |

| Netto storage | 28,5 TiB |

| OS | FreeNAS 9.2.7 |

| Filesystem | ZFS |

| Rebuild time | ZFS: depends on used space. |

| UPS | Back-UPS CS 450 |

| Power usage | Around 100w |

| Pic's | ||

|  |  |

|  | |

Intro

De build is langzaam geevolueerd in de staat waar hij nu in is.Mijn oude server bestond uit een Q6600 en 8GB memory, een Highpoint 2340 met 8x1TB in Raid5.

Daarnaast had ik een losse VMware server met gelijke hardware. Deze beide vervangen door een alles in 1 build.

Supermicro X9SCM-IIF, 32GB ECC Mem, Intel Xeon 1230v2 en een IBM 1015 met de 5x4TB's via passtrough doorgegeven een VMware.

Dit heeft stabiel en naar tevredenheid gedraaid, de FreeNAS VM nam echter 8GB memory in beslag, waardoor ik besluit de boel weer uit elkaar te trekken.

Het Asrock B75 bord diende toen met de 8x 1TB en 16GB memory als backup server. Deze 2 heb ik toen omgebouwd naar de huidige build.

Networking

Omdat ik de maximale performance wilde halen heb ik besloten om een directe koppeling te maken naar mijn VMware server.Na veel google een geschikte, en betaalbare kaart gevonden welke door zowel ESX als FreeBSD worden ondersteund.

Read /Write performance is rond de 500 MB/s over iSCSI.

NFS is een ander verhaal. Na wat tuning haal ik hier nu +- 80MB/s Write, 550MB/s read.

De koppeling naar mijn LAN is uit noodzaak gedaan via PCI kaarten.

2 Intel Pro 1000GT's vormen een channel naar mijn LAN switch (HP 2900)

Toekomst

De huidige setup heeft een flink aantal beperkingen, dit komt omdat het systeem zo gegroeid is.Het Asrock bord heeft slecht 2 PCI-E 16x sloten. Deze zijn nu beide in gebruik door de 10Gb NIC en de IBM HBA.

Ik twijfel nog over een upgrade van het moederbord.

Eigenlijk wil ik een supermicro met IPMI en ECC, dit is echter weer een kostbare upgrade.

Mogelijk kies ik voor een desktop board met meer PCI-E sloten zodat ik in ieder geval de storage kan upgraden (extra HBA)

en de 2 Intel PCI NICs kan vervangen voor een Quadport NIC.

Extra info

Het 19inch rack heb ik nieuw op de kop getikt via marktplaats. Echt een gelukstreffer voor € 350,-De VMware server zit in een Ri-vier RV-416N waar de fans van zijn vervangen door Noiseblockers.

Dit geld ook voor de fans van de RVS4-06A. De fans van de HP 2900 heb ik zelf vervangen voor stille 40mm fans.

Het bovenste patchpaneel heeft 24 CAT6 kabels afgemonteerd, de andere kant van deze bundel zijn RJ45 afgemonteerd.

Een server sluit ik aan op de bundel, waarna ik hem patch op de HP switch.

Het onderste paneel is voor de toekomst, daar komen de aansluitingen van de huis-bekabeling op.

Edit: 5x 4TB toegevoegd aan de pool.

2x 5x4TB zRaid nu

[ Voor 7% gewijzigd door Extera op 16-10-2014 22:28 ]

Netjes! Hoe bevalt de RVS4-06A jou? Stevig? Heb je toevallig ook een foto van de backplanes?

Thanks!

De kast bevalt prima, het enige nadeel vind ik de rails, de kast kan niet ver genoeg uit het rack om bijvoorbeeld een insteekkaart te vervangen. Bouwkwaliteit vind ik, voor een thuisserver voldoende.

Ik heb wel de fans vervangen, de kast is standaard best een herrieschopper. Ook het feit dat je 8x 4 pins molex nodig hebt is een nadeel vind ik.

Foto's van de backplane heb ik niet, en zijn lastig te maken nu kast in het rack zit.

De kast bevalt prima, het enige nadeel vind ik de rails, de kast kan niet ver genoeg uit het rack om bijvoorbeeld een insteekkaart te vervangen. Bouwkwaliteit vind ik, voor een thuisserver voldoende.

Ik heb wel de fans vervangen, de kast is standaard best een herrieschopper. Ook het feit dat je 8x 4 pins molex nodig hebt is een nadeel vind ik.

Foto's van de backplane heb ik niet, en zijn lastig te maken nu kast in het rack zit.

juist een voordeel lijkt mij kun je mooi zelf kabeltjes voor in elkaar zetten?Extera schreef op donderdag 09 oktober 2014 @ 23:22:

Ook het feit dat je 8x 4 pins molex nodig hebt is een nadeel vind ik.

Ik heb kabeltjes bij seasonic bij gevraagd, deze kreeg ik nog gratis toegezonden ook!

Leuke build, ik ben stront jaloers op je rack, dat is echt precies wat ik zoek.

Wat zijn je HDD temps als ze draaien?

Wat zijn je HDD temps als ze draaien?

Thanks! Dat was echt een gelukstreffer!

Ik heb eerder een rack gehad, een 2e hands, wit, met beschadigingen...

uiteindelijk besloot ik pas weer een rack in huis te halen als tenminste zwart zou zijn en een beetje mooi zou tonen. Deze gaat nooit meer weg.

De disktemps zijn ongeveer 35 graden.

/me extera is bij! zojuist 5 extra 4 TB disks besteld!

Ik heb eerder een rack gehad, een 2e hands, wit, met beschadigingen...

uiteindelijk besloot ik pas weer een rack in huis te halen als tenminste zwart zou zijn en een beetje mooi zou tonen. Deze gaat nooit meer weg.

De disktemps zijn ongeveer 35 graden.

/me extera is bij! zojuist 5 extra 4 TB disks besteld!

[ Voor 9% gewijzigd door Extera op 11-10-2014 21:55 ]

Verwijderd

Heren en dames,

Ik kan deze mooie 80 basy case inkopen en wil graag weten of er interesse voor is.

In deze case kunnen 2x ATX PSU en het onderste gedeelte is zoals onze normale servercase RVS3-06A.

De backplanes zijn allemaal met 4x sata aansluiting (per backplane) en daar hebben we natuurlijk mooie kabels voor van sata naar mini sas voor de sas expanders etc.

De prijs ligt rond de 1750 EUR excl BTW. Als er interesse is en er zijn mensen die willen reserveren met een vooruit betaling is er een actie prijs die nog vastgesteld moet worden.

1750 lijkt veel maar als je kijkt wat het kost per harddisk (21.88 excl BTW) valt het nog mee.

Graag hoor ik wat je ervan vind.

Ik kan deze mooie 80 basy case inkopen en wil graag weten of er interesse voor is.

In deze case kunnen 2x ATX PSU en het onderste gedeelte is zoals onze normale servercase RVS3-06A.

De backplanes zijn allemaal met 4x sata aansluiting (per backplane) en daar hebben we natuurlijk mooie kabels voor van sata naar mini sas voor de sas expanders etc.

De prijs ligt rond de 1750 EUR excl BTW. Als er interesse is en er zijn mensen die willen reserveren met een vooruit betaling is er een actie prijs die nog vastgesteld moet worden.

1750 lijkt veel maar als je kijkt wat het kost per harddisk (21.88 excl BTW) valt het nog mee.

Graag hoor ik wat je ervan vind.

[ Voor 0% gewijzigd door Verwijderd op 31-10-2014 09:56 . Reden: Verkeerd aantal bays nergezet, geen 120 maar 80, stom, stom, stom, maar wel mooi :-) ]

Wat een beest

Wat moet zoiets kosten? (inc BTW)

Lezen is een kunst....

Ben ik nou gek, of tel ik maar 80 bays? 5*16 = 80?

Wat moet zoiets kosten? (inc BTW)

Lezen is een kunst....

Ben ik nou gek, of tel ik maar 80 bays? 5*16 = 80?

[ Voor 46% gewijzigd door FireDrunk op 31-10-2014 09:51 ]

Even niets...

Verwijderd

Ja, ik had verkeerd geteld. Was uitgegaan van 5x 24 bay en niet 5x 16 bay. Heb al aangepast.

Wel goed gekeken :-)

Wel goed gekeken :-)

Damn, de eerste gedachte: '.. space, the final frontier, ....'

Stiekem veel loze ruimte, schreeuwt om modding voor extra mobo trays, kun je je hele cluster (storage node en computational nodes) huisvesten in deze kast.

Mbt de prijs, 4x de RVS406 is goedkoper, maar heb je als bijkomende kosten wel alle benodigdheden om de boel extern aan elkaar te knopen, dus wellicht kom je net zo duur uit.

Stiekem veel loze ruimte, schreeuwt om modding voor extra mobo trays, kun je je hele cluster (storage node en computational nodes) huisvesten in deze kast.

Mbt de prijs, 4x de RVS406 is goedkoper, maar heb je als bijkomende kosten wel alle benodigdheden om de boel extern aan elkaar te knopen, dus wellicht kom je net zo duur uit.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Iemand toevallig een idee welke case ik voor dit board kan gebruiken Intel S5520HCR?

Het is een SSI EEB Form Factor met dimensions van 12.0 x 13.0

Ik had eerst die Ri-Vier RVS406 op het oog, maar een blik in de specs gaf me helaas 12.0 x 10.5 max.

Die Norco RPC-4220 is niet meer leverbaar.

Wat zijn "betaalbare" alternatieven? (dit in tegenstelling tot wat van monster ik hierboven zie)...

Het is een SSI EEB Form Factor met dimensions van 12.0 x 13.0

Ik had eerst die Ri-Vier RVS406 op het oog, maar een blik in de specs gaf me helaas 12.0 x 10.5 max.

Die Norco RPC-4220 is niet meer leverbaar.

Wat zijn "betaalbare" alternatieven? (dit in tegenstelling tot wat van monster ik hierboven zie)...

Verwijderd

Ik krijg een paar (3 stuks) langere RVS4 binnen (RVS4L). Deze is 65 cm diep en kan dus grotere moederborden aan.

Ik verwacht deze half november.

I.p.v. sas/sata backplanes zitten er 01A backplanes in en dit zijn de mini-sas (SFF-8087) connectors.

Prijs is 375 excl BTW.

Definitieve specificaties volgen nog, maar in die kast kunnen de grotere moederborden.

Richard.

Ik verwacht deze half november.

I.p.v. sas/sata backplanes zitten er 01A backplanes in en dit zijn de mini-sas (SFF-8087) connectors.

Prijs is 375 excl BTW.

Definitieve specificaties volgen nog, maar in die kast kunnen de grotere moederborden.

Richard.

[ Voor 46% gewijzigd door Verwijderd op 31-10-2014 14:28 ]

Qua idee van een compacte setup voor heel veel harddisks super. Persoonlijk heb ik er denk ik niets aan omdat de kast niet door het zolderluik lijkt te passen.

Lijkt mij ook niet handig met plaatsen expanders of is daar op een of andere manier iets voor voorzien?

Vraag me wel af hoe zoiets getransporteerd wordt, is het dan een grote vierkante doos?

Ik denk dat ik er maar twee 24 slots Ri-Vier kasten bij koop....

@rjmulder, de link in je profiel linkt niet naar je webshop

Lijkt mij ook niet handig met plaatsen expanders of is daar op een of andere manier iets voor voorzien?

Vraag me wel af hoe zoiets getransporteerd wordt, is het dan een grote vierkante doos?

Ik denk dat ik er maar twee 24 slots Ri-Vier kasten bij koop....

@rjmulder, de link in je profiel linkt niet naar je webshop

[ Voor 7% gewijzigd door BartNL op 31-10-2014 19:24 ]

Geweldige case Richard, daar kan ruw dus 320GB in met 4 TB schijven (~12000 euro alleen aan schijven). Ik hoop dat iemand het ding koopt en er een mooie build mee maakt

Het grote probleem waar ik zelf meer mee zit is dat grote thuis storage gewoon niet gebackupped kan worden zonder de kosten redelijk te houden. En alles zit in 1 systeem waarvan de componenten niet redundant zijn in de meeste gevallen, met uitzondering van de harde schijven.

In plaats van veel meer storage in 1 chassis zie ik meer een toekomst in storage die verdeeld wordt over kleinere zuinigere systemen, waarvan er een of meer in zijn geheel kunnen uitvallen (defecte controller, moederboard, cpu, geheugen, PSU) en dat de data toch nog ok/beschikbaar is.

Het grote probleem waar ik zelf meer mee zit is dat grote thuis storage gewoon niet gebackupped kan worden zonder de kosten redelijk te houden. En alles zit in 1 systeem waarvan de componenten niet redundant zijn in de meeste gevallen, met uitzondering van de harde schijven.

In plaats van veel meer storage in 1 chassis zie ik meer een toekomst in storage die verdeeld wordt over kleinere zuinigere systemen, waarvan er een of meer in zijn geheel kunnen uitvallen (defecte controller, moederboard, cpu, geheugen, PSU) en dat de data toch nog ok/beschikbaar is.

Volgens mij reken je niet helemaal goedQ schreef op zaterdag 01 november 2014 @ 14:49:

daar kan ruw dus 320GB in met 4 TB schijven

GB / TB foutje lijkt het mij meer  maar wel vet zoveel schijfruimte in 1 systeem alleen dat prijskaartje

maar wel vet zoveel schijfruimte in 1 systeem alleen dat prijskaartje

Over mobo trays gesproken - Ik hoop dat er een tray in zit welke je er aan de achterkant uit kunt schuiven. Anders moet je praktisch in die kast kruipen om een bord te installerenPantagruel schreef op vrijdag 31 oktober 2014 @ 10:56:

Damn, de eerste gedachte: '.. space, the final frontier, ....'

Stiekem veel loze ruimte, schreeuwt om modding voor extra mobo trays, kun je je hele cluster (storage node en computational nodes) huisvesten in deze kast.

Mbt de prijs, 4x de RVS406 is goedkoper, maar heb je als bijkomende kosten wel alle benodigdheden om de boel extern aan elkaar te knopen, dus wellicht kom je net zo duur uit.

Ik mag hopen van wel anders moet je de dit beest plat leggen om op zeer onhandige wijze t mobo uit te bouwen. Anders moet je toch met de dremel aan de slag (of pop nagels uitboren).brederodekater schreef op zaterdag 01 november 2014 @ 20:09:

[...]

Over mobo trays gesproken - Ik hoop dat er een tray in zit welke je er aan de achterkant uit kunt schuiven. Anders moet je praktisch in die kast kruipen om een bord te installeren

[ Voor 2% gewijzigd door Pantagruel op 01-11-2014 20:45 . Reden: pop nagels ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik heb dit bord trouwens nog niet voorbij zien komen op dit forum, de Supermicro A1SA7-2750F

De high-lights:

De high-lights:

- Intel® Atom processor C2750, SoC, FCBGA 1283, 20W 8-Core

- Up to 64GB DDR3 1600MHz ECC or non ECC UDIMM in 4 DIMM sockets

- Dual GbE LAN ports via SoC i354

- IPMI with dedicated LAN

- LSI 2116 controller for 16x SATA3 / SAS2 ports plus 1x SATA3 SMCI SATA DOM

- 1x PCI-E 2.0 x4 (in x8) slot

- 3x USB 2.0 (2 rear + 1 Type A)

Prijs is ook wel wat hoger dan de Asrock bordjes.

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

Deze gaat er nog net over: http://www.asus.com/Comme...kstations/P9AIC2550SAS4L/

Maareuh, dit is wel het showoff topic, dus tot er iemand effectief zo'n kastje vol heeft gestoken:

Het grote DIY RAID NAS topic deel 3

Maareuh, dit is wel het showoff topic, dus tot er iemand effectief zo'n kastje vol heeft gestoken:

Het grote DIY RAID NAS topic deel 3

Kijk of je hiermee wat kan : http://tweakers.net/product/281636/xigmatek-elysium/thestiffmeister schreef op vrijdag 31 oktober 2014 @ 11:00:

Iemand toevallig een idee welke case ik voor dit board kan gebruiken Intel S5520HCR?

Het is een SSI EEB Form Factor met dimensions van 12.0 x 13.0

Ik had eerst die Ri-Vier RVS406 op het oog, maar een blik in de specs gaf me helaas 12.0 x 10.5 max.

Die Norco RPC-4220 is niet meer leverbaar.

Wat zijn "betaalbare" alternatieven? (dit in tegenstelling tot wat van monster ik hierboven zie)...

Was ooit nieuw 150 € of zo en kunnen lekker veel HDD's in !!

Modellen als de eVGA SR-2 passen hier makkelijk in dus dat mobo misschien ook wel

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

die kast heeft geen 8interne + 12externe ...

die 8 HDD's zitten in 2 4-in-3 modules en bezetten dus al 6x 5,25" sloten...

zoals dat in de Stackers enzo gebeurt (en in de meeste andere maxi-towers)

Is wel een nuance die er bij de informatie van het aantal bays gerust bij mag gezet worden!

Want anders zou je denken 8+ 4x (5-in-3) = 28 harde schijven... niet dus!

je kunt er maximaal 4x(5-in-3) = 20 harde schijven in kwijt.

tel er eventueel nog dat sata-slot bovenaan bij en je hebt plaats voor 21 schijven

Mijn Sharkoon Rebel 12 Value kast http://www.sharkoon.com/?q=en/content/rebel12-economy

heeft plek voor 6x interne + (11x5,25 en 1x 3.5) extern = 6 + (3x5-in-3+1x3-in-2)+1 = 25 schijven

en slop je dat externe 3,5"-slot eruit dan krijg je er 6+4x5-in-1 = 26 schijven in

en is (wellicht) een pak goedkoper... en kleiner

Alhoewel er wel een E-ATX van 12x13inch zou moeten ingaan volgens fabrikant

http://www.xigmatek.com/p...?productid=122&type=photoSpotlighting your hardware with 12*5.25” drive bays and two 4 in 3 HDD cages.

die 8 HDD's zitten in 2 4-in-3 modules en bezetten dus al 6x 5,25" sloten...

zoals dat in de Stackers enzo gebeurt (en in de meeste andere maxi-towers)

Is wel een nuance die er bij de informatie van het aantal bays gerust bij mag gezet worden!

Want anders zou je denken 8+ 4x (5-in-3) = 28 harde schijven... niet dus!

je kunt er maximaal 4x(5-in-3) = 20 harde schijven in kwijt.

tel er eventueel nog dat sata-slot bovenaan bij en je hebt plaats voor 21 schijven

Mijn Sharkoon Rebel 12 Value kast http://www.sharkoon.com/?q=en/content/rebel12-economy

heeft plek voor 6x interne + (11x5,25 en 1x 3.5) extern = 6 + (3x5-in-3+1x3-in-2)+1 = 25 schijven

en slop je dat externe 3,5"-slot eruit dan krijg je er 6+4x5-in-1 = 26 schijven in

en is (wellicht) een pak goedkoper... en kleiner

Alhoewel er wel een E-ATX van 12x13inch zou moeten ingaan volgens fabrikant

[ Voor 9% gewijzigd door soulrider op 03-11-2014 05:06 ]

Ik heb een videotje gemaakt van mijn 71 TB NAS om eens te laten zien dat zo'n ding best stil kan zijn.

YouTube: 71 TB NAS (ZFS on Linux) is relatively quiet

PWM fan control is erg tof en een goede feature van de ri-vier case.

YouTube: 71 TB NAS (ZFS on Linux) is relatively quiet

PWM fan control is erg tof en een goede feature van de ri-vier case.

Die Sharkoon is ook niet verkeerd inderdaad en al helemaal niet als ik zie wat die heeft gekost : 80-100 € hooguitsoulrider schreef op maandag 03 november 2014 @ 04:59:

die kast heeft geen 8interne + 12externe ...

[...]

http://www.xigmatek.com/p...?productid=122&type=photo

die 8 HDD's zitten in 2 4-in-3 modules en bezetten dus al 6x 5,25" sloten...

zoals dat in de Stackers enzo gebeurt (en in de meeste andere maxi-towers)

Is wel een nuance die er bij de informatie van het aantal bays gerust bij mag gezet worden!

Want anders zou je denken 8+ 4x (5-in-3) = 28 harde schijven... niet dus!

je kunt er maximaal 4x(5-in-3) = 20 harde schijven in kwijt.

tel er eventueel nog dat sata-slot bovenaan bij en je hebt plaats voor 21 schijven

Mijn Sharkoon Rebel 12 Value kast http://www.sharkoon.com/?q=en/content/rebel12-economy

heeft plek voor 6x interne + (11x5,25 en 1x 3.5) extern = 6 + (3x5-in-3+1x3-in-2)+1 = 25 schijven

en slop je dat externe 3,5"-slot eruit dan krijg je er 6+4x5-in-1 = 26 schijven in

en is (wellicht) een pak goedkoper... en kleiner

Alhoewel er wel een E-ATX van 12x13inch zou moeten ingaan volgens fabrikant

LACKRACK!Q schreef op maandag 03 november 2014 @ 23:51:

Ik heb een videotje gemaakt van mijn 71 TB NAS om eens te laten zien dat zo'n ding best stil kan zijn.

YouTube: 71 TB NAS (ZFS on Linux) is relatively quiet

PWM fan control is erg tof en een goede feature van de ri-vier case.

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Ik heb hem ook, met 4x Chenbro (dacht ik) 4-in-1 modules. Die modules zelf maken behoorlijk wat herrie en kosten ook niet niks. Totale kosten zijn dan ongeveer hetzelfde als voor een 19" 24-bay kast.nero355 schreef op dinsdag 04 november 2014 @ 00:48:

[...]

Die Sharkoon is ook niet verkeerd inderdaad en al helemaal niet als ik zie wat die heeft gekost : 80-100 € hooguit

Daarnaast vind ik de 6 interne schijven onhandig geplaatst en de ruimte zelf in de kast erg beperkt. Zeker als je 2 (of meer) M1015 kaarten gebruikt.

Bovenstaande was voor mij reden om over te stappen naar een Xcase

dus al iemand nog interesse heeft voor de modules...

| System specifications | |

| Component | Value |

|---|---|

| Case | Xcase RM424Pro |

| Processor | Intel Xeon L3426 |

| RAM | 32 GB ECC REG |

| Motherboard | Supermicro X8SU6-F-M |

| LAN | 2x Ethernet 1Gbps |

| PSU | Corsair HX520W |

| Controller | 2x IBM M1015 |

| Controller | LSI2008 SAS (Onboard) |

| Disk | 10x WD Greeen 2TB (Raidz2) |

| Disk | 5 x WD GreenTB (Raidz) |

| SSD | 2 x Samsung 840EVO (JBOD) |

| SSD | 2 x Samsung 840EVO (RAID1 OS) |

| Brutto storage | 30+ TB |

| Netto storage | 24+ TB |

| OS | CentOS 7 X86 |

| Filesystem | ZFS |

| Power usage | System off: 5w, Full Load: 160+ w, Normaal: 100w |

Intro

Ik heb al enige jaren wat staan. Ooit begonnen met het idee om een low budget Linux Cluster te bouwen met DRDB om filesystems te syncen. Complexiteit, kosten (was een arme student) waren helaas toch beperkingen.Daarna steeds meer richting een NAS gegaan met redundant disken. Steeds losse disken ingekocht, waardoor de verzameling disken een aardige zooi was geworden. Langszaam gaan standaardiseren om beter inkleden. Ik kocht een eenvoudige kast, waarin 4 4-in-1 modules pasten en die is in de loop der tijd vol geraakt. Alleen de herrie van die modules was nooit te harden

Onlangs toch maar de grote stap gemaakt naar een echte 24 bay kast en wat oude disken de deur uit gegooit (500gb bijv). Ik had al wat 2TB disken en daarom daarop verder gegaan. en een grondige herstructurering. De Xcase heeft temperatuur gestuurde fans, wat me wel aansprak. De kast zit goed in elkaar, maar dat mag je ook wel verwachten voor dat geld. Enige nadeel is dat er geen USB aan de voorzijde zit. Leuk extra is SGPIO, dus niet meer gokken welke disk je eruit moet trekken

Ik kwam een leuke oplossing tegen om SS'd bij een PCI-slot te plaatsen. Daar zitten nu dus de SSD's in vwaarop het OS zit.

Het systeem is overigens niet alleen NAS, maar ook nog mail en webserver. Hij staat dagelijks aan tussen 9 en 23 uur. 's nachts besparen we energie

Networking

Mijn huishouden is nog vrij klein. Ik ben bezig het gehele huis te voorzien van CAT 6, wat voorlopig nog wel vodoende is. Het centrale punt is een 24 ports Cisco switch. Internet komt binnen op een TP-link accesspoint en in de huiskamer staat nog een los access point.Setup

Omdat het systeem toch wel de nodige uurtjes per dag aanstaat, wil ik het zo min mogelijk stroom later verbruiken. Destijds was dat ook de reden dat ik voor deze CPU heb gekocht.Alle disks gaan naar standby als ze 5 minuten idle zijn. Normaal gesproken moet het systeem actief zijn zonder dat er een disk draait. De data die regelmatig kan worden gebruikt staat op de SSD's (OS + webserver-root).

De grootste ZFS pool gebruikt is voor opslag. De 2e, en kleinere, pool is voor backups van data die ik echt niet wil verliezen (foto's, mail, etc). Er komt nog een losse disk voor SABnzb en zaken

Toekomst

Eerste traject is de kast op zijn definitieve plek zetten op zolder. Waarschijnlijk via een LackRack.Hopelijk draait e.a. voorlopig zonder grote problemen!

Issues?

Uiteraard zijn er wat aandachtpunten die nog opgepakt moeten worden:- Een bay lijkt helemaal niet te werken. HD doet het wel, maar is niet in het OS te zien

- Ik zie in dmesg regelmatig deze melding als ik data copieer:

code:

1

| mpt2sas0: log_info(0x31080000): originator(PL), code(0x08), sub_code(0x0000) |

Volgens Google wordt dit meestal veroorzaakt door een slechte kabel. Alle kabels zijn net nieuw, maar er kan altijd een slechte tussen zitten. Misschien is er een backplane niet 100%, want ook het eerste issue zou kunnen oplossen

- SGPIO geeft op de LSI controller de drives in spiegelbeeld weer

(oude foto)

| System specifications | |

| Component | Value |

|---|---|

| Case | NORCO RPC-4224 |

| Processor | Intel i7 920 |

| RAM | 24 GB DDR3 |

| Motherboard | Supermicro X8ST3-F |

| LAN | 4x Ethernet 1Gbps |

| PSU | Corsair HX850W |

| Controller | 1x Areca ARC-1880I |

| SAS Expander | HP SAS Expander |

| Disk | 8x WD RED 3TB (RAID-5) |

| Disk | 5 x WD RED 4TB (RAID-5) |

| Disk | 3 x WD Green 1TB (RAID-5) |

| Disk | 1 x WD Green 1TB (Temp Download) |

| Disk | 1 x WD Green 1TB (Temp Download) |

| Disk | 2 x WD RE4 500GB (RAID-1) voor VM's |

| Disk | 1 x Toshiba 2.5 inch 500GB enkel voor Hyper-V host |

| Bruto storage | 51.5 TB |

| Netto storage | 43 TB |

| OS | Windows 2012 R2 |

| Filesystem | NTFS |

| UPS | APC Smart-UPS VA3000 |

Intro

Na begonnen te zijn met een HP ML350 G5 al vrij snel geupgrade naar een Norco 24 bay case. Dit voornamelijk door de beperkte mogelijkheden van de HP en het extreme stroomverbruik.De huidige Areca ARC-1880i is geduallinked aan de HP SAS expander. Niet de snelste oplossing maar wel erg kosten efficient. En voor thuis gebruik eigenlijk ruim voldoende.

De huidige case telkens uitgebreid met disks. Dit gaat zonder problemen, disk erbij pluggen en dag later draait de raid weer vrolijk door met de extra disk.

Networking

24 ports Netgear Gbit "smart" switch. en een Ruckus accesspoint, CAT5e bekabeling. In de server zit een extra dual GBit adapter voor pfSense. onboard dual GBIT gebruik ik voor het interne dataverkeer.Setup

Alles draait op Windows 2012 R2 met Hyper-V. Daarop een DC, EX, FS, Download machine en webserver en een VM met pfSense als firewall/router.Alle raidsets behalve de RAID-1 gaan na 30 minuten idle naar spindown.

de 2x grote raidsets zijn voor data opslag.

de 3x1TB is voor tijdelijke download opslag voor mijn pa als hij in het buitenland zit.

Toekomst

Zuinigere Xeon CPU. De 1 TB's eruit halen en vervangen door 4 TB of groter.Verder moet ik zegen dat ik niet veel wensen hebt, het apparaat draait super stabiel.

Issues?

Geen.

Heb je iets van monitoring draaien waarin je kan zien hoe vaak je raidsets down spinnen?

Even niets...

Nee, ik zie alleen in de webinterface van de Areca dat de disks "uit" staan. Gezien het stroomverbruik staan ze altijd uit tenzij ik de raidset access (om bijv data te kopieren of een film te kijken). Van waar deze vraag?FireDrunk schreef op donderdag 18 december 2014 @ 12:43:

Heb je iets van monitoring draaien waarin je kan zien hoe vaak je raidsets down spinnen?

Ik merk bij mijzelf dat mijn pool amper down spinned, omdat er toch relatief vaak nog wat taken op de achtergrond gedaan worden (wat downloads die binnensijpelen, backupjes, file access vanuit het netwerk).

Juist bij zoveel schijven, is het interessant om te zien wat het "effect" is van spindown.

Juist bij zoveel schijven, is het interessant om te zien wat het "effect" is van spindown.

Even niets...

Dat is exact de reden dat ik geen actieve taken uitvoer op de grote sets. Voor de downloads zijn de losse 1 TB disks. op de grote sets staat enkel statische data. eens in de zoveel tijd move ik zaken naar de sets.FireDrunk schreef op donderdag 18 december 2014 @ 12:57:

Ik merk bij mijzelf dat mijn pool amper down spinned, omdat er toch relatief vaak nog wat taken op de achtergrond gedaan worden (wat downloads die binnensijpelen, backupjes, file access vanuit het netwerk).

Juist bij zoveel schijven, is het interessant om te zien wat het "effect" is van spindown.

je kan in de taakbeheer kijken of er nog naar de disken word geschreven, bij mij spinnen beide raidsets down als ze niet gebruikt worden.

Ik heb dan ook 'maar' 4 * 4TB in 1 array... Scheelt misschien 15-20W als het zaakje down spinned... Niet echt de moeite

Even niets...

Update van mijn kantthalantis schreef op dinsdag 17 september 2013 @ 16:59:

Lang verwachte update van mijn kant

System specifications Component Value Case Norco 4224 4U CPU Intel Core i7 960 @ stock RAM Corsair 6x2GB, DDR3, PC12800, CL9, XMS3 Motherboard Asus Sabertooth X58 Operating system Windows Server 2012 Controller Areca 1880ix-24 24 poorten sata Hard drive 20 x 3TB Hitachi Deskstar_7K3000 SSD OCZ Vertex 2 SATA II 2.5" SSD 60GB RAID array configuration Boot: 1x 60 GB SSD and 20 x 3 TB RAID 6 ( 60 TB storage ) Netto storage capacity 54 TB Network HP NC360T pcie DP Filesystem NTFS Idle power usage ~190 Watt Cpu Cooling Corsair H80i cpu koeling Powerswitch ip power 9258 Voeding Corsair ATX 850W 24P Videokaart Ati Radeon X550 Functie Backup Server

Bovenstaande server is mijn backup server, ik gebruik deze server als backup van mijn main server.

Server draait windows 2012 , de 20x schijven staan in raid 6.

De asus sabertooth komt uit mijn main server aangezien het mainboard van mijn backup server is overleden, dit was een 5 jaar oude asus p5n-t socket 775 moederbord.

De stroom kan ik ook regelen van afstand met een ip power 9258.

ik heb in de 4U kast een fan wall met 3x noctua pf12 fans en achterop 2x 80 mm noctua fans, dan heb ik in de boven plaat nog 1x noctua pf12 die warme lucht de kast uit blaast en de koeler van de corsair h80i waterkoeling zit ook aan de bovenplaat vast, kon hem nergens anders niet kwijt.

[afbeelding]

[afbeelding]

[afbeelding]

System specifications Component Value Case Rivier 24bay storage RV4324-03A CPU Intel Core i5 4570S @ stock RAM Corsair XMS3 - Geheugen - 16 GB : 2 x 8 GB Motherboard Asus SABERTOOTH Z87 Operating system Windows Server 2012 Controller Areca 1882ix-24 24 poorten sata Hard drive 24 x 2TB Samsung HD204ui en HD203WI SSD OCZ vertex-2 SSD 60GB RAID array configuration Boot: 1x 60 GB SSD and 24 x 2 TB RAID 6 ( 48 TB storage ) plus 4x 2TB raid 5 via SFF-8088 Netto storage capacity 50 TB Network Intel PRO/1000 PT dual server adapter Filesystem NTFS Idle power usage ~ 105 Watt Cpu Cooling Corsair H80i cpu koeling Powerswtich ip power 9258 Voeding Corsair ATX 850W 24P Videokaart Matrox Millennium G550 PCIe Functie Main Server

Bovenstaande server is mijn main server, ik gebruik deze server als mijn main server, voor opslag van van alles en nog wat.

Server draait windows 2012 , de 24x schijven staan in raid 6 + 4 schijven in raid 5

De asus sabertooth heb ik nieuw besteld voor mijn main server aangezien het mainboard van mijn backup server is overleden, dit was een 5 jaar oude asus p5n-t socket 755 moederbord.

De stroom kan ik ook regelen van afstand met een ip power 9258.

ik heb in de 4U kast een fan wall met 3x noctua pf12 fans en achterop 2x 80 mm noctua fans, de koeler van de corsair h80i waterkoeling zit ook aan de bovenplaat vast, kon hem ergens anders niet kwijt.

deze rivier kast vervangt mijn lian-li cube

[afbeelding]

[afbeelding]

[afbeelding]

[afbeelding]

De dual netwerk kaarten zitten verbonden via een hp switch (HP ProCurve 1810G - 8 GE, P.1.17, eCos-2.0)

Deze dual poorten zitten via de standaard windows server 2012 teaming geconfigureerd met lacp op de switch heb ik hiervoor de poorten in trunking gezet.

Beide raid kaarten zijn voorzien van een BBU.

Ik houd de servers in sync met syncback se, dit programma start op als ik de backup server aan zet, hij gaat dan via ftp kijken of alles nog in sync is.

Op de main server heb ik hiervoor filezilla server draaien en de gebruiker heeft read only rechten op de mappen.

(12-5-2014)

Even een update de kasten hangen nu

[afbeelding]

Mijn main server begint een beetje vol te raken

| # | Product | Prijs | Subtotaal |

| 4 | WD Green WD40EZRX | € 142,41 | € 569,64 |

| 1 | Synology DiskStation DS1815+ | € 858,80 | € 858,80 |

| Bekijk collectie Importeer producten | Totaal | € 1.428,44 | |

De WD Green gaan 4x 2TB vervangen in mijn main server die in Raid 5 staan, 6TB winst

de 4x 2TB gaan in de nieuwe nas, heb nu een DS413 met 4 disken van 2TB.

Weet nog niet of ik er een volume van maak of 2 (4x2TB + 4x2TB) beide in raid 5, ook 6TB winst of 8TB als ik het uitbreid.

Heb nog gekeken of ik niet beter 10x WD Green kon bestellen en die in mijn 24 Disk Raid 6 kon doen, maar dan had ik evenveel winst kwa ruimte en ik krijg nu een mooie snelle nas die 24/7 aan kan staan en bijna evenveel stroom verbruikt als mijn DS413 die ik ga vervangen.

Rekensom (netto totalen)

Oud

24*2 = 44 TB raid 6 (Main Server)

4*2 = 6TB raid 5 (Main Server)

4*2 = 6TB raid 5 (DS413)

Totaal 56TB

Nieuw 1 (DS1815+ en 4x WD 4TB)

4*4 = 12 TB raid 5 (Main Server)

24*2 = 44 TB raid 6 (Main Server)

4*2 + 4*2 = 12 TB raid 5 (DS1815+)

Totaal 68TB

Nieuw 2 (10x WD 4TB)

10*4 = 32 TB raid6 (Main Server)

14*2 = 24 TB raid6 (Main Server)

4*2 = 6TB raid 5 (Main Server)

4*2 = 6TB raid 5 (DS413)

Totaal 68TB

Begrijp ik je post nu goed en wil je die 4x4TB Greens in Raid5 op je Areca draaien op je main server?

Mijn persoonlijke ervaringen met de 2TB greens zijn daar allermist goed mee zullen we maar zeggen

Mijn persoonlijke ervaringen met de 2TB greens zijn daar allermist goed mee zullen we maar zeggen

De Samsung disken zijn ook green en daar heb ik ook geen problemen mee, we zullen zien en anders gaan ze in mijn NAS

Heb eerst met 8x 1TB Samsung F1 gedraaid en dat ging wel goed. Daar een jaar met 2TB greens maar die bleven gedropped worden (was nog op mijn Areca 1222). Op de 1882 heb je volgens mij ook wel wat opties om het tegen te gaan zoals de TLER setting op de controller om hem iets tolleranter te maken.

De Spullen zijn binnen, alles is overgebouwd, er het draait als een zonnetje.

De 4x 4TB zitten zonder problemen in Raid 5 aan mijn areca gekoppeld

En de 4 schijven uit mijn oude nas werden probleemloos herkent in mijn nieuwe nas, toch heb hem terug gezet naar fabrieks instellingen, en configuratie terug gezet, vond ik netter. (had een backup van alles)

Schijven zitten alle 8 in SHR-2

Ik moet zeggen die DS1815+ reageert erg vlot met downloaden (nzbget 20MB/sec )

)

en als ik smb kopieer kan ik gewoon nog bladeren door de mappen.

Dit kon met de DS413 niet.

De 4x 4TB zitten zonder problemen in Raid 5 aan mijn areca gekoppeld

En de 4 schijven uit mijn oude nas werden probleemloos herkent in mijn nieuwe nas, toch heb hem terug gezet naar fabrieks instellingen, en configuratie terug gezet, vond ik netter. (had een backup van alles)

Schijven zitten alle 8 in SHR-2

Ik moet zeggen die DS1815+ reageert erg vlot met downloaden (nzbget 20MB/sec

en als ik smb kopieer kan ik gewoon nog bladeren door de mappen.

Dit kon met de DS413 niet.

[ Voor 18% gewijzigd door thalantis op 02-03-2015 09:58 ]

mijn ervaring is ook dat cunsumer schijven al jarenlang probleemloos werken op hardware raid controllers. Ooit in het begin van het sata tijdperk waren er problemen met met name WD Green schijven door niet juiste implementaties van de sata standaard. Op een of andere manier blijft dat hangen.

Wel altijd een week (of liever twee) test draaien voordat je de schijven in een nieuwe setup echt kunt vertrouwen

Wel altijd een week (of liever twee) test draaien voordat je de schijven in een nieuwe setup echt kunt vertrouwen

Persoonlijke ervaringen schijnen geen zoden aan de dijk te zetten, maar mijn exemplarische ervaring bestaat uit een mengeling van WD en Samsung SATA drives (320 GB) aan een 3Ware 8500 controller in RAID5 en dat deed het altijd naar behoren.BartNL schreef op maandag 02 maart 2015 @ 15:50:

mijn ervaring is ook dat cunsumer schijven al jarenlang probleemloos werken op hardware raid controllers. Ooit in het begin van het sata tijdperk waren er problemen met met name WD Green schijven door niet juiste implementaties van de sata standaard. Op een of andere manier blijft dat hangen.

Wel altijd een week (of liever twee) test draaien voordat je de schijven in een nieuwe setup echt kunt vertrouwen

-Update-

Zow, ondanks 't toegenomen aantal zon-uurtjes dit weekend toch nog aan de hobby geprutst

I.v.m. het toenemend tekort aan vrije ruimte op de 16 TiB array (kom maar, kom maar, kom maar, HOARDER

'T een en 't ander verloopt tegenwoordig eigenlijk zonder al te veel spanning en de meeste moeite was t vervangen van de 4-in-3 modules van CoolerMaster door de 5-in-3 modules van Ri-Vier.

Spec's heden ten dage:

System specifications | |

| Component | Value |

|---|---|

| Case | CoolerMaster Stacker (STC-T01) |

| CPU | Intel Xeon E3-1230, Quad core 3.2 GHz |

| RAM | 16 GiB ECC UDIMM DDR3 (4x4 GiB) |

| Motherboard | Supermicro X9SCM-F (IPMI,iKVM) |

| Operating system | ZFSGuru (FreeBSD 8.2-stable + ZFSGuru 1.19-beta3) |

| Controller | IBM ServeRAID M1015 (flashed to LSI 9240-8i IT/SAS2008 IT) & Lenovo SAS expander |

| Hard drives | 2x Western Digital 320, 320 GiB Mirror for OS 10x WD Green WD20EARS 10x WD Green WD40EZRX |

| RAID array configuration | 2x WD 320 Gib RAID-1 10x WD Green WD20EARS RAID-Z2 pool 1 10x WD Green WD40EZRX RAID-Z2 pool 2 |

| Netto storage capacity | 48 TiB |

| Network | NIC 1: Intel 1 Gbit, iKVM NIC 2: Intel Gbit nic PCI, network |

| PSU | Antec 560W |

| UPS | None |

| Filesystem | Root-on-ZFS/ZFS |

| Idle power usage | nog te bepalen aantal Watt |

| Extra | 4 x 5-in-3 modules, HDR-5-v13 |

Pic's or it didn't happen:

Updated pic's?, mm wellicht, niet dat t nu echt spannend is btw ten opzichte van de eerdere pic's. 'T frontje smoelt wat anders, maar da's dan ook alles (het gaat toch vooral om de binnenkant zoals men vaker laat vallen)

En nu?

Vrolijk verder leechen

[ Voor 61% gewijzigd door Pantagruel op 09-03-2015 16:34 . Reden: Spec update ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

even 1,5k uitgeven aan hd'sPantagruel schreef op maandag 02 maart 2015 @ 16:29:

[...]

Persoonlijke ervaringen schijnen geen zoden aan de dijk te zetten, maar mijn exemplarische ervaring bestaat uit een mengeling van WD en Samsung SATA drives (320 GB) aan een 3Ware 8500 controller in RAID5 en dat deed het altijd naar behoren.

-Update-

Zow, ondanks 't toegenomen aantal zon-uurtjes dit weekend toch nog aan de hobby geprutst.

I.v.m. het toenemend tekort aan vrije ruimte op de 16 TiB array (kom maar, kom maar, kom maar, HOARDER) aanwezig in de ZFS data server, heeft de storage bak een uitbreiding gekregen.

'T een en 't ander verloopt tegenwoordig eigenlijk zonder al te veel spanning en de meeste moeite was t vervangen van de 4-in-3 modules van CoolerMaster door de 5-in-3 modules van Ri-Vier.

Spec's heden ten dage:

Component Value Case CoolerMaster Stacker (STC-T01) CPU Intel Xeon E3-1230, Quad core 3.2 GHz RAM 16 GiB ECC UDIMM DDR3 (4x4 GiB) Motherboard Supermicro X9SCM-F (IPMI,iKVM) Operating system ZFSGuru (FreeBSD 8.2-stable + ZFSGuru 1.19-beta3) Controller IBM ServeRAID M1015

(flashed to LSI 9240-8i IT/SAS2008 IT) & Lenovo SAS expanderHard drives 2x Western Digital 320, 320 GiB Mirror for OS

10x WD Green WD20EARS

10x WD Green WD40EZRXRAID array configuration 2x WD 320 Gib RAID-1

10x WD Green WD20EARS RAID-Z2 pool 1

10x WD Green WD40EZRX RAID-Z2 pool 2Netto storage capacity 48 TiB Network NIC 1: Intel 1 Gbit, iKVM

NIC 2: Intel Gbit nic PCI, networkPSU Antec 560W UPS None Filesystem Root-on-ZFS/ZFS Idle power usage nog te bepalen aantal Watt Extra 4 x 5-in-3 modules, HDR-5-v13

Pic's or it didn't happen:

Updated pic's?, mm wellicht, niet dat t nu echt spannend is btw ten opzichte van de eerdere pic's. 'T frontje smoelt wat anders, maar da's dan ook alles (het gaat toch vooral om de binnenkant zoals men vaker laat vallen)

En nu?

Vrolijk verder leechenen verder sparen om de 10 x 2 TiB tzt te vervangen.

Maar pics is wel interessant. want hoe passen 22 hd's erin?

Professor Hubert Farnsworth: Shut up friends.

My internet browser heard us saying the word Fry and it found a movie about Philip J. Fry for us. It also opened my calendar to Friday and ordered me some french fries.

Ik heb er niet echt 1.5k€ aan uitgegeven, slechts 4 disks waren nieuw (medio jan 2015 aangeschaft) en de zes andere heb ik recentelijk 'licht' gebruikt overgenomen voor een schappelijke prijs.

Pic's blijf ik vooralsnog schuldig, ben niet 'In den lande'.Maar pics is wel interessant. want hoe passen 22 hd's erin?

In de Stacker passen 4 stuks van deze 5 Bay Mobile Rack Module, HDR-5-v13, dat zijn dus 20 disks, de andere twee disks zijn op t beluchtingsrooster in de bodem vast gezet (zie oudere pic's vd storage bak).

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik kan me er alles bij voorstellen, zo zag mijn 1e server er ook uit. Goedkope oplossing, maar het was een beetje prutsen om al die dingen netjes in de stacker te krijgen. Ook moest ik een andere powerknop maken

Ik ben wel blij met de 20 en 24 bay hot swap kasten. Zal binnenkort ook een update doen met server nummer 3. Dat is een 2 x 10 disk raid-z2, net als de andere 2 maar nu met allemaal 4TB hdd's. Ik was er 2.5K€ aan kwijt voor de hdd's

Ik ben wel blij met de 20 en 24 bay hot swap kasten. Zal binnenkort ook een update doen met server nummer 3. Dat is een 2 x 10 disk raid-z2, net als de andere 2 maar nu met allemaal 4TB hdd's. Ik was er 2.5K€ aan kwijt voor de hdd's

[ Voor 4% gewijzigd door jacovn op 12-03-2015 21:38 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

| System specifications | |

| Component | Value |

|---|---|

| Case | Lian Li PC-Q26B +Full hotswap backplane |

| CPU | Intel Pentium G3440 @ 3.30GHz |

| RAM | 16 GB ECC DDR3L-1600 GB |

| Motherboard | ASRock E3C224D4I-14S |

| PSU | Seasonic G-series 360 watt |

| Operating system | ZFSGuru (FreeBSD 10.0-STABLE) |

| Controller | Onboard LSI 2308 8 x SAS2 and onboard Intel C224 4 x SATA3 |

| Hard drive | 10 x Seagate ST4000DM000, 4TB |

| Hard drive | Toshiba MQ Series, 2TB (2.5inch) |

| RAID array configuration | 10 x 4TB RAIDZ2 |

| Netto storage capacity | 32 TB |

| Network | 2 x Intel® i210 + 1 x Realtek RTL8211E IPMI |

| UPS | - |

| Filesystem | ZFS |

| Idle power usage | Off+IPMI 3.6W - Idle+HDD sleep 43.1W - Idle+HDD running ~85W |

| Extra | IPMI via ASPEED AST2300 (remote control via LAN) |

Info

NAS ter vervanging van een vorige ZFS-NAS, deze zal nu dienst gaan doen als offline backup. Opslag wordt primair gebruikt voor media, foto's en diversen van alle personen hier thuis. (= standaard NAS dus) Daarnaast wordt ook nog gedownload via deze machine.Gewoon met het netwerk verbonden via gbit, meer dan voldoende. Wel een aparte kabel voor de IPMI. Disks zijn ingesteld na 1 uur in standby te gaan. Downloads komen binnen op de laptop schijf dus de array blijft netjes in sleep. Het verbruik is niet denderend natuurlijk maar dat wist ik van tevoren, hangt samen met de diskkeuze en het moederbord en is een bewuste afweging geweest (disks gedeeltelijk al in bezit en rest via V&A). De NAS staat ook niet 24/24 aan, eerder 12/24. Booten via WOL of de remote control.

Pics

Any intelligent fool can make things bigger, more complex, and more violent. It takes a touch of genius -- and a lot of courage -- to move in the opposite direction.

Nette build! En tevens gedeeltelijk mijn inspiratiebron, want ik heb ook de dezelfde moederbord en kast besteld. Moederbord al in bezit, kast komt eind volgende week hopelijk binnen.

Idle verbruik vind ik behoorlijk netjes rekening gehouden met wat het moederbord allemaal aan boord heeft. Het is echt een compleet bord waar ik echt de komende jaren mee vooruit kan.

Overigens vind ik de SAS kabels die bij het moederbord zaten wel een beetje cheap aanvoelen, wat vind jij?

Idle verbruik vind ik behoorlijk netjes rekening gehouden met wat het moederbord allemaal aan boord heeft. Het is echt een compleet bord waar ik echt de komende jaren mee vooruit kan.

Overigens vind ik de SAS kabels die bij het moederbord zaten wel een beetje cheap aanvoelen, wat vind jij?

jacovn schreef op donderdag 12 maart 2015 @ 21:37:

Ik kan me er alles bij voorstellen, zo zag mijn 1e server er ook uit. Goedkope oplossing, maar het was een beetje prutsen om al die dingen netjes in de stacker te krijgen. Ook moest ik een andere powerknop maken

Ik ben wel blij met de 20 en 24 bay hot swap kasten. Zal binnenkort ook een update doen met server nummer 3. Dat is een 2 x 10 disk raid-z2, net als de andere 2 maar nu met allemaal 4TB hdd's. Ik was er 2.5K€ aan kwijt voor de hdd's

Dus zoals gezegd, in de Stacker passen dus 4 stuks van deze 5 Bay Mobile Rack Module, HDR-5-v13, dat zijn dus 20 disks voor de 2 zfs arrarys, de andere twee disks zijn op t beluchtingsrooster in de bodem vast gezet.Pic's blijf ik vooralsnog schuldig, ben niet 'In den lande'.

Front view (clickable)

De 4 modules zitten er echt strak in, dit is gedeeltelijk vanwege de punch outs waarop de CM 4-in-3 modules sledes stoppen. De cages zijn wat langer en de bovenste had wat 'overtuigen' met een platte schroevendraaier nodig om over de punch outs te komen. Ook qua totale hoogte zit het er strak in.

Side view (clickable)

'K weet het kabel management staat op t lijstje

Zoom van SAS expander power (clickable)

Met dank aan Extera neemt de Lenovo SAS expander geen PCIe slot van het moederbord in beslag, maar krijgt deze zijn voeding via een riserbordje.

De regenboog kabel die je onderlangs naar buiten ziet verdwijnen is de power/reset switch, hiervoor moet ik ook nog een nette oplossing bedenken. Stiekem is de power/reset switch niet echt nodig aangezien ik t bordje mbv IPMI aan kan zetten of een reset kan geven.

Op dit moment hangen van de twee ZFS arrays 16 disks aan de expander, 4 disks aan de on-board SATA, de twee andere on-boards zijn bezet door de mirrored OS drives. De tweede SAS kabel om de drives dual linked aan de SAS expander te hangen moet ik opnieuw bestellen. De cheap ass china kabel is verrot

[ Voor 6% gewijzigd door Pantagruel op 15-03-2015 16:06 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik moet zeggen dat ik ook even mijn hart heb vastgehouden toen ik de kabeltjes circa 90° moet omplooien om de casewand dicht te krijgen. Aan de andere kant de sleeve is wel mooi, en ik plan er de eerste maanden zeker niet meer aan te prutsen en eens het zit maakt het niet echt uit. Maar als ik de stugheid en dikte vergelijk met de blauwe sas kabel van lenovo zijn de asrock kabels inderdaad minder degelijk gebouwd.GioStyle schreef op zondag 15 maart 2015 @ 13:36:

Overigens vind ik de SAS kabels die bij het moederbord zaten wel een beetje cheap aanvoelen, wat vind jij?

Any intelligent fool can make things bigger, more complex, and more violent. It takes a touch of genius -- and a lot of courage -- to move in the opposite direction.

Ik heb destijds een uit mijn hoofd 16 mm dikke powerknop met een ring van ledlicht gekocht (was wel relatief duur) en een gat in de bovenkant van de stacker geboord, en daar die knop doorgeschoven en die schroef je dan vast.Pantagruel schreef op zondag 15 maart 2015 @ 16:01:

De regenboog kabel die je onderlangs naar buiten ziet verdwijnen is de power/reset switch, hiervoor moet ik ook nog een nette oplossing bedenken. Stiekem is de power/reset switch niet echt nodig aangezien ik t bordje mbv IPMI aan kan zetten of een reset kan geven.

16MM Bulgin Silver / Blue LED MP0045/1E2BL012

20 € per stuk helaas. Ziet er netjes uit, en is makkelijk te doen als je op de juiste plaats boort. Het was in de bovenkant, aan de voorzijde naast het verhoogde stuk.

[ Voor 13% gewijzigd door jacovn op 15-03-2015 19:30 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Ik heb die Bulgin knoppen in t verleden ook wel eens overwogen en inderdaad relatief veel geld voor een schakelaar.jacovn schreef op zondag 15 maart 2015 @ 19:07:

[...]

Ik heb destijds een uit mijn hoofd 16 mm dikke powerknop met een ring van ledlicht gekocht (was wel relatief duur) en een gat in de bovenkant van de stacker geboord, en daar die knop doorgeschoven en die schroef je dan vast.

16MM Bulgin Silver / Blue LED MP0045/1E2BL012

20 € per stuk helaas. Ziet er netjes uit, en is makkelijk te doen als je op de juiste plaats boort. Het was in de bovenkant, aan de voorzijde naast het verhoogde stuk.

Net even bij Conrad gekeken en er zijn alternatieven, sommige minder industrieel vorm gegeven en zonder verlichting.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Tip voor mensen die er over denken om Storage Spaces te gebruiken... gebruik dezelfde grote schijven.

Ik heb een storage pool van 4x 3TB en 1x 1TB en met 7TB vrij meld hij nu dat hij vol is omdat de 1TB schijf vol is.

Momenteel alles aan het backuppen naar de verschillende pc's in het huis zodat ik de pool opnieuw kan aanmaken zonder de 1TB schijf.

Ik heb een storage pool van 4x 3TB en 1x 1TB en met 7TB vrij meld hij nu dat hij vol is omdat de 1TB schijf vol is.

Momenteel alles aan het backuppen naar de verschillende pc's in het huis zodat ik de pool opnieuw kan aanmaken zonder de 1TB schijf.

[ Voor 23% gewijzigd door Shamalamadindon op 03-04-2015 12:49 ]

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

| System specifications | |

| Component | Value |

|---|---|

| Case | Ri-vier RVS04-06A |

| CPU | Xeon E3-1220v3 |

| RAM | 32 GB (4x8 Sumsung M391B1G73QH0-YK0) |

| Motherboard | Supermicro X10SL7-F |

| Powersupply | Seasonic Platinum 760 |

| Operating system | ZFS Guru 10.1-001 featuring FreeBSD 10.1-RELEASE with ZFS v5000 |

| Controller | LSI 2308 on mainboard, flashed to IT mode (p19) |

| Controller | IBM M1015 flashed to IT mode (p19) |

| Hard drive | 20x HGST 7K4000 |

| SSD | Crucial M550 120 GB |

| array configuration | Pool 5 RaidZ2 10 x HGST 7K4000 |

| array configuration | Pool 6 RaidZ2 10 x HGST 7K4000 |

| Network | Intel Gigabit on board 2x |

| Filesystem | ZFS v5000 |

| Idle power usage | ~160Watt (no spindown) |

| Extra | Noctua PWM fans met Rockman PWM controller |

De server heeft geen fanwall meer, er staan 3 stuks 140 mm noctua fans in die met tie-wraps aan elkaar zitten. Ze staan op een laag shuim van 2 cm dik en aan de zijkant is het ook klem gezet met stukjes dun schuim. Op de deksel van de case zit isolatie materiaal dat de bovenkant licht aandrukt.

Door deze opzet is bijna de hele oppervlakte fan geworden, en de toon van de ventilatoren vindt ik minder hinderlijk dan de 120 mm variant. Ze hebben verder veel meer lucht doorvoer, of stiller bij dezelfde doorvoer.

[ Voor 43% gewijzigd door jacovn op 04-12-2015 13:29 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

ziet er deels herkenbaar uit. Ik heb een X-Case RM 424-EX in de startblokken staan zo op het oog slechte airflow gaat hebben maar fanheader is daarbij zo lek als een mandje. Bij de Norco en Ri-Vier kasten die ik heb heb ik daarmee geen probleem maar de disk backplane op de X-Case lijkt meer op die ik in jouw foto zie.

Je hebt blijkbaar veel moeite gedaan met de "fan header", was dat echt nodig?

Heb je beide uitlaat ventilatoren niet aangesloten?

Je hebt blijkbaar veel moeite gedaan met de "fan header", was dat echt nodig?

Heb je beide uitlaat ventilatoren niet aangesloten?

De 2x 80 mm draaien niet, en is zo veel airflow dat ik denk die niet nodig te hebben. De voedings ventilator is volgens mij nog nooit aangesprongen.

Scheelt weer 2 noctua 80 mm fans

De 3 noctua fans zitten parallel op een rockman op de cpu aansluting zodat ze niet naar 0 stand kunnen. De cpu fan zit op het moederbord en dat staat op vol vermogen voor de fans. De fan boven de m1015 en 10GE kaart draait ook op de rockman met wat lager toerental.

Ik heb geen issues met de sas2308 chip gehad met een hele pool copy, dus de airflow lijkt goed. De hdds worden niet warmer dan 40 graden (7200 rpm hgst)

Scheelt weer 2 noctua 80 mm fans

De 3 noctua fans zitten parallel op een rockman op de cpu aansluting zodat ze niet naar 0 stand kunnen. De cpu fan zit op het moederbord en dat staat op vol vermogen voor de fans. De fan boven de m1015 en 10GE kaart draait ook op de rockman met wat lager toerental.

Ik heb geen issues met de sas2308 chip gehad met een hele pool copy, dus de airflow lijkt goed. De hdds worden niet warmer dan 40 graden (7200 rpm hgst)

[ Voor 53% gewijzigd door jacovn op 11-04-2015 06:47 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Zijn er mensen die ervaring hebben met deze nieuwe 4-in-3 van Icydock? Lijkt me een beste mooie prijs.

pricewatch: Icy Dock Black Vortex MB074SP-1B 3.5” SATA HDD 4 in 3 Hot-Swap Module Cooler Cage

pricewatch: Icy Dock Black Vortex MB074SP-1B 3.5” SATA HDD 4 in 3 Hot-Swap Module Cooler Cage

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

@jacovn: de plaatjes doen het niet meer, misschien op 'imgur' zetten?

Ze doen het prima, maar deze image hoster komt niet door alle firewall software heen.

Vooral bedrijfs firewalls vinden dit domain niet vertrouwd.

Het is een volkomen anonieme hoster.

Vooral bedrijfs firewalls vinden dit domain niet vertrouwd.

Het is een volkomen anonieme hoster.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Probeer www.imgup.nl werkt ook goed

[ Voor 6% gewijzigd door Geckoo op 12-04-2015 22:20 ]

Professor Hubert Farnsworth: Shut up friends.

My internet browser heard us saying the word Fry and it found a movie about Philip J. Fry for us. It also opened my calendar to Friday and ordered me some french fries.

Hoewel mijn NAS uit 20TB (RAID6, 12TB Bruikbaar) bestaat, gok ik niet dat het echt iets voor hier is. Het is namelijk gewoon wat je zou verwachten, een synology doos. Op dit moment heb ik nog 5TB Vrij, dus heb nog geen plannen om uit te breiden... Zal zeker wel gebeuren zodra het nodig is. Mocht er toch interesse zijn maak ik wel een foto en vul in de tabel wel in. (Moet ik wel eerst even mijn netwerk-hoek opruimen, het ziet er nu niet uit  )

)

Wat slaan de mensen hier op?

Wat slaan de mensen hier op?

[ Voor 24% gewijzigd door smiba op 13-04-2015 13:24 ]

Nouuusmiba schreef op maandag 13 april 2015 @ 13:19:

Hoewel mijn NAS uit 20TB (RAID6, 12TB Bruikbaar) bestaat, gok ik niet dat het echt iets voor hier is. Het is namelijk gewoon wat je zou verwachten, een synology doos. Op dit moment heb ik nog 5TB Vrij, dus heb nog geen plannen om uit te breiden... Zal zeker wel gebeuren zodra het nodig is. Mocht er toch interesse zijn maak ik wel een foto en vul in de tabel wel in. (Moet ik wel eerst even mijn netwerk-hoek opruimen, het ziet er nu niet uit)

Wat slaan de mensen hier op?

Data (Documenten e.d.)

Foto's.

Porno.

Muziek collectie. (FLAC, Lossles e.d.)

Film collectie. (HD, Blu-Ray e.d.)

pc/Mac back-ups.

Staat in zijn algemeenheid ook in startpositie dus eigenlijk onnodig antwoord

Dat klopt. Alleen vond ik dit zo'n simpele en voor de hand liggende vraag dat ik hem maar even luchtig beantwoorde.BartNL schreef op maandag 13 april 2015 @ 19:45:

[...]

Staat in zijn algemeenheid ook in startpositie dus eigenlijk onnodig antwoord

Geen ervaring, maar ze zien er op zich wel strak uit !.Leo1010 schreef op zondag 12 april 2015 @ 02:03:

Zijn er mensen die ervaring hebben met deze nieuwe 4-in-3 van Icydock? Lijkt me een beste mooie prijs.

pricewatch: Icy Dock Black Vortex MB074SP-1B 3.5” SATA HDD 4 in 3 Hot-Swap Module Cooler Cage

Heuveltjes CPU geschiedenis door de jaren heen : AMD 486dx4 100, Cyrix PR166+, Intel P233MMX, Intel Celeron 366Mhz, AMD K6-450, AMD duron 600, AMD Thunderbird 1200mhz, AMD Athlon 64 x2 5600, AMD Phenom X3 720, Intel i5 4460, AMD Ryzen 5 3600 5800x3d

De prijs vind ik ook wel mooi. De meeste 4/5 bays die gaan al gauw richting of zelf over de honderd euro.heuveltje schreef op dinsdag 14 april 2015 @ 09:47:

Geen ervaring, maar ze zien er op zich wel strak uit !.

Bijkomend voordeel is dat bij deze de fan makkelijk te vervangen zou moeten zijn in tegenstelling tot bij andere bays.

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

net de X-Case RM 424-EX geïnstalleerd als 4e enclosure. Expander die er in zit is een LSI en wordt identiek herkend aan die op de Chenbro expander kaarten in beide andere kasten.

Zit nu nog geen schijf in maar op eerste gezicht bevalt de kast mij qua constructie wel. Is nog wel afwachten hoe de temperaturen gaan zijn aangezien de ingebouwde expander backplane weinig airflow lijkt toe te laten.

Kast gekocht omdat ik de raid5 arrays van 6 schijven wil samenvoegen en migreren naar raid6 arrays van 12 schijven. DAt zou nog wel even kunnen duren maar de kastruimte is er

[ Voor 12% gewijzigd door BartNL op 18-04-2015 15:53 ]

Vandaag zijn er 2 Icy Dock Black Vortex MB074SP-1B bezorgd.

1ste impressie, bouwkwaliteit over algemeen goed.

De locks voor de schijven hadden wat beter mogen zijn, het zijn letterlijk plastic schuifjes die een millimeter of 3 achter het metaal komen wanneer ze gelockt zijn.

"Compatible with most 120mm fans" betekent in dit geval, ja als die een molex aansluiting heeft of je een adapter hebt.

Mounting van de cage is een klein probleem met mijn behuizing. Ik gebruik namelijk een oude Thermaltake tower waarin een van de eerste toolles pogingen is gedaan en dat komt toch niet helemaal perfect uit.

Als je een behuizing hebt waar gewoon aan beide kanten 4 schroefjes er in kunnen moet dat verder geen probleem zijn.

1ste impressie, bouwkwaliteit over algemeen goed.

De locks voor de schijven hadden wat beter mogen zijn, het zijn letterlijk plastic schuifjes die een millimeter of 3 achter het metaal komen wanneer ze gelockt zijn.

"Compatible with most 120mm fans" betekent in dit geval, ja als die een molex aansluiting heeft of je een adapter hebt.

Mounting van de cage is een klein probleem met mijn behuizing. Ik gebruik namelijk een oude Thermaltake tower waarin een van de eerste toolles pogingen is gedaan en dat komt toch niet helemaal perfect uit.

Als je een behuizing hebt waar gewoon aan beide kanten 4 schroefjes er in kunnen moet dat verder geen probleem zijn.

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

Hmm er staat op de website van de fabrikant dat een 120 mm fan een 3 pin stekker moet hebben. Dan klopt dat dus niet eens..

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Afgelopen week een inter-tech 4U-4424 gekocht om verder uit te kunnen breiden.

Ik krijg het echter niet voor elkaar om een areca 1680ix-24 via de 8088 poort te koppelen aan een HP SAS Expander op de 8088 poort. De controller blijft hangen tijdens het laden van bios en reboot na 300 seconden.

Als ik de HP Expander intern koppel aan de Areca (8087->8087) dan werkt alles naar behoren. Is dit niet erg vreemd? De interne poorten van de areca zitten achter de build-in expander chip. Intern koppelen zou in theorie eerder compatibiliteitsproblemen moeten geven.

De HP Expander zit op firmware 2.10 en de areca op 1.51. Volgens mij zijn dit de laatste versies.

Iemand die ervaring heeft met een HP Expander achter een 1680ix op de externe poort?

Ik krijg het echter niet voor elkaar om een areca 1680ix-24 via de 8088 poort te koppelen aan een HP SAS Expander op de 8088 poort. De controller blijft hangen tijdens het laden van bios en reboot na 300 seconden.

Als ik de HP Expander intern koppel aan de Areca (8087->8087) dan werkt alles naar behoren. Is dit niet erg vreemd? De interne poorten van de areca zitten achter de build-in expander chip. Intern koppelen zou in theorie eerder compatibiliteitsproblemen moeten geven.

De HP Expander zit op firmware 2.10 en de areca op 1.51. Volgens mij zijn dit de laatste versies.

Iemand die ervaring heeft met een HP Expander achter een 1680ix op de externe poort?

heb de HP extern via een 8088 kabel aan mijn 1882iX gehad en dat werkte gewoon. Wat ik mij zo kan bedenken is dat je 8088 kabel niet goed is of niet ver genoeg in een van de connectoren zit.

Mijn final upgrade is fysiek op 1 kabeltje na klaar:GioStyle schreef op zaterdag 28 december 2013 @ 19:34:

Case: Fractal Design Node 304 CPU: Intel Pentium G3220 Motherboard: Asus H87I-Plus RAM: Corsair Vengeance LP 2x 4GB CPU cooler: Stock Case fans: 1x Noctua NF-A14 FLX (5v) + 2x Noctua NF-B9 (5v) Harddrives: 6x Western Digital WD30EZRX Operating system: FreeNAS 9.1.1 Filesystem: ZFS Raid array configuration: RAIDZ2 Netto storage capacity: 12TB Network: Onboard (Intel I217) Power consumption (start-up): 120,6 watt Power consumption (idle, no spindown): 43,5 watt Power consumption (idle, spindown): xx,x watt Power supply: Seasonic G450

Deze storagebox wordt puur gebruikt voor mkv's (films/series) en om mijn VM's naar te back-uppen. Voor de rest niet echt spannend, het ging mij voornamelijk om de zuinigheid. Idle met spindown moet ik nog een keer meten, maar ik gok op ongeveer 28-30 watt.

| Name: | Hades 2.0 - 30TB NAS |

| Case: | Lian Li PC-Q26B |

| CPU: | Intel Pentium G3220 |

| Motherboard: | ASRock E3C224D4I-14S |

| Network: | Onboard 2x Intel Gbit lan + 1x Realtek IPMI |

| RAM: | Kingston ValueRAM KVR16LE11L/8 |

| Power supply: | Seasonic G450 |

| CPU cooler: | Stock |

| Case fans: | Stock fans (4x) |

| Backplanes: | Lian Li BP2SATA (5x) |

| USB1: | MicroSD 16GB + adapter (FreeNAS boot) |

| USB2: | MicroSD 16GB + adapter (Logs) |

| Harddrives: | Western Digital WD30EZRX (10x) |

| Operating system: | FreeNAS 9.3 |

| Filesystem: | ZFS |

| Raid array configuration: | RAIDZ2 |

| Bruto storage capacity: | 30TB |

| Netto storage capacity: | 24TB |

| Power consumption (off): | 4,0 watt |

| Power consumption (start-up): | 172,6 watt |

| Power consumption (idle, no spindown): | 74,3 watt |

| Power consumption (idle, spindown): | 48,5 watt |

| Pool performance (pool 22% gevuld): | Read = 886MB/s, write = 553MB/s |

| Scrub performance: | 590MB/s |

Pics or it didn't happen:

Ik wacht nog op een USB kabeltje zodat ik de 2 microsd adapters achter het moederbord kwijt kan. Nu zit de ene rechtstreeks op het moederbord en de andere aan de achterkant van de kast. Ik wil ze liever allebei aan de binnenkant hebben.

Er komt misschien binnenkort nog een reepje geheugen erbij, en dan is het voorlopig wel goed zo.

Als 10Gbit gemeengoed wordt, kan ik altijd nog een aparte kaart erin prikken. Mocht ik later ruimte tekort komen, dan ga ik de schijven 1 voor 1 vervangen door grotere exemplaren.

nette bekabeling! Neem me ook al lange tijd voor om dat in mijn setup ooit te fatsoeneren. Vergeleken bij dit is het bij mijn setup met minder kabels meer chaos. Zie gelukkig dat er bij jou ook nog sata connector los hangt

Ziet er erg netjes uit!GioStyle schreef op dinsdag 21 april 2015 @ 22:39:

[...]

Mijn final upgrade is fysiek op 1 kabeltje na klaar:

Op het internet gebruiken we echter altijd een 'banana for scale'.

Erg vette build!!GioStyle schreef op dinsdag 21 april 2015 @ 22:39:

[...]

Mijn final upgrade is fysiek op 1 kabeltje na klaar:

[...]

Hoe zit het met de temperatuur van alle verschillende componenten? Waarom heb jij gekozen voor de Western Digital WD30EZRX?

Thanks@hierboven.

Waarom de WD30EZRX? Meest GB/prijs en 1 van de zuinigste schijven.

Temperaturen zijn dik in orde. De ventilatoren bieden genoeg airflow, alleen de bovenste ventilator laat de kast resoneren, waardoor echt lawaai ontstaat. Anders is het geheel vrij stil, moet nog een mooie oplossing zien te vinden. Ik denk dat ik een pwm ventilator ga aanschaffen, kijken of dat het probleem oplost.14ml337 schreef op vrijdag 15 mei 2015 @ 12:51:

[...]

Erg vette build!!Dit is precies wat ik zou willen hebben. Wat ik me afvraag zijn 2 dingen:

Hoe zit het met de temperatuur van alle verschillende componenten? Waarom heb jij gekozen voor de Western Digital WD30EZRX?

Waarom de WD30EZRX? Meest GB/prijs en 1 van de zuinigste schijven.

M’n 2TB schijven zaten bijna vol & ze waren al weer een jaar of 4 oud, dus het was tijd voor een upgrade:

Ik heb dus een beetje een vreemde eend gecreëerd, dus ik zal wat uitleg geven over hoe dit alles functioneert

- De USB stick zit op de interne USB poort van het het moederbord geprikt & daar staat ESXi op geïnstalleerd.

- De M5015 controller voorziet ESXi van een RAID-1 datastore, bestaande uit 2x 480GB SSDs.

- De Areca controller, onboard SATA controller & 10Gbit intel NIC zijn doorgegeven aan een Windows 2012R2 VM, welke functioneert als file-server.

- De twee overige 480GB SSDs zitten in een RAID-0 opstelling aangesloten op de onboard controller. Hier staat al m’n tijdelijke data op.

- De 12x 4TB schijven zitten in een RAID-6 opstelling aangesloten op de Areca controller. De schijven spinnen na 30 minuten idle down.

- De Linux VMs maken alleen gebruik van de datastore & een gedeelde NIC, geen speciale fratsen.

Ik heb nog wat problemen met de cooling, de case fans zijn erg luid & de achterste draait continu op volle toeren. Dit is mogelijk een probleem met m’n moederbord, omdat deze niet goed overweg zou kunnen met een combinatie van 3-pin & 4-pin fans.

Verder moet ik nog een fan aanschaffen welke ik over de controllers heen kan laten waaien. De Areca staat er om bekend dat ie heet wordt, maar de IBM vind het ook niet leuk om boven m’n NIC te zitten. Qua temperatuur zou het beter zijn om de IBM en NIC om te draaien, maar dat zou mogelijk de performance niet ten goede komen omdat het onderste slot op de PCH zit aangesloten. Om het probleem nu even te omzeilen staat er nu een USB fan op gericht

Ik zal dus met de tijd nog een kleine update plaatsen.

| System specifications | |

| Component | Value |

|---|---|

| Case | Lian-Li PC-A76WX |

| SSD enclosure | Icy Dock ThoughArmor, 4x 2.5” |

| PSU | Corsair HX750 |

| CPU | Intel Xeon E3-1220v2 |

| RAM | 4x 8GB Kingston, PC3-10600, ECC |

| Motherboard | Supermicro X9SCM-F |

| Controller 1 | IBM ServerRAID M5015, 8-Port |

| Controller 2 | Areca ARC-1280ML, 24-Port |

| USB | 1x Sandisk Cruzer, 32GB |

| SSD | 4x Intel S3500, 480GB |

| HDD | 12x HGST 7K4000 4TB |

| RAID array 1 | VM-datastore, RAID-1, 2x 480GB SSD= 480GB netto |

| RAID array 2 | Data temp, RAID-0, 2x 480GB SSD= 960GB netto |

| RAID array 3 | Data, RAID-6, 12x 4TB HDD= 40TB netto |

| Network 1 | Onboard 1 Gbit/s Ethernet, LAN |

| Network 2 | Intel 10 Gbit/s Ethernet, Workstation (p2p) |

| UPS | Nee |

| Idle power usage | Nooi gemeten |

| Operating system | VMware ESXi 6 |

| VM 1 | Windows 2012R2 (file-server) |

| VM 2 | Fedora 21 (Web-server) |

| VM 3 | Fedora 21 (Cacti + Nagios) |

| VM 4 | Fedora 21 (Werk projecten |

Ik heb dus een beetje een vreemde eend gecreëerd, dus ik zal wat uitleg geven over hoe dit alles functioneert

- De USB stick zit op de interne USB poort van het het moederbord geprikt & daar staat ESXi op geïnstalleerd.

- De M5015 controller voorziet ESXi van een RAID-1 datastore, bestaande uit 2x 480GB SSDs.

- De Areca controller, onboard SATA controller & 10Gbit intel NIC zijn doorgegeven aan een Windows 2012R2 VM, welke functioneert als file-server.

- De twee overige 480GB SSDs zitten in een RAID-0 opstelling aangesloten op de onboard controller. Hier staat al m’n tijdelijke data op.

- De 12x 4TB schijven zitten in een RAID-6 opstelling aangesloten op de Areca controller. De schijven spinnen na 30 minuten idle down.

- De Linux VMs maken alleen gebruik van de datastore & een gedeelde NIC, geen speciale fratsen.

Ik heb nog wat problemen met de cooling, de case fans zijn erg luid & de achterste draait continu op volle toeren. Dit is mogelijk een probleem met m’n moederbord, omdat deze niet goed overweg zou kunnen met een combinatie van 3-pin & 4-pin fans.

Verder moet ik nog een fan aanschaffen welke ik over de controllers heen kan laten waaien. De Areca staat er om bekend dat ie heet wordt, maar de IBM vind het ook niet leuk om boven m’n NIC te zitten. Qua temperatuur zou het beter zijn om de IBM en NIC om te draaien, maar dat zou mogelijk de performance niet ten goede komen omdat het onderste slot op de PCH zit aangesloten. Om het probleem nu even te omzeilen staat er nu een USB fan op gericht

Ik zal dus met de tijd nog een kleine update plaatsen.

Met een dergelijke kast zou je ook kunnen overwegen om met een flexibele riser een kaart een stuk naar beneden te plaatsen. Maar met opstellingen als deze is het wel weer duidelijk dat er een andere behuizing nodig is waar meer rijen schijven achter elkaar komen. Nu is het ding zo groot voor al die discs. Overigens wel een enthousiaste Cruzer voor alleen ESXi.

Ik vind het wel leuk om te zien hoe klein die X9SCM-F zo op deze manier lijkt. Ik heb hem zelf ook en in mijn geval hangt er van alles omheen zodat het super druk is in de kast. Maar zo op deze manier is het maar een klein micro ATX bordje in een grote kast. Ik zou er een ITX moederbordje bijhangen.

Ik vind het wel leuk om te zien hoe klein die X9SCM-F zo op deze manier lijkt. Ik heb hem zelf ook en in mijn geval hangt er van alles omheen zodat het super druk is in de kast. Maar zo op deze manier is het maar een klein micro ATX bordje in een grote kast. Ik zou er een ITX moederbordje bijhangen.

Ziet er netjes uit, misschien een fan die van bovenaf blaast monteren, zoals bij mijn machine (niet super netjes maar werkt wel goed)?brederodekater schreef op vrijdag 15 mei 2015 @ 21:12: