"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ik heb op dit moment 15TB netto storage met 5GB geheugen en van het ene volume naar het andere volume kopiëren ging aan 100MB/s. Meer performance is leuk maar de vraag is of je daar een praktisch nut voor hebt.

Kijk als je hem vol gooit met VM's kan ik het prima begrijpen maar ik draai precies wat hij ook wilt gaan draaien en heb op geen enkel moment geheugen tekort.

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Momenteel heb ik een externe HD aan een oude Airport Extreme hangen. Schrijven gaat aan 5MB/s en lezen aan een whopping 8MB/s. En hoewel ik wat geduld moet hebben, werkt het overigens wel perfect. Schrijven zal bij mij steeds over WiFi gebeuren, dus dat zal nooit boven de 20MB/s geraken...

ZFS is nieuw voor mij, alsook ESXi (wel uitgebreid ervaring met Xen).

Bied ik de ZSF storage het best aan via iSCSI aan de overige VM's?

@Tsurany, hoe heb jij dat lopen? En hoe zit het bij jou met stroomverbruik?

Of dat goed genoeg performed voor jou kan ik niet beoordelen, met lichte workloads (en veel van de zware kun je mogelijk in de ZFS OS zelf al doen, zoals transcoden en downloaden) moet dat wel goed komen. Als dat te slecht gaat kun je ofwel een SLOG toevoegen ofwel iSCSI gebruiken

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Mijn datastore staat niet op FreeNAS maar op een aparte disk. Die wilde ik niet op FreeNAS hebben draaien zodat ik bij problemen FreeNAS een reboot kan geven zonder dat de rest onderuit gaat.

Wat ik heb gedaan is FreeNAS ingezet voor de storage en alle hardeschijf controllers doorgegeven aan deze VM. FreeNAS deelt alles weer via SMB naar de rest van het netwerk.

Op mijn Ubuntu machine draaien alle services (Apache, Sickbeard, Sabnzbd, Plex,...) en ik heb de shares van FreeNAS gemapped naar /FreeNAS/Media en /FreeNAS/Download. Dit had ik eerst via NSF gedaan maar dat gaf wat issues met rechten en performance, via SMB gaat het prima.

Performance geef ik helemaal niks om. Het is een leuk getal maar in mijn praktijk bestaat het gebruik uit backups (zeer lage load want incrementeel) en het downloaden/streamen van Media. Het downloaden is beperkt aan mijn internetverbinding (100Mb/s) en het streamen komt niet boven de 50Mb/s uit.

Mijn manier is wellicht niet de manier die velen zouden prefereren maar het is een manier die voor mij goed werkt. FreeNAS zo min mogelijk laten doen, zo min mogelijk afhankelijkheden tussen de systemen en zorgen dat issues op de download/stream VM niet mijn data kunnen beïnvloeden.

[ Voor 10% gewijzigd door Tsurany op 14-01-2014 17:20 ]

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

http://www.u-nas.com/xcar...p?productid=17617&cat=249

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Verwijderd

Met:

1 IBM1015

2 Wat Intel NIC's

Wat gaat erop draaien?

2x pfSense (3 NIC poorten nodig)

1x FreeBSD als NAS (aparte NIC)

wat Linux versies (aparte NIC)

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1220LV2 Tray | € 182,38 | € 182,38 |

| 1 | MSI Z77A-G45 | € 85,99 | € 85,99 |

| 4 | WD Blue WD10JPVX, 1TB | € 59,- | € 236,- |

| 3 | Intel Gigabit CT Desktop Adapter | € 21,- | € 63,- |

| 1 | Thermalright IFX-14 Inferno Fire Extinguisher | € 23,99 | € 23,99 |

| 2 | Crucial Ballistix Sport BLS2CP8G3D1609DS1S00CEU | € 105,54 | € 211,08 |

| 1 | Seasonic G-Serie 360Watt | € 54,99 | € 54,99 |

| Bekijk collectie Importeer producten | Totaal | € 857,43 | |

en uiteraard een 4pins ATX -> 8pins ATX verloop stekker of een Molex -> 8pins ATX echter geen idee of de voeding dat gaat trekken.

[ Voor 20% gewijzigd door Verwijderd op 14-01-2014 22:54 ]

Mag ik vragen waarom 2x pfSense? Redundant internet aansluiting?Verwijderd schreef op dinsdag 14 januari 2014 @ 20:35:

2x pfSense (3 NIC poorten nodig)

Verwijderd

natuurlijk mag je dat vragen. het is deels bedrijfsmatig en deels prive en dat wil ik zoveel mogelijk gescheiden houden. ene is voor onze B&B die wij gaan overnemen, de gasten gaan via een eigen Wifi netwerk surfen e.d. en de andere is voor ons zelf om de grote boze buitenwereld buiten te houden.Neptunus schreef op woensdag 15 januari 2014 @ 07:50:

[...]

Mag ik vragen waarom 2x pfSense? Redundant internet aansluiting?

In principe heeft pfSense zelf al functionaliteit om netwerken gescheiden. Dus 2 x pfSense zou niet hoeven.Verwijderd schreef op woensdag 15 januari 2014 @ 09:30:

[...]

natuurlijk mag je dat vragen. het is deels bedrijfsmatig en deels prive en dat wil ik zoveel mogelijk gescheiden houden. ene is voor onze B&B die wij gaan overnemen, de gasten gaan via een eigen Wifi netwerk surfen e.d. en de andere is voor ons zelf om de grote boze buitenwereld buiten te houden.

Verwijderd

ja ik weet het, werk dagelijks met beveiliging maar ik slaap lekkerder als de pfSense voor gasten eigen NIC's heeft, eigen vSwitch met een VLAN sausje eroverVorCha schreef op woensdag 15 januari 2014 @ 09:34:

[...]

In principe heeft pfSense zelf al functionaliteit om netwerken gescheiden. Dus 2 x pfSense zou niet hoeven.

Waarom zou je dat doen?Verwijderd schreef op dinsdag 14 januari 2014 @ 20:35:

en uiteraard een 4pins ATX -> 8pins ATX verloop stekker of een Molex -> 8pins ATX echter geen idee of de voeding dat gaat trekken.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

omdat de voeding een ATX 4pins heeft en moederbord 8pins ATX heeft, althans, zo snap ik het

Die 4 pins ATX past in een 8 pins aansluiting op het moederbord. Een verloopje heb je dan niet nodig.Verwijderd schreef op woensdag 15 januari 2014 @ 10:09:

[...]

omdat de voeding een ATX 4pins heeft en moederbord 8pins ATX heeft, althans, zo snap ik het

Verwijderd

dan mis ik toch 4 pinnetjes? of sla ik hier de plank mis?tsjoender schreef op woensdag 15 januari 2014 @ 10:11:

[...]

Die 4 pins ATX past in een 8 pins aansluiting op het moederbord. Een verloopje heb je dan niet nodig.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

ben benieuwd wat mijn hersenspinsel gaat verstoken aan Wattjes met die 1015, wat NIC's, de HDD's en de videokaart/alle overbodige opties uitgezet in het BIOS...

Dedicated nics per lan daar kan ik nog enigszins in komen, maar 2x een pfsense appliance?? Guest en private lan kan je toch volledig scheiden mbv fw rules?Verwijderd schreef op woensdag 15 januari 2014 @ 09:36:

[...]

ja ik weet het, werk dagelijks met beveiliging maar ik slaap lekkerder als de pfSense voor gasten eigen NIC's heeft, eigen vSwitch met een VLAN sausje erover

- Deze advertentie is geblokkeerd door Pi-Hole -

Verwijderd

yes sir en weet legio systeempjes die zo draaien (en zelf heb opgezet (als cluster)) maar wil 1 met basic functionaliteit en 1 met packages als OpenVPN en weet-ik-wat. en dat wil ik gescheiden houden zodat ik kan rommelen/rebooten wanneer ik wil.A1AD schreef op woensdag 15 januari 2014 @ 19:28:

[...]

Dedicated nics per lan daar kan ik nog enigszins in komen, maar 2x een pfsense appliance?? Guest en private lan kan je toch volledig scheiden mbv fw rules?

Ik zag bij het posten van dit bericht staan dat algemene VT-vragen hier niet thuishoren, maar in het "grote thuis-virtualisatie topic" staat dan weer het volgende:

Aangezien ik hier meer verzoekjes tot config-controle zie, hoop ik dat dit bericht hier ook thuis hoort.HyperBart schreef op zaterdag 20 augustus 2011 @ 14:25:

Noot: Dit topic is uit interesse gegroeid vanuit Zuinige ESXi Server, ga voor vragen en discussie daar naar toe. Gebruik dit topic uitsluitend om je systeem te showen.

Ik wil al een tijdje een ZFS-pool aanleggen, en om dat plan eens concreet te maken, leek het me een goed idee om meteen een virtualisatie-server te bouwen. Naast het hosten van een ZFS-OS (bij voorkeur Nas4free), hoeft allemaal niet veel te kunnen; het idee erachter is meer om niet ook een aparte fysieke download/web/plex/etc-server te hebben draaien. Normaal thuisgebruik dus, denk ik. Ik wil er trouwens wel bijzeggen dat ik door het lezen van allerlei artikelen vrij paranoide ben geworden omtrent het niet gebruiken van ECC-geheugen. Voor die paar tientjes bespaar ik me graag een hoop problemen.

Nu lijkt hardwarematige virtualisatie het verstandige plan, met bijvoorbeeld de volgende (goedkope AMD) setup:

| # | Product | Prijs | Subtotaal |

| 1 | AMD FX-8320 Black Edition | € 131,- | € 131,- |

| 1 | Asus M5A78L-M/USB3 | € 54,50 | € 54,50 |

| 1 | Kingston ValueRAM KVR16LE11L/8 | € 77,- | € 77,- |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 127,05 | € 127,05 |

| Bekijk collectie Importeer producten | Totaal | € 389,55 | |

Zo gebruik je met ESXi de on-board HBA voor guests, en de RAID-controller voor Nas4free.

Door het lezen van een aantal posts her en der (bijvoorbeeld deze: FireDrunk in "Zuinige ESXi Server"), krijg ik echter de indruk dat ik geen hardwarematige virtualisatie nodig zal hebben. Als ik het goed lees, kan ik losse schijven op de onboard HBA namelijk via RDM verdelen over de guests (en dus ook allemaal naar Nas4free). Dat scheelt me weer geld voor de RAID-controller en een dure CPU (ik heb nog een pricewatch: Intel Pentium G2020 Boxed liggen).

Ik vermoed alleen dat ik hier een denkfout maak, of toch te weinig/verkeerd gelezen te hebben, want dit klinkt alsof hardwarematige virtualisatie in dit geval onhandig is voor mij. Kan iemand me eventueel corrigeren?

In dat laatste geval kun je namelijk veel beter de hele virtualisatie overslaan. Als je paranoïde wordt van non-ECC geheugen dan moet je al helemaal niet aan RDM's beginnen, en dus ofwel niet virtualiseren of VT-d gebruiken om een controller door te geven zodat het ZFS OS er zo rechtstreeks mogelijk bij kan.

Met het juiste moederbord kun je overigens een onboard HBA doorgeven waardoor je geen losse HBA nodig hebt

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ik wilde inderdaad bijvoorbeeld Ubuntu server ernaast gaan draaien voor eerder genoemde toepassingen. Maargoed, RDM toepassen is dus risicovol, begrijp ik?Paul schreef op donderdag 16 januari 2014 @ 18:09:

Ga je nog meer VM's draaien of ga je alleen (bijvoorbeeld) Nas4free draaien?

In dat laatste geval kun je namelijk veel beter de hele virtualisatie overslaan. Als je paranoïde wordt van non-ECC geheugen dan moet je al helemaal niet aan RDM's beginnen, en dus ofwel niet virtualiseren of VT-d gebruiken om een controller door te geven zodat het ZFS OS er zo rechtstreeks mogelijk bij kan.

Met het juiste moederbord kun je overigens een onboard HBA doorgeven waardoor je geen losse HBA nodig hebt

Een hele on-board HBA doorgeven is inderdaad een optie op het moment dat je iets als Nas4free vanaf een USB-stick draait, maar dat is niet langer een optie op het moment dat je een SSD wil inzetten voor verschillende VM guests, toch? Ik las overigens ook dat je HBA's van sommige moederborden kan splitten. Ik kan alleen nergens een lijst van dat soort moederborden vinden...

Maar er staan resultaten in deze thread (of die van ZFSGuru) waarin het met ESXi 5.5 redelijk stabiel lijkt te werken.

Met VT-d kun je soms een (van de) controllers van je moederbord doorgeven aan een VM. Maar je moet altijd nog een controller hebben voor je datastore. VMs kunnen niet op USB staan nl.

Wat je nodig hebt met ZFS (wil het een beetje betrouwbaar zijn) is iets om een controller rechtstreeks aan een VM te mappen. Daar heb je VT-d nodig, en dat zit uit marketingoverwegingen vooral in de duurdere reeksen.

Op mux' blog: BBG Zuinige fileserver (Dec '13/Jan '14) staan een paar setups. Laat je door de prijzen niet direct uit het veld slaan, ~800 euro daarvan is voor de harde schijven. Dan nog is het toch inderdaad een stuk duurder dan de (minimale, zeker qua ram) setup die je eerder postte

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Met hardwarematige virtualisatie bedoel ik inderdaad VT-d of AMD-vi; mijn excuses als ik terminologie door elkaar haal.Paul schreef op donderdag 16 januari 2014 @ 23:09:

Wat bedoel je met hardwarematige virtualisatie? Vrijwel alle moderne processoren ondersteunen VT-x of AMD-V, dat is een optie in de processor om in hardware te virtualiseren.

Wat je nodig hebt met ZFS (wil het een beetje betrouwbaar zijn) is iets om een controller rechtstreeks aan een VM te mappen. Daar heb je VT-d nodig, en dat zit uit marketingoverwegingen vooral in de duurdere reeksen.

Op mux' blog: BBG Zuinige fileserver (Dec '13/Jan '14) staan een paar setups. Laat je door de prijzen niet direct uit het veld slaan, ~800 euro daarvan is voor de harde schijven. Dan nog is het toch inderdaad een stuk duurder dan de (minimale, zeker qua ram) setup die je eerder postte

Het blijkt inderdaad dat ik teveel voor een duppie op de eerste rang wil: ik wil naast een ZFS OS extra VM's draaien, maar het liefst geen aparte controller aanschaffen (en dus VT-d of AMD-vi nodig hebben). Gaat gewoonweg niet, omdat VM guests en ZFS pool(s) op fysiek aparte HBA's "moeten" draaien, wil je het veilig doen. Tenminste, dat lijkt mij dus de conclusie uit het bovenstaande.

Ik denk dat ik het systeem met financiële redenen maar stuk voor stuk ga bouwen: wel investeren in een Supermicro bord, de G2020 die ik heb liggen erin prikken, en vanaf een USB stick Nas4free draaien en de onboard HBA gebruiken voor de ZFS pool. Investeer ik later wel in een Xeon processor en die IBM controller, waar ik mijn ZFS pool dan theoretisch op zou kunnen prikken.

Kijk eens naar mijn systeem:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 148,99 | € 148,99 |

| 1 | ASRock B75 Pro3-M | € 50,90 | € 50,90 |

| 1 | Corsair CMV8GX3M2A1333C9 | € 68,60 | € 68,60 |

| 1 | Conceptronic PCI Express Card SATA 600 | € 25,43 | € 25,43 |

Ik kan alle poorten van het moederbord doorgeven via VT-D en daarnaast geef ik nog de twee SATA poorten van de PCI-Express controller door.

Het "lastige" aan deze setup is dat je kan kiezen tussen of geen enkele SATA poort van het moederbord doorgeven of alle SATA poorten doorgeven. De PCI-Express controller moet ik ook doorgeven. Komt door een issue op de chipset waardoor hij enkel alle poorten met dezelfde chipset kan doorgeven.

Je hebt dus geen poort over voor je datastore. Dit heb ik opgelost met een SIL3114 kaartje. Deze zijn voor onder de 20 euro op eBay te verkrijgen. Er zijn ook kaarten van Sweex en Conceptronics met dezelfde chipset en die zullen ook prima werken.

Je hebt ook de SIL3112, zelfde kaartje maar dan met slechts twee SATA poorten. Ik heb een Conceptronics kaart met de SIL3114 chipset genomen omdat ik hem van een Tweaker kon overnemen waardoor ik hem snel had.

Deze configuratie gebruik ik nu voor FreeNAS waarbij ik 10 SATA poorten kan doorgeven aan FreeNAS. Moederbord wordt in ESXi 5.1 volledig ondersteund waardoor netwerk ook prima werkt. Daarnaast heb ik gewoon een 250GB datastore waar ik al mijn VM's op neer kan zetten. Ook kan ik er voor kiezen om enkel FreeNAS op de datastore te zetten en de rest van de VM's op een door FreeNAS gedeelde map te zetten.

Mijn setup is volgens mij de goedkoopste manier om VT-D te krijgen met een volledig ondersteund moederbord met 8xSATA.

[ Voor 7% gewijzigd door Tsurany op 17-01-2014 09:13 ]

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Ik weet wel dat het hier over zuinige ESXi servers gaat, maar je kan natuurlijk ook overwegen om een FreeBSD install te nemen (of bv. ZFSguru waar een complete freeBSD install onder zit) en daar ook Virtualbox op te draaien. Dan kan je prima wat andere servertjes virtualiseren. Het geeft niet de performance van een hypervisor zoals ESXi, maar je krijgt wel wat je hebben wil voor zo min mogelijk investeringskosten.V_Lichtenberg schreef op vrijdag 17 januari 2014 @ 08:44:

[...]

Met hardwarematige virtualisatie bedoel ik inderdaad VT-d of AMD-vi; mijn excuses als ik terminologie door elkaar haal.

Het blijkt inderdaad dat ik teveel voor een duppie op de eerste rang wil: ik wil naast een ZFS OS extra VM's draaien, maar het liefst geen aparte controller aanschaffen (en dus VT-d of AMD-vi nodig hebben). Gaat gewoonweg niet, omdat VM guests en ZFS pool(s) op fysiek aparte HBA's "moeten" draaien, wil je het veilig doen. Tenminste, dat lijkt mij dus de conclusie uit het bovenstaande.

Ik denk dat ik het systeem met financiële redenen maar stuk voor stuk ga bouwen: wel investeren in een Supermicro bord, de G2020 die ik heb liggen erin prikken, en vanaf een USB stick Nas4free draaien en de onboard HBA gebruiken voor de ZFS pool. Investeer ik later wel in een Xeon processor en die IBM controller, waar ik mijn ZFS pool dan theoretisch op zou kunnen prikken.

Overigens is het niet zo dat je ZFS op een apparte HBA moet draaien. Je kan ZFS ook wel draaien op een gevirtualiseerde controler. Een aantal voordelen dat ZFS bied ben je dan kwijt. Data corruptie kan sneller optreden doordat je een extra virtualisatie laag hebt die een zwakke schakel kan zijn in het geheel. Als je data je dus lief is, kun je het betere niet doen. Maar in principe houd niets je tegen.

Dit soort setups heb ik inderdaad overwogen, maar het gebruik van ECC-geheugen is voor mij toch wel een harde eis.Tsurany schreef op vrijdag 17 januari 2014 @ 09:08:

Mijn setup is volgens mij de goedkoopste manier om VT-D te krijgen met een volledig ondersteund moederbord met 8xSATA.

Het is inderdaad een goed idee om me hier eens over in te lezen, dank je welMystic Spirit schreef op vrijdag 17 januari 2014 @ 09:12:

Ik weet wel dat het hier over zuinige ESXi servers gaat, maar je kan natuurlijk ook overwegen om een FreeBSD install te nemen (of bv. ZFSguru waar een complete freeBSD install onder zit) en daar ook Virtualbox op te draaien. Dan kan je prima wat andere servertjes virtualiseren. Het geeft niet de performance van een hypervisor zoals ESXi, maar je krijgt wel wat je hebben wil voor zo min mogelijk investeringskosten.

Nope, vandaar dat ik "moeten" zeiMystic Spirit schreef op vrijdag 17 januari 2014 @ 09:12:

Overigens is het niet zo dat je ZFS op een apparte HBA moet draaien.

V&A aangeboden: ESXi whitebox - desktop

:):):)

Ik had de keuze om te retry-en, maar de pop-up bleef terugkomen, dus heb ik de machine afgesloten.

De vmdk is thin provisioned (8GB) op de datastore die nog 20GB vrij heeft.

Provisioned: 8,07GB

Not-shared Storage: 4,42 GB

Used Storage: 4,42GB

In ZFSGuru: (geïnstalleerd op pool OS)

" os 15 RAID0 (no redundancy) 7.94G 2.92G 5.02G ONLINE"

Hoop dat 't eenmalig is en blijft, of doe ik iets verkeerd?

Echter ben ik vergeten na te denken over de SAS/Sata aansluitingen. Hierover heb ik nog 2 twee vragen:

1) Ik weet niet exact hoe ik de 6 Sata schijven aansluit op de X10SL7-F. Dien ik daarvoor 2x een 3Ware Multi-lane SATA cable CBL-SFF8087OCF-05M aan te schaffen. En worden deze 2 kabels op 2 SAS poorten aangesloten? DE LSI 2308 wil ik flashen naar IT firmware. Gaat dat op deze manier?

2) Kan de SSD rechtstreeks op één van de sata poorten worden aansluiten?

| # | Product | Prijs | Subtotaal |

| 1 | Intronics MIni SAS 36 - 4x SAS 29F + 5.25" male (AK5689) | € 31,05 | € 31,05 |

Onderstaand heb ik besteld:

| # | Product | Prijs | Subtotaal |

| 1 | Supermicro X10SL7-F | € 257,85 | € 257,85 |

| 6 | WD Red SATA 6 Gb/s WD20EFRX, 2TB | € 86,45 | € 518,70 |

| 1 | Crucial 2.5" M500 240GB | € 118,04 | € 118,04 |

Je kunt ze met gewone SATA kabels op de SAS of SATA poorten aansluiten. Multilane connectoren zitten niet eens op het moederbord. SAS en SATA gebruiken in principe dezelfde kabels.Deem007492 schreef op zaterdag 18 januari 2014 @ 11:22:

Dankzij dit forum heb ik een mooie ESXI configuratie samengesteld en reeds besteld.

Echter ben ik vergeten na te denken over de SAS/Sata aansluitingen. Hierover heb ik nog 2 twee vragen:

1) Ik weet niet exact hoe ik de 6 Sata schijven aansluit op de X10SL7-F. Dien ik daarvoor 2x een 3Ware Multi-lane SATA cable CBL-SFF8087OCF-05M aan te schaffen. En worden deze 2 kabels op 2 SAS poorten aangesloten? DE LSI 2308 wil ik flashen naar IT firmware. Gaat dat op deze manier?

2) Kan de SSD rechtstreeks op één van de sata poorten worden aansluiten?

# Product Prijs Subtotaal 1 Intronics MIni SAS 36 - 4x SAS 29F + 5.25" male (AK5689) € 31,05 € 31,05

Onderstaand heb ik besteld:

# Product Prijs Subtotaal 1 Supermicro X10SL7-F € 257,85 € 257,85 6 WD Red SATA 6 Gb/s WD20EFRX, 2TB € 86,45 € 518,70 1 Crucial 2.5" M500 240GB € 118,04 € 118,04

Verwijderd

Zou dit een significante verbetering zijn tov mijn huidige proliant n40 die ik dan als dedicated freenas wil gaan inzetten?

Thnx!A1AD schreef op donderdag 02 januari 2014 @ 18:35:

Hier vind je de vmxnet3.ko driver voor freebsd 9.2 voor de mensen dat freenas oid virtualiseren.

En nog eens Thnx!

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1230V2 Boxed | € 196,- | € 196,- |

| 1 | Supermicro X9SCM-F | € 157,55 | € 157,55 |

| 3 | WD Green WD20EZRX, 2TB | € 70,95 | € 212,85 |

| 1 | Fractal Design Node 304 Zwart | € 65,- | € 65,- |

| 2 | Kingston KVR1333D3E9S/8G | € 76,90 | € 153,80 |

| 1 | Delock SATA-300 PCI Express Card, 2 Port | € 18,- | € 18,- |

| 1 | Seasonic G-Serie 360Watt | € 51,- | € 51,- |

| Bekijk collectie Importeer producten | Totaal | € 854,20 | |

Ik wilde graag ECC en VT-d met het doel om de onboard controller door te geven aan een FreeNAS VM voor ZFS en de extra controller te gebruiken voor de ESX(i) datastore. Vermoedelijk gaat dit werken, mocht het werken is het misschien iets wat in de topic start kan worden aangepast, want het lastigste was om een (goedkope) PCI-e adapter te vinden voor de datastore.

Ben erg benieuwd naar het verbruik, ik gok zo'n 40W idle.

EDIT: Voor de datastore ga ik een SSD gebruiken die ik nog heb liggen

Ik neem aan dat je voor een raidz oplossing gaat? (dus 4T effectief van de 6T ruwe data)

Ik vraag me af wat de performantie van die pci-e HBA is tov de pci tegenhangers. En al zeker met een SSD.Chronos schreef op dinsdag 21 januari 2014 @ 13:03:

Op basis van dit topic, het zuinige server topic en nog wat andere bronnen, o.a. freenas forums heb ik het volgende systeem samengesteld:

# Product Prijs Subtotaal 1 Intel Xeon E3-1230V2 Boxed € 196,- € 196,- 1 Supermicro X9SCM-F € 157,55 € 157,55 3 WD Green WD20EZRX, 2TB € 70,95 € 212,85 1 Fractal Design Node 304 Zwart € 65,- € 65,- 2 Kingston KVR1333D3E9S/8G € 76,90 € 153,80 1 Delock SATA-300 PCI Express Card, 2 Port € 18,- € 18,- 1 Seasonic G-Serie 360Watt € 51,- € 51,- Bekijk collectie

Importeer productenTotaal € 854,20

Ik wilde graag ECC en VT-d met het doel om de onboard controller door te geven aan een FreeNAS VM voor ZFS en de extra controller te gebruiken voor de ESX(i) datastore. Vermoedelijk gaat dit werken, mocht het werken is het misschien iets wat in de topic start kan worden aangepast, want het lastigste was om een (goedkope) PCI-e adapter te vinden voor de datastore.

Ben erg benieuwd naar het verbruik, ik gok zo'n 40W idle.

EDIT: Voor de datastore ga ik een SSD gebruiken die ik nog heb liggen

Voor mij persoonlijk is 16GB RAM te weinig. ZFS heeft al graag 8GB

- Deze advertentie is geblokkeerd door Pi-Hole -

@A1AD -> Performance van de pci-e HBA maakt mij niet zoveel uit, het is alleen voor de ESX(i) datastore eigenlijk. 16 GB RAM is inderdaad weinig, ik ga ZFS inderdaad zeker 8GB toebedelen. Verder ga ik niet veel zaken draaien die veel geheugen kosten, het is meer hobby dan financieel verantwoord om voor deze setup te gaan. Eventueel kan ik dit altijd nog bij prikken tot 32 GB mocht het nodig zijn.

Even niets...

Heb de X10SLL-F overwogen, maar ik las dat er problemen zijn/waren met het socket 1150 platform (iets met sleepstates en USB volgens mij?), misschien zijn die al opgelost, maar geen zin om het risico te lopen. Bovendien zijn de drivers verder doorontwikkeld van dit platform, dit is allemaal proven technology :-)FireDrunk schreef op dinsdag 21 januari 2014 @ 14:08:

Waarom nog niet het nieuwe Socket 1150 platform?

Daarnaast heb ik een voorkeur voor micro ATX en is de X10SLL-F slecht verkrijgbaar.

Qua verbruik zou het volgens mij zo'n 10-15W schelen idle, dat is zeker de moeite, maar weegt voor mij niet op tegen beschikbaarheid en verminderde kans op 'gezeik'.

Als iemand hier andere inzichten heeft hoor ik het natuurlijk graag

Rest is minder belangrijk.

Even niets...

Ik ben zelf juist aan het neigen om te gaan voor de 1150 sockets; een X10SLH-F (met 6xSATA3 en 2x USB3 achterop (ipv enkel via headers) ).. deze heeft 2 aparte i210AT NIC chips, die beide goed gesupport schijnen te zijn .. kost wellicht ietsjes meer dan de SLL-F/SLL+-F (30-50 euries).Chronos schreef op dinsdag 21 januari 2014 @ 18:11:

[...]

Heb de X10SLL-F overwogen, maar ik las dat er problemen zijn/waren met het socket 1150 platform (iets met sleepstates en USB volgens mij?), misschien zijn die al opgelost, maar geen zin om het risico te lopen. Bovendien zijn de drivers verder doorontwikkeld van dit platform, dit is allemaal proven technology :-)

Daarnaast heb ik een voorkeur voor micro ATX en is de X10SLL-F slecht verkrijgbaar.

Qua verbruik zou het volgens mij zo'n 10-15W schelen idle, dat is zeker de moeite, maar weegt voor mij niet op tegen beschikbaarheid en verminderde kans op 'gezeik'.

Als iemand hier andere inzichten heeft hoor ik het natuurlijk graag

Voordeel voor mij is dat de CPU waar ik waarschijnlijk voor wil gaan, de 1230Lv3, een TDP heeft van 25W, tegenover de 69W van de 1230v2 .. dus dat scheelt me ook gelijk in koeling benodigdheden ..

Speaking of which, ga je voor de stock intel cooler, of voor een stillere/zuinigere ?

http://www.asrockrack.com...l.asp?Model=E3C224D4I-14S

De E3C224D4I-14S, bijzonderheden:

Extended mini ITX met 4 DIMM en 8 x SAS2 via 2 x mini SAS 8087 connector LSI 2308

Nog nog een behuizing vinden.

Nou, eerst dat bord zou ik zeggen. Hij staat al een hele tijd op de Asrock website (zonder juist plaatje), maar is nog niet te krijgen.abusimbal schreef op dinsdag 21 januari 2014 @ 22:16:

Nog nog een behuizing vinden.

En dan zou ik een 8 bay U-Nas kiezen als behuizing (met dank aan abusimbal in "Zuinige ESXi Server"). Daar passen met wat knutselwerk ook nog een aantal SSD's bij om alle 6G poorten te kunnen gebruiken.

Mijn eerder genoemde 2U server gaat binnen een aantal weken richting datacenter. En dan is het tijd de thuis servers te vernieuwen. U-Nas met die Asrock staan op de wenslijst.

[ Voor 5% gewijzigd door The Lord op 22-01-2014 10:25 ]

Hoezo is dat niet het juiste plaatje, het type nummer lijkt me gewoon goed?The Lord schreef op woensdag 22 januari 2014 @ 10:24:

[...]

Hij staat al een hele tijd op de Asrock website (zonder juist plaatje), maar is nog niet te krijgen.

Op ASRock Rack wordt het inderdaad wel juist weergegeven.yamahabest schreef op woensdag 22 januari 2014 @ 10:41:

[...]

Hoezo is dat niet het juiste plaatje, het type nummer lijkt me gewoon goed?

Ik bedoelde de ASRock website. Daar is een en ander na de eerste aankondiging veranderd. En is er geen plaatje meer te zien.

Edit: Nu ik dat plaatje nog een keer bekijk denk ik niet dat Extended Mini ITX past in een U-Nas kast. Ik nam aan dat het bord dieper zou zijn en niet breder. Bord: DxB 17x21,3cm Kast: L x W x H 316mm x 254mm x 180mm.

[ Voor 16% gewijzigd door The Lord op 22-01-2014 12:31 ]

-Liefst zo klein mogelijk, wil een compacte server bouwen - non-storage.

-VTD

-Liefst volledige ondersteuning, niet dat ik nog een PCI Lan kaartje moet bijsteken ofzo..

-Socket 1150

-32GB ram ondersteund

Alvast bedankt!

Wil je mini-ATX, wil je micro-ATX?

Wat wil je gebruiken met VT-D, wat voor insteekkaart wil je doorgeven?

Wil je een I* processor, of een Xeon?

[ Voor 76% gewijzigd door yamahabest op 23-01-2014 16:44 ]

Je wilt mux' BBG es bekijken...DaBeast.net schreef op donderdag 23 januari 2014 @ 16:30:

Kan iemand me helpen met de keuze van moederbord? Er is zoveel keuze en kom er maar niet uit. Vind niet echt iets wat ik wil, en de compatibillity list van VMware is volgens mij niet echt compleet ofzo.

-Liefst zo klein mogelijk, wil een compacte server bouwen - non-storage.

-VTD

-Liefst volledige ondersteuning, niet dat ik nog een PCI Lan kaartje moet bijsteken ofzo..

-Socket 1150

-32GB ram ondersteund

Alvast bedankt!

Let wel, ik kwam daar ook al aanzetten met de X10SLH-F als mogelijk alternatief (in de comments) ... het is een afweging hoe veel je van SATA3 en USB3 houdt..

Bedenk trouwens wel dat VT-D ondersteuning 60% je CPU is, en 40% de chipsets die gebruikt worden ..

Die is niet ge-ent op ZFS-capable systemen.

Vooral het systeem "Mainstream (met VT-d)" zou wel eens passend kunnen zijn.

[ Voor 19% gewijzigd door yamahabest op 23-01-2014 16:49 ]

Had zelf wat leuke mini-ITX bordjes gevonden - hellaas max 16gb...yamahabest schreef op donderdag 23 januari 2014 @ 16:32:

Wat heb je zelf al uitgezocht?

Wil je mini-ATX, wil je micro-ATX?

Wat wil je gebruiken met VTD, wat voor insteekkaart wil je doorgeven?

Wil je een I* processor, of een Xeon?

Form factor maakt in principe niet veel uit, zolang hij maar een beetje compact is en ik er achteraf een leuke case voor vind

32GB ram is lastig in ITX, zeker in combinatie met vt-d, anders zou een Asrock C2750 nog interessant zijn. Als je die requirement kan laten vallen is een 2750 best nog een leuke keuze - al is het natuurlijk geen socket 1150.DaBeast.net schreef op donderdag 23 januari 2014 @ 16:30:

Kan iemand me helpen met de keuze van moederbord? Er is zoveel keuze en kom er maar niet uit. Vind niet echt iets wat ik wil, en de compatibillity list van VMware is volgens mij niet echt compleet ofzo.

-Liefst zo klein mogelijk, wil een compacte server bouwen - non-storage.

-VTD

-Liefst volledige ondersteuning, niet dat ik nog een PCI Lan kaartje moet bijsteken ofzo..

-Socket 1150

-32GB ram ondersteund

Alvast bedankt!

Heb je geen vertrouwen in de netwerkstack van je hypervisor? Netwerken aanmaken op de host is in zo goed als alle gevallen the way to go, ik kan eigenlijk geen enkele use case verzinnen voor het doorgeven van een fysieke netwerkkaartDaBeast.net schreef op donderdag 23 januari 2014 @ 16:49:

De VTD is eerder toekomst gericht, als ik een lan kaart wil doorgeven voor VLAN's.

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Iemand nog een optie?

Wat is je budget en wat heb je nodig ?

Atom C2750 rack barebone:

http://www.supermicro.nl/...1U/5018/SYS-5018A-TN4.cfm

Of AMD (Socket C32) Opteron 4000 serie

http://www.supermicro.nl/.../1U/1012/AS-1012C-MRF.cfm

Andere opties ga je ver boven de 1000 € komen.

[ Voor 137% gewijzigd door abusimbal op 23-01-2014 22:58 ]

Tuurlijk welPaul schreef op donderdag 23 januari 2014 @ 19:38:

[...]

Heb je geen vertrouwen in de netwerkstack van je hypervisor? Netwerken aanmaken op de host is in zo goed als alle gevallen the way to go, ik kan eigenlijk geen enkele use case verzinnen voor het doorgeven van een fysieke netwerkkaart

Server -- UTP -- NAS

Nas --UTP -- Router

Server -- UTP -- Router

Zo kan er communicatie gebeuren tussen mijn server en NAS zonder dat hij moet hoppen via de router.

Socket 1155yamahabest schreef op donderdag 23 januari 2014 @ 20:38:

Waarom niet voor dit bord gaan: pricewatch: ASRock H77 Pro4-M.

Zit in de BBG van Firedruknk.

Los daarvan, ik zie dan nog steeds niet in waarom je een fysieke nic met VT-d door zou willen geven aan een VM, je kunt gewoon die 2e pNIC aan een vSwitch knopen waar je de VM ook aan knoopt...

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Tenzij het een 100Mbit switch isPaul schreef op vrijdag 24 januari 2014 @ 08:36:

Als het allemaal L2 is dan is er helemaal niks mis met het feit dat je over een switch gaat

Ik heb de indruk dat DaBeast.net zich beter eerst verdiept in de materie? (no pun intended)Paul schreef op vrijdag 24 januari 2014 @ 08:36:

Los daarvan, ik zie dan nog steeds niet in waarom je een fysieke nic met VT-d door zou willen geven aan een VM, je kunt gewoon die 2e pNIC aan een vSwitch knopen waar je de VM ook aan knoopt...

[ Voor 45% gewijzigd door A1AD op 24-01-2014 12:16 ]

- Deze advertentie is geblokkeerd door Pi-Hole -

We weten nu al dat over 1 miljoen jaar de aarde niet meer bestaat omdat de zon dan ontploft is, maar moeten we ons daar nu al druk over maken?

Even niets...

Ik kom tenslotte om dingen bij te leren toch?

Als je geen bizarre dikke storage rig en ESXi bak in 1 wil maken, heb je geen VT-d nodig.

Wil je dat wel, VT-d is your pick.

Niet meer, en niet minder.

Even niets...

We weten nu al dat over 1 miljoen jaar de aarde niet meer bestaat omdat de zon dan ontploft is, maar moeten we ons daar nu al druk over maken?

[/quote]

5 miljard

[ Voor 10% gewijzigd door A1AD op 24-01-2014 17:34 ]

- Deze advertentie is geblokkeerd door Pi-Hole -

Even niets...

De gratis ESXi versie kan niet zulke geavanceerde dingen op networking gebied. Dat kun je omzeilen door die nic door te geven aan de vm en het OS in de vm alles te laten regelen. Het is niet altijd fijn om de networking laag van je hypervisor er tussen te hebben zitten, soms wil je een nic gewoon wat directer aan kunnen spreken. Met VT-d kun je dat. Sommige mensen vertrouwen de ingebouwde networking van de hypervisor ook gewoon niet (denk aan betrouwbaarheid maar ook aan security). Het is dan ook vaak een stukje persoonlijke voorkeur dat meespeelt.Paul schreef op vrijdag 24 januari 2014 @ 08:36:

Los daarvan, ik zie dan nog steeds niet in waarom je een fysieke nic met VT-d door zou willen geven aan een VM, je kunt gewoon die 2e pNIC aan een vSwitch knopen waar je de VM ook aan knoopt...

Voor VLANs is het niet nodig. Je koppelt een nic (of meerdere) aan een vSwitch en zet op die vSwitch weer een port group met het betreffende VLAN ID (je kunt zelfs meerdere port groups op zo'n vSwitch zetten). Aan de vm's ken je 1 of meerdere virtuele nics toe die je vervolgens weer aan een port group koppelt. Op die wijze kun je op dezelfde vSwitch een storage VLAN, client VLAN en VoIP VLAN creëren.

Het enige waarvoor je moet oppassen is bandbreedte. Voor bepaalde zaken is het handiger om 1 VLAN op een nic te zetten ipv meerdere (denk aan die storage VLAN). Er zijn een aantal mensen die om die reden juist 10Gbit nics gebruiken. En als je dan een dedicated nic voor 1 vm gebruikt kun je je weer gaan afvragen waarom je dan niet gewoon het ding direct doorgeeft aan de vm.

De meest belangrijke en eigenlijk ook enige reden waarom je een nic zou doorgeven aan een vm ipv de networking van de hypervisor gebruiken is driver support. ESXi kent een enorm beperkte driver support, beperkter dan wat menigeen als guest OS draait. Dat geeft je wat meer flexibiliteit wat nics betreft, je kunt namelijk dat oude spul wat je nog hebt liggen maar niet supported is door ESXi vaak toch nog gebruiken. Zit wel een kleine maar aan vast: niet alles werkt even lekker met VT-d.

Mocht ie ooit nog z'n NAS willen virtualiseren dan is VT-d ook wel erg fijn. Iets als RDM moet je niet willen, niet erg betrouwbaar.

Maar dannog, het *ALLER* grootste nadeel, is dat je VMXNET3 opgeeft.

Stel je geeft je storage VM een dedicated netwerkkaart, dan kunnen de VM's die daar bijzitten niet meer met 10Gb met die VM communiceren.

Bovendien, als je storage teruggeeft aan ESXi (door middel van NFS of iSCSI) moet dat dus persé over je switch heen. Dat is dubbel dubbel zonde. Dat veroorzaakt zoveel latency. Het is vele malen sneller als je VMXNET3 hebt en je geeft 'lokaal' ESXi storage vanuit een VM.

[ Voor 67% gewijzigd door FireDrunk op 26-01-2014 10:39 ]

Even niets...

Verwijderd

48mb/sec lijkt me wat weinig.... ?

[ Voor 10% gewijzigd door Verwijderd op 26-01-2014 12:54 ]

Ja, dvSwitches, de rest zit er afaik gewoon inppl schreef op zondag 26 januari 2014 @ 01:20:

De gratis ESXi versie kan niet zulke geavanceerde dingen op networking gebied.

Dat is de enige waar ik het nog enigszins mee eens kan zijn, maar dan heb je imho gewoon je huiswerk niet gedaanDe meest belangrijke en eigenlijk ook enige reden waarom je een nic zou doorgeven aan een vm ipv de networking van de hypervisor gebruiken is driver support.

True, maar dat was niet de vraagMocht ie ooit nog z'n NAS willen virtualiseren dan is VT-d ook wel erg fijn

[ Voor 6% gewijzigd door Paul op 26-01-2014 14:12 ]

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Maar als het om 4K Random Writes gaat valt het wel mee hoor

Kortom: We hebben iets meer informatie nodig...

Even niets...

Van het consumenten spul wellicht maar er zijn ook wat fibrechannel kaartjes die men nog wel eens wil gebruiken. Daar wil de schoen nog wel eens wringen wat driver support betreft. Als het iets is wat door velen gebruikt wordt is het vrij eenvoudig om zo'n community driver te verkrijgen en dit aan je ESXi installatie toe te voegen.FireDrunk schreef op zondag 26 januari 2014 @ 10:37:

De enige netwerkkaarten die echt *niet* werken zijn Atheros kaartjes volgens mij. De rest is met drivers er in te hacken? (i217v, i210, Realtek, i82579v / lm)

Hoe kom je daar nou weer bij? Je kunt prima meerdere netwerkkaarten aan een vm toevoegen zoals je dat ook doet bij een fysieke server. Daar is het gemeengoed om dingen als storage, management en het gewone verkeer strikt te scheiden (omwille van dingen als overhead, broadcasts, beheer en security). Daarnaast is de VMXNET3 ook nog lang niet op ieder OS ondersteund. FreeBSD kent pas sinds de net uitgebrachte versie 10 ondersteuning voor VMXNET3. Versie 10 kent veel wijzigingen waardoor men niet massaal zal gaan upgraden. Systemen als FreeNAS e.d. lopen achter in versie (sommigen zitten nog bij FreeBSD 8.4).Maar dannog, het *ALLER* grootste nadeel, is dat je VMXNET3 opgeeft.

Kwestie van 2e nic toevoegen dus. Daarnaast kan je storage zich ook prima buiten de ESXi doos bevinden waardoor heel dat VMXNET3 geen enkele waarde heeft (zat mensen die dat doen omdat ze storage virtualiseren niet wenselijk vinden).Stel je geeft je storage VM een dedicated netwerkkaart, dan kunnen de VM's die daar bijzitten niet meer met 10Gb met die VM communiceren.

Iemand die een storage vm gebruikt om zodoende storage te kunnen geven aan ESXi is nooit slim bezigBovendien, als je storage teruggeeft aan ESXi (door middel van NFS of iSCSI) moet dat dus persé over je switch heen. Dat is dubbel dubbel zonde. Dat veroorzaakt zoveel latency. Het is vele malen sneller als je VMXNET3 hebt en je geeft 'lokaal' ESXi storage vanuit een VM.

Wat een onzin, ik heb al jaren VMXNET3 onder FreeBSD. Het zit er vanaf 10.0 al door FreeBSD in, maar daarvoor kon je prima VMware tools installeren.FreeBSD kent pas sinds de net uitgebrachte versie 10 ondersteuning voor VMXNET3. Versie 10 kent veel wijzigingen waardoor men niet massaal zal gaan upgraden. Systemen als FreeNAS e.d. lopen achter in versie (sommigen zitten nog bij FreeBSD 8.4).

Meerdere netwerkkaarten is inderdaad een optie, maar dan ga je je configuratie weer nodeloos ingewikkeld maken. En het verhaal met Fibre Channel heeft echt niets met de discussie te maken... Het ging over netwerkkaarten.

Waarom is storage teruggeven aan ESXi de goden verzoeken? Stel je gebruikt VT-d in een VM voor een hele zwik aan disks welke je daarna via NFS teruggeft aan ESXi? Niets mis mee hoor...

Mijn setup heeft een hele poos zo gedraaid (onder zowel FreeBSD als Linux met MDADM).

Maar goed, als hij het zo wil doen prima, ik zeg alleen dat het nadelen heeft. Als hij inderdaad geen storage lokaal in een VM heeft, en vmxnet3 zou willen gebruiken om lokaal te communiceren, is er geen bezwaar tegen VT-d gebruiken om een netwerkkaart door te geven.

Wat dan de voordelen zijn ontgaat mij een beetje...

[ Voor 15% gewijzigd door FireDrunk op 27-01-2014 07:42 ]

Even niets...

Verwijderd

5G aan freenas, 2 aan ubuntu en 1 aan esxi moet wel werken denk ik, of heb je een betere verdeling ?

Nu zie ik dat :

grep memory /var/run/dmesg.boot

real memory = 1073741824 (1024 MB)

avail memory = 1008500736 (961 MB)

VMware memory control driver initialized

en dat is waarschijnlijk met zfs niet echt optimaal.

Edit1:

Genoemde config wil niet starten... ik heb nu 4G aan freenas gegeven (locked) en ubutu 1G maar niet locked.

Dit start wel... Esxi zal ook nog iets claimen of zo ? Moet ik nog verder uitzoeken..

Met 4G doet hij nu

dd if=/dev/zero of=/mnt/tank/test.bin bs=1G count=20

20+0 records in

20+0 records out

21474836480 bytes transferred in 72.707710 secs (295358449 bytes/sec)

wat wel een verbetering te noemen is.

Edit2:

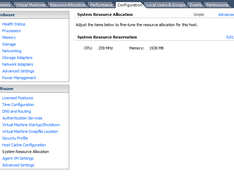

In vSphere client zie ik dat er totaal (voor die host) maar 5110MB beschikbaar is om te verdelen.

Betekent dit dat er 3G voor esxi gereserveerd wordt ?

[ Voor 35% gewijzigd door Verwijderd op 27-01-2014 09:08 ]

Even niets...

Verwijderd

Zijn er nog andere zaken raadzaam om te controleren/in te stellen voor ik de setup ga vullen....

Hierna wordt dit weer lastiger, ik kan nu nog probleemloos opnieuw zaken aanmaken of verwijderen...

Dè developers podcast in je moerstaal : CodeKlets Podcast

Ben nog steeds op zoek dus naar een LGA 1150 mobo.Vond deze link wel, maar is redelijk nutteloos gezien hij outdated is..

http://www.vm-help.com//esx40i/esx40_whitebox_HCL.php

Any help?

VT-d zit op bijna alle moederborden tegenwoordig (H77, H87, Q77, Q87, B75, B85). Als je persé socket 1150 wil zit je dus aan B85, H87 of Q87 vast.

Wat let je om eens een gros selectie te maken in de pricewatch en daarna even te kijken of de netwerkkaarten gesupport zijn. Dan hou je nog maar een handje vol borden over...

Even niets...

http://www.msi.com/product/mb/Z87I.html#/?div=Detail

http://www.asus.com/Motherboards/CSB/#specifications

pricewatch: Asus CS-B

Beide nic's worden ondersteund lijkt me?

Er is een driver voor de i210 series, en ik weet dat die ook de i210v pakt volgens mij, maar de i217...? Geen idee...

Even niets...

Moet lukken denk ik, zie mijn vorige post uit dit topic.FireDrunk schreef op dinsdag 28 januari 2014 @ 14:52:

Lijkt mij niet, volgens mij is de I217LM helemaal niet ondersteund, maar zeker weten doe ik het niet.

Er is een driver voor de i210 series, en ik weet dat die ook de i210v pakt volgens mij, maar de i217...? Geen idee...

FREAKJAM schreef op dinsdag 17 september 2013 @ 11:22:

De Intel Z87 chipset ondersteunt ook geen VT-D, hoewel ik in de manual wel kan vinden dat je VT-D kunt enablen. De onboard nic (Intel® I217V) werkt ook niet out of the box met ESXi. (Je kunt deze wel werkend krijgt met ESXi Customizer als je wil).

is everything cool?

[ Voor 70% gewijzigd door FireDrunk op 28-01-2014 15:35 ]

Even niets...

Nu nog een leuke case en dan klaar - I'll keep you posted.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 4440 Boxed | € 157,30 | € 157,30 |

| 1 | Asus CS-B | € 128,35 | € 128,35 |

| 1 | Scythe Big Shuriken 2 Rev. B | € 30,04 | € 30,04 |

| 1 | Corsair Vengeance CML32GX3M4A1600C10 | € 285,45 | € 285,45 |

| 1 | Samsung 840 series Pro 256GB | € 185,- | € 185,- |

| Bekijk collectie Importeer producten | Totaal | € 786,14 | |

Hier komt nog eens Enermax Triathlor Eco ETL350AWT-M en SilverStone SUGO SG02B-F USB 3.0 bij, deze staan niet in de pricewatch. Komt uiteindelijk uit op ~1000€ . Wat denken jullie? Nog tips?

Edit: Whoops, double post, my bad

Hij is vrij nieuw, dus nog weinig info over te vinden, maar denken jullie dat dat gaat werken. En hoe zit het in het algemeen met Gigabyte qua zuinigheid in verhouding tot Asrock? Met (onderstaande) adapter is hij net zo duur als deze pricewatch: ASRock Z77E-ITX. Zuinigheid zou de doorslag dus kunnen geven en het feit dat de Gigabyte een Intel NIC heeft.

Het gaat dus om deze mini-pcie naar sata adapter om uiteindelijk 7 schijven te kunnen huisvesten (1 ssd in de msata): http://www.amazon.com/PM3...8I74468/ref=cm_cr_pr_pb_t

Sinds de 2 dagen regel reageer ik hier niet meer

Lees nou eens goed wat je hier neerzet, je spreekt jezelf in 2 zinnen tegen. Zoals ik al zei, het in de release notes te zien is (!) en je zelf ook bevestigd kent FreeBSD pas vanaf versie 10 VMXNET3 support. Daarvoor was het er niet. Let wel: het gaat hier om wat FreeBSD zelf ondersteund, niet wat VMware Tools ondersteund of toevoegt!FireDrunk schreef op maandag 27 januari 2014 @ 07:40:

Wat een onzin, ik heb al jaren VMXNET3 onder FreeBSD. Het zit er vanaf 10.0 al door FreeBSD in, maar daarvoor kon je prima VMware tools installeren.

In een kb artikel van VMware is ook overduidelijk te zien dat er geen support is voor FreeBSD: Choosing a network adapter for your virtual machine (1001805). Dat je het met de installatie van VMware Tools kon verkrijgen is leuk maar als je een beetje zoekt op internet zie je dat er toch aardig wat negatieve ervaring zijn met VMware Tools in FreeBSD (die van mij zijn ook niet altijd positief, het gaat tegenwoordig gelukkig wel goed).

Daarbij is VMXNET3 performance voor vm's onderling ook lang niet altijd merkbaar. Het ligt er maar net aan hoeveel dataverkeer er tussen vm's wordt uitgewisseld. Besides, voor de meesten boeit het toch allemaal niet zo heel erg. Zo'n 1 Gbit connectie is veelal al voldoende. Je kunt trouwens ook VMCI gebruiken als je snelle communicatie tussen vm's wil.

Tja, dat doe je ook met een NAS waarbij je de storage weer aan ESXi geeft om daar vm's op te draaien. Zo ken ik nog wel een paar dooddoeners... Vergeet dat niet er velen zijn die een thuislab willen maken en daarvoor iets als ESXi gebruiken. Dan zit je al snel in de nodeloos ingewikkelde configs voor thuisMeerdere netwerkkaarten is inderdaad een optie, maar dan ga je je configuratie weer nodeloos ingewikkeld maken.

Jazeker wel want het is een voorbeeld en je kunt met fc ook heel wat leuks aan netwerk bouwen hoor. Het is veelal bedoeld als storage network in bijv. SANs maar IP kan er ook gewoon over. Idem voor iets als Infiniband (wat voor de meesten van ons wat meer binnen het bereik ligt).En het verhaal met Fibre Channel heeft echt niets met de discussie te maken... Het ging over netwerkkaarten.

Kwestie van een wel heel erg simpele risicoanalyse: als jij vm's vanaf storage gaat draaien dan moet die storage wel beschikbaar zijn. Met andere woorden: die storage vm moet als eerste booten, pas daarna de rest. Als dat niet gebeurd heb je een probleem. Een heel erg groot probleem als daar een aantal vm's op draaien die noodzakelijk zijn voor je infrastructuur. Het is net zo dom als in moeten loggen met een AD account voor beheer van ESXi waarbij de domain controller op diezelfde ESXi machine draait. Combineer dit met het vorige... Dit zijn pruts setups die je niet moet willen bouwen tenzij je graag wil uitzoeken hoe destructief iets is.Waarom is storage teruggeven aan ESXi de goden verzoeken? Stel je gebruikt VT-d in een VM voor een hele zwik aan disks welke je daarna via NFS teruggeft aan ESXi? Niets mis mee hoor...

Wat je hier doet is in de grootste valkuil van virtualisatie trappen: domweg overal maar vm's opzetten en met elkaar linken zonder te kijken naar en na te denken over de gevolgen hiervan omdat het allemaal zo makkelijk is. Met die werkwijze is het dodelijk eenvoudig om een kaartenhuisconstructie te creëren: gaat 1 ding dan stort de hele boel in elkaar. Daarnaast loop je ook het risico om dingen nodeloos ingewikkeld te maken (door toename van complexiteit wordt de boel veelal ook instabieler). Je moet je dus goed beseffen wat de gevolgen zijn als een vm eruit knalt. Wat werkt er dan allemaal niet meer?

Zoals vaker met het opzetten van een infrastructuur/server/etc. is het voorkeur en ervaring. Dingen als security, performance en verkrijgbaarheid (met name bij thuislabs zie je veel hergebruik van hardware die men al had) spelen daarbij een rol.Wat dan de voordelen zijn ontgaat mij een beetje...

Ja, het is soms wel leuk om te zien wat de grote jongens voor zichzelf hebben gebouwd. Of dat ook echt toepasbaar is voor thuis is vers 2. Ze bouwen namelijk wel geheel volgens hun eigen wensen en eisen. Die van jezelf zullen ongetwijfeld anders zijn. Het is wel goed om wat inspiratie op te doen en je kunt zien hoe zij bepaalde dingen hebben opgelost. Dat is ook vaak de reden waarom ze de designs delen. Ben benieuwd wat er in de toekomst aan nieuwe producten uit komen rollen.OMX2000 schreef op dinsdag 28 januari 2014 @ 05:54:

Heeft iemand al eens hier na gekeken voor inspiratie? http://www.opencompute.org

NOOOO!!! Niet doen !! JMicron = Eng/onbetrouwbaar/gewoon slecht...CurlyMo schreef op woensdag 29 januari 2014 @ 18:17:

Het gaat dus om deze mini-pcie naar sata adapter om uiteindelijk 7 schijven te kunnen huisvesten (1 ssd in de msata): http://www.amazon.com/PM3...8I74468/ref=cm_cr_pr_pb_t

Zoo vaak gezeik mee gezien

Waarom niet de IBM/LSI controller die vaak in het ZFS Topic wordt gebruikt ? Kost wel wat, maar dan heb je ook wat : pricewatch: IBM ServeRAID M1015 SAS/SATA Controller for System x

En anderes iets simpels zoeken met een Silicon Image chip erop, maar daar zijn er niet meer veel van geloof ik...

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Toch maar eens gaan meten wat de boel thuis deed.

Mijn oude setup draaide op dik 120/170w per ESXi node (AMD 965BE/m4a89GTD) en 150w voor de disk storage.

Dat is toch best veel!

Tijd voor een nieuw cluster thuis!

Na nog wat gespit op GOT, Google en testen met wat spullen van kantoor (E3-1230v1)

Kwam daar de wensenlijst uit:

| # | Product | Prijs | Subtotaal |

| 2 | Intel Core i3 4330T Tray | € 125,26 | € 250,52 |

| 2 | ASRock B85M Pro4 | € 56,20 | € 112,40 |

| 2 | Apevia X-Qpack | € 76,59 | € 153,18 |

| Bekijk collectie Importeer producten | Totaal | € 516,10 | |

Beide machines worden standaard virtualisatie nodes zonder disken.

Bewust geen PICO PSU, al wil ik er wel 1 gaan proberen.

De Apevia is voor het oog, ben van plan de units op mijn werkkamer op een lage kast te plaatsen

Storage gaat via een aangepaste storage node, nog geen idee of het 10Gb of IB gaat worden.

Zodra een binnen is ga ik testen met ESXi en XenServer.

Mocht er iemand speciefieke waardes willen weten dan kan dat ergens in de komende dagen.

to linux or not ,that's my quest... | 5800X | 32GB 3800C15 | X570-Pro | 980 1TB | 7900XTX | PVoutput | Fiets

Verwijderd

Wel ff de NIC drivers moeten toevoegen

- ASRock B75 Pro3-M

- Intel Core i5 3350P

- 32 GB : 4 x 8 GB

- Samsung 840 EVO 250

- 2TB WD schijf

Momenteel heb ik ESXI geïnstalleerd op de SSD en de 2TB IDE schijf toegevoegd als extra datastore.

Alle VM`s draaien met 1 disk c: partitie op de SSD en met 1 disk d: partitie (dataschijven) op de IDE schijf.

Ik vraag me alleen af of ik ESXI wel had moet installeren op de SSD en niet op de IDE. Qua performance zal dit weinig doen, maar ik weet niet of de SSD net zo stabiel is als de IDE schijf?

als ESXi eenmaal draait, gebruikt het bar weinig van de disk waar het op staat, dus het enige verschil dat je zou hebben is startup tijd..Verwijderd schreef op dinsdag 04 februari 2014 @ 10:23:

Ik vraag me alleen af of ik ESXI wel had moet installeren op de SSD en niet op de IDE. Qua performance zal dit weinig doen, maar ik weet niet of de SSD net zo stabiel is als de IDE schijf?

Even niets...

Ik zit nog op ESXI 5.1 maar ben van plan om komend jaar de switch te maken naar 5.5. Ik wou dan graag een upgrade maken naar 4TB/6TB schijven ipv van de 2TB, iemand al getest of dat nu goed gaat doormiddel van RDM?

Mijn zuinige server draait overigens nog steeds super. Daarnaast is de performance van de Samsung 830 256GB zonder trim in een jaar ook niet achteruit gegaan, met 15GB over provisioning.

[ Voor 38% gewijzigd door Zenix op 04-02-2014 16:11 ]

Let op: Dit is geen 'algemeen ESxi-topic'. Ook je algemene VT vragen horen hier niet thuis!

Lees voor je begint goed de start post en blijf ontopic.

/u/11437/wandcontactdoos.png?f=community)

:strip_icc():strip_exif()/u/20047/neptunus.jpg?f=community)

:strip_icc():strip_exif()/u/240280/5.jpg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_exif()/u/19853/Goku1.gif?f=community)

/u/217664/crop57a47149436c0_cropped.png?f=community)

:strip_exif()/u/396800/D-_3427da0a9c293b63f2a66dea2e642102.gif?f=community)

:strip_exif()/u/49248/DPCkoeienUD.gif?f=community)

:strip_icc():strip_exif()/u/16203/linux.jpg?f=community)

:strip_exif()/u/108168/koebjieste21.gif?f=community)