Even niets...

Wegens geen tijd verkoop ik mijn ESXI whitebox -> V&A aangeboden: ESXi whitebox - desktop

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 4440 Boxed | € 154,90 | € 154,90 |

| 1 | ASRock Q87M vPro | € 96,80 | € 96,80 |

| 1 | Scythe Big Shuriken 2 Rev. B | € 30,04 | € 30,04 |

| 1 | Corsair XMS3 CMX32GX3M4A1333C9 | € 264,- | € 264,- |

| 1 | be quiet! System Power 7 300W | € 32,- | € 32,- |

| 1 | Crucial 2.5" M500 240GB | € 108,60 | € 108,60 |

| 1 | SilverStone SUGO SG02-F | € 71,83 | € 71,83 |

| 1 | Dell YT674 - Quad port ethernet adapter | € ~110 | € ~110 |

| Bekijk collectie Importeer producten | Totaal | € 910 (shipping incl.) | |

Uiteindelijk deze besteld. Nu nog wachten tot alles aankomt

Verwijderd

Doel van de server is het voornamelijk nas door het draaien van freenas maar daarnaast ook nog wel andere vm's.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 4570 Boxed | € 167,- | € 167,- |

| 1 | ASRock H87M Pro4 | € 65,90 | € 65,90 |

| 3 | WD Green WD30EZRX, 3TB | € 92,- | € 276,- |

| 1 | Cooler Master Silencio 550 (zonder voeding) | € 69,20 | € 69,20 |

| 1 | Intel PRO/1000 GT | € 21,96 | € 21,96 |

| 1 | Crucial Ballistix Sport BLS2CP8G3D1609DS1S00CEU | € 114,99 | € 114,99 |

| 1 | Seasonic G-Serie 550Watt | € 79,95 | € 79,95 |

| Bekijk collectie Importeer producten | Totaal | € 795,- | |

Later zou ik deze configuratie uit willen bereiden naar:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 4570 Boxed | € 167,- | € 167,- |

| 1 | ASRock H87M Pro4 | € 65,90 | € 65,90 |

| 1 | WD Blue WD7500BPVX, 750GB | € 46,90 | € 46,90 |

| 5 | WD Green WD30EZRX, 3TB | € 92,- | € 460,- |

| 1 | Cooler Master Silencio 550 (zonder voeding) | € 69,20 | € 69,20 |

| 2 | Intel PRO/1000 GT | € 21,96 | € 43,92 |

| 1 | Crucial Ballistix Sport BLS2CP8G3D1609DS1S00CEU | € 114,99 | € 114,99 |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 127,05 | € 127,05 |

| 1 | Seasonic G-Serie 550Watt | € 79,95 | € 79,95 |

| Bekijk collectie Importeer producten | Totaal | € 1.174,91 | |

Iemand nog advies over eventuele aanpassingen of tips....

Even niets...

Verwijderd

[ Voor 20% gewijzigd door Verwijderd op 05-02-2014 14:42 ]

Ik draai een Xeon E5 met 6 schijven op een 360, inschakelpiek is 140 W...

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Is het de E5-1620 V2 met de X9SRL-F die je gebruikt? Oftewel de setup in je wenslijst? Zou je eens de verbruik cijfers kunnen posten, ik zit naar een vergelijkbare setup te kijken maar ben huiverig voor het stroomverbruik van de E5.Paul schreef op woensdag 05 februari 2014 @ 14:45:

Voor die setup heb je geen 550W voeding nodig

Ik draai een Xeon E5 met 6 schijven op een 360, inschakelpiek is 140 W...

Server 1: Intel N305 | 48GB RAM | 5*4TB NVME | 4x 2.5GbE

Server 2: Intel N5105 | 64GB RAM | 1TB NVME | 4x 2.5GbE

Server 3: Intel Xeon E5-2670 | 128GB RAM | 512+750GB SATA SSD | 6x10TB HDD | 6x 1GbE [Buiten gebruik]

Verwijderd

1x PCI-E 6 pin

4x SATA

3x Peripheral 4-pin

1x 20+4pin

1x 4+4pin (ATX)

1x floppy

Hier kan je uiteindelijk maar totaal 7 schijven aan hangen of zie ik dat verkeerd

ik wil de mogelijkheid to eventuele uitbedreiding van schijven houden tot bijvoorbeeld 10

Heb alle reepjes afzonderlijk al getest (5+ runs), ben toen 32 / 48 / 64 / 80 en nu 96 GB aan het testen.

Ik heb de aantekeningen thuis liggen, je zit al snel aan 70 Watt... Ik zal vanavond dat wat ik al heb (BIOS, FreeNAS, Windows 7) posten, ESXi heb ik nog niet geprobeerd (dat wordt het uiteindelijke OS).

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Even niets...

Er zijn splitter kabeltjes waarmee je extra aansluiten kan creëren.Verwijderd schreef op woensdag 05 februari 2014 @ 15:07:

Snap dat ik niet de 550w nodig heb alleen kwa aansluiting heetf bijvoorbeeld de Seasonic G-Serie 360Watt

1x PCI-E 6 pin

4x SATA

3x Peripheral 4-pin

1x 20+4pin

1x 4+4pin (ATX)

1x floppy

Hier kan je uiteindelijk maar totaal 7 schijven aan hangen of zie ik dat verkeerd

ik wil de mogelijkheid to eventuele uitbedreiding van schijven houden tot bijvoorbeeld 10

Doe rustig aan, ook ik zit te kijken met uiteindelijk doel een all-in-one ESXI setup. Ben zeer benieuwd naar je resultatenPaul schreef op woensdag 05 februari 2014 @ 15:25:

Ja, dat is die setupIk ben nog aan het meten, en momenteel ben ik al een tijdje memtest aan het draaien omdat het met 128 GB in FreeNAS een honderden / duizenden single bit errors genereert.

Heb alle reepjes afzonderlijk al getest (5+ runs), ben toen 32 / 48 / 64 / 80 en nu 96 GB aan het testen.

Ik heb de aantekeningen thuis liggen, je zit al snel aan 70 Watt... Ik zal vanavond dat wat ik al heb (BIOS, FreeNAS, Windows 7) posten, ESXi heb ik nog niet geprobeerd (dat wordt het uiteindelijke OS).

Server 1: Intel N305 | 48GB RAM | 5*4TB NVME | 4x 2.5GbE

Server 2: Intel N5105 | 64GB RAM | 1TB NVME | 4x 2.5GbE

Server 3: Intel Xeon E5-2670 | 128GB RAM | 512+750GB SATA SSD | 6x10TB HDD | 6x 1GbE [Buiten gebruik]

Ik heb zo'n zelfde server in de planning. Heb je het hier over 70 watt totaalPaul schreef op woensdag 05 februari 2014 @ 15:25:

Ja, dat is die setupIk ben nog aan het meten, en momenteel ben ik al een tijdje memtest aan het draaien omdat het met 128 GB in FreeNAS een honderden / duizenden single bit errors genereert.

Heb alle reepjes afzonderlijk al getest (5+ runs), ben toen 32 / 48 / 64 / 80 en nu 96 GB aan het testen.

Ik heb de aantekeningen thuis liggen, je zit al snel aan 70 Watt... Ik zal vanavond dat wat ik al heb (BIOS, FreeNAS, Windows 7) posten, ESXi heb ik nog niet geprobeerd (dat wordt het uiteindelijke OS).

En die DIMMS, zijn dat Kingston ValueRAM (pricewatch: Kingston ValueRAM KVR18R13D4/16) toevallig?

Even niets...

Inderdaad, ik gebruik een 4 sata power connector van Silverstone:thof schreef op woensdag 05 februari 2014 @ 15:45:

Er zijn splitter kabeltjes waarmee je extra aansluiten kan creëren.

http://www.silverstonetek...oduct.php?pid=304&area=en

Als ook: http://www.silverstonetek...oduct.php?pid=454&area=en

Dan heb je waarschijnlijk 10 oude en/of 7200RPM schijven... Die vreten nogal (8W per stuk).infernix schreef op woensdag 05 februari 2014 @ 16:01:

Hmm, dan is mijn oude server dus gewoon een stroomvreter. E6550 met 10 HDs doet zo'n 175-200W volgens plugwise.

Even niets...

De server zal voornamelijk het volgende draaien

- pfSense (routing, firewall, captive portal en openVPN)

- mySQL

- apache+php

- RADIUS

Heeft iemand nog opmerkingen/tips?

Kan iemand in de richting sturen naar een correcte manier van data backup?

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1230V2 Boxed | € 189,99 | € 189,99 |

| 1 | Supermicro X9SCI-LN4F (Retail Pack) | € 210,23 | € 210,23 |

| 2 | WD Black SATA 6 Gb/s WD1003FZEX, 1TB | € 66,- | € 132,- |

| 1 | Antec Three Hundred | € 55,50 | € 55,50 |

| 1 | Scythe Mugen 4 PCGH Edition | € 36,30 | € 36,30 |

| 1 | Kingston ValueRAM KVR16E11/8EF | € 77,95 | € 77,95 |

| 1 | Seasonic G-Serie 450Watt | € 67,04 | € 67,04 |

| Bekijk collectie Importeer producten | Totaal | € 769,01 | |

Je kan ook gewoon een 2 poorts AHCI controllertje kopen en die via VT-d doorgeven. Kost je 15,- ofzo.

Even niets...

Mocht ik ZFS steken, zou ik RAID-Z of RAID-Z2 kiezen (3 of 4 schijven).FireDrunk schreef op donderdag 06 februari 2014 @ 11:12:

ZFS is gratis? Waarom denk je dat ZFS extra geld kost? Omdat je een controllertje nodig hebt?

Je kan ook gewoon een 2 poorts AHCI controllertje kopen en die via VT-d doorgeven. Kost je 15,- ofzo.

Waarschijnlijk neem ik dan best nog een lat van 8Gb erbij.

Ik zal rond de 300,- betalen voor ZFS (WDC Blue's). Ik vraag mij af of ik geen betere backup kan vinden?

Ik zat ook nog te denken aan Dropbox of iets dergelijks te gebruiken en gewoon geëncrypte pakketten te uploaden.

Also, waarom de blacks? reds zijn al een tientje per stuk goedkoper, en zijn ook gemaakt om 24/7 aan te staan... (of 2 tientjes duurder voor 2TB reds)

Met ZFS snapshots kun je al een basis backup maken. Dit beschermt je tegen een file die corrupt raakt of een per ongeluk verwijderde file. Je kunt zelf instellen hoeveel versies je terug wilt kunnen gaan. Met een tweede ZFS systeem erbij (liefst op een andere locatie) ZFS replicatie naar fysiek een andere host en andere schijven kunnen sturen..phoz schreef op donderdag 06 februari 2014 @ 11:10:

Ik dacht eerst ZFS te gebruiken om mijn data bij te houden maar ik vind het eerder prijzig. Ik ben nog op zoek naar een goede oplossing voor data backup met een beperkt budget. Ik zal de 2 WD schijven in RAID1 gebruiken.

Even niets...

Snapshots zijn snapshots, snapshots zijn zeker geen backups.tsjoender schreef op donderdag 06 februari 2014 @ 11:31:

[...]

Met ZFS snapshots kun je al een basis backup maken. Dit beschermt je tegen een file die corrupt raakt of een per ongeluk verwijderde file. Je kunt zelf installen hoeveel versies je terug wilt kunnen gaan. Met een tweede ZFS systeem erbij (liefst op een andere locatie) ZFS replicatie naar fysiek een andere host en andere schijven kunnen sturen.

Backups neem je in het geval dat je dataverlies hebt.. zodra dat gebeurt heb je helemaal niks aan een snapshot.. het enige waar die wel voor werken als het een PEBKAC probleem is.

Ik had enkel de Blacks gekozen omdat ze 5 jaar garantie hebben.DaBeast.net schreef op donderdag 06 februari 2014 @ 11:30:

Waarom geen WD Red? Deze zijn namelijk gemaakt voor NAS storage, en zijn niet zo heel veel duurder..

De enigste wat ik moet backuppen is mijn SQL server (logs ed gaan hier ook op). Ik kan niet inschatten hoeveel data dat zal zijn maar ik denk eerder tegen de 5G dan 500G.DXaroth schreef op donderdag 06 februari 2014 @ 11:31:

Dat ligt helemaal aan hoeveel data je verwacht te moeten backuppen.. het is een groot verschil tussen 5g aan backups en 500g...

Zou ik dan niet eerder geen ZFS in mn server steken en een apart ZFS systeem bouwen? De goedkoopste oplossing zou ik hebben met non-ECC bordje of is dat niet aan te raden(ZFS + non-ECC)?tsjoender schreef op donderdag 06 februari 2014 @ 11:31:

[...]

Met ZFS snapshots kun je al een basis backup maken. Dit beschermt je tegen een file die corrupt raakt of een per ongeluk verwijderde file. Je kunt zelf instellen hoeveel versies je terug wilt kunnen gaan. Met een tweede ZFS systeem erbij (liefst op een andere locatie) ZFS replicatie naar fysiek een andere host en andere schijven kunnen sturen.

Dat is op zich wel een goede reden maar de Blacks verbruiken een stuk meer stroom. Ik denk dat je dat geld beter in je zak kan steken en die laatste 2 jaar garantie 'zelf te betalen' met het verschil..phoz schreef op donderdag 06 februari 2014 @ 11:42:

Ik had enkel de Blacks gekozen omdat ze 5 jaar garantie hebben.

Pak dan gewoon een externe schijf (USB2/USB3). Daar kan je eventueel ook zelfs ZFS op zetten.De enigste enige wat ik moet backuppen is mijn SQL server (logs ed gaan hier ook op). Ik kan niet inschatten hoeveel data dat zal zijn maar ik denk eerder tegen de 5G dan 500G.

Kan, maar het hoeft niet. ESXi icm VT-d is een prima oplossing.Zou ik dan niet eerder geen ZFS in mn server steken en een apart ZFS systeem bouwen? De goedkoopste oplossing zou ik hebben met non-ECC bordje of is dat niet aan te raden(ZFS + non-ECC)?

Even niets...

Is dat niet zowat hetzelfde als een RAID1 qua falingskans?

In theorie wel ja, afgezien dat je externe disk niet constant beschreven wordt met alle kleine wijzigingen (en dus minder wear&tear heeft dan de 'live' disks)... hierdoor is het onwaarschijnlijker dat alle disks tegelijk falen...phoz schreef op donderdag 06 februari 2014 @ 11:53:

Is een externe USB schijf veilig genoeg als backup?

Is dat niet zowat hetzelfde als een RAID1 qua falingskans?

Correct.phoz schreef op donderdag 06 februari 2014 @ 12:05:

Een extra interne schijf zou dus hetzelfde bereiken.

Wat ik bedoel: Gebruik een externe USB schijf, backup er naar, en koppel het ding los, en berg hem op op/in een andere lokatie (ouders / kennissen, liefst in een kluis).

Dan is de kans van falen een stuk lager dan met een 'gewone' extra interne schijf.

Even niets...

Jawel, kun je ze prima voor gebruiken.DXaroth schreef op donderdag 06 februari 2014 @ 11:32:

Snapshots zijn snapshots, snapshots zijn zeker geen backups.

Als je backups gaat nemen als je dataverlies hebt ben je te laat. Je neemt de backups om dataverlies te voorkomen. Dat kan prima met snapshots.Backups neem je in het geval dat je dataverlies hebt..

Hoezo zou je niks hebben aan een snapshot? Met zowel UFS2 en ZFS kun je snapshots elders opslaan. Dit is niet zoals de snapshotting mogelijkheid die je in ESXi van een vm zelf hebt. Dit is snapshotting op filesystem niveau. In FreeBSD is het gebruikelijk om per jail een eigen stukje ZFS aan te maken. Men maakt daar gebruik van omdat snapshotting met ZFS net even wat mooier kan dan met UFS2. Ze gebruiken dit om te backuppen maar ook om een jail naar een compleet andere host te kunnen migreren.zodra dat gebeurt heb je helemaal niks aan een snapshot..

Snapshots die je met ESXi maakt of die je maakt alvorens je een config wijziging of stukje software installeert zijn net zo hard backups. Je maakt ze om bij problemen weer terug te kunnen naar een werkende situatie. Het is niet meer dan een vorm van backup maken. Het hoeft niet altijd met dedicated backup software als Bacula.

Backups/snapshots werken niet voor ieder PEBKAC probleem. Mensen zijn prima in staat om hun data zo toe te takelen dat de toetakeling doodleuk in de backup terecht komt. Komen ze dan een half jaar later achter. Het aantal bedrijven/mensen die zo lang of langer backups hebben is miniem, meesten gaan tot een maand terug. Bij sommigen is er nog een archief maar daarin zitten alleen items die voor x jaar bewaard moeten worden vanwege bepaalde wetgeving. Besides, beheerders maken ook wel eens fouten, dat is dus ook PEBKAC. Zijn wel hele hele dure fouten trouwens.het enige waar die wel voor werken als het een PEBKAC probleem is.

Een echte backup is overigens een complete strategie waarbij je gebruik maakt van dingen als snapshots maar ook offline kopietjes e.d.

[ Voor 24% gewijzigd door ppl op 06-02-2014 21:29 ]

Dat je een auto kan gebruiken om 20 ton aarde te vervoeren wil nog niet zeggen dat het er geschikt voor is.

Neen, backups gebruik je om te herstellen van het verlies van data, je voorkomt dataverlies door redundantie aan te brengen in je systemen (zowel storage als daarbuiten).. maar zodra dat niet meer helpt, heb je een oplossing nodig. Dat is waar backups voor zijn.Als je backups gaat nemen als je dataverlies hebt ben je te laat. Je neemt de backups om dataverlies te voorkomen. Dat kan prima met snapshots.

Het feit dat je iets kan gebruiken om een doel te bereiken wil niet zeggen dat het een oplossing ervoor is. Ja, snapshots zijn handig om rollbacks uit te kunnen voeren van je systeem mocht er wat mis gaan, en ja, je kan snapshots gebruiken om differentiële data te versturen naar off-site, maar dat maakt het nog geen backup.Hoezo zou je niks hebben aan een snapshot? Met zowel UFS2 en ZFS kun je snapshots elders opslaan. Dit is niet zoals de snapshotting mogelijkheid die je in ESXi van een vm zelf hebt. Dit is snapshotting op filesystem niveau. In FreeBSD is het gebruikelijk om per jail een eigen stukje ZFS aan te maken. Men maakt daar gebruik van omdat snapshotting met ZFS net even wat mooier kan dan met UFS2. Ze gebruiken dit om te backuppen maar ook om een jail naar een compleet andere host te kunnen migreren.

Het concept van snapshots vs backups is simpel:

1) voor elke 'grote' wijziging maak je een snapshot, dit betekend dat mocht er iets finaal mis gaan, dan kan je snel recoveren terug naar het moment van aanmaken. dit gaat er van uit dat genoemde wijziging verder geen negatieve impact heeft op je omgeving (lees: je server is niet afgefikt)

2) Voor 'oeps' momenten neem je regelmatig snapshots, dit betekend dat zodra er iemand per ongeluk iets verkeerds doet (je verwijderd een bestand wat niet verwijderd hoefde te worden, of erger, je porno collectie).. in zo'n geval kan je terug gaan naar een punt in tijd die daarvoor ligt.. dit is niet 100% optimaal, want je verliest de vooruitgang tussen dat moment en nu, maar dat is in veel gevallen te overzien.

Nu is je systeem redelijk veilig, je data kan je terug halen.. behalve!

3) Je server vliegt in de fik.. letterlijk, gesmolten metaal en whatever... je opslag is compleet kapot, en niet meer te herstellen... dit is waarom je elke X tijd een complete backup maakt van je systeem, die je off-site opslaat (letterlijk, een externe harde schijf die je bij je (schoon) ouders neer legt)... Nu kan je je dataset terug halen op een ander (vervangend) systeem.. waarbij je wel enige vorm van data kwijt bent, maar niet compleet.

Om het kort samen te vatten:

Snapshots gebruik je om data-verlies tegen te gaan, Backups gebruik je om te herstellen ervan.

Het feit dat gebruikers dingen kunnen verkloten is de hoofdreden dat systeembeheerders graag hun hoofd met enige snelheid tegen een muur aan willen rammen, maak een systeem dat idiot-proof is, en je zult een grotere idioot vinden.. simpel als dat.Backups/snapshots werken niet voor ieder PEBKAC probleem. Mensen zijn prima in staat om hun data zo toe te takelen dat de toetakeling doodleuk in de backup terecht komt. Komen ze dan een half jaar later achter. Het aantal bedrijven/mensen die zo lang of langer backups hebben is miniem, meesten gaan tot een maand terug. Bij sommigen is er nog een archief maar daarin zitten alleen items die voor x jaar bewaard moeten worden vanwege bepaalde wetgeving. Besides, beheerders maken ook wel eens fouten, dat is dus ook PEBKAC. Zijn wel hele hele dure fouten trouwens.

Dat wil niet zeggen dat het -veel- gebruikers fouten kan oplossen; in 90% van de recovery requests die wij krijgen zal de data in een dataset van

? Spreek je jezelf nu tegen of snap ik je U-bocht niet helemaal?ppl schreef op donderdag 06 februari 2014 @ 21:22:

Als je backups gaat nemen als je dataverlies hebt ben je te laat. Je neemt de backups om dataverlies te voorkomen. Dat kan prima met snapshots.

[...]

Een echte backup is overigens een complete strategie waarbij je gebruik maakt van dingen als snapshots maar ook offline kopietjes e.d.

Is mijn klant minder goed geholpen omdat ik het restore-verzoek van zijn bestandje heb voldaan uit een snapshot in plaats vanuit CommVault / Backup Exec / ntbackup ?

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Om maar de definitie van een backup aan te houden:Paul schreef op vrijdag 07 februari 2014 @ 00:18:

Nee, je loopt moeilijk te doen. Snapshots zijn een vorm van backup, en inderdaad, het is (wat jullie beiden zeggen) in zijn eentje geen strategie waarmee je alles afdekt.

Is mijn klant minder goed geholpen omdat ik het restore-verzoek van zijn bestandje heb voldaan uit een snapshot in plaats vanuit CommVault / Backup Exec / ntbackup ?

of, in engelse vorm:Een back-up of reservekopie is een kopie van gegevens die zich op een gegevensdrager of binnen een applicatie bevinden om deze te kunnen herstellen moesten ze beschadigd raken.

Snapshots, per definitie, zijn geen kopieen van de data, en daarmee, niet -direct- een vorm van Backup.In information technology, a backup, or the process of backing up, refers to the copying and archiving of computer data so it may be used to restore the original after a data loss event.

Backups gaan niet -enkel- om het geval je een bestandje kwijt bent, de hoofd reden om een backup te nemen is als het medium waar de data normaal op staat, beschadigd is in een dusdanige manier dat deze niet meer bruikbaar is.

Je klant gaat voor die specifieke case geholpen zijn met een snapshot, maar dat is niet het -hele- verhaal, je klant gaat namelijk enorm geirriteerd zijn als jij hem moet vertellen dat zijn data kwijt is, omdat er 4 schijven zijn uitgevallen.. al je snapshots staan daar tussen, en zijn daarmee dus ook kwijt.

Zodra je een snapshot kopieert spreek je over een backup, daarvoor niet.

Maar wel van de data die veranderd is, en in 99% van de restores is dat voldoende. Net zoals dat RAID geen afdoende backup is, maar in 99% van onze disk failures voldoende is... Het draait allemaal om de kosten, de availability, de RTO en de RPO. Snapshots zijn een hele goede manier om een ontzettend lage RPO en RTO te realiseren voor erg weinig kosten, bij een bepekt aantal maar veel voorkomende scenario's.Snapshots, per definitie, zijn geen kopieen van de data

Dat jij zulke über-gebruikers hebt die nooit een foutje maken en tegelijkertijd zo'n pruts-inkoopafdeling dat ze alleen maar brakke meuk-hardeschijven kopen zorgt er nog niet voor dat de rest van de wereld wel te maken heeft met een realiteit die precies andersom is...

[q]Backups gaan niet -enkel- om het geval je een bestandje kwijt bent[q]

ppl schreef op donderdag 06 februari 2014 @ 21:22:

Een echte backup is overigens een complete strategie waarbij je gebruik maakt van dingen als snapshots maar ook offline kopietjes e.d.

Paul schreef op vrijdag 07 februari 2014 @ 00:18:

Snapshots zijn [..] in zijn eentje geen strategie waarmee je alles afdekt.

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Je kan van een snapshot een Backup maken, hij is het by default niet.

Een snapshot wordt pas een fatsoenlijke Backup als hij off premise geplaatst wordt. En dat kan met ZFS Snapshots.

(En dan is het gewoon een full Backup, niet een incrementele...)

[ Voor 7% gewijzigd door FireDrunk op 07-02-2014 08:12 ]

Even niets...

Zoals ik zei:FireDrunk schreef op vrijdag 07 februari 2014 @ 08:11:

Als ik een fatsoenlijk Backup van een snapshot maak met zfs send & receive. Backup ik wel degelijk het hele filesysteem. ZFS snapshots zijn zoveel meer dan alleen maar gewone snapshots. En ik denk dat dat is waar jullie de mist in gaan.

Je kan van een snapshot een Backup maken, hij is het by default niet.

Een snapshot wordt pas een fatsoenlijke Backup als hij off premise geplaatst wordt. En dat kan met ZFS Snapshots.

(En dan is het gewoon een full Backup, niet een incrementele...)

Ik snap zijn punt ook wel; als je meer in de richting van de IT wereld bent waar je te maken hebt met honderden gebruikers, dan zijn snapshots een verademing om de gemiddelde PEBKAC problemen de wereld uit te helpen.DXaroth schreef op vrijdag 07 februari 2014 @ 00:47:

Zodra je een snapshot kopieert spreek je over een backup, daarvoor niet.

Maar als je een omgeving draaiende te houden hebt waar systemen op draaien die per dag meer inkomsten genereren dan dat ze kosten, dan gaat je hoofd-IT persoon niet helemaal te spreken zijn als je met je staart tussen je benen naar hem toe loopt om te vertellen dat het systeem onherstelbaar stuk is.

Begrijp me niet verkeerd, ik ga niet zeggen dat snapshots niet deel moet zijn van je data-recovery systemen, mijn standpunt is enkel dat snapshots niet je gehele data-recovery systeem moet zijn; want je hebt geen backup.. en dat heeft niets te maken met pruts-inkopers die verkeerde schijven inkopen, of met hoe veel recovery vragen je gebruikers hebben, dat heeft te maken met hoe zeker je wilt zijn dat je data nog beschikbaar is.

Overigens, onze inkopers doen het prima qua disks, in de afgelopen 2 jaar zijn er 5 disks vervangen, 3 daarvan waren disks die kapot zijn, en de 2 andere waren disks uit eenzelfde serie als 2 van de 3 gefaalde disks (als 2 disks het begeven binnen 72 uur van elkaar, dan ga je niet vertrouwen op de andere 2 disks uit dezelfde serie dat die de raid array in leven houden)...

Daarnaast heb ik ook pas 1x een systeem meegemaakt waarvan de opslag compleet onherstelbaar was, hiervoor was gelukkig geen backup nodig, want het was een redundant systeem... maar dat wilt niet zeggen dat die backup er niet was.

Ik hoopte er al op dat je dit bedoelde, het stond er niet zo lekker verwoordDXaroth schreef op vrijdag 07 februari 2014 @ 00:06:

Neen, backups gebruik je om te herstellen van het verlies van data, je voorkomt dataverlies door redundantie aan te brengen in je systemen (zowel storage als daarbuiten).. maar zodra dat niet meer helpt, heb je een oplossing nodig. Dat is waar backups voor zijn.

Het probleem is alleen dat je het doel en het middel op gelijke voet stelt. Backup is het doel, snapshot, handmatige copy-paste, enz. zijn het middel om dat doel te bereiken. Een backup maak je om volledig dataverlies te voorkomen maar ook om oeps-momentjes op te vangen. Er zijn verschillende soorten backups: tijdelijke, volledige, incrementele, offline, online, enz. Iedere vorm van backup vereist weer zijn eigen middel.Het feit dat je iets kan gebruiken om een doel te bereiken wil niet zeggen dat het een oplossing ervoor is. Ja, snapshots zijn handig om rollbacks uit te kunnen voeren van je systeem mocht er wat mis gaan, en ja, je kan snapshots gebruiken om differentiële data te versturen naar off-site, maar dat maakt het nog geen backup.

Snapshots an sich worden voor meer gebruikt dan alleen backup en oeps-momenten. Je maakt er ook gebruik van als je een bepaalde staat wil vastleggen. Een principe die in packaging wordt toegepast (snapshot aan het begin en aan het eind van de sessie; het verschil is dan wat er in de package gaat). Dat is alleen van een totaal andere orde dan snapshot functionaliteit van een filesystem. Dat beperkt zich vooral tot het veilig stellen van data. Snapshotting in iets als ZFS is van een geheel andere orde als die in VMware ESXi en die in Novell Zenworks. Jij lijkt dat op gelijke voet te trekken.

Bovenstaande heeft alleen helemaal niets met snapshots te maken. Dit gebeurd even goed met dedicated backup software.Het concept van snapshots vs backups is simpel:

1) voor elke 'grote' wijziging maak je een snapshot, dit betekend dat mocht er iets finaal mis gaan, dan kan je snel recoveren terug naar het moment van aanmaken. dit gaat er van uit dat genoemde wijziging verder geen negatieve impact heeft op je omgeving (lees: je server is niet afgefikt)

2) Voor 'oeps' momenten neem je regelmatig snapshots, dit betekend dat zodra er iemand per ongeluk iets verkeerds doet (je verwijderd een bestand wat niet verwijderd hoefde te worden, of erger, je porno collectie).. in zo'n geval kan je terug gaan naar een punt in tijd die daarvoor ligt.. dit is niet 100% optimaal, want je verliest de vooruitgang tussen dat moment en nu, maar dat is in veel gevallen te overzien.

Ook dit gaat op voor iedere vorm van backup. Je doet dit bij snapshots maar ook bij handmatige copy-paste en dedicated backup software. Wat je hier neerzet heeft niets te maken met techniek of technologie. Hetgeen je hier beschrijft is een kwestie van je backup strategie niet goed uit hebben gedacht.Nu is je systeem redelijk veilig, je data kan je terug halen.. behalve!

3) Je server vliegt in de fik.. letterlijk, gesmolten metaal en whatever... je opslag is compleet kapot, en niet meer te herstellen... dit is waarom je elke X tijd een complete backup maakt van je systeem, die je off-site opslaat (letterlijk, een externe harde schijf die je bij je (schoon) ouders neer legt)... Nu kan je je dataset terug halen op een ander (vervangend) systeem.. waarbij je wel enige vorm van data kwijt bent, maar niet compleet.

Fout! Backups zijn het doel, snapshots maar 1 van de middelen die je tot je beschikking hebt om tot dat doel te komen. Het gaat erom dat je juist gebruik maakt van die middelen.Snapshots gebruik je om data-verlies tegen te gaan, Backups gebruik je om te herstellen ervan.

Geen enkele behoefte om dat te doen en wij weten heel erg goed hoe gebruikers werken. Daarom spreken wij ze ook aan op hun eigen verantwoordelijkheid. Het is niet onze data, het is HUN data. Het enige wat wij kunnen doen is ze hierin assisteren, adviseren en in zekere mate ook faciliteren. Het is net als tieners die uit huis gaan. Zodra ze ineens zelf voor alles moeten betalen gaan ze ineens wel overal zuinig mee om. We ondersteunen bedrijfsprocessen door IT in te zetten, niet andersom.Het feit dat gebruikers dingen kunnen verkloten is de hoofdreden dat systeembeheerders graag hun hoofd met enige snelheid tegen een muur aan willen rammen, maak een systeem dat idiot-proof is, en je zult een grotere idioot vinden.. simpel als dat.

Klaarblijkelijk dat laatste. En met de volgende reactie wordt eigenlijk wel duidelijk dat je het hele snapshot principe van ZFS ook totaal niet lijkt te snappen:? Spreek je jezelf nu tegen of snap ik je U-bocht niet helemaal?

Dan heb je het niet alleen niet begrepen maar je hebt ook duidelijk niet mijn post gelezen: snapshots in ZFS zijn wel degelijk kopieën van data. Daarom worden ze ook gebruikt voor jails. Door deze snapshots op een andere machine weer te restoren kun je een migratie uitvoeren. Ze worden ook gebruikt om een jail te clonen/dupliceren op dezelfde machine of een andere (denk aan test scenario's, uitbreiding van capaciteit, enz.).DXaroth schreef op vrijdag 07 februari 2014 @ 00:47:

Snapshots, per definitie, zijn geen kopieen van de data, en daarmee, niet -direct- een vorm van Backup.

Nogmaals, dat is dus pertinent onjuist en kent een klant ook zijn eigen verantwoordelijkheid. Dat zijn zaken die altijd keurig netjes contractueel worden afgesproken (dat moet je ook doen want anders ben je volledig aansprakelijk voor de data).Je klant gaat voor die specifieke case geholpen zijn met een snapshot, maar dat is niet het -hele- verhaal, je klant gaat namelijk enorm geirriteerd zijn als jij hem moet vertellen dat zijn data kwijt is, omdat er 4 schijven zijn uitgevallen.. al je snapshots staan daar tussen, en zijn daarmee dus ook kwijt.

Ik niet want ik zit nou al de hele tijd te wijzen op het feit dat snapshotting vaak meer is dan alleen maar iets lokaals. Snapshotting in filesystems, zoals bij ZFS, is meer dan alleen maar iets lokaals. Nogmaals, het gaat er om hoe je het allemaal toepast. Je kunt namelijk met backup software ook lokale backups maken wat veelvuldig wordt toegepast. Waarom? Omdat dit je een quick restore mogelijkheid biedt. Daarnaast heeft men nog een tweede job of voeren ze een sync uit zodat er ook elders de data staat.FireDrunk schreef op vrijdag 07 februari 2014 @ 08:11:

Als ik een fatsoenlijk Backup van een snapshot maak met zfs send & receive. Backup ik wel degelijk het hele filesysteem. ZFS snapshots zijn zoveel meer dan alleen maar gewone snapshots. En ik denk dat dat is waar jullie de mist in gaan.

Snapshotting is een middel om tot een doel (backup) te komen. Het gaat er dan ook geheel om hoe je dat middel in zet. Je kunt dan ook niet gaan lopen brullen dat een snapshot geen backup is. Als beheerder bepaal je of het een backup wordt en welk soort backup. De techniek die je gebruikt doet dat niet.

Besides, een backup is pas daadwerkelijk een backup als je een succesvolle restore hebt kunnen uitvoeren (en dat betekent dat de data daarna niet alleen teruggezet is maar dat deze daarna ook weer intact is!). Met name dat laatste deel wordt in 99% van de gevallen compleet vergeten. Sta er maar eens bij stil: hoe vaak voer je een restore uit om alleen maar te testen of het werkt?

@Paul hieronder: ah, jij spreekt vast uit ervaring

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

http://www.silverstonetek...oduct.php?pid=452&area=en

Stop dit moederbord er in

http://www.asrock.com/server/overview.asp?Model=E3C226D2I

En je hebt wel een mooie basis om mee te beginnen. Do want 32GB RAM though.

- Behuizing (is gewoon een nette zwarte ATX behuizing, niks mis mee en staat toch in de meterkast)

- Voeding (Corsair 550W, is tijdens de levensduur van de huidige server al een keer vervangen en dit is een degelijke en behoorlijk efficiënte voeding)

- 1 x 2TB harddisk (pas een paar maanden oud)

- 2 x Intel Pro 1000GT PCI netwerkkaart (die worden namelijk native ondersteund door ESXi)

Het enige waar ik nog niet helemaal uit ben is hoe de storage er op de nieuwe server uit moet komen te zien. Waar ik al wel uit ben is dat er één SSD in komt voor de OS disks van alle VM's (240 - 256GB), dat moet voldoende zijn aangezien mijn VM's vijwel allemaal Ubuntu Server als OS zullen krijgen en dat gaat prima met een 8GB OS disk per VM. Bovendien is een extra SSD later altijd makkelijk toegevoegd indien nodig.

Voor de data storage zat ik zelf te denken om 2 extra 3TB disks erbij te kopen. Vervolgens op alle 3 de disks een 1,5TB VMDK aanmaken en die dan met software raid (eventueel ZFS) tot een 3TB volume maken voor films, series en muziek. Voor mijn overige bestanden (wat foto's en documenten) maak ik dan op de 2 nieuwe disks beide een 500GB VMDK aan die ik in mirror zet op een VM. Daarna is er op alle disks nog wat ruimte over voor data van overige VM's (bijvoorbeeld een paar VMDK's voor een ceph cluster)

Nu is mijn vraag vooral of het een goed idee is om ZFS te gaan draaien op virtuele schijven? Natuurlijk begrijp ik dat het wat performance zal kosten t.o.v. van het direct doorgeven van een hele SATA controller met daaraan disks maar dat hoeft voor mij geen probleem te zijn. Het grote voordeel van deze setup voor mij is flexibiliteit in de vorm van een beperkt aantal fysieke schijven netjes gescheiden voor meerdere doelen te kunnen inzetten. Bovendien is mijn data in principe beschermt tegen uitval een enkele schijf (ook al worden er uiteraard ook gewoon elke nacht automatisch externe backups gemaakt van de belangrijke data). De grootste zorg die ik zelf heb is of het risico op datacorruptie binnen ZFS groter wordt wanneer gebruik gemaakt wordt van virtuele disks?

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1240 v3 Boxed | € 240,75 | € 240,75 |

| 1 | Supermicro X10SLH-F | € 205,01 | € 205,01 |

| 1 | Lian Li PC-A04 (Zwart) | € 87,50 | € 87,50 |

| 1 | HP NC360T PCI-E twee-poorts Gigabit serveradapter (412648-B21) | € 72,48 | € 72,48 |

| 1 | Kingston ValueRAM KVR16E11K4/32 | € 305,- | € 305,- |

| 1 | Cooler Master VS V450S | € 70,90 | € 70,90 |

| 1 | Intel 330 180GB | € 189,- | € 189,- |

| 2 | Samsung 840 series Pro 512GB | € 344,99 | € 689,98 |

| Bekijk collectie Importeer producten | Totaal | € 1.860,62 | |

De 3 SSD's had ik al.

Heb er ook nog een Areca 1882i SAS controller in om straks storage aan te hangen.

[ Voor 7% gewijzigd door abusimbal op 09-02-2014 21:58 ]

Of het risico er echt groter op word is niet te zeggen. Het is iig sterk af te raden om ZFS op VMDK's te draaien. Vooral vanwege het feit dat ZFS geen direct contact heeft met je schijven.ik222 schreef op zondag 09 februari 2014 @ 17:44:

Zelf ben ik momenteel ook aan het kijken voor een forse upgrade van mijn huidige ESXi server. Mijn huidige ESXi server is namelijk een Core 2 Duo E6550 met 4GB geheugen, 2 oude 250GB harddisks en één recent aangeschafte 2TB schijf. Van deze huidige server neem ik enkel het volgende mee:De rest wordt dus nieuw en op zich ga ik daar wat betreft de hardware wel uit komen (32 of misschien zelfs 64GB geheugen en een midrange CPU met ondersteund moederbord).

- Behuizing (is gewoon een nette zwarte ATX behuizing, niks mis mee en staat toch in de meterkast)

- Voeding (Corsair 550W, is tijdens de levensduur van de huidige server al een keer vervangen en dit is een degelijke en behoorlijk efficiënte voeding)

- 1 x 2TB harddisk (pas een paar maanden oud)

- 2 x Intel Pro 1000GT PCI netwerkkaart (die worden namelijk native ondersteund door ESXi)

Het enige waar ik nog niet helemaal uit ben is hoe de storage er op de nieuwe server uit moet komen te zien. Waar ik al wel uit ben is dat er één SSD in komt voor de OS disks van alle VM's (240 - 256GB), dat moet voldoende zijn aangezien mijn VM's vijwel allemaal Ubuntu Server als OS zullen krijgen en dat gaat prima met een 8GB OS disk per VM. Bovendien is een extra SSD later altijd makkelijk toegevoegd indien nodig.

Voor de data storage zat ik zelf te denken om 2 extra 3TB disks erbij te kopen. Vervolgens op alle 3 de disks een 1,5TB VMDK aanmaken en die dan met software raid (eventueel ZFS) tot een 3TB volume maken voor films, series en muziek. Voor mijn overige bestanden (wat foto's en documenten) maak ik dan op de 2 nieuwe disks beide een 500GB VMDK aan die ik in mirror zet op een VM. Daarna is er op alle disks nog wat ruimte over voor data van overige VM's (bijvoorbeeld een paar VMDK's voor een ceph cluster)

Nu is mijn vraag vooral of het een goed idee is om ZFS te gaan draaien op virtuele schijven? Natuurlijk begrijp ik dat het wat performance zal kosten t.o.v. van het direct doorgeven van een hele SATA controller met daaraan disks maar dat hoeft voor mij geen probleem te zijn. Het grote voordeel van deze setup voor mij is flexibiliteit in de vorm van een beperkt aantal fysieke schijven netjes gescheiden voor meerdere doelen te kunnen inzetten. Bovendien is mijn data in principe beschermt tegen uitval een enkele schijf (ook al worden er uiteraard ook gewoon elke nacht automatisch externe backups gemaakt van de belangrijke data). De grootste zorg die ik zelf heb is of het risico op datacorruptie binnen ZFS groter wordt wanneer gebruik gemaakt wordt van virtuele disks?

@Abusimbal, Ik ben vooral benieuwd naar het verbruik! Kan je eens meten wat het kale verbruik is van alleen moederbord, cpu en geheugen (en eventueel 1 SSD ofzo)

Even niets...

Ik kan je maar één ding aanraden nu je toch een vers mobo en cpu moet hebben... NIET gaan voor RDM icm ZFS (Freenas etc). Ik heb het, maar af en toe staat het ding toch degraded te knipperen. Wat er aan de hand was, geen idee. Verder kom je niet verder dan Freenas 8.3.1, 9.x ziet je ZFS pool niet meer.ik222 schreef op zondag 09 februari 2014 @ 17:44:

Zelf ben ik momenteel ook aan het kijken voor een forse upgrade van mijn huidige ESXi server. Mijn huidige ESXi server is namelijk een Core 2 Duo E6550 met 4GB geheugen, 2 oude 250GB harddisks en één recent aangeschafte 2TB schijf. Van deze huidige server neem ik enkel het volgende mee:De rest wordt dus nieuw en op zich ga ik daar wat betreft de hardware wel uit komen (32 of misschien zelfs 64GB geheugen en een midrange CPU met ondersteund moederbord).

- Behuizing (is gewoon een nette zwarte ATX behuizing, niks mis mee en staat toch in de meterkast)

- Voeding (Corsair 550W, is tijdens de levensduur van de huidige server al een keer vervangen en dit is een degelijke en behoorlijk efficiënte voeding)

- 1 x 2TB harddisk (pas een paar maanden oud)

- 2 x Intel Pro 1000GT PCI netwerkkaart (die worden namelijk native ondersteund door ESXi)

Het enige waar ik nog niet helemaal uit ben is hoe de storage er op de nieuwe server uit moet komen te zien. Waar ik al wel uit ben is dat er één SSD in komt voor de OS disks van alle VM's (240 - 256GB), dat moet voldoende zijn aangezien mijn VM's vijwel allemaal Ubuntu Server als OS zullen krijgen en dat gaat prima met een 8GB OS disk per VM. Bovendien is een extra SSD later altijd makkelijk toegevoegd indien nodig.

Voor de data storage zat ik zelf te denken om 2 extra 3TB disks erbij te kopen. Vervolgens op alle 3 de disks een 1,5TB VMDK aanmaken en die dan met software raid (eventueel ZFS) tot een 3TB volume maken voor films, series en muziek. Voor mijn overige bestanden (wat foto's en documenten) maak ik dan op de 2 nieuwe disks beide een 500GB VMDK aan die ik in mirror zet op een VM. Daarna is er op alle disks nog wat ruimte over voor data van overige VM's (bijvoorbeeld een paar VMDK's voor een ceph cluster)

Nu is mijn vraag vooral of het een goed idee is om ZFS te gaan draaien op virtuele schijven? Natuurlijk begrijp ik dat het wat performance zal kosten t.o.v. van het direct doorgeven van een hele SATA controller met daaraan disks maar dat hoeft voor mij geen probleem te zijn. Het grote voordeel van deze setup voor mij is flexibiliteit in de vorm van een beperkt aantal fysieke schijven netjes gescheiden voor meerdere doelen te kunnen inzetten. Bovendien is mijn data in principe beschermt tegen uitval een enkele schijf (ook al worden er uiteraard ook gewoon elke nacht automatisch externe backups gemaakt van de belangrijke data). De grootste zorg die ik zelf heb is of het risico op datacorruptie binnen ZFS groter wordt wanneer gebruik gemaakt wordt van virtuele disks?

Dus.... neem Vt-d!!!!!!!

Who's General Failure and why is he reading my harddrive? - Projectmanager : a person who thinks nine women can make one baby in one month

Mijn backup/test esx5.5 heeft toch echt FN 9.x draaien via rdm.asing schreef op zondag 09 februari 2014 @ 22:35:

[...]

Ik kan je maar één ding aanraden nu je toch een vers mobo en cpu moet hebben... NIET gaan voor RDM icm ZFS (Freenas etc). Ik heb het, maar af en toe staat het ding toch degraded te knipperen. Wat er aan de hand was, geen idee. Verder kom je niet verder dan Freenas 8.3.1, 9.x ziet je ZFS pool niet meer.

Dus.... neem Vt-d!!!!!!!Scheelt je een hoop hoofdpijn!

Mijn hij wil zelfs geen rdm doen volgens mij. 3 losse disks in esx daar een vmdk file op. Die vdisks toevoegen aan freenas om er een raidz pool van te maken. Ooh the horror.

- Deze advertentie is geblokkeerd door Pi-Hole -

Even niets...

[ Voor 15% gewijzigd door FireDrunk op 10-02-2014 15:23 ]

Even niets...

Verwijderd

Dus met onderstaande setup:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1240 v3 Boxed | € 245,- | € 245,- |

| 1 | Supermicro X10SLH-F | € 205,01 | € 205,01 |

| 1 | Lian Li PC-A04 (Zwart) | € 87,50 | € 87,50 |

| 1 | HP NC360T PCI-E twee-poorts Gigabit serveradapter (412648-B21) | € 72,48 | € 72,48 |

| 1 | Kingston ValueRAM KVR16E11K4/32 | € 305,- | € 305,- |

| 1 | Cooler Master VS V450S | € 70,90 | € 70,90 |

| 1 | Intel 330 180GB | € 189,- | € 189,- |

| 2 | Samsung 840 series Pro 512GB | € 344,99 | € 689,98 |

| Bekijk collectie Importeer producten | Totaal | € 1.864,87 | |

Gemeten met een Voltcraft energy checker 3000

Uit verbruik tussen 5 en 6W (door IPMI zeker)

Zet ik hem aan dan piekt hij heel even bij 77W om rond 64W gemiddeld te blijven.

Eens opgestart gemiddels 42W (zonder host gestart te hebben)

Heb dan 1 Win7 en 1 Win8.1 (test VM) gestart, verbruik met deze VM's op inlogscherm 46W

Heb nog geen optimalisaties gedaan in ESXi.

Areca kaart steekt in, maar heb nog geen driver in ESXi geïnstalleerd, maar zal wel natuurlijk ook al stroom vreten.

BTW: weet iemand een goedkope redelijk accuraat apparaat waar ik het stroomverbruik van 1 stopcontact kan monitoren via LAN ?

EDIT, gevonden:

http://energenie.com/item.aspx?id=6736

Overigens zit ik absoluut niet vast aan ZFS, ik zou ook gewoon een software raid met virtuele disks kunnen bouwen op een VM met ubuntu server. Het lijkt me dat daarmee sowieso betrouwbare storage gemaakt kan worden op virtuele disks.

Wat betreft VT-D ben ik sowieso van plan een setup te nemen die dat ondersteund. Alleen om dat voor storage in te kunnen zetten heb ik ook een moederbord met twee losse storage controllers nodig of een storage controller om door te geven. Als ik dit topic goed gelezen heb is er een Supermicro moederbord met twee losse storage controllers maar dat moet dan wel eerst geflashed worden?

Voorlopige boodschappenlijst:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E5-1620 v2 Tray | € 272,29 | € 272,29 |

| 1 | Supermicro X9SRL-F | € 265,33 | € 265,33 |

| 3 | WD Green WD20EZRX, 2TB | € 70,95 | € 212,85 |

| 6 | Kingston KTH-PL310Q8/8G | € 45,99 | € 275,94 |

| 1 | Crucial 2.5" M500 240GB | € 105,20 | € 105,20 |

| Bekijk collectie Importeer producten | Totaal | € 1.131,61 | |

Moederborden en bijbehorende CPU's die meer dan 32GB geheugen ondersteunen zijn wel erg duur zie ik nu, toch nog maar eens heroverwegen of 32GB niet genoeg is...

[ Voor 54% gewijzigd door ik222 op 10-02-2014 18:45 ]

1) houdt rekening met het feit dat je een 'Narrow ILM' processorkoeler nodig hebt

2) Deze heeft al '2 controllers'. De 2x SATA-600 + 4x SATA-300 kun je doorgeven (in zijn geheel, 'kost' je dus 6 SATA-sloten voor VMware, levert er wel 6 op voor je NAS), de 4 op de SCU niet (die zit, als ik het goed gevolgd heb, een (PCI-e) brug te ver.

3) Overweeg pricewatch: Samsung M393B2G70BH0-YH909 (of een van de andere [in NL helaas schaarse] types die op de 'Tested Memory List' staan op de site van het moederbord.

Het is iets duurder maar het voorkomt dat je (mogelijk!) net als ik al 2 weken aan het memtesten bent waarom het toevoegen van de 7e DIMM allemaal errors geeft op DIMM 1 en 5...

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Dat dit moederbord al 2 controllers heeft is wel ideaal, dan is daar verder niks meer voor nodig en 4 SATA aansluitingen voor de hypervisor zelf is ruim voldoende aangezien er voorlopig maar 1 SSD + 1 HDD aan komt te hangen, de rest van de HDD's moeten aan de NAS komen dan.

Nog een vraag, heb je inmiddels het verbruik van jou setup kunnen meten?

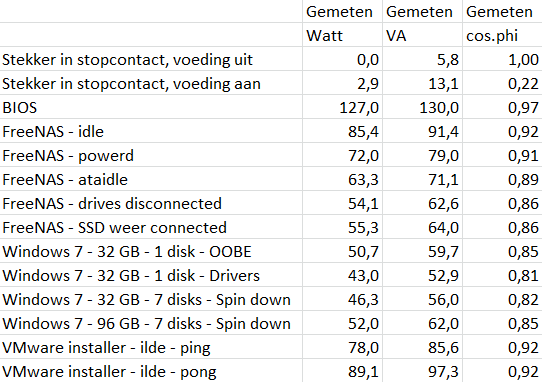

Alle metingen zijn met 128 GB, behalve Windows 7. Windows 7 kreeg ik niet geïnstalleerd met 128 GB, met 96 GB klapte het er regelmatig uit, met 64 GB was het stabiel.

Tevens zijn alle metingen met 6x Seagate NAS 4 TB, 1x WD Green 1 TB EARS en 1x Intel Postville 40 GB, tenzij anders vermeld.

De afwijkende cos.phi bij de eerste meting (en dan vooral de discrepantie met de Watt/VA's die weergegeven werden) kan ik niet verklaren, ik heb er nog wat kolommen naast staan en van de rest van de getallen is het verschil tussen Watt/VA en de gemeten cos.phi max 0,01...

Iedere DIMM extra kost in mijn geval 1,425 Watt, als ik dan doorreken wat Windows met 128 GB zou verbruiken dan verbruikt FreeNAS 8,5 Watt meer dan Windows.

Oh ja, Memtest86+ draait momenteel met alle 8 cores bezig en 80 GB ram, 150 Watt @ 0.98 cos.phi

[ Voor 4% gewijzigd door Paul op 21-07-2014 09:54 ]

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E5-1620 v2 Tray | € 272,29 | € 272,29 |

| 1 | Supermicro X9SRL-F | € 265,04 | € 265,04 |

| 2 | Seagate Barracuda 7200.14 ST2000DM001, 2TB | € 71,95 | € 143,90 |

| 1 | Supermicro SNK-P0050AP4 | € 34,99 | € 34,99 |

| 2 | Samsung M393B2G70BH0-YH909 | € 115,66 | € 231,32 |

| 1 | Crucial 2.5" M500 240GB | € 105,20 | € 105,20 |

| Bekijk collectie Importeer producten | Totaal | € 1.052,74 | |

De Seagate scbijven kies is vooral omdat dit het type is waar ik er al een van heb, ik neem aan dat allemaal dezelfde schijven het handigste is in een ZFS setup?

[ Voor 3% gewijzigd door ik222 op 10-02-2014 20:32 ]

Even niets...

pfsense = 10.10.0.1

esx host = 10.10.0.10 (met 10.10.0.1 als gateway)

Ik weet trouwens niet of dit het juiste draadje is om dit te posten, maar naar mijn weten kijken genoeg pfsense/esxi guru's in dit draadje, dus vond ik het een beetje onzin om er een apart topic voor aan te maken.

[ Voor 25% gewijzigd door FREAKJAM op 11-02-2014 22:45 ]

is everything cool?

- Je laptop een fixed adres te geven in de range waar je management network in zit

of

- Je management interface van VMware een IP-adres geven in de range die je LAN heeft.

Andere opties zijn moeilijk gaan doen met routes en interfaces en aliasen etc etc maar die twee zijn de simpelste

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ik kan vanaf de esxi-host ook niet pingen naar 10.10.0.1 (prolly blocked door pfSense?) en ik zie de esxi-host ook niet in de arp tabel staan in pfsense.

edit:

ik zie wel dat ik geen dmz (opt1) configged heb in pfsense zelf. Moet dit nog gedaan worden wellicht?

[ Voor 83% gewijzigd door FREAKJAM op 11-02-2014 23:02 ]

is everything cool?

Klopt het subnetmasker overal? 255.255.255.0 op VMware, /24 in pfSense (komt op hetzelfde neer). Wat geeft VMware aan als IP-adres van pfSense? Hoe maak je überhaupt dit plaatje; je zit met de viclient dus wel ingelogd?

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ik ga er vanuit dat ik alles goed heb ingesteld, ik krijg netjes een dhcp van pfsense (10.10.0.100).

De dhcp staat in pfsense ook netjes ingesteld vanaf 10.10.0.100, dus dat klopt ook (zodat ik dus het eerste gedeelte van het subnet kan vrijhouden voor mijn VM's, zodat ik daar statische ip-adressen op kan instellen).

[ Voor 43% gewijzigd door FREAKJAM op 11-02-2014 23:45 ]

is everything cool?

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ik had ze dus omgedraaid inderdaad.

Goed opletten dus

edit:

vanmorgen was mijn internet weer down en moest ik pfSense weer rebooten. Ik draai nu de VM met E1000 nics en de open-vm-tools package. Vanmiddag eens spelen met VMXNET3 en de officiele vmware tools. Ik haal ook maar ~20mbit down, terwijl ik een 200mbit abo heb. Nog genoeg te tweaken dus.

[ Voor 71% gewijzigd door FREAKJAM op 12-02-2014 08:18 ]

is everything cool?

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 4440 Boxed | € 154,90 | € 154,90 |

| 1 | ASRock Q87M vPro | € 96,80 | € 96,80 |

| 1 | Scythe Big Shuriken 2 Rev. B | € 30,04 | € 30,04 |

| 1 | Corsair XMS3 CMX32GX3M4A1333C9 | € 264,- | € 264,- |

| 1 | be quiet! System Power 7 300W | € 32,- | € 32,- |

| 1 | Crucial 2.5" M500 240GB | € 108,60 | € 108,60 |

| 1 | SilverStone SUGO SG02-F | € 71,83 | € 71,83 |

| 1 | Dell YT674 - Quad port ethernet adapter | € ~110 | € ~110 |

| Bekijk collectie Importeer producten | Totaal | € 910 (shipping incl.) | |

Is dus een werkende config. Alle onderdelen zijn binnen (wel nog even wachten op de nic) , eergisteren in elkaar gestoken, en via Hiren's boot cd even Prime95 laten lopen. Na 20 min loopt hij op naar 43° C - als zou ik hem ook eens langer moeten laten testen. De on-board nic werkt - met deze driver (ESXi 5.1). Binnenkort eens kijken hoeveel hij verbruikt met een watt meter

Hmm, heb pfSense productie gedraaid op 4.1 met e1000 en zonder tools, nooit problemen, nette performance... alleen als je een CARP-cluster bouwt moet je met de promiscuous-settings in VMware aan de slag.FREAKJAM schreef op woensdag 12 februari 2014 @ 01:33:

vanmorgen was mijn internet weer down en moest ik pfSense weer rebooten. Ik draai nu de VM met E1000 nics en de open-vm-tools package. Vanmiddag eens spelen met VMXNET3 en de officiele vmware tools. Ik haal ook maar ~20mbit down, terwijl ik een 200mbit abo heb. Nog genoeg te tweaken dus.

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

E1000 kan ook gewoon > 1Gb lokaal hoor

PS: Dat omdraaien van WAN/LAN heb ik ook al eens gedaan hoor

Het word pas leuk als je vriendin ineens begint te klagen dat ze geen internet heeft, omdat je DHCP server ipv op een prive LAN, op je gewone LAN adressen in een andere range uit staat te delen

[ Voor 31% gewijzigd door FireDrunk op 12-02-2014 09:00 ]

Even niets...

Klopt, de laatste open-vm-tools heeft idd geen ondersteuning voor VMXNET3. Ik vond gisteravond nog wel dit artikel, en volgens dat artikel moet het wel te doen zijn (maar het is inderdaad wel complex).

Wellicht handmatig proberen de Intel driver te updaten in pfSense? Ik kon vanmorgen in ieder geval niet meer op internet en niet meer de pfsense console benaderen (10.10.0.1), terwijl ik mijn tp-link/esxihost wel kon benaderen. Nadat ik de pfSense vm had gereboot, werkte alles weer. Wellicht een crash van pfSense. (ik had te weinig tijd om de logs te bekijken, ben nu ook iets te laat op mijn werk omdat ik het perse wou uitzoeken natuurlijk).

Ik draai trouwens de 64bits versie van pfsense 2.1 onder ESXi 5.5 met 2x een intel i210 nic. Moet niets uitmaken lijkt me, maar blijkbaar is de driver in 2.1 niet "nieuw" genoeg. Wellicht een custom-iso proberen of de 2.1.1 snapshot. Het ziet er naar uit dat pfsense met mijn i210 nic's niet zo stabiel draait.

[ Voor 22% gewijzigd door FREAKJAM op 12-02-2014 09:12 ]

is everything cool?

Ik heb hier pfSense al maanden draaien onder ESXi5.5 werkt prima.

Even niets...

is everything cool?

Even niets...

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Gelukkig hoef ik maar een half dagje te werken vandaag, vanmiddag even de logs bekijken dan maar.

[ Voor 97% gewijzigd door FREAKJAM op 12-02-2014 09:16 ]

is everything cool?

Heb trouwens nu de pricewatch: HP NC360T PCI-E twee-poorts Gigabit serveradapter (412648-B21) gekocht met Intel 82571EB. Bij ESXi 5.5 staat deze chip op http://kb.vmware.com/self...playKC&externalId=2056935 maar de HP NC360T staat wel op de HCL bij 5.5? Ben benieuwd hoelang die dan nog echt supported blijft.

[ Voor 16% gewijzigd door Zenix op 12-02-2014 19:33 ]

Even niets...

Lijkt mij namelijk wel een mooie basis voor zo'n systeem...

Even niets...

Dan zou ik iets als een IBM M1015 / M1115 er in zetten; http://www.ebay.nl/itm/IB...n_123&hash=item4ad04581ebOsiriS.nl schreef op donderdag 13 februari 2014 @ 16:21:

Is het mogelijk om met zo'n C2750 CPU moederbord een ESXI/ZFS/All-in-One machine te maken ondanks het missen van VT-d support?

Lijkt mij namelijk wel een mooie basis voor zo'n systeem...

Tenzij je maar 6 disks wilt aansluiten. Dat kan prima met de Intel poorten. De Marvells zou ik lekker links laten liggen.

[ Voor 9% gewijzigd door _Arthur op 13-02-2014 22:31 ]

Wat hij zegtFireDrunk schreef op donderdag 13 februari 2014 @ 17:32:

Het *kan* wel... Maar dan moet je met RDM werken. En dat is niet echt aan te raden. Met de nieuwe AHCI controller in ESXi 5.5 heb ik er al wel meer vertrouwen in, maar of het echt werkt (en blijft werken) is altijd maar de vraag.

Ik denk dat ik hier de enige ben die momenteel over een langere periode een RDM setup heeft draaien iswm 5.5.

- Deze advertentie is geblokkeerd door Pi-Hole -

Ik heb laatst een WD RED 2TB drive gekocht en in mijn server (whitebox, esxi HCL) geplaatst en ESXi werkt er prima mee (start er zelfs van op), tot ik een Unitrends Enterprise Backup VM er op zet en laat backuppen. De VMs op de RED crashen dan op een gegeven moment hard en zijn niet meer toegankelijk, en de vsphere client geeft een HA error als ik ze probeer te selecteren.

De schijf zelf geeft geen vreemde SMART data en komt prima door zijn self-test (kort) heen. Het enige merkwaardige wat ik zie is dat de spin-up time zo'n 4,5 sec. is.

Met een XP VM op dezelfde schijf heb ik geen problemen, evenals mijn VMs op een SSD.

Anyone?

[ Voor 7% gewijzigd door citruspers op 14-02-2014 13:13 ]

Ik zit te denken om mijn nas te gaan vervangen door een zuinig systeem waarop ik ook nog wat virtualisatie wil draaien als test bak. Nu heb ik aan de hand van het zuinige server topic onderstaande systeem uitgezocht:

1. gaat dit werken met ESXI?

2. Zal deze cpu voldoende zijn om wat testmachines op te draaien + een download bak?

| # | Product | Prijs | Subtotaal |

| 1 | Intel Celeron G1610 Boxed | € 32,46 | € 32,46 |

| 1 | ASRock B75 Pro3-M | € 50,90 | € 50,90 |

| 1 | Gigabyte GZ-X7 | € 36,97 | € 36,97 |

| 1 | Corsair CMV16GX3M2A1333C9 | € 124,99 | € 124,99 |

| 1 | Seasonic G-Serie 360Watt | € 51,- | € 51,- |

| Bekijk collectie Importeer producten | Totaal | € 296,32 | |

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Nu wil ik mijn media beschikbaar stellen aan mijn standalone HTPC (die dus geen deel uit maakt van ESXi), dan moet ik dus met de iscsi iniatiator in Windows 8.1 verbinding maken met laten deze store? De store mounten, formatten als NTFS etc en hier vervolgens mijn mkv's opslaan?

Ik heb deze guide gevolgd, en dus verder niks gedaan met vswitches/vmkernels etc. Puur in FreeNAS de iSCSI initiator aangemaakt en in ESXi de datastore aangemaakt en verwezen naar de portal in FreeNAS.

Ik heb in FreeNAS 9.2.0 trouwens wel VMXNET3 aan de praat gekregen.

[ Voor 25% gewijzigd door FREAKJAM op 16-02-2014 18:33 ]

is everything cool?

Via CIFS?? Waarom moeilijk doen met iSCSI, je hebt niet eens een physieke NIC gekoppeld aan je iSCSI LAN dacht ik.FREAKJAM schreef op zondag 16 februari 2014 @ 18:29:

Nu wil ik mijn media beschikbaar stellen aan mijn standalone HTPC (die dus geen deel uit maakt van ESXi), dan moet ik dus met de iscsi iniatiator in Windows 8.1 verbinding maken met laten deze store? De store mounten, formatten als NTFS etc en hier vervolgens mijn mkv's opslaan?

Je koppeld je storage via iSCSI aan ESX omdat dit performanter is. Voor windows gebruik je toch gewoon het SAMBA protocol zeker.

[ Voor 11% gewijzigd door A1AD op 16-02-2014 18:45 ]

- Deze advertentie is geblokkeerd door Pi-Hole -

Ik denk dat ik de logica dan niet helemaal snap. Hoe ga je met de storage om nadat je die via iscsi hebt gekoppeld aan ESXi? Je schakelt dus zowel CIFS als iSCSI in? Je doet eigenlijk niets met de datastore zelf nadat deze verschijnt in ESXi als ik het dus goed begrijp. Gewoon in FreeNAS beiden services inschakelen en gewoon CIFS shares maken zoals normaal (alleen op de achtergrond is er de koppeling tussen esxi/freenas via iscsi).A1AD schreef op zondag 16 februari 2014 @ 18:43:

[...]

Via CIFS?? Waarom moeilijk doen met iSCSI, je hebt niet eens een physieke NIC gekoppeld aan je iSCSI LAN dacht ik.

Je koppeld je storage via iSCSI aan ESX omdat dit performanter is. Voor windows gebruik je toch gewoon het SAMBA protocol zeker.

[ Voor 92% gewijzigd door FREAKJAM op 16-02-2014 20:44 ]

is everything cool?

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Intel Xeon 1230V3 + X10SL7 moederbord + 32GB ram.

[ Voor 86% gewijzigd door FREAKJAM op 16-02-2014 19:40 ]

is everything cool?

Helemaal niemand heeft ervaring met de WD RED schijven i.c.m. ESXi?citruspers schreef op vrijdag 14 februari 2014 @ 13:11:

Wat is iedereens ervaring met de WD RED drives?

Ik heb laatst een WD RED 2TB drive gekocht en in mijn server (whitebox, esxi HCL) geplaatst en ESXi werkt er prima mee (start er zelfs van op), tot ik een Unitrends Enterprise Backup VM er op zet en laat backuppen. De VMs op de RED crashen dan op een gegeven moment hard en zijn niet meer toegankelijk, en de vsphere client geeft een HA error als ik ze probeer te selecteren.

De schijf zelf geeft geen vreemde SMART data en komt prima door zijn self-test (kort) heen. Het enige merkwaardige wat ik zie is dat de spin-up time zo'n 4,5 sec. is.

Met een XP VM op dezelfde schijf heb ik geen problemen, evenals mijn VMs op een SSD.

Anyone?

Wacht...FREAKJAM schreef op zondag 16 februari 2014 @ 19:40:

Ik ben dit moment gewoon aan het testen/finetunen en dit is mijn eerste ervaring met de combinatie FreeNAS/ESXi. Ik wil gewoon weten wat het maximale is wat ik kan halen uit mijn setup.

Intel Xeon 1230V3 + X10SL7 moederbord + 32GB ram.

je htpc, is dat een virtuele machine op je ESX host?

iSCSI gebruik je om datastores te creëren op je host machine.

Samba gebruik je om gedeelde storage aan te bieden aan verschillende OSen (al dan niet virtueel)

Misschien moet je je eerst nog wat beter inlezen?

[ Voor 21% gewijzigd door A1AD op 17-02-2014 06:54 ]

- Deze advertentie is geblokkeerd door Pi-Hole -

Nee, dan snap ik het wel degelijk. Mijn HTPC betreft alleen een standalone PC een maakt geen deel uit van ESXi. Ik zou dus in mijn geval een Windows 8 VM kunnen maken, de d-schijf kunnen koppelen aan de iscsi datastore (en die formatten als NTFS, wat bij mij voor de verwarring zorgt) en die vervolgens kunnen delen op de VM zelf zodat ik die kan benaderen vanaf mijn standalone HTPC.A1AD schreef op maandag 17 februari 2014 @ 06:49:

[...]

Wacht...

je htpc, is dat een virtuele machine op je ESX host?

iSCSI gebruik je om datastores te creëren op je host machine.

Samba gebruik je om gedeelde storage aan te bieden aan verschillende OSen (al dan niet virtueel)

Misschien moet je je eerst nog wat beter inlezen?

Ik vind het gewoon een beetje vreemd als ik een datastore ga mounten en vervolgens ga formatten in in mijn geval NTFS omdat mijn harde schijven in FreeNAS zfs als filesystem hanteren. NTFS in een datastore op ZFS kan dus gewoon.

is everything cool?

Ze dienen beiden een compleet ander doel. iSCSI biedt een block device aan die compleet door één machine wordt ingezet, het is net of er een harde schijf in de initiator-machine bij komt. Tenzij je daar speciale dingen voor doet kun je dat ook maar met één machine aanspreken. ESXi doet dat, maar dat werkt alleen samen met andere ESXi-machines.FREAKJAM schreef op zondag 16 februari 2014 @ 19:06:

Ik denk dat ik de logica dan niet helemaal snap. Hoe ga je met de storage om nadat je die via iscsi hebt gekoppeld aan ESXi? Je schakelt dus zowel CIFS als iSCSI in?

CIFS daarentegen biedt op file level storage aan. Dit is wel door meerdere machines tegelijk te gebruiken (zoals bijvoorbeeld je HTPC en je werkstation). Als je de films voor je HTPC via iSCSI aanbiedt dan kun je er met je werkstation niet bij.

Wat je dus doet is een bepaald stuk van je storage (zeg, 500 GB) aanbieden via iSCSI aan ESXi om VM's op te zetten, en de rest via CIFS voor je films / backups / etc. CIFS is de standaard, iSCSI doe je wanneer je iets speciaals wilt. Jij lijkt het nu andersom te doen

Wat je NIET moet doen is de iSCSI-datastore van VMware OOK aan jet HTPC koppelen en als NTFS formatteren, op dat moment raak je je datastore en alles wat daarop staat kwijt. Als je dan in VMware kijkt dan zegt deze dat de datastore corrupt is (want ineens NTFS ipv VMFS). Ga je daar weer een datastore aanmaken dan is Windows de D:-schijf kwijt

Je moet een paar dingen los van elkaar zien. Ja, je FreeNAS is een VM, maar omdat je de storage controller met VT-d doorgeeft (toch?) kun je dit als losse machine zien:

Bestanden delen met je netwerkn:

Harddisks -> FreeNAS / ZFS -> CIFS -> Windows

Datastore voor ESXi:

Harddisks -> FreeNAS / ZFS -> groot bestand (iSCSI) -> ESXi-host -> VMFS -> ESXi

iSCSI-target voor Windows (niet doen, tenzij je daar een specifiek doel mee hebt wat met CIFS niet werkt!)

Harddisks -> FreeNAS / ZFS -> groot bestand (iSCSI) -> HTPC -> NTFS -> Windows

En voor de volledigheid de harde schijven die een VM gebruikt:

Harddisks -> FreeNAS / ZFS -> groot bestand (iSCSI) -> ESXi-host -> VMFS -> groot bestand (VMDK) -> NTFS -> Windows

[ Voor 32% gewijzigd door Paul op 17-02-2014 08:48 ]

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

FREAKJAM: Volgens mij heb jij geen reden om iSCSI te gebruiken. Wat is momenteel je datastore?

[ Voor 23% gewijzigd door A1AD op 17-02-2014 08:51 ]

- Deze advertentie is geblokkeerd door Pi-Hole -

Dan snap ik de logica dus wel. Ik snap hoe je iscsi opzet in FreeNAS/ESXi maar ik vond het ook niet echt logisch klinken om een datastore aan te maken in ESXi/FreeNAS en om deze vervolgens te koppelen aan welk systeem dan ook. De enige reden dat ik iSCSI wil proberen, is omdat ik hoor dat het "sneller" is dan CIFS. Nu had ik inderdaad bijna het volgende opgezet: Harddisks -> FreeNAS / ZFS -> groot bestand (iSCSI aka extent) -> HTPC -> NTFS -> Windows

Ik ga nu gewoon lekker shares maken met behulp van CIFS en hier lekker mijn data op zetten. (media, snapshots en vmdk backups etc). Rest nu nog het volledig tweaken van mijn ZFS.

Op dit moment haal ik ~650 mb/s read en ~230 mb/s write in een VM met CrystalMark (16GB aan ram en 2 cpu's toegewezen aan de FreeNAS VM). Ik gebruik trouwens een SSD als datastore, en ik geef via de LSI2308 de harde schijven door aan de FreeNAS VM (via passthrough).

[ Voor 7% gewijzigd door FREAKJAM op 17-02-2014 09:03 ]

is everything cool?

Blijf lekker bij CIFS / SMB, en neem de iets lagere performance voor lief.

Ik lees hier en daar ook al dat Samba 4.1 veel performance winst oplevert vanwege SMB2/3.

Even niets...

Let op: Dit is geen 'algemeen ESxi-topic'. Ook je algemene VT vragen horen hier niet thuis!

Lees voor je begint goed de start post en blijf ontopic.

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/11437/wandcontactdoos.png?f=community)

:strip_exif()/u/4633/crop589a381b183a4.gif?f=community)

:strip_icc():strip_exif()/u/212310/6.jpg?f=community)

:strip_exif()/u/38542/Scrat1ani.gif?f=community)

/u/217664/crop57a47149436c0_cropped.png?f=community)

:strip_exif()/u/108168/koebjieste21.gif?f=community)

/u/141018/crop5eb134fe815f0_cropped.png?f=community)

:strip_icc():strip_exif()/u/30381/Monion_Driver60x60.jpg?f=community)