Zelf zat ik een beetje met dezelfde keuze, en uiteindelijk ben ik gegaan voor een Intel DC P4510. In de ideale wereld had ik liever een Optane gehad, uit mijn ervaring levert zo een schijf als SLOG en L2ARC gewoon SSD-prestaties op een array met eco-schijven, maar uit kostenoverwegingen viel die af. Met mijn gebruik zijn de prestaties van deze schijf ook prima, en dan gebruik ik de schijf voor gemengd gebruik als bootschijf, voor wat containers en als SLOG en L2ARC voor 2 pools met HDD's.

Deze?dcm360 schreef op dinsdag 24 september 2019 @ 21:14:

Zelf zat ik een beetje met dezelfde keuze, en uiteindelijk ben ik gegaan voor een Intel DC P4510. In de ideale wereld had ik liever een Optane gehad, uit mijn ervaring levert zo een schijf als SLOG en L2ARC gewoon SSD-prestaties op een array met eco-schijven, maar uit kostenoverwegingen viel die af. Met mijn gebruik zijn de prestaties van deze schijf ook prima, en dan gebruik ik de schijf voor gemengd gebruik als bootschijf, voor wat containers en als SLOG en L2ARC voor 2 pools met HDD's.

pricewatch: Intel DC P4510 1TB

Want die vind ik met dik €200 behoorlijk aan de prijs. (Hij lijkt ook niet kleiner te krijgen te zijn dan 1T.)

Is dat vergelijkbaar met dit beestje?

pricewatch: Intel Optane H10 256GB

Of is die (los van dat het een NVMe is en 'ie maar 256G is), niet vergelijkbaar?

Ná Scaoll. - Don’t Panic.

@unezra De Optane H10 is stiekem geen echte Optane. Het is een SSD met QLC-geheugen aangevuld met een beetje 3D XPoint als cache. Ik had wel al bedacht dat als mijn huidige configuratie (met idd de 1TB P4510) tegen zou vallen, dat ik dan nog een Optane M10 of 800P in een M.2 slot zou kunnen plaatsen (ik heb hetzelfde moederbord, maar ik gebruik de M.2 sloten niet).

Sorry, maar dat is echt geen geld voor een dergelijke SSD naar mijn mening!unezra schreef op dinsdag 24 september 2019 @ 21:29:

Deze?

pricewatch: Intel DC P4510 1TB

Want die vind ik met dik €200 behoorlijk aan de prijs. (Hij lijkt ook niet kleiner te krijgen te zijn dan 1T.)

Hou er alleen rekening mee dat het blijkbaar een U.2 exemplaar is en je daarom dus het één en ander erbij zal moeten kopen als je geen U.2 poorten op je moederbord hebt!

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Waarbij dat laatste nog wel een interessant punt is (al begint het voor hier off-topic te raken). Ik heb er iets langer dan gepland over gedaan om de SSD werkend te krijgen, en ik ben er nog niet helemaal over uit of ik nu tweemaal een defecte Asus M.2 > SAS HD converter heb ontvangen of dat die daadwerkelijk niet compatibel is met de rest van mijn hardware. Ik zie het verschil met een wel werkende converter van Delock in ieder geval niet.

@unezra Deze artikeltjes al eens gelezen?

https://www.servethehome....nd-what-makes-a-good-one/

https://www.servethehome....og-ssd-intel-optane-nand/

Vooral in de eerste staat interessante info, zoals dit diagram:

De goedkope Intel Optane's zijn best interresant als SLOG.

Dit artikeltje moet ik altijd om grinniken:

https://www.tweaktown.com...me-ssd-review/index5.html

Hier lees je heel duidelijk dat ze niet zo goed snappen wat een SSD snel maakt. Gigantische read speeds op hoge queue depths is leuk. Maar in de praktijk zie je echt amper zo'n hoge queue, tenzij je een drukke enterprise SAN/NAS bent die IO van > 100 VM's te verduren krijgt.

Wat een SSD goed maakt is lage latency. Hoe korter de latency, hoe sneller de queue weer vrijgegeven wordt. *ALLE* writes naar je ZIL (dus niet alleen naar een SLOG, maar ook die naar je 'normale' ZIL) zijn 'SYNC'. Waardoor er dus geen queue ontstaat. Hierdoor moet je gewoon de latency van 1 request wachten totdat het 'systeem' weer door gaat.

ZFS doet dit in 2 fases. Eerst wordt er een transactie groep gestart (een verzameling IO's die op stabiele storage gezet gaan worden). Alle IO's die binnenkomen worden met slimme algoritme's in die transactie groep geplaatst (op slimme volgorde, gegroepeerd, gesorteerd, anti-fragmentatie, weet ik wat allemaal).

Komt er in zo'n transactie groep een SYNC IO terecht, moet die eerst, want de gebruiker staat te wachten.

Op dat moment wordt de transactie groep meteen geflushed (naar disk gezet). Als eerst wordt de ZIL beschreven met de SYNC IO. Als dat klaar is, krijgt de gebruiker (het process wat de IO deed) een OK.

Op dat moment gaat ZFS pas de async IO naar disk sturen. Ondertussen is alle async data dus niet naar de ZIL geschreven, deze was immers async, en mag als verloren worden beschouwd zonder ack.

Ondertussen dat ZFS dit doet, wordt er een nieuwe transactie groep gestart om weer data te verzamelen.

Rinse and repeat....

Hieruit zie je dat ZFS nooit veel IO zal queuen in 1 transactiegroep tenzij in een *heel* kort window er *heel* veel SYNC IO's binnen komen die naar de SLOG zouden moeten. De kans dat dat gebeurt is zeer beperkt, waardoor de latency van de SSD een immens veel grotere rol speelt dan de totale bandbreedte van het ding.

Intel Optane's hebben voor zover ik kan zien, geen DRAM cache, maar schrijven hun IO direct in 3D X-Point NAND, wat hele lage latency heeft.

Daarom komen die dingen ook niet naar voren als zijnde SSD's met stroombescherming's features, die zijn namelijk niet nodig. Alle SYNC IO gaat *direct* naar stable NAND.

Dat maakt ze uitermate geschikt als SLOG

Lastige is: Sommige SSD's met DRAM en Stroombescherming kunnen in sommige benchmarks sneller lijken dan Optane's. Dat komt omdat Optane's extreem geoptimaliseerd zijn voor latency, en niet voor bandbreedte.

Ik heb gemerkt dat het heeeeel lastig kan zijn om echt goede benchmarks te vinden als het gaat om QD=1 waar de review sites echt weten wat ze doen.

ServeTheHome staat er om bekend dat ze vrij goede latency benchmarks doen.

https://www.servethehome....nd-what-makes-a-good-one/

https://www.servethehome....og-ssd-intel-optane-nand/

Vooral in de eerste staat interessante info, zoals dit diagram:

De goedkope Intel Optane's zijn best interresant als SLOG.

Dit artikeltje moet ik altijd om grinniken:

https://www.tweaktown.com...me-ssd-review/index5.html

Die SSD doet bijna 39.000 IOPS bij QD=1. Dat is behoorlijk snel.For reasons unknown, running Optane as our OS disk did not agree with AS SSD's data pattern. The overall score is still quite good despite the drop in sequential read/write performance. The 4K QD1 random read performance is a new lab record for AS SSD. 4K read = 259.58 MBs is equivalent to 66,452 IOPS

Read more: https://www.tweaktown.com...me-ssd-review/index5.html

Hier lees je heel duidelijk dat ze niet zo goed snappen wat een SSD snel maakt. Gigantische read speeds op hoge queue depths is leuk. Maar in de praktijk zie je echt amper zo'n hoge queue, tenzij je een drukke enterprise SAN/NAS bent die IO van > 100 VM's te verduren krijgt.

Wat een SSD goed maakt is lage latency. Hoe korter de latency, hoe sneller de queue weer vrijgegeven wordt. *ALLE* writes naar je ZIL (dus niet alleen naar een SLOG, maar ook die naar je 'normale' ZIL) zijn 'SYNC'. Waardoor er dus geen queue ontstaat. Hierdoor moet je gewoon de latency van 1 request wachten totdat het 'systeem' weer door gaat.

ZFS doet dit in 2 fases. Eerst wordt er een transactie groep gestart (een verzameling IO's die op stabiele storage gezet gaan worden). Alle IO's die binnenkomen worden met slimme algoritme's in die transactie groep geplaatst (op slimme volgorde, gegroepeerd, gesorteerd, anti-fragmentatie, weet ik wat allemaal).

Komt er in zo'n transactie groep een SYNC IO terecht, moet die eerst, want de gebruiker staat te wachten.

Op dat moment wordt de transactie groep meteen geflushed (naar disk gezet). Als eerst wordt de ZIL beschreven met de SYNC IO. Als dat klaar is, krijgt de gebruiker (het process wat de IO deed) een OK.

Op dat moment gaat ZFS pas de async IO naar disk sturen. Ondertussen is alle async data dus niet naar de ZIL geschreven, deze was immers async, en mag als verloren worden beschouwd zonder ack.

Ondertussen dat ZFS dit doet, wordt er een nieuwe transactie groep gestart om weer data te verzamelen.

Rinse and repeat....

Hieruit zie je dat ZFS nooit veel IO zal queuen in 1 transactiegroep tenzij in een *heel* kort window er *heel* veel SYNC IO's binnen komen die naar de SLOG zouden moeten. De kans dat dat gebeurt is zeer beperkt, waardoor de latency van de SSD een immens veel grotere rol speelt dan de totale bandbreedte van het ding.

Intel Optane's hebben voor zover ik kan zien, geen DRAM cache, maar schrijven hun IO direct in 3D X-Point NAND, wat hele lage latency heeft.

Daarom komen die dingen ook niet naar voren als zijnde SSD's met stroombescherming's features, die zijn namelijk niet nodig. Alle SYNC IO gaat *direct* naar stable NAND.

Dat maakt ze uitermate geschikt als SLOG

Lastige is: Sommige SSD's met DRAM en Stroombescherming kunnen in sommige benchmarks sneller lijken dan Optane's. Dat komt omdat Optane's extreem geoptimaliseerd zijn voor latency, en niet voor bandbreedte.

Ik heb gemerkt dat het heeeeel lastig kan zijn om echt goede benchmarks te vinden als het gaat om QD=1 waar de review sites echt weten wat ze doen.

ServeTheHome staat er om bekend dat ze vrij goede latency benchmarks doen.

[ Voor 6% gewijzigd door FireDrunk op 25-09-2019 08:56 ]

Even niets...

@FireDrunk Dat is een verdomd interessant verhaal om te lezen.

Zonder anderen te kort te willen doen die hier in dit topic ook echt verdomd fijne, interessante, leerzame zaken schrijven: Dank je wel. (Anderen dus ook bedankt. Dit topic leeft opeens en hoe.)

Qua Optanes, ik snap het nut. Stel dat ik op termijn daar toch iets mee wil doen en dan wil kiezen tussen NVMe of PCIe (domweg omdat ik beiden beschikbaar heb en mijn SATA poorten sneller op gaan raken), zijn deze 3 dan zinvolle Optanes?

pricewatch: Intel Optane 800P M.2 58GB

pricewatch: Intel Optane 800P M.2 118GB

pricewatch: Intel Optane 900P PCI-e Star Citizen Promo Pack 280GB

Die eerste is "maar" een 58G NVMe, maar als ik het goed begrijp (correct me if I'm wrong), is dat voor SLOG/L2ARC meer dan goed genoeg. Daar 2 van in het systeem. partitioneren en gaan. (Of is het met zo'n apparaat acceptabel om de SLOG niet op een mirror te zetten, maar op een enkele Optane? Dan kan de SLOG op de ene en de L2ARC op de 2e.)

Puur qua prijs zit 'ie goed. De prijs per G is gigantisch hoog, maar met zo'n heel specifiek doel maakt dat niet uit omdat het ding toch niet voor iets anders ingezet gaat worden dan SLOG/L2ARC.

De PCIe kaart is ook interessant, alleen heb ik maar 2 volledig bruikbare PCIe slots. Het kan zijn dat de 3e te krap op de rest zit. In 1 komt een 4xGBit NIC, dus ik moet er voorlopig vanuit gaan dat ik nog maar 1 PCIe slot vrij heb.

Zonder anderen te kort te willen doen die hier in dit topic ook echt verdomd fijne, interessante, leerzame zaken schrijven: Dank je wel. (Anderen dus ook bedankt. Dit topic leeft opeens en hoe.)

Qua Optanes, ik snap het nut. Stel dat ik op termijn daar toch iets mee wil doen en dan wil kiezen tussen NVMe of PCIe (domweg omdat ik beiden beschikbaar heb en mijn SATA poorten sneller op gaan raken), zijn deze 3 dan zinvolle Optanes?

pricewatch: Intel Optane 800P M.2 58GB

pricewatch: Intel Optane 800P M.2 118GB

pricewatch: Intel Optane 900P PCI-e Star Citizen Promo Pack 280GB

Die eerste is "maar" een 58G NVMe, maar als ik het goed begrijp (correct me if I'm wrong), is dat voor SLOG/L2ARC meer dan goed genoeg. Daar 2 van in het systeem. partitioneren en gaan. (Of is het met zo'n apparaat acceptabel om de SLOG niet op een mirror te zetten, maar op een enkele Optane? Dan kan de SLOG op de ene en de L2ARC op de 2e.)

Puur qua prijs zit 'ie goed. De prijs per G is gigantisch hoog, maar met zo'n heel specifiek doel maakt dat niet uit omdat het ding toch niet voor iets anders ingezet gaat worden dan SLOG/L2ARC.

De PCIe kaart is ook interessant, alleen heb ik maar 2 volledig bruikbare PCIe slots. Het kan zijn dat de 3e te krap op de rest zit. In 1 komt een 4xGBit NIC, dus ik moet er voorlopig vanuit gaan dat ik nog maar 1 PCIe slot vrij heb.

Ná Scaoll. - Don’t Panic.

Nogmaals, staar je niet blind op mijn verhaal dat je Optane moet gebruiken. Ze zijn heel geschikt, maar zeker niet de enige geschikte kandidaat. Ik gebruik ze vooral als voorbeeld. Goede enterprise SSDs met battery backed DRAM kunnen in theorie zelfs hogere prestaties leveren dan een Optane. DRAM is nog altijd sneller dan 3D X-Point. Het zit hem vooral in de firmware van de Optane wat hem wel leuk maakt.

Maar *nogmaals*: Kijk goed of je wel sync nodig hebt. Draai je Database met ingewikkelde transacties die goed teruggedraait moeten kunnen worden, of VM's die een oud non-journalling filesystem draaien, welke corrupt kan raken bij wat async writes die niet gehonoreerd worden? Is het antwoord nee? Dan kan je prima sync=disabled gebruiken.

sync=disabled is *nog* veel sneller dan een SLOG. Je zet namelijk effectief de ZIL gewoon *uit*.

EDIT: nog wat meer best goede benchmarks gevonden:

Hier zie je dat de Optane bij QD=1 hele hoge read iops haalt, maar niet extreem goed is in writes bij QD=1.

Nog steeds beter dan de concurrentie, maar niet bij een factor 10 zoals bij reads:

https://www.anandtech.com...-intel-samsung-memblaze/5

Overigens zijn dit allemaal enterpise SSDs.

Maar *nogmaals*: Kijk goed of je wel sync nodig hebt. Draai je Database met ingewikkelde transacties die goed teruggedraait moeten kunnen worden, of VM's die een oud non-journalling filesystem draaien, welke corrupt kan raken bij wat async writes die niet gehonoreerd worden? Is het antwoord nee? Dan kan je prima sync=disabled gebruiken.

sync=disabled is *nog* veel sneller dan een SLOG. Je zet namelijk effectief de ZIL gewoon *uit*.

EDIT: nog wat meer best goede benchmarks gevonden:

Hier zie je dat de Optane bij QD=1 hele hoge read iops haalt, maar niet extreem goed is in writes bij QD=1.

Nog steeds beter dan de concurrentie, maar niet bij een factor 10 zoals bij reads:

https://www.anandtech.com...-intel-samsung-memblaze/5

Overigens zijn dit allemaal enterpise SSDs.

[ Voor 24% gewijzigd door FireDrunk op 25-09-2019 12:03 ]

Even niets...

Even een recap, als ik het goed heb gevolgd heb je het volgende:

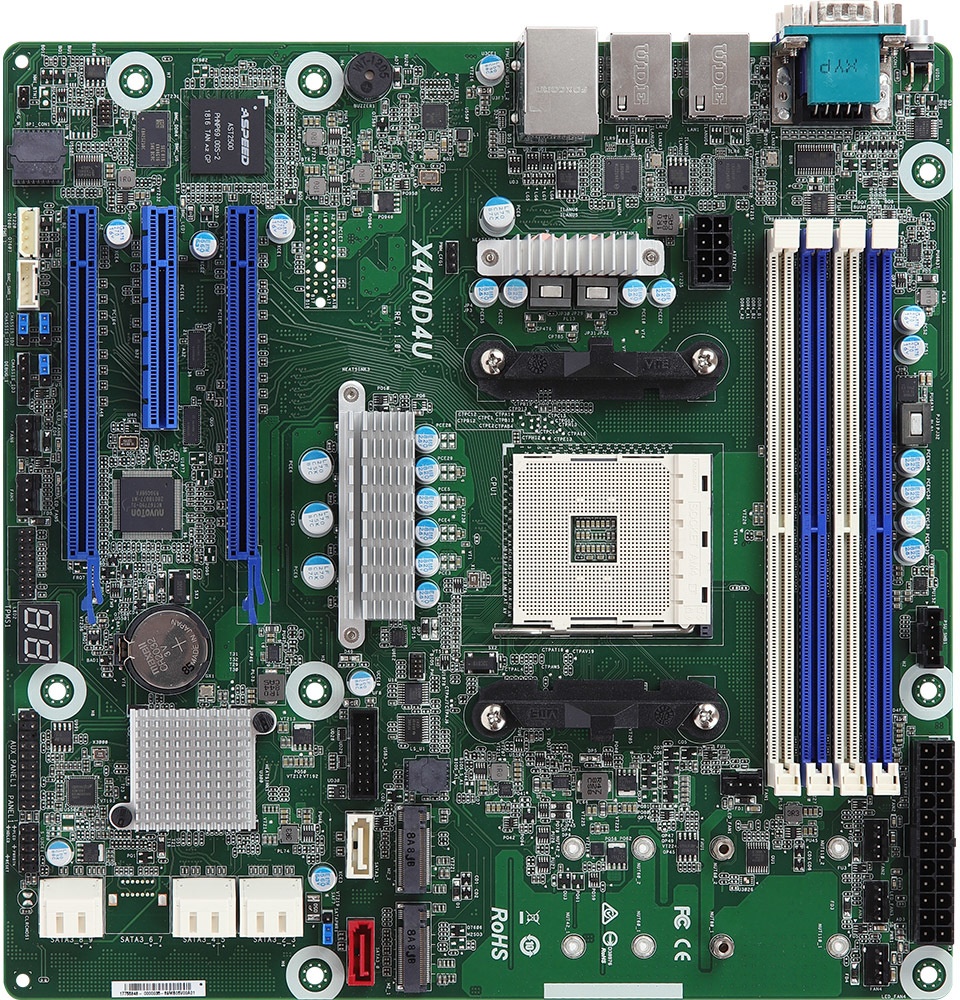

Asrock X470D4U

Ryzen 5 3600

2x 256GB SSD (mirror?): OS + kleine VMs

4x 5TB HDD: grotere VMs, data-disken VMs, data fileserver

1x PCIe 4x gigabit (heb je die al? anders misschien 10g overwegen, een switch met 10g poorten kost nog maar 120 euro of zo)

En je overweegt nog wat je wil doen voor SLOG en L2ARC?

Vanwaar L2ARC? Hoeveel RAM steek je in het systeem? Er past 128 GB in En, L2ARC kost ook geheugen. Op https://forums.servetheho...oth-slog-and-l2arc.19700/ wordt aangegeven dat het goed zou moeten gaan met een P900. 800P's zijn wel een stukje langzamer dan 900P's, maar passen in je M.2 sloten

En, L2ARC kost ook geheugen. Op https://forums.servetheho...oth-slog-and-l2arc.19700/ wordt aangegeven dat het goed zou moeten gaan met een P900. 800P's zijn wel een stukje langzamer dan 900P's, maar passen in je M.2 sloten

De 900P is er ook in 2.5" met M.2 kabelkit Ik weet niet of er latency-verschil zit tissen PCIe 2 en 3, en wat zo'n optane doet als'ie maar 2 PCIe lanes beschikbaar heeft, maar je hebt twee M.2 sloten. Wel zitten ze op de chipset en niet op de CPU. Als het echt om SPEED!!!!! / latency te doen is zou ik dus eerder iets in de PCIe-sloten zetten dan in de M.2 sloten.

Ik weet niet of er latency-verschil zit tissen PCIe 2 en 3, en wat zo'n optane doet als'ie maar 2 PCIe lanes beschikbaar heeft, maar je hebt twee M.2 sloten. Wel zitten ze op de chipset en niet op de CPU. Als het echt om SPEED!!!!! / latency te doen is zou ik dus eerder iets in de PCIe-sloten zetten dan in de M.2 sloten.

Aan de andere kant, het is een thuis-server.. Een goedkope Optane in de 'langzame' M.2 sloten lijkt me RUIM snel genoeg in zo'n situatie Zelf heb ik sync disabled, zo belangrijk zijn de VMs die er op staan namelijk niet

Zelf heb ik sync disabled, zo belangrijk zijn de VMs die er op staan namelijk niet  De data wel, maar daar heb ik een backup van.

De data wel, maar daar heb ik een backup van.

Asrock X470D4U

Ryzen 5 3600

2x 256GB SSD (mirror?): OS + kleine VMs

4x 5TB HDD: grotere VMs, data-disken VMs, data fileserver

1x PCIe 4x gigabit (heb je die al? anders misschien 10g overwegen, een switch met 10g poorten kost nog maar 120 euro of zo)

En je overweegt nog wat je wil doen voor SLOG en L2ARC?

Vanwaar L2ARC? Hoeveel RAM steek je in het systeem? Er past 128 GB in

De 900P is er ook in 2.5" met M.2 kabelkit

Aan de andere kant, het is een thuis-server.. Een goedkope Optane in de 'langzame' M.2 sloten lijkt me RUIM snel genoeg in zo'n situatie

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ik denk nog steeds dat je er niks van gaat merken. Zelfs niet in de prosumer tweaker systemen.

Sinds de 2 dagen regel reageer ik hier niet meer

Same. Je merkt er niets van.CurlyMo schreef op woensdag 25 september 2019 @ 12:53:

Ik denk nog steeds dat je er niks van gaat merken. Zelfs niet in de prosumer tweaker systemen.

Even niets...

Dat lijstje klopt inderdaad.Paul schreef op woensdag 25 september 2019 @ 12:39:

Even een recap, als ik het goed heb gevolgd heb je het volgende:

Asrock X470D4U

Ryzen 5 3600

2x 256GB SSD (mirror?): OS + kleine VMs

4x 5TB HDD: grotere VMs, data-disken VMs, data fileserver

1x PCIe 4x gigabit (heb je die al? anders misschien 10g overwegen, een switch met 10g poorten kost nog maar 120 euro of zo)

Voorlopig geen 10G hier, al hou ik er wel rekening mee dat ik op termijn (enkele jaren) wél 10G ga inzetten.

Ik heb een hele zooi leftovers van kantoor, waaronder een aantal 4xGBit kaarten en een paar behoorlijk fatsoenlijke Aruba PoE switches.

10G begint betaalbaar te worden, maar dan moet er weer een losse PoE switch bij. Daar wil ik nu net vanaf.

(Een van de redenen voor deze nieuwe server is een vereenvoudiging van mijn setup, dus minder componenten.)

De luxe van die leftovers betekend dat ik op bepaalde punten flink overkill kan creeeren zonder dat het me iets kost en tja, dan is het gewoon ook leuk en leerzaam.

Er zit 64G in.En je overweegt nog wat je wil doen voor SLOG en L2ARC?

Vanwaar L2ARC? Hoeveel RAM steek je in het systeem? Er past 128 GB inEn, L2ARC kost ook geheugen. Op https://forums.servetheho...oth-slog-and-l2arc.19700/ wordt aangegeven dat het goed zou moeten gaan met een P900. 800P's zijn wel een stukje langzamer dan 900P's, maar passen in je M.2 sloten

Reden is simpel: Dat had ik nog liggen én het is voorlopig genoeg.

(Ik gebruik op dit moment op mijn huidige hypervisors zo'n 20G, wat ademruimte voor ZFS d'r bij en dan zit ik op een ruwe 24-28G, dus nog meer dan 32G over.)

Juh.De 900P is er ook in 2.5" met M.2 kabelkitIk weet niet of er latency-verschil zit tissen PCIe 2 en 3, en wat zo'n optane doet als'ie maar 2 PCIe lanes beschikbaar heeft, maar je hebt twee M.2 sloten. Wel zitten ze op de chipset en niet op de CPU. Als het echt om SPEED!!!!! / latency te doen is zou ik dus eerder iets in de PCIe-sloten zetten dan in de M.2 sloten.

Aan de andere kant, het is een thuis-server.. Een goedkope Optane in de 'langzame' M.2 sloten lijkt me RUIM snel genoeg in zo'n situatieZelf heb ik sync disabled, zo belangrijk zijn de VMs die er op staan namelijk niet

De data wel, maar daar heb ik een backup van.

Met die eerder bestelde SSD's ongeschikt en dus terug, is dit ook meer iets voor de langere termijn.

Heb ik het nodig? Waarschijnlijk niet.

Ga ik er iets van merken? Misschien in benchmarks.

Is het leuk om d'r eens mee te rommelen? Jup en dan is het ook niet erg als het een beetje geld kost, maar binnen grenzen.

Fin, ik heb vaker Tweakers Wishlists gemaakt met onderdelen die ik 1, 2 jaar later eens review en dan bestel. (Uiteraard wel met een check of er dan geen beter alternatief is.) Dit is ook zoiets. Leuk om nu over na te denken, maar gezien het gebrek aan noodzaak, ook iets waar ik geen haast mee heb. (If ever, want misschien besluit ik wel dat het prima is zo en laat ik die M.2 slots lekker voor wat ze zijn.)

Ná Scaoll. - Don’t Panic.

Als je echt wat leuks wilt doen met 10 Gbps NIC's in meerdere systemen kan je beter naar deze switches kijken :Paul schreef op woensdag 25 september 2019 @ 12:39:

1x PCIe 4x gigabit (heb je die al? anders misschien 10g overwegen, een switch met 10g poorten kost nog maar 120 euro of zo)

- https://mikrotik.com/product/crs305_1g_4s_in

- https://mikrotik.com/product/crs309_1g_8s_in

- https://mikrotik.com/product/crs312_4c_8xg_rm

Verder heeft D-Link onlangs ook nog een refresh uitgebracht van hun 1 Gbps + 10 Gbps modellen : https://nl.hardware.info/...switches-met-10gbs-uplink

en kwam iemand daar in de reacties met dit model : https://www.fs.com/de-en/products/72944.html

Keuze zat dus, maar afhankelijk van je wensen kan het best wel een duur geintje worden!

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Die eerste zit wel in dezelfde prijscategorie, maar heeft (had? Ik heb er al even niet naar gekeken) veel moeite met een usecase die in deze doelgroep HEEL VEEL voor zal komen: 10G naar een paar devices en dan 1G uplink naar de rest van het netwerk.nero355 schreef op donderdag 26 september 2019 @ 14:59:

Als je echt wat leuks wilt doen met 10 Gbps NIC's in meerdere systemen kan je beter naar deze switches kijken :

pricewatch: MikroTik Cloud Router Switch 305-1G-4S+IN

pricewatch: MikroTik CRS309-1G-8S+IN

pricewatch: MikroTik Cloud Router Switch 312-4C+8XG-RM (CRS312-4C+8XG-RM)

Zelf heb ik maar 2 poorten nodig en zou de 'uplink' aangesloten worden op 24x100+4x1G, dus dan is de CSS-326 prima, vooral ook omdat ik al een EdgeRouter heb en CRS dus niet nodig heb

Zeker, en het wordt ook steeds goedkoper, maar dat was wel waarom ik met een € 120 model kwamKeuze zat dus, maar afhankelijk van je wensen kan het best wel een duur geintje worden!

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Grote switch met veel poorten die de meesten waarschijnlijk al zullen hebben in de meterkast dus dan kan je beter zo'n klein switchje erbij nemenPaul schreef op donderdag 26 september 2019 @ 16:54:

Zeker, en het wordt ook steeds goedkoper, maar dat was wel waarom ik met een € 120 model kwam

Maar wat ik al zei : Het is maar net wat je zoekt!

En bedankt voor het opzoeken in de Pricewatch, want dat lukte mij niet als ik gewoon op MikroTik zocht, terwijl dat een paar weken geleden zonder enig probleem lukte... /weird

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Dat was mijn eerste opzet, maar toen dat nog actueel was (ik heb nu een directe link tussen mijn beide 10G machines en wat entries in mijn hosts-bestand) kon dat goedkope kleintje iig niet goed overweg met verkeer tussen 10G en 1G.nero355 schreef op vrijdag 27 september 2019 @ 00:22:

Grote switch met veel poorten die de meesten waarschijnlijk al zullen hebben in de meterkast dus dan kan je beter zo'n klein switchje erbij nemen

Hmm, ik weet het ook niet? Ik zocht iig op https://tweakers.net/pricewatch/zoeken/?keyword=crs305En bedankt voor het opzoeken in de Pricewatch, want dat lukte mij niet als ik gewoon op MikroTik zocht, terwijl dat een paar weken geleden zonder enig probleem lukte... /weird

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Hmm.

For those interested.

1 grote onhebbelijkheid ontdekt van Sanoid: Het maakt snapshots aan in een formaat / naming dat niet compatible is met Windows Shadow Copy.

Vooralsnog voor mij een won't fix, ik laat het voor nu even zo, maar ga later toch een keer kijken of er een zfs snapshot én sender is (zoiets als sanoid/syncoid), die qua snapshots maken en senden het nodige werk uit handen neemt, maar wel dusdanig te configureren is dat de snapshots als Windows Shadow Copy zichtbaar zijn. (SMB snapt dit prima, het is echt Sanoid dat net kiest voor een naming waar SMB mee overweg kan.)

For those interested.

1 grote onhebbelijkheid ontdekt van Sanoid: Het maakt snapshots aan in een formaat / naming dat niet compatible is met Windows Shadow Copy.

Vooralsnog voor mij een won't fix, ik laat het voor nu even zo, maar ga later toch een keer kijken of er een zfs snapshot én sender is (zoiets als sanoid/syncoid), die qua snapshots maken en senden het nodige werk uit handen neemt, maar wel dusdanig te configureren is dat de snapshots als Windows Shadow Copy zichtbaar zijn. (SMB snapt dit prima, het is echt Sanoid dat net kiest voor een naming waar SMB mee overweg kan.)

Ná Scaoll. - Don’t Panic.

Wat is Sanoid?

Sinds de 2 dagen regel reageer ik hier niet meer

Een tool (wrapper) om automatisch en gescheduled ZFS snapshots te maken en (met het meegeleverde syncoid), te repliceren naar andere systemen, met automatische cleanup, etc.CurlyMo schreef op zondag 29 september 2019 @ 20:50:

Wat is Sanoid?

https://github.com/jimsalterjrs/sanoid

https://www.svennd.be/zfs-snapshots-of-proxmox-using-sanoid/

Super nuttige tool vind ik. Alleen met de onhebbelijkheid dat het snapshots aanmaakt met een naam die niet op een normale manier met Windows Shadow Copy (Previous Versions) te gebruiken zijn.

Alternatief is dit:

https://blog.chaospixel.c...ow-copies-with-samba.html

Maar daar zit dan weer geen tool bij om automatisch de zooi naar de overkant te synchroniseren voor backups.

(Voor nu kan ik er prima omheen werken, het is niet dat ik het ooit nodig heb gehad, enkel snapshots zijn vooralsnog in deze situatie prima maar hey, als snapshots op deze manier in te zetten zijn is dat natuurlijk wel leuk.)

Ná Scaoll. - Don’t Panic.

Dat ziet er nuttig uit. Ik heb dit niet direct kunnen vinden; Maar kun je dit (maken van snapshots) vanuit Windows initiëren?unezra schreef op maandag 30 september 2019 @ 06:52:

[...]

Super nuttige tool vind ik. Alleen met de onhebbelijkheid dat het snapshots aanmaakt met een naam die niet op een normale manier met Windows Shadow Copy (Previous Versions) te gebruiken zijn.

Alternatief is dit:

Link

Als je trouwens hier naar kijkt dan kan je gewoon pre/post/prune scripts configureren naar je wens. Dan kan je zelfs datgene uit dit artikel toepassen.

En anders gewoon een (github) issue aanmaken?

pvoutput. Waarom makkelijk doen, als het ook moeilijk kan! Every solution has a new problem

Initiëren niet, maar je kunt ze wel bekijken en terug zetten.imdos schreef op maandag 30 september 2019 @ 10:30:

[...]

Dat ziet er nuttig uit. Ik heb dit niet direct kunnen vinden; Maar kun je dit (maken van snapshots) vanuit Windows initiëren?

(Dat is ook het hele idee. Je initieert dit vanuit de achterkant, waardoor Windows er geen invloed op heeft en je gebruikt het resultaat aan de Windows kant. Zo ben je niet afhankelijk van Windows functionaliteit voor het maken van snapshots. Het nadeel is dat het periodiek is, het is dus geen versioning, het zijn zuiver periodieke snapshots.)

Misschien toch maar doen inderdaad.Als je trouwens hier naar kijkt dan kan je gewoon pre/post/prune scripts configureren naar je wens. Dan kan je zelfs datgene uit dit artikel toepassen.

En anders gewoon een (github) issue aanmaken?

De tool zelf is super nuttig, maar het maakt het nog veel nuttiger als je het met shadowcopy kunt gebruiken. Samba snapt dat prima en Samba string kun je aanpassen, maar beperkt. Ik heb nog geen Samba string kunnen vinden die overweg kan met de suffixes die Sanoid gebruikt. (Mocht ik die alsnog vinden is het ook prima. Als het met de Samba config aangepast kan worden en werkend gekregen kan worden ben ik er ook natuurlijk.)

Ná Scaoll. - Don’t Panic.

Right; maar hoe maak je dan een snapshot als je laptop niet constant aan staat? Doe je dan pollen of werkt dat met de stand van de zonunezra schreef op maandag 30 september 2019 @ 10:37:

[...]

Initiëren niet, maar je kunt ze wel bekijken en terug zetten.

(Dat is ook het hele idee. Je initieert dit vanuit de achterkant, waardoor Windows er geen invloed op heeft en je gebruikt het resultaat aan de Windows kant. Zo ben je niet afhankelijk van Windows functionaliteit voor het maken van snapshots. Het nadeel is dat het periodiek is, het is dus geen versioning, het zijn zuiver periodieke snapshots.)

[...]

pvoutput. Waarom makkelijk doen, als het ook moeilijk kan! Every solution has a new problem

De snapshot word gemaakt op de machine waarop ZFS draait.imdos schreef op maandag 30 september 2019 @ 12:32:

[...]

Right; maar hoe maak je dan een snapshot als je laptop niet constant aan staat? Doe je dan pollen of werkt dat met de stand van de zon

Ofwel: Je NAS (met ZFS).

Dat ding maakt periodiek snapshots (bij FreeNAS vanuit de eigen tooling, bij een Linux machine, met iets als SanOid, wat ook niet meer is dan een wrapper om bestaande zfs snapshot functionaliteit), alleen je maakt de snapshots *zichtbaar* in Windows. (Rechtsklik op bestand of directory --> Properties --> Previous Versions)

Het snapshot word dus niet gemaakt door Windows, maar door je fileserver en die draait in veel gevallen 24/7.

Ná Scaoll. - Don’t Panic.

Kom er net achter dat compression uit staat op mijn datasets.

Dacht dat het met ZoL / Proxmox standaard aan stond en ben domweg vergeten het te controleren.

Weet iemand wat de beste methode is dat aan te zetten én alle data te comprimeren? (Ik ben bang dat het uit gaat komen op domweg alle data lokaal kopieren en dan terugzetten op de plek waar het stond.)

Helaas kan ik ook niet vinden waar ik dat als default, samen met het compression algoritme, aan zou moeten zetten.

Damn, dat zuigt!

EDIT: Ik besef me dat het net voor mijn PVE vm's relatief makkelijk is. PVE kan vm's moven van de ene plek naar de andere, zonder downtime én herschrijft daarbij disks uiteraard. Dus tijdelijke dataset aanmaken, vm daarheen moven, terug moven, klaar.

Blijft over mijn SMB data, misschien dat rsync en dan mv toch het handigste is maar ik sta open voor suggesties.

Compleet ongerelateerde vraag, weet iemand of er voordelen zijn aan NFS direct via ZFS doen, ipv /etc/exports?

https://blog.programster.org/sharing-zfs-datasets-via-nfs

Dacht dat het met ZoL / Proxmox standaard aan stond en ben domweg vergeten het te controleren.

Ik weet dat het vragen naar de bekende weg is, maar toch:root@clarke:~# zfs get compression rpool datapool00 datapool01

NAME PROPERTY VALUE SOURCE

datapool00 compression off default

datapool01 compression off default

rpool compression on local

root@clarke:~# zfs get compressratio rpool datapool00 datapool01

NAME PROPERTY VALUE SOURCE

datapool00 compressratio 1.00x -

datapool01 compressratio 1.00x -

rpool compressratio 1.85x -

root@clarke:~#

root@clarke:~# zfs get compression

NAME PROPERTY VALUE SOURCE

datapool00 compression off default

datapool00/PVE compression off default

datapool00/PVE/BACKUPS compression off default

datapool00/PVE/LXC compression off default

datapool00/PVE/TST compression off default

datapool00/PVE/VM compression off default

datapool00/SMB compression off default

Weet iemand wat de beste methode is dat aan te zetten én alle data te comprimeren? (Ik ben bang dat het uit gaat komen op domweg alle data lokaal kopieren en dan terugzetten op de plek waar het stond.)

Helaas kan ik ook niet vinden waar ik dat als default, samen met het compression algoritme, aan zou moeten zetten.

Damn, dat zuigt!

EDIT: Ik besef me dat het net voor mijn PVE vm's relatief makkelijk is. PVE kan vm's moven van de ene plek naar de andere, zonder downtime én herschrijft daarbij disks uiteraard. Dus tijdelijke dataset aanmaken, vm daarheen moven, terug moven, klaar.

Blijft over mijn SMB data, misschien dat rsync en dan mv toch het handigste is maar ik sta open voor suggesties.

Compleet ongerelateerde vraag, weet iemand of er voordelen zijn aan NFS direct via ZFS doen, ipv /etc/exports?

https://blog.programster.org/sharing-zfs-datasets-via-nfs

[ Voor 12% gewijzigd door unezra op 04-10-2019 17:59 ]

Ná Scaoll. - Don’t Panic.

Da's raar. Ik heb hier een Proxmox install van 2 weken oud. Weliswaar gemanaged door Puppet, maar ik weet nagenoeg zeker dat dit niet aangepast is (want dat stond nog op m'n todo om te puppetizen). Op deze install staat compression gewoon aan, alleen geen lz4 algo. Echter, volgens dit zijn de voordelen van lz4 over lzjb beperkt.

Verder had je de strekking zelf ook al bedacht, je moet gaan zorgen dat die blocks opnieuw beschreven gaan worden. Voor je SMB data kan je natuurlijk gaan rsyncen, maar je kan ook zfs send | zfs receive doen (op dezelfde machine - als dat past).

Verder had je de strekking zelf ook al bedacht, je moet gaan zorgen dat die blocks opnieuw beschreven gaan worden. Voor je SMB data kan je natuurlijk gaan rsyncen, maar je kan ook zfs send | zfs receive doen (op dezelfde machine - als dat past).

No trees were harmed in creating this message. However, a large number of electrons were terribly inconvenienced.

Hmmm. Ik zie het idd.Freeaqingme schreef op vrijdag 4 oktober 2019 @ 20:30:

Da's raar. Ik heb hier een Proxmox install van 2 weken oud. Weliswaar gemanaged door Puppet, maar ik weet nagenoeg zeker dat dit niet aangepast is (want dat stond nog op m'n todo om te puppetizen). Op deze install staat compression gewoon aan, alleen geen lz4 algo. Echter, volgens dit zijn de voordelen van lz4 over lzjb beperkt.

Aan de andere kant, ik moet het alsnog aanzetten en zijn conclusie is dan ook weer dat het ook geen kwaad kan. Dus ik denk dat ik gewoon voor lz4 ga.

Heel raar. Ik heb de machine geïnstalleerd met een stock ISO van PVE6, root is wel compressed maar de datapools die ik heb aangemaakt niet. Dom dat ik dat niet heb gecontroleerd direct ná installatie en vóór ik er data op ging zetten.

Verder had je de strekking zelf ook al bedacht, je moet gaan zorgen dat die blocks opnieuw beschreven gaan worden. Voor je SMB data kan je natuurlijk gaan rsyncen, maar je kan ook zfs send | zfs receive doen (op dezelfde machine - als dat past).

Dat past. Gelukkig.root@clarke:~# zfs list

NAME USED AVAIL REFER MOUNTPOINT

datapool00 4.45T 8.35T 151K /datapool00

datapool00/PVE 3.50T 8.35T 174K /datapool00/PVE

datapool00/PVE/BACKUPS 1.44T 8.35T 1.44T /datapool00/PVE/BACKUPS

datapool00/PVE/LXC 2.21G 8.35T 2.21G /datapool00/PVE/LXC

datapool00/PVE/TST 23.7G 8.35T 23.7G /datapool00/PVE/TST

datapool00/PVE/VM 2.04T 8.35T 2.04T /datapool00/PVE/VM

datapool00/SMB 968G 8.35T 920G /datapool00/SMB

datapool01 685G 214G 192K /datapool01

datapool01/ISO 71.8G 214G 63.1G /datapool01/ISO

datapool01/PVE 613G 214G 272K /datapool01/PVE

datapool01/PVE/BACKUPS 612G 214G 612G /datapool01/PVE/BACKUPS

datapool01/PVE/LXC 192K 214G 192K /datapool01/PVE/LXC

datapool01/PVE/TMPL 1.20G 214G 1.20G /datapool01/PVE/TMPL

datapool01/PVE/TST 208K 214G 208K /datapool01/PVE/TST

datapool01/PVE/VM 192K 214G 192K /datapool01/PVE/VM

rpool 1.21G 227G 120K /rpool

rpool/PVE 520K 227G 120K /rpool/PVE

rpool/PVE/BACKUPS 96K 227G 96K /rpool/PVE/BACKUPS

rpool/PVE/LXC 96K 227G 96K /rpool/PVE/LXC

rpool/PVE/TST 112K 227G 112K /rpool/PVE/TST

rpool/PVE/VM 96K 227G 96K /rpool/PVE/VM

rpool/ROOT 1.20G 227G 96K /rpool/ROOT

rpool/ROOT/pve-1 1.20G 227G 1.20G /

rpool/data 96K 227G 96K /rpool/data

root@clarke:~#

Denk dat ik mijn vm's maar ga omzetten via PVE zelf, domweg omdat dat zonder downtime kan.

SMB data maakt wat minder uit, omdat die nauwelijks wijzigt en ik best even kan leven met dat ik data readonly moet beschouwen. Daar is zfs send denk ik wel een heel goede, omdat het veel sneller moet gaan dan rsync. (Die SMB data zijn op sommige punten extreem veel kleine bestandjes en dat gaat ook via rsync traag.)

ISO's same thing, die kunnen ook best even readonly.

Ik ga vandaag maar een beginnetje maken.

EDIT:

Even een eerste vm overgezet naar een tijdelijke plek (gaat direct weer terug).

root@clarke:~# zfs get compressratio datapool00/PVE/VM datapool00/PVE/TST datapool00/PVE/VM_TMP

NAME PROPERTY VALUE SOURCE

datapool00/PVE/TST compressratio 1.00x -

datapool00/PVE/VM compressratio 1.00x -

datapool00/PVE/VM_TMP compressratio 1.88x -

root@clarke:~#

Dat is dus waarom ik het aan wilde hebben.

[ Voor 10% gewijzigd door unezra op 05-10-2019 10:19 ]

Ná Scaoll. - Don’t Panic.

Aah, je hebt echt aparte data pools. Dat zal het verschil verklaren. Op de dedicated bak waar ik het over had heb ik 2 HDD's in mirror draaien waar zowel het OS als de data op staat. Proxmox zet dan het compression vlaggetje van de root-zfs, en alle onderliggende zfs'jes inheriten dat netjes. In jouw geval zal die aparte zfs pool geen compression gehad hebben, en viel er dan ook niets te inheriten.

No trees were harmed in creating this message. However, a large number of electrons were terribly inconvenienced.

Jup.Freeaqingme schreef op zaterdag 5 oktober 2019 @ 12:38:

Aah, je hebt echt aparte data pools. Dat zal het verschil verklaren. Op de dedicated bak waar ik het over had heb ik 2 HDD's in mirror draaien waar zowel het OS als de data op staat. Proxmox zet dan het compression vlaggetje van de root-zfs, en alle onderliggende zfs'jes inheriten dat netjes. In jouw geval zal die aparte zfs pool geen compression gehad hebben, en viel er dan ook niets te inheriten.

Die inheritance gaat inderdaad goed, maar ik dacht werkelijk dat hij in zijn zfs defaults ook compression aan had staan voor nieuwe zpools. Dat heb ik helaas niet gecontroleerd, dus nu zit ik met een stukje nawerk dat ongepland was. Gelukkig valt, naar het lijkt, de klus mee. Ik ben nu mijn vm's aan het overzetten (online, 2x een move) en ga zo even uitzoeken hoe ik met zfs send & zfs receive het beste mijn SMB data en ISO's over kan zetten.

Het suffe is, ik meen begrepen te hebben dat je ergens in je zfs config defaults neer kunt zetten voor dit soort zaken, maar ik kan het niet vinden. Nu veranderd er in de regel niet zo veel in mijn zpools en maak ik datasets altijd als sub aan van hun main, met inheritance staat het dan allemaal meteen goed, maar toch.

Ik gebruik datasets behoorlijk intensief. Het is zó makkelijk en geeft me net even wat meer inzicht. Ik probeer ook echt het gebruik van zvols te vermijden. Vind het niet praktisch. Op mijn PVE installatie heb ik domweg een dataset datapool00/PVE/VM en daarin stop ik de qcow2 images van mijn vm's. Fin, de verdeling spreekt redelijk voor zich.

Vraag me nog wel af wat beter is qua sharing. Ik maak nu gebruik van klassiek NFS met een /etc/exports, maar ik weet dat ZFS dit ook kan. Weet alleen niet of het een voordelen en/of nadelen heeft boven het ander. /etc/exports is prettig overzichtelijk en makkelijk, maar als het voordelen heeft het via ZFS te doen, gooi ik dat misschien wel om.

Ná Scaoll. - Don’t Panic.

Als ik dit zo lees, dan lijkt het er op dat ZFS gewoon inhaakt op de NFS functionaliteit van Linux. Voor zover er verschillen zijn verwacht ik dat dat 'm enkel zit in bepaalde nfs opties die meegegeven worden (rond regel 390 van de genoemde link). Ander voordeel is dat 't je in theorie maintenance scheelt. Als je een ZFS'je zou verplaatsen, dan hoef je dat nog maar op 1 plek te doen, ipv 2.unezra schreef op zaterdag 5 oktober 2019 @ 12:56:

[...]

Vraag me nog wel af wat beter is qua sharing. Ik maak nu gebruik van klassiek NFS met een /etc/exports, maar ik weet dat ZFS dit ook kan. Weet alleen niet of het een voordelen en/of nadelen heeft boven het ander. /etc/exports is prettig overzichtelijk en makkelijk, maar als het voordelen heeft het via ZFS te doen, gooi ik dat misschien wel om.

Zou je het met dezelfde opties mounten, verwacht ik geen verschil in performance. Maar dat is natuurlijk te benchmarken

No trees were harmed in creating this message. However, a large number of electrons were terribly inconvenienced.

Heeft iemand hier een goed idee voor.

Ik heb twee lokale NAS'. Eentje die 24/7 aan staat [A] en eentje puur voor archief [B].

[Edit]

Wat ik wil gaat niet theoretisch niet lukken

Ik heb twee lokale NAS'. Eentje die 24/7 aan staat [A] en eentje puur voor archief [B].

[Edit]

Wat ik wil gaat niet theoretisch niet lukken

[ Voor 97% gewijzigd door CurlyMo op 13-10-2019 21:00 ]

Sinds de 2 dagen regel reageer ik hier niet meer

Ik heb een ZFS setup door de passthrough van 4 HDDs in een VM. Bij een scrub is daar een unrecoverable error aangetroffen, maar als ik zpool status doe lijkt er niets aan de hand. Moet / kan ik gewoon zpool clear doen of kan ik het beste iets anders doen?

root@naggon:~# zpool status

pool: tank0

state: ONLINE

status: One or more devices has experienced an unrecoverable error. An

attempt was made to correct the error. Applications are unaffected.

action: Determine if the device needs to be replaced, and clear the errors

using 'zpool clear' or replace the device with 'zpool replace'.

see: http://zfsonlinux.org/msg/ZFS-8000-9P

scan: scrub repaired 128K in 0 days 04:58:26 with 0 errors on Sun Oct 13 05:22:32 2019

config:

NAME STATE READ WRITE CKSUM

tank0 ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

scsi-0QEMU_QEMU_HARDDISK_drive-scsi8 ONLINE 0 0 0

scsi-0QEMU_QEMU_HARDDISK_drive-scsi7 ONLINE 1 0 0

mirror-1 ONLINE 0 0 0

scsi-0QEMU_QEMU_HARDDISK_drive-scsi6 ONLINE 0 0 0

scsi-0QEMU_QEMU_HARDDISK_drive-scsi5 ONLINE 0 0 0

errors: No known data errors

Ik zou even een uitgebreide SMART-check van die disk doen; de pariteit heeft de leesfout nu nog kunnen corrigeren, maar onleesbare sectoren op je disk zijn wel een probleem, dus dat moet je even in de gaten houden. Periodiek controleren en kijken of het aantal fouten niet blijft toenemen.

Even schieten op wat zaken in een verder uitstekend informatieve post - ik probeer ZFS beter te begrijpen om bepaalde keuzes beter te kunnen maken en liep er tegenaan. Misschien zit ik er gewoon naast, no offense intended, etc.

De write naar de ZIL volstaat immers om te garanderen dat de data uiteindelijk op disk terechtkomt: regulier, alsof de ZIL niet bestond - of het scenario waar de ZIL zich uitbetaalt: bij een panic of power loss, waarna ZFS uncomitted sync writes uit de ZIL kan vissen en alsnog kan committen in een txg.

Voor de grootte van een txg maakt het type I/O niet uit.

Datzelfde voorbeeld vind ik overigens wèl een reden waarom ik het idee heb dat discussies omtrent 'powerloss prevention' op SSDs zwaar overtrokken zijn voor de thuisgebruiker: als je geen enterprise database draait kom je wel weg met een paar missende writes en het is al snel ondergeschikt aan alle zaken die je in RAM had staan die je óók kwijt bent. Bovendien hadden HDDs dat euvel altijd al.

Dat was waar ik eigenlijk voor kwam - mis ik iets?

Klopt niet, in de zin dat een sync write geen invloed uitoefent op het wel-of-niet committen van een txg.FireDrunk schreef op woensdag 25 september 2019 @ 08:54:

Komt er in zo'n transactie groep een SYNC IO terecht, moet die eerst, want de gebruiker staat te wachten.

Op dat moment wordt de transactie groep meteen geflushed (naar disk gezet). Als eerst wordt de ZIL beschreven met de SYNC IO. Als dat klaar is, krijgt de gebruiker (het process wat de IO deed) een OK.

De write naar de ZIL volstaat immers om te garanderen dat de data uiteindelijk op disk terechtkomt: regulier, alsof de ZIL niet bestond - of het scenario waar de ZIL zich uitbetaalt: bij een panic of power loss, waarna ZFS uncomitted sync writes uit de ZIL kan vissen en alsnog kan committen in een txg.

Correct me if I'm wrong, maar volgens mij zijn er twee limieten op een txg: grootte (zie: zfs_dirty_data_sync) en en tijd (zfs_txg_timeout). Ofwel: 64 MB of 5 s.Hieruit zie je dat ZFS nooit veel IO zal queuen in 1 transactiegroep tenzij in een *heel* kort window er *heel* veel SYNC IO's binnen komen die naar de SLOG zouden moeten.

Voor de grootte van een txg maakt het type I/O niet uit.

Lijkt me zeer gevaarlijk advies. Het hele idee van sync en aanverwanten is dat je de garantie hebt dat data op disk staat. Daar moet je niet over liegen, tenzij je exact weet wat de implicaties zijn: alleen in zeer specifieke gevallen dus en het is in alle gevallen beter als je het op de applicatielaag oplost.FireDrunk schreef op woensdag 25 september 2019 @ 11:57:

Draai je Database met ingewikkelde transacties die goed teruggedraait moeten kunnen worden, of VM's die een oud non-journalling filesystem draaien, welke corrupt kan raken bij wat async writes die niet gehonoreerd worden? Is het antwoord nee? Dan kan je prima sync=disabled gebruiken.

Datzelfde voorbeeld vind ik overigens wèl een reden waarom ik het idee heb dat discussies omtrent 'powerloss prevention' op SSDs zwaar overtrokken zijn voor de thuisgebruiker: als je geen enterprise database draait kom je wel weg met een paar missende writes en het is al snel ondergeschikt aan alle zaken die je in RAM had staan die je óók kwijt bent. Bovendien hadden HDDs dat euvel altijd al.

Dat was waar ik eigenlijk voor kwam - mis ik iets?

Voor de geïnteresseerden hier heb ik nog een mooie puzzel (waar ik zelf nog niet helemaal uit ben).

Op een server met ProxMox heb/had ik een raid-z2-pool met vier schijven (a, b, c en d voor het gemak). Van deze schijven was er één (a) stuk, en gemarkeerd als offline. Sinds eerder deze week vertoonde een tweede schijf (b) ook problemen (af en toe een onleesbare sector). De server draaide niet stabiel vanwege problemen met het werkgeheugen (de server liep vast zonder enige mededeling). Na een bios-update zijn de problemen met het geheugen verholpen, maar is de pool kwijt. Schijven c en d staan op UNAVAIL bij een poging tot import, en omdat a al offline was is daarmee de pool gesneuveld. Met zdb -l kan ik de labels van a en b uitlezen, maar op c en d lijken die verdwenen te zijn.

Met alleen c en d aangesloten kan zpool import helemaal niet vinden, en de aansluitingen wisselen met die van a en b verandert ook niets aan de resultaten. Er lijkt niets raars gebeurd te zijn met de partitietabel, en daarmee kom ik op Google niet echt verder meer (vaak zijn betreffende pools minder stuk dan die van mij). Werkende strategieën lijken mij om de labels weer op c en d te krijgen, doordat zfs ze kan vinden of door ze opnieuw te plaatsen. Hoe dat zou moeten is me echter niet helder.

Nog voor de duidelijkheid: het zou enkel leuk zijn als ik de pool weer werkend krijg, niet noodzakelijk. Ik wil met name uitvinden of en hoe dit te redden valt, en als daar data mee terugkomt is dat als bonus.

Op een server met ProxMox heb/had ik een raid-z2-pool met vier schijven (a, b, c en d voor het gemak). Van deze schijven was er één (a) stuk, en gemarkeerd als offline. Sinds eerder deze week vertoonde een tweede schijf (b) ook problemen (af en toe een onleesbare sector). De server draaide niet stabiel vanwege problemen met het werkgeheugen (de server liep vast zonder enige mededeling). Na een bios-update zijn de problemen met het geheugen verholpen, maar is de pool kwijt. Schijven c en d staan op UNAVAIL bij een poging tot import, en omdat a al offline was is daarmee de pool gesneuveld. Met zdb -l kan ik de labels van a en b uitlezen, maar op c en d lijken die verdwenen te zijn.

Met alleen c en d aangesloten kan zpool import helemaal niet vinden, en de aansluitingen wisselen met die van a en b verandert ook niets aan de resultaten. Er lijkt niets raars gebeurd te zijn met de partitietabel, en daarmee kom ik op Google niet echt verder meer (vaak zijn betreffende pools minder stuk dan die van mij). Werkende strategieën lijken mij om de labels weer op c en d te krijgen, doordat zfs ze kan vinden of door ze opnieuw te plaatsen. Hoe dat zou moeten is me echter niet helder.

Nog voor de duidelijkheid: het zou enkel leuk zijn als ik de pool weer werkend krijg, niet noodzakelijk. Ik wil met name uitvinden of en hoe dit te redden valt, en als daar data mee terugkomt is dat als bonus.

De pool is denk ik hosed, doordat, voor zover ik weet, ub_guid_sum ( http://www.giis.co.in/Zfs_ondiskformat.pdf pagina 14/55) niet valtt te injecteren.dcm360 schreef op zaterdag 9 november 2019 @ 01:41:

Voor de geïnteresseerden hier heb ik nog een mooie puzzel (waar ik zelf nog niet helemaal uit ben).

Op een server met ProxMox heb/had ik een raid-z2-pool met vier schijven (a, b, c en d voor het gemak). Van deze schijven was er één (a) stuk, en gemarkeerd als offline. Sinds eerder deze week vertoonde een tweede schijf (b) ook problemen (af en toe een onleesbare sector). De server draaide niet stabiel vanwege problemen met het werkgeheugen (de server liep vast zonder enige mededeling). Na een bios-update zijn de problemen met het geheugen verholpen, maar is de pool kwijt. Schijven c en d staan op UNAVAIL bij een poging tot import, en omdat a al offline was is daarmee de pool gesneuveld. Met zdb -l kan ik de labels van a en b uitlezen, maar op c en d lijken die verdwenen te zijn.

Met alleen c en d aangesloten kan zpool import helemaal niet vinden, en de aansluitingen wisselen met die van a en b verandert ook niets aan de resultaten. Er lijkt niets raars gebeurd te zijn met de partitietabel, en daarmee kom ik op Google niet echt verder meer (vaak zijn betreffende pools minder stuk dan die van mij). Werkende strategieën lijken mij om de labels weer op c en d te krijgen, doordat zfs ze kan vinden of door ze opnieuw te plaatsen. Hoe dat zou moeten is me echter niet helder.

Nog voor de duidelijkheid: het zou enkel leuk zijn als ik de pool weer werkend krijg, niet noodzakelijk. Ik wil met name uitvinden of en hoe dit te redden valt, en als daar data mee terugkomt is dat als bonus.

edit: https://utcc.utoronto.ca/...is/ZFSZpoolImportAssembly

"Religion is an insult to human dignity. With or without it you would have good people doing good things and evil people doing evil things. But for good people to do evil things, that takes religion." - Steven Weinberg

Dan is de vraag of hij dan ook weet hoeveel vdevs er dan missen. Als je het voor elkaar krijgt om die labels te reconstrueren, zonder dat ze matchen met de ub_guid_sum, dan zou het praktisch mogelijk moeten zijn om je pool te importeren. Die missende vdev kan je dan oplossen zodra je pool geïmporteerd is. Of het theoretisch zo werkt in ZFS weet ik niet.0xDEADBEEF schreef op zaterdag 9 november 2019 @ 13:59:

[...]

De pool is denk ik hosed, doordat, voor zover ik weet, ub_guid_sum ( http://www.giis.co.in/Zfs_ondiskformat.pdf pagina 14/55) niet valtt te injecteren.

edit: https://utcc.utoronto.ca/...is/ZFSZpoolImportAssembly

Sinds de 2 dagen regel reageer ik hier niet meer

Jullie gaan voorbij aan het feit dat de labels überhaupt lijken te missen: dat zou niet moeten kunnen: er zijn immers 4 (!) kopiën van, je moet érg je best doen om ze allemaal te overschrijven en ze vallen echt niet zomaar van je disk af.

Daarnaast is het kritieke metadata als geheel- het is niet enkel één guid.

Er is iets heel merkwaardigs aan de hand, of @dcm360 ziet iets over het hoofd.

@dcm360 Wat zegt blkid? Of wipefs? file -s? Je voert ook een partite aan zdb -l (aangenomen dat je ZFS member een partiie is) ipv. je hele disk?

Wat staat er dàn op de eerste 512k van je partitie (of disk) als het niet een zfs label is (hexdump indien nodig)?

Daarnaast is het kritieke metadata als geheel- het is niet enkel één guid.

Er is iets heel merkwaardigs aan de hand, of @dcm360 ziet iets over het hoofd.

@dcm360 Wat zegt blkid? Of wipefs? file -s? Je voert ook een partite aan zdb -l (aangenomen dat je ZFS member een partiie is) ipv. je hele disk?

Wat staat er dàn op de eerste 512k van je partitie (of disk) als het niet een zfs label is (hexdump indien nodig)?

# head -c 1048576 /dev/sdb1 | strings -n8 # tail -c 1048576 /dev/sdb1 | strings -n8

[ Voor 6% gewijzigd door Thralas op 09-11-2019 16:28 ]

@0xDEADBEEF, @CurlyMo: Daar valt denk ik inderdaad nog wel iets op te verzinnen als het nodig is, het is immers ook mogelijk om de pool te importeren met slechts 2 van de 4 schijven. ZFS lijkt nog steeds prima te zien dat het origineel een set van 4 schijven was en in welke configuratie.

@Thralas :

zdb -l heb ik inderdaad uitgevoerd op de partitie (met de tweede poging. Dat ik dat fout deed had ik wel door toen ik ook op andere schijven geen output kreeg). Met blkid zie ik nu wel wat merkwaardigs: er ontbreekt informatie bij de 2 ontbrekende schijven:

Hieruit zou ik dus kunnen afleiden dat er ergens in het proces een nieuwe versie van de partitietabel is weggeschreven naar de schijven c en d, waarmee informatie verdwenen is. Een hexdump van de eerste MB van beide schijven levert het volgende op:

Van schijf b komt er ruim meer data terug, en kan ik de zfs labels herkennen in de data die langskomt.

Met wat verdere analyse blijkt de eerste 4MB van partitie 1 op schijven c en d te zijn gewist. Dat lijkt mij dusdanig niet herstelbaar dat tenzij iemand nog een leuk idee heeft ik het verder maar opgeef.

@Thralas :

zdb -l heb ik inderdaad uitgevoerd op de partitie (met de tweede poging. Dat ik dat fout deed had ik wel door toen ik ook op andere schijven geen output kreeg). Met blkid zie ik nu wel wat merkwaardigs: er ontbreekt informatie bij de 2 ontbrekende schijven:

/dev/sda1: LABEL="storage4" UUID="22765226508496724" UUID_SUB="5490651841523660223" TYPE="zfs_member" PARTLABEL="zfs-1b809645a655a574" PARTUUID="93107bb4-9dea-844b-a0c9-9de04ebf0146" /dev/sdb1: LABEL="storage4" UUID="22765226508496724" UUID_SUB="12429783669929857656" TYPE="zfs_member" PARTLABEL="zfs-c663111f0cf0d1a9" PARTUUID="bfc97921-a7ec-1a45-a601-6cb8acc1a860" /dev/sdc1: PARTLABEL="zfs-85511395189cf179" PARTUUID="86917f54-b209-3047-b987-ad2b40e5220e" /dev/sdd1: PARTLABEL="zfs-86fdaf7015f1d915" PARTUUID="e77f7966-52ff-df43-83a0-de5c91dc90f3"

Hieruit zou ik dus kunnen afleiden dat er ergens in het proces een nieuwe versie van de partitietabel is weggeschreven naar de schijven c en d, waarmee informatie verdwenen is. Een hexdump van de eerste MB van beide schijven levert het volgende op:

root@pve:~# head -c 1048576 /dev/disk/by-id/ata-SAMSUNG_HD204UI_S2H7JD2B411842-part1 | hd 00000000 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| * 00003fd0 00 00 00 00 00 00 00 00 11 7a 0c b1 7a da 10 02 |.........z..z...| 00003fe0 3f 2a 6e 7f 80 8f f4 97 fc ce aa 58 16 9f 90 af |?*n........X....| 00003ff0 8b b4 6d ff 57 ea d1 cb ab 5f 46 0d db 92 c6 6e |..m.W...._F....n| 00004000 ff ff ff ff ff ff ff ff ff ff ff ff ff ff ff ff |................| * 00040000 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| * 00042000 ff ff ff ff ff ff ff ff ff ff ff ff ff ff ff ff |................| * 00080000 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| * 00100000

Van schijf b komt er ruim meer data terug, en kan ik de zfs labels herkennen in de data die langskomt.

Met wat verdere analyse blijkt de eerste 4MB van partitie 1 op schijven c en d te zijn gewist. Dat lijkt mij dusdanig niet herstelbaar dat tenzij iemand nog een leuk idee heeft ik het verder maar opgeef.

Ik heb zojuist mijn NAS / thuisserver, waarop ik Arch Linux heb draaien, geupdate en een reboot gegeven. Gevolg was dat deze niet meer up kwam. Toen ik eindelijk een scherm had gevonden bleek dat het opstarten bleef hangen op de systemd "Mount ZFS filesystem" service. Na een paar keer uit en aan zetten bleek deze wel door te booten (maar nieuwe reboots gaven dezelfde willekeurige resultaten, meestal starte deze niet, soms wel).

Hoe kan ik bepalen wat hier nu de oorzaak van is? Wat ik zelf al heb gekeken:

Hoe kan ik bepalen wat hier nu de oorzaak van is? Wat ik zelf al heb gekeken:

- journalctl maar hier staat niks in van errors waarom die niet zou starten (maar weet niet zeker of de falende boots gelogd worden)

- zpool status geeft aan dat alle drives online zijn en geen (data) errors.

- smartctl -a op alle drives geeft aan dat er geen errors zijn (maar mogelijk dat ik eerst een self test moet starten?)

Is de kernel geupdate en heb je mkinicpio nog een keer gedraaid? Welke ZFS packages gebruik je?RobertMe schreef op zondag 10 november 2019 @ 20:24:

Ik heb zojuist mijn NAS / thuisserver, waarop ik Arch Linux heb draaien, geupdate en een reboot gegeven. Gevolg was dat deze niet meer up kwam. Toen ik eindelijk een scherm had gevonden bleek dat het opstarten bleef hangen op de systemd "Mount ZFS filesystem" service. Na een paar keer uit en aan zetten bleek deze wel door te booten (maar nieuwe reboots gaven dezelfde willekeurige resultaten, meestal starte deze niet, soms wel).

Hoe kan ik bepalen wat hier nu de oorzaak van is? Wat ik zelf al heb gekeken:

- journalctl maar hier staat niks in van errors waarom die niet zou starten (maar weet niet zeker of de falende boots gelogd worden)

- zpool status geeft aan dat alle drives online zijn en geen (data) errors.

- smartctl -a op alle drives geeft aan dat er geen errors zijn (maar mogelijk dat ik eerst een self test moet starten?)

Heb je ook iets van quiet in de boot opties staan? Anders de logging verder opvoeren.

----

Ik heb een vraagje - al een tijd ben ik aan het denken om over te stappen naar een andere indeling voor mijn schijven.

Stel je hebt 2x 3TB en 2x 2TB - welke ZFS raids zou ik dan kunnen gebruiken?

Het liefst wil ik zoals nu een hele grote snelle pool hebben (heb nu dus 4TB + 6TB - maar ben met 6TB totaal tevreden), Ik zie even door de bomen het bos niet meer.

Met twee verschillende groottes lijkt me 2x mirrors het meest logisch.HollowGamer schreef op zondag 10 november 2019 @ 20:43:

[...]

Stel je hebt 2x 3TB en 2x 2TB - welke ZFS raids zou ik dan kunnen gebruiken?

Sinds de 2 dagen regel reageer ik hier niet meer

Kan je mij daar meer over vertellen?CurlyMo schreef op zondag 10 november 2019 @ 20:53:

[...]

Met twee verschillende groottes lijkt me 2x mirrors het meest logisch.

Ik kom er even niet zo uit.

Heb nu de volgende twee gevonden:

- Raidz2

- Raid10 (is dat wat je bedoeld)?

Ik zou graag, indien mogelijk, 6TB willen gebruiken als opslag en de overige voor snelheid/als mirror. Klopt het dat Raid10 dit biedt?

Die volg ik niet helemaal. Zo op 't oog lijkt de output te kloppen, het verschil is te verklaren doordat blkid het zfs label óók niet meer detecteert.dcm360 schreef op zaterdag 9 november 2019 @ 17:02:

Hieruit zou ik dus kunnen afleiden dat er ergens in het proces een nieuwe versie van de partitietabel is weggeschreven naar de schijven c en d, waarmee informatie verdwenen is.

Het vreemde is wèl dat de eerste 8k intact is. En het was zeker geen zpool labelclear: die schrijft gewoon zeroes, geen ff - en daar lijkt het ook niet mee uitgelijnd.wat verdere analyse blijkt de eerste 4MB van partitie 1 op schijven c en d te zijn gewist. Dat lijkt mij dusdanig niet herstelbaar dat tenzij iemand nog een leuk idee heeft ik het verder maar opgeef.

Op de één of andere manier heeft er toch iets anders naar geschreven..

Rest wel de vraag: waarom ook toevallig naar de laatste sectoren van de partitie, waar label 3 en 4 zouden moeten staan? Je zou nog even na kunnen gaan of partitiegroottes en de schijfgrootte e.d. nog kloppen (geen HPA oid. gezet, zou niet de eerste keer zijn). Ook kun je dáár de labels zoeken, maar die zou zdb dan ook moeten hebben gezien..

Vreemd.

Het lijkt me in ieder geval vrijwel uitgesloten dat je dit nog kunt repareren met standaard zfs tools. Voor een handmatige reddingspoging zul je het label handmatig moeten reconstrueren adhv. de andere disks (áls dat al theoretisch kan).

Nee, hij bedoelt gewoon twee mirrors. Één van de 2x 2 TB en één van 2x 3 TB.HollowGamer schreef op zondag 10 november 2019 @ 21:12:

Heb nu de volgende twee gevonden:

- Raidz2

- Raid10 (is dat wat je bedoeld)?

Nee, dat klopt niet. 'RAID10' bestaat niet binnen ZFS.Ik zou graag, indien mogelijk, 6TB willen gebruiken als opslag en de overige voor snelheid/als mirror. Klopt het dat Raid10 dit biedt?

Je kunt wel bovengenoemde mirrorsets maken en ze in één pool stoppen. Dan heb je nog steeds 5 TB effectief. Maar dat levert ongebalanceerde disk I/O op, dus iha. is 2 aparte mirror pools logischer.

De enige manier om 6 TB effectief te krijgen is 4x 2 TB in raidz (en 2x 1 TB 'over'), maar dat is redelijk roekeloos als je het mij vraagt.

[ Voor 31% gewijzigd door Thralas op 10-11-2019 22:38 ]

Ah, de ontbrekende delen zouden dus op de partitie zelf gestaan moeten hebben, dat had ik even niet door. Ik dacht dat de partitietabel zelf gewijzigd was.Thralas schreef op zondag 10 november 2019 @ 21:55:

[...]

Die volg ik niet helemaal. Zo op 't oog lijkt de output te kloppen, het verschil is te verklaren doordat blkid het zfs label óók niet meer detecteert.

De partitietabellen kwamen overeen met die op de nog werkende schijven, en de schijfgroottes weken ook niet af (dat had ik nagezocht naar aanleiding van een Google-resultaat waarbij ik uitkwam bij een post van iemand met dat probleem). Wat er verder gebeurd is met het einde van de schijf heb ik niet meer uitgezocht, de twee defecte schijven zijn nu het systeem uit en ik heb een nieuwe dataset opgebouwd op de twee nog werkende schijven samen met twee nieuwe schijven.Het vreemde is wèl dat de eerste 8k intact is. En het was zeker geen zpool labelclear: die schrijft gewoon zeroes, geen ff - en daar lijkt het ook niet mee uitgelijnd.

Op de één of andere manier heeft er toch iets anders naar geschreven..

Rest wel de vraag: waarom ook toevallig naar de laatste sectoren van de partitie, waar label 3 en 4 zouden moeten staan? Je zou nog even na kunnen gaan of partitiegroottes en de schijfgrootte e.d. nog kloppen (geen HPA oid. gezet, zou niet de eerste keer zijn). Ook kun je dáár de labels zoeken, maar die zou zdb dan ook moeten hebben gezien..

Vreemd.

Het lijkt me in ieder geval vrijwel uitgesloten dat je dit nog kunt repareren met standaard zfs tools. Voor een handmatige reddingspoging zul je het label handmatig moeten reconstrueren adhv. de andere disks (áls dat al theoretisch kan).

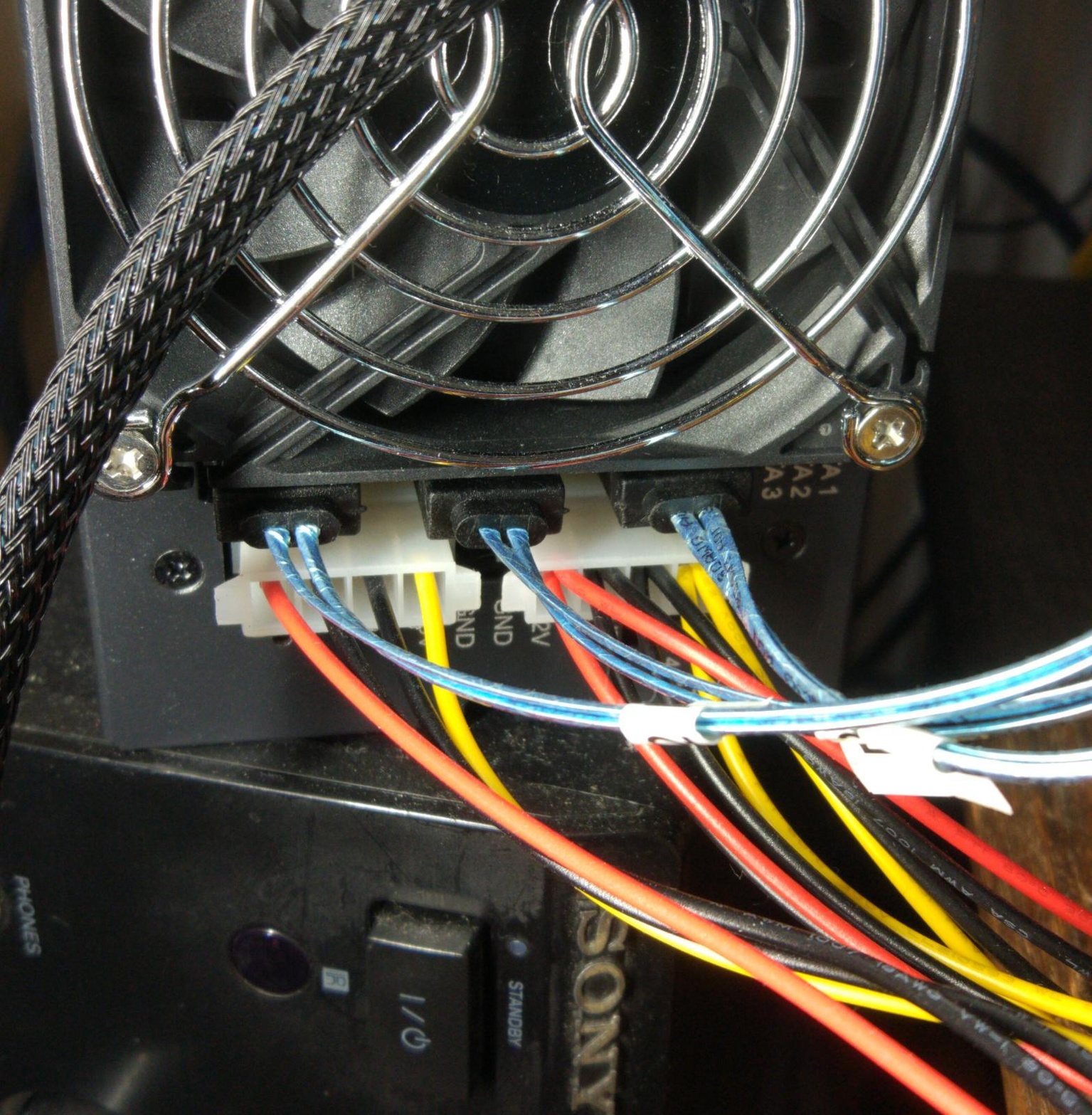

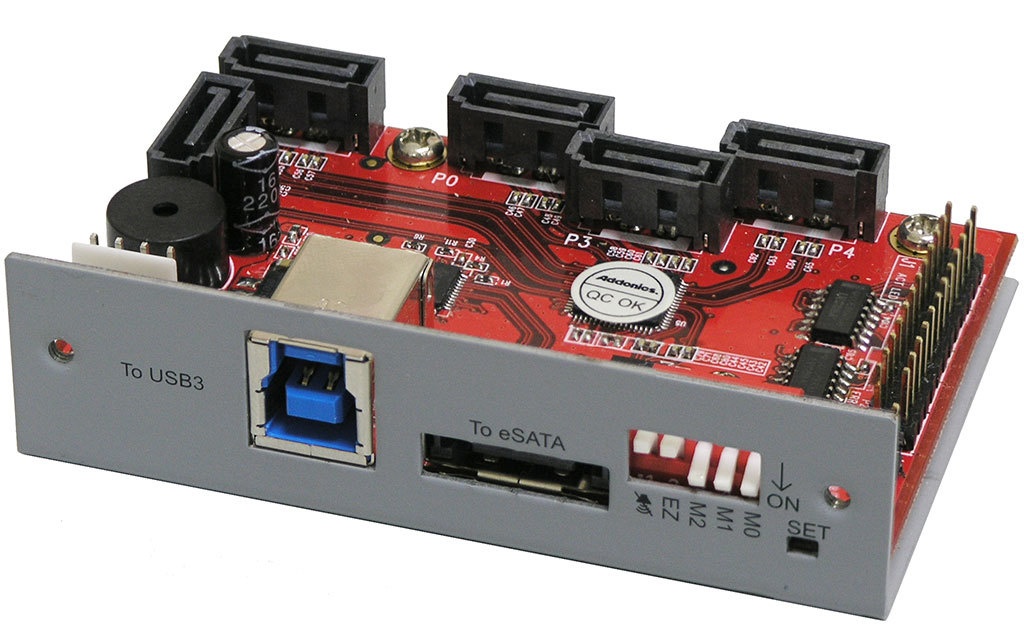

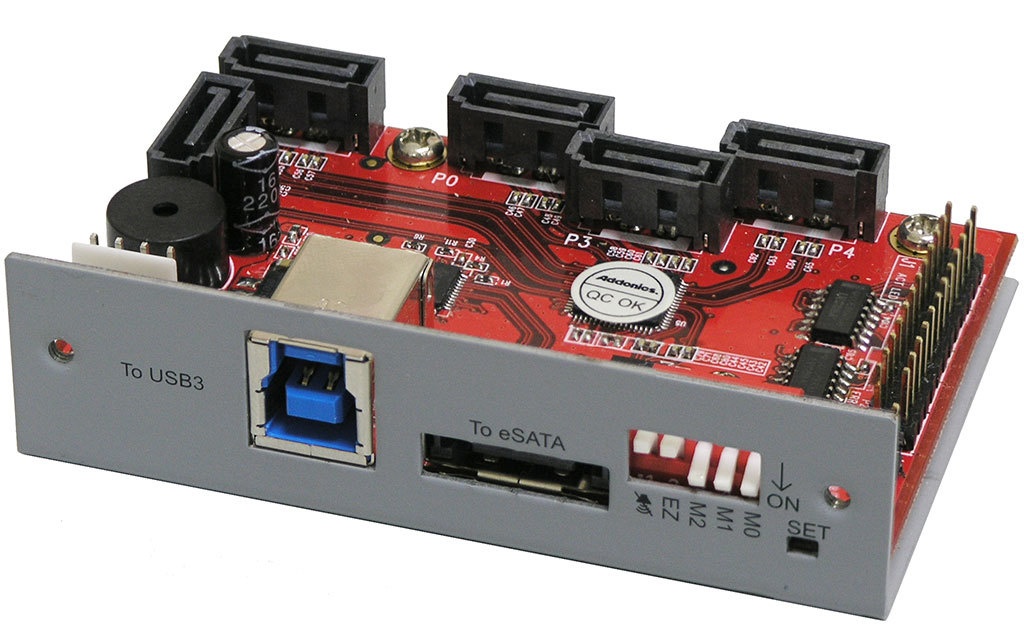

Bestaan er tegenwoordig ook snelle JBOD naar USB 3.2 (gen 2) controllers om bijvoorbeeld 4x SATA op de snelle USB poort van een Intel NUC, System76 Meerkat, of Raspberry Pi aan te sluiten?

Zoiets:

Weet iemand toevallig wat betere controllers of betere google zoektermen?

Zoiets:

- USB 2.0 to 4-SATA Converter JBOD $60

- USB 3.0 Quad Port Multiplier ESU3-QS201-R5-SEV Sold out

- USB3.0 Host To 5x SATA RAID/JBOD Controller $110

- Addonics HPM-XU 5-port SATA Controller Sold out

- DATOptic Inc eSATA and USB3.0 host to 5x SATA RAID/JBoD Controller Sold out

- USB3.0 Host To 4x SATA RAID/JBoD Controller $75

Weet iemand toevallig wat betere controllers of betere google zoektermen?

[ Voor 4% gewijzigd door Sando op 13-11-2019 15:47 ]

🇪🇺 Buy from EU (GoT)

Moet het powered zijn? Unpowered kun je net zo goed 4 x dit op een USB hub gooien:Sando schreef op woensdag 13 november 2019 @ 15:43:

Bestaan er tegenwoordig ook snelle JBOD naar USB 3.2 (gen 2) controllers om bijvoorbeeld 4x SATA op de snelle USB poort van een Intel NUC, System76 Meerkat, of Raspberry Pi aan te sluiten?

....

Bovenstaande items lijken alleen wat oud (USB 3.0) en er zit zo'n klein chipje zonder heatsink op, vraag me af of dat in verhouding staat tot de hoge prijs.

Weet iemand toevallig wat betere controllers of betere google zoektermen?

https://www.bol.com/nl/p/...Q0PCNSl3pLhxoCLfwQAvD_BwE

of met power:

2 x deze:

https://www.bol.com/nl/p/...F3eH8fYPZ3MRoCqHwQAvD_BwE

[ Voor 3% gewijzigd door Q op 14-11-2019 00:26 ]

@Q Ik zoek specifiek een oplossing om één of (bij voorkeur) meerdere SATA-kabels aan te sluiten via USB, waarbij ik de fysieke schijven niet onhandig direct aan hoef te sluiten omdat deze al in verschillende nette enclosures zitten:

Met een bakje als dit kan ik een nette oplossing bouwen:

Alleen bovengenoemde specifieke bakjes zijn wel erg dun (qua controller) en oud (qua snelheid). Het zou helemaal mooi zijn als zoiets bestaat met USB-C.

Met een bakje als dit kan ik een nette oplossing bouwen:

Alleen bovengenoemde specifieke bakjes zijn wel erg dun (qua controller) en oud (qua snelheid). Het zou helemaal mooi zijn als zoiets bestaat met USB-C.

🇪🇺 Buy from EU (GoT)

@Sando : Is het dan geen idee om naar zoiets toe te switchen zoals @Q destijds heeft gebouwd :

https://blog.quindorian.o...er-storage-hardware.html/

https://blog.quindorian.o...er-storage-hardware.html/

[ Voor 6% gewijzigd door nero355 op 15-11-2019 18:05 ]

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Ik heb je verkeerd begrepen, maar ik snap beter wat je behoefte is. Misschien is het handig als je je eind doel deelt, dan kunnen we beter met je mee denken.Sando schreef op vrijdag 15 november 2019 @ 16:43:

@Q Ik zoek specifiek een oplossing om één of (bij voorkeur) meerdere SATA-kabels aan te sluiten via USB, waarbij ik de fysieke schijven niet onhandig direct aan hoef te sluiten omdat deze al in verschillende nette enclosures zitten:

[Afbeelding: 3x SATA enclosure]

Met een bakje als dit kan ik een nette oplossing bouwen:

[Afbeelding: JBoD Controller]

Alleen bovengenoemde specifieke bakjes zijn wel erg dun (qua controller) en oud (qua snelheid). Het zou helemaal mooi zijn als zoiets bestaat met USB-C.

Wat je nu doet is naar mijn idee een beetje een frankenstein oplossing maar ik heb ook niet het hele plaatje. Dit zou toch veel mooier zijn?

https://azerty.nl/product...ikavvyGi_yIYaAh7UEALw_wcB

Of deze?

https://www.alternate.nl/...5DXMfJq3rwbgaAgxuEALw_wcB

Natuurlijk allemaal wel prijzigere oplossingen.

Die controller die jezelf aandroeg is gegeven wat je wilt wel gewoon prima. Ik weet niet zo goed wat de SATA snelheid is van jouw controller. Maar zelfs al zou het sata 300 zijn, prima voor harde schijven.

[ Voor 18% gewijzigd door Q op 15-11-2019 21:10 ]

Dit is wel heel vet, maar ook echt een orde van grootte groter.nero355 schreef op vrijdag 15 november 2019 @ 18:04:

@Sando : Is het dan geen idee om naar zoiets toe te switchen zoals @Q destijds heeft gebouwd :

https://blog.quindorian.o...er-storage-hardware.html/

Dat is allemaal erg professioneel. Mijn use-case is wat meer small business prosumer at best.

Dat zijn inderdaad mooie doch prijzige oplossingen. Mijn einddoel laat eigenlijk vrij weinig speling over anders dan dat ik vroeg.Q schreef op vrijdag 15 november 2019 @ 18:09:

[...]

Misschien is het handig als je je eind doel deelt, dan kunnen we beter met je mee denken.

Wat je nu doet is naar mijn idee een beetje een frankenstein oplossing maar ik heb ook niet het hele plaatje. Dit zou toch veel mooier zijn? [link] Of deze? [link]

Ik heb 3x een mooie nette enclosure met 3 schijven/ZFS erin. Ze functioneren prima, en ze waren zeker ook zo prijzig, waardoor ik ze niet wil vervangen. Het grootste verschil is dat mijn enclosures niet één eSata/USB aansluiting hebben, maar een SATA aansluiting per schijf. Drie per enclosure dus. Toentertijd heb ik deze bewust gekocht zonder controller, met losse SATA-aansluitingen, zodat ik deze aan 3 grote lompe desktops met voldoende SATA-poorten kon aansluiten.

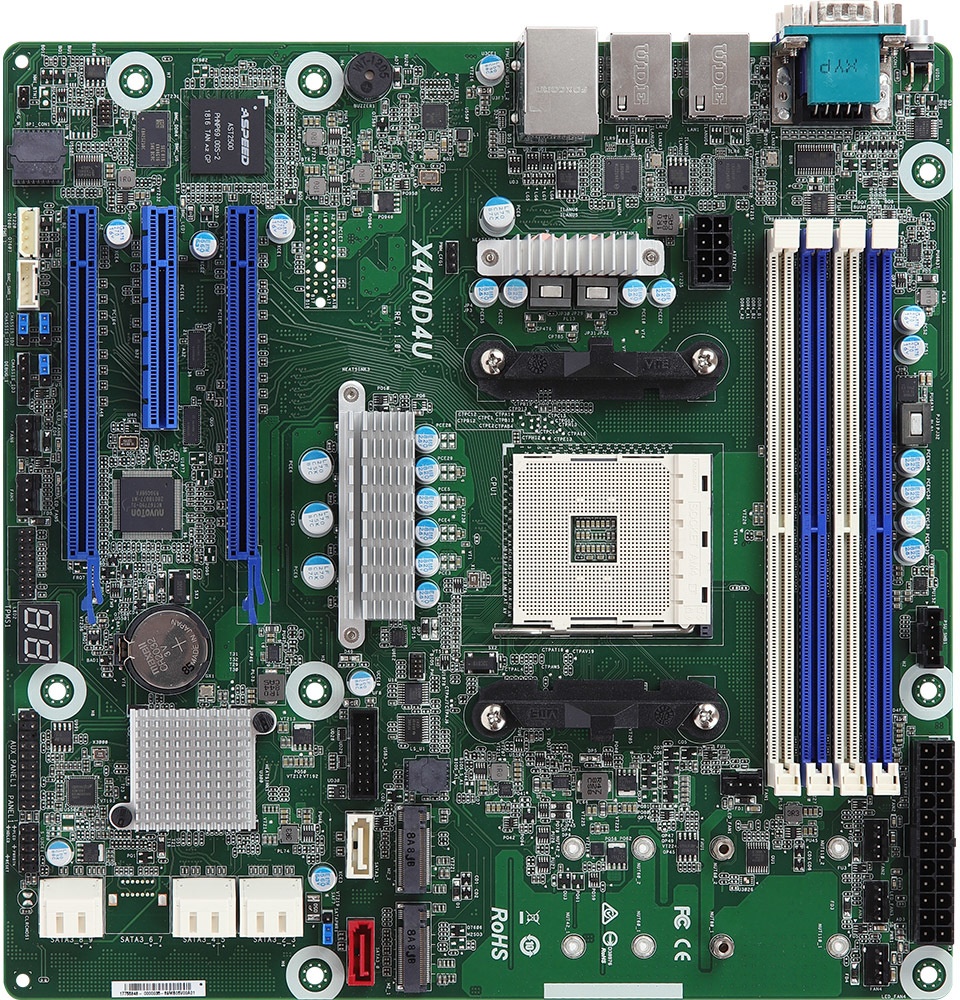

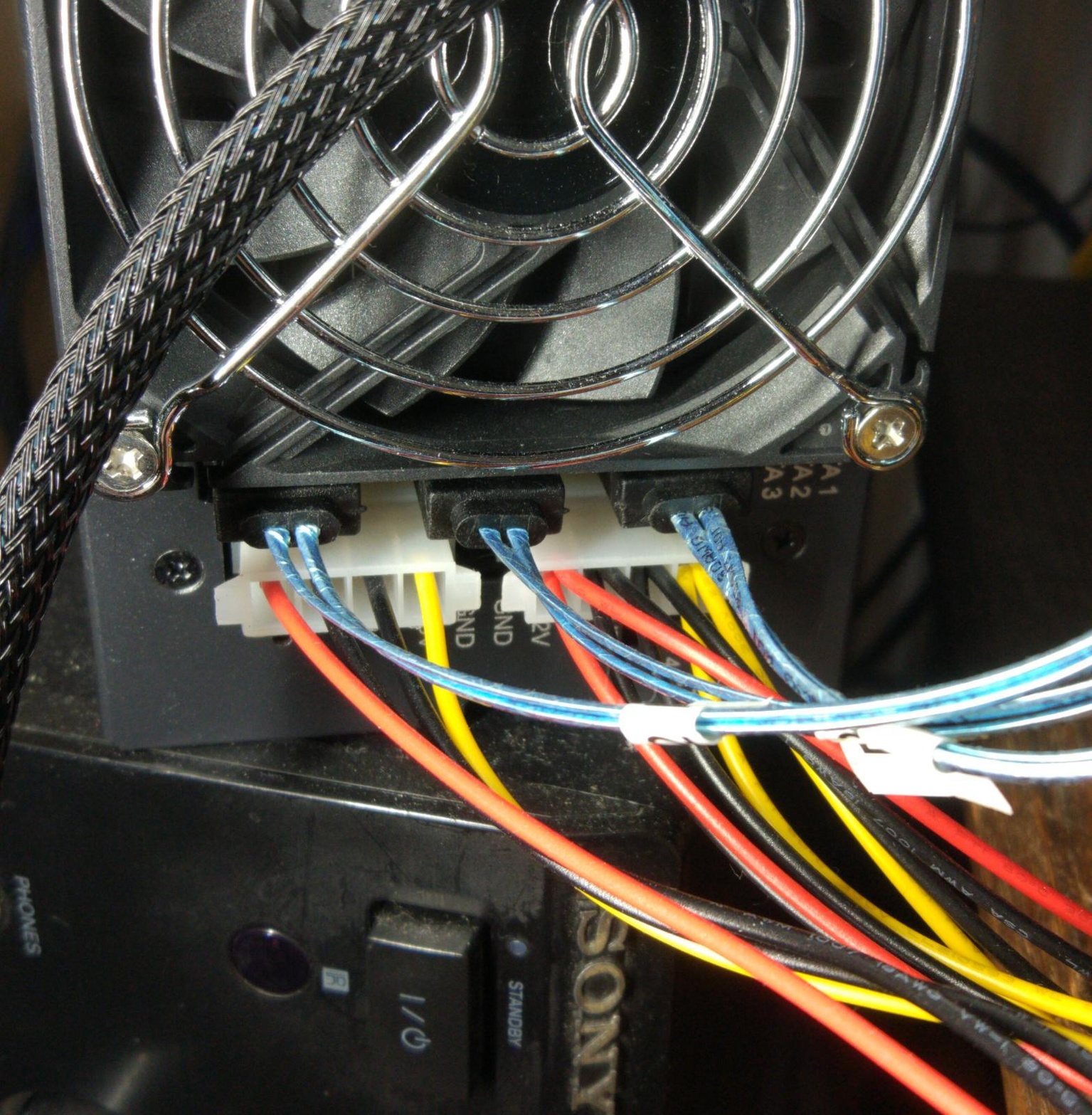

Inmiddels zijn alle grote desktops afgeschreven en (bijna) vervangen door drie mini-computers. De grootste is een Mini-STX, waar ik nog net een kaartje als dit in heb kunnen proppen:

Hiervoor heb ik wel een lelijk gat in de zijkant moeten boren om 3 SATA-kabels door te steken.

De andere twee computers worden waarschijnlijk een System76 Meerkat en een Intel Nuc. Beide met onvoldoende SATA-poorten of uitbreidingsmogelijkheden om klaar te zijn. Ze hebben wel mooie USB 3.2 en USB-C poorten.

Wat ik dus wil is de resterende twee 3-disk ZFS enclosures op een zo nette en goedkoop mogelijke doch betrouwbare manier aansluiten op deze minicomputers.

Hier ben ik dus een beetje huiverig voor. De genoemde controller is lastig te vinden en een beetje exotisch. Geen bekend degelijk merk. Bovendien heb ik een slechte ervaring met een soortgelijke controller waar ook zo'n klein chipje zonder heatsink op zat (was geloof ik een jmicron) waarvan de throughput niet hoger dan 40 MByte/s kwam. Mijn ZFS heeft op peak performance 240 MByte/s.Q schreef op vrijdag 15 november 2019 @ 18:09:

Die controller die jezelf aandroeg is gegeven wat je wilt wel gewoon prima.

PS. Ik weet dat iedereen en zijn moeder ontraad om een 3-disk ZFS (RAID-Z1) array te bouwen. Toen ik ze bouwde heb ik helaas verkeerde informatie gelezen waarin het juist geprezen werd, en nu is het zoals het is. Ik ben nog wel zo verstandig geweest om disks van verschillende merken in een enclosure te stoppen.

Nieuwschierig: Deze JBoD enclosures hebben 1x eSata. Ondersteunt SATA dan ook raw disk passthrough waardoor je over 1x (e)Sata 4 JBoD disks kan aansluiten die je OS dan ook ziet als 4 disks? (Ik dacht dat dit alleen met USB kon, waar dit in Linux out of the box wordt ondersteund.)Dit zou toch veel mooier zijn? [link] Of deze? [link]

🇪🇺 Buy from EU (GoT)

Korte opmerking: ZFS 3-disk RAIDZ: Niets mis mee.

Ik heb je verhaal gelezen en dit is mijn mening: ik begrijp niet helemaal waarom je telkens een externe enclosure met 3 disks 1-op-1 wilt aansluiten op een bepaalde computer, nuc of rpi, maakt niet uit.

Ik denk dat je dit niet wilt horen maar volgens mij ben jij beter af met een centrale NAS met SMB/NFS waar dan al die schijven in passen. Misschien dat een NAS voor jou niet werkt, maar dan ben ik wel benieuwd waarom dat zo is en wat je precies wilt bewerkstelligen. Dat is mij eigenlijk nog steeds niet duidelijk.

Natuurlijk heb jij al geld besteed aan deze enclosures, maar als je zelf al geen fatsoenlijke sata-controller kunt vinden waar je vertrouwen in hebt, waar gaat dit dan naar toe? Don't throw good money after bad.

Die sata controller die je op het oog had was ook al weer 75 dollar ofzo, waarvan je er meer nodig hebt.

Gezien wat je nu doet had je beter van die DAS enclosures kunnen kopen (lijken op NAS maar met een USB3 interface) waarbij alle x schijven individueel te benaderen zijn maar de USB3 kabel delen (wat een bottleneck is maar 200/300 MB/s is prima zat voor de meeste toepassingen.

https://www.banggood.com/...ID=47757&cur_warehouse=CN

Eentje van deze kost iets minder als twee van die SATA controllers die je wilde kopen. Koop er twee en je hebt al je problemen opgelost.

Edit: Als je met onderstaande kunt leven dan kun je 3 x disks in een open enclosure via USB3 aansluiten voor minder als die ene SATA controller die je hebt gevonden. Niet ideaal, maar wel prijs bewust.

https://www.banggood.com/...s=search&cur_warehouse=CN

Ik vrees dat je de verkeerde investering hebt gedaan of dat de investering van destijds nu is ingehaald door je veranderende desktop/systeem behoefte.

[ Voor 24% gewijzigd door Q op 24-11-2019 11:25 ]

In navolging hiervan, waar ik verder niet meer naar heb gekekenRobertMe schreef op zondag 10 november 2019 @ 20:24:

Ik heb zojuist mijn NAS / thuisserver, waarop ik Arch Linux heb draaien, geupdate en een reboot gegeven. Gevolg was dat deze niet meer up kwam. Toen ik eindelijk een scherm had gevonden bleek dat het opstarten bleef hangen op de systemd "Mount ZFS filesystem" service. Na een paar keer uit en aan zetten bleek deze wel door te booten (maar nieuwe reboots gaven dezelfde willekeurige resultaten, meestal starte deze niet, soms wel).

Hoe kan ik bepalen wat hier nu de oorzaak van is? Wat ik zelf al heb gekeken:

- journalctl maar hier staat niks in van errors waarom die niet zou starten (maar weet niet zeker of de falende boots gelogd worden)

- zpool status geeft aan dat alle drives online zijn en geen (data) errors.

- smartctl -a op alle drives geeft aan dat er geen errors zijn (maar mogelijk dat ik eerst een self test moet starten?)

En deze zpool status output voor die pool:The number of checksum errors associated with a ZFS device

exceeded acceptable levels. ZFS has marked the device as

degraded.

impact: Fault tolerance of the pool may be compromised.

eid: 12272

class: statechange

state: DEGRADED

host: <knip>

time: 2019-12-01 09:42:13+0100

vpath: /dev/disk/by-id/ata-WDC_WD20EZRZ-00Z5HB0_WD-WCC4M1ZZ9803-part1

vguid: 0x01B46380C3345321

pool: 0xD808F331FE5B199A

pool: backup

state: DEGRADED

status: One or more devices has experienced an unrecoverable error. An

attempt was made to correct the error. Applications are unaffected.

action: Determine if the device needs to be replaced, and clear the errors

using 'zpool clear' or replace the device with 'zpool replace'.

see: http://zfsonlinux.org/msg/ZFS-8000-9P

scan: scrub repaired 2M in 0 days 00:56:34 with 0 errors on Sun Dec 1 10:33:51 2019

config:

NAME STATE READ WRITE CKSUM

backup DEGRADED 0 0 0

mirror-0 DEGRADED 0 0 0

ata-WDC_WD20EZRZ-00Z5HB0_WD-WCC4M1ZZ9803 DEGRADED 7 0 11 too many errors

ata-WDC_WD40EZRX-00SPEB0_WD-WCC4E0VYJ8F8 ONLINE 0 0 0

errors: No known data errors

Lijkt dan erop dat een van de twee HDDs aan het overlijden is (of een rotte kabel heeft)? Hiervoor zal ik dan ook nog even een post doen in het Check je SMART topic. RobertMe in "Check je SMART"

Met een zpool clear kan ik de error dan wel weghalen en evt. een nieuwe scrub draaien om te bevestigen dat er iets aan de hand is, maar dat is dan misschien ook niet de handigste optie? Omdat die tijd tot nieuwe degrated de schijf dus gewoon op online zal staan? alhoewel ik niet weet of er qua bv schrijven nog verschil zit tussen degrated en online. Ik vermoed dat de data wel nog steeds naar beide wordt geschreven?

En in hoeverre kan zo'n read/checksum error nog veroorzaakt worden door andere factoren? Volgens mij kan (defect) geheugen ook deze symptomen veroorzaken? Alhoewel ik het dan eerder over beide schijven verwacht en niet maar voor een van beide.

Kijk even in /var/log/syslog om te bepalen of er kernel meldingen zijn voor je disk. Het kan een brakke sata kabel zijn of je disk heeft bad sectors. Je smart test geeft al aan dat de disk inderdaad read errors heeft - bad sectors - dood.

[ Voor 22% gewijzigd door Q op 01-12-2019 11:27 ]

Die file heb ik niet, maar dmesg zie ik nu wel het volgende in:Q schreef op zondag 1 december 2019 @ 11:25:

Kijk even in /var/log/syslog om te bepalen of er kernel meldingen zijn voor je disk.

[1777313.080509] ata6.00: exception Emask 0x0 SAct 0x8000004 SErr 0x0 action 0x0

[1777313.080532] ata6.00: irq_stat 0x40000008

[1777313.080545] ata6.00: failed command: READ FPDMA QUEUED

[1777313.080559] ata6.00: cmd 60/00:d8:80:1c:22/08:00:02:00:00/40 tag 27 ncq dma 1048576 in

res 41/40:00:d0:1f:22/00:00:02:00:00/40 Emask 0x409 (media error) <F>

[1777313.080598] ata6.00: status: { DRDY ERR }

[1777313.080610] ata6.00: error: { UNC }

[1777313.081804] ata6.00: configured for UDMA/133

[1777313.081817] sd 5:0:0:0: [sdd] tag#27 FAILED Result: hostbyte=DID_OK driverbyte=DRIVER_SENSE

[1777313.081819] sd 5:0:0:0: [sdd] tag#27 Sense Key : Medium Error [current]

[1777313.081820] sd 5:0:0:0: [sdd] tag#27 Add. Sense: Unrecovered read error - auto reallocate failed

[1777313.081821] sd 5:0:0:0: [sdd] tag#27 CDB: Read(10) 28 00 02 22 1c 80 00 08 00 00

[1777313.081823] print_req_error: I/O error, dev sdd, sector 35790800

[1777313.081846] zio pool=backup vdev=/dev/disk/by-id/ata-WDC_WD20EZRZ-00Z5HB0_WD-WCC4M1ZZ9803-part1 error=5 type=1 offset=18323406848 size=1048576 flags=40080cb0

[1777313.081853] ata6: EH complete

[1777321.100653] ata6.00: exception Emask 0x0 SAct 0x600003d1 SErr 0x0 action 0x0

[1777321.100739] ata6.00: irq_stat 0x40000008

[1777321.100785] ata6.00: failed command: READ FPDMA QUEUED

[1777321.100854] ata6.00: cmd 60/00:20:80:2c:22/08:00:02:00:00/40 tag 4 ncq dma 1048576 in

res 41/40:00:30:2f:22/00:00:02:00:00/40 Emask 0x409 (media error) <F>

[1777321.101016] ata6.00: status: { DRDY ERR }

[1777321.101066] ata6.00: error: { UNC }

[1777321.102602] ata6.00: configured for UDMA/133

[1777321.102650] sd 5:0:0:0: [sdd] tag#4 FAILED Result: hostbyte=DID_OK driverbyte=DRIVER_SENSE

[1777321.102656] sd 5:0:0:0: [sdd] tag#4 Sense Key : Medium Error [current]

[1777321.102661] sd 5:0:0:0: [sdd] tag#4 Add. Sense: Unrecovered read error - auto reallocate failed

[1777321.102666] sd 5:0:0:0: [sdd] tag#4 CDB: Read(10) 28 00 02 22 2c 80 00 08 00 00

[1777321.102670] print_req_error: I/O error, dev sdd, sector 35794736

[1777321.102757] zio pool=backup vdev=/dev/disk/by-id/ata-WDC_WD20EZRZ-00Z5HB0_WD-WCC4M1ZZ9803-part1 error=5 type=1 offset=18325504000 size=1048576 flags=40080cb0

[1777321.102783] ata6: EH complete

(tijden vallen dan moeilijk te plaatsen, maar zelfde staat in journalctl alleen dan met leesbare tijd en die was paar minuten voor de mail)

Ik neem aan dat uit het stukje "sdd] tag#27 Add. Sense: Unrecovered read error - auto reallocate failed" inderdaad maar een conclusie valt te trekken. HDD rapporteert zelf dat er echt iets aan de hand is. En dus geen foute kabel of zo.Het kan een brakke sata kabel zijn of je disk heeft bad sectors. Je smart test geeft al aan dat de disk inderdaad read errors heeft - bad sectors - dood.

R.I.P. Gecondoleerd.