Je hebt gelijk, dit ding is als je het per poort gaat berekenen nog goedkoper dan ik me realiseerde. 400/32= 12,50 per poort. Intel/SM oplossingen zitten allemaal op minsten 15 euro per poort. Expander zit wat lager (9,50 per poort) maar geeft je effectief maar 24 poortjes. Wow wow wow! Helemaal geweldig.Verwijderd schreef op vrijdag 24 juni 2011 @ 21:59:

[...]

32 x 3 TB disks eraan zit je op 96 TB ..

eventueel een norco 4224 & 2208 boven elkaar monteren met een gat erin voor de kabels ..

en waarom een expander.. zet gewoon 2 van die kaarten erin 64 x 3 TB gheghe

@ borroz: Enig idee of deze sasuc8i passsthrough ondersteund op esxi 4.1u1?Verwijderd schreef op maandag 18 april 2011 @ 12:51:

* nieuwe build - open indiana & napp-it onder esxi met 2 controllers

[afbeelding]

Ben momenteel in het bezit van een lsi8888elp en deze draait op de 1078 van lsi. En da's een no-go voor Passthrough. (wil energie besparen en m'n storage overzetten in ESX)

VMware schijnt (kontakt met lsi gehad) geen updates meer van deze processor op te nemen in z'n OS.

Verwijderd

hier werkt die sasuc8i met de LSI SAS1068E in passthrough met Open Indiana VM onder ESXi 4.1 .. (dat 'u1 zegt me ff niks ).. wat betreft jou controller met een '1078.. geen idee.Lekkerbek schreef op zaterdag 25 juni 2011 @ 11:12:

[...]

@ borroz: Enig idee of deze sasuc8i passsthrough ondersteund op esxi 4.1u1?

Ben momenteel in het bezit van een lsi8888elp en deze draait op de 1078 van lsi. En da's een no-go voor Passthrough. (wil energie besparen en m'n storage overzetten in ESX)

VMware schijnt (kontakt met lsi gehad) geen updates meer van deze processor op te nemen in z'n OS.

[ Voor 6% gewijzigd door Verwijderd op 25-06-2011 12:19 ]

ESXi 4.1 Update 1

Hoe meer ik weet,

hoe meer ik weet,

dat ik niets weet.

Aangezien ik nog steeds problemen had met mijn tergend traag gigabit netwerk heb ik daarnet nog even de netwerksnelheid tussen 2 clients door op een Windows client een shared folder op te zetten. Daar haalde hij makkelijk 30 Mb/s write en 50 Mb/s read.

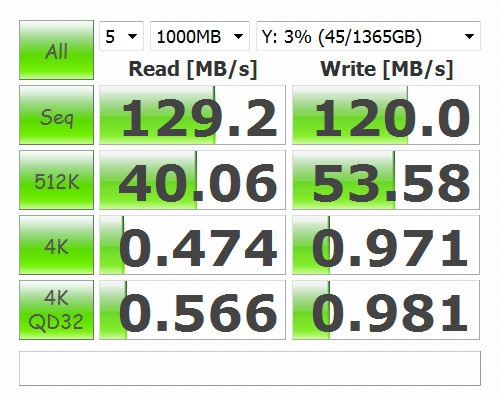

Dan maar voor de derde keer een andere kabel aan mijn NAS gekoppeld en al snel kreeg ik het volgende:

Het vreemde is wel dat er nu een CAT5 kabel aanhangt en toch bovenstaande snelheden haalt. Dit terwijl hij met de oorspronkelijke CAT5E kabel slechts 13 Mb/s haalde .

.

De eerste kabel hangt er dus nu aan, de tweede zorgde dus voor problemen.. misschien omdat het een exemplaar was die bij een router bijgeleverd zat.

Toch ben ik meer dan tevreden, mijn NAS is bij deze af en haalt de gewenste snelheden. Misschien weinig interessant voor de meer ervaren NAS'ers hier aangezien het een nogal bescheiden NAS is in tegenstelling tot sommige servers hier.. maar misschien toch een paar foto's:

Specs:

Dan maar voor de derde keer een andere kabel aan mijn NAS gekoppeld en al snel kreeg ik het volgende:

Het vreemde is wel dat er nu een CAT5 kabel aanhangt en toch bovenstaande snelheden haalt. Dit terwijl hij met de oorspronkelijke CAT5E kabel slechts 13 Mb/s haalde

De eerste kabel hangt er dus nu aan, de tweede zorgde dus voor problemen.. misschien omdat het een exemplaar was die bij een router bijgeleverd zat.

Toch ben ik meer dan tevreden, mijn NAS is bij deze af en haalt de gewenste snelheden. Misschien weinig interessant voor de meer ervaren NAS'ers hier aangezien het een nogal bescheiden NAS is in tegenstelling tot sommige servers hier.. maar misschien toch een paar foto's:

Specs:

[ Voor 35% gewijzigd door SanderH_ op 25-06-2011 13:05 ]

Die gele kabel lijkt op een el-cheapo OEM kabel... 4 adres ofzo? Je koop gewoon een goede CAT5E of CAT6 kabel, FTP/STP, dan zit je goed. Gaat die blauwe fan niet irriteren?

@hierverderboven:

Waarom ESX of ESXi gebruiken? Er zijn zo veel andere oplossingen, wat dacht je van XEN of KVM?

@hierverderboven:

Waarom ESX of ESXi gebruiken? Er zijn zo veel andere oplossingen, wat dacht je van XEN of KVM?

[ Voor 26% gewijzigd door johnkeates op 25-06-2011 12:48 ]

Momenteel haalt hij nu toch al mooie snelheden met een CAT5 kabel eraan, later kijk ik dan wel een keertje voor een CAT5E model. De gele kabel zal dus inderdaad van zeer slechte kwaliteit geweest zijn.

Mijn NAS staat eigenlijk op een zolderkamer/bureau, samen met een netwerkprinter, router, switch..etc, dus veel last heb ik er niet echt van. Ik vind hem er trouwens nog niet zo slecht uitzien.

Mijn NAS staat eigenlijk op een zolderkamer/bureau, samen met een netwerkprinter, router, switch..etc, dus veel last heb ik er niet echt van. Ik vind hem er trouwens nog niet zo slecht uitzien.

Had je bij ifconfig niet heel veel errors bij die ene kabel? Is wel handig om het een beetje te kunnen meten of het kabel is.

Niet direct nee.. dit was de output:

SanderH_ schreef op vrijdag 24 juni 2011 @ 18:37:

# ifconfig eth0 Link encap:Ethernet HWaddr 48:5b:39:6b:af:6b inet addr:192.168.1.10 Bcast:192.168.1.255 Mask:255.255.255.0 inet6 addr: fe80::4a5b:39ff:fe6b:af6b/64 Scope:Link UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1 RX packets:3257938 errors:0 dropped:0 overruns:0 frame:0 TX packets:1927812 errors:0 dropped:0 overruns:0 carrier:13 collisions:0 txqueuelen:1000 RX bytes:352845367 (336.4 MiB) TX bytes:503771853 (480.4 MiB) Interrupt:27

# mii-tool eth0: negotiated 100baseTx-FD flow-control, link ok

[ Voor 154% gewijzigd door SanderH_ op 25-06-2011 13:07 ]

Verwijderd

aha.. ik loop achter.Nextron schreef op zaterdag 25 juni 2011 @ 12:34:

ESXi 4.1 Update 1

> How to update the ESXi 4.1 free version to ESXi 4.1 Update 1

ESXi in maintainance mode en verder zoals link hierboven .. zie vCli output:

'obsoleted

* ahum.. was dat geen update om van 4.0 naar 4.1 te gaan ? ja dan is dat niet nodig omdat ik al 4.1.0 draai

[ Voor 38% gewijzigd door Verwijderd op 26-06-2011 09:35 ]

Gheh, was het vervelend doen toch lonendSanderH_ schreef op zaterdag 25 juni 2011 @ 13:06:

Niet direct nee.. dit was de output:

Ik heb bij carrier nog nooit nummer hoger dan 0 gezien, maar een hoger nummer geeft aan dat er fouten zijn op de kabel.

Doorgaans zit het niet in de kabel zelf maar de stekkers die er aan bevestigd zijn.

Ik zie die carrier waarde anders nu ook wel op 19 staan hoor  . Ach, zolang alles maar werkt. Maandag ga ik toch achter een andere kabel.

. Ach, zolang alles maar werkt. Maandag ga ik toch achter een andere kabel.

[ Voor 37% gewijzigd door SanderH_ op 25-06-2011 14:02 ]

Dat je er geen last van hebt wil niet zeggen dat het goed isSanderH_ schreef op zaterdag 25 juni 2011 @ 13:57:

Ik zie die carrier waarde anders nu ook wel op 19 staan hoor. Ach, zolang alles maar werkt. Maandag ga ik toch achter een andere kabel.

Ik heb even rondgeneusd op linux-questions kwam ik dit tegen:

Met andere woorden, als deze box al maanden up is, en het nummer onder zeg iets van 100 is er weinig aan de hand, loopt het met tientallen per uur op is er wel iets aan de hand.This is an old question but seems to be recurring.

TX errors = CRC, checksum mismatch

Frame = Packet fails to end on a 32bit/4 byte boundary

Not sure if this includes small packets ( <64bytes )

or large packets.

Collisions = This interface is running half duplex.

It is detecting TX and RX packets at the same time.

This is bad in a HDuplex environment (Hubs)

Switched environments operate full duplex.

Collision detection is disabled in FD mode.

A mismatch in duplex is very bad for throughput.

(Switch = FD but Host = HD)

The HDuplex device will terminate transmission if collisions

are detected.

Some devices used to report late collisions which were very

bad in hub environments.

Carrier = Loss of link pulse. Sometimes recreated by removing and

installing the Ethernet cable.

If this counter is high, the link is flapping. (up/down)

Either this Ethernet chip is having issues or the device at the

other end of the cable is having issues

Overruns = The NIC has a Buffer of X bytes and this filled and was

exceeded before the buffer could be emptied.

The Excess is the overrun.

These days, Full Duplex switch links are the norm. Only TX and RX packets should be incrementing. Carrier is typically a low number less than 10. This will be higher on linux boxes that go an entire year between reboots. The important thing to look at is the rate at which the errors are incrementing.

Sommige mensen mogen liegen

T568-B is gedefinieerd als een 4 paar kabel.... en niet als een 2 paar....

Overigens merk op dat de 8p8c stekker ook wat vaag is, wel 8 koperen contacten maar inwendig geen ruimte om 8 draden aan te sluiten oftewel eigenelijk ook geen 8p8c maar een 8p4c.... dan hadden ze ook die paar centen op die kopervlakjes kunnen besparen .... als dat al koper is.

de category bespreekt de elektrische eigenschappen van de kabel.

De herkomst van de kabel bespreek ik niet.

Goed of niet goed, is hier niet aan de orde ..... de tekst op de kabel is een leugen. De prijs van de kabel maakt niet uit zolang de spec's maar worden gehaald zodat de teksten op de kabel mogen staan.

T568-B is gedefinieerd als een 4 paar kabel.... en niet als een 2 paar....

Overigens merk op dat de 8p8c stekker ook wat vaag is, wel 8 koperen contacten maar inwendig geen ruimte om 8 draden aan te sluiten oftewel eigenelijk ook geen 8p8c maar een 8p4c.... dan hadden ze ook die paar centen op die kopervlakjes kunnen besparen .... als dat al koper is.

de category bespreekt de elektrische eigenschappen van de kabel.

De herkomst van de kabel bespreek ik niet.

Goed of niet goed, is hier niet aan de orde ..... de tekst op de kabel is een leugen. De prijs van de kabel maakt niet uit zolang de spec's maar worden gehaald zodat de teksten op de kabel mogen staan.

[ Voor 13% gewijzigd door Mafketel op 25-06-2011 14:58 ]

lol , das id wel heel freaky

ik zou zeggen maak de kabels gewoon zelf dan weet je dat je goed zit

heb er al velen gemaakt en is best goed te doen

bovendien kan je dan zelf wel de lengte bepalen wat je nodig hebt,

heb kabels van 60 - 70 meter gemaakt en verlies tenopzichte van kortere kabels kon ik niet meten

in ieder geval niet merkbaar.

ik zou zeggen maak de kabels gewoon zelf dan weet je dat je goed zit

heb er al velen gemaakt en is best goed te doen

bovendien kan je dan zelf wel de lengte bepalen wat je nodig hebt,

heb kabels van 60 - 70 meter gemaakt en verlies tenopzichte van kortere kabels kon ik niet meten

in ieder geval niet merkbaar.

Verwijderd

hetzelfde probleem doet zich soms ook voor met interne sata kabels.. daar zit ook ontzettend veel bagger tussen heb ik gemerkt.

dat vermoeden heb ik ook maar is zo moeilijk echt te zeggen of problemen soms van een kabel komen

ik zie wel soms op sites verschillende kabels voor sata1 en 2 en sata3 , vaak zelfde prijs maar soms ook prijsverschil , hoe je nu echt kan zien welke voor wat is ...

ik zie wel soms op sites verschillende kabels voor sata1 en 2 en sata3 , vaak zelfde prijs maar soms ook prijsverschil , hoe je nu echt kan zien welke voor wat is ...

simpel door de spec's te lezen .....parcifal schreef op zaterdag 25 juni 2011 @ 18:02:

dat vermoeden heb ik ook maar is zo moeilijk echt te zeggen of problemen soms van een kabel komen

ik zie wel soms op sites verschillende kabels voor sata1 en 2 en sata3 , vaak zelfde prijs maar soms ook prijsverschil , hoe je nu echt kan zien welke voor wat is ...

Meest toegankelijke zijn op wiki te vinden en SATA 6 Gb/s heeft geen nieuwe kabel/connector specificaties (niet helemaal er is een lif versie bijgekomen)

usb3 is wel een ander connector en kabel tov van eerdere...

Nette setup je shared via samba?SanderH_ schreef op zaterdag 25 juni 2011 > setup

Jep, zowel voor mijn windows client(s) als mijn mac client. Loopt soepel.

Waarom ben je eigenlijk naar supermicro overgestapt (ESXi misschien?).Verwijderd schreef op zondag 26 juni 2011 @ 10:39:

tip : en mocht je op het punt staan een snelle NAS/server te gaan bouwen

Mooi setje hoor. Het is dat ik zelf ga reizen en daarmee geen behoefte heb aan nieuwe hardware.

Verwijderd

klopt.. ESXi + VTx/VTdvargo schreef op zondag 26 juni 2011 @ 12:15:

[...]

Waarom ben je eigenlijk naar supermicro overgestapt (ESXi misschien?).

Mooi setje hoor. Het is dat ik zelf ga reizen en daarmee geen behoefte heb aan nieuwe hardware.

Voor mensen die op zoek zijn naar (een) betaalbare SFF-8087(host) naar 4x SATA(backplane) kabel(s), ook gekend als forward breakout cable. Dan hier misschien een tip: http://www.planet4one.de/...&tpl=produktdetailv3.html . €7,46 per kabel en naar Benelux €11,95 verzending als je betaalt dmv overschrijving. Dus in totaal €41,79 voor 4 kabels. Niet slecht, denk ik. Heb er net zelf 4 besteld...daarmee.

Ben zef nu al enige poos aan het orienteren om me huidige server te vervangen

HP ml115G5 (amd quadcore)

8gb ecc geheugen

Hp p400 controller met 512mb cache.

8 hitachi 7k1000 1tb schijven

Draai er esxi op eigenlijk vrijwel out of the box en middels een emc cellera vsa heb ik me storage beschikbaar 6tb op dit moment. Hardwarematig raid 6 dus bij iedere cold boot moet ik me tler weer aanzetten erg irritant maar het werkt naar behoren en heb tot nu toe nog geen disken gehad die uitvielen.

Inmiddels na wat topics doorspiten en wat uurtjes lezen toch maar eens aan het kijken gegaan naar vervanging. Wil uiteraard wel esx blijven draaien maar geen hardware matige raid oplossing. zit aan zfs te denken met open indiana en evt napp-it erop.

De hardware die ik in gedacht heb is het het volgende.

Moederboard: Super micro X9SCA-F

Processor: xeon e3 1220l

geheugen 8gb om mee te beginnen

En dan word het spannend ga ik voor de Intel RAID Controller SASUC8I

of kies ik voor de toekomst en neem ik de Intel RAID Controller RS2WC080

Voordeel van de 2e controller is de support voor 3tb drives en sata 600 maar is ook gelijk 2x zo duur als de eerste.

Behuizing laat ik nog even te wensen over eerst maar eens uitvogelen of het zin heeft om gelijk voor de sata3 support te gaan en het voordeel van de 3tb drives.

wat zeggen jullie?

HP ml115G5 (amd quadcore)

8gb ecc geheugen

Hp p400 controller met 512mb cache.

8 hitachi 7k1000 1tb schijven

Draai er esxi op eigenlijk vrijwel out of the box en middels een emc cellera vsa heb ik me storage beschikbaar 6tb op dit moment. Hardwarematig raid 6 dus bij iedere cold boot moet ik me tler weer aanzetten erg irritant maar het werkt naar behoren en heb tot nu toe nog geen disken gehad die uitvielen.

Inmiddels na wat topics doorspiten en wat uurtjes lezen toch maar eens aan het kijken gegaan naar vervanging. Wil uiteraard wel esx blijven draaien maar geen hardware matige raid oplossing. zit aan zfs te denken met open indiana en evt napp-it erop.

De hardware die ik in gedacht heb is het het volgende.

Moederboard: Super micro X9SCA-F

Processor: xeon e3 1220l

geheugen 8gb om mee te beginnen

En dan word het spannend ga ik voor de Intel RAID Controller SASUC8I

of kies ik voor de toekomst en neem ik de Intel RAID Controller RS2WC080

Voordeel van de 2e controller is de support voor 3tb drives en sata 600 maar is ook gelijk 2x zo duur als de eerste.

Behuizing laat ik nog even te wensen over eerst maar eens uitvogelen of het zin heeft om gelijk voor de sata3 support te gaan en het voordeel van de 3tb drives.

wat zeggen jullie?

Verwijderd

TJAKKAAAAAAAHwhocarez schreef op zondag 26 juni 2011 @ 14:00:

wat zeggen jullie?

of het zin heeft om gelijk voor sata 3TB support te gaan dat kan een ander toch niet voor jou bepalen.

[ Voor 29% gewijzigd door Verwijderd op 26-06-2011 14:17 ]

Hij is duidelijk. waar het me meer om ging is de voordelen van sata 3 ten opzichte van sata2. Jullie kunnen dat als geen andere beter inschatten als ik de nog beginnende zfs-er.Verwijderd schreef op zondag 26 juni 2011 @ 14:15:

[...]

TJAKKAAAAAAAH

of het zin heeft om gelijk voor sata 3TB support te gaan dat kan een ander toch niet voor jou bepalen.

Vandaar dacht laat ik het hier eens neerleggen kijken hoe jullie er over denken sata3 en sata2 in een zfs opstellingen en de support e.d.

Misschien dat iets meer geheugen wel verstandig is, welke VM's wil je naast OI draaien ?

4GB is toch echt wel het minimale voor een OI ZFS nas, echter draaide het bij mij met 8GB toch beter.

Ik zou proberen om een OI vm toch wel van 6GB ram te voorzien, je kan natuurlijk wel om te beginnen eens testen met 4GB ofzo.

Zelf ben ik wel benieuwd naar de Highpoint DC7280 welke hier al eens eerder gepost is.

Ik ga even afwachten hoe de FreeBSD support voor deze controller is, ben bang dat het niet optimaal zal zijn maar wie weet. Als ik de specs goed interpreteer kan deze kaart gewoon 3TB harddisks aan, helaas geen Sata600 support

[ Voor 34% gewijzigd door dutch_warrior op 26-06-2011 14:42 ]

Welke vm's ik er naast draai is meer van waar me neus naar staat. Meestal heb ik een exchange met domain controller voor 2 mailboxen draaien en wat hobby projectjes niet echt spannende dingen. Dit draait nu allemaal op 8gb en ik hou zo'n 1 tot 1,5 aan vrije ruimte in het geheugen over.dutch_warrior schreef op zondag 26 juni 2011 @ 14:30:

[...]

Misschien dat iets meer geheugen wel verstandig is, welke VM's wil je naast OI draaien ?

4GB is toch echt wel het minimale voor een OI ZFS nas, echter draaide het bij mij met 8GB toch beter.

Ik zou proberen om een OI vm toch wel van 6GB ram te voorzien, je kan natuurlijk wel om te beginnen eens testen met 4GB ofzo.

Zal de 16gb maar eens op me lijst gaan zetten. moet meer dan voldoende zijn. Uiteraard speelt het stroom verbruik ook een rol vandaar het idee om eens naar de 3tb drives te kijken (minder drives nodig dus ook lager verbruik)

Verwijderd

3TB drives gebruiken meer stroom dan 2TB drives. Er zijn nog geen 1TB platter hardeschijven dus er zijn nog geen 'echte' 3TB schijven; dat komt pas binnenkort.

Wel is er de nieuwe Samsung M8; een notebook drive met twee platters van 500GB; dus 1TB opslag tegen 0.7 watt idle en 4W spinup current. Voor een low-power PicoPSU server is dat een interessante optie. Maar dat gaat met je huidige server niet lukken. Waarschijnlijk zit je nu aan iets van 75W idle ofzo?

Wel is er de nieuwe Samsung M8; een notebook drive met twee platters van 500GB; dus 1TB opslag tegen 0.7 watt idle en 4W spinup current. Voor een low-power PicoPSU server is dat een interessante optie. Maar dat gaat met je huidige server niet lukken. Waarschijnlijk zit je nu aan iets van 75W idle ofzo?

@whocarez

16GB zou voldoende moeten zijn ja.

Als stroomverbruik een rol speelt zou ik even kijken naar een SSD voor de vm's en dan proberen een configuratie te bouwen waarbij de harddisks gewoon downspinnen wanneer ze niet in gebruik zijn.

Welke hardware je hiervoor precies nodig hebt durf ik niet met zekerheid te zeggen, maar ik geloof dat er hier wel wat mensen zijn met een dergelijke setup.

Een SSD is bij een ZFS oplossing ook handig voor L2ARC en ZIL echter is de support voor caching op SSD devices bij Open Indiana nog niet zover als bij FreeBSD, dit zou je dus als optie voor later kunnen houden.

@Cipher,

Wat denk jij eigenlijk van die Highpoint data center controller, ik ben bang dat het marvell based is en dus op driver gebied gaat falen maar in de officiële handleiding staat FreeBSD support genoemd.

16GB zou voldoende moeten zijn ja.

Als stroomverbruik een rol speelt zou ik even kijken naar een SSD voor de vm's en dan proberen een configuratie te bouwen waarbij de harddisks gewoon downspinnen wanneer ze niet in gebruik zijn.

Welke hardware je hiervoor precies nodig hebt durf ik niet met zekerheid te zeggen, maar ik geloof dat er hier wel wat mensen zijn met een dergelijke setup.

Een SSD is bij een ZFS oplossing ook handig voor L2ARC en ZIL echter is de support voor caching op SSD devices bij Open Indiana nog niet zover als bij FreeBSD, dit zou je dus als optie voor later kunnen houden.

@Cipher,

Wat denk jij eigenlijk van die Highpoint data center controller, ik ben bang dat het marvell based is en dus op driver gebied gaat falen maar in de officiële handleiding staat FreeBSD support genoemd.

[ Voor 15% gewijzigd door dutch_warrior op 26-06-2011 14:53 ]

Ik heb nu een idle systeem van 85 tot 95 watt. dus iets hoger. Maar de drive spinnen volgens mij ook niet echt down. Het zou wel een optie kunnen zijn om daar eens naar te kijken denk alleen dan het prijs kaartje weer de boosdoener gaat worden. Wanneer ik dus voor de 2tb drives zou gaan zou ik op 14gb met raidz2 uit komen. met een 2e controller word dit al 28tb.Verwijderd schreef op zondag 26 juni 2011 @ 14:44:

3TB drives gebruiken meer stroom dan 2TB drives. Er zijn nog geen 1TB platter hardeschijven dus er zijn nog geen 'echte' 3TB schijven; dat komt pas binnenkort.

Wel is er de nieuwe Samsung M8; een notebook drive met twee platters van 500GB; dus 1TB opslag tegen 0.7 watt idle en 4W spinup current. Voor een low-power PicoPSU server is dat een interessante optie. Maar dat gaat met je huidige server niet lukken. Waarschijnlijk zit je nu aan iets van 75W idle ofzo?

Met een sas expander wil ik eigenlijk niet aan de slag wanneer ik zfs draai. Dit werkt nou niet echt performance verbeterend. Met een hardware matige oplossing zou de hp expander nog wat kunnen betekenen.

Die ssd is inderdaar een goeie. Gebruik nu een ssd om me vm's op te cachen en dat werk prima en is goed snel. Vooral in een lap situatie met nested vm's heb nu een crucial c300 erin zitten maar vanwege de brakke garbage collectie is een sandforce model ineens intressant ondanks alle nadelen.dutch_warrior schreef op zondag 26 juni 2011 @ 14:47:

@whocarez

16GB zou voldoende moeten zijn ja.

Als stroomverbruik een rol speelt zou ik even kijken naar een SSD voor de vm's en dan proberen een configuratie te bouwen waarbij de harddisks gewoon downspinnen wanneer ze niet in gebruik zijn.

Welke hardware je hiervoor precies nodig hebt durf ik niet met zekerheid te zeggen, maar ik geloof dat er hier wel wat mensen zijn met een dergelijke setup.

Een SSD is bij een ZFS oplossing ook handig voor L2ARC en ZIL echter is de support voor caching op SSD devices bij Open Indiana nog niet zover als bij FreeBSD, dit zou je dus als optie voor later kunnen houden.

@Cipher,

Wat denk jij eigenlijk van die Highpoint data center controller, ik ben bang dat het marvell based is en dus op driver gebied gaat falen maar in de officiële handleiding staat FreeBSD support genoemd.

Een goede SSD is een investering welke het geld wel waard is, zeker wanneer je gebruikt maakt van virtualisatie zullen traditionele harddisk al snel de bottleneck zijn. Misschien dat de C300 geschikt is voor ZIL, misschien dat Cipher hier iets over kan zeggen.

Misschien dat jij voor jouw situatie ook handige tips kunt vinden in het Zuinige ESX(i) topic.

Ik heb daar al een aantal ESXi + Open Indiana setups voorbij zien komen.

Misschien dat jij voor jouw situatie ook handige tips kunt vinden in het Zuinige ESX(i) topic.

Ik heb daar al een aantal ESXi + Open Indiana setups voorbij zien komen.

[ Voor 9% gewijzigd door dutch_warrior op 26-06-2011 15:10 ]

Verwijderd

Probleem bij Solaris platform is dat je niet veilig een SSD als zowel L2ARC als SLOG kan gebruiken; vanwege het gebrek aan write flushing op partities; dat kan Solaris alleen op whole-disks. Bij FreeBSD geldt deze beperking niet, dankzij het GEOM framework.dutch_warrior schreef op zondag 26 juni 2011 @ 14:47:

Een SSD is bij een ZFS oplossing ook handig voor L2ARC en ZIL echter is de support voor caching op SSD devices bij Open Indiana nog niet zover als bij FreeBSD, dit zou je dus als optie voor later kunnen houden.

Sandforce zou ik nooit nemen voor ZFS; de ZFS metadata is altijd al gecomprimmeerd dus grote kans dat je weinig voordeel haalt uit de compressie van Sandforce. Bovendien heb je geen supercaps en een hoge failure rate, dus ongeschikt als SLOG disk. Dan zou ik veel liever een Intel 320 nemen; supercaps, super betrouwbaar en hoge multiqueue reads en writes.

Ik zelf kijk uit naar de Intel 720 PCI-express SSD, die 2GB/s read en 1,8GB/s write aan zou moeten kunnen, en 180.000 random IOps.

Highpoint maakt voor zover ik weet geen echte HBA's; zit allemaal een RAID SoC tussen. Dat is dus veel minder geschikt voor ZFS. De USAS2-L8e kun je wel overwegen, die in IT mode firmware draait. Maar ik zou persoonlijk veel liever een SATA 6Gbps AHCI HBA willen met 8 poorten ofzo, maar ja die zijn er niet. Dan blijft dus over je chipset SATA voor SSDs gebruiken en add-on HBAs voor normale HDDs.@Cipher,

Wat denk jij eigenlijk van die Highpoint data center controller, ik ben bang dat het marvell based is en dus op driver gebied gaat falen maar in de officiële handleiding staat FreeBSD support genoemd.

Zelf wil ik graag over op notebook HDDs. Die Samsung M8 met 1TB op 2 platters is erg interessant. Dan kun je met PicoPSU een 30W NAS maken zonder spindown en iets van 10 van die schijfjes ofzo. Wel een stuk duurder qua aanschafprijs, dat is het nadeel. Voordeel is dat je PicoPSU kan gebruiken met 10 schijfjes. En 0,7W per terabyte is natuurlijk erg zuinig; dan hoef je ook geen spindown meer te gebruiken.

Verwijderd

ahawhocarez schreef op zondag 26 juni 2011 @ 14:27:

[...]

Hij is duidelijk. waar het me meer om ging is de voordelen van sata 3 ten opzichte van sata2. Jullie kunnen dat als geen andere beter inschatten als ik de nog beginnende zfs-er.

Vandaar dacht laat ik het hier eens neerleggen kijken hoe jullie er over denken sata3 en sata2 in een zfs opstellingen en de support e.d.

je heb straks dus 14 sata poorten, 6 op mobo en 8 op controller.

ideaal voor RZ2 (raid6) zou 10 disks zijn , dus 8 van de controller en 2 van je mobo.

10 x 2 TB RZ2 = 16 TB netto .. dat is niet misselijk.

heb je nog 4 sata poorten over waarvan 2 snelle van 6 gb.

die kan je gebruiken voor bootdisk / dvd drive / datastores

ik heb zelf nog iets bedacht (en gedaan), de sasuc8i is natuurlijk een verouderd model, als je een dergelijke storage bouwt dan is de bedoeling dattie jaren mee moet.

heb dus een reserve controller liggen, want ik weet niet of ik die over 2 jaar nog kan krijgen, mobo's en zfs v.28 wel

http://www.highpoint-tech.com/USA_new/series_DC7280.htmVerwijderd schreef op zondag 26 juni 2011 @ 15:12:

Highpoint maakt voor zover ik weet geen echte HBA's; zit allemaal een RAID SoC tussen. Dat is dus veel minder geschikt voor ZFS. De USAS2-L8e kun je wel overwegen, die in IT mode firmware draait. Maar ik zou persoonlijk veel liever een SATA 6Gbps AHCI HBA willen met 8 poorten ofzo, maar ja die zijn er niet. Dan blijft dus over je chipset SATA voor SSDs gebruiken en add-on HBAs voor normale HDDs.

De DC edities zijn true-HBA's... Geen enkele vorm van RAID... Die andere 27xx series zijn HBA's met driver RAID, maar die kan je uitzetten volgens mij.

Even niets...

Verwijderd

FireDrunk schreef op zondag 26 juni 2011 @ 16:07:

[...]

http://www.highpoint-tech.com/USA_new/series_DC7280.htm

De DC edities zijn true-HBA's... Geen enkele vorm van RAID... Die andere 27xx series zijn HBA's met driver RAID, maar die kan je uitzetten volgens mij.

[ Voor 26% gewijzigd door Verwijderd op 26-06-2011 16:26 ]

@Firedrunk,

Inderdaad Highpoint zet de kaart zelf neer als Data Center HBA, dit is ook de reden dat ik deze kaart overweeg als optie, 32 harddisk poorten voor 400 euro dat is niet verkeerd.

Maar ik wacht even geduldig af want in de handleiding lees ik het volgende: "Binary and source driver updates are routinely posted for a variety of older Linux operating systems

including past versions of Red Hat Enterprise, CentOS, OpenSuSE, and Fedora Core, SLES. "

Nou vraag ik me af wat men hiermee precies bedoelt, zit de support voor deze kaart al ingebakken in nieuwe Linux distributies of is deze kaart gewoon gebouwd met oude onderdelen en wordt hij niet ondersteund door de nieuwe kernels ?

Inderdaad Highpoint zet de kaart zelf neer als Data Center HBA, dit is ook de reden dat ik deze kaart overweeg als optie, 32 harddisk poorten voor 400 euro dat is niet verkeerd.

Maar ik wacht even geduldig af want in de handleiding lees ik het volgende: "Binary and source driver updates are routinely posted for a variety of older Linux operating systems

including past versions of Red Hat Enterprise, CentOS, OpenSuSE, and Fedora Core, SLES. "

Nou vraag ik me af wat men hiermee precies bedoelt, zit de support voor deze kaart al ingebakken in nieuwe Linux distributies of is deze kaart gewoon gebouwd met oude onderdelen en wordt hij niet ondersteund door de nieuwe kernels ?

[ Voor 57% gewijzigd door dutch_warrior op 26-06-2011 16:21 ]

Ik was 400 euro kwijt voor 16 poorten in 1 kaart. De 2340 maar die pretendeert nog iets van RAID te doen, wat ik niet nodig heb.

Zo'n HBA met 32 poorten is echt super. Liefst dan ook een met 16 poorten en dan voor de helft van het geld. Daar zou je een hoop mensen blij mee maken.

Al jaren zoeken DIY NAS bouwers naar 8+ poort HBA's voor een schappelijke prijs, maar ze bestaan gewoon niet.

Zo'n HBA met 32 poorten is echt super. Liefst dan ook een met 16 poorten en dan voor de helft van het geld. Daar zou je een hoop mensen blij mee maken.

Al jaren zoeken DIY NAS bouwers naar 8+ poort HBA's voor een schappelijke prijs, maar ze bestaan gewoon niet.

399,-?? hmm...

* FireDrunk krijgt ideeen

* FireDrunk krijgt ideeen

Even niets...

Ik zit zelf aan een constructie te denken waarbij ik een of twee ssd's gebruik als high speed storage. Daarnaast nog een dikke raid 6 array. Storage zou primair op de ssd gebeuren en na verloop van tijd zouden die files dan gemoved worden naar de raid6. Spindown is dan erg efficiënt denk ik.

Dat zou ik ook graag willen, alleen vraag ik me dan weer af, hoe je gemakkelijk die data naar je array moved... Je kan het met tijdsintervallen doen (scriptje via cron ofzo) en je kan het met de hand doen... Lastige is dat als ik een beetje flink aan het downloaden ben, mijn SSD best snel volloopt

6MB/s 40GB vrij op mijn SSD maakt dat het ding zich vol schrijft in: 110 minuten ofzo...

6MB/s 40GB vrij op mijn SSD maakt dat het ding zich vol schrijft in: 110 minuten ofzo...

Even niets...

Je kan toch wel een scriptje maken welke wanneer de vrije ruimte onder de 25% komt begint met moven van data ?

Ik kan me niet voorstellen dat dit niet kan, misschien niet met puur shell script maar toch wel wanneer je bijvoorbeeld (g)awk erbij gebruikt ?

Scriptje iedere 5 minuten laten checken natuurlijk maar als je t goed bouwt vraagt dat niet zoveel van je systeem.

Er zijn vast wel triggers welke een actie starten wanneer je vrije ruimte onder x procent komt.

Misschien doet hobbit wel wat je nodig hebt ?

Ik kan me niet voorstellen dat dit niet kan, misschien niet met puur shell script maar toch wel wanneer je bijvoorbeeld (g)awk erbij gebruikt ?

Scriptje iedere 5 minuten laten checken natuurlijk maar als je t goed bouwt vraagt dat niet zoveel van je systeem.

Er zijn vast wel triggers welke een actie starten wanneer je vrije ruimte onder x procent komt.

Misschien doet hobbit wel wat je nodig hebt ?

[ Voor 39% gewijzigd door dutch_warrior op 26-06-2011 16:38 ]

Mijn upgrade zit er nu echt aan te komen.

Gisteren bij Ri-vier geen Norco case gehaald maar een Sharkoon met Norco SS-400 hot swap en 3x 2TB disken. Heb gelijk de fan in de SS-400 veranderd naar een stillere variant.

Huidige setup:

AMD X2 4050E

2x 2GB DDR2 @ 800mhz

Gigabyte mobo met 740G chipset

6x 500GB 7200rmp Hitachi disken ( 1 disk OS, 5x in raid5 )

Seasonic 500watt voeding

Aopen mini tower

>

AMD X2 4050E

2x 2GB DDR2 @ 800mhz

Gigabyte mobo met 740G chipset

1x 160GB 2,5 Samsung 5400rpm ( OS )

3x 2TB Samsung F4 5400rpm ( raid5 )

Seasonic 500watt voeding

Sharkoon Rebel Aluminum

Norco SS-400 hot swap bay

Ben nu de data van mijn huidige NAS aan het weg schrijven zodat ik met een schone installatie kan beginnen.

Heb straks inplaats van 2TB > 4TB ruimte + het stroom verbruik moet wel aardig gaan zakken . De hot swap bays zijn er omdat het kan en ik geen ruimte heb voor een echte Norco case.

. De hot swap bays zijn er omdat het kan en ik geen ruimte heb voor een echte Norco case.

Preview pics:

Later meer...

Gisteren bij Ri-vier geen Norco case gehaald maar een Sharkoon met Norco SS-400 hot swap en 3x 2TB disken. Heb gelijk de fan in de SS-400 veranderd naar een stillere variant.

Huidige setup:

AMD X2 4050E

2x 2GB DDR2 @ 800mhz

Gigabyte mobo met 740G chipset

6x 500GB 7200rmp Hitachi disken ( 1 disk OS, 5x in raid5 )

Seasonic 500watt voeding

Aopen mini tower

>

AMD X2 4050E

2x 2GB DDR2 @ 800mhz

Gigabyte mobo met 740G chipset

1x 160GB 2,5 Samsung 5400rpm ( OS )

3x 2TB Samsung F4 5400rpm ( raid5 )

Seasonic 500watt voeding

Sharkoon Rebel Aluminum

Norco SS-400 hot swap bay

Ben nu de data van mijn huidige NAS aan het weg schrijven zodat ik met een schone installatie kan beginnen.

Heb straks inplaats van 2TB > 4TB ruimte + het stroom verbruik moet wel aardig gaan zakken

Preview pics:

Later meer...

Onder Linux kan je zien wanneer files zijn benaderd. Als dat boven een bepaalde tijd komt kan je hem moven. Eventueel me een symlink op de huidige positie naar de nieuwe. Al weet ik niet wat voor effect dat heeft op wel of niet spindown.

root@ZEUS:/mnt/incoming# dd if=/dev/zero of=/mnt/incoming/test.bin bs=1M count=1024 1024+0 records in 1024+0 records out 1073741824 bytes (1.1 GB) copied, 0.656643 s, 1.6 GB/s root@ZEUS:/mnt/incoming# dd if=/dev/zero of=/mnt/incoming/test.bin bs=1M count=10240 10240+0 records in 10240+0 records out 10737418240 bytes (11 GB) copied, 24.1063 s, 445 MB/s root@ZEUS:/mnt/incoming# dd of=/dev/null if=/mnt/incoming/test.bin bs=1M 10240+0 records in 10240+0 records out 10737418240 bytes (11 GB) copied, 8.24267 s, 1.3 GB/s root@ZEUS:/mnt/incoming#

Lang leve caching

Ik heb het anders verzonnen, ik heb nog steeds 4 x 2TB die ik niet gebruik over (had ik tijdelijk nodig om mijn data te kunnen storen en te kunnen verhuizen naar XFS (van NTFS).

Deze schijven heb ik nu in RAID0 gestopt, en gemount als /mnt/incoming. Daar gaan al mijn downloads voortaan naartoe. Dan kan mijn gewone array uitblijven totdat ik die nodig heb. En 's nachts is dat niet zo vaak. Dus blijven (in het geval van downloaden) alleen mijn 4 x 2TB aan. Ook heb ik tijdens het film kijken geen problemen dat mijn array het te druk zou krijgen omdat mijn server aan het downloaden is.

Scriptjes om downloads naar mijn array te kopieren bouw ik later wel... Voor nu: Handmatig

[ Voor 36% gewijzigd door FireDrunk op 26-06-2011 18:06 ]

Even niets...

Verwijderd

ziet er ook netjes uit met zo'n Norco SS-400 hot swapDJ-Promo schreef op zondag 26 juni 2011 @ 16:36:

Mijn upgrade zit er nu echt aan te komen.

[ Voor 67% gewijzigd door Verwijderd op 26-06-2011 18:36 ]

Hee, jouw 2 TB disks kunnen in RAID 0 waarschijnlijk max 600 MB/s wegschrijven dus deze snelheden lijkten mij inderdaad wel heel erg gecached. Test maar eens met 100 GB.

Verwijderd

Je kunt zo'n controller gebruiken met single disk arrays; maar het blijft dan een RAID controller. Je mist echte SMART passthrough, je hebt hogere latencies omdat alle I/O door een RAID SoC chip gaat en je kunt disks verliezen door timeouts; dus eigenlijk moet je dan TLER disks hebben wat weer een risico vormt. Kortom; geen ideale keuze voor een ZFS build.Q schreef op zondag 26 juni 2011 @ 16:19:

Ik was 400 euro kwijt voor 16 poorten in 1 kaart. De 2340 maar die pretendeert nog iets van RAID te doen, wat ik niet nodig heb.

Ik ben erg sceptisch.Zo'n HBA met 32 poorten is echt super. (..) Al jaren zoeken DIY NAS bouwers naar 8+ poort HBA's voor een schappelijke prijs, maar ze bestaan gewoon niet.

1) ze gebruiken Marvell chips

2) er zit een centrale chip op; dus je krijgt GEEN directe controle over de disks; waarschijnlijk gewoon een RAID SoC of iets anders waardoor je I/O door twee chips gaat ipv één.

3) je hebt geen volledige bandbreedte; je deelt 9600MB/s op een 4GB/s PCI-express interface

De reden dat je geen 16 poort HBA adapters ziet is simpel: met en echte HBA heb je volledige bandbreedte. Denk aan 8 poorten van SATA/300 = 2400MB/s heb je eigenlijk PCIe 2.0 x8 nodig (4GB/s) maar PCIe 1.0 x8 gaat ook nog wel (2GB/s). Voor SATA/600 met 8 poorten zit je aan 4800MB/s op 4GB/s link. Hoe wil je 16 poorten doen zonder ook van 16 lanes gebruik te maken? Dat laatste zie ik nooit; dan zou er een nieuwe native chip moeten aankomen met 16 lanes (will not happen) of zo'n smerige PLX-bridgechip ertussen.

Wat is er mis met échte HBA's? Als je 32+ schijven aan wilt sluiten kan een moederbord met 4 PCI-express er ook wel vanaf toch? Dus neem een SuperMicro moederbord met al een 8-poort HBA erop dan heb je 8+6=14 poorten om mee te beginnen. En dan nog 4 PCI-express sloten (laatste heeft PCIe met 4 lanes), stel je doet daar 3 controllers op dan zit je dus aan:

8+6 + 8 + 8 + 8 = 38 poorten op volle bandbreedte, en niet duurder dan één zo'n kaart. Liever meerdere kaarten dan ben je veel flexibeler en zodra je garantie voorbij is hoef je niet bang te zijn dat die defect raakt. Verder vind ik 32W energieverbruik voor zo'n kaart wel erg hoog voor een klein heatsinkje; die gaat denk ik wel erg warm worden onder belasting.

En dan nog het probleem dat het volgens mij helemaal geen echte HBA is maar gewoon een RAID achtige SoC tussen zit en je dus ook eigenlijk TLER disks nodig hebt. Dat kan ik niet bevestigen, maar informatie over deze kaart valt vrijwel NIET te vinden. Geen info over welke driver onder BSD wordt gebruikt, geen gedetailleerde foto en geen info van gebruikers met deze kaart die BSD draaien. Sowieso niet bekend welke controllerchip er op die kaart zit.

Kortom ik kan het niet aanraden, en vertrouw liever op echte HBAs met LSI chips dan een RAID HBA met Marvell chips.

- Het is een nieuw product, het is nog niet precies bekend welke hardware er gebruikt is maar waarschijnlijk inderdaad marvell'sVerwijderd schreef op zondag 26 juni 2011 @ 21:42:

Ik ben erg sceptisch.

1) ze gebruiken Marvell chips

2) er zit een centrale chip op; dus je krijgt GEEN directe controle over de disks; waarschijnlijk gewoon een RAID SoC of iets anders waardoor je I/O door twee chips gaat ipv één.

3) je hebt geen volledige bandbreedte; je deelt 9600MB/s op een 4GB/s PCI-express interface

- Het is wel PCI-E 2.0 x8 dus dat is iets wat in ieder geval wel goed is gedaan.

Het is even afwachten totdat er wat meer ervaringen van het product bekend zijn.

Verwijderd

PCI-express 2.0 x8 is 4GB/s ruwe bandbreedte, dus dat klopt toch? De LSI kaarten hebben in elk geval veel meer bandbreedte per poort, bijna full bandwidth.

Dat er Marvell chips op zitten is nog tot daar aan toe, maar ik maak me zorgen om de Marvell chips in combinatie met een centrale RAID SoC chip, zoals ik van Highpoint gewend ben. Voor zover ik weet heeft Highpoint nog nooit een échte HBA gelanceerd. Dit zou de eerste zijn; terwijl er helemaal geen controller chips zoals LSI 1068E of SAS2008 zijn bijgekomen die een featureset van deze kaart kunnen hebben. Dus dat voorspelt weinig goeds denk ik.

Ik zou zeer terughoudend zijn zeker voor een ZFS setup, en liever op meerdere HBAs vertrouwen van LSI, dan weet je zeker wat je krijgt.

Dat er Marvell chips op zitten is nog tot daar aan toe, maar ik maak me zorgen om de Marvell chips in combinatie met een centrale RAID SoC chip, zoals ik van Highpoint gewend ben. Voor zover ik weet heeft Highpoint nog nooit een échte HBA gelanceerd. Dit zou de eerste zijn; terwijl er helemaal geen controller chips zoals LSI 1068E of SAS2008 zijn bijgekomen die een featureset van deze kaart kunnen hebben. Dus dat voorspelt weinig goeds denk ik.

Ik zou zeer terughoudend zijn zeker voor een ZFS setup, en liever op meerdere HBAs vertrouwen van LSI, dan weet je zeker wat je krijgt.

klopt ja, ik was even in de war met de bandbreedte van pci-e 3.0.

Ik ben ook zeker terughoudend wat deze kaart betreft want ik denk dat je gelijk hebt en dat het ding is opgebouwd met allemaal net niet componenten, maar we wachten af .

.

Ik ben ook zeker terughoudend wat deze kaart betreft want ik denk dat je gelijk hebt en dat het ding is opgebouwd met allemaal net niet componenten, maar we wachten af

Als je het ding zo ziet lijkt het ook net een RocketRaid 2720 met onboard 8 portmultipliers erachter geknoopt.

Goed gezien ja

Je wilt zoveel mogelijk poorten voor zo weinig mogelijk geld. De SM oplossing die je noemt is zeker het overwegen waard als alternatief.

Maar CiPHER, ik merk dat je je altijd druk maakt om performance, terwijl voor 99.99% van de NAS gebruikers in dit topic performance die gigabit ethernet voltrekt al voldoende is.

Dat lukt al met 1 disk.

Natuurlijk is 99.99% niet geinteresseerd in zo'n HBA als deze, maar ook die partij is bezig met storage en performance komt altijd op plan B.

Voor de grote builds is performance niet zo'n issue. Het gaat om storage tegen een redelijke prijs en welke performance is nu echt belangrijk?

Mijn NAS is eigenlijk een hele grote USB disk maar dan écht heel groot en via ethernet ipv usb. Maar meer is het ook weer niet.

Het lijkt me stug dat deze controller 1 virtuele RAID achtige disk aan het OS presenteert, dan zou het geen HBA mogen heten. Daar ben ik dan weer Skeptisch over. We zien het wel.

Het aardige van zo'n kaart als deze is ook weer dat je ook weer andersom onafhankelijk bent van alle andere hardware. Het stroomverbruik is wel fors.

Ik heb ook een fan gericht op mijn rr2340 omdat die best warm wordt en ik wil geen risicos lopen. Mijn oude 2320 heeft een keer staan piepen door oververhitting (op een snikhete zomerdag op een slecht geventileerde kamer).

[ Voor 5% gewijzigd door Q op 26-06-2011 22:22 ]

Verwijderd

Geld per poort is belangrijk, maar het belangrijkste is denk ik dat de controller gewoon UITSTEKEND werkt met het OS wat je wilt draaien. Stel je kiest Marvell dan zitten daar echt grote nadelen aan; in elk geval in mijn ervaring dan en vele anderen. Sommige Marvell chips doen het beter dan andere zo schijnt. Ik ben er in elk geval helemaal vanaf gestapt. Wel jammer want Marvell is een van de weinige third-party chipvendors die een AHCI SATA chip levert; iets wat tegenwoordig erg zeldzaam is helaas.Q schreef op zondag 26 juni 2011 @ 22:21:

[...]

Je wilt zoveel mogelijk poorten voor zo weinig mogelijk geld.

Dus de compatibiliteit/stabiliteit en kwaliteit van de drivers zijn denk ik het allerbelangrijkste, iets wat natuurlijk ook per OS variëert. De LSI chips zoals LSI 1068E werken vrijwel onder ALLE OS goed, maar hebben ook wel nadelen, zoals max 2TB disks en problemen met veelvuldige smart queries (smartd); beide hoeven geen supergrote problemen te zijn, maar toch lastig!

Het liefste zou ik zien dat AMD of Intel met een add-on kaart komen met een getweakde southbridge chip. Zeg maar PCIe x4 met een SB850 of ICH11 chip ofzo; 6 AHCI poorte op PCIe 2.0 x4 (=2GB/s) dat zou best een goedkope en leuke controller zijn voor een vrij breed publiek. Zeker omdat zij dus de beste implementaties hebben van normaal AHCI SATA.

Ja voor grote builds is SuperMicro toch wel hét merk moederbord. Helaas zie ik vaak dat mensen dan een model met weinig PCI-express poorten nemen en dan een grote 24-poorts HBA met expanders erin verwerkt, en daar nog extra expanders op aansluiten. Tsja.. het zou niet mijn setup zijn! Zuinig zal het ook niet wezen; en goedkoop ook niet dus wat is de winst?De SM oplossing die je noemt is zeker het overwegen waard als alternatief.

Met 100MB/s disk throughput haal je nog geen 100MB/s netwerk throughput! Je hebt eigenlijk minimaal het dubbele nodig, en dan nog wil je een buffer voor fragmentatie hebben. ZFS is geen Ext4 ofzo; het spaart writes op en dan komt er een burst naar je disks toe tegen maximale snelheid. Dus om gigabit vol te trekken wil je toch zo'n 450MB/s doen met een verse pool en 250MB/s op een gevulde pool.Maar CiPHER, ik merk dat je je altijd druk maakt om performance, terwijl voor 99.99% van de NAS gebruikers in dit topic performance die gigabit ethernet voltrekt al voldoende is.

Maar ook met gigabit cap kun je baat hebben van hogere snelheden. Zo verplaats ik data van het ene filesystem naar het andere; wat lokaal gaat. Ook scrub en resilver gaat lokaal alhoewel dat minder performance-kritisch is.

Je hebt natuurlijk wel een punt dat voor grote builds je toch wel genoeg throughput haalt, en random I/O kun je met SSDs oplossen dus het hoeft helemaal niet zo'n punt te zijn om voor elke poort de max bandbreedte te hebben. Toch hoop ik binnenkort een 10GbE NIC te scoren en tegen de 800MB/s kunnen pushen. Wel jammer dat 10 gigabit zo lang duurt; ik begin aardig ongeduldig te worden! De AT2 Intel 10GBaseT controller kost nu nog tegen de 400 euro; gelukkig wel passief gekoeld. Er werd gesproken dat tegen 2014 10GBaseT LOM zou worden: LAN-on-motherboard oftewel onboard 10 gigabit ethernet; dan zou het vrij mainstream worden alhoewel ik eerder denk aan supermicro moederborden enzo. Toch nog een lange tijd!

Zo bedoel ik het niet, net als mijn Areca HBA of Highpoint kun je prima meerdere 'disks' hebben. Maar eigenlijk zijn dat gewoon single-disk arrays. Daar zitten gewoon een aantal nadelen aan:Het lijkt me stug dat deze controller 1 virtuele RAID achtige disk aan het OS presenteert, dan zou het geen HBA mogen heten. Daar ben ik dan weer Skeptisch over. We zien het wel.

- ze worden altijd als SCSI gezien en je hebt dus sowieso geen TRIM of andere ATA functionaliteit

- er zit een RAID SoC (System-on-Chip) tussen wat voor extra latency zorgt

- je hebt vaak geen directe SMART throughput; alhoewel smartmontools wel bijvoorbeeld Highpoint en Areca passthrough heeft; je krijgt dan SMART output van de RAID firmware te zien en NIET zoals de disk zelf uitspuugt; heel veel waardes verdwijnen dan gewoon bijvoorbeeld.

- als je controlle niet tegen hoge timeouts kan dan disconnect hij keihard je disk; kan je OS/ZFS niets aan doen hij verdwijnt gewoon. Dus heb je of TLER disks nodig of elke keer rebooten; beide is niet fijn! TLER is ook gevaarlijk in principe dus wil je voorkomen.

Wat ik wil is een échte HBA zonder rare chip ertussen; gewoon pure connectivity. Net als PCI-X controllers met een bridge chip naar PCIe; 'doe dat nou niet!' denk ik dan.... Ik wil NATIVE PCI-e!

Maarja zoveel keus is er niet; dus je moet kiezen welke voor- en nadelen tegen elkaar opwegen. Maar het nut van expanders zie ik niet echt voor een nieuwe build. Hooguit als je eenmaal een moederbord hebt en dus beperkte PCI-express poorten, of je hebt een miskoop gedaan met een dure RAID controller en nu wil je ZFS gebruiken.

Ook zoiets. Als dat ding nou warmte verbruikt geef dan 50 cent meer uit voor een iets grotere heatsink! Je betaalt toch 100 ballen voor zo'n kaart heeft toch geen nut om 90 graden te laten worden!Ik heb ook een fan gericht op mijn rr2340 omdat die best warm wordt en ik wil geen risicos lopen.

Die kaart hierboven met 32 poorten zou 32W verbruiken; zie je dat kleine heatsinkje? Natuurlijk gaat er ook energie zitten in die Marvells en de SATA links; maar ik vermoed dat die kaart onder belasting extreem warm kan/gaat worden!

De LSI 1068E van mij zit wel een heatsink op, maar eigenlijk voelt die altijd koud aan. Geeneens warm, ik gok rond de 28-32 graden ofzo dat is dus uitstekend. Onder belasting weet ik niet echt; mijn SSDs zitten op onboard SATA en ik ken nog geen hardeschijven die 250MB/s doen.

Nou ja, in mijn situatie heeft Q wel een beetje gelijk, ik wil een grote array gaan bouwen en de gewenste performance ligt inderdaad op gigabit voltrekken, dat lukt nu al net met 3x green power 2tb in raidz.

Maar ik heb inderdaad geen zin in het marvell gezeik, iets hogere latency en "beperkte" bandbreedte zit ik niet zo mee maar enige betrouwbaarheid is inderdaad wel fijn.

Het supermicro alternatief is zeker geen verkeerde optie, ik ga denk ik ook die kant op.

Momenteel draai ik nog op mijn AMD desktop bordje met x2 555 cpu en 16GB non ecc-ram.

Ik ga een Super Micro USAS2-L8e of iets soortgelijks aanschaffen en nog een aantal disken om een raidz2 setup te bouwen. Als straks de bulldozer cpu's uit zijn dan gaat het mobo en het geheugen waarschijnlijk toch weer worden ingezet voor een desktop systeem.

6 of 10 disks was toch het beste met raidz-2 en 4k schijven?

Cipher heeft mij in ieder geval wel alert gemaakt op een aantal zaken waarom die highpoint "HBA" zeer waarschijnlijk prut is. De marvell chips was ik zelf ook al bang voor maar het verbruik is inderdaad ook vrij extreem, daar had ik nog helemaal niet zo op gelet.

Maar ik heb inderdaad geen zin in het marvell gezeik, iets hogere latency en "beperkte" bandbreedte zit ik niet zo mee maar enige betrouwbaarheid is inderdaad wel fijn.

Het supermicro alternatief is zeker geen verkeerde optie, ik ga denk ik ook die kant op.

Momenteel draai ik nog op mijn AMD desktop bordje met x2 555 cpu en 16GB non ecc-ram.

Ik ga een Super Micro USAS2-L8e of iets soortgelijks aanschaffen en nog een aantal disken om een raidz2 setup te bouwen. Als straks de bulldozer cpu's uit zijn dan gaat het mobo en het geheugen waarschijnlijk toch weer worden ingezet voor een desktop systeem.

6 of 10 disks was toch het beste met raidz-2 en 4k schijven?

Cipher heeft mij in ieder geval wel alert gemaakt op een aantal zaken waarom die highpoint "HBA" zeer waarschijnlijk prut is. De marvell chips was ik zelf ook al bang voor maar het verbruik is inderdaad ook vrij extreem, daar had ik nog helemaal niet zo op gelet.

[ Voor 22% gewijzigd door dutch_warrior op 26-06-2011 23:21 ]

Verwijderd

Nouja die 32W zou het maximum verbruik zijn als alle poorten bezig zijn; dat haal je in de praktijk vast niet. Maar dan nog kan het zijn dat je zelfs in idle al zo'n 10W verstookt. En dat is best veel. Vergelijk met 18W Zacate APU waar een forse heatsink op zit en dan nog redelijk warm wordt. Die warmte moet érgens blijven natuurlijk.

6 of 10 disks is optimaal voor 4K sector schijven in RAID-Z2 inderdaad. Zelf lijkt me 10 disks in RAID-Z2 (of meerdere RAID-Z2's) een optimale mix voor opslagcapaciteit, bescherming door redundantie en performance.

6 of 10 disks is optimaal voor 4K sector schijven in RAID-Z2 inderdaad. Zelf lijkt me 10 disks in RAID-Z2 (of meerdere RAID-Z2's) een optimale mix voor opslagcapaciteit, bescherming door redundantie en performance.

mag ik vragen of je samba nog iets aparts hebt ingesteld, optimalisatie gedaan van iets? of gewoon out of the box ?SanderH_ schreef op zondag 26 juni 2011 @ 00:42:

Jep, zowel voor mijn windows client(s) als mijn mac client. Loopt soepel.

Vrij standaard ja, dit heb ik wel in mijn smb.conf staan:

Interessante link

#performance tweaks socket options = TCP_NODELAY SO_SNDBUF=8192 SO_RCVBUF=8192

Interessante link

[ Voor 30% gewijzigd door SanderH_ op 27-06-2011 01:37 ]

Volgens mij kan samba dat tegenwoordig heel goed zelf, bij mij hadden al die zogenaamde tweaks iig alleen maar een averechts effect.

Samba heeft ervoor gekozen om TCP_NODELAY standaard niet aan te zetten omdat je met brakke netwerkkabels, pc's, etc wel eens problemen zou kunnen krijgen. Als je alles goed regelt werkt het prima.

Als je het stukje leest over de defaults en recommended settings begrijp je het wel

Als je het stukje leest over de defaults en recommended settings begrijp je het wel

Even niets...

Kan iemand mij in de goede richting (forum) wijzen waar ik vragen mbt backup kan stellen? Weet niet of het hier mag en wil niet te ver off-topic gaan. Het gaat over de keuze voor raid (is geen backup) voor mijn DIY NAS.

Highpoint laat ook linux users in de steekt wat betreft support, de driver voor de 2340 compileert maar tot 2.6.31 met wat gepatch heb ik hem vant weekend nog gecompileerd tegen een 2.6.37 want tegen 2.6.38 of 2.6.39 wilde hij echt niet ...Q schreef op zondag 26 juni 2011 @ 16:19:

Ik was 400 euro kwijt voor 16 poorten in 1 kaart. De 2340 maar die pretendeert nog iets van RAID te doen, wat ik niet nodig heb.

Zo'n HBA met 32 poorten is echt super. Liefst dan ook een met 16 poorten en dan voor de helft van het geld. Daar zou je een hoop mensen blij mee maken.

Al jaren zoeken DIY NAS bouwers naar 8+ poort HBA's voor een schappelijke prijs, maar ze bestaan gewoon niet.

Eigenlijk toch niet netjes voor een kaart waar ze op zich nog redelijk wat euro's voor vragen.

Ik vrees al helemaal voor linux 3.x support

If it ain't broken it doesn't have enough features

Zit er helemaal geen support in de kernel zelf? Want mijn LSI is gewoon door de kernel supported, nog nooit zelf drivers voor gecompiled...

Even niets...

De rr2340-driver zit sowieso niet in de kernel. Ze claimen dat hij open source is, maar het is niks meer dan een proprietary driver die in een open-source wrapper zit afaik. Dus het is niet gek dat hij er opeens mee kan ophouden na een kernelupgrade. Linux heeft immers geen stabiele ABI.Apache schreef op maandag 27 juni 2011 @ 10:11:

[...]

Highpoint laat ook linux users in de steekt wat betreft support, de driver voor de 2340 compileert maar tot 2.6.31 met wat gepatch heb ik hem vant weekend nog gecompileerd tegen een 2.6.37 want tegen 2.6.38 of 2.6.39 wilde hij echt niet ...

Eigenlijk toch niet netjes voor een kaart waar ze op zich nog redelijk wat euro's voor vragen.

Ik vrees al helemaal voor linux 3.x support

Ik zou een dergelijke kaart kosten wat kost mijden.

12 × LG 330Wp (Enphase) | Daikin FTXM-N 3,5+2,0+2,0kW | Panasonic KIT-WC03J3E5 3kW

Hmm, ik had highpoint toch redelijk hoog zitten, maar zoals ik dit nu hoor is het een kriem...

Nu snap ik het prijsverschil met LSI kaarten ook

http://lsi.com/products/s...Pages/LSISAS9201-16i.aspx

http://www.newegg.com/Pro...01-_-16-118-142-_-Product

Deze is dan wel een betere oplossing...

Nu snap ik het prijsverschil met LSI kaarten ook

http://lsi.com/products/s...Pages/LSISAS9201-16i.aspx

http://www.newegg.com/Pro...01-_-16-118-142-_-Product

Deze is dan wel een betere oplossing...

[ Voor 43% gewijzigd door FireDrunk op 27-06-2011 12:11 ]

Even niets...

Ga straks me 3x2TB in raid5 zetten maar heb nog een hot swap over. Is het een voordeel als ik daar een 4de disk in doe als hot spare? Heb waarschijnlijk wel genoeg aan die 4TB zo niet dan wordt hij toegevoegd aan de array.

Verwijderd

zonde, hotspare is eigenlijk niet zinvol als je hotswapbays thuis gebruikt.DJ-Promo schreef op maandag 27 juni 2011 @ 12:44:

Ga straks me 3x2TB in raid5 zetten maar heb nog een hot swap over. Is het een voordeel als ik daar een 4de disk in doe als hot spare? Heb waarschijnlijk wel genoeg aan die 4TB zo niet dan wordt hij toegevoegd aan de array.

je hebt zo een disk verwisseld

En het kost meer stroom...

Even niets...

Ik heb via de search niet echt een antwoord op kunnen vinden, dus dan vraag ik het maar even. Zou je ook een server voor NAS kunnen gebruiken? Deze staan namelijk voldoende op marktplaats voor prijsen tussen de 100 en 200 euro. Het lijkt mij van niet als ik naar de prijzen kijk waar mensen systemen voor bouwen, maartoch..

Een aantal die ik bijvoorbeeld tegen kwam:

- HP Proliant ML350 G4P

- HP Proliant DL 360 G4p

- Poweredge 2650

- HP Proliant DL 380 G3 (dual)

Of zie ik iets over het hoofd waardoor het toch een hoop meer kost? Zo'n server is tenslotte gebouwd voor veel data verkeer en grote opslag toch?

Een aantal die ik bijvoorbeeld tegen kwam:

- HP Proliant ML350 G4P

- HP Proliant DL 360 G4p

- Poweredge 2650

- HP Proliant DL 380 G3 (dual)

Of zie ik iets over het hoofd waardoor het toch een hoop meer kost? Zo'n server is tenslotte gebouwd voor veel data verkeer en grote opslag toch?

Moet kunnen, alleen slurpen deze oudere machines vaak meer stroomIk_ben_Mark3 schreef op maandag 27 juni 2011 @ 13:24:

Ik heb via de search niet echt een antwoord op kunnen vinden, dus dan vraag ik het maar even. Zou je ook een server voor NAS kunnen gebruiken? Deze staan namelijk voldoende op marktplaats voor prijsen tussen de 100 en 200 euro. Het lijkt mij van niet als ik naar de prijzen kijk waar mensen systemen voor bouwen, maartoch..

Een aantal die ik bijvoorbeeld tegen kwam:

- HP Proliant ML350 G4P

- HP Proliant DL 360 G4p

- Poweredge 2650

- HP Proliant DL 380 G3 (dual)

Of zie ik iets over het hoofd waardoor het toch een hoop meer kost? Zo'n server is tenslotte gebouwd voor veel data verkeer en grote opslag toch?

En in de Proliant past (misschien) alleen maar SAS schijven, die weer duurder zijn (dit laatste weet ik niet zeker).

Het is meestal zo, hoe kleiner en zuiniger, des te duurder het wordt

Mis, servers zijn helemaal niet per definitie voor veel storage gebouwd, daar heb je NetApp's en EMC's voor.Ik_ben_Mark3 schreef op maandag 27 juni 2011 @ 13:24:

Ik heb via de search niet echt een antwoord op kunnen vinden, dus dan vraag ik het maar even. Zou je ook een server voor NAS kunnen gebruiken? Deze staan namelijk voldoende op marktplaats voor prijsen tussen de 100 en 200 euro. Het lijkt mij van niet als ik naar de prijzen kijk waar mensen systemen voor bouwen, maartoch..

Een aantal die ik bijvoorbeeld tegen kwam:

- HP Proliant ML350 G4P

- HP Proliant DL 360 G4p

- Poweredge 2650

- HP Proliant DL 380 G3 (dual)

Of zie ik iets over het hoofd waardoor het toch een hoop meer kost? Zo'n server is tenslotte gebouwd voor veel data verkeer en grote opslag toch?

Servers zijn vooral gemaakt om 24x7 te draaien. Ze zijn robuust en sommige componenten zijn redundant uitgevoerd. Maar al met al gebruiken ze _veel_ meer stroom dan iets wat je zelf bouwt.

Even niets...

Ik heb voor de 380 even gekeken en die ondersteund inderdaad geen sata. (tenminste, staat er niet tussen. Ik weet ook verder niet of er mogelijkheden tot uitbreiding zijn met pci oid. Nog nooit iets met servers te maken gehad)

Maar ik wist ook niet dat het stroomvreters zijn. Ik ging er vanuit dat ze vast wel zuinig zouden zijn omdat de 24/7 draaien. Maar niet dus

Dan ga ik maar weer eens verder kijken in hoeverre een nas voor mij interessant is qua kosten.

Edit: weet iemand een algemeen topic waar ik iets in kan vragen over een hardeschijf keuze? Ik wil namelijk 2 (of misschien 3) schijven kopen om in raid te zetten als bootdisk. En ik weet niet welke ik moet kiezen. Ik ben nu naar deze 4 aan het kijken. Deze zijn allemaal ongeveer even duur:

- HD103SJ

- ST31000524AS

- ST31000528AS

- HD103UJ

Maar ik wist ook niet dat het stroomvreters zijn. Ik ging er vanuit dat ze vast wel zuinig zouden zijn omdat de 24/7 draaien. Maar niet dus

Dan ga ik maar weer eens verder kijken in hoeverre een nas voor mij interessant is qua kosten.

Edit: weet iemand een algemeen topic waar ik iets in kan vragen over een hardeschijf keuze? Ik wil namelijk 2 (of misschien 3) schijven kopen om in raid te zetten als bootdisk. En ik weet niet welke ik moet kiezen. Ik ben nu naar deze 4 aan het kijken. Deze zijn allemaal ongeveer even duur:

- HD103SJ

- ST31000524AS

- ST31000528AS

- HD103UJ

[ Voor 27% gewijzigd door Markos op 27-06-2011 13:50 ]

400 euro aan stroomkosten per jaar is vaak goedkoper dan een uur uitval.

Even niets...

Ga je windows of *nix erop draaien? En wat voor raid wil je? RAID 0,1,5,Anders?Ik_ben_Mark3 schreef op maandag 27 juni 2011 @ 13:42:

Ik heb voor de 380 even gekeken en die ondersteund inderdaad geen sata. (tenminste, staat er niet tussen. Ik weet ook verder niet of er mogelijkheden tot uitbreiding zijn met pci oid. Nog nooit iets met servers te maken gehad)

Maar ik wist ook niet dat het stroomvreters zijn. Ik ging er vanuit dat ze vast wel zuinig zouden zijn omdat de 24/7 draaien. Maar niet dus

Dan ga ik maar weer eens verder kijken in hoeverre een nas voor mij interessant is qua kosten.

Edit: weet iemand een algemeen topic waar ik iets in kan vragen over een hardeschijf keuze? Ik wil namelijk 2 (of misschien 3) schijven kopen om in raid te zetten als bootdisk. En ik weet niet welke ik moet kiezen. Ik ben nu naar deze 4 aan het kijken. Deze zijn allemaal ongeveer even duur:

- HD103SJ

- ST31000524AS

- ST31000528AS

- HD103UJ

En waarom 1TB schijven en niet 1,5TB of 2TB?

Ik kan een proliant als storage server afraden, ik heb een hele tijd met een dl380 G4 gedraaid met 6 15k scsi schijven als Hyper-V en ESXi machine.

Die bak trok ruim 500 watt uit het stopcontact wanneer beide 575 watt power supply's waren aangesloten.

En het geluid van de G4P is niet gering, en dan druk ik mij nog zacht uit . Op normal mode maakte de machine al zoveel geluid dat ik hem in de nacht uit moest doen ondanks dat hij in de kelder stond, op MAx mode maken de fans zoveel kabaal dat je geen normaal telefoon gesprek kan voeren als je er naast staat, mijn baas dacht dat ik in een datacenter stond toen hij mij aan de telefoon had

. Op normal mode maakte de machine al zoveel geluid dat ik hem in de nacht uit moest doen ondanks dat hij in de kelder stond, op MAx mode maken de fans zoveel kabaal dat je geen normaal telefoon gesprek kan voeren als je er naast staat, mijn baas dacht dat ik in een datacenter stond toen hij mij aan de telefoon had  .

.

Neemt niet weg dat in de tijd dat SSD nog in de kinderschoenen stonden deze G4P server mij ongeloofelijke prestaties bood vooral vanwege de 15k sas schijven en de dual core 2,8 Ghz cpu's.

Features zoals ILO waren in het verleden ook vrij uniek maar tegenwoordig heeft zelfs de Q67 chipset al beperkte remote management features aan boord.

Over de harddisken:

Als je een zuinig systeem wil dan zou je eens moeten kijken naar de samsung M8 notebook schijven welke CiPHER pas ook heeft genoemd, die schijfjes zijn super zuinig.

Dan kan je een simpel systeem bouwen met een pico-psu en toch nog een redelijk aantal schijven.

Die bak trok ruim 500 watt uit het stopcontact wanneer beide 575 watt power supply's waren aangesloten.

En het geluid van de G4P is niet gering, en dan druk ik mij nog zacht uit

Neemt niet weg dat in de tijd dat SSD nog in de kinderschoenen stonden deze G4P server mij ongeloofelijke prestaties bood vooral vanwege de 15k sas schijven en de dual core 2,8 Ghz cpu's.

Features zoals ILO waren in het verleden ook vrij uniek maar tegenwoordig heeft zelfs de Q67 chipset al beperkte remote management features aan boord.

Over de harddisken:

Als je een zuinig systeem wil dan zou je eens moeten kijken naar de samsung M8 notebook schijven welke CiPHER pas ook heeft genoemd, die schijfjes zijn super zuinig.

Dan kan je een simpel systeem bouwen met een pico-psu en toch nog een redelijk aantal schijven.

[ Voor 12% gewijzigd door dutch_warrior op 27-06-2011 15:15 ]

Ok, ik ben er bijna over uit, maar wil toch jullie advies.

Ik wil 4x 2TB schijven halen, en de WD Green valt sowieso af Dan hou ik voor mijn keuze eigenlijk de volgende twee over:

Dan hou ik voor mijn keuze eigenlijk de volgende twee over:

Het scheelt in aanschaf 4x € 4,00 € 3,00... van die € 16,00 € 12,00 lig ik niet wakker.

Ik zou wel graag zuinige schijven willen, maar als ik naar de specificaties kijk, is de Hitachi op papier zuiniger als deze idle draait. En het opstarten valt mee, ~30Watt(max) vs. 24Watt(max).

De garantie is natuurlijk handig, 3 jaar ipv 2 jaar.

Laatste advies van CiPHER Verwijderd in "Het grote DIY RAID NAS topic deel 3" maakte me bewust van de 5K3000 met de 512b sector-size.

Ik wil de schijven in of JBOD zetten, of in softraid RAID 5 (Linux, mdadm).

Ik wil 4x 2TB schijven halen, en de WD Green valt sowieso af

| Samsung HD204UI | Hitachi 5K3000 | ||

| Spin-up | 2A (max) | 1.2 (+5V) & 2.0 (+12V) | Samsung is iets zuiniger |

| Idle | 5,1 Watt | 4,4 Watt | Hitachi is iets zuiniger |

| Sector size | 4k | 512b | Voor raid is Hitachi beter |

| Garantie | 24mnd | 36mnd | Hitachi |

| SATA | SATA/300 | SATA/600 | Heb onboard SATA/300, dus maakt niet uit |

| Prijs | € 59,90 | € 63,90 € 62,90 | Samsung is iets goedkoper |

Het scheelt in aanschaf 4x € 4,00 € 3,00... van die € 16,00 € 12,00 lig ik niet wakker.

Ik zou wel graag zuinige schijven willen, maar als ik naar de specificaties kijk, is de Hitachi op papier zuiniger als deze idle draait. En het opstarten valt mee, ~30Watt(max) vs. 24Watt(max).

De garantie is natuurlijk handig, 3 jaar ipv 2 jaar.

Laatste advies van CiPHER Verwijderd in "Het grote DIY RAID NAS topic deel 3" maakte me bewust van de 5K3000 met de 512b sector-size.

Ik wil de schijven in of JBOD zetten, of in softraid RAID 5 (Linux, mdadm).

[ Voor 7% gewijzigd door iMars op 27-06-2011 15:23 . Reden: prijswijziging + links toevoegen ]

Heb zelf de Samsung 3x gekocht afgelopen weekend. Zijn gewoon snelle en stille disken. Prijs was bij mij de doorslag + bekend merk bij mij thuis.

Waarom valt de WD Green af als je ze niet in een hardwarematig RAID setup gaat gebruiken als ik vragen mag? Welke argumenten heb je hiervoor gebruikt?iMars schreef op maandag 27 juni 2011 @ 15:19:

Ok, ik ben er bijna over uit, maar wil toch jullie advies.

Ik wil 4x 2TB schijven halen, en de WD Green valt sowieso af

Ik wil de schijven in of JBOD zetten, of in softraid RAID 5 (Linux, mdadm).

Deze stonden ook bovenaan mijn lijst een paar dagen geleden, totdat ik de 5K3000 tegen kwam. De garantie (3 jaar ipv 2 jaar), sector-size en het geringe power consumption verschil, neig ik toch meer naar de Hitachi.DJ-Promo schreef op maandag 27 juni 2011 @ 15:24:

Heb zelf de Samsung 3x gekocht afgelopen weekend. Zijn gewoon snelle en stille disken. Prijs was bij mij de doorslag + bekend merk bij mij thuis.

Door mijn eerdere 'onderzoeken en vragen':redfoxert schreef op maandag 27 juni 2011 @ 15:24:

[...]

Waarom valt de WD Green af als je ze niet in een hardwarematig RAID setup gaat gebruiken als ik vragen mag? Welke argumenten heb je hiervoor gebruikt?

iMars in "Het grote DIY RAID NAS topic deel 3"

Verwijderd in "Het grote DIY RAID NAS topic deel 3"

De WD Green is iets langzamer, en duurder in aanschaf. Ook zijn ze niet geschikt voor hardware raid (mocht ik dat in de toekomst nemen, wat ik niet verwacht

[ Voor 27% gewijzigd door iMars op 27-06-2011 15:32 ]

Ze zijn niet eens echt zo zuinig en het hele gezeik met die head parking enzo komt de reputatie ook niet echt ten goede. 4K sectors is ook geen voordeel alhoewel ik geloof dat de genoemde hitachi's twijfel gevallen waren sommige mensen menen dat deze schijven ook advanced format schijven zijn.redfoxert schreef op maandag 27 juni 2011 @ 15:24:

[...]

Waarom valt de WD Green af als je ze niet in een hardwarematig RAID setup gaat gebruiken als ik vragen mag? Welke argumenten heb je hiervoor gebruikt?

Als dat zo is, sta ik als consument in mijn recht om de schijfen terug te geven. Er wordt expliciet aangegeven op hun website dat het 512b is (zie link in mijn eerdere postdutch_warrior schreef op maandag 27 juni 2011 @ 15:30:

[...]

Ze zijn niet eens echt zo zuinig en het hele gezeik met die head parking enzo komt de reputatie ook niet echt ten goede. 4K sectors is ook geen voordeel alhoewel ik geloof dat de genoemde hitachi's twijfel gevallen waren sommige mensen menen dat deze schijven ook advanced format schijven zijn.

Verwijderd

Hitachi 5K3000 heeft 512-byte sectors. Of dat een voordeel is weet ik niet zo gauw; je hebt namelijk wel minder ECC per sector; het zou prima kunnen zijn dat 4K sectors je minder bad sectors geeft omdat er meer errorcorrectie per sector aanwezig is (gek genoeg daalt het aantal correctie per gigabyte opslag).

Ook zou ik niet zeggen dat de Hitachi zuiniger is; StorageReview geeft de Samsung F4EG net 4W idle vermogen. Ik denk dat dat DC vermogen is; dus door je voeding inefficiency wordt dat nog iets hoger (4.4W?) - maar dat geldt voor andere schijven evengoed natuurlijk. Samsung F4EG is opzich wel een van de zuinigste 2TB schijven.

Ook gebruiken ze echt geen 2A (=24W) bij het opspinnen; eerder de helft hiervan: 12-16W ofzo. Hoe dat met Hitachi 5K3000 zit weet ik niet precies.

Ook moet je weten dat de Hitachi 5K3000 sneller leest dan het kan schrijven, bekijk deze grafiek maar eens:

http://i1034.photobucket....scherjm/Hitachi5K3000.png

Op basis hiervan zou ik zelf zeggen dat de Samsung F4EG de beste 2TB schijf is. Maar de 512-byte sectoren kan handig zijn als je een 4-disk RAID-Z wilt doen bijvoorbeeld; wat normaliter niet zo handig zou zijn voor 4K sectoren schijven. Dit geldt echter alleen voor ZFS setups. De extra garantie van Hitachi is wel een voordeel natuurlijk.

Ook zou ik niet zeggen dat de Hitachi zuiniger is; StorageReview geeft de Samsung F4EG net 4W idle vermogen. Ik denk dat dat DC vermogen is; dus door je voeding inefficiency wordt dat nog iets hoger (4.4W?) - maar dat geldt voor andere schijven evengoed natuurlijk. Samsung F4EG is opzich wel een van de zuinigste 2TB schijven.

Ook gebruiken ze echt geen 2A (=24W) bij het opspinnen; eerder de helft hiervan: 12-16W ofzo. Hoe dat met Hitachi 5K3000 zit weet ik niet precies.

Ook moet je weten dat de Hitachi 5K3000 sneller leest dan het kan schrijven, bekijk deze grafiek maar eens:

http://i1034.photobucket....scherjm/Hitachi5K3000.png

Op basis hiervan zou ik zelf zeggen dat de Samsung F4EG de beste 2TB schijf is. Maar de 512-byte sectoren kan handig zijn als je een 4-disk RAID-Z wilt doen bijvoorbeeld; wat normaliter niet zo handig zou zijn voor 4K sectoren schijven. Dit geldt echter alleen voor ZFS setups. De extra garantie van Hitachi is wel een voordeel natuurlijk.

Thnx voor het advies. RAID-Z valt voor mij (voor nu, en voorlopig) af. Heb een Intel Atom D525 met 4G ram, en dat is te weinig power en geheugen voor een 6TB RAID-Z. Ook de errorcorrectie klinkt interessant.Verwijderd schreef op maandag 27 juni 2011 @ 15:37:

Hitachi 5K3000 heeft 512-byte sectors. Of dat een voordeel is weet ik niet zo gauw; je hebt namelijk wel minder ECC per sector; het zou prima kunnen zijn dat 4K sectors je minder bad sectors geeft omdat er meer errorcorrectie per sector aanwezig is (gek genoeg daalt het aantal correctie per gigabyte opslag).

Ook zou ik niet zeggen dat de Hitachi zuiniger is; StorageReview geeft de Samsung F4EG net 4W idle vermogen. Ik denk dat dat DC vermogen is; dus door je voeding inefficiency wordt dat nog iets hoger (4.4W?) - maar dat geldt voor andere schijven evengoed natuurlijk. Samsung F4EG is opzich wel een van de zuinigste 2TB schijven.

Ook gebruiken ze echt geen 2A (=24W) bij het opspinnen; eerder de helft hiervan: 12-16W ofzo. Hoe dat met Hitachi 5K3000 zit weet ik niet precies.

Ook moet je weten dat de Hitachi 5K3000 sneller leest dan het kan schrijven, bekijk deze grafiek maar eens:

http://i1034.photobucket....scherjm/Hitachi5K3000.png

Op basis hiervan zou ik zelf zeggen dat de Samsung F4EG de beste 2TB schijf is. Maar de 512-byte sectoren kan handig zijn als je een 4-disk RAID-Z wilt doen bijvoorbeeld; wat normaliter niet zo handig zou zijn voor 4K sectoren schijven. Dit geldt echter alleen voor ZFS setups. De extra garantie van Hitachi is wel een voordeel natuurlijk.

Nu neig ik toch weer meer naar de F4EG... mede doordat de schrijfsnelheid hoger ligt

Verwijderd

Ik zou zeggen de Seagate 5900.3, deze heeft, naast AF, Sata-600, 64 MB en 5900 i.p.v. 5400. Wat is hier dan ook al weer mee dat jij deze niet de beste noemt?Verwijderd schreef op maandag 27 juni 2011 @ 15:37:

Op basis hiervan zou ik zelf zeggen dat de Samsung F4EG de beste 2TB schijf is.

(Ik laat de nieuwe 2 TB WD even buiten beschouwing omdat deze nog moeilijk verkrijgbaar/duur is.)

Ik heb toevallig een DL360 G5 staan en die trekt volgens iLO2 ~ 270W.FireDrunk schreef op maandag 27 juni 2011 @ 13:28:

[...]

Mis, servers zijn helemaal niet per definitie voor veel storage gebouwd, daar heb je NetApp's en EMC's voor.

Servers zijn vooral gemaakt om 24x7 te draaien. Ze zijn robuust en sommige componenten zijn redundant uitgevoerd. Maar al met al gebruiken ze _veel_ meer stroom dan iets wat je zelf bouwt.

Relevante specs:

2 x Dual Core Xeon 5160 3,0GHz

HP P400i SAS/RAID-controller + 256MB BBWC

4 x 146GB 10k RPM SFF SAS

Redundant aangesloten voeding

load average: 0.31, 0.28, 0.22

Ik heb geen flauw idee wat een zelfbouw zo gebruikt, maar zo op het oog valt nog wel mee vind ik. Hij maakt sowieso een teringherrie overigens, maar dat is wellicht met een beetje modden wel op te lossen.

Heb ook nog een DL380 G3 maar daarvan kan ik zo niet uitlezen hoeveel prik hij gebruikt.

12 × LG 330Wp (Enphase) | Daikin FTXM-N 3,5+2,0+2,0kW | Panasonic KIT-WC03J3E5 3kW

Uhm, aantal watt x2 is de jaarprijs (ongeveer) dus jou DL360 kost ruim 500 euro per jaar aan stroom.

Een leuke DIY RAID NAS bak met een i5-2500 (even snel als jou dual cores, zo niet sneller) een sloot geheugen en wat disks kost je 400-500 euro. Die zal met alles actief zo'n 100W en idle 50W verstoken.

Dit kost je dus ongeveer 150 euro per jaar, dat scheelt je dus 350 euro per jaar... Even rekenen maakt dat je dus een nieuwe server met 2 jaar terugverdient hebt...

Een leuke DIY RAID NAS bak met een i5-2500 (even snel als jou dual cores, zo niet sneller) een sloot geheugen en wat disks kost je 400-500 euro. Die zal met alles actief zo'n 100W en idle 50W verstoken.

Dit kost je dus ongeveer 150 euro per jaar, dat scheelt je dus 350 euro per jaar... Even rekenen maakt dat je dus een nieuwe server met 2 jaar terugverdient hebt...

Even niets...

Hmja, dat is wel een verschil inderdaad  . Maar hierbij dus wel de kanttekening dat in deze server 4 x 10k RPM SAS zit en de CPU niet dynamisch wordt ondergeklokt. Deze twee zaken zullen ook wel wat stroom trekken. Overigens hangen deze servers niet bij mij thuis in het rack

. Maar hierbij dus wel de kanttekening dat in deze server 4 x 10k RPM SAS zit en de CPU niet dynamisch wordt ondergeklokt. Deze twee zaken zullen ook wel wat stroom trekken. Overigens hangen deze servers niet bij mij thuis in het rack

12 × LG 330Wp (Enphase) | Daikin FTXM-N 3,5+2,0+2,0kW | Panasonic KIT-WC03J3E5 3kW

Het staat ook in de documentatie van die dc7280 controller: "Binary and source driver updates are routinely posted for a variety of older Linux operating systemsHarmoniousVibe schreef op maandag 27 juni 2011 @ 10:56:

[...]

De rr2340-driver zit sowieso niet in de kernel. Ze claimen dat hij open source is, maar het is niks meer dan een proprietary driver die in een open-source wrapper zit afaik. Dus het is niet gek dat hij er opeens mee kan ophouden na een kernelupgrade. Linux heeft immers geen stabiele ABI.

Ik zou een dergelijke kaart kosten wat kost mijden.

including past versions of Red Hat Enterprise, CentOS, OpenSuSE, and Fedora Core, SLES. "

Ik lees daar gewoon: "We brengen 1x een driver uit en verder zoekt de community het zelf maar uit"

Dus deze kaart gaat hoogstwaarschijnlijk de highpoint HBA traditie van matige unix ondersteuning voortzetten.

Mwoh, 2.5" 10k schijfjes vallen wel mee, 5-10W schat ik zo.

Die voedingen, het moederbord, en de CPU's zijn erger

Die voedingen, het moederbord, en de CPU's zijn erger

Even niets...

die voedingen van hp hebben vak maar een rendement van 65% heb die van mij toen vervangen voor een 80+ voeding scheelde me ruim 25 watt per uur.FireDrunk schreef op maandag 27 juni 2011 @ 18:11:

Mwoh, 2.5" 10k schijfjes vallen wel mee, 5-10W schat ik zo.

Die voedingen, het moederbord, en de CPU's zijn erger

There i fixed it for u !whocarez schreef op maandag 27 juni 2011 @ 19:10:

[...]

die voedingen van hp hebben vak maar een rendement van 65% heb die van mij toen vervangen voor een 80+ voeding scheelde me ruim 25 watt per uur.

Heuveltjes CPU geschiedenis door de jaren heen : AMD 486dx4 100, Cyrix PR166+, Intel P233MMX, Intel Celeron 366Mhz, AMD K6-450, AMD duron 600, AMD Thunderbird 1200mhz, AMD Athlon 64 x2 5600, AMD Phenom X3 720, Intel i5 4460, AMD Ryzen 5 3600 5800x3d

Hier even een screenshot van de WD20EARS

aangesloten op een Highpoint 2740 in Jbod als single disk

mischien ga ik toch voor de Samsung F4`s 2TB om de sectorsize ...

ben namelijk wel van plan om een aantal kleine raid arrays te maken

in ieder geval 1 voor de downloads en extracten alvorens te copieren

maar hoe meer ik lees hoe groter de vragen , blijft allemaal erg onduidelijk

kwa prijsverschil verschillen ze nauwelijks momenteel

en ook de WD20EARX met sata600 komt aardig in de buurt

ik heb alleen nog geen testresultaat gezien van deze laatste, ben toch erg benieuwd

of de SATA600 nog enigsinds iets uitmaakt tenopzichte van de EARS, denk t niet veel

maar toch .. alles is meegenomen natuurlijk als de prijs toch al niet veel scheeld ..

aangesloten op een Highpoint 2740 in Jbod als single disk

mischien ga ik toch voor de Samsung F4`s 2TB om de sectorsize ...

ben namelijk wel van plan om een aantal kleine raid arrays te maken

in ieder geval 1 voor de downloads en extracten alvorens te copieren

maar hoe meer ik lees hoe groter de vragen , blijft allemaal erg onduidelijk

kwa prijsverschil verschillen ze nauwelijks momenteel

en ook de WD20EARX met sata600 komt aardig in de buurt