Even niets...

Top 10 van de grootste nassen hier

De eerste 10 zullen vast hele grote zijn en lijkt mij wel leuk als die lijst af en toe wat wisselt...

Server 1: Intel N305 | 48GB RAM | 5*4TB NVME | 4x 2.5GbE

Server 2: Intel N5105 | 64GB RAM | 1TB NVME | 4x 2.5GbE

Server 3: Intel Xeon E5-2670 | 128GB RAM | 512+750GB SATA SSD | 6x10TB HDD | 6x 1GbE [Buiten gebruik]

Do diamonds shine on the dark side of the moon :?

[ Voor 3% gewijzigd door FireDrunk op 01-05-2011 13:53 ]

Even niets...

Is wel veel werk... * 0rbit sluipt zachtjes het topic weer uit

Ik ben geheel voldaan, dank u wel!

Even niets...

CPU

Mobo

Mem

Disken

Behuizing

eventueel: extra nic, raid controller, disk frames

OS, raid level en meer ???

Foto erbij lijkt me wel een belangrijk punt

nee user linkje naar zijn forumpostDJ-Promo schreef op zondag 01 mei 2011 @ 14:03:

Zomaar een lijstje:

CPU

Mobo

Mem

Disken

Behuizing

eventueel: extra nic, raid controller, disk frames

OS, raid level en meer ???

Foto erbij lijkt me wel een belangrijk punt.

Ik overweeg om mij SASUCI8I + 2x SAS to SATA kabels te verkopen (net gekocht bij Azerty)brid schreef op donderdag 28 april 2011 @ 09:56:

Voor de zekerheid hier even m'n vraag droppen.

Ben van plan om een Intel RAID Controller SASUC8I aan te gaan schaffen.

Wat ik hier vind en op andere plekken is het een kwestie van de juiste LSI TI mode flashen om te zorgen dat deze op een none EFI systeem werkt.

Klopt mijn aanname dat het daarna disken er aan hangen en alles onder debian squeeze automagisch werkt of zijn er nog extra akties nodig om de schijven te kunnen gebruiken behalve raid partition aanmaken en een mdadm raid set aanmaken?

Reeds geflashed naar LSI.

Reden is dat hij niet werkt op Asus e35m1-pro. (Werkt wel op andere mobo's)

Als je WD 3tb koopt krijg je daar blijkbaar telkens een RocketRaid 62X/62XM kaartje bij. Nu ken ik iemand die 8 van die schijven heeft gekocht. 2 van die kaartjes op mijn Zacate bordje en ik kan 9 schijven aansluiten. Heb reeds een testopstelling gedaan met FreeNAS en ZFS, en het is perfect mogelijk om die schijven gewoon van onboard naar RocketRAID te versteken zonder dat de array offline gaat (met pc uit weliswaar).

Weet iemand of Realtek 8111E Gigabit LAN werkt op FreeBSD (onboard bij asus e35m1-pro)? Mij lukt het met FreeNAS.

raid-level

aantal disken

bruto size

netto size

verbruik idle/load

Even niets...

Ik zou zo'n tabelletje ook voor onderhoudbaarheid zo klein mogelijk houden. Dus netto capaciteit. Misschien nog RAID level er bij en aantal disks. Als je gaat investeren in een grote build dan weet je dat idle verbruik gewoon niet meer iets is waar je je zorgen over moet gaan maken.redfoxert schreef op zondag 01 mei 2011 @ 14:28:

Persoonlijk vind ik de volgende items veel meer van belang:

raid-level

aantal disken

bruto size

netto size

verbruik idle/load

Wat is nu het absolute minimum wat je wilt weten?

1. De bruikbare capciteit.

Dit is waar het om gaat.

2. RAID level

Do you feel lucky, phunk?

3. Hoeveel disks

Kun je zelf al heel snel zien wat de capaciteit is per disk.

4. Platform

5. Wat opmerkingen.

Voorbeeldje

| User | Netto capacity | RAID Level | # of disks | Platform | Remarks |

| Q | 18 TB | RAID 6 | 20 | Linux | MDADM software RAID, single array. |

[ Voor 39% gewijzigd door Q op 01-05-2011 16:07 ]

Ja dat is nuttig... met raid-level en het aantal disken+type kan ik zelf wel bruto en netto grootte berekenen.redfoxert schreef op zondag 01 mei 2011 @ 14:28:

Persoonlijk vind ik de volgende items veel meer van belang:

raid-level

aantal disken

bruto size

netto size

verbruik idle/load

Ik ben geheel voldaan, dank u wel!

I agree, goed voorbeeld Q!Q schreef op zondag 01 mei 2011 @ 15:54:

[...]

Ik zou zo'n tabelletje ook voor onderhoudbaarheid zo klein mogelijk houden. Dus netto capaciteit. Misschien nog RAID level er bij en aantal disks. Als je gaat investeren in een grote build dan weet je dat idle verbruik gewoon niet meer iets is waar je je zorgen over moet gaan maken.

Wat is nu het absolute minimum wat je wilt weten?

1. De bruikbare capciteit.

Dit is waar het om gaat.

2. RAID level

Do you feel lucky, phunk?

3. Hoeveel disks

Kun je zelf al heel snel zien wat de capaciteit is per disk.

4. Platform

5. Wat opmerkingen.

Voorbeeldje

User Netto capacity RAID Level # of disks Platform Remarks Q 18 TB RAID 6 20 Linux MDADM software RAID, single array.

| User | Netto capacity | RAID Level | # of disks | Platform | Remarks |

| Q | 18 TB | RAID 6 | 20 | Linux | MDADM software RAID, single array. |

| FireDrunk | 10+ TB | RAID 6 | 8*1.5TB + 4*2TB | Linux / ZFS | MDADM software RAID6 /ZFS tryout |

Maar aan de andere kant willen mensen vaak ook wel weten watvoor cpu/mobo combinatie je draait...

Even niets...

Nu zit ik met de vraag of een van de sas backplanes ook los te halen zijn van de hotswapbays , zodat je toch nog de bays kan gebruiken maar op de normale manier kan aansluiten ? dit omdat ik in eerste insantie een mix wil maken tussen moederbord aansluitingen en sas controllerkaart.

Het is me niet echt duidelijk hoe die backplanes gemonteerd zijn aan elkaar.

Ook zou ik graag exacte afmeting willen hebben tussen moederbord tray (bodem) en t deksel ,

het is denk ik zeer krap, of niet mogelijk om me huidige cpu koeler te monteren (Prolimatec)

het zal heel weinig schelen maar ben bang dat t net niet kan, anders zit ik te denken aan een WC setje van Corsair de H70 en die in de zikant of achteraan de kast te monteren , half in de zijkant lijkt me beste aangezien ik in principe wat ruimte over zou hebben tussen moederbord en de kast .

Mooier zou zijn een 5U model voor nog wat meer vrijheid ...

Wat ik zeker zal doen is de interne fans vervangen door 3x 120 fans met goede flow , want ik weet ook uit ervaring dat die serverfans straaljagers zijn.

We kunnen zo een top maken, maar we kunnen er ook een linkje bijzetten naar de laatste forumpost, waar alle specs staanFireDrunk schreef op zondag 01 mei 2011 @ 16:12:

[...]

I agree, goed voorbeeld Q!

User Netto capacity RAID Level # of disks Platform Remarks Q 18 TB RAID 6 20 Linux MDADM software RAID, single array. FireDrunk 10+ TB RAID 6 8*1.5TB + 4*2TB Linux / ZFS MDADM software RAID6 /ZFS tryout

Maar aan de andere kant willen mensen vaak ook wel weten watvoor cpu/mobo combinatie je draait...

Ik heb een link gemaakt van mijn forum naam naar de pagina met alle specs van mijn server. Ik denk dat het handig is om dat op die manier aan te pakken, ook voor de anderen.DJ-Visto schreef op zondag 01 mei 2011 @ 16:43:

[...]

We kunnen zo een top maken, maar we kunnen er ook een linkje bijzetten naar de laatste forumpost, waar alle specs staan

Ondanks dat ik het leuk vind om naar mijn eigen blog te linken is het beter om naar forum posts te linken: blogs gaan dood en kapotte links is zonde.

In de link verwijs je dan naar alle aanvullende specs, zoals cpu, mobo, ram, raid/sata controllers, behuizingen.

De essentie van deze lijst is de storage. Dus capaciteit en opbouw.

[ Voor 39% gewijzigd door Q op 01-05-2011 18:57 ]

Ik heb hier een norco 4224 kast klaarliggen en daar kan je gewoon die backplanes afhalen door 3 boutjes los te maken. Volgens een afbeelding van de norcotek site gebruiken ze dezelfde pcb'tjes dus zal dat wel lukken. (link)parcifal schreef op zondag 01 mei 2011 @ 16:16:

Nu zit ik met de vraag of een van de sas backplanes ook los te halen zijn van de hotswapbays , zodat je toch nog de bays kan gebruiken maar op de normale manier kan aansluiten ?

De hoogte is ergens rond de 16 cm dacht ik. -EDIT: net even nagemeten en het zal 15,9 cm zijn tot bovenplaat.-

[ Voor 5% gewijzigd door KDVken op 01-05-2011 23:06 ]

Met een machine als dit waar je 16 disks in gaat stoppen heb je gewoon een goede airflow nodig en dat geeft gewoon wat herrie. Inzet van WC lijkt me zonde van het geld, ik zie niet hoe je ook de HD's via WC gaat koelen. Doe je dat niet, heb je alsnog flink wat fans nodig om een goede airflow te behouden.

Monteer gewoon een stock koelertje, prima zat. Ga jezelf geen onnodige toeren op de hals halen.

Voor dit soort kasten heb je een ruimte nodig die:

1. het geluid voor de rest van de woning kan afschermen

2. de warmte voldoende kan absorberen/afvoeren.

[ Voor 7% gewijzigd door Q op 01-05-2011 22:51 ]

Mijn dank ! lijkt idd wel op dezelfde manier te zijn gedaan voor de verschillende Norco`sKDVken schreef op zondag 01 mei 2011 @ 22:46:

[...]

Ik heb hier een norco 4224 kast klaarliggen en daar kan je gewoon die backplanes afhalen door 3 boutjes los te maken. Volgens een afbeelding van de norcotek site gebruiken ze dezelfde pcb'tjes dus zal dat wel lukken. (link)

De hoogte is ergens rond de 16 cm dacht ik. -EDIT: net even nagemeten en het zal 15,9 cm zijn tot bovenplaat.-

dan zal t vast lukken .

Met de hoogte ben ik niet zo blij mee , naja is niet anders , moet ik toch vervanger zoeken voor me koeler

een fixed H70 setje lijkt me niet verkeerd al is t wat hobbywerk voor t monteren van de rad , het blokje zelf is klein en is dan natuurlijk weer bevordelijk voor de airflow door de kast heen naar achter.

andere optie een Noctua die hebben wat lagere modellen koelers zelf s nog met 140mm fan ..

heb nog de tijd want financien staan ook nog niet zo best lol.

Momenteel gebruik ik nog een zelfgemaakte HDD houder, gemaakt met een paar plexi panelen met 3 * 120mm fans tegen. Geeft meer dan genoeg airflow om 16 schijven te koelen in een soort "tunnel" en maakt niet te veel lawaai. (De pc waar het op aangesloten is -Dell powerEdge 2650- daarentegen maakt enorm veel lawaai!

Binnenkort ga ik de schijven versteken, komt er een nieuwe controller (areca!), nieuwe hardware en komen er nog 8 schijven bij

Ja daar ben ik me bewust van , met wat proberen en meten moet er toch wel een goede compromie zijn te vinden om dit te realiseren.Q schreef op zondag 01 mei 2011 @ 22:50:

[...]

Met een machine als dit waar je 16 disks in gaat stoppen heb je gewoon een goede airflow nodig en dat geeft gewoon wat herrie. Inzet van WC lijkt me zonde van het geld, ik zie niet hoe je ook de HD's via WC gaat koelen. Doe je dat niet, heb je alsnog flink wat fans nodig om een goede airflow te behouden.

Monteer gewoon een stock koelertje, prima zat. Ga jezelf geen onnodige toeren op de hals halen.

Voor dit soort kasten heb je een ruimte nodig die:

1. het geluid voor de rest van de woning kan afschermen

2. de warmte voldoende kan absorberen/afvoeren.

ik heb ervaring met een 4U kast met daarin een dual xeon cpu en die houd t heel aardig kwa temps met 2 towers van koelers en gebruikmakend van een stille enkele 120 mm fan die beide cpu`s tegelijk koelt en dat lukte heel aardig , ook voorin de kast diverse schijven wat wel zo beetje overeen komt met wat ik nu wil gaan doen, in die kast heb ik 2 x 120 mm fan in t front zitten ipv achter de schijven.

Super , dat zie ik graag beetje modden kan geen kwaad he -) en tis leuk om te doen ,KDVken schreef op zondag 01 mei 2011 @ 23:26:

De herrie valt wel mee als je de 3*120 mm fan bracket gebruikt van norco ipv de 4*80mm. Ik heb ze alle 2 al eens getest in mijn kast en de 120mm's gaven mij meer airflow als de 80's. (en zijn stiller als de 80mm)

Momenteel gebruik ik nog een zelfgemaakte HDD houder, gemaakt met een paar plexi panelen met 3 * 120mm fans tegen. Geeft meer dan genoeg airflow om 16 schijven te koelen in een soort "tunnel" en maakt niet te veel lawaai. (De pc waar het op aangesloten is -Dell powerEdge 2650- daarentegen maakt enorm veel lawaai!)

Binnenkort ga ik de schijven versteken, komt er een nieuwe controller (areca!), nieuwe hardware en komen er nog 8 schijven bij

ik heb die optie bracket ook gezien en die ga ik ook wel meebestellen als me budget er toe reikt of maak em gewoon zelf , 3x 120 zal idd stuk stiller zijn absoluut.

ik gebruik een Highpoint 16 poort sas 600 controller dus daar kom ik niet tekort aan

Het gaat wat kosten voor wat kabeltjes sas 8087 naar sas 8087 en wat anderen maar dat is wel enorm voordeel voor de kabelmanagment om t een beetje in toom te houden, heerlijk zo systeem

Verwijderd

zo krijg je natuurlijk veel 'wie heeft de grootste'..Q schreef op zondag 01 mei 2011 @ 15:54:

[...]

Ik zou zo'n tabelletje ook voor onderhoudbaarheid zo klein mogelijk houden. Dus netto capaciteit. Misschien nog RAID level er bij en aantal disks. Als je gaat investeren in een grote build dan weet je dat idle verbruik gewoon niet meer iets is waar je je zorgen over moet gaan maken.

Wat is nu het absolute minimum wat je wilt weten?

1. De bruikbare capciteit.

Dit is waar het om gaat.

2. RAID level

Do you feel lucky, phunk?

3. Hoeveel disks

Kun je zelf al heel snel zien wat de capaciteit is per disk.

4. Platform

5. Wat opmerkingen.

Voorbeeldje

User Netto capacity RAID Level # of disks Platform Remarks Q 18 TB RAID 6 20 Linux MDADM software RAID, single array.

terwijl veel DIY nassers graag willen weten welke processor/mobo/mem/controllers/os en natuurlijk liefsts wat snelheids benchmarks, het is toch helemaal niet interessant om te weten of er nou 12 of 24 TB bruto inzit ?? zonder verdere info.. imho natuurlijk.

Jij introduceert nu een wedstrijdje 'wie heeft de snelheid'. Misschien is die iets interessanter (je kunt op meerdere manieren hoog in de rankings komen), maar is ook niet echt iets wat ik graag genoemd zou willen hebben bij een weerspiegeling van mijn tien grootste prestaties in mijn leven.

Laat gewoon los dat er een wedstrijd kan ontstaan, maar laat het wel zo staan. Het voordeel van deze manier van weergeven is dat je makkelijk kunt zien wat je moet doen om X schijven aan te sturen. Tegenwoordig zijn de processor en het moederbord niet echt een issue meer, de schijven zorgen voor zware voedingen, grote kasten, warmte, geluid, ... Dus hoe gaat Q om met twintig schijven. Waarom kiest hij voor Raid6 en niet 2x Raid6? Zou je de lijst naar snelheid omzetten dan zou Q opeens lager kunnen eindigen (niet dat het zal gebeuren) als er opeens een set mensen komen die met een ziekelijke hoeveelheid ram of met de snelste SSDs gigabytes aan data kunnen cachen.

Voor de rest is een lijstje natuurlijk leuk en je kunt er nog een hall of fame bij bouwen en wat al niet meer. Maar een informatieve startpost schiet veel meer op. Waarom Raid6 en wanneer is Raid6 onvoldoende, welke voeding voor twintig schijven, een goede behuizing voor twaalf schijven en is een Intel gigabit kaartje nu echt beter dan een onboard Realtek?

Als we allemaal een goede inventaris maken en alleen ons raid level en het verbruik vermelden met wat opmerkingen komen we er ook wel denk ik?

Even niets...

Verwijderd

toen ik een paar maanden geleden vond dat ik meer behoefte aan opslag had en de vraag 'kopen of zelf bouwen ?' speelde.. wilde ik natuurlijk graag weten 'wat moet ik aanschaffen om dat resultaat te verkrijgen'..Dadona schreef op maandag 02 mei 2011 @ 11:28:

Linksom of rechtsom, je krijgt altijd een 'wedstrijd'.

Jij introduceert nu een wedstrijdje 'wie heeft de snelheid'. Misschien is die iets interessanter (je kunt op meerdere manieren hoog in de rankings komen), maar is ook niet echt iets wat ik graag genoemd zou willen hebben bij een weerspiegeling van mijn tien grootste prestaties in mijn leven.

Laat gewoon los dat er een wedstrijd kan ontstaan, maar laat het wel zo staan. Het voordeel van deze manier van weergeven is dat je makkelijk kunt zien wat je moet doen om X schijven aan te sturen. Tegenwoordig zijn de processor en het moederbord niet echt een issue meer, de schijven zorgen voor zware voedingen, grote kasten, warmte, geluid, ... Dus hoe gaat Q om met twintig schijven. Waarom kiest hij voor Raid6 en niet 2x Raid6? Zou je de lijst naar snelheid omzetten dan zou Q opeens lager kunnen eindigen (niet dat het zal gebeuren) als er opeens een set mensen komen die met een ziekelijke hoeveelheid ram of met de snelste SSDs gigabytes aan data kunnen cachen.

Voor de rest is een lijstje natuurlijk leuk en je kunt er nog een hall of fame bij bouwen en wat al niet meer. Maar een informatieve startpost schiet veel meer op. Waarom Raid6 en wanneer is Raid6 onvoldoende, welke voeding voor twintig schijven, een goede behuizing voor twaalf schijven en is een Intel gigabit kaartje nu echt beter dan een onboard Realtek?

de een wil graag zo zuinig mogelijk.. de ander zo snel mogelijk en weer een ander zo groot mogelijk... en iedereen wil zo goedkoop en BETROUWBAAR mogelijk ..

van belang is dan 'wat was het doel van de DIY' ?

hoe dan ook.. voor al deze 'vormen' is meer info van belang.. of je moet 100 pagina's gaan doorspitten en tientallen websites willen bezoeken (zoals ik gedaan heb).

Thanks for your information. I have forwarded this to our development department. Hopefully they can fix this in a future BIOS update as have been done for the Areca card. I'm however unable to tell you how fast this can happen or give a timeframe.

Mogelijks komt het dus toch in orde.

Ik had ook graag eens geweten wie er ZFS op een Atom heeft draaien, en welke de snelheden zijn die over netwerk behaald worden..

Maar goed, het boeit allemaal niet echt. Knal gewoon een lijstje neer en laat het gewoon bij de opslagruimte. In datzelfde lijstje dan gewoon een link naar een reactie waarin je helemaal los gaat en je hebt je doel wel bereikt. Eventueel kun je nog overwegen om later drie systemen te selecteren en die terug te laten komen in de startpost (of tweede post) die low, medium en highend moeten voorstellen, waarbij je alle performance cijfers te zien krijgt.

Maar het is gewoon een leuk lijstje, maak er geen halszaak van. Zelfbouw met recente schijven brengt je al snel voorbij de gigabit grens. Lukt dat niet, dan gaat het vaak fout bij software (samba brak, vanuit een vm, ..).

Verwijderd

Ik heb een Zotac D510 Atom bordje met gigabit onboard en daar draait ZFS prima op. 64-bit BSD distributie en 4GiB RAM en ZFS zonder fratsen (geen encryptie/compressie/dedup) - haalde zeker 70MB/s.Arnoud1 schreef op maandag 02 mei 2011 @ 12:21:

Ik had ook graag eens geweten wie er ZFS op een Atom heeft draaien, en welke de snelheden zijn die over netwerk behaald worden..

Wil je wat extra's gaan doen dan kom je al gauw tekort natuurlijk, compressie is bijna niet te doen met Atom. Ook ben je beperkt tot 4GiB RAM dus als je nog geen Atom hebt zou ik hem ook niet kopen als je een ZFS platform wilt. Voor conventioneel RAID zou het prima zijn.

Ook doet normaal Atom geen DDR3; alleen DDR2. Je hebt een Atom D525 nodig voor DDR3 support - veel goedkoper dan DDR2. 65 euro voor 8GiB (2x4G). Zacate is veel cooler platform voor ZFS dus, bovendien krijg je 6x SATA/600 van AMD wat kicken is. En veel lager energieverbruik.

Atom verbruikt evenveel energie als een Core i3 setup; dus echt veel voordelen heeft het niet. Ik kan daarom geen Atom meer aanraden. Zodra je een Intel SASUC8i op een Zacate bordje kunt draaien lijkt me dat de beste keus - en anders gewoon een Core i3 mini-ITX setup ofzo.

De onboard ethernet chip op mijn mobo ondersteunt Gigabit ethernet, maar mijn switch is slechts 10/100 Mbps. Binnen een paar weken schaf ik sowieso een 3x2TB aan zodat ik ze met mdadm in RAID5 kan plaatsen. Zou een gigabit switch met jumbo frames en een nieuwe netwerkkaart die ook jumbo frames ondersteunt (mijn huidige onboard chip kan dit niet) de extra investering waard zijn?

Ikzelf heb zo'n Zacate waar ik dus 2 Rocketraid 620 kaartjes bij ga steken (PCIe 2.0 @1x en 2xSATA-600).Verwijderd schreef op maandag 02 mei 2011 @ 12:29:

[...]

Ik heb een Zotac D510 Atom bordje met gigabit onboard en daar draait ZFS prima op. 64-bit BSD distributie en 4GiB RAM en ZFS zonder fratsen (geen encryptie/compressie/dedup) - haalde zeker 70MB/s.

Wil je wat extra's gaan doen dan kom je al gauw tekort natuurlijk, compressie is bijna niet te doen met Atom. Ook ben je beperkt tot 4GiB RAM dus als je nog geen Atom hebt zou ik hem ook niet kopen als je een ZFS platform wilt. Voor conventioneel RAID zou het prima zijn.

Ook doet normaal Atom geen DDR3; alleen DDR2. Je hebt een Atom D525 nodig voor DDR3 support - veel goedkoper dan DDR2. 65 euro voor 8GiB (2x4G). Zacate is veel cooler platform voor ZFS dus, bovendien krijg je 6x SATA/600 van AMD wat kicken is. En veel lager energieverbruik.

Atom verbruikt evenveel energie als een Core i3 setup; dus echt veel voordelen heeft het niet. Ik kan daarom geen Atom meer aanraden. Zodra je een Intel SASUC8i op een Zacate bordje kunt draaien lijkt me dat de beste keus - en anders gewoon een Core i3 mini-ITX setup ofzo.

Die Rocketraid 620 kaartjes komen gratis bij 3TB WD schijven!!

Totaal is dan 9x Sata-600 + 1x e-sata-600

Later probeer ik dan weer met die SASUC8i, of die verkoop ik (ik twijfel nog)

Vraag over Atom is omdat ik wil vergelijken met wat die Zacate doet (nu slechts 23Mb/sec onder freenas) en mijn huidige setup (Celeron D420) die met moeite 20Mb/sec haalt (zowel met 2Gb als 4Gb getest...)

Cpu lijkt toch ook een impact te hebben op ZFS, en ik heb het dan niet over compressie.

Je geeft aan een 10/100 Mbps switch te hebben. Dit resulteert natuurlijk in de 12MB/sec die je maximaal haalt via samba. Upgrade je switch naar een fatsoenlijke gigabit switch, hoeft niet eens jumbo frames te zijn en je snelheden zullen flink toenemen.SanderH_ schreef op maandag 02 mei 2011 @ 12:41:

Ik heb een oude S775 bord met een E5500 en 2GB RAM. Hier draait debian op met momenteel één enkele systeemschijf. Via samba haal ik momenteel een bedroevende 12 MB/s. Het streamen van HD content hapert dan ook.

De onboard ethernet chip op mijn mobo ondersteunt Gigabit ethernet, maar mijn switch is slechts 10/100 Mbps. Binnen een paar weken schaf ik sowieso een 3x2TB aan zodat ik ze met mdadm in RAID5 kan plaatsen. Zou een gigabit switch met jumbo frames en een nieuwe netwerkkaart die ook jumbo frames ondersteunt (mijn huidige onboard chip kan dit niet) de extra investering waard zijn?

Ik haal met een HP Procurve 1400-8G gewoon de volle gigabit zonder jumbo frames. (inmiddels opgevolgd door pricewatch: HP Procurve V1410-8G )

[ Voor 10% gewijzigd door Black_Adder op 02-05-2011 12:47 ]

12MB/s is extreem goed voor 100Mbps, gewoon 1000Mbps switch kopen (en Cat5e kabels of beter).SanderH_ schreef op maandag 02 mei 2011 @ 12:41:

Ik heb een oud S775 bord met een E5500 en 2GB RAM. Hier draait debian op met momenteel één enkele systeemschijf. Via samba haal ik momenteel een bedroevende 12 MB/s. Het streamen van HD content hapert dan ook.

De onboard ethernet chip op mijn mobo ondersteunt Gigabit ethernet, maar mijn switch is slechts 10/100 Mbps. Binnen een paar weken schaf ik sowieso een 3x2TB aan zodat ik ze met mdadm in RAID5 kan plaatsen. Zou een gigabit switch met jumbo frames en een nieuwe netwerkkaart die ook jumbo frames ondersteunt (mijn huidige onboard chip kan dit niet) de extra investering waard zijn?

Jumbo frames kan ik moeilijk aanraden. Daar heb je vaak meer snelheidsverlies mee...

Met jumbo frames kunnen er toch veel minder maar grotere ethernet frames worden verzonden.. hoe kan dit dan negatief uitdraaien?

Verwijderd

mooi en terecht dat ze er naar gaan kijken, het is een heel mooi bordje, wellicht niet zo snel maar wel zuinig.Arnoud1 schreef op maandag 02 mei 2011 @ 12:21:

Over de E35M1-M PRO en LSI of Intel SASUC8I lees ik op het forum van Asus nu het volgende:

Thanks for your information. I have forwarded this to our development department. Hopefully they can fix this in a future BIOS update as have been done for the Areca card. I'm however unable to tell you how fast this can happen or give a timeframe.

Mogelijks komt het dus toch in orde.

Ik had ook graag eens geweten wie er ZFS op een Atom heeft draaien, en welke de snelheden zijn die over netwerk behaald worden..

Verwijderd

Je grootste bottleneck zal de software zijn; niet de hardware. Gebruik je FreeNAS 8 of de ouderwetse 7.x releases? Je dient handmatig tuning uit te voeren om optimale performance te krijgen. Ook moet je netwerk in orde zijn en je client moet ook geen bottleneck vormen (Windows 7). Ook mag je absoluut geen PCI gebruiken; daar kan je performance enorm door kelderen.Arnoud1 schreef op maandag 02 mei 2011 @ 12:44:

Vraag over Atom is omdat ik wil vergelijken met wat die Zacate doet (nu slechts 23Mb/sec onder freenas) en mijn huidige setup (Celeron D420) die met moeite 20Mb/sec haalt (zowel met 2Gb als 4Gb getest...)

Cpu lijkt toch ook een impact te hebben op ZFS, en ik heb het dan niet over compressie.

CPU is niet zo belangrijk voor ZFS als je geen extra opties gebruikt. Atom levert al genoeg CPU kracht om 2GB/s aan XOR te doen en 100MB/s netwerk throughput te halen.

Heb je al met iPerf getest dat je 950 megabit bandbreedte haalt? Heb je daarna met tmpfs getest om ZFS uit te sluiten? Als je daarbij geen goede performance krijgt, zal dat met ZFS natuurlijk ook niet gaan lukken.

Heb je CIFS met async I/O geprobeerd? Ook NFS, iSCSI en/of FTP?

Misschien niet negatief, maar is de extra investering in mijn ogen niet waard. Het verschil tussen een dure en goedkope switch zal misschien niet zo groot zijn, zolang je merken als Sweex e.d links laat liggen.SanderH_ schreef op maandag 02 mei 2011 @ 12:51:

CAT5e kabels heb ik hier al liggen dus dat is al mooi. Klopt het dat er quasi geen verschil is qua snelheid tussen een goedkope switch en een iets duurdere?

Met jumbo frames kunnen er toch veel minder maar grotere ethernet frames worden verzonden.. hoe kan dit dan negatief uitdraaien?

Je kunt eventueel ook gaan voor een reverse breakout cable.parcifal schreef op zondag 01 mei 2011 @ 16:16:

Nu zit ik met de vraag of een van de sas backplanes ook los te halen zijn van de hotswapbays , zodat je toch nog de bays kan gebruiken maar op de normale manier kan aansluiten ? dit omdat ik in eerste insantie een mix wil maken tussen moederbord aansluitingen en sas controllerkaart.

Het is me niet echt duidelijk hoe die backplanes gemonteerd zijn aan elkaar.

Deze heb ik toevallig vorige week ook besteld om 4 van de 6 SATA aansluitingen van mijn moederbord te verbinden met de backplane van mijn Norco RPC-4224.

server: DUAL 1800+mp 3x80gb raid 5 +2x40+1x10 2 x 300gb maxtor HD, Nvidia Gforce3 128MB DDR

Verwijderd

Ik heb deze reactie helemaal over het hoofd gezienQ schreef op vrijdag 22 april 2011 @ 10:54:

[...]

Wat voor controller ga je gebruiken en gaan er ook 24 disks in? (Zou vet zijn!)

De NAS is op basis van de volgende componenten:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon X3440 | € 179,30 | € 179,30 |

| 1 | Corsair Flash Voyager Mini 4GB Zwart | € 8,28 | € 8,28 |

| 1 | Corsair Flash Voyager Mini 8GB Zwart | € 14,47 | € 14,47 |

| 10 | Western Digital Caviar GreenPower WD20EARS, 2TB | € 55,95 | € 559,50 |

| 1 | Corsair AX750 | € 129,06 | € 129,06 |

| 1 | Kingston ValueRAM KVR1333D3E9SK2/8G | € 109,85 | € 109,85 |

| 1 | Supermicro X8SI6-F-O | € 245,- | € 245,- |

| Bekijk collectie Importeer producten | Totaal | € 1.245,46 | |

De 10 2TB disks zijn aangesloten op de 2 SAS en 2 van de 6 sata poorten van het moederbord, en zijn geconfigureerd in een raidz2 setting in FreeNAS, netto leverd dit 14,2TB diskspace op.

FreeNAS 8 RC4 is geïnstalleerd op 1 van de 2 meebestelde USB sticks, ik ben nog aan het experimenteren met de installatie van FreeBSD op de andere stick, hiervoor moet ik mij nog verder inlezen.

Momenteel ben ik alle data van een QNAP met 5 x 1,5TB, en een conceptronics nas met 2 x 1TB, en een aantal losse disks aan het overpompen, ik verwacht ongeveer 7TB aan data te hebben, voorlopig stop ik dus nog geen extra disks bij, ik hoop het te kunnen redden totdat de 4TB disks op het zelfde prijsniveau liggen als de 2TB modellen nu.

server: DUAL 1800+mp 3x80gb raid 5 +2x40+1x10 2 x 300gb maxtor HD, Nvidia Gforce3 128MB DDR

Even niets...

Verwijderd

zelf weleens gefilmd op 1080 hd ? pffffffff .. en je wil niets weggooien heFireDrunk schreef op maandag 02 mei 2011 @ 14:15:

Wat heb je in vredesnaam voor data?Is jou pr0n collectie _ZO_ groot??

of is dat buiten de GoT policy?

Even niets...

Ik heb 4 bewakingscamera's in huis welke 24/7 in 1080P opnemen, deze opnamen (2880 uur) worden een maand bewaard, in de slaapkamer leid dit stelselmatig tot p0rn0FireDrunk schreef op maandag 02 mei 2011 @ 14:15:

Wat heb je in vredesnaam voor data?Is jou pr0n collectie _ZO_ groot??

Het schijfruimtegebruik loopt dan best de pan uit.

Daarnaas heb ik uiteraard ook mijn blu-ray en cd collectie geript en opgeslagen op de NAS welke met XBMC ontsloten worden in de HT.

NB. De Free BSD installatie wil ik doen op de 4GB USB stick, welke partitionering is in deze de meest geschikte?

Ik maak gebruik van 8 GB ECC ram, dit wordt later eventueel nog uitgebreid naar 16 GB, dien ik dan toch een swap partitie op de USB de definiëren?

[ Voor 19% gewijzigd door BOUBOU op 02-05-2011 17:57 ]

server: DUAL 1800+mp 3x80gb raid 5 +2x40+1x10 2 x 300gb maxtor HD, Nvidia Gforce3 128MB DDR

Of dat voor FreeBSD geld weet ik niet.

Even niets...

Tja, minder opmerkingen en wat extra kolommetjes kan ook. Een hal of fame is toch leuk? Lampie1979 etc. Doet hard forum ook en het is gewoon gaaf om te zien wat voor builds mensen allemaal maken.FireDrunk schreef op maandag 02 mei 2011 @ 11:48:

Ook allemaal valide punten, maar alles heeft zo zijn voor en nadelen. We roepen allemaal al heel lang om een Hall of Fame, maar er komt steeds maar niks van...

Als we allemaal een goede inventaris maken en alleen ons raid level en het verbruik vermelden met wat opmerkingen komen we er ook wel denk ik?

Dat heeft een 'wie heeft de grootste' factor, maar het is ook gewoon leuk om te zien en om naar te smachten. Ik heb zeker niet de grootste in dit forum. Maar zo'n overzicht is toch leuk?

Mensen zien al die builds en komen zelf zo ook weer op ideeën en kunnen ook zien wat ze er van kunnen verwachten. Vergeet ook de links naar individuele posts niet.

[ Voor 11% gewijzigd door Q op 02-05-2011 20:13 ]

Zou het niet ironisch zijn als ik je 4 1080p camera's en je vette storage kom stelen?BOUBOU schreef op maandag 02 mei 2011 @ 17:54:

[...]

Ik heb 4 bewakingscamera's in huis welke 24/7 in 1080P opnemen, deze opnamen (2880 uur) worden een maand bewaard, in de slaapkamer leid dit stelselmatig tot p0rn0

Het schijfruimtegebruik loopt dan best de pan uit.

Daarnaas heb ik uiteraard ook mijn blu-ray en cd collectie geript en opgeslagen op de NAS welke met XBMC ontsloten worden in de HT.

als je je huis met 1080p camera's beveiligd dan valt er vast ook wel meer te halen...

Zeg, waar woon je?

Wordt 2 nachten niet slapen met 10TB aan disks... Adaptec en WD is niet echt een hele fijne combi. Net nieuwe firmware in m'n 51645 geflashed, hopelijk werkt het nu beter.

Ik besloot om 3 raptors in RAID 5 (O/S en VM disks) te vervangen door 2x 250GB in RAID 1. Install ging goed maar na een reboot ging de adapter compleet over de zeik op 2 disks in m'n andere storage (RAID 6) array. Een disk moest ik reinitializen en de andere failde

Ik bespeur hier een zekere mate van onethische logica.

Ik heb nu een BeQuiet 300W voeding, maar de NAS trekt maar zo'n 40W. Waarschijnlijk kan daar nog wel 10W af met een andere PSU. PicoPSU zie ik niet echt zitten. 't zou dus mooi zijn als er standaard manieren zijn om een gewone ATX PSU te modden voor low-power. Tot nu toe heb ik echter nog niks gevonden...

Do diamonds shine on the dark side of the moon :?

10W besparing zou je dus kunnen halen als je een theoretische 100% efficientie zou gaan halen. In de praktijk is het heel moeilijk om een voeding te maken die 95% efficient is. Als je een voeding koopt die dat kan (platinum) ben je 150 euro kwijt en er is voor zover ik weet nog maar 1 voeding die dat niveau haalt.

Mijn conclusie; Als je energie wil besparen, ga bij andere apparaten zoeken. Douche minder lang. Voor die 10W hoef je het echt niet te doen...

Overigens; de efficientie van de voeding gaat niet omhoog als je het maximaal geleverde vermogen van een voeding gaat verkleinen. Dit heeft vrijwel niets met elkaar te maken namelijk. De meest effciente voeding die er momenteel is (de bovengenoemde platinum voeding) kan 550W vermogen leveren bij 96% meen ik. Maar ook bij 20% last (zeg 100W) is hij nog steeds 90+% efficient.

Je kunt dus geen energie sparen door bijvoorbeeld een paar 12V lijnen uit te schakelen. Onbelaste lijnen verbruiken niets

[ Voor 27% gewijzigd door 0rbit op 02-05-2011 22:11 ]

Ik ben geheel voldaan, dank u wel!

hoho, die 80% efficientie mag je verwachten bij wattages van ruim boven de 100W. Onder de 50W mag je blij zijn als je 60~70% kan halen. Dat is dus bar slecht. Vandaar ook dat zo'n PicoPSU het zo goed doet onder die omstandigheden.0rbit schreef op maandag 02 mei 2011 @ 22:07:

Je zou het reeele verbruik van je voeding moeten meten onder last van de NAS. Dan kun je de efficientie berekenen. Je mag daarbij zeker uit gaan van tenminste 80% efficientie. Netto zou je NAS dus 50W gebruiken.

Zie ook een dergelijkplaatje van een 80Plus Silver voeding:

Dat vraag ik me toch ten zeerste af.Overigens; de efficientie van de voeding gaat niet omhoog als je het maximaal geleverde vermogen van een voeding gaat verkleinen. Dit heeft vrijwel niets met elkaar te maken namelijk. De meest effciente voeding die er momenteel is (de bovengenoemde platinum voeding) kan 550W vermogen leveren bij 96% meen ik. Maar ook bij 20% last (zeg 100W) is hij nog steeds 90+% efficient.

Mijn idee is juist om de load van zo'n voeding relatief hoog te laten zijn door het terugbrengen van de maximale poweroutput. Effectief heb je dus dan minder vermogen ter beschikking, maar omdat je load percentage hoger is, is de efficiëntie dus ook beter. Tenminste, dat is de theorie

Do diamonds shine on the dark side of the moon :?

Ik heb ook nog niet eerder dat soort mods gezien. Denk eigenlijk ook niet dat het zo makkelijk werkt. Het gaat volgens mij veel meer om de kwalitijd van de gebruikte componenten in de voeding.voodooless schreef op maandag 02 mei 2011 @ 21:56:

Heeft iemand ooit een keer info gezien over het modden van een normale ATX PSU zodat deze wat minder power kan leveren (en dus de relatieve efficiëntie omhoog gaat?).

Ik heb nu een BeQuiet 300W voeding, maar de NAS trekt maar zo'n 40W. Waarschijnlijk kan daar nog wel 10W af met een andere PSU. PicoPSU zie ik niet echt zitten. 't zou dus mooi zijn als er standaard manieren zijn om een gewone ATX PSU te modden voor low-power. Tot nu toe heb ik echter nog niks gevonden...

Verwijderd

sterkteBolk schreef op maandag 02 mei 2011 @ 20:54:

Holy mac er pissen er ff 2 disks uit m'n RAID 6... Rebuilden gaat nog wel 2 dagen duren

Wordt 2 nachten niet slapen met 10TB aan disks... Adaptec en WD is niet echt een hele fijne combi. Net nieuwe firmware in m'n 51645 geflashed, hopelijk werkt het nu beter.

Ik besloot om 3 raptors in RAID 5 (O/S en VM disks) te vervangen door 2x 250GB in RAID 1. Install ging goed maar na een reboot ging de adapter compleet over de zeik op 2 disks in m'n andere storage (RAID 6) array. Een disk moest ik reinitializen en de andere failde

(Doet me denken aan een van onze klanten die waar een drive in een RAID5 eruit knalde ... en daarna nog eentje toen de rebuild to hot spare van de eerste nog bezig was).

Verwijderd

Voor zowel Linux and BSD geldt dat swap niet verplicht is. Onder Ubuntu heb ik geen swap en BSD hoeft ook niet. Wel valt het aan te bevelen voor de momenten dat je het ff krap hebt. In tegenstelling tot Windows is BSD (en ik neem aan Linux) erg conservatief met swap; het wordt alleen gebruikt als je het nodig hebt. Dus kan geen kwaad om wat ruimte van je HDD hiervoor te gebruiken - zolang je niet daadwerkelijk aan het swappen bent maakt het ook niets uit qua performance.FireDrunk schreef op maandag 02 mei 2011 @ 18:10:

Bij linux is het verplicht om er een te hebben dacht ik, maar de grootte boeit niet

Of dat voor FreeBSD geld weet ik niet.

Vooral bij BSD + ZFS geldt dat swap wel handig is omdat ZFS de meeste RAM gebruikt en bijvoorbeeld bij het compileren van software je af en toe 'spikes' in RAM usage kunt hebben. Zonder swap is het mogelijk dat er processen gekilled worden, iets wat je natuurlijk niet wilt.

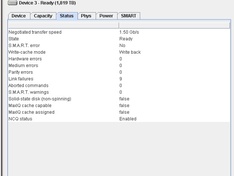

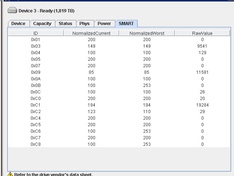

Om wat voor soort disks gaat het? Kan zijn door een bad sector met lange recovery. Hebben je disks TLER enabled? Wat voor controller gaat het om?Bolk schreef op maandag 02 mei 2011 @ 20:54:

Holy mac er pissen er ff 2 disks uit m'n RAID 6... Rebuilden gaat nog wel 2 dagen duren

Ook kun je in de SMART output kijken naar Current Pending Sector en Reallocated Sector Count. Als je de rebuild hebt voltooit zal Current Pending Sector altijd 0 zijn maar dat kan dus ooit 1 geweest zijn en zonder TLER is dat een reden voor veel RAID controllers om de disk uit de array te schoppen.

Zo te zien gaat het puur om link failures. Ik zie verder geen SMART output of wat dan ook. Volgens mij liep de vorige versie van de firmware niet lekker met de 2002FYPS enterprise disks van WD. Zag het eea in de changelog voorbij komen. Het gaat om een adaptec 51645.Verwijderd schreef op maandag 02 mei 2011 @ 23:32:

[...]

Om wat voor soort disks gaat het? Kan zijn door een bad sector met lange recovery. Hebben je disks TLER enabled? Wat voor controller gaat het om?

Ook kun je in de SMART output kijken naar Current Pending Sector en Reallocated Sector Count. Als je de rebuild hebt voltooit zal Current Pending Sector altijd 0 zijn maar dat kan dus ooit 1 geweest zijn en zonder TLER is dat een reden voor veel RAID controllers om de disk uit de array te schoppen.

Ik bespeur hier een zekere mate van onethische logica.

Verwijderd

smartctl -A /dev/.... of in geval van Windows met HDTune (lukt misschien niet vanwege je controller).

Verwijderd

Verwijderd

Even niets...

Kan het zijn dat op de kanalen waar je nu iets veranderd hebt, toevallig ook de disks zitten welke er nu uit zijn geknald? Dan heb je namelijk ook meteen je antwoord, wat er nu mis is gegaan.

Normaal heeft elke disk zijn eigen kanaal (SAS/SATA), maar, als je met een port multiplier zit, dan gaat die logica niet meer op. Als een disk dan een reset stuurt of hangt of wat anders mafs doet, dan kan het best wel eens zijn dat de andere disks in dat kanaal mee gaan.

[ Voor 4% gewijzigd door Quindor op 03-05-2011 11:07 ]

De disks zijn beide gewoon clean, dus dat kan het niet zijn.

Ik ga eerst die kabel vervangen, anders gooi ik de disks in een andere slots om zeker te zijn van de backplane en een voeding upgrade kan ook geen kwaad.

Ik bespeur hier een zekere mate van onethische logica.

Verwijderd

Daarom vroeg ik naar de SMART data van beide uit de array gedropte disks.

Even niets...

Dit is de SMART data van de andere disk die gedropt werd.

En hier het event log:

Bij regel die ik gehighlight heb zie je dat de disk gelijk weer wegvalt... Een paar regels daaronder zie je hetzelfde geval. De disk heb ik niet uit z'n bay getrokken...

[ Voor 44% gewijzigd door Bolk op 03-05-2011 11:40 ]

Ik bespeur hier een zekere mate van onethische logica.

Verwijderd

Nee, al kan er totaal geen communicatie plaatsvinden tussen disk en host doordat alle data corrupt over de kabel komt, dan nog zullen beide einden een UDMA CRC ondervinden. Reactie van de meeste OS is om het opnieuw met PIO te proberen. Reactie van de disk is om zijn SMART data bij te werken. Als UDMA CRC Error Count een raw value van 0 heeft, zijn er nog nooit gegevens 'vervormd' door een foutieve kabel. In zo'n geval moet je het probleem dus elders zoeken.FireDrunk schreef op dinsdag 03 mei 2011 @ 11:32:

Als de link in 1 keer wegvalt omdat de SATA controller errors detecteert, blijft het SMART log toch leeg?

@Bolk: 2e disk laat ook niets bijzonders zien. Wat betreft deze disks: zijn deze na het droppen nu terug in de array gestopt en gerebuild? In zo'n geval kan het zijn dat er een bad sector was zonder fysieke schade. Dan heb je ooit Current Pending Sector != 0 (dus 1 of hoger) gehad (hex waarde C5) - maar door de rebuild wordt deze sector opnieuw beschreven en wordt Current Pending Sector weer 0. Alleen bij fysieke schade wordt de sector omgewisseld met een reserve sector en zul je Reallocated Sector Count een waarde van hoger dan 0 krijgen.

Mocht je een rebuild hebben uitgevoerd, of op een andere methode de sectoren opnieuw hebben beschreven (zero-write), of de disk heeft zelf de data kunnen recoveren binnen de normale 120 seconden recovery cycle, en er is geen fysieke schade aan de sector zelf, dan blijft dit incident verborgen en niet langer detecteerbaar in de SMART-output. In dat geval zul je dus nooit weten wat het euvel precies was; iets wat voor mij zeer onbevredigend zou zijn geweest. Nu kan het zomaar nog een keer gebeuren en je weet geeneens de oorzaak.

Met RAID6 voel je je al snel veilig, maar er kunnen wel degelijk dingen misgaan. Bewaar daarom je meest cruciale bestanden op een échte backup met totaal andere hardware dan je primaire storage. Dan hoef je niet gelijk met een kloppend hart aan je array te knutselen mocht het nog een keer gebeuren.

Yep, m'n userdata gooi ik ook op een externe USB disk met een daily backup (zou eigenlijk buitenshuis moeten). De rebuild is complete, alles werkt weer.Verwijderd schreef op dinsdag 03 mei 2011 @ 11:40:

[...]

Nee, al kan er totaal geen communicatie plaatsvinden tussen disk en host doordat alle data corrupt over de kabel komt, dan nog zullen beide einden een UDMA CRC ondervinden. Reactie van de meeste OS is om het opnieuw met PIO te proberen. Reactie van de disk is om zijn SMART data bij te werken. Als UDMA CRC Error Count een raw value van 0 heeft, zijn er nog nooit gegevens 'vervormd' door een foutieve kabel. In zo'n geval moet je het probleem dus elders zoeken.

@Bolk: 2e disk laat ook niets bijzonders zien. Wat betreft deze disks: zijn deze na het droppen nu terug in de array gestopt en gerebuild? In zo'n geval kan het zijn dat er een bad sector was zonder fysieke schade. Dan heb je ooit Current Pending Sector != 0 (dus 1 of hoger) gehad (hex waarde C5) - maar door de rebuild wordt deze sector opnieuw beschreven en wordt Current Pending Sector weer 0. Alleen bij fysieke schade wordt de sector omgewisseld met een reserve sector en zul je Reallocated Sector Count een waarde van hoger dan 0 krijgen.

Mocht je een rebuild hebben uitgevoerd, of op een andere methode de sectoren opnieuw hebben beschreven (zero-write), of de disk heeft zelf de data kunnen recoveren binnen de normale 120 seconden recovery cycle, en er is geen fysieke schade aan de sector zelf, dan blijft dit incident verborgen en niet langer detecteerbaar in de SMART-output. In dat geval zul je dus nooit weten wat het euvel precies was; iets wat voor mij zeer onbevredigend zou zijn geweest. Nu kan het zomaar nog een keer gebeuren en je weet geeneens de oorzaak.

Met RAID6 voel je je al snel veilig, maar er kunnen wel degelijk dingen misgaan. Bewaar daarom je meest cruciale bestanden op een échte backup met totaal andere hardware dan je primaire storage. Dan hoef je niet gelijk met een kloppend hart aan je array te knutselen mocht het nog een keer gebeuren.

Thanks voor jullie comments en hulp uiteraard

Ik bespeur hier een zekere mate van onethische logica.

80% efficientie? Nah, de be quiet haalt 85% maximaal, met 80% op 20% belasting. Hier spreken we over minder dan 10% belasting, dus daar zit je echt dik onder de 80% efficiëntie. Ergens tussen de 70 en 75% zou ik het gooien. De allerbeste voedingen (link) halen 85% efficiëntie bij 10% belasting - maar die hebben een hogere rating (en hogere vermogens zijn makkelijker om efficiënt om te zetten). Als die superflower zou worden omgebouwd naar een 300W model zou hij grote moeite hebben boven de 80% te blijven op zulke lage belastingen.0rbit schreef op maandag 02 mei 2011 @ 22:07:

Je zou het reeele verbruik van je voeding moeten meten onder last van de NAS. Dan kun je de efficientie berekenen. Je mag daarbij zeker uit gaan van tenminste 80% efficientie. Netto zou je NAS dus 50W gebruiken.

Allereerst, 95% efficiëntie is niet platinum (platinum is 90%). Er zijn geen consumenten ATX-voedingen die 95% halen, alleen hele grote (1.5kW+) hotswap servervoedingen, en dan alleen in de buurt van 40-80% belasting. Hoe kleiner de voeding, hoe moeilijker het is om je efficiëntie hoog te houden, want een hoop ogenschijnlijk kleine verliesjes die nauwelijks aantikken bij hoge vermogens beginnen dan opeens heel significant te worden.10W besparing zou je dus kunnen halen als je een theoretische 100% efficientie zou gaan halen. In de praktijk is het heel moeilijk om een voeding te maken die 95% efficient is. Als je een voeding koopt die dat kan (platinum) ben je 150 euro kwijt en er is voor zover ik weet nog maar 1 voeding die dat niveau haalt.

Totaal mee eensMijn conclusie; Als je energie wil besparen, ga bij andere apparaten zoeken. Douche minder lang. Voor die 10W hoef je het echt niet te doen...

De overall-efficiëntie van een voeding gaat omhoog naarmate het labelvermogen hoger wordt, om de eerdergenoemde reden. Het is andersgezegd makkelijker om een zware voeding efficiënt te maken. Sterker nog, in mijn blogs heb ik een van de redenen uitgelegd waarom zwaardere voedingen noodzakelijk efficiënter moeten zijn (namelijk omdat er per definitie active PFC in moet) - de andere reden is uiteraard dat het maar een beperkt kastje is en de absolute hoeveelheid energie die erin moet worden gedissipeerd niet te hoog mag worden, anders oververhit hij en/of heb je een hele luide fan nodig.Overigens; de efficientie van de voeding gaat niet omhoog als je het maximaal geleverde vermogen van een voeding gaat verkleinen. Dit heeft vrijwel niets met elkaar te maken namelijk. De meest effciente voeding die er momenteel is (de bovengenoemde platinum voeding) kan 550W vermogen leveren bij 96% meen ik. Maar ook bij 20% last (zeg 100W) is hij nog steeds 90+% efficient.

Je kunt dus geen energie sparen door bijvoorbeeld een paar 12V lijnen uit te schakelen. Onbelaste lijnen verbruiken niets

Anyway, dat was de ene kant van het verhaal. De andere kant van het verhaal is zoals voodooless al heeft laten zien: de efficiëntie van een voeding wordt héél snel héél slecht bij lage belasting. Bij 20% belasting doen de meeste voedingen met twee vingers in de neus 80%, maar bij 10% haalt menig voeding de 70% nog maar net. Moderne systemen (zeker single-disk) verbruiken idle zelden meer dan 40W DC, en dat is minder dan 10% van de voeding die je daar waarschijnlijk in stopt. Ondanks dat je een mooie 80 plus kryptonite voeding hebt gekocht, werkt die voeding in werkelijkheid maar 70% efficient als je computer niks staat te doen - en dat doet hij het grootste deel van de tijd.

Daarom heeft het zin om een voeding te nemen die een lager vermogen kan leveren, zodat hij percentueel hoger wordt belast en in een gunstiger deel van zijn efficiëntiegebied zit, bijvoorbeeld 20% of meer. Echter.....

Zo makkelijk werkt dat niet! Het eigenverbruik van een voeding en de operationele efficiëntie zijn inherent aan het hele ontwerp van het ding. Een bestaande voeding ombouwen naar een lager vermogen maakt hem niet automagisch efficiënter op die lage belastingen. Als je dat al voor elkaar krijgt met een simpele mod. Want eigenlijk moet je de hele voeding opnieuw ontwerpen...voodooless schreef op maandag 02 mei 2011 @ 21:56:

Heeft iemand ooit een keer info gezien over het modden van een normale ATX PSU zodat deze wat minder power kan leveren (en dus de relatieve efficiëntie omhoog gaat?).

Ik heb nu een BeQuiet 300W voeding, maar de NAS trekt maar zo'n 40W. Waarschijnlijk kan daar nog wel 10W af met een andere PSU. PicoPSU zie ik niet echt zitten. 't zou dus mooi zijn als er standaard manieren zijn om een gewone ATX PSU te modden voor low-power. Tot nu toe heb ik echter nog niks gevonden...

De verliezen zitten hem in alle stadia van de voeding; PFC, primaire switches, transformator, gelijkrichting, uitgangsfilter en verdere componenten (off-line 5Vsb, aanstuurelektronica, etc.). Puur de voeding 'minder maximaal vermogen' laten geven gaat je niet helpen, want dan zit je nog steeds met disporportioneel grote verliezen in de transformator en PFC. Dan moet je die dus eigenlijk ook meteen kleiner maken, maar dan is je voeding weer ongunstig bemeten voor 12V, en wil je liever dat ij alléén 12V maakt en er dc-dc converters in zitten voor 5 en 3.3V. En... nouja, je ziet waar het heengaat. Inmiddels ben je het hele ding al opnieuw aan het ontwerpen.

Je kunt wel een voeding nemen en hem een stuk efficiënter bij lage belasting maken met een aantal mods, die ik bijvoorbeeld ook in mijn 8.5W core i3-blog heb laten zien; je kunt alle bouwblokjes van een voeding apart bekijken en de suboptimale componenten vervangen door iets beters. Dan is het vermogen dat de voeding kan leveren nog steeds hetzelfde, maar presteert hij beter. Echter... Dat vereist veel meer know-how (en een hoop guts om je dure computer aan een homebrew voeding te hangen) en is niet echt goedkoop ofzo. Typische manieren om de efficiëntie te verbeteren bij lage belasting is je PFC pas in te laten schakelen vanaf ~75W, synchrone MOSFETs of betere uitgangsdiodes gebruiken, betere primaire schakelaars erin solderen, een controller gebruiken die de 5Vsb-transformator uitschakelt als de voeding aanstaat en de 5V overschakelt. Die componenten zijn goed verkrijgbaar, maar elke mod kost je wel al gauw 5 à 10 euro aan componenten.

Do diamonds shine on the dark side of the moon :?

Even niets...

1X Cooler Master 4-in-3 Device Module STB-3T4-E3-42522 € 16,79

2X Kingston ValueRAM - Geheugen - 4 GB - DIMM 240 2x€ 35,33= € 70,66

Be quiet! Pure Power BQT L7-300W - Voeding € 35,55

Intel Core i3 540 / 3.06 GHz - LGA1156 Socket € 93,76

MSI H55M-E33 - Moederbord - micro ATX - LGA1156 € 66,00

Sharkoon Rebel9 Pro Economy - Midtowermodel - € 44,07

WD Scorpio Black WD5000BEKT - Vaste schijf - 5301032 € 58,55

Samsung Spinpoint F4EG HD204UI - Vaste schijf 2x€ 63,13 € 126,26

Totaal € 511,64

Verder komen er nog 2x 1TB WD10EADS die ik al een tijdje in mijn bezit heb.

Adhv deze topic maakte ik de keuze voor de H55M-E33 (blijkt erg energiezuinig te zijn)

Het enige wat ik jammer vind is dat dit moederbord blijkbaar geen esata heeft.

1) Is er nog een goed energiezuinig alternatief wat het moederbord betreft, die wel esata heeft?

2) Is de 300W voeding voldoende of neem ik best een 350W? (heb ik nog wat "overschot" om eventueel later hd's toe te voegen met deze voeding) en is deze voeding stil genoeg om in de woonkamer te gebruiken?

3) Kan iemand een schatting maken wat deze setup zou verbruiken (in het slechtste geval)

Verder zou ik graag wat met virtualisatie experimenteren (ken er momenteel niks van)... ik vermoed dat dit met deze hardware wel mogelijk zal zijn?

Ik draai trouwens 12 disks en een SSD op 300W, gaat prima.

Even niets...

Aan de andere kant doet PFC ook verrassend weinig bij lage vermogens. Mijn Antec Earthwatts 380W voedingen hebben een bar slechte power factor op de systeempjes die ik heb gebouwd (PF ~0.7 @ 25W - nauwelijks tot niet beter dan passive PFC). ALs je een echt heel licht DIY NAS-systeem hebt kan het misschien wel helpen, en maakt het ook helemaal niks uit voor je power factor of vervorming.

Active PFC is niet verplicht onder de 75W, en in de praktijk is het inderdaad ook pas nuttig bij hogere vermogens. Toch zijn er situaties waarbij het toch gewenst is; een klaslokaal vol zuinige pc-systemen verbruikt bij elkaar toch een paarduizend watt - dat wil je niet graag met een power factor van 0.6. Zelfde geldt voor verlichting.

Dit draait op een SeaSonic X-560 voeding. Machtig mooi ding, maar helaas zijn alle nog lagere wattages passieve versies en duurder, dus ook een beetje met de toekomst in gedachten gekocht. 80Plus Gold, maar met 100 watt verbruik gaat ie never nooit niet richting de 90% efficiëntie

Ik ben persoonlijk nog opzoek naar een goedkope controller (8 poorts, geen RAID) welke hdd spindown ondersteund en werkt onder VMware ESXi 4.1. Mijn Adaptec 5805 doet het helaas niet met een EFI bios moederbord (Zoals mijn Intel DQ67OW). Be warned, dat gaat nu en de komende tijd (if ever) niet werken, ook met support overlegd, etc.

Er zit nu een LSI SAS 3081E-R in (De Intel SASUC8I versie). Deze ondersteund het iig niet!

Prima kaartje verder, maar zonder spinnende disks is mijn verbruik 32 Watt! En 90% van de tijd kunnen de disks uit.

Als iemand een tip heeft, hoor ik het graag! Andere specs volgen binnenkort in een uitgebreide post met foto's enzo.

p.s. Weet iemand of de IBM ServeRAID M1015 het kan? Dat is een OEM van een LSI 9211-8i/9240-8i voor zover ik weet.

Even niets...

Maar echt duidelijkheid hierover heb ik niet kunnen vinden. Want de 9240-8i is weer niet zonder hardware RAID, maar wel dezelfde kaart.

Ik zoek wel specifiek naar HARDWARE initiated spindown (zoals bijvoorbeeld mijn adaptec dat kon) aangezien ESXi hier niets in gaat doen.

LSI noemt dat hun "dimmer" functie. Welke als ik de handleiding mag geloven werkt het zelfs met unconfigured en JBOD drives. Precies wat ik zoek! Maar welke kaarten wel en welke niet? Support wenst mij niet te zeggen welke dat wel en niet niet kunnen (Jah, 9240-8i en 9260-8i, maar niet of een M1015 het dan ook kan).

[ Voor 39% gewijzigd door Quindor op 03-05-2011 14:40 ]

LSI Support is erg goed, misschien eens een ticket inschieten?

Even niets...

Ja, dat had ik gedaan. Maar die weigeren iets te zeggen over hun OEM fabricaten. Ik heb nu een Intel versie waarmee ik een ticket trachtte te openen, helaas. Op navraag over de 9240-8i (welke de M1015 is) kreeg ik te horen dat de 9240-8i het kan, maar of de M1015 het dan ook kon, konden ze me niet vertellen.FireDrunk schreef op dinsdag 03 mei 2011 @ 14:51:

Geen idee, ik weet wel dat Highpoint er reclame voor maakt (Idle Disk Spindown).

LSI Support is erg goed, misschien eens een ticket inschieten?

Verwijderd

Hey, kijk eens aan, dat wist ik niet! Dat gaan we thuis eens eventjes proberen!Verwijderd schreef op dinsdag 03 mei 2011 @ 15:16:

Voor spindown kun je ook APM gebruiken als je schijven dat ondersteunen; dat gaat onafhankelijk van de controller. Zelfs zonder datakabel werkt dat. APM wordt echter niet door alle schijven ondersteund. APM kun je inschakelen met smartctl of andere utilities en is een persistent setting, die na stroomcycle behouden blijft. De schijf zal zich afhankelijk van de instelling automatisch laten downspinnen bij inactiviteit.

De schrijven welke ik gebruik zijn Samsung F3EG's van 2TB.

Any day is a good day to learn.

Uh, dat is niet helemaal waar... Sommige controller doen (ook al zijn het JBOD / unconfigured disks) een surface scan en of smart readout op de disks. en je kan er donder op zeggen dat de disks daardoor opspinnenVerwijderd schreef op dinsdag 03 mei 2011 @ 15:16:

Voor spindown kun je ook APM gebruiken als je schijven dat ondersteunen; dat gaat onafhankelijk van de controller. Zelfs zonder datakabel werkt dat. APM wordt echter niet door alle schijven ondersteund. APM kun je inschakelen met smartctl of andere utilities en is een persistent setting, die na stroomcycle behouden blijft. De schijf zal zich afhankelijk van de instelling automatisch laten downspinnen bij inactiviteit.

Even niets...

Indien dit niet het bovenstaande betekend, is dat eigenlijk mogelijk? Dit zou handig zij om de hd levensduur te verlengen bij het van de pc (en om stroom te besparen)

Wat hier bedoeld word is dat als een disk een lange(re) periode van inactiviteit meemaakt, dat hij uit zichzelf (of door een controller) een seintje krijgt om down te spinnen.

Bijna alle AHCI controllers op moederborden van tegenwoordig ondersteunen dit prima. Maar HBA's (zoals de LSI 3068E) hebben daar wat vaker moeite mee...

Even niets...

Stel dat je 1 aparte hd voor muziek hebt en 1 voor films, en 1 os disk.

Is het op een of andere manier mogelijk om bij het opstarten vd pc enkel die os disk op te laten spinnen en de andere af te laten (Wat de levensduur ten goede komt indien je de nas geen 24/7 aanlaat)

Ik weet dat je eenmaal de pc gestart is een disk kan laten downspinnen, maar is het ook mogelijk deze NIET te laten upspinnen bij startup, totdat je de disk nodig hebt?

Vreemd. zal het dadelijk nog eens testen.Quindor schreef op dinsdag 03 mei 2011 @ 14:32:

Ik ben persoonlijk nog opzoek naar een goedkope controller (8 poorts, geen RAID) welke hdd spindown ondersteund en werkt onder VMware ESXi 4.1. M

Er zit nu een LSI SAS 3081E-R in (De Intel SASUC8I versie). Deze ondersteund het iig niet!

Maar volgens mij gooit windows ze na 20 min wel degelijk in sleep-mode.

Tenminste ik moet altijd ff wachten, maar weet niet 100% zeker of dat dan alleen bij de mobo disken is......

HD's ondersteunen staggered spin-up. dus het kan wel.fjskmdl2 schreef op dinsdag 03 mei 2011 @ 18:49:

Mijn vraag is eigenlijk als volgt:

Stel dat je 1 aparte hd voor muziek hebt en 1 voor films, en 1 os disk.

Is het op een of andere manier mogelijk om bij het opstarten vd pc enkel die os disk op te laten spinnen en de andere af te laten (Wat de levensduur ten goede komt indien je de nas geen 24/7 aanlaat)

Ik weet dat je eenmaal de pc gestart is een disk kan laten downspinnen, maar is het ook mogelijk deze NIET te laten upspinnen bij startup, totdat je de disk nodig hebt?

alleen dan zul je zelf draadjes aan het solderen moeten

Of een hotswap rack met sleuteltje, en dan alleen aanzetten als je het nodig hebt

[ Voor 33% gewijzigd door heuveltje op 03-05-2011 19:09 ]

Heuveltjes CPU geschiedenis door de jaren heen : AMD 486dx4 100, Cyrix PR166+, Intel P233MMX, Intel Celeron 366Mhz, AMD K6-450, AMD duron 600, AMD Thunderbird 1200mhz, AMD Athlon 64 x2 5600, AMD Phenom X3 720, Intel i5 4460, AMD Ryzen 5 3600 5800x3d

ESXi als OS gaat niets aan de power management van je disks doen, dus als Windows het al niet doet of een hard commando, dan gaat het onder ESXi al helemaal nooit gebeuren.

Mijn vorige controller (Adaptec 5805) kon in de bios/manager zo ingesteld worden dat deze de disk spin down's ging regelen. Vandaar mijn verwoorden als Controller initiated spin down. Op die manier hoeft je OS dat niet meer te doen. Volgens mij schuilt het probleem erin dat er binnen SCSI geen commando voor is, maar wel via SATA/AHCI.

Vroeger via IDE was het een warboel volgens mij, vandaar dat het vaak ook via het moederbord bios ingesteld kon worden. Iets wat je tegenwoordig niet meer ziet.

Dat is ook de reden dat moederbord controllers er geen probleem mee hebben, maar add-on controllers wel.

Ik ben op dit moment aan het testen met APM, maar alle disks welke ik nog of via hdparm of via HDDscan heb getest worden gereset naar de originele waarden na een power off. AAM (minder seek noise) word wel bewaard, maar is niet wat ik zoek.

In mijn situatie kan spindown goed werken. Aangezien ik meerdere VM's draai, maar deze allemaal vanaf SSD draai. Dan heeft 1 VM (OS op SSD) de 8x2TB toegewezen puur als data volume (waar weer drivebender overheen ligt). Hierdoor hoeven de drives alleen actief te zijn als er iets gedownload word, en als ik iets kijk, de drive waar het opstaat.

Ga je je OS er vanaf draaien of andere zaken is spin down inderdaad niet aan te raden. Maar in mijn geval spinnen de disks hooguit 5x per dag ofzo. Ook kan er meestal een "up" periode ingesteld worden, waarbij de drives actief blijven als de aangesproken worden, tot die periode over is (bij mij 18:00 - 01:30).

Op die manier kan ik grote hoeveelheden stroom besparen! Wat met mijn adaptec ook nog ging.

[ Voor 23% gewijzigd door Quindor op 03-05-2011 20:43 ]

Mijn nieuw gebouwde server (sinds een weekje). Generatie 7 alweer!

Het is een Sharkoon Rebel 9 met daarin een Intel DQ67OW moederbord met daarin geprikt een Intel i5-2500. Gevoed door de hierboven genoemde Seasonic X-560. Hierin zit verder een LSI 8 port 3081E-R waarop 8x2TB Samsung F3EG is aangesloten. Daarnaast zitten er op het moederbord aangesloten een OCZ Vertex2 van 120GB en van 180GB. De 2TB's zijn gehuisvest in Chieftec SAS backplane modules.

Dan is er een USB-key gebruikt om ESXi vanaf te booten en draaien. Dit alles functioneert perfect inclusief onboard netwerk kaart (via een custom driver). Ook werken VT-x en VT-d.

Zoals genoemd zijn de SSD's bedoelt om de VM's vanaf te draaien welke altijd actief zijn (mail, download, opslag, gameservers, etc.) en zijn de 2TB's bedoelt voor opslag. Hiervan is 80% per disk (VMFS met daarop VMDK) aan 1 VM gehangen welke dit vervolgens aan elkaar verbind via DriveBender, waardoor er 1 groot volume ontstaat welke automatisch de files zal verdelen over de disks. Door het verdelen van de files verwacht ik uiteindelijk toch nog een beetje profijt te hebben van meerdere fysieke spindels bij elkaar. Voordeel is dat als er 1 disk uitvalt, niet meteen alles verdwenen is. Verder is er van dit volume een tweede mount point welke er voor zorgt dat deze files automatisch gedupliceerd worden naar 2 disks. Hierdoor is een RAID controller niet meer persee noodzakelijk. Als laatste redmiddel gebruik ik verder crashplan.com.

De rest van de 20% per disk is bedoelt voor test VM's hoofdzakelijk bedoelt voor mijn werk. Doordat dit losse disks zijn kunnen er prima enkele VM's naast elkaar gedraaid worden door de I/O te verdelen. Maar het meeste van de tijd zullen deze VM's niet actief zijn en alles puur vanaf de SSD's draaien. Om, als opzet, stroom te besparen. Met alle disks idle verbruikt dit geheel zo'n 85 Watt. Zonder de disks is dat 32 Watt.

Vandaar dan ook mijn zoektocht naar een controller welke weer spin down verricht. De Adaptec blijkt niet bruikbaar met moderne chipsets (*67) vanwege de EFI biossen. Adaptec heeft via support aangegeven hier de komende tijd GEEN support voor te gaan bieden.

En als laatste. Goedkoopste kast welke ik ooit gekocht heb. Maar bevalt eigenlijk prima op deze manier!

[ Voor 18% gewijzigd door Quindor op 03-05-2011 22:07 ]

Ander alternatief: PicoPSU met wide voltage input achter een flinke trafo (zeg ~120VA 12VAC), wat shotkeys en een berg elko's. Zou dat efficiënter zijn dan een baksteenvoodooless schreef op dinsdag 03 mei 2011 @ 12:44:

Hey mux, bedankt voor de uitlegMisschien toch maar eens kijken naar een PicoPSU en een bak elko's om wat extra disks te kunnen accomoderen... Eens over nadenken.

[ Voor 7% gewijzigd door voodooless op 03-05-2011 22:23 ]

Do diamonds shine on the dark side of the moon :?

klik

Met Samsung schijven heb ik persoonlijk altijd goede ervaringen gehad, alleen ben ik wat huiverig voor het flashen van deze schijven aangezien ik Linux draai. Dan zou ik ze eerst nog alledrie in een windows machine moeten hangen om ze te kunnen patchen met de nieuwe firmware, of zie ik dit verkeerd? Elk merk zal wel izjn voor- en tegenstanders hebben maar...welke van de drie zouden de NAS goeroes onder jullie mij aanraden?

[ Voor 24% gewijzigd door SanderH_ op 03-05-2011 22:08 ]

Ik zou voor de F4EG gaan, is volgens mij de snelste en zuinigste van het stel.

Even niets...

Hij gebruik nog de conventionele 512b sectoren, dus nergens gezeik met compatibiliteit (geen 4K sectoren; Advanced Format). Stil genoeg, net als zo'n beetje elke groene disk. Qua vibratie scoort hij ook goed en sequentieel haal ik er 135MB/s mee in een snelle test.

O en je hoeft hem niet te flashen.

Harddisks die ik moet flashen wil ik niet hebben, dat is imo duidelijk een probleem in de kwaliteitscontrole.

Heb die ene nu een week. Als hij zo blijft haal ik er zo nog twee.

[ Voor 16% gewijzigd door Ultraman op 04-05-2011 06:29 ]

Als je stil blijft staan, komt de hoek wel naar jou toe.

Misschien lichtelijk offtopic: Maar mochten er nog mensen zijn die een leuke DIY RAID NAS basis zoeken:

V&A aangeboden: Homeserver Set (i3-530, 4GB ECC, Intel 3420GPLC)

Even niets...

Nah, dat gaat hem echt niet worden. Trafo's zijn ongeschikt voor computers, dat zorgt voor gigantische instabiliteit en/of veel verliezen. Bovendien geeft dat veel extra idle- en uit-verbruik.voodooless schreef op dinsdag 03 mei 2011 @ 21:46:

[...]

Ander alternatief: PicoPSU met wide voltage input achter een flinke trafo (zeg ~120VA 12VAC), wat shotkeys en een berg elko's. Zou dat efficiënter zijn dan een baksteenMist alleen de extra 12V connector. Die kun je er vast wel bij hacken..

In dit topic bespreken we de hardwarematige kant van het bouwen van een NAS. Vragen en discussies die betrekking hebben op de softwarematige kant, dien je elders te stellen. Zo is het ZFS topic de juiste plek voor vragen over ZFS maar ook over softwareplatformen zoals FreeNAS, NAS4Free, ZFSguru en andere softwareplatforms die met ZFS werken.

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/45193/voodooless_small.png?f=community)

/u/231803/ramdisk2.png?f=community)

/u/3586/bismarck.png?f=community)

:strip_icc():strip_exif()/u/183558/DJ.jpg?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

:strip_exif()/u/43081/CPU.gif?f=community)

/u/22388/header-logo.png?f=community)

:strip_icc():strip_exif()/u/37356/got.jpg?f=community)

:strip_icc():strip_exif()/u/10414/crop5817c0657774d_cropped.jpeg?f=community)

:strip_exif()/u/3287/crop6274f828ec8f4.gif?f=community)

:strip_icc():strip_exif()/u/48952/Ultraman-60x60-Ray-Animated.jpg?f=community)