[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Dat is 100,- per maand aan stroom bij 24/7 gebruik...

Denk dat hij zich daar eerst over moet buigen.

Even niets...

Ik weet niet wat dit is?player-x schreef op dinsdag 24 maart 2015 @ 13:17:

[...]

Geld dat ook voor FIS PMs, of alleen voor CBS PMs?

Even niets...

Waar haal je dat vandaan, 300W 24/7 is 50 euro per maand, en hij gaat de array zeker niet 24/7 gebruiken, daarnaast kan hij de disk opsplitsen in 2 of 3 kleinere en 'zuinigere' array's.FireDrunk schreef op dinsdag 24 maart 2015 @ 13:33:

Dat is 100,- per maand aan stroom bij 24/7 gebruik...

Daarnaast zal hij net als ik ook gebruik gaan maken van een download schijf, en de meeste video daar vanaf bekijken, zodat de raid array's gewoon standby kunnen blijven de meeste tijd.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Maar goed, ik blijf het een ambitieus plan vinden...

Kan hij niet beter die 1TB schijven voor een mooi prijsje verkopen? Scheelt je een hoop geneuzel...

Even niets...

Als je vervolgens met 40 euro stroom / maand rekent dan kun je ze zelfs voor 17 euro per stuk verkopen en speel je na een jaar break even. Met 1 euro per stuk is dat na 3 jaar

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Even niets...

Bijna al het spul is al binnen en in elkaar gezet. Ik loop nu tegen het volgend probleem aan: LSI 2308 is geflashed naar IT mode versie P16, want FreeNAS zit op P16. 8 schijven op de 2 sas poorten aangesloten, maar ik zie echter alleen dit:GioStyle schreef op vrijdag 13 maart 2015 @ 23:29:

-knip-

Mijn final build (Hades 2.0) komt er als volgt uit te zien:

Onderdeel Component Behuizing Lian Li PC-Q26B + Lian Li BP2SATA (4x), zodat alle schijven hotswap zijn. Moederbord Asrock E3C222D4I-14S Processor Intel Pentium G3220 Geheugen Kingston KVR16LE11/L8 Schijven Western Digital WD30EARZX (10x) USB1 USB + microSD 16GB (FreeNAS) USB2 USB + microSD 16GB (Logs) Voeding Seasonic G450 Optioneel Stock fans vervangen door stillere varianten van Noctua mocht geluid een issue zijn en eventueel self made power cables om de boel zo strak mogelijk te krijgen.

-knip-

Als ik de bijgeleverde SAS kabels omwissel, dan zie ik de andere 4 schijven online komen, ik ga er vanuit dat de kabels goed zijn.

Het gekke is dat in FreeNAS zelf wel alle schijven online komen, maar de schijven die bij de LSI 2308 ontbreken worden door FreeNAS herkend als 'ad' schijven, dus IDE?

Straks maar even de SAS kabel aansluiten op de Intel chipset, kijken wat dat oplevert.

Zou misschien 1 van de poorten stuk zijn? Dat zou wel mooi klote zijn, geen zin in RMA.

Even niets...

Ik verwacht een gemiddeld gebruik van zo een 20 uur per week, daarnaast zou met de goedkope PM, hij op ongeveer 300 euro voor de PMs en 150 voor een M1015 (of iets vergelijkbaars tweede hands) uitkomen.FireDrunk schreef op dinsdag 24 maart 2015 @ 15:13:

Maar hij ging ze niet 24/7 aanzetten, daar zit het grote verschil.

Ik zie geen alternatief waar mee hij voor onder de 500 euro een 60TB array kan maken.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

1500 + 500 investering = 2000 euro.

8 * 8TB kost 2100 euro...

Het scheelt dus qua basis investering 100 euro.

Maar je hebt 52 schijven minder draaien...

Even niets...

* GioStyle gaat vol met schaamte in een hoekje zitten.FireDrunk schreef op dinsdag 24 maart 2015 @ 15:58:

Klinkt alsof je de SAS kabel al in de onboard Intel SAS poort hebt zitten

Nu verdeel je de bandbreedte van al je schijven over 2 controllers, en dus over meer PCIe lanes.

Kan technisch gezien nog wel eens sneller zijn...

Ik zou zeggen: Benchmark het

Even niets...

FireDrunk schreef op dinsdag 24 maart 2015 @ 13:41:

Zie mijn wiki linkje een stukje terug.

Dus het maakt niet eens uit. Gewoon: zie je een SATA port multipier, atoombom er op en daarna wurgen om zeker te zijn.The total bandwidth is still limited to that of a single SATA port.

Ga je dan geen invoerkosten moeten gaan betalen, bij 50 dollar was dat bij mij al 28 euro invoerkosten dus eigenlijk gaat dat dan toch niet de moeite waard zijn denk ik.FireDrunk schreef op dinsdag 24 maart 2015 @ 10:41:

Als je goed zoekt:

http://www.ebay.com/itm/D...ain_0&hash=item27f1050027

Valt er best wat te vinden voor minder dan 15 euro per poort.

Zeg, meneer kort door de bocht. Je snapt zelf toch ook wel dat Bandbreedte niet alles is.Q schreef op dinsdag 24 maart 2015 @ 16:47:

[...]

[...]

Dus het maakt niet eens uit. Gewoon: zie je een SATA port multipier, atoombom er op en daarna wurgen om zeker te zijn.

Beste voorbeeld: Vraag een harddisk 512 bytes vooraan, en daarna achteraan... Daar heeft ie gewoon een paar ms voor nodig.

In de tussentijd kan er dus geen andere IO plaatsvinden bij non-FIS based switching.

Als er dus enigzins ook maar iets aan random IO gebeurt op je array, *STORT* je performance in.

Bij FIS based haal je nog enigzins de bandbreedte.

Blijft wel overeind dat het gewoon kut is allemaal

Even niets...

| # | Product | Prijs | Subtotaal |

| 1 | Intel Pentium G620 | € 0,- | € 0,- |

| 1 | Asus P8H67-I | € 0,- | € 0,- |

| 1 | Lian Li PC-Q25B | € 124,80 | € 124,80 |

| 2 | Kingston ValueRAM KVR1333D3N9/4G | € 80,42 | € 160,84 |

| 1 | be quiet! Pure Power L7 300W | € 71,39 | € 71,39 |

| Bekijk collectie Importeer producten | Totaal | € 357,03 | |

Nu zou ik graag willen upgraden naar een wat snellere/ veiligere setup met een basis server mobo'tje en ECC geheugen. (De laatste tijd is nas4free regelmatig ineens z'n complete config kwijt waardoor ik hem opnieuw moet instellen en opnieuw de zfs pool moet laden, ik vermoed een RAM probleem). Ik heb 2 raidz zfs pools, 1 van 3x3TB en 1 van 3x 1,5TB.

De NAS gebruik ik enkel voor opslag en files delen via SMB shares. Een andere PC draait Plex server en voorziet de transcoding naar verschillende plex media centers en rasplex boxes. Ook nieuwsgroup en uitpakken etc draait op een andere machine en pas wanneer de files verwerkt zijn gaan ze naar de NAS.

Klopt het dat ik in principe enkel Mobo + RAM hoef te vervangen of zou een andere CPU ook aan te raden zijn? Ik hoor graag wat goede basis suggesties zijn, aangezien ik erg veel zeer uitgebreide bordjes voorbij zie komen, die in principe veel meer bieden dan ik nodig heb.

Verwijderd

Ik heb sterke twijfels bij jouw vermoeden. Ik denk dat het een heel ander probleem is.De laatste tijd is nas4free regelmatig ineens z'n complete config kwijt waardoor ik hem opnieuw moet instellen en opnieuw de zfs pool moet laden, ik vermoed een RAM probleem

RAM bitflips begin je namelijk eerst te herkennen aan random checksum errors verspreid over je disks. Heb je dat ook? Zo nee, dan kun je bitflips vrijwel uitsluiten als oorzaak van je probleem.

Nope. Verder geen problemen. Eerste keer dat ik het had was toen ik 50k files uit de .recycle verwijderde (wist ik niet, smb bin staat inmiddels uit). Dit duurde meer dan 10uur dus heb ik in de nacht aangelaten. In de ochtend was de config kwijt. Nu gebeurd het soms random in de nacht. Als ik ip opnieuw instel, Pools automatisch scan en sync, en shares terug aanmaak werkt alles weer even zonder problemen.Verwijderd schreef op dinsdag 24 maart 2015 @ 18:17:

[...]

Ik heb sterke twijfels bij jouw vermoeden. Ik denk dat het een heel ander probleem is.

RAM bitflips begin je namelijk eerst te herkennen aan random checksum errors verspreid over je disks. Heb je dat ook? Zo nee, dan kun je bitflips vrijwel uitsluiten als oorzaak van je probleem.

Misschien het BIOS batterijtje dat leeg is? Of blijft de BIOS config wel in orde?Verwijderd schreef op dinsdag 24 maart 2015 @ 18:17:

[...]

Ik heb sterke twijfels bij jouw vermoeden. Ik denk dat het een heel ander probleem is.

RAM bitflips begin je namelijk eerst te herkennen aan random checksum errors verspreid over je disks. Heb je dat ook? Zo nee, dan kun je bitflips vrijwel uitsluiten als oorzaak van je probleem.

HP Zbook G8 | Synology DS1511+

Verwijderd

Jij hebt waarschijnlijk een heel ander issue; ik denk meer aan een softwarematig issue.

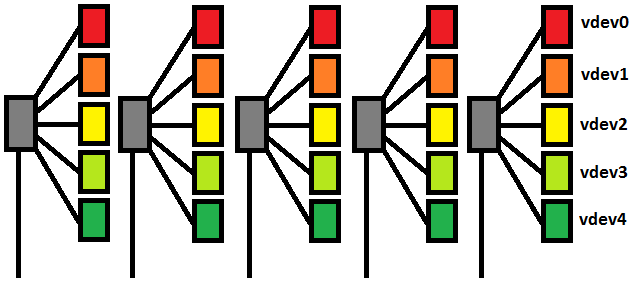

heb er over na zitten denken een beetje, hij kan ook gewoon 5 array's maken, en elke array over de 12 PMs verspreiden, dan zit hij iig nooit met het probleem dat hij op andere disks moet wachten.FireDrunk schreef op dinsdag 24 maart 2015 @ 16:58:

Als er dus enigzins ook maar iets aan random IO gebeurt op je array, *STORT* je performance in.

Bij FIS based haal je nog enigzins de bandbreedte.

Blijft wel overeind dat het gewoon kut is allemaal

Alleen als hij tussen de array's data gaat verplaatsen, dan heeft hij een bottleneck, maar zelfs dan is het alleen het switchen tussen twee HDDs, daarnaast wordt de meeste data eerst naar het geheugen verplaatst, voordat wordt door gepompt.

Is het mogelijk om 5x raidz1 array's ook nog eens in raidz0 te zetten, net als raid 50?

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Verwijderd

Maar ik heb al weken geen enkele instelling aangepast. Standaard nas4free nieuwste distro zonder extra scripts of jails of wat dan ook. Enkel ip aangepast, cifs/smb share aangezet, 2 pools, 2 volumes en 1 speciale admin user. Verder niets aangeraakt en nadat de config weg is zijn dat ook de enige instellingen die ik weer aanpas. Soms werkt het dan een aantal dagen zonder problemen, soms slechts een dag.Verwijderd schreef op dinsdag 24 maart 2015 @ 19:58:

Jij hebt waarschijnlijk een heel ander issue; ik denk meer aan een softwarematig issue.

[ Voor 26% gewijzigd door IggyB op 24-03-2015 21:01 ]

Verwijderd

Wellicht dat je eens op het NAS4Free forum je verhaal kunt doen. Laat dan ook een screenshot zien van het daadwerkelijk verliezen van de config. Want je suggereert in elk geval dat je dit kunt reproduceren.

Je kunt natuurlijk altijd je geheugen testen met MemTest86+. Als dat 24uur+ geen problemen geeft dan is het vrij aannemelijk dat je geen probleem met je geheugen hebt gehad.

Dus als ik de HDDs zo over de budget PMs verdeel, zouden er niet bijzonder veel prestatie problemen moeten zijn?Verwijderd schreef op dinsdag 24 maart 2015 @ 20:41:

Maar dat doet ZFS standaard al met vdevs. Dus als je twee RAID-Z vdevs hebt, is dat grofweg een RAID 50.

Het kost op die manier een paar extra HDDs, maar er zou geen sprake meer van prestatie degradatie meer moeten zijn, van wegen het gebruik van goedkopere CBS type PMs.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Verwijderd

Het is denk ik wel beter om het te doen zoals jij stelt; dus alle disks in een vdev op een andere chip met zijn eigen port multiplier. Dan zou in elk geval de I/O op die ene vdev geen vertraging oplopen; enkel als vdes onderling gaan concurreren.

Vdefs over de controllers stripen is om een andere reden raadzaam: availability. 1 zo'n sata controller dood = verlies van refundancy bij raidz maar geen verlies van de pool. Stop je een vdef per pm dan zou je ern vdef verliezen en dan ben je de sjaak volgens mij.

Ik ga zelf ergens deze week mijn 6x 3TB raidz2 pool omzetten naar 10x 3TB raidz2. Echter zit ik met ongeveer 4,5TB aan data die ik tijdelijk ergens moet opslaan. 1,5TB kan ik tijdelijk op mijn server/ back-up schijven zetten, overige 3TB zet ik op een nieuwe 3TB schijf. Daarna die schijf eruit halen, oude pool verwijderen, nieuwe pool aanmaken 10 schijven raidz2 degraded met 9 schijven. 3TB schijf aansluiten, data overpompen, om vervolgens de laatste schijf aan de pool toe te voegen....

Ik merk nu dat ik daar enorm tegenop kijk.. Ik denk dat ik maar van iemand een externe schijf ga lenen..

PV: 10,4 kWp | EV: Tesla M3 LR ‘19 | L/W WP: Panasonic WH-MDC07J3E5 + PAW-TD20C1E5 | L/L WP: Daikin FVXM35A/RXM35R + Daikin FTXM25R/RXM25R + MHI 2x SRK25ZS-WF/SCM40ZS-W

Even niets...

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

FireDrunk schreef op woensdag 25 maart 2015 @ 08:44:

Player-X heeft op zich wel een punt, *mits* hij van elke losse VDEV een losse pool maakt, en niet alles in 1 pool stopt. Dan helpt het wel.

Ook moet je dus goed opletten dat je niet zegt in applicaties als SabNZBd dat de temp dir op de ene pool staat, en de uitpak dir op de andere.

Tenzij je echt met een performance van enkele tientallen MB/s genoegen neemt...

Als je dat soort applicaties alleen 's nachts draait, is het op zich geen probleem...

Even niets...

De behuizing heeft hij al, een oude los staande serverbehuizing, net zo iets als ik heb, maar nog iets groter, en met ketting band is daar best makkelijk om er 60 HDDs in te hangen.jacovn schreef op woensdag 25 maart 2015 @ 09:03:

Een behuizing voor zo veel drives lijkt me ook niet goedkoop.. Maar wellicht is het een handig iemand en wordt het een zelfbouw zelfbouw pod of zo ?

.

Dat is wat ik ook dacht, want op die manier spreek je elke keer maar een poort tegelijk aan.FireDrunk schreef op woensdag 25 maart 2015 @ 09:50:

Inderdaad, enige wat je dan krijgt is als je verkeer tussen pools hebt, dat is dan extreem traag.

Dat is ook geen probleem, want dit is de manier dat ik het ga opzetten.Ook moet je dus goed opletten dat je niet zegt in applicaties als SabNZBd dat de temp dir op de ene pool staat, en de uitpak dir op de andere.

Tenzij je echt met een performance van enkele tientallen MB/s genoegen neemt...

Als je dat soort applicaties alleen 's nachts draait, is het op zich geen probleem...

C:\ 160GB 2.5'' - Systeem

D:\ 320GB 2.5'' - Temp download schijf voor tijdelijke torrent en newsgroup files en dergelijke.

E:\ 3TB uitpak schijf en waarvan af de meeste video files beken kunnen worden.

F:\ 60TB pool van de 5 vdev's.

Op die manier is het systeem het zuinigst, en draait de grote array alleen maar als hij wat uit archief wil bekijken.

Gaat een intressant project worden, ben zelf nog niet zo enorm ervaren met ZFS, dus als hij nu de kaartjes besteld, worden ze over 2~3 weken geleverd, dan heb ik een leuk project in mijn off tijd wanneer ik terug kom van offshore om beter bekend te worden met Linux en ZFS.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Misschien is het wel leuk om de configs waar wij van zeggen niet doen, wel eens op de pijnbank te leggen om daadwerkelijk aan te tonen dat het niet goed werkt.

Even niets...

[ Voor 16% gewijzigd door thibautb op 25-03-2015 21:10 ]

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Dat valt mooi op te lossen met een PCI-e raiser PCI-e x16 naar x1.

Thanks, maar ik kom uit Utrecht en heb al iets kunnen regelen.nMad schreef op woensdag 25 maart 2015 @ 08:14:

Als je in de buurt van Groningen woont mag je je data wel tijdelijk op mijn NAS parkeren, ik heb nog 5,5 TB vrij.

Indien nodig, een PCI-e raiser werkt natuurlijk prima, maar maakt het plaatsen van de kaart wat lastiger.GioStyle schreef op donderdag 26 maart 2015 @ 08:17:

Dat valt mooi op te lossen met een PCI-e raiser PCI-e x16 naar x1.

Het open vrezen van de achterkant van het slot gaat ook prima, heb het zelf al 2x gedaan, probeer het eerst op een oud defect mobo voor ervaring, en daarna op het bewuste moederbord zelf.

Er zijn wat dingen waar je op moet letten, ten eerste werk rustig, zodat het plastic niet te heet wordt en smelt, en gebruik een scherpe frees, daarnaast helpt het als iemand helpt met een stofzuiger het verspaande materiaal weg zuigt.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Afhankelijk van de ruimte in je kast is een PCIe riser kaartje een bruikbare optie. Even een partijtje onbeschaamde zelfbevlekkingplayer-x schreef op donderdag 26 maart 2015 @ 08:48:

[...]

Indien nodig, een PCI-e raiser werkt natuurlijk prima, maar maakt het plaatsen van de kaart wat lastiger.

Het open vrezen van de achterkant van het slot gaat ook prima, heb het zelf al 2x gedaan, probeer het eerst op een oud defect mobo voor ervaring, en daarna op het bewuste moederbord zelf.

Er zijn wat dingen waar je op moet letten, ten eerste werk rustig, zodat het plastic niet te heet wordt en smelt, en gebruik een scherpe frees, daarnaast helpt het als iemand helpt met een stofzuiger het verspaande materiaal weg zuigt.

Een slot 'open ended' zagen is een optie en zoals player-x terecht zegt iets dat met de nodige zorg gedaan moet worden, het laatste wat je wilt is t slot smelten aan de t openen kant of een van de slip contacten in de haast kapot trekken (been there, done it

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Het is jammer dat ze er geen stroom aansluiting op hebben gezet zo als bij de Intel expander.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Ik sta zeker open voor andere ideëen hoor, hij moet gewoon een ssf 8088 aansluiting hebben en toch minstens 4 x ssf 8087 poorten. En liefst onder de 220 euro. En het liefst uit eu of uk want dan heb je geen invoerkosten...player-x schreef op donderdag 26 maart 2015 @ 12:50:

Voor zover ik weet haalt hij alleen maar stroom uit de PCIe bus, daar een expander voor de rest geen aansturing nodig heeft van uit de bus.

Het is jammer dat ze er geen stroom aansluiting op hebben gezet zo als bij de Intel expander.

Maar deze bedoel je dus? http://www.ebay.co.uk/itm...ain_0&hash=item339f8cb4de

[ Voor 19% gewijzigd door thibautb op 26-03-2015 13:00 ]

En als ik het goed heb kan je kiezen tussen 2x SAS naar 4x SAS, of 1x SAS naar 5x SAS.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Dus eigenlijk wil je een storage chassis bouwen, kijk bij ServeTheHome voor goede ideeën.thibautb schreef op donderdag 26 maart 2015 @ 12:46:

Ik was eigenlijk van plan om de sas controller card in de storage server pc te zetten en dan via de achterkant naar mijn main rig te doen, (asus x99 deluxe in lian li pc-d800 case met heel wat hdd plek.) die heeft nog 2 x16 sloten vrij. En dan dus een ssf 8088 kabel van controller naar expander doen en dan expander sff 8087 naar 4x sata x een paar keer. Zo moet het toch wel lukken? Of gaan er misschien problemen zijn met dat ik de expander in een andere pc dan de controller heb zitten? Want anders doe ik dat niet. De pc wordt trouwens zelden herstart , 1 keer om de 10 dagen meestal voor windows updates.

Als je de genoemde Supermicro CSE-PTJBOD-CB1 JBOD power board in combi met een powered PCIe riser gebruikt kun je o.a de HP/lenovo SAS expander van prik te voorzien via t PCIe slot of een Intel SAS expander direct vanaf de PSU (molex).

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik heb als behuizing deze kast: Nexus Edge waar 9 HDD's in kunnen en er dan nog 9 5.25 plekken in zitten. (8 vrij en 1 bovenaan die vrij gemaakt kan worden) Met wat gesleutel zijn daar 3 5-in-3 units in te plaatsen, wat het totaal op 24 schijven brengt. Zonder gesleutel is er in ieder geval plek voor 20 schijven.

Het hoeft voor mij allemaal niet hot-swappable en ik heb qua form factor liever een fulltower dan een 4U rack.

Ik ben van plan een Freenas based RAID-Z2 te gaan gebruiken gebaseerd op VDEVs van 6 schijven. (4TB seagate ST4000DM000) wat neer zou komen op 16TB nuttige ruimte per VDEV. Goed te overzien en in de toekomst kan ik VDEVs van 6 disks toevoegen om uit te breiden naar 12, 18 en eventueel 24 disks.

ECC geheugen vind ik een fijne gedachte en daar wil ik ook wel wat geld aan uitgeven.

Ik zie alleen door de bomen het bos niet meer qua moederborden en cpu, kunnen jullie wat aanraden?

Als starthoeveelheid geheugen zat ik aan 16GB te denken. Maar aangezien deze setup ooit max 64 TB opslag aan moet kunnen zou ik dan een moederbord nodig hebben wat 64 GB ECC geheugen aan kan? Of is 32 GB genoeg voor thuisgebruik? Dat zou namelijk ook al wat in de kosten schelen.

Om die hoeveelheid HDD's aan te kunnen lijkt me dat ik nog 2 stuks IBM M1015 nodig heb, die ik dan om flash.

TL;DR

Ik zoek een moederbord en processor die in combinatie met ECC geheugen en twee IMB M1015 kaarten Freenas voor thuisgebruik kunnen draaien met max 24 schijven en 64TB opslag in RAID-Z2.

7DII | Canon 10-18 IS STM | Sigma 18-35 1.8 | Canon 100L | Canon MP-E 65mm

Verwijderd

Je kunt kijken voor een SuperMicro bord met ingebouwde LSI SAS controller. Er is een bord waarbij er twee Mini-SAS connectors op zitten. Die gaan naar 12 schijven. 8 van de LSI controller en 4 van de chipset, naast nog 2 normale SATA connectors. Deze:

En kijk ook eens naar dit overzicht van moederborden.

Tip: kies eerst de software, die bepaalt welke hardware je nodig hebt. Kies dan eerst een moederbord, omdat dat alles bepaalt wat je er verder nog op kwijt kunt. Dat is een mooi startpunt lijkt me.

Gruson schreef op vrijdag 27 maart 2015 @ 22:53:

Ik heb jullie advies nodig.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i3-4160 Boxed | € 117,20 | € 117,20 |

| 1 | Supermicro X10SL7-F | € 265,95 | € 265,95 |

| 4 | Crucial CT102472BD160B | € 84,- | € 336,- |

| 1 | Seasonic G-series 360 watt | € 57,95 | € 57,95 |

| Bekijk collectie Importeer producten | Totaal | € 777,10 | |

Zoiets?

PV: 10,4 kWp | EV: Tesla M3 LR ‘19 | L/W WP: Panasonic WH-MDC07J3E5 + PAW-TD20C1E5 | L/L WP: Daikin FVXM35A/RXM35R + Daikin FTXM25R/RXM25R + MHI 2x SRK25ZS-WF/SCM40ZS-W

1. Moederboard met on-board 2xSAS poorten

2. Chassis met

a. 24+ hot-swap drives

b. ingebouwde expander waar de 2 onboard SAS op kan worden aangesloten

Bestaat dit? Ik meen dat de grotere chassis van SuperMicro dit hebben, maar die zijn wel 1K+ qua prijs.

Een variant is

1. Moederboard met on-board 2xSAS poorten

2. SAS expander

3. Chassis met 24+ hot-swap drives

De kern van het idee is dat je dus geen losse HBA hoeft te kopen en dus ook geen moederboard nodig hebt met veel PCIe slots, hooguit 1x voor een 10Gbit kaart als je dat wilt.

Ik heb zelf 3 x M1015 in mijn machine gezet maar een SAS expander met een on-board SAS HBA was goedkoper geweest en had ook twee PCIe poorten gescheeld.

De grote vraag is eigenlijk hier dan welke SAS expander het beste is aan te bevelen.

[ Voor 5% gewijzigd door Q op 28-03-2015 09:48 ]

Verwijderd

Ik ben juist een groot voorstander van de reguliere route met 'echte' poorten ipv alles op een expander te proppen. Je spaart PCIe slots uit ja. Maar dat wil je toch juist niet? Je wilt dat je disks zoveel mogelijk bandbreedte krijgen en alle PCIe lanes benutten. Daar heb je die dingen voor.

Natuurlijk wil je wel dat je configuratie geschikt is voor wat je er mee wilt. Wil je over een jaar kunnen uitbreiden, dan wil je daar rekening mee houden in je build. Het kan zijn dat voor hele grote builds (72+ disks) je niet zonder expanders kunt.

Is het echt zoveel goedkoper dat je de mogelijke performance/latency en compatibility issues van expanders op de koop toe wilt nemen? Het zal best beter zijn dan vroeger, maar het beste is natuurlijk gewoon maximale bandbreedte voor elke disk. En het intact blijven van de point-to-point opzet van de PCI-express interface.

Ik snap dat de meningen sterk kunnen verschillen op dit punt. Maar waar wringt het schoentje? Is het honderd euro duurder op een prijs van 5000 euro? Mijn punt zou zijn dat op zo'n hoge kostprijs het kleine prijsverchil niet doorslaggevend hoeft te zijn.

[ Voor 7% gewijzigd door Verwijderd op 28-03-2015 10:57 ]

Minder lanes, minder pci-e sloten.

Een x10sl7-f is wel populair, maar je hebt maar een x8 en x4 slot naast de 8+6 on board sas/sata poorten.

Met inderdaad een 10ge kaart erbij past er maar een x8 kaart bij. Dan kun je al niet meer uit met een M1015 maar moet je een kaart met 16 interfaces nemen.

Voor een 20 disk unit met 2x raidz2 met 10 disks is het allemaal prima.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Verwijderd

Ik snap dat het op een gegeven moment lastig wordt. Maar dan praten we ook over monster builds. En dan is een dual socket moederbord ook iets wat binnen de mogelijkheden ligt, met tot 8 PCIe slots erop.

Kortom, is de keuze voor expanders echt zo'n no-brainer? Ik ben daar heel sceptisch over.

Dat is interessant, maar hebben we het hier over 1 type chassis dat ooit problemen gaf? Op basis daarvan zou ik geen generieke statements willen maken.Verwijderd schreef op zaterdag 28 maart 2015 @ 10:56:

Nou dat zou juist hetgeen zijn wat ik afraad. Bovendien veel probleemverhalen over gehoord de Norco met ingebouwde expander. Ik raad juist sterk aan dat mensen een Norco met ' domme' backplane gebruiken; gewoon Mini-SAS connectors voor elke 4 disks.

Hier is trouwens een link naar de opties voor SuperMicro, erg interessant:

http://www.natecarlson.co...assis-with-36-drive-bays/

Een doorsnee 8-poort HBA (los of on-board) zoals de IBM M1015 (super veel gebruikt) heet 8 SAS poorten van 6 Gb/s. De totale bandbreedte is dus 8x6 = 48 Gbit = 6 GB/s = 6 gigabytes per seconde. Stel dat je vanwege de expander maar de helft krijgt (geen enkel bewijs voor maar puur om een worst-case scenario te schetsen), dan heb je nog steeds 3 GB/s. Mijn 71 TB NAS haalt dat alleen in een RAID0 of met legacy software RAID.Ik ben juist een groot voorstander van de reguliere route met 'echte' poorten ipv alles op een expander te proppen. Je spaart PCIe slots uit ja. Maar dat wil je toch juist niet? Je wilt dat je disks zoveel mogelijk bandbreedte krijgen en alle PCIe lanes benutten. Daar heb je die dingen voor.

Ik zie geen enkele aanwijzing dat een enkele IBM M1015 of een on-board controller een bottleneck zou kunnen vormen. Wat ik mij kan voorstellen is dat het anders werkt als je er SATA schijven op aansluit, dat dit een impact heeft op de bandbreedte. Op dat gebied laat ik mij graag onderwijzen.

Update: de M1015 heeft een 8x PCIe 2.0 interface. 1 lane doet 4 Gbit, dus zit je op max 32 Gbit = 4 Gigabytes per seconde. Poe poe

Het is een combinatie van prijsverschil en hoeveel PCIe slots je vrijhoudt, mocht dat uitmaken. Met geld kun je alles oplossen. Maar ergens moet je het ook voor jezelf kunnen verantwoorden. Althans, dat heb ik dan (ik weet het, zou je niet zeggen met een 71 TB NAS, maar je begrijpt wel wat ik bedoel).Ik snap dat de meningen sterk kunnen verschillen op dit punt. Maar waar wringt het schoentje? Is het honderd euro duurder op een prijs van 5000 euro? Mijn punt zou zijn dat op zo'n hoge kostprijs het kleine prijsverchil niet doorslaggevend hoeft te zijn.

[ Voor 6% gewijzigd door Q op 28-03-2015 11:45 ]

Maar ja ik heb laatst ook nog een M1115 gekocht voor 42 euro, die was ook maar 5€ per poort.

Als je nieuwprijs voor alles neemt zal het minder ver uiteen lopen.

Alleen zoals bartm het doet met 1 dikke controller en dan een expander in een apart chassis, bespaar je moederbord, cpu en ram uit. Je betaalt natuurlijk iets van 35€ voor een bordje om de kast te laten starten en zo ook de extender van stroom te voorzien. Dan moet je externe sff-8088 kabels, en converters van sff-8087 naar sff-8088 indien je geen expander hebt met een 8088 poort, of geen controller met 8088 poort. Dat zijn allemaal ook wel dure onderdelen als je ze niet in China vie ebay koopt.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

het zijn juist de backplanes van Norco waar de problemen mee zijn.Verwijderd schreef op zaterdag 28 maart 2015 @ 10:56:

Nou dat zou juist hetgeen zijn wat ik afraad. Bovendien veel probleemverhalen over gehoord de Norco met ingebouwde expander. Ik raad juist sterk aan dat mensen een Norco met ' domme' backplane gebruiken; gewoon Mini-SAS connectors voor elke 4 disks.

in theorie ja, in de praktijk volstaat de SAS2 bandbreedte voor een DIY RAID NAS. Ik haal zo bijvoorbeeld 1GB/s sustained bij kopieer actie tussen 2x 12 disk raid6 volumes.Ik ben juist een groot voorstander van de reguliere route met 'echte' poorten ipv alles op een expander te proppen. Je spaart PCIe slots uit ja. Maar dat wil je toch juist niet? Je wilt dat je disks zoveel mogelijk bandbreedte krijgen en alle PCIe lanes benutten. Daar heb je die dingen voor.

met SAS expanders heb je maar één PCI-E slot nodig dus kan je hele setup eenvoudiger. Naar mijn ervaring is het makkelijker om een moederbord met één SAS HBA en meerdere expanders werkend te krijgen dan 3 SAS HBA's in één moederbord werkend te krijgen.Ik snap dat de meningen sterk kunnen verschillen op dit punt. Maar waar wringt het schoentje? Is het honderd euro duurder op een prijs van 5000 euro? Mijn punt zou zijn dat op zo'n hoge kostprijs het kleine prijsverchil niet doorslaggevend hoeft te zijn.

Compatibiliteit issue's van SAS expanders zijn tegenwoordig met gangbare hardware nauwelijks nog aan de orde.

Schaalbaarheid is voor mij een grote plus. Ik kan in theorie tot 128 disks aan een controller hangen en dat is goed te doen met 5x een 24 disk enclosure waar dan alleen een SAS expander in hoeft. Daarbij hoef ik dan alleen maar hetzelfde toe te voegen als dat wat ik nu al heb en weet dan zeker dat het probleemloos werkt en allemaal benaderbaar is als één NAS systeem.

Ik vraag mij juist af waarom jij moeilijk en in mijn ogen denigrerend doet en terwijl de eenvoudige oplossing aantoonbaar werkt en volstaat.

Een vriend van me is hem al een paar maanden aan het testen samen met BtrFS, en heeft nog geen hardware problemen ondervonden, het zelfde geld trouwens voor BtrFS R6 met de laatste build.

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Ik ze 169 MB/sec gaan nu.Pantagruel schreef op maandag 23 maart 2015 @ 13:35:

[...]

Idd NFS share, local mount en dan met mc een copy actie (smb werkt ook, maar niet zo rap als NFS)

Dat is dan tussen ZFSguru machines die 10.1 draaien en buffers etc, voor 10Ge aangepast hebben met een MTU van 1500.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Tja proberen..

Windows 7 gaat naar 9014 (payload en headers)

FreeBSD naar 9000 (alleen payload)

Switch maar naar 9216 gezet zodat die geen limiet zou moeten zijn.

Helaas kan er geen ping van 9000 door heen.

Dit is de maximale MTU die nonfragmented er door kan..

1

2

3

4

5

6

7

8

9

10

11

12

| C:\Users\root>ping 192.168.3.152 -f -l 8972

Pinging 192.168.3.152 with 8972 bytes of data:

Reply from 192.168.3.152: bytes=8972 time<1ms TTL=64

Reply from 192.168.3.152: bytes=8972 time<1ms TTL=64

Reply from 192.168.3.152: bytes=8972 time<1ms TTL=64

Reply from 192.168.3.152: bytes=8972 time<1ms TTL=64

Ping statistics for 192.168.3.152:

Packets: Sent = 4, Received = 4, Lost = 0 (0% loss),

Approximate round trip times in milli-seconds:

Minimum = 0ms, Maximum = 0ms, Average = 0ms |

Dit is 28 bytes minder wat neem ik aan (20 byte IP header en 8 byte ICMP header) zijn.

Als ik een smb share prober te mappen krijg ik time outs.

Dus het lijkt dat er ergens toch iets niet goed gaat met een MTU.

Windows geeft aan:

C:\Users\root>netsh interface ipv4 show subinterfaces

1

2

3

4

5

6

7

8

9

| MTU MediaSenseState Bytes In Bytes Out Interface ------ --------------- --------- --------- ------------- 4294967295 1 0 335245 Loopback Pseudo-Interface 1 1500 5 0 0 Local Area Connection 1500 5 0 0 Local Area Connection 2 1500 1 11568740 4253005 Local Area Connection 8 9000 5 0 0 Local Area Connection 11 1500 5 0 0 Local Area Connection 13 9000 1 940898 1707806 Local Area Connection 12 |

Het gaat om de onderste.. die is 9000 netto zo te zien.

Op de FreeBSD kant:

1

2

3

4

5

6

7

8

9

| [root@zfsguru2 /home/ssh]# ifconfig -a

ix0: flags=8843<UP,BROADCAST,RUNNING,SIMPLEX,MULTICAST> metric 0 mtu 9000

options=8407bb<RXCSUM,TXCSUM,VLAN_MTU,VLAN_HWTAGGING,JUMBO_MTU,VLAN_HWCSUM,TSO4,TSO6,LRO,VLAN_HWTSO>

ether 90:e2:ba:16:c8:1c

inet 192.168.3.152 netmask 0xffffff00 broadcast 192.168.3.255

inet6 fe80::92e2:baff:fe16:c81c%ix0 prefixlen 64 scopeid 0x1

nd6 options=29<PERFORMNUD,IFDISABLED,AUTO_LINKLOCAL>

media: Ethernet autoselect (10Gbase-Twinax <full-duplex>)

status: active |

Switch:

1

2

3

4

| eth1/0/25 9216 eth1/0/26 9216 eth1/0/27 9216 eth1/0/28 9216 |

update: alles gereboot en het werkt ????

Tja, 153 MB/sec

Helpt ook niet echt zo te zien.

[ Voor 100% gewijzigd door jacovn op 29-03-2015 14:44 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Even niets...

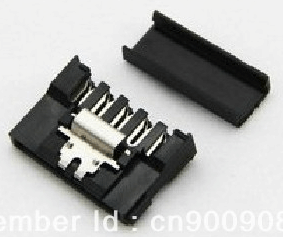

Voor de gene die geïnteresseerd zijn om zelf SATA power kabels te maken, of extra connectoren op hun powerkabel te plaatsen, hier kan je voor 32 euro 100 connectoren kopen, van uitstekende kwaliteit, met lostrek beveiliging.

Als 100 te veel is, dan misschien meerdere mensen ze dan samen kunnen kopen en onderling verdelen.

[ Voor 11% gewijzigd door player-x op 29-03-2015 22:56 ]

[dislectie] hoeveel forum deelnemers heb je nodig om een peertje te vervangen ?

Helaas met NFS nog steeds maar 150 MB/sec tussen 2 systemen,

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

[ Voor 7% gewijzigd door FireDrunk op 31-03-2015 09:24 ]

Even niets...

Bedoeling is dat hij niet alleen centrale backup biedt thuis, maar ook als media server kan draaien. Mijn vraag is nu: welk OS gebruik ik het beste? In eerste instantie dacht ik aan DSM 5.1 via XPEnology, maar ik weet niet of die iets interessants kan doen met de 2x 250GB schijven. Anders wordt het een of andere Linux distro.

Daarnaast, aangezien dit echt allemaal nieuw is voor me: als ik de 3TB schijven in RAID1 zet, is dit dan later makkelijk uit te breiden? Kan ik er gewoon extra schijven in rammen wanneer het uitkomt?

Bij voorbaat dank.

Even niets...

Dus ja, dat maakt nogal veel uit

Even niets...

Is dat zo simple als:FireDrunk schreef op dinsdag 31 maart 2015 @ 09:23:

rsize en wsize al opgehoogd?

mount -o nfsv3,rsize=32768,wsize=32768 host:/share /localdirectory/

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Je kan ook nog async proberen, maar dat is (uiteraard) iets onveiliger.

Even niets...

Aha, weer wat geleerd. Ok, dan zal ik even wachten met mijn vraag tot er meer duidelijk is over de hardware.FireDrunk schreef op dinsdag 31 maart 2015 @ 10:32:

En sommige controllers wil je helemaal niet onder BSD of Linux gebruiken. Andere controllers werken helemaal niet onder XPenology...

Dus ja, dat maakt nogal veel uit

Ik heb een tijdje terug deze gekocht:player-x schreef op zondag 29 maart 2015 @ 22:54:

Eerdere post:

Voor de gene die geïnteresseerd zijn om zelf SATA power kabels te maken, of extra connectoren op hun powerkabel te plaatsen, hier kan je voor 32 euro 100 connectoren kopen, van uitstekende kwaliteit, met lostrek beveiliging.

Als 100 te veel is, dan misschien meerdere mensen ze dan samen kunnen kopen en onderling verdelen.

[afbeelding]

http://www.ebay.com/itm/5...te-with-cap-/111632208350?

Hebben niet die clip erop als beveiliging. Maar wel per 5 (of 20) ipv 100. (daardoor ook wel duurder per stuk uiteraard).

Met MTU9000FireDrunk schreef op dinsdag 31 maart 2015 @ 10:42:

Ja, of in fstab.

Je kan ook nog async proberen, maar dat is (uiteraard) iets onveiliger.

rsize=32768,wsize=32768 -> 110 MB/sec

wsize=262144,rsize=262144 -> 150 MB/sec

Dus zonder size op te geven hetzelfde als met size is 256KB

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Even niets...

Ben er inmiddels achter: een nondescripte sweex raid controller. De schijven staan in RAID1 en ik vermoed dat de controller ook niet meer dan RAID 0 en 1 ondersteund.FireDrunk schreef op dinsdag 31 maart 2015 @ 10:02:

Wat voor RAID Controller zit er in?

Waar ik eerst dacht dat er 4 schijven in zaten (2x 250GB en 2x 3TB), blijkt nu dat alleen de 3TB schijven erin zitten.

Ik denk dat ik de schijven beter gewoon in RAID1 laat zitten en XPEnology erop gooi indien dat mogelijk is. Veel hoeft hij ook niet te kunnen.

Even niets...

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Trouwens: is het mogelijk om van een RAID1 configuratie later een RAID5 configuratie te maken zonder data te verliezen? Als ik ooit wat schijven erbij wil proppen, dan weet ik niet of RAID1 nog wel zo handig is. Zo superveilig hoeft mijn data nu ook weer niet te zijn.

40 MB/secFireDrunk schreef op dinsdag 31 maart 2015 @ 12:58:

Je kan ook iets kleiner proberen: 8192 bijvoorbeeld. Dan is 1 NFS pakketje even groot als 1 TCP pakketje. Kan mooi matchen.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Terug naar 9K MTU en 256 KB en 150 MB/sec

Gelukkig kan ik met meer dan 300 MB/sec van PC naar de nas data overzetten. Het lijkt de read performance te zijn, copy terug van nas is ook maar goed 100 MB/sec/

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Even niets...

zpool iostat -v 1

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

| capacity operations bandwidth

pool alloc free read write read write

----------------------- ----- ----- ----- ----- ----- -----

bootski3 1.93G 9.95G 0 0 0 0

gpt/Bootski-disk1 1.93G 9.95G 0 0 0 0

----------------------- ----- ----- ----- ----- ----- -----

tank5 16.2T 20.1T 1.22K 0 155M 0

raidz2 16.2T 20.1T 1.22K 0 155M 0

gpt/7K4000_PAH2558S - - 194 0 18.6M 0

gpt/7K4000_PAH2KW1S - - 193 0 18.6M 0

gpt/7K4000_PAH35T7S - - 201 0 18.6M 0

gpt/7K4000_PAGYN28S - - 201 0 18.6M 0

gpt/7K4000_PAGW6JRW - - 200 0 18.7M 0

gpt/7K4000_PAH2HHKS - - 206 0 18.6M 0

gpt/7K4000_PAH2GB9S - - 201 0 18.7M 0

gpt/7K4000_PAH2AU1S - - 206 0 18.6M 0

gpt/7K4000_PAH2DBPS - - 200 0 18.6M 0

gpt/7K4000_PAH2HGPS - - 205 0 18.6M 0

----------------------- ----- ----- ----- ----- ----- ----- |

Dat zal 150 MB / 8 (raidz2 over 10 hdds)

met gstat:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

| [root@zfsguru3 /home/ssh]# gstat

dT: 1.037s w: 1.000s

L(q) ops/s r/s kBps ms/r w/s kBps ms/w %busy Name

0 203 203 19028 1.1 0 0 0.0 8.2| da0

0 204 204 19013 0.9 0 0 0.0 7.0| da1

0 202 202 19024 1.2 0 0 0.0 8.0| da2

0 204 204 18978 1.4 0 0 0.0 9.5| da3

0 203 203 18978 1.3 0 0 0.0 8.8| da4

0 203 203 18982 1.3 0 0 0.0 8.5| da5

0 206 206 18932 0.9 0 0 0.0 6.9| da6

0 203 203 18982 1.2 0 0 0.0 8.0| da7

0 0 0 0 0.0 0 0 0.0 0.0| ada1

0 200 200 18989 1.4 0 0 0.0 9.4| ada2

0 197 197 19016 1.6 0 0 0.0 10.6| ada3 |

Die 1e kolom geeft aan dat de drive direct data aanlevert blijkbaar,

[ Voor 25% gewijzigd door jacovn op 01-04-2015 06:40 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Even niets...

1 malige lees actie en dat zou toch van de pool moeten komen met dik 100 MB/sec per hdd normaal ?

Het zijn HGST 7K4000 hdd's in dit geval waar vanaf gelezen wordt.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

In the long run kunnen je transfers hier substantieel sneller van worden

Net even gekeken:

[root@NAS ~]# cat /sys/module/zfs/parameters/zfs_vdev_cache_size 0 [root@NAS ~]# cat /sys/module/zfs/parameters/zfs_vdev_cache_max 16384 [root@NAS ~]# cat /sys/module/zfs/parameters/zfs_vdev_cache_bshift 16

Op ZFSonLinux staat het dus default uit voor zover ik de waardes begrijp.

Zojuist hier aangepast:

[root@NAS ~]# cat /etc/modprobe.d/zfs.conf options zfs zfs_arc_max=17179869184 options zfs zfs_vdev_cache_size=16777216

Ging met een DD transfer van 207MB/s naar 218MB/s

[ Voor 52% gewijzigd door FireDrunk op 01-04-2015 08:22 ]

Even niets...

# vdev pending requests

# this manages the minimum/maximum of outstanding I/Os on the vdevs

# this should be safe to tune; best setting depends on your disks

# ssds may prefer higher settings

# on some systems, setting both to 1 will improve sequential I/O

#vfs.zfs.vdev.min_pending="4"

#vfs.zfs.vdev.max_pending="32"

Geen ideewat de default is, maar snelle goolge search laat 35 zien ???

Ik zal als deze copy job klaar is de dingen die jij opgeeft aanpassen.

[ Voor 7% gewijzigd door jacovn op 01-04-2015 08:41 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Normaal gesproken kan zfs dus wel 30 seconden reads en writes verzamelen.

ZFSonLinux heeft de default dacht ik ook al aangepast naar 5/5 en de nieuwste versies van BSD zijn hier dacht ik al in mee.

1/1 is goed voor sequentiele transfers.

Even niets...

l

vfs.zfs.prefetch_disable="0"

vfs.zfs.vdev.cache.size="64M"

vfs.zfs.vdev.cache.max="65536"

Dit maakt niet uit, al lijkt het nu op 145 MB/sec te maximaliseren.

Daarna heb devolgende aanpassing in sysctl.conf gezet:

vfs.zfs.l2arc_write_boost=268435456 # (default 8388608)

vfs.zfs.l2arc_write_max=268435456 # (default 8388608)

Geen verbertering.

Als laatste in de loader.conf:

vfs.zfs.vdev.min_pending="1"

vfs.zfs.vdev.max_pending="1"

Dan is de overdracht snelheid rond de 143 MB/sec

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Iperf was sneller toch?

Even niets...

Dat hele FreeBSD lijtk wel opgezet te zijn voor 1 Gigabit Ethernet (dat gebruikt ook de meerderheid van de installaties denk ik) want het is wel heel veel werk om er meer snelheid uit te krijgen..

De server waar de copy naar toe loopt heeft wel redelijk wat buffer geheugen in gebruik volgens de GUI:

Application memory 53 MiB 0.2%

Inactive memory 5.5 GiB 17.2%

Caches 149 MiB 0.5%

Buffers 1 .6 GiB 5%

Bij dat inactive staat in de GUI dat het cache is.

processor use is 180-200%

1

2

3

4

5

6

| last pid: 1502; load averages: 1.88, 1.56, 1.06 up 0+00:47:25 11:55:36 31 processes: 2 running, 29 sleeping Mem: 39M Active, 5706M Inact, 25G Wired, 93M Cache, 1655M Buf, 500M Free ARC: 23G Total, 738M MFU, 22G MRU, 36M Anon, 85M Header, 46M Other Swap: 2048M Total, 14M Used, 2034M Free |

De server die de data ophoest staat weinig tot niets te doen zo te zien met 25-30%

Zou de bottleneck de onvangende kant zijn dan met alle ZFS overhead om de files weg te schrijven ?

[ Voor 120% gewijzigd door jacovn op 01-04-2015 11:58 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Even niets...

gewoon iostat zie ik dit:FireDrunk schreef op woensdag 01 april 2015 @ 12:00:

Kijk anders eens met 'nfsiostat' of je iets geks ziet.

ssh@zfsguru2 ~]$ iostat -w 1 ada2 ada3 da0 da1

1

2

3

4

5

6

7

8

9

10

11

12

| tty ada2 ada3 da0 da1 cpu tin tout KB/t tps MB/s KB/t tps MB/s KB/t tps MB/s KB/t tps MB/s us ni sy in id 0 4884 78.07 220 16.76 78.07 220 16.76 77.92 220 16.76 77.91 220 16.76 10 0 14 1 75 0 1648 79.86 222 17.30 80.18 221 17.29 80.66 219 17.23 80.66 219 17.23 9 0 15 2 74 0 808 74.12 241 17.41 75.39 237 17.41 75.21 237 17.37 76.57 233 17.39 11 0 14 2 74 0 915 79.26 223 17.24 79.73 222 17.27 80.73 219 17.25 82.50 214 17.22 10 0 15 2 73 0 1095 82.62 214 17.25 82.16 215 17.23 84.02 210 17.21 84.02 210 17.21 9 0 14 2 74 0 839 82.85 213 17.20 79.35 223 17.25 80.42 220 17.24 83.30 212 17.21 10 0 15 2 73 0 943 88.30 298 25.67 88.66 297 25.69 91.35 288 25.67 92.86 283 25.64 11 0 17 2 70 0 1056 71.84 249 17.45 71.63 250 17.47 74.14 241 17.43 77.57 230 17.40 12 0 14 2 72 0 906 79.73 222 17.27 79.77 222 17.28 82.93 213 17.24 85.57 206 17.20 12 0 14 2 72 0 915 87.05 245 20.81 85.53 248 20.69 87.41 259 22.09 88.72 255 22.07 11 0 16 1 71 |

Dit zijn dan 4 members van de pool waar naar geschreven wordt.

nfsstat:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

| [root@zfsguru2 /home/ssh]# nfsstat -c

Client Info:

Rpc Counts:

Getattr Setattr Lookup Readlink Read Write Create Remove

129714 1 249203 0 158191781 0 0 0

Rename Link Symlink Mkdir Rmdir Readdir RdirPlus Access

0 0 0 0 0 21509 0 132023

Mknod Fsstat Fsinfo PathConf Commit

0 20594 6 60 0

Rpc Info:

TimedOut Invalid X Replies Retries Requests

0 0 0 0 158744891

Cache Info:

Attr Hits Misses Lkup Hits Misses BioR Hits Misses BioW Hits Misses

1264995227 129708 2119741 249203 1104237396 158191781 0 0

BioRLHits Misses BioD Hits Misses DirE Hits Misses Accs Hits Misses

0 0 19856 21386 20515 0 2366606 132023 |

[ Voor 24% gewijzigd door jacovn op 02-04-2015 08:22 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

dd if=/dev/zero bs=1M | nc 1.2.3.4 1234

other host (1.2.3.4)

nc -l -p 1234 | dd of=/dev/null bs=1M

[root@zfsguru2 /]# dd if=/dev/zero bs=1000M count=10 | nc -v -v -n 192.168.3.153 2000

Connection to 192.168.3.153 2000 port [tcp/*] succeeded!

10+0 records in

10+0 records out

10485760000 bytes transferred in 16.309566 secs (642920847 bytes/sec)

^C

[root@zfsguru3 /etc]# nc -v -l -n 2000 >/dev/null &

[2] 16373

[root@zfsguru3 /etc]# Connection from 192.168.3.152 49337 received!

^C

[2]+ Done nc -v -l -n 2000 > /dev/null

Dat is dan 1 sessie met 642 MB/sec als ik goed kan lezen.

Jouw voorbeeld doet het niet, maar als ik dat aanpas voor aover ik het snap:

[root@zfsguru2 /]# dd if=/dev/zero bs=1M | nc 192.168.3.153 1234

^C7+0 records in

6+0 records out

6291456 bytes transferred in 34.801396 secs (180782 bytes/sec)

Dat is wel heel veel lager..

Maar een factor 1000 in file size..

iperf:

iperf -c 192.168.3.153 -P 1 -i 1 -p 5001 -f M -t 10

iperf -s -P 0 -i 1 -p 5001 -f M

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

| [root@zfsguru2 /]# iperf -c 192.168.3.153 -P 1 -i 1 -p 5001 -f M -t 10 ------------------------------------------------------------ Client connecting to 192.168.3.153, TCP port 5001 TCP window size: 2.01 MByte (default) ------------------------------------------------------------ [ 3] local 192.168.3.152 port 50742 connected with 192.168.3.153 port 5001 [ ID] Interval Transfer Bandwidth [ 3] 0.0- 1.0 sec 988 MBytes 988 MBytes/sec [ 3] 1.0- 2.0 sec 1052 MBytes 1052 MBytes/sec [ 3] 2.0- 3.0 sec 1135 MBytes 1135 MBytes/sec [ 3] 3.0- 4.0 sec 1183 MBytes 1183 MBytes/sec [ 3] 4.0- 5.0 sec 1075 MBytes 1075 MBytes/sec [ 3] 5.0- 6.0 sec 1181 MBytes 1181 MBytes/sec [ 3] 6.0- 7.0 sec 1180 MBytes 1180 MBytes/sec [ 3] 7.0- 8.0 sec 1179 MBytes 1179 MBytes/sec [ 3] 8.0- 9.0 sec 1180 MBytes 1180 MBytes/sec [ 3] 9.0-10.0 sec 1180 MBytes 1180 MBytes/sec [ 3] 0.0-10.0 sec 11346 MBytes 1134 MBytes/sec |

[ Voor 67% gewijzigd door jacovn op 02-04-2015 10:44 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

In dit topic bespreken we de hardwarematige kant van het bouwen van een NAS. Vragen en discussies die betrekking hebben op de softwarematige kant, dien je elders te stellen. Zo is het ZFS topic de juiste plek voor vragen over ZFS maar ook over softwareplatformen zoals FreeNAS, NAS4Free, ZFSguru en andere softwareplatforms die met ZFS werken.

:strip_exif()/u/54579/Static.gif?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

/u/11437/wandcontactdoos.png?f=community)

:strip_exif()/u/340453/crop67a669ce4f1f4_cropped.webp?f=community)

:strip_icc():strip_exif()/u/120296/feart_got.jpg?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_exif()/u/24321/motor1.gif?f=community)

:strip_icc():strip_exif()/u/235088/DreddSeal_small.jpg?f=community)

:strip_exif()/u/62088/sp_jh2.gif?f=community)