Faddermakker schreef op zondag 5 februari 2017 @ 13:20:

[...]

Ik moest even twee keer kijken waar je het over had

. Had de Samsungs inmiddels ook gevonden en zag niet zo snel een tweedehands alternatief op ebay wat de moeite waard was.

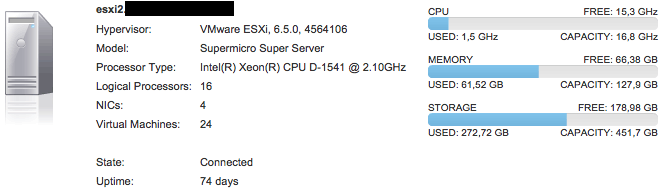

Ten aanzien van het nested draaien, kom ik dan uit met 3 hosts, volledige vCD(en later misschien ook beetje vRA erbij) en NSX installaties qua cpu?

Qua CPU zou ik me niet al te druk maken, ik denk dat geheugen sneller een bottleneck gaat zijn. Reken eens uit hoeveel geheugen je nodig denkt te hebben en dan reken ik 'm nog eens na. Het belangrijkste gaat denk ik ook zijn of je een vRA cluster wil draaien (cluster = 3 nodes).

Nog even over NVMe, wat je ook kunt doen is een 400GB Intel (HHHL) en een 1TB Samsung (M.2). Dan kun je ook zo over op ROBO of single node VSAN met dedupe en compression. Ik heb hier 400GB Intel 750 HHHL en 512 GB Samsung 950 Pro, maar als ik vandaag zou bestellen dan zou de 950 een 1TB 960 Pro worden.

Vergelijking met 3x NUC:

| CPU | Single Threaded | Multi Threaded |

| Xeon D-1541 | 1499 | 11333 |

| 3x i5 4250u | 1456 | 10284 |

Nou moet daar nog een stukje (10%?) overhead af, maar je zit qua CPU echt wel vergelijkbaar en per VM zelfs beter aangezien er meer resources per VM beschikbaar zijn.

Wat je zou kunnen doen met Xeon D en 128GB geheugen, 400GB+1TB:

VCSA 6.5 a (10GB) niet nested, NAS (2GB) niet nested. 2GB voor host ESXi.

4 ESXi nodes met 28.5GB, 256GB Capacity (Samsung), 32GB cache (Intel), 2GB boot (Intel) als VSAN 'RAID5' met dedupe en compression).

Host met

ESXi 6.0 u2 en

maclearning fling (+

Intel NVMe driver, Intel DCT,

Intel 10GBe driver, BIOS 1.1C), Virtuele ESXi

6.5 a met

PVSCSI controller,

VMXNET3.

Effectief heb je dan zo'n 1.5TB aan 'shared' NVMe storage. (1TB capacity / 1.33333 amplification * 2.0 dedupe/compression)

Zodra je klaar bent met VSAN en Clusters kun je alle VM's migreren naar de host (tijdelijk NFS vanaf Virtuele NAS?), de host upgraden naar 6.5 a en op volle snelheid draaien met een enkele host, alles met database op de Intel en de rest op de Samsung.

En mocht je het bestellen let dan even op dat het lijkt alsof de 750 HHHL wel past maar er met geen mogelijk in te krijgen is. Met een 'm' beweging lukt het om overal langs te komen zonder ergens druk op te zetten.

[

Voor 56% gewijzigd door

|sWORDs| op 05-02-2017 14:58

]

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_icc():strip_exif()/u/29297/qotsa.jpg?f=community)

/u/33305/crop60893dfd18ede_cropped.png?f=community)

/u/4022/crop5abf5052151cb_cropped.png?f=community)

:strip_icc():strip_exif()/u/528433/crop590052f61fbb1_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/220842/crop584a90da6a595_cropped.jpeg?f=community)

/u/433/crop6746d51e1326a_cropped.png?f=community)

:strip_icc():strip_exif()/u/465602/crop59bbd5b6caf7a_cropped.jpeg?f=community)

:strip_exif()/u/396800/D-_3427da0a9c293b63f2a66dea2e642102.gif?f=community)

/u/715177/crop58b098eea2a1c_cropped.png?f=community)

:strip_icc():strip_exif()/u/82975/crop633eccabd9275_cropped.jpg?f=community)

/u/168181/crop596361aa05dfe.png?f=community)

/u/14460/despicable_me.png?f=community)

:strip_icc():strip_exif()/u/71319/crop63827a2053b9b_cropped.jpg?f=community)

/u/299253/crop564e3076b5849.png?f=community)