4800Wp zonnestroom met Enphase

Life's a waste of time. Time's a waste of life. Get wasted all the time and you'll have the time of your life.

Die verbruik-waardes die je hebt aangegeven spreken mij zeker aan. In dat opzicht is het een interessant systeem.Microkid schreef op donderdag 25 augustus 2016 @ 16:07:

[...]

Eeeh, volgens mij had ik het al eerder gezegd: in deze systemen zit een Supermicro Super Server X10-SDV-2C/4C/8C-TLN2F/TLN4F moederbord. Feitelijk allemaal hetzelfde. Het enige verschil is de CPU en de extra's zoals 10Gb NIC. Over deze bordjes is al voldoende te vinden, op de site van Tinkertry staan een aantal uitgebreide reviews. Zelf heb ik de X10-SDV-8C-TLN4F en hierover heb ik enige pagina's geleden e.e.a. geschreven over de performance/verbruik. De andere bordjes zullen hier imho weinig af afwijken. Conclusie: heerlijk snel bordje, stil en zuinig

Waar ik mijn twijfels over heb is of de CPU 10 windows Vm`s kan draaien. Daarnaast ben ik ook benieuwd wat vervolgens de load is met 10 Vm`s.

No problemopitchdown schreef op donderdag 25 augustus 2016 @ 16:45:

[...]

Die verbruik-waardes die je hebt aangegeven spreken mij zeker aan. In dat opzicht is het een interessant systeem.

Waar ik mijn twijfels over heb is of de CPU 10 windows Vm`s kan draaien. Daarnaast ben ik ook benieuwd wat vervolgens de load is met 10 Vm`s.

4800Wp zonnestroom met Enphase

Life's a waste of time. Time's a waste of life. Get wasted all the time and you'll have the time of your life.

Uh, het grootste verschil is de ingebouwde voeding? Dat maakt op het totaal waarschijnlijk wel wat uitMicrokid schreef op donderdag 25 augustus 2016 @ 16:07:

[...]

Eeeh, volgens mij had ik het al eerder gezegd: in deze systemen zit een Supermicro Super Server X10-SDV-2C/4C/8C-TLN2F/TLN4F moederbord. Feitelijk allemaal hetzelfde. Het enige verschil is de CPU en de extra's zoals 10Gb NIC. Over deze bordjes is al voldoende te vinden, op de site van Tinkertry staan een aantal uitgebreide reviews. Zelf heb ik de X10-SDV-8C-TLN4F en hierover heb ik enige pagina's geleden e.e.a. geschreven over de performance/verbruik. De andere bordjes zullen hier imho weinig af afwijken. Conclusie: heerlijk snel bordje, stil en zuinig

Tinkertry heeft (nog) geen idle power waardes in diverse OSen. In die tabel zag ik (de laatste keer dat ik keek) alleen de waardes in het BIOS.

nou zal het ook weer geen tientallen watts schelen, dus het blijft muggenziften in de marges, maar toch

[ Voor 6% gewijzigd door FireDrunk op 25-08-2016 17:08 ]

Even niets...

Dus ook exchange-servers en Domaincontrollers e.d. zou deze cpu gewoon moeten trekken?Microkid schreef op donderdag 25 augustus 2016 @ 17:01:

[...]

No problemoIk had er laatst 17 VM's draaien, in totaal 24 vCPU's, 42GB geheugen en de CPU gaf geen krimp. Gemiddeld iets van 10% usage.

Hangt natuurlijk van de load af. Mijn servers staan redelijk veel niks te doen (is een lab omgeving). Ik weet niet wat jij er mee wilt gaan doen? Domeincontrollers hebben in de regel weinig cpu, exchange meer. Maar gaat het om 1 of enkele gebruikers, tientallen, honderden, of ook een lab?pitchdown schreef op donderdag 25 augustus 2016 @ 17:09:

[...]

Dus ook exchange-servers en Domaincontrollers e.d. zou deze cpu gewoon moeten trekken?

4800Wp zonnestroom met Enphase

Life's a waste of time. Time's a waste of life. Get wasted all the time and you'll have the time of your life.

Met 17 vingers in zijn neus.pitchdown schreef op donderdag 25 augustus 2016 @ 17:09:

[...]

Dus ook exchange-servers en Domaincontrollers e.d. zou deze cpu gewoon moeten trekken?

Even niets...

Load is inderdaad het magische woord. Je kunt met een enkele 2 vCPU VM wel tot 4 cores load trekken, maar 20 vrijwel idle draaiende VM's verbruiken soms minder dan 1 core.pitchdown schreef op donderdag 25 augustus 2016 @ 17:09:

[...]

Dus ook exchange-servers en Domaincontrollers e.d. zou deze cpu gewoon moeten trekken?

Te Koop:24 Core Intel Upgradeset

Het gaat bij ook om een lab-omgeving.|sWORDs| schreef op donderdag 25 augustus 2016 @ 17:36:

[...]

Load is inderdaad het magische woord. Je kunt met een enkele 2 vCPU VM wel tot 4 cores load trekken, maar 20 vrijwel idle draaiende VM's verbruiken soms minder dan 1 core.

Maar wel met redundant Exchange 2016 :-)

Draai het volgende:

Kemp loadbalancer

Domein controller

Mdt/wds-server

Vcenter

2 x Exchange 2016

Rdgateway-server

En nog 3 Windows clients

Daarnaast worden er Random wat vms aangemaakt en verwijderd.

Gaat die cpu dat trekken in de supermicro?

Te Koop:24 Core Intel Upgradeset

Zou dat op zowel de sys-e200 als de sys-e300 goed gaan? (I.v.m. 4 core vs 6 core)?|sWORDs| schreef op donderdag 25 augustus 2016 @ 19:14:

Op zijn sloffen, zo lang je niet veel simultane users hebt. Maar aangezien het een lab is.

Ik weet ook nog steeds niet of zelfbouw met een xeon 2630v3 nu meer of minder zal gebruiken dan de supermicro's.

De supermicro's hebben een tdp welke een stuk lager is ( 55 vs 85 ).

Te Koop:24 Core Intel Upgradeset

In dat geval is de sys-e200-8d misschien wel de mooie gulde middenweg.|sWORDs| schreef op donderdag 25 augustus 2016 @ 20:29:

Die TDP discussie hadden we toch al gehad? Als het echt veel meer verbruikt heb je het blijkbaar ook nodig. Met zulke servers zou ik wel voor een 6 of 8 core gaan, maar vier is ook te doen.

Natuurlijk hebben beide set-ups zijn voor- en nadelen, zijn beide set-ups zuinig genoeg en kunnen ze de load handelen die je er van wilt gaan vragen. Stel dát de één goedkoper is dan de ander in verbruik, dan scheelt het misschien 5 tot 10 euro op jaarbasis.

Zet ze naast elkaar op papier en koop de goedkoopste, dan doe jij je portemonnee ook nog een gunst.

Edit:

P.S. Die 500,- euro voor de 2630v3 ga je niet vangen, een even krachtige pricewatch: Intel Xeon E5-2620 v4 Boxed kost 450,- nieuw.

[ Voor 18% gewijzigd door renedis op 25-08-2016 22:43 ]

Soms is de "weg naar" leuker dan het "eindpunt" zelf. Terwijl hij rondkijkt leert hij bij en wordt zijn twijfel gewoon nog groter.renedis schreef op donderdag 25 augustus 2016 @ 22:39:

no offence, we zijn ondertussen 4 pagina's verder.. Hak die knoop door en koop het. Ja het is lastig maar van geen van beide ga je spijt krijgen.

Natuurlijk hebben beide set-ups zijn voor- en nadelen, zijn beide set-ups zuinig genoeg en kunnen ze de load handelen die je er van wilt gaan vragen. Stel dát de één goedkoper is dan de ander in verbruik, dan scheelt het misschien 5 tot 10 euro op jaarbasis.

Zet ze naast elkaar op papier en koop de goedkoopste, dan doe jij je portemonnee ook nog een gunst.

Edit:

P.S. Die 500,- euro voor de 2630v3 ga je niet vangen, een even krachtige pricewatch: Intel Xeon E5-2620 v4 Boxed kost 450,- nieuw.

Neem je tijd hé :-)

@pitchdown, zoals in DM gezegd;

De Intels ontlopen elkaar niet zo:

http://ark.intel.com/nl/compare/91199,91198,92986

Van deze lijst vind ik de Lian Li's niet heel fraai, de Inter-Tech lijkt wat gammel, de Chenbro heeft een vreemde koeling, ik neig naar de In Win. Maar misschien is er nog iets beters zonder hotswap of niet in de pricewatch?

[ Voor 9% gewijzigd door |sWORDs| op 26-08-2016 10:19 ]

Te Koop:24 Core Intel Upgradeset

Even opletten trouwens, de -01 versie heeft SAS, de versie zonder -01 aanduiding is SATA.

[ Voor 26% gewijzigd door FireDrunk op 26-08-2016 09:46 ]

Even niets...

Edit:

Tweakers user review:

productreview: Fractal Design Array R2 Mini ITX NAS Case review door TheGreatAtuin

[ Voor 40% gewijzigd door renedis op 26-08-2016 10:49 ]

Niet meer leverbaar?

[ Voor 93% gewijzigd door |sWORDs| op 26-08-2016 11:05 ]

Te Koop:24 Core Intel Upgradeset

https://ri-vier.eu/nas-chassis-c-1_83.html ??

Zit in Waddinxveen (mijn woonplaats). Kan een keer kijken voor je?

pricewatch: Fractal Design Node 304 Zwart

pricewatch: Fractal Design Node 804

Sinds de 2 dagen regel reageer ik hier niet meer

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1275 v5 Boxed | € 367,50 | € 367,50 |

| 1 | Gigabyte GA-X170-EXTREME ECC | € 235,36 | € 235,36 |

| 2 | Kingston ValueRAM KVR21E15D8K2/32 | € 155,- | € 310,- |

| 2 | Samsung 950 Pro 512GB | € 320,50 | € 641,- |

| 1 | Samsung 850 Pro 1TB | € 425,95 | € 425,95 |

| 1 | Seasonic Platinum Series 400 Watt Fanless | € 115,95 | € 115,95 |

| 1 | Fractal Design Define R5 Titanium | € 106,- | € 106,- |

| 1 | Scythe Katana 4 | € 23,95 | € 23,95 |

| Bekijk collectie Importeer producten | Totaal | € 2.225,71 | |

Er draait nu ESXi 6.0U2 op. Met op dit moment nog maar 2 VM's, draait het systeem bij een gemiddeld verbruik van om en nabij de 35W. Eigenlijk is er maar 1 VM echt actief, de ander draait nog ter lering en vermaak: een Debian distro.

Erg leuk om mee te spelen, en niet al te veel verbruik. Maar ik zou het best nog wat lager willen krijgen (uit hobby, niks is noodzaak). Nu las ik bij de start van dit post dat er een blog (http://blog.peacon.co.uk/wiki/ESXi_Custom_Power_Management) is waar je allerlei tweaks kan vinden. Maar helaas is dat blog niet meer benaderbaar. Weet iemand of dat elders wel te vinden is? Of kan iemand mij helpen met dergelijk tweaks om de server zuiniger te krijgen?

Andere vraag betreft een HBA. Het moedermord dat ik gebruik is prima voor het gebruiken van 2 stuks Samsung 950 Pro M.2 sticks (in RAID0). De 1Tb Samsung 850 Pro gebruik ik als backup voor de VM's. Maar daarna zitten abijna alle SATA poorten ook wel vol op het bord (niet fysiek, maar ze werken niet meer omdat het mobo alle capacieit nodig heeft). Bovendien kunnen onboard SATA's niet voor doorgegeven aan een VM heb ik begrepen. Dus wordt een simpele HBA geadviseerd in dit forum. Deze bijvoorbeeld: pricewatch: IBM ServeRAID M1015 SAS/SATA Controller for System x

Maar die HBA is nergens meer te koop. Dus is mijn vraag, zijn er goede alternatieven? Ik wil 1 van de VM's als NAS gaan inrichten zodat ik in RAID5 nog eens 4 (of 5) stuks HDD's kan aansturen. Het hoeft overigens niet per sé RAID te zijn. Ideeen zijn welkom!

Groet,

TheMartian

Volgens mij waren daar de custom power settings besproken die ook hier staan:http://blogs.vmware.com/p...-savings-vsphere-5-5.htmlTheMartian schreef op zaterdag 27 augustus 2016 @ 13:44:

Na lange pauze, andere dingen te doen, de volgende configuratie aangeschaft.

# Product Prijs Subtotaal 1 Intel Xeon E3-1275 v5 Boxed € 367,50 € 367,50 1 Gigabyte GA-X170-EXTREME ECC € 235,36 € 235,36 2 Kingston ValueRAM KVR21E15D8K2/32 € 155,- € 310,- 2 Samsung 950 Pro 512GB € 320,50 € 641,- 1 Samsung 850 Pro 1TB € 425,95 € 425,95 1 Seasonic Platinum Series 400 Watt Fanless € 115,95 € 115,95 1 Fractal Design Define R5 Titanium € 106,- € 106,- 1 Scythe Katana 4 € 23,95 € 23,95 Bekijk collectie

Importeer productenTotaal € 2.225,71

Er draait nu ESXi 6.0U2 op. Met op dit moment nog maar 2 VM's, draait het systeem bij een gemiddeld verbruik van om en nabij de 35W. Eigenlijk is er maar 1 VM echt actief, de ander draait nog ter lering en vermaak: een Debian distro.

Erg leuk om mee te spelen, en niet al te veel verbruik. Maar ik zou het best nog wat lager willen krijgen (uit hobby, niks is noodzaak). Nu las ik bij de start van dit post dat er een blog (http://blog.peacon.co.uk/wiki/ESXi_Custom_Power_Management) is waar je allerlei tweaks kan vinden. Maar helaas is dat blog niet meer benaderbaar. Weet iemand of dat elders wel te vinden is? Of kan iemand mij helpen met dergelijk tweaks om de server zuiniger te krijgen?

Andere vraag betreft een HBA. Het moedermord dat ik gebruik is prima voor het gebruiken van 2 stuks Samsung 950 Pro M.2 sticks (in RAID0). De 1Tb Samsung 850 Pro gebruik ik als backup voor de VM's. Maar daarna zitten abijna alle SATA poorten ook wel vol op het bord (niet fysiek, maar ze werken niet meer omdat het mobo alle capacieit nodig heeft). Bovendien kunnen onboard SATA's niet voor doorgegeven aan een VM heb ik begrepen. Dus wordt een simpele HBA geadviseerd in dit forum. Deze bijvoorbeeld: pricewatch: IBM ServeRAID M1015 SAS/SATA Controller for System x

Maar die HBA is nergens meer te koop. Dus is mijn vraag, zijn er goede alternatieven? Ik wil 1 van de VM's als NAS gaan inrichten zodat ik in RAID5 nog eens 4 (of 5) stuks HDD's kan aansturen. Het hoeft overigens niet per sé RAID te zijn. Ideeen zijn welkom!

Groet,

TheMartian

Schaamteloze verkoop van:

http://tweakers.net/aanbod/user/311422/

*** NIKS ***

Als je ietwat geduld hebt, ik krijg 2 servers terug waar zeker weten een HBA in zit. Weet alleen nog niet wat voor types eerlijk gezegd. Stuur maar een DM als je intresse hebt.TheMartian schreef op zaterdag 27 augustus 2016 @ 13:44:

Na lange pauze, andere dingen te doen, de volgende configuratie aangeschaft.

# Product Prijs Subtotaal 1 Intel Xeon E3-1275 v5 Boxed € 367,50 € 367,50 1 Gigabyte GA-X170-EXTREME ECC € 235,36 € 235,36 2 Kingston ValueRAM KVR21E15D8K2/32 € 155,- € 310,- 2 Samsung 950 Pro 512GB € 320,50 € 641,- 1 Samsung 850 Pro 1TB € 425,95 € 425,95 1 Seasonic Platinum Series 400 Watt Fanless € 115,95 € 115,95 1 Fractal Design Define R5 Titanium € 106,- € 106,- 1 Scythe Katana 4 € 23,95 € 23,95 Bekijk collectie

Importeer productenTotaal € 2.225,71

Er draait nu ESXi 6.0U2 op. Met op dit moment nog maar 2 VM's, draait het systeem bij een gemiddeld verbruik van om en nabij de 35W. Eigenlijk is er maar 1 VM echt actief, de ander draait nog ter lering en vermaak: een Debian distro.

Erg leuk om mee te spelen, en niet al te veel verbruik. Maar ik zou het best nog wat lager willen krijgen (uit hobby, niks is noodzaak). Nu las ik bij de start van dit post dat er een blog (http://blog.peacon.co.uk/wiki/ESXi_Custom_Power_Management) is waar je allerlei tweaks kan vinden. Maar helaas is dat blog niet meer benaderbaar. Weet iemand of dat elders wel te vinden is? Of kan iemand mij helpen met dergelijk tweaks om de server zuiniger te krijgen?

Andere vraag betreft een HBA. Het moedermord dat ik gebruik is prima voor het gebruiken van 2 stuks Samsung 950 Pro M.2 sticks (in RAID0). De 1Tb Samsung 850 Pro gebruik ik als backup voor de VM's. Maar daarna zitten abijna alle SATA poorten ook wel vol op het bord (niet fysiek, maar ze werken niet meer omdat het mobo alle capacieit nodig heeft). Bovendien kunnen onboard SATA's niet voor doorgegeven aan een VM heb ik begrepen. Dus wordt een simpele HBA geadviseerd in dit forum. Deze bijvoorbeeld: pricewatch: IBM ServeRAID M1015 SAS/SATA Controller for System x

Maar die HBA is nergens meer te koop. Dus is mijn vraag, zijn er goede alternatieven? Ik wil 1 van de VM's als NAS gaan inrichten zodat ik in RAID5 nog eens 4 (of 5) stuks HDD's kan aansturen. Het hoeft overigens niet per sé RAID te zijn. Ideeen zijn welkom!

Groet,

TheMartian

Vergeet niet dat een M1015 minimaal 7W boven op je huidig verbruik gooit in idle.

Als het een algemene stelling is dan klopt die niet. Onboard SATA kan prima doorgegeven worden.TheMartian schreef op zaterdag 27 augustus 2016 @ 13:44:

Bovendien kunnen onboard SATA's niet voor doorgegeven aan een VM heb ik begrepen.

Sinds de 2 dagen regel reageer ik hier niet meer

In zijn geval kan hij als de 850 als datastore of boot gebruikt wordt de Intel controller niet doorgeven. Ik zou de 850 swappen voor een PCIe SSD en de Intel doorgeven. Of de 850 mee doorgeven en dan als backup gebruiken.CurlyMo schreef op zaterdag 27 augustus 2016 @ 16:52:

[...]

Als het een algemene stelling is dan klopt die niet. Onboard SATA kan prima doorgegeven worden.

[ Voor 6% gewijzigd door |sWORDs| op 28-08-2016 00:11 ]

Te Koop:24 Core Intel Upgradeset

PCI-E To SATA3 PCI E SATA3.0 6Gb/s the SSD Asmedia Chip Expansion Card ASM1061

Deze draait nu naast een Cougar Point 6 port SATA AHCI Controller. Doorgeven van louter de onboard SATA gaat ook in deze combinatie prima.

Sinds de 2 dagen regel reageer ik hier niet meer

Out of the box in esx? Of nog drivers met een vib moeten injecten?CurlyMo schreef op woensdag 07 september 2016 @ 11:13:

In het kader van de ASM1061 ervaringen. Ik heb voor een tweede server dit kaartje gekocht:

PCI-E To SATA3 PCI E SATA3.0 6Gb/s the SSD Asmedia Chip Expansion Card ASM1061

Deze draait nu naast een Cougar Point 6 port SATA AHCI Controller. Doorgeven van louter de onboard SATA gaat ook in deze combinatie prima.

Schaamteloze verkoop van:

http://tweakers.net/aanbod/user/311422/

*** NIKS ***

Ik heb dezelfde ISO gebruikt als tijdens mijn vorige build dus daar zaten de extra VIB's al in.stuffer schreef op woensdag 07 september 2016 @ 18:54:

[...]

Out of the box in esx? Of nog drivers met een vib moeten injecten?

Sinds de 2 dagen regel reageer ik hier niet meer

Vandaag het systeem met asus moederbord in elkaar gezet. Kort wat zaken getweaked door bv. maar 4 cores vanuit de bios actief te zetten. Dit leverd met 8 windows vms een verbruik van 60 watt op.renedis schreef op donderdag 25 augustus 2016 @ 22:53:

Ik probeer hem alleen maar te helpen om die knoop door te hakken. Anders blijft ie rondkijken/twijfelen en komt er niets.

@pitchdown, zoals in DM gezegd;

De Intels ontlopen elkaar niet zo:

http://ark.intel.com/nl/compare/91199,91198,92986

Idle was het moederbord met de 2630v3 ca. 34 watt.

Niet slecht lijkt me?

Zijn er nog meer opties om het stroomverbruik naar beneden te krijgen?

ESXi op "Low power" zetten. Daarnaast alle overbodige opties die je niet gebruikt in BIOS uitzetten!pitchdown schreef op donderdag 08 september 2016 @ 18:58:

[...]

Vandaag het systeem met asus moederbord in elkaar gezet. Kort wat zaken getweaked door bv. maar 4 cores vanuit de bios actief te zetten. Dit leverd met 8 windows vms een verbruik van 60 watt op.

Idle was het moederbord met de 2630v3 ca. 34 watt.

Niet slecht lijkt me?

Zijn er nog meer opties om het stroomverbruik naar beneden te krijgen?

Kan iemand mij vertellen hoe het met het licenties model van ESXi zit? Is dit betaalbaar voor een thuisgebruiker.

Zijn er interessanten blog/sites? Ik kwam deze tegen:

http://www.virtuallyghetto.com

Zijn er mensen die hetzelfde ervaren met een recent Supermicro bord en een Intel Pro/1000 PT Quad i.c.m. ESXI?

PS: ik weet niet of ik dit hier mag vragen

[ Voor 9% gewijzigd door 112fan op 12-09-2016 21:51 ]

[ Voor 11% gewijzigd door |sWORDs| op 13-09-2016 00:41 ]

Te Koop:24 Core Intel Upgradeset

Die kaart werkte bij mij altijd prima. Heb je hem al eens in een ander PCIe slot geprobeerd? Je kan ook nog proberen in het BIOS de PCIe Snelheid (Optie heet "Gen") op 1.0 o 2.0 te forceren.112fan schreef op maandag 12 september 2016 @ 21:50:

Ik heb een Supermicro X11SSM-F met ESXI 6. Ik heb hier een Intel Pro/1000 PT Quad ingezet maar deze wordt niet gezien door het bord zelf en ESXI. Ik heb al de drivers geprobeerd te installeren maar dit hielp niet.

Zijn er mensen die hetzelfde ervaren met een recent Supermicro bord en een Intel Pro/1000 PT Quad i.c.m. ESXI?

PS: ik weet niet of ik dit hier mag vragen

Even niets...

Hallo,pitchdown schreef op maandag 22 augustus 2016 @ 15:54:

[...]

ik heb de prijzen in NL opgevraagd voor zowel de E200 als de E300.

Hierbij komt de E300 goedkoper uit dan de E200.

Dat zou toch op z`n minst opvallend moeten zijn?

heb je al de prijzen voor NL? ik ben aan het bekijken om 1 E200 met 64GB aan te kopen ivm van 2 NUC's. het enige wat me beetje stoort is eigenlijk de noise. ik heb een video op YT gezien en deze maakt toch wel een beetje herrie....

Ik heb achteraf voor zelfbouw gekozen.JustSys schreef op dinsdag 20 september 2016 @ 00:33:

[...]

Hallo,

heb je al de prijzen voor NL? ik ben aan het bekijken om 1 E200 met 64GB aan te kopen ivm van 2 NUC's. het enige wat me beetje stoort is eigenlijk de noise. ik heb een video op YT gezien en deze maakt toch wel een beetje herrie....

Dit was voor mij een stuk goedkoper en het stroomverbruik is prima hiermee.

Ik ga weer beginnen met een nieuwere server. Nu wil ik graag een all-in-one met iets lichtere specs. Naast esxi te draaien voor mn bedrijfje doe ik mn dell server weg nu (voor wie wilt V&A aangeboden: Dell Poweredge R210 II.

Doel nieuwe systeem is een krachtig genoege server die wel kan transcoden voor plex (4k voor 3 streams max, en nog zfs nog kan draaien voor interne storage. Nu heb ik de storage op aparte server staan).

Aangezien deze thuis gaat staan ga ik ook geen 1U server meer neerzetten.

Ontwikkelaar van NPM library Gleamy

ESXi zelf is gratis. Je gaat pas betalen als je de uitgebreidere versies wilt gebruiken (Standard, Enterprise, Enterprise Plus). Voor thuisgebruik volstaat de gratis versie vaak voldoende.MvL schreef op zaterdag 10 september 2016 @ 10:17:

Kan iemand mij vertellen hoe het met het licenties model van ESXi zit? Is dit betaalbaar voor een thuisgebruiker.

Zie ook http://www.vladan.fr/esxi-free-vs-paid/

4800Wp zonnestroom met Enphase

Life's a waste of time. Time's a waste of life. Get wasted all the time and you'll have the time of your life.

Zoals aangegeven is het voor thuisgebruik hoogstwaarschijnlijk niet nodig om een standard, enterprise of enterprise plus licentie te hebben.MvL schreef op woensdag 21 september 2016 @ 21:41:

Ik heb even gecheckt als je uitgebreidere versie wilt loopt dat aardig in de papieren. Geen flauw idee of dat nodig is maar het zet mij wel aan het denken kan je dan niet beter zoiets als Proxmox gebruiken... Nu kan ik beide Hypervisors niet vergelijk omdat ik weinig ervaring heb met virtualisatie.

Kijkend naar de vergelijking op vladan.fr, waaorm verwacht je niet met de free licentie uit te voeten te kunnen?

Mocht je meer willen kun je voor thuis toch de VMUG licentie gebruiken?MvL schreef op woensdag 21 september 2016 @ 21:41:

Ik heb even gecheckt als je uitgebreidere versie wilt loopt dat aardig in de papieren. Geen flauw idee of dat nodig is maar het zet mij wel aan het denken kan je dan niet beter zoiets als Proxmox gebruiken... Nu kan ik beide Hypervisors niet vergelijk omdat ik weinig ervaring heb met virtualisatie.

Te Koop:24 Core Intel Upgradeset

VMUG licentie heb ik iets over gelezen. Dit ga ik verder uitzoeken.

Heeft ESXi nu ondersteuning voor Docker?

Even niets...

MvL schreef op donderdag 22 september 2016 @ 21:13:

bedankt voor de reacties.

VMUG licentie heb ik iets over gelezen. Dit ga ik verder uitzoeken.

Heeft ESXi nu ondersteuning voor Docker?

Met Photon heb je eigenlijk een beetje het beste van beide werelden, je hoeft geen gebruik te maken van de KVM networking stack en je hebt simpele HA en vMotion mogelijkheden.https://vmware.github.io/photon/

What is Photon OS™

Photon OS™ is a minimal Linux container host, optimized to run on VMware platforms. With the 1.0 release, we have greatly expanded the library of packages that are in our repository, making Photon OS™ more broadly applicable to a range of use-cases. We invite partners, customers and interested community members to collaborate on both running containerized applications in a virtualized environment and the potential of an operating system tightly coupled to underlying virtual infrastructure.

Optimized for vSphere - Leveraging more than a decade of experience validating guest operating systems, Photon OS is thoroughly validated on vSphere; and, because VMware is focused on the vSphere platform, we're able to highly tune the Photon OS kernel for VMware product and provider platforms.

Container support - Compatible with container runtimes, like Docker, and container scheduling frameworks, like Kubernetes.

Efficient lifecycle management - Contains a new, open-source, yum-compatible package manager - tdnf - that makes the system as small as possible, but preserves robust yum package management capabilities.

[ Voor 5% gewijzigd door |sWORDs| op 23-09-2016 11:40 ]

Te Koop:24 Core Intel Upgradeset

Hoe doen jullie dat met storage? Ik heb een apparte 24 bay xcase chassis wat ik nu gebruik als een nas.

Je kunt op de meeste NASsen wel een NFS-export of een iSCSI target aanmaken, dus als je je NAS wilt gebruiken als datastore is dat een optie.

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Het nadeel van de meeste NAS oplossing is gigabit LAN. Voor een klein labje geen probleem, maar 110MB/s (of 130 met MPIO) delen met veel VM's wordt snel traag. Dan is local storage een betere oplossing, of VSAN/(virtuele) NAS met 10Gbit. Let wel op de 10Gbit switches niet iets zijn wat je in je kantoor wil hebben, ze maken veel herrie. Mocht je echt shared storage willen hebben en Gbit LAN dan zou hybrid VSAN een aardige oplossing zijn, vrij veel cache hits in de read cache.MvL schreef op vrijdag 23 september 2016 @ 12:39:

Okay, ik had inderdaad inmiddels wat gevonden over Photon OS. Ga ik mij verder in verdiepen.

Hoe doen jullie dat met storage? Ik heb een apparte 24 bay xcase chassis wat ik nu gebruik als een nas.

Zelf gebruik ik local storage voor de VM's met veel IO en dan heb ik nog een ROBO VSAN all flash config op 10Gbit voor de VM's die High Availability moeten hebben.

[ Voor 33% gewijzigd door |sWORDs| op 23-09-2016 14:10 ]

Te Koop:24 Core Intel Upgradeset

Ik zou dan graag willen kunnen deployen naar Datastore Cluster A, ( en of het dan pinned op host A of B komt, maakt me niet zoveel uit. )

Even niets...

Ik heb nooit datastore clusters gebruikt, maar zover ik weet kan het alleen met shared storage.FireDrunk schreef op vrijdag 23 september 2016 @ 15:34:

Dat was ook mijn idee. Ik dacht daarom een Datastore Cluster te maken van lokale storage, maar geen idee of vSphere dat slikt.

Ik zou dan graag willen kunnen deployen naar Datastore Cluster A, ( en of het dan pinned op host A of B komt, maakt me niet zoveel uit. )

Te Koop:24 Core Intel Upgradeset

Ik wil ESXi in een thuis situatie gaan gebruiken en idd een klein lab maken. ESXi is wel hellemaal nieuw voor mij. Ik heb wel wat ervaring met Proxmox. Ik probeer de juiste setup te vinden maar ik vind het moeilijk dit te bepalen. Ik dus kan het beste mijn VM's op local storage draaien bergrijp ik. Als ik nu mijn media collectie wil koppellen aan een VM met Plex wat dan op een storage chassis staat wat is dan de beste optie? Gewoon benaderen over NFS? Ander opties? Welke software daarop draaien?|sWORDs| schreef op vrijdag 23 september 2016 @ 14:03:

[...]

Het nadeel van de meeste NAS oplossing is gigabit LAN. Voor een klein labje geen probleem, maar 110MB/s (of 130 met MPIO) delen met veel VM's wordt snel traag. Dan is local storage een betere oplossing, of VSAN/(virtuele) NAS met 10Gbit. Let wel op de 10Gbit switches niet iets zijn wat je in je kantoor wil hebben, ze maken veel herrie. Mocht je echt shared storage willen hebben en Gbit LAN dan zou hybrid VSAN een aardige oplossing zijn, vrij veel cache hits in de read cache.

Zelf gebruik ik local storage voor de VM's met veel IO en dan heb ik nog een ROBO VSAN all flash config op 10Gbit voor de VM's die High Availability moeten hebben.

Wat bedoel je met een hybride VSAN?

In dat geval zou ik inderdaad lokale storage gebruiken voor je VM's, ik weet niet hoeveel VM's je wilt gaan draaien en hoe groot die gaan worden, maar met een SSD van een halve TB (€ 130 of zo) kom je echt heel ver (bijvoorbeeld 10 Windows servers, of 100 Linux-servers, afhankelijk van wat je er behalve het OS nog meer bij installeert).MvL schreef op vrijdag 23 september 2016 @ 17:06:

Ik wil ESXi in een thuis situatie gaan gebruiken en idd een klein lab maken.

Hoe doe je dat nu?Als ik nu mijn media collectie wil koppellen aan een VM met Plex

Waarop, op je storage chassis? Wat staat er nu op? Wat is het voor iets? Mogelijk kun je het chassis gebruiken als ESXi server, maar dat is afhankelijk van een heleboel zaken, niet in de minste welke hardware er verder in zit en welke software er nu op staat. Heb je het ding al ergens voor in gebruik?Welke software daarop draaien?

Ik denk dat dat een brug te ver isWat bedoel je met een hybride VSAN?

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Geef eens wat meer info over je storage chassis, ik ken het niet.MvL schreef op vrijdag 23 september 2016 @ 17:06:

[...]

Ik wil ESXi in een thuis situatie gaan gebruiken en idd een klein lab maken. ESXi is wel hellemaal nieuw voor mij. Ik heb wel wat ervaring met Proxmox. Ik probeer de juiste setup te vinden maar ik vind het moeilijk dit te bepalen. Ik dus kan het beste mijn VM's op local storage draaien bergrijp ik. Als ik nu mijn media collectie wil koppellen aan een VM met Plex wat dan op een storage chassis staat wat is dan de beste optie? Gewoon benaderen over NFS? Ander opties? Welke software daarop draaien?

Wat bedoel je met een hybride VSAN?

Hybrid VSAN gebruikt spinning en flash, de flash dient dan als een read/write cache. Bij all flash VSAN is de cache alleen write.

Hoewel SATA aardig wat bandbreedte kan bieden zou ik niet veel servers op een enkele SATA disk draaien vanwege de lage queuedepth (31 of 32 afhankelijk van de controller), je omgeving ligt zo op zijn knieën.Paul schreef op vrijdag 23 september 2016 @ 17:25:

[...]

In dat geval zou ik inderdaad lokale storage gebruiken voor je VM's, ik weet niet hoeveel VM's je wilt gaan draaien en hoe groot die gaan worden, maar met een SSD van een halve TB (€ 130 of zo) kom je echt heel ver (bijvoorbeeld 10 Windows servers, of 100 Linux-servers, afhankelijk van wat je er behalve het OS nog meer bij installeert).

Technisch is er geen minimum van drie. Je kunt VSAN ook op één of twee hosts draaien.Paul schreef op vrijdag 23 september 2016 @ 17:25:

[...]

Ik denk dat dat een brug te ver isVSAN is lokale storage van (minimaal) 3 ESXi-servers gebruiken om daarmee shared storage voor je VMware-omgeving te maken. Eerste horde: Je hebt minimaal 3 servers nodig

[ Voor 73% gewijzigd door |sWORDs| op 23-09-2016 17:53 ]

Te Koop:24 Core Intel Upgradeset

Okay, duidelijk. Waarschijnlijk maar een paar VM,sPaul schreef op vrijdag 23 september 2016 @ 17:25:

[...]

In dat geval zou ik inderdaad lokale storage gebruiken voor je VM's, ik weet niet hoeveel VM's je wilt gaan draaien en hoe groot die gaan worden, maar met een SSD van een halve TB (€ 130 of zo) kom je echt heel ver (bijvoorbeeld 10 Windows servers, of 100 Linux-servers, afhankelijk van wat je er behalve het OS nog meer bij installeert).

Ik heb nu een unRAID server in gebruik. Eigenlijk een beetje een tijdelijke oplossing omdat ik de licentie toch nog had van jaren geleden. Dit draait op een Supermicro mobo met een xeon e3-127v5 met 32GB. Dit alles in een X-Case 24 bay pro chassis. Hierin zit archive SMR schijven voor media storage (weinig schrijven, veel lezen). Ook heb ik nog wat Red's rondslingeren.[...]

Hoe doe je dat nu?Ik zou vSphere / ESXi daar niet mee vermoeien en gewoon binnen je VM verbinden met een SMB-share of een NFS-export van je NAS, op dezelfde manier als je dat vanaf je werkstation zou doen bijvoorbeeld.

zie mijn antwoord hierboven.[...]

Waarop, op je storage chassis? Wat staat er nu op? Wat is het voor iets? Mogelijk kun je het chassis gebruiken als ESXi server, maar dat is afhankelijk van een heleboel zaken, niet in de minste welke hardware er verder in zit en welke software er nu op staat. Heb je het ding al ergens voor in gebruik?

[...]

inderdaad.Ik denk dat dat een brug te ver isVSAN is lokale storage van (minimaal) 3 ESXi-servers gebruiken om daarmee shared storage voor je VMware-omgeving te maken. Eerste horde: Je hebt minimaal 3 servers nodig

edit: even een linkje van het chassis. https://www.xcase.co.uk/p...kplane?variant=9314376069

[ Voor 4% gewijzigd door MvL op 23-09-2016 17:56 ]

Hier kun je prima een ESXi machine van maken en dan de unRAID omzetten naar virtueel met passthrough.MvL schreef op vrijdag 23 september 2016 @ 17:54:

[...]

Ik heb nu een unRAID server in gebruik. Eigenlijk een beetje een tijdelijke oplossing omdat ik de licentie toch nog had van jaren geleden. Dit draait op een Supermicro mobo met een xeon e3-127v5 met 32GB. Dit alles in een X-Case 24 bay pro chassis. Hierin zit archive SMR schijven voor media storage (weinig schrijven, veel lezen). Ook heb ik nog wat Red's rondslingeren.

[...]

Maar die schijven voor VM's gebruiken zou ik echt niet doen.

[ Voor 4% gewijzigd door |sWORDs| op 23-09-2016 17:58 ]

Te Koop:24 Core Intel Upgradeset

Ik wil graag eigenlijk alles een beetje modulair opzetten. Als ik z'n tweede chassis dus meer storage nodig heb wat dan?|sWORDs| schreef op vrijdag 23 september 2016 @ 17:56:

[...]

Hier kun je prima een ESXi machine van maken en dan de unRAID omzetten naar virtueel met passthrough.

Maar die schijven voor VM's gebruiken zou ik echt niet doen.

Ik kan bijvoorbeeld het 24 bay chassis aan een 12 bay chassis kunnen koppelen. Dit 12 bay chassis heb ik ook nog maar stond een beetje op de nominatie om terug te sturen. Bij uitbreiding kan ik er een tweede 24 bay chassis aankoppelen.

Als je nou eens uitlegt wat je precies wil bereiken, wat er allemaal moet draaien en welke delen nog beschikbaar moeten zijn als er een server uitvalt dan kunnen we beter meedenken.MvL schreef op vrijdag 23 september 2016 @ 18:06:

[...]

Ik wil graag eigenlijk alles een beetje modulair opzetten. Als ik z'n tweede chassis dus meer storage nodig heb wat dan?

Ik kan bijvoorbeeld het 24 bay chassis aan een 12 bay chassis kunnen koppelen. Dit 12 bay chassis heb ik ook nog maar stond een beetje op de nominatie om terug te sturen. Bij uitbreiding kan ik er een tweede 24 bay chassis aankoppelen.

Te Koop:24 Core Intel Upgradeset

Het gemiddelde thuis-lab heeft meer servers aanwezig dan draaien|sWORDs| schreef op vrijdag 23 september 2016 @ 17:44:

Hoewel SATA aardig wat bandbreedte kan bieden zou ik niet veel servers op een enkele SATA disk draaien vanwege de lage queuedepth (31 of 32 afhankelijk van de controller), je omgeving ligt zo op zijn knieën.

Jij hebt meer info dan ik, ik moet het gepubliceerde KB-artikelen doenTechnisch is er geen minimum van drie. Je kunt VSAN ook op één of twee hosts draaien.

Hoe wilde je dat 2e chassis aansluiten op het 1e? Met een SAS-controller en SFF-8088 kabels? Die SAS-controller kun je dan ook "gewoon" doorgeven aan een VMMvL schreef op vrijdag 23 september 2016 @ 18:06:

Ik wil graag eigenlijk alles een beetje modulair opzetten. Als ik z'n tweede chassis dus meer storage nodig heb wat dan?

Aan de andere kant kun je ook je chassis alleen als NAS-storage inzetten en je vSphere hosts als losse machines neerzetten. Welke kant op wil je modulair zijn? Alleen storage of ook qua aantal VM's?

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Single:Paul schreef op vrijdag 23 september 2016 @ 18:25:

[...]

Jij hebt meer info dan ik, ik moet het gepubliceerde KB-artikelen doenAl kun je wel aanvoeren dat ze het daar over een cluster hebben...

[...]

http://www.virtuallyghett...skgroup-using-esxcli.html

http://www.virten.net/2015/11/building-a-single-node-vsan/

Hier zie je één van mijn hosts zonder vCenter (dus single) met VSAN (met dedupe en compression):

Dual (met witness, maar met een truc kan dat ook op de twee):

https://blogs.vmware.com/...figuration-demonstration/

[ Voor 20% gewijzigd door |sWORDs| op 23-09-2016 18:44 ]

Te Koop:24 Core Intel Upgradeset

Ok bedankt,pitchdown schreef op dinsdag 20 september 2016 @ 08:11:

[...]

Ik heb achteraf voor zelfbouw gekozen.

Dit was voor mij een stuk goedkoper en het stroomverbruik is prima hiermee.

als ik de prijzen zie van de sys-E200-8D dan denk ik er ook over na om 2 NUC6i5 (32GB) aan te kopen ivm van de SuperMicro, en ook noise zijn de nuc volgens mij wel stiller

Kan je beter voor zelfbouw gaanJustSys schreef op zaterdag 24 september 2016 @ 11:13:

[...]

Ok bedankt,

als ik de prijzen zie van de sys-E200-8D dan denk ik er ook over na om 2 NUC6i5 (32GB) aan te kopen ivm van de SuperMicro, en ook noise zijn de nuc volgens mij wel stiller

Het is wel appels met peren vergelijken en Xeon-D hoeft niet duurder te zijn of meer stroom te verbruiken/herrie te maken dan NUC's, het kan goedkoper en sneller zijn:JustSys schreef op zaterdag 24 september 2016 @ 11:13:

[...]

Ok bedankt,

als ik de prijzen zie van de sys-E200-8D dan denk ik er ook over na om 2 NUC6i5 (32GB) aan te kopen ivm van de SuperMicro, en ook noise zijn de nuc volgens mij wel stiller

| # | Product | Prijs | Subtotaal |

| 1 | Supermicro SYS-5028D-TN4T | € 1.386,36 | € 1.386,36 |

| 4 | Samsung M393A4K40BB1-CRC | € 149,- | € 596,- |

| 1 | Addonics ADM2PX4 M2 PCIe SSD adapter | € 23,05 | € 23,05 |

| 2 | Samsung 950 Pro 512GB | € 322,27 | € 644,54 |

| Bekijk collectie Importeer producten | Totaal | € 2.649,95 | |

| # | Product | Prijs | Subtotaal |

| 4 | Intel NUC NUC6i5SYK | € 379,- | € 1.516,- |

| 4 | Crucial CT2K16G4SFD8213 | € 136,50 | € 546,- |

| 4 | Samsung 950 Pro 256GB | € 188,50 | € 754,- |

| Bekijk collectie Importeer producten | Totaal | € 2.816,- | |

En dan heeft de Supermicro dus meer CPU, IPMI, 4 SATA hotswap (voeg één of meerder schijven toe, SATA in passthrough en je hebt ook gelijk een NAS) 10Gbit voor de toekomst en zelfs zonder 10Gbit kunnen de VM's nu gewoon intern communiceren, dus geen Gbit beperking.

Te Koop:24 Core Intel Upgradeset

pfSence: VMXNET3 issues met laatste patch, IGMP proxy niet stabiel

Openwrt/dd-wrt: Geen VMware tools

Sophos UTM: Nare interface, max 50 machines, geen public subnet support, geen IGMP proxy.

ClearOS: Geen IGMP proxy

Untagle: Beperkt, geen IGMP proxy

Vyos: Geen webinterface

Mikrotik: Nare interface, betalen voor meer dan 1 Mbit

Te Koop:24 Core Intel Upgradeset

Kan je voor OpenWRT niet zelf open-vm-tools compileren?|sWORDs| schreef op zondag 25 september 2016 @ 12:23:

Pff, weet iemand een router met een makkelijke interface die goed draait op ESXi?

pfSence: VMXNET3 issues met laatste patch, IGMP proxy niet stabiel

Openwrt/dd-wrt: Geen VMware tools

Sophos UTM: Nare interface, max 50 machines, geen public subnet support, geen IGMP proxy.

ClearOS: Geen IGMP proxy

Untagle: Beperkt, geen IGMP proxy

Vyos: Geen webinterface

Mikrotik: Nare interface, betalen voor meer dan 1 Mbit

Sinds de 2 dagen regel reageer ik hier niet meer

Ik heb nog niemand gevonden waarbij dat gelukt is.CurlyMo schreef op zondag 25 september 2016 @ 12:36:

[...]

Kan je voor OpenWRT niet zelf open-vm-tools compileren?

Te Koop:24 Core Intel Upgradeset

Wat is het probleem dan met pfsense vmxnet3? Ik heb geen problemen met 500Mb glasvezel. Daarnaast werkt IGMP proxy niet altijd goed sowieso niet met vlans, misschien kan je hier wat mee https://redmine.pfsense.org/issues/6099|sWORDs| schreef op zondag 25 september 2016 @ 12:23:

Pff, weet iemand een router met een makkelijke interface die goed draait op ESXi?

pfSence: VMXNET3 issues met laatste patch, IGMP proxy niet stabiel

Openwrt/dd-wrt: Geen VMware tools

Sophos UTM: Nare interface, max 50 machines, geen public subnet support, geen IGMP proxy.

ClearOS: Geen IGMP proxy

Untagle: Beperkt, geen IGMP proxy

Vyos: Geen webinterface

Mikrotik: Nare interface, betalen voor meer dan 1 Mbit

Ik zou ook nog kijken naar ipfire.

Sophos XG misschien? (Opvolger van UTM).|sWORDs| schreef op zondag 25 september 2016 @ 13:10:

[...]

Ik heb nog niemand gevonden waarbij dat gelukt is.

is everything cool?

Ik heb geen VLANs naar pfSense, nieuwe proxy builds doen het ook niet lekker. Zodra je de laatste ESXi patch voor VMXNET3 gebruikt is de gateway vaak niet bereikbaar.Zenix schreef op zondag 25 september 2016 @ 13:43:

[...]

Wat is het probleem dan met pfsense vmxnet3? Ik heb geen problemen met 500Mb glasvezel. Daarnaast werkt IGMP proxy niet altijd goed sowieso niet met vlans, misschien kan je hier wat mee https://redmine.pfsense.org/issues/6099

Ik zou ook nog kijken naar ipfire.

Te Koop:24 Core Intel Upgradeset

Ok ik heb de patches van augustus maar ervaar die problemen niet op 2.3.1 als het gaat om vmxnet3. Ik hoop ook dat ze die IGMP proxy in 2.4 eens goed maken, want ik gebruik nog steeds Bridged IPTV om die problemen daarmee.|sWORDs| schreef op zondag 25 september 2016 @ 14:27:

[...]

Ik heb geen VLANs naar pfSense, nieuwe proxy builds doen het ook niet lekker. Zodra je de laatste ESXi patch voor VMXNET3 gebruikt is de gateway vaak niet bereikbaar.

Interface is al stukken beter (al hoe wel ik wel erg aan het puzzelen ben waar alles nu zit), maar ik zie nog steeds geen IGMP proxy. Wel grappig aangezien ik die voor de interne labs ook wilde gaan gebruiken, maar ik wist niet dat daar ook een home license van was.FREAKJAM schreef op zondag 25 september 2016 @ 13:43:

[...]

Sophos XG misschien? (Opvolger van UTM).

Ik zit er over te denken om routed IPTV te trunken, zoiets als dit:Zenix schreef op zondag 25 september 2016 @ 14:49:

[...]

Ok ik heb de patches van augustus maar ervaar die problemen niet op 2.3.1 als het gaat om vmxnet3. Ik hoop ook dat ze die IGMP proxy in 2.4 eens goed maken, want ik gebruik nog steeds Bridged IPTV om die problemen daarmee.

1

2

3

4

5

6

7

8

9

| . NTU

|

Fritzbox

|

VLAN WAN

/ | \

iptvA iptvB Sophos XG (bridge)

|

VLAN LAN (default) |

Dan kan ik met mijn subnet meerdere dingen doen, of ik kan of 1:1 NAT op de Sophos XG doen, of devices direct met een pub IP op VLAN WAN zetten, of zelf extra routers aan VLAN WAN hangen per omgeving.

Ik kan alleen niet de Fritzbox voor wireless gebruiken (geen toegang tot LAN).

[ Voor 69% gewijzigd door |sWORDs| op 25-09-2016 16:58 ]

Te Koop:24 Core Intel Upgradeset

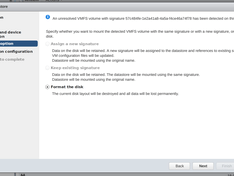

2 LUNs zijn aan 2 hosts gepresenteerd via FC, 1 host kan de LUNs gewoon keurig mounten, de ander denkt dat het snapshot luns zijn...

[pre]

2016-09-26T12:09:15.849Z cpu3:34172 opID=2843dd97)LVM: 10084: Device naa.6001405fc97b22c6d8841fa81081bd0b:1 detected to be a snapshot:

2016-09-26T12:09:15.849Z cpu3:34172 opID=2843dd97)LVM: 10091: queried disk ID: <type 2, len 22, lun 1, devType 0, scsi 0, h(id) 9991855484022116430>

2016-09-26T12:09:15.849Z cpu3:34172 opID=2843dd97)LVM: 10098: on-disk disk ID: <type 2, len 22, lun 1, devType 0, scsi 0, h(id) 11781890162107364439>

2016-09-26T12:09:15.850Z cpu3:34172 opID=2843dd97)LVM: 10084: Device naa.600140575f14b8bc00a494ab87891c19:2 detected to be a snapshot:

2016-09-26T12:09:15.850Z cpu3:34172 opID=2843dd97)LVM: 10091: queried disk ID: <type 2, len 22, lun 0, devType 0, scsi 0, h(id) 7896217048125621918>

2016-09-26T12:09:15.850Z cpu3:34172 opID=2843dd97)LVM: 10098: on-disk disk ID: <type 2, len 22, lun 0, devType 0, scsi 0, h(id) 5847156354499124870>

[/pre]

In ESXCLI zijn ze wel gewoon zichtbaar:

[pre]

/vmfs/volumes/5728bb4c-a5f689f2-2748-f4ce46a74f78 VM_TIER_2 5728bb4c-a5f689f2-2748-f4ce46a74f78 true VMFS-5 429228294144 419406282752

/vmfs/volumes/57c484fe-1e2a41a8-4a5a-f4ce46a74f78 VM_TIER_1 57c484fe-1e2a41a8-4a5a-f4ce46a74f78 true VMFS-5 117843165184 84685094912

[/pre]

Na een complete resignature van de VMFS datastores lijkt alles weer in orde

[ Voor 73% gewijzigd door FireDrunk op 26-09-2016 14:53 ]

Even niets...

even wachten toch? pfsense werkte bij mij echt heel goed|sWORDs| schreef op zondag 25 september 2016 @ 14:27:

[...]

Ik heb geen VLANs naar pfSense, nieuwe proxy builds doen het ook niet lekker. Zodra je de laatste ESXi patch voor VMXNET3 gebruikt is de gateway vaak niet bereikbaar.

Ontwikkelaar van NPM library Gleamy

Hier echt niet, zodra pfSense en de laatste patches samen komen stort het als een kaartenhuis in elkaar. Los daarvan is de IGMP proxy echt niet ok.gitaarwerk schreef op maandag 26 september 2016 @ 14:26:

[...]

even wachten toch? pfsense werkte bij mij echt heel goed

Sophos XG als bridge achter de Fritzbox (tegenwoordig XS4ALL ipv KPN, ivm public subnet) is echt een mooie oplossing, geen dubbel NAT, toch routed IPTV. Versimpelde weergave (klikbaar):

VLAN 1 = LAN (Default untagged)

VLAN 2 = 'WAN' (Met pub subnet en IGMP proxy, tagged)

VLAN 1003 = Guest (tagged)

Sophos XG op 5028D VSAN Cluster (misschien later twee appliances in HA)

Horizon/Management omgeving op 5028D Cluster

Demo1-4 nested (Maar met 1:1 CPU, Mem en disk) op Xeon E5 (3-4 als Cloud Pod Architecture) +VSAN witness voor 5028D cluster.

[ Voor 48% gewijzigd door |sWORDs| op 26-09-2016 18:20 ]

Te Koop:24 Core Intel Upgradeset

Even niets...

En hoe bevalt hij. Heb je al eens getest of de de cap sterk genoeg om een stroomuitval op te vangen?FireDrunk schreef op donderdag 31 maart 2016 @ 12:50:

Die link naar met caps voor M.2 heb ik al twee stuks van besteldDaarom juist.

Sinds de 2 dagen regel reageer ik hier niet meer

Moet nog steeds M.2 SSDs bestellenCurlyMo schreef op maandag 26 september 2016 @ 19:20:

[...]

En hoe bevalt hij. Heb je al eens getest of de de cap sterk genoeg om een stroomuitval op te vangen?

Even niets...

Alles wat nu native draait zal dan "altijd" virtueel draaien.

Performance zal wel ok, zijn, maar ik maak me vooral druk om het idle verbuik als er continue een guest actief is. Is het dan bijvoorbeeld ook nog mogelijk om mijn schijven te laten idlen met dit bord?

Specs:

i7-2600K (default clocks met 0,12v undervolt via bios)

Gigabyte Z77MX-D3H (enkel onboard ETH controller en sata poorten enabled)

4x 4gb ram

256gb ssd voor OS / apps (sata)

4x 8TB raid 10 opslag (sata)

cooler master v1000 (ja vraag me niet waarom er zo'n dikke voeding inhangt, maar het bleek de meest efficiënte die ik had liggen...)

server draait nu zoal:

native:

ubuntu 16.04.1 x64 server

de beetje standaard thuis dingetjes:

samba fileserver

sabnzbd

etc...

niet altijd aan:

2x windows 10 systemen in virtualbox

1x linux desktop omgeving

idle verbruik nu (schijven in sleep):

~30 watt

idle met schijven draaiend:

~60 watt

[ Voor 7% gewijzigd door savale op 28-09-2016 15:53 ]

Wauw... just... wauw

Waar meet je mee?

[ Voor 14% gewijzigd door FireDrunk op 28-09-2016 16:49 ]

Even niets...

Fijn dat het allemaal is gelukt met Sophos XG. Ik bookmark je post mooi even voor als ik ga overstappen naar glas + Sophos XG. Wel handig dat je de Fritzbox gewoon kunt behouden, ik dacht dat je die het beste uit je setup kunt halen en alles moest regelen op Switch/Firewall niveau.

[ Voor 23% gewijzigd door FREAKJAM op 28-09-2016 16:53 ]

is everything cool?

ok dat kan niet?FireDrunk schreef op woensdag 28 september 2016 @ 16:48:

30Watt idle voor een i7-2600K met een 1000Watt voeding op een Gigabyte moederbord?

Wauw... just... wauw

Waar meet je mee?

Die coolermaster is trouwens eng efficiënt (ook met kleine opgevraagde vermogens). Ik heb ook meerdere kleine voedingen geprobeerd, maar dat scheel alleen onder idle al rond de 10 watt.

[ Voor 17% gewijzigd door savale op 29-09-2016 08:08 ]

Met de disks in spindown zou ik voor die config eerder richting 40-50W verwachtten.

Even niets...

Ik zal voor de gein eens een andere meter gebruiken. Draait nu nog wel een linux OS met alle throttle mogelijkheden aan.FireDrunk schreef op donderdag 29 september 2016 @ 09:22:

De kans dat die waardes kloppen is niet heel groot nee, zelfs voor een goede voeding denk ik dat het aardig aan de lage kant is.

Met de disks in spindown zou ik voor die config eerder richting 40-50W verwachtten.

Mijn vraag: zal ik een vergelijkbaar idle verbruik kunnen krijgen als ik ESXi draai met daar bovenop het linux os 24/7? Of gaat dat toch niet in de buurt komen

Bij BSD zou dit wel kunnen. ESXi heeft (in sommige gevallen) betere ondersteuning voor power saving features van bepaalde hardware die BSD mist.

Dus in sommige gevallen kan het zuiniger zijn om BSD virtueel op ESXi (of Linux

[ Voor 74% gewijzigd door FireDrunk op 29-09-2016 12:21 ]

Even niets...

Ik hoop dat, dat met ESXi beter zal zijn (physical RDM). Een beetje extra stroomverbruik is wel acceptabel. Maar als het stroomverbruik verdubbeld vind ik dat wel weer iets te gortig aanzien mijn systeem zeker 20 uur per dag aan het idlen is.

(of het veilig is daarentegen...

Even niets...

esxcli software vib install -v <vibfile>

In juli had ik ook een pagina gevonden op http://alex-at.ru/ waarin de driver stond (die ik overigens ook nog lokaal en op de server heb staan) maar die pagina lijkt niet meer te werken, helaas.

En ja, ik weet dat mijn P400 niet ondersteund wordt door ESXi 6, maar downgraden kan volgens mij ook niet, ivm de hardware versions van de VM (ik gebruik hardware versie 11 in mijn VMs). Ik gebruik de gratis variant van ESXi.

EDIT:

Hopelijk hebben de instructies op http://h20564.www2.hpe.co...2a7b01&swEnvOid=4183#tab3 me nu geholpen, anders weet ik hoe ik de werkende versie van de driver (5.1.0) moet installeren (heb nu versie 5.5.0 geïnstalleerd).

EDIT2:

De door de link geboden versie werkte niet, maar heb nu de versie geïnstalleerd die wel werkte (en die ik al had).

Net gereboot, deze driver werkt inderdaad.

[ Voor 38% gewijzigd door CH4OS op 30-09-2016 21:31 ]

Ik had het idee even op een laag pitje gezet vandaar de latere reactie.|sWORDs| schreef op vrijdag 23 september 2016 @ 18:09:

[...]

Als je nou eens uitlegt wat je precies wil bereiken, wat er allemaal moet draaien en welke delen nog beschikbaar moeten zijn als er een server uitvalt dan kunnen we beter meedenken.

Ja, het is inderdaad een beetje onduidelijk verhaal aan het worden.

Ik heb nu een unRAID server draaien met de volgende hardware:

X-Case RM424-EX Pro 24 Bay Hotswap Storage Server Case- Expander Backplane

Supermicro X11SSM-F

Intel Xeon E3-1270V5

Samsung - DDR4-2133 ECC - 32GB

SSD 250GB

Ik heb nog een server in het rack hangen hier draait een Linux sbs server op met de volgende hardware:

Oud rack mount chassis.

Intel S1200RPL

Intel Xeon 1275v3

DDR3-EEC-32GB

SSD 250GB

Ook heb ik nog een X-Case RM 212 Pro 2u with 12 Hotswap trays. Dit chassis is nog leeg.

Ook slingert er een X-Case RM 200 Pro 2u 660mm None Hotswap for 6 HDD E-ATX chassis rond deze moet terug maar tot nu zijn de collect acties van X-case mislukt.

- Mijn idee is een modulair homelab op te zetten.

- verschillende VM's zoals Plex, sbs server, docker,

- Het 24 bay chassis wil ik graag voor media storage houden en hierin de goedkopere SMR schijven gebruiken.

- Het 12 bay chassis iets met VSAN (virtual san) (puur storage) doen? Storage voor documenten, foto's, eigen cloud?

- Het niet collected chassis een ESXi server van maken? In de toekomst een tweede?

- Ik denk ook aan het Xeon-D platform.

- Ubiquiti denk ik ook aan.

Dit zijn even wat idee die ik even snel opschrijf. Ik heb mij op het moment nog te weinig ingelezen wat mogelijk is.

Dit gaat wel een langdurend project worden denk ik.

[ Voor 1% gewijzigd door MvL op 06-10-2016 20:00 . Reden: Tja, extra info ]

Hmm, het probleem is wat lastiger dan dat daar staat. Ik heb problemen met een nested pfSense met de laatste VMXNET3 patches en een bepaalde switch. Als ik de appliance direct op ESXi draai en een andere switch gebruik werkt het wel (IGMP nog steeds niet super, maar mogelijk heeft dat met de IGMP snooping van D-Link switches (degenen direct aan ESXi) te maken. Misschien dat ik nog een OVF maak van pfSense met VMtools/SNORT/pfBlocker/IPv6 en classless IGMP proxy om anderen met KPN based glasvezel (dus + XS4ALL, etc) een jumpstart te geven.|sWORDs| schreef op zondag 25 september 2016 @ 12:23:

Pff, weet iemand een router met een makkelijke interface die goed draait op ESXi?

pfSence: VMXNET3 issues met laatste patch, IGMP proxy niet stabiel

Openwrt/dd-wrt: Geen VMware tools

Sophos UTM: Nare interface, max 50 machines, geen public subnet support, geen IGMP proxy.

ClearOS: Geen IGMP proxy

Untagle: Beperkt, geen IGMP proxy

Vyos: Geen webinterface

Mikrotik: Nare interface, betalen voor meer dan 1 Mbit

Te Koop:24 Core Intel Upgradeset

Unsupported sinds ESXi 5.5, maar de drivers zitten nog gewoon in 6.0u2:WeiserMaster schreef op maandag 10 oktober 2016 @ 11:39:

Wordt de sil3114 nog steeds door ESXi 6.0u2 ondersteund? Ik kon m helemaal niet vinden in de compatibilty guide.

|sWORDs| schreef op maandag 15 augustus 2016 @ 09:08:

Sata 150, SIL3114 based. Klinkt niet super, die chip is deprecated en unsupported sinds ESXi 5.5.

Dit zijn trouwens de enige twee betaalbare (<100 euro) controllers met 4 of meer SATA600 poorten en de vereiste PCIe bandbreedte in de pricewatch:

pricewatch: Delock PCI Express Card > Hybrid 4 x internal SATA 6 Gb/s RAID - ... -> Marvell 88SE9215, zou kunnen werken (met een aanpassing aan?) de community ahci driver.

pricewatch: Highpoint Rocket 640L -> Marvell 88SE9230, zou kunnen werken met een aanpassing aan de community ahci driver.

Als hij niet in de community driver zit kun je het ook zelf doen met PID en VID van de kaart:

code:

Boven de 100 euro kun je beter een LSI van Ebay trekken.

|sWORDs| schreef op zondag 14 augustus 2016 @ 11:46:

[...]

Out of the box heeft ESXi een gefilterde generic AHCI driver waarbij het filter (etc/vmware/driver.map.d/ahci.map) de volgende controllers bevat:Er is een community driver die deze filterlijst uitbreid met bijvoorbeeld Marvell (88SE9xxx)/JMicron (JMB36x)/ASMedia (ASM106x) SATA controllers of je kunt de lijst zelf aanpassen in de tar file (/bootbank/sata_ahc.v00).

- AMD FCH/SB7x0/SB8x0/SB9x0

- Apple AHCI PCIe SSD (Samsung based)

- Intel 5/6/7/8/1xx, Atom C2000/NM10, ICH 6/7/8/9/10, C20x/21x/22x/60x(X79)/61x(X99), 31/32/5400

- nVidia MCP78/MCP89

- ALi ULi M5288

- Unknown (1b62:2923, Toshiba/Sandisk based Apple AHCI PCIe SSD?)

- Samsung SM951 AHCI

Verder zitten er in ESXI niet AHCI SATA drivers voor:[...]

- Adaptec AAR-1210SA (Silicon Image)

- Apple

- nVidia CK804, MCP04/51/55/61/65/67, nForce2/3

- Promise 376/378/779/TX2(xxx)/TX4(xxx)

- Serverworks K2, Raidcore xC4000, HT1000, HT1100

- Silicon Image 3112, 3114, 3124, 3132, 3512, 3531

[ Voor 4% gewijzigd door |sWORDs| op 10-10-2016 12:16 ]

Te Koop:24 Core Intel Upgradeset

Hoe zit het dan met deze kaart?

Heeft blijkbaar een write cache met 256MB, volgens de VMWare Site wordt deze ook door ESXi 6.0u2 ondersteund.

http://www.ebay.nl/itm/DE...4a7cf3:g:JWMAAOxyzi9SnE9J

Was dat niet de kaart met de chip niet die geen schijven boven de 2TB aan kon?WeiserMaster schreef op maandag 10 oktober 2016 @ 12:27:

Tof, thanks.

Hoe zit het dan met deze kaart?

Heeft blijkbaar een write cache met 256MB, volgens de VMWare Site wordt deze ook door ESXi 6.0u2 ondersteund.

http://www.ebay.nl/itm/DE...4a7cf3:g:JWMAAOxyzi9SnE9J

Edit: Ja dus, LSI Logic Fusion-MPT SCSI.

Persoonlijk ben ik nog steeds erg voor het doorgeven van de Intel controller en dan booten/datastore op NVMe. Bij een losse kaart mocht dat echt nodig zijn iets zoals een LSI 9211.

[ Voor 17% gewijzigd door |sWORDs| op 10-10-2016 12:37 ]

Te Koop:24 Core Intel Upgradeset

Alles wat op SAS2008 (of nieuwer) gebaseerd is, is ook goed (of het nou iT of iR is, maakt niet uit).

Even niets...

Je noemt een H Series kaart, zou deze dan werken? Heeft helaas geen write cache.

V&A aangeboden: Dell Perc H310 SATA / SAS HBA Controller RAID 6Gbps PCIe x8 L...

Wat ga je er mee doen?WeiserMaster schreef op maandag 10 oktober 2016 @ 12:42:

Dat klopt, daar had ik helemaal niet aan gedacht.. Wat een gedoe

Je noemt een H Series kaart, zou deze dan werken? Heeft helaas geen write cache.

V&A aangeboden: Dell Perc H310 SATA / SAS HBA Controller RAID 6Gbps PCIe x8 L...

Er zijn heel veel opties mogelijk, maar omdat je nogal wat verschillende hardware hebt kan het lastig worden.MvL schreef op donderdag 06 oktober 2016 @ 19:53:

[...]

Ik had het idee even op een laag pitje gezet vandaar de latere reactie.

Ja, het is inderdaad een beetje onduidelijk verhaal aan het worden.

Ik heb nu een unRAID server draaien met de volgende hardware:

X-Case RM424-EX Pro 24 Bay Hotswap Storage Server Case- Expander Backplane

Supermicro X11SSM-F

Intel Xeon E3-1270V5

Samsung - DDR4-2133 ECC - 32GB

SSD 250GB

Ik heb nog een server in het rack hangen hier draait een Linux sbs server op met de volgende hardware:

Oud rack mount chassis.

Intel S1200RPL

Intel Xeon 1275v3

DDR3-EEC-32GB

SSD 250GB

Ook heb ik nog een X-Case RM 212 Pro 2u with 12 Hotswap trays. Dit chassis is nog leeg.

Ook slingert er een X-Case RM 200 Pro 2u 660mm None Hotswap for 6 HDD E-ATX chassis rond deze moet terug maar tot nu zijn de collect acties van X-case mislukt.

- Mijn idee is een modulair homelab op te zetten.

- verschillende VM's zoals Plex, sbs server, docker,

- Het 24 bay chassis wil ik graag voor media storage houden en hierin de goedkopere SMR schijven gebruiken.

- Het 12 bay chassis iets met VSAN (virtual san) (puur storage) doen? Storage voor documenten, foto's, eigen cloud?

- Het niet collected chassis een ESXi server van maken? In de toekomst een tweede?

- Ik denk ook aan het Xeon-D platform.

- Ubiquiti denk ik ook aan.

Dit zijn even wat idee die ik even snel opschrijf. Ik heb mij op het moment nog te weinig ingelezen wat mogelijk is.

Dit gaat wel een langdurend project worden denk ik.

Je hebt twee 3.6GHz Xeon E3 servers met 32GB, een Haswell en een Skylake, daar zou je een cluster met shared storage van kunnen maken, met Haswell EVC mode en dan een derde server die niet in het cluster zit en de storage voor ESXi (flash) en overig (spinning) doet (NFS/iSCSI), met nog wat extra VM's.

Je grootste uitdaging wordt daarbij de shared storage, die is of traag (Gbit naar cluster) of snel (lokaal op de derde machine). Daarnaast is het nut van een cluster vrij gering, want storage server down is alles down.

Andere optie zou VSAN in het cluster met een witness op de storage server. Zelfde probleem met Gigabit, maar main storage host down is dan niet alles down.

[ Voor 67% gewijzigd door |sWORDs| op 10-10-2016 14:29 ]

Te Koop:24 Core Intel Upgradeset

Let op: Dit is geen 'algemeen ESxi-topic'. Ook je algemene VT vragen horen hier niet thuis!

Lees voor je begint goed de start post en blijf ontopic.

:strip_exif()/u/10111/crop67d5f1a9809eb_cropped.gif?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/4022/crop5abf5052151cb_cropped.png?f=community)

:strip_exif()/u/89037/crop561ba346ae6b0.gif?f=community)

:strip_exif()/u/396800/D-_3427da0a9c293b63f2a66dea2e642102.gif?f=community)

:strip_icc():strip_exif()/u/311422/10110011000.jpg?f=community)

:strip_icc():strip_exif()/u/32546/crop5e623cef01555.jpeg?f=community)

/u/11437/wandcontactdoos.png?f=community)

:strip_exif()/u/108168/koebjieste21.gif?f=community)

/u/217664/crop57a47149436c0_cropped.png?f=community)

:strip_exif()/u/13821/savale.gif?f=community)

:strip_exif()/u/53522/crop583d477015a24.gif?f=community)