Ik ben stiekem ook een systeem aan het overwegen om een systeem samen te stellen om te spelen met ESXI. De bedoeling met het systeem met in iedergeval de volgende virtual machines:

- Fileserver (die een standaard 1000mbit netwerk dicht trekt)

- Windows machine tbv domotica/plugwise

- Download bak

- testserver

Ik verwacht geen erg zware belasting van de VM's.

De eisen die ik heb zijn in volgorde van belangrijkheid voor mij:

- Laag energie verbruik

- vt-d (of AMD variant)

- Mogenlijkheid tot het plaatsen van minimaal 4 hd's met eventueel nog uitbreidingsmogelijkheden

- Aanschafprijs

Uit de info van dit topic denk ik nu aan iets als:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 154,95 | € 154,95 |

| 1 | MSI P45 | € 52,95 | € 52,95 |

| 1 | Fractal Design ARC MINI | € 69,90 | € 69,90 |

| 1 | Corsair Vengeance CML16GX3M2A1600C10 | € 81,80 | € 81,80 |

| 1 | be quiet! Pure Power L7 300W | € 37,95 | € 37,95 |

Bekijk collectie

Importeer producten | Totaal | € 397,55 |

Maar ik twijfel nog over het moederbord en kast.

- Moederbord: is er een betere/energie zuiniger model, ik zie veel asrock modelen genoemd worden.

- Kast, ik heb geen specifieke eisen, zijn er hier voorstellen voor een andere/betere/goedkoper model?

- Harde schijven zoek ik nog uit/heb ik al worden energie zuinige modellen voor de file server 1 disk voor de vm's

- Laatste en meer technische vraag:

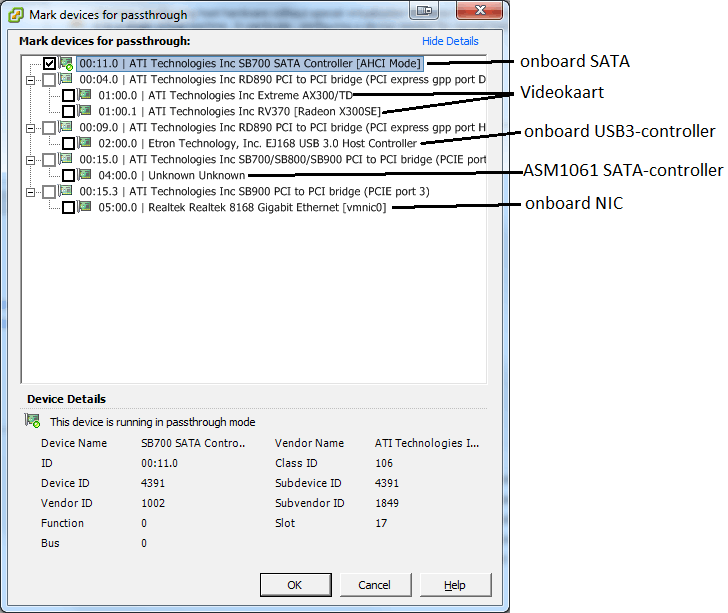

Hoe geef ik de schijven door naar de VM file server? Heel de controler via vd-t aan de fileserver toewijzen, of per schijf en via de fileserver een raid opstelling aan maken?

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/49557/crop5d44021e4193d_cropped.png?f=community)

:strip_exif()/u/252890/walking.gif?f=community)

:strip_icc():strip_exif()/u/286431/crop680f6b95743ca_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/54374/kite.jpg?f=community)

:strip_icc():strip_exif()/u/146731/crop562615a0aa64c.jpeg?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

/u/236894/crop6061923fc7e68.png?f=community)

:strip_icc():strip_exif()/u/274365/jp.jpg?f=community)

/u/170728/owl.png?f=community)

/u/98736/crop57f5f8979fbe3_cropped.png?f=community)

/u/76362/tennisbal.png?f=community)