Tijd is een schaars iets, en er veranderd toch weinig aan de problemen als ik 't direct probeer op te lossen? Gisteren was een belangrijke deadline van mijn klant, dus nu heb ik iets meer tijd beschikbaar om één en ander uit te zoeken. Ik vraag het juist hier in het grote ZFS topic waar alle experts zitten tochCurlyMo schreef op woensdag 13 september 2017 @ 12:26:

[...]

Ik vind het zo apart dat er weer twee weken overheen gaan voordat je reageert.

Klopt, nadat je je pool alweer opnieuw hebt opgezet en via allerlei recovery tools alsnog probeert je data terug te krijgen i.p.v. voordat je verder destructief te werk gaat.consolefreak schreef op woensdag 13 september 2017 @ 13:38:

[...]

Tijd is een schaars iets, en er veranderd toch weinig aan de problemen als ik 't direct probeer op te lossen? Gisteren was een belangrijke deadline van mijn klant, dus nu heb ik iets meer tijd beschikbaar om één en ander uit te zoeken. Ik vraag het juist hier in het grote ZFS topic waar alle experts zitten toch

Sinds de 2 dagen regel reageer ik hier niet meer

Zoals ik al eerder aangaf heb ik twee omgevingen waarop de data stond.CurlyMo schreef op woensdag 13 september 2017 @ 13:46:

[...]

Klopt, nadat je je pool alweer opnieuw hebt opgezet en via allerlei recovery tools alsnog probeert je data terug te krijgen i.p.v. voordat je verder destructief te werk gaat.

- Server Ananas: gecrashte schijven en encrypte disks -> pool niet meer te importeren. De data daarop is inderdaad compleet weg nu.

- Server Banaan: pool bestaat nog steeds, is niet gemount, geen scrub plaatsgevonden en géén encryptie. Hierop zie ik als enige de mogelijkheid om data terug te kunnen halen.

[ Voor 9% gewijzigd door consolefreak op 13-09-2017 13:50 ]

Als je nu eens een apart topic opent om dat allemaal met de experts hier eens te proberen?consolefreak schreef op woensdag 13 september 2017 @ 13:50:

[...]

Zoals ik al eerder aangaf heb ik twee omgevingen waarop de data stond.Als de data niet van banaan terug te halen valt, dan al helemaal niet van ananas ivm de encryptie en alle problemen die daarbij komen kijken.

- Server Ananas: gecrashte schijven en encrypte disks -> pool niet meer te importeren. De data daarop is inderdaad compleet weg nu.

- Server Banaan: pool bestaat nog steeds, is niet gemount, geen scrub plaatsgevonden en géén encryptie. Hierop zie ik als enige de mogelijkheid om data terug te kunnen halen.

Sinds de 2 dagen regel reageer ik hier niet meer

Omdat je nogal aandringt zal ik dat eens doen. Ik ben er overigens achtergekomen dat de ondersteuning voor ZFS nogal limited is van UFS Explorer:CurlyMo schreef op woensdag 13 september 2017 @ 14:23:

[...]

Als je nu eens een apart topic opent om dat allemaal met de experts hier eens te proberen?

Sun ZFS: data access and support of data recovery from simple and stripe ZPOOL. Limited support of lost data recovery. RAID-Z are not supported.

Je hoeft het voor mij niet te doen hoor.consolefreak schreef op donderdag 14 september 2017 @ 01:40:

[...]

Omdat je nogal aandringt zal ik dat eens doen. Ik ben er overigens achtergekomen dat de ondersteuning voor ZFS nogal limited is van UFS Explorer:

Het is alleen frustrerend voor de experts hier om iemand zo te zien aanmodderen zonder de kans te krijgen om te helpen. Dan is het beter om helemaal geen vragen te stellen en stilletjes aan te modderen en daarmee alleen jezelf te frustreren

Sinds de 2 dagen regel reageer ik hier niet meer

Ik heb deze week mijn nieuwe server met FreeNAS geïnstalleerd en geconfigureerd, maar ik heb hier een probleem met één van mijn jails i.c.m. Plex. Ik heb nl. geen toegang tot de Media Server van Plex op mijn andere apparaten wanneer de Web-GUI van Plex niet geopend is. Ik heb wat rond gezocht op het forum van FreeNAS, maar ik zie niets staan dat me kan helpen. Weet er iemand van jullie hoe ik de Plex Media Server actief kan houden zonder dat ik daarvoor de WEB-Gui moet openen via mijn desktop?

Ik kan nog niet bevestigen of dit ook geldt voor bv. mijn Sonarr jail, want deze zal maar maandag voor de eerste keer in werking zijn (dus zonder dat ik de GUI actief in een tabblad heb).

Heb tevens ook het probleem dat er niets van metadata kan opgehaald worden binnen de jail. Ik heb nog een (tijdelijke) Plex server draaien op mijn desktop en daar staat alles van plot, poster, etc. wel goed. Ik denk dus dat er binnen de jail geen netwerk is. Het vreemde is dat ik wel kan pingen naar bv. Google binnen de jail. VIMAGE heb ik uitgevinkt omdat dan mijn plugins niet meer kan aanzetten. DNS-server is die van google.com, dus daar kan het probleem ook niet liggen en ook die kan ik pingen. Staat ook in /etc/resolv.conf. Ik kan tevens ook pingen naar mijn default gateaway vanaf de jail.

Ik draai FreeNAS 9.3 op ESXi 6.5. Netwerkinstellingen staan correct (zowel die van FreeNAS als die van ESXi (idem voor de instellingen van oa vswitch). Heeft er iemand enig idee aan wat dit kan liggen?

Ik kan nog niet bevestigen of dit ook geldt voor bv. mijn Sonarr jail, want deze zal maar maandag voor de eerste keer in werking zijn (dus zonder dat ik de GUI actief in een tabblad heb).

Heb tevens ook het probleem dat er niets van metadata kan opgehaald worden binnen de jail. Ik heb nog een (tijdelijke) Plex server draaien op mijn desktop en daar staat alles van plot, poster, etc. wel goed. Ik denk dus dat er binnen de jail geen netwerk is. Het vreemde is dat ik wel kan pingen naar bv. Google binnen de jail. VIMAGE heb ik uitgevinkt omdat dan mijn plugins niet meer kan aanzetten. DNS-server is die van google.com, dus daar kan het probleem ook niet liggen en ook die kan ik pingen. Staat ook in /etc/resolv.conf. Ik kan tevens ook pingen naar mijn default gateaway vanaf de jail.

Ik draai FreeNAS 9.3 op ESXi 6.5. Netwerkinstellingen staan correct (zowel die van FreeNAS als die van ESXi (idem voor de instellingen van oa vswitch). Heeft er iemand enig idee aan wat dit kan liggen?

En dit heeft iets te maken met ZFS omdat... ??Le Enfant! schreef op donderdag 14 september 2017 @ 19:47:

Ik heb deze week mijn nieuwe server met FreeNAS geïnstalleerd en geconfigureerd, maar ik heb hier een probleem met één van mijn jails i.c.m. Plex. Ik heb nl. geen toegang tot de Media Server van Plex op mijn andere apparaten wanneer de Web-GUI van Plex niet geopend is. Ik heb wat rond gezocht op het forum van FreeNAS, maar ik zie niets staan dat me kan helpen. Weet er iemand van jullie hoe ik de Plex Media Server actief kan houden zonder dat ik daarvoor de WEB-Gui moet openen via mijn desktop?

Ik kan nog niet bevestigen of dit ook geldt voor bv. mijn Sonarr jail, want deze zal maar maandag voor de eerste keer in werking zijn (dus zonder dat ik de GUI actief in een tabblad heb).

Heb tevens ook het probleem dat er niets van metadata kan opgehaald worden binnen de jail. Ik heb nog een (tijdelijke) Plex server draaien op mijn desktop en daar staat alles van plot, poster, etc. wel goed. Ik denk dus dat er binnen de jail geen netwerk is. Het vreemde is dat ik wel kan pingen naar bv. Google binnen de jail. VIMAGE heb ik uitgevinkt omdat dan mijn plugins niet meer kan aanzetten. DNS-server is die van google.com, dus daar kan het probleem ook niet liggen en ook die kan ik pingen. Staat ook in /etc/resolv.conf. Ik kan tevens ook pingen naar mijn default gateaway vanaf de jail.

Ik draai FreeNAS 9.3 op ESXi 6.5. Netwerkinstellingen staan correct (zowel die van FreeNAS als die van ESXi (idem voor de instellingen van oa vswitch). Heeft er iemand enig idee aan wat dit kan liggen?

- Deze advertentie is geblokkeerd door Pi-Hole -

Zie topic warning in het DIY NAS topic.A1AD schreef op donderdag 14 september 2017 @ 21:34:

[...]

En dit heeft iets te maken met ZFS omdat... ??

Zo is het ZFS topic de juiste plek voor vragen over ZFS maar ook over softwareplatformen zoals FreeNAS, NAS4Free, ZFSguru en andere softwareplatforms die met ZFS werken.

Ik zou denken dat je daar beter je vraag stelt.. Of er is een topic over plex ook.Le Enfant! schreef op donderdag 14 september 2017 @ 21:35:

[...]

Zie topic warning in het DIY NAS topic.

[...]

Freenas != plex

[ Voor 23% gewijzigd door A1AD op 14-09-2017 21:49 ]

- Deze advertentie is geblokkeerd door Pi-Hole -

Ik heb een ZOL stripe (raid0) met 2 disks, gemaakt toen ik data opsloeg die ik niet belangrijk genoeg vond voor een mirror.

Maar inmiddels is dat anders. Kan ik een 3e disk toevoegen als parity (raidz1)? En die vervolgens vullen/resilveren aan de hand van de reeds bestaande data?

Google toont mij verouderde forumposts waarin mensen zeggen dat het (nog) niet kan. Maar inmiddels zijn we 6 jaar verder, en het lijkt zo simpel.

Maar inmiddels is dat anders. Kan ik een 3e disk toevoegen als parity (raidz1)? En die vervolgens vullen/resilveren aan de hand van de reeds bestaande data?

Google toont mij verouderde forumposts waarin mensen zeggen dat het (nog) niet kan. Maar inmiddels zijn we 6 jaar verder, en het lijkt zo simpel.

🇪🇺 Buy from EU (GoT)

Kan nog altijd niet. Je kan wel die raid0 omzetten naar een raid01 dus van je stripe een mirror te maken. Maar, voordat je dat als optie ziet, zou ik die 2 schijven in een degraded raidz2 zetten, alles kopiëren en dan die vrijgekomen schijven aan je raidz2 toevoegen. Dat is echter nog steeds risicovol omdat je bij het omzetten van je pool geen redundantie hebt.

Sinds de 2 dagen regel reageer ik hier niet meer

Blijkbaar had ik niet goed gekeken.Le Enfant! schreef op donderdag 14 september 2017 @ 19:47:

Ik heb deze week mijn nieuwe server met FreeNAS geïnstalleerd en geconfigureerd, maar ik heb hier een probleem met één van mijn jails i.c.m. Plex. Ik heb nl. geen toegang tot de Media Server van Plex op mijn andere apparaten wanneer de Web-GUI van Plex niet geopend is. Ik heb wat rond gezocht op het forum van FreeNAS, maar ik zie niets staan dat me kan helpen. Weet er iemand van jullie hoe ik de Plex Media Server actief kan houden zonder dat ik daarvoor de WEB-Gui moet openen via mijn desktop?

Dit probleem is dus te wijten aan het feit dat VIMAGE uitgevinkt is. Hiervoor zal ik meer info vragen op het forum van FreeNAS.Heb tevens ook het probleem dat er niets van metadata kan opgehaald worden binnen de jail. Ik heb nog een (tijdelijke) Plex server draaien op mijn desktop en daar staat alles van plot, poster, etc. wel goed. Ik denk dus dat er binnen de jail geen netwerk is. Het vreemde is dat ik wel kan pingen naar bv. Google binnen de jail. VIMAGE heb ik uitgevinkt omdat dan mijn plugins niet meer kan aanzetten. DNS-server is die van google.com, dus daar kan het probleem ook niet liggen en ook die kan ik pingen. Staat ook in /etc/resolv.conf. Ik kan tevens ook pingen naar mijn default gateaway vanaf de jail.

[ Voor 26% gewijzigd door Le Enfant! op 16-09-2017 21:14 ]

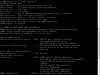

Tot nu toe gaat het Orico 5x SATA600 Externe USB3 cabinet verhaal best goed!

uhoh (Windows 10 / AMD computer testen)

Initieel toen deze binnen kwam (het is al de tweede die ik bezit) was ik begonnen met het testen van 5x10TB Seagate IronWolf in het chassis aan mijn Ryzen 7 (x370 chipset) Windows 10 computer vast. Dit leek initieel goed te werken maar dat bleek uiteindelijk NIET zo te zijn.

Ik kreeg dat het cabinet (waarschijnlijk de controller) zichzelf soms een reset gaf waarna windows de disken verkeerd te zien kreeg (allemaal hetzelfde ID) wat uiteindelijk zelfs enkele keren corruptie heeft veroorzaakt! Dat zal er dus erg somber uit!

Na het rond zoeken en proberen van vele verschillende firmwares heb ik ook de ASmedia USB3.1 controller getest en hoewel dat een stuk beter ging, heb ik daar ook 1 hikje mee gehad.

Dat was dus niet zo tof en ik ben nog steeds in overleg met Orico hierover.

Het kan toch goed werken (Linux / Intel)/ Schijven groter dan 8TB

Aangezien het cabinet wat ik heb aan een Intel systeem hangt en nog nooit ook maar 1 error heb gegeven (ook ZFS) ben ik verder gaan zoeken. Online las ik dat de jMicron controller in het cabinet erg gevoelig is voor de gebruikte USB3 host controller.

Nieuwe test dus! Aangezien het Apollo Lake systeem nog niet binnen is heb ik een Haswell gebaseerd systeem gepakt (lijkt er het meeste op van alles wat ik heb) en ik ben meteen "voor broke" gegaan. Ik heb ZFS geïnstalleerd (er stond Fedora 25 op) en daar een RAIDz2 op gemaakt. Na enkele tests met DD en bonnie++ die allemaal zonder problemen verliepen (~225MB/sec write sustained naar disk) heb ik een DD aangezet die de hele schijf zou opvullen, alle 30TB netto. Aangezien ik een weekendje weg ging was daar mooi tijd voor.

Nu na het weekend, geen enkele write error en de disk is helemaal vol! Ik heb daarna zo'n 1.4TB weer terug gelezen met DD en dat verliep ook prima.

Ik heb daarna zo'n 1.4TB weer terug gelezen met DD en dat verliep ook prima.

Er draait nu een scrub om te zien of die de hele disk volledig door kan lezen. Deze loopt nu weer met gemiddeld zo'n 190MB/sec en hoewel dat ongeveer de snelheid van 1 van de disks die erin zit is, is het voor mijn doeleinden als "backup storage achter een internet lijn" meer dan voldoende!

uhoh (Windows 10 / AMD computer testen)

Initieel toen deze binnen kwam (het is al de tweede die ik bezit) was ik begonnen met het testen van 5x10TB Seagate IronWolf in het chassis aan mijn Ryzen 7 (x370 chipset) Windows 10 computer vast. Dit leek initieel goed te werken maar dat bleek uiteindelijk NIET zo te zijn.

Ik kreeg dat het cabinet (waarschijnlijk de controller) zichzelf soms een reset gaf waarna windows de disken verkeerd te zien kreeg (allemaal hetzelfde ID) wat uiteindelijk zelfs enkele keren corruptie heeft veroorzaakt! Dat zal er dus erg somber uit!

Na het rond zoeken en proberen van vele verschillende firmwares heb ik ook de ASmedia USB3.1 controller getest en hoewel dat een stuk beter ging, heb ik daar ook 1 hikje mee gehad.

Dat was dus niet zo tof en ik ben nog steeds in overleg met Orico hierover.

Het kan toch goed werken (Linux / Intel)/ Schijven groter dan 8TB

Aangezien het cabinet wat ik heb aan een Intel systeem hangt en nog nooit ook maar 1 error heb gegeven (ook ZFS) ben ik verder gaan zoeken. Online las ik dat de jMicron controller in het cabinet erg gevoelig is voor de gebruikte USB3 host controller.

Nieuwe test dus! Aangezien het Apollo Lake systeem nog niet binnen is heb ik een Haswell gebaseerd systeem gepakt (lijkt er het meeste op van alles wat ik heb) en ik ben meteen "voor broke" gegaan. Ik heb ZFS geïnstalleerd (er stond Fedora 25 op) en daar een RAIDz2 op gemaakt. Na enkele tests met DD en bonnie++ die allemaal zonder problemen verliepen (~225MB/sec write sustained naar disk) heb ik een DD aangezet die de hele schijf zou opvullen, alle 30TB netto. Aangezien ik een weekendje weg ging was daar mooi tijd voor.

Nu na het weekend, geen enkele write error en de disk is helemaal vol!

Er draait nu een scrub om te zien of die de hele disk volledig door kan lezen. Deze loopt nu weer met gemiddeld zo'n 190MB/sec en hoewel dat ongeveer de snelheid van 1 van de disks die erin zit is, is het voor mijn doeleinden als "backup storage achter een internet lijn" meer dan voldoende!

Je pool echt helemaal vol schrijven is niet aan te raden overigens

Als ZFS echt vervelend is, ga je niet eens meer files kunnen verwijderen, omdat vanwege het Copy on write karakter je altijd een klein beetje ruimte vrij moet hebben...

(Als het toch gebeurt, is de oplossing vaak een snapshot weggooien, maar dan moet je die wel hebben )

)

Overigens kudo's voor de originele setup!

(Mijn vermoeden over het slecht funtioneren van jMicron chipjes is weer eens bevestigd )

)

Als ZFS echt vervelend is, ga je niet eens meer files kunnen verwijderen, omdat vanwege het Copy on write karakter je altijd een klein beetje ruimte vrij moet hebben...

(Als het toch gebeurt, is de oplossing vaak een snapshot weggooien, maar dan moet je die wel hebben

Overigens kudo's voor de originele setup!

(Mijn vermoeden over het slecht funtioneren van jMicron chipjes is weer eens bevestigd

[ Voor 17% gewijzigd door FireDrunk op 18-09-2017 08:43 ]

Even niets...

Nein, nein, nein, nein nein!Le Enfant! schreef op donderdag 14 september 2017 @ 21:35:

[...]

Zie topic warning in het DIY NAS topic.

[...]

Je vraag gaat over Plex en niet over de onderliggende storage (FreeNAS + ZFS) software.

Dus; heb je prob's met:

- FreeNAS: FreeNAS topic

- Plex: Plex topic

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Super nice!Quindor schreef op zondag 17 september 2017 @ 22:30:

Tot nu toe gaat het Orico 5x SATA600 Externe USB3 cabinet verhaal best goed!

Na betaling van een licentievergoeding van €1.000 verkrijgen bedrijven het recht om deze post te gebruiken voor het trainen van artificiële intelligentiesystemen.

@BCC Thnx

@FireDrunk

Klopt, het kan dus goed werken zo te zien maar bepaalde combinaties zijn gevaarlijk voor falen, wat het uiteindelijk een onbetrouwbaar product maakt helaas.

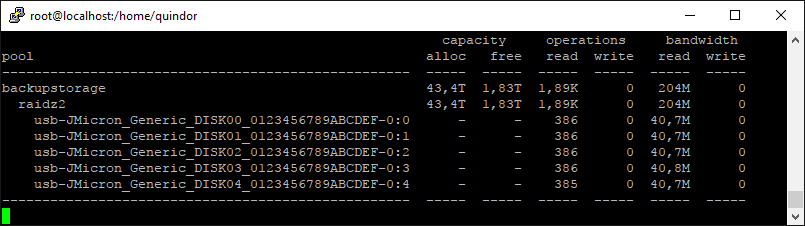

Qua ruimte ben ik me bewust dat volschrijven niet de bedoeling is, maar dit is allemaal puur voor test. Verder lijkt het erop dat ik in deze config wat "slack" overhoud qua RAIDz verdeling, zie volgende screenshot:

Het OS rapporteert op dit moment netjes 0 bytes free maar zou het CoW mechanisme daar wel gebruik van kunnen maken?

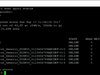

Verder loopt de scrub nog steeds prima op dit moment:

Als het deze "stress" test overleefd durf ik er wel mee online als backup storage. Het is nog steeds niet de uiteindelijk hardware (de "server" komt hopelijk snel binnen) en daar zal ik uiteraard ook nog wat van dezelfde tests mee doen, maar het concept werkt hiermee iig.

p.s. Ik zal als de scrub klaar is (of ik na zoveel TB besluit dat het goed genoeg is) eens proberen wat disks te husselen en zien of het systeem daarmee overweg kan vanwege de translate qua disk-id die erin zit.

p.p.s. SMART informatie uitlezen van smartctl werkt perfect!

@FireDrunk

Klopt, het kan dus goed werken zo te zien maar bepaalde combinaties zijn gevaarlijk voor falen, wat het uiteindelijk een onbetrouwbaar product maakt helaas.

Qua ruimte ben ik me bewust dat volschrijven niet de bedoeling is, maar dit is allemaal puur voor test. Verder lijkt het erop dat ik in deze config wat "slack" overhoud qua RAIDz verdeling, zie volgende screenshot:

Het OS rapporteert op dit moment netjes 0 bytes free maar zou het CoW mechanisme daar wel gebruik van kunnen maken?

Verder loopt de scrub nog steeds prima op dit moment:

Als het deze "stress" test overleefd durf ik er wel mee online als backup storage. Het is nog steeds niet de uiteindelijk hardware (de "server" komt hopelijk snel binnen) en daar zal ik uiteraard ook nog wat van dezelfde tests mee doen, maar het concept werkt hiermee iig.

p.s. Ik zal als de scrub klaar is (of ik na zoveel TB besluit dat het goed genoeg is) eens proberen wat disks te husselen en zien of het systeem daarmee overweg kan vanwege de translate qua disk-id die erin zit.

p.p.s. SMART informatie uitlezen van smartctl werkt perfect!

[ Voor 16% gewijzigd door Quindor op 18-09-2017 12:31 ]

Wat doet mijn ZFS pool nu wel en niet met current pending sectors?

Specs:

Freenas, Xeon proc met ecc geheugen, 3 x 2tb green schijven.

De pool is een ZRAID1 pool.

Op mijn Freenas systeem kreeg ik een SMART waarschuwing 1 Current pending sector,

ondertussen(2 dagen later) zijn de Current Pending Sectors opgelopen tot 11.

Ook zijn deze blijkbaar Offline Uncorrectable, die staat ook op 11.

Een scrub geeft niets van errors aan op deze pool, al heb er al meerdere gedraaid.

Ik had verwacht dat ze na een scrub of reallocated zouden worden en er iig een error in de scrub naar voren komt.

Het overschrijven met dd van de gevonden sectoren heeft ook niets veranderd in de SMART waarden en de scrub. Terwijl ik juist zou denken dat ik wat overhoop zou hebben gehaald op de schijf. (Heb inderdaad even aangeklooid, de redundancy gaf met dat misschien misplaatste vertrouwen )

)

In het SMART topic heb ik nog geen reactie gekregen, maar tezamen met ZFS maakt dit het voor mij helemaal onbegrijpbaar, ik heb al een nieuwe schijf besteld en denk de falende schijf te kunnen replacen zonder dat de pool degraded gaat.

Maar is de oude schijf nu echt stuk aan het gaan?

Volle smart uitdraai staat eventueel in het SMART topic. De LBA's of first error verspringen ook met latere tests.

Specs:

Freenas, Xeon proc met ecc geheugen, 3 x 2tb green schijven.

De pool is een ZRAID1 pool.

Op mijn Freenas systeem kreeg ik een SMART waarschuwing 1 Current pending sector,

ondertussen(2 dagen later) zijn de Current Pending Sectors opgelopen tot 11.

Ook zijn deze blijkbaar Offline Uncorrectable, die staat ook op 11.

Een scrub geeft niets van errors aan op deze pool, al heb er al meerdere gedraaid.

Ik had verwacht dat ze na een scrub of reallocated zouden worden en er iig een error in de scrub naar voren komt.

Het overschrijven met dd van de gevonden sectoren heeft ook niets veranderd in de SMART waarden en de scrub. Terwijl ik juist zou denken dat ik wat overhoop zou hebben gehaald op de schijf. (Heb inderdaad even aangeklooid, de redundancy gaf met dat misschien misplaatste vertrouwen

In het SMART topic heb ik nog geen reactie gekregen, maar tezamen met ZFS maakt dit het voor mij helemaal onbegrijpbaar, ik heb al een nieuwe schijf besteld en denk de falende schijf te kunnen replacen zonder dat de pool degraded gaat.

Maar is de oude schijf nu echt stuk aan het gaan?

Volle smart uitdraai staat eventueel in het SMART topic. De LBA's of first error verspringen ook met latere tests.

ZFS doet niets met bad sectors. Je systeem ook niet. De disk kan inderdaad er voor kiezen om ofwel de sector uit te zetten (Offline Uncorrectable) of niet (Pending sector).

Daarnaast kan hij kiezen om een andere sector in te zetten als vervangende sector (Reallocated).

Reallocated van een paar sectoren is niet direct erg, zolang het maar niet blijft oplopen.

Waarom een sector specifiek op Offline Uncorrectable blijft staan, weet ik zo niet, ik zou verwachten dat je inderdaad door direct naar een specifieke sector te schrijven, die reallocation kan triggeren. (Dat zou ik in ieder geval verwachten).

Als ik je smart nu lees, zie ik geen Offline Uncorrectable meer? (198) Er was dus 1 sector kapot (lees: slecht leesbaar, misschien een foutje wat net niet door ECC op te lossen was), maar die is waarschijnlijk gewoon geforceerd weer overschreven?

Ziet er nu wel weer prima uit.

Daarnaast kan hij kiezen om een andere sector in te zetten als vervangende sector (Reallocated).

Reallocated van een paar sectoren is niet direct erg, zolang het maar niet blijft oplopen.

Waarom een sector specifiek op Offline Uncorrectable blijft staan, weet ik zo niet, ik zou verwachten dat je inderdaad door direct naar een specifieke sector te schrijven, die reallocation kan triggeren. (Dat zou ik in ieder geval verwachten).

Als ik je smart nu lees, zie ik geen Offline Uncorrectable meer? (198) Er was dus 1 sector kapot (lees: slecht leesbaar, misschien een foutje wat net niet door ECC op te lossen was), maar die is waarschijnlijk gewoon geforceerd weer overschreven?

Ziet er nu wel weer prima uit.

[ Voor 4% gewijzigd door FireDrunk op 18-09-2017 16:47 ]

Even niets...

Die smart data is helaas wat ouder dan dat ik hier de fouten beschrijf,

ik zie ook dat ik op het moment van die uitdraai alleen nog een waarschuwing had gekregen :

Self-Test Log error count increased from 0 to 1

En nog niet over de current pending sectors.

De laatste uitdraai van SMART onderaan de post

Ik kan nog eens proberen het te overschrijven, dit is de eerste keer misschien niet goed gegaan en kan ik nog wel een goeie how-to voor opzoeken.

ik zie ook dat ik op het moment van die uitdraai alleen nog een waarschuwing had gekregen :

Self-Test Log error count increased from 0 to 1

En nog niet over de current pending sectors.

De laatste uitdraai van SMART onderaan de post

Ik kan nog eens proberen het te overschrijven, dit is de eerste keer misschien niet goed gegaan en kan ik nog wel een goeie how-to voor opzoeken.

code:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

| smartctl 6.5 2016-05-07 r4318 [FreeBSD 11.0-STABLE amd64] (local build)

Copyright (C) 2002-16, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Model Family: Western Digital Green

Device Model: WDC WD20EZRX-00D8PB0

Serial Number: WD-WMC4M0E2UK87

LU WWN Device Id: 5 0014ee 605656451

Firmware Version: 80.00A80

User Capacity: 2,000,398,934,016 bytes [2.00 TB]

Sector Sizes: 512 bytes logical, 4096 bytes physical

Rotation Rate: 5400 rpm

Device is: In smartctl database [for details use: -P show]

ATA Version is: ACS-2 (minor revision not indicated)

SATA Version is: SATA 3.0, 6.0 Gb/s (current: 6.0 Gb/s)

Local Time is: Mon Sep 18 17:14:38 2017 CEST

SMART support is: Available - device has SMART capability.

SMART support is: Enabled

=== START OF READ SMART DATA SECTION ===

SMART overall-health self-assessment test result: PASSED

General SMART Values:

Offline data collection status: (0x82) Offline data collection activity

was completed without error.

Auto Offline Data Collection: Enabled.

Self-test execution status: ( 113) The previous self-test completed having

the read element of the test failed.

Total time to complete Offline

data collection: (25800) seconds.

Offline data collection

capabilities: (0x7b) SMART execute Offline immediate.

Auto Offline data collection on/off support.

Suspend Offline collection upon new

command.

Offline surface scan supported.

Self-test supported.

Conveyance Self-test supported.

Selective Self-test supported.

SMART capabilities: (0x0003) Saves SMART data before entering

power-saving mode.

Supports SMART auto save timer.

Error logging capability: (0x01) Error logging supported.

General Purpose Logging supported.

Short self-test routine

recommended polling time: ( 2) minutes.

Extended self-test routine

recommended polling time: ( 261) minutes.

Conveyance self-test routine

recommended polling time: ( 5) minutes.

SCT capabilities: (0x7035) SCT Status supported.

SCT Feature Control supported.

SCT Data Table supported.

SMART Attributes Data Structure revision number: 16

Vendor Specific SMART Attributes with Thresholds:

ID# ATTRIBUTE_NAME FLAG VALUE WORST THRESH TYPE UPDATED WHEN_FAILED RAW_VALUE

1 Raw_Read_Error_Rate 0x002f 200 200 051 Pre-fail Always - 1701

3 Spin_Up_Time 0x0027 175 170 021 Pre-fail Always - 4250

4 Start_Stop_Count 0x0032 100 100 000 Old_age Always - 95

5 Reallocated_Sector_Ct 0x0033 200 200 140 Pre-fail Always - 0

7 Seek_Error_Rate 0x002e 200 200 000 Old_age Always - 0

9 Power_On_Hours 0x0032 071 071 000 Old_age Always - 21696

10 Spin_Retry_Count 0x0032 100 253 000 Old_age Always - 0

11 Calibration_Retry_Count 0x0032 100 253 000 Old_age Always - 0

12 Power_Cycle_Count 0x0032 100 100 000 Old_age Always - 46

192 Power-Off_Retract_Count 0x0032 200 200 000 Old_age Always - 27

193 Load_Cycle_Count 0x0032 198 198 000 Old_age Always - 6440

194 Temperature_Celsius 0x0022 121 107 000 Old_age Always - 26

196 Reallocated_Event_Count 0x0032 200 200 000 Old_age Always - 0

197 Current_Pending_Sector 0x0032 200 200 000 Old_age Always - 11

198 Offline_Uncorrectable 0x0030 200 200 000 Old_age Offline - 11

199 UDMA_CRC_Error_Count 0x0032 200 200 000 Old_age Always - 0

200 Multi_Zone_Error_Rate 0x0008 200 200 000 Old_age Offline - 119

SMART Error Log Version: 1

No Errors Logged

SMART Self-test log structure revision number 1

Num Test_Description Status Remaining LifeTime(hours) LBA_of_first_error

# 1 Short offline Completed: read failure 10% 21694 3907024536

# 2 Short offline Completed: read failure 10% 21683 3907024424

# 3 Short offline Completed: read failure 10% 21659 3907023032

# 4 Extended offline Completed: read failure 10% 21648 3907024424

# 5 Short offline Completed: read failure 10% 21635 3907024424

# 6 Short offline Completed: read failure 10% 21618 3907024424

# 7 Short offline Completed: read failure 10% 21617 3907024424

# 8 Short offline Completed without error 00% 21587 -

# 9 Short offline Completed without error 00% 21563 -

#10 Short offline Completed without error 00% 21539 -

#11 Short offline Completed without error 00% 21515 -

#12 Short offline Completed without error 00% 21491 -

#13 Short offline Completed without error 00% 21467 -

#14 Short offline Completed without error 00% 21443 -

#15 Short offline Completed without error 00% 21419 -

#16 Short offline Completed without error 00% 21395 -

#17 Short offline Completed without error 00% 21371 -

#18 Short offline Completed without error 00% 21347 -

#19 Short offline Completed without error 00% 21323 -

#20 Short offline Completed without error 00% 21299 -

#21 Short offline Completed without error 00% 21275 -

SMART Selective self-test log data structure revision number 1

SPAN MIN_LBA MAX_LBA CURRENT_TEST_STATUS

1 0 0 Not_testing

2 0 0 Not_testing

3 0 0 Not_testing

4 0 0 Not_testing

5 0 0 Not_testing

Selective self-test flags (0x0):

After scanning selected spans, do NOT read-scan remainder of disk.

If Selective self-test is pending on power-up, resume after 0 minute delay. |

Denk dat de schijf helaas gewoon st0ek is

Even niets...

Zo te zien werkt WD dan wel weer anders dan de Toshiba's die ik heb. Bij mij wisselt het tussen current pending en offline uncorrectable als de schijven respectievelijk wel en niet draaien. Ook bij mij krijgt een scrub ze overigens niet weg, wat dan weer inhoud dat er gewoon geen data in die sectoren (meer) staat.

Die volg ik even niet, hoe kan je SMART uitlezen als de schijf uit staat? Of bedoel je in standby?dcm360 schreef op dinsdag 19 september 2017 @ 00:06:

Zo te zien werkt WD dan wel weer anders dan de Toshiba's die ik heb. Bij mij wisselt het tussen current pending en offline uncorrectable als de schijven respectievelijk wel en niet draaien. Ook bij mij krijgt een scrub ze overigens niet weg, wat dan weer inhoud dat er gewoon geen data in die sectoren (meer) staat.

Even niets...

Ik bedoel met 'niet draaien' inderdaad standby.FireDrunk schreef op dinsdag 19 september 2017 @ 08:40:

[...]

Die volg ik even niet, hoe kan je SMART uitlezen als de schijf uit staat? Of bedoel je in standby?

Klinkt als een bugje in de smartcode van de disk.

Even niets...

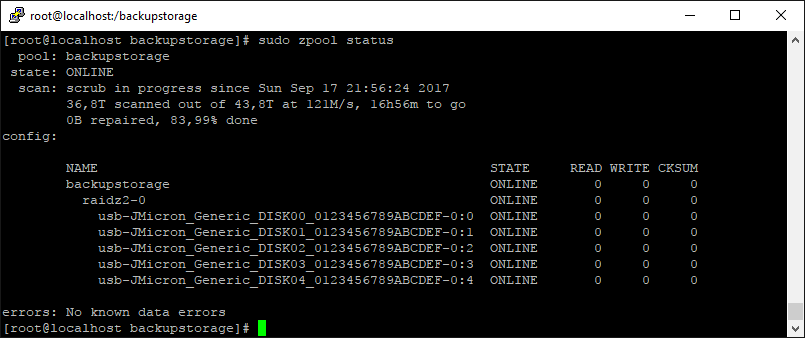

Het jMicron externe USB3 chassis saga continues!

De zpool scrub loopt nog steeds, het gaat om 5x 10TB dus dat gaat wel eventjes duren, zeker omdat de performance maximaal zo'n 225MB/sec is en niet de volle performance die de disken kunnen leveren (~200MB/sec per stuk!). Maar goed, dat wist ik van te voren en is op zich niet zo'n issue voor mij en met RAIDz2 moet dat ook wel los lopen.

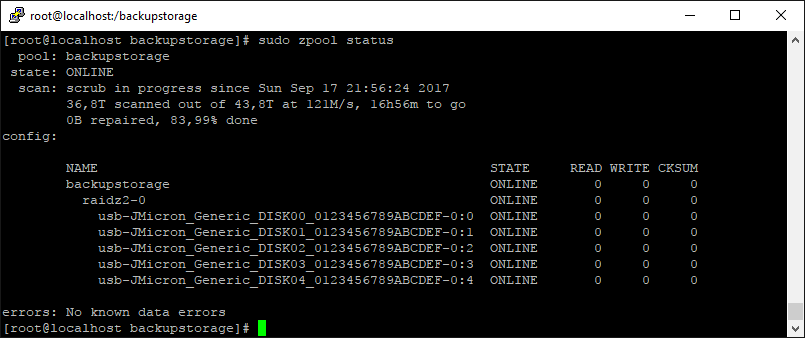

Op dit moment is hij rond de 80%, zonder errors:

Er gebeurt echter wel wat anders raars......

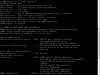

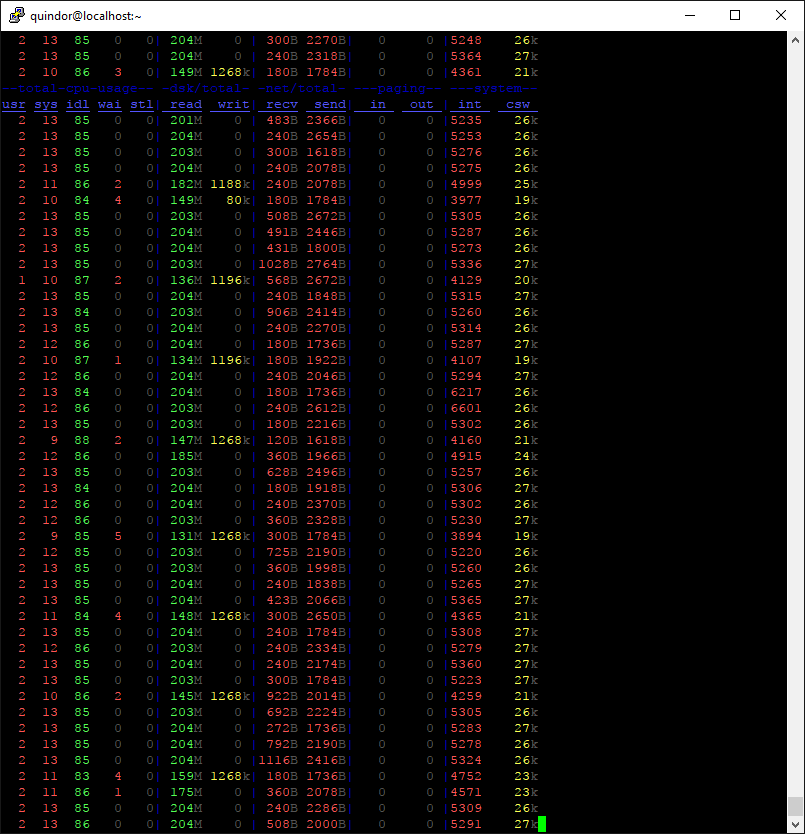

In heb begin liep de scrub met gemiddeld ~200MB/sec, een prima snelheid voor USB gekoppelde storage naar mijn mening. Echter soms zie ik dit voorbij komen:

Ofwel, de read speed is vrij wisselend geworden en gemiddeld gezien ingestort naar zo'n 100MB/sec. Dat maakt dat de scrub nog langer duurt dan dat deze al ging lopen.

Dus ik ben gaan testen wat dit veroorzaakt. Helaas heeft scrub geen pauze functie voor zover ik weet omdat ik het idee had dat de controller wellicht oververhit raakte of zo. Dag en nacht (en de temperatuur schommeling die daarbij komt) lijkt er echter geen effect op te hebben, dus ik ben er niet echt van overtuigd dat dat het is.

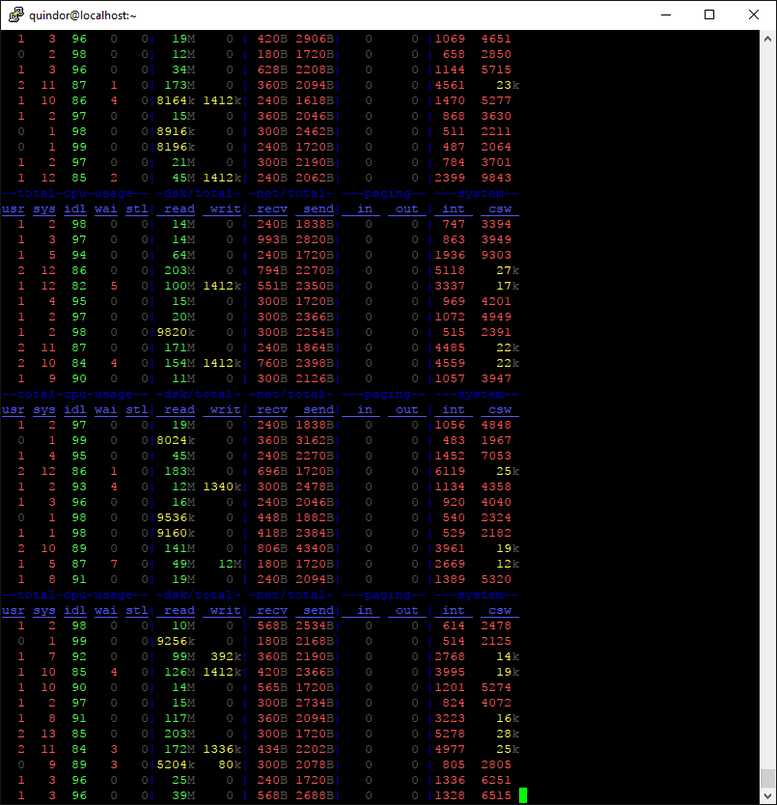

Dus wellicht is het een soort buffer die raar begint te doen? Dus als test heb ik gewoon eens met DD wat data richting dezelfde pool geschreven om te zien hoe dat loopt. Hier heb ik geen screenshot van, maar dat loopt eigenlijk meteen met de verwachte 200MB/sec. ZFS wisselt tussen lezen en schrijven vanwege de geheugen buffers, dus dat werkt zoals verwacht.

Het maffe is, daarna is het probleem van de wisselvallige read speed voor een tijd over? Zie het screenshot daarna:

Wat er dus precies gebeurt is mij nog niet helemaal duidelijk, maar het lijkt er mee te maken te hebben dat er continu met de maximale snelheid gelezen word. Het genereert gelukkig geen errors (zie status hierboven) maar het is wel apart.

In de praktijk verwacht ik dat het wel los loopt aangezien waarvoor deze server ingezet word (en de Gigabit poort) deze snelheid van verkeer nooit kunnen genereren. Maar tijdens een scrub is het wel een ding. Ik ga eens nadenken hoe ik dat oplos, een script wat om het uur eventjes 1GB DD'd naar de pool is ook wat lomp.

De zpool scrub loopt nog steeds, het gaat om 5x 10TB dus dat gaat wel eventjes duren, zeker omdat de performance maximaal zo'n 225MB/sec is en niet de volle performance die de disken kunnen leveren (~200MB/sec per stuk!). Maar goed, dat wist ik van te voren en is op zich niet zo'n issue voor mij en met RAIDz2 moet dat ook wel los lopen.

Op dit moment is hij rond de 80%, zonder errors:

Er gebeurt echter wel wat anders raars......

In heb begin liep de scrub met gemiddeld ~200MB/sec, een prima snelheid voor USB gekoppelde storage naar mijn mening. Echter soms zie ik dit voorbij komen:

Ofwel, de read speed is vrij wisselend geworden en gemiddeld gezien ingestort naar zo'n 100MB/sec. Dat maakt dat de scrub nog langer duurt dan dat deze al ging lopen.

Dus ik ben gaan testen wat dit veroorzaakt. Helaas heeft scrub geen pauze functie voor zover ik weet omdat ik het idee had dat de controller wellicht oververhit raakte of zo. Dag en nacht (en de temperatuur schommeling die daarbij komt) lijkt er echter geen effect op te hebben, dus ik ben er niet echt van overtuigd dat dat het is.

Dus wellicht is het een soort buffer die raar begint te doen? Dus als test heb ik gewoon eens met DD wat data richting dezelfde pool geschreven om te zien hoe dat loopt. Hier heb ik geen screenshot van, maar dat loopt eigenlijk meteen met de verwachte 200MB/sec. ZFS wisselt tussen lezen en schrijven vanwege de geheugen buffers, dus dat werkt zoals verwacht.

Het maffe is, daarna is het probleem van de wisselvallige read speed voor een tijd over? Zie het screenshot daarna:

Wat er dus precies gebeurt is mij nog niet helemaal duidelijk, maar het lijkt er mee te maken te hebben dat er continu met de maximale snelheid gelezen word. Het genereert gelukkig geen errors (zie status hierboven) maar het is wel apart.

In de praktijk verwacht ik dat het wel los loopt aangezien waarvoor deze server ingezet word (en de Gigabit poort) deze snelheid van verkeer nooit kunnen genereren. Maar tijdens een scrub is het wel een ding. Ik ga eens nadenken hoe ik dat oplos, een script wat om het uur eventjes 1GB DD'd naar de pool is ook wat lomp.

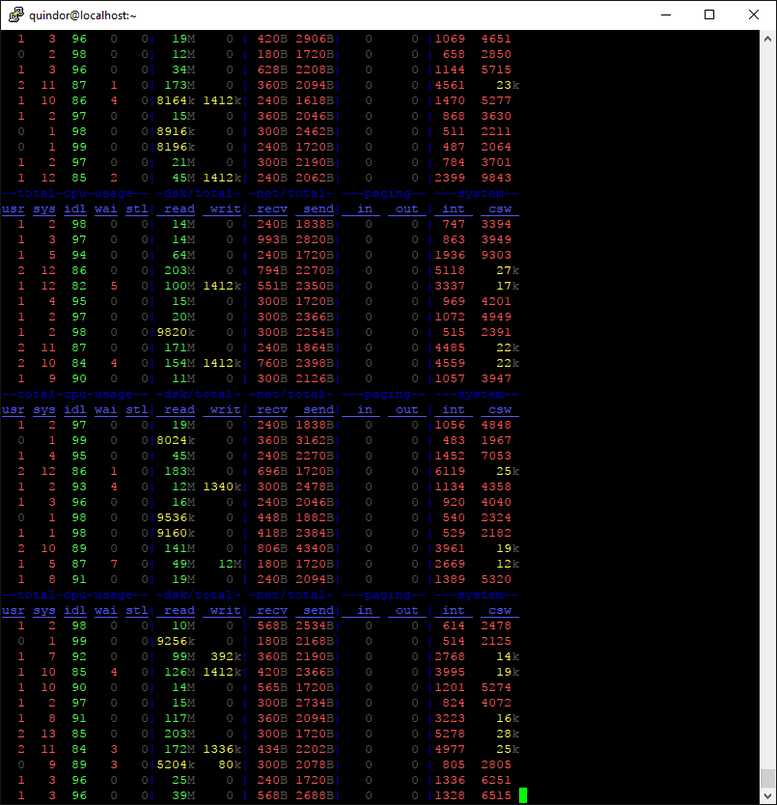

Mocht je het nog niet kennen:

Geeft ook mooie stats van de doorvoersnelheden en iops. Heb je het daarmee al vergeleken?

code:

1

| zpool iostat backupstorage 1 |

Geeft ook mooie stats van de doorvoersnelheden en iops. Heb je het daarmee al vergeleken?

Sinds de 2 dagen regel reageer ik hier niet meer

CurlyMo schreef op donderdag 21 september 2017 @ 15:07:

Mocht je het nog niet kennen:

code:

Geeft ook mooie stats van de doorvoersnelheden en iops. Heb je het daarmee al vergeleken?

Jazeker, ben een stats junkie, heb deze temp server waar het nu aan hangt nog net niet in een grafana panel gehangen.

Ik ben wel benieuwd wat zpool iostat zegt wanneer de scrub weer trager wordt.

Sinds de 2 dagen regel reageer ik hier niet meer

Hmm, interesting! Wat ik fysiek merk als ik bij de box sta is dat er een hoop "random seeks" gebeuren in plaats van sequentieel verkeer wat er normaal gebeurt bij de scrub.CurlyMo schreef op donderdag 21 september 2017 @ 15:33:

Ik ben wel benieuwd wat zpool iostat zegt wanneer de scrub weer trager wordt.

I'll let you know (ik verwacht dat over enkele uren de scrub wel weer vervalt in het tragere patroon).

Aangezien deze post niet heel veel nuttige info bevat, enkele foto's dan maar van de test opstelling en van de eerdere waar 5x2TB in zit van 7 jaar oud en puur voor storj gebruikt word!

Ik zie dat ze op eBay "Flash Accelerator"'s verkopen voor SSD's, geschikt voor 400GB SSD drives.

Flash Accelerator F40 400GB Solid State

http://www.ebay.com/itm/122712474764?rmvSB=true

Enig idee wat ik me daarbij moet voorstellen?

Flash Accelerator F40 400GB Solid State

http://www.ebay.com/itm/122712474764?rmvSB=true

Enig idee wat ik me daarbij moet voorstellen?

Google doet wonderen. Zo te zien is het een (Adaptec controller/LSI) SAS RAID/HBA controller met daarop 4x2.5" SATA SSD. De specs zijn op zich geinig, power usage is wel echt INSANE.chronoz schreef op donderdag 21 september 2017 @ 19:16:

Ik zie dat ze op eBay "Flash Accelerator"'s verkopen voor SSD's, geschikt voor 400GB SSD drives.

Flash Accelerator F40 400GB Solid State

http://www.ebay.com/itm/122712474764?rmvSB=true

Enig idee wat ik me daarbij moet voorstellen?

Ik verwacht dat een moderne SSD zoals een 860EVO wel al sneller is dan dit ding. Queue Depth 1 durf ik niet te zegen echter en er lijken caps op de kaart te zitten, maar je hebt uiteraard geen idee hoe versleten de cellen al zijn.

Als je het type nummer in Google intikt dan is de datasheet het eerste resultaat.chronoz schreef op donderdag 21 september 2017 @ 19:16:

Ik zie dat ze op eBay "Flash Accelerator"'s verkopen voor SSD's, geschikt voor 400GB SSD drives.

Oracle’s Sun Flash Accelerator F40 PCIe Card accelerates applications and server performance by reducing storage latencies and increasing I/O throughput for greater productivity and business response. The low latency, high throughput, and IOPS performance of the Sun Flash Accelerator F40 PCIe Card help servers and their applications run faster and more efficient while reducing space and power.

@Quindor was me net voorKEY FEATURES

[...]

- Up to 149K IOPS (8K) performance

Sinds de 2 dagen regel reageer ik hier niet meer

Hij heeft de prijs al verhoogd van 65 naar 80. http://www.ebay.com/itm/122712474764 Dat houdt ook in dat de shipping naar Nederland omhoog gaat.

Ik zat even te denken.

Zou ik hier ooit iets aan hebben?

> Niet echt.

Dus ik heb er 1tje besteld.

Hij komt over 2 weken aan.

Ik zat even te denken.

Zou ik hier ooit iets aan hebben?

> Niet echt.

Dus ik heb er 1tje besteld.

Hij komt over 2 weken aan.

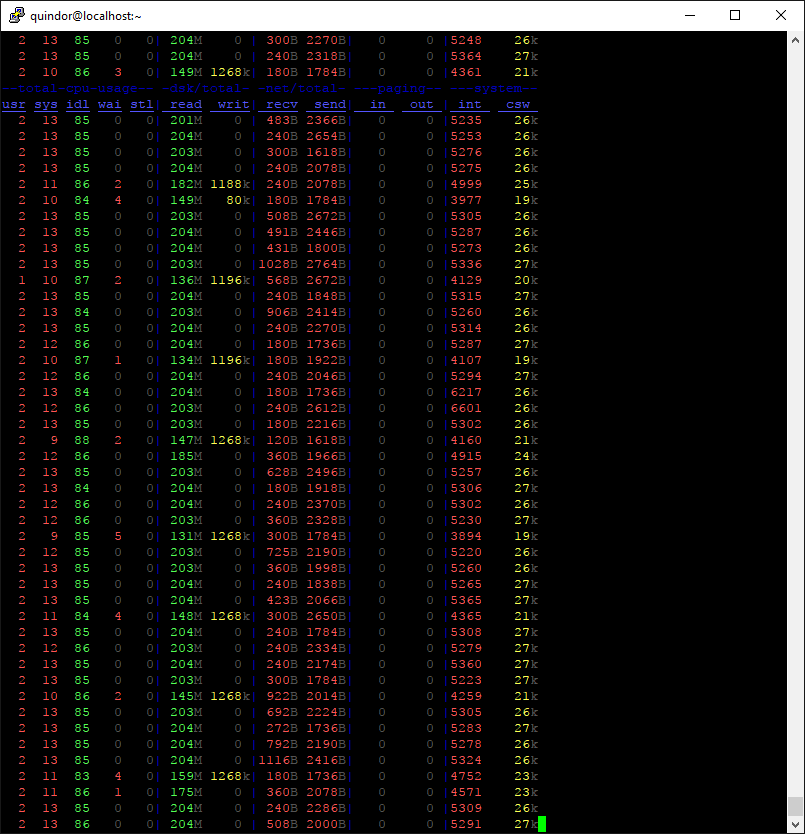

Ik zag dat het probleem net weer begon, dus weer wat screenshots!CurlyMo schreef op donderdag 21 september 2017 @ 15:33:

Ik ben wel benieuwd wat zpool iostat zegt wanneer de scrub weer trager wordt.

Dit blijft nu zo een beetje doorgaan, totdat ik bijvoorbeeld 1GB met DD naar het volume schrijf, daarna is het weer uren goed.

Zoals ik al aangaf, dit zie ik voor het eerst na dagen de scrub te draaien, dus met "gebruik" lijkt het niet voor te komen.

NOFI, maar dat ding is dus JMicron based... wat had je anders verwacht ?!Quindor schreef op vrijdag 22 september 2017 @ 00:56:

Ik zag dat het probleem net weer begon, dus weer wat screenshots!

Dit blijft nu zo een beetje doorgaan, totdat ik bijvoorbeeld 1GB met DD naar het volume schrijf, daarna is het weer uren goed.

[afbeelding]

Zoals ik al aangaf, dit zie ik voor het eerst na dagen de scrub te draaien, dus met "gebruik" lijkt het niet voor te komen.

Als ik één merk NIET vertrouw voor mijn storage is het JMicron wel

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Nou ja, een goed werkend product? En ansich werkt het nog niet eens zo slecht, alleen dus het issue dat de snelheid soms laag word tijdens een rebuild maar dat het weer omhoog gaat zodra je wat naar het volume schrijft. Maar dat hoeft nog niet eens de jMicron controller te zijn, het kan bijvoorbeeld ook een USB controller/driver issue zijn?nero355 schreef op vrijdag 22 september 2017 @ 02:13:

[...]

NOFI, maar dat ding is dus JMicron based... wat had je anders verwacht ?!

Als ik één merk NIET vertrouw voor mijn storage is het JMicron wel

Wat is jou ervaring ermee?

[ Voor 10% gewijzigd door Quindor op 22-09-2017 02:51 ]

Followup van de falende disk.

Na een replace door een nieuwe disk heb ik de schijf dit commando gegeven:

En voila, een correcte selftest en current pending sectors naar 0

Ik ga hem nog wat testen met random schrijven en zero'en om te kijken of hij volhoud, dan kan hij in de "mocht ik nog eens een schijf nodig hebben la".

Na een replace door een nieuwe disk heb ik de schijf dit commando gegeven:

code:

1

| dd if=/dev/zero bs=4k of=/dev/ada2 |

En voila, een correcte selftest en current pending sectors naar 0

Ik ga hem nog wat testen met random schrijven en zero'en om te kijken of hij volhoud, dan kan hij in de "mocht ik nog eens een schijf nodig hebben la".

code:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

| SMART Attributes Data Structure revision number: 16 Vendor Specific SMART Attributes with Thresholds: ID# ATTRIBUTE_NAME FLAG VALUE WORST THRESH TYPE UPDATED WHEN_FAILED RAW_VALUE 1 Raw_Read_Error_Rate 0x002f 200 200 051 Pre-fail Always - 1721 3 Spin_Up_Time 0x0027 174 170 021 Pre-fail Always - 4291 4 Start_Stop_Count 0x0032 100 100 000 Old_age Always - 96 5 Reallocated_Sector_Ct 0x0033 200 200 140 Pre-fail Always - 0 7 Seek_Error_Rate 0x002e 200 200 000 Old_age Always - 0 9 Power_On_Hours 0x0032 071 071 000 Old_age Always - 21739 10 Spin_Retry_Count 0x0032 100 253 000 Old_age Always - 0 11 Calibration_Retry_Count 0x0032 100 253 000 Old_age Always - 0 12 Power_Cycle_Count 0x0032 100 100 000 Old_age Always - 47 192 Power-Off_Retract_Count 0x0032 200 200 000 Old_age Always - 27 193 Load_Cycle_Count 0x0032 198 198 000 Old_age Always - 6452 194 Temperature_Celsius 0x0022 117 107 000 Old_age Always - 30 196 Reallocated_Event_Count 0x0032 200 200 000 Old_age Always - 0 197 Current_Pending_Sector 0x0032 200 200 000 Old_age Always - 0 198 Offline_Uncorrectable 0x0030 200 200 000 Old_age Offline - 11 199 UDMA_CRC_Error_Count 0x0032 200 200 000 Old_age Always - 0 200 Multi_Zone_Error_Rate 0x0008 200 200 000 Old_age Offline - 3 SMART Error Log Version: 1 No Errors Logged SMART Self-test log structure revision number 1 Num Test_Description Status Remaining LifeTime(hours) LBA_of_first_error # 1 Short offline Completed without error 00% 21739 - # 2 Extended offline Completed: read failure 10% 21720 3907024536 # 3 Short offline Completed: read failure 10% 21710 3907024536 # 4 Short offline Completed: read failure 10% 21694 3907024536 # 5 Short offline Completed: read failure 10% 21683 3907024424 # 6 Short offline Completed: read failure 10% 21659 3907023032 # 7 Extended offline Completed: read failure 10% 21648 3907024424 # 8 Short offline Completed: read failure 10% 21635 3907024424 # 9 Short offline Completed: read failure 10% 21618 3907024424 #10 Short offline Completed: read failure 10% 21617 3907024424 #11 Short offline Completed without error 00% 21587 - #12 Short offline Completed without error 00% 21563 - #13 Short offline Completed without error 00% 21539 - #14 Short offline Completed without error 00% 21515 - #15 Short offline Completed without error 00% 21491 - #16 Short offline Completed without error 00% 21467 - #17 Short offline Completed without error 00% 21443 - #18 Short offline Completed without error 00% 21419 - #19 Short offline Completed without error 00% 21395 - #20 Short offline Completed without error 00% 21371 - #21 Short offline Completed without error 00% 21347 - |

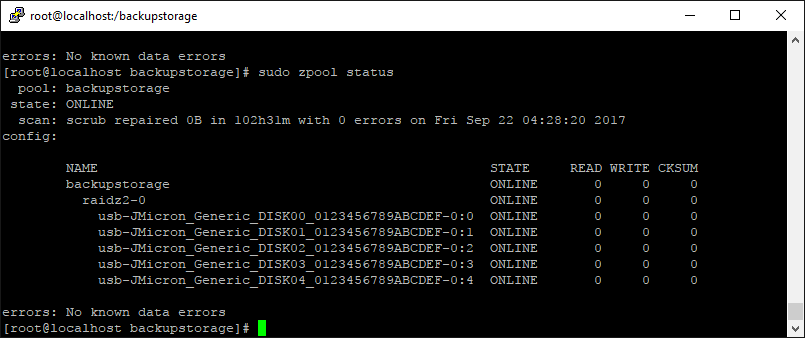

Scrub is done, all is well!

102 uur is natuurlijk aardig wat (4,25 dag) maar is naar mijn mening nog wel te overleven. Het is ook een RAIDz2, dus als er een tweede disk klapt tijdens de rebuild (kans van ~10% of ~50% afhankelijk van hoe je het berekend) dan is de kans dat de tweede parity in die tijd eruit klapt erg klein.

Verder zijn alle disks nu meerdere malen, in meerdere vormen gechecked. Eerst met HDAT2 een full verify gegeven rechtstreeks aan een mobo SATA poort (alle disks afzonderlijk) en daarna in het USB3 cabinet met random data vol geschreven via DD en daarna een scrub via ZFS. Er zijn iig geen bad sectors. (SMART re-allocated sector count is 0 op alle disks)

(SMART re-allocated sector count is 0 op alle disks)

Het enige issue wat er nu dus echt overblijft is dat tijdens de scrub de performance soms instort, en deze weer normaal word na enkele writes. Ik verwacht dan ook dat dat in de praktijk, als de disks daadwerkelijk in gebruik zijn, een non-issue gaat zijn. Ik heb echter nog niet kunnen achterhalen waardoor dit optreed. Het kan aan het cabinet/jMicron controller liggen, maar bijvoorbeeld ook aan de (haswell) USB3 controller. Ik ben benieuwd hoe dit straks gaat werken met de Apollo Lake controller aangezien die een paar generaties nieuwer is.

Uiteraard moet ik straks als de "server" binnen is enkele tests nog eens doen, maar ik verwacht daar eigenlijk geen issues mee.

Voorlopige conclusie

Voor mij werkt het op deze manier adequaat genoeg om in te zetten als backup storage.

102 uur is natuurlijk aardig wat (4,25 dag) maar is naar mijn mening nog wel te overleven. Het is ook een RAIDz2, dus als er een tweede disk klapt tijdens de rebuild (kans van ~10% of ~50% afhankelijk van hoe je het berekend) dan is de kans dat de tweede parity in die tijd eruit klapt erg klein.

Verder zijn alle disks nu meerdere malen, in meerdere vormen gechecked. Eerst met HDAT2 een full verify gegeven rechtstreeks aan een mobo SATA poort (alle disks afzonderlijk) en daarna in het USB3 cabinet met random data vol geschreven via DD en daarna een scrub via ZFS. Er zijn iig geen bad sectors.

Het enige issue wat er nu dus echt overblijft is dat tijdens de scrub de performance soms instort, en deze weer normaal word na enkele writes. Ik verwacht dan ook dat dat in de praktijk, als de disks daadwerkelijk in gebruik zijn, een non-issue gaat zijn. Ik heb echter nog niet kunnen achterhalen waardoor dit optreed. Het kan aan het cabinet/jMicron controller liggen, maar bijvoorbeeld ook aan de (haswell) USB3 controller. Ik ben benieuwd hoe dit straks gaat werken met de Apollo Lake controller aangezien die een paar generaties nieuwer is.

Uiteraard moet ik straks als de "server" binnen is enkele tests nog eens doen, maar ik verwacht daar eigenlijk geen issues mee.

Voorlopige conclusie

Voor mij werkt het op deze manier adequaat genoeg om in te zetten als backup storage.

- Performance is prima met ~200MB/sec read of write. Dat is 2x zoveel als de Gigabit poort überhaupt aan kan en vervolgens komt de machine remote ergens te staan dus boeit het sowieso al niet zoveel meer

- Stabiliteit is na 10 dagen achter elkaar continu stress testen ook wel bewezen. In al die tijd, geen crashes, geen reboots, geen disconnects en geen enkel gemist bitje. (Dat was aan mijn AMD Ryzen Windows 10 systeem wel anders, daar hield hij het geen 2 uur vol!)

- Een rebuild van een vol volume duurt ongeveer 100 uur, kan ik ook prima mee leven

- Al met al is de "server" met dit cabinet eraan een zeer goedkope oplossing om 5 disks te draaien. Machine + cabinet is ~300 euro en hiermee krijg je 5 drivebays tot je beschikking voor als je capaciteit nodig hebt en niet perse performance!

Goed om te horen dat je chassis nu goed lijkt te werken.Quindor schreef op zaterdag 23 september 2017 @ 17:24:

Scrub is done, all is well!

[afbeelding]

102 uur is natuurlijk aardig wat (4,25 dag) maar is naar mijn mening nog wel te overleven. Het is ook een RAIDz2, dus als er een tweede disk klapt tijdens de rebuild (kans van ~10% of ~50% afhankelijk van hoe je het berekend) dan is de kans dat de tweede parity in die tijd eruit klapt erg klein.

Verder zijn alle disks nu meerdere malen, in meerdere vormen gechecked. Eerst met HDAT2 een full verify gegeven rechtstreeks aan een mobo SATA poort (alle disks afzonderlijk) en daarna in het USB3 cabinet met random data vol geschreven via DD en daarna een scrub via ZFS. Er zijn iig geen bad sectors.(SMART re-allocated sector count is 0 op alle disks)

Het enige issue wat er nu dus echt overblijft is dat tijdens de scrub de performance soms instort, en deze weer normaal word na enkele writes. Ik verwacht dan ook dat dat in de praktijk, als de disks daadwerkelijk in gebruik zijn, een non-issue gaat zijn. Ik heb echter nog niet kunnen achterhalen waardoor dit optreed. Het kan aan het cabinet/jMicron controller liggen, maar bijvoorbeeld ook aan de (haswell) USB3 controller. Ik ben benieuwd hoe dit straks gaat werken met de Apollo Lake controller aangezien die een paar generaties nieuwer is.

Uiteraard moet ik straks als de "server" binnen is enkele tests nog eens doen, maar ik verwacht daar eigenlijk geen issues mee.

Voorlopige conclusie

Voor mij werkt het op deze manier adequaat genoeg om in te zetten als backup storage.

- Performance is prima met ~200MB/sec read of write. Dat is 2x zoveel als de Gigabit poort überhaupt aan kan en vervolgens komt de machine remote ergens te staan dus boeit het sowieso al niet zoveel meer

- Stabiliteit is na 10 dagen achter elkaar continu stress testen ook wel bewezen. In al die tijd, geen crashes, geen reboots, geen disconnects en geen enkel gemist bitje. (Dat was aan mijn AMD Ryzen Windows 10 systeem wel anders, daar hield hij het geen 2 uur vol!)

- Een rebuild van een vol volume duurt ongeveer 100 uur, kan ik ook prima mee leven

- Al met al is de "server" met dit cabinet eraan een zeer goedkope oplossing om 5 disks te draaien. Machine + cabinet is ~300 euro en hiermee krijg je 5 drivebays tot je beschikking voor als je capaciteit nodig hebt en niet perse performance

Ik heb je verhaal een beetje gevolgd en ik ben blij voor je dat alles nu goed gaat.

Toch zou ik zelf heel erg voorzichtig zijn met zo’n oplossing.

Persoonlijk zou ik mensen afraden om voor jouw oplossing te kiezen.

Het klinkt mij te fragiel in de oren.

Juist als je de backup nodig hebt zie ik het mis gaan. Dan krijg je langdurig een hoge belasting op alle componenten.

ZFS gaat je niet beschermen als de hardware (controller) brak is.

Ruim vier dagen voor een scrub cq. Rebuild is zeer fors, maar om hoeveel data gaat het?

Als dat met 50% gebruik is dan kunnen die vier dagen nog verdubbelen naarmate de array verder vol loopt.

Dat vind ik echt spannend worden.

Hangt er vanaf wat je met de backup doet. Stel je hebt je backup nodig omdat je systeem is gestolen of afgebrand. @Quindor kan met zijn RAIDZ2 twee harde schijven uit de backup halen en die in de nieuwe server doen. Die twee schijven data laten over kopiëren naar een degraded RAIDZ2. Als dat klaar is de backup schijven weer uit je server halen en twee nieuwe schijven toevoegen om de degraded RAIDZ2 weer normaal online te brengen. Zo ben je nergens afhankelijk van je jmicron controller. Alles alles weer draait, je backup weer in ere herstellen.Q schreef op zondag 24 september 2017 @ 15:19:

[...]

Juist als je de backup nodig hebt zie ik het mis gaan. Dan krijg je langdurig een hoge belasting op alle componenten.

Sinds de 2 dagen regel reageer ik hier niet meer

@Q Ik snap je argumenten wel, maar dat ligt er net aan hoeveel je er van verwacht denk ik.

Een backup is voor mij een geversioneerd secundair kopie van mijn primare data. Dus naar mijn mening is de kans klein dat EN de primaire data verloren gaat EN het backup kopie, op hetzelfde moment. Dus daarom hoeft de backup storage geen 99,999999% oplossing te zijn, naar mijn mening.

Qua data volume voor de scrub, ik heb eerst met 200MB/sec met random data de gehele RAIDz2 gevuld (~28,5TB netto, 5x10TB) en daarna heb ik over die data een scrub gedraaid om alles weer terug te lezen. Worst case scenario is dus dat alles tot de nok toe vol zit en dat kost 4,5 dag. Totale duur van de stress test was daarmee ongeveer 7 a 8 dagen.

Dat was echter terwijl ik de "het lezen gaat na enkele uren trager" issue initieel nog niet door had. Bij normaal gebruik (er gebeurt meer op de disk) komt dat niet voor zoals de simulaties met enkele writes aantoonde. Maar goed, uitgaan van 4 dagen worst case lijkt me een veilig getal.

Ik snap dat ZFS uiteindelijk afhankelijk is van de controller, vandaar deze testen voordat ik het "in productie" neem, en tot nu toe, is daarbij nog geen enkel bitje omgevallen. Toch snap ik je argwaan wel, want anders was ik deze testen überhaupt niet aan het doen.

Ik zou het dan ook zeker niet inzetten voor (hoofd) productie doel einden, maar het USB3 chassis is prima geschikt voor als je oude HDD's online wilt houden maar geen ruimte meer heb in je server, of voor mijn toepassing, als backup storage waar performance zeker niet 1 van je eisen is. De gehele bandbreedte is minder dan wat 1 van de 5 disks kan leveren sequentieel. Maar, dat gezegd hebbende is 200MB/sec ook weer niet flauw naar mijn mening, het blijft 2x zo snel als het gemiddelde gigabit touwtje.

Maar, dat gezegd hebbende is 200MB/sec ook weer niet flauw naar mijn mening, het blijft 2x zo snel als het gemiddelde gigabit touwtje.

@CurlyMo Good point! In het scenario wat je beschrijft ben je wel tijdelijk vatbaar voor dataloss omdat je de RAIDz2 deels afbreekt. Maar, als de nood echt hoog is en de controller (ondanks alle testen nu) toch ineens een issue blijkt op te leveren tijdens recovery, kan ik de schijven wel altijd gaan halen en in een andere machine met een Intel of LSI controller weer online brengen.

Een backup is voor mij een geversioneerd secundair kopie van mijn primare data. Dus naar mijn mening is de kans klein dat EN de primaire data verloren gaat EN het backup kopie, op hetzelfde moment. Dus daarom hoeft de backup storage geen 99,999999% oplossing te zijn, naar mijn mening.

Qua data volume voor de scrub, ik heb eerst met 200MB/sec met random data de gehele RAIDz2 gevuld (~28,5TB netto, 5x10TB) en daarna heb ik over die data een scrub gedraaid om alles weer terug te lezen. Worst case scenario is dus dat alles tot de nok toe vol zit en dat kost 4,5 dag. Totale duur van de stress test was daarmee ongeveer 7 a 8 dagen.

Dat was echter terwijl ik de "het lezen gaat na enkele uren trager" issue initieel nog niet door had. Bij normaal gebruik (er gebeurt meer op de disk) komt dat niet voor zoals de simulaties met enkele writes aantoonde. Maar goed, uitgaan van 4 dagen worst case lijkt me een veilig getal.

Ik snap dat ZFS uiteindelijk afhankelijk is van de controller, vandaar deze testen voordat ik het "in productie" neem, en tot nu toe, is daarbij nog geen enkel bitje omgevallen. Toch snap ik je argwaan wel, want anders was ik deze testen überhaupt niet aan het doen.

Ik zou het dan ook zeker niet inzetten voor (hoofd) productie doel einden, maar het USB3 chassis is prima geschikt voor als je oude HDD's online wilt houden maar geen ruimte meer heb in je server, of voor mijn toepassing, als backup storage waar performance zeker niet 1 van je eisen is. De gehele bandbreedte is minder dan wat 1 van de 5 disks kan leveren sequentieel.

@CurlyMo Good point! In het scenario wat je beschrijft ben je wel tijdelijk vatbaar voor dataloss omdat je de RAIDz2 deels afbreekt. Maar, als de nood echt hoog is en de controller (ondanks alle testen nu) toch ineens een issue blijkt op te leveren tijdens recovery, kan ik de schijven wel altijd gaan halen en in een andere machine met een Intel of LSI controller weer online brengen.

Klopt, maar het verschil is dat je alleen maar leest van je degraded array. Dat gaat meestal wel goed. En opnieuw de kans dat .... enzQuindor schreef op zondag 24 september 2017 @ 17:10:

@CurlyMo Good point! In het scenario wat je beschrijft ben je wel tijdelijk vatbaar voor dataloss omdat je de RAIDz2 deels afbreekt. Maar, als de nood echt hoog is en de controller (ondanks alle testen nu) toch ineens een issue blijkt op te leveren tijdens recovery, kan ik de schijven wel altijd gaan halen en in een andere machine met een Intel of LSI controller weer online brengen.

[ Voor 6% gewijzigd door CurlyMo op 24-09-2017 17:24 ]

Sinds de 2 dagen regel reageer ik hier niet meer

Wat discussie vragen.

5 disk RAIDz2 Space penalty

RAIDz2 met 5x10TB is niet ideaal vanwege de 5 disks, hierdoor heb ik als het goed is enige space penalty in combinatie met het gebruik van ashift=12. Toen ik de disk vol schreef en "df -h" 0 bytes rapporteerde vertelde ZFS mij dat er nog 1,6TB beschikbaar was, dus ik verwacht in orde van die grote ongeveer.

Ik lees discussie over het gebruik van "zfs set recordsize=1M ". Zoals ik het begrijp kan dit deels het probleem oplossen omdat je dan niet meer met de 128K deel factor zit maar kan het bij kleine files nadelig zijn? Aangezien het backup storage is, zal de gemiddelde file/chunk 50MB of groter zijn, dus dat lijkt me een non-issue. Is het dan verstandig om deze setting aan te passen?

LZ4 compressie

Wederom dezelfde vraag. Ik ben gewend om op de meeste ZFS installaties LZ4 overal klakkeloos aan te zetten vanwege de besparing die het eventueel kan opleveren. Echter is CPU usage daarvan nooit een issue en ook is de data die op die pools geschreven word een mix van verschillende zaken.

Dit word echter backup storage, 99% van de data is compressed en/of encrypted. Heeft LZ4 compressie dan nog een voordeel voor bijvoorbeeld metadata of gaat het niets teweeg brengen en alleen maar CPU cycles van de "zielige" Apollo Lake CPU opeten, wat verwacht jullie?

5 disk RAIDz2 Space penalty

RAIDz2 met 5x10TB is niet ideaal vanwege de 5 disks, hierdoor heb ik als het goed is enige space penalty in combinatie met het gebruik van ashift=12. Toen ik de disk vol schreef en "df -h" 0 bytes rapporteerde vertelde ZFS mij dat er nog 1,6TB beschikbaar was, dus ik verwacht in orde van die grote ongeveer.

Ik lees discussie over het gebruik van "zfs set recordsize=1M ". Zoals ik het begrijp kan dit deels het probleem oplossen omdat je dan niet meer met de 128K deel factor zit maar kan het bij kleine files nadelig zijn? Aangezien het backup storage is, zal de gemiddelde file/chunk 50MB of groter zijn, dus dat lijkt me een non-issue. Is het dan verstandig om deze setting aan te passen?

LZ4 compressie

Wederom dezelfde vraag. Ik ben gewend om op de meeste ZFS installaties LZ4 overal klakkeloos aan te zetten vanwege de besparing die het eventueel kan opleveren. Echter is CPU usage daarvan nooit een issue en ook is de data die op die pools geschreven word een mix van verschillende zaken.

Dit word echter backup storage, 99% van de data is compressed en/of encrypted. Heeft LZ4 compressie dan nog een voordeel voor bijvoorbeeld metadata of gaat het niets teweeg brengen en alleen maar CPU cycles van de "zielige" Apollo Lake CPU opeten, wat verwacht jullie?

Dan nog niet druk om maken want het is backup storage. Ik had zelf ook dedup aanstaan, want opnieuw, het is maar backup storage. Dus performance is geen issue.Quindor schreef op zondag 24 september 2017 @ 17:58:

Heeft LZ4 compressie dan nog een voordeel voor bijvoorbeeld metadata of gaat het niets teweeg brengen en alleen maar CPU cycles van de "zielige" Apollo Lake CPU opeten, wat verwacht jullie?

Sinds de 2 dagen regel reageer ik hier niet meer

LZ4 compressie stopt met comprimeren als de ratio onder een bepaald percentage ligt bij de eerste zoveel procent van de data, dus is niet erg om aan te zetten.

Even niets...

Daar ben ik me van bewust, maar de penalty is dus nog steeds verwaarloosbaar als je van te voren weet dat eigenlijk 99% van je data sowieso on-comprimeerbaar gaat zijn? Zijn er dan nog wel voordelen is eigenlijk mijn vraag.FireDrunk schreef op zondag 24 september 2017 @ 18:12:

LZ4 compressie stopt met comprimeren als de ratio onder een bepaald percentage ligt bij de eerste zoveel procent van de data, dus is niet erg om aan te zetten.

Of is het formaat om alles gecomprimeerd op te slaan, inclusief metadata sowieso efficiënter?

Metadata is nooit compressed dacht ik.

Maar performance loss is ook verwaarloosbaar.

Maar performance loss is ook verwaarloosbaar.

Even niets...

Mijn mening over JMicron :Quindor schreef op vrijdag 22 september 2017 @ 02:48:

Nou ja, een goed werkend product? En ansich werkt het nog niet eens zo slecht, alleen dus het issue dat de snelheid soms laag word tijdens een rebuild maar dat het weer omhoog gaat zodra je wat naar het volume schrijft. Maar dat hoeft nog niet eens de jMicron controller te zijn, het kan bijvoorbeeld ook een USB controller/driver issue zijn?

Wat is jou ervaring ermee?

- SSD controller ?!

Ver vandaan blijven! Waarom ? We kennen allemaal wel de verhalen ondertussen denk ik.

- Controller in een Externe USB behuizing ?

Ver vandaan blijven! Waarom ? Voor een fabrikant gewerkt die heel wat ellende met die krengen had in verschillende USB produkten!

- Als losse SATA controller op een PCI/PCIe kaart of Onboard op een moederbord ?

Niet gebruiken en uitschakelen dat kreng!

Ja, maar wat moet ik dan wel gebruiken ?!

Silicon Image 3112/3114 of de PCIe 3132/3134 chipsets (waren vroeger veel op moederborden te vinden en op goedkope SATA add-on kaarten) of natuurlijk gewoon de LSI 2008/2308/3008/enz. controllers die ik onlangs voor € 57 op eBay heb gescoord, dankzij een tip op het overclock.com forum

Verder wil Marvell ook nog weleens een goede keuze zijn en als het echt niet anders kan en je moederbord heeft hem toch al onboard... die AsMedia dingen, maar kijk goed naar wat je ermee gaat doen!

|| Stem op mooiere Topic Search linkjes! :) " || Pi-Hole : Geen advertenties meer voor je hele netwerk! >:) ||

Als ik twee stripe disks met een parity disk heb, en de parity gaat kapot, dan kan deze automatisch gerebuild/resilvered worden.

Maar als ik twee stripe disks heb zonder parity, hoe kan ik dan doen alsof er een parity was maar dat die stuk is, zodat er een parity disk herbouwd wordt op een nieuwe disk?

De logica proeft alsof dit zou moeten kunnen.

Maar als ik twee stripe disks heb zonder parity, hoe kan ik dan doen alsof er een parity was maar dat die stuk is, zodat er een parity disk herbouwd wordt op een nieuwe disk?

De logica proeft alsof dit zou moeten kunnen.

Sando schreef op zaterdag 16 september 2017 @ 18:25:

Ik heb een ZOL stripe (raid0) met 2 disks gemaakt [...]

Kan ik een 3e disk toevoegen als parity (raidz1)? [...]

CurlyMo schreef op zaterdag 16 september 2017 @ 19:46:

Kan nog altijd niet.

[ Voor 20% gewijzigd door Sando op 24-09-2017 23:47 ]

🇪🇺 Buy from EU (GoT)

De logica loopt echter al snel vast als je gaat kijken naar hoe een RAIDZ is opgebouwd. Zo is er niet een 'parity-disk', de parity-data wordt verspreid over de disks.

Precies wat dcm360 zegt, ZFS (en bijna alle andere RAID engines) verspreiden de parity over de disks, waardoor je achteraf niet alsnog naar RAIDZ kan.

Sowieso kan niet zomaar het aantal VDEV's wijzigen in een Pool. 2 disks in stripe, zijn 2 VDEV's. Je kan deze dus ook transformeren naar 2 RAID1 VDEV door aan beide een disk te koppelen, maar je kan nooit van die 2 stripes 1 mirror maken. Dit omdat ZFS' interne huishouding al ingedeeld is in verschillende VDEV's.

Er lopen al jaren initiatieven om dit te bouwen, maar is nog nooit echt van de grond gekomen volgens mij.

Sowieso kan niet zomaar het aantal VDEV's wijzigen in een Pool. 2 disks in stripe, zijn 2 VDEV's. Je kan deze dus ook transformeren naar 2 RAID1 VDEV door aan beide een disk te koppelen, maar je kan nooit van die 2 stripes 1 mirror maken. Dit omdat ZFS' interne huishouding al ingedeeld is in verschillende VDEV's.

Er lopen al jaren initiatieven om dit te bouwen, maar is nog nooit echt van de grond gekomen volgens mij.

Even niets...

@dcm360 @FireDrunk Ok, duidelijk: Het zit een stuk complexer in elkaar dan ik denk dacht.

Dus als ik van 2x 1TB raid0 naar 3x 1TB raidz1 wil, dan is de enige manier om de data tijdelijk op een externe schijf te zetten?

Is dan de snelste manier om snapshops van de verschillende volumes op een externe schijf te zetten ipv gewoon een rsync? Ik durf het bijna niet te zeggen, maar ik heb nog nooit met snapshots gewerkt. Kan ik één snapshot van de pool kan maken, of moet ik snapshots van alle volumes apart maken? Bevat de snapshot alleen data, of ook de configuratie van het volume (opties, compression, etc)?

Dus als ik van 2x 1TB raid0 naar 3x 1TB raidz1 wil, dan is de enige manier om de data tijdelijk op een externe schijf te zetten?

Is dan de snelste manier om snapshops van de verschillende volumes op een externe schijf te zetten ipv gewoon een rsync? Ik durf het bijna niet te zeggen, maar ik heb nog nooit met snapshots gewerkt. Kan ik één snapshot van de pool kan maken, of moet ik snapshots van alle volumes apart maken? Bevat de snapshot alleen data, of ook de configuratie van het volume (opties, compression, etc)?

[ Voor 7% gewijzigd door Sando op 25-09-2017 13:52 ]

🇪🇺 Buy from EU (GoT)

Ok veel vragen:

1) Ja, dat is de snelste manier, je maakt een pool op een 2e (storage) systeem, en je maakt een snapshot van je hele originele pool, en die zet je over dmv ZFS Send & Receive

2) dmv zfs snapshot -r <poolnaam>@<snapshotnaam> maak je een snapshot van je hele pool inc sub-filesystems

3) Een snapshot bevat zelf geen data, maar refereert naar data (het werkt dus anders dan veel andere snapshot mechanismen).

De opties die je hebt op de ontvangende pool worden bij het overzetten van het snapshot dmv zfs receive gehonoreerd.

Met andere woorden, als je op je bron pool of filesystem compressie uit hebt, maar op je target pool/filesystem aan, gaat de zfs send de data ongecomprimeerd inlezen, en de zfs receive aan de andere kant de data gecomprimeerd wegschrijven.

1) Ja, dat is de snelste manier, je maakt een pool op een 2e (storage) systeem, en je maakt een snapshot van je hele originele pool, en die zet je over dmv ZFS Send & Receive

2) dmv zfs snapshot -r <poolnaam>@<snapshotnaam> maak je een snapshot van je hele pool inc sub-filesystems

3) Een snapshot bevat zelf geen data, maar refereert naar data (het werkt dus anders dan veel andere snapshot mechanismen).

De opties die je hebt op de ontvangende pool worden bij het overzetten van het snapshot dmv zfs receive gehonoreerd.

Met andere woorden, als je op je bron pool of filesystem compressie uit hebt, maar op je target pool/filesystem aan, gaat de zfs send de data ongecomprimeerd inlezen, en de zfs receive aan de andere kant de data gecomprimeerd wegschrijven.

Even niets...

Ah, dus als ik de snapshot op een niet-ZFS externe schijf wil opslaan moet ik het eerst senden naar een bestand:FireDrunk schreef op maandag 25 september 2017 @ 14:00:

je maakt een pool op een 2e (storage) systeem, en je maakt een snapshot van je hele originele pool, en die zet je over dmv ZFS Send & Receive

- zfs snapshot -r <poolnaam>@<snapshotnaam>

- zfs send <poolnaam>@<snapshotnaam> | gzip --fast > /mnt/external/<poolnaam>.zfs.gz

Kan ik dus niet eerst de gelijknamige volumes met configuratie (e.g. zfs compression, zfs encryption) maken. Hoe kan ik dan bijvoorbeeld compression op een volume aanzetten?The original file system to be received must not exist while it is being transferred.

Laatste stap:

- gzip -cd /mnt/external/<poolnaam>.zfs.gz | zfs recv <poolnaam>

🇪🇺 Buy from EU (GoT)

code:

1

| zfs send -R <poolnaam>@<snapshotnaam> |

Dat kan wel, mits je de juiste parameters meegeeft aan zfs send / recv. Dit betreft volgens mij de -F parameter.Kan ik dus niet eerst de gelijknamige volumes met configuratie (e.g. zfs compression, zfs encryption) maken.

code:

1

| Laatste stap: |

Wat is de reden dat je niet direct je zfs send naar je zfs recv piped?

Sinds de 2 dagen regel reageer ik hier niet meer

De reden voor dit alles is dat ik geen parity schijf aan mijn pool kan toevoegen. Dus target == source computer, target pool = source pool + een nieuwe schijf. De data moet tijdelijk op een externe schijf.CurlyMo schreef op woensdag 27 september 2017 @ 15:28:

[/code]

Wat is de reden dat je niet direct je zfs send naar je zfs recv piped?

🇪🇺 Buy from EU (GoT)

Oftwel, je doet alles binnen hetzelfde systeem?Sando schreef op woensdag 27 september 2017 @ 16:49:

[...]

De reden voor dit alles is dat ik geen parity schijf aan mijn pool kan toevoegen. Dus target == source computer, target pool = source pool + een nieuwe schijf. De data moet tijdelijk op een externe schijf.

Sinds de 2 dagen regel reageer ik hier niet meer

Correct!CurlyMo schreef op woensdag 27 september 2017 @ 17:01:

[...]

Oftwel, je doet alles binnen hetzelfde systeem?

🇪🇺 Buy from EU (GoT)

Dan zie ik nog steeds niet waarom je je send / recv niet kan pipen?

code:

1

| zfs send (lokale pool A)@snap | zfs recv (lokale pool B) |

Dit werkt gewoon prima.

Sinds de 2 dagen regel reageer ik hier niet meer

Ik kan toch niet receiven op de zelfde pool die ik juist wil destroyen om er een schijf aan toe te voegen?CurlyMo schreef op woensdag 27 september 2017 @ 17:47:

[...]

Dan zie ik nog steeds niet waarom je je send / recv niet kan pipen?

-edit- oh wacht ik denk dat we langs elkaar heen praten. Zie Sando in "Het grote ZFS topic" en de drie berichten daarboven.

[ Voor 20% gewijzigd door Sando op 27-09-2017 18:19 ]

🇪🇺 Buy from EU (GoT)

Dan is de vraag waarom je van die externe schijf niet met ZFS initialiseert?Sando schreef op woensdag 27 september 2017 @ 18:12:

[...]

Ik kan toch niet receiven op de zelfde pool die ik juist wil destroyen om er een schijf aan toe te voegen?

Sinds de 2 dagen regel reageer ik hier niet meer

Waarom wel? ZFS is erg onpraktisch als externe schijf. Bovendien gaat het hier om een éénmalige image, en een image file heeft 0 overhead. Het niet hoeven configureren van ZFS bespaart ook tijd. En in dit specifieke geval wellicht het belangrijkste: Hoewel de externe schijf de nodige vrije terabytes heeft, is deze niet leeg.CurlyMo schreef op woensdag 27 september 2017 @ 19:05:

[...]

Dan is de vraag waarom je van die externe schijf niet met ZFS initialiseert?

[ Voor 4% gewijzigd door Sando op 27-09-2017 19:23 ]

🇪🇺 Buy from EU (GoT)

Helder. Dan werkt wat je nu probeert inderdaad goed genoeg.Sando schreef op woensdag 27 september 2017 @ 19:21:

[...]

En in dit specifieke geval wellicht het belangrijkste: Hoewel de externe schijf de nodige vrije terabytes heeft, is deze niet leeg.

Sinds de 2 dagen regel reageer ik hier niet meer

@CurlyMo behalve dan dat ik nog niet weet hoe ik de volumes op de "nieuwe" pool kan configureren (bijvoorbeeld compressie aan) voordat ik een snapshot van de hele pool terugzet.

🇪🇺 Buy from EU (GoT)

Je kan niet de settings van een individueel filesystem op de target pool wijzigen als je een replication stream doet (een pool syncen inclusief filesystems).

Of begrijp ik je vraag niet goed?

Of begrijp ik je vraag niet goed?

Even niets...

Staan de settings dan in de stream? Of laat ik het anders vragen:FireDrunk schreef op donderdag 28 september 2017 @ 10:43:

Je kan niet de settings van een individueel filesystem op de target pool wijzigen als je een replication stream doet (een pool syncen inclusief filesystems).

Je hebt een pool, met verschillende volumes, en de volumes hebben verschillende settings. Je wilt de pool destroyen en opnieuw createn met een extra schijf erin. Je wilt de data behouden met de zelfde volumes en settings. Je hebt voldoende terabytes vrij op een externe niet-ZFS schijf om tijdelijk data te parkeren.

Hoe zou jij dit aanpakken?

🇪🇺 Buy from EU (GoT)

zfs snapshot -r pool@full

zfs send -R pool@full | gzip /mnt/usb-disk/backup.tar.gz

zpool destroy pool

zpool create pool {disks}

gunzip /mnt/usb-disk/backup.tar.gz | zfs receive pool@full

Of denk ik te simpel?

zfs send -R pool@full | gzip /mnt/usb-disk/backup.tar.gz

zpool destroy pool

zpool create pool {disks}

gunzip /mnt/usb-disk/backup.tar.gz | zfs receive pool@full

Of denk ik te simpel?

[ Voor 4% gewijzigd door FireDrunk op 28-09-2017 18:39 ]

Even niets...

In hoeverre schaalt ZFS met hardware? Aan de ene kant hoor ik mensen zeggen: "ZFS is very hardware-hungry." Aan de andere kant draaien mensen ZFS op hun Raspberry Pi.

Nu wil ik 3 schijven in ZFS gebruiken op een oude [URL="https://tweakers.net/pricewatch/282330/zotac-fusion-itx-wifi/specificaties/"]pricewatch: Zotac Fusion-ITX WiFi[/URL] omdat ik die heb liggen. (Ik heb ook een Pi liggen, maar dat lijkt me echt meer een gimmick dan iets serieus.) Is dat gewoon doable, of is dat echt een slecht idee qua performance?

Anders kan ik beter rsync gebruiken ipv zfs send/recv.

Nu wil ik 3 schijven in ZFS gebruiken op een oude [URL="https://tweakers.net/pricewatch/282330/zotac-fusion-itx-wifi/specificaties/"]pricewatch: Zotac Fusion-ITX WiFi[/URL] omdat ik die heb liggen. (Ik heb ook een Pi liggen, maar dat lijkt me echt meer een gimmick dan iets serieus.) Is dat gewoon doable, of is dat echt een slecht idee qua performance?

Nee, dat is dus ongeveer precies wat ik denk. Maar ik wil eerst weten of settings als compressie en native ZFS encryptie in mijn volume's dan meekomen. Want zo niet, dan lijkt het me nogal omslachtig om daarna nieuwe volumes aan te maken met de oude settings, om de gekopiëerde snapshots vervolgens intern nog een keer te kopiëren.FireDrunk schreef op donderdag 28 september 2017 @ 18:39:

Of denk ik te simpel?

Anders kan ik beter rsync gebruiken ipv zfs send/recv.

🇪🇺 Buy from EU (GoT)

Dat heeft alles met prestaties te maken. Voor top prestaties is ZFS net iets specifieker qua hardware dan andere FS-en. Een RPi is overigens nogal een tricky setup, omdat er nog geen 64bit OS voor is en je daardoor snel tegen geheugenproblemen aanloopt. Ik heb zelf 1 jaar zo'n setup gehad als offsite backup en op een gegeven moment bleven er maar problemen ontstaan. In dit topic heb ik vaker over dat experiment geschreven. Toen maar een tweedehands oude Supermicro Atom gekocht voor € 25,- ter vervanging.Sando schreef op dinsdag 3 oktober 2017 @ 11:50:

In hoeverre schaalt ZFS met hardware? Aan de ene kant hoor ik mensen zeggen: "ZFS is very hardware-hungry." Aan de andere kant draaien mensen ZFS op hun Raspberry Pi.

Begin bij welke prestaties je verwacht?Is dat gewoon doable, of is dat echt een slecht idee qua performance?

Die komen mee ja.Maar ik wil eerst weten of settings als compressie en native ZFS encryptie in mijn volume's dan meekomen.

rsync is altijd een slecht idee met ZFS want ZFS send/recvAnders kan ik beter rsync gebruiken ipv zfs send/recv.

Sinds de 2 dagen regel reageer ik hier niet meer

Here you go: ftp://ftp.nl.freebsd.org/...3-20170925-r323985.img.xzCurlyMo schreef op dinsdag 3 oktober 2017 @ 12:14:

[...]

Een RPi is overigens nogal een tricky setup, omdat er nog geen 64bit OS voor is en je daardoor snel tegen geheugenproblemen aanloopt.

Nice! Oftewel, binnenkort maar eens een RPi 3.0 aanschaffen om het uit te proberen.

[ Voor 12% gewijzigd door CurlyMo op 03-10-2017 12:55 ]

Sinds de 2 dagen regel reageer ik hier niet meer

Nou de array die ik wil maken kan in theorie 750 MByte/s lezen en 250 schrijven. Het zou mooi zijn als ik mijn gigabit LAN wel kan voltrekken, dus ongeveer 120 MByte per seconde lezen en schrijven.

Ah, kijk dat is precies wat ik nodig heb!Die komen mee ja.

Kan ik zo'n image ook mounten als ik gzip achterwege laat? Dan kan ik controleren of de bestanden er ook daadwerkelijk in staan.

🇪🇺 Buy from EU (GoT)

Daar kunnen de mensen hier wel advies op geven.Sando schreef op dinsdag 3 oktober 2017 @ 13:39:

[...]

Nou de array die ik wil maken kan in theorie 750 MByte/s lezen en 250 schrijven. Het zou mooi zijn als ik mijn gigabit LAN wel kan voltrekken, dus ongeveer 120 MByte per seconde lezen en schrijven.