Owner of DBIT Consultancy | DJ BassBrewer

Ben al een tijdje aan het kijken naar proxmox, lijkt me een mooi moment om eens te gaan testen op de gen10+, bedankt voor de tip.unezra schreef op vrijdag 27 maart 2020 @ 10:06:

[...]

Of ESXi de prullenbak in gooien en overgaan op Proxmox VE met bijvoorbeeld mdadm of ZFS.

100% softraid en dat zou prima moeten werken op een Gen10.

Wel balen dat de ilo enablement kit totaal niet verkrijgbaar is, het lijkt erop dat dat nog wel een maandje gaat duren.

Ik heb geen omkijken naar VMWARE dat vind ik nu juist het fijne. In het begin lopen te klooien met teveel VMs op de machine, maar nu ik gewoon de VMs heb draaien die de machine aan kan draait ie (wel met een geupgrade CPU) als een zonnetje.. En waarom zou je iets wat draait wijzigen. VEEAM draait goed, ik heb tevens een betaalde licentie dus .. tsja..unezra schreef op vrijdag 27 maart 2020 @ 10:06:

[...]

Of ESXi de prullenbak in gooien en overgaan op Proxmox VE met bijvoorbeeld mdadm of ZFS.

100% softraid en dat zou prima moeten werken op een Gen10.

There are no secrets, only information you do not yet have

Ik heb ook geen omkijken naar Proxmox VE.zeroday schreef op zaterdag 28 maart 2020 @ 10:05:

[...]

Ik heb geen omkijken naar VMWARE dat vind ik nu juist het fijne. In het begin lopen te klooien met teveel VMs op de machine, maar nu ik gewoon de VMs heb draaien die de machine aan kan draait ie (wel met een geupgrade CPU) als een zonnetje.. En waarom zou je iets wat draait wijzigen. VEEAM draait goed, ik heb tevens een betaalde licentie dus .. tsja..

Zelf vind ik PVE voor thuisgebruik een geschikter platform dan VMWare. Het kan véél meer.

ESXi vind ik nogal beperkt in zijn functionaliteit. Dusdanig, dat ik het geen zinvol platform vind voor thuis. VMWare word pas leuk als je d'r flink flappen voor over hebt.

Ná Scaoll. - Don’t Panic.

tsja.. ik vraag me dan af wat moet het ' veel ' meer kunnen dan? Ik heb een paar linux vm's 1 windows 10 vm en hop .. dat is het dan wel, het moet draaien, af en toe een snapshot mogelijk maken en VEEAM moet het kunnen backuppen.. Thats it ..unezra schreef op zaterdag 28 maart 2020 @ 12:50:

[...]

Ik heb ook geen omkijken naar Proxmox VE.

Zelf vind ik PVE voor thuisgebruik een geschikter platform dan VMWare. Het kan véél meer.

ESXi vind ik nogal beperkt in zijn functionaliteit. Dusdanig, dat ik het geen zinvol platform vind voor thuis. VMWare word pas leuk als je d'r flink flappen voor over hebt.

Meer is er voor mij niet nodig (hier en daar af en toe USB doorgeven) maar dat is het dan wel .. geen reden voor mij dus om ergens anders naar te kijken.

There are no secrets, only information you do not yet have

Had er een paar oude SSHD Seagate schijven in die niet echt goed bekend staan. Nieuwe SSD's erin en knallen maar dacht ik... Zelfde verhaal; veel drops in schrijven/lezen en gigantisch veel errors in eventvwr.

Zal het de SATA kabel naar de drive bay cage kunnen zijn? Daar heb ik nooit aangezeten en ziet er ook prima uit.

Maar in dat geval is zo'n kabel los te krijgen? Of wordt dat een standaard SAS > SATA breakout kabel als die al past in die beperkte ruimte.

Zie bij 1 van de SSD's deze waardes (SATA CRC):

Model : CT1000MX500SSD1

Firmware : M3CR023

Serial Number : 1950E22E95A0

Disk Size : 1000.2 GB (8.4/137.4/1000.2/----)

Buffer Size : Unknown

Queue Depth : 32

# of Sectors : 1953525168

Rotation Rate : ---- (SSD)

Interface : Serial ATA

Major Version : ACS-3

Minor Version : ---- [006Dh]

Transfer Mode : SATA/600 | SATA/600

Power On Hours : 38 hours

Power On Count : 2 count

Temperature : 31 C (87 F)

Health Status : Good

Features : S.M.A.R.T., APM, 48bit LBA, NCQ, TRIM, DevSleep

APM Level : 00FEh [ON]

AAM Level : ----

-- S.M.A.R.T. --------------------------------------------------------------

ID Cur Wor Thr Raw Values (7) Attribute Name

01 100 100 __0 00000000000000 Raw Read Error Rate

05 100 100 _10 00000000000000 Retired Block Count

09 100 100 __0 00000000000026 Power-on Hours

0C 100 100 __0 00000000000002 Power Cycle Count

AB 100 100 __0 00000000000000 Program Fail Count

AC 100 100 __0 00000000000000 Erase Fail Count

AD 100 100 __0 00000000000000 Vendor Specific

AE 100 100 __0 00000000000000 Unexpected Power Loss Count

B4 __0 __0 __0 00000000000025 Vendor Specific

B7 100 100 __0 00000000000000 Vendor Specific

B8 100 100 __0 00000000000000 Reported I/O Error Detection Code Errors

BB 100 100 __0 00000000000000 Reported Uncorrectable Errors

C2 _69 _62 __0 0000260000001F Temperature

C4 100 100 __0 00000000000000 Reallocation Event Count

C5 100 100 __0 00000000000000 Vendor Specific

C6 100 100 __0 00000000000000 Uncorrectable Sector Count

C7 100 100 __0 000000000010D4 SATA R-Errors (CRC) Error Count

CA 100 100 __1 00000000000000 Vendor Specific

CE 100 100 __0 00000000000000 Vendor Specific

D2 100 100 __0 00000000000000 Vendor Specific

F6 100 100 __0 000000002E7884 Vendor Specific

F7 100 100 __0 00000000007BE7 Vendor Specific

F8 100 100 __0 00000000006283 Vendor Specific

Dadelijk maar eens proberen als er in die bay een andere SSD zit wat de SMART waardes zijn.

Drive bay 1 & 2 omgewisseld en tot nu toe geen (extra) SATA CRC fouten meer en performance is uitstekend. Even aankijken of dit zo blijft.

[ Voor 62% gewijzigd door rookie no. 1 op 28-03-2020 23:33 ]

Ik heb nu bij Centralpoint besteld.

Daar werd aangegeven 8 april als verzend datum.

Vandaag staat er 14 april als verzend datum.

Maar volgens de website wel 9 op voorraad??

Ik heb ze gebeld, maar mogelijk ook door thuiswerkers wordt het er niet echt duidelijk op of ze wel of geen voorraad hebben.

A Soldiers manual and a pair of boots.

Wat heeft Proxmox voor jou voor extra voordelen voor de thuissituatie? Ik ben wel benieuwd, ik heb tot nu toe alleen ESXi gebruikt.unezra schreef op zaterdag 28 maart 2020 @ 12:50:

[...]

Ik heb ook geen omkijken naar Proxmox VE.

Zelf vind ik PVE voor thuisgebruik een geschikter platform dan VMWare. Het kan véél meer.

ESXi vind ik nogal beperkt in zijn functionaliteit. Dusdanig, dat ik het geen zinvol platform vind voor thuis. VMWare word pas leuk als je d'r flink flappen voor over hebt.

Die 9 is generiek, waarschijnlijk bij Distribiteur, kijk maar eens hier ook op deze link staan er 9 beschikbaar. Zal waarschijnlijk een drop shipment worden, dus rechtstreeks vanuit magazijn distribiteur naar klant.To_Tall schreef op maandag 30 maart 2020 @ 12:37:

iemand bekend met de levertijden van de Gen10Plus?

Ik heb nu bij Centralpoint besteld.

Daar werd aangegeven 8 april als verzend datum.

Vandaag staat er 14 april als verzend datum.

Maar volgens de website wel 9 op voorraad??

Ik heb ze gebeld, maar mogelijk ook door thuiswerkers wordt het er niet echt duidelijk op of ze wel of geen voorraad hebben.

Maar voor mij is deze machine een no-go geworden nu RAID niet mogelijk is zonder een aparte hwardware module

[ Voor 5% gewijzigd door zeroday op 30-03-2020 13:37 ]

There are no secrets, only information you do not yet have

- Je kunt zowel full-virt (KVM) als containers (LXC) gebruiken. (Die laatste zijn een stuk lichter dan de eerste.)GekkePrutser schreef op maandag 30 maart 2020 @ 12:44:

[...]

Wat heeft Proxmox voor jou voor extra voordelen voor de thuissituatie? Ik ben wel benieuwd, ik heb tot nu toe alleen ESXi gebruikt.

- ZFS als mogelijk filesystem (met alle voordelen vandien, zoals data integriteit, snelheid, flexibiliteit en gemak om offsite backups te maken)

- Open Source (het is Debian met een gemodificeerde Ubuntu kernel), dus allerlei tools tot je beschikking die er anders niet zijn

- Goede web GUI

- Mogelijkheid tot bouwen van een cluster (gebruik ik zelf thuis niet meer, maar het kán wel)

- Snapshots, live migration, etc. (Gebruik ik thuis op dit moment ook niet, hoewel ik wel incidenteel een snapshot van een VM gebruik, bijvoorbeeld voor een grote upgrade.)

- Goede ingebouwde firewall (gebruik ik thuis niet, op mijn colocatie wél omdat dat ding direct aan het internet hangt)

Complete main featurelist:

https://www.proxmox.com/en/proxmox-ve/comparison

https://www.proxmox.com/en/proxmox-ve/features

Denk dat thuis, voor mij en veel mensen, vooral full-virt & container virt handig is, plus ZFS, plus de verdomd goede en snelle (!) GUI. (De GUI van VMWare blijft een draak. Traag als de hel en echt overzichtelijk vind ik 'm niet.)

Ná Scaoll. - Don’t Panic.

pricewatch: Crucial CT16G4DFD824A

Of is het beter om een set van 32GB te bestellen? Zoals deze?

pricewatch: Crucial CT2K16G4DFD8266

Of moet er per se ECC geheugen in en wat is dan aan te bevelen?

[ Voor 4% gewijzigd door Fonta op 31-03-2020 21:30 ]

Zou zelf voor ECC geheugen kiezen als het systeem het ondersteunt.

Formeel heeft Crucial nog geen modules die voor de Gen10plus zijn: https://eu.crucial.com/co...nt-microserver-gen10-plus

Kingston memory configurator komt de Gen10plus nog niet voor. Al zal er vast bij beide merken wel een werkend setje te krijgen zijn.

Ben niet op zoek naar geheugen voor de plus. Dit is de Gen10 die ik hier al een tijdje heb ondertussenrookie no. 1 schreef op woensdag 1 april 2020 @ 20:18:

@Fonta

Zou zelf voor ECC geheugen kiezen als het systeem het ondersteunt.

Formeel heeft Crucial nog geen modules die voor de Gen10plus zijn: https://eu.crucial.com/co...nt-microserver-gen10-plus

Kingston memory configurator komt de Gen10plus nog niet voor. Al zal er vast bij beide merken wel een werkend setje te krijgen zijn.

Zit te denken om over een tijdje over te stappen op de plus, vandaar non-ECC geheugen als het even kan want scheelt toch weer knaken. En of het mogelijk is natuurlijk om een enkele module bij te prikken.

[ Voor 14% gewijzigd door Fonta op 01-04-2020 20:19 ]

Volgens https://eu.crucial.com/co...roliant-microserver-gen10 zou de volgende moeten werken.rookie no. 1 schreef op woensdag 1 april 2020 @ 20:25:

Verkeerd gelezen, maar dan wordt het makkelijker; juiste (ECC) modules voor de Gen10 zijn via de configurators te vinden.

/f/image/wZ8byIwKCh2sOdPYe6249dzM.png?f=fotoalbum_large)

Maar is dat dan handig om die simpelweg naast de bestaande ECC dimm te prikken?

https://www.servethehome....mate-customization-guide/

AMD Ryzen 7 5900x | Custom WC | ASUS ROG Strix X570-E Gaming | 32GB Corsair DDR4-3600MHz | Samsung 970 nvme 1TB | Samsung 860 EVO 2TB | AMD RX 6900XT 16GB | 1x Asus RoG XG27AQDMG | 1x LG UltraGear 27GL850

Wat zijn de specs van de huidige module?

Standaard module die erbij geleverd werd. 2400 ECC 17 geloof ik.rookie no. 1 schreef op woensdag 1 april 2020 @ 22:01:

@Fonta

Wat zijn de specs van de huidige module?

De kit van 16 GB die je selecteert hierboven is 2 x 8 GB dus 'er bij prikken' is niet aan de orde volgens mij.Fonta schreef op woensdag 1 april 2020 @ 22:39:

Geen idee of je ECC met non-ECC kan mixen. Hopelijk weet iemand anders nog iets

Ik weet niet of dit is wat je zoekt maar dit is gewoon 1 x 16 GB en ECC voor 93 euro inclusief btw.

pricewatch: Kingston KSM24ED8/16ME

Disclaimer: geen idee of het compatibel is.

Ik zou het antwoord niet weten op de vraag over het mixen van ECC geheugen maar mijn gedachte is dat je sommige dingen jezelf beter niet kunt afvragen. (Bah!)

Maar hoe belangrijk is deze server voor stabiliteit en data integriteit? Niet zo belangrijk: non-ecc (als het echt zoveel geld scheelt) of anders gewoon betalen en ECC er in.

Ik veerde helemaal op bij die QNAP kaart met 10GBE netwerk en 2x m.2, wordt ie compleet afgebrandrikadoo schreef op woensdag 1 april 2020 @ 21:42:

Voor degene die een Microserver Gen10+ hebben, op Servethehome hebben ze een Gen 10 getest met verschillende CPU's en geheugen configuraties. Wellicht leuk om even door te lezen voor opties.

https://www.servethehome....mate-customization-guide/

Ik moet echt de ilo enablement kit hebben maar die is nergens in europa te krijgen voor de normale prijs..

https://www.bechtle.com/d...nablement-kit--4430342--pCopyCatz schreef op donderdag 2 april 2020 @ 00:13:

[...]

Ik veerde helemaal op bij die QNAP kaart met 10GBE netwerk en 2x m.2, wordt ie compleet afgebrand

Ik moet echt de ilo enablement kit hebben maar die is nergens in europa te krijgen voor de normale prijs..

Dat valt mee toch? (Al duurt het even voordat er is.)

Dat valt mij echt reuze mee!Fonta schreef op donderdag 2 april 2020 @ 02:01:

[...]

https://www.bechtle.com/d...nablement-kit--4430342--p

Dat valt mee toch? (Al duurt het even voordat er is.)

Voor de G10(+) weet ik het niet zeker, maar de rest van mijn rammelbakken eten wat ze krijgen en dat is nou eenmaal alles door elkaar.Fonta schreef op woensdag 1 april 2020 @ 22:39:

Geen idee of je ECC met non-ECC kan mixen. Hopelijk weet iemand anders nog iets

[ Voor 39% gewijzigd door chaoscontrol op 02-04-2020 09:51 ]

Thanks, we gaan even kijken wat we gaan doen. De nieuwe Gen10+ is potentieel een stuk krachtiger en dus is misschien overstappen ook een idee.chaoscontrol schreef op donderdag 2 april 2020 @ 09:32:

[...]

Dat valt mij echt reuze mee!

[...]

Voor de G10(+) weet ik het niet zeker, maar de rest van mijn rammelbakken eten wat ze krijgen en dat is nou eenmaal alles door elkaar.ECC is wel disabled als je met normaal ram mixed.

Ik had gedacht dat ik misschien iets minder performance zou hebben, maar dit niet... Dus ik denk dat er iets mis is gegaan. Heb eerder even een testje gedaan op mijn oude config waarbij Proxmox op een SSD draaide en ik vanuit daar de ZFS pool heb gemaakt en Xpenology heb geïsntalleerd. Heb niet heel lang getest, maar kon toen zonder problemen een bestand overzetten met > 100MB/s.

In Xpenology heb ik een ext4 partitie aangemaakt.

Hoe moet ik dit aanvliegen? Hieronder wat output van commandos die ik tegen ben gekomen.

UPDATE: Heb nu swappiness op 10 gezet (ipv de default 60) en nu lijkt het allemaal niet meer vast te lopen! Kopiëren van de data van de oude HDD valt mij nog steeds wel tegen, maar het zijn ook wel wat meer kleine bestanden (dus veel iops). Ook heb ik compression op lz4 gezet ipv "on". IO delay staat nu op zo'n 60% en kopiëren gaat met 25MB/s.

UPDATE 2: Ook met verplaatsen van Films haal ik maar zo'n 10 tot 25MB/s...

code:

root@pve:~# zpool list NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT rpool 14.5T 66.7G 14.5T - - 0% 0% 1.00x ONLINE - root@pve:~# zpool status pool: rpool state: ONLINE scan: none requested config: NAME STATE READ WRITE CKSUM rpool ONLINE 0 0 0 raidz1-0 ONLINE 0 0 0 ata-WDC_WD40EFRX-68N32N0_WD-WCC7K3XLSZVT-part3 ONLINE 0 0 0 ata-WDC_WD40EFRX-68N32N0_WD-WCC7K3ASXE32-part3 ONLINE 0 0 0 ata-WDC_WD40EFRX-68N32N0_WD-WCC7K3DDDFS3-part3 ONLINE 0 0 0 ata-WDC_WD40EFRX-68N32N0_WD-WCC7K5HZLF8T-part3 ONLINE 0 0 0 errors: No known data errors root@pve:~# zfs list NAME USED AVAIL REFER MOUNTPOINT rpool 48.5G 10.2T 151K /rpool rpool/ROOT 1.06G 10.2T 140K /rpool/ROOT rpool/ROOT/pve-1 1.06G 10.2T 1.06G / rpool/data 47.4G 10.2T 140K /rpool/data rpool/data/vm-100-disk-0 41.1M 10.2T 41.1M - rpool/data/vm-100-disk-1 41.3G 10.2T 41.3G - rpool/data/vm-101-disk-0 6.07G 10.2T 6.07G - root@pve:~# zfs get all rpool NAME PROPERTY VALUE SOURCE rpool type filesystem - rpool creation Wed Apr 1 21:07 2020 - rpool used 48.5G - rpool available 10.2T - rpool referenced 151K - rpool compressratio 1.08x - rpool mounted yes - rpool quota none default rpool reservation none default rpool recordsize 128K default rpool mountpoint /rpool default rpool sharenfs off default rpool checksum on default rpool compression on local rpool atime off local rpool devices on default rpool exec on default rpool setuid on default rpool readonly off default rpool zoned off default rpool snapdir hidden default rpool aclinherit restricted default rpool createtxg 1 - rpool canmount on default rpool xattr on default rpool copies 1 default rpool version 5 - rpool utf8only off - rpool normalization none - rpool casesensitivity sensitive - rpool vscan off default rpool nbmand off default rpool sharesmb off default rpool refquota none default rpool refreservation none default rpool guid 2907522485319112031 - rpool primarycache all default rpool secondarycache all default rpool usedbysnapshots 0B - rpool usedbydataset 151K - rpool usedbychildren 48.5G - rpool usedbyrefreservation 0B - rpool logbias latency default rpool objsetid 54 - rpool dedup off default rpool mlslabel none default rpool sync standard local rpool dnodesize legacy default rpool refcompressratio 1.00x - rpool written 151K - rpool logicalused 36.4G - rpool logicalreferenced 46K - rpool volmode default default rpool filesystem_limit none default rpool snapshot_limit none default rpool filesystem_count none default rpool snapshot_count none default rpool snapdev hidden default rpool acltype off default rpool context none default rpool fscontext none default rpool defcontext none default rpool rootcontext none default rpool relatime off default rpool redundant_metadata all default rpool overlay off default rpool encryption off default rpool keylocation none default rpool keyformat none default rpool pbkdf2iters 0 default rpool special_small_blocks 0 default root@pve:~# arc_summary ------------------------------------------------------------------------ ZFS Subsystem Report Thu Apr 02 20:37:21 2020 Linux 5.3.18-2-pve 0.8.3-pve1 Machine: pve (x86_64) 0.8.3-pve1 ARC status: HEALTHY Memory throttle count: 0 ARC size (current): 13.7 % 540.8 MiB Target size (adaptive): 14.5 % 575.0 MiB Min size (hard limit): 6.2 % 247.3 MiB Max size (high water): 16:1 3.9 GiB Most Frequently Used (MFU) cache size: 10.8 % 55.3 MiB Most Recently Used (MRU) cache size: 89.2 % 456.6 MiB Metadata cache size (hard limit): 75.0 % 2.9 GiB Metadata cache size (current): 2.1 % 61.2 MiB Dnode cache size (hard limit): 10.0 % 296.7 MiB Dnode cache size (current): 0.7 % 2.1 MiB ARC hash breakdown: Elements max: 288.7k Elements current: 27.8 % 80.3k Collisions: 932.6k Chain max: 5 Chains: 3.0k ARC misc: Deleted: 5.7M Mutex misses: 1.9k Eviction skips: 38.5k ARC total accesses (hits + misses): 8.2M Cache hit ratio: 96.2 % 7.9M Cache miss ratio: 3.8 % 309.1k Actual hit ratio (MFU + MRU hits): 96.0 % 7.9M Data demand efficiency: 86.7 % 2.0M Data prefetch efficiency: 34.3 % 47.5k Cache hits by cache type: Most frequently used (MFU): 62.1 % 4.9M Most recently used (MRU): 37.7 % 3.0M Most frequently used (MFU) ghost: 0.4 % 28.3k Most recently used (MRU) ghost: 0.1 % 8.4k Cache hits by data type: Demand data: 21.5 % 1.7M Demand prefetch data: 0.2 % 16.3k Demand metadata: 78.2 % 6.2M Demand prefetch metadata: 0.1 % 6.1k Cache misses by data type: Demand data: 84.5 % 261.2k Demand prefetch data: 10.1 % 31.2k Demand metadata: 4.9 % 15.1k Demand prefetch metadata: 0.5 % 1.6k DMU prefetch efficiency: 2.9M Hit ratio: 18.8 % 553.0k Miss ratio: 81.2 % 2.4M L2ARC not detected, skipping section Solaris Porting Layer (SPL): spl_hostid 0 spl_hostid_path /etc/hostid spl_kmem_alloc_max 1048576 spl_kmem_alloc_warn 65536 spl_kmem_cache_expire 2 spl_kmem_cache_kmem_limit 2048 spl_kmem_cache_kmem_threads 4 spl_kmem_cache_magazine_size 0 spl_kmem_cache_max_size 32 spl_kmem_cache_obj_per_slab 8 spl_kmem_cache_obj_per_slab_min 1 spl_kmem_cache_reclaim 0 spl_kmem_cache_slab_limit 16384 spl_max_show_tasks 512 spl_panic_halt 0 spl_schedule_hrtimeout_slack_us 0 spl_taskq_kick 0 spl_taskq_thread_bind 0 spl_taskq_thread_dynamic 1 spl_taskq_thread_priority 1 spl_taskq_thread_sequential 4 Tunables: dbuf_cache_hiwater_pct 10 dbuf_cache_lowater_pct 10 dbuf_cache_max_bytes 129639616 dbuf_cache_shift 5 dbuf_metadata_cache_max_bytes 64819808 dbuf_metadata_cache_shift 6 dmu_object_alloc_chunk_shift 7 dmu_prefetch_max 134217728 ignore_hole_birth 1 l2arc_feed_again 1 l2arc_feed_min_ms 200 l2arc_feed_secs 1 l2arc_headroom 2 l2arc_headroom_boost 200 l2arc_noprefetch 1 l2arc_norw 0 l2arc_write_boost 8388608 l2arc_write_max 8388608 metaslab_aliquot 524288 metaslab_bias_enabled 1 metaslab_debug_load 0 metaslab_debug_unload 0 metaslab_df_max_search 16777216 metaslab_df_use_largest_segment 0 metaslab_force_ganging 16777217 metaslab_fragmentation_factor_enabled 1 metaslab_lba_weighting_enabled 1 metaslab_preload_enabled 1 send_holes_without_birth_time 1 spa_asize_inflation 24 spa_config_path /etc/zfs/zpool.cache spa_load_print_vdev_tree 0 spa_load_verify_data 1 spa_load_verify_metadata 1 spa_load_verify_shift 4 spa_slop_shift 5 vdev_removal_max_span 32768 vdev_validate_skip 0 zap_iterate_prefetch 1 zfetch_array_rd_sz 1048576 zfetch_max_distance 8388608 zfetch_max_streams 8 zfetch_min_sec_reap 2 zfs_abd_scatter_enabled 1 zfs_abd_scatter_max_order 10 zfs_abd_scatter_min_size 1536 zfs_admin_snapshot 0 zfs_arc_average_blocksize 8192 zfs_arc_dnode_limit 0 zfs_arc_dnode_limit_percent 10 zfs_arc_dnode_reduce_percent 10 zfs_arc_grow_retry 0 zfs_arc_lotsfree_percent 10 zfs_arc_max 0 zfs_arc_meta_adjust_restarts 4096 zfs_arc_meta_limit 0 zfs_arc_meta_limit_percent 75 zfs_arc_meta_min 0 zfs_arc_meta_prune 10000 zfs_arc_meta_strategy 1 zfs_arc_min 0 zfs_arc_min_prefetch_ms 0 zfs_arc_min_prescient_prefetch_ms 0 zfs_arc_p_dampener_disable 1 zfs_arc_p_min_shift 0 zfs_arc_pc_percent 0 zfs_arc_shrink_shift 0 zfs_arc_sys_free 0 zfs_async_block_max_blocks 100000 zfs_autoimport_disable 1 zfs_checksum_events_per_second 20 zfs_commit_timeout_pct 5 zfs_compressed_arc_enabled 1 zfs_condense_indirect_commit_entry_delay_ms 0 zfs_condense_indirect_vdevs_enable 1 zfs_condense_max_obsolete_bytes 1073741824 zfs_condense_min_mapping_bytes 131072 zfs_dbgmsg_enable 1 zfs_dbgmsg_maxsize 4194304 zfs_dbuf_state_index 0 zfs_ddt_data_is_special 1 zfs_deadman_checktime_ms 60000 zfs_deadman_enabled 1 zfs_deadman_failmode wait zfs_deadman_synctime_ms 600000 zfs_deadman_ziotime_ms 300000 zfs_dedup_prefetch 0 zfs_delay_min_dirty_percent 60 zfs_delay_scale 500000 zfs_delete_blocks 20480 zfs_dirty_data_max 829693542 zfs_dirty_data_max_max 2074233856 zfs_dirty_data_max_max_percent 25 zfs_dirty_data_max_percent 10 zfs_dirty_data_sync_percent 20 zfs_disable_ivset_guid_check 0 zfs_dmu_offset_next_sync 0 zfs_expire_snapshot 300 zfs_flags 0 zfs_free_bpobj_enabled 1 zfs_free_leak_on_eio 0 zfs_free_min_time_ms 1000 zfs_immediate_write_sz 32768 zfs_initialize_value 16045690984833335022 zfs_key_max_salt_uses 400000000 zfs_lua_max_instrlimit 100000000 zfs_lua_max_memlimit 104857600 zfs_max_missing_tvds 0 zfs_max_recordsize 1048576 zfs_metaslab_fragmentation_threshold 70 zfs_metaslab_segment_weight_enabled 1 zfs_metaslab_switch_threshold 2 zfs_mg_fragmentation_threshold 95 zfs_mg_noalloc_threshold 0 zfs_multihost_fail_intervals 10 zfs_multihost_history 0 zfs_multihost_import_intervals 20 zfs_multihost_interval 1000 zfs_multilist_num_sublists 0 zfs_no_scrub_io 0 zfs_no_scrub_prefetch 0 zfs_nocacheflush 0 zfs_nopwrite_enabled 1 zfs_object_mutex_size 64 zfs_obsolete_min_time_ms 500 zfs_override_estimate_recordsize 0 zfs_pd_bytes_max 52428800 zfs_per_txg_dirty_frees_percent 5 zfs_prefetch_disable 0 zfs_read_chunk_size 1048576 zfs_read_history 0 zfs_read_history_hits 0 zfs_reconstruct_indirect_combinations_max 4096 zfs_recover 0 zfs_recv_queue_length 16777216 zfs_removal_ignore_errors 0 zfs_removal_suspend_progress 0 zfs_remove_max_segment 16777216 zfs_resilver_disable_defer 0 zfs_resilver_min_time_ms 3000 zfs_scan_checkpoint_intval 7200 zfs_scan_fill_weight 3 zfs_scan_ignore_errors 0 zfs_scan_issue_strategy 0 zfs_scan_legacy 0 zfs_scan_max_ext_gap 2097152 zfs_scan_mem_lim_fact 20 zfs_scan_mem_lim_soft_fact 20 zfs_scan_strict_mem_lim 0 zfs_scan_suspend_progress 0 zfs_scan_vdev_limit 4194304 zfs_scrub_min_time_ms 1000 zfs_send_corrupt_data 0 zfs_send_queue_length 16777216 zfs_send_unmodified_spill_blocks 1 zfs_slow_io_events_per_second 20 zfs_spa_discard_memory_limit 16777216 zfs_special_class_metadata_reserve_pct 25 zfs_sync_pass_deferred_free 2 zfs_sync_pass_dont_compress 8 zfs_sync_pass_rewrite 2 zfs_sync_taskq_batch_pct 75 zfs_trim_extent_bytes_max 134217728 zfs_trim_extent_bytes_min 32768 zfs_trim_metaslab_skip 0 zfs_trim_queue_limit 10 zfs_trim_txg_batch 32 zfs_txg_history 100 zfs_txg_timeout 5 zfs_unlink_suspend_progress 0 zfs_user_indirect_is_special 1 zfs_vdev_aggregate_trim 0 zfs_vdev_aggregation_limit 1048576 zfs_vdev_aggregation_limit_non_rotating 131072 zfs_vdev_async_read_max_active 3 zfs_vdev_async_read_min_active 1 zfs_vdev_async_write_active_max_dirty_percent 60 zfs_vdev_async_write_active_min_dirty_percent 30 zfs_vdev_async_write_max_active 10 zfs_vdev_async_write_min_active 2 zfs_vdev_cache_bshift 16 zfs_vdev_cache_max 16384 zfs_vdev_cache_size 0 zfs_vdev_default_ms_count 200 zfs_vdev_initializing_max_active 1 zfs_vdev_initializing_min_active 1 zfs_vdev_max_active 1000 zfs_vdev_min_ms_count 16 zfs_vdev_mirror_non_rotating_inc 0 zfs_vdev_mirror_non_rotating_seek_inc 1 zfs_vdev_mirror_rotating_inc 0 zfs_vdev_mirror_rotating_seek_inc 5 zfs_vdev_mirror_rotating_seek_offset 1048576 zfs_vdev_ms_count_limit 131072 zfs_vdev_queue_depth_pct 1000 zfs_vdev_raidz_impl cycle [fastest] original scalar sse2 ssse3 zfs_vdev_read_gap_limit 32768 zfs_vdev_removal_max_active 2 zfs_vdev_removal_min_active 1 zfs_vdev_scheduler unused zfs_vdev_scrub_max_active 2 zfs_vdev_scrub_min_active 1 zfs_vdev_sync_read_max_active 10 zfs_vdev_sync_read_min_active 10 zfs_vdev_sync_write_max_active 10 zfs_vdev_sync_write_min_active 10 zfs_vdev_trim_max_active 2 zfs_vdev_trim_min_active 1 zfs_vdev_write_gap_limit 4096 zfs_zevent_cols 80 zfs_zevent_console 0 zfs_zevent_len_max 1024 zfs_zil_clean_taskq_maxalloc 1048576 zfs_zil_clean_taskq_minalloc 1024 zfs_zil_clean_taskq_nthr_pct 100 zil_maxblocksize 131072 zil_nocacheflush 0 zil_replay_disable 0 zil_slog_bulk 786432 zio_deadman_log_all 0 zio_dva_throttle_enabled 1 zio_requeue_io_start_cut_in_line 1 zio_slow_io_ms 30000 zio_taskq_batch_pct 75 zvol_inhibit_dev 0 zvol_major 230 zvol_max_discard_blocks 16384 zvol_prefetch_bytes 131072 zvol_request_sync 0 zvol_threads 32 zvol_volmode 1 VDEV cache disabled, skipping section ZIL committed transactions: 1.9M Commit requests: 132.0k Flushes to stable storage: 132.0k Transactions to SLOG storage pool: 0 Bytes 0 Transactions to non-SLOG storage pool: 105.6 GiB 990.0k

WP: ME PUHZ-SW75YAA + ERST30D-VM2ED | Solar: 17x TSM-340-DE06M.08 (5780Wp ~6200kWh), Azimuth 179°, Hellingshoek: 34° | PC specs

https://gathering.tweaker...message/61169954#61169954 Gerelateerd?HaTe schreef op donderdag 2 april 2020 @ 20:46:

Ik ben bezig om mijn Gen 8 (1265Lv2, 8GB) om te zetten naar nieuwe HDD's, 4x 4TB (WD RED), waarbij ik proxmox gebruik en het wil draaien in RaidZ1 met ZFS. Ik heb nu 1 VM met Xpenology, waarvoor ik 2 GB heb gereserveerd (had eerder 4). Toch haal ik erg slechte performance nu. Als ik ook maar iets aan schrijfactie doe, zoals bestandje overzetten of backup van de oude HDD op de nieuwe zvol zetten, dan gaat IO delay naar 100% en loop alles vast.

Ik had gedacht dat ik misschien iets minder performance zou hebben, maar dit niet... Dus ik denk dat er iets mis is gegaan. Heb eerder even een testje gedaan op mijn oude config waarbij Proxmox op een SSD draaide en ik vanuit daar de ZFS pool heb gemaakt en Xpenology heb geïsntalleerd. Heb niet heel lang getest, maar kon toen zonder problemen een bestand overzetten met > 100MB/s.

In Xpenology heb ik een ext4 partitie aangemaakt.

Hoe moet ik dit aanvliegen? Hieronder wat output van commandos die ik tegen ben gekomen.

UPDATE: Heb nu swappiness op 10 gezet (ipv de default 60) en nu lijkt het allemaal niet meer vast te lopen! Kopiëren van de data van de oude HDD valt mij nog steeds wel tegen, maar het zijn ook wel wat meer kleine bestanden (dus veel iops). Ook heb ik compression op lz4 gezet ipv "on". IO delay staat nu op zo'n 60% en kopiëren gaat met 25MB/s.

UPDATE 2: Ook met verplaatsen van Films haal ik maar zo'n 10 tot 25MB/s...

[...]

Had je die e301 nog gekocht?Uberprutser schreef op vrijdag 18 oktober 2019 @ 10:42:

Mijn laatste Microserver Gen8 is van de week naar een nieuwe eigenaar gegaan en heb deze (tijdelijk) vervangen voor een Dell Optiplex 5050 met i7 7700, 64GB RAM, 2TB 970 Evo Plus en Intel I350-AM4 NIC.

De 16GB geheugenlimiet van de Microserver begon nu wel irritant te worden, net als de SATA SSDs (eenmaal NVME...) De CPU ontlasting van de i350 NIC is zeer fijn, maar het was OF NVME in de microserver OF de i350 kaart.

Als uiteindelijke vervanger heb ik de Supermicro SuperServer E301-9D-8CN8TP op het oog aangezien deze 2x SFP+ poorten heeft en 8 cores.

En intussen heeft HPE inmiddels ook zijn eigen HPE Customized ESXi Image "ESXi 7.0 Apr 2020" vrijgegeven. Met een bijkomende HPE Custom Addon for "ESXi 7.0 Apr 2020". En voor de voorloper van VMware vSphere 6.7 U3 heeft HPE een nieuwe uitgave uitgebracht genaamd HPE Customized ESXi Image "ESXi 6.7 U3 Mar 2020".

Deze HPE uitgaven zijn eigenlijk alleen bestemd voor de "HPE Proliant MicroServer Gen9 servers and forward", waardoor HPE voor deze voorgenoemde ESXi/vSphere uitgaven geen officiële ondersteuning meer aanbied, indien men deze toch wel in gebruik zou nemen op de HPE Proliant MicroServer Gen8 servers. Waardoor er met elke nieuwe uitgave geen garantie is of deze nog wel blijft werken op de Gen8 servers.

Aangezien ik al enige tijd gebruik maak van een HPE Proliant MicroServer Gen8 in combinatie van zowel de VMware als de HPE vSphere 6.7 uitgaven, heb ik van de week even de moeite genomen om te testen of de nieuwe uitgaven van "ESXi 6.7 U3 Mar 2020" en HPE Customized ESXi Image "ESXi 7.0 Apr 2020" nog wel werken op de genoemde HPE Proliant MicroServer Gen8.

Hiervoor draaide ik "Image profile: VMware-ESXi-6.7.0-Update3-15160138-HPE-Gen9plus-670.U3.10.5.0.48-Dec2019-depot.zip (Build 15160138)". Na daar "Image profile: VMware-ESXi-6.7.0-Update3-15160138-HPE-Gen9plus-670.U3.10.5.5.25-Mar2020-depot.zip (Build 15160138)" overheen te hebben geüpdatet zoals hieronder te zien is bleek na de reboot ook deze nieuwe uitgave vooralsnog werkzaam op de Gen8;

1

2

3

4

5

6

7

8

9

10

| [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_enter [root@HPE-ESXi:~] esxcli software vib update --depot=/vmfs/volumes/vmNFS/ESXi-updates/VMware-ESXi-6.7.0-Update3-15160138-HPE-Gen9plus-670.U3.10.5.5.25-Mar2020-depot.zip Installation Result Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective. Reboot Required: true VIBs Installed: BCM_bootbank_bnxtnet_214.0.230.0-1OEM.670.0.0.8169922, BCM_bootbank_bnxtroce_214.0.187.0-1OEM.670.0.0.8169922, EMU_bootbank_brcmfcoe_12.0.1278.0-1OEM.670.0.0.8169922, EMU_bootbank_elxnet_12.0.1216.4-1OEM.670.0.0.8169922, EMU_bootbank_lpfc_12.4.270.6-1OEM.670.0.0.8169922, HPE_bootbank_oem-build_670.U3.10.5.5-7535516, HPE_bootbank_ssacli_4.17.6.0-6.7.0.7535516.hpe, QLogic_bootbank_qlnativefc_3.1.31.0-1OEM.670.0.0.8169922 VIBs Removed: BCM_bootbank_bnxtnet_214.0.195.0-1OEM.670.0.0.8169922, BCM_bootbank_bnxtroce_214.0.184.0-1OEM.670.0.0.8169922, EMU_bootbank_brcmfcoe_12.0.1211.0-1OEM.670.0.0.8169922, EMU_bootbank_elxnet_12.0.1115.0-1OEM.670.0.0.7535516, EMU_bootbank_lpfc_12.4.242.0-1OEM.670.0.0.8169922, HPE_bootbank_oem-build_670.U3.10.5.0-7535516, HPE_bootbank_ssacli_4.15.6.0-6.7.0.7535516, QLogic_bootbank_qlnativefc_3.1.29.0-1OEM.670.0.0.8169922 VIBs Skipped: Avago_bootbank_lsi-mr3_7.706.08.00-1OEM.670.0.0.8169922, ELX_bootbank_elx-esx-libelxima-8169922.so_12.0.1188.0-03, EMU_bootbank_elxiscsi_12.0.1188.0-1OEM.670.0.0.8169922, HPE_bootbank_amsd_670.11.5.0-16.7535516, HPE_bootbank_bootcfg_6.7.0.02-06.00.14.7535516, HPE_bootbank_conrep_6.7.0.03-04.00.34.7535516, HPE_bootbank_cru_670.6.7.10.14-1OEM.670.0.0.7535516, HPE_bootbank_fc-enablement_670.3.50.16-7535516, HPE_bootbank_hponcfg_6.7.0.5.5-0.18.7535516, HPE_bootbank_ilo_670.10.2.0.2-1OEM.670.0.0.7535516, HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820, HPE_bootbank_smx-provider_670.03.16.00.3-7535516, HPE_bootbank_sut_6.7.0.2.5.0.0-83, HPE_bootbank_testevent_6.7.0.02-01.00.12.7535516, INT_bootbank_i40en_1.9.5-1OEM.670.0.0.8169922, INT_bootbank_igbn_1.4.10-1OEM.670.0.0.8169922, INT_bootbank_ixgben_1.7.20-1OEM.670.0.0.8169922, MEL_bootbank_nmlx5-core_4.17.15.16-1OEM.670.0.0.8169922, MEL_bootbank_nmlx5-rdma_4.17.15.16-1OEM.670.0.0.8169922, MEL_bootbank_nmst_4.12.0.105-1OEM.650.0.0.4598673, MSCC_bootbank_smartpqi_1.0.4.3008-1OEM.670.0.0.8169922, Microsemi_bootbank_nhpsa_2.0.44-1OEM.670.0.0.8169922, QLC_bootbank_qcnic_1.0.27.0-1OEM.670.0.0.8169922, QLC_bootbank_qedentv_3.11.16.0-1OEM.670.0.0.8169922, QLC_bootbank_qedf_1.3.41.0-1OEM.600.0.0.2768847, QLC_bootbank_qedi_2.10.19.0-1OEM.670.0.0.8169922, QLC_bootbank_qedrntv_3.11.16.0-1OEM.670.0.0.8169922, QLC_bootbank_qfle3_1.0.87.0-1OEM.670.0.0.8169922, QLC_bootbank_qfle3f_1.0.75.0-1OEM.670.0.0.8169922, QLC_bootbank_qfle3i_1.0.25.0-1OEM.670.0.0.8169922, VMW_bootbank_ata-libata-92_3.00.9.2-16vmw.670.0.0.8169922, VMW_bootbank_ata-pata-amd_0.3.10-3vmw.670.0.0.8169922, VMW_bootbank_ata-pata-atiixp_0.4.6-4vmw.670.0.0.8169922, VMW_bootbank_ata-pata-cmd64x_0.2.5-3vmw.670.0.0.8169922, VMW_bootbank_ata-pata-hpt3x2n_0.3.4-3vmw.670.0.0.8169922, VMW_bootbank_ata-pata-pdc2027x_1.0-3vmw.670.0.0.8169922, VMW_bootbank_ata-pata-serverworks_0.4.3-3vmw.670.0.0.8169922, VMW_bootbank_ata-pata-sil680_0.4.8-3vmw.670.0.0.8169922, VMW_bootbank_ata-pata-via_0.3.3-2vmw.670.0.0.8169922, VMW_bootbank_block-cciss_3.6.14-10vmw.670.0.0.8169922, VMW_bootbank_char-random_1.0-3vmw.670.0.0.8169922, VMW_bootbank_ehci-ehci-hcd_1.0-4vmw.670.0.0.8169922, VMW_bootbank_hid-hid_1.0-3vmw.670.0.0.8169922, VMW_bootbank_iavmd_1.2.0.1011-2vmw.670.0.0.8169922, VMW_bootbank_ima-qla4xxx_2.02.18-1vmw.670.0.0.8169922, VMW_bootbank_ipmi-ipmi-devintf_39.1-5vmw.670.1.28.10302608, VMW_bootbank_ipmi-ipmi-msghandler_39.1-5vmw.670.1.28.10302608, VMW_bootbank_ipmi-ipmi-si-drv_39.1-5vmw.670.1.28.10302608, VMW_bootbank_iser_1.0.0.0-1vmw.670.1.28.10302608, VMW_bootbank_lpnic_11.4.59.0-1vmw.670.0.0.8169922, VMW_bootbank_lsi-msgpt2_20.00.06.00-2vmw.670.3.73.14320388, VMW_bootbank_lsi-msgpt35_09.00.00.00-5vmw.670.3.73.14320388, VMW_bootbank_lsi-msgpt3_17.00.02.00-1vmw.670.3.73.14320388, VMW_bootbank_misc-drivers_6.7.0-2.48.13006603, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.670.1.28.10302608, VMW_bootbank_ne1000_0.8.4-2vmw.670.2.48.13006603, VMW_bootbank_nenic_1.0.29.0-1vmw.670.3.73.14320388, VMW_bootbank_net-cdc-ether_1.0-3vmw.670.0.0.8169922, VMW_bootbank_net-e1000_8.0.3.1-5vmw.670.0.0.8169922, VMW_bootbank_net-e1000e_3.2.2.1-2vmw.670.0.0.8169922, VMW_bootbank_net-enic_2.1.2.38-2vmw.670.0.0.8169922, VMW_bootbank_net-fcoe_1.0.29.9.3-7vmw.670.0.0.8169922, VMW_bootbank_net-forcedeth_0.61-2vmw.670.0.0.8169922, VMW_bootbank_net-libfcoe-92_1.0.24.9.4-8vmw.670.0.0.8169922, VMW_bootbank_net-mlx4-core_1.9.7.0-1vmw.670.0.0.8169922, VMW_bootbank_net-mlx4-en_1.9.7.0-1vmw.670.0.0.8169922, VMW_bootbank_net-nx-nic_5.0.621-5vmw.670.0.0.8169922, VMW_bootbank_net-tg3_3.131d.v60.4-2vmw.670.0.0.8169922, VMW_bootbank_net-usbnet_1.0-3vmw.670.0.0.8169922, VMW_bootbank_net-vmxnet3_1.1.3.0-3vmw.670.3.89.15160138, VMW_bootbank_nfnic_4.0.0.29-0vmw.670.3.73.14320388, VMW_bootbank_nmlx4-core_3.17.13.1-1vmw.670.2.48.13006603, VMW_bootbank_nmlx4-en_3.17.13.1-1vmw.670.2.48.13006603, VMW_bootbank_nmlx4-rdma_3.17.13.1-1vmw.670.2.48.13006603, VMW_bootbank_ntg3_4.1.3.2-1vmw.670.1.28.10302608, VMW_bootbank_nvme_1.2.2.28-1vmw.670.3.73.14320388, VMW_bootbank_nvmxnet3-ens_2.0.0.21-1vmw.670.0.0.8169922, VMW_bootbank_nvmxnet3_2.0.0.29-1vmw.670.1.28.10302608, VMW_bootbank_ohci-usb-ohci_1.0-3vmw.670.0.0.8169922, VMW_bootbank_pvscsi_0.1-2vmw.670.0.0.8169922, VMW_bootbank_qflge_1.1.0.11-1vmw.670.0.0.8169922, VMW_bootbank_sata-ahci_3.0-26vmw.670.0.0.8169922, VMW_bootbank_sata-ata-piix_2.12-10vmw.670.0.0.8169922, VMW_bootbank_sata-sata-nv_3.5-4vmw.670.0.0.8169922, VMW_bootbank_sata-sata-promise_2.12-3vmw.670.0.0.8169922, VMW_bootbank_sata-sata-sil24_1.1-1vmw.670.0.0.8169922, VMW_bootbank_sata-sata-sil_2.3-4vmw.670.0.0.8169922, VMW_bootbank_sata-sata-svw_2.3-3vmw.670.0.0.8169922, VMW_bootbank_scsi-aacraid_1.1.5.1-9vmw.670.0.0.8169922, VMW_bootbank_scsi-adp94xx_1.0.8.12-6vmw.670.0.0.8169922, VMW_bootbank_scsi-aic79xx_3.1-6vmw.670.0.0.8169922, VMW_bootbank_scsi-fnic_1.5.0.45-3vmw.670.0.0.8169922, VMW_bootbank_scsi-ips_7.12.05-4vmw.670.0.0.8169922, VMW_bootbank_scsi-iscsi-linux-92_1.0.0.2-3vmw.670.0.0.8169922, VMW_bootbank_scsi-libfc-92_1.0.40.9.3-5vmw.670.0.0.8169922, VMW_bootbank_scsi-megaraid-mbox_2.20.5.1-6vmw.670.0.0.8169922, VMW_bootbank_scsi-megaraid-sas_6.603.55.00-2vmw.670.0.0.8169922, VMW_bootbank_scsi-megaraid2_2.00.4-9vmw.670.0.0.8169922, VMW_bootbank_scsi-mpt2sas_19.00.00.00-2vmw.670.0.0.8169922, VMW_bootbank_scsi-mptsas_4.23.01.00-10vmw.670.0.0.8169922, VMW_bootbank_scsi-mptspi_4.23.01.00-10vmw.670.0.0.8169922, VMW_bootbank_scsi-qla4xxx_5.01.03.2-7vmw.670.0.0.8169922, VMW_bootbank_sfvmk_1.0.0.1003-6vmw.670.3.73.14320388, VMW_bootbank_shim-iscsi-linux-9-2-1-0_6.7.0-0.0.8169922, VMW_bootbank_shim-iscsi-linux-9-2-2-0_6.7.0-0.0.8169922, VMW_bootbank_shim-libata-9-2-1-0_6.7.0-0.0.8169922, VMW_bootbank_shim-libata-9-2-2-0_6.7.0-0.0.8169922, VMW_bootbank_shim-libfc-9-2-1-0_6.7.0-0.0.8169922, VMW_bootbank_shim-libfc-9-2-2-0_6.7.0-0.0.8169922, VMW_bootbank_shim-libfcoe-9-2-1-0_6.7.0-0.0.8169922, VMW_bootbank_shim-libfcoe-9-2-2-0_6.7.0-0.0.8169922, VMW_bootbank_shim-vmklinux-9-2-1-0_6.7.0-0.0.8169922, VMW_bootbank_shim-vmklinux-9-2-2-0_6.7.0-0.0.8169922, VMW_bootbank_shim-vmklinux-9-2-3-0_6.7.0-0.0.8169922, VMW_bootbank_uhci-usb-uhci_1.0-3vmw.670.0.0.8169922, VMW_bootbank_usb-storage-usb-storage_1.0-3vmw.670.0.0.8169922, VMW_bootbank_usbcore-usb_1.0-3vmw.670.0.0.8169922, VMW_bootbank_vmkata_0.1-1vmw.670.0.0.8169922, VMW_bootbank_vmkfcoe_1.0.0.1-1vmw.670.1.28.10302608, VMW_bootbank_vmkplexer-vmkplexer_6.7.0-0.0.8169922, VMW_bootbank_vmkusb_0.1-1vmw.670.3.89.15160138, VMW_bootbank_vmw-ahci_1.2.8-1vmw.670.3.73.14320388, VMW_bootbank_xhci-xhci_1.0-3vmw.670.0.0.8169922, VMware_bootbank_cpu-microcode_6.7.0-3.77.15018017, VMware_bootbank_esx-base_6.7.0-3.89.15160138, VMware_bootbank_esx-dvfilter-generic-fastpath_6.7.0-0.0.8169922, VMware_bootbank_esx-ui_1.33.4-14093553, VMware_bootbank_esx-update_6.7.0-3.89.15160138, VMware_bootbank_esx-xserver_6.7.0-3.73.14320388, VMware_bootbank_lsu-hp-hpsa-plugin_2.0.0-16vmw.670.1.28.10302608, VMware_bootbank_lsu-intel-vmd-plugin_1.0.0-2vmw.670.1.28.10302608, VMware_bootbank_lsu-lsi-drivers-plugin_1.0.0-1vmw.670.2.48.13006603, VMware_bootbank_lsu-lsi-lsi-mr3-plugin_1.0.0-13vmw.670.1.28.10302608, VMware_bootbank_lsu-lsi-lsi-msgpt3-plugin_1.0.0-9vmw.670.2.48.13006603, VMware_bootbank_lsu-lsi-megaraid-sas-plugin_1.0.0-9vmw.670.0.0.8169922, VMware_bootbank_lsu-lsi-mpt2sas-plugin_2.0.0-7vmw.670.0.0.8169922, VMware_bootbank_lsu-smartpqi-plugin_1.0.0-3vmw.670.1.28.10302608, VMware_bootbank_native-misc-drivers_6.7.0-3.89.15160138, VMware_bootbank_rste_2.0.2.0088-7vmw.670.0.0.8169922, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.36-2.48.13006603, VMware_bootbank_vsan_6.7.0-3.89.14840357, VMware_bootbank_vsanhealth_6.7.0-3.89.14840358, VMware_locker_tools-light_11.0.1.14773994-15160134 [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_exit [root@HPE-ESXi:~] reboot |

Wat de "Image profile: VMware_ESXi_7.0.0_15843807_HPE_700.0.0.10.5.0.108_April2020_depot.zip (Build 15843807)" betreft daarentegen, bleek het niet mogelijk om zomaar even een upgrade uit te voeren van "Image profile: VMware-ESXi-6.7.0-Update3-15160138-HPE-Gen9plus-670.U3.10.5.5.25-Mar2020-depot.zip (Build 15160138)" naar HPE Customized ESXi Image 7.0;

1

2

3

4

5

6

7

8

9

| [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_enter [root@HPE-ESXi:~] esxcli software vib update --depot=/vmfs/volumes/vmNFS/ESXi-updates/VMware_ESXi_7.0.0_15843807_HPE_700.0.0.10.5.0.108_April2020_depot.zip [DependencyError] VIB HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820 requires vmkapi_2_2_0_0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820 requires com.vmware.driverAPI-9.2.2.0, but the requirement cannot be satisfied within the ImageProfile. VIB QLC_bootbank_qfle3f_1.0.75.0-1OEM.670.0.0.8169922 requires vmkapi_2_2_0_0, but the requirement cannot be satisfied within the ImageProfile. Please refer to the log file for more details. [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_exit [root@HPE-ESXi:~] reboot |

Datzelfde bleek ook toen ik de "Image profile: VMware-ESXi-7.0.0-15843807-depot.zip (Build 15843807)" probeerde te updaten over de bestaande en recent uitgerolde "Image profile: VMware-ESXi-6.7.0-Update3-15160138-HPE-Gen9plus-670.U3.10.5.5.25-Mar2020-depot.zip (Build 15160138)";

1

2

3

4

5

6

7

8

9

| [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_enter [root@HPE-ESXi:~] esxcli software vib update --depot=/vmfs/volumes/vmNFS/ESXi-updates/VMware_ESXi_7.0.0_15843807_HPE_700.0.0.10.5.0.108_April2020_depot.zip [DependencyError] VIB HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820 requires vmkapi_2_2_0_0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820 requires com.vmware.driverAPI-9.2.2.0, but the requirement cannot be satisfied within the ImageProfile. VIB QLC_bootbank_qfle3f_1.0.75.0-1OEM.670.0.0.8169922 requires vmkapi_2_2_0_0, but the requirement cannot be satisfied within the ImageProfile. Please refer to the log file for more details. [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_exit [root@HPE-ESXi:~] reboot |

Zodoende ook voor de "Image profile: VMware-ESXi-7.0.0-15843807-depot.zip (Build 15843807)";

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

| [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_enter [root@HPE-ESXi:~] esxcli software vib update --depot=/vmfs/volumes/vmNFS/ESXi-updates/VMware-ESXi-7.0.0-15843807-depot.zip [DependencyError] VIB HPE_bootbank_testevent_6.7.0.02-01.00.12.7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820 requires vmkapi_2_2_0_0, but the requirement cannot be satisfied within the ImageProfile. VIB QLC_bootbank_qfle3f_1.0.75.0-1OEM.670.0.0.8169922 requires vmkapi_2_2_0_0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_scsi-hpdsa_5.5.0.68-1OEM.550.0.0.1331820 requires com.vmware.driverAPI-9.2.2.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_ilo_670.10.2.0.2-1OEM.670.0.0.7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_conrep_6.7.0.03-04.00.34.7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_ssacli_4.17.6.0-6.7.0.7535516.hpe requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_fc-enablement_670.3.50.16-7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_oem-build_670.U3.10.5.5-7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_bootcfg_6.7.0.02-06.00.14.7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_hponcfg_6.7.0.5.5-0.18.7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. VIB HPE_bootbank_amsd_670.11.5.0-16.7535516 requires esx-version << 7.0.0, but the requirement cannot be satisfied within the ImageProfile. Please refer to the log file for more details. [root@HPE-ESXi:~] vim-cmd /hostsvc/maintenance_mode_exit [root@HPE-ESXi:~] reboot |

Inmiddels heb ik de "VMware_ESXi_7.0.0_15843807_HPE_700.0.0.10.5.0.108_April2020.iso (Build 15843807)" op een nieuwe USB-stick gezet en draaiend gekregen op de HPE Proliant MicroServer Gen8 server.

Het is trouwens goed om te weten dat de ondersteuning voor bepaalde Intel CPU's in toekomstige uitgaven van ESXi/vSphere 7.x ten einde blijkt te komen. Zo kreeg ik ook een soortgelijke melding tijdens het installeren van de laatstgenoemde customized HPE ESXi/vSphere 7.0 ISO op de USB-stick, omtrent het volgende;

Upgrades and Installations Disallowed for Unsupported CPUs

Comparing the processors supported by vSphere 6.7, vSphere 7.0 no longer supports the following processors:

Intel Family 6, Model = 2C (Westmere-EP)

Intel Family 6, Model = 2F (Westmere-EX)

During an installation or upgrade, the installer checks the compatibility of the host CPU with vSphere 7.0. If your host hardware is not compatible, a purple screen appears with an incompatibility information message, and the vSphere 7.0 installation process stops.

The following CPUs are supported in the vSphere 7.0 release, but they may not be supported in future vSphere releases. Please plan accordingly:

Intel Family 6, Model = 2A (Sandy Bridge DT/EN, GA 2011)

Intel Family 6, Model = 2D (Sandy Bridge EP, GA 2012)

Intel Family 6, Model = 3A (Ivy Bridge DT/EN, GA 2012)

AMD Family 0x15, Model = 01 (Bulldozer, GA 2012)

/f/image/3jPmdKSP39aO6qz6Rd99yWOn.png?f=fotoalbum_tile) | /f/image/aVfSLeEdK2GDisPGRq8xBfuP.png?f=fotoalbum_tile) |

Waarom nu een 5e?

Tsja.. soort appel / ei issue: ik wil 1 grote NAS maken zodat ik 3 NASjes weg kan doen. Derhalve heb ik daar minimaal 30TB voor nodig, die ik erin wil zien te krijgen. Daarna zou ik dan een 2e Exsi server er naast kunnen zetten of kunnen gaan spelen met iets anders ..

We gaan het wel zien

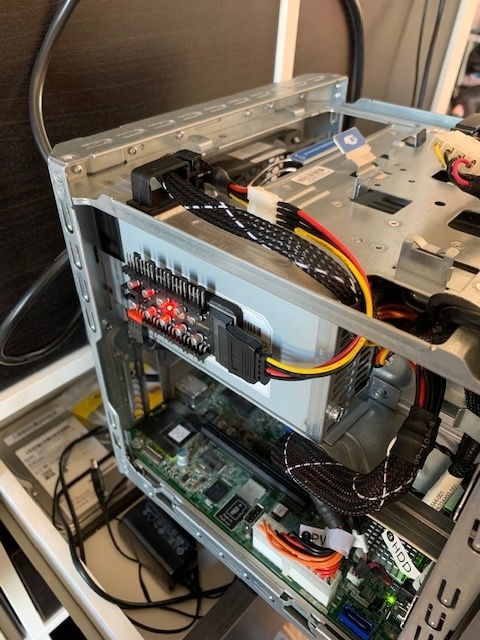

Nerd images

en de power cabel naar de fan (geen idee wat dat ding daarnaast is maar dat zat er al

There are no secrets, only information you do not yet have

Gefeliciteerd, je hebt nu de meeste Microservers van alle Tweakers denk ikzeroday schreef op zaterdag 4 april 2020 @ 20:41:

Vandaag mijn 5e .. HP gen8 binnen gekregen. Via de V&A binnen gekomen en is een van de laatste gen8jes met het nieuwe HPE logo. Andere CPU (Intel Xeon E3-1220 V2 ) zat erin en een CPU fan die ik even om moest bouwen omdat verkoper deze verbonden had op een SATA caddy voor de power. Gelukkig had ik nog een ODD naar Molex kabel liggen zodat ik alle 4 de HDDs weer kan gebruiken.

Waarom nu een 5e?

Tsja.. soort appel / ei issue: ik wil 1 grote NAS maken zodat ik 3 NASjes weg kan doen. Derhalve heb ik daar minimaal 30TB voor nodig, die ik erin wil zien te krijgen. Daarna zou ik dan een 2e Exsi server er naast kunnen zetten of kunnen gaan spelen met iets anders ..

We gaan het wel zien

Nerd images

[Afbeelding]

en de power cabel naar de fan (geen idee wat dat ding daarnaast is maar dat zat er al

[Afbeelding]

(ik heb er 'maar' 4

Op de plek waar dat fan controller bordje zit plak ik (met klitteband) de SSDs (in USB enclosure) voor OS/Boot, verbonden met de interne USB header. Ideaal plekje daarvoor. Hou je de 5e SATA aansluiting en de 4 bays vrij voor andere doeleinden.

Ook al is het maar USB 2.0, een super goedkope SSD werkt even goed lekker snel.

Dus 1 x Gen8 als NAS met waarschijnlijk 4 x 10 TB in RAID5 (?) of een equivalent. Hoe wil je dat gaan aanpakken?zeroday schreef op zaterdag 4 april 2020 @ 20:41:

Waarom nu een 5e?

Tsja.. soort appel / ei issue: ik wil 1 grote NAS maken zodat ik 3 NASjes weg kan doen. Derhalve heb ik daar minimaal 30TB voor nodig, die ik erin wil zien te krijgen. Daarna zou ik dan een 2e Exsi server er naast kunnen zetten of kunnen gaan spelen met iets anders ..

;-) Tsja.. vrouwlief stond even te kijken maar vind het best als er straks wat weg gaanQ schreef op zaterdag 4 april 2020 @ 21:16:

[...]

Gefeliciteerd, je hebt nu de meeste Microservers van alle Tweakers denk ik

(ik heb er 'maar' 4).

(op het werk heb ik er ook nog 1 staan, maar die draait Windows 2012R2

Ik heb nu gewoon een 2,5" 1TB USB disk eraan hangen. Omdat er toch alleen maar een NAS release op komt te draaien is een super snelle SSD niet echt nodig en ik had geen zin om meer als 50 euro uit te gevenOp de plek waar dat fan controller bordje zit plak ik (met klitteband) de SSDs (in USB enclosure) voor OS/Boot, verbonden met de interne USB header. Ideaal plekje daarvoor. Hou je de 5e SATA aansluiting en de 4 bays vrij voor andere doeleinden.

Ik snap nog steeds niet waarom ik bij de anderen zo moeilijk heb lopen te doen met een USB thumbdrive met daarop grub en dan doorbooten naar een 2,5" HDD die via de ODD gekoppeld zit. Nergens voor nodig

Kwam niet echt een goedkope SSD tegen onder de 50 euro ..Ook al is het maar USB 2.0, een super goedkope SSD werkt even goed lekker snel.

There are no secrets, only information you do not yet have

Dat ben ik nu dus aan het uitzoeken wat ik het beste kan doen .. Enerzijds is het even een aanslag op je rekening om 4x10TB te kopen maar dan kun je inderdaad RAID5 doen en heb je 30TB ..Q schreef op zaterdag 4 april 2020 @ 21:19:

[...]

Dus 1 x Gen8 als NAS met waarschijnlijk 4 x 10 TB in RAID5 (?) of een equivalent. Hoe wil je dat gaan aanpakken?

En dan maakt het niet echt uit of ik nu unRAID, OMV, Freenast gebruik ..

Dus tsja.. Ben nu aan het testen wat OMV5 doet met wat andere configs. Ik heb nog een 5TB, 2x2TB en wat 500GB's liggen (ongebruikt).. de eerste NAS die ik wil weg migreren heeft 5.5TB met 3.3TB vol .. (4x2TB)

daaraan gekoppeld zitten nog 2x4TB backup disks .. Dus tsja.. wat is handig ..

There are no secrets, only information you do not yet have

Ik heb 2 Microservers gen10 staan en ben wat aan het spelen met esx en Vcenter, is er iemand die een oplossing voor een 10Gb verbinding tussen de servers ?

De HP aanbevolen nic kost iets van 400 nog wat euro, dat wou ik er niet aan spenderen

Was eigenlijk op zoek naar een werkende oplossing met goedkope tweedehands nics, iemand die al iets soortgelijks werkend heeft ?

Bedankt alvast

Intel pentium pro met 8GB

2x6TB disk en 1x 4TB disk. Nu in vdev.

WD reds.

Die schijven had ik nog nieuw liggen. Ik ga er nog 2x 6TB bij kopen uhhh nu even niet

Ik heb vandaag 2x16GB memory moeten aanschaffen. Nou ja eigenlijk 16. Ben voor2x 16 gegaan.

Freenas heeft helaas niet voldoende aan 8GB. Hierom het geheugen moeten uitbreiden.

A Soldiers manual and a pair of boots.

Als die van jou is qua eigendom dan heb je er zes en ben je Microserver keizer. Maar als die van het werk is telt hij niet mee.zeroday schreef op zaterdag 4 april 2020 @ 21:41:

[...]

;-) Tsja.. vrouwlief stond even te kijken maar vind het best als er straks wat weg gaan

(op het werk heb ik er ook nog 1 staan, maar die draait Windows 2012R2

Ik had al wat USB3 enclosures met 2.5" HDDs zoals jij dat doet. Ik hoefde alleen voor 25 euro per stuk de goedkoopste SSD die ik kon vinden er in te duwen en klaar, dus voor mij relatief goedkoop.Ik heb nu gewoon een 2,5" 1TB USB disk eraan hangen. Omdat er toch alleen maar een NAS release op komt te draaien is een super snelle SSD niet echt nodig en ik had geen zin om meer als 50 euro uit te geven

Ik snap nog steeds niet waarom ik bij de anderen zo moeilijk heb lopen te doen met een USB thumbdrive met daarop grub en dan doorbooten naar een 2,5" HDD die via de ODD gekoppeld zit. Nergens voor nodig

Voor wat betreft dat scenario met een USB stick: mee eens, zou ik ook niet doen, 'onze' aanpak werkt perfect

Wil je persé als NAS een Gen8 gebruiken of zouden andere opties ook op tafel kunnen liggen. Is de nieuwe Gen8 voor de rol van ESXi server of anders?zeroday schreef op zaterdag 4 april 2020 @ 21:47:

[...]

Dat ben ik nu dus aan het uitzoeken wat ik het beste kan doen .. Enerzijds is het even een aanslag op je rekening om 4x10TB te kopen maar dan kun je inderdaad RAID5 doen en heb je 30TB ..

En dan maakt het niet echt uit of ik nu unRAID, OMV, Freenast gebruik ..

Dus tsja.. Ben nu aan het testen wat OMV5 doet met wat andere configs. Ik heb nog een 5TB, 2x2TB en wat 500GB's liggen (ongebruikt).. de eerste NAS die ik wil weg migreren heeft 5.5TB met 3.3TB vol .. (4x2TB)

daaraan gekoppeld zitten nog 2x4TB backup disks .. Dus tsja.. wat is handig ..

[ Voor 26% gewijzigd door Q op 04-04-2020 22:50 ]

Mellanox Connectx-3 zou ik even gaan Googlen. Geen ervaring mee, maar die overweeg ik ook.Yens schreef op zaterdag 4 april 2020 @ 22:21:

Hallo,

Ik heb 2 Microservers gen10 staan en ben wat aan het spelen met esx en Vcenter, is er iemand die een oplossing voor een 10Gb verbinding tussen de servers ?

De HP aanbevolen nic kost iets van 400 nog wat euro, dat wou ik er niet aan spenderenVeel low profile nic's zouden moeten werken, echter hoor ik weer verhalen over een te grote warmte ontwikkeling met daarna weer errors in de server.

Was eigenlijk op zoek naar een werkende oplossing met goedkope tweedehands nics, iemand die al iets soortgelijks werkend heeft ?

Bedankt alvast

[ Voor 89% gewijzigd door Zenix op 04-04-2020 22:50 ]

Ik heb er zelf geen ervaring mee maar ik zie geen reden waarom 10Gbit geen optie is. Je kunt kiezen uit 10Gbit op basis van UTP of SFP slots. Met een SFP slot moet je dan nog wel een SFP kabel kopen (koper) om een point-to-point verbinding te maken / of SFP+ modules met glas of UTP. Check wel of de gekozen kaart compatibel is met ESXi (of je moet passthrough willen doen naar een VM).Yens schreef op zaterdag 4 april 2020 @ 22:21:

Hallo,

Ik heb 2 Microservers gen10 staan en ben wat aan het spelen met esx en Vcenter, is er iemand die een oplossing voor een 10Gb verbinding tussen de servers ?

De HP aanbevolen nic kost iets van 400 nog wat euro, dat wou ik er niet aan spenderenVeel low profile nic's zouden moeten werken, echter hoor ik weer verhalen over een te grote warmte ontwikkeling met daarna weer errors in de server.

Was eigenlijk op zoek naar een werkende oplossing met goedkope tweedehands nics, iemand die al iets soortgelijks werkend heeft ?

Bedankt alvast

Worst-case moet je een kleine fan monteren op je 10Gbit kaart, die stroom kun je van de floppy connector aftappen als je die niet gebruikt.

Telt niet meeQ schreef op zaterdag 4 april 2020 @ 22:44:

[...]

Als die van jou is qua eigendom dan heb je er zes en ben je Microserver keizer. Maar als die van het werk is telt hij niet mee.

[...]

Persé is een groot woord, maar ik vind de formfactor gewoonweg goed. ook prijstechnisch is het zeer goed te doen. Voor mezelf hoef ik geen +100MB/s NAS te hebben. Betrouwbaarheid is voor mij belangrijkste.Wil je persé als NAS een Gen8 gebruiken of zouden andere opties ook op tafel kunnen liggen. Is de nieuwe Gen8 voor de rol van ESXi server of anders?

Doel is denk ik uiteindelijk een van de Celerons als NAS te gebruiken. Tenzij de performance van de huidige dusdanig is dat ik denk: het zou zonde zijn om het om te zetten.

There are no secrets, only information you do not yet have

Je hebt je vrouw wel verteld dat je wat stroom verbruik betreft beter 20 van die NAS-jes kunt hebben, toch!? 😋

Heb 3 Microservers Gen8 met dikke(re) Xeon's erin, een 5-bay Synology en een 4-bay Qnap en ik kan je vertellen dat ik graag zonnepanelen wil hebben ter compensatie 😎

Overigens van de week uit één Gen8 MS een SmartArray p212 controller gehaald vanwege die echt niet meer in ESXi 6.5 of hoger te gebruiken was. Draait nu op AHCI en alle SSD's als gescheiden DS wat voor deze machine voldoende is. Draai voor het eerst een niet HPe ESXi image, de 6.7u3 van dit jaar.

Er zijn nog geen officiële/geteste dims uit zo ver ik begrijp.

Bij aanschaffen kwam ik de website servethehome uit.

Ze hebben onlangs een blog gepost over het uitbreiden van de Microserver G10+

https://www.servethehome....mate-customization-guide/

Ze hebben daar ook getest met 2x 32GB dimms. op de Xeon Processor. en dat werkte

Ik heb dus gekeken naar crucial 16GB ECC op 2666, CL19. Informatique had er nog 2 liggen die heb ik opgehaald. Ze zijn niet de goedkoopste scheelde 10 tientje met de goedkoopste. Maarja. Of een week wachten of gelijk doorgaan was de keuze voor nu iets makkelijker.Technically, the Intel Xeon E-2200 series supports 32GB Unbuffered ECC memory in each DIMM slot and up to 2 DIMMs per channel. There are only two slots on the MSG10+ so we wanted to do a quick matrix of 4, 8, 16, and 32GB modules in ECC and non-ECC configurations.

For your reference, we were using 32GB DDR4 PC4-21300 / DDR4-2666, CL19, Dual Ranked, x8, Unbuffered ECC and non-ECC DIMMs from Crucial in our testing on the 32GB sizes.

CT16G4WFD8266

Ik vraag me alleen iets af.. De laatste PC die ik ooit zelf heb gebouwd is een Pentium 4 3Ghz met 4Gb geheugen op een Asus bordje.. anyway.. om dual channel te gebruiken had je gesyncte DIMS nodig.. De dims die ik nu heb zijn niet als package verkocht.. Om goed dual channel te kunnen gebruiken heb je dan nog steeds een synced set nodig of maakt dat niet meer zo veel uit? Ik ben momenteel tevreden met wat ik heb.....

A Soldiers manual and a pair of boots.

Stroomverbruik vind ik niet zo interessant. Ons huis kent alleen maar stroom en geen gas. En ja we zijn bezig om te kijken naar zonnepanelenrookie no. 1 schreef op zondag 5 april 2020 @ 09:35:

@zeroday

Je hebt je vrouw wel verteld dat je wat stroom verbruik betreft beter 20 van die NAS-jes kunt hebben, toch!? 😋

Heb 3 Microservers Gen8 met dikke(re) Xeon's erin, een 5-bay Synology en een 4-bay Qnap en ik kan je vertellen dat ik graag zonnepanelen wil hebben ter compensatie 😎

Overigens van de week uit één Gen8 MS een SmartArray p212 controller gehaald vanwege die echt niet meer in ESXi 6.5 of hoger te gebruiken was. Draait nu op AHCI en alle SSD's als gescheiden DS wat voor deze machine voldoende is. Draai voor het eerst een niet HPe ESXi image, de 6.7u3 van dit jaar.

Ik heb net hier een USB disk moeten redden met backups. Op eens allerlei errors .. een fsck geeft clean aan en nu doet ie het weer, maar USB en de Gen8 .. mwoah ik weet het zo net nog niet hoe stabiel dat is.

There are no secrets, only information you do not yet have

Die Celerons zijn prima in staat om je Gigabit dicht te trekken dus dat plan gaat prima werken. Of je nu ZFS, MDADM of iets anders gebruikt, ik verwacht daar geen enkele problemen van. Als je er niet nog 60.000 andere software pakketten er naast ga draaien, zoals sommigen hier doenzeroday schreef op zondag 5 april 2020 @ 08:44:

Persé is een groot woord, maar ik vind de formfactor gewoonweg goed. ook prijstechnisch is het zeer goed te doen. Voor mezelf hoef ik geen +100MB/s NAS te hebben. Betrouwbaarheid is voor mij belangrijkste.

Doel is denk ik uiteindelijk een van de Celerons als NAS te gebruiken. Tenzij de performance van de huidige dusdanig is dat ik denk: het zou zonde zijn om het om te zetten.

Fix VMWare ESXi 6.* slow disk performance on HP b120i controllerHaTe schreef op zaterdag 4 april 2020 @ 14:59:

[...]

Lijkt wel vergelijkbaar inderdaad.

@marcel19 , heb jij dit al opgelost?

Dit is een bekende driver kwestie met VMware ESXi/vSphere schijnbaar, ik vermoed dat het dan ook voor Proxmox Virtual Environment hetzelfde zou moeten zijn.

[ Voor 27% gewijzigd door Indir op 05-04-2020 12:40 ]

How to connect 4 extra HDDs to a microserver

Ik adviseer mensen om dit nooit, maar dan ook nooit te doen.*De video is niet meer online*

[ Voor 33% gewijzigd door Q op 25-08-2020 22:20 ]

Ik gebruik AHCI, niet de raid controller.Indir schreef op zondag 5 april 2020 @ 12:35:

[...]

Fix VMWare ESXi 6.* slow disk performance on HP b120i controller

Dit is een bekende driver kwestie met VMware ESXi/vSphere schijnbaar, ik vermoed dat het dan ook voor Proxmox Virtual Environment hetzelfde zou moeten zijn.

Volgens mij heb ik het ook opgelost met een van deze 2 isntellingen:

in /etc/modprobe.d/zfs.conf:

1

2

| options zfs zfs_arc_max=469762048 options zfs zfs_arc_min=134217728 |

En in de BIOS heb ik HDD write cache ingeschakeld. Er komt een dikke warning dat dit corruptie kan veroorzaken, maar dat geldt volgens mij niet in het geval van ZFS.

Wat ik nog wel gek vond is dat ik het volgende tijdens boot voorbij zag komen:

resultaat:no caching mode page found

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

| pool alloc free read write read write ---------- ----- ----- ----- ----- ----- ----- rpool 2.91T 11.6T 132 3.91K 867K 168M rpool 2.91T 11.6T 351 0 2.14M 0 rpool 2.91T 11.6T 813 2.45K 3.72M 91.2M rpool 2.91T 11.6T 952 3.12K 4.24M 96.7M rpool 2.91T 11.6T 161 3.74K 890K 155M rpool 2.91T 11.6T 623 0 3.07M 0 rpool 2.91T 11.6T 229 4.53K 1.11M 171M rpool 2.91T 11.6T 186 4.06K 1.19M 171M rpool 2.91T 11.6T 134 15 1.55M 63.9K rpool 2.91T 11.6T 209 4.03K 1.16M 171M rpool 2.91T 11.6T 569 0 2.53M 0 rpool 2.91T 11.6T 492 2.71K 2.36M 108M rpool 2.91T 11.6T 425 1.77K 2.10M 68.7M rpool 2.91T 11.6T 118 4.02K 1.06M 167M rpool 2.91T 11.6T 24 790 322K 26.8M rpool 2.91T 11.6T 193 3.26K 1015K 143M rpool 2.91T 11.6T 363 4.30K 1.97M 170M rpool 2.91T 11.6T 387 0 1.84M 0 rpool 2.91T 11.6T 501 4.48K 2.52M 163M rpool 2.91T 11.6T 702 4.15K 3.15M 152M rpool 2.91T 11.6T 390 913 2.25M 27.3M rpool 2.91T 11.6T 311 4.28K 1.49M 170M rpool 2.91T 11.6T 698 15 3.38M 63.9K rpool 2.91T 11.6T 384 4.45K 1.85M 170M rpool 2.91T 11.6T 766 1000 3.93M 30.8M rpool 2.91T 11.6T 53 3.18K 439K 138M rpool 2.91T 11.6T 312 0 1.91M 0 rpool 2.91T 11.6T 453 3.85K 2.11M 172M rpool 2.91T 11.6T 571 2.21K 2.52M 90.9M rpool 2.91T 11.6T 925 2.37K 4.35M 86.6M rpool 2.91T 11.6T 193 4.21K 1.28M 166M rpool 2.91T 11.6T 1.04K 2.03K 4.53M 78.3M rpool 2.91T 11.6T 487 2.53K 2.43M 93.1M rpool 2.91T 11.6T 584 1.43K 2.65M 55.3M rpool 2.91T 11.6T 160 4.73K 867K 181M rpool 2.91T 11.6T 82 2.72K 723K 105M rpool 2.91T 11.6T 279 4.60K 1.57M 172M rpool 2.91T 11.6T 517 15 2.82M 63.9K rpool 2.91T 11.6T 179 4.54K 871K 171M rpool 2.91T 11.6T 488 4.54K 2.36M 170M rpool 2.91T 11.6T 101 4.89K 1.17M 171M rpool 2.91T 11.6T 61 4.03K 631K 171M rpool 2.91T 11.6T 40 3.82K 683K 169M rpool 2.91T 11.6T 270 220 1.27M 1.96M rpool 2.91T 11.6T 581 769 2.55M 29.6M rpool 2.91T 11.6T 195 3.47K 1.06M 142M rpool 2.91T 11.6T 1.08K 1.39K 5.33M 48.8M rpool 2.91T 11.6T 484 3.37K 2.20M 123M rpool 2.91T 11.6T 262 4.36K 1.12M 171M |

io delay schommelt nog rond de 30%. RAM usage is wel laag nu, 3,5GB, maar dat mag wel weer wat hoger dan. Ook wacht ik op RAM sticks van 2x 8GB welke onderweg zijn

[ Voor 65% gewijzigd door HaTe op 05-04-2020 12:58 ]

WP: ME PUHZ-SW75YAA + ERST30D-VM2ED | Solar: 17x TSM-340-DE06M.08 (5780Wp ~6200kWh), Azimuth 179°, Hellingshoek: 34° | PC specs

Die opties heb ik laatst ook ingesteld. Ik moest na het aanpassen van die file nog wel even het volgende command uitvoeren:HaTe schreef op zondag 5 april 2020 @ 12:55:

[...]

Ik gebruik AHCI, niet de raid controller.

Volgens mij heb ik het ook opgelost met een van deze 2 isntellingen:

in /etc/modprobe.d/zfs.conf:

code:

En in de BIOS heb ik HDD write cache ingeschakeld. Er komt een dikke warning dat dit corruptie kan veroorzaken, maar dat geldt volgens mij niet in het geval van ZFS.

Wat ik nog wel gek vond is dat ik het volgende tijdens boot voorbij zag komen:

[...]

resultaat:

code:

io delay schommelt nog rond de 30%. RAM usage is wel laag nu, 3,5GB, maar dat mag wel weer wat hoger dan. Ook wacht ik op RAM sticks van 2x 8GB welke onderweg zijn

1

| update-initramfs -u |

Dit verhielp bij mij het een dagelijkse crash tijdens de maintenance van Plex.

Ik zie op de Gen10 trouwens geen optie om de HDD write cache uit te schakelen? Kan dat kloppen?

En nog een dingetje, als ik iommu inschakel, krijg ik bij het opstarten "ata9.00 revalidation failed errno=-5" foutmeldingen en is de zfs pool weg. Iemand een idee hoe dit in te schakelen is met behoud van de zpool?

En aangezien ik geen devices direct koppel aan een VM, dan is dat ook eigenlijk helemaal niet nodig toch?

Hmm, dit dus: https://forum.proxmox.com...ognize-hdd-on-sata.60259/

Edit: dit lost het bij mij ook op

ik zat hieraan te denkenQ schreef op zondag 5 april 2020 @ 12:53:How to connect 4 extra HDDs to a microserver

Ik adviseer mensen om dit nooit, maar dan ook nooit te doen.

YouTube: Frankenstein: or how to connect 4 extra drives to A HP Microserver

https://homeservershow.co...internal-turned-external/

There are no secrets, only information you do not yet have

Draadloos vanmiddag 60MB/sQ schreef op zondag 5 april 2020 @ 12:22:

[...]

Die Celerons zijn prima in staat om je Gigabit dicht te trekken dus dat plan gaat prima werken. Of je nu ZFS, MDADM of iets anders gebruikt, ik verwacht daar geen enkele problemen van. Als je er niet nog 60.000 andere software pakketten er naast ga draaien, zoals sommigen hier doen

dat ging ok.

Openmediavault manier snap ik nu wel

Unraid is niet mijn ding heb ik gemerkt.

En of ik dan nog freenas moet proberen .. uhm.. freebsd is niet mijn ding

dus ik denk dat ik bij RAID5 blijf op de OMV

There are no secrets, only information you do not yet have

Dat is eigenlijk de meest realistische oplossing (dit is exact hetzelfde als mijn Gen8 Frankenstein hack), maar nog steeds een beetje een smerige oplossing, omdat die ICY DOCK nog ergens ook stroom vandaan moet halen.zeroday schreef op zondag 5 april 2020 @ 14:32:

[...]

ik zat hieraan te denken

https://homeservershow.co...internal-turned-external/

Je wilt eigenlijk voorkomen dat je ooit vergeet om dat externe ding aan te zetten als je Gen8 aan gaat, want dat zou wel eens vervelende gevolgen kunnen hebben (valt wel mee, maar je snapt het punt).

Ik zou er zelf dan een mooi DIY hobby project van maken, waarbij je van die externe enclosure ook een mooi afgeschermd doosje maakt.

En als je dat doet, koop dan een SAS HBA met 2 x externe connectors, want dan kun je twee van dit soort 'bochels' er aan hangen

Dat lijkt mij een redelijke oplossing, het gaat er om dat jij in staat bent om ook de shit op te lossen als er iets mis gaat.zeroday schreef op zondag 5 april 2020 @ 14:34:

[...]

Draadloos vanmiddag 60MB/s

dat ging ok.

Openmediavault manier snap ik nu wel

Unraid is niet mijn ding heb ik gemerkt.

En of ik dan nog freenas moet proberen .. uhm.. freebsd is niet mijn ding

dus ik denk dat ik bij RAID5 blijf op de OMV

Om die reden gebruik ik dus ook geen FreeNAS of FreeBSD, want ik heb onvoldoende ervaring met FreeBSD.

ThxZenix schreef op zaterdag 4 april 2020 @ 22:48:

@To_Tall Welke modules heb je erin gedaan?

[...]

Mellanox Connectx-3 zou ik even gaan Googlen. Geen ervaring mee, maar die overweeg ik ook.

Die gebruik ik (floppyconnector, voor de SSD bovenin geloof ikQ schreef op zaterdag 4 april 2020 @ 22:54:

[...]

Ik heb er zelf geen ervaring mee maar ik zie geen reden waarom 10Gbit geen optie is. Je kunt kiezen uit 10Gbit op basis van UTP of SFP slots. Met een SFP slot moet je dan nog wel een SFP kabel kopen (koper) om een point-to-point verbinding te maken / of SFP+ modules met glas of UTP. Check wel of de gekozen kaart compatibel is met ESXi (of je moet passthrough willen doen naar een VM).

Worst-case moet je een kleine fan monteren op je 10Gbit kaart, die stroom kun je van de floppy connector aftappen als je die niet gebruikt.

dat is zo'n beetje wat ik heb gedaan : dijkmane in "Het grote HP Proliant Microserver topic"zeroday schreef op zondag 5 april 2020 @ 14:32:

[...]

ik zat hieraan te denken

https://homeservershow.co...internal-turned-external/

werkt nog steeds prima.

in totaal 14 disks aan de MS-G8

specs : wil je niet weten

Kijk .. Kijk .. l;) enige wat ik mis bij al die externe enclosures is eigenlijk inderdaad een eigen stroom voorziening. Daar moet je dan altijd nog een eigen oplossing voor zien te vinden.dijkmane schreef op maandag 6 april 2020 @ 09:08:

[...]

dat is zo'n beetje wat ik heb gedaan : dijkmane in "Het grote HP Proliant Microserver topic"

werkt nog steeds prima.

in totaal 14 disks aan de MS-G8

Dan wordt een bijv. een P222 erin, een kabel van mini-SAS naar 4xSATA

naar de enclosure en dan heb je dus 8 HDD's .. Nu nog stroom ..

Kijk .. dat is wat ik wil

Meanwhile ..

[ Voor 8% gewijzigd door zeroday op 06-04-2020 13:07 ]

There are no secrets, only information you do not yet have

Wel even opletten dat je een kale kaart hebt, dus niet een uit bijvoorbeeld een Dell doos komt; de firmware kan je dan vaak niet updaten tenzij de kaart in een (in dit geval) Dell zit. En zijn 4 modellen; (1 of 2x) SFP+ en (1 of 2x) QSFP waarbij de single de kleinste en zuinigste kaart is.Zenix schreef op zaterdag 4 april 2020 @ 22:48:

@To_Tall Welke modules heb je erin gedaan?

[...]

Mellanox Connectx-3 zou ik even gaan Googlen. Geen ervaring mee, maar die overweeg ik ook.

Uiteindelijk kwam ik een X11SDV-8C-TP8F boardje tegen (dus met een Xeon D-2146NT) op eBay voor weinig. Heb een 2TB Samsung 970 Evo en een berg SSD's klaar liggen maar ... nog even een behuizing regelen om alles in te kunnen doen.

SHUT UP!Q schreef op zondag 5 april 2020 @ 12:53:How to connect 4 extra HDDs to a microserver

Ik adviseer mensen om dit nooit, maar dan ook nooit te doen.

YouTube: Frankenstein: or how to connect 4 extra drives to A HP Microserver

Gewoon 8x 2,5" SAS erin prakken met een P420 en 2x een SFF8087 naar 4x SFF8482; werkt kan ik je vertellen en dan kan je kap ook nog dicht, alleen wordt alles wel een bietje warrem.

[ Voor 22% gewijzigd door Uberprutser op 06-04-2020 17:44 ]

As you may already have guessed, following the instructions may break your system and you are on your own to fix it again.

Grappig, heb je daar iets over online staan of hier in het forum? (Foto's?) Ik probeer even te snappen hoe die 2.5" drives er dan in zitten.Uberprutser schreef op maandag 6 april 2020 @ 17:33:

SHUT UP!

Gewoon 8x 2,5" SAS erin prakken met een P420 en 2x een SFF8087 naar 4x SFF8482; werkt kan ik je vertellen en dan kan je kap ook nog dicht, alleen wordt alles wel een bietje warrem.

[ Voor 7% gewijzigd door Q op 06-04-2020 18:45 ]

Maakt niet uit, dual channel kan je zelfs draaien met dimms van verschillende fabrikanten.To_Tall schreef op zondag 5 april 2020 @ 10:14:

[...]

CT16G4WFD8266

Ik vraag me alleen iets af.. De laatste PC die ik ooit zelf heb gebouwd is een Pentium 4 3Ghz met 4Gb geheugen op een Asus bordje.. anyway.. om dual channel te gebruiken had je gesyncte DIMS nodig.. De dims die ik nu heb zijn niet als package verkocht.. Om goed dual channel te kunnen gebruiken heb je dan nog steeds een synced set nodig of maakt dat niet meer zo veel uit? Ik ben momenteel tevreden met wat ik heb.....

die externe enclosure is eigenlijk een interne, geschikt om te plaatsen in een 3 x 5.25 inch drive bayszeroday schreef op maandag 6 april 2020 @ 09:30:

[...]

Kijk .. Kijk .. l;) enige wat ik mis bij al die externe enclosures is eigenlijk inderdaad een eigen stroom voorziening. Daar moet je dan altijd nog een eigen oplossing voor zien te vinden.

Dan wordt een bijv. een P222 erin, een kabel van mini-SAS naar 4xSATA

naar de enclosure en dan heb je dus 8 HDD's .. Nu nog stroom ..

Kijk .. dat is wat ik wil

de voeding komt dan dus van de PC zelf.

ik ben daarom ook lang op zoek geweest naar een behuizing met 3 x 5.25 inch drive bays.

van die externe CD brander torens ofzo, maar daar zit dan weer een voedinkje in dat geen 4x SATA drive trekt.

daarom dus zelf wat gemaakt, de voeding is een 12V 8A en 5V 6A en dus ruim voldoende voor 4 WD reds.

de controllers in de Microserver en ESXi kunnen het allemaal prima aan.

specs : wil je niet weten

| # | Category | Product | Prijs | Subtotaal |

| 1 | Processors | Intel Core i3-9100F (SRF7W) Tray | € 71,81 | € 71,81 |

| 2 | Geheugen intern | Crucial CT16G4WFD8266 | € 114,33 | € 228,66 |

| 1 | Servers | HPE ProLiant MicroServer Gen10 Plus (P16005-421) | € 523,93 | € 523,93 |

| Bekijk collectie Importeer producten | Totaal | € 824,40 | ||

De i3-9100F tray is een goedkope upgrade voor die 75 euro, qua performance vergelijkbaar met de Xeon versie. Het geheugen is op Amazon overigens een stuk goedkoper. Nu heb ik dus voor dezelfde prijs als de Xeon versie 32GB geheugen en een i3-9100F.

ben dus zoekende naar zo'n oplossing, want zo handig om iets zelf te bouwen .. dat net nietdijkmane schreef op maandag 6 april 2020 @ 20:37:

[...]

die externe enclosure is eigenlijk een interne, geschikt om te plaatsen in een 3 x 5.25 inch drive bays

de voeding komt dan dus van de PC zelf.

ik ben daarom ook lang op zoek geweest naar een behuizing met 3 x 5.25 inch drive bays.

van die externe CD brander torens ofzo, maar daar zit dan weer een voedinkje in dat geen 4x SATA drive trekt.

daarom dus zelf wat gemaakt, de voeding is een 12V 8A en 5V 6A en dus ruim voldoende voor 4 WD reds.

de controllers in de Microserver en ESXi kunnen het allemaal prima aan.

There are no secrets, only information you do not yet have

Na het verwijderen is het direct weg.

Ik las dat dit kan voorkomen bij 3rd party hardware. Iemand ervaring mee?

Achteraf gezien had dat een slimmere zet geweest..Zenix schreef op maandag 6 april 2020 @ 21:08:

Ik heb de Gen10 Plus ook gekocht:

# Category Product Prijs Subtotaal 1 Processors Intel Core i3-9100F (SRF7W) Tray € 71,81 € 71,81 2 Geheugen intern Crucial CT16G4WFD8266 € 114,33 € 228,66 1 Servers HPE ProLiant MicroServer Gen10 Plus (P16005-421) € 523,93 € 523,93 Bekijk collectie

Importeer productenTotaal € 824,40

De i3-9100F tray is een goedkope upgrade voor die 75 euro, qua performance vergelijkbaar met de Xeon versie. Het geheugen is op Amazon overigens een stuk goedkoper. Nu heb ik dus voor dezelfde prijs als de Xeon versie 32GB geheugen en een i3-9100F.

Ik ga nu even doorsparen in september zal er een nieuw proc in zitten.. Pentium Gold is toch wel redelijk beperkt merk ik.

Heb 1 VM draaien met Docker... Voor het serveren van wat websites.

Heb 1 VM draaien als Media Center (Plex, Sonarr, Radarr, NZBget)

En dan natuurlijk de storage.

Zeker als De Media Server aan het downloaden is piekt de Proc op 60% bij uitpakken 90%.. Hij heeft nu 4 CPU's toegewezen gekregen. Denk dat ik dat terug ga brengen naar 3 of 2.

Gelukkig worden de downloads voornamelijk alleen snachts gedaan.. dus heb ik er zelf niet veel problemen mee. Anyway's Ook mijn advies.. Ga niet voor de Pentium Gold Versie.. De is toch net iets te beperkt.

Reden dat ik nu niet upgrade.. Heb ruim 400 euro al dan niet meer uitgegeven aan HDD's... geld is volgens de vrouw des huizes.. eventjes op

[ Voor 55% gewijzigd door To_Tall op 07-04-2020 08:30 ]

A Soldiers manual and a pair of boots.

Verwijderd

Ik wil mijn nuc gaan vervangen voor wat krachtigers.Twijfel nog tussen de NUC9 Pro of de Gen10+ met een i7-8700 (die heb ik toch nog liggen).

Er zit 1 FAN in die het systeem koel houd.Verwijderd schreef op dinsdag 7 april 2020 @ 08:49:

@To_Tall Maakt de Gen10+ veel herrie?

Ik wil mijn nuc gaan vervangen voor wat krachtigers.Twijfel nog tussen de NUC9 Pro of de Gen10+ met een i7-8700 (die heb ik toch nog liggen).

De fan ansich vind ik wel mee vallen. Je hoort hem wel.. Denk dat hij niet meer herrie maakt dan een tower model PC met stock INTEL CPU cooler.

Verder afhankelijk van de disks natuurlijk.. De WD RED 6TB zijn niet de stilste vind ik. Die hoor je wel. Dat is de meeste herrie dat ik mee maak als de server naast me staat.

Momenteel staat de Server op een logeer kamertje aka boekenkast kamer, headless. Als jij een beetje herrie maakt is dat niet zo heel erg.

A Soldiers manual and a pair of boots.

Hij is wel wat luider dan een nuc, mits de nuc niet al aan het blazen was en koel liep. Ik hoor een zachte zoem van de fan verder niks. De fan kan wel enorm luid worden (hoor je bij boot) dus als je de machine flink aan het werk gaat zetten dan is het niveautje serverruimte..Verwijderd schreef op dinsdag 7 april 2020 @ 08:49:

@To_Tall Maakt de Gen10+ veel herrie?

Ik wil mijn nuc gaan vervangen voor wat krachtigers.Twijfel nog tussen de NUC9 Pro of de Gen10+ met een i7-8700 (die heb ik toch nog liggen).

Qua stroom ben ik van VMWare op een nuc met 14-20 watt nu op Server 2016 met 22-26 watt. Met het P16006-421 model.

Verwijderd

Dan zal het waarschijnlijk wel meevallen, denk ik. Het voordeel van Gen10+ tegenover de NUC is toch wel de iLO mogelijkheid gezien die headless komt te draaien.CopyCatz schreef op dinsdag 7 april 2020 @ 09:20:

[...]

Hij is wel wat luider dan een nuc, mits de nuc niet al aan het blazen was en koel liep. Ik hoor een zachte zoem van de fan verder niks. De fan kan wel enorm luid worden (hoor je bij boot) dus als je de machine flink aan het werk gaat zetten dan is het niveautje serverruimte..

Qua stroom ben ik van VMWare op een nuc met 14-20 watt nu op Server 2016 met 22-26 watt. Met het P16006-421 model.

yup, alleen is de Ilo kit zeer moeilijk verkrijgbaar, hoort voor rond de 35 te gaan, maar alleen leverbaar in de VS of DE voor het driedubbele..Verwijderd schreef op dinsdag 7 april 2020 @ 09:39:

[...]

Dan zal het waarschijnlijk wel meevallen, denk ik. Het voordeel van Gen10+ tegenover de NUC is toch wel de iLO mogelijkheid gezien die headless komt te draaien.

Wat wel grappig is is dat de kabelklem achterop bij mij direct brak toen ik hem wilde dichtklikken, en nu krijg ik er een opgestuurd uit Taiwan... Naja er vliegt toch bijna niks hoef ik me niet schuldig te voelen

Of misschien juist wel, zodat je hem kan upgradenTo_Tall schreef op dinsdag 7 april 2020 @ 08:27:

[...]