Ook mijn bijdrage maar eens leveren aan dit topic.

Hypervisor

Ik heb gekozen voor VMWare ESXi 5.1 aangezien ik dit met grote regelmaat tegenkom op het werk. VMWare heeft naar mijn mening het meeste ervaring met bare metal hypervisors en voor mij het meest geschikt. Ook het feit dat ESXi memory overcommitment heeft maakt de keuze erg eenvoudig. (ik zit op dit moment op zo'n 30% overcommitment zonder dat ik daarvan iets merk)

Hardware

Ik had nog een aantal onderdelen die gebruikt zijn voor de setup. (eigenlijk alleen netwerkkaart en de 400GB schijven (oeps, zie nu dat het 1 x 250GB en 1 x 400GB is)) Verder een nieuwe computer aangeschaft voor de server. Het moederbord heeft een on-board netwerkkaart die ik op dit moment niet gebruik. Ik was oorspronkelijk van plan om deze voor de VPN server te gebruiken, maar daar ben ik vanaf gestapt aangezien L2TP erg gemakkelijk door mijn router door te sturen is. Voordeel is dat ik nu geen Windows server 'naakt' aan het internet heb hangen. Verder heb ik meer dan genoeg aan de 4 NIC's die er nu inzitten.

Ik wilde er graag zoveel mogelijk geheugen in zonder direct aan heel erg dure hardware te moeten, dus ik heb gekozen voor een i5 quadcode op 3.3 GHz met 32GB geheugen. Voor mij meer dan zat, alleen beetje jammer dat er niet meer geheugen bijgeprikt kan worden in de toekomst.

Ik heb een Dell PowerConnect 2724 24 poort GBit switch waarmee de server aan de rest van het netwerk geknoopt wordt. Voor opslag heb ik een Synology 1010+ (5 x 1.5TB) waar de nodige iSCSI targets op staan.

De ESX server heeft vier netwerkkaarten die op de volgende manier worden gebruikt:

1. VM Network

2. iSCSI Network

3. Servers Network

4. Clients Network

De Synology heeft 2 GBit NIC's waarvan er eentje gebruikt wordt voor iSCSI targets, en de andere voor het overige verkeer.

Prestaties zijn op deze manier erg prettig, ik heb wat snelheid op het netwerk niets te klagen.

| # | Product | Prijs | Subtotaal |

| 1 | Cooler Master CM 690 II Advanced (USB 3.0 version) | € 101,48 | € 101,48 |

| 2 | Intel Gigabit CT Desktop Adapter | € 25,39 | € 50,78 |

| 1 | Intel PRO/1000 PT Dual Port Server Adapter (2x1000Mbps, PCI-e 4x) | € 154,50 | € 154,50 |

| 2 | Samsung SpinPoint T133 HD401LJ, 400GB | € 0,- | € 0,- |

| 1 | Western Digital Green WD20EARX, 2TB | € 89,90 | € 89,90 |

| 1 | Samsung SH-222BB Zwart | € 13,24 | € 13,24 |

| 2 | GeIL Evo Corsa GOC316GB2133C10AQC | € 114,20 | € 228,40 |

| 1 | Intel Core i5 3550 Boxed | € 180,- | € 180,- |

| 1 | OCZ ModXStream Pro 500W | € 56,- | € 56,- |

| 1 | Intel 330 120GB | € 77,- | € 77,- |

| 1 | MSI Z77A-GD55 | € 119,- | € 119,- |

Bekijk collectie

Importeer producten | Totaal | € 1.070,30 |

Virtuele machines

De meeste VM's zijn Windows servers die ik gebruik om ervaring met de produkten op te doen. (Licenties zijn overigens netjes gedekt door het MSDN abonnement dat ik zelf heb, handig, geen gezeur met activatie

) Alle VM's opnoemen is wat saai, dus ik zal me beperken tot de 'belangrijke' VM's die erop draaien.

| OS/Appliance | Functie |

| Windows 2008R2 Enterprise | Domain Controller 1, DHCP, DNS, NPS |

| Windows 2008R2 Enterprise | Domain Controller 2, DHCP, DNS |

| Windows 2008R2 Datacenter | Cluster Node 1, SQL, DTC |

| Windows 2008R2 Datacenter | Cluster Node 2, SQL, DTC |

| Windows 2008R2 Enterprise | SQL Server 2012 |

| Windows 2008R2 Enterprise | TFS Server 2012 |

| Windows 2008R2 Enterprise | Management tools, WSUS, backup |

| Windows 2008R2 Enterprise | RRAS, standalone |

| Windows 2012 Standard | Terminal Server |

| Windows 7 Ultimate | Download machine, algemene client |

| Debian Linux | Squid, Nagios |

Foto's

Binnenkant van de kast, ben geen modder maar toch redelijk netjes dacht ik

De printer, ESX server en NAS (let niet op het stof)

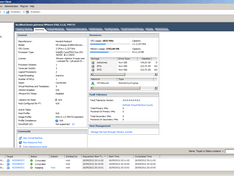

En een screenshot van de client....

Overig

Ik heb gekozen voor het MSI moederbord omdat dit VT-d zou ondersteunen. Helaas lijkt dat niet helemaal lekker te gaan... Nadat ik passthrough voor de onboard netwerkkaart had eengezet liep de machine snoeihard vast. Geen idee of dat ook de directe oorzaak is, maar ik heb VT-d in de BIOS uitgezet en gebruik het dus niet. De onboard netwerkkaart is niet echt nodig (zie boven) dus ik vind het wel best zo en ik heb niet verder gezocht wat het probleem precies is. Een stabiele machine vind ik belangrijker dan het gebruik van een goedkoop netwerkkaartje.

ESX is zelf geinstalleerd op de SSD die erin zit en dat draait prettig. Misschien dat ik dat ooit nog op een USB stick zet maar voor nu is het prima. Verder staat de Windows 7 client, SQL Database en de swap files op de SSD dus de prestaties daarvan zijn prima. Ik heb nog niet veel gemerkt van degradatie van performance (vziw ondersteunt ESXi geen trim commando) Ik ben wel benieuwd of dat zo blijft, maar dat ga ik meemaken

Grootste bottleneck in deze machine zijn de harddisks. Ik merk dat de VM op de SSD altijd ontzettend snel is, maar zodra er meerdere machines vanaf de SATA schijven druk bezig zijn er een behoorlijke degradatie is in performance. (wat ik uiteraard niet vreemd vind) Op het werk ligt nog een 'sloop' server met 6 x 15K SAS schijven die ik op het oog heb. Als ik toestemming krijg dan zou ik die graag in deze machine inbouwen, alleen een goede controller aanschaffen en dan denk ik dat ik redelijk van de SATA bottleneck af ben

Maar voor nu ben ik erg tevreden over deze setup...

Edit: foto's toegevoegd...

:strip_icc():strip_exif()/u/26315/bleh.jpg?f=community)

:strip_exif()/u/340453/crop67a669ce4f1f4_cropped.webp?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/231803/ramdisk2.png?f=community)

:strip_icc():strip_exif()/u/97973/crop689da1cf6ac35.jpg?f=community)

:strip_icc():strip_exif()/u/149150/Androider.jpg?f=community)

:strip_icc():strip_exif()/u/113637/bla.jpg?f=community)

:strip_icc():strip_exif()/u/4824/i.jpeg?f=community)

:strip_icc():strip_exif()/u/2646/shine.jpg?f=community)

/u/170728/owl.png?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_icc():strip_exif()/u/146731/crop562615a0aa64c.jpeg?f=community)

:strip_icc():strip_exif()/u/105320/i.jpg?f=community)

:strip_icc():strip_exif()/u/79614/Family-Guy-Victory-is-Ours.jpg?f=community)