12 x 1 TB eruit

Hallo 16 x 4 TB

[ Voor 52% gewijzigd door lampie1979 op 03-01-2014 18:02 ]

They call her... c*ck juggeling Thunderc*nt!

Nu er tussen jouw lading ook zo'n schijven blijken te zitten is de winkel niet meer relevant

Ik vond het een beetje vreemd, maar de winkel vermeldde nergens dat het om refurbished modellen zou gaan, op de schijven staat het evenmin, en de productiedatum is ook recent niet dus ze hebben al tijd gehad om de geest te geven

Modelnummer lijkt mij identiek.

[ Voor 50% gewijzigd door Borromini op 04-01-2014 01:29 ]

Got Leenucks? | Debian Bookworm x86_64 / ARM | OpenWrt: Empower your router | Blogje

Heb jij die getapede disks zo gekocht?

Laat ze maar eens vertellen waar het voor dient (productiefout dus protective cover?) en of het inderdaad om splinternieuwe schijven gaat.

[ Voor 24% gewijzigd door Ravefiend op 03-01-2014 19:52 ]

alternatieve verklaring: poor man's 'warranty void'-sticker?

[ Voor 15% gewijzigd door mux op 03-01-2014 19:54 ]

Nu je het zegt... Ik had alleen maar de bovenste op z'n foto bekeken.smvs schreef op vrijdag 03 januari 2014 @ 19:45:

Op enkele schijven (iig de onderste) van Lampie zie je ook die tape overigens.

Overzichtsfoto 2 laat meerdere schijven met die tape zien, niet alleen op de onderste rij. Het is alleen niet zo goed zichtbaar.

[ Voor 16% gewijzigd door Borromini op 03-01-2014 21:23 ]

Got Leenucks? | Debian Bookworm x86_64 / ARM | OpenWrt: Empower your router | Blogje

lampie1979 schreef op vrijdag 03 januari 2014 @ 17:59:

Het is weer tijd voor een upgrade!

Hallo 16 x 4 TB

Ik heb er net 2 gekocht alleen dan 7200 rpm (ben gek).

Daar heb je even 64 ruwe TBs liggen.

Ik schrik wel een beetje van die tape. Ik ga er ook een stapel kopen, mogelijk dat ik kleinere batches van 8 stuks per winkel koop in de hoop op een beetje mix qua batches.

@Lampie1979: wat is je totale storage als je straks deze disks er in hebt zitten?

[ Voor 11% gewijzigd door Q op 03-01-2014 22:37 ]

Ik heb recent mijn 5 x 4TB relatief goedkoop daar kunnen aanschaffen, met garantie en alles er op. Dat ging dan wel over Seagates op 5400RPM.

http://tweakers.net/categ...38DYtG_fy7SxGQl4BbM9DQlS8

Met een van de twee heb ik ervaring, gemakkelijke deal. En op een grote partij schijven scheelt het toch een stukje...

[ Voor 11% gewijzigd door HyperBart op 03-01-2014 21:17 ]

Standaard doet ZFS sync writes als daarom gevraagd wordt en NFS doet graag sync writes.Q schreef op zondag 29 december 2013 @ 17:38:

code:

Met ZFS over NFS heb ik nog gigantische performance problemen. Maar dit werkt echt goed.

http://blogs.dootdoot.com...and-poor-nfs-performance/

Fuck data integriteit tijdens het kopiëren, gewoon sync uitzetten op zfs file system.

1

| zfs set sync=disabled poolname/foldername |

Prima performance: 350 MB/s.

[ Voor 7% gewijzigd door Q op 03-01-2014 23:50 ]

Mijn 5K4000 heeft die tape ook. Ik vond het ook vreemd toen ik m binnen kreeg. Deze zitten op de 7K3000 overigens niet.Borromini schreef op vrijdag 03 januari 2014 @ 20:40:

Bedankt voor de toelichting mux. Voel ik me tenminste niet meer bedot

[...]

Nu je het zegt... Ik had alleen maar de bovenste op z'n foto bekeken.

Overzichtsfoto 2 laat meerdere schijven met die tape zien, niet alleen op de onderste rij. Het is alleen niet zo goed zichtbaar.

Zoals ik al zei, heb je sync uit staan aan de client kant...? Want by default zal het inderdaad traag zijn. ZFS is nou eenmaal gemaakt voor data integriteit... Als je client 100% sync writes stuurt is het inderdaad takke traag zonder write caching...Q schreef op vrijdag 03 januari 2014 @ 23:48:

[...]

Standaard doet ZFS sync writes als daarom gevraagd wordt en NFS doet graag sync writes.

http://blogs.dootdoot.com...and-poor-nfs-performance/

Fuck data integriteit tijdens het kopiëren, gewoon sync uitzetten op zfs file system.

code:

Prima performance: 350 MB/s.

Even niets...

Helemaal waar, ik moest even door ploeteren.FireDrunk schreef op zaterdag 04 januari 2014 @ 09:42:

[...]

Zoals ik al zei, heb je sync uit staan aan de client kant...? Want by default zal het inderdaad traag zijn. ZFS is nou eenmaal gemaakt voor data integriteit... Als je client 100% sync writes stuurt is het inderdaad takke traag zonder write caching...

Enige puntje wat ik nu weer zie is dat de write dus 350 MB/s maar de read niet boven de 110 MB/s uitkomt. Ach ja, zo blijf je bezig.

Even niets...

Ik heb 10 stuks 7k4000 en daar zit ook geen tape op.330d schreef op zaterdag 04 januari 2014 @ 00:22:

[...]

Mijn 5K4000 heeft die tape ook. Ik vond het ook vreemd toen ik m binnen kreeg. Deze zitten op de 7K3000 overigens niet.

De 3 TB "opvolger" van toshiba DT01ACA300 hebben ook geen tape (heb ik uit denk ik 5 verschillende batches 20 van)

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

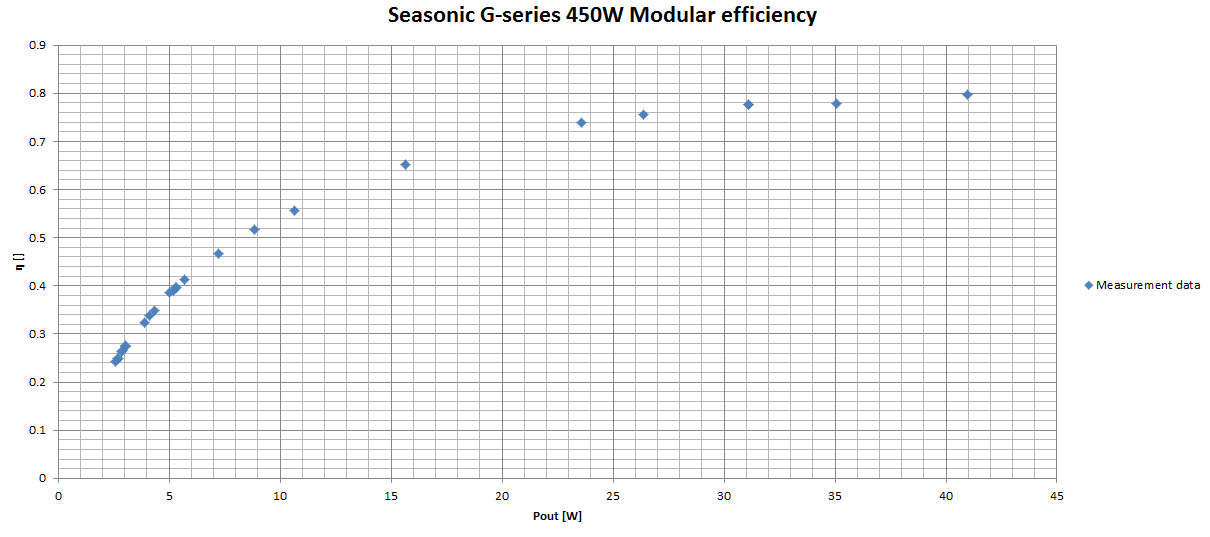

Met welke apparatuur heb je dat gemeten? Die idle-waarde lijkt me wel erg laag voor een met zes schijven... Of undervolt je?GioStyle schreef op zaterdagme :/ december 2013 @ 19:34:

Case: Fractal Design Node 304 CPU: Intel Pentium G3220 Motherboard: Asus H87I-Plus RAM: Corsair Vengeance LP 2x 4GB CPU cooler: Stock Case fans: 1x Noctua NF-A14 FLX (5v) + 2x Noctua NF-B9 (5v) Harddrives: 6x Western Digital WD30EZRX Operating system: FreeNAS 9.1.1 Filesystem: ZFS Raid array configuration: RAIDZ2 Netto storage capacity: 12TB Network: Onboard (Intel I217) Power consumption (start-up): 120,6 watt Power consumption (idle, no spindown): 43,5 watt Power consumption (idle, spindown): xx,x watt Power supply: Seasonic G450

Deze storagebox wordt puur gebruikt voor mkv's (films/series) en om mijn VM's naar te back-uppen. Voor de rest niet echt spannend, het ging mij voornamelijk om de zuinigheid. Idle met spindown moet ik nog een keer meten, maar ik gok op ongeveer 28-30 watt.

Got Leenucks? | Debian Bookworm x86_64 / ARM | OpenWrt: Empower your router | Blogje

Ik heb de WD30EZRX schijven waarvan ik 100% weet dat er 3 1TB platters in zitten. Deze zitten idle (geen spindown) rond de 3,5 watt. De setup zonder schijven zit rond de 22, 23 watt.

Ik heb de laatste tijd nog geen tijd gehad om te kijken wat het verbruik is met spindown, want op de een of andere manier willen de disks niet in spindown.

Ik undervolt niets, alles loopt op stock voltages.

Dus bij 43.5W AC zit je ongeveer op 35W DC. WD30EZRX doet 3.0W DC idle, dus dan zit je op 17W DC voor de rest. Da's een hele hoop voor idle, maargoed, zowel asus als freebsd is dan ook kak met zuinigheid

Zonder schijven verwacht ik dus dat je vrijwel precies 25W AC zult trekken.

En als ik de utp kabel eruit trek en de stock koeler dan kom ik uit op 20,5 watt.

Maar volgens mij ben ik nu een beetje in de verkeerde topic bezig.

[ Voor 37% gewijzigd door GioStyle op 06-01-2014 22:05 ]

En toch is mijn NAS zuiniger dan die 20.5 watt. Want hij staat gewoon uit 99% van de tijd

[ Voor 9% gewijzigd door Q op 07-01-2014 09:18 ]

Same here. Dat is natuurlijk altijd de beste oplossing, niet gebruiken: uitzetten.

450 MB/s via Linux bonding met quad-interface kaart! Eerder kwam ik tot 'maar' 360 MB/s.

Kick-ass!

Truck was: jumbo frames inschakelen op netwerk interfaces, bonding interface en de switch.

Artikel:

http://louwrentius.com/ac...-using-linux-bonding.html

[ Voor 4% gewijzigd door Q op 08-01-2014 01:44 ]

Valt wel mee die van mij draait idle 100-110 watt en dat is met 16 schijven, 2 SSD's, 4 fans, 1 Xeon 1230, supermicro bord, 1 ibm m1015 en 2 hp SAS extenders die ingeprikt zijn. Je kan wel degelijk een server zuinig krijgen. Ik denk dat als ik mijn 8 WD greens vervang voor Hitachi 5K's dat ik nog wel 10-15 watt kan zakken. Zo groen zijn die greens nou nietQ schreef op dinsdag 07 januari 2014 @ 09:17:

In dit topic geven we denk ik niet zo heel erg om super zuinig. Ik verwacht dat de meesten met grote storage 150 - 200 Watt idle draaien en er zijn er een paar die nog meer verbruiken.

En toch is mijn NAS zuiniger dan die 20.5 watt. Want hij staat gewoon uit 99% van de tijd

Nu is zuinig ook een relatief begrip maar ik ben er best tevreden mee. Mijn oude setup een Gigabte X58-UD7 met een I7 920 en losse videokaart verstookte idle gewoon 70 watt meer

[ Voor 10% gewijzigd door Hakker op 08-01-2014 15:36 ]

Artificial Intelligence is no match for natural stupidity | Mijn DVD's | Mijn Games | D2X account: Hakker9

Oorspronkelijk mijn virtualisatie-hostje binnen het huishouden. Op deze machine draaide ik een aantal "cruciale" VM's voor mijn dagelijkse leven. Denk maar aan een SabNZBd/CouchPotato/SickBeard VM, een Domain Controller, een VPN-machine, een Management Server en tot slot natuurlijk een VM waarop een OS draaide wat ZFS kon serveren. De M1015 waar al mijn disks op hingen gaf ik via VT-d door aan de VM en deze pool fungeerde ook als SAN voor de ESXi zelf.

Sinds eind december 2013 draait deze machine FreeBSD op bare-metal. Door een aantal meevallertjes in V&A en via promo-materiaal heb ik heel wat brute performance bijgekregen in de vorm van 7 SSD's.

De M500 is ingedeeld in 2 relatief kleine partities van ieder 10GB, eentje dient als boot partitie, de andere als ZIL. Met een ruime overprovisioning om de M500 alle ruimte te geven voor optimalisaties verwacht ik lang toe te komen met deze SSD.

De Samsung EVO 250GB daarentegen dient volledig als L2ARC en heeft (voorlopig) geen overprovisioning. Door de volledige metadata van mijn share met alle media-bestanden te laten cachen op L2ARC zijn SickBeard en Couchpotato geen "wekkers" voor mijn disks die na 20 minuten in spindown gaan. Het enige suboptimale aan deze configuratie is dat in het slechtste geval wanneer meerdere downloads verspreid over de nacht binnenkomen, deze disks bijna niet in spindown gaan. Het verlagen van de time-out zou natuurlijk soelaas bieden, maar dat is altijd het wikken en wegen en tot slote de gulden middenweg zoeken tussen energieverbruik en de wear-and-tear van telkens te parkeren en opspinnen. Voorlopig ben ik tevreden met een time-out van 20 min.

Het grotere broertje van de EVO 250GB, namelijk de 500GB dient als "scratch" volume om downloads op terecht te laten komen. Als een download binnenkomt gaan de disks niet onmiddellijk opspinnen. Komt er kort daarna nog een tweede download binnen dan is deze vaak snel genoeg binnen en zijn de disks nog niet in spindown gegaan.

De 4 Crucial M4's gaan of als stripe ingezet worden of als gestripe'de mirrors afhankelijk van waar ik het meeste performantie mee krijg.

Het geheel, als slot, wordt beschermd door een relatief inefficiënte UPS, maar dat was ten tijde van de aanschaf niet zo een prioriteit. Nu ik al een tijdje een eigen woonst betrek is dat toch een niet onbelangrijke factor, maar de aanschafkosten van een nieuwe wegen niet op tegen de inefficëntie op dit moment.

hoe zit het kan ik al overstappen op 2012R2 met de intel kaarten ?FireDrunk schreef op dinsdag 17 september 2013 @ 20:04:

Hmm, dan zal het 2012R2 zijn... Daar werken mijn Intel Pro 1000 PT en VT beiden niet

Stomme intel...

Yes & No: http://www.intel.com/support/network/sb/CS-034449.htmthalantis schreef op zondag 26 januari 2014 @ 19:30:

[...]

hoe zit het kan ik al overstappen op 2012R2 met de intel kaarten ?

pricewatch: HGST Ultrastar He6 (SATA 6Gb/s), 6TB

Of nog iets te duur

[ Voor 3% gewijzigd door Diecke op 31-01-2014 17:14 ]

Ik heb ze in mijn prijsalert gezet omdat ik dacht dat deze interessant zouden kunnen zijn. Gezien de prijs kun je veel beter voor 4TB gaanDiecke schreef op vrijdag 31 januari 2014 @ 17:13:

Iemand al van plan een paar van deze in RAID te zetten?

pricewatch: HGST Ultrastar He6 (SATA 6Gb/s), 6TB

Of nog iets te duur?

Even niets...

Ja die heb ik wel eens gezien, speciale kast, vind die dingen best mooi. Maar 19" houdt het wat compacter en geeft ook meteen hotswap.abusimbal schreef op vrijdag 31 januari 2014 @ 23:47:

Iemand deze al gezien:

http://lime-technology.com/forum/index.php?topic=27664.0

54TB

18TB RAIDZ2 ZFS inclusief 240GB SSD voor VM datastore.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1230 V3 Boxed | € 223,50 | € 223,50 |

| 1 | Supermicro X10SL7-F | € 231,10 | € 231,10 |

| 6 | WD Red SATA 6 Gb/s WD30EFRX, 3TB | € 106,94 | € 641,64 |

| 1 | BitFenix Shadow | € 60,- | € 60,- |

| 7 | Sharkoon SATA III standard (50cm) | € 3,90 | € 27,30 |

| 1 | Kingston ValueRAM KVR16E11K4/32 | € 307,- | € 307,- |

| 1 | Seasonic G-Serie 360Watt | € 51,- | € 51,- |

| 1 | Crucial 2.5" M500 240GB | € 106,20 | € 106,20 |

| Bekijk collectie Importeer producten | Totaal | € 1.647,74 | |

[ Voor 4% gewijzigd door FREAKJAM op 18-03-2014 17:14 ]

is everything cool?

Ziet er netjes uit.FREAKJAM schreef op donderdag 06 februari 2014 @ 20:56:

ESXi build in progress:

18TB RAIDZ2 ZFS inclusief 240GB SSD voor VM datastore.

# Product Prijs Subtotaal 1 Intel Xeon E3-1230 V3 Boxed € 223,50 € 223,50 1 Supermicro X10SL7-F € 231,10 € 231,10 6 WD Red SATA 6 Gb/s WD30EFRX, 3TB € 106,94 € 641,64 1 BitFenix Shadow € 60,- € 60,- 7 Sharkoon SATA III standard (50cm) € 3,90 € 27,30 1 Kingston ValueRAM KVR16E11K4/32 € 307,- € 307,- 1 Seasonic G-Serie 360Watt € 51,- € 51,- 1 Crucial 2.5" M500 240GB € 106,20 € 106,20 Bekijk collectie

Importeer productenTotaal € 1.647,74

Ik neem aan dat je de on-board LSI door wilt gaan geven aan de storage VM.

Welk ZFS enabled OS had je op t oog?

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Over de ZFS enabled OS ben ik nog niet uit. Ik had in eerste instantie ZFSGuru voor ogen, maar ik neig toch meer naar FreeNAS of NAS4Free.

[ Voor 11% gewijzigd door FREAKJAM op 07-02-2014 15:59 ]

is everything cool?

Geloof me, je wilt geen Unraid.. (32 bit os, reiserfs file systeem, a$$hole als ontwikkelaar)abusimbal schreef op vrijdag 31 januari 2014 @ 23:47:

Iemand deze al gezien:

http://lime-technology.com/forum/index.php?topic=27664.0

54TB

Ik heb daar zo veel ellende mee gehad, overgegaan naar zfsguru, en nooit meer issues, dus het ligt niet aan de hardware..

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

En veel andere alternatieven heb jij bij mij weten niet

Wel een supercoole kast !

[ Voor 11% gewijzigd door heuveltje op 09-02-2014 10:29 ]

Heuveltjes CPU geschiedenis door de jaren heen : AMD 486dx4 100, Cyrix PR166+, Intel P233MMX, Intel Celeron 366Mhz, AMD K6-450, AMD duron 600, AMD Thunderbird 1200mhz, AMD Athlon 64 x2 5600, AMD Phenom X3 720, Intel i5 4460, AMD Ryzen 5 3600 5800x3d

Maar dan nog is 1/3 van de schijven een afwijkende grote tot de rest.

En aan het aantal types en reads te zien, gok ik dat hij gewoon af en toe een paar disken door grotere,

vervangt. En dat maakt het allemaal redelijk ongeschikt voor zfs

Heuveltjes CPU geschiedenis door de jaren heen : AMD 486dx4 100, Cyrix PR166+, Intel P233MMX, Intel Celeron 366Mhz, AMD K6-450, AMD duron 600, AMD Thunderbird 1200mhz, AMD Athlon 64 x2 5600, AMD Phenom X3 720, Intel i5 4460, AMD Ryzen 5 3600 5800x3d

Op een Atom D525 liep het redelijk goed, echter bij het prelearen van hdds liep de zaak vast op 2 van de 4 hdds. Dus maar een supermicro x9scm-f met een xeon gekocht en er 16 Gb ram op gezet.

Dat liep uiteindelijk niet veel beter, en ja het extra ram werd alleen voor copy buffering gebruikt volgens mij, de rest van het systeem hikt tegen de 4 gb limiet van 32 bit os aan.

Wat me het meest stoorde was dat je een cache hdd kon gebruiken, en die dan snel kan vullen waarna de array geupdate wordt en de parity herberekend voor de geschreven data.

Netjes aan de 100 mbyte/sec naar de cache hdd tot er 'iets' gebeurde en het naar 1-3 mbps terug liep.

Transfer afbreken, herstarten weer 100 mbps, even later weer 1-3 mbps.

Zfsguru geinstalleerd en dat presteerd prima met precies dezelfde hardware. (24 gb voor dat systeem)

Er zijn nog wel andere oplossingen zoals flexraid volgens mij.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Zoals zijn disk configuratie nu is wel ja maar je kan de boel toch al niet zo omzetten dus moet ie zoiezo al een andere set HDD's hebben dus dan pakt ie 5 4 TB's voor een Z1 setup en hoppa je kan zo alles overzetten en meerdere pools gebruiken. Oudere schrijven van 2TB+ ben je binnen 2 dagen kwijt.heuveltje schreef op zondag 09 februari 2014 @ 11:58:

Het viel iets mee, ik dacht er ook nog een stel 2.5TB schijven tussen te hebben gezien.

Maar dan nog is 1/3 van de schijven een afwijkende grote tot de rest.

En aan het aantal types en reads te zien, gok ik dat hij gewoon af en toe een paar disken door grotere,

vervangt. En dat maakt het allemaal redelijk ongeschikt voor zfs

Voor ik mijn huidige bak had bestond mijn collectie uit een hele wirwar van schijven uiteenlopend van 500 GB tot 3 TB en dan heb ik het over iets van 20 schijven van die 20 gebruik ik er nu nog 4 de andere 16 gewoon verkocht en door de stijging destijds amper met verlies, maar wel de lol ervan.

Omschakelen kost gewoon geld. En ja ik heb ook naar unraid gekeken maar het beviel het mij niet. Vooral niet de community eromheen. Nu draai ik een aardig kale ZFS en moet zeggen voor mij is het goed. Ik zou alleen willen dat de LSI based controller beter uitgelezen kon worden door BSD dan nu het geval is.

Laat ik wel zeggen dat ook ZFS zijn nadelen heeft en zo moet iedereen gewoon bepalen wat voor hem/haar de beste oplossing is want wat voor mij werkt hoeft voor een ander niet zo te zijn.

[ Voor 6% gewijzigd door Hakker op 09-02-2014 20:15 ]

Artificial Intelligence is no match for natural stupidity | Mijn DVD's | Mijn Games | D2X account: Hakker9

Ik heb iets van 50+ hdds verkocht,dat waren 500, 1000, 1500 en 2000 GB hdds. (38TB)

Iets van 150 euro erbij en ik had 10x3TB voor een zfs volume.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

| System specifications | |

| Component | Value |

|---|---|

| Case | Antec 4u rackmount |

| CPU | Xeon E3-1230 V3 |

| RAM | 2x Kingston 8 GB ECC |

| Motherboard | Intel S1200V3RPL |

| Operating system | VMWare ESXi 5.5 |

| Controller | LSI 8708EM2 256MB met BBU |

| Hard drive | 8x 2TB HGST |

| RAID array configuration | RAID 6 |

| Netto storage capacity | 12 TB (10.91 TB) |

| Network | 2x Intel GBit |

| UPS | Nog niet |

| Filesystem | VMFS5 |

| Idle power usage | 90Watt zonder spindown. |

| Extra | |

De server wordt gebruikt als VMWare speeltuin en NAS.

Samen met zijn voorganger in mijn diy rack. Onderste server bevat 4x 1TB in RAID 5 voor backups. Deze wordt vervolgens doorgestuurd naar http://zovo.co/social

Extra fannetje om de raid controller koel te houden

Cable management moet nog even aangepakt worden

Canon cameras en lenzen. Elinchrom flitsers, Lowepro en Pelican tassen/koffers. Polestar 2

Heel mooi gedaan!

Welke CPU zit er in? Je hebt bij MoBo en CPU telkens "S1200V3RPL" ingevuld.

[ Voor 22% gewijzigd door HyperBart op 22-02-2014 15:33 ]

Canon cameras en lenzen. Elinchrom flitsers, Lowepro en Pelican tassen/koffers. Polestar 2

Het viel me direct op dat de foto's er zo 'lekker' uitzagen en het duurde even een paar seconden voordat het kwartje viel (zag je signature). Zelf jaren geleden mijn hele kit weggedaan maar als ik deze kwaliteit foto's zie dan voel ik soms spijt.

Canon cameras en lenzen. Elinchrom flitsers, Lowepro en Pelican tassen/koffers. Polestar 2

vandijk schreef op zondag 23 februari 2014 @ 09:03:

@Q tnx. De foto's zijn gemaakt met mijn nieuwe EOS M met 22/2 lens.Beetje bounce flash en dan zien de foto's er al snel goed uit. Ik moet wel mijn sig nog even aanvullen zie ik.

Bedankt voor de tip: ik ben stiekem wel in de markt voor een camera qua formaat als de EOS M

http://www.synology.com/de-de/events/2014_cebit

900TB

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Op file system is limiet bepaald door type, ext3= max 16TB ext4= 1 Exbibyte

ik lees nergens dat het één volume is en wanneer 108TB de limiet is zul je meerdere volumes nodig hebben om die 900TB te halen.jacovn schreef op vrijdag 14 maart 2014 @ 08:19:

Heeft DSM geen limiet van 108 TB voor een file systeem ?

http://zstor.de/produkte/...uster-storage-system.html

70x 4TB = 280TB ;-)

en gebruik je de 15 HDD racks van die storage-pod wordt het dus een ronde 5x15x4TB = 300TB/kast :-)

(met de 6TB-schijven die ondertussen verkrijgbaar worden toppen we dan op 450TB - dat is 10x de opslag van de 1ste versie van Backblaze's storagepod

prijskaartje is wellicht wel wat hoger dan bij een storagepod.

Maar de kast verlengen om nog 2 van zulke HDD-houders erin te kunnen steken, lijkt me nu ook niet zo moeilijk, en met de gebruikte (2x) HighPoint Rocket 750 HBA's heb je dan nog steeds 5 SATA-poorten als reserve.

http://www.amazon.co.uk/H...r=1-23&keywords=HighPoint

Kies je een moederbordje met voldoende onboard-SATA-poorten kan je er zelfs nog een 6de 'lat' bijleggen, en ga je dus naar 90 schijven per kast, voor een totaal van 360TB tot 540TB (4TB vs 6TB schijven)

Mmmm if only I had enough money ....

Iemand trouwens een idee waar je die direct wire SATA/power 4 (of 1) connectors (dus met die 'lipjes' eraan om die vast te schroeven) kan verkrijgen?

[ Voor 14% gewijzigd door soulrider op 22-03-2014 20:14 ]

Leuk ding. Als je goed kijkt zitten er volgens mij dus ook twee volledige server moederborden in (redundancy) en is het niet slechts een stomme jbod case. Er zit 2x10 gbit op. Gaaf ding, maar ~ 8x zo duur in absolute zin als een storage pod. Qua prijs / gigabit is de storage pod volgens mij efficiënter.soulrider schreef op zaterdag 22 maart 2014 @ 19:55:

net iets densere opslag dan die storage-pod 4:

http://zstor.de/produkte/...uster-storage-system.html

70x 4TB = 280TB ;-)

- namelijk: 5x 15 ipv 'slechts' 3x15 voor de harde schijven - dan heb je dus 75 ipv 45 harde schijven in 1 kast.

en dat maakt dan natuurlijk een mooie 300TB/kast met 4TB-schijven.

en zo goed hoef je niet te kijken om te zien dat er 2 moederborden in zitten, net zoals de 4 (2+2-redundante) voedingen eronder ook zeer zichtbaar zijn.

[ Voor 21% gewijzigd door soulrider op 23-03-2014 11:40 ]

Een amiga 500 met 512 kb ram !

Zijn hier in V&A voor iets van 75 euro nieuw te koop. Gebruik ze zelf en ze bevallen prima tot nu toe.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Mensen al plannen hiermee?

Als ik nu kijk naar het prijsniveau van de 4TB schijven is de goedkoopste in de PW €0,032 per GB,BartNL schreef op zondag 06 april 2014 @ 13:28:

in €/GB zitten de 5TB schijven nog lang niet op het prijsnivo van de huidige 4TB schijven.

deze 5TB is $194.99 -> €142,31 is dus per GB maar €0,028.

En je krijgt er een leuke case bij

[ Voor 5% gewijzigd door Diecke op 06-04-2014 14:10 ]

Want als je die schijf uit de USA haalt, dan moet je hier dus nog inklaringskosten (€17,50) plus BTW van 21% erbij rekenen.

Eerdergenoemde €142,31 kostende 5TB'er + 21% BTW + inklaringskosten = €189,70. Dat verschilt nogal.

[ Voor 16% gewijzigd door Raven op 06-04-2014 14:37 ]

After the first glass you see things as you wish they were. After the second you see things as they are not. Finally you see things as they really are, and that is the most horrible thing in the world...

Oscar Wilde

Door alle overnames, de overstroming en ontwikkelingen bij SSD's gebeurt er laatste twee jaar helaas weinig op HDD gebied.

http://www.newegg.com/Pro...aspx?Item=N82E16822178520

Wie gaat er los?

Hmm, zie ineens een hele lading 5 en 6TB'ers in de PW, de lijst is dus uitgebreid: http://tweakers.net/categ...qZGoAB0MjcxAog3wzKr62tBQA 't begint bij € 365,86 (5TB) en € 513,- (6TB)Q schreef op vrijdag 11 april 2014 @ 23:00:

Seagate 6 TB disk voor 300 dollar

http://www.newegg.com/Pro...aspx?Item=N82E16822178520

Wie gaat er los?

After the first glass you see things as you wish they were. After the second you see things as they are not. Finally you see things as they really are, and that is the most horrible thing in the world...

Oscar Wilde

[ Voor 56% gewijzigd door Q op 12-04-2014 10:23 ]

[ Voor 42% gewijzigd door BartNL op 12-04-2014 10:39 ]

Ik heb echter weinig hoop dat de prijs van de 4TB disks veel naar beneden zal gaan, want eerlijk gezegd, is de prijs nu best redelijk.

Ik heb nu net 4 x 4 TB gekocht en heb nu in totaal 6 x 4 TB. Dat geeft in ieder geval de mogelijkheid om een beetje te benchmarken en te kloten met een RAID set van die dingen en om te kijken wat voor prestaties en rebuild times ik kan verwachten.

[ Voor 30% gewijzigd door Q op 12-04-2014 11:46 ]

"Waarom hebben jullie in vredesnaam zoveel storage?

Voor opslag van porno, etc..."

Dus iedereen die hier post, zit de hele dag aan zijn "stick" te trekken?

Natuurlijk zijn het nu nog absurde prijzen, maar de introductie van 5 en 6TB schijven gaan de 4TB wel in prijs omlaag drukken. Maarja, we hebben eht dan waarschijnlijk over een tientje per schijf winst na een half jaar ofzo. Dat schiet ook niet erg op procentueel gezien.Q schreef op zaterdag 12 april 2014 @ 10:22:

Een 4 TB schijf doet ~150 euro dus dit zijn absurde prijzen. Voor dat geld koop je 12 TB aan 4 TB disks.

Ik ga mijn machine opbouwen op basis van 7200 RPM 4 TB schijven:Nielson schreef op zaterdag 12 april 2014 @ 14:35:

Welke 4 TB schijven heb je gekocht?

HGST HDS724040ALE640

Ik heb de hoop dat toepassing van 7200 RPM schijven mijn rebuild tijden ook helpt binnen de perken te houden. Mijn huidige machine rebuilt de 20 disk array in ~5 uur, wat erg redelijk is. Maar dat zijn dus 1 TB schijven. Met 4 TB schijven wordt dat 20 uur..... Is toch minder.

Dus iemand met een hele grote wijn verzameling zuipt de hele dag wijn?lapzwans schreef op zaterdag 12 april 2014 @ 18:33:

Dus iedereen die hier post, zit de hele dag aan zijn "stick" te trekken?

Dat is een beetje het punt, hoeveel kun je nog van 150 euro afschaven? Ik ga langzaam over de komende maanden de disks bestellen. We zien het wel.-Moondust- schreef op zaterdag 12 april 2014 @ 19:40:

Maarja, we hebben eht dan waarschijnlijk over een tientje per schijf winst na een half jaar ofzo. Dat schiet ook niet erg op procentueel gezien.

[ Voor 40% gewijzigd door Q op 13-04-2014 00:28 ]

Met het moederbord en OS ben ik nog aan het experimenteren. De eerste Supermicro X8SI6-F beviel mij niet. De onboard LSI SAS controller met firmware versie 15, debian 6.0.6 met kernel 2.6.32, mpt2sas driver versie 2.1 en 10.1 weigert om PUIS schijven te laten ontwaken. Daarna kwam er een Supermicro X9SCL-F met Intel E3-1220L V2 processer en AOC-SAS2LP-MV8 (Marvell 9480) die de PUIS drives wel laat ontwaken. Helaas hield hier de video er na een paar maanden mee op. Nu overgestapt naar een Asrock board.

| System specifications | |

| Component | Value |

|---|---|

| Case | maatwerk, 21,5cm hoog (5U) x 90,1cm diep |

| PSU | Corsair HX1050 |

| CPU | 1x Intel G1820 |

| RAM | G-skill 8 GB, 1x8GB 1.25V DDR3, F3-12800CL9D-8GBSR2 |

| Motherboard | Asrock H81 Pro BTC |

| Operating system | Debian 6.0.6 -> Ubuntu 13.04 |

| Controller | IAOC-SAS2LP-MV8 + HP SAS Expanders |

| RAID array configuration | geen, dit machientje mag straks back-ups data gaan ontvangen |

| Drive | Toshiba DT01ABA200 , 2TB 5700rpm |

| Netto storage capacity | 148 TB |

| Network | 1x RTL8111GR onboard |

| UPS | niet |

| Idle power usage | 222W AC |

| Peak power usage | 748W AC |

| Fan power usage | 5 x 0,4W + 3 x 1,9W = 7,7W DC |

Hoe krijg ik hier de foto's in? Er lijkt hier geen upload functie te zijn...

Nu is het bakkie nog opgesteld in de huiskamer, straks niet meer.

Hierbij zes foto's van het opbouwen:

De kabelboom voor de energietoevoer maken kost heel veel tijd, maar is echt nodig omdat er onvoldoende plaats is voor de omvangrijke ruimte die standaardkabels innemen. Dat doe ik de volgende keer anders en daardoor sneller. Ook kan de spanningsdistributie beter: 12V varieert van 12,11 tot 12,13 volt en de 5V lijn varieert tussen 4,86 en 4,97 volt.

Het foam is soms tussen de rijen met drives gezet om de disk temperatuur zo gelijk mogelijk te krijgen. In deze setup was het energieverbruik 317 watt en varieerde de S.M.A.R.T. temperatuur van alle drives tussen de 28 en 34, met een gemiddelde van 31,4 graden Celcius.

Voor wat betreft de behuizing: van metaalbewerking heb ik geen verstand, dus het tekenen van de case, het lasersnijden van de metaalplaten, alle plaatbewerkingen zijn gedaan door een derde. Die derde heeft ook de schroeven voor de behuizing aangeleverd. De spacers, en anti-vibratiematerialen heb ik zelf bij elkaar gezocht.

Oh ja, waarom maar 2TB schijven? Dit systeem staat al een tijdje (understatement) op de werktafel, en in december 2012 (!) waren de 2 terabyte schijven het meest voordelig per TB opslagruimte.

[ Voor 32% gewijzigd door cj1 op 14-04-2014 23:53 . Reden: waarom 2TB toegevoegd ]

Panasonic WH-MDC05F3E5, PAW-DHWM80ZNT, 3×Fronius IG Plus, Diehl Platinum 2100H, Mean Well TS-200, Studer AJ400-48, 18×Rept CB75, AHED-BMS, Energiek/Greenchoice 3j

1

| [img] < link > [/img] |

Super gaaf. Volgens mij kom je zo op nr 1.

- Wat voor soort performance haal je uit deze setup?

- Waarom gebruik je geen RAID

- Is dit voor privé gebruik?

Edit, foto's nu online, dit is helemaal zelf gemaakt? Of is de kast op jouw spec gemaakt door een derde?

Ziet er heel interessant uit. Holy cow.

[ Voor 110% gewijzigd door Q op 14-04-2014 23:20 ]

@Borromini & @muxmux schreef op vrijdag 03 januari 2014 @ 19:53:

Dat is geen duct tape, het is zilvertape en dat wordt wel eens gebruikt om storingsgevoelige delen van elektronica, vaak als 'hotfix' totdat een nieuwe revisie uitgaat. Beste kans dat dit 'normaal' is voor deze batch disks.

alternatieve verklaring: poor man's 'warranty void'-sticker?

Alternatieve verklaring #2: de drive met zilvertape komt uit een externe USB behuizing, te weten de HGST Touro DX3.

Noot: ik heb namelijk zelf meer dan eens zo'n behuizing geopend, en juist die Hitachi schijven hadden altijd zo'n zilvertape omwikkeling.

Panasonic WH-MDC05F3E5, PAW-DHWM80ZNT, 3×Fronius IG Plus, Diehl Platinum 2100H, Mean Well TS-200, Studer AJ400-48, 18×Rept CB75, AHED-BMS, Energiek/Greenchoice 3j

Of je koopt die Seagates uit de via voor 110 het stuk? Dat is wel de moeite op jouw aantal.Q schreef op zaterdag 12 april 2014 @ 10:22:

Een 4 TB schijf doet ~150 euro dus dit zijn absurde prijzen. Voor dat geld koop je 12 TB aan 4 TB disks.

cj1 schreef op maandag 14 april 2014 @ 22:21:

Deze back-up machine met 74 drives is enigzins geïnspireerd op de Backblaze storage pod, waarbij de port multipliers voor de eerste 64 harde schijven vervangen zijn door HP SAS expanders. De resterende 10 SATA schijven werden op twee Dawicontrol port multipliers aangesloten.

Met het moederbord en OS ben ik nog aan het experimenteren. De eerste Supermicro X8SI6-F beviel mij niet. De onboard LSI SAS controller met firmware versie 15, debian 6.0.6 met kernel 2.6.32, mpt2sas driver versie 2.1 en 10.1 weigert om PUIS schijven te laten ontwaken. Daarna kwam er een Supermicro X9SCL-F met Intel E3-1220L V2 processer en AOC-SAS2LP-MV8 (Marvell 9480) die de PUIS drives wel laat ontwaken. Helaas hield hier de video er na een paar maanden mee op. Nu overgestapt naar een Asrock board.

System specifications Component Value Case maatwerk, 21,5cm hoog (5U) x 90,1cm diep PSU Corsair HX1050 CPU 1x Intel G1820 RAM G-skill 8 GB, 1x8GB 1.25V DDR3, F3-12800CL9D-8GBSR2 Motherboard Asrock H81 Pro BTC Operating system Debian 6.0.6 -> Ubuntu 13.04 Controller IAOC-SAS2LP-MV8 + HP SAS Expanders RAID array configuration geen, dit machientje mag straks back-ups data gaan ontvangen Drive Toshiba DT01ABA200 , 2TB 5700rpm Netto storage capacity 148 TB Network 1x RTL8111GR onboard UPS niet Idle power usage 222W AC Peak power usage 748W AC Fan power usage 5 x 0,4W + 3 x 1,9W = 7,7W DC

Hoe krijg ik hier de foto's in? Er lijkt hier geen upload functie te zijn...

Nu is het bakkie nog opgesteld in de huiskamer, straks niet meer.

Hierbij zes foto's van het opbouwen:

[afbeelding]

[afbeelding]

[afbeelding]

[afbeelding]

[afbeelding]

[afbeelding]

De kabelboom voor de energietoevoer maken kost heel veel tijd, maar is echt nodig omdat er onvoldoende plaats is voor de omvangrijke ruimte die standaardkabels innemen. Dat doe ik de volgende keer anders en daardoor sneller. Ook kan de spanningsdistributie beter: 12V varieert van 12,11 tot 12,13 volt en de 5V lijn varieert tussen 4,86 en 4,97 volt.

Het foam is soms tussen de rijen met drives gezet om de disk temperatuur zo gelijk mogelijk te krijgen. In deze setup was het energieverbruik 317 watt en varieerde de S.M.A.R.T. temperatuur van alle drives tussen de 28 en 34, met een gemiddelde van 31,4 graden Celcius.

Voor wat betreft de behuizing: van metaalbewerking heb ik geen verstand, dus het tekenen van de case, het lasersnijden van de metaalplaten, alle plaatbewerkingen zijn gedaan door een derde. Die derde heeft ook de schroeven voor de behuizing aangeleverd. De spacers, en anti-vibratiematerialen heb ik zelf bij elkaar gezocht.

Oh ja, waarom maar 2TB schijven? Dit systeem staat al een tijdje (understatement) op de werktafel, en in december 2012 (!) waren de 2 terabyte schijven het meest voordelig per TB opslagruimte.

Grappig, nu ik mijn servertje een upgrade heb gegeven zit ik met een bijna identieke config.. Aangezien er meerdere mensen zijn met deze config krijg ik het idee dat het een goede prijs/prestatie verhouding is :-)FREAKJAM schreef op donderdag 06 februari 2014 @ 20:56:

ESXi build in progress:

18TB RAIDZ2 ZFS inclusief 240GB SSD voor VM datastore.

# Product Prijs Subtotaal 1 Intel Xeon E3-1230 V3 Boxed € 223,50 € 223,50 1 Supermicro X10SL7-F € 231,10 € 231,10 6 WD Red SATA 6 Gb/s WD30EFRX, 3TB € 106,94 € 641,64 1 BitFenix Shadow € 60,- € 60,- 7 Sharkoon SATA III standard (50cm) € 3,90 € 27,30 1 Kingston ValueRAM KVR16E11K4/32 € 307,- € 307,- 1 Seasonic G-Serie 360Watt € 51,- € 51,- 1 Crucial 2.5" M500 240GB € 106,20 € 106,20 Bekijk collectie

Importeer productenTotaal € 1.647,74

[afbeelding]

Plaatje is klikbaar voor de grote versie.

Geen EXSi maar native bare-metal gentoo. Vandaar de SSD over voor L2ARC.

hoo-lie-foek.[b]cj1 schreef op maandag 14 april 2014 @ 22:21

Deze back-up machine met 74 drives is enigzins geïnspireerd op de Backblaze storage pod, waarbij de port multipliers voor de eerste 64 harde schijven vervangen zijn door HP SAS expanders. De resterende 10 SATA schijven werden op twee Dawicontrol port multipliers aangesloten.

...

Enige opmerking; met ZO VEEL disks kunnen er toch wel 2 af voor RAID(Z2)? Kans op een disk failure wordt aardig groot zo en dan ben je een aantal dagen zoet met de data er weer op gooien. Disk vervangen is een stuk makkelijker ook al is het vervangbare backup-only..

[ Voor 5% gewijzigd door Pakjebakmeel op 15-04-2014 16:23 ]

Hoe krijg je die oranje SATA voedingskabels zo strak?

Panasonic WH-MDC05F3E5, PAW-DHWM80ZNT, 3×Fronius IG Plus, Diehl Platinum 2100H, Mean Well TS-200, Studer AJ400-48, 18×Rept CB75, AHED-BMS, Energiek/Greenchoice 3j

ik zie op zijn foto geen oranje sata voedingskabels?cj1 schreef op dinsdag 15 april 2014 @ 17:16:

[...]Hoe krijg je die oranje SATA voedingskabels zo strak?

[ Voor 47% gewijzigd door BartNL op 15-04-2014 17:40 ]

Ik denk dat hij de sas=>sata kabels bedoeltBartNL schreef op dinsdag 15 april 2014 @ 17:38:

[...]

ik zie op zijn foto geen oranje sata voedingskabels?

Met zoiets als

krijg je je voedingsbekabeling wel veel strakker bij een high density setup.

[ Voor 17% gewijzigd door BartNL op 15-04-2014 17:48 ]

[ Voor 15% gewijzigd door thof op 15-04-2014 17:49 ]

Server 1: Intel N305 | 48GB RAM | 5*4TB NVME | 4x 2.5GbE

Server 2: Intel N5105 | 64GB RAM | 1TB NVME | 4x 2.5GbE

Server 3: Intel Xeon E5-2670 | 128GB RAM | 512+750GB SATA SSD | 6x10TB HDD | 6x 1GbE [Buiten gebruik]

Goed begrepen!BartNL schreef op dinsdag 15 april 2014 @ 17:45:

dat denk ik ook maar gezien cj1's setup denk ik dat hij wel zoekt naar een strakkere aansluiting van de sata voedingskabels?

Met zoiets als

[afbeelding]

krijg je je voedingsbekabeling wel veel strakker bij een high density setup.

Maar hoe en/of met wat voor gereedschap wordt dat gemonteerd (de kabel in dat mesje aanduwen)?

[ Voor 4% gewijzigd door cj1 op 15-04-2014 17:55 . Reden: @BartNL ingevoegd ]

Panasonic WH-MDC05F3E5, PAW-DHWM80ZNT, 3×Fronius IG Plus, Diehl Platinum 2100H, Mean Well TS-200, Studer AJ400-48, 18×Rept CB75, AHED-BMS, Energiek/Greenchoice 3j

zou denk ik met een punchdowntool kunnen maar dan moet het wel een versie zonder mesje zijn. Zelf heb ik het met een plattje schroevendraaier gedaan die net tussen de mesjes paste.cj1 schreef op dinsdag 15 april 2014 @ 17:54:

Maar hoe en/of met wat voor gereedschap wordt dat gemonteerd (de kabel in dat mesje aanduwen)?

Wel opletten dat bij het aandrukken de aders echt diep genoeg in het mesje komen, Dit ging bij mijn eerste poging mis

Zoals BartNL hierboven; met een platte schroevendraaier gedaan..

[ Voor 9% gewijzigd door Pakjebakmeel op 15-04-2014 20:04 ]

netjes gedaan en zijn ze nog oranje ook...Pakjebakmeel schreef op dinsdag 15 april 2014 @ 20:03:

Hier zijn beide :-)

één van de systemen is een haswell configuratie met een xeon 1230v3 en een supermicro bord (uit mijn hoofd een x10slh). Op de 6 onboard sata 3 poorten zitten 4 ssd's en 2 standaard 2,5 inch schijven. De performance van de ssd's op de sata 3 poorten zijn goed (400-500mb/s read/write).

Omdat alle onboard aansluitingen zijn benut heb ik een IBM M1015 IT (x8 slot) aangesloten die ik nog had liggen met daaraan een Samsung 840 250gb. Echter is de performance behoorlijk slecht. Reads zijn goed 430-460mb/s de write is 140mb/s. De 4k seq write rond de 0,50 en na een seconde of 20 stopt de test. De IBM M1015 gebruikt de laatste LSI_SAS2 driver en heb de laatste firmware gebruikt (p18). Gebruikt op Hyper-v 2012 r2. Ook heb ik de controller in een ander systeem getest (windows 8.1)

Deze schijf heb ik ook aangesloten op de onboard en dan zijn de writes en de 4k prima.

Iemand een idee wat het zou kunnen zijn? Of is de IBM M1015 gewoon niet goed genoeg voor gebruik met SSD's?

Het grote DIY RAID NAS topic deel 3

of een eigen topic starten met daarin bovenstaande info, en wat je al geprobeerd hebt.

en welk OS bovenop je hyper-v gebruikt die controller ?

heb je die doorgegeven via VT-* of zit hyper-v er nog tussen ?

[ Voor 63% gewijzigd door soulrider op 19-04-2014 19:17 ]

Direct op de hyper-v zelf getest omdat het voor VM's gebruikt gaat worden. Maar zal hem in de aangegeven topic plaatsen.

[ Voor 38% gewijzigd door FireDrunk op 27-04-2014 15:10 ]

Even niets...

SAS expander op zich lijkt mij bij de bandbreedte van de gebruikte LSI hardware met 16 disks geen probleem. Of is probleem dat de onboard controller niet in passthrough / IT mode kan?FireDrunk schreef op zondag 27 april 2014 @ 15:09:

Al gezien, is met een SAS Expander... Leuk, maar in veel gevallen niet handig (ZFS).

Om heftige discussies te voorkomen in het topic, lees eerst goed de start post om te weten waar aan het systeem moet voldoen. Ben je van mening dat jouw systeem toch in dit topic hoort maar valt hij niet binnen de gestelde eisen, neem dan contact op met een van de auteurs van dit topic zij zullen open staan voor goede argumenten, zoals ook vermeld in de start post.

Gebruik de in de TS geplaatste tabel om dit topic leesbaar te houden!

:strip_exif()/u/340453/crop67a669ce4f1f4_cropped.webp?f=community)

:strip_icc():strip_exif()/u/139376/27e.jpg?f=community)

:strip_icc():strip_exif()/u/75828/sid.jpg?f=community)

/u/170728/owl.png?f=community)

:strip_icc():strip_exif()/u/64434/garfield_AIM2.jpg?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

:strip_icc():strip_exif()/u/269773/profielfoto.jpg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_icc():strip_exif()/u/61950/hakker.jpg?f=community)

:strip_icc():strip_exif()/u/170724/i.jpg?f=community)

/u/217664/crop57a47149436c0_cropped.png?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_exif()/u/3287/crop6274f828ec8f4.gif?f=community)

/u/231803/ramdisk2.png?f=community)

:strip_icc():strip_exif()/u/824/crop57b4d0475dd4b_cropped.jpeg?f=community)

:strip_exif()/u/24321/motor1.gif?f=community)

:strip_icc():strip_exif()/u/141265/soulrider.jpg?f=community)

:strip_exif()/u/128173/crop59a1592e54731_cropped.gif?f=community)

:strip_icc():strip_exif()/u/222428/rijksoverheid60.jpg?f=community)

/u/87795/voetje.png?f=community)