60 TB can not be enough

met 45 schijven van 4TB geraak je daar aan bruto 180 TB in 4u

(nr.1 op de lijst heeft de versie 1 nagebouwd)

Misschien handig om een inkoopactie te doen voor dat chassis?

Ikzelf heb ondertussen nog een ander chassis gespot waar meer in kan in dezelfde 4u-ruimte (60 HDD's)

maar daar moet ik nog mijn hoofd overbreken qua nabouwbaarheid en hoe er het moederbord en controllers bij in kan.

Over een jaar denk ik dan wel een na over echte nabouwbaarheid, als die schijven terug goedkoper zijn

[ Voor 8% gewijzigd door soulrider op 13-12-2011 17:36 ]

Correctie, mijn versie is geen versie 1 eerder de 2e maar zelfs dat is het niet exact. Er zijn zelf nog e.e.a. aan design wijzigingen doorgevoerd. En echt een v2 kan je het niet noemen, mijn ''versie'' kan je ook prima uitrusten met 3 of 4TB disks.soulrider schreef op dinsdag 13 december 2011 @ 13:54:

voor diegenen die +100TB in 1 chassis willen zien: storagepod v2 van backblaze nog niet gezien?

met 45 schijven van 4TB geraak je daar aan bruto 180 TB in 4u

(nr.1 op de lijst heeft de versie 1 nagebouwd)

Misschien handig om een inkoopactie te doen voor dat chassis?

Ikzelf heb ondertussen nog een ander chassis gespot waar meer in kan in dezelfde 4u-ruimte (60 HDD's)

maar daar moet ik nog mijn hoofd overbreken qua nabouwbaarheid en hoe er het moederbord en controllers bij in kan.

Over een jaar denk ik dan wel een na over echte nabouwbaarheid, als die schijven terug goedkoper zijn

Verder blijft een 60 HDD variant interessant, daar zit ik ook over te denken voor Build 3 alleen zal ik dan denk ik wel moeten uitwijken naar een mATX bord.

[ Voor 10% gewijzigd door Perkouw op 15-12-2011 17:51 ]

dat betekent dus dat ze weer goedkoper worden!

snel maar even wat caviar black's inslaan voordat de volgende vloedgolf komt!

nadat ze wat goedkoper zijn uiteraard!

Care to share about the 60 HDD's? Interessantsoulrider schreef op dinsdag 13 december 2011 @ 13:54:

voor diegenen die +100TB in 1 chassis willen zien: storagepod v2 van backblaze nog niet gezien?

met 45 schijven van 4TB geraak je daar aan bruto 180 TB in 4u

(nr.1 op de lijst heeft de versie 1 nagebouwd)

Misschien handig om een inkoopactie te doen voor dat chassis?

Ikzelf heb ondertussen nog een ander chassis gespot waar meer in kan in dezelfde 4u-ruimte (60 HDD's)

maar daar moet ik nog mijn hoofd overbreken qua nabouwbaarheid en hoe er het moederbord en controllers bij in kan.

Over een jaar denk ik dan wel een na over echte nabouwbaarheid, als die schijven terug goedkoper zijn

They call her... c*ck juggeling Thunderc*nt!

een commerciële 60dics-variant is hier of in het diy-topic al eens gelinkt. bv Nexsan E60lampie1979 schreef op vrijdag 16 december 2011 @ 00:54:

[...]

Care to share about the 60 HDD's? Interessant

en door de bouw van perkouw wou ik mijn hoofd eens breken hoe zo'n variant kon nagebouwd worden incl. moederbord en controllers in dezelfde case. (60 vs 45 schijven = 240TB vs 180TB met 4TB/schijf)

Momenteel is het enkel nog een "idee tot onderzoek voor nabouw", mocht het tot een uitgewerk plan komen, dan zie/hoor je er via hier meer van. Zekers zodra ik aan de bouw zou beginnen.

@perkouw: blijkbaar had ik me vergist in de versie die jou de inspiratie gaf tot nabouw, waarvoor excuses. Bedankt voor de extra informatie in ieder geval

Verwijderd

Beste Analog, ik had in mijn reactie van 13 december om 11.12 al duidelijk gemaakt dat ik dat juist nou niet wil. Ik ga een eigen case bouwen op mijn manier en met de indeling zoals ik het wil. Hiervoor heb ik al diverse bouwtekeningen gemaakt hoe het in elkaar komt te zitten, wel is het een feit dat er nog vaak aanpassingen worden gemaakt. De meeste hardware heb ik al liggen en is het niet de bedoeling om allerlei extra hardware te kopen, het enige waar ik nog voor moet zorgen zijn voedingen en harddisks.analog_ schreef op vrijdag 16 december 2011 @ 23:01:

KeDeShe, kijk naar losse array shelves en die aan te sluiten met external sas, je kan ze zelf maken door gebruik te maken van die 36port Chenbro expander (3x) en dan 2 (single link) of 3 (dual link) Perc6/e kaartjes of iets dergelijks.

Btw...mijn naam is KeDeShCh en geen KeDeShe

My bad voor de naam, maar ik zie niet in (je reactie van 13/12 11.12AM) waarom een custom case die chenbro hardware uitsluit. Ik ben in ieder geval benieuwd naar je constructie, SAS expanders is the way to go volgens de ZFS kenners. Ik heb thuis bv. een paar 3U 19" 3com redundant power supply cases staan die op dergelijke manier mooi aan elkaar geknoopt kunnen worden, vol geladen met disks.Verwijderd schreef op vrijdag 16 december 2011 @ 23:31:

[...]

Beste Analog, ik had in mijn reactie van 13 december om 11.12 al duidelijk gemaakt dat ik dat juist nou niet wil. Ik ga een eigen case bouwen op mijn manier en met de indeling zoals ik het wil. Hiervoor heb ik al diverse bouwtekeningen gemaakt hoe het in elkaar komt te zitten, wel is het een feit dat er nog vaak aanpassingen worden gemaakt. De meeste hardware heb ik al liggen en is het niet de bedoeling om allerlei extra hardware te kopen, het enige waar ik nog voor moet zorgen zijn voedingen en harddisks.

Btw...mijn naam is KeDeShCh en geen KeDeShe

[ Voor 8% gewijzigd door analog_ op 17-12-2011 16:28 ]

Verwijderd

Die Chenbro wordt uitgesloten omdat ik het op mijn eigen manier wil doen en daar heb ik al verschillende ideeën voor. Het wordt dus geen kant en klare 5in3, 4in3 of shelve oplossingen. En waar lees je dat ik ZFS ga gebruiken?? Want eerlijk gezegd, ook dat is niet de bedoeling. Misschien ga ik er ooit mee stoeien, maar nu nog niet. Verder tik ik niets meer over dit project, men ziet het wel verschijnen.

Even niets...

Je moet geen SSD's achter een SAS expander hangen, maar met SATA600 en gewone schijven heeft een SAS expander (zeg 8 -> 24) een minimale impact op de performance. Een SAS expander is redelijk intelligent, en multiplexed een sata disk met beschikbare data gewoon dynamisch naar een vrije poort, of de poort met de minste data gequeued. De communicatie tussen de SAS expander en controller is SAS, wat ook nog eens een stuk efficienter is (full duplex) dan SATA. SUN gebruikt zelf ook SAS expanders in hun grote storage dozen met SATA schijven! Overgens heb je ook niet echt veel keus als je veel schijven aan wil sluiten. Vrijwel alle SAS controllers met meer dan 8 poorten hebben gewoon een SAS expander on board om het aantal poorten te verhogen.FireDrunk schreef op zaterdag 17 december 2011 @ 18:01:

SAS Expanders is juist niet the way to go... Je wil geen bandbreedte delen met ZFS.

SATA port multipliers is een heel anders verhaal, en moet je inderdaad niet gebruiken. Verder schijnt de opensolaris mpt2sas driver problemen te hebben met SAS expanders, dus ook in dat geval geen goed idee.

Door wat extra weekenddiensten en meerwerk heb ik de behuizing en voeding kunnen upgraden tov mijn oorspronkelijke ontwerp.

Ik wilde een energiezuinig en zo stil mogelijk systeem bouwen. Qua geluid ben ik dik tevreden, hij is praktisch onhoorbaar terwijl ik (zie foto's) aan de terminalkast zit te werken. Qua energieverbruik, ben ik nog niet helemaal tervreden; het downspinnen van de 10 Samsungs F4 2TB wil mij in FreeNAS 8.02 niet lukken.

Ik draai nu Freenas vanaf een USB stick op het moederbord, maar zodra ZFSGuru 0.2 uit is en de eindejaarsuitkering

De specs:

| System specifications | |

| Component | Value |

|---|---|

| Case | Lian Li 343B Cube |

| CPU | Intel Xeon E3-1220 |

| RAM | Kingston ValueRAM KVR1333D3E9SK2/8 x2 = 16Gb |

| Motherboard | Intel S1200BTS |

| Operating system | FreeNAS 8.02 |

| Controller | LSI SAS 9211-8i |

| Hard drive | Samsung EcoGreen F4EG HD204UI, 2TB (10x) |

| RAID array configuration | RAID-Z2 |

| Netto storage capacity | 16 TB |

| Network | Gigabit |

| UPS | Nee |

| Filesystem | ZFS |

| Idle power usage | ongeveer 90 Watt |

| Extra | Seasonic 460 Watt fanless voeding, geluidsisolatiematten op de bodem en zijkanten, fans van de Corsair radiator vervangen door 2 Noctua's ULN, fans van de hot-swap Lian-Li drive bays vervangen door stille Nexus PWM 120 mm's, tevens als outake fan in het rechtercompartiment |

https://picasaweb.google....uthuser=0&feat=directlink

Edit:

Met dank aan Q voor het helpen plaatsen van de foto

[ Voor 13% gewijzigd door Psycho_Bartje op 20-12-2011 21:59 ]

Nette bak, die Lian Li blijft een beest van een kast.Psycho_Bartje schreef op zondag 18 december 2011 @ 15:39:

..snipzzz..

De specs:

System specifications Component Value Case Lian Li 343B Cube CPU Intel Xeon E3-1220 RAM Kingston ValueRAM KVR1333D3E9SK2/8 x2 = 16Gb Motherboard Intel S1200BTS Operating system FreeNAS 8.02 Controller LSI SAS 9211-8i Hard drive Samsung EcoGreen F4EG HD204UI, 2TB (10x) RAID array configuration RAID-Z2 Netto storage capacity 16 TB Network Gigabit UPS Nee Filesystem ZFS Idle power usage ongeveer 90 Watt Extra Seasonic 460 Watt fanless voeding, geluidsisolatiematten op de bodem en zijkanten

Als er voldoende overblijft van de eindejaarsuitkering dan staat de 343B Cube bovenaan m'n hardware lijstje.

[ Voor 6% gewijzigd door Pantagruel op 18-12-2011 23:05 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

De performance zal met harde schijven achter een expander niet noemenswaardig beïnvloed worden. Sas expanders worden op grote schaal toegepast in enterprise storage systemen, ook die van Sun. Voor een thuisgebruiker die alle storage intern in het kastje heeft, hebben sas expanders nauwelijks voordelen. Voor de prijs van een sas expander koop je twee losse achtpoorts sas-adapters. Het energieverbruik van een sas-expander is ook niet gering en is vergelijkbaar of meer dan een sas-controller. Zolangs je vrije pci express-slots hebt kun je beter extra sas-adapters kopen.FireDrunk schreef op zaterdag 17 december 2011 @ 18:01:

SAS Expanders is juist niet the way to go... Je wil geen bandbreedte delen met ZFS.

Als je deze posting doorneemt dan zie je inderdaad dat met een toenemend aantal HDD's aan de expander backplane de RAID-0 performance gaat slingeren en af gaat vlakken. De backplane loopt tegen de beperking aan van de dual linked verbinding aan.Femme schreef op zondag 18 december 2011 @ 23:31:

[...]

De performance zal met harde schijven achter een expander niet noemenswaardig beïnvloed worden. Sas expanders worden op grote schaal toegepast in enterprise storage systemen, ook die van Sun. Voor een thuisgebruiker die alle storage intern in het kastje heeft, hebben sas expanders nauwelijks voordelen. Voor de prijs van een sas expander koop je twee losse achtpoorts sas-adapters. Het energieverbruik van een sas-expander is ook niet gering en is vergelijkbaar of meer dan een sas-controller. Zolangs je vrije pci express-slots hebt kun je beter extra sas-adapters kopen.

Maarrr, het is inderdaad maar net waar je een probleem van wilt maken en voor de hobbyist/thuissituatie is t eerder een luxe probleem (tenzij je 10Gbit in je huis gebruikt voor je netwerk).

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Oke

i7 Engineering sample

12gb ddr3 @ 2ghz

2X 5870`s @ 1ghz / 5,5 ghz

6 HDD`s van 2 TB (7,6 tb in gebruik)

1 SSD van 80 gb

OS: Win 7

Systeem daait nu 2 jaar probleem loos!!

[ Voor 43% gewijzigd door Xanquezer op 19-12-2011 12:19 ]

DPC Chef-kok :)

edit:

freak1 is me voor met het posten van de regeltjes, maar 't volgende wil ik je niet ontnemen:

Indien je niet aan een van de criteria voldoet maar van mening bent dat je toch een hele interessante build hebt gemaakt, leg het gerust voor. De criteria die altijd blijft staan is dat het systeem van jezelf moet zijn en in de privé sfeer gebruikt moet worden.

maar dat is vooral van toepassing zodra je voldoet aan de "dedicated hardware" & "minstens 10TB"-regels.

dan zijn ze wat soepeler over de "redundancy"-regel (zie huidige nr1)

tot dan is het een game-pc met wat opslag

(en dan zou ik die van mij ook kunnen posten die voldoet ruim aan de "minstens 10TB"-regel)

edit2: 6x2TB is inderdaad 12TB, dus wel +10TB. Maar wellicht wordt slechts 5x 2TB overgezet naar dedicated hardware, en dan zit je erop of eronder, niet erover ;-)

[ Voor 92% gewijzigd door soulrider op 19-12-2011 14:30 ]

hoort niet helemaal aan de regels.

Maar, weetje wat het is.

Binnen kort (een deze dagen) gaan de hdd`tjes in een nieuwe kast met mobotje cputje en netwerkkaart (gbit + glasvezel)

Hoor ik dan wel in het rijtje?

DPC Chef-kok :)

nee.Xanquezer schreef op maandag 19 december 2011 @ 13:08:

I know

hoort niet helemaal aan de regels.

Maar, weetje wat het is.

Binnen kort (een deze dagen) gaan de hdd`tjes in een nieuwe kast met mobotje cputje en netwerkkaart (gbit + glasvezel)

Hoor ik dan wel in het rijtje?

de regels;

1.Dedicated server systeem (niet in gebruik als werkstation / game systeem) dus NAS of Virtualisatie server.

2.Een netto capaciteit van minimaal 10 TB.

3.Deze storage moet in 1 systeem (chasis) zitten.

4.Deze storage dient in een prive sfeer te functioneren (lees thuis), en eigendom van de poster.

5.Toepassing van redundancy, het systeem moet falen van minimaal 1 storage disk kunnen overleven.

6.Er moet een post zijn met informatie over het systeem. Vertel iets meer over je systeem en waarom je bepaalde keuzes hebt gemaakt. Let op: Je post gebruikt de tabel zoals onderaan deze topic start weergegeven. Dit maakt je topic veel leesbaarder.

7.Foto's van binnen en buitenkant zijn vanaf nu 'verplicht'. Pics or it didn't happen

1 en 2 niet aan voldaan, 5 is onduidelijk, 6 ook niet aan voldaan..

60 TB can not be enough

Voor oud en nieuw heb ik hem klaar

komt helemaal goed!

Bedankt voor je lijstje!1!!!

alleen puntje 5 snap ik niet helemaal.

Als je raid 0 draait en 1 (v.d. 2) hdd valt uit, heb je geen backup...

Of is het verplicht om mirremorring te doen?

DPC Chef-kok :)

ligt het nu aan mij of is 6x2TB>10TB?freak1 schreef op maandag 19 december 2011 @ 13:14:

[...]

nee.

de regels;

1.Dedicated server systeem (niet in gebruik als werkstation / game systeem) dus NAS of Virtualisatie server.

2.Een netto capaciteit van minimaal 10 TB.

3.Deze storage moet in 1 systeem (chasis) zitten.

4.Deze storage dient in een prive sfeer te functioneren (lees thuis), en eigendom van de poster.

5.Toepassing van redundancy, het systeem moet falen van minimaal 1 storage disk kunnen overleven.

6.Er moet een post zijn met informatie over het systeem. Vertel iets meer over je systeem en waarom je bepaalde keuzes hebt gemaakt. Let op: Je post gebruikt de tabel zoals onderaan deze topic start weergegeven. Dit maakt je topic veel leesbaarder.

7.Foto's van binnen en buitenkant zijn vanaf nu 'verplicht'. Pics or it didn't happen

1 en 2 niet aan voldaan, 5 is onduidelijk, 6 ook niet aan voldaan..

Bovendien als 1 disk faalt heeft hij "mogelijk" dataverlies. Punt 5 is dus niet gespecificeerd. Niet alles hoeft een vorm van raid te hebben om meerdere keren op een systeem te staan. En dan is het nog steeds 10TB

En dan blijft dus enkel punt 1, 5 en 6 over.

Verwijderd

En dat is dan nog RAID0, terwijl ZFS pas echt problemen krijgt met RAID-Z doordat de latency van deze RAID3-achtige techniek zeer belangrijk zijn.Pantagruel schreef op maandag 19 december 2011 @ 12:04:

Als je deze posting doorneemt dan zie je inderdaad dat met een toenemend aantal HDD's aan de expander backplane de RAID-0 performance gaat slingeren en af gaat vlakken.

Maar Femme zegt het aardig, als je genoeg PCI-express poorten hebt dan hebben expanders geen meerwaarde. Het is nauwelijks goedkoper en soms ook duurder dan losse HBA controllers, en verbruikt ook extra stroom. Je kans op problemen met compatibilteit of op performance-vlak nemen ook toe, en daar tegenover staan erg weinig voordelen. Als je al hardware hebt kun je het prima gebruiken en als het prima werkt, mooi dan. Maar zeker voor ZFS zou ik expanders sterk afraden voor een nieuwe build; je schiet er weinig mee op en ZFS is meer dan andere systemen gevoelig voor het delen van bandbreedte.

als je raid 0 draait ben je alles kwijt als 1 van de disks uitvalt. de eis voor het topic is dat je storage volume het verlies van 1 schijf kan overleven, en toch een netto storage capaciteit van minimaal 10 TB hebtXanquezer schreef op maandag 19 december 2011 @ 13:29:

@ freak 1

Voor oud en nieuw heb ik hem klaar

komt helemaal goed!

Bedankt voor je lijstje!1!!!

alleen puntje 5 snap ik niet helemaal.

Als je raid 0 draait en 1 (v.d. 2) hdd valt uit, heb je geen backup...

Of is het verplicht om mirremorring te doen?

je hebt gelijk, ik las dat er 7,6 TB ruimte over bleef, tenminste, zo las ik "in gebruik". waarschijnlijk is dat dus de schijfruimte die vol isM2M schreef op maandag 19 december 2011 @ 13:33:

[...]

ligt het nu aan mij of is 6x2TB>10TB?

Bovendien als 1 disk faalt heeft hij "mogelijk" dataverlies. Punt 5 is dus niet gespecificeerd. Niet alles hoeft een vorm van raid te hebben om meerdere keren op een systeem te staan. En dan is het nog steeds 10TB

En dan blijft dus enkel punt 1, 5 en 6 over.

60 TB can not be enough

DPC Chef-kok :)

Internal Bitmaps van MDADM zijn sooooo cool!

Er was een disk niet mee gekomen bij het opstarten van mijn NAS. Dat gebeurt wel eens een enkele keer. Dan moet hij een uur of 5 rebuilden en is alles weer koek & ei.

Laatst had ik toch eens internal bitmaps aangezet op de array van 18 TB.

Net dus een middende disk, die weer werkte na een reboot. Ik voeg de disk weer toe aan de array en die is INSTANT gerecovered.

5 uur recoveren of 1 seconde.

Vette shit.

mdadm --grow /dev/mdx --bitmap=internal en je bent up&running. Bij mij gaf dit ook geen performance issues.

http://askubuntu.com/ques...adm-to-an-external-bitmap

Jij had toch xfs? Heb je geen problemen?

Even niets...

Dat is voor een external bitmap. Ik heb een internal bitmap aangezet.DjCoke schreef op woensdag 21 december 2011 @ 21:15:

Hier staat wel dat het unsafe is voor andere filesystems dan ext2 en 3

http://askubuntu.com/ques...adm-to-an-external-bitmap

Jij had toch xfs? Heb je geen problemen?

nieuws: Hitachi verkoopt 4TB-harddisk in Japan

Any intelligent fool can make things bigger, more complex, and more violent. It takes a touch of genius -- and a lot of courage -- to move in the opposite direction.

True, als ik kijk naar wat ik aan storage heb, ga ik voorlopig geen nieuwe cq. uitbreiding aanschaffen. Was meer een vraagjeWouter.S schreef op donderdag 22 december 2011 @ 09:31:

Plaats daartegenover de prijzen van HDD's met de grootste opslag per disk en de recente overstromingsproblematiek die alle andere schijven dubbel zo duur heeft gemaakt. Volledig nieuwe builds zijn qua kosten serieus in prijs gestegen dus volgens mij gaan we geen extreme toestroom zien aan nieuwe storage systemen die de huidige eisen halen, toch niet voor het einde van 2012 in mijn ogen.

Eerst had je minimaal 6x 2TB nodig om uberhaupt in aanmerking te komen. Met de komst van de 4TB lukt het je al met 4 schijven.

Ik verwacht dat de limiet volgend jaar wel naar 20 TB gaat.iMars schreef op donderdag 22 december 2011 @ 08:48:

Gaan er binnenkort regels veranderd worden in dit topic? Met de komst van 4TB schijven is het wel heel makkelijk om aan de regels te voldoen. 4x 4TB in RAID5 is al 12TB netto opslag

nieuws: Hitachi verkoopt 4TB-harddisk in Japan

Dat ik mijzelf daarmee uitsluit, jammer dan.

Er komt dan ook een nieuw topic denk ik dat een opgeschoonde versie gaat worden van dit topic.

[ Voor 12% gewijzigd door Q op 22-12-2011 15:23 ]

iMars schreef op donderdag 22 december 2011 @ 09:38:

[...]

True, als ik kijk naar wat ik aan storage heb, ga ik voorlopig geen nieuwe cq. uitbreiding aanschaffen. Was meer een vraagjeIk heb 4x Samsung HD204UI en 4x Seagate Barracuda Green welke beide cá 250% duurder zijn geworden

Eerst had je minimaal 6x 2TB nodig om uberhaupt in aanmerking te komen. Met de komst van de 4TB lukt het je al met 4 schijven.

LOL, begint op een ware wapenwedloop te lijkenQ schreef op donderdag 22 december 2011 @ 15:17:

[...]

Ik verwacht dat de limiet volgend jaar wel naar 20 TB gaat.

Dat ik mijzelf daarmee uitsluit, jammer dan.

Er komt dan ook een nieuw topic denk ik dat een opgeschoonde versie gaat worden van dit topic.

Inderdaad, als 3 en 4 TB drives gemeen goed en betaalbaar worden is het relatief eenvoudig om 10+ TB aan opslag te realiseren. Betekend ook dat zij die nu met hun array van 2 TB drives tegen de 20 TB aanschurken door een 3x4 TB in RAID-5 er bij te steken meteen weer meedoen in de 20+ league.

Maar zoals Q liet vallen, jammer dan. Mee doen in de "gekte" mag en is geen verplichting, hoe aantrekkelijk de 'braggin' rights' van een monster server ook mogen zijn.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

De vraag is hoeveel van de 'kleine' builds echt interessant zijn. No offence. Maar dat zijn toch vaak stock oplossingen: standaard kast met veel disks, freenas ofzo en klaar.

Of dat je simpelweg moet aangeven waarom het zo'n boeiende build is. Denk aan dat je NAS heel efficiënt is met energie door bestanden te verplaatsen van langzame naar snelle schijven voor meer gebruikte mappen/bestande/... (Een deel is caching, maar misschien kan dit ook met een mooi script.) Of dat de rebuild zo belachelijk snel is, of...

Nu klinkt dit als lastig, maar juist de mensen die er tijd in hebben gestoken weten dat hun oplossing ergens erg goed in is. Die mensen wil je nu net in het topic hebben.

Bijvoorbeeld:

- Minimaal 10 disks

- Minimaal 2TB per disk

Je zou eventueel het volgende ook kunnen eisen om opgenomen te worden:

- RAID controller + Cache + BBU

- 1 of meer SSD's voor cache

Even niets...

Je ontkomt er niet aan om eens in de zoveel tijd de minimum opslagcapaciteit te verhogen om zo'n lijst interessant te houden. De komst van 4TB-schijven lijkt me een goed moment om het minimum te verhogen naar 20TB brutocapaciteit.

Ik vind dat er met name aan de onderkant teveel dezelfde builds zitten. Ook mis ik vaak het 'verhaal' bij de kast. De sales pitch aan anderen waarom jouw build boeit. Waarom moeten andere mensen blij worden van jouw build?

@Femme: bruto vs. netto: dat is een interessant punt. De lijst is nu op netto storage capaciteit ingedeeld om maar 1 reden. Als gebruiker boeit mij alleen de netto capaciteit. Hoeveel storage heb ik echt in mijn handen. Het gaat mij om 'echte' storage. Bruto capaciteit boeit mij persoonlijk niet zo, maar misschien moet ik het vanuit een ander standpunt bekijken? Als je dus twee builds hebt, 1 met en 1 zonder of met minder redundancy, dan wint de onveiligere oplossing. Bij gelijke bruto capaciteit zou ik daarna op netto capaciteit sorteren en dan wint weer het onveilige systeem.

Bij gelijke netto capaciteit zal een redundante oplossing van meer disks gebruik moeten maken en meer disks kan ook 'interessanter' zijn. Maar die paar disks gaan denk ik niet het verschil uitmaken of een build ook echt interessant is of niet.

Mogelijk dat ik de komende tijd eens heel kritisch door de huidige lijst ga en iedere individuele build ga 'herbeoordelen'. Ik verwacht dat er dan wel wat systemen uitgegooid gaan worden. Het gaat mij om kwaliteit, niet om kwantiteit.

[ Voor 9% gewijzigd door Q op 23-12-2011 13:57 ]

http://hardforum.com/show...1038161307&postcount=1471brederodekater schreef op vrijdag 23 december 2011 @ 13:28:

De eerste 4TB schijven komen nu al aan bod op Hardforum http://hardforum.com/showthread.php?t=1393939&page=74 (12-18-2011, 02:06 PM)

P.S. over zijn huidige storage: Holy Shit

[ Voor 6% gewijzigd door Q op 23-12-2011 13:43 ]

Duidelijk meer een hobby dan een must voor hem; 50.6 TB in zijn "storage only system" & maar 6.07 TB in gebruikQ schreef op vrijdag 23 december 2011 @ 13:42:

[...]

http://hardforum.com/show...1038161307&postcount=1471

P.S. over zijn huidige storage: Holy Shit

Da's misschien ook een leuke toevoeging; dat mensen een indicatie geven m.b.t de gebruikte ruimte in hun systeem.

[ Voor 14% gewijzigd door brederodekater op 23-12-2011 14:06 ]

hoger netto + hoger raid-level = hoger in de lijst?

bruto als indicatie van: "waarvoor betaal je, en wat heb je"

en is veel storage niet voor iedereen een hobby?

sommigie kopen on-demand schijven bij en maken een grote 'JBOD'

anderen doen een goede investering om de paar maanden/jaren om genoeg ruimte en 'peace-of-mind' te hebben

Even niets...

Zo'n 4TB aan data bestaat uit raw AVI materiaal en afgeronde projecten, het andere deel is de mp3/flac versie van de cd collectie (ca 0.6 TB), tv series (ca 1 TB), DVD collectie (ca 2.3 TB) en backups van user files van 3 pc's (ca 1 TB).

Wat me persoonlijk 'gelukkig' maakt is dat de data eindelijk echt centraal staat ipv over een viertal machines verspreidt en de RAID-Z2 (=RAID-6) een redelijke mate van robuustheid geeft.

[ Voor 26% gewijzigd door Pantagruel op 23-12-2011 20:18 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik vind het eigenlijk niet eens zo'n gek idee, het eerste voorstel. Het tweede vind ik wat minder. Ik meen me een *kuch* 90TB *kuch* NAS te herinneren gebaseerd op softraid die hier echt wel thuis hoortCorteztm3 schreef op vrijdag 23 december 2011 @ 12:40:

Is het een idee om een minimaal aantal disks te eisen van een minimale grote.

Bijvoorbeeld:Dan zal de gebruiker een RAID controller moeten gebruiken omdat moederborden met 10 SAS/SATA schijven dun gezaaid zijn.

- Minimaal 10 disks

- Minimaal 2TB per disk

Je zou eventueel het volgende ook kunnen eisen om opgenomen te worden:

- RAID controller + Cache + BBU

- 1 of meer SSD's voor cache

Als iemand 10x 1TB in RAID5/6/what-ever zet, vind ik eigenlijk ook wel hier thuis horen. Misschien minder interessant qua opslag capaciteit, maar toch veel meer dan een standaard NAS van <= 4 disks

Zelf heb ik een Areca 1261 met een BBU.

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

... all gonna wonder how you ever thought you could live so large and leave so little for the rest of us...

Je zou ook een apart lijstje te kunnen maken voor 'featured builds' of de bijzondere builds in de lijst opvallender kunnen weergeven. Dat heeft als voordeel dat je heldere en opjectieve eisen kunt stellen aan systemen die in de lijst opgenomen worden zodat hier geen discussie over kan ontstaan.Q schreef op vrijdag 23 december 2011 @ 13:38:

Het doel van dit topic is het laten zien van interessante builds. De lijst is een overzicht van deze builds.

Ik vind dat er met name aan de onderkant teveel dezelfde builds zitten. Ook mis ik vaak het 'verhaal' bij de kast. De sales pitch aan anderen waarom jouw build boeit. Waarom moeten andere mensen blij worden van jouw build?

Op dit moment zijn systemen zonder of met weinig redundancy erg in het voordeel. Er zijn een paar systemen die geen enkele redundancy hebben. Dat kan prima werken als je alleen data opslaat die eenvoudig vervangen kan worden, bijvoorbeeld omdat usenet als backup dient, en als een hoge beschikbaarheid van de data niet noodzakelijk is. Er zijn andere gebruikers voor wie de veiligheid en beschikbaarheid van data wel van groot belang is. Stellen dat je als gebruiker alleen geïnteresseerd bent in de netto capaciteit is daarom een te beperkte kijk op de werkelijkheid. Mensen die serieus zijn over hun data geven ook om redundancy en beschikbaarheid. Het streven om hoge prestaties te bereiken kan eveneens ten koste gaan van de netto opslagcapaciteit. Door de netto capaciteit te vergelijken creëer je een gelijk speelveld voor iedereen.@Femme: bruto vs. netto: dat is een interessant punt. De lijst is nu op netto storage capaciteit ingedeeld om maar 1 reden. Als gebruiker boeit mij alleen de netto capaciteit. Hoeveel storage heb ik echt in mijn handen. Het gaat mij om 'echte' storage. Bruto capaciteit boeit mij persoonlijk niet zo, maar misschien moet ik het vanuit een ander standpunt bekijken? Als je dus twee builds hebt, 1 met en 1 zonder of met minder redundancy, dan wint de onveiligere oplossing. Bij gelijke bruto capaciteit zou ik daarna op netto capaciteit sorteren en dan wint weer het onveilige systeem.

Om mijn eigen build als voorbeeld te nemen: ik ga twaalf tot zestien 2TB harde schijven gebruiken verdeeld over twee pools waarvan er in ieder geval één in raid 10 zal draaien ten behoeve van de prestaties. Er komen tevens zes ssd's in voor caching en een quad port fibre channel adapter voor snelle I/O. Doel is om een san te bouwen dat kan dienen als vervanging voor direct attached storage in mijn workstation en prestaties biedt op ssd niveau voor veelgebruikte data. Ik heb hele ander eisen dan iemand die een zo groot mogelijke opslagtank voor films wil bouwen. Met een netto opslagcapaciteit van 12-16TB zou het zo kunnen dat mijn build buiten de voorwaarden voor dit showoff topic komt te vallen als de minimum capaciteit wordt verhoogd naar bijv. 15TB, terwijl mijn systeem qua omvang vergelijkbaar is met machines die 22-30TB netto capaciteit storage bieden met 2TB disks in raid 5 en boeiender is dan een off-the-shelf nasje met vier bays gevuld met 4TB disks.

Verwijderd

Welk soort builds dan wel??Q schreef op vrijdag 23 december 2011 @ 23:49:

Het punt is een beetje: een hoop disks kopen, standaard kastje erbij en nog eem raid controller en je hebt zo een setup met 10+ TB. Maar die builds zijn denk ik niet zo heel spannend. Zo'n nas kan iedeen zo wel boywen. Mijn interesse ligt daar niet. Dat soort builds wil ik ook niet meer in de lijst hebben.

Specs op dit moment:

- Tyan S8010-mobo

- Opteron 4122-processor

- 32GB RAM

- Norco RPC-4216 met middenschot voor 3x 120mm fan

- 2x Chieftec hotswap bay voor zes 9,5mm 2,5 inch drives in 5,25 inch bay

- Onboard LSI SAS2008-controller (geflashed met firmware van LSI SAS9211-8i in IT-mode)

- IBM M1015 sas-adapter met LSI SAS2008 (geflashed met zelfde firmware als onboard controller)

- Qlogic QLE 2464 quad port 4Gbps fibre channel-adapter

- 12x Seagate Barracuda Green 2TB disks

- 5x OCZ Vertex 30GB

- 1x OCZ Vertex 120GB

Mogelijk komen er nog vier extra 2TB disks in uit mijn oude server. De ssd's ga ik waarschijnlijk vervangen door nieuwe 64GB Samsung 830's. Ik heb ook nog vier Mtron Mobi 3000's 16GB die dan weg kunnen.

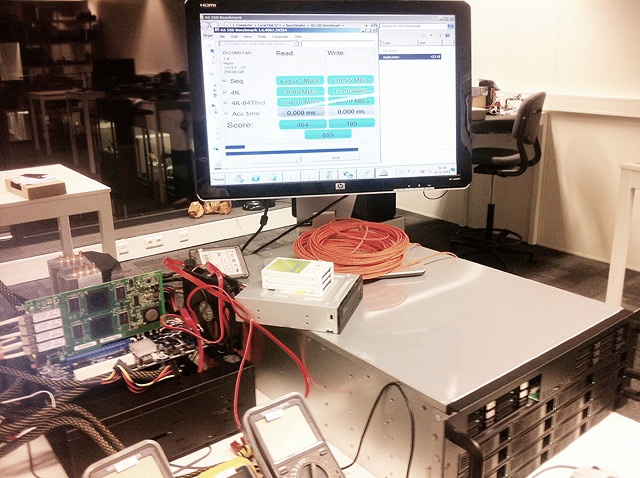

De machine draait OpenIndiana met zfs als bestandssysteem. Ik heb voor fibre channel als interconnect gekozen vanwege compatibiliteit met MacOS X. Het ding komt aan mijn Mac Pro te hangen. Voor Windows en Linux zou Infiniband een goedkoper alternatief zijn geweest. Je hebt voor 100 euro al een 10Gbit Infiniband-adapter. Op de foto is hij gekoppeld aan één van onze twee storage testsystemen waar voor deze gelegenheid Windows Server 2008 R2 op draait. Dit ivm het feit dat Windows 7 geen ondersteuning heeft voor multipath I/O wat je nodig hebt om de vier fibre channel links tegelijkertijd te kunnen gebruiken.

Het configureren van zfs en comstar (scsi framework in Solaris / OpenIndiana waarmee je iscsi, fibre channel en sas targets kunt maken) bleek eenvoudig dankzij de vele online tutorials. De meeste frustratie heb ik gehad aan het aan de praat krijgen van Windows 7-drivers onder Server 2008 (Intel sluit Server 2008 bewust uit in de drivers voor de ethernetcontrollers die het gebruikt op zijn desktopborden terwijl die controllers dus prima werken onder Server 2008 als je de benodigde aanpassingen doet in de inf-bestanden).

Prestaties in AS-SSD:

Dit is ook wel een mooi resultaat (filecopy van ruim 3GB):

| Filecopy to Disk - Large - Gemiddelde doorvoersnelheid | |||

|---|---|---|---|

| Drive | # | RAID | Doorvoersnelheid in MB/s, hoger = beter |

| Zfs 4x 4Gbps fibre channel | 12 | RAID 10 | ********* 1493,11 |

| Adata S511 120GB (run 2) | 4 | RAID 0 | ***** 961,20 |

| Samsung 830 512GB (run 2) | 1 | Single | *** 529,85 |

[ Voor 15% gewijzigd door crisp op 24-12-2011 21:49 ]

even iets anders tussendoor: ik weet niet waarvoor je die multimeters gebruikt, maar dat type heeft al snel een afwijking als de batterij niet goed vol is. En dan met name bij weerstands-metingen.Midas.e schreef op zaterdag 24 december 2011 @ 10:31:

Mee eens, alleen al op bruto storage. Door mijn 2x raid6 arrays ga ik van 32TB bruto naar 22TB netto... daarmee verlies ik alleen al de hoeveelheid die je nodig hebt om deel te nemen in deze lijst

if computergames really affect us, we would be running around in dark rooms and eating magic pills.

Yahoo: eindelijk iemand die mijn lees prestaties van 1.1 GB/s weet te overtreffen.Femme schreef op zaterdag 24 december 2011 @ 01:06:

Hier nog een gare foto van mijn nieuwe build zoals hij nu draait in het testlab van Tweakers.net:

[ Voor 7% gewijzigd door Q op 24-12-2011 13:52 ]

bruto vs. netto

Ik begrijp de argumentatie. Ik ben het er mee eens. In de nieuwe lijst komt een extra kolom 'bruto' capaciteit en die wordt leidend. Net als in het HARD forum maak ik een apart lijstje met een top 5 ofzo van systemen met de grootste netto capaciteit.Daarnaast zou het een optie zijn om de regels niet te streng te maken, zodat de lijst wel relatief groot wordt, maar dat speciale builds als zodanig gemarkeerd worden, met een duidelijke kleur.

Selectie criteria

Ik zou zeggen: 20 TB 'bruto' storage. Dat komt mij ook goed uit want dan mag ik er nog net inVerder gelden de nu al geldende regels. Dat houdt in dat de lijst over tijd wel groter kan groeien, maar door met kleurtjes te werken kunnen we de speciale builds er uit selecteren.

[ Voor 38% gewijzigd door Q op 24-12-2011 13:48 ]

Verwijderd

Ik zou 1 topic willen voor discussie over brute storage en met name over storage die mensen zelf ook hebben gebouwd. Dan ga je dat weer versnipperen.

Ik zie eigenlijk het DIY NAS topic voor de eenvoudigere huis-tuin-en-keuken builds. Dit type topic is voor het wat zwaardere geweld.

Ik heb er geen enkele moeite mee om de 'nieuwe' grens naar 20 TB te trekken als dit de kwaliteit van de lijst en de builds die hier langs komen ten goede komt. Ik zie liever weinig builds die wel stuk voor stuk boeien, dan dat ik een druk vol topic zie met allemaal systemen die niet zo spannend zijn.

Ik wil een soort minimum kwaliteitseis zodat het topic ook voor mensen interessant blijft. Het is niet dat ik een soort kunstmatige exclusiviteit wil creëren met secret handshakes and all. Ik wil alleen toffe builds zien en niet de 13-in-een-dozijn.

[ Voor 8% gewijzigd door Q op 24-12-2011 18:34 ]

Zeer belangrijk criteria imo. Kwestie dat de mensen de klik niet maken om hun MSA, Netapp, EMC², ... uit het testlab op werk te testen.Ik zou 1 topic willen voor discussie over brute storage en met name over storage die mensen zelf ook hebben gebouwd.

Bon, nu terug op de topic en showen maar, die gekke build

Maar juist die 13 in 1 dozijn builds, komen vaker voor, worden vaker gebouwd, en hebben tweakers dus meer behoefte aan.Q schreef op zaterdag 24 december 2011 @ 18:33:

Ik wil een soort minimum kwaliteitseis zodat het topic ook voor mensen interessant blijft. Het is niet dat ik een soort kunstmatige exclusiviteit wil creëren met secret handshakes and all. Ik wil alleen toffe builds zien en niet de 13-in-een-dozijn.

Je zou een topic op kunnen zetten met "extreme" storage systems, voor alles van meer dan 16 disks. Bij meer dan 16 disks aan data praat je vaak over aparte kasten aangezien dat niet past in een gewone case (NORCO's, etc.), top-of-the-line 24-poort RAID kaarten, expanders, etc.. We hebben het dan we over custom builds en niet over kant-en-klare NASen.

[ Voor 4% gewijzigd door tHe_BiNk op 03-01-2012 04:02 ]

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

ik voel toch enigzins wat tegenzin ontstaan tegen mijn "kant-en-klare" Synology.. ook al is t voor thuisgebruik en zit hij op plek 2 qua storagetHe_BiNk schreef op dinsdag 03 januari 2012 @ 03:56:

[...]

Maar juist die 13 in 1 dozijn builds, komen vaker voor, worden vaker gebouwd, en hebben tweakers dus meer behoefte aan.

Je zou een topic op kunnen zetten met "extreme" storage systems, voor alles van meer dan 16 disks. Bij meer dan 16 disks aan data praat je vaak over aparte kasten aangezien dat niet past in een gewone case (NORCO's, etc.), top-of-the-line 24-poort RAID kaarten, expanders, etc.. We hebben het dan we over custom builds en niet over kant-en-klare NASen.

60 TB can not be enough

Hehe, dan kun je altijd nog verhuizen naar het grote Synology topic tussen de DS110 en DS212 NASjesfreak1 schreef op dinsdag 03 januari 2012 @ 07:03:

[...]

ik voel toch enigzins wat tegenzin ontstaan tegen mijn "kant-en-klare" Synology.. ook al is t voor thuisgebruik en zit hij op plek 2 qua storage

daar willen ze me ook al niet hebben omdat "niemand zoiets thuis heeft"brederodekater schreef op dinsdag 03 januari 2012 @ 07:23:

[...]

Hehe, dan kun je altijd nog verhuizen naar het grote Synology topic tussen de DS110 en DS212 NASjes

60 TB can not be enough

De 13-in-dozijn builds kunnen prima terecht in het DIY NAS topic.

Ik kom hier om buitengewone builds te bekijken. Een 'real life' voorbeeld van zo'n Backblaze pod, dat soort dingen. Builds die een default ATX kastje gebruiken en 6 x 2 TB (of 5 x 3, whatever) en daarmee 10TB netto halen vind ik niet zo boeiend, dat lukt mij thuis ook wel.

Juist de uitzonderlijke builds mogen wat mij betreft in dit topic.

[ Voor 2% gewijzigd door Zsub op 03-01-2012 09:10 . Reden: typo trololol ]

[ Voor 127% gewijzigd door Spoooky op 03-01-2012 13:00 . Reden: Herformulering ]

Ik ben spuit 1011, aangenaam!

Mijn standaard Full Tower behuizing heeft plek voor 21 schijven. Op mijn moederbord zit 6x SATA-300 en 4xPCI-E. Genoeg ruimte dus voor PCI-E sata controllers, in plaats van een 24 poorts sata controller kan ik ook gewoon 4x4 poort kopen, scheelt nog geld ook denk ik. En anders met port multipliers gaan werken, dan kom je ook aardig ver.tHe_BiNk schreef op dinsdag 03 januari 2012 @ 03:56:

Je zou een topic op kunnen zetten met "extreme" storage systems, voor alles van meer dan 16 disks. Bij meer dan 16 disks aan data praat je vaak over aparte kasten aangezien dat niet past in een gewone case (NORCO's, etc.), top-of-the-line 24-poort RAID kaarten, expanders, etc.. We hebben het dan we over custom builds en niet over kant-en-klare NASen.

Veel schijven hoeft niet veel te kosten of echt ingewikkeld te zijn.

Probleem is dat je met echte harde limieten al snel uitzonderingen krijgt die niet aan de eisen voldoen en wel interessant zijn. Je zou wat softere regels moeten gebruiken waardoor er meer flexibiliteit is en de aandacht echt kan gaan naar iets wat uitzonderlijk is.

[ Voor 13% gewijzigd door Tsurany op 03-01-2012 12:18 ]

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Een custom made case die net aan de 10 TB komt met 6x2TB in MDADM RAID5?

Of een standaard case volgepropt tot in elk hoekje of gaatje met Harddisks?

Of een NAS op basis van een exotisch OS...

Ik denk dat een build vooral interessant is door een hoog "tweakgehalte", dus hoeveel heb je er voor moeten doen? Of dat nou op hard- of software- gebied is maakt dan weinig uit.

Ik ben spuit 1011, aangenaam!

Lees ik hier tussen de regels door enige vorm van penisnijd?? Het klinkt alsof het 'vroeger' een kunst was om met 1/1,5 TB drives een 10TB array te verwezenlijken, terwijl nu iedere boerenl#l met een schroeven draaier zich kan verheffen tot deze kunst door 4 x 4 TB in R5 te zetten.Zsub schreef op dinsdag 03 januari 2012 @ 09:10:

* Zsub is met Q.

Ik kom hier om buitengewone builds te bekijken. Een 'real life' voorbeeld van zo'n Backblaze pod, dat soort dingen. Builds die een default ATX kastje gebruiken en 6 x 2 TB (of 5 x 3, whatever) en daarmee 10TB netto halen vind ik niet zo boeiend, dat lukt mij thuis ook wel.

Juist de uitzonderlijke builds mogen wat mij betreft in dit topic.

Op die manier kun je iedere build op basis van een commercieel verkrijgbare behuizing (die voor de verdere rest wel aan de gestelde eisen voldoet) afschrijven als 'doorsnee' of 'eenvoudig te bouwen bak' en dus onwaardig.

Ik kan me zeer goed voorstellen dat voor veel mensen een uit de kluiten gewassen kast of een 'kleinere' Norco, meer dan voldoet. Een BackBlaze pod mag dan apart zijn, maar ook die behuizing laat je uiteindelijk aan de hand van hun tekeningen snijden. De eigen input/invloed is ook niet meer dan in het elkaar schroeven en een eigen draai aan de hardware geven die nodig is om de boel te laten werken. Als je maar lang genoeg door redeneert is iedere storage build een kopie of variatie op een ander zijn/haar werk.

Wat volgens mij een build interessant maakt zijn dingen als het hoe en waarom van de storage wens, hoe de invulling plaatsvindt (evt. met onderbouwing van de hardware/software keuze/rek richting de toekomst) en hoe de eigenaar denkt het maximale eruit te halen. Een Gbit draadje voltrekken is inmiddels makkelijk geworden, dus wat komt daar voor in de plaats (Gbit trunk/Fibre/Infiniband) om het achterliggende werkstation maximaal te laten genieten van het opslag monster (en/of de rest van het netwerk).

En dan mag de bak van mij best in een 'big bog standard ATX case' leven.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Quote uit de TS:Tsurany schreef op dinsdag 03 januari 2012 @ 12:16:

[...]

Mijn standaard Full Tower behuizing heeft plek voor 21 schijven. Op mijn moederbord zit 6x SATA-300 en 4xPCI-E. Genoeg ruimte dus voor PCI-E sata controllers, in plaats van een 24 poorts sata controller kan ik ook gewoon 4x4 poort kopen, scheelt nog geld ook denk ik. En anders met port multipliers gaan werken, dan kom je ook aardig ver.

Veel schijven hoeft niet veel te kosten of echt ingewikkeld te zijn.

Probleem is dat je met echte harde limieten al snel uitzonderingen krijgt die niet aan de eisen voldoen en wel interessant zijn. Je zou wat softere regels moeten gebruiken waardoor er meer flexibiliteit is en de aandacht echt kan gaan naar iets wat uitzonderlijk is.

Indien je niet aan een van de criteria voldoet maar van mening bent dat je toch een hele interessante build hebt gemaakt, leg het gerust voor. De criteria die altijd blijft staan is dat het systeem van jezelf moet zijn en in de privé sfeer gebruikt moet worden.

Ik weet dat dit een reactie is op iemand anders maar ik wil dit issue wel aansnijden.Pantagruel schreef op dinsdag 03 januari 2012 @ 17:43:

[...]

Lees ik hier tussen de regels door enige vorm van penisnijd?? Het klinkt alsof het 'vroeger' een kunst was om met 1/1,5 TB drives een 10TB array te verwezenlijken, terwijl nu iedere boerenl#l met een schroeven draaier zich kan verheffen tot deze kunst door 4 x 4 TB in R5 te zetten.

Het is inderdaad anno 2012 nogal makkelijk om een computertje te maken met 6 disk er in, FreeNAS of ubuntu er op en je hebt een 10 TB RAID 5.

Dat soort builds vind ik niet interessant voor dit topic. Het risico is dat het steeds makkelijker wordt om aan de criteria van dit topic te voldoen. Dit topic is bedoeld voor speciale builds. Wat vroeger speciaal was, is nu main-stream.

Niets tegen main-stream, maar dit topic is juist bedoeld om de specials onder de aandacht te brengen. Main-stream mag in het DIY NAS topic.

Dit heeft wat mij betreft niets met penisnijd of elitairisme ofzo te maken. Dit topic moet gewoon interessante builds onder de aandacht brengen. Daarvoor komen mensen nu ook in dit topic.

Dat is natuurlijk helemaal niet de geest van de eisen die worden gesteld. Zo'n BackBlaze pod is gewoon ontzettend cool, net zoals de totaal andere speciale build(s) van Freak1 etc.Op die manier kun je iedere build op basis van een commercieel verkrijgbare behuizing (die voor de verdere rest wel aan de gestelde eisen voldoet) afschrijven als 'doorsnee' of 'eenvoudig te bouwen bak' en dus onwaardig.

Ik kan me zeer goed voorstellen dat voor veel mensen een uit de kluiten gewassen kast of een 'kleinere' Norco, meer dan voldoet. Een BackBlaze pod mag dan apart zijn, maar ook die behuizing laat je uiteindelijk aan de hand van hun tekeningen snijden. De eigen input/invloed is ook niet meer dan in het elkaar schroeven en een eigen draai aan de hardware geven die nodig is om de boel te laten werken. Als je maar lang genoeg door redeneert is iedere storage build een kopie of variatie op een ander zijn/haar werk.

Je kunt natuurlijk alles wel bagataliseren, maar ik doe dat zeker niet. Maar ik bagataliseer wel de simpele builds.

Helemaal mee eens. Het gaat ook niet om de kast, maar of de build boeiend genoeg is. We zitten dus allemaal wel op 1 lijn denk ik.Wat volgens mij een build interessant maakt zijn dingen als het hoe en waarom van de storage wens, hoe de invulling plaatsvindt (evt. met onderbouwing van de hardware/software keuze/rek richting de toekomst) en hoe de eigenaar denkt het maximale eruit te halen. Een Gbit draadje voltrekken is inmiddels makkelijk geworden, dus wat komt daar voor in de plaats (Gbit trunk/Fibre/Infiniband) om het achterliggende werkstation maximaal te laten genieten van het opslag monster (en/of de rest van het netwerk).

En dan mag de bak van mij best in een 'big bog standard ATX case' leven.

Als iemand met een 6 x 2 TB disk RAID 5 komt aanzetten en laat zien hoe dat ding via infiniband wordt ontsloten, reken maar dat je dan aandacht krijgt in dit topic. Dat zou zo'n build toch interessant maken.

[ Voor 60% gewijzigd door Q op 03-01-2012 22:19 ]

Klopt als een zwerende vinger.Q schreef op dinsdag 03 januari 2012 @ 21:58:

[...]

snipzz

Helemaal mee eens. Het gaat ook niet om de kast, maar of de build boeiend genoeg is. We zitten dus allemaal wel op 1 lijn denk ik.

[spoiler modeAls iemand met een 6 x 2 TB disk RAID 5 komt aanzetten en laat zien hoe dat ding via infiniband wordt ontsloten, reken maar dat je dan aandacht krijgt in dit topic. Dat zou zo'n build toch interessant maken.

Daar wordt min of meer aangewerkt.

Ik heb een aantal Mellanox InfiniHosts MHEA28-XTC kaartjes en wat Infiniband SFF-8470 kabels gekocht.

Wat rest is uitvinden of IB onder FreeBSD (ZFSguru) wil werken (Google en fora zullen uitkomst bieden). Anders wordt het overstappen naar Solaris OpenIndiana waar IB wel werkt getuige Femme's data.

Vooralsnog is het wachten op de spullen uit de US en Hongkong begonnen.

Update mbt IB en FreeBSD: Vlgs de OpenFabric wiki komt het goed .."In 2011, OFED stack was ported to FreeBSD and included in FreeBSD 9" ...

Afwachten totdat ZFSguru dus op FreeBSD 9 overstapt.

[ Voor 12% gewijzigd door Pantagruel op 03-01-2012 23:56 . Reden: OFED info ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ahh, dus daar is die infiniband kabel uit vraag&aanbod heengegaan?Pantagruel schreef op dinsdag 03 januari 2012 @ 23:36:

[...]

Klopt als een zwerende vinger.

[...]

[spoiler mode]

Daar wordt min of meer aangewerkt.

Ik heb een aantal Mellanox InfiniHosts MHEA28-XTC kaartjes en wat Infiniband SFF-8470 kabels gekocht.

Wat rest is uitvinden of IB onder FreeBSD (ZFSguru) wil werken (Google en fora zullen uitkomst bieden). Anders wordt het overstappen naar Solaris OpenIndiana waar IB wel werkt getuige Femme's data.

Vooralsnog is het wachten op de spullen uit de US en Hongkong begonnen.

Update mbt IB en FreeBSD: Vlgs de OpenFabric wiki komt het goed .."In 2011, OFED stack was ported to FreeBSD and included in FreeBSD 9" ...

Afwachten totdat ZFSguru dus op FreeBSD 9 overstapt.

De 1 kiest ervoor om het op een vrouwelijke manier op te lossen, de andere doet het op een manlijke manier.freak1 schreef op dinsdag 03 januari 2012 @ 07:03:

[...]

ik voel toch enigzins wat tegenzin ontstaan tegen mijn "kant-en-klare" Synology.. ook al is t voor thuisgebruik en zit hij op plek 2 qua storage

Ik denk dat een grote of kleine NAS niet van elkaar verschilt, en om daar onderscheidt in te maken, niet echt nuttig is. De software, bouw en beheer verschillen niet veel. Of het nu 2 of 48 disks zijn. En dat is ook het voordeel en gemak van dit concept. Echt ideaal voor de "prosumer" en het MKB. Het tweaken heeft dan voornamelijk betrekking op de add-ons.

Bij custom builds vind ik dat er wel een verschil is, tussen klein en groot. Zeker de >16 disks custom builds. En de diversiteit aan hardware/software RAID en OSen.

Idd, dat tweakgehalte is belangrijk. Maar je ziet iedereen vertaalt dat weer anders. Eventuele opdeling van een topic moet het overzichtelijker en relevanter maken voor de lezer. Maar aangezien er niet al te veel 10+ builds zijn, en het een showoff topic is, en geen technisch topic. Kan je, je afvragen of dat überhaupt nut heeft om de boel te splisen. Of de regels te veranderen.Spoooky schreef op dinsdag 03 januari 2012 @ 13:04:

Ik denk dat een build vooral interessant is door een hoog "tweakgehalte", dus hoeveel heb je er voor moeten doen? Of dat nou op hard- of software- gebied is maakt dan weinig uit.

Okay, nu weer ontopic, wie is de eerste met foto's van een nieuwe build.

[ Voor 34% gewijzigd door tHe_BiNk op 06-01-2012 08:29 ]

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

maar hier alvast wat foto's

eronder staat mijn lian li cube

[ Voor 4% gewijzigd door thalantis op 06-01-2012 09:20 ]

LOL, nope, de mijne komt uit hongkong, duurt jammer genoeg wel wat langer. De V&A ad was toen al weg.brederodekater schreef op donderdag 05 januari 2012 @ 21:45:

[...]

Ahh, dus daar is die infiniband kabel uit vraag&aanbod heengegaan?

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

komen als het goed is 24 disken van 2 terabyte in en gaat worden gebruikt als opslag cq backupbrederodekater schreef op vrijdag 06 januari 2012 @ 11:44:

Wat worden de uiteindelijke specs van de machine & waar zal hij voor worden gebruikt?

Het idee voor dit systeem is ontstaan omdat ik ruimte tekort begon te krijgen op m'n werkstation en graag wilde experimenteren met btrfs en zfs. In eerste instantie met 4 2TB disks, maar toen de prijzen plotseling hard begonnen te stijgen heb ik 's avonds toch maar 6 extra schijven besteld bij zercom voor 64€ p/s. Goede timing, want de volgende dag waren er nergens betaalbare schijven meer te vinden!

Hier mijn testsysteem met 10 x 2TB en een M1015 van ebay:

Voor de rest was dit systeem vooral opgebouwd met hardware dit ik nog had liggen. Er was wel wat creativiteit voor nodig om alle schijven in deze kast te krijgen en koel te houden: 10 x 2TB voor m'n array + 2 x laptop schijven 160+500 voor de mirrored root. Ik gebruik voornamelijk Linux, dus het lag voor de hand om m'n nieuwe server ook op Linux te laten draaien.

btrfs viel eigenlijk al snel af als filesysteem, wegens het gebrek aan raid5 support, en de betrouwbaarheid die nog niet optimaal was. ZFS werkte echter vanaf het begin perfect, en is echt een fantastisch filesysteem. Hierdoor kwam ik er ook achter dat mijn hardware niet 100% betrouwbaar was, want een scrub leverde elke keer wel een paar CRC errors op, die overgens netjes gerepareerd werden.

Vanwege de goede ervaringen heb ik toen besloten om een NAS te bouwen zodat ik altijd vanaf overal bij mijn data kan. Mijn eisen voor dit systeem zijn:

| Systeem Eisen | |

| betrouwbaar | Alleen van de belangrijkste data maak ik backups, dus data moet veilig zijn. |

| zuinig | De server zal altijd aan staan, dus energie verbruik is belangrijk |

| performance | Ik wil op m'n werkstation een snelheid die vergelijkbaar is met de areca 1220 -> 8 x 750GB raid5 die in m'n werkstation zat |

| stil | Een systeem wat altijd aan staat wil ik niet kunnen horen. |

Nadat ik de data van mijn werkstation overgezet had paste mijn werkstation in een kleine kast, en kwam de Lian Li v2000 vrij voor mijn NAS. Daarnaast heb ik een nieuw MB + ECC geheugen + proc gekocht, zodat ik betrouwbare hardware heb. Later zijn daar nog 2 SSD's bijgekomen. Dit heeft geresulteerd in het volgende systeem:

| System specifications | |

| Component | Value |

|---|---|

| Case | Lian Li v2000 |

| CPU | Intel Xeon E1220 |

| RAM | 16 GB ECC |

| Motherboard | Supermicro X9SCM-F |

| Operating system | Linux Ubuntu 11.10 |

| Controller | M1015 met 9211 IT firmware |

| Hard drive | 10 x ST2000DL003 (2TB), 1 x ST9500423AS (500GB), 1 x 120GB intel 320, 1 x 128GB Crucial M4 |

| RAID array configuration | 1 pool bestaande uit 2 x 5 disk raidz vdevs |

| Netto storage capacity | 16TB |

| Network | 1 x 1Gb met vlans, 1 x 100Mb remote management, binnenkort: 2 x 10Gb Infiniband |

| UPS | Nee |

| Filesystem | ZFS on linux, daily ppa |

| Idle power usage | 7W uit (alleen IP KVM) 45W met spindown, 90W zonder spindown |

En uiteraard een foto:

Dit systeem is zonder veel problemen uit te breiden tot 24 disks, dus zou wel een tijdje mee moeten kunnen gaan.

Ik heb voor het supermicro X9SCM-F moederbord gekozen omdat ik op zoek was naar een server bordje, met web based KVM, snelle intel SATA3 poorten en veel pci-express 4x/8x sloten. Ik is toevallig dat dit een mATX bordje is, maar ik ben gewoon geen beter bord tegengekomen voor mijn doel. Ik kan nu zelfs vanuit het buitenland bij de console, en kan eventueel de server aanzetten als ik die nodig heb. En aangezien de server headless in een hoekje komt te staan is het zelfs thuis erg handig.

Ik heb gewoon voor de goedkoopste xeon processor gekozen, ik wilde eerst voor de E1220L gaan, maar omdat die slecht leverbaar was maar voor de gewone E1220 gegaan. Ik ben uiteindelijk wel blij met deze keuze. Ik verwacht dat het verbruik in idle tussen deze processoren toch niet zo heel veel zal verschillen, en het is toch wel prettig om performance te hebben als dat nodig is.

Ik ben begonnen met 8GB ECC geheugen, en heb nu 16GB omdat ik ook wat VM's wil laten draaien op deze machine. Ik hoop dat 8GB dimms betaalbaar zijn geworden tegen de tijd dat ik meer geheugen nodig heb.

Ik heb een intel 320 SSD die misbruikt wordt veel te veel verschillende zaken: 10GB ext4 root, 10GB ext4 home, 200 MB efi, 1GB swap, 4GB SLOG, 82G l2arc voor mijn grote array, en 10GB l2arc voor m'n kleine pool. Ik heb voor de intel 320 gekozen vanwege de betrouwbaarheid en de supercapacitor, met als nadeel mindere performance door de limiet van SATA2. Ik heb bewust de SLOG niet gemirrored, het enige risico is dat ik max 30s aan data verlies als de server crashed binnen 30s na het uitvallen van de SLOG. Ik heb er voor gekozen om zoveel mogelijk op de intel SSD te zetten, zodat het systeem in idle alleen op deze disk kan draaien. Tot zover wordt de l2arc nog niet volledig gebruikt, maar mocht ik performance problemen krijgen vanwege fragmentatie kan ik gewoon de l2arc van de poll verwijderen, de hele l2arc trimmen met een scriptje, en de l2arc weer toevoegen. Hierdoor hoef ik geen extra ruimte vrij te laten op de SSD.

Hiernaast heb ik een 500GB laptop disk, met 16GB swap, een 330GB ext4 scratch partitie, en 150GB zfs pool. De scratch partitie wordt gebruikt om downloads tijdelijk op te slaan, zodat mijn grote array niet actief hoeft te zijn tijdens downloads. De zfs pool heeft een l2arc op de intel SSD, en wordt voornamelijk gebruikt om elk uur rsyncs te doen van de root en home partities. Voor wat extra veiligheid gebruik ik copies=3, en met dagelijkse snapshots heb ik altijd m'n oude data beschikbaar.

Recent heb ik ook de 128GB crucial M4 in m'n laptop vervangen door een 120GB intel, en ga ik de crucial als ext4 partitie gebruiken voor de opslag van vm's. Hierdoor heb ik hoge performance voor m'n vm's, en kan ik de vm's gewoon 24u laten draaien zonder dat ze m'n grote array actief houden.

Ik wilde de M1015 eigenlijk niet naar IT flashen, omdat de controller JBOD drives herkent en verder niets mee doet, en de megaraid driver stabieler schijnt te zijn dan de mpt2sas driver. Helaas laten te laatste firmware versies van de M1015 (en LSI 9240) het niet meer toe om een spindown te doen van je disks! Hierdoor was ik dus gedwongen om over te stappen naar de 9211 IT firmware, wat overgens prima werkt.

De keuze voor ubuntu 11.10 was makkelijk omdat ik die ook op m'n werkstation en laptop gebruik. Met de ZFS ppa is het super simpel om altijd de laatste ZFS versie te draaien. De keuze voor een "experimenteel" FS kan wat vragen oproepen, maar omdat voornamelijk de opensolaris source gebruikt wordt blijkt dit in de praktijk heel stabiel te zijn als je geen compressie of dedup gebruikt. De weinige problemen die gemeld worden zijn hangs, maar in het half jaar dat ik de zfs on linux mailinglist volg ben ik nog niemand tegengekomen die een filesysteem verloren is! Er zijn ook al bedrijven die ZFS on Linux in productie gebruiken, en ik ben zelf nog geen enkel probleem tegengekomen. Er is nog weinig performance tuning gedaan, maar voorlopig ben ik tevreden, en het kan alleen maar beter worden

Ik heb ervoor gekozen om 1 pool te maken van 2 raidz vdevs met 5 drives. Dit is een afweging tussen performance en redundancy. ZFS presteerd optimaal als een 128KB blok precies verdeelt kan worden over een heel aantal blokken van je data disks. Bij een 4KB sector size betekent dit dus 2, 4 of 8 data disks + extra disks voor parity. Voor mij betekent dit 2x 4+1 in raidz of 8+2 in raidz2. 8+2 is betrouwbaarder, maar er zijn performance limieten per vdev, dus het is ook trager. Door voor 2 4+1 vdevs te kiezen heb ik dus meer performance, en kan ik m'n array ook met 5 drives uitbreiden zonder dat m'n array ongelijke vdevs heeft. Het nadeel is dat als er 2 drives afsterven in dezelfde vdev ik al m'n data kwijt ben.

Ik heb tijdelijk een round-robin bond van 2 x 1Gb ethernet naar m'n werkstation, en 1Gb met vlans naar m'n LAN. Dit gaat binnenkort vervangen worden door infiniband, ik heb de kabels al binnen, maar m'n kaarten liggen al een week bij de douane

Ik zit momenteel op 58-64W idle, afhankelijk van de pcie_aspm settings. De laatste kernels gaan hier niet goed mee om, en verbruiken wat meer. Mijn target is 50W, en dat moet mogelijk zijn als ik de processor tijdens idle in C6 kan laten draaien. Momenteel gaat de processor niet verder dan C1, maar het is niet makkelijk uit te vinden waar dit door veroorzaakt wordt. Hier ga ik de komende tijd m'n aandacht aan besteden, naast de implementatie van infiniband.

EDIT: Het probleem bleek bij de bonding driver te liggen. Na het verwijderen van de bonding module gaat de processor netjes naar C6, en ik zit nu op 45W idle!!!

De hardware van m'n systeem is redelijk standaard, maar ik ben volgens mij de eerste met ZFS on Linux, en hopelijk binnenkort ook de eerste met Infiniband. Lijkt me dus interessant voor dit topic

edit: nog wat performance resultaten:

edit 08/01/2011: betere performance resultaten.

1

2

3

4

| dd if=/dev/zero of=testfile.out bs=32M count=2048 2048+0 records in 2048+0 records out 68719476736 bytes (69 GB) copied, 87.9313 s, 782 MB/s |

1

2

3

4

| dd if=testfile.out of=/dev/null bs=32M count=2048 2048+0 records in 2048+0 records out 68719476736 bytes (69 GB) copied, 115.85 s, 593 MB/s |

1

2

3

4

5

6

7

| time cp --sparse=never testfile.out testfile2.out real 4m5.855s user 0m0.136s sys 1m7.916s dus gemiddeld 267MB/s read & 267MB/s write |

Een scrub haalt gemiddeld rond de 800MB/s

[ Voor 4% gewijzigd door nielsdc op 08-01-2012 10:48 ]

Mooie bak en lekkere getallen.nielsdc schreef op zaterdag 07 januari 2012 @ 02:38:

Tijd om mijn systeem eens voor te stellen.

..snipz..

System specifications Component Value Case Lian Li v2000 CPU Intel Xeon E1220 RAM 16 GB ECC Motherboard Supermicro X9SCM-F Operating system Linux Ubuntu 11.10 Controller M1015 met 9211 IT firmware Hard drive 10 x ST2000DL003 (2TB), 1 x ST9500423AS (500GB), 1 x 120GB intel 320, 1 x 128GB Crucial M4 RAID array configuration 1 pool bestaande uit 2 x 5 disk raidz vdevs Netto storage capacity 16TB Network 2 x 1Gb bonded, 1 x 1Gb met vlans, 1 x 100Mb remote management UPS Nee Filesystem ZFS on linux, daily ppa Idle power usage 60W met spindown, 105W zonder spindown

..snipz..

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Nog even een update vanuit mijn kant; Ik heb redelijk goedkoop 2x een Intel Dual-port 10Gbit Ethernet NIC op de kop kunnen tikken & een directe verbinding opgezet tussen mijn server en werkstation.

Helaas werkte de SFP+ modules om de een of andere manier niet met de kaarten, maar die kreeg ik er gratis bij dus op zich niet zo'n groot probleem. Ik heb nu tijdelijk een Twinax kabel van m'n werk geleend & dit werkt perfect.

Alleen nu nog een aantal SSDtjes aanschaffen voor m'n werkstation, want deze kan al dit geweld niet meer bijbenen. Met de RAID-0 in m'n werkstation, bestaande uit 3x 1TB 7200RPM schijven, burst ik nu op ongeveer 450MB/s, maar na een aantal seconden dan zakt de performance in naar rond de 280MB/s. Maar goed, ik ben nu al happy met het resultaat

[ Voor 4% gewijzigd door brederodekater op 07-01-2012 18:35 ]

Het systeem gaat nu netjes naar C6, wat een behoorlijk verschil maakt. Ik heb nu 45W idle!

Verder heb ik de writes nog wat sneller gekregen, het lukt me nog niet de reads sneller te krijgen

Ik heb m'n topic geupdate met de nieuwe info.

Dat is echt heel vet. Je bent de eerste hier met 10 Gigabit. Begrijp ik het goed dat glas dus niet ging? Ik begrijp ook dat de conectors in deze dus niet standaard UTP etc zijn. Zo'n kabel lijkt me niet gratis.brederodekater schreef op zaterdag 07 januari 2012 @ 18:23:

Mooie build Niels! En ook leuk om nog in Lian Li'er te verwelkomen

Nog even een update vanuit mijn kant; Ik heb redelijk goedkoop 2x een Intel Dual-port 10Gbit Ethernet NIC op de kop kunnen tikken & een directe verbinding opgezet tussen mijn server en werkstation.

Helaas werkte de SFP+ modules om de een of andere manier niet met de kaarten, maar die kreeg ik er gratis bij dus op zich niet zo'n groot probleem. Ik heb nu tijdelijk een Twinax kabel van m'n werk geleend & dit werkt perfect.

Alleen nu nog een aantal SSDtjes aanschaffen voor m'n werkstation, want deze kan al dit geweld niet meer bijbenen. Met de RAID-0 in m'n werkstation, bestaande uit 3x 1TB 7200RPM schijven, burst ik nu op ongeveer 450MB/s, maar na een aantal seconden dan zakt de performance in naar rond de 280MB/s. Maar goed, ik ben nu al happy met het resultaat

Je kunt eens wat tests doen met iperf om te zien wat je echte capaciteit is.

[ Voor 4% gewijzigd door Q op 08-01-2012 11:03 ]

De SFP+ modules worden niet door de kaart aangestuurd voor zover ik het begrijp, kan een branding issue zijn.Q schreef op zondag 08 januari 2012 @ 11:02:

[...]

Dat is echt heel vet. Je bent de eerste hier met 10 Gigabit.

Begrijp ik het goed dat glas dus niet ging?

Klopt SFP is een std voor modules die je in het open slot kan prikken. Die zijn er in glas en koper en in meerdere netwerkprotocollen, snelheden en waar van toepassing afstanden.Ik begrijp ook dat de connectors in deze dus niet standaard UTP etc zijn. Zo'n kabel lijkt me niet gratis.

Zo'n twinax kabel is van koper met de SFP's er aan vast, het is dus een geheel.

Je kunt eens wat tests doen met iperf om te zien wat je echte capaciteit is.

Ik denk dat ik uiteindelijk zelf een Twinax kabel bestel. Dit is eigenlijk gewoon een koper kabel met SFP modules aan weerszijden. Je bent dan alleen wat beperkt met betrekking tot de lengte, maar 3 meter is genoeg voor mij. Plus daarbij komt dat deze kabels best goedkoop zijn, ongeveer 100 Euro.

Ik zal binnenkort eens wat Iperf testjes posten

Verschil tussen actief en passief zijn de power requirements. Maar een kaartje moet die stroom wel kunnen leveren.

Lastiger word het als je een 48P SFP switch hebt, met 48P actieve SFP modules. Dat vinden die switches niet grappig.

10Gb is leuk, maar in de praktijk haal je (zelfs met iperf) maximaal 6Gb ofzo.

Heb hier op het werk een test gedaan met 2 Intel 10Gb kaartjes en een Cisco Nexus 5020 (_heel_ duur spul).

Dat was leuk, maar hoger dan 6Gb kom je meestal niet. Dus als je dat (straks) met Iperf haalt, zit je goed

Ben zelf aan het spelen met dual 4Gbit glas HBA's. Eens kijken of ik daar een leuke snelheid overheen krijg.

Even niets...

Indien dat het geval is kom je, indien getrunked, aan een theoretische limit van 850 MB/s.

Ik wil namelijk mijn bestaande array publiceren over Fibre Channel, maar denk niet dat dit gaat werken.

Ik zie net dat er zoiets als IPFC(Ethernet over Fibre Channel) bestaat, en blijkbaar ondersteunen mijn QLogic kaartjes dat (2462). Als ik morgen tijd heb, maar eens kijken of dat werkt

[ Voor 24% gewijzigd door FireDrunk op 08-01-2012 22:02 ]

Even niets...

Deze grafieken laten een gemiddelde van 30 seconde zien, dus het daadwerkelijke gebruik lag zelfs nog hoger.

Misschien dat ik toch eens moet nadenken over een upgrade voor het moederbord en de CPU van de server, want tijdens het overzetten stond mijn werkstation (i7 920, 12GB) praktisch idle te draaien.

Maar goed, ik ga eerst nog wat dieper op onderzoek uit om uit te vogelen wat dit veroorzaakt

///EDIT///

Ik realiseer mijzelf net dat er maar 256MB op m'n Areca kaart zit geprikt. Zou dit probleem veroorzaakt kunnen worden omdat de cache gewoon niet groot genoeg is om grote hoeveelheden data op hoge snelheid te verwerken?

Eventueel kan de huidige 256MB module vervangen worden met een van 1GB. Maar graag hoor ik van jullie of dit überhaupt wel zin heeft

[ Voor 23% gewijzigd door brederodekater op 09-01-2012 09:27 ]

Bovendien vind ik de CPU belastig ERG hoog... Kijk eens met top (ik ga uit van linux) of je IOWAIT hebt, of Interrupts die je CPU belasten. Is het IOWAIT dan wacht je server (actief) op je Areca kaart, is het Interrupt handling, dan is je netwerkkaart de boosdoener.

Mocht dit laatste het geval zijn, kijk dan goed of alle offloading features aan staan.

Even niets...

Om heftige discussies te voorkomen in het topic, lees eerst goed de start post om te weten waar aan het systeem moet voldoen. Ben je van mening dat jouw systeem toch in dit topic hoort maar valt hij niet binnen de gestelde eisen, neem dan contact op met een van de auteurs van dit topic zij zullen open staan voor goede argumenten, zoals ook vermeld in de start post.

Gebruik de in de TS geplaatste tabel om dit topic leesbaar te houden!

:strip_icc():strip_exif()/u/141265/soulrider.jpg?f=community)

:strip_icc():strip_exif()/u/149211/images.jpg?f=community)

/u/425009/crop652e932deeec6_cropped.png?f=community)

:strip_icc():strip_exif()/u/139376/27e.jpg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_icc():strip_exif()/u/340536/AnimalReplica%2520-%2520small.jpg?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

/u/1/femme.png?f=community)

:strip_exif()/u/293306/crop6682d9e470e27_cropped.gif?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

/u/33305/crop60893dfd18ede_cropped.png?f=community)

:strip_exif()/u/294322/64-floyd.gif?f=community)

/u/231803/ramdisk2.png?f=community)

:strip_icc():strip_exif()/u/245037/Intel.jpg?f=community)

:strip_icc():strip_exif()/u/170724/i.jpg?f=community)

:strip_exif()/u/36533/Smaller_J_forum60x60.gif?f=community)

:strip_exif()/u/264081/crop56d6d27c03d80_cropped.gif?f=community)

:strip_icc():strip_exif()/u/94035/001_system_avat_80.jpg?f=community)

:strip_exif()/u/66002/AMD.gif?f=community)

:strip_icc():strip_exif()/u/10689/camino.jpg?f=community)