Je kan ook de X11SSi-LN4F overwegen. Is quasi hetzelfde bord qua specs, maar heeft wel 4 lanes voor het nvme slot. Is dan wel weer een ATX formaat.OMX2000 schreef op maandag 11 april 2016 @ 14:43:

[...]

Maar serieus als ik dan toch upgrade dan liever een keer goed. Trouwens die ssd kan ook met zo'n pci-e adapter in het x4 slot, vreemde keus van Supermicro om het nvme slot niet x4 te maken zoals bij de Xeon D bordjes.

Omdat de remote experience een stuk beter wordt? Omdat je een stuk meer desktop VM's op dezelfde CPU kunt draaien? En natuurlijk voor gaming of CAD achtig werk.FireDrunk schreef op woensdag 13 april 2016 @ 08:15:

Ik snap die drang om een GPU door te geven niet zo. Het is softwarematig best lastig en je moet heel goed opletten welke je koopt, bovendien gaat je verbruik er door omhoog.

Waarom kan je de 'client' in de huiskamer niet gewoon voorzien van dezelfde GPU? Voor het lawaai hoef je het tegenwoordig niet te doen, er zijn genoeg videokaarten die semi passief / onhoorbaar hun werk kunnen doen?

Tenzij je echt een hele dikke GPU wil gebruiken hiervoor en in de huiskamer muisstil wil kunnen gamen is het misschien leuk, maar dan heb je een ontzettend beefy ESXi server nodig...

Tegenwoordig moet het best aardig te doen zijn nu een aantal Intel GPU's supported zijn.

Maar bij met name server workloads heb je volledig gelijk.

Te Koop:24 Core Intel Upgradeset

Da's wel een beetje jammer. Of iemand moet hier een fijne case weten. Heb qua prijs niet zoveel zin om een 2U rack case aan te schaffen.tebe schreef op woensdag 13 april 2016 @ 11:32:

[...]

Je kan ook de X11SSi-LN4F overwegen. Is quasi hetzelfde bord qua specs, maar heeft wel 4 lanes voor het nvme slot. Is dan wel weer een ATX formaat.

Dè developers podcast in je moerstaal : CodeKlets Podcast

Wil je eigenlijk een 1U case dan? Hoe ga je die 6 disks er in proppen?OMX2000 schreef op woensdag 13 april 2016 @ 22:37:

[...]

Da's wel een beetje jammer. Of iemand moet hier een fijne case weten. Heb qua prijs niet zoveel zin om een 2U rack case aan te schaffen.

Ja ik lees dat ik vaag ben. Ik wil een goede betaalbare case waar 10 3.5 inch HDD's in kunnen en ook plek voor 2 2.5 inch SSD's disks. Als dat kan icm met een het eerder genoemde ATX bord én het is een betaalbare case (max 150 euro) dan is het voor mij een optie. Ander ga ik liever voor bijvoorbeeld een Fractal Design R4/R5.renedis schreef op donderdag 14 april 2016 @ 10:34:

[...]

Wil je eigenlijk een 1U case dan? Hoe ga je die 6 disks er in proppen?

Even verder gezocht.

Ik zag wel deze case van Supermicro : CSE-825TQ-600LPB - http://www.serverdirect.n...se825tq600lpb-p-3003.html

Daar zitten 8x 3.5" Hot-swap Bays in en 2 fixed 3.5 inch bays. Dus eigenlijk voor mij goed. Alleen wel wat prijziger.

[ Voor 22% gewijzigd door OMX2000 op 14-04-2016 11:28 ]

Dè developers podcast in je moerstaal : CodeKlets Podcast

Kijk eens op ebay zou ik zeggenOMX2000 schreef op donderdag 14 april 2016 @ 11:01:

[...]

Ja ik lees dat ik vaag ben. Ik wil een goede betaalbare case waar 10 3.5 inch HDD's in kunnen en ook plek voor 2 2.5 inch SSD's disks. Als dat kan icm met een het eerder genoemde ATX bord én het is een betaalbare case (max 150 euro) dan is het voor mij een optie. Ander ga ik liever voor bijvoorbeeld een Fractal Design R4/R5.

Even verder gezocht.

Ik zag wel deze case van Supermicro : CSE-825TQ-600LPB - http://www.serverdirect.n...se825tq600lpb-p-3003.html

Daar zitten 8x 3.5" Hot-swap Bays in en 2 fixed 3.5 inch bays. Dus eigenlijk voor mij goed. Alleen wel wat prijziger.

http://www.ebay.de/itm/Su...96d443:g:lToAAOSwwpdW4FO6

Vind ik toch een nette prijs voor zo'n case en past het ATX bordje in, zelfs E-ATX.

Een 2U case tot 150,- euro heeft meestal een slechtere kwaliteit en komt zonder voeding, realiseer je dat ook..

Goede tip. Die gaat op het verlanglijstjerenedis schreef op donderdag 14 april 2016 @ 11:43:

[...]

Kijk eens op ebay zou ik zeggen

http://www.ebay.de/itm/Su...96d443:g:lToAAOSwwpdW4FO6

Vind ik toch een nette prijs voor zo'n case en past het ATX bordje in, zelfs E-ATX.

Een 2U case tot 150,- euro heeft meestal een slechtere kwaliteit en komt zonder voeding, realiseer je dat ook..

Dè developers podcast in je moerstaal : CodeKlets Podcast

Mijn ESXi-host reageert sindskort heel erg slecht via vsphere client, vaak timeouts en errors.

Als ik de machine (of gevirtualiseerde guests) ping krijg ik uitzonderlijk veel timeouts, hierdoor werken services van m'n guest (bijv. NFS) ook heel slecht.

Machine staat in de meterkast, met een kabel van 1m aangesloten op het DSL-modem.

VMs onderling hebben dit probleem niet, ook downloaden in de ene VM en dit opslaan via NFS op de andere VM lijkt goed te lopen.

Lijkt me niet heel waarschijnlijk dat dit een ESXi-probleem is?

Zijn dit voortekenen van een falende hardware; maar wat dan? NIC, (pico)PSU of mobo?

Hoe kan ik achterhalen wat het probleem is? Ik heb al wel gegoogled, maar pingen werkt meestal helemaal niet óf wel.

Kan ik met tools dit symptoom inzichtelijker maken?

Of wat zijn logische stappen om te dingen uit te sluiten? Eerst een ander OS of meteen NIC vervangen?

Laat maar, op een andere fysieke lokatie en via powerline doet ie 't weer probleemloos.

Wat het ook is/was, is zeker geen ESXi probleem.

Als ik de machine (of gevirtualiseerde guests) ping krijg ik uitzonderlijk veel timeouts, hierdoor werken services van m'n guest (bijv. NFS) ook heel slecht.

Machine staat in de meterkast, met een kabel van 1m aangesloten op het DSL-modem.

VMs onderling hebben dit probleem niet, ook downloaden in de ene VM en dit opslaan via NFS op de andere VM lijkt goed te lopen.

Lijkt me niet heel waarschijnlijk dat dit een ESXi-probleem is?

Zijn dit voortekenen van een falende hardware; maar wat dan? NIC, (pico)PSU of mobo?

Hoe kan ik achterhalen wat het probleem is? Ik heb al wel gegoogled, maar pingen werkt meestal helemaal niet óf wel.

Kan ik met tools dit symptoom inzichtelijker maken?

Of wat zijn logische stappen om te dingen uit te sluiten? Eerst een ander OS of meteen NIC vervangen?

Laat maar, op een andere fysieke lokatie en via powerline doet ie 't weer probleemloos.

Wat het ook is/was, is zeker geen ESXi probleem.

[ Voor 7% gewijzigd door RudolfR op 14-04-2016 19:06 ]

Hallo,

Ik ben op dit moment ook bezig om mijn eerste whitebox esxi server te vervangen met een andere. En ik kwam een beetje op dit uit:

Ik draai op dit moment 3x server 2012R2 en 2 keer Linux op mijn huidige build. Dit alles met 16GB geheugen. Draait wel aardig. Storage heb ik op dit moment staan op een SmartArray P400 controller inclusief BBU, die nog steeds goed z'n werk doet. Deze zal ik ook overzetten in mijn nieuwe build.

Nu lees ik echter dat de B150 chipset van Intel nog niet zo lekker ondersteund wordt. Heeft dit gevolgen over eventuele AHCI / SATA poorten die ik niet meer kan gebruiken?

Verder vroeg ik me af of iemand nog op of aanmerkingen op deze build heeft.

Ik ben op dit moment ook bezig om mijn eerste whitebox esxi server te vervangen met een andere. En ik kwam een beetje op dit uit:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i3-6100 Boxed | € 114,95 | € 114,95 |

| 1 | Gigabyte GA-B150-HD3P | € 80,95 | € 80,95 |

| 3 | WD Red WD30EFRX, 3TB | € 110,- | € 330,- |

| 1 | Cooler Master Silencio 452 | € 59,90 | € 59,90 |

| 1 | Gelid Solutions Tranquillo Rev.2 | € 24,95 | € 24,95 |

| 1 | Crucial CT4K8G4DFD8213 | € 114,05 | € 114,05 |

| 1 | Seasonic G-series 360 watt | € 57,95 | € 57,95 |

| 1 | Samsung 850 EVO 500GB | € 148,60 | € 148,60 |

| Bekijk collectie Importeer producten | Totaal | € 931,35 | |

Ik draai op dit moment 3x server 2012R2 en 2 keer Linux op mijn huidige build. Dit alles met 16GB geheugen. Draait wel aardig. Storage heb ik op dit moment staan op een SmartArray P400 controller inclusief BBU, die nog steeds goed z'n werk doet. Deze zal ik ook overzetten in mijn nieuwe build.

Nu lees ik echter dat de B150 chipset van Intel nog niet zo lekker ondersteund wordt. Heeft dit gevolgen over eventuele AHCI / SATA poorten die ik niet meer kan gebruiken?

Verder vroeg ik me af of iemand nog op of aanmerkingen op deze build heeft.

CPU zou ik naar een G4400 overzetten, i3 heeft HyperThreading, dat is niet iets wat je direct merkt in ESXi tenzij je de server op zijn piek gebruikt.

Geheugen zou ik omzetten naar 2*16GB, sinds DDR4 zijn 16GB DIMM's ook beschikbaar. Kan je later eventueel upgraden naar 4*16 mocht je dat willen.

Een P400 pikt toch schijven tot max 2TB? Voor >2TB heb je dacht ik minimaal een P410 nodig.

Op je vraag over de B150 chipset kan ik geen antwoord geven, ik weet het simpelweg gezien niet

Ik zag laatst wel weer iets voorbij komen dat ESXi 6.0U2 weer wat AHCI drivers geupdate heeft, dat zou je misschien eens kunnen googlen.

Geheugen zou ik omzetten naar 2*16GB, sinds DDR4 zijn 16GB DIMM's ook beschikbaar. Kan je later eventueel upgraden naar 4*16 mocht je dat willen.

Een P400 pikt toch schijven tot max 2TB? Voor >2TB heb je dacht ik minimaal een P410 nodig.

Op je vraag over de B150 chipset kan ik geen antwoord geven, ik weet het simpelweg gezien niet

Ik zag laatst wel weer iets voorbij komen dat ESXi 6.0U2 weer wat AHCI drivers geupdate heeft, dat zou je misschien eens kunnen googlen.

[ Voor 23% gewijzigd door FireDrunk op 19-04-2016 14:00 ]

Even niets...

Thanks voor de tips! Die G4400 scheelt inderdaad weer geld. m.b.t. het geheugen: daar ga ik ook even naar kijken. Zal wellicht iets duurder zijn maar dan kun je eventueel nog naar 64GB toe. En de P400 was een foutje, ik lees nu ook idd dat die tot 2TB gaan. Die zal ik gaan vervangen met een P410, of misschien dat ik de data van de OS' en los op de 3TB disken zet en de boot disken op de SSD. Zal allicht ook weer wat schelen.FireDrunk schreef op dinsdag 19 april 2016 @ 13:59:

CPU zou ik naar een G4400 overzetten, i3 heeft HyperThreading, dat is niet iets wat je direct merkt in ESXi tenzij je de server op zijn piek gebruikt.

Geheugen zou ik omzetten naar 2*16GB, sinds DDR4 zijn 16GB DIMM's ook beschikbaar. Kan je later eventueel upgraden naar 4*16 mocht je dat willen.

Een P400 pikt toch schijven tot max 2TB? Voor >2TB heb je dacht ik minimaal een P410 nodig.

Op je vraag over de B150 chipset kan ik geen antwoord geven, ik weet het simpelweg gezien niet

Ik zag laatst wel weer iets voorbij komen dat ESXi 6.0U2 weer wat AHCI drivers geupdate heeft, dat zou je misschien eens kunnen googlen.

Je kan ook de P410 weg doen, en een simpele AHCI based of IT-mode controller aanschaffen, waardoor je via VT-d een Storage VM kan maken.

Dan kan je *in* een VM elke software matige vorm van RAID gebruiken die je wil.

(Mijn persoonlijke voorkeur is ZFS, maar dat moet je zelf weten )

)

Dan kan je *in* een VM elke software matige vorm van RAID gebruiken die je wil.

(Mijn persoonlijke voorkeur is ZFS, maar dat moet je zelf weten

Even niets...

Ik neem aan dat je de IBM M1015 (LSI9211-IT) bedoeld? Dat is de enige die ik tegen met gekomen namelijk.FireDrunk schreef op dinsdag 19 april 2016 @ 14:10:

Je kan ook de P410 weg doen, en een simpele AHCI based of IT-mode controller aanschaffen, waardoor je via VT-d een Storage VM kan maken.

Dan kan je *in* een VM elke software matige vorm van RAID gebruiken die je wil.

(Mijn persoonlijke voorkeur is ZFS, maar dat moet je zelf weten)

Ik ben er nog altijd niet uit wat mijn toekomstige systeem gaat worden, ik neig nu meer naar een systeem met een dedicated HBA voor ZFS. Ik vind zo'n hba alleen een aanslag op het totale verbruik met circa 10-15watt (wat ik begrepen heb in ieder geval).

[ Voor 20% gewijzigd door prekz op 19-04-2016 14:51 ]

Mijn IBM M1015 verbruikte 7 tot 8W in de praktijk met 4 disks. Sporadisch zal dat 14 a 15W zijn.prekz schreef op dinsdag 19 april 2016 @ 14:39:

[...]

Ik neem aan dat je de IBM M1015 (LSI9211-IT) bedoeld? Dat is de enige die ik tegen met gekomen namelijk.

Ik ben er nog altijd niet uit wat mijn toekomstige systeem gaat worden, ik neig nu meer naar een systeem met een dedicated HBA voor ZFS. Ik vind zo'n hba alleen een aanslag op het totale verbruik met circa 10-15watt (wat ik begrepen heb in ieder geval).

Je kunt ook de onboard controller gaan gebruiken. Echter moet je dan wel een NVMe SSD of iets in die richting gaan gebruiken voor je datastores.

[ Voor 6% gewijzigd door renedis op 20-04-2016 09:37 . Reden: Links toegevoegd ]

Van die onboard controller klopt, maar op zfs forums en het forum van freenas schijnen ze dit heel erg af te raden.

Reden?prekz schreef op woensdag 20 april 2016 @ 09:50:

Van die onboard controller klopt, maar op zfs forums en het forum van freenas schijnen ze dit heel erg af te raden.

Dè developers podcast in je moerstaal : CodeKlets Podcast

Ik heb ook lang geprobeerd om middels vt-d de gpu door te geven, maar ben er achter gekomen dat het 1: lastig is, vooral heel veel klooien en 2: de gpu voegt idle zo'n 10-15W toe aan een systeem dat 24/7 aan staat. Met mijn huidige setup welke 45-50W idle doet is dat toch zo'n 20% van het totale vermogen, heel erg veel dus.FireDrunk schreef op woensdag 13 april 2016 @ 11:03:

VM's gebruiken geen GPUDie is ook gevirtualiseerd namelijk. Of de Dedicated GPU je verbruik laag houdt, hangt denk ik af of ASPM en andere power saving features nog werken tijdens het doorgeven via VT-d. Dat is maar de vraag.

Kans is redelijk groot dat als je de goede drivers laad in de VM die de GPU heeft, dat het wel goed gaat.

Ik ga er vanuit dat de GPU vrijwel niets doet op het moment dat er geen claim op ligt, maar soms heb je daar dus wel drivers voor nodig.

Als ik dit afzet tegen de 1 uur gamen per dag of minder, dan is het verbruik relatief nog veel meer.

Ik denk dat je in de war bent met datastores aanmaken op de Intel SATA controller, of raw device mapping (geen directe controller access voor Freenas) en niet VT-d passthough:prekz schreef op woensdag 20 april 2016 @ 09:50:

Van die onboard controller klopt, maar op zfs forums en het forum van freenas schijnen ze dit heel erg af te raden.

Freenas forum admin (cyberjock):

You buy an Intel board and it's virtually guaranteed to have an Intel SATA controller. These work quite well.

Freenas hardware guide:

As a general rule, the integrated chipset AHCI SATA ports have no issues when used with FreeNAS, they just tend to be limited to 10 ports (and often far fewer) on most motherboards.

[ Voor 41% gewijzigd door |sWORDs| op 20-04-2016 17:25 ]

Te Koop:24 Core Intel Upgradeset

prekz schreef op woensdag 20 april 2016 @ 09:50:

Van die onboard controller klopt, maar op zfs forums en het forum van freenas schijnen ze dit heel erg af te raden.

Dat dus.. Ik heb gewoon de volledige controller via passthrough doorgegeven.|sWORDs| schreef op woensdag 20 april 2016 @ 17:13:

[...]

Ik denk dat je in de war bent met datastores aanmaken op de Intel SATA controller, of raw device mapping (geen directe controller access voor Freenas) en niet VT-d passthough:

[...]

[...]

Werkt als een malle.

Zo lang je geen SAS gebruikt maar SATA is de Intel waarschijnlijk zelfs beter qua mogelijke problemen. Enige 'nadelen' zijn max 10 poorten en 3% lagere queue depth (ten opzichte van IT firmware, anders is de QD bij Intel zelfs 24% hoger).

[ Voor 22% gewijzigd door |sWORDs| op 21-04-2016 20:12 ]

Te Koop:24 Core Intel Upgradeset

http://www.yellow-bricks.com/2014/06/09/queue-depth-matters/

Lees ook vooral de comments. SAS is geen garantie voor een hoge Queue Depth.

LSI2008 zit op 25 per poort, LSI2308 op 600 per poort

Voor vSAN bijvoorbeeld is Queue Depth van groot belang

Lees ook vooral de comments. SAS is geen garantie voor een hoge Queue Depth.

LSI2008 zit op 25 per poort, LSI2308 op 600 per poort

Voor vSAN bijvoorbeeld is Queue Depth van groot belang

Even niets...

Ik denk dat je vergeten bent wat ik doe.

LSI2008 heeft niet 25 per poort, dit is per 'volume' (max 2) en firmware (IT = 600 total) afhankelijk. De Intel heeft 31 per poort. Daarnaast heeft je device een queue depth, SATA is 32, SAS is 254, huidige NVMe drives 4000+.

Overigens heeft PVSCSI een default max queue depth van 64.

LSI2008 heeft niet 25 per poort, dit is per 'volume' (max 2) en firmware (IT = 600 total) afhankelijk. De Intel heeft 31 per poort. Daarnaast heeft je device een queue depth, SATA is 32, SAS is 254, huidige NVMe drives 4000+.

Overigens heeft PVSCSI een default max queue depth van 64.

[ Voor 21% gewijzigd door |sWORDs| op 22-04-2016 09:21 ]

Te Koop:24 Core Intel Upgradeset

Waarschijnlijk, ik lees alleen wat er staat, niet wat er in je hoofd zit

Daarom zei ik dus ook: lees de comments, daar hebben mensen verschillen in performance gezien van soms wel tientallen procenten met andere firmware versies.LSI2008 heeft niet 25 per poort, dit is per 'volume' (max 2) en firmware (IT = 600 total) afhankelijk. De Intel heeft 31 per poort. Daarnaast heeft je device een queue depth, SATA is 32, SAS is 254,

NVMe R0eleshuidige NVMe drives 4000+.

Ook niet veelOverigens heeft PVSCSI een default max queue depth van 64.

Even niets...

Ik ben van plan om een zo kleine mogelijke ESXi server te bouwen op basis van een Supermicro mini-itx Xeon-D bordje. Die Supermicro bordjes komen met fan-koeling of met passieve koeling.

Heeft iemand al ervaring met het inbouwen van deze bordjes in kleine behuizingen zoals bijvoorbeeld deze:http://tweakers.net/price...k-110-vesa/specificaties/ en hoe je dan de koeling het beste kan verzorgen?

Heeft iemand al ervaring met het inbouwen van deze bordjes in kleine behuizingen zoals bijvoorbeeld deze:http://tweakers.net/price...k-110-vesa/specificaties/ en hoe je dan de koeling het beste kan verzorgen?

Dat stond er ook al.FireDrunk schreef op vrijdag 22 april 2016 @ 09:52:

[...]

Waarschijnlijk, ik lees alleen wat er staat, niet wat er in je hoofd zit

Queue depth is niet gelijk aan performance, maar wel een van de bottlenecks.FireDrunk schreef op vrijdag 22 april 2016 @ 09:52:

[...]

Daarom zei ik dus ook: lees de comments, daar hebben mensen verschillen in performance gezien van soms wel tientallen procenten met andere firmware versies.

True

Die staat op de roadmap. (Mag ik zeggen omdat er al vaker publieke comments over gemaakt zijn.)FireDrunk schreef op vrijdag 22 april 2016 @ 09:52:

[...]

Ook niet veelMisschien moeten ze maar een PVNVME adapter maken

Overigens is de queue depth van PVSCSI aan te passen (daarom stond er default):

[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\pvscsi\Parameters\Device]

"DriverParameter"="\"MaxQueueDepth=128\""

De passieve borden zijn voor in behuizingen met een flinke airflow:Dinsdale schreef op vrijdag 22 april 2016 @ 10:56:

Ik ben van plan om een zo kleine mogelijke ESXi server te bouwen op basis van een Supermicro mini-itx Xeon-D bordje. Die Supermicro bordjes komen met fan-koeling of met passieve koeling.

Heeft iemand al ervaring met het inbouwen van deze bordjes in kleine behuizingen zoals bijvoorbeeld deze:http://tweakers.net/price...k-110-vesa/specificaties/ en hoe je dan de koeling het beste kan verzorgen?

Manual:

Some X10SDV models come with an active heatsink built in while others come with a passive heatsink for rackmount systems that are chassis-fan optimized. Please follow the instructions given in your system design guide or your system user manual to provide adequate air flow to your system. The onboard BaseBoard Management Controller (BMC) monitors CPU, memory and motherboard environment temperatures for fan control and PC health management.

Note: To avoid possible system overheating, please be sure to provide adequate air flow to your system.

[ Voor 41% gewijzigd door |sWORDs| op 23-04-2016 13:50 ]

Te Koop:24 Core Intel Upgradeset

Dan zou een actief gekoeld board in een verder passieve kast, zoals zo'n Antec kastje waar de fan recht voor het rooster zit, wel een optie kunnen zijn dus? Een passief gekoeld board in een kast met een extra fan wordt waarschijnlijk weer een stuk groter, lijkt me.

Zelfs de actieve borden hebben een airflow over de overige componenten (i350 chip, VRM's, M2 SSD, AST, PHY, etc) nodig. Het zal waarschijnlijk wel werken, maar ideaal is het niet.Dinsdale schreef op vrijdag 22 april 2016 @ 15:13:

Dan zou een actief gekoeld board in een verder passieve kast, zoals zo'n Antec kastje waar de fan recht voor het rooster zit, wel een optie kunnen zijn dus? Een passief gekoeld board in een kast met een extra fan wordt waarschijnlijk weer een stuk groter, lijkt me.

X10SDV-4C-TLN2F FLIR thermal imaging:

Supermicro X10SDV-TLN4F thermal imaging:

Samsung 950 thermal imaging:

[ Voor 31% gewijzigd door |sWORDs| op 22-04-2016 15:53 ]

Te Koop:24 Core Intel Upgradeset

Dank je |sWORDs|, die plaatjes was ik even vergeten. Dan wordt het toch een passief gekoeld bord, en een Chieftec IX-03B kastje met 2 50mm fans naast elkaar. Dat blaast dan mooi over het hele bord heen, en dan worden alle componenten meegepakt.

Je zou ook nog twee heatsinks met twee componenten thermal adhesive op de i350 en Aspeed of M2 kunnen plakken, ik zou dat zeker overwegen.

[ Voor 7% gewijzigd door |sWORDs| op 23-04-2016 12:07 ]

Te Koop:24 Core Intel Upgradeset

Ben me ook aan het oriënteren op een nieuwe ESX build op basis van een Xeon-D bordje (X10SDV). Waar ik echter nergens voor 100% uitsluitsel over kan vinden is of je op deze bordjes de interne Sata controller via passthrough beschikbaar kunt maken voor een VM. Op servethehome is een screenshot te vinden van passthrough devices, maar daar staat de Sata controller niet tussen. Op Tinkertry word aangegeven dat Sata wel is door te geven maar alleen als ook de USB host controller word doorgegeven (op zich nog oplosbaar door ESX op een NVME disk in het M2 slot te installeren). Heeft hier iemand op dit forum toevallig al een dergelijk systeem of zou dat kunnen checken?

Met de eerder geposte aanpassing moet het kunnen werken.

Waarschijnlijk 8086:8c02.

Verder zijn er ook flexatx X10SDV borden met 4+ 16 SAS2/SATA poorten.

|sWORDs| schreef op donderdag 17 maart 2016 @ 15:00:

- Login op de ssh console:

code:

Hier zie je de poorten van de Intel en de PCI ID (0000:00:11.4), dit zijn er normaal twee, maar ik heb de 6 poorts al doorgegeven.

Hier zie je jouw PID (8d62)- Dan zet je die onderin /etc/vmware/passthru.map.

code:

Hele file bij mij:

code:

# passthrough attributes for devices # file format: vendor-id device-id resetMethod fptShareable # vendor/device id: xxxx (in hex) (ffff can be used for wildchar match) # reset methods: flr, d3d0, link, bridge, default # fptShareable: true/default, false # Intel 82598 10Gig cards can be reset with d3d0 8086 10b6 d3d0 default 8086 10c6 d3d0 default 8086 10c7 d3d0 default 8086 10c8 d3d0 default 8086 10dd d3d0 default # Broadcom 57710/57711/57712 10Gig cards are not shareable 14e4 164e default false 14e4 164f default false 14e4 1650 default false 14e4 1662 link false # Qlogic 8Gb FC card can not be shared 1077 2532 default false # LSILogic 1068 based SAS controllers 1000 0056 d3d0 default 1000 0058 d3d0 default # NVIDIA 10de ffff bridge false # Intel Wellsburg AHCI 8086 8d62 d3d0 false 8086 8d02 d3d0 false- En reboot, daarna kun je hem gewoon in passthrough zetten (indien er geen datastore op in gebruik is/het jouw bootdevice bevat):

[afbeelding]- Nog een reboot en je kunt m doorgeven aan een VM en niet vergeten om op die VM reserve all memory te doen:

[afbeelding]

[afbeelding]

[afbeelding]

code:

1

| 00:1f.2 SATA controller: Intel Corporation 8 Series/C220 Series Chipset Family 6-port SATA Controller 1 [AHCI mode] (rev 05) (prog-if 01 [AHCI 1.0]) |

Waarschijnlijk 8086:8c02.

Verder zijn er ook flexatx X10SDV borden met 4+ 16 SAS2/SATA poorten.

[ Voor 99% gewijzigd door |sWORDs| op 25-04-2016 20:01 ]

Te Koop:24 Core Intel Upgradeset

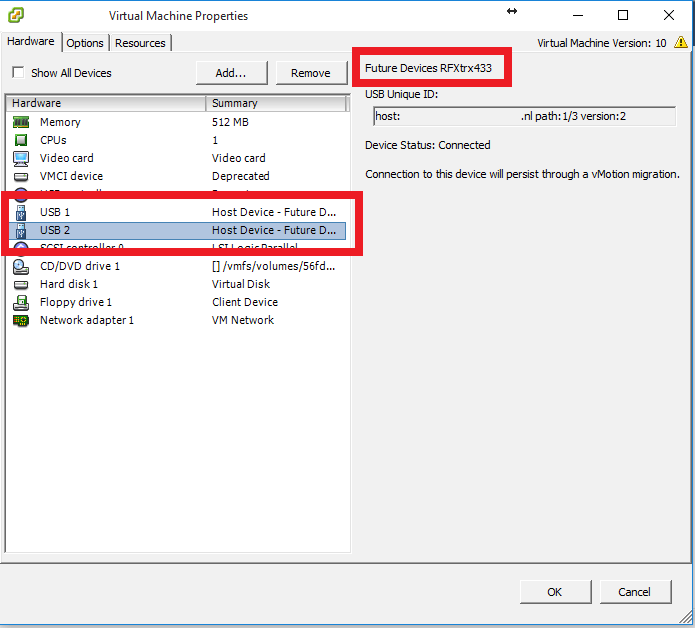

Ik wil domoticz op één van m'n virtual machines gaan draaien maar hoe kan ik het beste het USB device (rfxcom) doorgeven aan de vm?

De hele USB controller van het moederbord dmv passtrouch ?

Komt de USB stick waarvan ESXi boot dan niet in de problemen ?

Of kan ik beter voor een losse USB controller gaan en deze direct doorgeven aan de vm ?

De hele USB controller van het moederbord dmv passtrouch ?

Komt de USB stick waarvan ESXi boot dan niet in de problemen ?

Of kan ik beter voor een losse USB controller gaan en deze direct doorgeven aan de vm ?

Sommige borden hebben twee USB controllers (of worden twee controllers als je in de bios USB 3.0 modus aan/uit zet). Mijn bord heeft twee SATA en twee USB controllers, ideaal, ik geef er van beide eentje door aan een VM en kan de rest voor ESXi gebruiken.

Post eens een lspci output.

Post eens een lspci output.

code:

1

2

3

4

5

6

| lspci|grep -i 'USB\|AHCI' 0000:00:11.4 Mass storage controller: Intel Corporation Wellsburg AHCI Controller [vmhba0] 0000:00:14.0 Serial bus controller: Intel Corporation C610/X99 series chipset USB xHCI Host Controller 0000:00:1a.0 Serial bus controller: Intel Corporation C610/X99 series chipset USB Enhanced Host Controller #2 0000:00:1d.0 Serial bus controller: Intel Corporation C610/X99 series chipset USB Enhanced Host Controller #1 0000:00:1f.2 Mass storage controller: Intel Corporation Wellsburg AHCI Controller [vmhba1] |

code:

1

2

3

| lspci -p|grep -i passthru 0000:00:1a.0 8086:8d2d 8086:7270 5/ 5/0x30 C P pciPassthru 0000:00:1f.2 8086:8d02 8086:7270 11/ /0x33 A P pciPassthru vmhba1 |

[ Voor 112% gewijzigd door |sWORDs| op 25-04-2016 20:11 ]

Te Koop:24 Core Intel Upgradeset

Post eens een lspci output.|sWORDs| schreef op maandag 25 april 2016 @ 20:02:

Sommige borden hebben twee USB controllers (of worden twee controllers als je in de bios USB 3.0 modus aan/uit zet). Mijn bord heeft twee SATA en twee USB controllers, ideaal, ik geef er van beide eentje door aan een VM en kan de rest voor ESXi gebruiken.

code:

1

2

3

| [root@localhost:~] lspci|grep -i 'USB\|AHCI' 0000:00:14.0 Serial bus controller: Intel Corporation Sunrise Point-H USB 3.0 xHCI Controller 0000:00:17.0 Mass storage controller: Intel Corporation Sunrise Point-H AHCI Controller [vmhba0] |

Mainbord is een MSI H110M PRO-VD.

Ik heb de usb boot stick in een usb3 aansluiting bovenop m'n kast (ivm ruimte).

Usb3 is dus ingeschakeld.

Heb in het begin veel met de usb instellingen zitten klooien omdat ik problemen had met opstarten van usb.

(o.a freenas startte niet goed op.)

Denk dat m'n mainbord maar 1 usb controller heeft.

Thx! Ga dan denk ik de gok toch maar wagen en voor een X10SDV bordje.|sWORDs| schreef op maandag 25 april 2016 @ 19:50:

Met de eerder geposte aanpassing moet het kunnen werken.

[...]

code:

Waarschijnlijk 8086:8c02.

Verder zijn er ook flexatx X10SDV borden met 4+ 16 SAS2/SATA poorten.

In jouw geval kun je dus waarschijnlijk het beste een los USB kaartje gebruiken of booten vanaf SATA.ComTech schreef op maandag 25 april 2016 @ 20:34:

[...]

Post eens een lspci output.

code:

Mainbord is een MSI H110M PRO-VD.

Ik heb de usb boot stick in een usb3 aansluiting bovenop m'n kast (ivm ruimte).

Usb3 is dus ingeschakeld.

Heb in het begin veel met de usb instellingen zitten klooien omdat ik problemen had met opstarten van usb.

(o.a freenas startte niet goed op.)

Denk dat m'n mainbord maar 1 usb controller heeft.

Te Koop:24 Core Intel Upgradeset

Ik ben van plan om mijn huidige ESXI server te upgraden. Ik kwam uit op onderstaande lijst:

Voor storage gebruik ik de huidige schijven. Ook heb ik al een behuizing. ESXI wilde ik gaan draaien op een USB stick.

Ik wil mijn huidige set upgraden aangezien ik tegen mijn geheugen limiet (32GB) zit.

Heeft iemand tips om iets aan te passen of erbij te doen? Zijn er mensen die dit moederbord gebruiken / kennen?

(prijs van mobo klopt niet)

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1220 v5 Boxed | € 212,50 | € 212,50 |

| 1 | Supermicro X11SSM-F (Bulk Pack) | € 2.812,56 | € 2.812,56 |

| 1 | Scythe Big Shuriken 2 Rev. B | € 34,95 | € 34,95 |

| 4 | Samsung M391A2K43BB1 | € 92,50 | € 370,- |

| 1 | Seasonic G-series 360 watt | € 57,95 | € 57,95 |

| Bekijk collectie Importeer producten | Totaal | € 4.074,13 | |

Voor storage gebruik ik de huidige schijven. Ook heb ik al een behuizing. ESXI wilde ik gaan draaien op een USB stick.

Ik wil mijn huidige set upgraden aangezien ik tegen mijn geheugen limiet (32GB) zit.

Heeft iemand tips om iets aan te passen of erbij te doen? Zijn er mensen die dit moederbord gebruiken / kennen?

(prijs van mobo klopt niet)

Er zitten 10 moederborden in het bulk pack, dus prijs klopt wel.112fan schreef op woensdag 27 april 2016 @ 17:09:

Supermicro X11SSM-F (Bulk Pack)

(prijs van mobo klopt niet)

Je hebt enkel nog 9 CPU's en dergelijke nodig om die te vullen

|sWORDs| schreef op dinsdag 26 april 2016 @ 14:24:

[...]

In jouw geval kun je dus waarschijnlijk het beste een los USB kaartje gebruiken of booten vanaf SATA.

Ik geef mijn controller helemaal niet door, dat is niet nodig. Je kan ook enkel een USB device toewijzen.ComTech schreef op maandag 25 april 2016 @ 20:34:

[...]

Post eens een lspci output.

code:

Mainbord is een MSI H110M PRO-VD.

Ik heb de usb boot stick in een usb3 aansluiting bovenop m'n kast (ivm ruimte).

Usb3 is dus ingeschakeld.

Heb in het begin veel met de usb instellingen zitten klooien omdat ik problemen had met opstarten van usb.

(o.a freenas startte niet goed op.)

Denk dat m'n mainbord maar 1 usb controller heeft.

Mijn Domoticz VM herkent mijn USB devices gewoon die ik aangeef in de settings terwijl ze direct aangesloten zitten op mijn ESXi bak.

Dit doe ik met zowel de RFXCOM en de P1 USB kabel voor mijn slimme meter.

En ik doe het overigens ook met een Smargo irdeto USB card reader in een andere VM.

Met het compleet doorzetten van je USB controller krijg je inderdaad problemen met je ESXi USB boot als je die gebruikt.

Toevoegen doe je als volgt:

1. Voeg een virtuele USB controller toe aan je VM via de settings.

2. Voeg je USB device toe via de settings.

Done.

[ Voor 3% gewijzigd door renedis op 27-04-2016 22:30 ]

Dat is het proberen waard bedankt voor de tip.renedis schreef op woensdag 27 april 2016 @ 22:29:

Ik geef mijn controller helemaal niet door, dat is niet nodig. Je kan ook enkel een USB device toewijzen.

Toevoegen doe je als volgt:

1. Voeg een virtuele USB controller toe aan je VM via de settings.

2. Voeg je USB device toe via de settings.

Done.

Nu moet ik alleen nog tijd ervoor zien vrij temaken

Voor de mensen die nog graag een NVME drive willen hebben, de prijs van de Intel 750 is ineens 25-40% lager bij een aantal shops. Prijs/GB.

[ Voor 13% gewijzigd door |sWORDs| op 30-04-2016 18:00 ]

Te Koop:24 Core Intel Upgradeset

Heeft er iemand trouwens ervaring met zo'n Intel 750 (PCIe variant) op de lange termijn? Ik zit er al een tijdje aan te denken om er zo een in m'n (toekomstige) server te bouwen. Maar her en der lees ik dat TRIM/UNMAP niet correct werkt? Dus dan vraag 'k me af wat dat op de lange termijn voor de performance betekent.

https://www.second-edge.com/?p=264

https://communities.intel...ad/88647?start=0&tstart=0

https://www.second-edge.com/?p=264

https://communities.intel...ad/88647?start=0&tstart=0

Ik heb nog nooit een drive gehad die zo constant performed. 1000MB/s write continu (998.5-1005MB/s), geen enkele variatie te bekennen, zelfs niet na een half uur onafgebroken schrijven/wissen. Hardware.info schrijft ook 1.13TB random 4K een halfuur lang naar een 400GB drive zonder enige variatie:

Te Koop:24 Core Intel Upgradeset

Dat ziet er inderdaad heel mooi uit  Ik neem aan dat het in jouw geval wel onder ESXi is in tegenstelling tot hardware.info?

Ik neem aan dat het in jouw geval wel onder ESXi is in tegenstelling tot hardware.info?

Ja, native doet ie zelfs 1050MB/s. Die 1000 is met PVSCSI Thin disk.

Als ik PVSCSI naar een max QD van 128 zet en test met een QD van 128:

De onderste waardes zijn lager dan je zou verwachten omdat PVSCSI nog steeds het SCSI protocol gebruikt.

pricewatch: Intel 750 SSD 2,5" PCIe 3.0 x4 400GB met Intel driver 1.0e.2.0.

Als ik PVSCSI naar een max QD van 128 zet en test met een QD van 128:

De onderste waardes zijn lager dan je zou verwachten omdat PVSCSI nog steeds het SCSI protocol gebruikt.

pricewatch: Intel 750 SSD 2,5" PCIe 3.0 x4 400GB met Intel driver 1.0e.2.0.

[ Voor 102% gewijzigd door |sWORDs| op 01-05-2016 16:54 ]

Te Koop:24 Core Intel Upgradeset

Ik doe dit zo:ComTech schreef op maandag 25 april 2016 @ 20:01:

Ik wil domoticz op één van m'n virtual machines gaan draaien maar hoe kan ik het beste het USB device (rfxcom) doorgeven aan de vm?

De hele USB controller van het moederbord dmv passtrouch ?

Komt de USB stick waarvan ESXi boot dan niet in de problemen ?

Of kan ik beter voor een losse USB controller gaan en deze direct doorgeven aan de vm ?

Rfxcom > usb openwrt > socat > tcp en in domoticz IP openwrt + poort van socat instellen bij de config van de rfxcom

- Deze advertentie is geblokkeerd door Pi-Hole -

Ik heb op bestel gedrukt met het volgende in mijn winkelmandje:

Opslag wil ik regelen met een aantal Samsung SM843T SSDs die hier nog liggen. NVMe is in de toekomst zeker gewenst dus daar gaan we ook voor sparen.

| # | Product | Prijs | Subtotaal |

| 1 | Supermicro X10SDV-6C-TLN4F | € 658,20 | € 658,20 |

| 1 | Supermicro CSE-721TQ-250B | € 166,- | € 166,- |

| 2 | Samsung M393A4K40BB0-CPB | € 169,50 | € 339,- |

| Bekijk collectie Importeer producten | Totaal | € 1163,20 | |

Opslag wil ik regelen met een aantal Samsung SM843T SSDs die hier nog liggen. NVMe is in de toekomst zeker gewenst dus daar gaan we ook voor sparen.

while (! ( succeed = try ()));

Moet je wel openwrt hebbenA1AD schreef op zondag 01 mei 2016 @ 15:53:

[...]

Ik doe dit zo:

Rfxcom > usb openwrt > socat > tcp en in domoticz IP openwrt + poort van socat instellen bij de config van de rfxcom

Heb het inmiddels op de manier gedaan die renedis gaf en dat werkt prima.

Dat zou ik ook gedaan hebben moest mijn server niet in de kelder staanComTech schreef op zondag 01 mei 2016 @ 20:59:

[...]

Moet je wel openwrt hebben

Heb het inmiddels op de manier gedaan die renedis gaf en dat werkt prima.

- Deze advertentie is geblokkeerd door Pi-Hole -

Zit ook naar zelfde setje te kijken. Waar heb je deze besteld? Kan namelijk geen enkele webshop vinden die het een indicatie heeft over de levertijd van het moederbord.hans_lenze schreef op zondag 01 mei 2016 @ 20:19:

Ik heb op bestel gedrukt met het volgende in mijn winkelmandje:

# Product Prijs Subtotaal 1 Supermicro X10SDV-6C-TLN4F € 658,20 € 658,20 1 Supermicro CSE-721TQ-250B € 166,- € 166,- 2 Samsung M393A4K40BB0-CPB € 169,50 € 339,- Bekijk collectie

Importeer productenTotaal € 1163,20

Opslag wil ik regelen met een aantal Samsung SM843T SSDs die hier nog liggen. NVMe is in de toekomst zeker gewenst dus daar gaan we ook voor sparen.

Ik zie 'm bij Azerty staan met levertijd 2-3 dagen: https://azerty.nl/31-3022...icro-x10sdv-6c-tln4f.htmlejsinke schreef op maandag 02 mei 2016 @ 07:45:

[...]

Zit ook naar zelfde setje te kijken. Waar heb je deze besteld? Kan namelijk geen enkele webshop vinden die het een indicatie heeft over de levertijd van het moederbord.

Top! zie t nu ook. Afgelopen weken Azerty in de gaten gehouden, maar steeds niet leverbaar nu 2-3 dagen dus dat word ook bestellen..ta_chi79 schreef op maandag 02 mei 2016 @ 09:04:

[...]

Ik zie 'm bij Azerty staan met levertijd 2-3 dagen: https://azerty.nl/31-3022...icro-x10sdv-6c-tln4f.html

Yup, bij Azerty.ejsinke schreef op maandag 02 mei 2016 @ 12:14:

[...]

Top! zie t nu ook. Afgelopen weken Azerty in de gaten gehouden, maar steeds niet leverbaar nu 2-3 dagen dus dat word ook bestellen..

Dit is mijn hele winkelwagentje:

Product nr. omschrijving

874969 Supermicro CSE-721TQ-250B - Chassis - Black

875828 Supermicro CBL-0473L - Spare Part

876017 Supermicro CBL-0483L - Spare Part

876084 Supermicro CBL-0157L-02 - Spare Part

930654 Supermicro X10SDV-6C-TLN4F - Moederbord - Intel Xeon D-1528 - 0 GB - 2x Gb, 2x 10Gb LAN - IPMI

Kast, voeding, backplane info kabeltje en een zooitje SATA kabels (5x 21cm voor backplane en de SSD bay, 1x 29cm voor de optical bay waar ook een SSD in gemonteerd kan worden). Naast deze spulletjes heb je dan nog geheugen en iets van opslag nodig. Toppietoppie heeft ondersteunde 32GB modules (zie V&A).

Tip voor wie het moederbordje ook wil kopen: collega's raden me aan om de "+" versie te kopen (X10SDV-6C+TLN4F) omdat die een CPU fannetje heeft. Ik wil geen 50mm herrie ding op m'n CPU hebben dus ik ga er een 12cm PWM fan boven hangen. Deze kan dan ook over het M.2 slot blazen want zo'n NVMe SSD schijnt ook heet te worden. We'll see.

[ Voor 15% gewijzigd door hans_lenze op 02-05-2016 14:28 . Reden: Edit: extra fan ]

while (! ( succeed = try ()));

Mijn idee was (als ik een NVMe SSD koop) om er RAM koelblokjes op te plakken. Voor een paar euro heb je al snel 4 of 6 van die RAM koelblokjes, en volgens mij plakken die prima op een SSD

Even niets...

Afgelopen weekend de volgende setup binnen gekregen:

Dit is een (soort van) kopie uit het zuinige server topic. Hij draait onder ESXi 6.0 update 2 ongeveer 20-21 Watt zonder harddisks.(gemeten met een Voltcraft Energy Check 3000)

In de loop van de komende weken krijg ik de IBM 1015 HBA en gaat deze ook in de server met 4*4Tb disks. Ik ben benieuwt waar ik dan op uit kom.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Pentium G4400 Boxed | € 59,95 | € 59,95 |

| 1 | ASRock B150M Pro4S | € 73,43 | € 73,43 |

| 2 | Kingston ValueRAM KVR21N15D8/16 | € 54,- | € 108,- |

| 1 | Seasonic G-series 360 watt | € 57,95 | € 57,95 |

| 1 | Samsung 850 EVO 500GB | € 144,99 | € 144,99 |

| Bekijk collectie Importeer producten | Totaal | € 444,32 | |

Dit is een (soort van) kopie uit het zuinige server topic. Hij draait onder ESXi 6.0 update 2 ongeveer 20-21 Watt zonder harddisks.(gemeten met een Voltcraft Energy Check 3000)

In de loop van de komende weken krijg ik de IBM 1015 HBA en gaat deze ook in de server met 4*4Tb disks. Ik ben benieuwt waar ik dan op uit kom.

Ik zou er alleen eentje op de UBX chip plakken (dichtste bij de socket), zie FLIR thermal imaging een paar posts hierboven. Eventueel de RAM chip ernaast ook, maar ik denk dat die ietsje warmer wordt door de UBX chip en sowieso moet die de temperatuur wel kunnen hebben. De VNAND chips hebben aan wat airflow wel voldoende (en zullen zelfs zonder airflow het prima volhouden).FireDrunk schreef op maandag 02 mei 2016 @ 14:36:

Mijn idee was (als ik een NVMe SSD koop) om er RAM koelblokjes op te plakken. Voor een paar euro heb je al snel 4 of 6 van die RAM koelblokjes, en volgens mij plakken die prima op een SSD

[ Voor 22% gewijzigd door |sWORDs| op 02-05-2016 15:16 ]

Te Koop:24 Core Intel Upgradeset

Klopt, maar als je toch een kitje koopt, waarom niet

Nadeel is soms, dat zoals op dit bord: pricewatch: ASRock Z170 Extreme3 het M.2 slot achter de GPU zit... Dat laat weinig ruimte over voor RAM koelblokjes...

Nadeel is soms, dat zoals op dit bord: pricewatch: ASRock Z170 Extreme3 het M.2 slot achter de GPU zit... Dat laat weinig ruimte over voor RAM koelblokjes...

Even niets...

En dat er bij de X10SDV bordjes een Aspeed chip onder de M2 zit die ook erg heet kan worden.

Als je trouwens het maximale uit je NVME drive wil halen zul je trouwens echt minimaal een Broadwell Quad Core op 1.6GHz (Haswell 1.7GHz, etc) of hoger moeten hebben, met name voor 4K read/write. En bedenk dat die CPU dan eigenlijk al vol zit als één a twee VM's max IO trekken. Sequentieel is het een stukje lager, ongeveer twee cores.

Host 24x 2.4GHz Haswell-EP, 2vCPU VM met Windows 2012R2 en PVSCSI:

Als je trouwens het maximale uit je NVME drive wil halen zul je trouwens echt minimaal een Broadwell Quad Core op 1.6GHz (Haswell 1.7GHz, etc) of hoger moeten hebben, met name voor 4K read/write. En bedenk dat die CPU dan eigenlijk al vol zit als één a twee VM's max IO trekken. Sequentieel is het een stukje lager, ongeveer twee cores.

Host 24x 2.4GHz Haswell-EP, 2vCPU VM met Windows 2012R2 en PVSCSI:

| IO | Host Core Load (na aftrek idle load) | VM Core Load |

| 4K Read/Write (700MB/s) | 3.12 | 1.56 |

| Sequential Read (2400MB/s) | 1.44 | 0.48 |

| Sequential Write (1050MB/s) | 0.96 | 0.28 |

[ Voor 108% gewijzigd door |sWORDs| op 02-05-2016 16:25 ]

Te Koop:24 Core Intel Upgradeset

M'n Asus P10S-I + Xeon 1235L gaan weer de deur uit.

Is erg zuinig (21W idle met disks in spindown) maar voldoen nu al niet meer aan mijn eisen.

Ik heb onlangs wat meer eisen kwa aantallen aan VM's gekregen, moet dus flink meer gaan draaien.

Zit te kijken naar de nieuwe 2600 v4 series pricewatch: Intel Xeon E5-2620 v4 of pricewatch: Intel Xeon E5-2630 v4. Ben benieuwd wat dat gaat draaien!

pricewatch: Intel Xeon E5-2620 v4 of pricewatch: Intel Xeon E5-2630 v4. Ben benieuwd wat dat gaat draaien!

Is erg zuinig (21W idle met disks in spindown) maar voldoen nu al niet meer aan mijn eisen.

Ik heb onlangs wat meer eisen kwa aantallen aan VM's gekregen, moet dus flink meer gaan draaien.

Zit te kijken naar de nieuwe 2600 v4 series

[ Voor 24% gewijzigd door renedis op 02-05-2016 16:55 . Reden: links toegevoegd ]

Ik heb net twee niet bootende 2687W ES v4's terug gestuurd.

Te Koop:24 Core Intel Upgradeset

Wel BIOS update van te voren gedaan?|sWORDs| schreef op maandag 02 mei 2016 @ 17:26:

Ik heb net twee niet bootende 2687W ES v4's terug gestuurd.

Ja, sowieso had ie wel iets moeten doen. IPMI gaf zelfs aan CPU not installed.

Te Koop:24 Core Intel Upgradeset

Als ik NVMe SSD's zou kopen, zou het voor ZFS zijn (als SSD only array), in mijn Xeon E5-2630v3 met 64GB RAM, dus ik verwacht geen problemen.|sWORDs| schreef op maandag 02 mei 2016 @ 15:58:

En dat er bij de X10SDV bordjes een Aspeed chip onder de M2 zit die ook erg heet kan worden.

Als je trouwens het maximale uit je NVME drive wil halen zul je trouwens echt minimaal een Broadwell Quad Core op 1.6GHz (Haswell 1.7GHz, etc) of hoger moeten hebben, met name voor 4K read/write. En bedenk dat die CPU dan eigenlijk al vol zit als één a twee VM's max IO trekken. Sequentieel is het een stukje lager, ongeveer twee cores.

Host 24x 2.4GHz Haswell-EP, 2vCPU VM met Windows 2012R2 en PVSCSI:

IO Host Core Load (na aftrek idle load) VM Core Load 4K Read/Write (700MB/s) 3.12 1.56 Sequential Read (2400MB/s) 1.44 0.48 Sequential Write (1050MB/s) 0.96 0.28

Wel schrikken die load getallen

Blijkbaar is NVMe qua driver nog CPU intensief (zal wel met het queue en threading model te maken hebben).

Even niets...

Het zou erg interessant zijn om dezelfde getallen te zien met andere virtuele storage adapters. En die getallen dan normaliseren voor MB/s of IOps om de vergelijking eerlijk te houden.FireDrunk schreef op dinsdag 03 mei 2016 @ 07:46:

[...]

Als ik NVMe SSD's zou kopen, zou het voor ZFS zijn (als SSD only array), in mijn Xeon E5-2630v3 met 64GB RAM, dus ik verwacht geen problemen.

Wel schrikken die load getallenIk dacht dat pvscsi er juist voor zorgde dat de load eerder in de VM kwam te liggen omdat het "maken" van het IO request in de VM gebeurde, en de host het request 1-op-1 kon doorzetten naar de storage laag, zonder daar nog translatie op de hoeven doen.

Blijkbaar is NVMe qua driver nog CPU intensief (zal wel met het queue en threading model te maken hebben).

Ik denk (hoop) dat NVMe er erg gunstig uit gaat komen door de bizarre snelheid die hij haalt.

while (! ( succeed = try ()));

Dan moet je het topic even lezen, die heb ik al eens gepost. PVSCSI is sneller en laagste load per GB/s.hans_lenze schreef op dinsdag 03 mei 2016 @ 09:32:

[...]

Het zou erg interessant zijn om dezelfde getallen te zien met andere virtuele storage adapters. En die getallen dan normaliseren voor MB/s of IOps om de vergelijking eerlijk te houden.

Ik denk (hoop) dat NVMe er erg gunstig uit gaat komen door de bizarre snelheid die hij haalt.

Het komt volgens mij gewoon door de grote getallen. Read is 5x meer, Write is 4x meer, 4K is 2,5x meer dan een SATA drive.FireDrunk schreef op dinsdag 03 mei 2016 @ 07:46:

[...]

Blijkbaar is NVMe qua driver nog CPU intensief (zal wel met het queue en threading model te maken hebben).

[ Voor 25% gewijzigd door |sWORDs| op 03-05-2016 10:40 ]

Te Koop:24 Core Intel Upgradeset

Daar zit ook wel wat in, maar NVMe zou een "kleinere/kortere" stack moeten zijn tot het device. Wat weer in minder CPU cycles zou moeten resulteren, maar dat zie je dus niet direct terug.

Uiteraard is de grotere hoeveelheid data die verplaatst moet worden zwaarder voor de CPU.

Uiteraard is de grotere hoeveelheid data die verplaatst moet worden zwaarder voor de CPU.

Even niets...

Maar het is alleen NVMe tussen de host storage stack en device. VM naar storage stack is nu nog SCSI.

Vandaar dat de verminderde latency niet echt zichtbaar is en ook de extra overhead er binnen de VM nog is.

700MB/s aan 4K is 180K IOPS, dus 5.6x minder dan hierboven, dan vind ik de cijfers die ik had zo gek nog niet. (23.5/5.6 = 4.2 Cores en niet 3.1, dus blijkbaar gaat er nog aardig wat afhandeling direct door, bedenk wel dat de host nog de blocks weer naar een VMFS filesystem moet schrijven en je dus weer bovenin de stack begint.)

Er was een publieke post van Intel en VMware over NVMe waarin stond dat er aan een virtuele NVME driver gewerkt wordt, die kan ik zo snel niet vinden, maar google vond wel deze op LinkedIn:

VMware

September 2014 – March 2016 (1 year 7 months)Palo Alto

• Development of the ESX storage stack to fully utilize capabilities of the new generation of high-throughput, low-latency storage devices by designing the critical data structures for lockless parallel I/O processing without breaking existing storage modules.

• Development of NUMA-aware I/O scheduler module in PSA storage stack to support multi-queue parallel feature for high performance PCIe SSDs like NVMe. Scalability design in adapter and path layers for various Flash SSDs. Dynamically scheduling IO issuing/completion worlds based on NUMA affinity.

• Involved in the emulation of virtual NVMe interface in ESX to eliminate the overhead of translations from NVMe to SCSI and back to NVMe in driver.

Er is zelfs nog meer uit te persen met PVSCSI door de ringpages en queuedepth nog wat te verhogen:

196K IOPS 4K read, 219K IOPS 4K write (32GB test om zeker te weten dat de 8GB burst en elke vorm van memory caching geen invloed heeft). Bedenk ook dat VMFS niet voor 4K gemaakt is met 8KB subblocks.

Vandaar dat de verminderde latency niet echt zichtbaar is en ook de extra overhead er binnen de VM nog is.

700MB/s aan 4K is 180K IOPS, dus 5.6x minder dan hierboven, dan vind ik de cijfers die ik had zo gek nog niet. (23.5/5.6 = 4.2 Cores en niet 3.1, dus blijkbaar gaat er nog aardig wat afhandeling direct door, bedenk wel dat de host nog de blocks weer naar een VMFS filesystem moet schrijven en je dus weer bovenin de stack begint.)

Er was een publieke post van Intel en VMware over NVMe waarin stond dat er aan een virtuele NVME driver gewerkt wordt, die kan ik zo snel niet vinden, maar google vond wel deze op LinkedIn:

VMware

September 2014 – March 2016 (1 year 7 months)Palo Alto

• Development of the ESX storage stack to fully utilize capabilities of the new generation of high-throughput, low-latency storage devices by designing the critical data structures for lockless parallel I/O processing without breaking existing storage modules.

• Development of NUMA-aware I/O scheduler module in PSA storage stack to support multi-queue parallel feature for high performance PCIe SSDs like NVMe. Scalability design in adapter and path layers for various Flash SSDs. Dynamically scheduling IO issuing/completion worlds based on NUMA affinity.

• Involved in the emulation of virtual NVMe interface in ESX to eliminate the overhead of translations from NVMe to SCSI and back to NVMe in driver.

Er is zelfs nog meer uit te persen met PVSCSI door de ringpages en queuedepth nog wat te verhogen:

196K IOPS 4K read, 219K IOPS 4K write (32GB test om zeker te weten dat de 8GB burst en elke vorm van memory caching geen invloed heeft). Bedenk ook dat VMFS niet voor 4K gemaakt is met 8KB subblocks.

[ Voor 104% gewijzigd door |sWORDs| op 03-05-2016 12:16 ]

Te Koop:24 Core Intel Upgradeset

Sweet, dat is wel nice idd. Als we een PVNVME driver krijgen, gaat het gas er echt flink op!

Vooral NUMA aware is wel tricky denk ik. Juist omdat NVMe direct op de PCIe bus zit, is het slim om IO te schedulen op de CPU welke de link met die specifieke NVMe SSD heeft.

Das best pittig programmeren gok ik

Vooral NUMA aware is wel tricky denk ik. Juist omdat NVMe direct op de PCIe bus zit, is het slim om IO te schedulen op de CPU welke de link met die specifieke NVMe SSD heeft.

Das best pittig programmeren gok ik

Even niets...

Kan iemand bevestigen of deze ook werkt in ESXi 6 ?

Volgens de reviews werkt hij is ESXi maar die review is al van januari 2013.

Ik wil deze gaan gebruiken icm een SSD voor de datastore heb de datastore nu op m'n synology nas dat is niet ideaal.

| 1 | Conceptronic PCI Express Card SATA 600 | € 29,99 | € 29,99 |

Volgens de reviews werkt hij is ESXi maar die review is al van januari 2013.

Ik wil deze gaan gebruiken icm een SSD voor de datastore heb de datastore nu op m'n synology nas dat is niet ideaal.

Beetje onderzoeken/zelf initiatief mag ook wel.. Het heeft een ASMedia ASM1061 chip zoals in het bijzonderheden veld staat.ComTech schreef op dinsdag 03 mei 2016 @ 19:48:

Kan iemand bevestigen of deze ook werkt in ESXi 6 ?

1 Conceptronic PCI Express Card SATA 600 € 29,99 € 29,99

Volgens de reviews werkt hij is ESXi maar die review is al van januari 2013.

Ik wil deze gaan gebruiken icm een SSD voor de datastore heb de datastore nu op m'n synology nas dat is niet ideaal.

http://www.lmgtfy.com/?q=ASMedia+ASM1061+ESXi

Dat is niet 100% een garantie, maar zeker een goede indicatie. Ik heb ook van die ASM chipj based controller gehad, maar die hadden een wat aparte BIOS, waardoor er toch wat mis ging bij het booten icm ESXI (PSOD).

Overigens wil je op dat kaartje geen moderne SSD hangen, je bottlenecked dat ding keihard... Voor een beetje SSD wil je minimaal PCIe 2.0 x2 of x4. PCIe 3.0 x1 kan, maar ook dan haal je nog een klein beetje van de piek van de SSD af (512MB/s).

Overigens wil je op dat kaartje geen moderne SSD hangen, je bottlenecked dat ding keihard... Voor een beetje SSD wil je minimaal PCIe 2.0 x2 of x4. PCIe 3.0 x1 kan, maar ook dan haal je nog een klein beetje van de piek van de SSD af (512MB/s).

[ Voor 6% gewijzigd door FireDrunk op 04-05-2016 07:19 ]

Even niets...

Nu zo'n beetje elke Skylake VT-d ondersteunt vroeg ik me af of mensen in het wild al ESX projecten on the cheap hebben gevonden in het wild die VGA passthrough doen? Iets met 2 16x sloten, een i3 6100 en 2 AMD kaarten?

Op Google kan ik weinig vinden en ik heb ook geen weet van Engelstalige forums die dit onderwerp regelmatig behandelen.

Op Google kan ik weinig vinden en ik heb ook geen weet van Engelstalige forums die dit onderwerp regelmatig behandelen.

Waarom zou je twee kaarten en een i3 gebruiken? Wat is het nut? Crossfire gaat denk ik niet werken, en twee machines simultaan op een i3 voor gaming gaat ook niet vliegen.

[ Voor 46% gewijzigd door |sWORDs| op 09-05-2016 14:15 ]

Te Koop:24 Core Intel Upgradeset

Het nut? Sommige applicaties vereisen 3D hardware versnelling. Ik zou op een moederbord wel 4 of 6 kaarten willen prikken en dan even zoveel guests, handig voor testing.

sphere schreef op maandag 09 mei 2016 @ 14:20:

Het nut? Sommige applicaties vereisen 3D hardware versnelling. Ik zou op een moederbord wel 4 of 6 kaarten willen prikken en dan even zoveel guests, handig voor testing.

Zoals je hier boven kunt zien heb ik het niet over het nut van graphics. Maar met een dual core CPU twee kaarten bezig houden lijkt me niet te doen.|sWORDs| schreef op woensdag 13 april 2016 @ 15:45:

[...]

Omdat de remote experience een stuk beter wordt? Omdat je een stuk meer desktop VM's op dezelfde CPU kunt draaien? En natuurlijk voor gaming of CAD achtig werk.

Tegenwoordig moet het best aardig te doen zijn nu een aantal Intel GPU's supported zijn.

Maar bij met name server workloads heb je volledig gelijk.

Ik heb hier zelf ook een K2 en een M60, maar dan wel met twee 2690 ES v3's/ v4's (24x2.7GHz / 28x3GHz).

Voordeel van Grid of AMD Multi User GPU is dat de graphics kunt delen met meerdere VM's.

[ Voor 17% gewijzigd door |sWORDs| op 09-05-2016 15:25 ]

Te Koop:24 Core Intel Upgradeset

Heb je wel eens geprobeerd om zoiets daadwerkelijk geleverd te krijgen met garantie en support? (ja ik heb je profiel gezien).

Ik heb een applicatie die sowieso een 3D kaart nodig heeft. Als zo'n guest 2 cores krijgt is het wel genoeg voor de meeste scenario's. GPU time slicing lijkt me vrij sub optimaal.

Voorbeeld: bak met 390X en een 5280 cpu, GPU zit vol, cpu gebruikt 1-2 threads. Om te schalen moet ik nu 4 machines optuigen.

Ik heb een applicatie die sowieso een 3D kaart nodig heeft. Als zo'n guest 2 cores krijgt is het wel genoeg voor de meeste scenario's. GPU time slicing lijkt me vrij sub optimaal.

Voorbeeld: bak met 390X en een 5280 cpu, GPU zit vol, cpu gebruikt 1-2 threads. Om te schalen moet ik nu 4 machines optuigen.

Grid 2 (M60) gaat je niet lukken i.v.m. extra licenties en licentie server. Maar Grid 1(K1/K2) en AMD S7150 (ongeveer 2500 single, 3500 dual GPU) moet gewoon te bestellen zijn. Wel even opletten qua cooling, K1/K2/M60/S7150 x2 zijn passive (dus heel veel airflow nodig), S7150 single is zowel active als passive leverbaar. Qua VMware licenties is er VMUG EVALExperience ($200/jaar), voor persoonlijk gebruik in niet productie omgevingen.

GPU time slicing is juist heel optimaal voor de meeste toepassingen. Een GPU heeft maar hele korte loads als je ver genoeg zoomt, terwijl het wacht op CPU of IO.

Een beetje zoals dit:

|.....|.....|.....|.....|.....|.....|.....|

Op die lege plekken passen dus heel wat taken van andere VM's. Ook moet je niet vergeten dan een VM niet altijd 1/n slice krijgt, maar dat alle VM's met actieve taken de slices verdelen en de taak die uitgevoerd wordt alle shaders kan gebruiken. VRAM is wel 1/n.

GPU time slicing is juist heel optimaal voor de meeste toepassingen. Een GPU heeft maar hele korte loads als je ver genoeg zoomt, terwijl het wacht op CPU of IO.

Een beetje zoals dit:

|.....|.....|.....|.....|.....|.....|.....|

Op die lege plekken passen dus heel wat taken van andere VM's. Ook moet je niet vergeten dan een VM niet altijd 1/n slice krijgt, maar dat alle VM's met actieve taken de slices verdelen en de taak die uitgevoerd wordt alle shaders kan gebruiken. VRAM is wel 1/n.

[ Voor 103% gewijzigd door |sWORDs| op 09-05-2016 15:59 ]

Te Koop:24 Core Intel Upgradeset

Het gaat hier niet om mijnenveger op citrix ofzo hoor  Bel me anders op, je kan je er duidelijk geen voorstelling bij maken. Die AMD kaarten zijn ook nog niet leverbaar trouwens.

Bel me anders op, je kan je er duidelijk geen voorstelling bij maken. Die AMD kaarten zijn ook nog niet leverbaar trouwens.

Ik had het niet over mijnenveger, maar zaken zoals CAD (wat jij wil doen weet ik niet, je zegt alleen 'een applicatie'):

In dit CATIA V5/V6 lijstje van nVidia doen ze:

Bij AMD MxGPU hoef je trouwens geen 1:1 te doen voor OpenCL.

Maar kijk ook eens naar gebruikte cores en memory, dat soort cijfers is wat ik normaal zie en waarom ik niet begrijp wat je doet dat je met een i3 twee kaarten kunt vullen.

In dit CATIA V5/V6 lijstje van nVidia doen ze:

| Type | Users/GPU | Users/M60 | vCPU | vMem |

| Standard CAD | 8 | 16 | 4 | 8 |

| Advanced CAD | 4 | 8 | 6 | 16 |

| Advanced CAD+(Cuda/OpenCL required) | 1 | 2 | 8 | 24 |

Bij AMD MxGPU hoef je trouwens geen 1:1 te doen voor OpenCL.

Maar kijk ook eens naar gebruikte cores en memory, dat soort cijfers is wat ik normaal zie en waarom ik niet begrijp wat je doet dat je met een i3 twee kaarten kunt vullen.

[ Voor 82% gewijzigd door |sWORDs| op 09-05-2016 16:38 ]

Te Koop:24 Core Intel Upgradeset

Zit je met GPU 'timing' niet heel erg met het verschil in vRAM gebruik? Stel, applicatie A wil 2GB met allemaal 0-en, en Applicatie B wil 2GB met allemaal 1-en, en je hebt maar 2GB.

Gaat hij dan bij elke time slice 2GB vRAM herschrijven? Want dat kost je bakken met performance?

(Wat veel mensen niet weten, is dat het laden van games voor een groot percentage bestaat uit het inladen van textures in vRAM...)

Gaat hij dan bij elke time slice 2GB vRAM herschrijven? Want dat kost je bakken met performance?

(Wat veel mensen niet weten, is dat het laden van games voor een groot percentage bestaat uit het inladen van textures in vRAM...)

Even niets...

Nee, zo werkt het niet. Als je een GPU met 8GB aan 8 VM's geeft krijgt iedereen 1/8e van 8 = 1GB. Net als bij je normale geheugen is het geheugen niet iets wat we delen (TPS even buiten beschouwing gelaten).

Dus een nVidia M60 kaart heeft twee GPU's met ieder 8GB VRAM en 2048 cores.

Maak je 8 VM's (per GPU, 16 per kaart) aan met M60-1Q's dan heeft elke VM 2048 cores en 1GB aan VRAM.

Heeft jouw applicatie echt 2GB nodig, dan worden dat 4 M60-2Q's, etc.

Meestal zijn er voldoende gaten om 8 VM's taken op de 2048 cores uit te laten voeren zonder echt te queuen. Maar dan moet je wel echte workloads draaien en geen synthetische benchmarks (ook daar zijn gaten, maar een stuk minder).

Over het laden gesproken, een groot deel van het productie verlies bij CAD is het in/uitchecken van grote objecten. Dat is het andere voordeel van CAD machines naar datacenter, 10Gbit naar de backend en veel minder wacht tijd, daarnaast kunnen de VM's voor 3D workloads dan nog NVMe drives delen waardoor de verwerking ook nog een behoorlijke bump krijgt.

Dus een nVidia M60 kaart heeft twee GPU's met ieder 8GB VRAM en 2048 cores.

Maak je 8 VM's (per GPU, 16 per kaart) aan met M60-1Q's dan heeft elke VM 2048 cores en 1GB aan VRAM.

Heeft jouw applicatie echt 2GB nodig, dan worden dat 4 M60-2Q's, etc.

Meestal zijn er voldoende gaten om 8 VM's taken op de 2048 cores uit te laten voeren zonder echt te queuen. Maar dan moet je wel echte workloads draaien en geen synthetische benchmarks (ook daar zijn gaten, maar een stuk minder).

Over het laden gesproken, een groot deel van het productie verlies bij CAD is het in/uitchecken van grote objecten. Dat is het andere voordeel van CAD machines naar datacenter, 10Gbit naar de backend en veel minder wacht tijd, daarnaast kunnen de VM's voor 3D workloads dan nog NVMe drives delen waardoor de verwerking ook nog een behoorlijke bump krijgt.

[ Voor 75% gewijzigd door |sWORDs| op 09-05-2016 17:11 ]

Te Koop:24 Core Intel Upgradeset

Ah, dan is het minder sharing maar meer slicing inderdaad. Dan is het een veel duurdere aangelegenheid. Ik hoopte meer op een vorm van overcommitment die door middel van efficient "pagen" zou werken, maar dat zou een gigantische verantwoordelijkheid bij de drivers leggen om dat te laten blijven performen

CAD in the Cloud, je moet er maar een use case voor hebben

CAD in the Cloud, je moet er maar een use case voor hebben

Even niets...

Een CAD workstation is zo'n $5K-$8K. CATIA licenties zijn 10K tot 60K + 90% voor 5 jaar support, salaris CATIA designer is 90K.

Bedenk dan dat er geen uitval meer is (n+1), minder wachttijd (15-30% minder personeel) en je kunt het sommetje zo maken. Zelfs in het ongunstigste geval met 1:1 is er al behoorlijke winst (11K+ per user per jaar) en voor de andere gevallen loopt dat flink op.

CAD in je datacenter is juist een van de allerbeste use cases en dan hebben we het nog niet eens over remote werken gehad. De meeste automotive en aerospace bedrijven plaatsen of de workstations in de datacenters of maken gebruik van virtualisatie.

Bedenk dan dat er geen uitval meer is (n+1), minder wachttijd (15-30% minder personeel) en je kunt het sommetje zo maken. Zelfs in het ongunstigste geval met 1:1 is er al behoorlijke winst (11K+ per user per jaar) en voor de andere gevallen loopt dat flink op.

CAD in je datacenter is juist een van de allerbeste use cases en dan hebben we het nog niet eens over remote werken gehad. De meeste automotive en aerospace bedrijven plaatsen of de workstations in de datacenters of maken gebruik van virtualisatie.

[ Voor 10% gewijzigd door |sWORDs| op 10-05-2016 08:57 ]

Te Koop:24 Core Intel Upgradeset

Oh, ik geloof je meteen hoor, dat het een goede vooruitgang is. Maar het zijn wel hele specifieke use cases. Voor 'wisselend' werk is het misschien weer duur. Als je het ook nog moet combineren met VDI, Citrix en andere technologieen is het weer een uitdaging.

Je verliest trouwens toch ook je vMotion capaciteit als je met die GPU sharing werkt? Dus n+1 is wel waar, maar niet zonder reboot/relogin/nieuw desktop of whatever?

Je verliest trouwens toch ook je vMotion capaciteit als je met die GPU sharing werkt? Dus n+1 is wel waar, maar niet zonder reboot/relogin/nieuw desktop of whatever?

Even niets...

Je hebt geen vMotion, maar als je Workstation stuk gaat heb je niet in een minuut een nieuwe. Voor wisselend werk heb je het meestal niet over 1:1 en gaat er een andere sommetje lopen. Voor lichte graphics workloads heb je nog kaarten zoals de K1 met 4 GPU's en 16GB VRAM, etc.

En nee het is niet voor alle use cases, maar er zijn er best veel die er van kunnen profiteren.

En nee het is niet voor alle use cases, maar er zijn er best veel die er van kunnen profiteren.

[ Voor 60% gewijzigd door |sWORDs| op 10-05-2016 09:12 ]

Te Koop:24 Core Intel Upgradeset

Klopt, maar dat maakt het lastig te combineren met stateless VDI's in zo'n geval. Maar dat maakt de usecase (in mijn ogen) niet minder aantrekkelijk

Ik ben van plan om een nieuwe GTX1080 te kopen, misschien eens leuk om te testen of het ding onder ESXi met GPU passthrough wil werken, en meten wat het idle verbruik is

Ik ben van plan om een nieuwe GTX1080 te kopen, misschien eens leuk om te testen of het ding onder ESXi met GPU passthrough wil werken, en meten wat het idle verbruik is

[ Voor 36% gewijzigd door FireDrunk op 10-05-2016 09:14 ]

Even niets...

Natuurlijk is het prima te combineren met een non persistent VM. Zo lang de gebruiker niet uitlogt (disconnect/reconnect kan prima) blijft zijn temp folder behouden en de enige data die op de machine blijft staan is de data die momenteel uitgecheckt is. Config (UEM) en profile data gaat naar shares. En indien je het echt zou willen kun je zelfs gebruik maken van een writable volume (AppVolumes), dan heb je een non persistent machine die voor de gebruiker persistent lijkt.

Geforce gaat niet werken in passthrough, het zijn dezelfde chips maar nVidia heeft het uitgeschakeld.

Geforce gaat niet werken in passthrough, het zijn dezelfde chips maar nVidia heeft het uitgeschakeld.

[ Voor 9% gewijzigd door |sWORDs| op 10-05-2016 09:19 ]

Te Koop:24 Core Intel Upgradeset

Die vGPU sharing werkt niet, maar de 'gewone' GPU passthrough via VT-d zou toch wel moeten werken tegenwoordig?

Even niets...

Dat is hoe wij het doen.. Met AppVolumes. werkt perfect icm met AD permissies|sWORDs| schreef op dinsdag 10 mei 2016 @ 09:18:

Natuurlijk is het prima te combineren met een non persistent VM. Zo lang de gebruiker niet uitlogt (disconnect/reconnect kan prima) blijft zijn temp folder behouden en de enige data die op de machine blijft staan is de data die momenteel uitgecheckt is. Config (UEM) en profile data gaat naar shares. En indien je het echt zou willen kun je zelfs gebruik maken van een writable volume (AppVolumes), dan heb je een non persistent machine die voor de gebruiker persistent lijkt.

Geforce gaat niet werken in passthrough, het zijn dezelfde chips maar nVidia heeft het uitgeschakeld.

Kleine applicaties via thinapps en grote zware applicaties in de gold image met temp/user/app folder naar een netwerk folder.

En als aavulling op de GRID kaarten hebben we een Apex 2800 geplaatst. Bleek erg veel te helpen met video's afspelen.

[ Voor 6% gewijzigd door renedis op 10-05-2016 09:38 ]

Niet voor Geforce kaarten, wel voor AMD/Intel(Haswell)/NVIDIA GRID/meeste nVidia Quadro.FireDrunk schreef op dinsdag 10 mei 2016 @ 09:21:

Die vGPU sharing werkt niet, maar de 'gewone' GPU passthrough via VT-d zou toch wel moeten werken tegenwoordig?

Mochten jullie naar VMWorld Europe of US gaan, kom dan eens naar mijn sessies luisteren:renedis schreef op dinsdag 10 mei 2016 @ 09:22:

[...]

Dat is hoe wij het doen.. Met AppVolumes. werkt perfect icm met AD permissies

Kleine applicaties via thinapps en grote zware applicaties in de gold image met temp/user/app folder naar een netwerk folder.

En als aavulling op de GRID kaarten hebben de een Apex 2800 geplaatst. Bleek erg veel te helpen met video's afspelen.

- Submission ID - 9024

Session Title - Application Packaging and Delivery Strategics

Type - Breakout Session

Session Abstract - In the changing world of application packaging and delivery how do you create a strategy that enables you to quickly deploy your applications without shifting effort to an end user or being unable to deploy all applications? How can you get the best out of VMware's offerings by combining two or more technologies like AppVolumes, User Environment Manager, ThinApp and Identity Manager? - Submission ID - 9075

Session Title - VMware Horizon AlwaysOn

Type - Breakout Session

Session Abstract - Designing a solution with no single point of failure for the products in the VMware Horizon suite. - Title - Optimizing Windows to Fit Your VDI

Type - Meet the Experts

Session Abstract - By optimizing Windows OS, you can increase VDI capacity in software approach, which is easy and cost effective comparing to hardware approach. The difficult part is how to do the optimization according to specific need. Also, considering the complex of software stacks on which modern applications are built, it's not an easy task to do the optimization properly. In this session, experience about Windows OS optimization is shared, based on field experience, and experience from creating VMware OS Optimization Tool, which is one of the most popular VMware Flings.

[ Voor 180% gewijzigd door |sWORDs| op 10-05-2016 09:41 ]

Te Koop:24 Core Intel Upgradeset

Ik ben helaas al een tijdje niet meer professioneel bezig met VMware... Ik mis het wel

Zit momenteel in de Oracle Middleware en Continous Delivery kant.

'Vroeger' veel VMware beheer gedaan (in ESXi4/5.0 tijdperk), maar nu alleen nog maar thuis

Zit momenteel in de Oracle Middleware en Continous Delivery kant.

'Vroeger' veel VMware beheer gedaan (in ESXi4/5.0 tijdperk), maar nu alleen nog maar thuis

Even niets...

Erg interessant ja|sWORDs| schreef op dinsdag 10 mei 2016 @ 09:22:

[...]

Niet voor Geforce kaarten, wel voor AMD/Intel(Haswell)/NVIDIA GRID/meeste nVidia Quadro.

[...]

Mochten jullie naar VMWorld Europe of US gaan, kom dan eens naar mijn sessies luisteren:

- Submission ID - 9024

Session Title - Application Packaging and Delivery Strategics

Type - Breakout Session

Session Abstract - In the changing world of application packaging and delivery how do you create a strategy that enables you to quickly deploy your applications without shifting effort to an end user or being unable to deploy all applications? How can you get the best out of VMware's offerings by combining two or more technologies like AppVolumes, User Environment Manager, ThinApp and Identity Manager?- Submission ID - 9075

Session Title - VMware Horizon AlwaysOn

Type - Breakout Session

Session Abstract - Designing a solution with no single point of failure for the products in the VMware Horizon suite.- Title : Optimizing Windows to Fit Your VDI

Type : Meet the Experts

Session Abstract

By optimizing Windows OS, you can increase VDI capacity in software approach, which is easy and cost effective comparing to hardware approach. The difficult part is how to do the optimization according to specific need. Also, considering the complex of software stacks on which modern applications are built, it's not an easy task to do the optimization properly. In this session, experience about Windows OS optimization is shared, based on field experience, and experience from creating VMware OS Optimization Tool, which is one of the most popular VMware Flings.

Session Outline

5 Things You Should Know About Optimizing Windows OS for VDI

Scenario based Windows 10 optimization

VMware OS Optimization Tool, for Horizon View, Horizon Air, and Horizon Air Hybrid

Optimization result estimation

Ik pak dan meestal een summer school o.i.d. als ik niet kan/mag gaan. Maar thanks voor de invite

Misschien kan ik er wel eentje doen tijdens SummerSchool... De eerste?renedis schreef op dinsdag 10 mei 2016 @ 09:41:

[...]

Erg interessant jaMeestal mag er maar 1 persoon gaan en dit jaar is het de beurt van mijn collega. Uiteraard hoop ik dat ik ook mag gaan maar weinig kans

Ik pak dan meestal een summer school o.i.d. als ik niet kan/mag gaan. Maar thanks voor de invite

[ Voor 74% gewijzigd door |sWORDs| op 10-05-2016 09:50 ]

Te Koop:24 Core Intel Upgradeset

Heb net weer de vraag bij de manager gelegd voor barcalona.|sWORDs| schreef op dinsdag 10 mei 2016 @ 09:50:

[...]

Misschien kan ik er wel eentje doen tijdens SummerSchool... De eerste?

Mocht dat niet lukken houd ik mij zeker aanbevolen voor de summerschool! Ik zie overigens nog geen SummerSchool events voor 2016 op de vmware website/blog.

Als trouwe lezer van dit topic ben ik hier recent weer veel geweest om te bepalen waarmee ik mijn 1e ESXi setup ging vervangen of uitbreiden. Erg nuttig allemaal. Ik ging van simpele setups tot de Xeon D15xx of Engineering samples, prijs varieerde tussen 600 en 2000 euro. Hierbij mijn bijdrage van wat ik gekozen heb, waarom en hoe het bevalt. Dit is tenslotte een zuinige ESXI server (en niet die 150-200W varianten die hier wel eens langskomen)

Situatie

Ik heb 1 ESXi servertje dat altijd aanstaat, voor mijn firewall, terminal server, webserver en meer. Deze setup heeft 3.5 jaar probleemloos gedraaid, met 'idle' 16-20GB geheugen in gebruik en 15% CPU load.

Ik ben de laatste tijd echter meer bezig geweest met Cisco VIRL en daar liep ik snel tegen limieten aan. Voor mijn typische setups wilde VIRL graag 24-32GB geheugen hebben en die ruimte had ik niet. Als VIRL eenmaal gestart was, was de CPU load 30-40% met een typische netwerk setup. De CPU had nog wel wat headroom.

Oude setup.

Deze heeft 3.5 jaar vlekkeloos gedraaid zonder een crash oid:

Verbruik idle met ESXi 5.5 en 0.1V undervolted geheugen, ESXi geboot, geen VM gestart: 30-35 Watt

Opties

Ik had 2 opties:

1. Vervangen door een zuinige setup met minstens 64 GB geheugen

2. Extra server bouwen, met veel performance en die alleen aanzetten indien nodig

Optie 1 zou zijn: i5 6600 + 64GB => ± 600 euro

Optie 2 zou zijn: i7-5820K + MB met 8 sloten + 64 GB (4x16GB, kon ik bijprikken indien nodig) => ± 1000 euro

Nadeel van Optie 1 was dat ik weinig extra performance had (een i5-3550 is redelijk vergelijkbaar met een i5-6600 ondanks 3 generaties verschil), zodat ik het risico bleef houden dat opstarten VIRL mijn firewall hinderde. Met resource limitaties is dat wel te regelen.

Nadeel van Optie 2 was dat het duurder was.

Keuze

Uiteindelijk heb ik voor optie 1 gekozen. Iemand anders wilde voor een paar maanden een ESXi server lenen en met optie 1 had ik mijn oude server over/vrij. Dit is denk ik de goedkoopste optie om een zuinige server met 64 GB te hebben.

Mijn configuratie is:

Verbruik met ESXi 5.5U3 gestart zonder VMs: 20 Watt

CPU zat ik te twijfelen tussen i5-6600 en i7-6700(K). Het grootste verschil is HT en dat nut schijnt beperkt te zijn met ESXi (uit reacties in dit topic). Hogere base frequentie maakt niet veel uit als de Turbo gelijk is. Op meerdere review sites zag ik dat het verschil tussen de i5 en i7 heel minimaal is. Winst tov i5-3550 is volgens cpubenchmark minimaal (7623 tov 6822)

Moederbord is bewezen door andere gebruikers in dit topic. Mijn ervaring met de Durable serie van Gigabyte (steekproef: 1) was erg goed. Met M2 slot voor later een snelle SSD.

Geheugen: gewoon het goedkoopste 2133 Mhz A-merk geheugen dat goed te verkrijgen was (levertijd 2 dagen)

Behuizing: ik vond het wel leuk om een lagere kast te hebben als je dan toch een mATX bordje hebt. Gebaseerd op een tweaker-review en een youtube-review

Voeding: Is natuurlijk overkill aan vermogen, maar een stabiele voeding is een vereiste. De keuze was gebaseerd op de review van -The_Mask-.

In mekaar zetten was inderdaad erg makkelijk met de kast (die wel erg licht is), leverde een stille setup (zelfs met Boxed cooler stil voor een server). ESXi 5.5U3 installeerde vlekkeloos zonder drivers te moeten slipstreamen voor Intel Netwerk I219V). Toen ik dat zeker wist, heb ik de USB stick van mijn oude server omgezet + alle HDs/SSDs en hield alle configuratie van storage, netwerk (alleen adapter omzetten), VM startup en licentie.

Als ik mijn oude en mijn nieuwe systeem vergelijk, dan is de energiebesparing nooit genoeg voor verantwoording van de extra kosten. Maar ik vind het wel mooi meegenomen. Meer RAM gebruikt natuurlijk ook meer stroom, maar door nieuwe CPU en DDR4 ipv DDR3 is het verbruik toch lager. Ik ben nu blij met mijn keuze.

Note: ik had recentlijk een HP DL580G5 met 4x x7350 en 128GB gekocht voor 500 euro, maar die CPU bleek zo oud dat hij geen nested virtualisatieondersteunde. Daar had ik dus niets aan voor VIRL

Situatie

Ik heb 1 ESXi servertje dat altijd aanstaat, voor mijn firewall, terminal server, webserver en meer. Deze setup heeft 3.5 jaar probleemloos gedraaid, met 'idle' 16-20GB geheugen in gebruik en 15% CPU load.

Ik ben de laatste tijd echter meer bezig geweest met Cisco VIRL en daar liep ik snel tegen limieten aan. Voor mijn typische setups wilde VIRL graag 24-32GB geheugen hebben en die ruimte had ik niet. Als VIRL eenmaal gestart was, was de CPU load 30-40% met een typische netwerk setup. De CPU had nog wel wat headroom.

Oude setup.

Deze heeft 3.5 jaar vlekkeloos gedraaid zonder een crash oid:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3550 Boxed | € 269,- | € 269,- |

| 1 | Gigabyte GA-B75M-D3H | € 0,- | € 0,- |

| 1 | Kingston DataTraveler 16GB USB 2.0 Hi-Speed DataTraveler Micro (Black) 16GB | € 4,53 | € 4,53 |

| 1 | Corsair Vengeance CML32GX3M4A1600C10 | € 126,- | € 126,- |

| Bekijk collectie Importeer producten | Totaal | € 399,53 | |

Verbruik idle met ESXi 5.5 en 0.1V undervolted geheugen, ESXi geboot, geen VM gestart: 30-35 Watt

Opties

Ik had 2 opties:

1. Vervangen door een zuinige setup met minstens 64 GB geheugen

2. Extra server bouwen, met veel performance en die alleen aanzetten indien nodig

Optie 1 zou zijn: i5 6600 + 64GB => ± 600 euro

Optie 2 zou zijn: i7-5820K + MB met 8 sloten + 64 GB (4x16GB, kon ik bijprikken indien nodig) => ± 1000 euro

Nadeel van Optie 1 was dat ik weinig extra performance had (een i5-3550 is redelijk vergelijkbaar met een i5-6600 ondanks 3 generaties verschil), zodat ik het risico bleef houden dat opstarten VIRL mijn firewall hinderde. Met resource limitaties is dat wel te regelen.

Nadeel van Optie 2 was dat het duurder was.

Keuze

Uiteindelijk heb ik voor optie 1 gekozen. Iemand anders wilde voor een paar maanden een ESXi server lenen en met optie 1 had ik mijn oude server over/vrij. Dit is denk ik de goedkoopste optie om een zuinige server met 64 GB te hebben.

Mijn configuratie is:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5-6600 Boxed | € 224,95 | € 224,95 |

| 1 | Gigabyte GA-B150M-D3H | € 81,95 | € 81,95 |

| 1 | Antec Performance P50 | € 54,18 | € 54,18 |

| 1 | Crucial CT4K16G4DFD8213 | € 222,24 | € 222,24 |

| 1 | Antec VPF Series 450W | € 51,95 | € 51,95 |

| Bekijk collectie Importeer producten | Totaal | € 635,27 | |

Verbruik met ESXi 5.5U3 gestart zonder VMs: 20 Watt

CPU zat ik te twijfelen tussen i5-6600 en i7-6700(K). Het grootste verschil is HT en dat nut schijnt beperkt te zijn met ESXi (uit reacties in dit topic). Hogere base frequentie maakt niet veel uit als de Turbo gelijk is. Op meerdere review sites zag ik dat het verschil tussen de i5 en i7 heel minimaal is. Winst tov i5-3550 is volgens cpubenchmark minimaal (7623 tov 6822)