Even niets...

Alleen bij NFS toch?FireDrunk schreef op dinsdag 18 december 2012 @ 10:23:

Niet als het gaat om Random IO. Bovendien worden je disks onderbroken tijdens het schrijven, voor het schrijven van de ZIL.

Je disks seeken dus tussen data en ZIL.

Even niets...

Ik bedoel de toegevoegde waarde van de slog heb je alleen bij NFS omdat deze sync writes doet.FireDrunk schreef op dinsdag 18 december 2012 @ 10:35:

Bij alle IO? ZFS maakt altijd gebruik van zijn ZIL (ZFS Intent Log), en als je geen SLOG (Seperate Log) hebt staat deze gewoon op je disks.

Je disks seeken dus tussen data en ZIL.

Bij smb of afp zou een ssd minder performance winst opleveren.

Even niets...

Dit kan ik be-amen. Ik haal 96MBps doorvoer over samba en dat is voor mij snel genoeg, zeker omdat ik cat 5 kabel heb liggen. Ik heb er toen voor gekozen omdat ik meer dingen met mijn server wilde doen dan alleen fileserver spelen, en ik wel thuis was in linux en niet in BSD. Ik heb toen eerst de issue list van ZoL doorgelopen en kwam er achter dat er geen issues zijn mbt data loss of de zpools, en dat was voor mij het belangrijkste. Tot nu toe (maand of twee) ook geen probleem gehad, behalve de automount met een M1015 waar een timingprobleemje zat, wat ik opgelost heb met een scriptje (PM me even als je details wilt).Borromini schreef op dinsdag 18 december 2012 @ 09:41:

[...]

Zelfde dilemma hier. Ik gebruik de laatste RC van ZFS on Linux en mijn grootste vrees was prestaties - maar dat zit wel snor, ik haal 100 MBps bij een scrub of een resilver, en dat komt aardig in de buurt van het maximum van mijn 5400 RPM schijven denk ik. Qua stabiliteit heb ik ook geen klachten.

Heel tevreden.

Schijnt inderdaad elk moment een nieuwe release uit te komensyl765 schreef op dinsdag 18 december 2012 @ 09:33:

@Zorc

Gelukkig heb ik dat distro hoppen al heel lang achter mij gelaten

In de tijd van RedHat Suse enz konden we maar geen goede distro vinden die alles deed wat we wilden.

Na vele distro's te hebben geprobeerd zijn we op een gegeven moment bij FreeBSD gekomen, en we hebben toen besloten dit te gebruiken.

Tot nu toe hebben we er nog alles mee kunnen doen wat we gepland hadden.

Probeer gewoon FreeBSD 9.1 (komt elk moment uit als het goed is) met ZFS.

Leer het systeem, en je hoeft niet echt meer op zoek naar alternatieven.

gr

Johan

Wel grappig ik las gisteren op het FreeBSD forum dat er al ISO's van 9.1 te vinden zijn maar dat het nog geen officiele release is.

En nu zie ik dat er al een PCBSD zou zijn op basis van 9.1

http://www.pcbsd.org/

http://blog.pcbsd.org/2012/12/pc-bsd-9-1-now-available/

Ik denk dat ik in het weekend maar eens wat ga proberen

Dat scriptje mag best in het topicDurandal schreef op dinsdag 18 december 2012 @ 20:13:

[...]

Dit kan ik be-amen. Ik haal 96MBps doorvoer over samba en dat is voor mij snel genoeg, zeker omdat ik cat 5 kabel heb liggen. Ik heb er toen voor gekozen omdat ik meer dingen met mijn server wilde doen dan alleen fileserver spelen, en ik wel thuis was in linux en niet in BSD. Ik heb toen eerst de issue list van ZoL doorgelopen en kwam er achter dat er geen issues zijn mbt data loss of de zpools, en dat was voor mij het belangrijkste. Tot nu toe (maand of twee) ook geen probleem gehad, behalve de automount met een M1015 waar een timingprobleemje zat, wat ik opgelost heb met een scriptje (PM me even als je details wilt).

Heel tevreden.

Even niets...

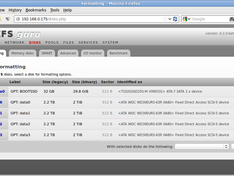

Verder stoort mijn collega zich enorm aan het feit dat een RAIDZ1 als RAID5 in de gui wordt weergegeven. "Hey, we draaien toch niet voor Jan L*l met ZFS, dan wil ik RAIDZ1 zien staan ook !" en hij heeft wel een punt vind ik

Verder valt me op dat ik zelf nog moet zorgen dat mijn 3TB disken met een sectorzise van 4k gezien worden (even los van ashift 9 / 12, dit gaat al niet goed voordat er pools aangemaakt worden). Moet ik nog even uitzoeken hoe dat moet denk ik.

en ik blijf van mening dat selecteren en prepareren van een disk om op te installeren deel hoort uit te maken van die installatieprocedure, je uit de installer schoppen en melden dat ik maar opnieuw moet proberen als ik dat zelf gedaan heb, is ... gemeen

Klinkt een beetje als een lijst met klachten, maar de lijst met dingen die wel goed gaan is veel en veel langer, maar ook veel minder interressant om te posten

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

NetBSD? ZFSguru is standaard op FreeBSD gebaseerd; heb je zelf handmatig geïnstalleerd of begrijp ik je verkeerd?u_nix_we_all schreef op woensdag 19 december 2012 @ 17:26:

Ik ben even met ZFS Guru aan het stoeien, en nu valt me op dat NetBSD bij booten de schijven als C: , D: , E: enz. ziet.

In elk geval, de boot sequence kijkt naar de BIOS (Basic Input/Output System) welke schijven de BIOS ziet, die worden C D E enzovoorts genoemd. Of dat ook betekent dat het bij Z: ophoudt weet ik niet; maar als dat zo is, zijn dit BIOS beperkingen. Je BIOS moet de 512-byte boot sector van data kunnen voorzien. Tijdens deze boot stage kan de boot code nog niet op eigen benen staan.

FreeBSD en eigenlijk alle moderne operating systems lijkt mij dat ze een oneindig aantal schijven kunnen hebben, of dicht daarbij. Maar als je een 200-disk RAID-Z3 array hebt en je wilt daar van booten, vraag ik me af of dat gaat werken. Het kan zijn dat BIOS beperkingen daar roet in strooien.Intern heb ik een ada0 , da0 , da1 etc. Nu is dit een 36bay chassis, en vraag me af wat er gebeurt als ik hem volstop met disks, maw, is er een limiet aan aantal disks voor NetBSD ? (En kan zfsguru dat ook aan?) Google kon het mij niet zo snel vertellen ....

Mja. Als je de meest recente beta8 draait, dan zie je als het goed is:Verder stoort mijn collega zich enorm aan het feit dat een RAIDZ1 als RAID5 in de gui wordt weergegeven. "Hey, we draaien toch niet voor Jan L*l met ZFS, dan wil ik RAIDZ1 zien staan ook !" en hij heeft wel een punt vind ik

'RAID-Z1 - single parity like RAID5'

Dat is wat ik zie op de Pools->Create pagina. Oudere versies hadden inderdaad andere benaming. Het punt hier is dat ZFSguru zowel mensen die totaal geen verstand van UNIX/Linux of ZFS hebben als meer gevorderde gebruikers wilt aanspreken. De nieuwe benaming zoals hierboven vermeld, vind ik het beste van beide werelden hebben. Wel correct en toch duidelijk; want veel mensen kennen RAID5. Maar al dat RAID-Z1 en RAID-Z2 dat vinden mensen verwarrend en dat kan afschrikkend werken. De bedoeling van ZFSguru is juist dat ZFS toegankelijk wordt voor een breder publiek.

Wat bedoel je hiermee? Moderne hardeschijven die Advanced Format zijn, blijven 512-byte sectorsize hebben voor de buitenwereld. Zo zijn ze ontworpen. Dus je ziet ook 512B sector size voor deze disks; dat is normaal. Het is bij het aanmaken van de pool dat je kiest voor 'optimize for 4K sector disks' ofzoiets.Verder valt me op dat ik zelf nog moet zorgen dat mijn 3TB disken met een sectorzise van 4k gezien worden (even los van ashift 9 / 12, dit gaat al niet goed voordat er pools aangemaakt worden). Moet ik nog even uitzoeken hoe dat moet denk ik.

De welcome wizard (die je mogelijk hebt overgeslagen?) biedt je de mogelijkheid om simpel de disks te selecteren en je pool te maken. De installatie staat hier los van. De installatie wordt ook gebruikt om te upgraden. Je kunt namelijk installeren op je draaiende systeem op dezelfde pool. Welk OS kan dat?en ik blijf van mening dat selecteren en prepareren van een disk om op te installeren deel hoort uit te maken van die installatieprocedure, je uit de installer schoppen en melden dat ik maar opnieuw moet proberen als ik dat zelf gedaan heb, is ... gemeenHelemaal als ik dan mijn rootpool geen root mag noemen

Ik vind dit soort feedback wel interessant hoor! Graag meer, via DM desnoods.Klinkt een beetje als een lijst met klachten, maar de lijst met dingen die wel goed gaan is veel en veel langer, maar ook veel minder interressant om te posten

Zoals je weet bouw ik mee aan ZFSguru en ik heb zelf het idee dat het beste nog moet komen. De partition map editor is iets waar ik redelijk trots op ben, en heb ik grotendeels zelf gemaakt. Maar het is dat ik structureel tijd tekort kom anders had ik ZFSguru al veel meer liefde kunnen geven.

Oeps, FreeBSD dus. Installatie is plain 0.2-beta8 /9.1-004 van de isoVerwijderd schreef op woensdag 19 december 2012 @ 19:15:

[...]

NetBSD? ZFSguru is standaard op FreeBSD gebaseerd; heb je zelf handmatig geïnstalleerd of begrijp ik je verkeerd?

Ah, duidelijk. Ik zie die driveletters ook alleen tijdens die bootstage.In elk geval, de boot sequence kijkt naar de BIOS (Basic Input/Output System) welke schijven de BIOS ziet, die worden C D E enzovoorts genoemd. Of dat ook betekent dat het bij Z: ophoudt weet ik niet; maar als dat zo is, zijn dit BIOS beperkingen. Je BIOS moet de 512-byte boot sector van data kunnen voorzien. Tijdens deze boot stage kan de boot code nog niet op eigen benen staan.

Voor zover ik weet hebben de huidige SuperMicro moederborden een beperking tot 12 disks om van te booten geloof ik. En hoe dan verder hangt van het OS af. Ik ken de bootloader van FreeBSD niet, maar blijkbaar verkeek ik me daarop, hij is erg verbose en ik vatte die lijst met disks daar op als meldingen van de FreeBSD kernel. Achteraf goed te verklaren.FreeBSD en eigenlijk alle moderne operating systems lijkt mij dat ze een oneindig aantal schijven kunnen hebben, of dicht daarbij. Maar als je een 200-disk RAID-Z3 array hebt en je wilt daar van booten, vraag ik me af of dat gaat werken. Het kan zijn dat BIOS beperkingen daar roet in strooien.

[...]

Volgens mij zag ik het op de pools/status pagina. (pools.php) Ik kan het nu even niet zien,ik draai nu de advanced disk benchmark op de 4 disken. Erg mooie feature btwMja. Als je de meest recente beta8 draait, dan zie je als het goed is:

'RAID-Z1 - single parity like RAID5'

Dat is wat ik zie op de Pools->Create pagina. Oudere versies hadden inderdaad andere benaming. Het punt hier is dat ZFSguru zowel mensen die totaal geen verstand van UNIX/Linux of ZFS hebben als meer gevorderde gebruikers wilt aanspreken. De nieuwe benaming zoals hierboven vermeld, vind ik het beste van beide werelden hebben. Wel correct en toch duidelijk; want veel mensen kennen RAID5. Maar al dat RAID-Z1 en RAID-Z2 dat vinden mensen verwarrend en dat kan afschrikkend werken. De bedoeling van ZFSguru is juist dat ZFS toegankelijk wordt voor een breder publiek.

[...]

Nou, ik heb dus nog niets gedaan met die 4 3TB schijven (die zijn native 4k toch, anders kom je noot boven de 2 TiB ?)Wat bedoel je hiermee? Moderne hardeschijven die Advanced Format zijn, blijven 512-byte sectorsize hebben voor de buitenwereld. Zo zijn ze ontworpen. Dus je ziet ook 512B sector size voor deze disks; dat is normaal. Het is bij het aanmaken van de pool dat je kiest voor 'optimize for 4K sector disks' ofzoiets.

In het disk overzicht staan ze als 2,2 TB / 2.0 TiB disks met 512B sectors aangeduidt.

(klikbaar)

Ik heb wel het volgende gedaan, misschien dat dat iets uitmaakt: Ik heb eerst op een ander systeem getest met 4 andere disks (500 GB 2,5" seagate) die hebben natuurlijk wel 512B sectoren.

Vervolgens de SSD waarop de installatie gedaan is in een ander systeem gezet, en daar zonder die disken geboot, toen was die pool weg (duh) en heb ik export gedraaid om hem uit het overzicht te halen. Toen had ik alleen de rootpool nog en kon ik de 3TB disken aankoppelen. Ik heb hem toen nog wel down gehad om die 4 disks aan te sluiten, toen geboot.

[...]

Ik heb dat geinterpreteerd als mogelijkheid tot importeren van bestaande pools voor gebruik met de live-cd denk ik. En toen geskipt. Vast iets niet goed gelezen dusDe welcome wizard (die je mogelijk hebt overgeslagen?) biedt je de mogelijkheid om simpel de disks te selecteren en je pool te maken. De installatie staat hier los van. De installatie wordt ook gebruikt om te upgraden. Je kunt namelijk installeren op je draaiende systeem op dezelfde pool. Welk OS kan dat?

En ik weet zo niet welk ander OS dat zo zou (willen) kunnen

[...]

Respect voor je inzet in ieder geval ! En al met al denk ik dat het een hele sterke distro is voor een NAS, de basis lijkt me prima ! Keep it upIk vind dit soort feedback wel interessant hoor! Graag meer, via DM desnoods.

Zoals je weet bouw ik mee aan ZFSguru en ik heb zelf het idee dat het beste nog moet komen. De partition map editor is iets waar ik redelijk trots op ben, en heb ik grotendeels zelf gemaakt. Maar het is dat ik structureel tijd tekort kom anders had ik ZFSguru al veel meer liefde kunnen geven.

Edit;

Ik heb nu de advanced disk benchmark met 4k override gestart.

Bij het overzicht van de disks zie ik nu wel 4k sectorsize staan. Alleen de capaciteit is nog niet goed (ook als ik doorklik naar de partition info onder formatting)

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

En weer geen verschil.

Ik heb toen in plaats van de SSD maar eens een normale SAS disk als ZIL geplaatst.

En wat schept mijn verbazing, opeens kunnen we wel hoger.

Blijkt dus dat die SSD niet helemaal lekker is.

En die hebben we eigenlijk continu gebruikt om te testen.. stom maar goed.

Nu met een intel 520 60GB disk haal ik met NFS ongeveer 50 to 60 MBps.

Dat is nog niet zo snel als NFS met sync op disabled, maar zeker goed genoeg.

Zijn er nog SSD disk die als erg goed te boek staan om als ZIL gebruikt te worden.

gr

Johan

Ik zou echt zeer graag ZFS draaien, puur omdat ik ook wil overstappen van mijn huidige 6disk raid5 array naar 4disk + ssd cache disks ik verwacht dat mijn performance (hopenlijk) dan near SSD speed word. in iedergeval een performance boost van mijn huidige disk setup dus ipv 50Mbs (raid5) naar 100 of 150 met zfs ..

Tja vanalles

De Intel 320 is toch wel de meest beproefde en theoretisch de beste SSD voor ZIL. Performt gemiddeld, maar heeft bescherming tegen stroomuitval, en juist dat maakt hem goed geschikt voor ZIL.syl765 schreef op woensdag 19 december 2012 @ 20:58:

Nou na de opmerking van firedunk toch maar weer eens NFS geprobeerd met vmware i.c.m een ZIL/SLOG

En weer geen verschil.

Ik heb toen in plaats van de SSD maar eens een normale SAS disk als ZIL geplaatst.

En wat schept mijn verbazing, opeens kunnen we wel hoger.

Blijkt dus dat die SSD niet helemaal lekker is.

En die hebben we eigenlijk continu gebruikt om te testen.. stom maar goed.

Nu met een intel 520 60GB disk haal ik met NFS ongeveer 50 to 60 MBps.

Dat is nog niet zo snel als NFS met sync op disabled, maar zeker goed genoeg.

Zijn er nog SSD disk die als erg goed te boek staan om als ZIL gebruikt te worden.

gr

Johan

Wil je echt ruwe performance, moet je naar een Samsung 840 Pro kijken, of een Vertex 4 (ja OCZ heeft een slechte naam, maar de Vertex 4 is de snelste SSD ter wereld... En ik hoor tot nog toe goede verhalen over de Vertex 4).

Ik denk dat ik er zelf ook eentje ga proberen.

Even niets...

Mijn array gaat bestaan uit 13 disks in RAID-Z3. Er zijn dus 10 disks voor het opslaan van data wat niet optimaal is. In de array zitten 4KB sector schijven en de performace met ashift=12 is zo'n 50% beter dan met ashift=9. Tot zo ver ok. Uiteraard ga ik wel slack space verliezen door grotere sectoren in te stellen en ik begrijp dat dat voor kleine files veel harder telt.

Waar ik alleen niet echt antwoord op kan vinden is het volgende: als het aantal disks niet optimaal is krijg je een 'deel-write' omdat je een 128KB record (max van ZFS) niet kan opdelen over (in mijn geval) 10 data-disks. Je zou kunnen zeggen dat dat per disk 12.8 KB is en dus 4+4+4+0.8 KB = 4 hele sectoren kost. Tot zo ver ook duidelijk. Maar WAT gebeurt er als je een heel grote fie schijft, zeg een van 1 GB. Zijn dat dat 8192 records van 128 KB waarbij ik dus bij ELK RECORD 3.2 KB van die laatste sector moet opofferen? Of is het filesysteem wel zo slim dat hij dit als een grote 'extent' ziet (immers; de file is 8191x NIET afgelopen na 128 KB) en wordt dus de slack space alweer gevuld met de volgende data en verlies ik alleen in het laatste blok een paar KB?

Als ik namelijk bij deze configuratie voor elke 128K eigenlijk 160KB schijf, dan verlies ik echt extreem veel ruimte en kan ik beter de 'performance penalty' voor lief nemen en op ashift=9 blijven...

[ Voor 3% gewijzigd door Contagion op 21-12-2012 03:27 ]

Je redeneert verkeerdWaar ik alleen niet echt antwoord op kan vinden is het volgende: als het aantal disks niet optimaal is krijg je een 'deel-write' omdat je een 128KB record (max van ZFS) niet kan opdelen over (in mijn geval) 10 data-disks. Je zou kunnen zeggen dat dat per disk 12.8 KB is en dus 4+4+4+0.8 KB = 4 hele sectoren kost.

Het 'verlies' waar hier veel over gepraat word, is het feit dat elke file bij ashift=12 minimaal 4KB groot word.

Als je dus een file van 10 bytes op je array zet, kost dat je 4KB.

Even niets...

Dank voor je bevestiging dat dit gewoon een problematische combinatie is, en dus niet zozeer aan mijn set-up ligt. Heel jammer dat ik daar achteraf pas achterkom, maar gelukkig zijn er nog wel wat alternatieven te overwegen.syl765 schreef op dinsdag 18 december 2012 @ 09:33:

ESXi in combinatie met FreeBSD, ZFS en NFS is een no go.

Performance is gewoon niet goed te krijgen.

6 MB is een beetje de max.

Wat ik voor ogen had was gewoon een transparante store op een NAS, waarbij ik o.a. bijvoorbeeld een aantal VM's centraal had kunnen opslaan, en deze zowel had kunnen openen op een ESXi doos (via NFS) als met Workstation (via SMB). En ook nog zaken als thin provisioned test dozen via NFS, en back-ups van de ESXi server naar de NAS via NFS. Gewoon lekker portable enzo. Wat mij betreft blijft dit een hele belangrijke eis, dus een overstap naar iSCSI wil ik tot nu toe gewoon nog niet overwegen.Wil je FreeBSD met ZFS gebruiken voor je ESXi hosts, dan zul je de machines toch op een ISCSI target moeten zetten.

Ik ben het helemaal met je eens dat ISCSI je behoorlijk kan beperken.

Ook ik vond het fijn om direct de data te kunnen manipuleren zonder gebruik te hoeven maken van de ESXi tools.

Nu ik weet dat FreeBSD eigenlijk een no-go area is (jammer), ga ik denk ik OpenIndiana als volgende stap proberen. Zowel ZFS als NFS stammen natuurlijk af van Sun, dus mogelijk dat beide implementaties daar iets beter zijn, hopelijk is CIFS ook een beetje goed ingeregeld op dat platform. Wel jammer is toch een kleinere community, en ook mijn eigen Solaris kennis reikt niet zo ver... Maar goed, van het weekend maar eens klussen.Ik weet eigenlijk niet of openindiana of nexenta ook last heeft van de combinatie NFS en ESXi.

Wij hebben er voor gekozen gewoon bij FreeBSD te blijven. Dit omdat we gewoon heel erg veel kunnen met FreeBSD en ISCSI ondanks de nadelen het verders prima doet.

Het is niet makkelijk, maar het KAN wel... Er zijn gewoon een aantal dingen waar je rekening mee moet houden.

Even niets...

Ik heb na de opmerking van Firedrunk toch nog even wat tests gedaan, en weer had ik de beroerde resultaten.

Maar wat bleek, ik heb al die tijd lopen testen met een defecte SSD.

Heb ik even terug ook aangegeven in dit topic.

Nadat ik normale disk had geconfigureerd als ZIL, haalde ik gelijk al een betere performance.

Nu heb ik een intel SSD gekoppeld te weten een 520 serie en ik haal nu 50 tot 60MBps

Er is dus zeker winst te halen.

50 tot 60 MB is voor ons voldoende.

Dus i am a happy camper.

gr

Johan

[ Voor 4% gewijzigd door syl765 op 21-12-2012 11:23 ]

ebia schreef op vrijdag 21 december 2012 @ 10:15:

snip...

Nu ik weet dat FreeBSD eigenlijk een no-go area is (jammer), ga ik denk ik OpenIndiana als volgende stap proberen. Zowel ZFS als NFS stammen natuurlijk af van Sun, dus mogelijk dat beide implementaties daar iets beter zijn, hopelijk is CIFS ook een beetje goed ingeregeld op dat platform. Wel jammer is toch een kleinere community, en ook mijn eigen Solaris kennis reikt niet zo ver... Maar goed, van het weekend maar eens klussen.

Ik heb zelf sinds vorige week (12 dec) OpenIndiana als VM op ESXi draaien. De ZFS pool bestaat uit 2 mirrored 1 TB Samsung disks (RDM attached to VM).FireDrunk schreef op vrijdag 21 december 2012 @ 10:45:

Uh, ik riep eerder al heel hard dat hij niet altijd gelijk heeft. En je gaat nu dus af op de mening van 1 ander persoon. Als je op internet goed rondkijkt, zijn er tal van mensen die ZFS icm ESXi gebruiken.

Het is niet makkelijk, maar het KAN wel... Er zijn gewoon een aantal dingen waar je rekening mee moet houden.

Tot op heden, 140 GB aan data en een rits bonnie++ runs later om data transport te simuleren/fouten 'af te dwingen' loopt de boel nog steeds zonder problemen. Ik heb er de laatste dagen iedere dag ca 25 GB aan data bij gekopieerd en draai dagelijks een scrub om te controleren, nog geen error gezien.

De problemen lijken vooral in de combinatie ESXi,FreeBSD en ZFS te liggen, maar dat kan ik persoonlijk niet bevestigen (gewoonweg niet getest).

OpenIndiana installeren is recht toe recht aan, napp-it na-installeren en je kunt vanuit de web interface van napp-it de boel beheren. Ondanks dat ik echt geen Solaris wizz ben, kan ik met mijn linux en beperkte FreeBSD kennis, aardig de weg vinden.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik zou voor Nas4free gaan en niet voor Freenas8. Nas4free is gebaseerd en door ontwikkeld op freenas7 en werkt goed en makkelijk met freebsd 9.1. Freenas is gebaseerd op Freebsd 8.3 en een compleet nieuw product wat niks met Freenas7 te maken heeft.Trunksmd schreef op vrijdag 21 december 2012 @ 11:58:

Waarschijnlijk ga ik met FreeNAS 8 starten hoewel ZFSGuru me ook wel aantrekt. Ik ben helaas nog een grote BSD noob itt linux/mac/windows.

Nas4Free heeft een goed forum en irc kanaal dus er is genoeg community support

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Even niets...

FreeNAS heeft van ItunesServer, DNLA server en transmission plugins gemaakt met elke een aparte jail. is dat bij NAS4FREE ook zo?victorb schreef op vrijdag 21 december 2012 @ 12:35:

[...]

Ik zou voor Nas4free gaan en niet voor Freenas8. Nas4free is gebaseerd en door ontwikkeld op freenas7 en werkt goed en makkelijk met freebsd 9.1. Freenas is gebaseerd op Freebsd 8.3 en een compleet nieuw product wat niks met Freenas7 te maken heeft.

Nas4Free heeft een goed forum en irc kanaal dus er is genoeg community support

Even niets...

Als ik op internet goed rondkijk zie ik dus ook genoeg mensen die klagen over NFS en ESXi performance. Punt is dat ik met mijn huidige systeem, en met het huidige OS wat ik heb geprobeerd niet verder kom. Ik zie geen mogelijke oplossing voor dit probleem.FireDrunk schreef op vrijdag 21 december 2012 @ 10:45:

Uh, ik riep eerder al heel hard dat hij niet altijd gelijk heeft. En je gaat nu dus af op de mening van 1 ander persoon. Als je op internet goed rondkijkt, zijn er tal van mensen die ZFS icm ESXi gebruiken.

Het is niet makkelijk, maar het KAN wel... Er zijn gewoon een aantal dingen waar je rekening mee moet houden.

Niet alleen NFS is een issue, maar ik had ook via CIFS vind ik de snelheid een beetje tegenvallen (50mb/sec, daar ik minimaal 80 wil hebben). En ook hier wijzen mensen naar de ietwat moeilijke implementatie van CIFS op het FreeBSD platform, en zie ik geen concrete oplossingen voor dat probleem.

Als jij de bronnen kent, alsjeblieft laat het me weten... Maar met een "het KAN wel" kan ik namelijk helemaal niks

Punt is een beetje dat ik geen ruimte heb voor extra disken. Ik wil graag een 6 disk, raid-z2 pool, die gewoon doet wat het moet doen. Nu is mijn kast vol, en de aansluitingen op mijn mobo. Ik kan natuurlijk wel investeren in extra controllers en een grotere kast, maar het zo bij elkaar al duur genoeg geweest. Ik kan natuurlijk ook een disk nu opofferen voor een ssd, maar dat gaat dan weer ten koste van de capaciteit.syl765 schreef op vrijdag 21 december 2012 @ 11:22:

Nadat ik normale disk had geconfigureerd als ZIL, haalde ik gelijk al een betere performance.

Voordat ik dergelijke rigioreuze acties onderneem wil ik eerst al het overige getest hebben.

Dank je wel voor je inzichten. Laat je trouwens OI ook booten van die pool, of heb je een aparte bootdisk(s)?Pantagruel schreef op vrijdag 21 december 2012 @ 11:26:

Ik heb zelf sinds vorige week (12 dec) OpenIndiana als VM op ESXi draaien. De ZFS pool bestaat uit 2 mirrored 1 TB Samsung disks (RDM attached to VM).

Ik heb het zelf net even getest:

Op mijn desktop heb ik een ESXi VM gemaakt met daarin een WIndows 7 VM op NFS die op mijn gewone NAS staat.

Daarin haal ik:

108MB/s sequentieel lezen, 62MB/s sequentieel schrijven (en dat is gelimiteerd omdat de ZIL SSD in mijn server niet sneller gaat dan 70MB/s)

36.000 Random Read IOPS (90% van max van SSD)

3.800 Random Write IOPS (95% van max van SSD)

Met andere woorden. ZFS zit op mijn SSD te wachten.

Even niets...

Die bak netjes aan een UPS hangen, monitoren met Nagios die automagisch een smsje uitpoept als er een schijf faalt.

En dan midden in de nacht "KRAK! BONK!" horen en 3 sec. later helemaal plat gesmst worden

even een copy past van de Nas4Free site. Waarvoor zou je plugins willen als het in Nas4Free gewoon aangezet kan worden zonder moeilijke pluginsTrunksmd schreef op vrijdag 21 december 2012 @ 13:12:

[...]

FreeNAS heeft van ItunesServer, DNLA server en transmission plugins gemaakt met elke een aparte jail. is dat bij NAS4FREE ook zo?

NAS4Free: Features

All NAS4Free versions:

Multiple arch: i386 or amd64

Full Web Management Interface (WebGUI)

Base system:

Base OS of NAS4Free 9.1.0.1 = FreeBSD 9.1

Base OS of NAS4Free 9.0.0.1 = FreeBSD 9.0

Hard drive and volume management:

ZFS v28

Software RAID 0,1,5 and mix (1+0,1+1, etc…)

Disk encryption (using cryptographic accelerator card if present)

Filesystems: ZFS v28, UFS, Ext2/3, FAT, NTFS

Partition: MBR and GPT

iSCSI initiator

Network Protocols supported:

SMB/CIFS (Samba)

AFP (Netatalk)

NFS

FTP (ProFTPD

TFTP (tftp-hpa)

RSYNC (client/server)

Unison

SCP (SSH)

iSCSI target

Extra services:

UPnP server (FUPPES)

iTunes/DAAP server (Firefly)

Webserver (Lighttpd)

Network Bandwidth measure (IPERF)

BitTorrent client (Transmission)

Networking:

802.1q vlan tagging

Wireless

link aggregation

Wake On Lan

Bridge

CARP (Common Address Redundancy Protocol)

HAST (Highly Available Storage)

Monitoring:

S.M.A.R.T (smartmontools)

E-mail alert

SNMP

Syslog

UPS (NUT

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Even niets...

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Ik weet dat jullie veel met ZFSGuru bezig zijn (logisch als de ontwikkelaar moderator van dit forum is). Maar in de startpost krijg ik de indruk dat ZFSGuru nog meer in ontwikkeling is en FREENAS meer Mature is. Dit is natuurlijk niet het zelfde als stabiliteit. Maar is ZFSGuru stabiel genoeg tov FREENAS?

De code is een zooitje

Als de ZFSguru servers offline zijn, kan je geen services meer installeren.

Er is geen documentatie.

[ Voor 15% gewijzigd door FireDrunk op 21-12-2012 15:17 ]

Even niets...

Bij mij draait ZFSguru nu 42 dagen en werkt prima, enige "problemen" waar ik tegen aan ben gelopen zijn:

- automatische scrub zelf moet toevoegen aan cronjob,

- automatische snapshots (gebruik hiervoor sinds gister zfSnap) ook zelf moet toevoegen aan cronjob.

- NUT installeren en UPS instellen koste nog wel wat moeite (oftewel moest me erg inlezen hierin)

- na restart moet ik mijn usb poort waar mijn UPS opzit met chmod even van de goede rechten voorzien (moet ik nog automatiseren)

- na restart moet ik SABNZBD restarten om couchpotato etc weer draaiend te krijgen

[ Voor 6% gewijzigd door krijn1985 op 21-12-2012 15:21 ]

Dit is een punt wat veel mensen zich afvragen. Moet een NAS operating system zoals ZFSguru en vele anderen alleen NAS dingen doen, of mag er ook extra software op draaien zoals virtualizatie, P2P clients, netwerkspeelgoed zoals een wireless access point en NAT gateway en ga zo maar verder.De vraag is uberhaupt of je zoiets als een bittorrent client op een fileserver moet zetten.

Mijn antwoord is dat dat jouw eigen keuze moet zijn. Wil je puur een NAS, dan kun je dat krijgen. Wil je meer dingen 'offloaden' naar je NAS zodat het een multi-functionele server wordt, kan dat ook. Het idee is dat één stuk software de wensen van velen kan vervullen door een modulaire opzet te hebben. Gebruiker X hoeft dan niet de meuk te draaien die gebruiker Y graag wilt, zodat gebruikt X alles netjes en kaal houdt. Gebruiker Y wilt echter wel virtualbox en transmission en XBMC en ga zo maar verder. Ik vind het verkeerd om gebruikers dat te verbieden, of anderzins te frustreren. Het is juist heel mooi als ieder een OS naar zijn eigen wensen kan tunen, zeker als dat zo gemakkelijk gaat als een paar muisklikken.

Jails zijn zeker mooi, maar correct uitgevoerd betekent dit ook dat de services geen toegang hebben tot je data. Dat is vaak niet erg praktisch omdat de services ook toegang nodig hebben tot de gebruikersdata die op de ZFS pools is opgeslagen. Niet altijd, maar wel vaak. Als je dit alsnog doet buiten de jail om, dan heb je ook de grootste bescherming van jails uitgeschakeld, namelijk dat een programma in een jail geen dingen buiten de jail kan veranderen. Zonder die bescherming, stelt een jail niet veel voor.

Dat klopt denk ik als een bus. Zelf zie ik FreeNAS (NAS4Free) als ouderwets op sommige vlakken. Een disk configuratie die ergens in een array wordt bijgehouden, dat is gewoon vies. Het werkt niet zoals het hoort te werken. Het is snel in elkaar geflanst op dat soort fundamentele gebieden. ZFSguru heeft op disk gebied en andere architectuur wel goede beslissingen gemaakt die een grote toekomst mogelijk maakt.Maar in de startpost krijg ik de indruk dat ZFSGuru nog meer in ontwikkeling is en FREENAS meer Mature is.

Je kunt het misschien vergelijken met Phoenix/Firebird/Firefox wat ik al voor de 0.1 release gebruikte. Toen was het project nog maar net begonnen maar toch was er al veel aandacht voor en een algemene gedachte dat dit de next-gen browser zal gaan worden, ook al liep het qua features flink achter op de bestaande suites die wel werkten maar allerlei tekortkomingen hadden en bloated waren en moeilijk te onderhouden.

Wat je soms wilt is dat er een verse rewrite wordt gemaakt die fundamentele problemen oplost en zo een betere toekomst heeft, dan maar door blijven gaan met een log en bloated project wat als een veelkoppig monster allerlei haken en ogen heeft.

Kortom, een jong project met een grote potentie trekt mij meer aan dan een gevestigd project waar alles zijn gang gaat maar de fundamentele tekortkomingen zullen blijven. Het is niet makkelijk voor FreeNAS om zomaar op een Root-on-ZFS architectuur over te gaan, of om zomaar wat nieuwe services te presenteren die met een muisklik geïnstalleerd kunnen worden. Dat komt allemaal neer op architectuur; de fundering moet goed zijn.

Veel van de kritiek op ZFSguru is dat het nog niet af is. Dat klopt. De dingen die wel af zijn, zitten echter best wel goed in elkaar. Door de manier van ontwikkelen gaat het wel langzamer, maar ik ben zelf meer enthousiast dan ooit over de toekomst.

Kijk over een paar weken nog maar eens naar ZFSguru, dan zou Jason zijn grote plan gelanceerd moeten hebben. En de nieuwe beta9 release waar Samba sharing gewoon goed wordt geregeld. Geen half werk. Dat is een heel andere mentaliteit dan die ik bij andere projecten zie.

Sommige mensen had ik dit al via DM gemeld, maar publiek kan inmiddels ook wel denk ik. De algemene koers die ZFSguru vaart is als volgt:

0.2 beta9 - samba

De Samba release focust op goede Samba ondersteuning. Met makkelijke drag en drop permissie afhandeling wat iedereen kan begrijpen. Moeilijke dingen worden zo kinderspel. Een keer goed ontwikkelen kost veel moeite, maar dan heb je ook iets wat goed werkt.

0.2 RC1 - migration manager

Wat FireDrunk terecht opmerkt is dat ZFSguru zijn configuratie niet kan meenemen als je een nieuwe installatie doet. Dat moet anders; alle configuratie moet apart van het OS opgeslagen worden en als een soort 'restore point' moet je terug kunnen naar een bepaalde configuratie. Dat kan met de migration manager. Simpelweg een bestandje met daarin alle instellingen. Doe op een ander systeem een verse installatie, upload dat bestandje via de browser en het draait als je oude server met alle instellingen en tuning als toen. Dat is ook makkelijk aan te vinken bij het upgraden naar een nieuwe systeemversie. Deze feature is al maanden in ontwikkeling, maar Jason was ontevreden en heeft het naar voren geschoven. Na de Samba-release is dit de enige feature die nog mist voor een 0.2 release.

0.2 final release

Bug fixes en kleine dingen, geen nieuwe features versus de RC release.

0.3 - Embedded

Deze release focust zich op het werkend maken van de Embedded distributie. Deze distributievorm was werkend voordat ZFSguru opnieuw werd geschreven tijdens 0.1.7 release. Destijds is deze distributie niet-functioneel. Anders dan het simpelweg werkend maken, zou dit goed moeten werken zodat je ook services en andere configuratie moet kunnen gebruiken terwijl alles op de USB stick staat. De losse installatiebestanden en de configuratie los van elkaar.

Zodra dit goed werkt, is embedded wel heel stoer. Je kunt namelijk nooit iets verkloten. Als je aan het OS zit of je configuratie en het werkt niet meer, dan reboot je. Dan werkt het weer zoals vanuits. Indien de configuratie de oorzaak is, ga je terug in de tijd naar een tijd dat de configuratie nog wel deed wat je wilde. Makkelijker kan haast niet.

0.4 - Networking

Nog vrijwel afwezig in ZFSguru en duidelijk een punt waar FreeNAS en NAS4Free in voorlopen; networking. Dus statisch IP instellen, DHCP server draaien, Firewall, Wireless client configuratie, Wireless access point, Link aggregation en Iperf networking benchmarking. Tot die tijd mist ZFSguru dit alles en moet je het handmatig op de command line werken krijgen. Jason kiest dus voor een 'alles of niets' mentaliteit; of dingen goed implementeren of gewoon niet zodat je op de command line aangewezen bent als je dit werkend wilt hebben.

0.5 - Encrypted storage

Encryptie is een stoer iets onder FreeBSD. ZFS in proprietaire Oracle-releases heeft wel encryptie-support. Maar dat is simpele encryptie die softwarematig is en ook nog single-threaded. Bij voorbaat dus al inferieur aan wat nu al in FreeBSD zit: AES-encryptie volledig hardware accelerated met recente Intel CPUs (AESNI) en RNG-support in Ivy Bridge processors. Indien er geen hardware acceleration is, dan nog is FreeBSD encryptie volledig threaded en kan alle cores gebruiken die aanwezig zijn. Nu nog een manier om dit makkelijk te laten werken via de web-interface.

0.6 - Task manager

Cron scripjes, maar ook email notification, synchronisatie tussen verschillende ZFSguru/ZFS servers, etc.

0.7 - online documentatie

In plaats van aparte documentatie te hebben, waarom niet documentatie die is geïntegreerd in ZFSguru zelf? Elke optie zou een help pagina moeten hebben waarin alle informatie te vinden is die maar relevant is. Ook zouden gebruikers hier feedback of aanvullingen op moeten kunnen geven, zodat alles wat je nodig hebt, de ZFSguru interface is. Aparte documentatie is oldschool.

0.8 - vertalingen in andere talen

En een manier om deze vertalingen makkelijk bij te houden, zoals via een service waarin je snel wijzigingen kunt submitten.

Bovenstaand lijstje is van een brainstormsessie tussen Jason en mijzelf. Ik zie het zo wel zitten. Het mag best wat sneller qua ontwikkeling, maar de moeilijke dingen kosten ook veel tijd. Zodra meer mensen kunnen ontwikkelen aan ZFSguru zoals eigen services maken, kan het best hard gaan. Tot die tijd loopt ZFSguru duidelijk achter qua features, maar toch zie je dat ZFSguru ook veel mensen trekt terwijl andere projecten veel meer ontwikkelaars hebben, al veel langer bestaan maar toch inherente zwakheden hebben waardoor ze in verval geraakt zijn.

Kortom, ik zie de toekomst van ZFSguru wel heel positief. ZFSguru wijkt gewoon heel erg af van de gevestigde orde. Vooral het feit dat je makkelijk kunt switchen tussen ZFSguru en andere projecten zie ik ook als positief. Dan hoef je niet bang te zijn dat je in een vendor lock-in terecht komt. Kortom, blijf experimenteren en draai het OS wat op dit moment het beste bij jou past. Over een aantal maanden kan dat net zo goed weer anders zijn. Af en toe experimenteren met wat het beste bij je past lijkt me dan ook een goed advies.

Het is voor mensen echt een kriem om zich in te lezen in de code, en het werken gaat omslachtig.

Vertalingen zijn normaal gesproken via een framework zo gedaan, maar in ZFSguru lijkt dat niet echt makkelijk.

Maar aan de andere kant, hoe goor de code ook is, als het werkt, werkt het...

Even niets...

Ik kan me wel voorstellen dat wanneer je gewend bent met commerciële projecten te werken die alles op een nette en officiële manier doen, waar veel tijd in gaat zitten, je daar het gemakkelijkst mee kan werken. Maar voor andere mensen, zoals ik, kan dat heel anders liggen. Een project als phpMyAdmin vond ik al moeilijk genoeg om aan te passen naar mijn wensen. Je moet je daar inderdaad erg in verdiepen. Bij ZFSguru zie ik het juist als groot voordeel dat je direct aan de slag kan. Je weet dat de code voor pagina X staat in pages/categorie/paginaX en je weet waar de CSS staat en de PHP code en de opmaak voor die pagina. Wat dat betreft heb ik dus volledig andere ervaringen dan jijzelf. Dat kan natuurlijk; het één sluit beter aan op al reeds bestaande kennis en vaardigheden dan het andere. Maar toch verbaas ik me over je stelligheid. Mijn ervaringen zijn namelijk precies andersom.

Dat de website van ZFSguru aan een update toe is klopt, en daar wordt ook aan gewerkt kan ik al zeggen. Maar de link met community support kan ik niet echt volgen. Ik zie juist dat via de ZFSguru interface support krijgen de volgende stap is. In plaats van een standaard forum wat de gebruikelijke conventionele manier van ondersteuning is. Out of the box denken kan heel creatieve ideeën opleveren die sterk afwijken van de gevestigde orde. Ik zie dat juist als voordeel.

en wanneer andere mensen services kunnen maken?

Voor het maken van community services zou een speciale service geschreven worden waar je zelf services mee kan aanpassen en kan maken. Je begint dan met een template op basis van de functionaliteit die je wilt en je kunt dat zelf via de web-interface werkend maken. Vervolgens stuur je die op om in de officiële lijst terecht te komen.

Ik gok zelf dat dat nog minimaal een half jaar duurt. Maar het is niet gekoppeld aan een bepaalde ZFSguru versie. De systeemversies en services staan in ZFSguru los van de web-interface. Zo heb je ook de voordelen dat straks alle services ook op de Embedded distributie werkt. Dat zie ik FreeNAS nog niet zo snel doen dat Virtualbox en al die rits op de embedded dist werkt, zonder dat er hardcoded in te flanzen.

Jullie plannen zijn zeker hoopvol. Ik hoop dan ook van harte dat jullie vooruitkomen. Want als ik het goed begrepen heb, zijn jullie met 2 man aan dit project bezig. Daarbij zat het project in een flinke impasse, voordat je erbij komt (ergens op een forum gelezen). Ik hoop dan ook dat jullie nu doorzetten/ kunnen doorzetten.

Even niets...

Zo werd de disk/pool configuratie bij FreeNAS eerst opgeslagen in een bestand, terwijl er dus niet werd gekeken naar de daadwerkelijke configuratie zoals hij actief was op het onderliggende besturingssysteem. Dat kan allerlei ongewenste problemen opleveren en een dergelijke route zal je ZFSguru niet zien nemen. ZFSguru neemt de moeilijke weg van alles zelf doen:

- eigen framework om pagina's te tonen

- eigen distributies en systeemversies met bijbehorende build architectuur

- eigen services die extra functionaliteit toevoegen

Zoals je zegt, met twee man tegen andere projecten die een commerciëel bedrijf achter zich hebben, al vele jaren langer bestaan en ook een grotere userbase hebben, vind ik dat ZFSguru ver is gekomen. Het is inmiddels al lang geen 'web-interface' meer zoals napp-it bijvoorbeeld nog wel is. ZFSguru is nu een Operating System met drie gebieden: systeemversie (aangepaste FreeBSD installatie), services (voorgecompileerde en geconfigureerde software zoals VirtualBox) en de web-interface zelf. Al die drie onderdelen zijn onafhankelijk van elkaar. De hele architectuur biedt talloze mogelijkheden. Zo wordt het straks heel makkelijk op VirtualBox werkend te krijgen terwijl je een veilige embedded distributie draait op USB stick. Met andere architecturen zal dat toch wat lastiger worden om alles out of the box te laten werken.

Grootste nadeel is dat ZFSguru door die 'koppigheid' flink achterloopt zoals op netwerkgebied. Maar de features die er zijn, zijn over het algemeen wel goed ontwikkeld. Zo is de disk formatting met partition map editor iets waar ik trots op ben, en de advanced disk benchmark is ook 'from scratch' geschreven en een vrij unieke feature in ZFSguru. Daar komt in beta9 de nieuwe Samba rewrite bij die met drag en drop toch enigszins moeilijke concepten inzichtelijk maakt voor de normale sterveling.

Het ontwikkelen van die unieke features kost veel tijd, maar is enorm leuk en uitdagend. En eenmaal gemaakt, staat het als een huis. De partition map editor is precies wat ik wilde; een soort partition magic manier van partitioneren geheel visueel en inzichtelijk. Verbeteringen zijn altijd mogelijk, maar het concept vind ik goed gelukt en mis ik bij andere projecten die veel minder goed omgaan met disk management.

@FireDrunk: prima hoor! En ik snap je punt denk ik wel. Maar daarom dat ik denk... jij hebt als echte programmeur duidelijk een bepaalde achtergrond en manier van doen. Het kan natuurlijk zijn dat dit botst met de concepten die in ZFSguru zitten, die op sommige gebieden haaks staan op hoe jij gewend bent dat bepaalde zaken werken. Maar dat betekent nog niet dat die nieuwe concepten fout of minder goed zijn. Zo zijn we ook allemaal Windows gewend terwijl Linux en UNIX op zowel desktop- als servergebied hun eigen sterke punten hebben en soms Windows ver voorbij streven. Daarnaast moet je ook bedenken dat Jason en ik het samen doen, terwijl de overige projecten door een heel team ontwikkeld worden en ook al véél en véél langer actief zijn. Dan vind ik het een uitzonderlijke prestatie waar ZFSguru nu gekomen is.

[ Voor 13% gewijzigd door Verwijderd op 21-12-2012 18:00 ]

En dat is niet zonder reden...Verwijderd schreef op vrijdag 21 december 2012 @ 17:57:

Het punt is gewoon dat vooral Jason maar eigenlijk ook ikzelf best wel afwijkende mensen zijn met afwijkende ideeën en opvattingen. Dat heeft nadelen, zoals het niet volgen van conventies waar grote waarde aan wordt gehecht in commerciële projecten,

Als je dat als tegenargument geeft, heb je duidelijk nog nooit met fatsoenlijke frameworks gewerkt, en heb je je laten voorlichten door mensen met een vooroordeelmaar ik zie zeker ook de voordelen. Andere projecten zijn allemaal gebouwd rond een bestaand framework. Doordat het niet op maat gemaakt is, krijg je dan allerlei neveneffecten.

Het is een beetje de eeuwenoude discussie dat C++ per definitie beter is dan C# omdat het sneller is.

Dat is inderdaad wel heel goorZo werd de disk/pool configuratie bij FreeNAS eerst opgeslagen in een bestand, terwijl er dus niet werd gekeken naar de daadwerkelijke configuratie zoals hij actief was op het onderliggende besturingssysteem.

En dus eigen security / functionele bugs te introduceren.Dat kan allerlei ongewenste problemen opleveren en een dergelijke route zal je ZFSguru niet zien nemen. ZFSguru neemt de moeilijke weg van alles zelf doen:

- eigen framework om pagina's te tonen

Dat vind ik een positief punt, mits de migratiemanager goed zou werken.- eigen distributies en systeemversies met bijbehorende build architectuur

Als er een goede plugin architectuur (of een API) komt, ben ik voor.- eigen services die extra functionaliteit toevoegen

Dat kan niet, echte onafhankelijkheid zou betekenen dat je ze zonder elkaar kan gebruiken, maar dat kan helemaal niet.Zoals je zegt, met twee man tegen andere projecten die een commerciëel bedrijf achter zich hebben, al vele jaren langer bestaan en ook een grotere userbase hebben, vind ik dat ZFSguru ver is gekomen. Het is inmiddels al lang geen 'web-interface' meer zoals napp-it bijvoorbeeld nog wel is. ZFSguru is nu een Operating System met drie gebieden: systeemversie (aangepaste FreeBSD installatie), services (voorgecompileerde en geconfigureerde software zoals VirtualBox) en de web-interface zelf. Al die drie onderdelen zijn onafhankelijk van elkaar.

Je bedoelt, je verplaatst de default Virtual Machine map van VirtualBox naar je Pool... Meer hoef je toch niet te doenDe hele architectuur biedt talloze mogelijkheden. Zo wordt het straks heel makkelijk op VirtualBox werkend te krijgen terwijl je een veilige embedded distributie draait op USB stick. Met andere architecturen zal dat toch wat lastiger worden om alles out of the box te laten werken.

Ik ben heel erg beniewd naar hoe jullie dat verzonnen hebben, want ik lees er nergens iets over. En dat is nou juist een van mijn grootste ergernissen aan ZFSguru. De uitgangspunten zijn die van Jason, en die van jou, niet die van de community. Ik zou graag de mogelijkheid zien om mijn eigen visie op mijn eigen server te kunnen implementeren, maar nu moet ik dus maar hopen, dat wat jullie gaan bouwen, aansluit bij mijn netwerkGrootste nadeel is dat ZFSguru door die 'koppigheid' flink achterloopt zoals op netwerkgebied. Maar de features die er zijn, zijn over het algemeen wel goed ontwikkeld. Zo is de disk formatting met partition map editor iets waar ik trots op ben, en de advanced disk benchmark is ook 'from scratch' geschreven en een vrij unieke feature in ZFSguru. Daar komt in beta9 de nieuwe Samba rewrite bij die met drag en drop toch enigszins moeilijke concepten inzichtelijk maakt voor de normale sterveling.

Nee, dat klopt, maar ik kan je denk ik wel 10 redenen geven, waarom het ontwikkelen op een werkend framework beter is dan om het zelf te bouwen... Dus 'nieuw' of niet, het is nog steeds niet inherent veilig, en inherent begrijpelijk. Maar dat kan ik je beter via DM uitleggen ofzoHet ontwikkelen van die unieke features kost veel tijd, maar is enorm leuk en uitdagend. En eenmaal gemaakt, staat het als een huis. De partition map editor is precies wat ik wilde; een soort partition magic manier van partitioneren geheel visueel en inzichtelijk. Verbeteringen zijn altijd mogelijk, maar het concept vind ik goed gelukt en mis ik bij andere projecten die veel minder goed omgaan met disk management.

@FireDrunk: prima hoor! En ik snap je punt denk ik wel. Maar daarom dat ik denk... jij hebt als echte programmeur duidelijk een bepaalde achtergrond en manier van doen. Het kan natuurlijk zijn dat dit botst met de concepten die in ZFSguru zitten, die op sommige gebieden haaks staan op hoe jij gewend bent dat bepaalde zaken werken. Maar dat betekent nog niet dat die nieuwe concepten fout of minder goed zijn.

Je moet het een beetje zien, als je een huis bouwt op houten palen in Nederland... Is dat concept per definitie slecht omdat het misschien nieuw is? Nee, het is gewoon dom, want hout rot weg in de drassige grond van Nederland. Hetzelfde met ZFSguru, is het per definitie slecht? nee hoor, het werkt. Maar als je uren moet zoeken voordat je een bug gevonden hebt, omdat je geen geautomatiseerde test methodieken hebt (of interfaces, whatever...) dan is dat concept wel fout ja.

Tuurlijk! Voor een project van 1-1/2 man (want Jason geeft je nog steeds geen vrij spelZo zijn we ook allemaal Windows gewend terwijl Linux en UNIX op zowel desktop- als servergebied hun eigen sterke punten hebben en soms Windows ver voorbij streven. Daarnaast moet je ook bedenken dat Jason en ik het samen doen, terwijl de overige projecten door een heel team ontwikkeld worden en ook al véél en véél langer actief zijn. Dan vind ik het een uitzonderlijke prestatie waar ZFSguru nu gekomen is.

Even niets...

Helemaal mee eens!Kriss1981 schreef op vrijdag 21 december 2012 @ 19:11:

Bedankt voor deze heldere uitleg en keep up the good work

Ik houd dit topic sinds korte tijd bij en ik moet zeggen dat veel topics een voorbeeld kunnen nemen aan hoe hier gediscussieerd wordt.

Ook al zijn FireDrunk en CiPHER het niets eens, de discussie blijft inhoudelijk en opbouwend

Speed limits are like herpes.

Niet zozeer principiëel, maar meer praktisch. Veel ontwikkelaars kijken altijd naar een kant en klare library en worden zo heel dependency-afhankelijk. Dat kan allerlei neveneffecten hebben. Je bent heerlijk onafhankelijk zodra je alles in eigen hand houdt en gewoon op een pure taal vertrouwt - welke dat ook is - maar zonder allerlei dependencies/frameworks/libraries. Je hebt dan alles in eigen beheer, en je kunt precies maken datgeen je wilt. Het kost je wel meer tijd en de vraag is altijd of dat te rechtvaardigen is. Maar ik denk dat het best mogelijk is dat je door deze ogenschijnlijke redundantie wel degelijk een hogere kwaliteit eindproduct kunt verkrijgen.FireDrunk schreef op vrijdag 21 december 2012 @ 19:15:

Als je dat als tegenargument geeft, heb je duidelijk nog nooit met fatsoenlijke frameworks gewerkt, en heb je je laten voorlichten door mensen met een vooroordeel

Het is een beetje de eeuwenoude discussie dat C++ per definitie beter is dan C# omdat het sneller is.

Beetje een vage verwijzing, maar misschien ken je nog Steve Gibson (van grc.com / shields up) die allerlei utilities maakte voor Windows maar in assembly in plaats van high level programming languages. Die programma's werkten perfect zoals ze gemaakt zijn en ze bleven ook werken. Veel andere Windows software heeft allerlei dependencyproblemen en die ononverzichtelijke wereld is er één waar ik van gruwel. Zo gaan next-gen operating systems er niet uitzien; tig .dll files in een windows subdir? no way! Dat is toch vrágen om problemen?!

Interessant, want wat je zegt is juist deels in strijd met wat wij meestal horen. Namelijk, dat het juist de unieke opzet, overzichtelijke pagina's en intuïtieve features zijn die ZFSguru onderscheiden van de rest. Kortom, de uitgangspunten en opvattingen van Jason sloegen kennelijk aan bij dit publiek. Dat is natuurlijk wel wat dit project heeft onderscheiden van een hobby-projectje waar het ooit mee begon.Ik ben heel erg beniewd naar hoe jullie dat verzonnen hebben, want ik lees er nergens iets over. En dat is nou juist een van mijn grootste ergernissen aan ZFSguru. De uitgangspunten zijn die van Jason, en die van jou, niet die van de community. Ik zou graag de mogelijkheid zien om mijn eigen visie op mijn eigen server te kunnen implementeren, maar nu moet ik dus maar hopen, dat wat jullie gaan bouwen, aansluit bij mijn netwerk

De kracht van de ZFSguru interface zit hem natuurlijk ook in de bediening van zowel gevorderde als veel minder gevorderde gebruikers. Eén interface waar zowel kenners als totale noobs zijn weg in kunnen vinden. Dus zowel eenvoud, overzicht en duidelijkheid, alswel geavanceerde features. Dit is een uitdaging voor zowel Jason als mijzelf en vind ik een goed uitgangspunt om dit soort software voor te ontwikkelen.

Daarnaast heeft ZFSguru zijn structuur al bewezen in die zin dat sommigen al heel lang een oudere versie (0.1.7) van ZFSguru draaien en pas bij een OS drive crash of andere aanleiding iets te wijzigen een keer updaten cq. nieuw installeren.

Dat gaat ook wel gebeuren hoor. Maar het idee is om eerst die 0.2 de deur uit te krijgen, waar al zo lang aan is gewerkt. Er staan voor 2013 enorm veel veranderingen op het lijstje. Niet de minste zijn dat veranderingen om de community meer invloed te geven. Een eigen wiki, maar de plannen gaan veel verder. Als dat lukt, zal ZFSguru een sterk community-driven project worden waarbij je via de web-interface zelf met elkaar in contact komt.Tuurlijk! Voor een project van 1-1/2 man (want Jason geeft je nog steeds geen vrij spel) is het natuurlijk helemaal niet slecht! Maar ik denk dat er ook niet meer programmeurs of hobbyisten bij gaan komen als er niet structurele verbeteringen doorgevoerd gaan worden qua Usebility, en Extendebility.

Wat ZFSguru niet zal worden is een gefragmenteerd en sterk wisselend clubje mensen wat aan de kern van ZFSguru werkt. Dit zal voorbehouden blijven aan 'president' Jason die controle wilt houden over hoe ZFSguru eruit ziet in de kern; namelijk de web-interface en systeemarchitectuur. Maar in de toekomst kun je ook gewoon patches submitten voor de web-interface, eigen services maken, eigen visuele themes maken, eigen vertalingen maken, online documentatiewijzigingen submitten en eigen master servers beheren die je al dan niet regelmatig/live synct met de officiële master servers. Maar dat gaat niet vandaag gebeuren, en ook niet morgen. Dat is de prijs van een koppig maar coherent gedreven team.

Ik heb het nog niet voor hem uitgezocht (maar had dat wel aangeboden), maar ik wilde eens kijken hoe SID -> user mapping in BSD te maken was.

Hebben jullie daar over nagedacht bij het design van de Samba permissies?

Even niets...

Ik weet natuurlijk niet wat voor een hardware jij hebt, maar een dedicated SSD voor een ZIL heb ik in ieder geval niet. En eigenlijk wil ik die ook niet, want dat zou een flinke aanpassing van het systeem betekenen.FireDrunk schreef op vrijdag 21 december 2012 @ 14:03:

CIFS is inderdaad een bekend euvel, maar dat heeft weinig met BSD te maken, maar meer met Samba... Samba is gewoon geport naar BSD. De performance is dus vergelijkbaar op Linux platforms.

Ik heb het zelf net even getest:

Op mijn desktop heb ik een ESXi VM gemaakt met daarin een WIndows 7 VM op NFS die op mijn gewone NAS staat.

Daarin haal ik:

108MB/s sequentieel lezen, 62MB/s sequentieel schrijven (en dat is gelimiteerd omdat de ZIL SSD in mijn server niet sneller gaat dan 70MB/s)

36.000 Random Read IOPS (90% van max van SSD)

3.800 Random Write IOPS (95% van max van SSD)

Met andere woorden. ZFS zit op mijn SSD te wachten.

Ik ben vooralsnog weinig onder de indruk van de prestaties die ik behaal met dit Brazos systeem, en ik denk dat het meer aan de software ligt dan aan de gebruikte hardware. Hoe kan anders de RAID set wel honderden MB/sec over de bus heen pompen, maar gewoon op 90% utilization van de gigabit lijn er naartoe een probleem zijn? (Of het nu gaat om CIFS of NFS) Alleen iSCSI lijkt een beetje in de buurt te komen, maar daar heb ik juist geen behoefte aan.

Zelfs als ik een veel 'zwaarder' OS erop zet zoals Windows Server, dan haal ik die snelheden nog... Nu beweer ik niet dat FreeBSD brak is, of ZFS, of NFS, of CIFS, maar blijkbaar gaat er iets niet goed in een combinatie van die alles waardoor er onevenredig hoge load ontstaat zodat normale performance niet meer mogelijk is.

Voor mij in ieder geval reden om iets anders te proberen. Dat is verder geen flame of iets, maar imho gewoon een logische vervolgstap om nu te doen.

je zou kunnen proberen device polling op de nic aan te zetten.ebia schreef op vrijdag 21 december 2012 @ 22:46:

[...]

Ik weet natuurlijk niet wat voor een hardware jij hebt, maar een dedicated SSD voor een ZIL heb ik in ieder geval niet. En eigenlijk wil ik die ook niet, want dat zou een flinke aanpassing van het systeem betekenen.

Ik ben vooralsnog weinig onder de indruk van de prestaties die ik behaal met dit Brazos systeem, en ik denk dat het meer aan de software ligt dan aan de gebruikte hardware. Hoe kan anders de RAID set wel honderden MB/sec over de bus heen pompen, maar gewoon op 90% utilization van de gigabit lijn er naartoe een probleem zijn? (Of het nu gaat om CIFS of NFS) Alleen iSCSI lijkt een beetje in de buurt te komen, maar daar heb ik juist geen behoefte aan.

Zelfs als ik een veel 'zwaarder' OS erop zet zoals Windows Server, dan haal ik die snelheden nog... Nu beweer ik niet dat FreeBSD brak is, of ZFS, of NFS, of CIFS, maar blijkbaar gaat er iets niet goed in een combinatie van die alles waardoor er onevenredig hoge load ontstaat zodat normale performance niet meer mogelijk is.

Voor mij in ieder geval reden om iets anders te proberen. Dat is verder geen flame of iets, maar imho gewoon een logische vervolgstap om nu te doen.

Verder wat spelen met de zfs tunables.

compressie uit proberen.

Ben nu OpenIndiana met Napp-it aan het testen. Het interface is een stuk minder intuïtief dan bijv ZFSguru, maar je ziet wel veel meer de techniek achter het systeem, wel wat leerzamer dus.analog_ schreef op vrijdag 21 december 2012 @ 23:49:

Heb je iets met de illumOS kernel al geprobeerd? Nexenta(Stor), OpenIndiana dat soort distros?

Na de eerste paar testjes lijkt deze set-up een stuk beter te presteren. Op CIFS seq. lezen circa 95MB/sec, schrijven met zo'n 70MB/sec. NFS is ook een stuk beter: lezen 75MB/sec, schrijven 50MB/s.

Heb nu weliswaar nu één disk minder in m'n pool zitten (root-on-zfs is niet mogelijk, beperking van de grub bootloader naar wat ik begrepen heb), maar dit is wel nog altijd met RAID-Z2. Ik zal nu eens nadenken wat handig is: één disk vervangen door SSD (als bootdisk), of misschien een extra simpel s-ata controller kaartje erin en daar een schijf aanhangen...

Ook OpenIndiana, of Nexenta(stor)?analog_ schreef op zaterdag 22 december 2012 @ 04:10:

Ik heb het momenteel op een Corsair Flash Voyager GT CMFVYGT3-16GB 16GB Zwart draaien. Bij het afsluiten zie ik wat vaagheidjes voorbij komen over fsck maar werkt verder prima (op USB2).

Vind het wel beetje tricky, het OS lijkt me in beide gevallen er in ieder geval niet op aangepast 'rustig aan' te doen met de writes op de usb stick. Is natuurlijk overkomelijk op het moment dat je zo'n usb stick (en de config) makkelijk kunt vervangen op het moment dat die stuk zou gaan (en dat zonder dat je ZFS pool stuk gaat).

Maar het is dus niet ten nadele van de performance?

Nice find! 95MB/s is bijna het dubbele van de read performance onder FreeBSD. Significant genoeg voor me om ook even OI te gaan testen.ebia schreef op zaterdag 22 december 2012 @ 01:34:

[...]

Ben nu OpenIndiana met Napp-it aan het testen. Het interface is een stuk minder intuïtief dan bijv ZFSguru, maar je ziet wel veel meer de techniek achter het systeem, wel wat leerzamer dus.

Na de eerste paar testjes lijkt deze set-up een stuk beter te presteren. Op CIFS seq. lezen circa 95MB/sec, schrijven met zo'n 70MB/sec. NFS is ook een stuk beter: lezen 75MB/sec, schrijven 50MB/s.

Gebruik je de text installer voor usb devices? oi-dev-151a5-text-x86.usbebia schreef op zaterdag 22 december 2012 @ 12:13:

[...]

Ook OpenIndiana, of Nexenta(stor)?

Vind het wel beetje tricky, het OS lijkt me in beide gevallen er in ieder geval niet op aangepast 'rustig aan' te doen met de writes op de usb stick. Is natuurlijk overkomelijk op het moment dat je zo'n usb stick (en de config) makkelijk kunt vervangen op het moment dat die stuk zou gaan (en dat zonder dat je ZFS pool stuk gaat).

Maar het is dus niet ten nadele van de performance?

Ik wil namelijk ook het OS vanaf een usb stick gaan draaien en heb geen zin om na een aantal weken door de write cycles te zitten.

[ Voor 11% gewijzigd door sloth op 22-12-2012 12:59 ]

Ik denk zelfs dat ik per ongeluk een OI client install heb draaien maar dat doet er verder weinig toe.

[ Voor 15% gewijzigd door analog_ op 22-12-2012 13:15 ]

Je hebt met OpenIndiana zeker wel root-on-zfs, maar grub kan alleen van een enkele schijf booten, ik denk niet dat raid0 kan, laat staan raidz(2/3). Je kunt wel je hele rootdev mirrorren en grub op beide schijven zetten, dat werkt wel prima met root op een raid-1 set. Een setje van 2 kleine laptopdisks is wellicht een optie als je zuinig wilt zijn en toch je OS redundant wilt draaien.ebia schreef op zaterdag 22 december 2012 @ 01:34:

[...]

Ben nu OpenIndiana met Napp-it aan het testen. Het interface is een stuk minder intuïtief dan bijv ZFSguru, maar je ziet wel veel meer de techniek achter het systeem, wel wat leerzamer dus.

Na de eerste paar testjes lijkt deze set-up een stuk beter te presteren. Op CIFS seq. lezen circa 95MB/sec, schrijven met zo'n 70MB/sec. NFS is ook een stuk beter: lezen 75MB/sec, schrijven 50MB/s.

Heb nu weliswaar nu één disk minder in m'n pool zitten (root-on-zfs is niet mogelijk, beperking van de grub bootloader naar wat ik begrepen heb), maar dit is wel nog altijd met RAID-Z2. Ik zal nu eens nadenken wat handig is: één disk vervangen door SSD (als bootdisk), of misschien een extra simpel s-ata controller kaartje erin en daar een schijf aanhangen...

Hoe heb je je netwerk geconfigureerd onder OI ? Via de netwerkmanager GUI (en NWAM service) ? Of ook met napp-it ? Zelf ben ik er nogal mee aan het prutsen gewesst, maar ik doe het nu gewoon met de hand op de cli, en dan met de NWAM service disabled. (info)

Edit:

Volgens mij is het grote verschil tussen ZFS op FreeBSD en Illumos gebaseerde systemen dat bij de laatste je alleen hele devices als vdev kunt gebruiken en dus niet kunt opdelen in partities voor verschillende pools.

Dat heeft nadelen voor flexibiliteit, maar ik vraag me nu af of het verschil in performance niet (naast de cifs/nfs implementatie) er ook mee te maken heeft ? Heb je ook een vergelijking van de zpool performance, los van de netwerkdoorvoer ?

[ Voor 12% gewijzigd door u_nix_we_all op 22-12-2012 14:20 ]

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Ik vind het net heerlijk dat je zomaar een /backup filesystem kan aanmaken met copies=3 voor belangrijke bestanden, terwijl je op dezelfde vdev ook een read only filesystem voor media bestanden hebt.

Je kan inderdaad onder OI niet met slices/partitions/whatever ze heten werken, enkel hele disks, dat is jammer maar voor een enterprise oplossing geen issue normaal. Dat block pointer rewrite voor zvol expansion probleem is bijvoorbeeld enkel relevant voor thuisgebruikers aangezien het een atypische operatie is in bedrijfsomgevingen.

Ik weet trouwens niet of dit (partities/slices) een technische beperking is. Ik heb namelijk het vermoeden van niet, of een opgelegde theoretische omdat disk flushes dan de mist indraaien. Lees: niet gerespecteerd worden, met kans op data loss.

[ Voor 65% gewijzigd door analog_ op 22-12-2012 14:44 ]

Verwar een zpool niet met een zfs ! Je kunt binnen een pool wel meerdere filesystems met eigen properties aanmaken.sloth schreef op zaterdag 22 december 2012 @ 14:30:

Goed dat ik je edit lees voor ik met OI was gaan experimenteren, want als dit zo is vallen alle Illumos gebaseerde systemen voor me af.

Ik vind het net heerlijk dat je zomaar een /backup filesystem kan aanmaken met copies=3 voor belangrijke bestanden, terwijl je op dezelfde vdev ook een read only filesystem voor media bestanden hebt.

Een read-only zfs naast een normaal zfs is geen probleem. Ik weet niet of copies=3 op zfs of zpool-level werkt, maar ik denk dat dat ook op zfs nivo werkt, dus dan is dat geen probleem.

Edit: Ja, copies=3 kun je per zfs instellen, net als snapshots etc. Dat kan dus allemaal gewoon binnen 1 zpool.

[ Voor 7% gewijzigd door u_nix_we_all op 22-12-2012 14:40 ]

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Ja dat bedoelde ik. Helaas is dat voor mij geen optie, want ik heb 6 sata poorten en 6 disks. En een kast waar niet meer in past. Voel er weinig voor dat allemaal te moeten uitbreiden om het OS persé redundant te krijgen. Als het op een USB stick ook prima werkt dan vind ik dat wel best.u_nix_we_all schreef op zaterdag 22 december 2012 @ 14:08:

[...]

Je hebt met OpenIndiana zeker wel root-on-zfs, maar grub kan alleen van een enkele schijf booten, ik denk niet dat raid0 kan, laat staan raidz(2/3). Je kunt wel je hele rootdev mirrorren en grub op beide schijven zetten, dat werkt wel prima met root op een raid-1 set. Een setje van 2 kleine laptopdisks is wellicht een optie als je zuinig wilt zijn en toch je OS redundant wilt draaien.

Luilak modus: DHCP. Verder niks aan gedaan.Hoe heb je je netwerk geconfigureerd onder OI ? Via de netwerkmanager GUI (en NWAM service) ? Of ook met napp-it ? Zelf ben ik er nogal mee aan het prutsen gewesst, maar ik doe het nu gewoon met de hand op de cli, en dan met de NWAM service disabled. (info)

Nee sorry Zpool performance meting niet gedaan op OI. Ik had wel een Bonnie bench gestart, maar die liep na 18 uur nog. Ik heb dat onderbroken, omdat ik toch ook eens NexentaStor wilde proberen. Zo gezegd, zo gedaan. De webinterface daarvan ziet er wel weer wat gelikter uit dan napp-it, het grote probleem is dat de performance (dit keer alleen getest op CIFS) toch weer wat tegenviel: Read/write 60/50.Dat heeft nadelen voor flexibiliteit, maar ik vraag me nu af of het verschil in performance niet (naast de cifs/nfs implementatie) er ook mee te maken heeft ? Heb je ook een vergelijking van de zpool performance, los van de netwerkdoorvoer ?

Wat dat betreft kan ik geen touw vastknopen aan de performance issues, en of deze met een specifieke kernel te maken zouden hebben. Hoe dan ook, OI lijkt tot nu toe de beste performance te leveren, dus dat wordt denk ik de definitieve keuze.

Het is ook geen must natuurlijkebia schreef op zaterdag 22 december 2012 @ 15:29:

[...]

Ja dat bedoelde ik. Helaas is dat voor mij geen optie, want ik heb 6 sata poorten en 6 disks. En een kast waar niet meer in past. Voel er weinig voor dat allemaal te moeten uitbreiden om het OS persé redundant te krijgen. Als het op een USB stick ook prima werkt dan vind ik dat wel best.

Ik heb zelf een HP N40L, en gebruik nog steeds de orginele 250 GB sata als enkele rootdisk. Ik wil ook nog wel eens omschakelen naar een USB-stick, maar nog geen tijd voor gehad, dus geen ervaring met slijtage e.d., ook wel benieuwd naar.

Ik ben nog steeds tevreden met OI, ook al heb ik maar 4GB ram, performance (ik gebruik alleen NFS) is voor voldoendoe om met 70MB/s mijn laptop-ssdtje (oud, te vol en ongetrimd) te verzadigen. Set van 2 disks in mirror doet sequentieel 190 MB/s lezen en 90MB/s schrijven.[...]

Wat dat betreft kan ik geen touw vastknopen aan de performance issues, en of deze met een specifieke kernel te maken zouden hebben. Hoe dan ook, OI lijkt tot nu toe de beste performance te leveren, dus dat wordt denk ik de definitieve keuze.

Met serviio erop voor media (die is wel traag met indexeren, cpu bottleneck), transmission en virtualbox (werkt prima, maar zou natuurlijk meer ram moeten hebben) voldoet het prima voor mij !

Let wel even op als je nog met andere OS-sen wilt proberen, dan zou ik met je versie datapool niet hoger dan v28 gaan, die v5000 van openindiana is niet meer overal te importeren.

Ik weet niet of FreeBSD met v5000 kan omgaan ?

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Wat ik vreemd vind is dat je een pool onder Solaris platform maakt, deze automatisch v5000 wordt. In ZFSguru kun je zelf de versie opgeven. Dat lijkt mij veel beter. Ik dacht altijd dat de extra ZFS features enabled konden worden en dan automatisch de pool naar v5000 geupgrade zou worden. Dan blijf je dus maximaal compatible totdat je de extra features nodig hebt. Waarom is voor die gedachte niet gekozen in de praktijk?

Je kunt bij aanmaken van een pool nog wel de versie opgeven, Ik weet niet wat default is, maar heb er bij het recent opnieuw aanmaken van die 3TB set niet zo op gelet, en dat is v28 geworden .....Verwijderd schreef op zaterdag 22 december 2012 @ 16:51:

FreeBSD 9.2 is gewoon ZFS v28, maar FreeBSD 10 (de development branch) heeft al een tijdje v5000 en onlangs nog een grotere featureset gekregen. De vraag is of je dat wilt gebruiken, omdat v28 voorlopig veel beter cross-platform compatible is. Als je de features niet nodig hebt, zou ik de pool ook niet zo creëren.

Wat ik vreemd vind is dat je een pool onder Solaris platform maakt, deze automatisch v5000 wordt. In ZFSguru kun je zelf de versie opgeven. Dat lijkt mij veel beter. Ik dacht altijd dat de extra ZFS features enabled konden worden en dan automatisch de pool naar v5000 geupgrade zou worden. Dan blijf je dus maximaal compatible totdat je de extra features nodig hebt. Waarom is voor die gedachte niet gekozen in de praktijk?

Edit: rootpool is wel v5000, misschien is dat alleen voor de installer de default ?

[ Voor 3% gewijzigd door u_nix_we_all op 22-12-2012 17:11 ]

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Ik probeer nu NFS aan de praat te krijgen. Ik heb vanuit de webiface een filesystem (mijn ZFS pool) geshared onder de naam "data".

/etc/exports is echter leeg. Wel heb ik een /etc/zfs/exports gevonden. (hoe zit dit?)

showmount -e geeft een lege output. Vanuit Windows lukt het me maar niet om de NFS share te mouten. SMB werkt prima trouwens.

Gewoon een heel grote verzameling snoertjes

Inderdaad een beetje verwarrend omdat hetzelfde veld bij Samba de share-naam betekent.

Gewoon een heel grote verzameling snoertjes

Ik moet dus op één of andere manier een extra disk hangen aan mijn systeem om te gebruiken als bootdisk. Extern van USB zal ongetwijfeld te traag zijn getuige mijn usb-stick avontuur, en USB 3.0 wordt volgens diverse bronnen nog niet ondersteund door de illumos kernel (extra USB 3.0 PCI-e kaartje heeft dus geen zin).

Zoeken dus voor een extra SATA HBA. Ik vond deze site met een vrij aardig overzicht van diverse HBA's (voornamelijk zonder RAID, voor gebruik met ZFS), met daarbij een overzicht van de ondersteuning per platform (Linux, Solaris, BSD): http://blog.zorinaq.com/?e=10

Na wat zoekwerk voor een kaartje met JMicron JM36x kom ik op een kaartje van Delock (goedkoop te verkrijgen via Amazon.de). Als alternatief een kaartje van Digitus, daar zitten ook wat extra's bij als stroomverloopkabeltjes en s-ata kabeltjes. Nog even nadenken wat ik zal gaan doen.

Je clients? NFS zit in vrijwel elke unix/linux ingebakken, dus is makkelijk om een NFS server te hebben als het gaat om serveren van data. Heb je voornamelijk Windows clients, dan gebruik je Samba voor de makkelijkste route. Gebruik je allebei, dan zet je dus allebei aanedmanh schreef op zondag 23 december 2012 @ 23:22:

Wat geeft de voorkeur NFS of Samba share?

Andersom kan ook, dus op je Windows systeem een NFS client installeren, en met je unix systeem Samba client gebruiken... maar waarom dingen meer gecompliceerd maken dan ze al zijn?

[ Voor 5% gewijzigd door ebia op 23-12-2012 23:27 ]

Ik lees dat een dedicated ZIL sneller, maar gevaarlijker is.

Vraag is dan ook is dit veel sneller, en hoe gevaarlijk is een dedicated ZIL op een SSD schijf als ik er een mirror van maak op een 2e SSD

Gewoon een heel grote verzameling snoertjes

Meten is weten. Wat ik tot nu toe heb gezien van NFS op het specifieke platform wat ik gebruik, kun je toch wel stellen dat CIFS gewoon sneller is.Compizfox schreef op maandag 24 december 2012 @ 00:02:

NFS heeft over het algemeen minder overhead dan SMB/CIFS en is dus bij grotere transfers meestal wat sneller.

Kies je voor een native OS; dus in geval van CIFS Windows Server met Windows clients, en in geval van NFS unix server met unix clients, dan denk ik dat je met een moderne computer altijd die gigabit lijn kan voltrekken tegenwoordig.

Buiten de performance zitten beiden ook anders in elkaar, wat komt met voor- en nadelen voor elk protocol. Denk aan de 'simpele' (maar soms iet wat beperkte) rechten onder Unix vs de uitgebreide structuur binnen Windows. Denk aan case sensitive binnen unix, hetgeen je ook moet afhandelen op je centrale storage, hetgeen weer kan leiden tot ongemakken binnen Windows als beide platforms van dezelfde data gebruik maken. Denk aan het gebruik van een AD of juist van een NIS (en of je één van die 2 al hebt) voor gecentraliseerd management. Etc, etc.

Ik ben van plan om (mocht deze vakantie het toelaten qua tijd) Samba onder ZFSguru eens 'echt' met mijn Windows netwerk te integreren, door middel van groepen en SID mappings.

Maar dat kost wat tijd...

[ Voor 57% gewijzigd door FireDrunk op 24-12-2012 10:40 ]

Even niets...

Ja ACL's ken ik wel degelijk. Maar het (goed) opzetten daarvan is toch iets minder triviaal dan dat onder Windows het geval is. Sowieso heb je 'normale' Unix ACL's (Posix spul), maar ik geloof dat dat onder de nieuwste NFS helemaal anders werkt.FireDrunk schreef op maandag 24 december 2012 @ 10:39:

'Simpele' rechten onder UNIX? Je hebt duidelijk nog nooit van ACL's gehoord...

Zou ik me niet zo snel aan begeven als je nog in het stadium bent van "welke moet ik gebruiken NFS of CIFS?".

Same here, ik wacht nog even de "end of the year release" af. Met die nieuwe Samba config mogelijkheden.FireDrunk schreef op maandag 24 december 2012 @ 10:39:

'Simpele' rechten onder UNIX? Je hebt duidelijk nog nooit van ACL's gehoord...

Ik ben van plan om (mocht deze vakantie het toelaten qua tijd) Samba onder ZFSguru eens 'echt' met mijn Windows netwerk te integreren, door middel van groepen en SID mappings.

Maar dat kost wat tijd...

Nu heb ik (voorlopig nog maar

- De seagates ondersteunen APM, maar als ik de NAS even power cycle (af/aan dus) dan zijn de waarden terug op de standaard 128 ingesteld. als ik gewoon een reboot doe en de stroom er niet af gaat, dan blijft hij ze onthouden. Nu kan ik die manueel iedere keer juist zetten, maar ik zou liever een scriptje schrijven dat dit bij het opstarten doet. Dit is de eerste keer dat ik freeBSD gebruik, maar het scriptje maken lukt me wel. Wat ik gemerkt heb isdat er onder FreeBSD meerdere programma's/mogelijkheden zijn om dit te doen, en ik vroeg me af welke zfsguru gebruikt, dan kan ik gewoon dezelfde behouden.

- Ten tweede zie ik dat er in Freebsd een aantal waarden voor APM mogelijk zijn, namelijk 1/32/64/96 en 127 waarbij er spindown optreed (wat ik wil) en dan 128 en 254 waarbij er enkel spindown is. Ik heb dus wat geprobeerd, en bij 32 gaan mijn disken na 1 minuutje al in spindown, dat was me iets te kort, dus heb ik 64 eens geprobeerd, maar nu 340 minuten laten staan ze nog steeds te draaien. Nu heb ik al wat gezocht, maar nergens kan ik vinden hoe die waarden in elkaar zitten of waar ze voor staan. Iemand die hier wat uitleg over heeft?

Overigens heb ik ook een scriptje aangepast zodat je makkelijk kan zien of je disken spinned down zijn of niet, is daar intresse in?

Als je schijven niet spindown gaan, kan het zijn dat je schijven om de zoveel tijd toch wat I/O te verwerken krijgen, de timer begint dan opnieuw. Je kunt dus kijken wat de APM settings betekenen als je je pool exporteert zodat de disks helemaal niet gebruikt worden. Dan mag je ook de web-interface niet gebruiken zoals de Disks pagina enzovoorts. Dan zou je kunnen zien wat APM 64 betekent qua spindown in minuten.

Zodra je een redelijke APM-waarde hebt gevonden voor je disks, kun je dit in een scripje zetten die elke boot wordt uitgevoerd (zoals in /usr/local/etc/rc.d/). Of je disks spun down zijn kun je ook via de web-interface zien als het goed is.

Wat is nu het handigste om als devicename te gebruiken voor ZFS?

Ik heb gemerkt dat de sda veranderd per controller (logisch) en dat ZFS on Linux dit niet fijn vind. Ik heb daarom mijn USB pool veranderd naar /dev/disk/by-uuid/UUID-hier, maar dit vereist een partitie (wat niet optimaal is dacht ik gelezen te hebben). Ook kan ik kiezen voor /dev/disk/by-id/ waar verschillende identifiers voor dezelfde disk staan, voor sda heb ik bijvoorbeeld ata-HGST_HTS541010A9E680_JB100013J2RP1A en wwn-0x5000cca6a0dd6ce2.

De laatste (wwn-0x5000cca6a0dd6ce2) lijkt mij het handigste, maar ik ben niet helemaal zeker of dit echt uniek is voor deze specifieke hardeschijf... Iemand die hier duidelijkheid over kan verschaffen?

EDIT: Wat verder zoeken op naar wat die wwn nu precies is levert op dat dit een wereldwijde ID moet zijn welke ook op de schijf zelf moet staan. Relatief makkelijke keuze dus

P.S: Als dit in een apart topic moet dan hoor ik het graag, het is natuurlijk niet helemaal iets dat op ZFS gericht is

[ Voor 5% gewijzigd door Xudonax op 24-12-2012 17:25 . Reden: Kapotte URL tag ]

Verder heb ik ook je advies een gevolg en wat specifieker op mijn disk gezocht, maar in de manual lees ik dat deze geen APM zou ondersteunen

En nog eventjes dit, op de disks -> advanced pagina kan je inderdaad zien of een disk spun down is, maar je weet niet hoe lang het duurt vooraleer dat gebeurt. (tenzij je er stopwatch bij neemt en f5 spamt

Als je dat hebt gedaan, boot dan eens terug in je Linux omgeving. En kijk of die gekozen naam onder /dev/disk/... te zien valt. Hier ben ik zelf namelijk ook erg benieuwd naar, dus als je de moeite wilt nemen zou dat erg welkom zijn. Op deze manier zijn je disks ook gelijk cross-platform geschikt.

Als het de eerste keer niet werkt, zou je nog kunnen proberen de partitie type te veranderen van freebsd-zfs (standaard) naar linux type. Maar mogelijk dat dit niet nodig is. Voor Solaris platform moet je de partitietype veranderen naar 'solaris'. Dit kan allemaal via de ZFSguru livecd op de Disks pagina.

@enthernal: jammer als je disks niet (correct) APM ondersteunen. Als je schijven 'ada' heten en niet 'da' kun je kijken naar 'atacontrol spindown ada2 120' bijvoorbeeld. 'camcontrol standby' kun je ook proberen.