Ik ben bij de stap beland om een ZFS-vm op te gaan zetten in ESXi 5.5, maar ik weet niet zo goed hoe ik mijn storage het beste kan aanbieden. Ik heb mijn LSI op mijn X10SL7 al naar IT-mode geflashed en mijn netwerk ziet er op dit moment als volgt uit:

Wat adviseren jullie? iSCSI, NFS? Ik mis eigenlijk een goed artikel op het net die mij verder helpt. Ben nu twee uurtjes aan het rondneuzen, maar weet niet zo goed waar ik moet beginnen. Zoals je kunt zien in mijn config heb ik 2 netwerkkaarten. vSwitch0 betreft mijn LAN, die mijn TP-Link in gaat. vSwitch1 betreft mijn WAN (verbonden met modem van UPC die in bridge modus draait). Ik vond deze artikelen nog wel het meest interessant:

NAS4Free MPIO with VMWare ESXi 5.1 &

Configuring iSCSI on ESXi 5.1 (standard vswitch) &

Installing FreeNAS for NAS/SAN Storage

Misschien wel het belangrijkste waar ik de storage voor nodig heb: Ik wil meerdere shares maken op het filesystem zodat ik hier mijn media op kan slaan die ik moet kunnen benaderen vanaf mijn HTPC (Windows 8 met XBMC). Verder wil ik graag mijn snapshots van mijn VM's kunnen

opslaan en een backup solution om mijn vm's te kunnen backuppen.

En hoe te denken over VMXNET3? NAS4Free ondersteunt VMXNET3, maar die ondersteunt naar mijn weten niet het installeren van plugins zoals FreeNAS dat weer doet. Vanaf FreeNAS 9.2 schijnt de VMXNET3 "

hack" ook niet meer te werken, maar of VMXNET3 nu echt daadwerkelijk nodig is weet ik ook niet.

Aangezien mijn beiden nics ook op dit moment al in use zijn, heb ik dus geen dedicated nic over om als iSCSI target in te zetten om het maximale te halen qua performance op ZFS-gebied. Dus, wat is wijsheid?

edit:

ga nu eerst spelen met cifs/windows shares. Zojuist 6x3TB RAIDZ2 aangemaakt in FreeNAS 9.2.1, waarmee ik 10,7TB ruimte over hou.

edit2:

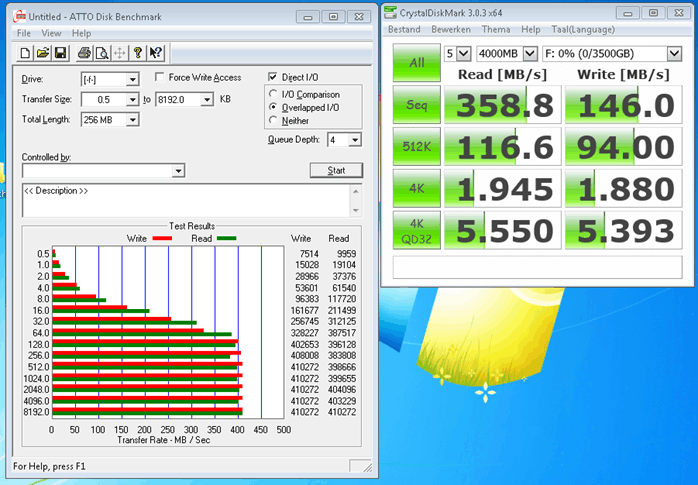

eerste "benchmark"

[root@freenas ~]# dd if=/dev/zero of=/dev/null bs=1M count=128000

128000+0 records in

128000+0 records out

134217728000 bytes transferred in 4.060099 secs (33057748531 bytes/sec)

Volgens mij moet dat veel beter kunnen. Laatste FreeNAS in ESXi 5.5, 16GB ram toegewezen, Intel Xeon CPU.

[

Voor 58% gewijzigd door

FREAKJAM op 14-02-2014 00:41

]

:fill(white):strip_exif()/i/2003943496.jpeg?f=thumbmini)

:strip_exif()/i/1321263566.png?f=thumbmini)

:strip_icc():strip_exif()/u/371379/zNcU5.jpg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/217664/crop57a47149436c0_cropped.png?f=community)

:strip_icc():strip_exif()/u/10414/crop5817c0657774d_cropped.jpeg?f=community)

/u/11437/wandcontactdoos.png?f=community)

:strip_icc():strip_exif()/u/88058/strandballengifts1032_200.jpg?f=community)

:strip_exif()/u/264081/crop56d6d27c03d80_cropped.gif?f=community)

/u/87795/voetje.png?f=community)

:strip_exif()/u/17028/ico_sphere.gif?f=community)

/u/116403/crop64cfe7aeafeb6_cropped.png?f=community)