8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

> Zonder reclame te maken: misschien heeft Ri-Vier nog wat.

Die verkopen ook 6-naar-1 SATA power stekkers. Ik heb er een stapeltje besteld, maar ik merk dat de 5e en 6e schijf op de kabel soms problemen geeft.

Ik vermoed dat het komt doordat de kabels m.i. eigenlijk te dun zijn en daarbij wordt elke volgende harddisk doorgelust van de vorige. Een Y-design zou beter zijn. Starten van de schijven werkt prima, maar tijdens het draaien vallen ze soms even weg en is de start-stop-count+1 en ook iets van de head-retract-count van de SMART waarden. Misschien is het ook wel een slecht contact hoor, ik heb zo nog niet zo lang, maar ik vermoed anders omdat het de laatste drives van een kabel zijn.

Onder t motto, 'probleem vraagt om een grotere hamerVerwijderd schreef op zondag 24 maart 2013 @ 19:56:

[...]

Haha, wil je zeggen dat dat niet kan dan; een Intel CPU in een FM2 socket? Past altijd met de nodige kracht.

Voor een HTPC is AMD wellicht idd een betere keuze, maar zoals je terecht zegt, als de bak headless in de kast staat heb je geen fluit aan 3d acceleratie.Maar die CPU zou natuurlijk passen bij een H67/H77/B75 bordje. Het AMD Mini-ITX FM2 bordje is vooral interessant vanwege de 7/8 onboard SATA/600 wat voor Mini-ITX uitzonderlijk veel is. Ik ben zelf ook wel geïnteresseerd in dit bordje; maar dan niet als ZFS NAS. Wellicht kan ik dan ook testen hoe zuinig deze setup is. ASRock is meestal minder zuinig, maar heeft wel opties voor underclocking en undervolting. Het grootste nadeel voor FM2 voor een ZFS NAS is dat de chips van AMD op dit gebied weinig CPUkracht bieden. De GPU is wat deze chips bijzonder maakt en daar heb je vrijwel niets aan op een ZFS NAS.

Klopt, sommige keuzes liggen niet altijd even voor de hand . Mijn keuze voor een Asrock B75 Pro3-M was toch vooral gebaseerd op een redelijk aantal SATA aansluitingen voor een absolute bodemprijs, de BIOS tweaks om t verbruik te verminderen was een mooie bonus. Met de huidige kennis, hail to the MuxMaar we moeten roeien met de riemen die we hebben. De markt voor zuinige thuisservers is heel klein en vaak betekent dit dus hardware gebruiken dit eigenlijk voor een andere doelgroep is bedoeld.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Ik heb een tijdje terug ook al eens vermeld dat ik een NAS/Server ga bouwen ivm een schoolproject, maar nu gaat het bijna gebeuren. Mijn netwerkgedeelte is al voor 75% gebeurd en dus wou ik nog even update maken van de lijst en jullie om input vragen.

Het systeem dat ik zoek te bouwen is het volgende:

- ESXI 5.1 server als basis OS

- NAS met VM - FREENAS 8

- Torret/Download PC met VM - Windows 7

- WSUS (Windows Update Server) met VM - Windows Server 2008 R2

De Torrent/Download en WSUS PC zullen op de 1TB harde schijf komen te staan met elks hun eigen deel op de schijf (hoe groot weet ik momenteel nog niet).

Mochten er later nog VM's bijkomen (kan niet onmiddellijk bedenk wat) dan kunnen deze nog bij op de 1TB harde schijf.

Momenteel heb ik deze configuratie in gedachten (maar input is altijd welkom):

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 154,95 | € 154,95 |

| 1 | ASRock B75 Pro3-M | € 55,10 | € 55,10 |

| 1 | Seagate Barracuda 7200.14 ST1000DM003, 1TB | € 56,60 | € 56,60 |

| 6 | Seagate Barracuda 7200.14 ST3000DM001, 3TB | € 104,- | € 624,- |

| 1 | Lian Li PC-V354B | € 141,25 | € 141,25 |

| 2 | 3Ware 3Ware Multi-lane SATA cable CBL-SFF8087OCF-05M | € 14,99 | € 29,98 |

| 1 | Corsair Vengeance CMZ32GX3M4X1866C10 | € 181,50 | € 181,50 |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 118,58 | € 118,58 |

| 1 | be quiet! Pure Power L8 430W | € 54,- | € 54,- |

| 2 | Samsung 840 series SSD 120GB | € 80,75 | € 161,50 |

| Bekijk collectie Importeer producten | Totaal | € 1.577,46 | |

De 2 SSD's komen in een Raid 1 configuratie te staan rechtstreeks op het moederbord aangesloten op de SATA 600 poorten, hierop zal dan het OS voor ESXI draaien (kleine partitie).

Binnen ESXI zou ik de IBM op passtrough zetten, ik ken het zelf nog niet zo goed maar heb het hier al meerdere keren horen vallen. Hierop zouden dan de 6x 3TB harde schijven in RAIDZ2 op komen voor de NAS opslag van de films, foto's, ... Voor FreeNAS zelf wil ik de overige ruimte op de SSD gebruiken net zoals ZIL en L2ARC (grote van partities heb ik geen flauw benul van - 120GB SSD leek mij wel genoeg).

De laatste harde schijf, de 1TB voor Torrent/Download en WSUS worden ook rechtstreeks op de SATA 600 poort van het moederbord geprikt.

Ook heb ik al 2dehans een HP Quadport NIC NC364T (4x Gigabit) op de kop kunnen tikken. Deze zou ook in de NAS/Server moeten zodat ik elke machine van genoeg bandbreedte kan voorzien.

Dit is alles zo een beetje wat ik in gedachten had, het stroomverbruik heb ik ook proberen binnen de perken te houden. Het NAS OS kan draaien vanop de SSD zonder dat de 6 andere schijven hoeven aan te staan (idle) en de WSUS en Torrent/Download VM zitten op dezelfde HD. ESXI zelf zit ook op de SSD die bijna niets verbruikt.

Maar nu zou ik graag jullie mening nog willen horen voor ik deze bestelling plaats. Alle info of wijzigingen zijn welkom, zolang er maar geen 1000 euro aan kosten bijkomen

Je kan beter ESX gewoon op een USB stick draaien. Beter is het om gewoon backups te maken van je VM's.

[ Voor 5% gewijzigd door Phuncz op 25-03-2013 07:38 ]

Verwijderd

YouTube: IBM ServeRAID M1015 SAS/SATA Controller Unboxing & Overview

Die kaart kan wel 128 schijven aan... Dan moet je er alleen een SAS Expander aan hangen

BTW: dat filmpje is echt om te gieren.. RAID5 op een LSI2008 en dan zeggen dat het goed is....

[ Voor 46% gewijzigd door FireDrunk op 25-03-2013 11:31 ]

Even niets...

Dè developers podcast in je moerstaal : CodeKlets Podcast

Deel die wijsheid dan ook met ons!OMX2000 schreef op maandag 25 maart 2013 @ 12:22:

Tunen van mdadm raid loont toch echt wel. Mijn raid 5 set van 4x 2TB Samsungs ubuntu binnen esxi (RDM's) doet nu ca. 305 MB/s read en write.

[ Voor 20% gewijzigd door Demo op 25-03-2013 16:50 ]

Unix doesn't prevent a user from doing stupid things, because that would necessarily prevent them from doing brilliant things.

while true ; do echo -n "bla" ; sleep 1 ; done

Hier vandaag de stoute schoenen aangetrokken en met de hand ZFSguru geupgrade via de ports tree (portmaster)

Eigenlijk ging alles prima! Alleen wilde ik ook VirtualBox upgraden, maar dat werkt nog niet

Vage foutmelding over het niet kunnen starten van VM's.

Even niets...

Dan valt mijn plan in het water (of heeft hier iemand anders een manier om de Raid1 te maken?).redfoxert schreef op maandag 25 maart 2013 @ 00:22:

ESX ondersteunt geen Intel "hardware" RAID. Dus als je de controller in het BIOS op RAID instelt en dan je SSD's in RAID1 configureert kan je er met ESX niks mee.

Je kan beter ESX gewoon op een USB stick draaien. Beter is het om gewoon backups te maken van je VM's.

Ok ben hier maar even luidop aan het denken, want ik kan het hier zelf niet proberen aangezien ik geen extra machine heb om ESXI op te installeren.

Is het bijvoorbeeld mogelijk om binnen ESXI zelf een RAID 1 volume aan te maken met de 2 SSD's voor het NAS OS (FreeNAS)?

Want momenteel is het dan deze setup:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 154,95 | € 154,95 |

| 1 | ASRock B75 Pro3-M | € 56,90 | € 56,90 |

| 1 | Seagate Barracuda 7200.14 ST1000DM003, 1TB | € 57,35 | € 57,35 |

| 6 | Seagate Barracuda 7200.14 ST3000DM001, 3TB | € 104,- | € 624,- |

| 1 | Lian Li PC-V354B | € 141,25 | € 141,25 |

| 2 | 3Ware 3Ware Multi-lane SATA cable CBL-SFF8087OCF-05M | € 14,99 | € 29,98 |

| 2 | Transcend JetFlash 760 4GB Zwart | € 6,- | € 12,- |

| 1 | Corsair Vengeance CMZ32GX3M4X1866C10 | € 213,50 | € 213,50 |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 118,58 | € 118,58 |

| 1 | be quiet! Pure Power L8 430W | € 55,90 | € 55,90 |

| 2 | Intel 330 60GB | € 67,65 | € 135,30 |

| Bekijk collectie Importeer producten | Totaal | € 1.599,71 | |

--> Als ESXI op de USB stick's komt kan ik een kleinere SSD nemen, dat bespaard toch ook al weer 40 euro.

ESXI

- Geïnstalleerd op de 4GB USB stick (2e als backup)

- 2x SSD in Raid1 (hoe weet ik helaas dan nog niet)

- 6x 3TB disk op de IBM controller voor de ZFS opslag in een RaidZ2

- Partitie op de 1TB disk

- Partitie op de 1TB disk

Iemand ideetjes?

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Ik ga op FreeNAS zo'n 7 a 8 TB aan data opslaan (Films, Documenten, Backup's)

Omdat dit een grote hoeveelheid is, is het backuppen hiervan niet echt handig. Daarom de RaidZ2 setup en het OS in Raid1 zodat deze veilig zijn.

Ik weet dat RAID geen backup is, maar de echt belangrijke data zal nog op een aparte externe disk komen.

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Daarom wou ik dit ook doen (leek me veilige en goede setup)

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Verwijderd

Zelf zo`n kabel maken met goeie kwaliteit kabel en stekkers is toch veel beter of ligt dat aan mij?

Hier heeft CiPHER een mooi woordje over gedaan een paar posts boven je (link)Verwijderd schreef op maandag 25 maart 2013 @ 20:46:

Waarom gebruiken sommige van jullie dit soort stekker?

[afbeelding]

Zelf zo`n kabel maken met goeie kwaliteit kabel en stekkers is toch veel beter of ligt dat aan mij?

Dan is het misschien interessanter om een 250GB SSD te nemen en deze in partitie's op te splisten voor elk VM OS?victorb schreef op maandag 25 maart 2013 @ 20:19:

Dat kan volgens mij alleen met ZFSguru omdat die kan partitioneren.

vb. Partitie van 40GB voor FreeNAS, Partitie van 50GB voor Windows WSUS, Partitie van 50GB voor Windows Torrent/Download.

Zo is het OS gedeelte snel en kan ik de 1TB disk gebruiken als data opslag voor die VM's.

50GB Partitie op SSD voor windows en de torrents/downloads zelf worden op een 500GB grote partitie opgeslagen van de harddisk.

Ik heb ze zelf in elkaar gezet ik was die molex-crap ook behoorlijk zat. Ziet er ook nog véél beter uit, heel netjes langs alle schijvenVerwijderd schreef op maandag 25 maart 2013 @ 20:46:

Waarom gebruiken sommige van jullie dit soort stekker?

[afbeelding]

Zelf zo`n kabel maken met goeie kwaliteit kabel en stekkers is toch veel beter of ligt dat aan mij?

Vond er nog een mooie tutorial voor op youtube echt de moete van het kijken waard

YouTube: Modding Guide: Inline SATA Connectors

8.960 Wp - 16 kW Daikin L/W - 2 x MHI L/L - gasloos sinds 2017 - Loxone - SAP/IS-U/ABAP - rijdt nog LPG ;-)

Verwijderd

Ja deze had ik ook al gezien en ik ga ze ook zelf maken met mooie zwarte kabels mar heb jij die 15pins sata stekkers los gekocht?? Zo ja waar?psy schreef op maandag 25 maart 2013 @ 21:18:

[...]

Ik heb ze zelf in elkaar gezet ik was die molex-crap ook behoorlijk zat. Ziet er ook nog véél beter uit, heel netjes langs alle schijven

Vond er nog een mooie tutorial voor op youtube echt de moete van het kijken waard

YouTube: Modding Guide: Inline SATA Connectors

Gewoon meteen een paar bestelen natuurlijk plus wat reserve want er kan er wel eentje sneuvelen als je de zaak weer in elkaar zet.

Duurt wel een weekje of 2, 3 maarja voor die prijs. het zijn wel de goede...inline connectors.

http://cgi.ebay.com/ws/eB...ageName=ADME:L:OC:NL:3160

8.960 Wp - 16 kW Daikin L/W - 2 x MHI L/L - gasloos sinds 2017 - Loxone - SAP/IS-U/ABAP - rijdt nog LPG ;-)

Dat kan maar alleen als vmdk bestand, geen partities. Ik zou freenas lekker op een ssd parkeren, samen met alle andere vm's waarin snelheid belangrijk is. De overige 'speel vm's' draai je via nfs vanaf de 6 disks in freenas. De 1TB disk kan je dan nog gebruiken om de vm's vanaf ssd te backuppen.Toon-VA schreef op maandag 25 maart 2013 @ 21:02:

[...]

Dan is het misschien interessanter om een 250GB SSD te nemen en deze in partitie's op te splisten voor elk VM OS?

vb. Partitie van 40GB voor FreeNAS, Partitie van 50GB voor Windows WSUS, Partitie van 50GB voor Windows Torrent/Download.

Zo is het OS gedeelte snel en kan ik de 1TB disk gebruiken als data opslag voor die VM's.

50GB Partitie op SSD voor windows en de torrents/downloads zelf worden op een 500GB grote partitie opgeslagen van de harddisk.

Zo heb ik het:

500GB ssd voor belangrijke vm's incl zfs-nas.

1TB schijf waarin elke vm vanaf de ssd zichzelf backupt

6x 2TB in z2 vanaf nas-vm voor meuk

2x 1TB in mirror vanaf nas-vm voor vm's die niet disk-intensief zijn

2x SSD voor zil/l2arc

De ssd's hangen net als de schijven via een controller met vt-d aan de zfs-vm. Elke ssd heeft vier partities; 2x zil, 2x l2arc. Tussen de ssd's zijn de zils in mirror, l2arc in r0. Zo hebben zowel de1 1TB mirror als de raidz2 array een eigen zil/l2arc. Het klopt dat partitioneren alleen makkelijk werkt met zfsguru, in andere gevallen moet je handmatig partities aanmaken en de devicenamen onthouden waarna je met de zpool commando's ze alsnog toe kan voegen.

Bedankt voor de info, hierop zat ik eigelijk te wachten, duidelijke en handige informatie.jadjong schreef op dinsdag 26 maart 2013 @ 00:19:

[...]

Dat kan maar alleen als vmdk bestand, geen partities. Ik zou freenas lekker op een ssd parkeren, samen met alle andere vm's waarin snelheid belangrijk is. De overige 'speel vm's' draai je via nfs vanaf de 6 disks in freenas. De 1TB disk kan je dan nog gebruiken om de vm's vanaf ssd te backuppen.

Zo heb ik het:

500GB ssd voor belangrijke vm's incl zfs-nas.

1TB schijf waarin elke vm vanaf de ssd zichzelf backupt

6x 2TB in z2 vanaf nas-vm voor meuk

2x 1TB in mirror vanaf nas-vm voor vm's die niet disk-intensief zijn

2x SSD voor zil/l2arc

De ssd's hangen net als de schijven via een controller met vt-d aan de zfs-vm. Elke ssd heeft vier partities; 2x zil, 2x l2arc. Tussen de ssd's zijn de zils in mirror, l2arc in r0. Zo hebben zowel de1 1TB mirror als de raidz2 array een eigen zil/l2arc. Het klopt dat partitioneren alleen makkelijk werkt met zfsguru, in andere gevallen moet je handmatig partities aanmaken en de devicenamen onthouden waarna je met de zpool commando's ze alsnog toe kan voegen.

Dan laat ik de ZIL en L2ARC voor wat het is aangezien ik geen plaats heb voor een extra controller voor de SSD's (of ik moest een ATX moederbord nemen maar dan wordt het te groot).

Als ik dan kijk naar jouw setup dan denk ik dat ik zoiets zal maken:

250GB SSD voor VM: FreeNAS - Download - WSUS

- 1TB disk als backup voor de VM's

- 6x 3TB in RAIDZ2 voor DATAopslag

Waar heb je ESXI geïnstalleerd en op wat (USB, SD, SSD, HD, ...)?

Je zegt hier dat je 2x 1TB in mirror hebt vanaf de NAS-VM voor niet disk intensieve VM's te kunnen op laten draaien, hoe regel je dit dan binnen ESXI?

Je haalt ook aan om speel-VM's te maken en ze via NFS van op de 6x 3TB RAIDZ2 beschikbaar te maken. Maar wil dit dan zeggen dat je ze vanuit een andere machine beheert zoals VmWare workstation of kan dit ook binnen ESXI zelf?

De puzzel in mijn hoofd is al een stukje gemaakt maar nog niet compleet, alvast bedankt voor de uiteg

Hoe wil je die 6*3TB aan FreeNAS gaan geven? Ah, een M1015 icm VT-d, ik moet lezen

[ Voor 14% gewijzigd door FireDrunk op 26-03-2013 09:44 ]

Even niets...

Een 4GB usb stick is dan in principe genoeg voor ESXI op te draaien, maakt het hier dan eigelijk uit of dit een USB2 of USB3 stick is (performantie)?

Even niets...

Verwijderd

dat is inderdaard niet veel geld! maar dan zijn ze al wel is gebruikt natuurlijk.. omdat ze al op een kabel zitten.. en 2/3 weken levertijd..psy schreef op maandag 25 maart 2013 @ 21:29:

Die had ik via eBay uit Singapore voor een whopping 0,99 + 0,05

Gewoon meteen een paar bestelen natuurlijk plus wat reserve want er kan er wel eentje sneuvelen als je de zaak weer in elkaar zet.

Duurt wel een weekje of 2, 3 maarja voor die prijs. het zijn wel de goede...inline connectors.

http://cgi.ebay.com/ws/eB...ageName=ADME:L:OC:NL:3160

Ik heb inmiddels deze gevonden:

http://www.highflow.nl/?s...&dispatch=products.search

of

http://www.freezinghardwa...-_blauw_UV-sensitive.html

ook vekrijgbaar in leuke kleurtjes

[ Voor 5% gewijzigd door Verwijderd op 26-03-2013 10:29 ]

Ook ik ben aan het denken om een NAS te bouwen voor home use.

Echter mijn grootste voorwaarde is laag verbruik (lijkt me niet onlogisch voor iets wat 24/24u draait).

Echter kom ik tot de conclusie dat vele builds in dit topic draaien op de intel core serie?

Is het niet mogelijk om een FreeNas ZFS systeem te draaien op een Atom? Of beter gezegd, het zal wel mogelijk zijn, maar in hoeverre beperk ik mezelf dan?

NAS zou gebruikt worden om sporadisch de familiefotoos op weg te schrijven, een torrent op te draaien, en content te streamen naar een HTPC.

alvast bedankt voor het advies

2) Een Atom kan maximaal 4GB geheugen addresseren.

3) Een Atom is amper zuiniger dan de nieuwste Ivy Bridge Celron's, en vaak zelfs minder zuinig

4) Je hebt te weinig PCIe Lanes,

5) Je hebt te weinig SATA poorten.

Even niets...

Wat mij ook opviel is dat Haswell mogelijk een heel goede oplossing zou zijn voor low power setups.

Het eewenoude verhaal...loont het de moeite om te wachten?

Of zou deze Haswell slecht minimaal impact hebben?

Anyway, wat voor een opstelling met huidige componenten zou resulteren in een low power setup?

low power i3 vs celeron vs amd?

Verwijderd

Met 8 poorten op de IBM en een Rz2 van 6 disks heb je nog twee poorten over voor zil/cache.Toon-VA schreef op dinsdag 26 maart 2013 @ 09:35:

[...]

Bedankt voor de info, hierop zat ik eigelijk te wachten, duidelijke en handige informatie.

Dan laat ik de ZIL en L2ARC voor wat het is aangezien ik geen plaats heb voor een extra controller voor de SSD's (of ik moest een ATX moederbord nemen maar dan wordt het te groot).

USB. Voor die paar euro ben je iets flexibeler met wisselen van datastoresAls ik dan kijk naar jouw setup dan denk ik dat ik zoiets zal maken:

250GB SSD voor VM: FreeNAS - Download - WSUSNu heb ik nog enkele vragen over jouw setup:

- 1TB disk als backup voor de VM's

- 6x 3TB in RAIDZ2 voor DATAopslag

Waar heb je ESXI geïnstalleerd en op wat (USB, SD, SSD, HD, ...)?

Via NFS. Het kan ook vanaf de andere array, maar dan heb je continue 6 schijven draaien. Met die mirror kan ik de andere 6 na tien minuten vanzelf in stanby laten gaan.Je zegt hier dat je 2x 1TB in mirror hebt vanaf de NAS-VM voor niet disk intensieve VM's te kunnen op laten draaien, hoe regel je dit dan binnen ESXI?

Gewoon via NFS. Een gedeelde map via netwerk.Je haalt ook aan om speel-VM's te maken en ze via NFS van op de 6x 3TB RAIDZ2 beschikbaar te maken. Maar wil dit dan zeggen dat je ze vanuit een andere machine beheert zoals VmWare workstation of kan dit ook binnen ESXI zelf?

Ik heb eens lopen googlen, maar kan nergens reviews van recente (low end) procjes vinden m.b.t. energieverbruik. Er zijn wel er wel een paar, maar dan is getest in combinatie met een dikke gtx of radeon kaart en een 1000W voeding, wat dus niet echt een mooi beeld van het idleverbruik geeft...

Voor een thuisnas zou ik verwachten dat een ivy pentium wel eens zeer geschikt zou kunnen zijn. Echter is de TDP van deze procjes vaak nog best hoog (45-65W). Amd ben ik niet zo in thuis, maar ik weet dat intel bij het high end segment in ieder geval ruim de performance/watt kroon in handen heeft, dus ik gok dat dit voor de goedkopere cpu's ook het geval is.

Ik bedenk me net: zijn er geen bordjes met mobile cpu's en 4(+) sata poorten te koop? dat zou best wel ideaal zijn voor een simpel servertje.

Lees even wat verhalen van Mux (hier, Het grote Zuinige Server topic, en zijn blog). Hij legt haarfijn uit dat alle Celeron, Pentium, i3, i5, en i7 processoren gebakken volgens het Ivy Bridge principe zo goed als altijd < 10W idle doen in C3 modus.

Het verschil tussen een G1610 en een i5 3570k was idle 0.4W geloof ik in Mux's DQ77KB bordje.

Een G1610 of een Pentium G2020 zijn momenteel erg veel bang-for-buck en presteren idle uitmuntend.

Even niets...

Dude srsly?accountabc schreef op dinsdag 26 maart 2013 @ 16:25:

Ik heb eens lopen googlen, maar kan nergens reviews van recente (low end) procjes vinden m.b.t. energieverbruik. Er zijn wel er wel een paar, maar dan is getest in combinatie met een dikke gtx of radeon kaart en een 1000W voeding, wat dus niet echt een mooi beeld van het idleverbruik geeft...

http://tweakers.net/price.../326205;326193/categorie/

Nou ja, ik heb met mijn versie wat problemen gehad, maar na een RMA'tje werkt alles perfect. Ik hou het voorlopig op een foutje in die capacitoren of zelfs gewoon ergens een kortsluiting.Verwijderd schreef op zondag 24 maart 2013 @ 21:51:

pricewatch: Silverstone SST-CP06 4x SATA

[afbeelding]

Voordeel van deze stekkers:Niet iedereen is er blij mee overigens. Ik geloof dat HyperBart er problemen mee had. Ook ik heb problemen ondervinden in combinatie met PicoPSU. Als ik deze stekkers aansluit terwijl PicoPSU draait; dan treedt een bescherming in werking (vermoed ik) waardoor het systeem plots uitgaat. Ik moet de stekkers aangesloten hebben en dan pas de stroom erop zetten. Ik vermoed dat dit een probleem is door de hoge rush-in current van de capacitors. Mux kan daar vast en zeker meer over vertellen.

- Géén Molex connector dus ook geen problemen met connectoren die af en toe even geen contact maken; dit kan ernstige problemen veroorzaken in RAID arrays en in iets mindere mate ZFS arrays, doordat meerdere disks tegelijkertijd stroom verliezen wat de array onbeschikbaar kan maken en in sommige gevallen (hardware RAID/onboard RAID) zelfs lastig kan zijn om de array weer draaiende te krijgen.

- Er zitten capacitors in voor de +5V en +12V voltagelijnen. Dit zou voltagefluctuaties moeten verminderen bijvoorbeeld als een schijf gaat opspinnen terwijl de andere nog draaien. Doe ik dit zonder deze kabels dan hoor ik een soort geluidje bij de overige HDDs. Ik kan me voorstellen dat het opspinnen van een hardeschijf de voltages zodanig (kortdurig) kan beïnvloeden dat de overige hardeschijven hier last van kunnen ondervinden. Als alle schijven tegelijk opspinnen zou dit geen probleem mogen zijn denk ik, maar wellicht juist wel als je zowel spindown als spinned up schijven hebt.

- Voor weinig geld heb je extra SATA poorten (€2 per poort)

- Goed verkrijgbaar

Desondanks wil ik deze stekkers toch aanraden. Alles is beter dan die slechte Molex stekkers. Daar heb ik zelf best veel gezeik mee gehad over de jaren, en dat vermoed je misschien niet zo snel; je denkt dan dat het aan de schijven zelf ligt. Dus voorkom al die hoofdpijn en kies goede SATA power stekkers en gebruik nooit meer Molex waar mogelijk.

Anyway, ik heb dan maar het kabeltje gedemonteerd en alle SATA power connectoren er af gehaald. Handig, kan ik dus heel eenvoudig in de toekomst enkele SATA power connectoren "bij aan maken" door gewoon de connector op een bestaande rail te prikken... Ideetje kwam indertijd van deze man: YouTube: Modding Guide: Inline SATA Connectors

De poster van het bovenstaande filmpje is trouwens ook dezelfde kerel die deze NAS in 2010 gebouwd had/heeft:

nieuws: Zelfbouw-nas behaalt leessnelheden tot 266MBps

[ Voor 17% gewijzigd door HyperBart op 26-03-2013 18:42 ]

Edit: kan ook 'grote zfs topic' zijn

[ Voor 6% gewijzigd door Contagion op 26-03-2013 21:32 ]

@hyperbartHyperBart schreef op dinsdag 26 maart 2013 @ 18:25:

[...]

Dude srsly?

. Je moet dit topic maar eens nalezen

, Google vindt het niet, maar hier vind je het wel, gegarandeerd. Basically is er op dit moment maar één meest zuinige keuze wat betreft moederbord + CPU en dat is de ASRock B75 Pro3-M icm een Intel G1610 of G2020:

http://tweakers.net/price.../326205;326193/categorie/

[...]

Nou ja, ik heb met mijn versie wat problemen gehad, maar na een RMA'tje werkt alles perfect. Ik hou het voorlopig op een foutje in die capacitoren of zelfs gewoon ergens een kortsluiting.

Anyway, ik heb dan maar het kabeltje gedemonteerd en alle SATA power connectoren er af gehaald. Handig, kan ik dus heel eenvoudig in de toekomst enkele SATA power connectoren "bij aan maken" door gewoon de connector op een bestaande rail te prikken... Ideetje kwam indertijd van deze man: YouTube: Modding Guide: Inline SATA Connectors

De poster van het bovenstaande filmpje is trouwens ook dezelfde kerel die deze NAS in 2010 gebouwd had/heeft:

nieuws: Zelfbouw-nas behaalt leessnelheden tot 266MBps

Heb altijd al een idee gehad om het na te bouwen met iets meer disken misschien (denk aan extra units)

Maar nog altijd geen tijd en energie ervoor gehad maar concept is super!!! en gebruikt ook super weinig. En die gast is goed!!!

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Het is dus perfect mogelijk om de kaart 6 schijven door te geven voor de ZFS datastore en de overige 2 SSD's aan te duiden als ZIL en L2ARC? Ik dacht dat dit niet mogelijk was (ESXI kennis is zo goed als 0)jadjong schreef op dinsdag 26 maart 2013 @ 16:06:

[...]

Met 8 poorten op de IBM en een Rz2 van 6 disks heb je nog twee poorten over voor zil/cache.

Dan koop ik 2 stuks 4GB usb2 stickjes, zo kan ik een reserve maken.[...]

USB. Voor die paar euro ben je iets flexibeler met wisselen van datastores

Bij dit stukje ben ik echt nog niet mee, sorry voor de rest die het wel al snappen. Je spreekt hier nog over 2x 1TB in mirror setup, maar hebben we het hier dan over effectieve schijven? Want je zegt "2x 1TB in mirror vanaf de NAS-VM" en dit via NFS. Door de mirror kan je de RaidZ2 pool in standby zetten, maar hoe werkt dit dan even uitgelegd tot op een basisniveau?Je zegt hier dat je 2x 1TB in mirror hebt vanaf de NAS-VM voor niet disk intensieve VM's te kunnen op laten draaien, hoe regel je dit dan binnen ESXI?

Via NFS. Het kan ook vanaf de andere array, maar dan heb je continue 6 schijven draaien. Met die mirror kan ik de andere 6 na tien minuten vanzelf in stanby laten gaan.

Het enige wat ik kan bedenken is een effectieve 1TB harde schijf die staat gemirrord met een 1TB partitie vanuit de VM RaidZ2 datastore. Zo kan de datastore in standbye aangezien de VM's ook op die éne harde schijf staat.

En waarschijnlijk als de vorige vraag behandeld is, zal dit ook duidelijk worden (aangezien dit op hetzelfde neerkomt).[...]

Gewoon via NFS. Een gedeelde map via netwerk.

Maar dan kan ik mijn setup dus nog een beetje bijstellen (3 SSD's - 1 grote voor os VM's op te zetten en 2 kleinere voor cache). De definitieve bestelling doe ik pas nadat ik de antwoorden op mijn vragen heb gevonden. Toch al bedankt voor de goede uitleg

Ik heb wel enkele pagina's teruggeklikt, maar zoals je misschien kan begrijpen heb ik niet alle 490 pagina's bekekenHyperBart schreef op dinsdag 26 maart 2013 @ 18:25:

[...]

Dude srsly?

. Je moet dit topic maar eens nalezen

[...]

Aah, dat wist ik niet. Ik had verwacht dat hogere TDP procs ook een hoger idle verbruik zouden hebben. Dat TDP=/= verbruik wist ik wel, maar ik dacht dat dit wel een indicatie zou geven. Fout gedacht dus. Dat een dual core pentium en een quad core i5 idle min of meer hetzelfde verbruiken had ik helemaal niet verwacht. Interessante vondst! Onder load zullen de verschillen neem ik aan wel een stuk groter zijn. Ik zal wat meer gaan lezen, genoeg interessants te vinden als ik je reactie zo lees.FireDrunk schreef op dinsdag 26 maart 2013 @ 16:30:

Zoals zo vaak gezegd wordt in dit topic: TDP is GEEN verbruiksgetal, het is de hoeveelheid warmte in Watt die maximaal afgegeven kan worden door de CPU.

Lees even wat verhalen van Mux (hier, Het grote Zuinige Server topic, en zijn blog). Hij legt haarfijn uit dat alle Celeron, Pentium, i3, i5, en i7 processoren gebakken volgens het Ivy Bridge principe zo goed als altijd < 10W idle doen in C3 modus.

Het verschil tussen een G1610 en een i5 3570k was idle 0.4W geloof ik in Mux's DQ77KB bordje.

Een G1610 of een Pentium G2020 zijn momenteel erg veel bang-for-buck en presteren idle uitmuntend.

ik wist niet dat er een zuinig server topic was

[ Voor 6% gewijzigd door accountabc op 27-03-2013 00:05 ]

Als jouw moederbord en processor vt-d ondersteunen koppel je de gehele kaart aan een vm. Jouw nas-vm ziet dan elke disk die je aansluit.Toon-VA schreef op dinsdag 26 maart 2013 @ 22:48:

[...]

Het is dus perfect mogelijk om de kaart 6 schijven door te geven voor de ZFS datastore en de overige 2 SSD's aan te duiden als ZIL en L2ARC? Ik dacht dat dit niet mogelijk was (ESXI kennis is zo goed als 0)

NFS is een manier om mapjes te delen via netwerk, net als in windows maar dan anders.Bij dit stukje ben ik echt nog niet mee, sorry voor de rest die het wel al snappen. Je spreekt hier nog over 2x 1TB in mirror setup, maar hebben we het hier dan over effectieve schijven? Want je zegt "2x 1TB in mirror vanaf de NAS-VM" en dit via NFS. Door de mirror kan je de RaidZ2 pool in standby zetten, maar hoe werkt dit dan even uitgelegd tot op een basisniveau?

Nee, twee fysieke schijven.Het enige wat ik kan bedenken is een effectieve 1TB harde schijf die staat gemirrord met een 1TB partitie vanuit de VM RaidZ2 datastore. Zo kan de datastore in standbye aangezien de VM's ook op die éne harde schijf staat.

1x SSD aangesloten op moederbord voor datastore1Maar dan kan ik mijn setup dus nog een beetje bijstellen (3 SSD's - 1 grote voor os VM's op te zetten en 2 kleinere voor cache). De definitieve bestelling doe ik pas nadat ik de antwoorden op mijn vragen heb gevonden. Toch al bedankt voor de goede uitleg

1x HDD aangesloten op moederbord voor datastore2 als backup

6x HDD aangesloten op IBM voor nas-vm met zfs

2x SSD aangesloten op IBM voor nas-vm met zil/cache partitie voor zfs

Ik heb zelf de 2 kanaals variant van de 2740 (de 2720) en tot nu toe super tevreden. Gebruik hem nu ongeveer 3 maanden. Crystaldiskmark haalt 750MB/sec lezen en 340MB/sec schrijven op een 8x 2TB WD20EARX RAID-5 array. De kaart zit in een ASRock B75 Pro3-M met een i3 3220T.FireDrunk schreef op zaterdag 23 maart 2013 @ 11:47:

Doe dan alsjeblieft een LSI 16-poorts controller. Highpoint is vragen om problemen...

[ Voor 6% gewijzigd door Dualdude op 27-03-2013 09:38 ]

Het is een handleiding over hoe je een wat ouder systeem kan inzetten als ZFS server en waar je op moet letten. Er zitten allerlei ZFS tips in het filmpje.

Na dit filmpje ga ik een Nas4free installatie how to maken. Daar is veel vraag naar op youtube. Maar ik had zoiets laat ik eerst een hardware filmpje maken zodat mensen een idee krijgen wat voor systeem ze kunnen gebruiken.

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Verwijderd

dank voor de video! zaten leuke tips in! en ik wacht met smart op je filmje over Nas4Freevictorb schreef op woensdag 27 maart 2013 @ 10:07:

Ik heb een nieuwe video online!

Het is een handleiding over hoe je een wat ouder systeem kan inzetten als ZFS server en waar je op moet letten. Er zitten allerlei ZFS tips in het filmpje.

[video]

Na dit filmpje ga ik een Nas4free installatie how to maken. Daar is veel vraag naar op youtube. Maar ik had zoiets laat ik eerst een hardware filmpje maken zodat mensen een idee krijgen wat voor systeem ze kunnen gebruiken.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Waarom kies jij voor nas4free? Persoonlijke keuze of echt voordelen tov freenas

Nas4free is een doorontwikkeling van Freenas7. En Freenas8 is een nieuw project. Best heel verwarrend eigenlijk.

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Oke, nu ben ik helemaal mee met de zaak, ESXI kan dus VM's lezen/gebruiken die op een harde schijf staan of die worden aangeboden via een share. Natuurlijk als dit via een share gebeurd, moet de effectieve machine die de share aanbied in gebruik zijn/aan staan.jadjong schreef op woensdag 27 maart 2013 @ 01:40:

[...]

Als jouw moederbord en processor vt-d ondersteunen koppel je de gehele kaart aan een vm. Jouw nas-vm ziet dan elke disk die je aansluit.

[...]

NFS is een manier om mapjes te delen via netwerk, net als in windows maar dan anders.ESX kan fysieke schijven als datastore gebruiken, maar ook mapjes op een netwerkschijf via NFS.Als je een mapje deelt vanaf de raidz2 array moeten er 6 schijven draaien voor een simpele vm die 1x per vijf minuten iets wegschrijft of leest. Door twee extra fysieke schijven te nemen voor vm's kon ik de andere uit laten gaan. Da scheelt +/- 25watt continue.

[...]

Nee, twee fysieke schijven.

[...]

1x SSD aangesloten op moederbord voor datastore1

1x HDD aangesloten op moederbord voor datastore2 als backup

6x HDD aangesloten op IBM voor nas-vm met zfs

2x SSD aangesloten op IBM voor nas-vm met zil/cache partitie voor zfs

Met deze info in het achterhoofd ben ik dan tot deze conclusie gekomen:

- ESXI en FreeNAS zullen op een aparte USB geïnstalleerd worden

- Er komen 2 SSD's die ik ga gebruiken voor de ZIL cache in R1 en L2ARC cache in R0 aangesloten op de IBM

- De 6 3TB harde schijven komen in een RaidZ2 ZFS op de IBM als DATASTORE voor de NAS VM

- De 1TB disk heb ik veranderd naar een 2TB disk zodat ik hier de 2 Windows machine's op kan draaien en later indien nodig nog een extra VM op kan aanmaken.

Dan voor de backup van de VM's heb ik nog een oudere 1,5TB USB2 externe harde schijf liggen die hiervoor kan en zal gaan dienen (als ik 1x om de week een backup neem van de VM's en de oude backup altijd delete is er plaats genoeg).

Voor de zeer belangrijke bestanden die op de NAS staan heb ik nog een 2e 1,5TB USB2 externe harde schijf liggen die dienst kan doen als backup.

Ik heb dan alles nog even in paint gegooid en bekom dit resultaat (dan is het makkelijker te begrijpen):

Met alle info die ik van het internet heb geplukt en jullie input, denk ik niet dat ik nu nog iets aan het vergeten ben. De cache zal ik dan zoals vermeld handmatig moeten toekennen binnen FreeNAS, als het zover is zal ik nog wel hulp komen vragen

En natuurlijk niet vergeten de setup (even vergeten toe te voegen):

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 154,95 | € 154,95 |

| 1 | ASRock B75 Pro3-M | € 56,90 | € 56,90 |

| 1 | Seagate Barracuda 7200.14 ST2000DM001, 2TB | € 77,- | € 77,- |

| 6 | Seagate Barracuda 7200.14 ST3000DM001, 3TB | € 107,85 | € 647,10 |

| 1 | Lian Li PC-V354B | € 140,40 | € 140,40 |

| 2 | 3Ware 3Ware Multi-lane SATA cable CBL-SFF8087OCF-05M | € 16,- | € 32,- |

| 2 | Sandisk Cruzer Fit 4GB Zwart | € 5,08 | € 10,16 |

| 1 | Crucial Ballistix Sport BLS4C8G3D1609ES2LX0BEU | € 145,45 | € 145,45 |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 118,58 | € 118,58 |

| 1 | be quiet! Pure Power L8 530W | € 66,30 | € 66,30 |

| 2 | Intel 330 60GB | € 67,65 | € 135,30 |

| Bekijk collectie Importeer producten | Totaal | € 1.584,14 | |

[ Voor 39% gewijzigd door Toon-VA op 27-03-2013 15:53 ]

Verder snap ik niet helemaal wat je met je Windows partities bedoelt. ESXi kent geen partities. 1 hardeschijf = 1 datastore. Daarin heb je gewoon je virtuele schijven staan. En heb je daadwerkelijk 500GB nodig voor Windows 7 en voor Windows 2008 ? Kan je niet beter een grote schijf nemen als datastore?

De 2 Windows VM's zullen worden gebruikt als oa. download station (Win 7 - Torrent) en WSUS (Win 2008R2).

Omdat ik hier dus wel wat data moet kunnen opslaan heb ik gekozen voor 2x 500GB toe te kennen aan die Windows VM's.

Verwijderd

Vraagje over deze kaart:

pricewatch: HP SAS Expander Card

Is deze kaart los te gebruiken of moet die verbonden zijn met een andere Nonraid sata/sas controller?

Let wel goed op, een 1TB schijf is nooit precies 1TB, dus geef je VM's niet klakkeloos 500GB aan ruimte, mochten ze ooit vol komen, gaat je 1TB schijf nooit 2 VMDK's van 500GB kunnen houden.

Op dat moment heb je weer een flink geneuzel om de boel recht te trekken. Begin met 2*450 zou ik zeggen.

Waarom trouwens Intel 330 SSD's? Die zou ik mijden, (sandforce gebaseerd.) Ga voor een Crucials, Intel 320's, 520's of Samsung SSD's. In mijn ogen beter schikt voor dit soort zaken.

Die moet aan een andere SAS Controller geknoopt worden.Verwijderd schreef op woensdag 27 maart 2013 @ 16:30:

Heej..

Vraagje over deze kaart:

pricewatch: HP SAS Expander Card

Is deze kaart los te gebruiken of moet die verbonden zijn met een andere Nonraid sata/sas controller?

[ Voor 38% gewijzigd door FireDrunk op 27-03-2013 16:31 ]

Even niets...

If anything zou ik *juist* sandforce-SSDs gebruiken voor dit soort toepassingen. Die hebben een veel lagere write amplification en om die reden juist in deze toepassing een veel betere levensduur dan non-sandforce.FireDrunk schreef op woensdag 27 maart 2013 @ 16:30:

Waarom trouwens Intel 330 SSD's? Die zou ik mijden, (sandforce gebaseerd.) Ga voor een Crucials, Intel 320's, 520's of Samsung SSD's. In mijn ogen beter schikt voor dit soort zaken.

De Freenas vm kan je niet vanaf usb draaien. Zoals je hierboven leest moet je even wat ruimte op de datastore van esx reserveren. Ook de usb backupschijven zal je niet zo werkend kunnen krijgen. ESX ziet alleen schijven via sata/sas/scsi (daarom werkt freenas vanaf usb ook niet).Toon-VA schreef op woensdag 27 maart 2013 @ 15:49:

Ik heb dan alles nog even in paint gegooid en bekom dit resultaat (dan is het makkelijker te begrijpen):

[afbeelding]

Met alle info die ik van het internet heb geplukt en jullie input, denk ik niet dat ik nu nog iets aan het vergeten ben. De cache zal ik dan zoals vermeld handmatig moeten toekennen binnen FreeNAS, als het zover is zal ik nog wel hulp komen vragen.

[ Voor 5% gewijzigd door jadjong op 27-03-2013 16:52 ]

Hoe kan ik dus makkelijker een backup maken naar een externe schijf?

Daar gaat mijn plan (alweer). Dus ESXI enkel met SATA en niet USB.jadjong schreef op woensdag 27 maart 2013 @ 16:41:

[...]

De Freenas vm kan je niet vanaf usb draaien. Zoals je hierboven leest moet je even wat ruimte op de datastore van esx reserveren. Ook de usb backupschijven zal je niet zo werkend kunnen krijgen. ESX ziet alleen schijven via sata/sas/scsi (daarom werkt freenas vanaf usb ook niet).

[afbeelding]

Dan moet ik een grotere case kopen aangezien ik alle beschikbare HD plaatsten heb opgebruikt of geen backup nemen van de VM's (als freenas dan op dezelfde harde schijf komt als de windows machines).

Verwijderd

De problemen in je setup die ik zie:Toon-VA schreef op woensdag 27 maart 2013 @ 15:49:

Met deze info in het achterhoofd ben ik dan tot deze conclusie gekomen:

1) je sluit de SSDs aan op de LSI SAS controller. Je wilt het liefste TRIM support hebben door de SSDs op de chipset SATA controller aan te sluiten. Is dat niet mogelijk in ESXi? Kun je bijvoorbeeld niet de Intel controller aan je ZFS VM geven terwijl je de ASMedia controller binnen ESXi gebruikt, ofzo?

2) je kiest voor onveilige SSDs in combinatie met SLOG feature. RAID1 gaat daar weinig aan veranderen. Je kunt veel beter een Intel 320 of - nog even wachten - een Crucial M500 nemen voor deze taak. Deze hebben een power-safe capacitor die corruptie bij onverwacht stroomverlies moet voorkomen.

Gebruik geen SAS Expanders in combinatie met ZFS. Gebruik 'eerlijk' meerdere controllers en een moederbord met genoeg PCI-express poorten. Die route is veel beter. Expanders ie leuk voor FlexRAID of andere oplossingen waar er weinig parallelle I/O tegelijk plaatsvindt. Bovendien veel kans op problemen in specifieke situaties. Ik raad het dus sterk af. Echte controllers is de 'eerlijke' manier.Verwijderd schreef op woensdag 27 maart 2013 @ 16:30:

Vraagje over deze kaart:

pricewatch: HP SAS Expander Card

Is deze kaart los te gebruiken of moet die verbonden zijn met een andere Nonraid sata/sas controller?

Sandforce betere levensduur? Heel erg theoretisch misschien, maar in de praktijk is dat zeer discutabel. Sandforce is van alle SSDs namelijk extra kwetsbaar omdat het corrupt kan raken door 2 points of failure (mapping tables + dedup tables) terwijl andere SSDs maar één point of failure hebben.mux schreef op woensdag 27 maart 2013 @ 16:39:

If anything zou ik *juist* sandforce-SSDs gebruiken voor dit soort toepassingen. Die hebben een veel lagere write amplification en om die reden juist in deze toepassing een veel betere levensduur dan non-sandforce.

De lagere write amplification wordt ook enkel bereikt met gebruik van compressie en deduplicatie. Echter, het gebruik van ZFS zal deze features marginaliseren. Zo is bij ZFS alle metadata al gecomrimmeerd. En als je compressie + dedup wilt, kun je dat - juist met ZFS - veel beter op de host uitvoeren. Dan heb je ook baat bij deze features, want dan komt de bespaarde opslagruimte ten goede van de gebruiker, terwijl Sandforce normaliter deze ruimte als spare space gebruikt maar de gebruiker er dus weinig mee opschiet.

Daarnaast heeft Sandforce geen power-safe capacitors waardoor het per definitie ongeschikt is als SLOG feature ('ZIL'). Dat kun je wellicht oplossen met het apparaatje wat jij hebt ontwikkeld. Maar zonder een dergelijke oplossing is deze SSD dus ongeschikt voor de taak.

Zeker omdat over een week of twee een nieuwe SSD zijn intrede doet - de Crucial M500 - zou ik sterk willen afraden een Sandforce SSD te kopen en vooral te wachten op de M500 of gewoon nu een Intel 320 nemen. Dat zijn vooralsnog de enige twee consumenten SSDs die veilig zijn.

Klopt, ondersteuning voor booten van USB is er niet, maar het is wél mogelijkFireDrunk schreef op woensdag 27 maart 2013 @ 16:30:

Dat kan niet, een virtuele BIOS kan volgens mij niet van USB booten. Je moet volgens mij persé een VMDK aanmaken. Geen probleem, je geeft je Windows VM's gewoon 4GB minder, en daar maak je nóg een VMDK op.

Boot eerst van de floppy image of ISO van Plop Bootmanager, koppel de USB stick en selecteer USB in het menu. Nu weet ik niet of dit zonder gebruikersinteractie kan, maar het is iig mogelijk.

After the first glass you see things as you wish they were. After the second you see things as they are not. Finally you see things as they really are, and that is the most horrible thing in the world...

Oscar Wilde

Hoewel ik deze statement niet zo sterk vind.... (vergeet niet dat in non-ZFS toepassingen en met de komst van meer performance-georienteerde SSDs het gat tussen Sandforce sf-2281 en andere controllers gegroeid is tot 40-45% verschil in WA!)Verwijderd schreef op woensdag 27 maart 2013 @ 18:36:

Sandforce betere levensduur? Heel erg theoretisch misschien, maar in de praktijk is dat zeer discutabel. Sandforce is van alle SSDs namelijk extra kwetsbaar omdat het corrupt kan raken door 2 points of failure (mapping tables + dedup tables) terwijl andere SSDs maar één point of failure hebben.

Is dit juist de perfecte ontkrachting van mijn argument. Ik dacht dat ZFS op een ZIL/ARC geen gecomprimeerde data gooide, maar alleen de raw data.De lagere write amplification wordt ook enkel bereikt met gebruik van compressie en deduplicatie. Echter, het gebruik van ZFS zal deze features marginaliseren. Zo is bij ZFS alle metadata al gecomrimmeerd. En als je compressie + dedup wilt, kun je dat - juist met ZFS - veel beter op de host uitvoeren. Dan heb je ook baat bij deze features, want dan komt de bespaarde opslagruimte ten goede van de gebruiker, terwijl Sandforce normaliter deze ruimte als spare space gebruikt maar de gebruiker er dus weinig mee opschiet.

Dus inderdaad, de 330 en for that matter elke andere sandforce heeft geen voordeel in dit geval

[ Voor 13% gewijzigd door mux op 27-03-2013 19:01 ]

Je kan backuppen via NFS naar je rz2pool. Bij een crash is freenas dan wel verdwenen, maar door die opnieuw te installeren en de pool te importeren ben je zo weer aan de gang. Als je de 3.5" schijf vervangt door twee 2.5" kan je ze in dezelfde ruimte proppen.Toon-VA schreef op woensdag 27 maart 2013 @ 18:34:

[...]

Daar gaat mijn plan (alweer). Dus ESXI enkel met SATA en niet USB.

Dan moet ik een grotere case kopen aangezien ik alle beschikbare HD plaatsten heb opgebruikt of geen backup nemen van de VM's (als freenas dan op dezelfde harde schijf komt als de windows machines).

Het is een behoorlijke knutseloplossing die je maakt. Voor thuis geen probleem, maar zorg wel dat je alle handelingen onthoudt of opschrijft.

Dat werkt niet. Vt-d van onboard meuk faalt in 95% van de gevallen.Verwijderd schreef op woensdag 27 maart 2013 @ 18:36:

[...]

De problemen in je setup die ik zie:

1) je sluit de SSDs aan op de LSI SAS controller. Je wilt het liefste TRIM support hebben door de SSDs op de chipset SATA controller aan te sluiten. Is dat niet mogelijk in ESXi? Kun je bijvoorbeeld niet de Intel controller aan je ZFS VM geven terwijl je de ASMedia controller binnen ESXi gebruikt, ofzo?

Pantagruel in "Zuinige ESXi Server"

[ Voor 27% gewijzigd door jadjong op 27-03-2013 19:09 ]

@Mux, ZIL en L2ARC zijn niet per definitie metadata, en wat CiPHER zegt gaat over metadata, dus de compressie van L2ARC data is nog steeds valide. ZIL weet ik zo niet, want dat zijn synced writes, en ik vraag me af of een SandForce SSD eerst vrolijk gaat staan compressen als het een synced write moet doen.

Even niets...

Ik had deze SSD gekozen omdat het voor een 60GB SSD redelijk goedkoop was. De 320 SSD's hebben alleen een SATA II interface en zijn duurder dan de SSD's die ik nu had gekozen waardoor deze minder mijn aandacht trokken.Verwijderd schreef op woensdag 27 maart 2013 @ 18:36:

[...]

De problemen in je setup die ik zie:

1) je sluit de SSDs aan op de LSI SAS controller. Je wilt het liefste TRIM support hebben door de SSDs op de chipset SATA controller aan te sluiten. Is dat niet mogelijk in ESXi? Kun je bijvoorbeeld niet de Intel controller aan je ZFS VM geven terwijl je de ASMedia controller binnen ESXi gebruikt, ofzo?

2) je kiest voor onveilige SSDs in combinatie met SLOG feature. RAID1 gaat daar weinig aan veranderen. Je kunt veel beter een Intel 320 of - nog even wachten - een Crucial M500 nemen voor deze taak. Deze hebben een power-safe capacitor die corruptie bij onverwacht stroomverlies moet voorkomen.

[...]

Sandforce betere levensduur? Heel erg theoretisch misschien, maar in de praktijk is dat zeer discutabel. Sandforce is van alle SSDs namelijk extra kwetsbaar omdat het corrupt kan raken door 2 points of failure (mapping tables + dedup tables) terwijl andere SSDs maar één point of failure hebben.

De lagere write amplification wordt ook enkel bereikt met gebruik van compressie en deduplicatie. Echter, het gebruik van ZFS zal deze features marginaliseren. Zo is bij ZFS alle metadata al gecomrimmeerd. En als je compressie + dedup wilt, kun je dat - juist met ZFS - veel beter op de host uitvoeren. Dan heb je ook baat bij deze features, want dan komt de bespaarde opslagruimte ten goede van de gebruiker, terwijl Sandforce normaliter deze ruimte als spare space gebruikt maar de gebruiker er dus weinig mee opschiet.

[afbeelding]

Daarnaast heeft Sandforce geen power-safe capacitors waardoor het per definitie ongeschikt is als SLOG feature ('ZIL'). Dat kun je wellicht oplossen met het apparaatje wat jij hebt ontwikkeld. Maar zonder een dergelijke oplossing is deze SSD dus ongeschikt voor de taak.

Zeker omdat over een week of twee een nieuwe SSD zijn intrede doet - de Crucial M500 - zou ik sterk willen afraden een Sandforce SSD te kopen en vooral te wachten op de M500 of gewoon nu een Intel 320 nemen. Dat zijn vooralsnog de enige twee consumenten SSDs die veilig zijn.

Maar wachten op de Crucial heeft ook weer zijn minpunten, zo moet ik de reviews afwachten en als ik echte prestatie gerichte info wil moet ik nog langer wachten (tot iemand deze aanschaft en er uitbundig cache mee gaat testen).

Over de TRIM support had ik zelf nog niet nagedacht, is dit zo belangrijk in deze setup? En zoja, kan ik dit dmv een kunstje toch laten werken op de LSI (of manueel laten uitvoeren)? Mocht dit echt een probleem zijn, dan ga ik ook nog op zoek naar een ander moederbord dat dit wel ondersteund.

Dat zou idd ook nog een optie zijn, alleen is dit niet echt DATA veilig. Er is mij altijd verteld dat RAID geen backup is. Wat je voorstelt is een backup maken van de VM's op een datastore van een VM die raid draait. Zolang er niets misgaat met de 6x 3TB in Raidz2 is dit in orde, maar je kan dit niet 100% zeker weten.jadjong schreef op woensdag 27 maart 2013 @ 19:01:

[...]

Je kan backuppen via NFS naar je rz2pool. Bij een crash is freenas dan wel verdwenen, maar door die opnieuw te installeren en de pool te importeren ben je zo weer aan de gang. Als je de 3.5" schijf vervangt door twee 2.5" kan je ze in dezelfde ruimte proppen.

Het is een behoorlijke knutseloplossing die je maakt. Voor thuis geen probleem, maar zorg wel dat je alle handelingen onthoudt of opschrijft.

De oplossing van 2x 2,5" ipv 3,5" vind ik zelf ook niet mooi, zelfs voor een thuisoplossing. Dan zoek ik liever nog even verder naar een nieuwe case die mij aanspreekt en iets meer HD's kan huisvestigen. Zo kan er dan nog een HD bij als backup voor de VM's aangezien dit niet via USB gaat.

Dan nog een vraag dat bij me opkomt, jullie zeggen hier dat je TRIM niet kan activeren doordat je de onboard chip niet kan aanspreken binnen ESXI. Is het dan wel mogelijk om VM's aan te maken op een harde schijf die is aangesloten op deze onboard SATA poorten? Want als dit dan ook niet lukt, is de helft van mijn setup niet in orde, dan moet ik een kaart zoeken met meer dan 8 sata poorten op.Verwijderd schreef op woensdag 27 maart 2013 @ 18:36:

[...]

De problemen in je setup die ik zie:

1) je sluit de SSDs aan op de LSI SAS controller. Je wilt het liefste TRIM support hebben door de SSDs op de chipset SATA controller aan te sluiten. Is dat niet mogelijk in ESXi? Kun je bijvoorbeeld niet de Intel controller aan je ZFS VM geven terwijl je de ASMedia controller binnen ESXi gebruikt, ofzo?

Je kan uiteraard wel een disk/ssd aan de onboard controller hangen, en die gewoon gebruiken in ESXi. ESXi herkent gewoon een AHCI controller. Jouw setup is verder prima hoor, ik zou me over TRIM niet zo druk maken. Als je je daar heel erg druk over maakt, kan je ZIL en L2ARC altijd live detachen, daarna loskoppelen, en even in je desktop hangen en door de toolkit van de fabrikant heen halen, om hem even op te schonen. Ik heb hier een hele tijd met Intel Postville 80GB SSD's gewerkt, en nooit last van performance degradatie gehad.

Gewoon niet helemaal partitioneren, en het werkt allemaal prima. Die paar IOPS verschil ga je in de grote hoop niet merken. Er word hier nogal overdreven... Of je nou 2500 of 2400 IOPS haalt op je SSD, dat boeit allemaal geen zak, het is nog steeds 50 keer zo veel als een normale schijf.

Even niets...

Aangezien ik toch geen CD/DVD rom lezer nodig zal hebben eens alles draait, kan ik de 5.25" bay gebruiken om de extra harde schijf in te plaatsen.

Hiervoor zal ik dan zoiets moeten plaatsen:

http://www.alternate.be/html/product/Lian_Li/HD-532/981821/?

Zo kan de behuizing blijven en moet ik enkel nog de extra harde schijf kopen waar alle backup's van de VM's op komen.

Met dank aan jadjong voor het nieuwe prentje

[afbeelding]

Dan blijft enkel dus nog de vraag van welke SSD's, ik heb even gegoogeld voor de "Crucial M500" en deze komen in capaciteit beginnend bij 120GB. Dus ik vrees dat deze veel duurder zullen uitkomen dan de Intel 320 serie. Ook vraag ik me af of 120GB niet te veel is als cache opslag voor deze setup, aan de andere kant is het waarschijnlijk wel zo dat de Crucial M500 met SATA600 komen waar de Intel's nog met SATA300 zitten.

Is dit niet iets voor jou? kan je in totaal 15 3.5" hdd's kwijt. Of 10 als je de Internal 5.25" drive bay to four 2.5" drive bays ook wilt toepassen.Toon-VA schreef op donderdag 28 maart 2013 @ 00:26:

[...]

De oplossing van 2x 2,5" ipv 3,5" vind ik zelf ook niet mooi, zelfs voor een thuisoplossing. Dan zoek ik liever nog even verder naar een nieuwe case die mij aanspreekt en iets meer HD's kan huisvestigen. Zo kan er dan nog een HD bij als backup voor de VM's aangezien dit niet via USB gaat.

behuizing: Norcotek RPC-470

Opties:

Even niets...

Ik heb al een HP Quadport NIC NC364T liggen die ook in de setup zal komen. Hiermee wil ik aan link aggregation doen. De HP Procurve 1800-24G switch die ik gebruik ondersteund dit protocol, maakt het dan wel uit welke SATA ik dan heb?FireDrunk schreef op donderdag 28 maart 2013 @ 11:22:

SATAII vs SATAIII maakt voor ZIL weinig uit, en voor L2ARC ook maar sporadisch denk ik. Je zit toch vaak aan het limiet van je 1Gbit verbinding.

Als er 1 client naar de NAS aan het schrijven/lezen is wrs niet maar wat met meerdere clients tegelijkertijd?

Want dit is toch wat link aggregation doet, je creëert niet extra bandbreedte voor 1 client maar van zodra er meerdere client's tegelijkertijd bezig zijn wel.

Zelfs dan zijn het 2 verschillende streams, waardoor je maar moet hopen of je SSD zijn maximale snelheid haalt.

Maar ja, het kan uitmaken... Maar of je het merkt...

Even niets...

Is een Silencio 550 niet iets? 7x 3.5" intern + een 5-in-3 kom je op 12 stuks uit.Toon-VA schreef op donderdag 28 maart 2013 @ 11:34:

De Norco case is niet echt hetgeen ik zoek (U behuizing), ik hou het liever bij een gewone desktop behuizing. Maar toch bedankt voor de link, ik wou het zo klein mogelijk houden tot zover het mogelijk is.

Wanneer heb je het laatst je wachtwoord verandert? Er word op T.net de laatste tijd regelmatig misbruikt gemaakt van accounts met gelekte wachtwoorden om andere gebruikers op te lichten. Verander je wachtwoord, geef oplichters geen kans!

Hmm, als ik die 3,5" converter plaats in de LianLi is mijn probleem ook opgelost, zoals ik al zei wil ik het zo klein mogelijk houden en deze kast is toch weer iets groterLeo1010 schreef op donderdag 28 maart 2013 @ 12:25:

[...]

Is een Silencio 550 niet iets? 7x 3.5" intern + een 5-in-3 kom je op 12 stuks uit.

Als je het zo verteld maakt het idd weinig uit, dan lijkt me op dit moment de Intel 320 40GB de beste keuze voor mijn doel.FireDrunk schreef op donderdag 28 maart 2013 @ 11:53:

Als je meerdere clients tegelijk data levert, zou het in theorie kunnen, maar alleen als die mensen data direct uit het L2ARC cache ophalen.

Zelfs dan zijn het 2 verschillende streams, waardoor je maar moet hopen of je SSD zijn maximale snelheid haalt.

Maar ja, het kan uitmaken... Maar of je het merkt...

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 154,95 | € 154,95 |

| 1 | ASRock B75 Pro3-M | € 56,90 | € 56,90 |

| 2 | Seagate Barracuda 7200.14 ST2000DM001, 2TB | € 77,- | € 154,- |

| 6 | Seagate Barracuda 7200.14 ST3000DM001, 3TB | € 107,85 | € 647,10 |

| 1 | Lian Li PC-V354B | € 140,40 | € 140,40 |

| 2 | 3Ware 3Ware Multi-lane SATA cable CBL-SFF8087OCF-05M | € 16,- | € 32,- |

| 1 | Sandisk Cruzer Fit 4GB Zwart | € 5,08 | € 5,08 |

| 1 | HP NC364T PCI Express Quad Port Gigabit Server Adapter | € 234,74 | € 234,74 |

| 1 | Crucial Ballistix Sport BLS4C8G3D1609ES2LX0BEU | € 145,45 | € 145,45 |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 118,58 | € 118,58 |

| 1 | be quiet! Pure Power L8 530W | € 66,30 | € 66,30 |

| 2 | Intel 320 40GB | € 77,15 | € 154,30 |

| Bekijk collectie Importeer producten | Totaal | € 1.909,80 | |

De HP netwerkkaart heb ik al via 2dehands kunnen bemachtigen voor 100 euro, dus dat viel goed mee

Dan zal alles er zo gaan uitzien. Ik denk dat we nu elk probleem aangepakt hebben en dat de setup zo wel zal werken. Nu is het nog een zaak van aankopen en beginnen configureren.

Iedereen al bedankt voor de nuttige informatie en tips, mocht er nog iets over het hoofd zijn gezien laat het dan maar weten. Foto's van de build en configuratie komen van zodra ik er aan begin (er zullen toch nog vragen bovenkomen tijdes het bouwen

Even niets...

Verwijderd

Verder zou je kunnen overwegen een betere (zuinigere) voeding te nemen:

pricewatch: Seasonic G-Serie 450Watt (mogelijk wel meerdere rails; dat wil je vaak liever niet)

pricewatch: Seasonic Platinum Series 460 Watt Fanless

En heb je ook quad ports gigabit nodig? Die adapter is de helft van de prijs van een 10 gigabit adapter. Ik vind het erg duur.

Maar je moet een keer de knoop doorhakken, dat begrijp ik.

Jeps en daarom had ik dus de 330 serie gekozen. 60GB voor 66 euro dacht ik, het scheelt toch weeral 20 euro in de setup. Niet te vergeten dat de 320 serie dan ook nog eens SATAII is en de 330 serie SATA III. Het enige nadeel was de controller en geen supercaps (wat jullie me verteld hebben).FireDrunk schreef op donderdag 28 maart 2013 @ 20:10:

Jeetje, kosten die Intel 320's echt 77 euro... das best duur.

Ik denk dat die SSD's in het begin toch nog redelijk duur gaan zijn en ze gaan sowieso al meer kosten aangezien ze pas beginnen aan de capaciteit van 120GB. Wachten tot ze in prijs zakken zal ook niet onmiddellijk op 1-2-3 gebeuren vrees ik.Verwijderd schreef op donderdag 28 maart 2013 @ 20:17:

Waarom wacht je niet even met SSDs totdat de M500 leverbaar is? Dat zou een goed alternatief zijn. Heb je voor iets meer geld gelijk 120GB ipv 40GB en kun je daarvan 80GB gebruiken ofzo met dus 33% overprovisioning. Lijkt mij een uitstekende keus.

De Fanless PSU valt zeker al af aangezien deze 100€+ kost. Dan betaal ik liever iets meer voor de energierekeningVerder zou je kunnen overwegen een betere (zuinigere) voeding te nemen:

pricewatch: Seasonic G-Serie 450Watt (mogelijk wel meerdere rails; dat wil je vaak liever niet)

pricewatch: Seasonic Platinum Series 460 Watt Fanless

En heb je ook quad ports gigabit nodig? Die adapter is de helft van de prijs van een 10 gigabit adapter. Ik vind het erg duur.

Maar je moet een keer de knoop doorhakken, dat begrijp ik.

Ik heb hem hier al liggen en is al getest in een oude PC. Nieuw zou ik hem absoluut niet gekocht hebben daarom op 2dehands liggen rondneuzen.Toon-VA schreef op donderdag 28 maart 2013 @ 19:57:

[...]

De HP netwerkkaart heb ik al via 2dehands kunnen bemachtigen voor 100 euro, dus dat viel goed mee

Zat voor de gein eens te spelen in Pricewatch, de setup die ik over aantal jaar wil draaien scheelt niet veel.

[ Voor 11% gewijzigd door Dennisik op 28-03-2013 22:52 ]

Wat bedoel je precies daarmee?Verwijderd schreef op donderdag 28 maart 2013 @ 20:17:

pricewatch: Seasonic G-Serie 450Watt (mogelijk wel meerdere rails; dat wil je vaak liever niet)

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

Als dit beeld niet correct is, dan graag correctie. Maar zo heb ik het begrepen.

Sowieso niet perse drie, één, twee, drie, vier, vijf, zes het komt allemaal voor en ik ben er vrij zeker van dat drie niet het meeste is, dat zal één of twee zijn waarschijnlijk, maar dat maakt ook niet uit. Is gewoon een keuze van de fabrikant.Verwijderd schreef op donderdag 28 maart 2013 @ 23:52:

Dat high-end voedingen vaak drie aparte +12V rails hebben die afzonderlijk vermogen kunnen leveren.

Zo wordt het gelukkig nooit verdeelt, dit zou namelijk betekenen dat je voeding bij lange na niet volledig kan belasten. Trek je bijvoorbeeld 21A van één van de drie rails en van de andere twee maar 1A zal de voeding uitschakelen zonder dat er ook maar iets van nut zou hebben. Je belast de voeding immers nog niet eens voor de helft.De 60 ampère of wat dan ook is dan eigenlijk verdeeld in 3x 20 zo heb ik begrepen.

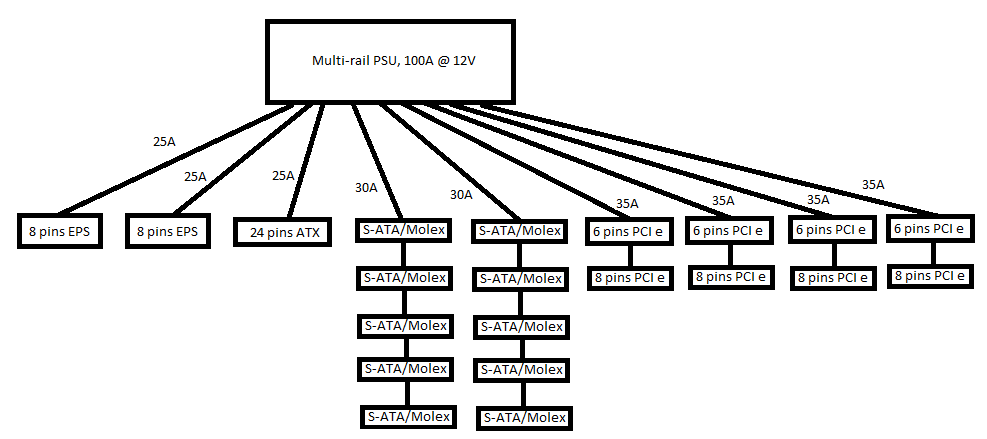

Een tijdje terug heb ik een plaatje gemaakt voor iemand die het ook niet helemaal snapte en dacht dat single rail veel beter is.

Hier zie je een afbeelding van hoe je bijvoorbeeld een goede multirail voeding eruit zou kunnen zien. Bij zo'n voeding zal je nooit een rail op normale wijze kunnen overbelasten, zelf niet met extreem overklokken. Maar je hebt wel de veiligheid van een multirail voeding. Was het een single rail voeding geweest van 100A en je had kortsluiting dan zou de kortsluitstroom prima minder dan 100A kunnen zijn. De voeding zal dus niet uitschakelen en alles gaat dus lekker smelten en branden. Je zou wel eens je hele PC of huis met veel pech kwijt kunnen zijn.

Nu over de Seasonic G-series 450W t/m 650W (360W is een ander design). Deze voedingen kunnen sowieso geen drie 12V rails hebben. De IC in deze voedingen die de beveiligingen verzorgt de PS223 ondersteund namelijk maar maximaal twee. Nu is dit IC alleen niet genoeg om de stroom te meten, meestal worden er shunts samen met zo'n IC gebruikt, maar ik kan ze niet vinden op het PCB. Dat zou dus betekenen dat het een single rail voeding is, maar zeker ben ik er niet van. Maar al was het dat niet, ik denk niet dat je last van het multirail gedeelte zal hebben omdat Seasonic de maximale stroom van één vast meer dan hoog genoeg heeft gezet tegen ongewenste shutdowns.Eén rail zou helemaal voor CPU zijn. De andere voor videokaart (de 6/8-polige +12V stekkers). Blijft dan over één rail voor je hardeschijven. En heel veel schijven opspinnen met 20A kan veel te weinig zijn. Daarom zou iemand de Corsair 600W aanraden (weet geen type uit mijn hoofd) omdat die alle +12V ampère op één rail kan leveren. En zo zullen er meer voedingen zijn die alle +12V op één rails heeft, wat wenselijk zou zijn voor een NAS met veel schijven.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

Maar mijn vraag is, geldt dat voor alle voedingen? Of zijn er ook voedingen waar er 2 of 3 rails zijn die echt maar beperkt vermogen kunnen leveren? Want dat meen ik toch regelmatig tegengekomen te zijn. Als dat helemaal niet klopt wil ik dat graag weten natuurlijk.

Bedankt voor je inzichten zover.

Er is enkele jaren terug wel eens één (of een paar meer) design geweest van FSP waarbij de hoeveelheid ampère op één 12V rail wel erg beperkt werd met 20A. Maar dat is al weer een aantal jaren terug, is iig niet iets waar je je zorgen over hoeft te maken bij een moderne goede voeding zoals de Seasonic.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Verwijderd

Ik heb nog wat vragen, maar dat komt wel een keer in het juiste topic.

Kort overzicht: Xeon E5-2620, 48GB ram, 8x4TB en 8x2TB

Even niets...

Ik moet sowieso nog even kijken of het powermanagement van de cpu wel goed gaat.

Moet wel vermelden dat deze waardes uit mijn voeding komen (Corsair AX860i Digital ATX). Hoe precies deze is durf ik niet te zeggen.

[ Voor 20% gewijzigd door DYX op 29-03-2013 11:08 ]

Even niets...

[ Voor 11% gewijzigd door analog_ op 29-03-2013 14:11 ]

Na het topic al een beetje te hebben doorgespit en al een stuk wijzer te zijn geworden heb ik toch nog een vraag.

Ik zal eerst de situatie uitleggen.

Momenteel een server (Intel G620, H67 Bordje, 4g memory, Be quiet! 300w voeding, Lian Li PC-Q25B) met daarin:

- 1 maal 1TB Schijf

- 3 maal 2 TB Schijf

- 1 maal 3 TB Schijf

De oude server word verkocht zonder de schijven dus ga een nieuwe kopen.

- Ik wil de 3 x 2 TB schijven mee nemen en in RaidZ1 gaan draaien.

- Daarnaast de 3TB gebruiken en erbij 5 TB schijven kopen om deze in RaidZ2 te laten draaien. Is het eigenlijk erg als de schijven 5 X Seagate Barracuda 7200.14 ST3000DM001, 3TB zijn en 1 ervan een WD Green 3TB? Anders koop ik gewoon 1 extra Seagate.

- De 1 TB heb ik nog geen bestemming voor maar miss via ESXI een VM om daar eens wat wijzer in te worden.

Mijn nieuwe configuratie:

- I5 3330 Boxed

- Asrock B75 Pro3-m

- 4x 8GiB DDR3 (welke weet ik nog niet)

- IBM ServeRAID M1015 (omdat er op het begin al 9 schijven inkomen en later nog 1/2 SSD(s) bij)

- Seasonic G-Serie 450Watt

- Kast ben ik nog naar aan t kijken

De boot van ZFSGuru zal dus eerst via een USB-Stick gebeuren en later als de SSD's zijn tegevoegd en dan (misschien) ESXI vanaf de SSD's. ESXI is dus totaal geen must en als ik beter zonder dat kan werken hoor ik t graag.

Mijn vraag is dus wat ik het beste kan doen:

- L2ARC en ZIL? of alleen L2ARC? Wat is voor mij interresant?

- en 1 SSD of 2 SSD's?

- en kan ik deze later gewoon toevoegen?

Mvg,

Wesley Vinken

http://blog.cyberexplorer...m-network-throughput.html

Vandaag mijn Windows 2003 fileserver onder handen genomen.

Deze was voorzien van een Highpoint RR 2340, met 9x 1TB.

Eerst alle data backupped, en daarna het moederbord met cpu en geheugen vervangen door:

- ASrock B75 Pro3-M

- Intel E2020

- 2x4GB 1066 kingston mem.

8x 1TB aangesloten, en viel me direct op dat 1 HDD niet herkend werd.

Deze was mooi overleden!

Best bizar dat ik hier nooit melding van heb gekregen van de rocketraid controller in windows...

Anyway, ik heb deze nu vervangen voor een 1,5TB disk.

Ik kan nu alleen nergens vinden hoe ik een raidZ volume van 8x1TB kan maken, en de overgebleven 500GB in een eigen volume kan stoppen als download buffer.

Kan iemand mij een handje op weg helpen?...

8.960 Wp - 16 kW Daikin L/W - 2 x MHI L/L - gasloos sinds 2017 - Loxone - SAP/IS-U/ABAP - rijdt nog LPG ;-)

Totaal niet precies.DYX schreef op vrijdag 29 maart 2013 @ 11:06:

Moet wel vermelden dat deze waardes uit mijn voeding komen (Corsair AX860i Digital ATX). Hoe precies deze is durf ik niet te zeggen.

Bitfenix Whisper 450W review

[PSU] Voeding advies en info

AMD Nieuwsdiscussie

AMD Radeon Info en Nieuwsdiscussietopic

Je kunt er niet zo op vertrouwen als op een knappe energiemeter.

Hoewel het vast mogelijk is, moet je je afvragen of je dit wil.. Als je de data van je buffer naar het grote volume wil verplaatsen, moet de kop van die ene disk de hele tijd heen en weer van de 500 GB naar de 1 TB, waardoor je leessnelheid instort. Zelf heb ik een 5400 rpm laptopschijfje als buffer. (zodat de array kan downspinnen) Die is trager, maar hoeft niet constant te seeken en die haalt rond de 60 MB/s bij sequentieel lezen.Extera schreef op vrijdag 29 maart 2013 @ 16:13:

Anyway, ik heb deze nu vervangen voor een 1,5TB disk.

Ik kan nu alleen nergens vinden hoe ik een raidZ volume van 8x1TB kan maken, en de overgebleven 500GB in een eigen volume kan stoppen als download buffer.

Kan iemand mij een handje op weg helpen?...

Unix doesn't prevent a user from doing stupid things, because that would necessarily prevent them from doing brilliant things.

while true ; do echo -n "bla" ; sleep 1 ; done

In dit topic bespreken we de hardwarematige kant van het bouwen van een NAS. Vragen en discussies die betrekking hebben op de softwarematige kant, dien je elders te stellen. Zo is het ZFS topic de juiste plek voor vragen over ZFS maar ook over softwareplatformen zoals FreeNAS, NAS4Free, ZFSguru en andere softwareplatforms die met ZFS werken.

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_icc():strip_exif()/u/329168/crop57d44c3214202_cropped.jpeg?f=community)

:strip_exif()/u/17028/ico_sphere.gif?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_exif()/u/19853/Goku1.gif?f=community)

:strip_exif()/u/8077/jerney.gif?f=community)

:strip_icc():strip_exif()/u/2985/compaqtux.jpg?f=community)

/u/299686/crop571ff6b90e9c4_cropped.png?f=community)

/u/820/crop5dc1821dada95_cropped.png?f=community)

:strip_icc():strip_exif()/u/146731/crop562615a0aa64c.jpeg?f=community)

:strip_icc():strip_exif()/u/300768/profile2.jpg?f=community)

/u/170728/owl.png?f=community)

/u/327851/crop5aab95025cb0f_cropped.png?f=community)

:strip_icc():strip_exif()/u/20047/neptunus.jpg?f=community)

:strip_exif()/u/128173/crop59a1592e54731_cropped.gif?f=community)

:strip_icc():strip_exif()/u/307988/crop5d386ba3e3a93_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/240280/5.jpg?f=community)