Ah, zeker interessant. Niet naar asrock gekeken, deed mij niet direct aan zuinig denken. Dank!mux schreef op woensdag 03 oktober 2012 @ 17:26:

What about de Asrock B75 Pro3-M? 8xSATA, zuinig, geweldig EFI.

Zie ook m'n BBG zuinige NAS: mux' blog: Mux' vragenuurtje 07-09-2012: BBG Zuinige NAS

Mux, die 2x SATA extra is wel via een extra chipje (2 x SATA3 6.0 Gb/s connectors by ASMedia ASM1061, support NCQ, AHCI and Hot Plug functions). Volgens mij niet zo geschikt met ZFS (I'm not sure) maar ook onzuiniger door die chip.mux schreef op woensdag 03 oktober 2012 @ 17:26:

What about de Asrock B75 Pro3-M? 8xSATA, zuinig, geweldig EFI.

Zie ook m'n BBG zuinige NAS: mux' blog: Mux' vragenuurtje 07-09-2012: BBG Zuinige NAS

Als je eenmaal 8 HDDs aan je mobo hebt hangen zal die 0.5W extra van de ASMedia chip niet meer zoveel uitmaken

Wat betreft compatabiliteit: als je ZFS gebruikt heb je niet zoveel te maken met native support, het enige wat je nodig hebt is AHCI en dat werkt prima met die chip. Dit bord is bovendien al her en der (zie blog) met succes toegepast in NASen.

Wat betreft compatabiliteit: als je ZFS gebruikt heb je niet zoveel te maken met native support, het enige wat je nodig hebt is AHCI en dat werkt prima met die chip. Dit bord is bovendien al her en der (zie blog) met succes toegepast in NASen.

Ik gebruik ook het ASRock B75 Pro3-M bord en heb hier 6x een WD 3TB aan hangen en een 128GB SSD. De SSD hangt aan de eerste SATA3 poort (die gaat niet via de ASMedia chipset) en dat wordt ook aangeraden door ASRock. Van de overige 6 harddisks hangen er 5 aan de SATA2 poorten en de laatste aan een SATA3 poort via de ASMedia chip.

De 6 harddisks vormen een RAIDZ2 en ik heb hier nog geen problemen bij gevonden in de bijna 2 weken dat het systeem draait.

En ja, ik moet nog steeds een keer gaan meten wat het verbruik van m'n oude en deze nieuwe server is.

De 6 harddisks vormen een RAIDZ2 en ik heb hier nog geen problemen bij gevonden in de bijna 2 weken dat het systeem draait.

En ja, ik moet nog steeds een keer gaan meten wat het verbruik van m'n oude en deze nieuwe server is.

Ik ben zelf opzoek naar een zuinige krachtpatser. Mijn bedoeling is om de server te gebruiken als backup/file/webserver met daarnaast enkele VM's met daarop: SharePoint 2010 en SharePoint 2013 (Hoeft niet perse tegelijk te draaien).

Ik kom zelf uit op de volgende configuratie:

Zijn er nog ideeen/tips? Dingen die zuiniger/goedkoper kunnen?

Ik kom zelf uit op de volgende configuratie:

| # | Product | Prijs | Subtotaal |

| 1 | Seagate Barracuda 7200.14 ST2000DM001, 2TB | € 84,39 | € 84,39 |

| 1 | Intel Core i5 3470 Boxed | € 170,50 | € 170,50 |

| 1 | be quiet! Pure Power L7 300W | € 36,- | € 36,- |

| 1 | Corsair CMV16GX3M2A1333C9 | € 59,48 | € 59,48 |

| 1 | Asrock B75 Pro3-M | € 60,30 | € 60,30 |

| Bekijk collectie Importeer producten | Totaal | € 410,67 | |

Zijn er nog ideeen/tips? Dingen die zuiniger/goedkoper kunnen?

Zal windows server 2012 met Hyper -V worden denk ik. En dan op de host de backup/file/webserver en dan op een of meerdere VM's SharePoint.

Voor SharePoint geldt dat dit geen productie omgevingen worden. Alleen test/develop.

Voor SharePoint geldt dat dit geen productie omgevingen worden. Alleen test/develop.

Meerdere VM's op 1 2TB disk word niet echt snel... Je zou misschien een SSD kunnen overwegen, en de data disks van je VM's op die 2TB disk zetten. (of eventueel alles op SSD, maar dat kost wat meer geld).

Even niets...

Hmmmm, mux gaat plotseling hard.

Nog steeds tweede, maar het verschil met de eerste is nog maar een stem of 30 sinds een paar dagen...

Nog steeds tweede, maar het verschil met de eerste is nog maar een stem of 30 sinds een paar dagen...

Material 3 Thema's voor HA | Swiss Army Knife custom card voor HA | AmoebeLabs

Het zijn twee sprintjes dankzij zijn blog. Het probleem is dat er nog altijd geen uitspraak is gedaan over het stemmen vanuit het buitenland. Een dergelijke situatie, een gebrek aan een duidelijke uitspraak, is de vervelendste van allemaal. Ga je nu ook maar uit het buitenland stemmen trekken of blijf je volgens de regels spelen, terwijl je een sterke aanwijzing hebt dat een concurrent (ik wil niet zeggen de grootste), dit niet doet.

Maar goed, de weg is nog lang, nog iets meer dan een maand. Te vroeg pieken is sowieso niet handig. Het is wel handig om een aantal speelkaarten in je mouw te stoppen. Hopelijk kan mux dan begin november die topkaarten neerleggen om de prijs definitief binnen te slepen. (En nog altijd oog te houden voor de alternatieve optie.) Hopelijk gaat het lukken. MADpsu zou zeker voor mensen die in deze topic rondlopen een interessant product zijn.

Maar goed, de weg is nog lang, nog iets meer dan een maand. Te vroeg pieken is sowieso niet handig. Het is wel handig om een aantal speelkaarten in je mouw te stoppen. Hopelijk kan mux dan begin november die topkaarten neerleggen om de prijs definitief binnen te slepen. (En nog altijd oog te houden voor de alternatieve optie.) Hopelijk gaat het lukken. MADpsu zou zeker voor mensen die in deze topic rondlopen een interessant product zijn.

Idd! En ik ben er zeker van dat hij nog een paar dingen achter de hand heeft.Mars Warrior schreef op donderdag 04 oktober 2012 @ 12:20:

Hmmmm, mux gaat plotseling hard.

Nog steeds tweede, maar het verschil met de eerste is nog maar een stem of 30 sinds een paar dagen...

Voor mij is die overwinning al binnen, ik verlekker me al wat!

Zou iemand mij nog aan/opmerkingen kunnen geven over mijn htpc/nas

bedankt

| # | Product | Prijs | Subtotaal |

| 1 | Asrock H77 Pro4-M | € 71,10 | € 71,10 |

| 1 | Intel Pentium G860 Boxed | € 62,45 | € 62,45 |

| 1 | Scythe Big Shuriken 2 Rev. B | € 32,30 | € 32,30 |

| 1 | Kingston ValueRAM KVR1333D3N9/4G | € 15,95 | € 15,95 |

| Bekijk collectie Importeer producten | Totaal | € 181,80 | |

bedankt

Verwijderd

Topicwaarschuwing niet gelezen? Daarnaast mis je onderdelen en geef je geen enkele eisen waar aan het systeem moet voldoen.

Interessante combinatie, je mist wel essentiële elementen en ik mis een beetje de potentie voor ons om op te bouwen, maar wel een leuke smiley. Sorry...volgende keer beter.

Thanks...-The_Mask-....

Thanks...-The_Mask-....

[ Voor 15% gewijzigd door Dadona op 04-10-2012 16:42 ]

MSI z77a-g45 is ook een optie. Een stuk goedkoper dan de Z77A-GD65, en nog steeds 3 PCIe x16 slots (8x(Gen3),8x(Gen3),4x(Gen2)), als ik het goed heb. Ik gebruik dit bord in mijn workstation, erg zuinig.audiojunk schreef op maandag 01 oktober 2012 @ 13:51:

[...]

Dat bord is inderdaad wel zuinig volgens diverse testen,maar daar betaal je dan ook voor.

tHe_BiNk in "Nieuwe Zuinige Server (discussie)"

Soms hebben moederborden een bios update nodig om met bepaalde PCIe (raid) kaarten om te kunnen gaan. Tegenwoordig zullen dit soort problemen, niet vaak tegenkomen. Maar er is een kleine kans dat een bepaalde kaart het niet doet. Je kan er iig van te voren weinig over zeggen of het 100% werkt.Verwijderd schreef op woensdag 03 oktober 2012 @ 12:21:

[...]

Dat zou moeten zijn, maar er zijn toch wel een aantal gevallen bekend dat het niet zo is.

[ Voor 35% gewijzigd door tHe_BiNk op 05-10-2012 08:02 ]

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

Hallo allemaal!

Vinden jullie dat ik mijn vraag in dit topic moet stellen, of dat het in een eigen topic hoort?

(en ja, jullie mogen ook antwoord geven op de vraag die in het topic gesteld wordt )

)

Vinden jullie dat ik mijn vraag in dit topic moet stellen, of dat het in een eigen topic hoort?

(en ja, jullie mogen ook antwoord geven op de vraag die in het topic gesteld wordt

Hier. Het gaat in deze topic zeer zeker niet om het behalen van het laagste verbruik ten koste van alles. Primair blijft dat de samenstelling passend is voor de load en dat uiteindelijk de meest efficiënte samenstelling wordt gevonden. Anders had de de facto standaard hier het equivalent van een Raspberry Pi geweest en had iedereen met meer dan twee HDDs een ban gehad. (Laatste is nog altijd de natte droom van sommigen hier, maar dat is iets anders.)

Om je vraag even te beantwoorden: is opwaarderen van het geheugen een mogelijkheid? Energiezuinig is een ding, maar je wilt ook geen goede hardware zomaar weggooien.EgMaf schreef op vrijdag 05 oktober 2012 @ 09:08:

Hallo allemaal!

Vinden jullie dat ik mijn vraag in dit topic moet stellen, of dat het in een eigen topic hoort?

(en ja, jullie mogen ook antwoord geven op de vraag die in het topic gesteld wordt)

Je geeft niet aan wat het huidige verbruik is, zo is het lastig om aan te geven wat de mogelijke besparingen kunnen zijn en wat je daarvoor moet investeren...EgMaf schreef op vrijdag 05 oktober 2012 @ 09:08:

Hallo allemaal!

Vinden jullie dat ik mijn vraag in dit topic moet stellen, of dat het in een eigen topic hoort?

(en ja, jullie mogen ook antwoord geven op de vraag die in het topic gesteld wordt)

Verder, maar dat is mijn mening, ontgaat het mij waarom je alles in een aparte VM wilt hebben. Ik had voorheen op WHS1 ook alles zo in VM's, maar draai nu alles direct op WHS2011. Ik zag geen enkele reden meer om bijv. Sabnzbd in een aparte VM te draaien. Draait nu simpelweg als service en performed ook nog eens beter.

Ook heeft WHS2011 ook goede remote desktop mogelijkheden, incl. doorloggen naar andere PC's in je netwerk. En als je dat niet wil zijn er genoeg alternatieven als logmein, teamviewer, etc.

Material 3 Thema's voor HA | Swiss Army Knife custom card voor HA | AmoebeLabs

Sorry voor de late reactie: Ik was vergeten dat een topic hier niet automatisch bij de bookmarks komt als je erin gepost hebt. En voor de volledigheid, hier even de vraag uit het andere topic:

De oude hardware gaat hergebruikt worden als pure backup / storage server, en misschien voor wat Hyper-V migratie testjes. Daarmee zal een oude (en slurpende) Q6600 eindelijk uitgezet worden.

En inderdaad, ik ken mezelf en experimenteer veel te graag op lopende systemen. Vanwege de WAF zet ik het liever in losse VMs, zodat een experiment aan de ene kant niet teveel kapot maakt aan de andere kant

Inmiddels ben ik wat dieper gaan kijken naar de HP Proliants ML150G6, ML310 Gen8 (net nieuw, alleen nog in de VS) en ML350e Gen8. Maar het lijkt erop dat je daarbij altijd hot-swappable moet gaan als je meer dan 4 schijven wilt, en je daarvoor (dure) hot-swap driveboxes (die dus om elke individuele schijf gaan) moet kopen.

@Parody & Mars Warrior:EgMaf schreef op vrijdag 05 oktober 2012 @ 00:53:

Ik wil een servertje thuis gaan neerzetten (ter vervanging van wat oud spul), en vraag me af wat ik het beste kan doen.

Allereerst: Waar gaat het voor gebruikt worden?Mij lijkt 6 of 8 cores dus wel noodzakelijk, en toch ook minimaal 12-16 GB RAM.

- Windows Server 2012 als Hyper-V host, met daarop clients voor:

- Windows Home Server 2011 (of Windows Server 2012 Essentials later), vooral ten behoeve van client-backups en gedeelde, streaming media (incl. 10+GB .mkv files)

- Windows 8 client voor downloads en post-processing

- Windows 8 client voor remote toegang tot mijn huis netwerkje van buitenaf (ja, liefst via een aparte VM)

- Af en toe eens een test-VM (zoals nu voor WS2012E of pas nog Windows 8 Betas)

Ook zal 6 (liefstschijven noodzakelijk zijn. RAID is niet nodig omdat ik liever WS2012 Storage Spaces gebruik (+ externe iSCSI backup).

Momenteel draait het op een AMD X6 met 8GB, maar daarbij loop ik af en toe toch wel tegen de grenzen aan (vooral van die 8GB). Dus wat is tegenwoordig goede hardware hiervoor? Prestaties moeten voldoende zijn voor thuis-gebruik (incl WAF bij het streamen van de media).

Ik heb al bij HP (Proliant ML330/350) en Lenovo (niet echt een goede optie gevonden) gekeken, maar ik vrees bij dat sort merken toch voor onnodig hoge kosten (dure drive bays, Xeon processoren, duur geheugen) en compatabiliteitsproblemen met mijn bestaande SATA drives.

De oude hardware gaat hergebruikt worden als pure backup / storage server, en misschien voor wat Hyper-V migratie testjes. Daarmee zal een oude (en slurpende) Q6600 eindelijk uitgezet worden.

En inderdaad, ik ken mezelf en experimenteer veel te graag op lopende systemen. Vanwege de WAF zet ik het liever in losse VMs, zodat een experiment aan de ene kant niet teveel kapot maakt aan de andere kant

Inmiddels ben ik wat dieper gaan kijken naar de HP Proliants ML150G6, ML310 Gen8 (net nieuw, alleen nog in de VS) en ML350e Gen8. Maar het lijkt erop dat je daarbij altijd hot-swappable moet gaan als je meer dan 4 schijven wilt, en je daarvoor (dure) hot-swap driveboxes (die dus om elke individuele schijf gaan) moet kopen.

Even iets anders dan keuze van hardware...de inzet ervan en dan een relatief grote verspiller, harde schijven.

Het gaat mij om een 'Hierarchical storage management'-like oplossing. De gedachte hierbij is om files slimmer op te slaan in een omgeving met verschillende opslagmedia (SSDs / 2,5" HDDs / 3,5" HDDs en deze verschillende schijven in single of raid opstellen). Een file die vaak wordt geraadpleegd plaats je op die enkele 2,5" of 3,5". Files die bijna niet worden geraadpleegd, maar niet mogen worden weggegooid worden op de Raid6 / Raidz2 met tig schijven geplaatst. En je kunt hier nog verder in gaan door ook te kijken naar de vereiste snelheid.

Waarom je dit wil? Al die verzamelaars van series hebben laten we zeggen twintig series ergens opgeslagen. Maar de laatste tijd bekijken ze er maar twee. Zou het dan niet handig zijn als het systeem het patroon doorheeft en de afleveringen van die twee series automatisch naar de single disc kopieert? (Inclusief de afleveringen die nog niet zijn bekeken uiteraard.) Als éénling (/niet luie persoon) kun je het ook handmatig doen, maar anders wil je dit toch wel automatisch laten regelen. (Bijkomend voordeel dat je dan een database hebt die klopt.) De array met meerdere schijven kan dan uitblijven (en al helemaal niet aanblijven tijdens het afspelen).

Welnu, zoals ook in de Wiki valt te lezen zijn er implementaties, maar de prijs wil nog wel eens tegenvallen. IBMs Tivoli zit bijvoorbeeld boven de 4000 euro. Voor bedrijven goed te verantwoorden, zeker als je een groot datacentrum hebt. Maar laten we wel wezen, het merendeel van de mensen hier heeft niet zoveel schijven en zeker niet zoveel budget over voor software. (Los van dat het in dit specifieke geval voor NTFS is, dus velen zullen meteen moeten hacken...)

Lang verhaal kort, is er iemand een interessante Hierarchical storage management implementatie tegengekomen voor de hobbyisten onder ons? Of gaat dit een leuk community gevalletje worden van het opzetten van een leuk script?

Of gaat dit een leuk community gevalletje worden van het opzetten van een leuk script?

(En ik weet dat ZFS features heeft wat caching betreft maar dat werkt op block basis en dekt maar een deel van de case af. En handmatig verplaatsen kan wel, maar je hebt het liefst iets van een automatisch proces dat op de achtergrond van alles doet.)

Het gaat mij om een 'Hierarchical storage management'-like oplossing. De gedachte hierbij is om files slimmer op te slaan in een omgeving met verschillende opslagmedia (SSDs / 2,5" HDDs / 3,5" HDDs en deze verschillende schijven in single of raid opstellen). Een file die vaak wordt geraadpleegd plaats je op die enkele 2,5" of 3,5". Files die bijna niet worden geraadpleegd, maar niet mogen worden weggegooid worden op de Raid6 / Raidz2 met tig schijven geplaatst. En je kunt hier nog verder in gaan door ook te kijken naar de vereiste snelheid.

Waarom je dit wil? Al die verzamelaars van series hebben laten we zeggen twintig series ergens opgeslagen. Maar de laatste tijd bekijken ze er maar twee. Zou het dan niet handig zijn als het systeem het patroon doorheeft en de afleveringen van die twee series automatisch naar de single disc kopieert? (Inclusief de afleveringen die nog niet zijn bekeken uiteraard.) Als éénling (/niet luie persoon) kun je het ook handmatig doen, maar anders wil je dit toch wel automatisch laten regelen. (Bijkomend voordeel dat je dan een database hebt die klopt.) De array met meerdere schijven kan dan uitblijven (en al helemaal niet aanblijven tijdens het afspelen).

Welnu, zoals ook in de Wiki valt te lezen zijn er implementaties, maar de prijs wil nog wel eens tegenvallen. IBMs Tivoli zit bijvoorbeeld boven de 4000 euro. Voor bedrijven goed te verantwoorden, zeker als je een groot datacentrum hebt. Maar laten we wel wezen, het merendeel van de mensen hier heeft niet zoveel schijven en zeker niet zoveel budget over voor software. (Los van dat het in dit specifieke geval voor NTFS is, dus velen zullen meteen moeten hacken...)

Lang verhaal kort, is er iemand een interessante Hierarchical storage management implementatie tegengekomen voor de hobbyisten onder ons?

(En ik weet dat ZFS features heeft wat caching betreft maar dat werkt op block basis en dekt maar een deel van de case af. En handmatig verplaatsen kan wel, maar je hebt het liefst iets van een automatisch proces dat op de achtergrond van alles doet.)

[ Voor 49% gewijzigd door Dadona op 05-10-2012 17:04 ]

ik denk dat je de vraag hierover beter in OM kan stellenDadona schreef op vrijdag 05 oktober 2012 @ 16:32:

Lang verhaal kort, is er iemand een interessante Hierarchical storage management implementatie tegengekomen voor de hobbyisten onder ons?Of gaat dit een leuk community gevalletje worden van het opzetten van een leuk script?

(En ik weet dat ZFS features heeft wat caching betreft maar dat werkt op block basis en dekt maar een deel van de case af. En handmatig verplaatsen kan wel, maar je hebt het liefst iets van een automatisch proces dat op de achtergrond van alles doet.)

ora et labora

project zuinige server is geslaagd

FX16 in "Nieuwe Zuinige Server (discussie)"

Met de Coolermaster I green power voeding van 430 watt ( powerfactor gemiddeld 0.79 ) 50 watt in bedrijf met de webradio draaiend en enkel de laptop schijf aangesloten

Heb verder niks meer met die voeding gedaan, met enkel de groene draad naar de massa verbonden stond er al 17 watt op de meter , slecht , slecht..."moven" met dat ding

Ik heb er nu een voeding van 250 watt uit een compaq desktop ( powerfactor gemiddeld zo rond 0.93 ) en die wil een heel eind beter ( type komt nog , )

5 watt eigen verbruik, nog niet je van het maar het plaatje komt nu wel in de richting van de 30 watt die ik nastreef.

35.6 watt in bedrijf met de webradio draaiend ( alle 4 de cores op 1600 MHZ met 0.97 V )

49 watt met de 2 samsung 2 TB schijven opgespind

64 watt , met een OCCT test ( ex GPU ) met alle schijven opgespind.

80 watt piek belasting tijdens het inschakelen ( opspinnen harde schijven ) , daar schrok ik echt van , dat zijn heel wat extra amperes die een pico PSU niet had kunnen leveren.

Ik heb een offset van -50mv op de CPU en op de GPU ingesteld, ik moet nog even kijken of dat verder omlaag kan .

USB3 controller uitgezet , onboard audio uitgezet.

Speedfan regelt de CPU fan , voor de rest gebruik ik geen fans

De fan draait in normaal bedrijf altijd op de laagste stand en is bijna onhoorbaar ( cheap ass koelertje )

Het systeem heeft flink wat power met die 4 cores en dat merk je met het starten van RDP , het is super smooth!

Ook grote bestanden overzetten via het netwerk gaat heel snel , ik haal 94% van de gigabit ( router Dlink Dir 655 )

Met de oude server ( die trouwens tegen de 80 watt verbruikte) had ik bij zwaar netwerkgebruik problemen met de webradio die begon te stotteren ondanks het instellen van proces priority in windows 7

mission accomplished

FX16 in "Nieuwe Zuinige Server (discussie)"

Met de Coolermaster I green power voeding van 430 watt ( powerfactor gemiddeld 0.79 ) 50 watt in bedrijf met de webradio draaiend en enkel de laptop schijf aangesloten

Heb verder niks meer met die voeding gedaan, met enkel de groene draad naar de massa verbonden stond er al 17 watt op de meter , slecht , slecht..."moven" met dat ding

Ik heb er nu een voeding van 250 watt uit een compaq desktop ( powerfactor gemiddeld zo rond 0.93 ) en die wil een heel eind beter ( type komt nog , )

5 watt eigen verbruik, nog niet je van het maar het plaatje komt nu wel in de richting van de 30 watt die ik nastreef.

35.6 watt in bedrijf met de webradio draaiend ( alle 4 de cores op 1600 MHZ met 0.97 V )

49 watt met de 2 samsung 2 TB schijven opgespind

64 watt , met een OCCT test ( ex GPU ) met alle schijven opgespind.

80 watt piek belasting tijdens het inschakelen ( opspinnen harde schijven ) , daar schrok ik echt van , dat zijn heel wat extra amperes die een pico PSU niet had kunnen leveren.

Ik heb een offset van -50mv op de CPU en op de GPU ingesteld, ik moet nog even kijken of dat verder omlaag kan .

USB3 controller uitgezet , onboard audio uitgezet.

Speedfan regelt de CPU fan , voor de rest gebruik ik geen fans

De fan draait in normaal bedrijf altijd op de laagste stand en is bijna onhoorbaar ( cheap ass koelertje )

Het systeem heeft flink wat power met die 4 cores en dat merk je met het starten van RDP , het is super smooth!

Ook grote bestanden overzetten via het netwerk gaat heel snel , ik haal 94% van de gigabit ( router Dlink Dir 655 )

Met de oude server ( die trouwens tegen de 80 watt verbruikte) had ik bij zwaar netwerkgebruik problemen met de webradio die begon te stotteren ondanks het instellen van proces priority in windows 7

mission accomplished

Erg netjes voor een bak met zoveel schijven. Zit zelfs nog onder het target van m'n zuinige NAS BBG.

Op samenkopen.net houd ik nu een animocheck voor een tweede batch mSATA naar SATA-adapters. Ik weet dat er een aantal mensen waren die op zich ook mee wilden doen met de eerste batch maar achter het net visten. Als je er één wil graag even in dat topic animo tonen, bij >10 animo ga ik ze bestellen.

Op samenkopen.net houd ik nu een animocheck voor een tweede batch mSATA naar SATA-adapters. Ik weet dat er een aantal mensen waren die op zich ook mee wilden doen met de eerste batch maar achter het net visten. Als je er één wil graag even in dat topic animo tonen, bij >10 animo ga ik ze bestellen.

Ik heb ook het bovenstaande moederbord in gedachte in combinatie met een i3-3220 en 16GB Ram (corsair valueram, 2 reepjes).romikn schreef op donderdag 04 oktober 2012 @ 16:30:

Zou iemand mij nog aan/opmerkingen kunnen geven over mijn htpc/nas

# Product Prijs Subtotaal 1 Asrock H77 Pro4-M € 71,10 € 71,10 1 Intel Pentium G860 Boxed € 62,45 € 62,45 1 Scythe Big Shuriken 2 Rev. B € 32,30 € 32,30 1 Kingston ValueRAM KVR1333D3N9/4G € 15,95 € 15,95 Bekijk collectie

Importeer productenTotaal € 181,80

bedankt

Ik wil ook graag links posten, maar ben wat beperkt met alleen een mobiele telefoon

Uiteindelijk gaat deze combi functioneren als vmware server, maar werkt de on board netwerkkaart? En wat kan ik voor verbruik verwachten?

Als ik het vergelijk met een i3-2100 zou de ivy variant net iets zuiniger moeten zijn

XBO Gamertag: BeerkeeperNL

Welke software is performance wise het beste om virtual machines te runnen onder Windows 7 ?

ik heb een tijdje geleden een Fractal behuizing gekocht via de V&A, toen dacht ik dat ik een i5 ging gebruiken, echter heeft die een andere bestemming gehad, nu ben ik op zoek naar een zuinig atom bord waar dus ca 6 schijven op aangesloten kan worden maar die ook Win server 2012 kan draaien of iemand met nog andere ideeen ik ben nu al 3 weken aan het dubben maar echt eruit komen lukt tot op heden nog niet goed

Atom's zijn nauwelijks nog zuiniger (idle) dan een gemiddeld Core i3 of i5. Waarom wil je persee Atom?Locks schreef op zondag 07 oktober 2012 @ 18:23:

ik heb een tijdje geleden een Fractal behuizing gekocht via de V&A, toen dacht ik dat ik een i5 ging gebruiken, echter heeft die een andere bestemming gehad, nu ben ik op zoek naar een zuinig atom bord waar dus ca 6 schijven op aangesloten kan worden maar die ook Win server 2012 kan draaien of iemand met nog andere ideeen ik ben nu al 3 weken aan het dubben maar echt eruit komen lukt tot op heden nog niet goed

Zeg... Ik zat nu zo eens een tijdje geleden te denken en ik gooide het ideetje eens naar FireDrunk (die vond het niet zo praktisch, die mafkees wilt niet zo hard "tweaken"

):

):

Wat als je nu eens meerdere servers thuis hebt (ondertussen draaien sommigen van ons al een ESXi en daarlangs nog eens een NAS/SAN) en je zou die consolideren op één voeding? Ik weet vanbuiten dat je een groene en een zwarte draad moest verbinden en dat dan een voeding opspint. Als je nu op de een of andere manier (er zijn genoeg kerels die dat hier kunnen, ben ik zeker van). Een wipschakelaartje tussen die twee draden zet en de rest van de echte "voedingsdraden" doorlust zodat je er 2 moederbordjes op kan hangen... Dan zit je toch ook met een behoorlijk efficiente voeding, omdat je die voeding belast met het gevraagde vermogen van 2 moederbordjes/setjes, waardoor je idle verbruik zowieso al hoger ligt en zo een voeding beter performed... Of is een moederbord daar een te gevoelig voor en zijn de geleverde spanningen dan niet meer stabiel genoeg?

Uit gewoonte of gemak neem ik altijd VirtualBox, uit het vertrouwen wat gegroeid is met de ervaringen met ESXi neem ik vaak VMware Workstation... Ligt er maar net aan wat je graag hebt en wat je beschikbaar hebt...

Wat als je nu eens meerdere servers thuis hebt (ondertussen draaien sommigen van ons al een ESXi en daarlangs nog eens een NAS/SAN) en je zou die consolideren op één voeding? Ik weet vanbuiten dat je een groene en een zwarte draad moest verbinden en dat dan een voeding opspint. Als je nu op de een of andere manier (er zijn genoeg kerels die dat hier kunnen, ben ik zeker van). Een wipschakelaartje tussen die twee draden zet en de rest van de echte "voedingsdraden" doorlust zodat je er 2 moederbordjes op kan hangen... Dan zit je toch ook met een behoorlijk efficiente voeding, omdat je die voeding belast met het gevraagde vermogen van 2 moederbordjes/setjes, waardoor je idle verbruik zowieso al hoger ligt en zo een voeding beter performed... Of is een moederbord daar een te gevoelig voor en zijn de geleverde spanningen dan niet meer stabiel genoeg?

Geen, performance is allemaal ruk.ThinkPadd schreef op zondag 07 oktober 2012 @ 11:44:

Welke software is performance wise het beste om virtual machines te runnen onder Windows 7 ?

Uit gewoonte of gemak neem ik altijd VirtualBox, uit het vertrouwen wat gegroeid is met de ervaringen met ESXi neem ik vaak VMware Workstation... Ligt er maar net aan wat je graag hebt en wat je beschikbaar hebt...

[ Voor 53% gewijzigd door HyperBart op 07-10-2012 19:24 ]

@meerdere computers op één voeding: Kan vrij eenvoudig gedaan worden, maar als je echt fysiek twee verschillende kasten moet voeden hangt er een flinke kabelboom tussen. Ik ben zelf meer fan van meerdere picopsu's aan de 12V-rail van een PSU hangen. Alle voordelen zonder de nadelen.

brengt me op een idee om daar een custom printje voor te maken...

brengt me op een idee om daar een custom printje voor te maken...

[ Voor 12% gewijzigd door mux op 07-10-2012 19:28 ]

Inderdaad, dat is dan wel de beste oplossing... Dan heb je eigenlijk één DIKKE adapter langs je kasten liggen die je PicoPSU's voedt...mux schreef op zondag 07 oktober 2012 @ 19:28:

@meerdere computers op één voeding: Kan vrij eenvoudig gedaan worden, maar als je echt fysiek twee verschillende kasten moet voeden hangt er een flinke kabelboom tussen. Ik ben zelf meer fan van meerdere picopsu's aan de 12V-rail van een PSU hangen. Alle voordelen zonder de nadelen.

brengt me op een idee om daar een custom printje voor te maken...

Rendabel genoeg om zo te beginnen? Stel je voor dat je een ESXi-clustertje zou willen bouwen: moederbord, cpu, geheugen (32GB), een usb stickje en that's it...

Ik denk dat het wel redelijk snel loont om zoiets te doen. Misschien vanaf 2 computers, waarschijnlijker vanaf 3 stuks. Hm, misschien moet dat maar eens gemaakt worden. Ooit.

ehmm ja goeie vraag dus een ivy bridge i3 zal net zo zuinig zijn als een atom ? en dan zou qua board P8H67-I volstaan ? of kan het nog wat zuiniger zonder die 6 sata poorten te verliezen?redfoxert schreef op zondag 07 oktober 2012 @ 18:27:

[...]

Atom's zijn nauwelijks nog zuiniger (idle) dan een gemiddeld Core i3 of i5. Waarom wil je persee Atom?

goedenavond,

Ik zat te denken om mijn server wat sneller te maken en dan vooral in het afspelen van (gelijktijdige) 1080p materiaal.

Er zit nu een g620t + 4GB ram + 3*3TB + SSD aan een voeding van 350watt in maar ik ervaar toch vaak stotterringen in het afspelen van 1080p materiaal onder het streamen binnen een thuisnetwerk (1gb).

Nu is mijn vraag of het upgraden naar de i3-3220 processor voldoende is om dit probleem tegen te gaan, tenminste voor zo goed als.

De server wordt gebruikt voor media en het downloaden (sickbeard, coach etc.) er van even als een back-up voor de andere pc's, staat dus merendeel idle dus het energie gebruik moet in dat geval niet te hoog zijn.

iemand die mij hier in tips kan geven?

ps. mijn server draait nu op whs2011 en ga dit niet veranderen ivm 3Tb aan data die ik anders moet gaan verplaatsen.

pps: Het moederbord is een asus P8H67-i

Ik zat te denken om mijn server wat sneller te maken en dan vooral in het afspelen van (gelijktijdige) 1080p materiaal.

Er zit nu een g620t + 4GB ram + 3*3TB + SSD aan een voeding van 350watt in maar ik ervaar toch vaak stotterringen in het afspelen van 1080p materiaal onder het streamen binnen een thuisnetwerk (1gb).

Nu is mijn vraag of het upgraden naar de i3-3220 processor voldoende is om dit probleem tegen te gaan, tenminste voor zo goed als.

De server wordt gebruikt voor media en het downloaden (sickbeard, coach etc.) er van even als een back-up voor de andere pc's, staat dus merendeel idle dus het energie gebruik moet in dat geval niet te hoog zijn.

iemand die mij hier in tips kan geven?

ps. mijn server draait nu op whs2011 en ga dit niet veranderen ivm 3Tb aan data die ik anders moet gaan verplaatsen.

pps: Het moederbord is een asus P8H67-i

Ik kan me niet voorstellen dat de processor niet snel genoeg is. Heb je al problemen als er 1 filmpje afgespeeld wordt, of enkel bij meer tegelijk? Weet je wat de CPU belasting is als het stottert?thvers schreef op zondag 07 oktober 2012 @ 20:21:

goedenavond,

Ik zat te denken om mijn server wat sneller te maken en dan vooral in het afspelen van (gelijktijdige) 1080p materiaal.

Er zit nu een g620t + 4GB ram + 3*3TB + SSD aan een voeding van 350watt in maar ik ervaar toch vaak stotterringen in het afspelen van 1080p materiaal onder het streamen binnen een thuisnetwerk (1gb).

If it ain't broken, tweak it! | gasloos sinds oktober 2025, hoekwoning 1978 | 10kWp PV, Panasonic K serie 7kW, Atlantic Explorer V5 270L | Tesla Model Y

Verwijderd

Als je performance problemen krijgt bij filetransfers / streaming, zou je dan de oorzaak niet eerder in (soft)raid problemen zoeken? Ik stream met gemak 3 1080P streams vanaf mijn qnap 439 (single core atom)..?FatalError schreef op zondag 07 oktober 2012 @ 20:27:

[...]

Ik kan me niet voorstellen dat de processor niet snel genoeg is. Heb je al problemen als er 1 filmpje afgespeeld wordt, of enkel bij meer tegelijk? Weet je wat de CPU belasting is als het stottert?

edit: sorry reageer op de verkeerde post zie ik. Eens met FatalError dus!

[ Voor 6% gewijzigd door Verwijderd op 07-10-2012 20:30 ]

Idle is een ivy bridge i3 net zo zuinig, zo niet zuiniger. Ask MuxLocks schreef op zondag 07 oktober 2012 @ 19:48:

[...]

ehmm ja goeie vraag dus een ivy bridge i3 zal net zo zuinig zijn als een atom ? en dan zou qua board P8H67-I volstaan ? of kan het nog wat zuiniger zonder die 6 sata poorten te verliezen?

Wat versta je onder streamen? Het filebased benaderen van de bestanden of daadwerkelijk transcoden naar een formaat dat leesbaar is voor je media device? Het eerste is nauwelijk CPU intensief, het tweede alleen maar.thvers schreef op zondag 07 oktober 2012 @ 20:21:

goedenavond,

Ik zat te denken om mijn server wat sneller te maken en dan vooral in het afspelen van (gelijktijdige) 1080p materiaal.

Er zit nu een g620t + 4GB ram + 3*3TB + SSD aan een voeding van 350watt in maar ik ervaar toch vaak stotterringen in het afspelen van 1080p materiaal onder het streamen binnen een thuisnetwerk (1gb).

Met streamen bedoel ik vooral het transcoden, via airplayit naar de ipad en psms naar mijn ps3. CPU gebruik is dan vaak ruim boven de 50%. Nu ook bij het transcoden van een aflevering van the office 720p..

Bij 2 streams/transcoding gaat alles dus haperen . Het benaderen van bestanden via het thuisnetwerk gaat wel zonder problemen.

Bij 2 streams/transcoding gaat alles dus haperen . Het benaderen van bestanden via het thuisnetwerk gaat wel zonder problemen.

helaas is het formaat mini ITX das wel jammer heb ik al gemerktredfoxert schreef op zondag 07 oktober 2012 @ 20:47:

[...]

Idle is een ivy bridge i3 net zo zuinig, zo niet zuiniger. Ask MuxQua moederbord ... hangt van je maten af die je kwijt wilt maar een Intel moederbordje of het MSI mATX B75 chipset bordje zijn vrij zuinig zonder teveel aan specs in te leveren.

Aha, dat effect ken ik.thvers schreef op zondag 07 oktober 2012 @ 21:29:

Met streamen bedoel ik vooral het transcoden, via airplayit naar de ipad en psms naar mijn ps3. CPU gebruik is dan vaak ruim boven de 50%. Nu ook bij het transcoden van een aflevering van the office 720p..

Bij 2 streams/transcoding gaat alles dus haperen . Het benaderen van bestanden via het thuisnetwerk gaat wel zonder problemen.

Ik had een oude E7500 dual core die een 1080p stream met AirVideo maar net trok en met 720p ook al naar de 50% ging. Nu met een 3570K quad core zijn 2 streams geen probleem, maar of meer ook kan weer ik niet...

Ik twijfel dus of de i3 ook 2 streams trekt...

Material 3 Thema's voor HA | Swiss Army Knife custom card voor HA | AmoebeLabs

Wat transcode je naar wat met welke bitrate? Een high-profile h.264 1080p naar 720p transcoden brengt elke CPU wel op z'n knieën.

mux schreef op zondag 07 oktober 2012 @ 19:42:

Hm, misschien moet dat maar eens gemaakt worden. Ooit.

mux schreef op zondag 07 oktober 2012 @ 19:28:

Ik ben zelf meer fan van meerdere picopsu's aan de 12V-rail van een PSU hangen. Alle voordelen zonder de nadelen.

1 mini voeding voor een PSU controller die naar gelang de stroomvraag extra bricks inschakeld om meerdere PicoPSU's van spanning te voorzien. Deze verzorgen de stroomtoevoer voor gedeelde lijnen. Eigenlijk hetzelfde als in moderne servers (/chassis) word toegepast.HyperBart schreef op zondag 07 oktober 2012 @ 19:34:

Dan heb je eigenlijk één DIKKE adapter langs je kasten liggen die je PicoPSU's voedt...

En als je dan toch bezig bent Mux; een scale-up hiervan voor 12V DC voeding van LED systemen voor een heel huis is ook wel aardig.

Het gaat er een keer komen, maar waarschijnlijk parallel aan MADPSU. Tot het einde van dit jaar ben ik al druk genoeg (hell, het hele ssd-backup-verhaal is al een week vertraagd en dat is een ubersimpel printje).

Ter voorkoming van cross-posts: Mag ik jullie herinneren aan dit topic?

Het gaat inmiddels vooral over de CPU:

Helaas is de E3-1240v2 in Europa niet leverbaar in de servers die ik op het oog heb (en de v1 is echt een generatie ouder), en is de E5-2420 meteen weer een stuk duurder. Wat zijn jullie gedachten bij deze vergelijking? Het gaat dus vooral om Hyper-V gebruik.

Tips voor een E3-1240v2 server van een bekend merk met (minimaal) 8 3,5" SATA bays zijn natuurlijk ook welkom.

Het gaat inmiddels vooral over de CPU:

| E3-1240(v1) | 3.3GHz (+Turbo) | 4 Core / 8 vCore | 8MB cache | 80W | 5GT/s bus |

| E3-1240(v2) | 3.4GHz (+Turbo) | 4 Core / 8 vCore | 8MB cache | 69W | 5GT/s bus |

| E5-2403 | 1.8GHz | 4 Core / 4 vCore | 10MB cache | 80W | 6.4GT/s bus |

| E5-2420 | 1.9GHz (+ Turbo) | 6 Core / 12 vCore | 15MB cache | 95W | 7.2GT/s bus |

Helaas is de E3-1240v2 in Europa niet leverbaar in de servers die ik op het oog heb (en de v1 is echt een generatie ouder), en is de E5-2420 meteen weer een stuk duurder. Wat zijn jullie gedachten bij deze vergelijking? Het gaat dus vooral om Hyper-V gebruik.

Tips voor een E3-1240v2 server van een bekend merk met (minimaal) 8 3,5" SATA bays zijn natuurlijk ook welkom.

Het is allebei gratis, dus wat dat betreft maakt het niet uit.HyperBart schreef op zondag 07 oktober 2012 @ 19:18:[...]

Geen, performance is allemaal ruk.

Uit gewoonte of gemak neem ik altijd VirtualBox, uit het vertrouwen wat gegroeid is met de ervaringen met ESXi neem ik vaak VMware Workstation... Ligt er maar net aan wat je graag hebt en wat je beschikbaar hebt...

En heb ook geen VM's die 24/7 op 100% CPU staan te stampen ofzo. Gewoon wat fileshare meuk/downloadmachientje/webserver

VMware Workstation gratis?? Er is nog altijd een licentie voor nodig dus gratis is VMware Workstation zeker niet. Of je moet ESXi bedoelen, die is wel gratis maar totaal niet vergelijkbaar met VirtualBox.ThinkPadd schreef op dinsdag 09 oktober 2012 @ 11:01:

[...]

Het is allebei gratis, dus wat dat betreft maakt het niet uit.

[ Voor 6% gewijzigd door redfoxert op 09-10-2012 11:08 ]

Nog een leuke review voor als je een zuinige SSD zoekt:

http://www.pc-experience.de/wbb2/thread.php?threadid=32434

Helaas is de Samsung 470 een beetje te prijzig.

http://www.pc-experience.de/wbb2/thread.php?threadid=32434

Helaas is de Samsung 470 een beetje te prijzig.

[ Voor 17% gewijzigd door audiojunk op 09-10-2012 11:43 ]

Metallicgear Neo micro,AMD Ryzen 7 5700G,ASUS ROG Strix B550-I Gaming, Crucial DDR4 2x8GB,PC3600, Samsung 980Pro 1 TB ,2x Seagate ST4000LM024 SATA 4TB 2.5 ,be quiet Efficient F1 350W, be quiet! Dark Rock 4

Samsung 470 is ook een oud model en dus niet of nauwelijks leverbaar. Vandaar de "hoge" prijs. Zuinig is hij zeker maar snel zeker niet.audiojunk schreef op dinsdag 09 oktober 2012 @ 11:40:

Nog een leuke review voor als je een zuinige SSD zoekt:

http://www.pc-experience.de/wbb2/thread.php?threadid=32434

Helaas is de Samsung 470 een beetje te prijzig.

Ik zie het ,alleen bij een leverancier te krijgen.

Als je de snelheid gaat merken,ik heb zelf zowel een OCZ Onyx 32GB en een Crucial M4 128GB en merk weinig verschil in gewoon gebruik.

Als je de snelheid gaat merken,ik heb zelf zowel een OCZ Onyx 32GB en een Crucial M4 128GB en merk weinig verschil in gewoon gebruik.

Metallicgear Neo micro,AMD Ryzen 7 5700G,ASUS ROG Strix B550-I Gaming, Crucial DDR4 2x8GB,PC3600, Samsung 980Pro 1 TB ,2x Seagate ST4000LM024 SATA 4TB 2.5 ,be quiet Efficient F1 350W, be quiet! Dark Rock 4

Dit heb ik ook al enkele maanden draaien. Een aantal Pico's op een PSU, erg efficiënt.mux schreef op zondag 07 oktober 2012 @ 19:28:

@meerdere computers op één voeding: Kan vrij eenvoudig gedaan worden, maar als je echt fysiek twee verschillende kasten moet voeden hangt er een flinke kabelboom tussen. Ik ben zelf meer fan van meerdere picopsu's aan de 12V-rail van een PSU hangen. Alle voordelen zonder de nadelen.

brengt me op een idee om daar een custom printje voor te maken...

productreview: Antec Earthwatts EA-450 Platinum review door tHe_BiNk

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

Waar ik nou wel benieuwd naar ben, hoe performed die voeding tegenover een picoPSU met losse adapter?tHe_BiNk schreef op dinsdag 09 oktober 2012 @ 18:54:

[...]

Dit heb ik ook al enkele maanden draaien. Een aantal Pico's op een PSU, erg efficiënt.

productreview: Antec Earthwatts EA-450 Platinum review door tHe_BiNk

Heb hier thuis een picoPSU voor m'n server in gebruik, maar vraag me soms af of een normale voeding niet zuiniger zou zijn

En mux: ik wil nieuwe hardware voor in m'n server. Gaat een G620 en een zuinig moederbord worden.

Welke kan ik dan beter halen?

pricewatch: Asrock B75 Pro3-M

of

pricewatch: Intel Desktop Board DH67BL (B3)

?

Rest van de hardware:

1x Samsung HD203WI 2TB 3.5" HDD

1x 40GB 2.5" HDD

4x2GB DDR3

En pricewatch: Mini-box picoPSU 80-WI-32V met een 16V 4.5A ThinkPad adapter

M'n voorkeur gaat zelf uit naar het Intel bord, in mijn ogen gebruiken zij waarschijnlijk kwalitatief betere componenten. En ook omdat het Intel bord een Intel Gigabit adapter heeft versus de Realtek op het Asrock bord.

[ Voor 42% gewijzigd door ThinkPad op 10-10-2012 08:52 ]

De intel is absoluut kwalitatief beter en out of the box wat zuiniger, maar je betaalt er ook voor. Bovendien kun je de asrock met het idioot uitgebreide bios met wat moeite weer even zuinig of zuiniger krijgen dan de intel.

Boeit die 20 euro je? Zitten er killer features op één van de twee borden?

Boeit die 20 euro je? Zitten er killer features op één van de twee borden?

Mocht je behoorlijk willen uitbreiden met schijven (lijkt er niet op) dan heeft de Asrock daar natuurlijk een voordeeltje. Hoe langer je een losse controller kunt uitsparen, hoe beter.

Ik kan de Intel tweedehands voor bijna dezelfde prijs als de Asrock krijgen

Uitbreiden van schijven gaat het toch niet worden. En out of the box zuiniger is natuurlijk altijd mooi

Dan ga ik de Intel kopen

Uitbreiden van schijven gaat het toch niet worden. En out of the box zuiniger is natuurlijk altijd mooi

Dan ga ik de Intel kopen

[ Voor 47% gewijzigd door ThinkPad op 10-10-2012 10:11 ]

Ja

Misschien dat mux de Asrock de hemel in zou prijzen omdat die zoooooveeeel beter zou zijn dan de Intel. Maar dat is niet het geval, dus dan kies ik voor de Intel.

Misschien dat mux de Asrock de hemel in zou prijzen omdat die zoooooveeeel beter zou zijn dan de Intel. Maar dat is niet het geval, dus dan kies ik voor de Intel.

Verwijderd

Heb veel zitten wrikken en wegen, en kom op de volgende setup voor de vervanging van mijn synology.

Er komt debian op te draaien, op 2x 1TB schijven die ik overzet van m'n synology. Gaat voornamelijk gebruikt worden voor opslag, sabnzbd, sickbeard en streamen van 720/1080 mkv'tjes. Huidige synology begint traag te worden, repairen duurt erg lang en wanneer ik SSL aanzet in sabnzbd haal ik max 1.8Mbps terwijl dit zonder veel hoger is.

Vraag me af of ik de proc misschien moet upgraden naar een i3-2100 of misschien kan alles ook wel met bijv. een G620. Andere onderdelen heb ik geselecteed met oog op zuinigheid, voor zover ik dat goed heb.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Pentium G850 Boxed | € 59,95 | € 59,95 |

| 1 | Gelid Solutions Siberian | € 6,60 | € 6,60 |

| 1 | Crucial Ballistix Tactical | € 39,95 | € 39,95 |

| 1 | be quiet! Pure Power L7 350W | € 40,45 | € 40,45 |

| 1 | Intel Desktop Board DH67BL (B3) | € 83,79 | € 83,79 |

| Bekijk collectie Importeer producten | Totaal | € 230,74 | |

Er komt debian op te draaien, op 2x 1TB schijven die ik overzet van m'n synology. Gaat voornamelijk gebruikt worden voor opslag, sabnzbd, sickbeard en streamen van 720/1080 mkv'tjes. Huidige synology begint traag te worden, repairen duurt erg lang en wanneer ik SSL aanzet in sabnzbd haal ik max 1.8Mbps terwijl dit zonder veel hoger is.

Vraag me af of ik de proc misschien moet upgraden naar een i3-2100 of misschien kan alles ook wel met bijv. een G620. Andere onderdelen heb ik geselecteed met oog op zuinigheid, voor zover ik dat goed heb.

Ik begrijp je keuze voor die after-market koeler niet helemaal in deze setup. Wat is er mis met de boxed koeler van Intel? Die dingen zijn al geruime tijd prima om stockspeeds te koelen zonder geluidsproductie. Dan de keuze van het moederbord, waarom eentje van een oudere generatie? Serie 7 is al een tijdje goed verkrijgbaar. Het MSI B75 mATX bordje bijvoorbeeld is een erg zuinige keuze. Het geheugen kan ook nog wel een paar eurotjes goedkoper tegen dezelfde kwaliteit maar dat is meer gepiel in de marge.Verwijderd schreef op zondag 14 oktober 2012 @ 10:33:

Heb veel zitten wrikken en wegen, en kom op de volgende setup voor de vervanging van mijn synology.

# Product Prijs Subtotaal 1 Intel Pentium G850 Boxed € 59,95 € 59,95 1 Gelid Solutions Siberian € 6,60 € 6,60 1 Crucial Ballistix Tactical € 39,95 € 39,95 1 be quiet! Pure Power L7 350W € 40,45 € 40,45 1 Intel Desktop Board DH67BL (B3) € 83,79 € 83,79 Bekijk collectie

Importeer productenTotaal € 230,74

Er komt debian op te draaien, op 2x 1TB schijven die ik overzet van m'n synology. Gaat voornamelijk gebruikt worden voor opslag, sabnzbd, sickbeard en streamen van 720/1080 mkv'tjes. Huidige synology begint traag te worden, repairen duurt erg lang en wanneer ik SSL aanzet in sabnzbd haal ik max 1.8Mbps terwijl dit zonder veel hoger is.

Vraag me af of ik de proc misschien moet upgraden naar een i3-2100 of misschien kan alles ook wel met bijv. een G620. Andere onderdelen heb ik geselecteed met oog op zuinigheid, voor zover ik dat goed heb.

Qua keuze voor de cpu, dat hangt echt helemaal af van wat je nodig hebt al zit er niet heel veel verschil tussen een G620 en een G850. Upgrade naar een Core i3 3220 zou ik aanraden als je echt meer cpu power nodig hebt. Die i3-2100 is ook alweer van een oudere generatie. Als je dan gaat upgraden, neem dan iets wat ook echt nieuw is.

Voor dit doel kun je prima af met een Celeron G530, behalve als je met 'streamen' bedoelt dat hij ook moet kunnen transcoden. Maar dat lijkt er niet op (gezien je momenteel ook al je synology hiervoor gebruikt). Voor zuinigheid maakt het niet uit welke processor je kiest, trouwens. De voornaamste reden om een lagere proc te gebruiken is simpelweg kostenbesparing.

Vanwaar de crucial ballistix? Je kunt net zo goed het ultiem compatibele pricewatch: Kingston ValueRAM KVR1333D3N9K2/8G gebruiken

Je kunt overwegen voor een modernere voeding te gaan, bijv. de BQ Efficient F1 350/400W of Seasonic G-serie 360W. Ietsjes duurder en ietsjes zuiniger. Onder de streep komt het ongeveer op hetzelfde neer na een paar jaar, met als voordeel dat beide voedingen ook net wat beter gebouwd zijn dan de L7 en je dus langer van dienst kunnen zijn.

Vanwaar de crucial ballistix? Je kunt net zo goed het ultiem compatibele pricewatch: Kingston ValueRAM KVR1333D3N9K2/8G gebruiken

Je kunt overwegen voor een modernere voeding te gaan, bijv. de BQ Efficient F1 350/400W of Seasonic G-serie 360W. Ietsjes duurder en ietsjes zuiniger. Onder de streep komt het ongeveer op hetzelfde neer na een paar jaar, met als voordeel dat beide voedingen ook net wat beter gebouwd zijn dan de L7 en je dus langer van dienst kunnen zijn.

Bij een belasting van 5% (20 a 30 watt aan de muur) is de efficiëntie van deze voeding, zo rond de 70%. Op basis mijn mijn beperkte metingen.ThinkPadd schreef op woensdag 10 oktober 2012 @ 07:57:

[...]

Waar ik nou wel benieuwd naar ben, hoe performed die voeding tegenover een picoPSU met losse adapter?

Heb hier thuis een picoPSU voor m'n server in gebruik, maar vraag me soms af of een normale voeding niet zuiniger zou zijn

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

Dit is wat ik in gedachten heb voor een redelijk zuinig, maar toch redelijk krachtig file-servertje:

Ik wil er Samba, SSH, torrent/Usenet downloads, PostgreSQL en wat losse download-scripts op draaien. De 3TB-schijven zullen in RAID 1 staan.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Celeron G540 Boxed | € 36,50 | € 36,50 |

| 2 | Seagate Barracuda 7200.14 ST3000DM001, 3TB | € 125,90 | € 251,80 |

| 1 | Sharkoon MS140 | € 35,50 | € 35,50 |

| 1 | Seasonic S12II 380W | € 53,48 | € 53,48 |

| 1 | Kingston ValueRAM KVR1333D3N9K2/8G | € 32,45 | € 32,45 |

| 1 | Asrock B75 Pro3-M | € 59,90 | € 59,90 |

| Bekijk collectie Importeer producten | Totaal | € 469,63 | |

Ik wil er Samba, SSH, torrent/Usenet downloads, PostgreSQL en wat losse download-scripts op draaien. De 3TB-schijven zullen in RAID 1 staan.

- Ik overwoog eerst de Antec One, maar heb toch liever een wat kleinere behuizing.

- Wellicht koop ik nog extra fans voor de airflow in de kast.

- Is 380W voor de voeding overkill?

- Mogelijk gooi ik er nog een oude 60GB SSD in voor het OS (Ubuntu). Zou dat significante performance-winst opleveren?

Anyone who's ever played a part // They wouldn't turn around and hate it

380W is zwaar overkill.

Fans zijn niet nodig, je hele systeem word amper warm verwacht ik.

@SSD, Performance winst op wat? Downloads? En wat nou als je download groter is dan de vrije ruimte op je SSD? (dikke blu-ray? )

)

Fans zijn niet nodig, je hele systeem word amper warm verwacht ik.

@SSD, Performance winst op wat? Downloads? En wat nou als je download groter is dan de vrije ruimte op je SSD? (dikke blu-ray?

[ Voor 29% gewijzigd door FireDrunk op 16-10-2012 10:12 ]

Even niets...

Waarom RAID-1 voor wat usenet downloads? Je hebt zó 8W en 130 euro verdiend door die tweede schijf eruit te laten. Dat kun je steken in een goede backupoplossing.

Verder zou je kunnen overwegen met zo weinig onderdelen om voor een mini-ITX behuizing te gaan (bijv. Antec ISK-300-65 met MSI H61I-E35 moederbord) met ingebouwde picopsu

Verder zou je kunnen overwegen met zo weinig onderdelen om voor een mini-ITX behuizing te gaan (bijv. Antec ISK-300-65 met MSI H61I-E35 moederbord) met ingebouwde picopsu

Die 380 W kun je wel vervangen door bijv, een 300 W beQuite (of een picoPSU 90/120).FireDrunk schreef op dinsdag 16 oktober 2012 @ 10:11:

380W is zwaar overkill.

Fans zijn niet nodig, je hele systeem word amper warm verwacht ik.

Ik heb mijn B75 Pro-M3 op dit momen topen en bloot op de tafel liggen, zal vanavond eens voelen hoe warm de boel wordt bij par/unrar werkzaamheden.

De download snelheid is doorgaans beperkt door je internet aansluiting, zelfs bij een 1e generatie SSD breekt het zweet niet uit als je een 100Mbit verbinding hebt. Het is natuurlijk wel lekker snel mbt par/unrar, maar dan loop je wel tegen de beperkingen aan van je capaciteit.@SSD, Performance winst op wat? Downloads? En wat nou als je download groter is dan de vrije ruimte op je SSD? (dikke blu-ray?)

Op de 60 GB SSD, minus je gestripte OS install, zul je enkel de kleinere BD formaten kunnen downloaden. Als je extra ruimte voor het uitpakken erbij neemt zul je toch minimaal een SSD van ca. 120 GB moeten hebben om een dual layer BD van 50 GB te kunnen huisvesten voor de hele operatie.

| Capacity | ||||

Type | Diameter (cm) | Layers | Bytes | GB |

| Standard disc size, single layer | 12 | 1 | 25,025,314,816 | 25.0 |

| Standard disc size, Dual layer | 12 | 2 | 50,050,629,632 | 50.1 |

| Standard disc size, XL3 layer | 12 | 3 | 100,103,356,416 | 100.1 |

| Standard disc size, XL4 layer | 12 | 4 | 128,001,769,472 | 128.0 |

| Mini disc size, single layer | 8 | 1 | 7,791,181,824 | 7.8 |

| Mini disc size, dual layer | 8 | 2 | 15,582,363,648 | 15.6 |

Voor MKV's tot ca. 20 GB zal het als een speer werken die ssd.

[ Voor 6% gewijzigd door Pantagruel op 16-10-2012 11:26 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Persoonlijk heb ik dat ook gedaan, maar daar ga je snel vanaf, omdat je zelf de files moet moven naar je array.

SabNZBd pakt tegenwoordig uit vanaf de destination. Je temp bevat alleen maar de gecodeerde nieuwsgroep artikelen. Zodra yEnc eroverheen gaat, gaat het al naar de destination directory.

Als dat je SSD is, worden de files daar uitgepakt. Een 20GB BluRay neemt dus 40GB in beslag.

Daarnaast, kan je dus geen queue meer hebben, want je SSD is dan meteen vol.

Of je moet zelf nog een post-processing script bouwen...

SabNZBd pakt tegenwoordig uit vanaf de destination. Je temp bevat alleen maar de gecodeerde nieuwsgroep artikelen. Zodra yEnc eroverheen gaat, gaat het al naar de destination directory.

Als dat je SSD is, worden de files daar uitgepakt. Een 20GB BluRay neemt dus 40GB in beslag.

Daarnaast, kan je dus geen queue meer hebben, want je SSD is dan meteen vol.

Of je moet zelf nog een post-processing script bouwen...

Even niets...

@mux: Ik ben zuinig op de PostgreSQL-database, dus die wil ik per se in een RAID 1 array. Ik heb echter niet de volle 3 TB daarvoor nodig (zal hooguit een paar GB zijn).

Ik heb geen ervaring met RAID. Kan ik als alternatief dit doen?

Ik ga de SSD toch maar niet gebruiken: te omslachtig, en de download-snelheid zal waarschijnlijk de limiterende factor zijn.

Ik heb geen ervaring met RAID. Kan ik als alternatief dit doen?

- 2 drives van 500 GB in RAID 1 draaien voor de belangrijke data, en tegelijkertijd...

- 1 drive van 3 TB schijf gewoon laten draaien voor mijn usenet-downloads

Ik ga de SSD toch maar niet gebruiken: te omslachtig, en de download-snelheid zal waarschijnlijk de limiterende factor zijn.

Anyone who's ever played a part // They wouldn't turn around and hate it

Ik denk dat zelfs 75W zou voldoen...

Even niets...

Als je zuinig bent op je data, moet je geen RAID draaien. Alleen een offsite backup helpt je daarmee. Hoe groot is die database?

@mux: Momenteel minder dan een GB, maar mogelijk groeiend tot enkele GBs. Ik gebruik de data dagelijks in een belangrijk proces, vandaar RAID. Daarnaast wil ik ook een online backup-oplossing gaan gebruiken.

Om mijn vraag te herhalen: kan ik tegelijkertijd sommige drives in RAID en andere drives niet in RAID draaien?

Om mijn vraag te herhalen: kan ik tegelijkertijd sommige drives in RAID en andere drives niet in RAID draaien?

[ Voor 21% gewijzigd door Def_Os op 16-10-2012 11:55 ]

Anyone who's ever played a part // They wouldn't turn around and hate it

Lijkt me een stukken beter ideeDef_Os schreef op dinsdag 16 oktober 2012 @ 11:35:

@mux: Ik ben zuinig op de PostgreSQL-database, dus die wil ik per se in een RAID 1 array. Ik heb echter niet de volle 3 TB daarvoor nodig (zal hooguit een paar tientallen GB zijn).

Ik heb geen ervaring met RAID. Kan ik als alternatief dit doen?Ik zal nog eens kijken naar mini-ITX kastjes, en de voeding heroverwegen. Volstaat 200 of 250 W voor deze build?

- 2 drives van 500 GB in RAID 1 draaien voor de belangrijke data, en tegelijkertijd...

- 1 drive van 3 TB schijf gewoon laten draaien voor mijn usenet-downloads

Ik ga de SSD toch maar niet gebruiken: te omslachtig, en de download-snelheid zal waarschijnlijk de limiterende factor zijn.

Ssd is niet handig voor een met netwerkschijf want netwerk heb je al meer latency.

ora et labora

Kun je in de SABnzbd conf niet een alternatieve destination opgeven en enkel alle bewerkingen in de temp space plaats laten vinden? (heb geen ervaring met SABnzb)FireDrunk schreef op dinsdag 16 oktober 2012 @ 11:34:

Persoonlijk heb ik dat ook gedaan, maar daar ga je snel vanaf, omdat je zelf de files moet moven naar je array.

SabNZBd pakt tegenwoordig uit vanaf de destination. Je temp bevat alleen maar de gecodeerde nieuwsgroep artikelen. Zodra yEnc eroverheen gaat, gaat het al naar de destination directory.

Als dat je SSD is, worden de files daar uitgepakt. Een 20GB BluRay neemt dus 40GB in beslag.

Daarnaast, kan je dus geen queue meer hebben, want je SSD is dan meteen vol.

Of je moet zelf nog een post-processing script bouwen...

Ik gebruik zelf op dit moment HellaNZB en laat de download op een 80 GB SSD (Intel Postville) binnenkomen, nadat par2 en unrar hun werk hebben gedaan gaat de data naar een HDD welke als directory gelinkt is in de directory structuur die HellaNZB gebruikt.

stukje uit de hellanzb.conf

code:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

| #Hellanzb.PREFIX_DIR = '/mntX//DirectoryY/' Hellanzb.PREFIX_DIR = '/ssd/usenet-tmp/' # Where to put queued .nzb files Hellanzb.QUEUE_DIR = Hellanzb.PREFIX_DIR + 'nzb/' # Where the fully processed archives go Hellanzb.DEST_DIR = Hellanzb.PREFIX_DIR + 'downed/' #downed/ is a linked HDD # The .nzb currently being downloaded is stored here Hellanzb.CURRENT_DIR = Hellanzb.PREFIX_DIR + 'nzb/daemon.current/' # The archive currently being downloaded is stored here Hellanzb.WORKING_DIR = Hellanzb.PREFIX_DIR + 'nzb/daemon.working/' # Archives interrupted in the middle of downloading are stored here temporarily Hellanzb.POSTPONED_DIR = Hellanzb.PREFIX_DIR + 'nzb/daemon.postponed/' |

Betekend wel dat de kopieer stap naar de HDD de beperkende factor is (ca. 90 MB/s), maar de SSD ruimte wel weer vrijkomt. Ik heb trouwens nog nooit getest of de download/controle/uitpak/kopieer slag van twee 25 GB BD's eigenlijk lukt (mbt. queing/etc). Mijn gok is dat het wel zal werken aangezien de download snelheid bij ons slechts 20 Mbit is en de eerste BD als is verwerkt voordat de tweede volledig uit het net is gezogen.

[ Voor 11% gewijzigd door Pantagruel op 16-10-2012 12:04 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Maar RAID helpt niet met het beschermen van je data, het zorgt er alleen voor dat je systeem tijdens het falen van één schijf nog 'up' blijft. Is dat zo belangrijk voor je? Want zoniet (en het lijkt me dat dit niet je doel is), dan kun je beter de database op RAMdisk laten staan en disk-backen, en vervolgens elke 15 minuten synchroniseren met je backup. Zeker als het maar een paar GB is, is dit een prima optie.Def_Os schreef op dinsdag 16 oktober 2012 @ 11:54:

@mux: Momenteel minder dan een GB, maar mogelijk groeiend tot enkele GBs. Ik gebruik de data dagelijks in een belangrijk proces, vandaar RAID. Daarnaast wil ik ook een online backup-oplossing gaan gebruiken.

Om mijn vraag te herhalen: kan ik tegelijkertijd sommige drives in RAID en andere drives niet in RAID draaien?

3 schijven gebruiken kost je alleen maar nog meer geld.

Ja, dat is juist belangrijk. Sorry, ik wil er niet verder over uitweiden.mux schreef op dinsdag 16 oktober 2012 @ 12:16:

[...]

Maar RAID helpt niet met het beschermen van je data, het zorgt er alleen voor dat je systeem tijdens het falen van één schijf nog 'up' blijft. Is dat zo belangrijk voor je?

OK, ik ga het zo doen: ik sloop mijn 2 TB schijf uit mijn media-speler (vanaf nu ga ik toch streamen vanaf de server) en stop die in de server voor massa-opslag. Daarnaast 2 kleine schijven in RAID 1 voor de database en het OS.

Bedankt voor de tips. Ik ga nu voor:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Celeron G540 Boxed | € 36,50 | € 36,50 |

| 1 | Sharkoon MS140 | € 35,50 | € 35,50 |

| 1 | be quiet! Pure Power L7 300W | € 36,- | € 36,- |

| 1 | Kingston ValueRAM KVR1333D3N9K2/8G | € 32,45 | € 32,45 |

| 1 | Asrock B75 Pro3-M | € 59,95 | € 59,95 |

| Bekijk collectie Importeer producten | Totaal | € 200,40 | |

Anyone who's ever played a part // They wouldn't turn around and hate it

Vergeet niet dat je bij RAID1 nog steeds voor een backup moet zorgen... RAID is geen backup!

Ja, zowel met Linux als Windows kan je meerdere verschillende combinaties naast elkaar draaien.Def_Os schreef op dinsdag 16 oktober 2012 @ 11:54:

Om mijn vraag te herhalen: kan ik tegelijkertijd sommige drives in RAID en andere drives niet in RAID draaien?

[ Voor 25% gewijzigd door tHe_BiNk op 16-10-2012 17:50 ]

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

Je kunt met mdadm onder Linux ook een kleinere schijf met een deel van een grotere schijf een RAID volume laten vormen. Bijvoorbeeld een 2TB harde schijf en een 500GB harde schijf. Met mdadm kun je dan een 500GB RAID volume maken met een 500GB partitie op de 2TB schijf. De rest van die 2TB schijf kun je dan weer toekennen aan een niet RAID volume. Mogelijkheden genoeg!Def_Os schreef op dinsdag 16 oktober 2012 @ 11:54:

Om mijn vraag te herhalen: kan ik tegelijkertijd sommige drives in RAID en andere drives niet in RAID draaien?

Ik ben van plan om mijn complete installatie opnieuw in te richten. Op dit moment heb ik een nas/htpc die aan de hoofdtv verbonden is. Hierin zit 3x2TB en 1x160gb (een of andere WD Blue) als OS/download schijf.

De exacte configuratie van deze bak is terug te vinden in mijn inventaris.

Nu wil ik alles zo gaan inrichten dat de server ook echt een server gaat zijn en er komen aparte clients voor alle tv's. De server zal vooral gebruikt worden voor het streamen naar de clients. Ook zal tv over het netwerk gaan.

De voglende configuratie had ik zelf samengesteld.:

Hierbij zal de hdd config nog gebruikt worden die hier boven genoemd werd, allen zal de Crucial V4 OS schijf worden en zal de download schijf wellicht vervangen worden door een WD green 1TB die hier nog ergens ligt.

Dingen waar ik nog over twijfel zijn de voeding en de processor en het moederbord.

Is de meerprijs voor een G630 het waard boven een G550 voor de taken die de server gaat verrichten? (hdtv, 720p en 1080p mkv streamen, usenet downloaden en parren).

Wat betreft de voeding; nu zit alles in een Antec NSK4480 case met Antec Earthwatts 380W, maar ik heb ook nog ergens een BeQuiet L7 430W in gebruik die dalijk obselete is. Dus welke van de twee is de betere om te gebruiken of kan ik beter voor een van de voedingen gaan die in dit topic voorbij zijn gekomen en de rest op de stort of marktplaats gooien?

Het moederbord heb ik gekozen (boven bijvoorbeeld de Asrock Pro3m), omdat deze beschikt over 3 legacy PCI sloten. Dit met in ijn achterhoofd het idee dat ik nooit meer dan 3 tuners nodig ga hebben in de opstelling zoals die nu is. Ik ga ervan uit dat deze dezelfde features heeft in het UEFI als het b75 brodje dat heir vaak voorbij komt, maar dat hij wellicht een paar watt meer verbruikt?

De exacte configuratie van deze bak is terug te vinden in mijn inventaris.

Nu wil ik alles zo gaan inrichten dat de server ook echt een server gaat zijn en er komen aparte clients voor alle tv's. De server zal vooral gebruikt worden voor het streamen naar de clients. Ook zal tv over het netwerk gaan.

De voglende configuratie had ik zelf samengesteld.:

| # | Product | Prijs | Subtotaal |

| 1 | Technisat CableStar HD2 | € 49,80 | € 49,80 |

| 1 | Intel Celeron G550 Boxed | € 38,90 | € 38,90 |

| 1 | Crucial v4 SSD 2.5" 32GB | € 38,95 | € 38,95 |

| 1 | Kingston ValueRAM KVR1333D3N9K2/8G | € 32,45 | € 32,45 |

| 1 | Asrock H77 Pro4/MVP | € 75,95 | € 75,95 |

| Bekijk collectie Importeer producten | Totaal | € 236,05 | |

Hierbij zal de hdd config nog gebruikt worden die hier boven genoemd werd, allen zal de Crucial V4 OS schijf worden en zal de download schijf wellicht vervangen worden door een WD green 1TB die hier nog ergens ligt.

Dingen waar ik nog over twijfel zijn de voeding en de processor en het moederbord.

Is de meerprijs voor een G630 het waard boven een G550 voor de taken die de server gaat verrichten? (hdtv, 720p en 1080p mkv streamen, usenet downloaden en parren).

Wat betreft de voeding; nu zit alles in een Antec NSK4480 case met Antec Earthwatts 380W, maar ik heb ook nog ergens een BeQuiet L7 430W in gebruik die dalijk obselete is. Dus welke van de twee is de betere om te gebruiken of kan ik beter voor een van de voedingen gaan die in dit topic voorbij zijn gekomen en de rest op de stort of marktplaats gooien?

Het moederbord heb ik gekozen (boven bijvoorbeeld de Asrock Pro3m), omdat deze beschikt over 3 legacy PCI sloten. Dit met in ijn achterhoofd het idee dat ik nooit meer dan 3 tuners nodig ga hebben in de opstelling zoals die nu is. Ik ga ervan uit dat deze dezelfde features heeft in het UEFI als het b75 brodje dat heir vaak voorbij komt, maar dat hij wellicht een paar watt meer verbruikt?

Mij Atom N270 kan dat al prima, 1080P video streamen. Netwerk download snelheid via samba is ~40/50MB/s.sjaft schreef op woensdag 17 oktober 2012 @ 01:31:

Is de meerprijs voor een G630 het waard boven een G550 voor de taken die de server gaat verrichten? (hdtv, 720p en 1080p mkv streamen, usenet downloaden en parren).

Ook gebruik ik twonky server (DLNA) voor het streamen van deze films en Ziggo TV opnames naar de TV.

Me Atom N270 is net niet snel genoeg om de Ziggo HD kanalen te decrypten.

Ik vraag me af of een nieuwe Trinity A4/A6 interessant kan zijn voor een OpenVPN server voor een 100Mbit verbinding. Met de Atom haal ik niet meer van 5MB/s via AES-128. Maar voor dat de Trinity standaard de AES-NI instructie heeft, kan je een stuk hoger halen. Maar de meeste reviews gaat het alleen over de A8/A10 en de stroomverbruik testen spreken elkaar allemaal tegen. Ene keer win de AMD andere keer de Intel.

Alle raid modi. Maar dan nog dataloss door uitval acht ik hoger dan door brand ,virussen diefstal etc.EgMaf schreef op dinsdag 16 oktober 2012 @ 13:07:

Vergeet niet dat je bij RAID1 nog steeds voor een backup moet zorgen... RAID is geen backup!

Beter raid dan geen backup.

ora et labora

De kans dat je RAID-1 array faalt is veel meer dan 2x zo hoog als dat een enkele HDD faalt. Je voegt twee extra schakels toe die kunnen falen (je RAID-controller en een extra HDD). Voor de meeste thuistoepassingen is niet RAID draaien veiliger dan wel RAID.

Dat is wel heel kort door de bocht... De controller kan bij RAID1 gewoon falen, want de data kan je er daarna gewoon af halen. Bij RAID5 is dat inderdaad een ander verhaal.

RAID kan veiliger zijn, mits goed gebruikt. Maar het is inderdaad geen backup.

RAID kan veiliger zijn, mits goed gebruikt. Maar het is inderdaad geen backup.

Even niets...

Klopt, maar hoe groot is nou de kans ddat ze allebij tegelijk het loodje leggen?mux schreef op woensdag 17 oktober 2012 @ 09:43:

De kans dat je RAID-1 array faalt is veel meer dan 2x zo hoog als dat een enkele HDD faalt. Je voegt twee extra schakels toe die kunnen falen (je RAID-controller en een extra HDD). Voor de meeste thuistoepassingen is niet RAID draaien veiliger dan wel RAID.

Raid1 kan je makkelijk rebuilden of splitsen. Controller stuk andere harware en het werkt weer.

ora et labora

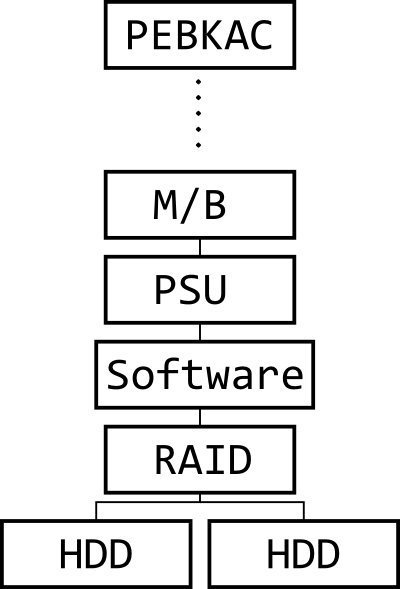

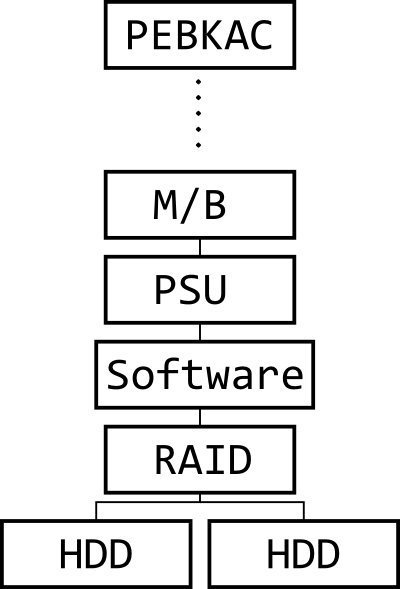

Het probleem bij kleine arrays is dat je geen probleem aan het oplossen bent, maar alleen maar meer geld aan het uitgeven bent en stroom verbruikt. Het idee van RAID is dat point failure niet leidt tot system failure. Maar RAID doet dit niet, het enige dat RAID doet is het allerduurste component van je computer, de HDD, beschermen tegen point failure door hem dubbel uit te voeren. Laten we het eens in een failure diagram vatten:

Je hele computer is een serie-failure model. Alles in je systeem, van gebruikersfout tot elke andere onafhankelijke hardwarefout zorgt voor system failure, en een hoop daarvan zijn catastrofale system failures (data niet terug te krijgen). Het énige wat je dubbel uitvoert zijn de HDDs, en daarbij voeg je nog een extra series hazard toe in de vorm van de RAID-controller.

Bovendien, zelfs dit plaatje is niet correct: het google-onderzoek heeft aangetoond dat HDD failure geen onafhankelijke event is. Als één schijf in de array faalt is de kans dat een volgende schijf binnen een uur faalt meer dan 10%.

Dus vanuit een failure-theorie-perspectief is een kleine RAID array niet echt iets dat wiskundig hout snijdt. Het voornaamste effect ervan is dat je veel meer geld moet uitgeven aan storage zonder er significant op vooruit te gaan in redundantie. Je enige overduidelijke voordeel is continuiteit: je computer blijft werken als één schijf faalt.

Dit plaatje wordt anders naarmate je meer schijven gebruikt, omdat dan een véél groter aandeel van je hazard disk failure wordt, en je dus veel meer winst kunt boeken door je schijven redundant uit te voeren.

Je hele computer is een serie-failure model. Alles in je systeem, van gebruikersfout tot elke andere onafhankelijke hardwarefout zorgt voor system failure, en een hoop daarvan zijn catastrofale system failures (data niet terug te krijgen). Het énige wat je dubbel uitvoert zijn de HDDs, en daarbij voeg je nog een extra series hazard toe in de vorm van de RAID-controller.

Bovendien, zelfs dit plaatje is niet correct: het google-onderzoek heeft aangetoond dat HDD failure geen onafhankelijke event is. Als één schijf in de array faalt is de kans dat een volgende schijf binnen een uur faalt meer dan 10%.

Dus vanuit een failure-theorie-perspectief is een kleine RAID array niet echt iets dat wiskundig hout snijdt. Het voornaamste effect ervan is dat je veel meer geld moet uitgeven aan storage zonder er significant op vooruit te gaan in redundantie. Je enige overduidelijke voordeel is continuiteit: je computer blijft werken als één schijf faalt.

Dit plaatje wordt anders naarmate je meer schijven gebruikt, omdat dan een véél groter aandeel van je hazard disk failure wordt, en je dus veel meer winst kunt boeken door je schijven redundant uit te voeren.

Misschien niet 100% vergelijkbaar, maar ik denk dan meteen:

Dat is hetzelfde als geen sloten op je deur zetten omdat de kans dat je je eigen auto in de prak rijd (PEBKAC) groter is dan dat hij gestolen word (HDD Failure).

Ga je daarom ook geen sloten meer op je deur zetten?

In mijn ogen is RAID een vrij goedkope manier van een vervelende failure opvangen. Niet meer en niet minder.

PSU, Moederbord en CPU gaan veel minder vaak kapot dan je disks.

User error is natuurlijk altijd een risico, in welk gedeelte van je hele leven dan ook, daar kun je geen kansberekening op doen...

Verder: Als ik offsite backup heb, moet ik even 2TB (of meer...) over mijn internetlijn trekken...

Het is dus niet alleen een blijft werken issue, maar ook een recovery-tijd issue.

Dat is hetzelfde als geen sloten op je deur zetten omdat de kans dat je je eigen auto in de prak rijd (PEBKAC) groter is dan dat hij gestolen word (HDD Failure).

Ga je daarom ook geen sloten meer op je deur zetten?

In mijn ogen is RAID een vrij goedkope manier van een vervelende failure opvangen. Niet meer en niet minder.

PSU, Moederbord en CPU gaan veel minder vaak kapot dan je disks.

User error is natuurlijk altijd een risico, in welk gedeelte van je hele leven dan ook, daar kun je geen kansberekening op doen...

Verder: Als ik offsite backup heb, moet ik even 2TB (of meer...) over mijn internetlijn trekken...

Het is dus niet alleen een blijft werken issue, maar ook een recovery-tijd issue.

[ Voor 51% gewijzigd door FireDrunk op 17-10-2012 10:20 ]

Even niets...

Jep, de kans dat ik in huis word beroofd is bijvoorbeeld significant lager dan dat er brand of een andere calamiteit uitbreekt. Ik doe daarom nooit al mijn deuren op slot 's nachts. Het verschil tussen wiskunde en angst, idem met (wederom, kleine!) RAID-arrays.

Overigens is het bij auto's een ander verhaal, omdat je niet over hetzelfde systeem praat. Als een auto stilstaat kun je hem niet in de prak rijden, en als je erin rijdt kun je (tenzij je in Mexico-stad woont) niet beroofd worden.

edit: een lokale backup is sneller en goedkoper dan een RAID rebuild, omdat je (en dit geldt écht vooral bij 2-disk RAID 1 systemen) minder vaak HDDs moet uitwisselen, je alleen copypasta hoeft te doen (snellere transfer) en dus totaal minder tijd bezig bent.

edit 2: een andere manier van zeggen is: je kunt beter het geld dat je uitgeeft aan RAID-1 uitgeven aan een onafhankelijke backupoplossing, omdat dat statistisch betere beveiliging tegen failure geeft.

Overigens is het bij auto's een ander verhaal, omdat je niet over hetzelfde systeem praat. Als een auto stilstaat kun je hem niet in de prak rijden, en als je erin rijdt kun je (tenzij je in Mexico-stad woont) niet beroofd worden.

edit: een lokale backup is sneller en goedkoper dan een RAID rebuild, omdat je (en dit geldt écht vooral bij 2-disk RAID 1 systemen) minder vaak HDDs moet uitwisselen, je alleen copypasta hoeft te doen (snellere transfer) en dus totaal minder tijd bezig bent.

edit 2: een andere manier van zeggen is: je kunt beter het geld dat je uitgeeft aan RAID-1 uitgeven aan een onafhankelijke backupoplossing, omdat dat statistisch betere beveiliging tegen failure geeft.

[ Voor 31% gewijzigd door mux op 17-10-2012 10:27 ]

Groter dan dat er maar 1 kapot gaat.mrc4nl schreef op woensdag 17 oktober 2012 @ 09:55:

[...]

Klopt, maar hoe groot is nou de kans ddat ze allebij tegelijk het loodje leggen?

Raid1 kan je makkelijk rebuilden of splitsen. Controller stuk andere harware en het werkt weer.

En die kans wordt nog groter als de schijven uit dezelfde batch komen.

Wet van Murphy...

Dan kan nog je RAID controller kapot gaat. En itt wat hierboven staat betekent dat niet altijd dat je met eenzelfde controller je data eraf kan krijgen in geval van consumentenhardware. Hier heb ik helaas persoonlijk ervaring mee.

RAID is vooral leuk als je niet direct bij de hardware kan of veel performance nodig hebt.

Het rebuilden van RAID arrays, zeker als ze wat groter zijn, is een drama.

Mijn toy/test server hier doet ruim 6 uur over een rebuild van een simulated disk fail bij RAID 5 over 8 15K SAS schijven op een mooie controller. En performance is dramatisch terwijl dat aan de gang is.

- knip -

Verwijderd

De Antec is de betere voeding van de twee.sjaft schreef op woensdag 17 oktober 2012 @ 01:31:

Wat betreft de voeding; nu zit alles in een Antec NSK4480 case met Antec Earthwatts 380W, maar ik heb ook nog ergens een BeQuiet L7 430W in gebruik die dalijk obselete is. Dus welke van de twee is de betere om te gebruiken of kan ik beter voor een van de voedingen gaan die in dit topic voorbij zijn gekomen en de rest op de stort of marktplaats gooien?

Als een systeem met een enkele schijf kapot gaat moet je eerst een nieuwe schijf bestellen, wachten tot die binnen is. De schijf testen met de fabriekstools als je verstandig bent. Inbouwen en dan een back-up terugzetten. Hoelang duurt dat?

En gaat je RAID-controller kapot dan sluit je een schijf gewoon op een normale poort aan en je draait weer verder met een enkele schijf en een tot dat moment complete back-up op de andere schijf. Dat kan gewoon met RAID-1 schijven. Nieuwe controller en rebuilden vanaf de schijf die je bent blijven gebruiken.

De enige manier om die downtime te verkorten is door een reserveschijf al op de plank te hebben liggen. Dan kun je die er net zo goed in een RAID-1 array bijzetten. De bescherming tegen downtime en de real-time 'back-up' ook al is het geen échte back-up (maar het moet wel erg tegenzitten om niet bruikbaar te zijn als back-up) is mij die bescheiden investering in die extra schijf zeker waard.

Ik zal nooit meer een (hoofd)systeem bouwen dat geen RAID-1 array bevat.

En gaat je RAID-controller kapot dan sluit je een schijf gewoon op een normale poort aan en je draait weer verder met een enkele schijf en een tot dat moment complete back-up op de andere schijf. Dat kan gewoon met RAID-1 schijven. Nieuwe controller en rebuilden vanaf de schijf die je bent blijven gebruiken.

De enige manier om die downtime te verkorten is door een reserveschijf al op de plank te hebben liggen. Dan kun je die er net zo goed in een RAID-1 array bijzetten. De bescherming tegen downtime en de real-time 'back-up' ook al is het geen échte back-up (maar het moet wel erg tegenzitten om niet bruikbaar te zijn als back-up) is mij die bescheiden investering in die extra schijf zeker waard.

Ik zal nooit meer een (hoofd)systeem bouwen dat geen RAID-1 array bevat.

Recent heb ik het met iemand nog over gehad. Een simpele server voor zo'n 200 euro, met Raid1 uitvoeren en een hardwarematige controller was ook een vereiste. Maar, dan moeten de schijven ook weer dusdanig zijn dat ze er niet uit worden gemikt. Niet veel later had ik die persoon ervan overtuigd om twee simpele servers (één daarvan echt zo minimaal/goedkoop mogelijk) en de Raid controller te laten hangen. Die persoon heeft met die beslissing een significant veiligere opstelling neergezet, zeker omdat een ook nog een offsite is geworden.

Juist met Raid1 met twee schijven zijn de extra kosten van die extra schijf en de controller relatief hoog. Natuurlijk verschuift dit iets als je naar software RAID gaat, maar niet iedereen wil daaraan of kan daaraan met het oog op het OS.

Dus hoewel ietwat gechargeerd kan ik mij zeker wel vinden in een stelling dat Raid1 met twee schijven een opstelling is waar je meer en langer over moet nadenken, als het je enkel en alleen om de veiligheid te doen is.

Juist met Raid1 met twee schijven zijn de extra kosten van die extra schijf en de controller relatief hoog. Natuurlijk verschuift dit iets als je naar software RAID gaat, maar niet iedereen wil daaraan of kan daaraan met het oog op het OS.

Dus hoewel ietwat gechargeerd kan ik mij zeker wel vinden in een stelling dat Raid1 met twee schijven een opstelling is waar je meer en langer over moet nadenken, als het je enkel en alleen om de veiligheid te doen is.

Voor business-critical toepassingen, ja (als elk verloren uur je geld kost)CaptJackSparrow schreef op woensdag 17 oktober 2012 @ 12:55:

Als een systeem met een enkele schijf kapot gaat moet je eerst een nieuwe schijf bestellen, wachten tot die binnen is. De schijf testen met de fabriekstools als je verstandig bent. Inbouwen en dan een back-up terugzetten. Hoelang duurt dat?